JP6740641B2 - ウェアラブル端末、制御方法、およびプログラム - Google Patents

ウェアラブル端末、制御方法、およびプログラム Download PDFInfo

- Publication number

- JP6740641B2 JP6740641B2 JP2016040948A JP2016040948A JP6740641B2 JP 6740641 B2 JP6740641 B2 JP 6740641B2 JP 2016040948 A JP2016040948 A JP 2016040948A JP 2016040948 A JP2016040948 A JP 2016040948A JP 6740641 B2 JP6740641 B2 JP 6740641B2

- Authority

- JP

- Japan

- Prior art keywords

- angle

- information processing

- user

- unit

- processing terminal

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/58—Means for changing the camera field of view without moving the camera body, e.g. nutating or panning of optics or image sensors

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G06F3/167—Audio in a user interface, e.g. using voice commands for navigating, audio feedback

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F1/00—Details not covered by groups G06F3/00 - G06F13/00 and G06F21/00

- G06F1/16—Constructional details or arrangements

- G06F1/1613—Constructional details or arrangements for portable computers

- G06F1/163—Wearable computers, e.g. on a belt

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F1/00—Details not covered by groups G06F3/00 - G06F13/00 and G06F21/00

- G06F1/16—Constructional details or arrangements

- G06F1/1613—Constructional details or arrangements for portable computers

- G06F1/1633—Constructional details or arrangements of portable computers not specific to the type of enclosures covered by groups G06F1/1615 - G06F1/1626

- G06F1/1684—Constructional details or arrangements related to integrated I/O peripherals not covered by groups G06F1/1635 - G06F1/1675

- G06F1/1686—Constructional details or arrangements related to integrated I/O peripherals not covered by groups G06F1/1635 - G06F1/1675 the I/O peripheral being an integrated camera

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/0304—Detection arrangements using opto-electronic means

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/50—Constructional details

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/50—Constructional details

- H04N23/51—Housings

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/64—Computer-aided capture of images, e.g. transfer from script file into camera, check of taken image quality, advice or proposal for image composition or decision on when to take image

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/667—Camera operation mode switching, e.g. between still and video, sport and normal or high- and low-resolution modes

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/69—Control of means for changing angle of the field of view, e.g. optical zoom objectives or electronic zooming

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Multimedia (AREA)

- General Physics & Mathematics (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- Signal Processing (AREA)

- Computer Hardware Design (AREA)

- General Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Health & Medical Sciences (AREA)

- Studio Devices (AREA)

Description

1.情報処理端末の外観

2.カメラブロックの構造

3.撮影モード

4.情報処理端末の内部構成と動作

5.変形例

6.情報処理端末の構造の詳細

7.その他

図1は、本技術の一実施形態に係る情報処理端末の外観の構成例を示す図である。

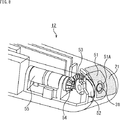

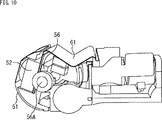

図8は、カメラブロックの構造を示す図である。上述したカメラモジュール、レンズ31などがカメラブロックに含まれる。

ここで、情報処理端末1の撮影モードについて説明する。

図12は、静止画撮影モードの撮影シーケンスの例を示す図である。

図13は、静止画連写モードの撮影シーケンスの例を示す図である。

図14は、インターバル撮影モードの撮影シーケンスの例を示す図である。

図15は、オート撮影モードの撮影シーケンスの例を示す図である。

図16は、動画撮影モードの撮影シーケンスの例を示す図である。

<4−1.情報処理端末の内部構成>

図17は、情報処理端末1の内部の構成例を示すブロック図である。

次に、図20のフローチャートを参照して、情報処理端末1の撮影処理について説明する。図20の処理は、例えば、ユーザの発話に基づいて音声コマンドが検出されたときに開始される。

<5−1.制御システムの例>

行動状態の取得、調整角度の決定、および角度調整の全ての処理が情報処理端末1により行われるものとしたが、行動状態の取得と調整角度の決定については、他の機器により行われるようにすることが可能である。

画角の制御を光学的に行う場合について主に説明したが、トリミングにより切り出す範囲を変えることで電子的に行うことも可能である。この場合、レンズ31には、魚眼レンズなどの焦点距離の短いレンズが用いられる。

センサデータに基づいて行動状態を取得するものとしたが、行動状態の取得方法は任意に変更可能である。

GPSセンサとしての信号処理回路114により検出された位置情報に基づいてユーザの行動状態が取得されるようにしてもよい。この場合、行動状態取得部131は、位置情報と行動状態とを対応付けた情報を管理している。

無線通信の接続先の機器に基づいてユーザの行動状態が特定されるようにしてもよい。この場合、行動状態取得部131は、接続先の機器の識別情報と行動状態とを対応付けた情報を管理している。

上述したように、情報処理端末1は、NFCタグ105を内蔵しており、近接された機器と近距離の無線通信を行うことが可能である。撮影を行う前に近接された機器に基づいてユーザの行動状態が取得されるようにしてもよい。この場合、行動状態取得部131は、近接された機器の識別情報と行動状態とを対応付けた情報を管理している。

・装着位置の例

情報処理端末1が首掛け型のウェアラブル端末であるものとしたが、カメラを有する他の形状のウェアラブル端末にも、上述した画角の制御機能を適用可能である。

カメラの画角を制御する雲台に上述した画角の制御機能を適用するようにしてもよい。

各行動状態に応じた角度調整に用いるパラメータ(角度)は、設計時のまま固定の値であってもよいし、装着位置の違い、体格差、自転車乗車時の姿勢の違いなどに応じて、適宜変更されるようにしてもよい。

次に、情報処理端末1の構造の詳細について説明する。

<7−1.コンピュータの構成例>

上述した一連の処理は、ハードウェアにより実行することもできるし、ソフトウェアにより実行することもできる。一連の処理をソフトウェアにより実行する場合には、そのソフトウェアを構成するプログラムが、専用のハードウェアに組み込まれているコンピュータ、または汎用のパーソナルコンピュータなどに、プログラム記録媒体からインストールされる。

本技術は、以下のような構成をとることもできる。

ユーザの行動状態を示す行動状態情報を取得する取得部と、

前記行動状態情報に応じて、取得される画像の画角を制御する制御部と

を備える情報処理装置。

(2)

前記制御部は、前記画像を撮影する撮影部が有するレンズの角度、および前記レンズの焦点距離のうちの少なくともいずれかを変えることによって、前記画角を制御する

前記(1)に記載の情報処理装置。

(3)

前記取得部は、センサの検出結果に基づいて、前記ユーザの行動状態を取得する

前記(1)または(2)に記載の情報処理装置。

(4)

前記センサをさらに備え、

前記情報処理装置は前記ユーザの頭部より下の部位に装着される装置である

前記(3)に記載の情報処理装置。

(5)

前記情報処理装置は、湾曲させたバンドで左右のユニットを繋げることによって構成された筐体を有し、前記ユーザの首に掛けて装着される

前記(4)に記載の情報処理装置。

(6)

前記情報処理装置を装着した前記ユーザから見た、前記ユーザの前方を撮影方向に含む撮影部をさらに備える

前記(1)乃至(5)のいずれかに記載の情報処理装置。

(7)

前記制御部は、筐体に形成された開口の内側に配置された前記撮影部が有するレンズの角度を変え、前記画角を制御する

前記(6)に記載の情報処理装置。

(8)

前記制御部は、撮影を行わない場合、前記レンズが前記開口から露出しないように前記撮影部を制御する

前記(7)に記載の情報処理装置。

(9)

前記制御部は、撮影された画像の切り出し範囲を変えることによって、前記画角を制御する

前記(1)に記載の情報処理装置。

(10)

前記制御部は、直立状態と乗り物に乗っている状態とを少なくとも含む前記行動状態に応じて、前記画角を制御する

前記(1)乃至(9)のいずれかに記載の情報処理装置。

(11)

前記行動状態は、前記直立状態として歩行状態を含む

前記(10)に記載の情報処理装置。

(12)

前記行動状態は、前記乗り物に乗っている状態として、自転車に乗車している状態を含む

前記(10)に記載の情報処理装置。

(13)

前記制御部は、前記情報処理装置の姿勢にも基づいて、前記画角を制御する

前記(1)乃至(12)のいずれかに記載の情報処理装置。

(14)

前記制御部は、前記情報処理装置の装着位置にも基づいて、前記画角を制御する

前記(1)乃至(13)のいずれかに記載の情報処理装置。

(15)

前記制御部は、前記情報処理装置の移動の速さにも基づいて、前記画角を制御する

前記(1)乃至(14)のいずれかに記載の情報処理装置。

(16)

前記センサは、慣性センサである

前記(4)に記載の情報処理装置。

(17)

前記センサは、生体センサである

前記(4)に記載の情報処理装置。

(18)

ユーザの行動状態を示す行動状態情報を取得し、

前記行動状態情報に応じて、取得される画像の画角を制御する

ステップを含む制御方法。

(19)

ユーザの行動状態を示す行動状態情報を取得し、

前記行動状態情報に応じて、取得される画像の画角を制御する

ステップを含む処理をコンピュータシステムに実行させるプログラム。

Claims (13)

- 湾曲させたバンドの左右の先端にそれぞれユニットが設けられた筐体を有し、ユーザの首に掛けて装着されるウェアラブル端末であって、

前記ユニットの先端に設けられた、レンズの角度を調整可能な撮影部と、

前記ユーザの前傾姿勢をセンサの検出結果に基づいて取得する取得部と、

前記ユーザの前方を撮影するように前記レンズの角度を前記前傾姿勢に応じて上方向に変えることによって、前記撮影部が撮影する画像の画角を制御する制御部と

を備えるウェアラブル端末。 - 前記制御部は、さらに、前記レンズの焦点距離を変えることによって、前記画角を制御する

請求項1に記載のウェアラブル端末。 - 前記撮影部は、前記ユニットの先端に形成された開口の内側に配置される

請求項1または2に記載のウェアラブル端末。 - 前記制御部は、撮影を行わない場合、前記レンズが前記開口から露出しないように前記撮影部を制御する

請求項3に記載のウェアラブル端末。 - 前記制御部は、前記ウェアラブル端末の姿勢にも基づいて、前記画角を制御する

請求項1乃至4のいずれかに記載のウェアラブル端末。 - 前記制御部は、前記ウェアラブル端末の移動の速さにも基づいて、前記画角を制御する

請求項1乃至5のいずれかに記載のウェアラブル端末。 - 前記センサは、慣性センサである

請求項1乃至6のいずれかに記載のウェアラブル端末。 - 前記センサは、生体センサである

請求項1乃至6のいずれかに記載のウェアラブル端末。 - 前記ユニットに設けられたマイクロフォンをさらに備え、

前記制御部は、前記ユーザにより入力された音声コマンドに従って前記撮影部による撮影を制御する

請求項1乃至8のいずれかに記載のウェアラブル端末。 - 前記制御部は、前記撮影部による撮影を、前記音声コマンドに応じた撮影モードで行わせる

請求項9に記載のウェアラブル端末。 - 左右の前記ユニットのそれぞれに設けられ、音楽、または前記撮影部による撮影の効果音を出力するスピーカをさらに備える

請求項1乃至10のいずれかに記載のウェアラブル端末。 - 湾曲させたバンドの左右の先端にそれぞれユニットが設けられた筐体を有し、ユーザの首に掛けて装着される、レンズの角度を調整可能な撮影部が前記ユニットの先端に設けられたウェアラブル端末が、

前記ユーザの前傾姿勢をセンサの検出結果に基づいて取得し、

前記ユーザの前方を撮影するように前記レンズの角度を前記前傾姿勢に応じて上方向に変えることによって、前記撮影部が撮影する画像の画角を制御する

制御方法。 - 湾曲させたバンドの左右の先端にそれぞれユニットが設けられた筐体を有し、ユーザの首に掛けて装着される、レンズの角度を調整可能な撮影部が前記ユニットの先端に設けられたウェアラブル端末を制御するコンピュータに、

前記ユーザの前傾姿勢をセンサの検出結果に基づいて取得し、

前記ユーザの前方を撮影するように前記レンズの角度を前記前傾姿勢に応じて上方向に変えることによって、前記撮影部が撮影する画像の画角を制御する

処理を実行させるプログラム。

Priority Applications (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016040948A JP6740641B2 (ja) | 2016-03-03 | 2016-03-03 | ウェアラブル端末、制御方法、およびプログラム |

| CN201780013700.6A CN109074125A (zh) | 2016-03-03 | 2017-02-20 | 信息处理设备、控制方法和程序 |

| EP17709205.3A EP3423916A1 (en) | 2016-03-03 | 2017-02-20 | Information processing apparatus, control method, and program |

| PCT/JP2017/006076 WO2017150239A1 (en) | 2016-03-03 | 2017-02-20 | Information processing apparatus, control method, and program |

| US16/077,778 US10686975B2 (en) | 2016-03-03 | 2017-02-20 | Information processing apparatus and control method |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016040948A JP6740641B2 (ja) | 2016-03-03 | 2016-03-03 | ウェアラブル端末、制御方法、およびプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2017158083A JP2017158083A (ja) | 2017-09-07 |

| JP2017158083A5 JP2017158083A5 (ja) | 2019-04-04 |

| JP6740641B2 true JP6740641B2 (ja) | 2020-08-19 |

Family

ID=58231679

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016040948A Active JP6740641B2 (ja) | 2016-03-03 | 2016-03-03 | ウェアラブル端末、制御方法、およびプログラム |

Country Status (5)

| Country | Link |

|---|---|

| US (1) | US10686975B2 (ja) |

| EP (1) | EP3423916A1 (ja) |

| JP (1) | JP6740641B2 (ja) |

| CN (1) | CN109074125A (ja) |

| WO (1) | WO2017150239A1 (ja) |

Families Citing this family (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| GB2603295B (en) * | 2017-09-28 | 2023-03-29 | Canon Kk | Image pickup apparatus and control method therefor |

| JP6341526B1 (ja) * | 2018-01-16 | 2018-06-13 | 新生環境株式会社 | 自己行動記録カメラ |

| CN108446019B (zh) * | 2018-02-13 | 2020-11-06 | 重庆大学 | 一种基于可穿戴设备传感器技术的用户行为测量方法及操作纠偏模型 |

| JP2020030329A (ja) | 2018-08-23 | 2020-02-27 | キヤノン株式会社 | 撮像システムおよび制御方法 |

| CN111756960B (zh) * | 2019-03-27 | 2021-11-05 | 广东小天才科技有限公司 | 一种基于可穿戴设备的拍摄控制方法及可穿戴设备 |

| JP2020182140A (ja) * | 2019-04-26 | 2020-11-05 | 日本電産コパル株式会社 | 撮像装置及び撮像システム |

| JP6719140B1 (ja) * | 2019-11-15 | 2020-07-08 | Fairy Devices株式会社 | 首掛け型装置 |

Family Cites Families (21)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6429895B1 (en) | 1996-12-27 | 2002-08-06 | Canon Kabushiki Kaisha | Image sensing apparatus and method capable of merging function for obtaining high-precision image by synthesizing images and image stabilization function |

| JP2000059666A (ja) * | 1998-08-07 | 2000-02-25 | Victor Co Of Japan Ltd | 撮像装置 |

| US7456875B2 (en) * | 2002-03-14 | 2008-11-25 | Sony Corporation | Image pickup apparatus and method, signal processing apparatus and method, and wearable signal processing apparatus |

| GB2395081A (en) * | 2002-10-31 | 2004-05-12 | Hewlett Packard Co | Image capture system |

| CN100350792C (zh) * | 2004-04-14 | 2007-11-21 | 奥林巴斯株式会社 | 摄像装置 |

| JP2007104036A (ja) * | 2005-09-30 | 2007-04-19 | Konica Minolta Photo Imaging Inc | 表示装置 |

| US7855743B2 (en) * | 2006-09-08 | 2010-12-21 | Sony Corporation | Image capturing and displaying apparatus and image capturing and displaying method |

| JP2008124885A (ja) * | 2006-11-14 | 2008-05-29 | Sony Corp | 撮像システム、撮像方法 |

| JP4458131B2 (ja) * | 2007-08-23 | 2010-04-28 | ソニー株式会社 | 画像撮像装置、撮像方法 |

| JP2009118135A (ja) | 2007-11-06 | 2009-05-28 | Sony Corp | 撮像装置、撮像方法 |

| US8976086B2 (en) * | 2010-12-03 | 2015-03-10 | Esight Corp. | Apparatus and method for a bioptic real time video system |

| WO2013084448A1 (ja) * | 2011-12-07 | 2013-06-13 | パナソニック株式会社 | 撮像装置 |

| US20140267615A1 (en) * | 2013-03-15 | 2014-09-18 | William F. Tapia | Wearable camera |

| JP2015089059A (ja) * | 2013-11-01 | 2015-05-07 | ソニー株式会社 | 情報処理装置、情報処理方法、及びプログラム |

| US9578307B2 (en) * | 2014-01-14 | 2017-02-21 | Toyota Motor Engineering & Manufacturing North America, Inc. | Smart necklace with stereo vision and onboard processing |

| US10024679B2 (en) * | 2014-01-14 | 2018-07-17 | Toyota Motor Engineering & Manufacturing North America, Inc. | Smart necklace with stereo vision and onboard processing |

| US9629774B2 (en) * | 2014-01-14 | 2017-04-25 | Toyota Motor Engineering & Manufacturing North America, Inc. | Smart necklace with stereo vision and onboard processing |

| JP2015141215A (ja) * | 2014-01-27 | 2015-08-03 | 村田機械株式会社 | ヘッドマウントディスプレイ装置 |

| JP6252849B2 (ja) * | 2014-02-07 | 2017-12-27 | ソニー株式会社 | 撮像装置および方法 |

| US10182213B2 (en) * | 2014-06-02 | 2019-01-15 | Vivint, Inc. | Security camera privacy shutter |

| JP6642432B2 (ja) * | 2014-07-31 | 2020-02-05 | ソニー株式会社 | 情報処理装置及び情報処理方法、並びに画像表示システム |

-

2016

- 2016-03-03 JP JP2016040948A patent/JP6740641B2/ja active Active

-

2017

- 2017-02-20 EP EP17709205.3A patent/EP3423916A1/en not_active Withdrawn

- 2017-02-20 WO PCT/JP2017/006076 patent/WO2017150239A1/en active Application Filing

- 2017-02-20 CN CN201780013700.6A patent/CN109074125A/zh active Pending

- 2017-02-20 US US16/077,778 patent/US10686975B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| EP3423916A1 (en) | 2019-01-09 |

| JP2017158083A (ja) | 2017-09-07 |

| US20190052784A1 (en) | 2019-02-14 |

| WO2017150239A1 (en) | 2017-09-08 |

| US10686975B2 (en) | 2020-06-16 |

| CN109074125A (zh) | 2018-12-21 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6740641B2 (ja) | ウェアラブル端末、制御方法、およびプログラム | |

| US20230156319A1 (en) | Autonomous media capturing | |

| US11172292B2 (en) | Voice processing system | |

| WO2017212958A1 (ja) | 情報処理装置、情報処理方法、およびプログラム | |

| JPWO2016016984A1 (ja) | 撮像装置およびその被写体追尾方法 | |

| US20200314331A1 (en) | Image capturing apparatus, method for controlling the same, and storage medium | |

| JP2015080186A (ja) | 自動測位追尾撮影システム及び自動測位追尾撮影方法 | |

| CN113393856A (zh) | 拾音方法、装置和电子设备 | |

| CN111368765A (zh) | 车辆位置的确定方法、装置、电子设备和车载设备 | |

| KR20220128585A (ko) | 웨어러블 촬상장치, 촬상장치와 통신하는 휴대 기기 및 캘리브레이터, 이들의 제어방법과 이들의 제어 프로그램을 기억한 기억매체 | |

| US11729488B2 (en) | Image capturing apparatus, method for controlling the same, and storage medium | |

| CN113678141A (zh) | 用于盲人和视力受损人员的立体声装置 | |

| CN112584037B (zh) | 保存图像的方法及电子设备 | |

| US9742988B2 (en) | Information processing apparatus, information processing method, and program | |

| CN115184956B (zh) | Tof传感器系统和电子设备 | |

| JP7118456B2 (ja) | 首掛け型装置 | |

| WO2021095832A1 (ja) | 首掛け型装置 | |

| CN112447272A (zh) | 用于健身训练的提示方法和电子设备 | |

| WO2022091507A1 (ja) | 判定装置、及び判定方法 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20190219 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20190219 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20190924 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20191001 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20191122 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20200407 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200602 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20200623 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20200706 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 6740641 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |