JP6203406B2 - 拡張現実環境内の平面の広がりを判定するためのシステムおよび方法 - Google Patents

拡張現実環境内の平面の広がりを判定するためのシステムおよび方法 Download PDFInfo

- Publication number

- JP6203406B2 JP6203406B2 JP2016538974A JP2016538974A JP6203406B2 JP 6203406 B2 JP6203406 B2 JP 6203406B2 JP 2016538974 A JP2016538974 A JP 2016538974A JP 2016538974 A JP2016538974 A JP 2016538974A JP 6203406 B2 JP6203406 B2 JP 6203406B2

- Authority

- JP

- Japan

- Prior art keywords

- map

- flat

- occlusion

- support

- constructing

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T15/00—3D [Three Dimensional] image rendering

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T17/00—Three dimensional [3D] modelling, e.g. data description of 3D objects

- G06T17/10—Constructive solid geometry [CSG] using solid primitives, e.g. cylinders, cubes

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/30—Determination of transform parameters for the alignment of images, i.e. image registration

- G06T7/32—Determination of transform parameters for the alignment of images, i.e. image registration using correlation-based methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/30—Determination of transform parameters for the alignment of images, i.e. image registration

- G06T7/33—Determination of transform parameters for the alignment of images, i.e. image registration using feature-based methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/60—Type of objects

- G06V20/64—Three-dimensional objects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10024—Color image

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10028—Range image; Depth image; 3D point clouds

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Computer Graphics (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Software Systems (AREA)

- General Engineering & Computer Science (AREA)

- Computer Hardware Design (AREA)

- Geometry (AREA)

- Multimedia (AREA)

- Processing Or Creating Images (AREA)

- Length Measuring Devices By Optical Means (AREA)

- Image Processing (AREA)

Description

12 AR対応モバイルデバイス

14 オブジェクト

16 3次元キャラクタ

18 視野

20 センサ

22 センサプロセッサ

24 カメラ

26 カメラプロセッサ

28 ディスプレイ

30 グラフィックスプロセッサ

32 タッチセンサ

34 タッチセンサプロセッサ

36 通信モジュール

38 プロセッサ

40 (非一時的)メモリ

42 バス

44 ソフトウェアプログラムコード

46 コンピュータ可読媒体

210 平らな表面特定モジュール

220 サポートマップ構築モジュール

230 遮蔽マップ構築モジュール

240 境界表現構築モジュール

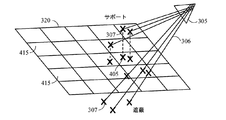

305 RGBDカメラ

306 視線

307 3Dの点

310 オブジェクト

315 全体的な環境

320 サポート面

405 点

410 点

415 グリッドのセル

510 比較的明るい陰影

520 比較的暗い陰影

530 左下角の領域

610 凸包

620 凹形の輪郭

630 2D点群

705 線分

710 線分

715 線分の内側

720 線分の外側

725 線分の内側

730 線分の外側

800 方法

900 コンピュータシステム

902 バス

904 プロセッサ

906 ストレージデバイス

908 入力デバイス

910 出力デバイス

912 通信サブシステム

914 オペレーティングシステム

916 アプリケーションプログラム

918 作業メモリ

Claims (20)

- 平らなオブジェクトの表現を構築するための方法であって、

見る位置から撮影された物理的シーンのデプス画像を取得するステップであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、ステップと、

平らな表面を特定するステップであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、ステップと、

サポートマップを構築するステップであって、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、ステップと、

遮蔽マップを構築するステップであって、

前記平らな表面を複数のセルに区切るステップと、

各セルに関して、前記見る位置から広がり、かつ前記平らな表面において前記セルを横切るのに十分なだけ大きなデプス値を有する点の数を数えるステップと

を含み、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、ステップと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストするステップと、

前記テストするステップに基づいて前記平らな表面の境界を構築するステップと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築するステップと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築するステップと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築するステップと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類するステップと

を含む、方法。 - 平らなオブジェクトの表現を構築するための方法であって、

見る位置から撮影された物理的シーンのデプス画像を取得するステップであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、ステップと、

平らな表面を特定するステップであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、ステップと、

サポートマップを構築するステップであって、

前記平らな表面を複数のセルに区切るステップと、

各セルに関して、前記見る位置から前記セルまで、または前記セルの上の空間の垂直なカラム内の位置まで広がるようにデプス値を有する点の数を数えるステップと

を含み、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、ステップと、

遮蔽マップを構築するステップであって、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、ステップと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストするステップと、

前記テストするステップに基づいて前記平らな表面の境界を構築するステップと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築するステップと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築するステップと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築するステップと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類するステップと

を含む、方法。 - 平らなオブジェクトの表現を構築するための方法であって、

見る位置から撮影された物理的シーンのデプス画像を取得するステップであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、ステップと、

平らな表面を特定するステップであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、ステップと、

サポートマップを構築するステップであって、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、ステップと、

遮蔽マップを構築するステップであって、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、ステップと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストするステップと、

前記テストするステップに基づいて前記平らな表面の境界を構築するステップと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築するステップと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築するステップと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築するステップと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類するステップであって、

線分を前記サポートマップに射影するステップと、

前記線分を前記遮蔽マップに射影するステップと、

前記射影された線分が前記平らなオブジェクトの真の端と一致するかどうかを判定するステップと

を含む、ステップと

を含む、方法。 - 前記平らなオブジェクトが、前記物理的シーン内のテーブルトップである、請求項1〜3のいずれか一項に記載の方法。

- 前記デプス画像が、RGBデプスカメラを用いて取得される、請求項1〜3のいずれか一項に記載の方法。

- 平らなオブジェクトの表現を構築するためのデバイスであって、

メモリと、

見る位置から撮影された物理的シーンのデプス画像を取得するためのカメラであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、カメラと、

1つまたは複数のプロセッサであって、

平らな表面を特定することであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、特定することと、

サポートマップを構築することであって、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、構築することと、

遮蔽マップを構築することであって、

前記平らな表面を複数のセルに区切ることと、

各セルに関して、前記見る位置から広がり、かつ前記平らな表面において前記セルを横切るのに十分なだけ大きなデプス値を有する点の数を数えることと

を含み、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストすることと、

前記テストすることに基づいて前記平らな表面の境界を構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築することと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築することと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築することと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類することと

を行うように構成される、プロセッサと

を備える、デバイス。 - 平らなオブジェクトの表現を構築するためのデバイスであって、

メモリと、

見る位置から撮影された物理的シーンのデプス画像を取得するためのカメラであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、カメラと、

1つまたは複数のプロセッサであって、

平らな表面を特定することであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、特定することと、

サポートマップを構築することであって、

前記平らな表面を複数のセルに区切ることと、

各セルに関して、前記見る位置から前記セルまで、または前記セルの上の空間の垂直なカラム内の位置まで広がるようにデプス値を有する点の数を数えることと

を含み、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、構築することと、

遮蔽マップを構築することであって、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストすることと、

前記テストすることに基づいて前記平らな表面の境界を構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築することと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築することと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築することと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類することと

を行うように構成される、プロセッサと

を備える、デバイス。 - 平らなオブジェクトの表現を構築するためのデバイスであって、

メモリと、

見る位置から撮影された物理的シーンのデプス画像を取得するためのカメラであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、カメラと、

1つまたは複数のプロセッサであって、

平らな表面を特定することであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、特定することと、

サポートマップを構築することであって、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、構築することと、

遮蔽マップを構築することであって、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストすることと、

前記テストすることに基づいて前記平らな表面の境界を構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築することと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築することと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築することと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類することであって、

線分を前記サポートマップに射影することと、

前記線分を前記遮蔽マップに射影することと、

前記射影された線分が前記平らなオブジェクトの真の端と一致するかどうかを判定することと

を含む、分類することと

を行うように構成される、プロセッサと

を備える、デバイス。 - 前記平らなオブジェクトが、前記物理的シーン内のテーブルトップである、請求項6〜8のいずれか一項に記載のデバイス。

- 前記カメラが、RGBデプスカメラである、請求項6〜8のいずれか一項に記載のデバイス。

- 実行されるときに、デバイスに含まれる1つまたは複数のコンピューティングデバイスに、

見る位置から撮影された物理的シーンのデプス画像を取得することであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、取得することと、

平らな表面を特定することであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、特定することと、

サポートマップを構築することであって、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、構築することと、

遮蔽マップを構築することであって、

前記平らな表面を複数のセルに区切ることと、

各セルに関して、前記見る位置から広がり、かつ前記平らな表面において前記セルを横切るのに十分なだけ大きなデプス値を有する点の数を数えることと

を含み、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストすることと、

前記テストすることに基づいて前記平らな表面の境界を構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築することと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築することと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築することと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類することと

を行わせる、平らなオブジェクトの表現を構築するためのコンピュータが実行可能な命令を記憶する、1つまたは複数の非一時的コンピュータ可読記録媒体。 - 実行されるときに、デバイスに含まれる1つまたは複数のコンピューティングデバイスに、

見る位置から撮影された物理的シーンのデプス画像を取得することであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、取得することと、

平らな表面を特定することであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、特定することと、

サポートマップを構築することであって、

前記平らな表面を複数のセルに区切ることと、

各セルに関して、前記見る位置から前記セルまで、または前記セルの上の空間の垂直なカラム内の位置まで広がるようにデプス値を有する点の数を数えることと

を含み、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、構築することと、

遮蔽マップを構築することであって、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストすることと、

前記テストすることに基づいて前記平らな表面の境界を構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築することと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築することと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築することと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類することと

を行わせる、平らなオブジェクトの表現を構築するためのコンピュータが実行可能な命令を記憶する、1つまたは複数の非一時的コンピュータ可読記録媒体。 - 実行されるときに、デバイスに含まれる1つまたは複数のコンピューティングデバイスに、

見る位置から撮影された物理的シーンのデプス画像を取得することであって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、取得することと、

平らな表面を特定することであって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、特定することと、

サポートマップを構築することであって、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、構築することと、

遮蔽マップを構築することであって、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストすることと、

前記テストすることに基づいて前記平らな表面の境界を構築することと、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築することと、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築することと、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築することと、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類することであって

線分を前記サポートマップに射影することと、

前記線分を前記遮蔽マップに射影することと、

前記射影された線分が前記平らなオブジェクトの真の端と一致するかどうかを判定することと

を含む、分類することと

を行わせる、平らなオブジェクトの表現を構築するためのコンピュータが実行可能な命令を記憶する、1つまたは複数の非一時的コンピュータ可読記録媒体。 - 前記平らなオブジェクトが、前記物理的シーン内のテーブルトップである、請求項11〜13のいずれか一項に記載の非一時的コンピュータ可読記録媒体。

- 前記デプス画像が、RGBデプスカメラを用いて取得される、請求項11〜13のいずれか一項に記載の非一時的コンピュータ可読記録媒体。

- 平らなオブジェクトの表現を構築するための装置であって、

見る位置から撮影された物理的シーンのデプス画像を取得するための手段であって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、手段と、

平らな表面を特定するための手段であって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、手段と、

サポートマップを構築するための手段であって、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、手段と、

遮蔽マップを構築するための手段であって、

前記平らな表面を複数のセルに区切るための手段と、

各セルに関して、前記見る位置から広がり、かつ前記平らな表面において前記セルを横切るのに十分なだけ大きなデプス値を有する点の数を数えるための手段と

を含み、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、手段と、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストするための手段と、

前記テストすることに基づいて前記平らな表面の境界を構築するための手段と、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築するための手段と、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築するための手段と、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築するための手段と、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類するための手段と

を含む、装置。 - 平らなオブジェクトの表現を構築するための装置であって、

見る位置から撮影された物理的シーンのデプス画像を取得するための手段であって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、手段と、

平らな表面を特定するための手段であって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、手段と、

サポートマップを構築するための手段であって、

前記平らな表面を複数のセルに区切るための手段と、

各セルに関して、前記見る位置から前記セルまで、または前記セルの上の空間の垂直なカラム内の位置まで広がるようにデプス値を有する点の数を数えるための手段と

を含み、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、手段と、

遮蔽マップを構築するための手段であって、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、手段と、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストするための手段と、

前記テストすることに基づいて前記平らな表面の境界を構築するための手段と、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築するための手段と、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築するための手段と、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築するための手段と、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類するための手段と

を含む、装置。 - 平らなオブジェクトの表現を構築するための装置であって、

見る位置から撮影された物理的シーンのデプス画像を取得するための手段であって、前記デプス画像が、複数のデプス値を含むとともに、前記物理的シーン内の複数の点に対応し、各デプス値が、前記見る位置から前記物理的シーン内の前記複数の点のうちの1つまでの距離を示す、手段と、

平らな表面を特定するための手段であって、前記平らなオブジェクトが前記平らな表面に沿って位置付けられると推定される、手段と、

サポートマップを構築するための手段であって、前記サポートマップが、前記平らなオブジェクトによって占められる前記平らな表面の部分および前記平らなオブジェクトの上に載っているオブジェクトのあり得る表面を示す、手段と、

遮蔽マップを構築するための手段であって、前記遮蔽マップが、前記平らなオブジェクトがない前記平らな表面の部分を示す、手段と、

前記遮蔽マップおよび前記サポートマップを用いて前記平らな表面の境界をテストするための手段と、

前記テストすることに基づいて前記平らな表面の境界を構築するための手段と、

前記遮蔽マップおよび前記サポートマップを用いて前記平らなオブジェクトの少なくとも1つの境界の表現を構築するための手段と、

前記遮蔽マップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいて遮蔽傾きマップを構築するための手段と、

前記サポートマップおよび前記平らなオブジェクトの前記少なくとも1つの境界に基づいてサポート傾きマップを構築するための手段と、

前記遮蔽傾きマップおよび前記サポート傾きマップに基づいて前記平らなオブジェクトの境界に関連するセグメントを分類するための手段であって、

線分を前記サポートマップに射影するための手段と、

前記線分を前記遮蔽マップに射影するための手段と、

前記射影された線分が前記平らなオブジェクトの真の端と一致するかどうかを判定するための手段と

を含む、手段と

を含む、装置。 - 前記平らなオブジェクトが、前記物理的シーン内のテーブルトップである、請求項16〜18のいずれか一項に記載の装置。

- 前記デプス画像が、RGBデプスカメラを用いて取得される、請求項16〜18のいずれか一項に記載の装置。

Applications Claiming Priority (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US201361872436P | 2013-08-30 | 2013-08-30 | |

| US61/872,436 | 2013-08-30 | ||

| US14/268,721 US9514574B2 (en) | 2013-08-30 | 2014-05-02 | System and method for determining the extent of a plane in an augmented reality environment |

| US14/268,721 | 2014-05-02 | ||

| PCT/US2014/051955 WO2015031139A1 (en) | 2013-08-30 | 2014-08-20 | System and method for determining the extent of a plane in an augmented reality environment |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2016534466A JP2016534466A (ja) | 2016-11-04 |

| JP2016534466A5 JP2016534466A5 (ja) | 2017-03-16 |

| JP6203406B2 true JP6203406B2 (ja) | 2017-09-27 |

Family

ID=52582548

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016538974A Active JP6203406B2 (ja) | 2013-08-30 | 2014-08-20 | 拡張現実環境内の平面の広がりを判定するためのシステムおよび方法 |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US9514574B2 (ja) |

| EP (1) | EP3039655B1 (ja) |

| JP (1) | JP6203406B2 (ja) |

| KR (1) | KR20160048901A (ja) |

| CN (1) | CN105493154B (ja) |

| WO (1) | WO2015031139A1 (ja) |

Families Citing this family (28)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9304582B1 (en) * | 2013-12-19 | 2016-04-05 | Amazon Technologies, Inc. | Object-based color detection and correction |

| WO2016079960A1 (en) * | 2014-11-18 | 2016-05-26 | Seiko Epson Corporation | Image processing apparatus, control method for image processing apparatus, and computer program |

| JP2017007033A (ja) * | 2015-06-22 | 2017-01-12 | シャープ株式会社 | ロボット |

| JP6602096B2 (ja) * | 2015-08-18 | 2019-11-06 | 株式会社明和eテック | 欠陥検出装置 |

| US10088736B2 (en) * | 2015-09-24 | 2018-10-02 | Amazon Technologies, Inc. | Unmanned aerial vehicle descent |

| KR102337931B1 (ko) | 2016-06-27 | 2021-12-13 | 로베르트 보쉬 게엠베하 | 동적 가림 핸들링을 위한 시스템들 및 방법들 |

| US10565786B1 (en) * | 2016-06-30 | 2020-02-18 | Google Llc | Sensor placement interface |

| KR102246841B1 (ko) * | 2016-10-05 | 2021-05-03 | 매직 립, 인코포레이티드 | 표면 모델링 시스템들 및 방법들 |

| CN108629800A (zh) * | 2017-03-20 | 2018-10-09 | 北京三星通信技术研究有限公司 | 平面确定方法及增强现实显示信息的显示方法、相应装置 |

| DK180470B1 (en) | 2017-08-31 | 2021-05-06 | Apple Inc | Systems, procedures, and graphical user interfaces for interacting with augmented and virtual reality environments |

| US10402646B2 (en) | 2017-09-21 | 2019-09-03 | Amazon Technologies, Inc. | Object detection and avoidance for aerial vehicles |

| EP3468182A1 (en) * | 2017-10-06 | 2019-04-10 | InterDigital VC Holdings, Inc. | A method and apparatus for encoding a point cloud representing three-dimensional objects |

| KR102509823B1 (ko) * | 2017-12-27 | 2023-03-14 | 삼성전자주식회사 | 그리드 기반의 평면 추정 방법 및 장치 |

| DK180842B1 (en) | 2018-01-24 | 2022-05-12 | Apple Inc | Devices, procedures, and graphical user interfaces for System-Wide behavior for 3D models |

| US11126257B2 (en) * | 2018-04-17 | 2021-09-21 | Toyota Research Institute, Inc. | System and method for detecting human gaze and gesture in unconstrained environments |

| KR102540546B1 (ko) | 2018-08-23 | 2023-06-05 | 현대자동차주식회사 | 가솔린 egr 시스템의 밸브개방 제어장치 및 방법 |

| CN109472873B (zh) * | 2018-11-02 | 2023-09-19 | 北京微播视界科技有限公司 | 三维模型的生成方法、装置、硬件装置 |

| CN110070600B (zh) * | 2018-11-02 | 2023-09-15 | 北京微播视界科技有限公司 | 三维模型的生成方法、装置、硬件装置 |

| CN113168820A (zh) | 2018-12-13 | 2021-07-23 | 麦克赛尔株式会社 | 显示终端、显示控制系统以及显示控制方法 |

| JP2020148712A (ja) * | 2019-03-15 | 2020-09-17 | 東芝インフォメーションシステムズ株式会社 | 測距システム、測距装置及び配置方法 |

| US11030474B1 (en) * | 2019-05-28 | 2021-06-08 | Apple Inc. | Planar region boundaries based on intersection |

| JP2021033572A (ja) * | 2019-08-22 | 2021-03-01 | 株式会社豊田自動織機 | 画像データ収集装置及び画像データ仕分け方法 |

| US20220335649A1 (en) * | 2019-10-30 | 2022-10-20 | Hewlett-Packard Development Company, L.P. | Camera pose determinations with depth |

| JP7366797B2 (ja) | 2020-02-19 | 2023-10-23 | 株式会社Ihiインフラシステム | コンクリート床版の平坦度計測装置 |

| KR20210157601A (ko) | 2020-06-22 | 2021-12-29 | 현대자동차주식회사 | 결빙 개선을 위한 lp-egr 시스템의 제어장치 및 방법 |

| CN111899293B (zh) * | 2020-09-29 | 2021-01-08 | 成都索贝数码科技股份有限公司 | Ar应用中的虚实遮挡处理方法 |

| US11960009B2 (en) * | 2020-12-30 | 2024-04-16 | Zoox, Inc. | Object contour determination |

| US11972524B2 (en) * | 2021-03-30 | 2024-04-30 | Hcl Technologies Limited | Method and system for generating tightest revolve envelope for computer-aided design (CAD) model |

Family Cites Families (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6420698B1 (en) | 1997-04-24 | 2002-07-16 | Cyra Technologies, Inc. | Integrated system for quickly and accurately imaging and modeling three-dimensional objects |

| US7509241B2 (en) | 2001-07-06 | 2009-03-24 | Sarnoff Corporation | Method and apparatus for automatically generating a site model |

| JP4162095B2 (ja) | 2003-12-11 | 2008-10-08 | ストライダー ラブス,インコーポレイテッド | 遮蔽された部分の表面を対称性の算出により見込み復元するための技術 |

| US8050491B2 (en) * | 2003-12-17 | 2011-11-01 | United Technologies Corporation | CAD modeling system and method |

| JP2006065608A (ja) * | 2004-08-27 | 2006-03-09 | Fuji Xerox Co Ltd | 3次元モデル生成装置および方法 |

| JP2006323608A (ja) * | 2005-05-18 | 2006-11-30 | Kozo Keikaku Engineering Inc | 立体構造物群モデル作成装置、立体構造物群モデル作成方法及び立体モデル作成システム |

| WO2010049850A1 (en) | 2008-10-28 | 2010-05-06 | Koninklijke Philips Electronics N.V. | Generation of occlusion data for image properties |

| US8933925B2 (en) | 2009-06-15 | 2015-01-13 | Microsoft Corporation | Piecewise planar reconstruction of three-dimensional scenes |

| KR101686169B1 (ko) * | 2010-02-09 | 2016-12-14 | 삼성전자주식회사 | 옥트리 기반의 3차원 맵 생성 장치 및 방법 |

| CN102509342A (zh) * | 2011-09-22 | 2012-06-20 | 北京航空航天大学 | 一种共享增强现实场景中协同式虚实遮挡处理方法 |

| US9092657B2 (en) * | 2013-03-13 | 2015-07-28 | Microsoft Technology Licensing, Llc | Depth image processing |

-

2014

- 2014-05-02 US US14/268,721 patent/US9514574B2/en active Active

- 2014-08-20 WO PCT/US2014/051955 patent/WO2015031139A1/en active Application Filing

- 2014-08-20 KR KR1020167008050A patent/KR20160048901A/ko active Search and Examination

- 2014-08-20 EP EP14766026.0A patent/EP3039655B1/en active Active

- 2014-08-20 JP JP2016538974A patent/JP6203406B2/ja active Active

- 2014-08-20 CN CN201480046887.6A patent/CN105493154B/zh not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| CN105493154A (zh) | 2016-04-13 |

| JP2016534466A (ja) | 2016-11-04 |

| CN105493154B (zh) | 2019-05-31 |

| WO2015031139A1 (en) | 2015-03-05 |

| EP3039655A1 (en) | 2016-07-06 |

| EP3039655B1 (en) | 2020-04-29 |

| US9514574B2 (en) | 2016-12-06 |

| US20150062117A1 (en) | 2015-03-05 |

| KR20160048901A (ko) | 2016-05-04 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6203406B2 (ja) | 拡張現実環境内の平面の広がりを判定するためのシステムおよび方法 | |

| US10083540B2 (en) | Virtual light in augmented reality | |

| KR102529120B1 (ko) | 영상을 획득하는 방법, 디바이스 및 기록매체 | |

| JP6423435B2 (ja) | 物理的光景を表すための方法および装置 | |

| US10789776B2 (en) | Structural modeling using depth sensors | |

| KR101227255B1 (ko) | 마커 크기 기반 인터렉션 방법 및 이를 구현하기 위한 증강 현실 시스템 | |

| JP2018507476A (ja) | コンピュータビジョンに関する遮蔽処理 | |

| EP3629302B1 (en) | Information processing apparatus, information processing method, and storage medium | |

| US9595125B2 (en) | Expanding a digital representation of a physical plane | |

| KR20160027862A (ko) | 이미지 데이터를 처리하는 방법과 이를 지원하는 전자 장치 | |

| US11562545B2 (en) | Method and device for providing augmented reality, and computer program | |

| KR102561274B1 (ko) | 디스플레이 장치 및 디스플레이 장치의 제어 방법 | |

| CN110286906B (zh) | 用户界面显示方法、装置、存储介质与移动终端 | |

| KR101308184B1 (ko) | 윈도우 형태의 증강현실을 제공하는 장치 및 방법 | |

| CN113178017A (zh) | Ar数据展示方法、装置、电子设备及存储介质 | |

| JP2017016166A (ja) | 画像処理装置及び画像処理方法 | |

| JP7107015B2 (ja) | 点群処理装置、点群処理方法およびプログラム | |

| CN109710054B (zh) | 用于头戴式显示设备的虚拟物体呈现方法和装置 | |

| KR101939530B1 (ko) | 지형정보 인식을 기반으로 증강현실 오브젝트를 표시하는 방법 및 그 장치 | |

| KR20130015617A (ko) | 포즈 예측 방법과 장치 그리고 증강 현실 시스템 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170206 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20170206 |

|

| A871 | Explanation of circumstances concerning accelerated examination |

Free format text: JAPANESE INTERMEDIATE CODE: A871 Effective date: 20170206 |

|

| A975 | Report on accelerated examination |

Free format text: JAPANESE INTERMEDIATE CODE: A971005 Effective date: 20170331 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20170406 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20170424 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170721 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20170731 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20170829 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6203406 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |