JP6066712B2 - 記録装置、記録方法およびプログラム - Google Patents

記録装置、記録方法およびプログラム Download PDFInfo

- Publication number

- JP6066712B2 JP6066712B2 JP2012276875A JP2012276875A JP6066712B2 JP 6066712 B2 JP6066712 B2 JP 6066712B2 JP 2012276875 A JP2012276875 A JP 2012276875A JP 2012276875 A JP2012276875 A JP 2012276875A JP 6066712 B2 JP6066712 B2 JP 6066712B2

- Authority

- JP

- Japan

- Prior art keywords

- moving image

- recording

- audio data

- data

- audio

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N9/00—Details of colour television systems

- H04N9/79—Processing of colour television signals in connection with recording

- H04N9/80—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback

- H04N9/804—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback involving pulse code modulation of the colour picture signal components

- H04N9/8042—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback involving pulse code modulation of the colour picture signal components involving data reduction

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N5/00—Details of television systems

- H04N5/76—Television signal recording

- H04N5/765—Interface circuits between an apparatus for recording and another apparatus

- H04N5/77—Interface circuits between an apparatus for recording and another apparatus between a recording apparatus and a television camera

- H04N5/772—Interface circuits between an apparatus for recording and another apparatus between a recording apparatus and a television camera the recording apparatus and the television camera being placed in the same enclosure

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N9/00—Details of colour television systems

- H04N9/79—Processing of colour television signals in connection with recording

- H04N9/80—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback

- H04N9/804—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback involving pulse code modulation of the colour picture signal components

- H04N9/806—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback involving pulse code modulation of the colour picture signal components with processing of the sound signal

- H04N9/8063—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback involving pulse code modulation of the colour picture signal components with processing of the sound signal using time division multiplex of the PCM audio and PCM video signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N9/00—Details of colour television systems

- H04N9/79—Processing of colour television signals in connection with recording

- H04N9/80—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback

- H04N9/82—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback the individual colour picture signal components being recorded simultaneously only

- H04N9/8205—Transformation of the television signal for recording, e.g. modulation, frequency changing; Inverse transformation for playback the individual colour picture signal components being recorded simultaneously only involving the multiplexing of an additional signal and the colour video signal

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Signal Processing For Digital Recording And Reproducing (AREA)

- Television Signal Processing For Recording (AREA)

Description

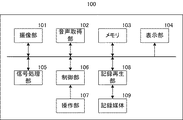

図1において、撮像部101は、公知の撮像素子やAD変換器などを備える動画取得部として機能し、被写体を撮影して動画データを出力する。音声取得部102は、マイクロフォンやAD変換器などを備え、被写体の周辺の音声を取得し、音声データを出力する。

更に、同時記録モードにより記録された動画データを、n秒単位で一部を削除する編集処理を行った結果、編集後の動画ファイルを再生した際に、この追加音声を再生させるようにすることで、対応する動画よりも音声の方が先に再生されるのを防ぐようにする。

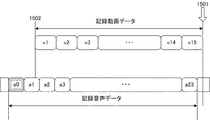

御部106は、記録再生部108に対し、符号化された動画データと音声データとを、記録媒体109に既に記録されている同時記録モードの動画ファイルに追記するように指示する。記録再生部108は、指定された動画ファイルに対し、メモリ103に記憶された動画データと音声データとを追加して記録する(S1407)。

次に、制御部106は、同時記録モードで記録された動画ファイルが既に記録媒体109に記録されていた場合、この動画ファイルを先頭から再生した場合の、動画データと音声データの終端部における動画と音声の時間差を検出する(S1408)。終端部分(再生終了位置)の時間差は以下のように求められる。

ビデオトラックの再生終了時間=ビデオ再生開始タイミング(edts)+ビデオサンプルの再生時間(stsc)×ビデオサンプル数(stsz)

音声トラックの再生終了時間=音声再生開始タイミング(edts)+音声サンプルの再生時間(stsc)×音声サンプル数(stsz)

このように、ファイルの先頭から再生した場合の、終端部分の動画と音声の時間差が求められる。

更に、本実施形態では、同時記録モードでの1回の記録が終了する毎に、この1回の記録により記録される動画データと音声データの先頭と終端部それぞれにおける動画と音声の時間差を検出し、付加情報としてmoovに格納する。以下、1回の記録により記録される動画と音声を1シーンと呼ぶ。本実施形態では、各シーンについて、先頭と終端部分それぞれについての時間差の情報がmoovに格納される。この際、追加音声と動画の先頭との時間差ではなく、追加音声の次のAAUと動画の先頭との時間差が、先頭部分の時間差として記録される。

本実施形態では、時間差を示す情報として、所定の周波数のクロックのカウント値を記録する。例えば、MPEG符号化では、決められた周波数のクロックをカウントするカウンタのカウント値に基づき、復号タイミングや、復号された画像、音声の出力タイミングが管理される。そこで、この復号のための所定周波数のクロックのカウント値が時間差の情報として記録される。なお、これ以外にも、動画と音声の時間差を示す情報であれば、他の形式でもよい。

一方、終端部分の時間差が、1AAUの再生時間よりも大きい場合、制御部106は、追加して記録する音声データの先頭AAUのオフセット情報を音声トラックに格納する。このように、新たに記録された動画データと音声データの情報がmoovに追加される。更に、制御部106は、今回記録したシーンについて、先頭部分と終端部分の動画と音声の時間差の情報を付加情報としてmoovに格納する。

制御部106は、以上のように部分削除の処理を実行した後、削除部分以降の各シーンについて、動画ファイルを先頭から再生した場合の、動画データと音声データの各シーンにおける終端部分の時間差を前述の様に算出する。

そして、終端部分の時間差が1AAUの再生時間を超える場合、制御部106は、その次のシーンの先頭のAAUである追加音声を再生させるように、先頭のAAUのオフセットをmoovに追加する。

なお、追記モードにおいて、ユーザが記録開始と停止を指示する構成とし、ユーザによる記録開始から記録停止の指示までの動画と音声を記録するようにしてもよい。また、追記モードにおいて、記録媒体109に記録済みの動画ファイルの中から、ユーザが選択した動画ファイルに対して動画と音声を追記する構成としてもよい。また、追記モードが設定される直前に記録された動画ファイルを選択する等、その他の構成とすることも可能である。

前述した本発明の実施形態における記録装置を構成する各手段、並びに記録方法の各工程は、コンピュータのRAMやROMなどに記憶されたプログラムが動作することによって実現できる。このプログラム及び前記プログラムを記憶したコンピュータ読み取り可能な記憶媒体は本発明に含まれる。

Claims (12)

- 動画データを取得する動画取得手段と、

音声データを取得する音声取得手段と、

第1の期間に対応した動画サンプルを符号化単位として前記取得された動画データを符号化し、第2の期間に対応した音声サンプルを符号化単位として前記取得された音声データを符号化する符号化手段と、

前記符号化手段により符号化された動画データと音声データとを動画ファイルに格納して記録媒体に記録する記録手段と、

前記取得された動画データの記録開始位置に基づいて、前記取得された音声データの記録開始位置を決定する制御手段とを備え、

前記制御手段は、前記取得された動画データの記録開始位置よりも、少なくとも前記第2の期間に対応した音声サンプルだけ前の位置を前記取得された音声データの記録開始位置として決定し、前記記録された音声データの再生開始位置を、前記記録された音声データの先頭から前記音声データの符号化単位だけ後の位置と決定することを特徴とする記録装置。 - 前記記録手段は、記録指示に応じて新たな動画ファイルを生成して記録し、前記制御手段は、前記取得された音声データの記録開始位置を、前記取得された動画データの記録開始位置よりも前記第2の期間に対応した音声サンプルだけ前の位置と決定することを特徴とする請求項1に記載の記録装置。

- 前記記録手段は、前記記録媒体に既に記録されている所定の動画ファイルに対し、記録指示に応じて前記記録媒体に記録された動画データと音声データとを追加し、前記制御手段は、前記所定の動画ファイルにおける動画データの再生終了位置と音声データの再生終了位置との時間差だけ前の位置を、前記取得した音声データの記録開始位置と決定することを特徴とする請求項1に記載の記録装置。

- 前記制御手段は、前記時間差が前記第2の期間よりも大きいか否かを判別し、前記時間差が前記第2の期間より小さい場合、前記記録された音声データの再生開始位置を、前記記録された音声データの先頭から前記音声データの符号化単位だけ後の位置とし、前記時間差が前記第2の期間よりも大きい場合、前記記録された音声データの先頭を再生開始位置とすることを特徴とする請求項3に記載の記録装置。

- 前記符号化手段により符号化された動画データと音声データとを記憶するメモリを備え、

前記符号化手段は、記録待機状態において、前記動画取得手段により取得された動画データと前記音声取得手段により取得された音声データとを順次符号化しながら、少なくとも所定期間の前記符号化した動画データと前記符号化した音声データとを前記メモリに記憶し、

前記記録手段は、前記記録待機状態における記録指示に応じて、前記メモリに記憶された、前記所定期間の符号化された動画データと、前記所定期間の符号化された動画データに対応した期間の符号化された音声データとを、前記記録媒体に記録し、前記記録指示に応じて記録した動画データと音声データとを、前記記録媒体に既に記録されている所定の動画ファイルに対して追加し、

前記制御手段は、前記記録指示に応じた前記動画サンプルから前記所定期間だけ前の動画サンプルに対応した音声サンプルを含む前記音声データの符号化単位の一つ前の符号化単位の先頭の音声サンプルを、前記音声データの記録開始位置とすることを特徴とする請求項1に記載の記録装置。 - 前記制御手段は、前記所定の動画ファイルの動画データの再生終了位置と音声データの再生終了位置との時間差が、前記第2の期間よりも大きいか否かを判別し、前記時間差が前記第2の期間以下である場合、前記記録指示に応じて記録された音声データの再生開始位置を、前記記録指示に応じて記録された音声データの先頭から前記音声データの符号化単位だけ後の位置とし、前記時間差が前記第2の期間よりも大きい場合、前記記録指示に応じて記録された音声データの先頭を再生開始位置とすることを特徴とする請求項5に記載の記録装置。

- 前記制御手段は、前記取得された動画データの記録開始位置を前記記録指示に応じて決定し、前記記録指示があるまで前記符号化手段を制御して、前記符号化された音声データの少なくとも前記第2の期間より長い第3の期間に対応した音声サンプルを前記メモリに繰り返し記憶することを特徴とする請求項5に記載の記録装置。

- 前記制御手段は、前記符号化された音声データの再生開始位置を示す管理情報を生成して前記記録手段が記録する前記動画ファイルに格納するとともに、前記取得された動画データの記録開始位置を前記符号化された動画データの再生開始位置とする管理情報を生成して前記動画ファイルに格納することを特徴とする請求項1に記載の記録装置。

- 前記制御手段は、前記記録媒体に記録されている一つの動画ファイルに格納された符号化された動画データおよび音声データに、前記記録媒体に記録されている他の動画ファイルに格納された符号化された動画データおよび音声データを結合したときは、前記他の動画ファイルの符号化された音声データの再生開始位置を、前記一つの動画ファイルの符号化された動画データの再生終了位置と前記一つの動画ファイルの符号化された音声データに結合された前記他の動画ファイルの音声データの再生開始位置との時間差に従って変更することを特徴とする請求項8に記載の記録装置。

- 前記制御手段は、結合された複数の符号化された動画データと音声データから一つの符号化された動画データと音声データを削除して、前記削除した符号化された動画データと音声データの直前と直後の符号化された動画データと音声データをそれぞれ結合する時は、前記削除した符号化された動画データおよび音声データの直前の符号化された動画データと音声データの再生終了位置の時間差と前記削除した符号化された動画データおよび音声データの直後の符号化された動画データと音声データの再生終了位置の時間差とに従って、前記直前の符号化された音声データに結合された前記直後の符号化された音声データの再生開始位置を変更することを特徴とする請求項8又は9に記載の記録装置。

- 前記動画取得手段は、撮像手段を含むことを特徴とする請求項1から10のいずれか一項に記載の記録装置。

- 動画データを取得するステップと、

音声データを取得するステップと、

第1の期間に対応した動画サンプルを符号化単位として前記取得された動画データを符号化し、第2の期間に対応した音声サンプルを符号化単位として前記取得された音声データを符号化するステップと、

前記符号化された動画データと音声データとを動画ファイルに格納して記録媒体に記録するステップと、

前記取得された動画データの記録開始位置に基づいて、前記取得された音声データの記録開始位置を決定するステップとを備え、

前記決定するステップは、前記取得された動画データの記録開始位置よりも、少なくとも前記第2の期間に対応した音声サンプルだけ前の位置を前記取得された音声データの記録開始位置として決定し、前記記録された音声データの再生開始位置を、前記記録された音声データの先頭から前記音声データの符号化単位だけ後の位置と決定することを特徴とする記録方法。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012276875A JP6066712B2 (ja) | 2012-12-19 | 2012-12-19 | 記録装置、記録方法およびプログラム |

| US14/106,023 US9025931B2 (en) | 2012-12-19 | 2013-12-13 | Recording apparatus, recording method, and program |

| CN201310706201.9A CN103888662B (zh) | 2012-12-19 | 2013-12-19 | 记录设备和记录方法 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012276875A JP6066712B2 (ja) | 2012-12-19 | 2012-12-19 | 記録装置、記録方法およびプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2014121049A JP2014121049A (ja) | 2014-06-30 |

| JP2014121049A5 JP2014121049A5 (ja) | 2016-02-12 |

| JP6066712B2 true JP6066712B2 (ja) | 2017-01-25 |

Family

ID=50930986

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2012276875A Active JP6066712B2 (ja) | 2012-12-19 | 2012-12-19 | 記録装置、記録方法およびプログラム |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US9025931B2 (ja) |

| JP (1) | JP6066712B2 (ja) |

| CN (1) | CN103888662B (ja) |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6745629B2 (ja) * | 2016-04-01 | 2020-08-26 | キヤノン株式会社 | 情報処理装置およびその制御方法 |

| CN108664534A (zh) * | 2017-04-02 | 2018-10-16 | 田雪松 | 应用服务数据的获取方法及系统 |

Family Cites Families (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP2261916A3 (en) * | 1998-02-23 | 2011-03-09 | Kabushiki Kaisha Toshiba | Information storage medium, information playback method and apparatus and information recording method |

| JP2000078531A (ja) * | 1998-04-28 | 2000-03-14 | Hitachi Ltd | オ―ディオデ―タ編集方法、編集システム |

| JP3224371B2 (ja) * | 1998-11-30 | 2001-10-29 | 松下電器産業株式会社 | 符号化av信号の同期方法 |

| US7274862B2 (en) * | 2001-09-27 | 2007-09-25 | Sony Corporation | Information processing apparatus |

| JP2004248104A (ja) * | 2003-02-14 | 2004-09-02 | Sony Corp | 情報処理装置及び情報処理方法 |

| JP3675465B2 (ja) * | 2003-10-29 | 2005-07-27 | ソニー株式会社 | 符号化制御装置および符号化システム |

| JP5059301B2 (ja) * | 2005-06-02 | 2012-10-24 | ルネサスエレクトロニクス株式会社 | 同期再生装置および同期再生方法 |

| JP4227604B2 (ja) * | 2005-07-25 | 2009-02-18 | シャープ株式会社 | 動画像再生装置及び記録媒体 |

| JP4501854B2 (ja) * | 2005-12-22 | 2010-07-14 | 株式会社日立製作所 | 映像音声記録装置 |

| JP4838191B2 (ja) | 2007-05-08 | 2011-12-14 | シャープ株式会社 | ファイル再生装置、ファイル再生方法、ファイル再生を実行させるプログラム及びそのプログラムを記録した記録媒体 |

| US20130188922A1 (en) * | 2012-01-23 | 2013-07-25 | Research In Motion Limited | Multimedia File Support for Media Capture Device Position and Location Timed Metadata |

-

2012

- 2012-12-19 JP JP2012276875A patent/JP6066712B2/ja active Active

-

2013

- 2013-12-13 US US14/106,023 patent/US9025931B2/en active Active

- 2013-12-19 CN CN201310706201.9A patent/CN103888662B/zh not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| US20140169753A1 (en) | 2014-06-19 |

| CN103888662B (zh) | 2017-04-12 |

| JP2014121049A (ja) | 2014-06-30 |

| US9025931B2 (en) | 2015-05-05 |

| CN103888662A (zh) | 2014-06-25 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6066712B2 (ja) | 記録装置、記録方法およびプログラム | |

| JP2012156587A (ja) | 動画記録装置 | |

| JP5917123B2 (ja) | 記録装置 | |

| JP5713701B2 (ja) | 動画記録装置 | |

| JP6112852B2 (ja) | 記録装置、記録方法およびプログラム | |

| JP4883797B2 (ja) | 記録装置 | |

| JP5848594B2 (ja) | 記録装置 | |

| JP6049410B2 (ja) | 画像処理装置および画像処理方法 | |

| JP2014045353A (ja) | 画像処理装置 | |

| JP4385987B2 (ja) | 映像処理装置,映像処理方法,およびコンピュータプログラム | |

| JP2004220679A (ja) | 再生装置 | |

| KR20080095382A (ko) | 동영상 파일 목록 편집 방법 | |

| JP2015099995A (ja) | 記録装置及び記録装置の制御方法 | |

| JP4724551B2 (ja) | 動画像処理装置及び動画像処理方法 | |

| JP2014075730A (ja) | 画像処理装置、画像処理方法、プログラム | |

| JP2009105477A (ja) | 再生装置及び再生方法 | |

| JP5889459B2 (ja) | 記録装置 | |

| JP5511739B2 (ja) | 記録装置及び記録方法 | |

| JP2015046948A (ja) | 画像処理装置 | |

| JP2014096194A (ja) | 記録装置及び記録方法 | |

| JP2013240111A (ja) | データ処理装置、方法および制御プログラム | |

| JP2008028948A (ja) | 画像処理装置及び画像処理方法 | |

| JP2014022868A (ja) | 画像処理装置 | |

| JP2014060498A (ja) | 画像処理装置、画像処理方法、プログラム | |

| JP2011124851A (ja) | 信号処理装置 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20151221 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20151221 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20161116 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20161122 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20161220 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 6066712 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |