JP4985201B2 - 電子機器、動きベクトル検出方法及びプログラム - Google Patents

電子機器、動きベクトル検出方法及びプログラム Download PDFInfo

- Publication number

- JP4985201B2 JP4985201B2 JP2007205755A JP2007205755A JP4985201B2 JP 4985201 B2 JP4985201 B2 JP 4985201B2 JP 2007205755 A JP2007205755 A JP 2007205755A JP 2007205755 A JP2007205755 A JP 2007205755A JP 4985201 B2 JP4985201 B2 JP 4985201B2

- Authority

- JP

- Japan

- Prior art keywords

- block

- motion vector

- frame

- detection

- frame image

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/102—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or selection affected or controlled by the adaptive coding

- H04N19/103—Selection of coding mode or of prediction mode

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/134—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or criterion affecting or controlling the adaptive coding

- H04N19/142—Detection of scene cut or scene change

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/169—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding

- H04N19/17—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding the unit being an image region, e.g. an object

- H04N19/176—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding the unit being an image region, e.g. an object the region being a block, e.g. a macroblock

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/50—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding

- H04N19/503—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding involving temporal prediction

- H04N19/51—Motion estimation or motion compensation

- H04N19/55—Motion estimation with spatial constraints, e.g. at image or region borders

Description

同図に示すように、記録再生装置100は、CPU(Central Processing Unit)1、RAM(Random Access Memory)2、操作入力部3、映像特徴検出部4、デジタルチューナ5、IEEE1394インタフェース6、Ethernet(登録商標)/無線LAN(Local Area Network)インタフェース7、USB(Universal Serial Bus)インタフェース8、メモリカードインタフェース9、HDD10、光ディスクドライブ11、バッファコントローラ13、セレクタ14、デマルチプレクサ15、AV(Audio/Video)デコーダ16、OSD(On Screen Display)17、映像D/A(Digital/Analog)コンバータ18及び音声D/Aコンバータ19を有している。

同図(a)は左パンを示しており、この場合、映像中の物体は右方向へ移動する。

同図(b)は右パンを示しており、この場合、映像中の物体は左方向へ移動する。

同図(c)は下チルトを示しており、この場合、映像中の物体は上方向へ移動する。

同図(d)は上チルトを示しており、この場合、映像中の物体は下方向へ移動する。

同図(e)はズームインを示しており、この場合、映像中の物体は拡大する。

同図(f)はズームアウトを示しており、この場合、映像中の物体は縮小する。

映像コンテンツからカメラ動作系特徴を検出するには、映像コンテンツ中からブロックマッチングにより動きベクトルを検出する必要がある。しかし、上記図4に示すように、ズーム動作では、パン動作やチルト動作に比べて、動作中の画像の移動量が小さいため、その検出レベルも小さいと考えられる。したがって、従来のように1つのブロックによりブロックマッチングを行うと、ズームを検出できずに誤検出が発生する可能性がある。そこで、本実施形態においては、複数のブロックを組み合わせてブロックマッチングを行うことを考える。

同図に示すように、映像特徴検出部4は、画像処理部21、1フレーム間メモリ部22、10フレーム間メモリ部23、20フレーム間メモリ部24、30フレーム間メモリ部25、これらメモリ部毎のマッチング処理部26、28、30及び32、フェード/カット処理部27、29、31及び33、動きベクトル処理部34、カメラ特徴判定部36、フェード/カット判定部35及びシーンID処理部37を有する。

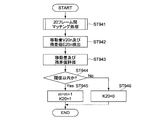

同図に示すように、まず、映像特徴検出部4は、各映像特徴の検出フラグの初期設定を行う(ステップ41)。検出フラグとは、映像コンテンツ中から、上記パン、チルト、ズーム及び手振れの各カメラ動作系特徴と、フェード及びカットの各映像編集系特徴とがそれぞれ検出されたことを示すフラグである。各映像特徴の検出フラグは、それぞれDpan、Dtilt、Dzoom、Dbure、Dfade及びDcutで表され、それぞれのフラグ値を0にすることで各初期設定が行われる。

同図に示すように、マッチング処理部26は、元画像(S)である基準フレーム71内に、動きベクトルの探索範囲を規定する探索領域72を設定し、当該探索領域72の内部に、動きベクトルの検出対象範囲として参照画像領域73を設定する。

Pn1(xn-an, Fn(xn-an))

Pn2(xn+an, Fn(xn+an))

bn1_y = (dn1_y + dn2_y + dn3_y + dn4_y) / 4

bn1_cb = (dn1_cb + dn2_cb + dn3_cb + dn4_cb) /4

bn1_cr = (dn1_cr + dn2_cr + dn3_cr + dn4_cr) / 4

|V1xn|<8、かつ、|V1yn|<8、かつ、E1n<Eth

であるか否かを判断する(ステップ923、924)。上記各値が判定基準を満たす場合には、マッチング処理部26は、便宜的な重み係数K1をK1=1とし、上記確からしい検出データの数のカウンタ値mをm=m+1とする(ステップ925)。また、上記各値が判定基準を満たさない場合には、マッチング処理部26は、K1=0とする(ステップ926)。そして、マッチング処理部26は、上記検出した移動量V1xn、V1yn及び残差値E1nと共に、上記重み係数K1及びカウンタ値mを動きベクトル処理部34へ出力する。

|V10xn|<8、かつ、|V10yn|<8、かつ、E10n<Eth

であるか否かを判断する(ステップ933、934)。上記各値が判定基準を満たす場合には、マッチング処理部28は、便宜的な重み係数K10をK10=1とし、上記確からしい検出データの数のカウンタ値mをm=m+1とする(ステップ935)。また、上記各値が判定基準を満たさない場合には、マッチング処理部28は、K10=0とする(ステップ936)。そして、マッチング処理部28は、上記検出した移動量V10xn、V10yn及び残差値E10nと共に、上記重み係数K10及びカウンタ値mを動きベクトル処理部34へ出力する。

|V20xn|<8、かつ、|V20yn|<8、かつ、E20n<Eth

であるか否かを判断する(ステップ943、944)。上記各値が判定基準を満たす場合には、マッチング処理部30は、便宜的な重み係数K20をK20=1とし、上記確からしい検出データの数のカウンタ値mをm=m+1とする(ステップ945)。また、上記各値が判定基準を満たさない場合には、マッチング処理部30は、K20=0とする(ステップ946)。そして、マッチング処理部30は、上記検出した移動量V20xn、V20yn及び残差値E20nと共に、上記重み係数K20及びカウンタ値mを動きベクトル処理部34へ出力する。

|V30xn|<8、かつ、|V30yn|<8、かつ、E30n<Eth

であるか否かを判断する(ステップ953、954)。上記各値が判定基準を満たす場合には、マッチング処理部32は、便宜的な重み係数K30をK30=1とし、上記確からしい検出データの数のカウンタ値mをm=m+1とする(ステップ955)。また、上記各値が判定基準を満たさない場合には、マッチング処理部32は、K30=0とする(ステップ956)。そして、マッチング処理部32は、上記検出した移動量V30xn、V30yn及び残差値E30nと共に、上記重み係数K30及びカウンタ値mを動きベクトル処理部34へ出力する。

この検出フレーム間隔L1tは、基準フレーム71間のpts(Presentation Time Stamp)時間間隔p0と、当該基準フレーム71から1フレーム後の探索フレーム75間のpts時間間隔p1tとの比として、次式で算出することができる。

L1t=p1t/p0

これは、映像コンテンツによって、フレームレートが異なる場合が想定できることから、上記勾配を算出する場合に、1フレーム間隔の時間をいわば正規化するためである。

よって、x方向における移動量についての勾配は、次式で求められる。

T1xn=V1xn/L1t

また、y方向における移動量についての勾配は、次式で求められる。

T1yn=V1yn/L1t

この検出フレーム間隔L10tは、基準フレーム71間のpts時間間隔p0と、当該基準フレーム71から10フレーム後の探索フレーム75間のpts時間間隔p10tとの比として、次式で算出することができる。

L10t=p10t/p0

よって、x方向における移動量についての勾配は、次式で求められる。

T10xn=V10xn/L10t

また、y方向における移動量についての勾配は、次式で求められる。

T10yn=V10yn/L10t。

この検出フレーム間隔L20tは、基準フレーム71間のpts時間間隔p0と、当該基準フレーム71から20フレーム後の探索フレーム75間のpts時間間隔p20tとの比として、次式で算出することができる。

L20t=p20t/p0

よって、x方向における移動量についての勾配は、次式で求められる。

T20xn=V20xn/L20t

また、y方向における移動量についての勾配は、次式で求められる。

T20yn=V20yn/L20t

この検出フレーム間隔L30tは、基準フレーム71間のpts時間間隔p0と、当該基準フレーム71から30フレーム後の探索フレーム75間のpts時間間隔p30tとの比として、次式で算出することができる。

L30t=p30t/p0

よって、x方向における移動量についての勾配は、次式で求められる。

T30xn=V30xn/L30t

また、y方向における移動量についての勾配は、次式で求められる。

T30yn=V30yn/L30t

Tavex(n)=(K1 T1xn + K10 T10xn + K20 T20xn + K30 T30xn) / (K1 + K10 + K20 + K30)

Tavey(n)=( K1 T1yn + K10 T10yn + K20 T20yn + K30 T30yn) / (K1 + K10 + K20 + K30)

また、(K1+K10+K20+K30)=0の場合、Tavex(n)及びTavey(n)は、それぞれ次式の通りとなる。

Tavex(n)=0

Tavey(n)=0

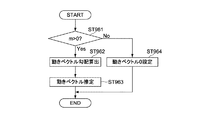

次に、動きベクトル処理部34は、上記算出した勾配平均を用いて、便宜的に40フレーム間隔における動きベクトルを推定する(ステップ963)。具体的には、動きベクトル処理部34は、上記算出した勾配平均に、フレーム間隔を乗算することで、上記図19で示した等価的な移動量を算出することができる。すなわち、40フレーム間隔における推定動きベクトル(推定移動量)は、x方向、y方向についてそれぞれ次式により求めることができる。

40×Tavex(n)

40×Tavey(n)

sinθ≒θ

cosθ≒1

Pxvari = (1/N) Σ ((Pxave −Px(n))×(Pxave −Px(n)) )

Pyvari = (1/N) Σ ((Pyave −Py(n))×(Pyave −Py(n)) )

まず、フェード/カット処理部27、29、31及び33の処理について説明する。

63

H= ΣEn

n=0

映像コンテンツは、いくつかのシーン区間により構成される。1つのシーン区間と他のシーン区間との境界は、シーンチェンジとなる。このシーンチェンジは、上記検出したフェードまたはカットによるものである。一般的には、映像コンテンツは、類似画像(フレーム)区間と、上記検出したカメラ動作系特徴を有する画像(フレーム)区間とで構成される。類似画像区間とは、上記検出したシーンIDが同一であるフレームで構成される区間である。また、稀に、類似画像区間がなく、カメラ動作系特徴区間のみで構成される映像コンテンツもある。

同図(b)は、映像コンテンツが、類似画像区間と、ズームイン区間とで構成される場合を示している。

同図(c)は、映像コンテンツが、類似画像区間と、ズームアウト区間とで構成される場合を示している。

同図(d)は、映像コンテンツが、類似画像区間と、左パン区間とで構成される場合を示している。

同図(e)は、映像コンテンツが、類似画像区間と、下チルト区間とで構成される場合を示している。

同図(f)は、映像コンテンツが、類似画像区間と、左パン、ズームイン及び下チルトが混在した区間とで構成される場合を示している。

同図に示すように、区間t0〜t1は類似画像区間であり、シーンIDは同一となっている。区間t1〜t2は非類似画像区間であり、シーンIDは全て異なり、ID値が増加している。区間t2〜t3は類似画像区間であるが、区間t0〜t1の画像は異なる画像であり、異なるIDが付与されている。t3以降の区間は類似画像区間であり、区間t0〜t1の画像と類似の画像であるため、当該区間t0〜t1とID値が同一となっている。

この場合、区間全体にわたってカメラ動作系特徴は検出されず、アフィン係数解析によるパン、チルト及びズームの各係数は0か、その絶対値が所定の閾値以下となる。

同図に示すように、区間t0〜t1は類似画像区間であり、シーンIDは同一となっている。t1以降の区間はズームイン区間であり、シーンIDは同一ではないが、ズームインの係数が検出されている。

同図に示すように、区間t0〜t1は類似画像区間であり、シーンIDは同一となっている。t1以降の区間はズームアウト区間であり、シーンIDは同一ではないが、ズームアウトの係数が検出されている。

同図に示すように、区間t0〜t1は類似画像区間であり、シーンIDは同一となっている。t1以降の区間は左パン区間であり、シーンIDは同一ではないが、左パンの係数が検出されている。

同図に示すように、区間t0〜t1は類似画像区間であり、シーンIDは同一となっている。t1以降の区間は下チルト区間であり、シーンIDは同一ではないが、下チルトの係数が検出されている。

同図に示すように、区間t0〜t1は類似画像区間であり、シーンIDは同一となっている。t1以降の区間は、ズームイン、左パン及び下チルトの各カメラ動作系特徴が同時に検出された区間であり、シーンIDは同一ではないが、ズームイン、左パン及び下チルトの各係数が検出されている。

すなわち、CPU1は、ハイライト再生モード1では、ズーム区間のみをハイライトシーンとして抽出し、ユーザに最低限のハイライトシーンを極力短時間で提供できるようにする。

また、CPU1は、ハイライト再生モード2では、ズーム区間にパン区間を加えて、再生時間は若干増加するものの、ハイライトシーンをより詳細に提供できるようにする。

そして、CPU1は、ハイライト再生モード3では、ズーム区間及びパン区間に更にチルト区間を加えて、再生時間がより長くなっても更に詳細な詳細にハイライトシーンを提供できるようにする。

CPU1は、上記コンテンツリスト上でハイライト再生モードを選択させる際に、これらの各モードも併せて選択させるようにする。

例えばCPU1は、上記手振れ検出フラグがDbure=1となっているか否かに基づいて、HDD10等に記録された映像コンテンツにそれぞれ異なる属性を付与して、2つのカテゴリに分類する。これにより、CPU1は、例えば、ユーザから操作入力部3を介して上記コンテンツリストの表示要求があった場合に、当該コンテンツリストを上記カテゴリ毎に表示させることが可能となる。また、CPU1は、ユーザがコンテンツを検索する際に、検索クエリとして上記カテゴリを選択させるようにすることもできる。これにより、映像コンテンツの検索範囲が狭まるため、検索処理の負荷を軽減し速度を向上させることも可能となる。

4…映像特徴検出部

10…HDD

16…AVデコーダ

21…画像処理部

22〜25…フレーム間メモリ部

22…1フレーム間メモリ部

23…10フレーム間メモリ部

24…20フレーム間メモリ部

25…30フレーム間メモリ部

26.28…マッチング処理部

26、28、30、32…マッチング処理部

27、29、31、33…フェード/カット処理部

34…動きベクトル処理部

35…フェード/カット判定部

36…カメラ特徴判定部

37…ID処理部

71…基準フレーム

72…探索領域

73…参照画像領域

75…探索フレーム

81…データメモリ

82…ベクトル距離演算部

83…ID生成部

84…IDメモリ

100…記録再生装置

Claims (6)

- 映像データを構成する複数のフレーム画像のうち、第1のフレーム画像の第1の位置から第1のブロックを抽出する抽出手段と、

前記各フレーム画像のうち前記第1のフレーム画像との間に第1の時間長を有する第2のフレーム画像内の探索領域から、前記第1のブロックとの間の残差値が最小となる第2のブロックを探索するとともに、前記第1のフレーム画像との間に前記第1の時間長とは異なる第2の時間長を有する第3のフレーム画像内の前記探索領域から、前記第1のブロックとの間の前記残差値が最小となる第3のブロックを探索する探索手段と、

前記第1のブロックと前記第2のブロックとの間の第1の動きベクトルを検出するとともに、前記第1のブロックと前記第3のブロックとの間の第2の動きベクトルを検出して、前記第1及び第2の動きベクトルを基に前記映像データ中の動き特徴を検出する検出手段と、

前記探索された第2のブロックが、前記第1の位置に対応する前記第2のフレーム内の第2の位置から第1の閾値以上移動した第3の位置で探索され、かつ、前記残差値が第2の閾値以上である場合に、前記第1の動きベクトルの検出を規制するよう制御し、当該第1の動きベクトルの検出が規制された場合に、前記第2の動きベクトルを基に前記動き特徴を検出するよう制御する制御手段と

を具備する電子機器。 - 請求項1に記載の電子機器であって、

前記探索手段は、前記第1のフレーム画像との間に前記第1及び第2の時間長とは異なる第3の時間長を有する第4のフレーム画像内の前記探索領域から、前記第1のブロックとの間の前記残差値が最小となる第4のブロックを探索し、

前記検出手段は、前記第1のブロックと前記第4のブロックとの間の第3の動きベクトルを検出して、前記第1、第2及び第3の動きベクトルを基に、前記第1のフレーム画像との間に前記第1、第2及び第3の時間長のいずれよりも長い第4の時間長を有する第5のフレーム画像内で検出されるであろう第4の動きベクトルを推定し、当該推定された第4の動きベクトルを基に前記動き特徴を検出し、

前記制御手段は、前記第1の動きベクトルの検出が規制された場合に、前記第2及び第3の動きベクトルを基に前記第4の動きベクトルを推定するよう制御する

電子機器。 - 請求項2に記載の電子機器であって、

前記検出手段は、

前記第1の動きベクトル及び前記第1の時間長を基に第1の勾配を算出する手段と、

前記第2の動きベクトル及び前記第2の時間長を基に第2の勾配を算出する手段と、

前記第3の動きベクトル及び前記第3の時間長を基に第3の勾配を算出する手段と、

前記算出された第1、第2及び第3の勾配を平均して第4の勾配を算出する手段と、

前記算出された第4の勾配を基に前記第4の動きベクトルを推定する手段とを有し、

前記制御手段は、前記第1の動きベクトルの検出が規制された場合に、前記第2及び第3の勾配を平均して前記第4の勾配を算出するよう制御する

電子機器。 - 請求項3に記載の電子機器であって、

前記検出手段は、前記第1、第2及び第3の勾配を、前記第1、第2及び第3の時間長をそれぞれ前記第1のフレーム画像の時間長で除した各値と、前記第1、第2、第3の動きベクトルとの各比として算出する

電子機器。 - 映像データを構成する複数のフレーム画像のうち、第1のフレーム画像の第1の位置から第1のブロックを抽出し、

前記各フレーム画像のうち前記第1のフレーム画像との間に第1の時間長を有する第2のフレーム画像内の探索領域から、前記第1のブロックとの間の残差値が最小となる第2のブロックを探索するとともに、前記第1のフレーム画像との間に前記第1の時間長とは異なる第2の時間長を有する第3のフレーム画像内の前記探索領域から、前記第1のブロックとの間の前記残差値が最小となる第3のブロックを探索し、

前記第1のブロックと前記第2のブロックとの間の第1の動きベクトルを検出するとともに、前記第1のブロックと前記第3のブロックとの間の第2の動きベクトルを検出し、

前記第1及び第2の動きベクトルを基に前記映像データ中の動き特徴を検出し、

前記探索された第2のブロックが、前記第1の位置に対応する前記第2のフレーム内の第2の位置から第1の閾値以上移動した第3の位置で探索され、かつ、前記残差値が第2の閾値以上である場合に、前記第1の動きベクトルの検出を規制するよう制御し、

前記第1の動きベクトルの検出が規制された場合に、前記第2の動きベクトルを基に前記動き特徴を検出するよう制御する

動きベクトル検出方法。 - 電子機器に、

映像データを構成する複数のフレーム画像のうち、第1のフレーム画像の第1の位置から第1のブロックを抽出するステップと、

前記各フレーム画像のうち前記第1のフレーム画像との間に第1の時間長を有する第2のフレーム画像内の探索領域から、前記第1のブロックとの間の残差値が最小となる第2のブロックを探索するとともに、前記第1のフレーム画像との間に前記第1の時間長とは異なる第2の時間長を有する第3のフレーム画像内の前記探索領域から、前記第1のブロックとの間の前記残差値が最小となる第3のブロックを探索するステップと、

前記第1のブロックと前記第2のブロックとの間の第1の動きベクトルを検出するとともに、前記第1のブロックと前記第3のブロックとの間の第2の動きベクトルを検出するステップと、

前記第1及び第2の動きベクトルを基に前記映像データ中の動き特徴を検出するステップと、

前記探索された第2のブロックが、前記第1の位置に対応する前記第2のフレーム内の第2の位置から第1の閾値以上移動した第3の位置で探索され、かつ、前記残差値が第2の閾値以上である場合に、前記第1の動きベクトルの検出を規制するよう制御するステップと、

前記第1の動きベクトルの検出が規制された場合に、前記第2の動きベクトルを基に前記動き特徴を検出するよう制御するステップと

を実行させるためのプログラム。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2007205755A JP4985201B2 (ja) | 2007-08-07 | 2007-08-07 | 電子機器、動きベクトル検出方法及びプログラム |

| US12/221,240 US8363726B2 (en) | 2007-08-07 | 2008-07-31 | Electronic apparatus, motion vector detecting method, and program therefor |

| CN200810129814XA CN101364305B (zh) | 2007-08-07 | 2008-08-07 | 电子装置、运动向量检测方法和其程序 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2007205755A JP4985201B2 (ja) | 2007-08-07 | 2007-08-07 | 電子機器、動きベクトル検出方法及びプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2009042917A JP2009042917A (ja) | 2009-02-26 |

| JP2009042917A5 JP2009042917A5 (ja) | 2010-05-06 |

| JP4985201B2 true JP4985201B2 (ja) | 2012-07-25 |

Family

ID=40346498

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2007205755A Expired - Fee Related JP4985201B2 (ja) | 2007-08-07 | 2007-08-07 | 電子機器、動きベクトル検出方法及びプログラム |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US8363726B2 (ja) |

| JP (1) | JP4985201B2 (ja) |

| CN (1) | CN101364305B (ja) |

Families Citing this family (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US8665326B2 (en) * | 2009-01-30 | 2014-03-04 | Olympus Corporation | Scene-change detecting device, computer readable storage medium storing scene-change detection program, and scene-change detecting method |

| JP2010199656A (ja) * | 2009-02-23 | 2010-09-09 | Panasonic Corp | 動画撮像装置 |

| JP5691374B2 (ja) * | 2010-10-14 | 2015-04-01 | 富士通株式会社 | データ圧縮装置 |

| US9762848B2 (en) * | 2013-03-15 | 2017-09-12 | Google Inc. | Automatic adjustment of video orientation |

| US20150348587A1 (en) * | 2014-05-27 | 2015-12-03 | Thomson Licensing | Method and apparatus for weighted media content reduction |

| WO2017106076A1 (en) * | 2015-12-16 | 2017-06-22 | Gopro, Inc. | Dynamic synchronization of frame rate to a detected cadence in a time lapse image sequence |

| CN108764026B (zh) * | 2018-04-12 | 2021-07-30 | 杭州电子科技大学 | 一种基于时序检测单元预筛选的视频行为检测方法 |

| CN113326069A (zh) * | 2020-02-28 | 2021-08-31 | 广东龙芯中科电子科技有限公司 | 操作系统启动方法、装置、电子设备及存储介质 |

Family Cites Families (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2809656B2 (ja) * | 1988-12-09 | 1998-10-15 | 松下電器産業株式会社 | 画像の動きベクトル検出装置及び揺れ補正装置 |

| JPH0944681A (ja) * | 1995-08-01 | 1997-02-14 | Matsushita Electric Ind Co Ltd | 移動物体領域検出装置 |

| JPH10262258A (ja) * | 1997-03-19 | 1998-09-29 | Sony Corp | 画像符号化装置及び方法 |

| EP0973336A2 (en) * | 1998-07-15 | 2000-01-19 | Sony Corporation | Motion vector detecting, picture encoding and recording method and apparatus |

| TW444507B (en) * | 1998-10-22 | 2001-07-01 | Sony Corp | Detecting method and device for motion vector |

| US6304604B1 (en) * | 1998-12-24 | 2001-10-16 | Compaq Computer Corporation | Method and apparatus for configuring compressed data coefficients to minimize transpose operations |

| JP4176230B2 (ja) * | 1999-03-19 | 2008-11-05 | 株式会社ルネサステクノロジ | 座標位置制御システム、座標位置制御方法およびその方法をコンピュータに実行させるプログラムを記録したコンピュータ読み取り可能な記録媒体 |

| EP1294194B8 (en) * | 2001-09-10 | 2010-08-04 | Texas Instruments Incorporated | Apparatus and method for motion vector estimation |

| JP2003299040A (ja) | 2002-04-03 | 2003-10-17 | Sony Corp | 動きベクトル検出装置及び方法 |

| JP4039273B2 (ja) * | 2003-02-26 | 2008-01-30 | 松下電器産業株式会社 | 動きベクトル検出装置 |

| US7894526B2 (en) * | 2004-02-27 | 2011-02-22 | Panasonic Corporation | Motion estimation method and moving picture coding method |

| US20100202532A1 (en) * | 2007-03-09 | 2010-08-12 | Dolby Laboratories Licensing Corporation | Multi-frame motion extrapolation from a compressed video source |

-

2007

- 2007-08-07 JP JP2007205755A patent/JP4985201B2/ja not_active Expired - Fee Related

-

2008

- 2008-07-31 US US12/221,240 patent/US8363726B2/en not_active Expired - Fee Related

- 2008-08-07 CN CN200810129814XA patent/CN101364305B/zh not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| JP2009042917A (ja) | 2009-02-26 |

| US20090041126A1 (en) | 2009-02-12 |

| CN101364305A (zh) | 2009-02-11 |

| US8363726B2 (en) | 2013-01-29 |

| CN101364305B (zh) | 2012-08-15 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP4683031B2 (ja) | 電子機器、コンテンツ分類方法及びそのプログラム | |

| JP4985201B2 (ja) | 電子機器、動きベクトル検出方法及びプログラム | |

| JP4666784B2 (ja) | ビデオシーケンスのキーフレーム抽出方法及びビデオシーケンスのキーフレーム抽出装置 | |

| US7027509B2 (en) | Hierarchical hybrid shot change detection method for MPEG-compressed video | |

| US7469010B2 (en) | Extracting key frames from a video sequence | |

| US8411735B2 (en) | Data processing apparatus, data processing method, and program | |

| US7853897B2 (en) | Information processing apparatus and method, and program | |

| JP4536402B2 (ja) | 映像再生装置、映像再生方法及びその方法をコンピュータに実行させるためのプログラム | |

| JP4613867B2 (ja) | コンテンツ処理装置及びコンテンツ処理方法、並びにコンピュータ・プログラム | |

| US6940910B2 (en) | Method of detecting dissolve/fade in MPEG-compressed video environment | |

| JP4645707B2 (ja) | コンテンツデータ処理装置 | |

| US20080279280A1 (en) | Moving picture decoding integrated circuit | |

| JP4514203B2 (ja) | 動きベクトル検出装置及び方法 | |

| JP4687834B2 (ja) | 映像記述子生成装置 | |

| JP2009212605A (ja) | 情報処理方法、情報処理装置及びプログラム | |

| JP4835540B2 (ja) | 電子機器、映像特徴検出方法及びプログラム | |

| JP2010033532A (ja) | 電子機器、動きベクトル検出方法及びそのプログラム | |

| JP4893524B2 (ja) | 電子機器、映像データ判定方法及びプログラム | |

| JP2009042915A (ja) | 電子機器、動きベクトル検出方法及びプログラム | |

| JP5070179B2 (ja) | シーン類似判定装置、そのプログラム及びサマリ映像生成システム | |

| JP2007174202A (ja) | 動きベクトル検出装置およびその方法 | |

| KR100821023B1 (ko) | 영상 신호 기록 재생 장치, 영상 신호 기록 재생 방법, 및기록 매체 | |

| KR20020040503A (ko) | 동영상 비디오 스트림의 장면전환 검출방법 | |

| JP2008085540A (ja) | プログラム、検出方法、及び検出装置 | |

| Chuang et al. | A rapid scheme for slow-motion replay segment detection |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20100317 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20100317 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20111028 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20111108 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20111213 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20120403 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20120416 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20150511 Year of fee payment: 3 |

|

| LAPS | Cancellation because of no payment of annual fees |