JP2020052979A - 情報処理装置およびプログラム - Google Patents

情報処理装置およびプログラム Download PDFInfo

- Publication number

- JP2020052979A JP2020052979A JP2018184795A JP2018184795A JP2020052979A JP 2020052979 A JP2020052979 A JP 2020052979A JP 2018184795 A JP2018184795 A JP 2018184795A JP 2018184795 A JP2018184795 A JP 2018184795A JP 2020052979 A JP2020052979 A JP 2020052979A

- Authority

- JP

- Japan

- Prior art keywords

- frame rate

- priority mode

- estimation accuracy

- imaging device

- orientation

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Granted

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T1/00—General purpose image data processing

- G06T1/20—Processor architectures; Processor configuration, e.g. pipelining

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T11/00—2D [Two Dimensional] image generation

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2200/00—Indexing scheme for image data processing or generation, in general

- G06T2200/28—Indexing scheme for image data processing or generation, in general involving image processing hardware

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20004—Adaptive image processing

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30244—Camera pose

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- General Engineering & Computer Science (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Human Computer Interaction (AREA)

- Length Measuring Devices By Optical Means (AREA)

- Image Analysis (AREA)

- User Interface Of Digital Computer (AREA)

Abstract

Description

以下、添付図面を参照して本発明の好適な実施形態について説明する。

第1の実施形態では、フレームレート優先モードの場合、撮像のフレームレートに合致するようにEKF(拡張カルマンフィルター)のような予測を用いて撮像装置の位置姿勢を推定した。ここで、モード切り替え部1040は、フレームレート優先モードの場合、所望のフレームレートをフレームレートの上限値として設定してもよい。本変形例では、撮像装置の更新レートに基づいて設定する。

第1の実施形態では、ジャイロの計測値である加速度または角速度に応じてフレームレート優先モードと推定精度の優先モードを判定し、モードに応じた処理によって撮像装置の位置姿勢を推定した。しかし、フレームレート優先モードと推定精度の優先モードを切り替えるモード切り替え情報は、ジャイロの計測値である加速度または角速度に基づくものに限らない。

第2の実施形態では、過去フレームにおけるカメラの位置または姿勢の変化量に応じて、フレームレート優先モードと推定精度の優先モードを判定し、モードに応じた処理によって撮像装置の位置姿勢を推定した。しかし、フレームレート優先モードと推定精度の優先モードを切り替えるモード切り替え情報は、これに限るものではない。

第3の実施形態では、モード切り替え情報としてジェスチャーを利用し、ジェスチャーに応じて、フレームレート優先モードと推定精度の優先モードを判定し、モードに応じた処理によって撮像装置の位置姿勢を推定した。しかし、フレームレート優先モードと推定精度の優先モードを切り替えるモード切り替え情報は、これに限るものではない。

第4の実施形態では、モード切り替え情報として音声認識情報を利用し、音声認識情報に応じて、フレームレート優先モードと推定精度の優先モードを判定し、モードに応じた処理によって撮像装置の位置姿勢を推定した。しかし、フレームレート優先モードと推定精度の優先モードを切り替えるモード切り替え情報は、これに限るものではない。

第1の実施形態では、フレームレート優先モードの場合、撮像のフレームレートに合致するようにEKF(拡張カルマンフィルター)のような予測を用いて撮像装置の位置姿勢を推定した。しかし、推定精度の優先モードよりもフレームレートを向上させるのであればこれに限らない。

第1の実施形態では、ジャイロの計測値である加速度または角速度に応じてフレームレート優先モードと推定精度の優先モードを判定し、モードに応じた処理によって撮像装置の位置姿勢を推定した。しかし、フレームレート優先モードと推定精度の優先モードを切り替えるモード切り替え情報は、ジャイロの計測値である加速度または角速度に基づくものに限らない。

第1の実施形態では、ジャイロの計測値である加速度または角速度に応じてフレームレート優先モードと推定精度の優先モードを判定し、モードに応じた処理によって撮像装置の位置姿勢を推定した。しかし、フレームレート優先モードと推定精度の優先モードを切り替えるモード切り替え情報は、ジャイロの計測値である加速度または角速度に基づくものに限らない。

第1の実施形態では、ジャイロの計測値である加速度または角速度に応じてフレームレート優先モードと推定精度の優先モードを判定し、モードに応じた処理によって撮像装置の位置姿勢を推定した。ここで、ユーザーが動き出した際にフレームレートが低いとHMDを装着したユーザーの動きに映像が追い付いてこられずHMDを装着したまま動く際に転倒や衝突などの危険性が向上する。

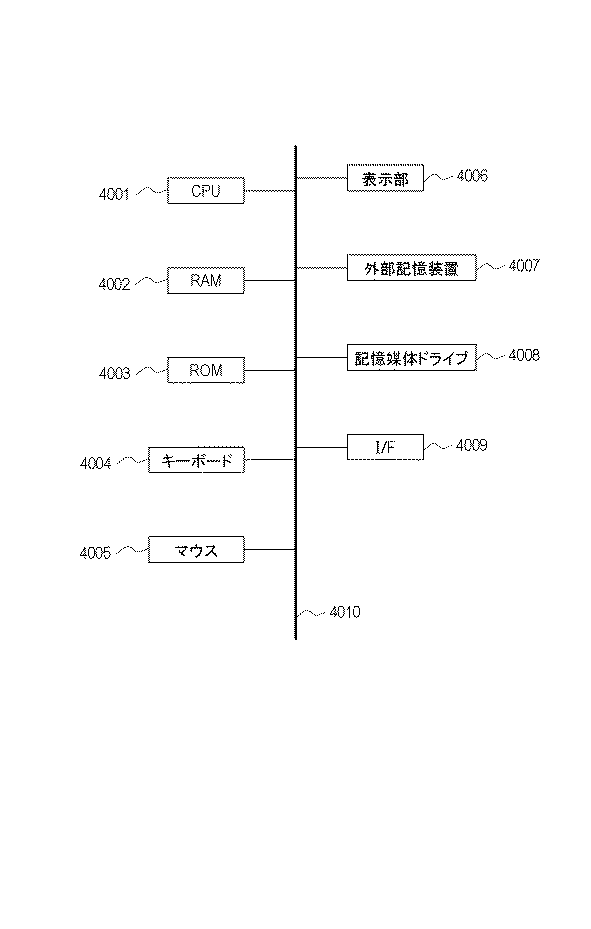

本発明は、上述の実施形態の1以上の機能を実現するプログラムを、ネットワーク又は記憶媒体を介してシステム又は装置に供給し、そのシステム又は装置のコンピュータにおける1つ以上のプロセッサーがプログラムを読出し実行する処理でも実現可能である。また、1以上の機能を実現する回路(例えば、ASIC)によっても実現可能である。

Claims (15)

- 撮像装置から画像を取得する取得手段と、

フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択する選択手段と、

前記選択手段で選択されたモードに基づき、前記画像の特徴から前記撮像装置の位置または姿勢の少なくともいずれか一方を推定する推定手段と、

前記推定された前記撮像装置の位置または姿勢の少なくともいずれか一方に基づく画像を表示手段に表示させる制御手段と、を有することを特徴とする情報処理装置。 - 前記推定精度の優先モードにおける前記推定手段による推定は、フレームレート優先モードよりも、前記撮像装置の位置または姿勢の少なくともいずれか一方の推定に時間がかかることを特徴とする請求項1に記載の情報処理装置。

- 前記推定精度の優先モードにおける前記推定手段による推定は、フレームレート優先モードよりも、前記画像の特徴をより多く用いることを特徴とする請求項1または請求項2に記載の情報処理装置。

- 前記選択手段は、前記撮像装置の位置または姿勢の少なくともいずれか一方の変化量に基づき、フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択することを特徴とする請求項1乃至3のいずれか1項に記載の情報処理装置。

- 前記選択手段は、ジャイロの計測値に基づき、前記撮像装置の位置または姿勢の少なくともいずれか一方の変化量に基づき、フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択することを特徴とする請求項1乃至3のいずれか1項に記載の情報処理装置。

- 前記選択手段は、音声の情報に基づき、前記撮像装置の位置または姿勢の少なくともいずれか一方の変化量に基づき、フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択することを特徴とする請求項1乃至3のいずれか1項に記載の情報処理装置。

- 前記選択手段は、ジェスチャーの情報に基づき、前記撮像装置の位置または姿勢の少なくともいずれか一方の変化量に基づき、フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択することを特徴とする請求項1乃至3のいずれか1項に記載の情報処理装置。

- 前記制御手段は、前記選択手段でフレームレート優先モードが選択された場合、フレームレートの上限値を、前記撮像装置または前記表示手段の更新レートに設定することを特徴とする請求項1乃至7のいずれか1項に記載の情報処理装置。

- 前記選択手段は、CPUの負荷の情報に基づき、前記撮像装置の位置または姿勢の少なくともいずれか一方の変化量に基づき、フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択することを特徴とする請求項1乃至3のいずれか1項に記載の情報処理装置。

- 前記選択手段は、前記画像から検出したオプティカルフローまたはモーションブラーに基づき、前記撮像装置の位置または姿勢の少なくともいずれか一方の変化量に基づき、フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択することを特徴とする請求項1乃至3のいずれか1項に記載の情報処理装置。

- 前記推定精度の優先モードと前記フレームレート優先モードとでは、前記推定手段において処理される前記画像の特徴の数が異なることを特徴とする請求項1乃至10のいずれか1項に記載の情報処理装置。

- 前記推定精度の優先モードと前記フレームレート優先モードとでは、前記推定手段において用いられるエッジ強調またはノイズリダクションの画像処理パラメーターが異なることを特徴とする請求項1乃至11のいずれか1項に記載の情報処理装置。

- 前記選択手段は、ユーザーによるユーザーインターフェースへの選択の入力に基づき、フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択することを特徴とする請求項1乃至3のいずれか1項に記載の情報処理装置。

- 前記選択手段は、前記撮像装置よりも更新レートの速いセンサーを利用して取得された前記画像の中のユーザーの動きに基づき、フレームレートよりも前記撮像装置の位置または姿勢の少なくともいずれか一方の推定精度を優先する推定精度の優先モードと、前記推定精度よりもフレームレートを優先するフレームレート優先モードと、のいずれかを選択することを特徴とする請求項1乃至3のいずれか1項に記載の情報処理装置。

- コンピュータを、請求項1乃至14のいずれか1項に記載の情報処理装置の各手段として機能させるためのプログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2018184795A JP7406875B2 (ja) | 2018-09-28 | 2018-09-28 | 情報処理装置およびプログラム |

| US16/579,493 US10970807B2 (en) | 2018-09-28 | 2019-09-23 | Information processing apparatus and storage medium |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2018184795A JP7406875B2 (ja) | 2018-09-28 | 2018-09-28 | 情報処理装置およびプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2020052979A true JP2020052979A (ja) | 2020-04-02 |

| JP2020052979A5 JP2020052979A5 (ja) | 2021-11-11 |

| JP7406875B2 JP7406875B2 (ja) | 2023-12-28 |

Family

ID=69945128

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2018184795A Active JP7406875B2 (ja) | 2018-09-28 | 2018-09-28 | 情報処理装置およびプログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US10970807B2 (ja) |

| JP (1) | JP7406875B2 (ja) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2025004917A1 (ja) * | 2023-06-30 | 2025-01-02 | ソニーグループ株式会社 | 情報処理装置、情報処理方法、情報処理システム |

Families Citing this family (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US10937191B2 (en) * | 2018-10-23 | 2021-03-02 | Dell Products, Lp | Predictive simultaneous localization and mapping system using prior user session positional information |

| US11227007B2 (en) * | 2019-07-23 | 2022-01-18 | Obayashi Corporation | System, method, and computer-readable medium for managing image |

| US11158087B2 (en) * | 2019-12-06 | 2021-10-26 | Intel Corporation | Adaptive virtual camera for indirect-sparse simultaneous localization and mapping systems |

| EP4205386A4 (en) * | 2020-10-16 | 2024-01-24 | Zhejiang Dahua Technology Co., Ltd. | SYSTEMS AND METHODS FOR DATA TRANSMISSION |

| CN112102411B (zh) * | 2020-11-02 | 2021-02-12 | 中国人民解放军国防科技大学 | 一种基于语义误差图像的视觉定位方法及装置 |

| WO2022226603A1 (en) * | 2021-04-30 | 2022-11-03 | Visionary Machines Pty Ltd | Systems and methods for generating and/or using 3-dimensional information with one or more cameras |

| US11812165B2 (en) * | 2021-06-16 | 2023-11-07 | Mediatek Inc. | Method and apparatus for dynamically changing frame rate of sensor output frames according to whether motion blur condition is met |

Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2016122975A (ja) * | 2014-12-25 | 2016-07-07 | セイコーエプソン株式会社 | 表示装置、及び、表示装置の制御方法 |

| JP2017207818A (ja) * | 2016-05-16 | 2017-11-24 | キヤノン株式会社 | 画像処理装置、画像処理方法、プログラム |

Family Cites Families (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6741790B1 (en) * | 1997-05-29 | 2004-05-25 | Red Hen Systems, Inc. | GPS video mapping system |

| JP4532982B2 (ja) | 2004-05-14 | 2010-08-25 | キヤノン株式会社 | 配置情報推定方法および情報処理装置 |

| US7456833B1 (en) * | 2005-06-15 | 2008-11-25 | Nvidia Corporation | Graphical representation of load balancing and overlap |

| US9978180B2 (en) * | 2016-01-25 | 2018-05-22 | Microsoft Technology Licensing, Llc | Frame projection for augmented reality environments |

-

2018

- 2018-09-28 JP JP2018184795A patent/JP7406875B2/ja active Active

-

2019

- 2019-09-23 US US16/579,493 patent/US10970807B2/en active Active

Patent Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2016122975A (ja) * | 2014-12-25 | 2016-07-07 | セイコーエプソン株式会社 | 表示装置、及び、表示装置の制御方法 |

| JP2017207818A (ja) * | 2016-05-16 | 2017-11-24 | キヤノン株式会社 | 画像処理装置、画像処理方法、プログラム |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2025004917A1 (ja) * | 2023-06-30 | 2025-01-02 | ソニーグループ株式会社 | 情報処理装置、情報処理方法、情報処理システム |

Also Published As

| Publication number | Publication date |

|---|---|

| US10970807B2 (en) | 2021-04-06 |

| JP7406875B2 (ja) | 2023-12-28 |

| US20200104969A1 (en) | 2020-04-02 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2020052979A (ja) | 情報処理装置およびプログラム | |

| EP3718048B1 (en) | Method of analyzing objects in images recorded by a camera of a head mounted device | |

| JP3512992B2 (ja) | 画像処理装置および画像処理方法 | |

| JP6789624B2 (ja) | 情報処理装置、情報処理方法 | |

| JP6723061B2 (ja) | 情報処理装置、情報処理装置の制御方法およびプログラム | |

| TWI701941B (zh) | 圖像處理方法及裝置、電子設備及儲存介質 | |

| JP2019522851A (ja) | 3次元空間内の姿勢推定 | |

| KR20170031733A (ko) | 디스플레이를 위한 캡처된 이미지의 시각을 조정하는 기술들 | |

| EP3644826A1 (en) | A wearable eye tracking system with slippage detection and correction | |

| JP2017129567A (ja) | 情報処理装置、情報処理方法、プログラム | |

| WO2022174594A1 (zh) | 基于多相机的裸手追踪显示方法、装置及系统 | |

| JP6894707B2 (ja) | 情報処理装置およびその制御方法、プログラム | |

| CN113228117B (zh) | 创作装置、创作方法和记录有创作程序的记录介质 | |

| KR101256046B1 (ko) | 공간 제스처 인식을 위한 신체 트래킹 방법 및 시스템 | |

| JP2019144958A (ja) | 画像処理装置、画像処理方法およびプログラム | |

| JP2012048463A (ja) | 情報処理装置およびその方法 | |

| JP2021009557A (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| JP2023054710A (ja) | 情報処理装置および方法、プログラム | |

| JP6632298B2 (ja) | 情報処理装置、情報処理方法及びプログラム | |

| JP2022516466A (ja) | 情報処理装置、情報処理方法、並びにプログラム | |

| CN117612251A (zh) | 一种人体姿态识别方法及系统 | |

| JP2015201734A (ja) | 画像処理装置、画像処理装置の制御方法およびプログラム | |

| CN112183271A (zh) | 一种图像处理的方法及装置 | |

| JP7710185B2 (ja) | 撮影装置、撮影作業支援方法、および撮影作業支援プログラム | |

| JP2016142577A (ja) | 画像処理装置、画像処理方法、画像処理システム、及びプログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210928 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20210928 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20221206 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20230201 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20230606 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20230728 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20231114 |

|

| RD01 | Notification of change of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7421 Effective date: 20231213 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20231213 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 7406875 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |