JP2017144521A - 情報処理装置、情報処理方法、及びプログラム - Google Patents

情報処理装置、情報処理方法、及びプログラム Download PDFInfo

- Publication number

- JP2017144521A JP2017144521A JP2016028899A JP2016028899A JP2017144521A JP 2017144521 A JP2017144521 A JP 2017144521A JP 2016028899 A JP2016028899 A JP 2016028899A JP 2016028899 A JP2016028899 A JP 2016028899A JP 2017144521 A JP2017144521 A JP 2017144521A

- Authority

- JP

- Japan

- Prior art keywords

- user

- action

- information processing

- processing apparatus

- distance

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Ceased

Links

- 230000010365 information processing Effects 0.000 title claims abstract description 180

- 238000003672 processing method Methods 0.000 title claims abstract description 6

- 230000009471 action Effects 0.000 claims abstract description 201

- 230000004044 response Effects 0.000 claims description 39

- 238000000034 method Methods 0.000 description 40

- 230000008569 process Effects 0.000 description 38

- 230000006870 function Effects 0.000 description 20

- 238000004891 communication Methods 0.000 description 19

- 238000012545 processing Methods 0.000 description 19

- 230000004048 modification Effects 0.000 description 12

- 238000012986 modification Methods 0.000 description 12

- 238000004458 analytical method Methods 0.000 description 10

- 230000004913 activation Effects 0.000 description 8

- 238000010586 diagram Methods 0.000 description 8

- 230000000694 effects Effects 0.000 description 6

- 238000003384 imaging method Methods 0.000 description 6

- 238000013459 approach Methods 0.000 description 5

- 238000001514 detection method Methods 0.000 description 4

- 238000006243 chemical reaction Methods 0.000 description 3

- 230000003287 optical effect Effects 0.000 description 3

- 239000003795 chemical substances by application Substances 0.000 description 2

- 238000004590 computer program Methods 0.000 description 2

- 238000012790 confirmation Methods 0.000 description 2

- 230000001151 other effect Effects 0.000 description 2

- 230000005236 sound signal Effects 0.000 description 2

- 230000004397 blinking Effects 0.000 description 1

- 238000004364 calculation method Methods 0.000 description 1

- 230000008859 change Effects 0.000 description 1

- 230000000295 complement effect Effects 0.000 description 1

- 238000012217 deletion Methods 0.000 description 1

- 230000037430 deletion Effects 0.000 description 1

- 238000005516 engineering process Methods 0.000 description 1

- 230000003203 everyday effect Effects 0.000 description 1

- 238000009434 installation Methods 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 230000007774 longterm Effects 0.000 description 1

- 229910044991 metal oxide Inorganic materials 0.000 description 1

- 150000004706 metal oxides Chemical class 0.000 description 1

- 238000003058 natural language processing Methods 0.000 description 1

- 230000002093 peripheral effect Effects 0.000 description 1

- 239000004065 semiconductor Substances 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G06F3/167—Audio in a user interface, e.g. using voice commands for navigating, audio feedback

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/04—Segmentation; Word boundary detection

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/06—Creation of reference templates; Training of speech recognition systems, e.g. adaptation to the characteristics of the speaker's voice

- G10L15/065—Adaptation

- G10L15/07—Adaptation to the speaker

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/08—Speech classification or search

- G10L15/10—Speech classification or search using distance or distortion measures between unknown speech and reference templates

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/28—Constructional details of speech recognition systems

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L17/00—Speaker identification or verification techniques

- G10L17/22—Interactive procedures; Man-machine interfaces

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L25/00—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00

- G10L25/78—Detection of presence or absence of voice signals

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

- G10L2015/223—Execution procedure of a spoken command

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

- G10L2015/225—Feedback of the input speech

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

- G10L2015/226—Procedures used during a speech recognition process, e.g. man-machine dialogue using non-speech characteristics

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- Acoustics & Sound (AREA)

- Computational Linguistics (AREA)

- Theoretical Computer Science (AREA)

- General Health & Medical Sciences (AREA)

- General Physics & Mathematics (AREA)

- General Engineering & Computer Science (AREA)

- Signal Processing (AREA)

- Artificial Intelligence (AREA)

- User Interface Of Digital Computer (AREA)

- Manipulator (AREA)

Abstract

Description

<<1.概要>>

<<2.構成例>>

<<3.動作>>

<3−1.動作例1>

<3−2.動作例2>

<<4.変形例>>

<4−1.変形例1>

<4−2.変形例2>

<4−3.変形例3>

<<5.ハードウェア構成例>>

<<6.むすび>>

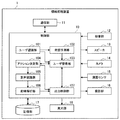

図2は、本実施形態による情報処理装置1の構成の一例を示すブロック図である。図2に示すように、情報処理装置1は、制御部10、通信部11、収音部12、スピーカ13、カメラ14、測距センサ15、投影部16、記憶部17、及び発光部18を有する。

続いて、本実施形態による情報処理装置1のいくつかの動作例について、図4〜16を参照して説明する。

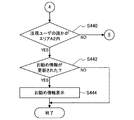

まず、図4、5を参照し、ユーザ応答を求めるアクションが行われ、音声認識が開始される場合の動作例を動作例1として以下に説明する。

上述した動作例1では、発話の予測に基づいて、ユーザの応答を求めるアクションが行われて、音声認識が開始される場合の動作例を説明した。続いて、以下に説明する動作例2では、ユーザとの距離に応じたアクションの特定の例について具体的に説明する。

「お客さんでしょうか・・・。」

「なんだか緊張します・・・。」

「うーん、誰かに似てる気が・・・。」

「すてきなお洋服ですね。」

以上、本開示の一実施形態を説明した。以下では、本開示の一実施形態の幾つかの変形例を説明する。なお、以下に説明する各変形例は、単独で本開示の実施形態に適用されてもよいし、組み合わせで本開示の実施形態に適用されてもよい。また、各変形例は、本開示の実施形態で説明した構成に代えて適用されてもよいし、本開示の実施形態で説明した構成に対して追加的に適用されてもよい。

上記では、アクション決定部104が、ユーザとの距離に基づいて、当該ユーザへのアクションを決定する例を説明したが、本開示は係る例に限定されない。以下に、他のアクション決定例を説明する。

また、上記実施形態では、ユーザ応答を求めるアクションの例として、ユーザの用件を伺う表示や発話を説明したが、本開示は係る例に限定されない。例えば、情報処理装置1は、ユーザの情報に基づいて、ユーザの用件を推測して、推測された用件の確認に係る表示や発話を出力してもよい。例えば、毎日所定の時刻に翌日のスケジュールを確認するユーザに対して、情報処理装置1は、当該ユーザの用件が翌日のスケジュール確認であると推定して、翌日のスケジュールを表示しつつ、用件が正しいか確認するメッセージを表示してもよい。係る構成によれば、よりスムーズなユーザとの対話が実現される。

また、上記実施形態では、ターゲットユーザにのみアクションが出力される例を説明したが、本開示は係る例に限定されない。例えば、情報処理装置1は、ターゲットユーザではないユーザに対して、「前のユーザとの対話が終わるまで少し待っていて」といった発話を出力してもよい。また、情報処理装置1は、ターゲットユーザではないユーザに対して、まだ対話を開始していないが、対話意思があることに気付いていることを示す出力(例えば発光部18が当該ユーザの方向を光らせる等)を行ってもよい。

以上、本開示の実施形態を説明した。上述したユーザ認識処理、発話予測処理、ユーザ管理処理、アクション決定処理、音声認識処理、意味解析処理、出力制御処理等の情報処理は、ソフトウェアと、情報処理装置1との協働により実現される。以下では、本実施形態に係る情報処理装置である情報処理装置1のハードウェア構成例として、情報処理装置1000のハードウェア構成例について説明する。

以上、説明したように、本開示の実施形態によれば、ユーザとの距離に基づいてアクションを決定することで、よりユーザの意思に沿ったアクションを出力することが可能である。

(1)

ユーザとの距離に基づいて、前記ユーザへのアクションを決定するアクション決定部と、

前記アクションを出力させる出力制御部と、

を備える情報処理装置。

(2)

前記ユーザとの距離は、前記情報処理装置と前記ユーザとの間の距離である、前記(1)に記載の情報処理装置。

(3)

前記アクションの対象となるターゲットユーザを特定するユーザ管理部をさらに備える、前記(1)または(2)に記載の情報処理装置。

(4)

前記ユーザ管理部は前記ユーザの状態に基づいて、前記ターゲットユーザを特定する、前記(3)に記載の情報処理装置。

(5)

前記ユーザ管理部は前記ユーザとの距離、または前記ユーザの状態の継続時間にさらに基づいて、前記ターゲットユーザを特定する、前記(4)に記載の情報処理装置。

(6)

前記ユーザ管理部は、前記ユーザの状態に基づいてユーザを複数の種別に分類し、

前記アクション決定部は、分類されたユーザの種別にさらに基づいて、前記ユーザへのアクションを決定する、前記(3)〜(5)のいずれかに記載の情報処理装置。

(7)

前記アクション決定部は、所定の種別に分類されたユーザのうち、前記ユーザとの距離が最も小さいユーザとの距離に応じて、アクションを決定する、前記(6)に記載の情報処理装置。

(8)

前記ユーザ管理部は、前記所定の種別に分類されたユーザに基づいて前記ターゲットユーザを特定する、前記(7)に記載の情報処理装置。

(9)

前記ユーザ管理部は、ユーザの発話が予測された場合に、発話が予測された当該ユーザを前記ターゲットユーザとして特定する、前記(3)〜(8)のいずれか一項に記載の情報処理装置。

(10)

前記アクション決定部は、前記ユーザの発話が予測された場合、前記ユーザの応答を求めるアクションを、前記ユーザへのアクションとして決定する、前記(9)に記載の情報処理装置。

(11)

前記アクション決定部は、さらにユーザの属性情報に基づいて前記アクションを決定する、前記(1)〜(10)のいずれか一項に記載の情報処理装置。

(12)

前記アクション決定部は、所定の属性を有するユーザが存在する場合、前記ユーザの応答を求めないアクションを、前記ユーザへのアクションとして決定する、前記(11)に記載の情報処理装置。

(13)

前記アクション決定部により決定された前記アクションに応じて、音声認識を開始する音声認識部をさらに備える、前記(1)〜(12)のいずれか一項に記載の情報処理装置。

(14)

前記アクション決定部は、前記ユーザとの距離が、第一の距離以下の場合に、前記ユーザの応答を求めるアクションを、前記ユーザへのアクションとして決定する、前記(1)〜(13)のいずれか一項に記載の情報処理装置。

(15)

前記アクション決定部は、前記ユーザとの距離が、前記第一の距離より大きい場合に、前記ユーザの応答を求めないアクションを、前記ユーザへのアクションとして決定する、前記(14)に記載の情報処理装置。

(16)

前記アクション決定部は、前記ユーザとの距離が、第二の距離以下の場合に、前記ユーザの応答を求めない表示を、前記ユーザへのアクションとして決定する、前記(15)に記載の情報処理装置。

(17)

前記アクション決定部は、前記ユーザとの距離が、前記第二の距離より大きく、第三の距離以下の場合に、前記ユーザの応答を求めない発話を、前記ユーザへのアクションとして決定する、前記(16)に記載の情報処理装置。

(18)

ユーザとの距離に基づいて、前記ユーザへのアクションを決定することと、

前記アクションを出力させることと、

を含む情報処理方法。

(19)

コンピュータに、

ユーザとの距離に基づいて、前記ユーザへのアクションを決定する機能と、

前記アクションを出力させる機能と、

を実現させるための、プログラム。

10 制御部

11 通信部

12 収音部

13 スピーカ

14 カメラ

15 測距センサ

16 投影部

17 記憶部

18 発光部

101 ユーザ認識部

102 発話予測部

103 ユーザ管理部

104 アクション決定部

105 音声認識部

106 意味解析部

107 出力制御部

Claims (19)

- ユーザとの距離に基づいて、前記ユーザへのアクションを決定するアクション決定部と、

前記アクションを出力させる出力制御部と、

を備える情報処理装置。 - 前記ユーザとの距離は、前記情報処理装置と前記ユーザとの間の距離である、請求項1に記載の情報処理装置。

- 前記アクションの対象となるターゲットユーザを特定するユーザ管理部をさらに備える、請求項1に記載の情報処理装置。

- 前記ユーザ管理部は前記ユーザの状態に基づいて、前記ターゲットユーザを特定する、請求項3に記載の情報処理装置。

- 前記ユーザ管理部は前記ユーザとの距離、または前記ユーザの状態の継続時間にさらに基づいて、前記ターゲットユーザを特定する、請求項4に記載の情報処理装置。

- 前記ユーザ管理部は、前記ユーザの状態に基づいてユーザを複数の種別に分類し、

前記アクション決定部は、分類されたユーザの種別にさらに基づいて、前記ユーザへのアクションを決定する、請求項3に記載の情報処理装置。 - 前記アクション決定部は、所定の種別に分類されたユーザのうち、前記ユーザとの距離が最も小さいユーザとの距離に応じて、アクションを決定する、請求項6に記載の情報処理装置。

- 前記ユーザ管理部は、前記所定の種別に分類されたユーザに基づいて前記ターゲットユーザを特定する、請求項7に記載の情報処理装置。

- 前記ユーザ管理部は、ユーザの発話が予測された場合に、発話が予測された当該ユーザを前記ターゲットユーザとして特定する、請求項3に記載の情報処理装置。

- 前記アクション決定部は、前記ユーザの発話が予測された場合、前記ユーザの応答を求めるアクションを、前記ユーザへのアクションとして決定する、請求項9に記載の情報処理装置。

- 前記アクション決定部は、さらにユーザの属性情報に基づいて前記アクションを決定する、請求項1に記載の情報処理装置。

- 前記アクション決定部は、所定の属性を有するユーザが存在する場合、前記ユーザの応答を求めないアクションを、前記ユーザへのアクションとして決定する、請求項11に記載の情報処理装置。

- 前記アクション決定部により決定された前記アクションに応じて、音声認識を開始する音声認識部をさらに備える、請求項1に記載の情報処理装置。

- 前記アクション決定部は、前記ユーザとの距離が、第一の距離以下の場合に、前記ユーザの応答を求めるアクションを、前記ユーザへのアクションとして決定する、請求項1に記載の情報処理装置。

- 前記アクション決定部は、前記ユーザとの距離が、前記第一の距離より大きい場合に、前記ユーザの応答を求めないアクションを、前記ユーザへのアクションとして決定する、請求項14に記載の情報処理装置。

- 前記アクション決定部は、前記ユーザとの距離が、第二の距離以下の場合に、前記ユーザの応答を求めない表示を、前記ユーザへのアクションとして決定する、請求項15に記載の情報処理装置。

- 前記アクション決定部は、前記ユーザとの距離が、前記第二の距離より大きく、第三の距離以下の場合に、前記ユーザの応答を求めない発話を、前記ユーザへのアクションとして決定する、請求項16に記載の情報処理装置。

- ユーザとの距離に基づいて、前記ユーザへのアクションを決定することと、

前記アクションを出力させることと、

を含む情報処理方法。 - コンピュータに、

ユーザとの距離に基づいて、前記ユーザへのアクションを決定する機能と、

前記アクションを出力させる機能と、

を実現させるための、プログラム。

Priority Applications (6)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016028899A JP2017144521A (ja) | 2016-02-18 | 2016-02-18 | 情報処理装置、情報処理方法、及びプログラム |

| KR1020187019102A KR20180113503A (ko) | 2016-02-18 | 2016-12-13 | 정보 처리 장치, 정보 처리 방법 및 프로그램 |

| PCT/JP2016/087096 WO2017141530A1 (ja) | 2016-02-18 | 2016-12-13 | 情報処理装置、情報処理方法、及びプログラム |

| US16/073,939 US11237794B2 (en) | 2016-02-18 | 2016-12-13 | Information processing device and information processing method |

| EP16890667.5A EP3419020B1 (en) | 2016-02-18 | 2016-12-13 | Information processing device, information processing method and program |

| CN201680081621.4A CN108701455A (zh) | 2016-02-18 | 2016-12-13 | 信息处理装置、信息处理方法和程序 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016028899A JP2017144521A (ja) | 2016-02-18 | 2016-02-18 | 情報処理装置、情報処理方法、及びプログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2017144521A true JP2017144521A (ja) | 2017-08-24 |

| JP2017144521A5 JP2017144521A5 (ja) | 2018-04-26 |

Family

ID=59625697

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016028899A Ceased JP2017144521A (ja) | 2016-02-18 | 2016-02-18 | 情報処理装置、情報処理方法、及びプログラム |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US11237794B2 (ja) |

| EP (1) | EP3419020B1 (ja) |

| JP (1) | JP2017144521A (ja) |

| KR (1) | KR20180113503A (ja) |

| CN (1) | CN108701455A (ja) |

| WO (1) | WO2017141530A1 (ja) |

Cited By (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2019072787A (ja) * | 2017-10-13 | 2019-05-16 | シャープ株式会社 | 制御装置、ロボット、制御方法、および制御プログラム |

| JP2019079083A (ja) * | 2017-10-19 | 2019-05-23 | アイシン精機株式会社 | 運転支援装置 |

| JP2019185389A (ja) * | 2018-04-10 | 2019-10-24 | 日本電信電話株式会社 | 情報処理装置、情報処理方法および情報処理プログラム |

| KR20210008089A (ko) * | 2018-08-21 | 2021-01-20 | 구글 엘엘씨 | 자동화된 어시스턴트를 호출하기 위한 다이내믹 및/또는 컨텍스트 특정 핫워드 |

| JP2021135363A (ja) * | 2020-02-26 | 2021-09-13 | 株式会社サイバーエージェント | 制御システム、制御装置、制御方法及びコンピュータプログラム |

| JP2022119878A (ja) * | 2018-05-04 | 2022-08-17 | グーグル エルエルシー | ユーザと自動化されたアシスタントインターフェースとの間の距離に応じて自動化されたアシスタントのコンテンツを生成するおよび/または適応させること |

| US11423890B2 (en) | 2018-08-21 | 2022-08-23 | Google Llc | Dynamic and/or context-specific hot words to invoke automated assistant |

Families Citing this family (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR102228866B1 (ko) * | 2018-10-18 | 2021-03-17 | 엘지전자 주식회사 | 로봇 및 그의 제어 방법 |

Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0311400A (ja) * | 1989-06-08 | 1991-01-18 | Toshiba Corp | 音声認識装置 |

| JPH0588691A (ja) * | 1991-09-30 | 1993-04-09 | Toshiba Corp | 音声対話装置 |

| JP2007199552A (ja) * | 2006-01-30 | 2007-08-09 | Toyota Motor Corp | 音声認識装置と音声認識方法 |

| JP2010204260A (ja) * | 2009-03-02 | 2010-09-16 | Brother Ind Ltd | 対話装置 |

| JP2015513704A (ja) * | 2012-03-16 | 2015-05-14 | ニュアンス コミュニケーションズ, インコーポレイテッド | ユーザ専用自動発話認識 |

Family Cites Families (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP4751192B2 (ja) | 2005-12-12 | 2011-08-17 | 本田技研工業株式会社 | 移動ロボット |

| JP2007160440A (ja) | 2005-12-12 | 2007-06-28 | Honda Motor Co Ltd | 脚式移動ロボットの制御装置 |

| JP4976903B2 (ja) | 2007-04-05 | 2012-07-18 | 本田技研工業株式会社 | ロボット |

| KR101644421B1 (ko) * | 2008-12-23 | 2016-08-03 | 삼성전자주식회사 | 사용자의 관심 정도에 기반한 컨텐츠 제공장치 및 방법 |

| KR101581883B1 (ko) * | 2009-04-30 | 2016-01-11 | 삼성전자주식회사 | 모션 정보를 이용하는 음성 검출 장치 및 방법 |

| JP5834941B2 (ja) * | 2012-01-19 | 2015-12-24 | 富士通株式会社 | 注目対象特定装置、注目対象特定方法、及びプログラム |

| JP6171353B2 (ja) * | 2013-01-18 | 2017-08-02 | 株式会社リコー | 情報処理装置、システム、情報処理方法およびプログラム |

| US20170017501A1 (en) | 2013-12-16 | 2017-01-19 | Nuance Communications, Inc. | Systems and methods for providing a virtual assistant |

| EP2911149B1 (en) | 2014-02-19 | 2019-04-17 | Nokia Technologies OY | Determination of an operational directive based at least in part on a spatial audio property |

| WO2015130273A1 (en) | 2014-02-26 | 2015-09-03 | Empire Technology Development Llc | Presence-based device mode modification |

| EP2933070A1 (en) * | 2014-04-17 | 2015-10-21 | Aldebaran Robotics | Methods and systems of handling a dialog with a robot |

| JP2017138476A (ja) | 2016-02-03 | 2017-08-10 | ソニー株式会社 | 情報処理装置、情報処理方法、及びプログラム |

-

2016

- 2016-02-18 JP JP2016028899A patent/JP2017144521A/ja not_active Ceased

- 2016-12-13 EP EP16890667.5A patent/EP3419020B1/en not_active Not-in-force

- 2016-12-13 US US16/073,939 patent/US11237794B2/en active Active

- 2016-12-13 WO PCT/JP2016/087096 patent/WO2017141530A1/ja active Application Filing

- 2016-12-13 KR KR1020187019102A patent/KR20180113503A/ko unknown

- 2016-12-13 CN CN201680081621.4A patent/CN108701455A/zh not_active Withdrawn

Patent Citations (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0311400A (ja) * | 1989-06-08 | 1991-01-18 | Toshiba Corp | 音声認識装置 |

| JPH0588691A (ja) * | 1991-09-30 | 1993-04-09 | Toshiba Corp | 音声対話装置 |

| JP2007199552A (ja) * | 2006-01-30 | 2007-08-09 | Toyota Motor Corp | 音声認識装置と音声認識方法 |

| JP2010204260A (ja) * | 2009-03-02 | 2010-09-16 | Brother Ind Ltd | 対話装置 |

| JP2015513704A (ja) * | 2012-03-16 | 2015-05-14 | ニュアンス コミュニケーションズ, インコーポレイテッド | ユーザ専用自動発話認識 |

Non-Patent Citations (1)

| Title |

|---|

| 木原 民雄、外2名: "人の位置移動による状況即応型デジタルサイネージの構成法", 情報処理学会論文誌, vol. 53, no. 2, JPN6017008337, 15 February 2012 (2012-02-15), JP, pages 868 - 878, ISSN: 0004172823 * |

Cited By (16)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2019072787A (ja) * | 2017-10-13 | 2019-05-16 | シャープ株式会社 | 制御装置、ロボット、制御方法、および制御プログラム |

| JP2019079083A (ja) * | 2017-10-19 | 2019-05-23 | アイシン精機株式会社 | 運転支援装置 |

| JP2019185389A (ja) * | 2018-04-10 | 2019-10-24 | 日本電信電話株式会社 | 情報処理装置、情報処理方法および情報処理プログラム |

| JP2022119878A (ja) * | 2018-05-04 | 2022-08-17 | グーグル エルエルシー | ユーザと自動化されたアシスタントインターフェースとの間の距離に応じて自動化されたアシスタントのコンテンツを生成するおよび/または適応させること |

| US11789522B2 (en) | 2018-05-04 | 2023-10-17 | Google Llc | Generating and/or adapting automated assistant content according to a distance between user(s) and an automated assistant interface |

| US11423890B2 (en) | 2018-08-21 | 2022-08-23 | Google Llc | Dynamic and/or context-specific hot words to invoke automated assistant |

| JP2021532394A (ja) * | 2018-08-21 | 2021-11-25 | グーグル エルエルシーGoogle LLC | 自動化アシスタントを呼び出すための動的および/またはコンテキスト固有のホットワード |

| CN112292724A (zh) * | 2018-08-21 | 2021-01-29 | 谷歌有限责任公司 | 用于调用自动助理的动态和/或场境特定热词 |

| JP2023015054A (ja) * | 2018-08-21 | 2023-01-31 | グーグル エルエルシー | 自動化アシスタントを呼び出すための動的および/またはコンテキスト固有のホットワード |

| KR102498811B1 (ko) | 2018-08-21 | 2023-02-10 | 구글 엘엘씨 | 자동화된 어시스턴트를 호출하기 위한 다이내믹 및/또는 컨텍스트 특정 핫워드 |

| KR20230023832A (ko) * | 2018-08-21 | 2023-02-17 | 구글 엘엘씨 | 자동화된 어시스턴트를 호출하기 위한 다이내믹 및/또는 컨텍스트 특정 핫워드 |

| JP7341171B2 (ja) | 2018-08-21 | 2023-09-08 | グーグル エルエルシー | 自動化アシスタントを呼び出すための動的および/またはコンテキスト固有のホットワード |

| KR20210008089A (ko) * | 2018-08-21 | 2021-01-20 | 구글 엘엘씨 | 자동화된 어시스턴트를 호출하기 위한 다이내믹 및/또는 컨텍스트 특정 핫워드 |

| KR102599607B1 (ko) | 2018-08-21 | 2023-11-07 | 구글 엘엘씨 | 자동화된 어시스턴트를 호출하기 위한 다이내믹 및/또는 컨텍스트 특정 핫워드 |

| US11810557B2 (en) | 2018-08-21 | 2023-11-07 | Google Llc | Dynamic and/or context-specific hot words to invoke automated assistant |

| JP2021135363A (ja) * | 2020-02-26 | 2021-09-13 | 株式会社サイバーエージェント | 制御システム、制御装置、制御方法及びコンピュータプログラム |

Also Published As

| Publication number | Publication date |

|---|---|

| EP3419020A1 (en) | 2018-12-26 |

| EP3419020A4 (en) | 2019-02-27 |

| CN108701455A (zh) | 2018-10-23 |

| WO2017141530A1 (ja) | 2017-08-24 |

| EP3419020B1 (en) | 2021-09-22 |

| US11237794B2 (en) | 2022-02-01 |

| US20190042188A1 (en) | 2019-02-07 |

| KR20180113503A (ko) | 2018-10-16 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| WO2017141530A1 (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| JP6669162B2 (ja) | 情報処理装置、制御方法、およびプログラム | |

| WO2017134935A1 (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| JP6516585B2 (ja) | 制御装置、その方法及びプログラム | |

| JP6669073B2 (ja) | 情報処理装置、制御方法、およびプログラム | |

| JP6739907B2 (ja) | 機器特定方法、機器特定装置及びプログラム | |

| JP6428954B2 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| KR102551715B1 (ko) | Iot 기반 알림을 생성 및 클라이언트 디바이스(들)의 자동화된 어시스턴트 클라이언트(들)에 의해 iot 기반 알림을 자동 렌더링하게 하는 명령(들)의 제공 | |

| JP6053097B2 (ja) | 機器操作システム、機器操作装置、サーバ、機器操作方法およびプログラム | |

| WO2016157658A1 (ja) | 情報処理装置、制御方法、およびプログラム | |

| WO2017168936A1 (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| JPWO2015133022A1 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| WO2019107145A1 (ja) | 情報処理装置、及び情報処理方法 | |

| JP6973380B2 (ja) | 情報処理装置、および情報処理方法 | |

| WO2018139036A1 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| JP6678315B2 (ja) | 音声再生方法、音声対話装置及び音声対話プログラム | |

| WO2017195440A1 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| US20210224066A1 (en) | Information processing device and information processing method | |

| CN109658924B (zh) | 会话消息处理方法、装置及智能设备 | |

| US20200160833A1 (en) | Information processor, information processing method, and program | |

| US11818820B2 (en) | Adapting a lighting control interface based on an analysis of conversational input | |

| JP2017182275A (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| US20210385101A1 (en) | Information processing apparatus and information processing method | |

| WO2018139050A1 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| JP2017211798A (ja) | ネットワークシステム、情報処理方法、およびサーバ |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20180314 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20180314 |

|

| RD04 | Notification of resignation of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7424 Effective date: 20190208 |

|

| RD03 | Notification of appointment of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7423 Effective date: 20190214 |

|

| RD04 | Notification of resignation of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7424 Effective date: 20190222 |

|

| RD02 | Notification of acceptance of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7422 Effective date: 20190515 |

|

| RD04 | Notification of resignation of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7424 Effective date: 20190522 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20190604 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20190717 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20191217 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200210 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20200602 |

|

| A045 | Written measure of dismissal of application [lapsed due to lack of payment] |

Free format text: JAPANESE INTERMEDIATE CODE: A045 Effective date: 20201027 |