JP2015527805A - ビデオ信号処理方法及び装置 - Google Patents

ビデオ信号処理方法及び装置 Download PDFInfo

- Publication number

- JP2015527805A JP2015527805A JP2015521545A JP2015521545A JP2015527805A JP 2015527805 A JP2015527805 A JP 2015527805A JP 2015521545 A JP2015521545 A JP 2015521545A JP 2015521545 A JP2015521545 A JP 2015521545A JP 2015527805 A JP2015527805 A JP 2015527805A

- Authority

- JP

- Japan

- Prior art keywords

- motion vector

- inter

- block

- view

- viewpoint

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/50—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding

- H04N19/503—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding involving temporal prediction

- H04N19/51—Motion estimation or motion compensation

- H04N19/513—Processing of motion vectors

- H04N19/517—Processing of motion vectors by encoding

- H04N19/52—Processing of motion vectors by encoding by predictive encoding

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/102—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or selection affected or controlled by the adaptive coding

- H04N19/103—Selection of coding mode or of prediction mode

- H04N19/105—Selection of the reference unit for prediction within a chosen coding or prediction mode, e.g. adaptive choice of position and number of pixels used for prediction

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/50—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding

- H04N19/597—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding specially adapted for multi-view video sequence encoding

Abstract

Description

多視点ビデオ信号データを圧縮符号化又は復号する技術は、空間的冗長性、時間的冗長性及び視点間存在する冗長性を考慮している。また、多視点映像の場合、3次元映像を具現するために、2以上の視点で撮影された多視点テクスチャ画像を符号化することができる。また、必要によって、多視点テクスチャ画像に対応する奥行データを更に符号化することができる。もちろん、奥行データを符号化する際、空間的冗長性、時間的冗長性又は視点間冗長性を考慮して圧縮符号化することができる。奥行データは、カメラと対応する画素との間の距離情報を表現したものであり、本明細書中で奥行データは奥行情報、奥行映像、奥行ピクチャ、奥行シーケンス、奥行ビットストリームなどのように、奥行に関連する情報として柔軟に解釈することができる。また、本明細書でいう符号化は、符号化、復号の両概念とも含むことができ、本発明の技術的思想及び技術的範囲によって柔軟に解釈することができる。

Claims (15)

- ビデオ信号を処理する方法であって、

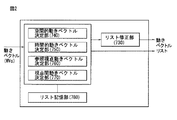

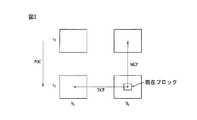

参照視点動きベクトルを用いて符号化されたブロックを求めて、現在テクスチャブロックの空間的隣接ブロックを探索するステップと、

前記探索された空間的隣接ブロックの参照視点動きベクトルに対応する参照視点間動きベクトルを、候補リストに記憶するステップと、

参照視点動きベクトルで符号化されたブロックを求めて、前記現在テクスチャブロックの時間的隣接ブロックを探索するステップと、

前記探索された時間的隣接ブロックの参照視点動きベクトルに対応する参照視点間動きベクトルを前記候補リストに記憶するステップと、

前記候補リストに記憶された参照視点間動きベクトルのいずれか一つを用いて、前記現在テクスチャブロックの視点間動きベクトルを導出するステップと、

前記導出された視点間動きベクトルを用いて、現在テクスチャブロックについて視点間インタ予測を行うステップと、

を有する方法。 - 前記候補リストに記憶された参照視点間動きベクトルを用いて、前記現在テクスチャブロックの視点間動きベクトルを導出するステップは、

前記空間的隣接ブロック及び前記時間的隣接ブロックのうち、視点間インタ予測で符号化されたブロックが存在しない場合にだけ行われる、請求項1に記載の方法。 - 前記候補リストに記憶された参照視点間動きベクトルを用いて、前記現在テクスチャブロックの視点間動きベクトルを導出するステップは、

前記候補リストに最初に記憶された参照視点間動きベクトルを用いて導出するステップを有する、請求項1に記載の方法。 - 前記現在テクスチャブロックの予測モードを確認するステップと、

前記予測モードがスキップモードである場合、前記導出された視点間動きベクトルを記憶するステップと、を更に有し、

前記記憶された視点間動きベクトルは、他のテクスチャブロックの視点間動きベクトル導出に再利用される、請求項1に記載の方法。 - 前記空間的隣接ブロックは、

前記現在テクスチャブロックの左下隣接ブロック、左隣接ブロック、右上隣接ブロック、上隣接ブロック及び左上隣接ブロックのうち少なくとも一つを含む、請求項1に記載の方法。 - 前記時間的隣接ブロックは、

同一位置のブロック及び同一位置のブロックに隣接した隣接ブロックを含む符号化ブロックのうち少なくとも一つを含む、請求項1に記載の方法。 - 前記参照視点間動きベクトルは、

前記空間的隣接ブロック及び前記時間的隣接ブロックのうち少なくとも一つが参照視点動きベクトルで導出された場合、前記参照視点動きベクトルに対応する視点間動きベクトルである、請求項1に記載の方法。 - ビデオ信号を処理する装置であって、

参照視点動きベクトルで符号化されたブロックを求めて、現在テクスチャブロックの空間的隣接ブロックを探索し、前記探索された空間的隣接ブロックの参照視点動きベクトルに対応する参照視点間動きベクトルを候補リストに記憶し、参照視点動きベクトルで符号化されたブロックを求めて前記現在テクスチャブロックの時間的隣接ブロックを探索し、前記探索された時間的隣接ブロックの参照視点動きベクトルに対応する参照視点間動きベクトルを前記候補リストに記憶する視点間動きベクトル決定部を備え、

前記視点間動きベクトル決定部は、

前記候補リストに記憶された参照視点間動きベクトルのいずれか一つを用いて、前記現在テクスチャブロックの視点間動きベクトルを導出し、前記導出された視点間動きベクトルを用いて現在テクスチャブロックについて視点間インタ予測を行う、装置。 - 前記視点間動きベクトル決定部は、

前記空間的隣接ブロック及び前記時間的隣接ブロックのうち、視点間インタ予測で符号化されたブロックが存在しない場合にだけ前記現在テクスチャブロックの視点間動きベクトルを導出する、請求項8に記載の装置。 - 前記視点間動きベクトル決定部は、

前記候補リストに最初に記憶された参照視点間動きベクトルを用いて、前記現在テクスチャブロックの視点間動きベクトルを導出する、請求項8に記載の装置。 - 前記視点間動きベクトル決定部は、

現在テクスチャブロックの予測モードを確認し、前記予測モードがスキップモードである場合、前記導出された視点間動きベクトルを記憶し、

前記記憶された視点間動きベクトルは、他のテクスチャブロックの視点間動きベクトル導出に再利用される、請求項8に記載の装置。 - 前記空間的隣接ブロックは、

前記現在テクスチャブロックの左下隣接ブロック、左隣接ブロック、右上隣接ブロック、上隣接ブロック及び左上隣接ブロックのうち少なくとも一つを含む、請求項8に記載の装置。 - 前記時間的隣接ブロックは、

同一位置のブロック及び同一位置のブロックに隣接した隣接ブロックを含む符号化ブロックのうち少なくとも一つを含む、請求項8に記載の装置。 - 前記参照視点間動きベクトルは、

前記空間的隣接ブロック及び前記時間的隣接ブロックのうち少なくとも一つが参照視点動きベクトルで導出された場合、前記参照視点動きベクトルに対応する視点間動きベクトルである、請求項8に記載の装置。 - 請求項1に記載のビデオ信号を処理する方法が記憶された、非一時的計算機可読記録媒体。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US201261670121P | 2012-07-10 | 2012-07-10 | |

| US61/670,121 | 2012-07-10 | ||

| PCT/KR2013/006099 WO2014010918A1 (ko) | 2012-07-10 | 2013-07-09 | 비디오 신호 처리 방법 및 장치 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015527805A true JP2015527805A (ja) | 2015-09-17 |

| JP2015527805A5 JP2015527805A5 (ja) | 2016-09-01 |

Family

ID=49916296

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2015521545A Pending JP2015527805A (ja) | 2012-07-10 | 2013-07-09 | ビデオ信号処理方法及び装置 |

Country Status (7)

| Country | Link |

|---|---|

| US (1) | US20150208083A1 (ja) |

| EP (1) | EP2874390A4 (ja) |

| JP (1) | JP2015527805A (ja) |

| KR (1) | KR20150043319A (ja) |

| CN (1) | CN104429078A (ja) |

| BR (1) | BR112015000240A2 (ja) |

| WO (1) | WO2014010918A1 (ja) |

Families Citing this family (7)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2014013880A1 (ja) * | 2012-07-18 | 2014-01-23 | ソニー株式会社 | 画像処理装置および方法 |

| US9936219B2 (en) * | 2012-11-13 | 2018-04-03 | Lg Electronics Inc. | Method and apparatus for processing video signals |

| US9288507B2 (en) * | 2013-06-21 | 2016-03-15 | Qualcomm Incorporated | More accurate advanced residual prediction (ARP) for texture coding |

| CN108235031B (zh) | 2016-12-15 | 2019-11-05 | 华为技术有限公司 | 一种运动矢量解码方法及解码器 |

| WO2019061537A1 (en) * | 2017-09-30 | 2019-04-04 | Huawei Technologies Co., Ltd. | METHOD AND APPARATUS FOR DERIVING CANDIDATES FROM TIME MOVEMENT DATA IN VIDEO CODING |

| WO2020140221A1 (zh) * | 2019-01-02 | 2020-07-09 | 北京大学 | 候选mv列表构建方法和装置 |

| MX2021013067A (es) * | 2019-04-25 | 2021-12-14 | Op Solutions Llc | Candidatos en tramas con movimiento global. |

Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2013138621A1 (en) * | 2012-03-14 | 2013-09-19 | Qualcomm Incorporated | Disparity vector construction method for 3d-hevc |

Family Cites Families (10)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP4869049B2 (ja) * | 2006-12-08 | 2012-02-01 | 株式会社東芝 | 補間フレーム画像作成方法および補間フレーム画像作成装置 |

| WO2008133455A1 (en) * | 2007-04-25 | 2008-11-06 | Lg Electronics Inc. | A method and an apparatus for decoding/encoding a video signal |

| CN101415122B (zh) * | 2007-10-15 | 2011-11-16 | 华为技术有限公司 | 一种帧间预测编解码方法及装置 |

| US8213515B2 (en) * | 2008-01-11 | 2012-07-03 | Texas Instruments Incorporated | Interpolated skip mode decision in video compression |

| CN107105280B (zh) * | 2010-12-14 | 2020-01-03 | M&K控股株式会社 | 用于编码运动画面的设备 |

| KR20120068743A (ko) * | 2010-12-17 | 2012-06-27 | 한국전자통신연구원 | 인터 예측 방법 및 그 장치 |

| WO2012171442A1 (en) * | 2011-06-15 | 2012-12-20 | Mediatek Inc. | Method and apparatus of motion and disparity vector prediction and compensation for 3d video coding |

| EP3657796A1 (en) * | 2011-11-11 | 2020-05-27 | GE Video Compression, LLC | Efficient multi-view coding using depth-map estimate for a dependent view |

| US9525861B2 (en) * | 2012-03-14 | 2016-12-20 | Qualcomm Incorporated | Disparity vector prediction in video coding |

| JP6042536B2 (ja) * | 2012-07-02 | 2016-12-14 | 寰發股▲ふん▼有限公司HFI Innovation Inc. | 3dビデオ符号化におけるビュー間候補導出の方法と装置 |

-

2013

- 2013-07-09 BR BR112015000240A patent/BR112015000240A2/pt not_active IP Right Cessation

- 2013-07-09 JP JP2015521545A patent/JP2015527805A/ja active Pending

- 2013-07-09 EP EP13816796.0A patent/EP2874390A4/en not_active Ceased

- 2013-07-09 CN CN201380036652.4A patent/CN104429078A/zh active Pending

- 2013-07-09 WO PCT/KR2013/006099 patent/WO2014010918A1/ko active Application Filing

- 2013-07-09 US US14/413,139 patent/US20150208083A1/en not_active Abandoned

- 2013-07-09 KR KR20157003576A patent/KR20150043319A/ko not_active Application Discontinuation

Patent Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2013138621A1 (en) * | 2012-03-14 | 2013-09-19 | Qualcomm Incorporated | Disparity vector construction method for 3d-hevc |

Non-Patent Citations (1)

| Title |

|---|

| GERHARD TECH ET AL., 3D-HEVC TEST MODEL 3, JPN6017015195, 24 March 2013 (2013-03-24), pages 16 - 21 * |

Also Published As

| Publication number | Publication date |

|---|---|

| BR112015000240A2 (pt) | 2017-08-08 |

| EP2874390A1 (en) | 2015-05-20 |

| EP2874390A4 (en) | 2016-02-24 |

| KR20150043319A (ko) | 2015-04-22 |

| US20150208083A1 (en) | 2015-07-23 |

| WO2014010918A1 (ko) | 2014-01-16 |

| CN104429078A (zh) | 2015-03-18 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US10659758B2 (en) | Image encoding method and image decoding method | |

| CN111971960B (zh) | 用于基于帧间预测模式处理图像的方法及其装置 | |

| JP6291032B2 (ja) | ビデオ信号処理方法及び装置 | |

| JP2015527805A (ja) | ビデオ信号処理方法及び装置 | |

| JP2015527806A (ja) | ビデオ信号処理方法及び装置 | |

| US11606566B2 (en) | Method for processing image on basis of inter-prediction mode and apparatus therefor | |

| JP6231560B2 (ja) | ビデオ信号処理方法およびビデオ信号処理装置 | |

| KR20150085027A (ko) | 화상 부호화 방법, 화상 복호 방법, 화상 부호화 장치, 화상 복호 장치, 화상 부호화 프로그램 및 화상 복호 프로그램 | |

| CN114586350A (zh) | 基于交叉分量自适应环路滤波的图像编译装置和方法 | |

| CN114051728A (zh) | 基于块大小执行bdpcm的图像解码方法及其设备 | |

| CN114175646A (zh) | 图像解码方法及其装置 | |

| WO2019194502A1 (ko) | 인터 예측 모드 기반 영상 처리 방법 및 이를 위한 장치 | |

| CN114270835A (zh) | 基于默认合并模式推导预测样本的图像解码方法及其装置 | |

| CN113508583A (zh) | 基于帧内块编译的视频或图像编译 | |

| RU2625526C2 (ru) | Способ и устройство для обработки видеосигнала | |

| CN114586351A (zh) | 基于自适应环路滤波的图像编译设备和方法 | |

| CN114208169A (zh) | 用于色度分量的图像解码方法及其装置 | |

| WO2019194498A1 (ko) | 인터 예측 모드 기반 영상 처리 방법 및 이를 위한 장치 | |

| KR101753592B1 (ko) | 비디오 신호 처리 방법 및 장치 | |

| CN114270824A (zh) | 用于基于帧间预测编译图像的方法和装置 | |

| CN114342387A (zh) | 基于运动预测的图像编译方法和装置 | |

| CN114270833A (zh) | 用于在视频/图像编译系统中移除重叠信令的方法和装置 | |

| CN114208181A (zh) | 用于色度量化参数数据的图像解码方法及其装置 | |

| CN114073078A (zh) | 视频/图像编译系统中的语法信令的方法和装置 | |

| CN113273210B (zh) | 用于编译关于合并数据的信息的方法和装置 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20160711 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20160711 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20170420 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20170509 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170809 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20180123 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20180821 |