JP2015114757A - 情報処理装置、情報処理方法及びプログラム - Google Patents

情報処理装置、情報処理方法及びプログラム Download PDFInfo

- Publication number

- JP2015114757A JP2015114757A JP2013255049A JP2013255049A JP2015114757A JP 2015114757 A JP2015114757 A JP 2015114757A JP 2013255049 A JP2013255049 A JP 2013255049A JP 2013255049 A JP2013255049 A JP 2013255049A JP 2015114757 A JP2015114757 A JP 2015114757A

- Authority

- JP

- Japan

- Prior art keywords

- information processing

- area

- processing apparatus

- candidate

- superimposed display

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T11/00—2D [Two Dimensional] image generation

- G06T11/60—Editing figures and text; Combining figures or text

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Computer Graphics (AREA)

- Computer Hardware Design (AREA)

- General Engineering & Computer Science (AREA)

- Software Systems (AREA)

- Controls And Circuits For Display Device (AREA)

- User Interface Of Digital Computer (AREA)

- Processing Or Creating Images (AREA)

Abstract

【課題】ARによる重畳表示において視認性が損なわれるのを防止すること。

【解決手段】情報処理装置は、撮像部と、制御部と、出力部とを有する。上記制御部は、上記撮像部により撮像された画像からコンテンツの重畳表示候補となる候補領域を検出し、上記候補領域のうち、輝度分布の起伏変化が閾値以下の領域を重畳表示領域として検出し、ユーザに上記重畳表示領域上で仮想的に視認されるように配置される上記コンテンツを生成するように構成される。上記出力部は、上記生成されたコンテンツを上記重畳表示領域に重畳させて出力するように構成される。

【選択図】図3

【解決手段】情報処理装置は、撮像部と、制御部と、出力部とを有する。上記制御部は、上記撮像部により撮像された画像からコンテンツの重畳表示候補となる候補領域を検出し、上記候補領域のうち、輝度分布の起伏変化が閾値以下の領域を重畳表示領域として検出し、ユーザに上記重畳表示領域上で仮想的に視認されるように配置される上記コンテンツを生成するように構成される。上記出力部は、上記生成されたコンテンツを上記重畳表示領域に重畳させて出力するように構成される。

【選択図】図3

Description

本技術は、入力画像上にコンテンツを重畳表示することが可能な情報処理装置、当該情報処理装置における情報処理方法及びプログラムに関する。

近年、現実空間と仮想空間とを融合した環境である複合現実感(MR: Mixed Reality)に関する研究が盛んに行われており、その中でも、現実空間に仮想空間のコンテンツを重畳表示することで現実の感覚を増強するAR(Augmented Reality)が注目されている。

上記ARは、例えばスマートフォンや、HMD(Head Mount Display)、シースルー眼鏡型等のウェアラブル機器等において既に実現されている。例えば、下記特許文献1には、遺跡の中を歩き回る見学者が所持する携帯型端末装置において、カメラで撮影された遺跡の実写画像に、遺跡の中の展示物に関する情報を重畳させて表示する技術が開示されている。

しかしながら、上記特許文献1のような従来技術においては、カメラに写っている画像上の、例えば仮想コンテンツの重畳表示領域のテクスチャ成分が強い場合等には、当該仮想コンテンツの視認性が損なわれるという問題があった。

以上のような事情に鑑み、本技術の目的は、ARによる重畳表示において視認性が損なわれるのを防止することが可能な情報処理装置、情報処理方法及びプログラムを提供することにある。

上述の課題を解決するため、本技術の一形態に係る情報処理装置は、撮像部と、制御部と、出力部とを有する。上記制御部は、上記撮像部により撮像された画像からコンテンツの重畳表示候補となる候補領域を検出し、上記候補領域のうち、輝度分布の起伏変化が第1の閾値以下の領域を重畳表示領域として検出し、ユーザに上記重畳表示領域上で仮想的に視認されるように配置される上記コンテンツを生成するように構成される。上記出力部は、上記生成されたコンテンツを上記重畳表示領域に重畳させて出力するように構成される。

これにより情報処理装置は、輝度分布の起伏変化が小さい領域、すなわちテクスチャが弱い領域を検出してコンテンツを重畳表示するため、テクスチャが強い領域にコンテンツが重畳表示されて視認性が損なわれるのを防止することができる。

上記制御部は、上記候補領域のうち、三次元形状の起伏変化が第2の閾値以下の領域を上記重畳表示領域として検出してもよい。

これにより情報処理装置は、平坦な領域を重畳表示領域として検出することで、コンテンツを実世界の形状に沿った形で視認性よく表示することができる。

上記制御部は、上記入力された画像から、上記候補領域が動体領域であるか否かを検出し、上記動体領域を上記重畳表示領域から除外してもよい。

これにより情報処理装置は、動体領域にコンテンツが表示されないようにすることで、視認性のみならず安全性も向上させることができる。

当該情報処理装置の姿勢を検出するように構成されたセンサをさらに具備してもよい。この場合上記制御部は、上記センサにより検出された姿勢の変動を検出し、上記入力された画像から、上記姿勢の変動を差し引いて上記動体領域を検出してもよい。

これにより情報処理装置は、姿勢の変動による影響をキャンセルすることで、装置の移動中も、画像内の動体領域を高精度に検出することができる。

上記制御部は、上記入力された画像のうち連続する第1の画像及び第2の画像からそれぞれ第1の深度分布及び第2の深度分布を算出し、上記第1の画像及び第2の画像の時間間隔において検出された上記姿勢の変動量を上記第1の深度分布に反映させて第3の深度分布を算出し、上記第2の深度分布と上記第3の深度分布との差分の有無を検出することで、上記動体領域の有無を検出してもよい。

これにより情報処理装置は、フレーム間の深度分布を、姿勢の変動量分ずらして比較することで、装置の移動も、画像内の動体領域を高精度に検出することができる。

当該情報処理装置の姿勢を検出するセンサをさらに具備してもよい。この場合上記制御部は、上記センサの検出結果を基に、当該情報処理装置が静止しているか否かを判断し、当該情報処理装置が静止している場合に上記入力された連続した画像の差分を抽出することで、上記動体領域を検出してもよい。

これにより情報処理装置は、重畳表示処理を静止状態にのみ限定することで、動体領域の検出を簡略化して処理負荷を軽減することができる。

上記出力部は、上記生成されたコンテンツを上記重畳表示領域に半透過状態で重畳させて出力してもよい。この場合上記制御部は、上記輝度分布の起伏変化が第1の閾値以下の上記候補領域が検出されない場合、上記生成されたコンテンツの透過度を上記半透過状態よりも下げて重畳させるように上記出力部を制御してもよい。

これにより情報処理装置は、テクスチャの弱い領域が見つからない場合には、コンテンツの透過度を下げることで、視認性及び安全性の低下を防ぐことができる。

上記制御部は、上記輝度分布の起伏変化が第1の閾値以下の上記候補領域が検出されない場合、上記コンテンツを、上記候補領域以外の領域に、上記輝度分布の起伏変化が第1の閾値より大きい候補領域と関連付けて表示させるように上記出力部を制御してもよい。

これにより情報処理装置は、テクスチャの弱い領域が見つからない場合でも、候補領域以外の領域に、例えば候補領域からの引き出し線付きでコンテンツを表示させることで、領域とコンテンツとの関連性をユーザに把握させることができる。

上記制御部は、上記入力された画像から、動体領域を上記重畳表示領域として検出してもよい。

これにより情報処理装置は、動体をコンテンツの重畳表示領域とすることで、ユーザの興味を惹くことができる。

本技術の他の形態に係る情報処理方法は、

撮像装置により撮像され入力された画像からコンテンツの重畳表示候補となる候補領域を検出すること、

上記検出された候補領域のうち、輝度分布の起伏変化が所定の閾値以下の領域を重畳表示領域として検出すること、

ユーザに上記重畳表示領域上で仮想的に視認されるように配置される上記コンテンツを生成すること、及び、

上記生成されたコンテンツを上記重畳表示領域に重畳させて出力することを含む。

撮像装置により撮像され入力された画像からコンテンツの重畳表示候補となる候補領域を検出すること、

上記検出された候補領域のうち、輝度分布の起伏変化が所定の閾値以下の領域を重畳表示領域として検出すること、

ユーザに上記重畳表示領域上で仮想的に視認されるように配置される上記コンテンツを生成すること、及び、

上記生成されたコンテンツを上記重畳表示領域に重畳させて出力することを含む。

本技術のまた別の形態に係るプログラムは、情報処理装置に、

撮像装置により撮像され入力された画像からコンテンツの重畳表示候補となる候補領域を検出するステップと、

上記検出された候補領域のうち、輝度分布の起伏変化が所定の閾値以下の領域を重畳表示領域として検出するステップと、

ユーザに上記重畳表示領域上で仮想的に視認されるように配置される上記コンテンツを生成するステップと、

上記生成されたコンテンツを上記重畳表示領域に重畳させて出力するステップと

を実行させる。

撮像装置により撮像され入力された画像からコンテンツの重畳表示候補となる候補領域を検出するステップと、

上記検出された候補領域のうち、輝度分布の起伏変化が所定の閾値以下の領域を重畳表示領域として検出するステップと、

ユーザに上記重畳表示領域上で仮想的に視認されるように配置される上記コンテンツを生成するステップと、

上記生成されたコンテンツを上記重畳表示領域に重畳させて出力するステップと

を実行させる。

以上のように、本技術によれば、ARによる重畳表示において視認性が損なわれるのを防止することができる。しかし、当該効果は本技術を限定するものではない。

以下、本技術に係る実施形態を、図面を参照しながら説明する。

[システムの概要]

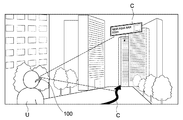

図1は、本技術の一実施形態に係るシステムの概要を示した図である。

図1は、本技術の一実施形態に係るシステムの概要を示した図である。

同図に示すように、本実施形態では、ユーザが頭部にシースルー眼鏡型のHMD(Head Mount Display)100を装着することで、AR環境が実現される。ユーザは、HMD100のレンズ(表示部)を通して実環境を視認しながら、当該実環境における道路、建物、看板等に重畳して仮想的に表示されるコンテンツCを視認することができる。

例えば、同図に示すように、ユーザから見て、道路上にはユーザの目的地までのルートをナビゲートするラインが表示されたり、ビル上にはそのビルに存在するレストランやバーの情報が表示されたりする。

本実施形態では、上記ARシステムにおける重畳表示の実行の際に、HMD100は、ユーザの視認性に鑑みて、テクスチャの強い(輝度分布の起伏変化が大きい)領域等を避けてコンテンツを重畳表示することが可能である。

[HMDのハードウェア構成]

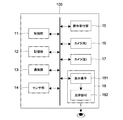

図2は、上記HMD100のハードウェア構成を示したブロック図である。

図2は、上記HMD100のハードウェア構成を示したブロック図である。

同図に示すように、HMD100は、制御部11、記憶部12、通信部13、センサ部14、操作受付部15、右カメラ16、左カメラ17及び表示部18を有する。

制御部11は、例えばCPU(Central Processing Unit)やGPU(Graphics Processing Unit)等からなり、コンテンツの重畳表示処理等において各種演算処理を行いながらHMD100の各ブロック全体を統括的に制御する。

記憶部12は、例えばフラッシュメモリ(SSD;Solid State Drive)、その他の固体メモリ等の不揮発性メモリである。記憶部12は、OSや各種アプリケーション、各種データを記憶する。特に本実施形態においては、記憶部12は、例えば重畳表示対象のコンテンツ(例えば広告用のテキストや画像等)を記憶する。

通信部13は、例えばWiFi(Wireless Fidelity)等の無線LAN(Local Area Network)やBluetooth(登録商標)等の規格に対応した無線通信モジュールであり、例えばユーザの携帯するスマートフォン等の機器と通信可能とされている。また通信部13は、スマートフォン等のユーザの携帯機器を介して、または直接、インターネット上から、コンテンツや地図情報等の重畳表示に必要なデータを受信することが可能である。

センサ部14は、ジャイロセンサ、加速度センサ、地磁気センサ等の各種センサから構成され、仮想三次元オブジェクトOの表示処理のために、HMD100(ユーザ)の姿勢、位置、方向等を検出する。

操作受付部15は、例えばタッチパネル、ボタン、スイッチ等からなり、ユーザの各種操作を受け付ける。

右カメラ16及び左カメラ17は、それぞれ例えばHMD100の右フレーム及び左フレームに設けられ、両者で撮影された画像間の視差から、ユーザの前方の実環境(物体の位置、立体的形状及び深度(Depth Map))を認識するステレオカメラとして機能する。

表示部18は、透過ディスプレイとして構成され、表示素子181と光学部材182とを有する。表示部18は、例えばHMD100のフレーム部に収容される表示素子181によりコンテンツの画像を形成し、その画像光を光学部材182内に導光しユーザの目に出射することで、コンテンツの画像をユーザに提示する。コンテンツの画像は二次元画像でも三次元画像でもよい。

表示素子181は例えばLCD(Liquid Crystal Display)で構成される。光学部材182は、偏向素子(ホログラム回折格子)及び表示面としての導光板を有し、偏光素子によりRGBの各色に対応する特定波長の光が回折反射され、導光板内で全反射されることで画像がユーザの目に出射される。

[HMDの動作]

次に、以上のように構成されたHMD100の動作について説明する。以降の説明においては、HMDの制御部11を主な動作主体として説明するが、この動作は制御部11の制御下において実行される他のハードウェア及びソフトウェアと協働して行われる。

次に、以上のように構成されたHMD100の動作について説明する。以降の説明においては、HMDの制御部11を主な動作主体として説明するが、この動作は制御部11の制御下において実行される他のハードウェア及びソフトウェアと協働して行われる。

(重畳表示処理)

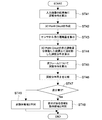

図3は、上記HMD100のコンテンツ重畳表示処理の流れを示したフローチャートである。

図3は、上記HMD100のコンテンツ重畳表示処理の流れを示したフローチャートである。

同図に示すように、まず、HMD100の制御部11には、右カメラ16及び左カメラ17が撮像した画像群が入力される(ステップ31)。入力される画像群は、片方のカメラからのものでも構わない。

続いて制御部11は、入力された画像から、ユーザが存在する実環境情報を認識する(ステップ32)。

具体的には、制御部11は、入力された画像それぞれについて、カメラ16及び17の姿勢を推定及び算出する。カメラ16及び17の姿勢は、三次元世界における位置と角度(カメラ16及び17が向いている向き)からなる。これらは例えば画像間の画素値や特徴点のマッチング結果や、上記センサ部14(加速度センサ・角速度(ジャイロ)センサ、地磁気センサ)の情報などから求めることができる。

さらに制御部11は、追加的に深度情報(DepthMap)を算出することも考えられる。当該深度情報は、時系列の複数フレーム、あるいは上記カメラ16及び17から入力されたステレオ画像のペアなど、複数画像のマッチングから求められる。また、IRセンサによりIRパターンを照射する等、別センサを使う等の手法も適用可能である。

さらに制御部11は、画像から物体を認識したり、GPS情報を利用したりして実環境を認識することも可能である。

続いて制御部11は、実環境の認識結果を基に、広告や地図情報に紐付いた各種情報など、重畳表示するコンテンツ及びその重畳表示の候補領域を、ユーザからのリクエストやコンテキストに応じて決定する(ステップ33)。

重畳表示候補領域の選定にあたり、制御部11は、ユーザの視線を検出してもよい。ユーザの視線は、右カメラ16及び左カメラ17により検出されてもよいし、例えばユーザの瞳孔を検出可能な近赤外LED(Light Emitting Diode)センサ等の専用のセンサまたはそれとカメラとの組み合わせ、その他の光学的・物理的・電気的な手法により検出されてもよい。

続いて制御部11は、重畳表示候補領域の画像を解析し、それが重畳領域として適しているかを判定する(ステップ34)。

具体的には、制御部11は、上記重畳表示候補領域が、動体領域か、テクスチャ領域か、または非平面領域かを検出し(ステップ35)、重畳表示候補領域がそれら3つの条件に合致する場合には、当該領域を候補から除外する(ステップ36)。

動体領域としては、例えば人混みや車の通りなどが相当する。制御部11は、カメラ16及び17の姿勢の変動を差し引いた上で、被写体側に動体が存在しているかを検出することができる。動体領域が重畳表示候補から除外されるのは、視認性の面のみならず安全性の面でも問題があるからである。当該動体領域の検出方法の詳細については後述する。

テクスチャ領域は、輝度分布の起伏変化が激しい領域である。制御部11は、入力画像の矩形領域内での輝度の分散などの分布から、テクスチャが強いかどうか判別することでテクスチャ領域を検出することができる。

制御部11は、例えば重畳表示候補領域の輝度分布の起伏変化が所定の閾値を超えている場合には、当該領域を重畳表示候補から除外する。すなわち、輝度分布の起伏変化が閾値以下の領域を重畳表示領域として検出する。

上述のとおり、HMD100はシースルー眼鏡型のデバイスであり、視認性及び安全性の面から、重畳表示は半透過で行なうことが基本と考えられるため、テクスチャ成分が強い、つまり分散の高い領域への重畳表示は避けられるべきである。

非平面領域は、三次元形状の分布が平坦でない領域である。例えば壁や床、あるいは中空など、形状が平坦な領域は、重畳されるコンテンツがその実世界における形状に沿った形で表示できるため、重畳領域として適している。

非平面領域(平面領域)は、上述のとおり、上記カメラ16及び17のステレオ画像や時系列の複数フレーム等、複数画像のマッチングによるパッシブな深度情報取得手法により検出されてもよいし、センサによるIRパターンの照射等によるアクティブな深度情報取得手法により検出されてもよい。

制御部11は、例えば重畳表示候補領域の三次元形状の分布の起伏変化が所定の閾値(上記テクスチャ領域の閾値とは異なる)を超えている場合には、当該領域を重畳表示候補から除外する。すなわち、三次元計上の分布の起伏変化が閾値以下の領域を重畳表示領域として検出する。

続いて制御部11は、上記判定及び候補領域からの除外後、重畳表示可能な領域が存在するか否かを判定する(ステップ37)。

重畳表示可能な領域が存在すると判定した場合(No)、制御部11は、当該領域を重畳表示領域として決定し、表示部18において、それに関連付けられたコンテンツを生成して、当該領域上に重畳表示する(ステップ39)。

重畳表示可能な領域が存在しないと判定した場合(Yes)、制御部11は、重畳表示候補領域以外の領域であって、上記除外基準に該当しない領域を、重畳表示領域として決定する(ステップ38)。

そして制御部11は、当該候補領域以外の領域にコンテンツを重畳表示する(ステップ39)。この際、制御部11は、例えば除外された候補領域から重畳表示領域にかけて線分を表示したり、除外された候補領域から吹き出し状でコンテンツを表示したりして、領域間の関連付けを示してもよい。

また制御部11は、候補領域以外の重畳表示領域が見つからない場合には、検出されたテクスチャ領域や非平面領域上に、透過度を通常の値よりも下げたコンテンツを重畳表示してもよい。

制御部11は、上記のような各種判定基準により、ユーザにとって視認性が良く、かつ視界を妨げない領域に各種コンテンツを重畳表示することができる。

(動体領域検出処理)

ここで、上記コンテンツ重畳表示処理における動体領域の検出処理の詳細について説明する。図4は、当該動体領域の検出処理の流れを示したフローチャートである。

ここで、上記コンテンツ重畳表示処理における動体領域の検出処理の詳細について説明する。図4は、当該動体領域の検出処理の流れを示したフローチャートである。

上述の通り、本実施形態では、制御部11は、HMD100の自己運動(カメラ16及び17の姿勢の変動)を考慮した上で動体領域を検出する。

同図に示すように、制御部11はまず、カメラ16及び17からの同時刻における複数視点の画像間でマッチングを行なうことで、画素毎に実世界でのZ方向の奥行き、深度分布を算出する(ステップ41)。当該深度分布は所謂Depth Mapに相当する。

また制御部11は、単一のカメラしか有さない場合や2つのカメラのうち一方しか用いない場合でも、当該カメラの焦点距離やセンサのサイズ等の内部パラメータ(Intrinsic Parameter)及びカメラの位置・向きを示すパラメータ(Extrinsic Parameter)を元に射影変換を行なうことで、カメラ画像上の各画素に対応する被写体及び領域が実世界の三次元空間においてどこの座標に位置するかを算出することもできる。

続いて制御部11は、上記Depth Map上での画素を、実世界の三次元空間上にマッピングした点群(3D Point Cloud)を作成する(ステップ42)。

続いて制御部11は、上記ジャイロセンサ、加速度センサ等、センサ部14の各種センサ情報から、自己運動量(三次元の位置及び角度の変動量)を算出する(ステップ43)。この自己運動量は、上記深度分布を算出したフレームの次のフレームにおいて、上記Extrinsic Parameterが変動することに相当する。

続いて制御部11は、直前のフレームにおいて上述の手法で算出した3D Point Cloudを、上記センサ情報から算出した自己運動量における位置・角度に置かれたカメラ上に逆射影してDepth Mapを算出する(ステップ44)。

続いて制御部11は、次フレームにて、同じく上述の手法でDepth Mapを算出する(ステップ45)。

続いて制御部11は、上記ステップ44で算出したDepth Mapと、上記ステップ45で算出したDepth Mapとを、重畳表示候補領域単位で比較する(ステップ46)。

入力画像内の物体が、剛体または静止物体であれば、上記両Depth Mapの差分はほぼ0になるはずである。したがって制御部11は、当該差分がある場合には(ステップ47のYes)、当該差分が存在する領域を動体領域と判別する(ステップ48)。

一方、差分がない場合には(ステップ47のNo)、制御部11は、重畳表示候補領域は動体領域ではないと判別する(ステップ49)。

ここで制御部11は、深度のみならず輝度値の差分も考慮して動体領域か否かを判断することが可能である。

制御部11は、以降も同様に、時系列でのフレーム間比較を逐次行なうことで、動体領域を検出することができる。

以上のように、本実施形態によれば、HMD100は、実環境に応じて、動体領域、テクスチャ領域及び非平面領域を表示領域から除外するように、重畳表示の位置を適用的に制御することで、視認性を向上することができる。

[変形例]

本技術は上述の実施形態にのみ限定されるものではなく、本技術の要旨を逸脱しない範囲内において種々変更され得る。

本技術は上述の実施形態にのみ限定されるものではなく、本技術の要旨を逸脱しない範囲内において種々変更され得る。

上述の実施形態においては、動体領域、テクスチャ領域及び非平面領域が全て重畳表示候補領域から除外されたが、これら3つのうちいずれか1つまたはいずれか2つが除外条件とされてもよい。

例えばHMD100は、非平面領域については、当該非平面形状を検出して、深度情報等を基に、当該非平面形状に沿ってコンテンツを変形させて、当該領域上にコンテンツを重畳表示してもよい。

また例えば、HMD100は、入力画像から、動体領域をあえて重畳表示領域として検出してもよい。この場合、HMD100は、安全性を考慮して、動体領域を重畳表示領域とするのを、ユーザが静止している場合に限ってもよい。

上述の実施形態では、HMD100は、自己運動を考慮した上で被写体が動体かどうか検知した。しかし、HMD100等のグラス型のウェアラブル機器では、ユーザの移動中は安全性を考慮して重畳表示を行なわず、ユーザが立ち止まった際にのみ重畳表示を行なうことで、ユーザの注意及び注視を喚起する、といったユースケースも考えられる。

この場合、HMD100は、動体領域の検出処理を自己静止状態に限定してもよい。これにより、検出処理が簡略化され、処理負荷が軽減される。

すなわち、HMD100は、ジャイロ/加速度センサ等の測定値の結果から、自己運動量が無い(姿勢がほぼ静止している)、いわゆる自己静止状態をまず検出する。そしてHMD100は、自己は静止している状態という前提のもと、時系列の画像間で差分を取るだけで、輝度差分のある画素または領域を、動体領域とみなすことができる。

上述の実施形態では、ステレオカメラを有するシースルー眼鏡型のHMDが本技術に適用された例が示されたが、本技術はこれに限られない。

例えば、同様のウェアラブルデバイスの表示部に網膜プロジェクタが用いられてもよい。また、スマートフォンやタブレット等のカメラで撮像された画像が表示部に表示されさらにコンテンツが重畳表示されることによって上述の実施形態と同様の処理が実現されてもよい。

[その他]

本技術は以下のような構成もとることができる。

(1)

撮像部と、

前記撮像部により撮像された画像からコンテンツの重畳表示候補となる候補領域を検出し、前記候補領域のうち、輝度分布の起伏変化が第1の閾値以下の領域を重畳表示領域として検出し、ユーザに前記重畳表示領域上で仮想的に視認されるように配置される前記コンテンツを生成するように構成された制御部と、

前記生成されたコンテンツを前記重畳表示領域に重畳させて出力するように構成された出力部と

を具備する情報処理装置。

(2)

上記(1)に記載の情報処理装置であって、

前記制御部は、前記候補領域のうち、三次元形状の起伏変化が第2の閾値以下の領域を前記重畳表示領域として検出する

情報処理装置。

(3)

上記(1)に記載の情報処理装置であって、

前記制御部は、前記撮像された画像から、前記候補領域が動体領域であるか否かを検出し、前記動体領域を前記重畳表示領域から除外する

情報処理装置。

(4)

上記(3)に記載の情報処理装置であって、

当該情報処理装置の姿勢を検出するように構成されたセンサをさらに具備し、

前記制御部は、前記センサにより検出された姿勢の変動を検出し、前記撮像された画像から、前記姿勢の変動を差し引いて前記動体領域を検出する

情報処理装置。

(5)

上記(4)に記載の情報処理装置であって、

前記制御部は、前記撮像された画像のうち連続する第1の画像及び第2の画像からそれぞれ第1の深度分布及び第2の深度分布を算出し、前記第1の画像及び第2の画像の時間間隔において検出された前記姿勢の変動量を前記第1の深度分布に反映させて第3の深度分布を算出し、前記第2の深度分布と前記第3の深度分布との差分の有無を検出することで、前記動体領域の有無を検出する

情報処理装置。

(6)

上記(3)に記載の情報処理装置であって、

当該情報処理装置の姿勢を検出するように構成されたセンサをさらに具備し、

前記制御部は、前記センサの検出結果を基に、当該情報処理装置が静止しているか否かを判断し、当該情報処理装置が静止している場合に前記撮像された連続した画像の差分を抽出することで、前記動体領域を検出する

情報処理装置。

(7)

上記(1)に記載の情報処理装置であって、

前記出力部は、前記生成されたコンテンツを前記重畳表示領域に半透過状態で重畳させて出力し、

前記制御部は、前記輝度分布の起伏変化が第1の閾値以下の前記候補領域が検出されない場合、前記生成されたコンテンツの透過度を前記半透過状態よりも下げて重畳させるように前記出力部を制御する

情報処理装置。

(8)

上記(1)に記載の情報処理装置であって、

前記制御部は、前記輝度分布の起伏変化が第1の閾値以下の前記候補領域が検出されない場合、前記コンテンツを、前記候補領域以外の領域に、前記輝度分布の起伏変化が第1の閾値より大きい候補領域と関連付けて表示させるように前記出力部を制御する

情報処理装置。

(9)

上記(1)に記載の情報処理装置であって、

前記制御部は、前記撮像された画像から、動体領域を前記重畳表示領域として検出する

情報処理装置。

本技術は以下のような構成もとることができる。

(1)

撮像部と、

前記撮像部により撮像された画像からコンテンツの重畳表示候補となる候補領域を検出し、前記候補領域のうち、輝度分布の起伏変化が第1の閾値以下の領域を重畳表示領域として検出し、ユーザに前記重畳表示領域上で仮想的に視認されるように配置される前記コンテンツを生成するように構成された制御部と、

前記生成されたコンテンツを前記重畳表示領域に重畳させて出力するように構成された出力部と

を具備する情報処理装置。

(2)

上記(1)に記載の情報処理装置であって、

前記制御部は、前記候補領域のうち、三次元形状の起伏変化が第2の閾値以下の領域を前記重畳表示領域として検出する

情報処理装置。

(3)

上記(1)に記載の情報処理装置であって、

前記制御部は、前記撮像された画像から、前記候補領域が動体領域であるか否かを検出し、前記動体領域を前記重畳表示領域から除外する

情報処理装置。

(4)

上記(3)に記載の情報処理装置であって、

当該情報処理装置の姿勢を検出するように構成されたセンサをさらに具備し、

前記制御部は、前記センサにより検出された姿勢の変動を検出し、前記撮像された画像から、前記姿勢の変動を差し引いて前記動体領域を検出する

情報処理装置。

(5)

上記(4)に記載の情報処理装置であって、

前記制御部は、前記撮像された画像のうち連続する第1の画像及び第2の画像からそれぞれ第1の深度分布及び第2の深度分布を算出し、前記第1の画像及び第2の画像の時間間隔において検出された前記姿勢の変動量を前記第1の深度分布に反映させて第3の深度分布を算出し、前記第2の深度分布と前記第3の深度分布との差分の有無を検出することで、前記動体領域の有無を検出する

情報処理装置。

(6)

上記(3)に記載の情報処理装置であって、

当該情報処理装置の姿勢を検出するように構成されたセンサをさらに具備し、

前記制御部は、前記センサの検出結果を基に、当該情報処理装置が静止しているか否かを判断し、当該情報処理装置が静止している場合に前記撮像された連続した画像の差分を抽出することで、前記動体領域を検出する

情報処理装置。

(7)

上記(1)に記載の情報処理装置であって、

前記出力部は、前記生成されたコンテンツを前記重畳表示領域に半透過状態で重畳させて出力し、

前記制御部は、前記輝度分布の起伏変化が第1の閾値以下の前記候補領域が検出されない場合、前記生成されたコンテンツの透過度を前記半透過状態よりも下げて重畳させるように前記出力部を制御する

情報処理装置。

(8)

上記(1)に記載の情報処理装置であって、

前記制御部は、前記輝度分布の起伏変化が第1の閾値以下の前記候補領域が検出されない場合、前記コンテンツを、前記候補領域以外の領域に、前記輝度分布の起伏変化が第1の閾値より大きい候補領域と関連付けて表示させるように前記出力部を制御する

情報処理装置。

(9)

上記(1)に記載の情報処理装置であって、

前記制御部は、前記撮像された画像から、動体領域を前記重畳表示領域として検出する

情報処理装置。

11…制御部

12…記憶部

13…通信部

14…センサ部

15…操作受付部

16…右カメラ

17…左カメラ

18…表示部

100…HMD(Head Mount Display)

12…記憶部

13…通信部

14…センサ部

15…操作受付部

16…右カメラ

17…左カメラ

18…表示部

100…HMD(Head Mount Display)

Claims (11)

- 撮像部と、

前記撮像部により撮像された画像からコンテンツの重畳表示候補となる候補領域を検出し、前記候補領域のうち、輝度分布の起伏変化が第1の閾値以下の領域を重畳表示領域として検出し、ユーザに前記重畳表示領域上で仮想的に視認されるように配置される前記コンテンツを生成するように構成された制御部と、

前記生成されたコンテンツを前記重畳表示領域に重畳させて出力するように構成された出力部と

を具備する情報処理装置。 - 請求項1に記載の情報処理装置であって、

前記制御部は、前記候補領域のうち、三次元形状の起伏変化が第2の閾値以下の領域を前記重畳表示領域として検出する

情報処理装置。 - 請求項1に記載の情報処理装置であって、

前記制御部は、前記撮像された画像から、前記候補領域が動体領域であるか否かを検出し、前記動体領域を前記重畳表示領域から除外する

情報処理装置。 - 請求項3に記載の情報処理装置であって、

当該情報処理装置の姿勢を検出するように構成されたセンサをさらに具備し、

前記制御部は、前記センサにより検出された姿勢の変動を検出し、前記撮像された画像から、前記姿勢の変動を差し引いて前記動体領域を検出する

情報処理装置。 - 請求項4に記載の情報処理装置であって、

前記制御部は、前記撮像された画像のうち連続する第1の画像及び第2の画像からそれぞれ第1の深度分布及び第2の深度分布を算出し、前記第1の画像及び第2の画像の時間間隔において検出された前記姿勢の変動量を前記第1の深度分布に反映させて第3の深度分布を算出し、前記第2の深度分布と前記第3の深度分布との差分の有無を検出することで、前記動体領域の有無を検出する

情報処理装置。 - 請求項3に記載の情報処理装置であって、

当該情報処理装置の姿勢を検出するように構成されたセンサをさらに具備し、

前記制御部は、前記センサの検出結果を基に、当該情報処理装置が静止しているか否かを判断し、当該情報処理装置が静止している場合に前記撮像された連続した画像の差分を抽出することで、前記動体領域を検出する

情報処理装置。 - 請求項1に記載の情報処理装置であって、

前記出力部は、前記生成されたコンテンツを前記重畳表示領域に半透過状態で重畳させて出力し、

前記制御部は、前記輝度分布の起伏変化が第1の閾値以下の前記候補領域が検出されない場合、前記生成されたコンテンツの透過度を前記半透過状態よりも下げて重畳させるように前記出力部を制御する

情報処理装置。 - 請求項1に記載の情報処理装置であって、

前記制御部は、前記輝度分布の起伏変化が第1の閾値以下の前記候補領域が検出されない場合、前記コンテンツを、前記候補領域以外の領域に、前記輝度分布の起伏変化が第1の閾値より大きい候補領域と関連付けて表示させるように前記出力部を制御する

情報処理装置。 - 請求項1に記載の情報処理装置であって、

前記制御部は、前記撮像された画像から、動体領域を前記重畳表示領域として検出する

情報処理装置。 - 撮像装置により撮像された画像からコンテンツの重畳表示候補となる候補領域を検出し、

前記検出された候補領域のうち、輝度分布の起伏変化が所定の閾値以下の領域を重畳表示領域として検出し、

ユーザに前記重畳表示領域上で仮想的に視認されるように配置される前記コンテンツを生成し、

前記生成されたコンテンツを前記重畳表示領域に重畳させて出力する

情報処理装置。 - 情報処理装置に、

撮像装置により撮像された画像からコンテンツの重畳表示候補となる候補領域を検出するステップと、

前記検出された候補領域のうち、輝度分布の起伏変化が所定の閾値以下の領域を重畳表示領域として検出するステップと、

ユーザに前記重畳表示領域上で仮想的に視認されるように配置される前記コンテンツを生成するステップと、

前記生成されたコンテンツを前記重畳表示領域に重畳させて出力するステップと

を実行させるプログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013255049A JP2015114757A (ja) | 2013-12-10 | 2013-12-10 | 情報処理装置、情報処理方法及びプログラム |

| US14/551,571 US9563981B2 (en) | 2013-12-10 | 2014-11-24 | Information processing apparatus, information processing method, and program |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013255049A JP2015114757A (ja) | 2013-12-10 | 2013-12-10 | 情報処理装置、情報処理方法及びプログラム |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| JP2015114757A true JP2015114757A (ja) | 2015-06-22 |

Family

ID=53271682

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013255049A Pending JP2015114757A (ja) | 2013-12-10 | 2013-12-10 | 情報処理装置、情報処理方法及びプログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US9563981B2 (ja) |

| JP (1) | JP2015114757A (ja) |

Cited By (13)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2017122270A1 (ja) * | 2016-01-12 | 2017-07-20 | サン電子株式会社 | 画像表示装置 |

| JP2017528834A (ja) * | 2014-09-11 | 2017-09-28 | ノキア テクノロジーズ オサケユイチア | 画像を表示するための方法、装置およびコンピュータ・プログラム |

| JP2017174018A (ja) * | 2016-03-22 | 2017-09-28 | Line株式会社 | 表示制御方法、プログラム、及び端末 |

| WO2018020735A1 (ja) * | 2016-07-28 | 2018-02-01 | 株式会社コロプラ | 情報処理方法及び当該情報処理方法をコンピュータに実行させるためのプログラム |

| JP2018116484A (ja) * | 2017-01-18 | 2018-07-26 | 株式会社コロプラ | 情報処理方法及び当該情報処理方法をコンピュータに実行させるためのプログラム |

| JP2018200519A (ja) * | 2017-05-26 | 2018-12-20 | 株式会社テクテック | 拡張現実表示システム、プログラム及び方法 |

| JPWO2017169158A1 (ja) * | 2016-03-29 | 2019-02-07 | ソニー株式会社 | 情報処理装置、情報処理方法、およびプログラム |

| JPWO2017187708A1 (ja) * | 2016-04-26 | 2019-02-28 | ソニー株式会社 | 情報処理装置、情報処理方法、及びプログラム |

| WO2020157995A1 (ja) * | 2019-01-28 | 2020-08-06 | 株式会社メルカリ | プログラム、情報処理方法、及び情報処理端末 |

| JP2022007185A (ja) * | 2020-06-25 | 2022-01-13 | 株式会社トプコン | アイウェア表示システム |

| JP2022121592A (ja) * | 2017-04-19 | 2022-08-19 | マジック リープ, インコーポレイテッド | ウェアラブルシステムのためのマルチモード実行およびテキスト編集 |

| US12051167B2 (en) | 2016-03-31 | 2024-07-30 | Magic Leap, Inc. | Interactions with 3D virtual objects using poses and multiple-DOF controllers |

| US12474788B2 (en) | 2015-10-20 | 2025-11-18 | Magic Leap, Inc. | Selecting virtual objects in a three-dimensional space |

Families Citing this family (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| GB2532464B (en) * | 2014-11-19 | 2020-09-02 | Bae Systems Plc | Apparatus and method for selectively displaying an operational environment |

| GB2532465B (en) | 2014-11-19 | 2021-08-11 | Bae Systems Plc | Interactive control station |

| WO2016135473A1 (en) | 2015-02-25 | 2016-09-01 | Bae Systems Plc | Apparatus and method for effecting a control action in respect of system functions |

| KR20160121287A (ko) * | 2015-04-10 | 2016-10-19 | 삼성전자주식회사 | 이벤트에 기반하여 화면을 디스플레이하는 방법 및 장치 |

| US10304203B2 (en) * | 2015-05-14 | 2019-05-28 | Qualcomm Incorporated | Three-dimensional model generation |

| US9852550B2 (en) * | 2015-08-05 | 2017-12-26 | Civic Resource Group International Inc. | System and method of markerless injection of ads in AR |

| CA2927046A1 (en) * | 2016-04-12 | 2017-10-12 | 11 Motion Pictures Limited | Method and system for 360 degree head-mounted display monitoring between software program modules using video or image texture sharing |

| EP3430595B1 (en) * | 2017-05-23 | 2020-10-28 | Brainlab AG | Determining the relative position between a point cloud generating camera and another camera |

| WO2019026392A1 (ja) * | 2017-07-31 | 2019-02-07 | ソニー株式会社 | 情報処理装置、情報処理方法、およびプログラム |

| US11120593B2 (en) | 2019-05-24 | 2021-09-14 | Rovi Guides, Inc. | Systems and methods for dynamic visual adjustments for a map overlay |

| US11674818B2 (en) | 2019-06-20 | 2023-06-13 | Rovi Guides, Inc. | Systems and methods for dynamic transparency adjustments for a map overlay |

Family Cites Families (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2011252879A (ja) | 2010-06-04 | 2011-12-15 | Aisin Aw Co Ltd | 表示画像生成装置、表示画像生成方法および表示画像生成プログラム |

| WO2013044983A1 (en) * | 2011-09-30 | 2013-04-04 | Layar B.V. | Feedback to user for indicating augmentability of an image |

| EP2704055A1 (en) * | 2012-08-31 | 2014-03-05 | Layar B.V. | Determining space to display content in augmented reality |

| WO2015029318A1 (ja) * | 2013-08-26 | 2015-03-05 | パナソニックIpマネジメント株式会社 | 3次元表示装置および3次元表示方法 |

-

2013

- 2013-12-10 JP JP2013255049A patent/JP2015114757A/ja active Pending

-

2014

- 2014-11-24 US US14/551,571 patent/US9563981B2/en active Active

Cited By (26)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2017528834A (ja) * | 2014-09-11 | 2017-09-28 | ノキア テクノロジーズ オサケユイチア | 画像を表示するための方法、装置およびコンピュータ・プログラム |

| US10916057B2 (en) | 2014-09-11 | 2021-02-09 | Nokia Technologies Oy | Method, apparatus and computer program for displaying an image of a real world object in a virtual reality enviroment |

| US12474788B2 (en) | 2015-10-20 | 2025-11-18 | Magic Leap, Inc. | Selecting virtual objects in a three-dimensional space |

| WO2017122270A1 (ja) * | 2016-01-12 | 2017-07-20 | サン電子株式会社 | 画像表示装置 |

| JPWO2017122270A1 (ja) * | 2016-01-12 | 2018-10-11 | サン電子株式会社 | 画像表示装置 |

| JP2017174018A (ja) * | 2016-03-22 | 2017-09-28 | Line株式会社 | 表示制御方法、プログラム、及び端末 |

| JPWO2017169158A1 (ja) * | 2016-03-29 | 2019-02-07 | ソニー株式会社 | 情報処理装置、情報処理方法、およびプログラム |

| US12406454B2 (en) | 2016-03-31 | 2025-09-02 | Magic Leap, Inc. | Interactions with 3D virtual objects using poses and multiple-dof controllers |

| US12051167B2 (en) | 2016-03-31 | 2024-07-30 | Magic Leap, Inc. | Interactions with 3D virtual objects using poses and multiple-DOF controllers |

| JPWO2017187708A1 (ja) * | 2016-04-26 | 2019-02-28 | ソニー株式会社 | 情報処理装置、情報処理方法、及びプログラム |

| US11017257B2 (en) | 2016-04-26 | 2021-05-25 | Sony Corporation | Information processing device, information processing method, and program |

| JP7092028B2 (ja) | 2016-04-26 | 2022-06-28 | ソニーグループ株式会社 | 情報処理装置、情報処理方法、及びプログラム |

| WO2018020735A1 (ja) * | 2016-07-28 | 2018-02-01 | 株式会社コロプラ | 情報処理方法及び当該情報処理方法をコンピュータに実行させるためのプログラム |

| JP2018116484A (ja) * | 2017-01-18 | 2018-07-26 | 株式会社コロプラ | 情報処理方法及び当該情報処理方法をコンピュータに実行させるためのプログラム |

| JP2022121592A (ja) * | 2017-04-19 | 2022-08-19 | マジック リープ, インコーポレイテッド | ウェアラブルシステムのためのマルチモード実行およびテキスト編集 |

| US11960636B2 (en) | 2017-04-19 | 2024-04-16 | Magic Leap, Inc. | Multimodal task execution and text editing for a wearable system |

| JP7336005B2 (ja) | 2017-04-19 | 2023-08-30 | マジック リープ, インコーポレイテッド | ウェアラブルシステムのためのマルチモード実行およびテキスト編集 |

| US11017235B2 (en) | 2017-05-26 | 2021-05-25 | Dwango Co., Ltd. | Augmented reality display system, program, and method |

| US10839218B2 (en) | 2017-05-26 | 2020-11-17 | Dwango Co., Ltd. | Augmented reality display system, program, and method |

| JP2018200519A (ja) * | 2017-05-26 | 2018-12-20 | 株式会社テクテック | 拡張現実表示システム、プログラム及び方法 |

| JP7296406B2 (ja) | 2019-01-28 | 2023-06-22 | 株式会社メルカリ | プログラム、情報処理方法、及び情報処理端末 |

| US11734898B2 (en) | 2019-01-28 | 2023-08-22 | Mercari, Inc. | Program, information processing method, and information processing terminal |

| JPWO2020157995A1 (ja) * | 2019-01-28 | 2021-10-28 | 株式会社メルカリ | プログラム、情報処理方法、及び情報処理端末 |

| WO2020157995A1 (ja) * | 2019-01-28 | 2020-08-06 | 株式会社メルカリ | プログラム、情報処理方法、及び情報処理端末 |

| JP2022007185A (ja) * | 2020-06-25 | 2022-01-13 | 株式会社トプコン | アイウェア表示システム |

| JP7502914B2 (ja) | 2020-06-25 | 2024-06-19 | 株式会社トプコン | アイウェア表示システムおよびアイウェア表示方法 |

Also Published As

| Publication number | Publication date |

|---|---|

| US9563981B2 (en) | 2017-02-07 |

| US20150161762A1 (en) | 2015-06-11 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2015114757A (ja) | 情報処理装置、情報処理方法及びプログラム | |

| JP7596303B2 (ja) | パススルー画像処理によるヘッドマウントディスプレイ | |

| CN110998666B (zh) | 信息处理装置、信息处理方法以及程序 | |

| EP3195595B1 (en) | Technologies for adjusting a perspective of a captured image for display | |

| US20200341284A1 (en) | Information processing apparatus, information processing method, and recording medium | |

| KR20230017849A (ko) | 증강 현실 안내 | |

| JP6558839B2 (ja) | 媒介現実 | |

| US20180174366A1 (en) | Information processing apparatus, information processing method, and program | |

| US10999412B2 (en) | Sharing mediated reality content | |

| US9979946B2 (en) | I/O device, I/O program, and I/O method | |

| US9933853B2 (en) | Display control device, display control program, and display control method | |

| US11024040B2 (en) | Dynamic object tracking | |

| US20110149043A1 (en) | Device and method for displaying three-dimensional images using head tracking | |

| WO2015200406A1 (en) | Digital action in response to object interaction | |

| US11004273B2 (en) | Information processing device and information processing method | |

| US20190064528A1 (en) | Information processing device, information processing method, and program | |

| TWI453462B (zh) | 智慧型電子裝置之虛擬望遠系統及其方法 | |

| KR20230029923A (ko) | 롤링 셔터 카메라들을 사용하는 시각적 관성 추적 | |

| US11227494B1 (en) | Providing transit information in an augmented reality environment | |

| US10171800B2 (en) | Input/output device, input/output program, and input/output method that provide visual recognition of object to add a sense of distance | |

| US20140049540A1 (en) | Image Processing Device, Method, Computer Program Product, and Stereoscopic Image Display Device | |

| US20170300121A1 (en) | Input/output device, input/output program, and input/output method | |

| US10642349B2 (en) | Information processing apparatus | |

| KR20210102210A (ko) | 상호 작용을 위한 물리적 인터페이스로서의 모바일 플랫폼 | |

| JP6365879B2 (ja) | 表示制御装置、表示制御方法、表示制御プログラム、および投影装置 |