JP2012515966A - 物体の挙動を監視するためのデバイスおよび方法 - Google Patents

物体の挙動を監視するためのデバイスおよび方法 Download PDFInfo

- Publication number

- JP2012515966A JP2012515966A JP2011547053A JP2011547053A JP2012515966A JP 2012515966 A JP2012515966 A JP 2012515966A JP 2011547053 A JP2011547053 A JP 2011547053A JP 2011547053 A JP2011547053 A JP 2011547053A JP 2012515966 A JP2012515966 A JP 2012515966A

- Authority

- JP

- Japan

- Prior art keywords

- data

- behavior

- coordinate system

- measurement data

- approximate representation

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/041—Digitisers, e.g. for touch screens or touch pads, characterised by the transducing means

- G06F3/044—Digitisers, e.g. for touch screens or touch pads, characterised by the transducing means by capacitive means

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/041—Digitisers, e.g. for touch screens or touch pads, characterised by the transducing means

- G06F3/046—Digitisers, e.g. for touch screens or touch pads, characterised by the transducing means by electromagnetic means

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F2203/00—Indexing scheme relating to G06F3/00 - G06F3/048

- G06F2203/048—Indexing scheme relating to G06F3/048

- G06F2203/04808—Several contacts: gestures triggering a specific function, e.g. scrolling, zooming, right-click, when the user establishes several contacts with the surface simultaneously; e.g. using several fingers or a combination of fingers and pen

Abstract

Description

が差し挟まれている。表示(変換)データ506内の仮想点の位置関係は、センシング表面の付近の物体の部分/点(すなわち、本発明の例における実際の指と他の手の部分)の間の位置関係に対応する。

Vcap=V・jXc/(jXc+R)

によって与えられ、Xcはコンデンサのインピーダンスである。

Vcap=V・[d/sqrt(d2+(2π・F・R・ε0・A)2]

に展開できる。

10 監視ユニット

12 データ入力モジュール

14 デジタルシグナルプロセッサ

16 測定データ

18 変換モジュール

20 出力データ

30 デバイス

32 近接センサマトリックス

40 ホスト電子システム

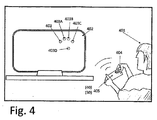

41A コンピュータデバイス

41B 表示ユニット

42 データ入力ユニット

601 ユーザの指

603 パッド

604 コンデンサ

611 励起源(電源)

612 送信機パッド

613 受信機パッド

614 電気力線

701 2Dセンサマトリックス配置構成

702 アナログ増幅器

703 アナログ/デジタルコンバータ

704 CPU

705 送信機

706 センシングパッド

707 AC電源信号

811 電圧信号

812 センシング表面(例えば、単一パッドのセンシング表面)

813 電気力線

817 空間領域

819 セグメント

821 位置逸脱

851、855 電源ユニット

853 電界

854 フレーム

855 電圧源

901 センシングパッド

902 スイッチ

903 単一のインターフェイス

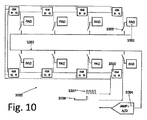

1001 配線

1003 スイッチ

1004 共通インターフェイス

1005 Dフリップフロップ

1006 パルス

1007 クロックパルス

1020 第1のDフリップフロップ

Claims (36)

- 対象物の少なくとも一部の挙動を監視するための方法であって、

(a)所定のセンシング表面に対する対象物の挙動を示す測定データを用意する段階と、

(b)前記センシング表面に対する前記対象物の挙動を示す前記測定データを処理し、それを仮想座標系内の前記挙動の近似的表現に変換する段階と、

を含み、

前記変換は、仮想点と、前記対象物の対応する部分と、の間の位置関係を維持していることを特徴とする方法。 - 前記近似的表現を示すデータを、前記仮想座標系の遠隔位置に伝送する段階を含むことを特徴とする請求項1に記載の方法。

- 前記測定データを、前記仮想座標系の遠隔位置に伝送し、これにより前記測定データの前記処理結果を前記遠隔位置における前記近似的表現にすることを可能にする段階を含むことを特徴とする請求項1に記載の方法。

- 前記伝送は、IR、Bluetooth、無線周波(RF)、および音響伝達のうちの少なくとも1つを含む無線信号伝送を含むことを特徴とする請求項2または3に記載の方法。

- 前記所定のセンシング表面は、近接センサマトリックスの表面であることを特徴とする請求項1から4のいずれか一項に記載の方法。

- 前記近似的表現を示すデータを、特定の電子デバイスに入力されるデータの所定のフォーマットに整形する段階を含むことを特徴とする請求項1から5のいずれか一項に記載の方法。

- 前記挙動を示す前記データは、前記所定のセンシング表面に対する前記対象物の前記部分の位置を含むことを特徴とする請求項1から6のいずれか一項に記載の方法。

- 前記挙動を示す前記データは、前記所定のセンシング表面に対する前記対象物の部分の位置の変化を含むことを特徴とする請求項1から7のいずれか一項に記載の方法。

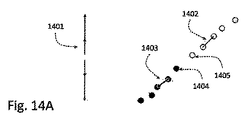

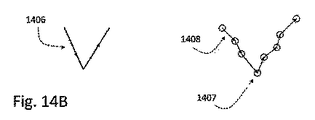

- 前記挙動を示す前記データは、前記所定のセンシング表面に対する前記対象物の部分の運動パターンを含むことを特徴とする請求項1から8のいずれか一項に記載の方法。

- 前記対象物の少なくとも一部の前記挙動を示すデータを用意する段階は、連続検出モードおよびサンプリング検出モードの一方または両方の組み合わせのいずれかを使用して前記物体の前記少なくとも一部の前記位置を検出する段階を含むことを特徴とする請求項8または9に記載の方法。

- 前記測定データは、三次元空間内の前記挙動を示すことを特徴とする請求項1から10のいずれか一項に記載の方法。

- 前記近似的表現は、前記三次元座標系内の前記対象物の前記少なくとも一部の前記挙動に対応することを特徴とする請求項1から11のいずれか一項に記載の方法。

- 前記変換は、前記仮想点のそれぞれと前記対象物の前記少なくとも一部の前記対応する部分のそれぞれとの間の距離を示すデータを決定する段階を含むことを特徴とする請求項1から12のいずれか一項に記載の方法。

- 前記対象物の前記少なくとも一部を識別し、それにより前記測定データを生成できるようにする段階を含むことを特徴とする請求項1から13のいずれか一項に記載の方法。

- 前記近接センサマトリックスの付近のノイズエネルギーを識別する段階と、

それに応じて前記近接センサマトリックスを操作する段階と、

を含むことを特徴とする請求項5から14のいずれか一項に記載の方法。 - 前記ノイズエネルギーは、周波数が前記近接センサマトリックスの動作周波数範囲内にあるか、または少なくとも部分的に重なり合うことによって識別され、

前記ノイズエネルギーを識別した後の前記近接センサマトリックスの動作は、前記近接センサマトリックスによる測定を妨げる段階または前記範囲を外れるように前記動作周波数をシフトする段階のいずれかを含むことを特徴とする請求項15に記載の方法。 - 前記対象物は、人体の少なくとも一部に関連付けられることを特徴とする請求項1から15のいずれか一項に記載の方法。

- 前記対象物は、人の少なくとも一方の手の複数の指に関連付けられることを特徴とする請求項17に記載の方法。

- 前記対象物は、人の手または指の少なくとも一部から所定の位置の人体の一部を含むことを特徴とする請求項17に記載の方法。

- 前記近似的表現は、前記対象物の前記少なくとも一部の形状を示すデータを含むことを特徴とする請求項1から19のいずれか一項に記載の方法。

- 前記近似的表現は、前記対象物の前記少なくとも一部に対応するパターンを示すデータを含むことを特徴とする請求項1から20のいずれか一項に記載の方法。

- 前記近似的表現は、前記対象物の前記少なくとも一部の色調を示すデータを含むことを特徴とする請求項1から21のいずれか一項に記載の方法。

- 前記近似的表現は、前記対象物の前記少なくとも一部の透明度レベルを示すデータを含むことを特徴とする請求項1から22のいずれか一項に記載の方法。

- 前記遠隔位置における前記座標系は、表示ユニットに関連付けられることを特徴とする請求項4から23のいずれか一項に記載のシステム。

- 前記測定データを用意する段階は、前記対象物の少なくとも一部の位置が前記センシング表面に対して変化する経路を示すデータを取得する段階を含むことを特徴とする請求項1から23のいずれか一項に記載の方法。

- 対象物の少なくとも一部の挙動を監視する際に使用するための監視ユニットであって、

所定のセンシング表面に関連付けられている特定の座標系内の前記対象物の少なくとも一部の挙動を示す測定データを受信するように構成されたデータ入力モジュールと、

前記変換が仮想点と前記対象物の前記少なくとも一部の中の対応する部分との間の位置関係を維持されるように、前記測定データに応答し前記測定データを前記対象物の少なくとも一部分の近似的表現に変換し仮想座標系内に置くように構成され、かつそのように動作可能であり、それにより前記近似的表現を特定の電子デバイスに入力されるデータの所定のフォーマットに整形することを可能にするデジタルシグナルプロセッサと、

を備えることを特徴とする監視ユニット。 - 対象物の挙動を監視する際に使用するためのデバイスであって、

請求項22に記載の前記監視ユニットと、

前記監視ユニットの前記入力データモジュールにリンクされ、前記センシング表面および前記特定の座標系を画定し、前記特定の座標系内の前記対象物の前記少なくとも一部の前記挙動を示す前記測定データを生成するように構成され、かつそのように動作可能である位置センサデバイスと、

を備えることを特徴とするデバイス。 - 前記位置センサデバイスは、接触モードと非接触モードのうちの一方またはその両方の組み合わせで前記測定データを生成することができる近接センサマトリックスを備えることを特徴とする請求項27に記載のデバイス。

- 前記対象物の少なくとも一部の前記表現を示すデータを前記仮想座標系の遠隔位置に伝送するように構成された送信機ユニットを備え、

前記データは、IRモード、Bluetoothモード、RFモード、および音響伝達モードのうちの少なくとも1つで伝送されることを特徴とする請求項27または28に記載のデバイス。 - 前記デジタルシグナルプロセッサの出力に接続可能であり、かつ、前記近似的表現を示すデータを受信し、前記データを特定の電子デバイスに入力されるデータの所定のフォーマットに変換するように構成されるとともにそのように動作可能であるフォーマッタユーティリティを備えることを特徴とする請求項27から29のいずれか一項に記載のデバイス。

- 前記送信機ユニットの出力に接続可能であり、かつ、前記近似的表現を示すデータを受信し、前記データを特定の電子デバイスに入力されるデータの所定のフォーマットに変換するように構成されるとともにそのように動作可能であるフォーマッタユーティリティを備えることを特徴とする請求項27から29のいずれか一項に記載のデバイス。

- 前記近接センサマトリックスは、前記挙動の近似的表現が適用される電子デバイスのキーパッドに関連付けられ、

前記測定データは、前記キーパッドの記号に対してユーザの指の前記挙動を示すことを特徴とする請求項28から31のいずれか一項に記載のデバイス。 - 対象物の挙動を監視する際に使用するためのデバイスであって、

請求項26に記載の前記監視ユニットと、

前記仮想座標系を定義するように構成されるデータ入力ユニットと、

を備え、

前記データ入力ユニットは、前記近似的表現を示すデータを受信するために前記デジタルシグナルプロセッサの出力にリンクされることを特徴とするデバイス。 - 前記デジタルシグナルプロセッサの前記出力と前記データ入力ユニットとの間に相互接続され、前記近似的表現を示すデータを受信し、前記データを前記データ入力ユニットに入力されるデータの所定のフォーマットに変換するように構成され、かつそのように動作可能であるフォーマッタユーティリティを備えることを特徴とする請求項33に記載のシステム。

- 前記センシング表面に対する前記挙動を示すとともに、IRデータ、Bluetoothデータ、RFデータ、および音響データのうちの少なくとも1つの形式である、前記測定データを受信し、前記デジタルシグナルプロセッサに入力される対応するデータを生成するように構成された信号受信機ユニットを備えることを特徴とする請求項33または34に記載のシステム。

- 対象物の少なくとも一部の挙動を監視するためのシステムであって、

(a)センシング表面および第1の座標系を定義し、前記特定の座標系内の前記センシング表面に対して前記対象物の少なくとも一部の前記挙動を示す測定データを生成するように構成され、かつそのように動作可能である位置センサデバイスと、

(b)第2の座標系を定義するデータ提示デバイスと、

(c)前記位置センサデバイスと前記データ提示デバイスとの間で相互リンクされ、前記変換が仮想点と前記対象物の前記少なくとも一部の中の対応する部分との間の位置関係を維持するように、前記測定データに応答し前記測定データを前記対象物の前記少なくとも一部の近似的表現に変換し前記第2の仮想座標系内に置くように構成され、かつそのように動作可能であるデジタルシグナルプロセッサと、

を備えることを特徴とするシステム。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US14735709P | 2009-01-26 | 2009-01-26 | |

| US61/147,357 | 2009-01-26 | ||

| PCT/IL2010/000063 WO2010084498A1 (en) | 2009-01-26 | 2010-01-26 | Device and method for monitoring an object's behavior |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2012515966A true JP2012515966A (ja) | 2012-07-12 |

| JP2012515966A5 JP2012515966A5 (ja) | 2013-03-14 |

Family

ID=42112202

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2011547053A Pending JP2012515966A (ja) | 2009-01-26 | 2010-01-26 | 物体の挙動を監視するためのデバイスおよび方法 |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US8830189B2 (ja) |

| EP (1) | EP2389622A1 (ja) |

| JP (1) | JP2012515966A (ja) |

| KR (1) | KR20110132349A (ja) |

| CN (1) | CN102334086A (ja) |

| WO (1) | WO2010084498A1 (ja) |

Cited By (13)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2012533122A (ja) * | 2009-07-10 | 2012-12-20 | アップル インコーポレイテッド | タッチ及びホバー感知 |

| JP2013539113A (ja) * | 2010-08-24 | 2013-10-17 | クアルコム,インコーポレイテッド | 電子デバイスディスプレイの上方の空気中で物体を移動させることによって電子デバイスアプリケーションと相互作用するための方法および装置 |

| JP2014219768A (ja) * | 2013-05-02 | 2014-11-20 | 船井電機株式会社 | 情報処理装置及び情報処理システム |

| JP2015011679A (ja) * | 2013-07-02 | 2015-01-19 | シャープ株式会社 | 操作入力装置及び入力操作処理方法 |

| JP2016509304A (ja) * | 2013-08-13 | 2016-03-24 | サムスン エレクトロニクス カンパニー リミテッド | 相互作用感知 |

| JP2016529615A (ja) * | 2013-08-30 | 2016-09-23 | クゥアルコム・インコーポレイテッドQualcomm Incorporated | タッチセンサデータの改善された処理のためのシステム及び方法 |

| JP2017516186A (ja) * | 2014-03-14 | 2017-06-15 | 株式会社ソニー・インタラクティブエンタテインメント | 空間感知を備えるゲーム機 |

| JP2017220140A (ja) * | 2016-06-10 | 2017-12-14 | 三菱電機株式会社 | 表示装置 |

| US9921689B2 (en) | 2014-12-04 | 2018-03-20 | Fujitsu Limited | Information processing method, information processing apparatus, and storage medium |

| US10042446B2 (en) | 2013-08-13 | 2018-08-07 | Samsung Electronics Company, Ltd. | Interaction modes for object-device interactions |

| KR20200019666A (ko) * | 2017-06-16 | 2020-02-24 | 밸브 코포레이션 | 손가락 움직임 감지 기능을 갖춘 전자 제어기 |

| US11625898B2 (en) | 2016-10-11 | 2023-04-11 | Valve Corporation | Holding and releasing virtual objects |

| US11786809B2 (en) | 2016-10-11 | 2023-10-17 | Valve Corporation | Electronic controller with finger sensing and an adjustable hand retainer |

Families Citing this family (109)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US7110525B1 (en) | 2001-06-25 | 2006-09-19 | Toby Heller | Agent training sensitive call routing system |

| US20060152482A1 (en) * | 2005-01-07 | 2006-07-13 | Chauncy Godwin | Virtual interface and control device |

| WO2008095132A2 (en) * | 2007-01-31 | 2008-08-07 | Perceptive Pixel, Inc. | Methods of interfacing with multi-point input devices and multi-point input systems employing interfacing techniques |

| US8065624B2 (en) * | 2007-06-28 | 2011-11-22 | Panasonic Corporation | Virtual keypad systems and methods |

| DE202007017303U1 (de) * | 2007-08-20 | 2008-04-10 | Ident Technology Ag | Computermaus |

| US9035876B2 (en) | 2008-01-14 | 2015-05-19 | Apple Inc. | Three-dimensional user interface session control |

| US8933876B2 (en) | 2010-12-13 | 2015-01-13 | Apple Inc. | Three dimensional user interface session control |

| KR20110132349A (ko) | 2009-01-26 | 2011-12-07 | 지로 테크놀로지스 (2009) 엘티디. | 객체의 거동을 모니터링하는 장치 및 방법 |

| US8325181B1 (en) * | 2009-04-01 | 2012-12-04 | Perceptive Pixel Inc. | Constraining motion in 2D and 3D manipulation |

| KR101484826B1 (ko) * | 2009-08-25 | 2015-01-20 | 구글 잉크. | 직접적인 조작 제스처들 |

| CN102959616B (zh) | 2010-07-20 | 2015-06-10 | 苹果公司 | 自然交互的交互真实性增强 |

| US9201501B2 (en) | 2010-07-20 | 2015-12-01 | Apple Inc. | Adaptive projector |

| JP5569271B2 (ja) | 2010-09-07 | 2014-08-13 | ソニー株式会社 | 情報処理装置、情報処理方法およびプログラム |

| WO2012032515A1 (en) | 2010-09-07 | 2012-03-15 | Zrro Technologies (2009) Ltd. | Device and method for controlling the behavior of virtual objects on a display |

| US9092089B2 (en) | 2010-09-15 | 2015-07-28 | Advanced Silicon Sa | Method for detecting an arbitrary number of touches from a multi-touch device |

| JP5693729B2 (ja) * | 2010-09-15 | 2015-04-01 | アドヴァンスト・シリコン・ソシエテ・アノニム | マルチタッチ装置から任意の数のタッチを検出する方法 |

| US8959013B2 (en) * | 2010-09-27 | 2015-02-17 | Apple Inc. | Virtual keyboard for a non-tactile three dimensional user interface |

| US9569003B2 (en) * | 2010-09-30 | 2017-02-14 | Broadcom Corporation | Portable computing device including a three-dimensional touch screen |

| KR20120051208A (ko) * | 2010-11-12 | 2012-05-22 | 엘지전자 주식회사 | 멀티미디어 장치의 사물을 이용한 제스쳐 인식 방법 및 장치 |

| US8872762B2 (en) | 2010-12-08 | 2014-10-28 | Primesense Ltd. | Three dimensional user interface cursor control |

| US8421752B2 (en) * | 2011-01-27 | 2013-04-16 | Research In Motion Limited | Portable electronic device and method therefor |

| JP5519546B2 (ja) * | 2011-01-31 | 2014-06-11 | パナソニック株式会社 | 手書き文字入力装置 |

| WO2012107892A2 (en) | 2011-02-09 | 2012-08-16 | Primesense Ltd. | Gaze detection in a 3d mapping environment |

| JP5095021B2 (ja) | 2011-04-04 | 2012-12-12 | シャープ株式会社 | 表示装置、情報処理システム、プログラム及びテレビジョン受信機 |

| KR101789683B1 (ko) * | 2011-06-13 | 2017-11-20 | 삼성전자주식회사 | 디스플레이 장치 및 그의 제어 방법, 그리고 리모컨 장치 |

| US8881051B2 (en) | 2011-07-05 | 2014-11-04 | Primesense Ltd | Zoom-based gesture user interface |

| US9459758B2 (en) | 2011-07-05 | 2016-10-04 | Apple Inc. | Gesture-based interface with enhanced features |

| US9377865B2 (en) | 2011-07-05 | 2016-06-28 | Apple Inc. | Zoom-based gesture user interface |

| US9030498B2 (en) | 2011-08-15 | 2015-05-12 | Apple Inc. | Combining explicit select gestures and timeclick in a non-tactile three dimensional user interface |

| US9122311B2 (en) | 2011-08-24 | 2015-09-01 | Apple Inc. | Visual feedback for tactile and non-tactile user interfaces |

| US9218063B2 (en) | 2011-08-24 | 2015-12-22 | Apple Inc. | Sessionless pointing user interface |

| US9904646B2 (en) | 2011-09-27 | 2018-02-27 | Microchip Technology Incorporated | Virtual general purpose input/output for a microcontroller |

| WO2013049861A1 (en) | 2011-09-29 | 2013-04-04 | Magic Leap, Inc. | Tactile glove for human-computer interaction |

| WO2013051054A1 (ja) * | 2011-10-03 | 2013-04-11 | 古野電気株式会社 | タッチパネルを有する装置、レーダ装置、プロッタ装置、舶用ネットワークシステム、情報表示方法及び情報表示プログラム |

| US20130088434A1 (en) * | 2011-10-06 | 2013-04-11 | Sony Ericsson Mobile Communications Ab | Accessory to improve user experience with an electronic display |

| US20130104039A1 (en) * | 2011-10-21 | 2013-04-25 | Sony Ericsson Mobile Communications Ab | System and Method for Operating a User Interface on an Electronic Device |

| US9323379B2 (en) * | 2011-12-09 | 2016-04-26 | Microchip Technology Germany Gmbh | Electronic device with a user interface that has more than two degrees of freedom, the user interface comprising a touch-sensitive surface and contact-free detection means |

| US20130155010A1 (en) * | 2011-12-14 | 2013-06-20 | Microchip Technology Incorporated | Capacitive Proximity Based Gesture Input System |

| US8693731B2 (en) | 2012-01-17 | 2014-04-08 | Leap Motion, Inc. | Enhanced contrast for object detection and characterization by optical imaging |

| US11493998B2 (en) | 2012-01-17 | 2022-11-08 | Ultrahaptics IP Two Limited | Systems and methods for machine control |

| US10691219B2 (en) | 2012-01-17 | 2020-06-23 | Ultrahaptics IP Two Limited | Systems and methods for machine control |

| US8638989B2 (en) | 2012-01-17 | 2014-01-28 | Leap Motion, Inc. | Systems and methods for capturing motion in three-dimensional space |

| US9501152B2 (en) | 2013-01-15 | 2016-11-22 | Leap Motion, Inc. | Free-space user interface and control using virtual constructs |

| US9679215B2 (en) | 2012-01-17 | 2017-06-13 | Leap Motion, Inc. | Systems and methods for machine control |

| US9229534B2 (en) | 2012-02-28 | 2016-01-05 | Apple Inc. | Asymmetric mapping for tactile and non-tactile user interfaces |

| US20130241854A1 (en) * | 2012-03-06 | 2013-09-19 | Industry-University Cooperation Foundation Hanyang University | Image sharing system and user terminal for the system |

| US20130244730A1 (en) * | 2012-03-06 | 2013-09-19 | Industry-University Cooperation Foundation Hanyang University | User terminal capable of sharing image and method for controlling the same |

| CN104246682B (zh) | 2012-03-26 | 2017-08-25 | 苹果公司 | 增强的虚拟触摸板和触摸屏 |

| US8698746B1 (en) * | 2012-04-24 | 2014-04-15 | Google Inc. | Automatic calibration curves for a pointing device |

| WO2013177761A1 (zh) * | 2012-05-30 | 2013-12-05 | 华为技术有限公司 | 显示控制方法和装置 |

| KR20130137989A (ko) * | 2012-06-08 | 2013-12-18 | 엘지이노텍 주식회사 | 근접센서를 구비한 터치윈도우 |

| US9507462B2 (en) * | 2012-06-13 | 2016-11-29 | Hong Kong Applied Science and Technology Research Institute Company Limited | Multi-dimensional image detection apparatus |

| US9829996B2 (en) * | 2012-06-25 | 2017-11-28 | Zspace, Inc. | Operations in a three dimensional display system |

| WO2014003796A1 (en) * | 2012-06-30 | 2014-01-03 | Hewlett-Packard Development Company, L.P. | Virtual hand based on combined data |

| TWI498771B (zh) * | 2012-07-06 | 2015-09-01 | Pixart Imaging Inc | 可辨識手勢動作的眼鏡 |

| KR101913817B1 (ko) * | 2012-08-29 | 2018-10-31 | 삼성전자주식회사 | 터치스크린 입력 처리 방법 및 장치 |

| WO2014041548A1 (en) * | 2012-09-13 | 2014-03-20 | Zrro Technologies (2009) Ltd. | System and method for controlling behavior of a cursor |

| WO2014047944A1 (en) * | 2012-09-29 | 2014-04-03 | Siemens Aktiengesellschaft | system and method for improving manufacturing production |

| GB2506862B (en) * | 2012-10-09 | 2015-08-12 | Novalia Ltd | Book |

| US9285893B2 (en) | 2012-11-08 | 2016-03-15 | Leap Motion, Inc. | Object detection and tracking with variable-field illumination devices |

| US8829926B2 (en) * | 2012-11-19 | 2014-09-09 | Zrro Technologies (2009) Ltd. | Transparent proximity sensor |

| US10609285B2 (en) | 2013-01-07 | 2020-03-31 | Ultrahaptics IP Two Limited | Power consumption in motion-capture systems |

| US9465461B2 (en) | 2013-01-08 | 2016-10-11 | Leap Motion, Inc. | Object detection and tracking with audio and optical signals |

| US9459697B2 (en) | 2013-01-15 | 2016-10-04 | Leap Motion, Inc. | Dynamic, free-space user interactions for machine control |

| JP5495406B2 (ja) * | 2013-01-25 | 2014-05-21 | パナソニック株式会社 | 入力装置および入力方法 |

| US9720504B2 (en) * | 2013-02-05 | 2017-08-01 | Qualcomm Incorporated | Methods for system engagement via 3D object detection |

| US20140282269A1 (en) * | 2013-03-13 | 2014-09-18 | Amazon Technologies, Inc. | Non-occluded display for hover interactions |

| US9702977B2 (en) | 2013-03-15 | 2017-07-11 | Leap Motion, Inc. | Determining positional information of an object in space |

| US9146633B1 (en) * | 2013-03-15 | 2015-09-29 | hopTo Inc. | Touch-based hovering on remote devices |

| US9916009B2 (en) | 2013-04-26 | 2018-03-13 | Leap Motion, Inc. | Non-tactile interface systems and methods |

| US9195332B2 (en) | 2013-05-23 | 2015-11-24 | Nokia Technologies Oy | Apparatus with deformable flexible user interface area and adjustable hover input region and associated methods |

| US10281987B1 (en) | 2013-08-09 | 2019-05-07 | Leap Motion, Inc. | Systems and methods of free-space gestural interaction |

| US10846942B1 (en) | 2013-08-29 | 2020-11-24 | Ultrahaptics IP Two Limited | Predictive information for free space gesture control and communication |

| JP2015060303A (ja) * | 2013-09-17 | 2015-03-30 | 船井電機株式会社 | 情報処理装置 |

| US9632572B2 (en) | 2013-10-03 | 2017-04-25 | Leap Motion, Inc. | Enhanced field of view to augment three-dimensional (3D) sensory space for free-space gesture interpretation |

| US9996638B1 (en) | 2013-10-31 | 2018-06-12 | Leap Motion, Inc. | Predictive information for free space gesture control and communication |

| USD741877S1 (en) * | 2013-11-21 | 2015-10-27 | Microsoft Corporation | Display screen with animated icon |

| US9613262B2 (en) | 2014-01-15 | 2017-04-04 | Leap Motion, Inc. | Object detection and tracking for providing a virtual device experience |

| US10627904B2 (en) | 2014-02-07 | 2020-04-21 | Ultrahaptics IP Two Limited | Systems and methods of determining interaction intent in three-dimensional (3D) sensory space |

| US9805254B2 (en) * | 2014-02-18 | 2017-10-31 | Lenovo (Singapore) Pte. Ltd. | Preventing display clearing |

| FR3017723B1 (fr) * | 2014-02-19 | 2017-07-21 | Fogale Nanotech | Procede d'interaction homme-machine par combinaison de commandes tactiles et sans contact |

| US9679197B1 (en) | 2014-03-13 | 2017-06-13 | Leap Motion, Inc. | Biometric aware object detection and tracking |

| KR102216554B1 (ko) | 2014-03-14 | 2021-02-17 | 삼성디스플레이 주식회사 | 터치 패널 및 이를 포함하는 표시 장치 |

| US10459623B2 (en) | 2014-04-17 | 2019-10-29 | Microchip Technology Incorporated | Touch detection in a capacitive sensor system |

| US10782657B2 (en) | 2014-05-27 | 2020-09-22 | Ultrahaptics IP Two Limited | Systems and methods of gestural interaction in a pervasive computing environment |

| US9552069B2 (en) | 2014-07-11 | 2017-01-24 | Microsoft Technology Licensing, Llc | 3D gesture recognition |

| DE202014103729U1 (de) | 2014-08-08 | 2014-09-09 | Leap Motion, Inc. | Augmented-Reality mit Bewegungserfassung |

| CN104407786A (zh) * | 2014-09-30 | 2015-03-11 | 深圳市亿思达科技集团有限公司 | 实现全息图像显示的交互式显示方法、控制方法及系统 |

| US20160103550A1 (en) * | 2014-10-08 | 2016-04-14 | Kapik Inc. | Sensing system and method |

| US10748439B1 (en) | 2014-10-13 | 2020-08-18 | The Cognitive Healthcare Company | Automated delivery of unique, equivalent task versions for computer delivered testing environments |

| US10444980B1 (en) * | 2014-10-13 | 2019-10-15 | The Cognitive Healthcare Company | Biomechanical motion measurement and analysis for self-administered tests |

| US10383553B1 (en) | 2014-10-14 | 2019-08-20 | The Cognitive Healthcare Company | Data collection and analysis for self-administered cognitive tests characterizing fine motor functions |

| KR102244650B1 (ko) | 2014-10-24 | 2021-04-28 | 삼성디스플레이 주식회사 | 표시 장치 |

| CN105549798A (zh) * | 2014-10-30 | 2016-05-04 | 中强光电股份有限公司 | 触控投影幕及使用触控投影幕的投影系统 |

| KR102399589B1 (ko) * | 2014-11-05 | 2022-05-18 | 삼성전자주식회사 | 디바이스에 오브젝트를 디스플레이 하는 방법, 그 디바이스 및 기록매체 |

| US10296147B2 (en) | 2015-02-02 | 2019-05-21 | Samsung Display Co., Ltd. | Touch screen and display device including the same |

| KR102381121B1 (ko) | 2015-02-02 | 2022-04-01 | 삼성디스플레이 주식회사 | 터치패널 및 이를 포함하는 표시장치 |

| KR102381659B1 (ko) | 2015-03-10 | 2022-04-04 | 삼성디스플레이 주식회사 | 플렉서블 표시장치 |

| US11953618B2 (en) * | 2015-07-17 | 2024-04-09 | Origin Research Wireless, Inc. | Method, apparatus, and system for wireless motion recognition |

| CN106406784A (zh) * | 2015-07-27 | 2017-02-15 | 宏碁股份有限公司 | 影像输出装置 |

| CN108450007B (zh) * | 2015-09-14 | 2020-12-15 | 密歇根大学董事会 | 使用廉价惯性传感器的冗余阵列的高性能惯性测量 |

| KR102464814B1 (ko) | 2015-10-15 | 2022-11-09 | 삼성디스플레이 주식회사 | 터치 감지부, 이를 포함하는 터치 스크린 패널 및 터치 스크린 패널의 구동 방법 |

| US20170131775A1 (en) * | 2015-11-10 | 2017-05-11 | Castar, Inc. | System and method of haptic feedback by referral of sensation |

| CN107199888A (zh) * | 2016-03-18 | 2017-09-26 | 松下知识产权经营株式会社 | 姿势输入系统和姿势输入方法 |

| JP6728865B2 (ja) * | 2016-03-25 | 2020-07-22 | 富士ゼロックス株式会社 | 手上げ検出装置及び手上げ検出プログラム |

| US10228693B2 (en) * | 2017-01-13 | 2019-03-12 | Ford Global Technologies, Llc | Generating simulated sensor data for training and validation of detection models |

| US11698457B2 (en) * | 2019-09-04 | 2023-07-11 | Pixart Imaging Inc. | Object detecting system and object detecting method |

| CN114721576A (zh) * | 2020-12-18 | 2022-07-08 | 华为技术有限公司 | 手指触摸操作显示方法及装置 |

| CN114382377B (zh) * | 2022-01-04 | 2023-05-30 | 长春一汽富维汽车零部件股份有限公司 | 车窗控制近电场手势识别系统 |

Citations (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPS6324319A (ja) * | 1986-03-17 | 1988-02-01 | Mitsubishi Electric Corp | 情報入力装置 |

| US4988981A (en) * | 1987-03-17 | 1991-01-29 | Vpl Research, Inc. | Computer data entry and manipulation apparatus and method |

| US5381158A (en) * | 1991-07-12 | 1995-01-10 | Kabushiki Kaisha Toshiba | Information retrieval apparatus |

| JP2006072854A (ja) * | 2004-09-03 | 2006-03-16 | Matsushita Electric Ind Co Ltd | 入力装置 |

| JP2007226820A (ja) * | 1998-01-26 | 2007-09-06 | Wayne Westerman | マルチタッチ表面装置 |

| US20070291007A1 (en) * | 2006-06-14 | 2007-12-20 | Mitsubishi Electric Research Laboratories, Inc. | Method and system for switching between absolute and relative pointing with direct input devices |

| US20080012835A1 (en) * | 2006-07-12 | 2008-01-17 | N-Trig Ltd. | Hover and touch detection for digitizer |

| US20080158173A1 (en) * | 2007-01-03 | 2008-07-03 | Apple Computer, Inc. | Multi-touch surface stackup arrangement |

| US20080297487A1 (en) * | 2007-01-03 | 2008-12-04 | Apple Inc. | Display integrated photodiode matrix |

| JP2010061224A (ja) * | 2008-09-01 | 2010-03-18 | Honda Motor Co Ltd | 自動車用入出力装置 |

| US20100164897A1 (en) * | 2007-06-28 | 2010-07-01 | Panasonic Corporation | Virtual keypad systems and methods |

Family Cites Families (17)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US4145748A (en) * | 1977-12-23 | 1979-03-20 | General Electric Company | Self-optimizing touch pad sensor circuit |

| US4550221A (en) * | 1983-10-07 | 1985-10-29 | Scott Mabusth | Touch sensitive control device |

| FR2662528B1 (fr) * | 1990-05-25 | 1994-03-11 | Sextant Avionique | Dispositif pour la localisation d'un objet situe a proximite d'une aire de detection et clavier transparent utilisant ledit dispositif. |

| EP0574213B1 (en) * | 1992-06-08 | 1999-03-24 | Synaptics, Inc. | Object position detector |

| US5543588A (en) | 1992-06-08 | 1996-08-06 | Synaptics, Incorporated | Touch pad driven handheld computing device |

| US5594222A (en) * | 1994-10-25 | 1997-01-14 | Integrated Controls | Touch sensor and control circuit therefor |

| GB9613315D0 (en) * | 1996-06-25 | 1996-08-28 | Philips Electronics Nv | Virtual environment interaction and navigation device |

| WO2000044018A1 (en) * | 1999-01-26 | 2000-07-27 | Harald Philipp | Capacitive sensor and array |

| US6498590B1 (en) | 2001-05-24 | 2002-12-24 | Mitsubishi Electric Research Laboratories, Inc. | Multi-user touch surface |

| JP2003067107A (ja) * | 2001-08-28 | 2003-03-07 | Foundation For Advancement Of Science & Technology | 触覚提示装置 |

| US7145552B2 (en) * | 2003-10-22 | 2006-12-05 | Solectron Corporation | Electric field proximity keyboards and detection systems |

| US8931780B2 (en) | 2005-08-11 | 2015-01-13 | N-Trig Ltd. | Apparatus for object information detection and methods of using same |

| US8094136B2 (en) * | 2006-07-06 | 2012-01-10 | Flatfrog Laboratories Ab | Optical touchpad with three-dimensional position determination |

| US8316324B2 (en) * | 2006-09-05 | 2012-11-20 | Navisense | Method and apparatus for touchless control of a device |

| DE102007016408A1 (de) * | 2007-03-26 | 2008-10-02 | Ident Technology Ag | Mobiles Kommunikationsgerät und Eingabeeinrichtung hierfür |

| US8766925B2 (en) | 2008-02-28 | 2014-07-01 | New York University | Method and apparatus for providing input to a processor, and a sensor pad |

| KR20110132349A (ko) | 2009-01-26 | 2011-12-07 | 지로 테크놀로지스 (2009) 엘티디. | 객체의 거동을 모니터링하는 장치 및 방법 |

-

2010

- 2010-01-26 KR KR1020117019992A patent/KR20110132349A/ko not_active Application Discontinuation

- 2010-01-26 WO PCT/IL2010/000063 patent/WO2010084498A1/en active Application Filing

- 2010-01-26 JP JP2011547053A patent/JP2012515966A/ja active Pending

- 2010-01-26 EP EP10709072A patent/EP2389622A1/en not_active Withdrawn

- 2010-01-26 CN CN2010800095181A patent/CN102334086A/zh active Pending

-

2011

- 2011-07-26 US US13/190,935 patent/US8830189B2/en not_active Expired - Fee Related

Patent Citations (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPS6324319A (ja) * | 1986-03-17 | 1988-02-01 | Mitsubishi Electric Corp | 情報入力装置 |

| US4988981A (en) * | 1987-03-17 | 1991-01-29 | Vpl Research, Inc. | Computer data entry and manipulation apparatus and method |

| US4988981B1 (en) * | 1987-03-17 | 1999-05-18 | Vpl Newco Inc | Computer data entry and manipulation apparatus and method |

| US5381158A (en) * | 1991-07-12 | 1995-01-10 | Kabushiki Kaisha Toshiba | Information retrieval apparatus |

| JP2007226820A (ja) * | 1998-01-26 | 2007-09-06 | Wayne Westerman | マルチタッチ表面装置 |

| JP2006072854A (ja) * | 2004-09-03 | 2006-03-16 | Matsushita Electric Ind Co Ltd | 入力装置 |

| US20070291007A1 (en) * | 2006-06-14 | 2007-12-20 | Mitsubishi Electric Research Laboratories, Inc. | Method and system for switching between absolute and relative pointing with direct input devices |

| US20080012835A1 (en) * | 2006-07-12 | 2008-01-17 | N-Trig Ltd. | Hover and touch detection for digitizer |

| US20080158173A1 (en) * | 2007-01-03 | 2008-07-03 | Apple Computer, Inc. | Multi-touch surface stackup arrangement |

| US20080297487A1 (en) * | 2007-01-03 | 2008-12-04 | Apple Inc. | Display integrated photodiode matrix |

| US20100164897A1 (en) * | 2007-06-28 | 2010-07-01 | Panasonic Corporation | Virtual keypad systems and methods |

| JP2010061224A (ja) * | 2008-09-01 | 2010-03-18 | Honda Motor Co Ltd | 自動車用入出力装置 |

Cited By (21)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2012533122A (ja) * | 2009-07-10 | 2012-12-20 | アップル インコーポレイテッド | タッチ及びホバー感知 |

| JP2013539113A (ja) * | 2010-08-24 | 2013-10-17 | クアルコム,インコーポレイテッド | 電子デバイスディスプレイの上方の空気中で物体を移動させることによって電子デバイスアプリケーションと相互作用するための方法および装置 |

| JP2014219768A (ja) * | 2013-05-02 | 2014-11-20 | 船井電機株式会社 | 情報処理装置及び情報処理システム |

| JP2015011679A (ja) * | 2013-07-02 | 2015-01-19 | シャープ株式会社 | 操作入力装置及び入力操作処理方法 |

| US10042446B2 (en) | 2013-08-13 | 2018-08-07 | Samsung Electronics Company, Ltd. | Interaction modes for object-device interactions |

| JP2016509304A (ja) * | 2013-08-13 | 2016-03-24 | サムスン エレクトロニクス カンパニー リミテッド | 相互作用感知 |

| US10318090B2 (en) | 2013-08-13 | 2019-06-11 | Samsung Electronics Company, Ltd. | Interaction sensing |

| US10108305B2 (en) | 2013-08-13 | 2018-10-23 | Samsung Electronics Company, Ltd. | Interaction sensing |

| US10042504B2 (en) | 2013-08-13 | 2018-08-07 | Samsung Electronics Company, Ltd. | Interaction sensing |

| JP2016529615A (ja) * | 2013-08-30 | 2016-09-23 | クゥアルコム・インコーポレイテッドQualcomm Incorporated | タッチセンサデータの改善された処理のためのシステム及び方法 |

| JP2017208109A (ja) * | 2013-08-30 | 2017-11-24 | クゥアルコム・インコーポレイテッドQualcomm Incorporated | タッチセンサデータの改善された処理のためのシステム及び方法 |

| US9987554B2 (en) | 2014-03-14 | 2018-06-05 | Sony Interactive Entertainment Inc. | Gaming device with volumetric sensing |

| JP2017516186A (ja) * | 2014-03-14 | 2017-06-15 | 株式会社ソニー・インタラクティブエンタテインメント | 空間感知を備えるゲーム機 |

| US9921689B2 (en) | 2014-12-04 | 2018-03-20 | Fujitsu Limited | Information processing method, information processing apparatus, and storage medium |

| JP2017220140A (ja) * | 2016-06-10 | 2017-12-14 | 三菱電機株式会社 | 表示装置 |

| US11625898B2 (en) | 2016-10-11 | 2023-04-11 | Valve Corporation | Holding and releasing virtual objects |

| US11786809B2 (en) | 2016-10-11 | 2023-10-17 | Valve Corporation | Electronic controller with finger sensing and an adjustable hand retainer |

| KR20200019666A (ko) * | 2017-06-16 | 2020-02-24 | 밸브 코포레이션 | 손가락 움직임 감지 기능을 갖춘 전자 제어기 |

| JP2020524335A (ja) * | 2017-06-16 | 2020-08-13 | バルブ コーポレーション | 指動作のセンシングを備えた電子コントローラ |

| JP7143336B2 (ja) | 2017-06-16 | 2022-09-28 | バルブ コーポレーション | 指動作のセンシングを備えた電子コントローラ |

| KR102599441B1 (ko) * | 2017-06-16 | 2023-11-10 | 밸브 코포레이션 | 손가락 움직임 감지 기능을 갖춘 전자 제어기 |

Also Published As

| Publication number | Publication date |

|---|---|

| KR20110132349A (ko) | 2011-12-07 |

| EP2389622A1 (en) | 2011-11-30 |

| US8830189B2 (en) | 2014-09-09 |

| CN102334086A (zh) | 2012-01-25 |

| US20110279397A1 (en) | 2011-11-17 |

| WO2010084498A4 (en) | 2010-09-16 |

| WO2010084498A1 (en) | 2010-07-29 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2012515966A (ja) | 物体の挙動を監視するためのデバイスおよび方法 | |

| US20210271340A1 (en) | Gesture recognition devices and methods | |

| JP6539816B2 (ja) | 1つのシングル・センシング・システムを使用したマルチ・モーダル・ジェスチャー・ベースの対話型のシステム及び方法 | |

| KR101688355B1 (ko) | 다수의 지각 감지 입력의 상호작용 | |

| JP6333568B2 (ja) | センサを用いる近接動作認識装置及びその装置を用いた方法 | |

| US9760214B2 (en) | Method and apparatus for data entry input | |

| TWI492146B (zh) | 以組合資料爲基礎之虛擬手 | |

| EP2972669B1 (en) | Depth-based user interface gesture control | |

| EP2717120B1 (en) | Apparatus, methods and computer program products providing finger-based and hand-based gesture commands for portable electronic device applications | |

| KR100630806B1 (ko) | 동작 인식 장치를 이용한 명령 입력 방법 | |

| KR101234111B1 (ko) | 비접촉 입력 인터페이싱 장치 및 이를 이용한 비접촉 입력 인터페이싱 방법 | |

| TWI471815B (zh) | 手勢辨識裝置及方法 | |

| US20150084884A1 (en) | Extending the free fingers typing technology and introducing the finger taps language technology | |

| US20130241832A1 (en) | Method and device for controlling the behavior of virtual objects on a display | |

| US20120192119A1 (en) | Usb hid device abstraction for hdtp user interfaces | |

| US20170003762A1 (en) | Systems and methods for text entry | |

| GB2470654A (en) | Data input on a virtual device using a set of objects. | |

| KR20140114913A (ko) | 사용자 기기의 센서 운용 방법 및 장치 | |

| JP4720568B2 (ja) | ユーザ入力装置及びユーザ入力方法 | |

| CN105739752A (zh) | 顶部安装点击板模块 | |

| US20230031200A1 (en) | Touchless, Gesture-Based Human Interface Device | |

| KR101808759B1 (ko) | 손 동작 상호작용 시스템 및 방법 | |

| JP2023025681A (ja) | スクロールホイール指紋センサ一体型ユーザ入力装置を用いた認証を行うar/vrナビゲーション | |

| KR101489069B1 (ko) | 동작 기반의 정보 입력 방법 및 이러한 방법을 사용한 입력 장치 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20130125 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20130125 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20140129 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20140224 |

|

| RD03 | Notification of appointment of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7423 Effective date: 20140328 |

|

| RD04 | Notification of resignation of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7424 Effective date: 20140411 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A821 Effective date: 20140328 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20140502 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20140513 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20140604 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20140611 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20140723 |

|

| A602 | Written permission of extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A602 Effective date: 20140730 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20140806 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20150204 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20150415 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20150511 |

|

| A601 | Written request for extension of time |

Free format text: JAPANESE INTERMEDIATE CODE: A601 Effective date: 20150703 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20151013 |