BR112015032026B1 - Sistema de reconhecimento de evento adaptativo, método para reconhecer um evento alvo e meio legível por computador - Google Patents

Sistema de reconhecimento de evento adaptativo, método para reconhecer um evento alvo e meio legível por computador Download PDFInfo

- Publication number

- BR112015032026B1 BR112015032026B1 BR112015032026-0A BR112015032026A BR112015032026B1 BR 112015032026 B1 BR112015032026 B1 BR 112015032026B1 BR 112015032026 A BR112015032026 A BR 112015032026A BR 112015032026 B1 BR112015032026 B1 BR 112015032026B1

- Authority

- BR

- Brazil

- Prior art keywords

- user

- event

- related information

- corresponds

- events

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F1/00—Details not covered by groups G06F3/00 - G06F13/00 and G06F21/00

- G06F1/26—Power supply means, e.g. regulation thereof

- G06F1/32—Means for saving power

- G06F1/3203—Power management, i.e. event-based initiation of a power-saving mode

- G06F1/3234—Power saving characterised by the action undertaken

- G06F1/325—Power saving in peripheral device

- G06F1/3259—Power saving in cursor control device, e.g. mouse, joystick, trackball

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F1/00—Details not covered by groups G06F3/00 - G06F13/00 and G06F21/00

- G06F1/16—Constructional details or arrangements

- G06F1/1613—Constructional details or arrangements for portable computers

- G06F1/163—Wearable computers, e.g. on a belt

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F1/00—Details not covered by groups G06F3/00 - G06F13/00 and G06F21/00

- G06F1/16—Constructional details or arrangements

- G06F1/1613—Constructional details or arrangements for portable computers

- G06F1/1633—Constructional details or arrangements of portable computers not specific to the type of enclosures covered by groups G06F1/1615 - G06F1/1626

- G06F1/1684—Constructional details or arrangements related to integrated I/O peripherals not covered by groups G06F1/1635 - G06F1/1675

- G06F1/1694—Constructional details or arrangements related to integrated I/O peripherals not covered by groups G06F1/1635 - G06F1/1675 the I/O peripheral being a single or a set of motion sensors for pointer control or gesture input obtained by sensing movements of the portable computer

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F1/00—Details not covered by groups G06F3/00 - G06F13/00 and G06F21/00

- G06F1/26—Power supply means, e.g. regulation thereof

- G06F1/32—Means for saving power

- G06F1/3203—Power management, i.e. event-based initiation of a power-saving mode

- G06F1/3234—Power saving characterised by the action undertaken

- G06F1/325—Power saving in peripheral device

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/0304—Detection arrangements using opto-electronic means

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/05—Digital input using the sampling of an analogue quantity at regular intervals of time, input from a/d converter or output to d/a converter

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/10—Image acquisition

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/10—Image acquisition

- G06V10/12—Details of acquisition arrangements; Constructional details thereof

- G06V10/14—Optical characteristics of the device performing the acquisition or on the illumination arrangements

- G06V10/141—Control of illumination

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/10—Image acquisition

- G06V10/12—Details of acquisition arrangements; Constructional details thereof

- G06V10/14—Optical characteristics of the device performing the acquisition or on the illumination arrangements

- G06V10/145—Illumination specially adapted for pattern recognition, e.g. using gratings

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/18—Eye characteristics, e.g. of the iris

- G06V40/19—Sensors therefor

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/20—Movements or behaviour, e.g. gesture recognition

-

- Y—GENERAL TAGGING OF NEW TECHNOLOGICAL DEVELOPMENTS; GENERAL TAGGING OF CROSS-SECTIONAL TECHNOLOGIES SPANNING OVER SEVERAL SECTIONS OF THE IPC; TECHNICAL SUBJECTS COVERED BY FORMER USPC CROSS-REFERENCE ART COLLECTIONS [XRACs] AND DIGESTS

- Y02—TECHNOLOGIES OR APPLICATIONS FOR MITIGATION OR ADAPTATION AGAINST CLIMATE CHANGE

- Y02D—CLIMATE CHANGE MITIGATION TECHNOLOGIES IN INFORMATION AND COMMUNICATION TECHNOLOGIES [ICT], I.E. INFORMATION AND COMMUNICATION TECHNOLOGIES AIMING AT THE REDUCTION OF THEIR OWN ENERGY USE

- Y02D10/00—Energy efficient computing, e.g. low power processors, power management or thermal management

Abstract

MÉTODO PARA RECONHECER UM EVENTO-ALVO SELECIONADO E SISTEMA PARA RECONHECER EVENTO ADAPTATIVO. A presente invenção refere-se a um sistema e métodos relacionados para reconhecimento de evento adaptativo. Em um exemplo, um sensor selecionado de um dispositivo de exibição montado na cabeça é operado em uma primeira taxa de sondagem que corresponde a uma latência de potencial mais elevada. As informações iniciais relacionadas ao usuário são recebidas. Onde as informações iniciais relacionadas ao usuário correspondem a um pré-evento, o sensor selecionado é operado em uma segunda taxa de sondagem mais rápida que a primeira taxa de sondagem e que corresponde a uma latência potencial inferior. As informações subsequentes relacionadas ao usuário são recebidas. Onde as informações subsequentes relacionadas ao usuário correspondem a um evento-alvo selecionado, a retroalimentação associada ao evento-alvo selecionado é proporcionada ao usuário por meio do dispositivo de exibição montado na cabeça.

Description

[0001] Em sistemas de interface de usuário, minimizar a latência experimentada pelo usuário entre uma entrada de usuário e a resposta do sistema para a entrada cria uma experiência mais natural e agradável para o usuário. Em sistemas de realidade aumentada, por exemplo, reduzir tal latência fornece uma qualidade maior e experiência de realidade aumentada mais realista. Em alguns sistemas de realidade aumentada, um ou mais sensores podem receber entrada de usuário que dispara uma resposta de sistema. Para monitor tal entrada de usuário, o sistema pode sondar periodicamente os sensores para entrada. A latência de sondagem que corresponde à frequência de sondagem pode ser uma fonte significativa de latência percebida pelo usuário.

[0002] Adicionalmente e em relação a dispositivos portáteis e ou tros energizados por bateria, conservar uso de energia e vida útil de bateria correspondente também podem ser considerações. Embora utilizar taxas altas de amostragem de sensor todas as vezes possa reduzir latência de amostragem, isso também consume de modo inde- sejado mais energia e reduz a vida útil da bateria. Por outro lado, embora utilizar taxas baixas de amostragem posa reduzir o uso de energia e aumentar a vida útil da bateria, tais taxas baixas de amostragem também aumentam a latência.

[0003] Diversas modalidades são reveladas no presente documen to, que se referem a sistemas e métodos para reconhecer um evento- alvo selecionado. Por exemplo, uma modalidade revelada fornece um método que inclui, em um dispositivo de exibição que compreende uma pluralidade de sensores, operar um sensor selecionado em uma primeira taxa de sondagem que corresponde a uma latência de potencial mais elevada. As informações iniciais relacionadas ao usuário do sensor selecionado são recebidas. O método inclui determinar se as informações iniciais relacionadas ao usuário correspondem a um dentre uma pluralidade de pré-eventos, em que cada um dos pré-eventos corresponde a um ou mais padrões diferentes de pré-eventos e cada um dos padrões leva a um evento-alvo possível diferente.

[0004] Enquanto as informações iniciais relacionadas ao usuário correspondem a um dentre uma pluralidade de pré-eventos, o método inclui operar o sensor selecionado em uma segunda taxa de sondagem que é mais rápida que a primeira taxa de sondagem e que corresponde a uma latência potencial inferior que é menor que a latência de potencial mais elevada. As informações relacionadas ao usuário subsequentes do sensor selecionado são recebidas. Enquanto as informações relacionadas ao usuário subsequentes correspondem ao evento-alvo selecionado dentre os eventos-alvo possíveis diferentes, a retroalimentação associada ao evento-alvo selecionado é fornecida para o usuário por meio do dispositivo de exibição.

[0005] Este sumário é fornecido para introduzir uma seleção de conceitos em uma forma simplificada que serão ainda descritos abaixo na Descrição Detalhada. Essa descrição resumida não se destina a identificar recursos chaves ou recursos essenciais do assunto reivindicado, nem se destina a ser usada para limitar o escopo do assunto reivindicado. Além disso, a matéria reivindicada não se limita às implantações que solucionem qualquer uma ou todas as desvantagens verificadas em qualquer parte desta descrição.

[0006] A Figura 1 é uma vista esquemática de um sistema de re- conhecimento de evento adaptativo de acordo com uma modalidade da presente descrição.

[0007] A Figura 2 mostra um dispositivo de exibição montado na parte superior exemplificativo de acordo com uma modalidade da presente descrição.

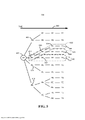

[0008] A Figura 3 é uma ilustração esquemática de pré-eventos sob a forma de movimentos de mão que levam a um evento-alvo selecionado.

[0009] A Figura 4 é uma ilustração esquemática dos pré-eventos de Figura 3 que são detectados e uma taxa de sondagem de sensor que é controlada de acordo com uma modalidade da presente descrição.

[00010] A Figura 5 é uma ilustração esquemática de uma pluralidade de padrões de pré-eventos que levam eventos-alvo possíveis diferentes.

[00011] As Figuras 6A e 6B são um fluxograma de um método para reconhecer um evento-alvo selecionado de acordo com uma modalidade da presente descrição.

[00012] A Figura 7 é uma ilustração esquemática simplificada de uma modalidade de um dispositivo de computação.

[00013] A Figura 1 mostra uma vista esquemática de uma modalidade de um sistema de reconhecimento de evento adaptativo 10. O sistema de reconhecimento de evento adaptativo 10 inclui um programa de reconhecimento de evento adaptativo 14 que pode ser armazenado em armazenamento em massa 18 de um dispositivo de computação 22. O programa de reconhecimento de evento adaptativo 14 pode ser carregado na memória 26 e executado por um processador 30 do dispositivo de computação 22 para executar um ou mais dos métodos e processos descritos em maiores detalhes abaixo. O dispositivo de computação 22 pode incluir adicionalmente uma fonte de alimentação 32, como uma bateria, para prover energia para os componentes do dispositivo de computação.

[00014] O sistema de reconhecimento de evento adaptativo 10 inclui um programa de exibição de realidade misturada 34 que pode gerar um ambiente virtual 38 para exibir por meio de um dispositivo de exibição, como o dispositivo de exibição montado na parte de cima (HMD) 42, para criar um ambiente de realidade misturada 44. O ambiente de realidade misturada inclui o ambiente virtual 38 exibido dentro de um ambiente físico 48. Conforme descrito em maiores detalhes abaixo, as informações relacionadas ao usuário 52 podem ser recebidas do ambiente físico 48 por meio do dispositivo de HMD 42.

[00015] O dispositivo de computação 22 pode assumir a forma de um dispositivo de computação do tipo desktop, um dispositivo de computação móvel, como um telefone inteligente, computador do tipo laptop, computador do tipo notebook ou computador do tipo tablet, computador de rede, computador de entretenimento doméstico, televisão interativa, sistema de jogos ou outro tipo adequado de dispositivo de computação. Detalhes adicionais em relação aos componentes e aspectos de computação do dispositivo de computação 22 são descritos em maiores detalhes abaixo em referência à Figura 7.

[00016] O dispositivo de computação 22 pode ser conectado de modo operacional ao dispositivo de HMD 42 com o uso de uma conexão com fio ou pode empregar uma conexão sem fio por meio de WiFi, Bluetooth ou qualquer outro protocolo de comunicação sem fio adequado. Por exemplo, o dispositivo de computação 22 pode ser acoplado de modo comunicativo a uma rede 16. A rede 16 pode assumir a forma de uma rede de área local (LAN), rede de área ampla (WAN), rede com fio, rede sem fio, rede de área pessoal ou uma combinação das mesmas e pode incluir a Internet.

[00017] O dispositivo de computação 22 também pode se comunicar com um ou mais dentre outros dispositivos de computação por meio de rede 16. Adicionalmente, o exemplo ilustrado na Figura 1 mostra o dispositivo de computação 22 como um componente separado do dispositivo de HMD 42. Será verificado que em outros exemplos, o dispositivo de computação 22 pode ser integrado ao dispositivo de HMD 42.

[00018] Agora, também em referência à Figura 2, um exemplo de um dispositivo de HMD 200 sob a forma de um par de óculos usáveis com um visor transparente 54 é fornecido. Será verificado que em outros exemplos, o dispositivo de HMD 200 pode assumir outras formas adequadas nas quais um visor transparente, semitransparente ou não transparente é sustentado na frente de um olho ou olhos do espectador. Também será verificado que o dispositivo de HMD 42 mostrado na Figura 1 pode assumir a forma do dispositivo de HMD 200, conforme descrito em maiores detalhes abaixo, ou qualquer outro dispositivo de HMD adequado. Adicionalmente, muitos outros tipos e configurações de dispositivos de exibição que têm diversos fatores de forma também podem ser usados dentro do escopo da presente descrição. Tais dispositivos de exibição podem incluir telefones inteligentes portáteis, computadores do tipo tablet e outros dispositivos de exibição adequados.

[00019] Em referência às Figuras 1 e 2, o dispositivo de HMD 42 inclui um sistema de exibição 56 e um visor transparente 54 que permite que imagens como objetos holográficos sejam entregues aos olhos de um usuário 46. O visor transparente 54 pode ser configurado para aumentar visualmente uma aparência de um ambiente físico 48 para um usuário 46 que vê o ambiente físico através do visor transparente. Por exemplo, a aparência do ambiente físico 48 pode ser aumentada por conteúdo gráfico (por exemplo, um ou mais pixels, cada um, que têm uma respectiva cor e brilho) que é apresentado por meio do visor transparente 54 para criar um ambiente de realidade misturada.

[00020] O visor transparente 54 também pode ser configurado para habilitar um usuário a ver um objeto de mundo real, físico no ambiente físico 48 através de um ou mais pixels parcialmente transparentes que estão exibindo uma representação de objeto virtual. Conforme mostrado na Figura 2, em um exemplo, o visor transparente 54 pode incluir elementos de produção de imagem localizado dentro de lentes 204 (como, por exemplo, um visor de Diodo Emissor de Luz Orgânico translúcido). Como outro exemplo, o visor transparente 54 pode incluir um modulador de luz em uma borda das lentes 204. Nesse exemplo, as lentes 204 podem servir como um guia de luz para entregar luz do modulador de luz para os olhos de um usuário. Tal guia de luz pode habilitar um usuário a perceber uma imagem holográfica em 3D locali-zada dentro do ambiente físico 48 que o usuário está visualizando, enquanto também permite que o usuário veja objetos físicos no ambiente físico criando, desse modo, um ambiente de realidade misturada 44.

[00021] O dispositivo de HMD 42 também pode incluir diversos sensores e sistemas relacionados. Por exemplo, o dispositivo de HMD 42 pode incluir um sistema de rastreamento ocular 60 que utiliza pelo menos um sensor voltado para dentro 208. O sensor voltado para dentro 208 pode ser um sensor de imagem que é configurado para adquirir dados de imagem sob a forma de dados de rastreamento ocular dos olhos do usuário. Desde que o usuário tenha consentido a aquisição e uso dessas informações, o sistema de rastreamento ocular 60 pode usar essas informações para rastrear uma posição e/ou movimento dos olhos do usuário.

[00022] Em um exemplo, o sistema de rastreamento ocular 60 inclui um subsistema de detecção de olhar configurado para detectar uma direção de olhar de cada olho de um usuário. O subsistema de detecção de olhar pode ser configurado para determinar direções de olhar de cada um dos olhos do usuário de qualquer maneira adequada. Por exemplo, o subsistema de detecção de olhar pode compreender uma ou mais fontes de luz, como fontes de luz infravermelha, configuradas para ocasionar uma cintilação de luz para refletir a partir da córnea de cada olho de um usuário. Um ou mais sensores de imagem podem, então, ser configurados para capture uma imagem dos olhos do usuário. Em alguns exemplos, o sistema de rastreamento ocular 60 também pode ser empregado como um dispositivo de entrada de usuário para fornecer informações relacionadas ao usuário 52, de modo que um usuário possa interagir com o dispositivo de HMD 42 por meio de movimentos dos olhos do usuário.

[00023] O dispositivo de HMD 42 também pode incluir sistemas de sensor que recebem dados de ambiente físico, como informações relacionadas ao usuário 52, do ambiente físico 48. Por exemplo, o dispositivo de HMD 42 pode incluir um sistema de sensor óptico 62 que utiliza pelo menos sensor voltado para fora 212, como um sensor óptico, para capturar dados de imagem do ambiente físico 48. O sensor voltado para fora 212 pode detectar movimentos dentro de seu campo de visão, como entradas com base em gesto ou outros movimentos executados por um usuário 46 ou por uma pessoa ou objeto físico dentro do campo de visão. O sensor voltado para fora 212 também pode capturar informações de imagem bidimensional e informações de profundidade do ambiente físico 48 e objetos físicos dentro do ambiente. Por exemplo, o sensor voltado para fora 212 pode incluir uma câmera de profundidade, uma câmera de luz visível, uma câmera de luz infravermelha e/ou uma câmera de rastreamento de posição.

[00024] O dispositivo de HMD 42 pode incluir constatação de profundidade por meio de um ou mais câmera de profundidades. Em um exemplo, cada câmera de profundidade pode incluir câmeras esquerda e direita de um sistema de visão estereoscópica. As imagens de resolução no tempo de um ou mais dessas câmeras de profundidade podem ser registradas entre si e/ou para imagens de outro sensor óptico como uma câmera de espectro visível e podem ser combinadas para render vídeo de resolução profunda.

[00025] Em outros exemplos, uma câmera de profundidade de luz estruturada pode ser configurada para projetar uma iluminação infravermelha estruturada e para espelhar a iluminação refletida de uma cena na qual a iluminação é projetada. Um mapa de profundidade da cena pode ser construído com base em espaçamentos entre recursos adjacentes nas diversas regiões de uma cena imageada. Em ainda outros exemplos, uma câmera de profundidade pode assumir uma forma de uma câmera de profundidade de tempo de voo configurada para projetar uma iluminação infravermelha pulsada em uma cena e detectar a iluminação refletida da cena. Será verificado que qualquer outra câmera de profundidade adequada pode ser usada dentro do escopo da presente descrição.

[00026] O sensor voltado para fora 212 pode capturar imagens do ambiente físico 48 no qual um usuário 46 está situado. Em um exemplo, o programa de exibição de realidade misturada 34 pode incluir um sistema de modelagem em 3D que usa tal entrada para gerar um ambiente virtual 38 que modela o ambiente físico 48 ao redor do usuário 46.

[00027] O dispositivo de HMD 42 também pode incluir um sistema de sensor de posição 66 que utiliza um ou mais sensores de movimento 220 para capturar dados de posição e, desse modo, habilitar detecção de movimento, rastreamento de posição e/ou constatação de orientação do dispositivo de HMD. Por exemplo, o sistema de sensor de posição 66 pode ser utilizado para determinar uma direção, velocidade e/ou aceleração de uma cabeça do usuário. O sistema de sensor de posição 66 também pode ser utilizado para determinar uma orientação de pose de cabeça de uma cabeça do usuário. Em um exemplo, o sistema de sensor de posição 66 pode compreender uma unidade de medição de inércia configurada como seis eixos geométricos ou seis graus de sistema de sensor de posição de liberdade. Esse sistema de sensor de posição exemplificativo pode, por exemplo, incluir três ace- lerômetros e três giroscópios para indicar ou medir uma alteração na localização do dispositivo de HMD 42 dentro de espaço tridimensional ao longo de três eixos geométricos ortogonais (por exemplo, x, y, z) e uma alteração em uma orientação do dispositivo de HMD sobre os três eixos geométricos ortogonais (por exemplo, rolagem, passo, orientação).

[00028] O sistema de sensor de posição 66 também pode suportar outras técnicas de posicionamento adequadas, como GPS ou outros sistemas de navegação global. Adicionalmente, embora exemplos específicos de sistemas de sensor de posição tenham sido descritos, será verificado que outros sistemas de sensor de posição adequados podem ser usados. Em alguns exemplos, sensores de movimento 220 também podem ser empregados como dispositivo de entrada de usuários para fornecer informações relacionadas ao usuário 52, de modo que um usuário posa interagir com o dispositivo de HMD 42 por meio de gestos do pescoço e da cabeça ou mesmo do corpo.

[00029] O dispositivo de HMD 42 também pode incluir um sistema de sensor biométrico 70 que utiliza um ou mais sensores biométricos 232 para capturar dados biométricos de usuário. Por exemplo, o sistema de sensor biométrico 70 pode ser utilizado para medir ou determinar dados biométricos de usuário que incluem, por exemplo, frequência cardíaca, resposta pupilar, saturação de hemoglobina, condu- tividade de pele, respiração, perspiração e atividade de onda cerebral.

[00030] O dispositivo de HMD 42 também pode incluir um sistema de microfone 72 que inclui um ou mais microfones 224 que capturam dados de áudio. Em outros exemplos, o áudio pode ser apresentado ao usuário por meio de um ou mais alto-falantes 228 no dispositivo de HMD 42. O primeiro dispositivo de HMD 42 também pode incluir uma bateria 74 ou outra fonte de alimentação portátil adequada que fornece energia para os diversos componentes do dispositivo de HMD.

[00031] O dispositivo de HMD 42 também pode incluir um processador 236 que tem um subsistema de lógica e um subsistema de armazenamento, conforme discutido em maiores detalhes abaixo em relação à Figura 7, que estão em comunicação com os diversos sensores e sistemas do dispositivo de HMD. Em um exemplo, o subsistema de armazenamento pode incluir instruções que são executáveis pelo subsistema de lógica para receber entradas de sinal dos sensores e encaminhar tais entradas para o dispositivo de computação 22 (em forma não processada ou processada) e para apresentar imagens para um usuário por meio do visor transparente 54.

[00032] Será observado que o dispositivo de HMD 42 e sensores relacionados e outros componentes descritos acima e ilustrados nas Figuras 1 e 2 são fornecidos a título de exemplificação. Esses exemplos não se destinam a ser limitantes de qualquer maneira, como quaisquer outros sensores, componentes adequados e/ou combinação de sensores e componentes podem ser utilizados. Portanto, deve ser entendido que o dispositivo de HMD 42 pode incluir sensores adicionais e/ou alternativos, câmeras, microfones, dispositivos de entrada, dispositivos de emissão, etc. sem se afastar do escopo dessa descrição. Adicionalmente, a configuração física do dispositivo de HMD 42 e seus diversos sensores e subcomponentes pode assumir uma variedade de formas diferentes sem se afastar do escopo dessa descrição.

[00033] Além disso e conforme discutido em maiores detalhes abai- xo, será verificado que os diversos sistemas de sensor e componentes relacionados podem ser operados em diversas taxas ou frequências de sondagem para monitorar informações relacionadas ao usuário 52 fornecidas por usuário 46. Conforme descrito em maiores detalhes abaixo, as taxas de sondagem de um ou mais sensores podem ser controladas em resposta à determinação de se as informações relacionadas ao usuário 52 correspondem a um pré-evento.

[00034] Agora, em referência às Figuras 3 a 5, as descrições de casos de uso e modalidades exemplificativos do sistema de reconhecimento de evento adaptativo 10 serão fornecidos agora. Nos exemplos a seguir, informações relacionadas ao usuário 52 sob a forma de movimentos de mão e gestos correspondentes são recebidas pelo sistema de sensor óptico 62. Será verificado que, em outros exemplos, muitas outras formas de informações relacionadas ao usuário 52 podem ser recebidas e utilizadas pelo sistema de reconhecimento de evento adaptativo 10 para controlar operação de sensor conforme descrito em maiores detalhes abaixo. Tais outras formas de informações relacionadas ao usuário 52 incluem, porém, sem limitação, outros dados de movimento de usuário, dados de rastreamento ocular, dados de posição, dados biométricos e dados de áudio.

[00035] A Figura 3 é uma ilustração esquemática de pré-eventos sob a forma de movimentos de mão que levam a um evento-alvo selecionado que compreende um gesto-alvo. No exemplo mostrado na Figura 3, um ou mais sensores ópticos no sistema de sensor óptico 62 de dispositivo de HMD 42 podem capturar dados de imagem de uma mão do usuário 304 que executa um gesto de mão. Nesse exemplo, o dedo indicador 308 e o polegar 312 realizam um gesto de aperto no qual o usuário começa com o dedo e o polegar formando uma pose geralmente em formato de U aberta 316. A partir dessa pose 316, o usuário fecha a lacuna entre o dedo indicador 308 e polegar 312 até que o dedo e o polegar se encontrem para fazer uma pose de aperto 330.

[00036] Em um exemplo e conforme descrito em maiores detalhes abaixo, mediante a detecção de que o usuário completou o gesto de aperto ao colocar juntos o dedo indicador 308 e o polegar 312 na pose se aperto 330, o sistema de reconhecimento de evento adaptativo 10 pode fornecer retroalimentação 78 para o usuário 46 por meio do dispositivo de HMD 42. A retroalimentação 78 pode compreender, por exemplo, a execução de um comando em relação a uma execução de programa por meio do dispositivo de HMD 42. Por exemplo, o gesto de aperto ilustrado na Figura 3 pode ser usado por um aplicativo de fotografia para capturar uma foto do ambiente físico 48. Nesse exemplo, a retroalimentação 78 também pode incluir uma indicação para o usuário de que uma foto foi capturada, como fornecer um som de liberação de obturador, um ícone de brilho intermitente, etc., por meio do dispositivo de HMD 42.

[00037] Em outros exemplos, a retroalimentação 78 pode compreender qualquer outro comando utilizado em um contexto de entrada de usuário, como selecionar, copiar ou colar um elemento exibido para o usuário por meio de dispositivo de HMD 42. Em outros exemplos, o comando pode controlar um aspecto operacional do dispositivo de HMD 42 ou outro dispositivo eletrônico. Será verificado que os exemplos anteriores são meramente ilustrativos e que a retroalimentação 78 pode compreender qualquer comando, ação, notificação ou outro evento que é associado a um evento-alvo selecionado, como um ges-to-alvo e é fornecido para um usuário.

[00038] Conforme verificado acima, para fornecer uma experiência realista e crível para o usuário, qualquer latência entre uma entrada de usuário como um gesto-alvo e a retroalimentação associada é minimizada de modo desejável. No entanto, minimizar latência pode incluir operar de modo contínuo sensores em taxas de sondagem altas que usam mais energia, impõe sobrecargas computacionais maiores e reduz de modo correspondente vida útil da bateria. Vantajosamente e conforme descrito em maiores detalhes abaixo, o sistema de reconhecimento de evento adaptativo 10 pode reduzir latência enquanto também minimiza uso de energia e sobrecarga computacional habilitando, desse modo, vida útil melhorada da bateria.

[00039] Também em referência às Figuras 4 e 5, em um exemplo, o programa de reconhecimento de evento adaptativo 14 pode ser configurado para receber informações relacionadas ao usuário 52 que compreendem dados de imagem do sistema de sensor óptico 62 que mostra a mão do usuário 304 em uma variedade de poses, que inclui as poses mostradas na Figura 3. Conforme mostrado nas Figuras 3 e 4, a partir de um estado Inicial 402 que corresponde a um ponto no tempo, o programa de reconhecimento de evento adaptativo 14 pode ser configurado para operar um sensor selecionado do sistema de sensor óptico 62 em uma taxa de sondagem de padrão que corresponde a uma latência de potencial mais elevada. A taxa de sondagem de padrão pode ser, por exemplo, 0,5 Hz., 1,0 Hz., 5,0 Hz., ou qualquer outra frequência adequada. Tal taxa de sondagem de padrão também pode corresponder a um estado de consumo de energia menor do sensor selecionado.

[00040] O sensor selecionado que opera na taxa de sondagem de padrão pode receber informações relacionadas ao usuário 52, como dados de imagem da mão do usuário 304 e fornecer tais informações ao programa de reconhecimento de evento adaptativo 14. O programa de reconhecimento de evento adaptativo 14 pode, então, determinar se tais informações correspondem a um dentre uma pluralidade de pré-eventos (PE). Agora, em referência ao exemplo mostrado na Figura 5, a partir do estado Inicial 402, o programa de reconhecimento de evento adaptativo 14 pode determinar se informações relacionadas ao usuário 52 correspondem a PE 506, PE 510, PE 514 ou PE 518. Conforme mostrado na Figura 5, cada um dos pré-eventos PE 506, PE 510, PE 514 e PE 518 corresponde a um ou mais padrões diferentes de pré-eventos e cada um dos padrões leva a um evento-alvo possível diferente (TE). Por exemplo, PE 510 corresponde a 3 padrões diferentes, indicados em 522, 526 e 530, que levam a 3 eventos-alvo diferentes TE 534, TE 538 e TE 542, respectivamente.

[00041] Será verificado que para cada pré-evento subsequente que é detectado, o número de eventos-alvo possíveis é reduzido. Adicionalmente, a probabilidade de que o usuário está no processo de execução de um evento-alvo possível particular aumenta. Em conformidade e conforme descrito em maiores detalhes abaixo, conforme cada pré-evento é detectado e uma posição atual dentro de um certo padrão avança para mais perto de um evento-alvo, uma taxa de sondagem de um sensor selecionado pode ser aumentada para reduzir a latência. Adicionalmente, até que um pré-evento subsequente seja detectado, a taxa de sondagem de um sensor selecionado pode permanecer em uma taxa relativamente inferior parar, desse modo, conservar energia e melhorar vida útil da bateria.

[00042] Em um exemplo e também em referência à Figura 3, o programa de reconhecimento de evento adaptativo 14 pode receber dados de imagem da mão do usuário 304 fazendo a pose geralmente em formato de U 316. O programa de reconhecimento de evento adaptati- vo 14 pode determinar que a pose geralmente em formato de U 316 corresponde a PE 510 na Figura 5. PE 510 é um membro de padrões 522, 526 e 530.

[00043] Em conformidade, o programa de reconhecimento de evento adaptativo 14 pode avançar para um estado de Detecção 1 406 no qual a taxa de sondagem do sensor selecionado é aumentada para operar em uma taxa de sondagem mais rápida F1 que é mais rápida que a taxa de sondagem de padrão do estado Inicial 402. Por exemplo, em que a taxa de sondagem de padrão é 1,0 Hz., a taxa de sondagem mais rápida F1 pode ser 10 Hz. A taxa de sondagem mais rápida F1 aumentada do estado de Detecção 1 406 também corresponde ao uso de energia aumentado pelo sensor selecionado, indicado como P1 mais alto, quando comparado ao uso de energia do estado Inicial 402. A taxa de sondagem mais rápida F1 do estado de Detecção 1 406 também corresponde a uma latência de potencial reduzida, indicada como L1 reduzida, que é menor que a latência de potencial mais elevada do estado Inicial 402.

[00044] Para propósitos dessa descrição, uma latência de potencial de um sensor que opera em uma certa taxa de sondagem é definida como um período de tempo de potencial máximo entre a ocorrência de um evento, como a pré-evento ou um evento-alvo, e a detecção da ocorrência de evento pelo sensor. Por exemplo, em que uma taxa de sondagem de sensor é 1 Hz., uma latência de potencial associada a essa taxa de sondagem pode ser de aproximadamente 0,99 segundos. Em outras palavras, aproximadamente 0,99 segundos seria o tempo decorrido de potencial máximo entre a ocorrência de um evento, como um pré-evento ou um evento-alvo, e a detecção da ocorrência de evento pelo sensor. Em conformidade, aumentar uma taxa de sondagem do sensor diminui de modo correspondente a latência de potencial daquele sensor. Também será verificado que em alguns exemplos, a latência atual entre a ocorrência de um evento e a detecção da ocorrência de evento pelo sensor será menor que a latência de potencial daquela operação de sensor.

[00045] A partir do estado de Detecção 1 406, o programa de reconhecimento de evento adaptativo 14 pode receber dados de imagem da mão do usuário 304 que faz uma pose em formato de U modificada 320 na qual o dedo indicador 308 e polegar 312 estão mais próximos que na pose anterior 316. O programa de reconhecimento de evento adaptativo 14 pode determinar que a pose em formato de U modificada 320 corresponde a PE 550 na Figura 5. PE 550 é um membro de padrões 522 e 526. Desse modo, os eventos-alvo possíveis foram reduzidos para TE 534 e TE 538.

[00046] Em conformidade, o programa de reconhecimento de evento adaptativo 14 pode avançar para um estado de Detecção 2 410 no qual a taxa de sondagem do sensor selecionado é aumentada para operar em uma taxa de sondagem mais rápida F2 que é mais rápida que a taxa de sondagem mais rápida F1 do estado de Detecção 1 406. Por exemplo, em que a taxa de sondagem mais rápida F1 é 10 Hz, a taxa de sondagem mais rápida F2 pode ser 60 Hz. A taxa de sondagem mais rápida F2 aumentada do estado de Detecção 2 410 também corresponde ao uso de energia aumentado pelo sensor selecionado, indicado como P2 mais alto, quando comparado ao uso de energia P1 mais alto do estado de Detecção 1 406. A taxa de sondagem mais rápida F2 do estado de Detecção 2 410 também corresponde a uma la- tência de potencial reduzida adicional, indicada como L2 Reduzida, que é menor que a L1 reduzida latência de potencial do estado de Detecção 1 406.

[00047] A partir do estado de Detecção 2 410, o programa de reconhecimento de evento adaptativo 14 pode receber dados de imagem da mão do usuário 304 fazendo uma pode próxima a aperto 324 na qual o dedo indicador 308 e polegar 312 são separados por uma distância menor, como aproximadamente 2 mm., quando comparada à pose em formato de U modificada 320. O programa de reconhecimento de evento adaptativo 14 pode determinar que a pose próxima a aperto 324 corresponde a PE 554 na Figura 5. PE 554 é um membro de padrão 522. Desse modo, os eventos-alvo possíveis foram agora reduzidos a um único evento-alvo, TE 534.

[00048] Em conformidade, o programa de reconhecimento de evento adaptativo 14 pode avançar para um estado de Detecção 3 414 no qual a taxa de sondagem do sensor selecionado é aumentada para operar em uma taxa de sondagem F3 mais rápida que é mais rápida que a taxa de sondagem mais rápida F2 do estado de Detecção 2 410. Por exemplo, em que a taxa de sondagem mais rápida F2 é 60 Hz, a taxa de sondagem F3 mais rápida pode ser 120 Hz. A taxa de sondagem F3 mais rápida aumentada do estado de Detecção 3 414 também corresponde ao uso de energia aumentado pelo sensor selecionado, indicado como P3 mais alto, quando comparado ao uso de energia P2 mais alto do estado de Detecção 2 410. A taxa de sondagem F3 mais rápida do estado de Detecção 3 414 também corresponde a uma la- tência de potencial reduzida adicional, indicada como L3 reduzida, que é menor que a latência de potencial L2 reduzida do estado de Detecção 2 410.

[00049] A partir do estado de Detecção 3 414, o programa de reconhecimento de evento adaptativo 14 pode receber dados de imagem da mão do usuário 304 fazendo a pose de aperto 330 na qual o dedo indicador 308 e polegar 312 estão se tocando, conforme indicado pelo estado ocorrido 418 de Evento-alvo 543. O programa de reconhecimento de evento adaptativo 14 pode determinar que a pose de aperto 330 corresponde ao evento-alvo selecionado TE 534 na Figura 5. O programa de reconhecimento de evento adaptativo 14 pode, então, fornecer retroalimentação associada ao evento-alvo selecionado TE 534 para o usuário por meio do dispositivo de HMD 42.

[00050] Em referência às Figuras 4 e 5, em alguns exemplos o programa de reconhecimento de evento adaptativo 14 pode ser configurado para reduzir a taxa de sondagem do sensor selecionado, em que informações relacionadas ao usuário 52 que correspondem a um pré- evento não são recebidas dentro de um período de tempo predeterminado. Por exemplo, quando o estado de Detecção 1 é iniciado, o programa de reconhecimento de evento adaptativo 14 pode iniciar um temporizador. Se informações relacionadas ao usuário 52 que correspondem a um dos próximos pré-eventos possíveis PE 550 e PE 552 não forem recebidas dentro de um período de tempo predeterminado, então, o programa de reconhecimento de evento adaptativo 14 pode afetar uma condição expirada e reverter para o estado Inicial 402 que corresponde à taxa de sondagem de padrão mais lenta e uso de energia mais baixo.

[00051] Condições expiradas similares podem ser utilizadas para o estado de Detecção 2 e/ou de Detecção 3. Vantajosamente, dessa maneira, o consumo de energia pode ser reduzido quando uma probabilidade de receber um próximo pré-evento possível cai abaixo de um limite predeterminado que corresponde ao período de tempo predeterminado. Em um exemplo, os períodos de tempo predeterminados para uma condição expirada podem ser 3 segundos para o estado de Detecção 1, 2 segundos para o estado de Detecção 2, e 1,0 segundo para o estado de Detecção 3. Será verificado que quaisquer períodos de tempo predeterminados adequados e limites de probabilidade predeterminados podem ser utilizados.

[00052] Vantajosamente, mediante a manutenção da taxa de sondagem de sensores em taxas mais lentas até que um pré-evento seja detectado, o sistema de reconhecimento de evento adaptativo 10 minimiza o uso de energia pelo sensor, bem como consumo de largura de banda de sinais de sensor. Por exemplo, ao esperar para operar o sensor na sondagem F3 mais rápida, maior até que PE 554 seja detectado, o estado de uso de energia P3 maior, mais elevado pode ser evitado até que uma probabilidade do evento-alvo selecionado que ocorre exceda um limite predeterminado.

[00053] Adicionalmente, o sistema de reconhecimento de evento adaptativo 10 aumenta de modo sequencial a taxa de sondagem do sensor selecionado conforme pré-eventos adicionais são detectados. Dessa maneira e conforme ilustrado na Figura 3, as latências de potencial correspondentes entre a ocorrência e a detecção de um pré- evento são reduzidas de modo sequencial. Além disso, ao operar o sensor na taxa de sondagem F3 mais rápida, maior mediante a detecção de PE 554, o sistema de reconhecimento de evento adaptativo 10 também minimiza latência de potencial entre a ocorrência do evento- alvo selecionado TE 534 e a detecção do evento.

[00054] Em outro exemplo, antes da detecção do evento-alvo selecionado 534, o programa de reconhecimento de evento adaptativo 14 pode pré-buscar pelo menos uma porção da retroalimentação 78 associada a um ou mais eventos-alvo. Por exemplo, no estado de Detecção 2 410, que corresponde a PE 550 na Figura 5, há dois padrões possíveis 522 e 526 e dois eventos-alvo possíveis TE 534 e TE 538, respectivamente, remanescentes. Nesse exemplo, no estado de Detecção 2 410 o programa de reconhecimento de evento adaptativo 14 pode pré-buscar uma porção da retroalimentação 78 associada tanto a TE 534 quanto a TE 538. Em um exemplo, 50% da retroalimentação 78 associada tanto a TE 534 quando a TE 538 pode ser pré-buscada. Será verificado que qualquer porção de retroalimentação adequada pode ser pré-buscada. Em alguns exemplos, 100% da retroalimentação pode ser pré-buscada.

[00055] Por exemplo, em que TE 534 corresponde a um comando de liberação de obturador para um aplicativo de câmera, o programa de reconhecimento de evento adaptativo 14 pode pré-buscar 50% dos dados associados ao comando e 50% dos dados de imagem que serão fornecidos ao usuário por meio do dispositivo de HMD 42 para indicar que uma imagem foi capturada. De modo similar, em que TE 538 corresponde a um comando de zoom para o aplicativo de câmera, o programa de reconhecimento de evento adaptativo 14 pode pré-buscar 50% dos dados associados ao comando de zoom e 50% dos dados de imagem que serão fornecidos para o usuário por meio do dispositivo de HMD 42 para indicar que a câmera está aplicando zoom.

[00056] Em outros exemplos, o programa de reconhecimento de evento adaptativo 14 pode pré-buscar pelo menos uma porção da retroalimentação 78 associada a um ou mais eventos-alvo em outros pontos no tempo que precedem temporariamente o um ou mais eventos-alvo ao longo de linha do tempo 302. Por exemplo, o programa de reconhecimento de evento adaptativo 14 pode pré-buscar pelo menos uma porção de retroalimentação no estado de Detecção 3 414, que corresponde a PE 554 na Figura 5 ou no estado de Detecção 1 406, que corresponde a PE 510 na Figura 5.

[00057] Em outro exemplo, em que informações relacionadas ao usuário 52 correspondem a um pré-evento preditivo que não é o evento-alvo selecionado, o programa de reconhecimento de evento adapta- tivo 14 pode ser configurado para determinar um tempo de execução estimado no qual o evento-alvo selecionado ocorrerá. Por exemplo, a partir do estado de Detecção 2 410, o programa de reconhecimento de evento adaptativo 14 pode receber informações relacionadas ao usuário 52 que correspondem a PE 554. PE 554 pode ser um pré-evento preditivo que corresponde a uma probabilidade predeterminada que evento-alvo TE 534 ocorrerá de modo subsequente.

[00058] Em referência à Figura 3, após correlacionar as informações relacionadas ao usuário 52 ao pré-evento preditivo PE 554, o programa de reconhecimento de evento adaptativo 14 pode determinar um Tempo de execução estimado de Evento-alvo 534 no qual o evento-alvo 534 ocorrerá. Em um exemplo, o Tempo de execução estimado de Evento-alvo 534 pode ser determinado acessando-se uma lacuna de tempo estimado predeterminada, ilustrada em 340 na Figura 3, entre a detecção de PE 554 e a ocorrência do evento-alvo 534. Conforme mostrado na Figura 3, adicionando-se a lacuna de tempo estimada 340 ao tempo real no qual o pré-evento 554 foi detectado, o Tempo de execução estimado de Evento-alvo 534 pode ser determinado.

[00059] Ao usar o Tempo de execução estimado de Evento-alvo 534, o programa de reconhecimento de evento adaptativo 14 pode fornecer retroalimentação 78 associada ao evento-alvo selecionado para o usuário tanto no Tempo de execução estimado de Evento-alvo 534 quanto antes do Tempo de execução estimado de Evento-alvo 534. Em um exemplo, a retroalimentação 78 pode ser fornecida no Tempo de execução estimado de Evento-alvo 534 que pode corresponder de modo muito próximo ao tempo real que o evento-alvo TE 534 ocorre. Vantajosamente, dessa maneira, o usuário pode experimentar uma latência percebida que é efetivamente zero ou, talvez, desprezível.

[00060] Em outro exemplo, a retroalimentação 78 pode ser fornecida antes do Tempo de execução estimado de Evento-alvo 534 por um período de tempo predeterminado. Vantajosamente, nesse exemplo, o usuário pode experimentar uma latência percebida negativa na qual a retroalimentação 78 é percebida pelo usuário antes do evento-alvo TE 534 ser completado. Em alguns exemplos, isso pode fornecer ao usuário uma experiência intensificada de interação em tempo real com o dispositivo de HMD 42 e o sistema de reconhecimento de evento adaptativo 10. Em alguns exemplos, fornecer a retroalimentação 78 antes do Tempo de execução estimado de Evento-alvo 534 também pode ser utilizada para desviar o processamento e/ou outros atrasos de sistema e latências que podem ser associados ao fornecimento da retroalimentação para o usuário por meio do dispositivo de HMD 42. Dessa maneira, a latência associada à retroalimentação 78 que é percebida pelo usuário pode ser minimizada.

[00061] Nos exemplos descritos acima, será verificado que qualquer taxa de sondagem de sensores adequada e progressão temporal de taxas de sondagem aumentadas podem ser utilizadas. De modo similar, quaisquer poses, gestos ou outros movimentos de mão adequados podem ser designados como pré-eventos e eventos-alvo.

[00062] Conforme verificado acima, também será verificado que diversos outros sistemas de sensores podem detectar diversas outras formas de informações relacionadas ao usuário 52 e dispositivo de HMD 42 podem fornecer tais informações ao programa de reconhecimento de evento adaptativo 14. Tais informações podem ser correlacionadas a outros pré-eventos, padrões e eventos-alvo associados que se referem às informações.

[00063] Também será observado que os pré-eventos e padrões de Figura 5 podem ser determinados empiricamente através de estudos laboratoriais, estudos de usuário ou quaisquer outros métodos adequados. As lacunas de tempo estimadas entre a ocorrência de pré- eventos e a execução de eventos-alvo podem ser determinadas de modo similar através de estudos laboratoriais, estudos de usuário ou quaisquer outros métodos adequados. Em que um evento-alvo selecionado é previsto, uma probabilidade de limite do evento-alvo selecionado que ocorre que segue um penúltimo pré-evento pode ser utilizado para diminuir a ocorrência de erros de previsão. Em alguns exem-plos, pré-eventos, eventos-alvo, padrões e lacunas de tempo estimadas podem ser armazenados em armazenamento em massa 18 de dispositivo de computação 22 ou em uma fonte remota que é acessada por meio de rede 16.

[00064] As Figuras 6A e 6B ilustram um fluxograma de um método 600 para reconhecer um evento-alvo selecionado de acordo com uma modalidade da presente descrição. A descrição a seguir de método 600 é fornecida com referência aos componentes de software e hardware do sistema de reconhecimento de evento adaptativo 10 descrito acima e mostrado nas Figuras 1 e 2. Será verificado que o método 600 também pode ser executado em outros contextos com o uso de outros componentes de hardware e software adequados.

[00065] Em referência à Figura 6A, em 604, o método 600 inclui, em um dispositivo de exibição que compreende uma pluralidade de sensores, operar um sensor selecionado a partir da pluralidade de sensores em uma primeira taxa de sondagem que corresponde a uma latência de potencial mais elevada. Em 608, a pluralidade de sensores de entrada pode ser selecionada a partir de sensores de imagem, sensores de posição, microfones, sensores de rastreamento ocular e sensores biométricos. Em 612, o dispositivo de exibição é um dispositivo de exibição montado na parte superior.

[00066] Em 616, o método 600 pode incluir receber informações iniciais relacionadas ao usuário do sensor selecionado. Em 620, em que as informações iniciais relacionadas ao usuário não são recebidas dentro de um período de tempo predeterminado, em que o método 600 pode incluir controlar o sensor selecionado para operar em uma taxa de sondagem de tempo expirado que é mais lenta que a primeira taxa de sondagem. Em 624, o método 600 pode incluir determinar se as informações iniciais relacionadas ao usuário correspondem a um dentre uma pluralidade de pré-eventos, em que cada um dos pré-eventos corresponde a um ou mais padrões diferentes de pré-eventos e, cada um dos padrões leva a um evento-alvo possível diferente. Em 628, cada um dos padrões pode compreender uma sequência diferente dos pré-eventos.

[00067] Em 632, em que as informações iniciais relacionadas ao usuário correspondem a um dentre uma pluralidade de pré-eventos, o método 600 pode incluir operar o sensor selecionado em uma segunda taxa de sondagem que é mais rápida que a primeira taxa de sonda- gem e que corresponde a uma latência potencial inferior que é menor que a latência de potencial mais elevada. Em 636, após receber as informações iniciais relacionadas ao usuário, o método 600 pode incluir pré-buscar pelo menos uma porção da retroalimentação associada ao evento-alvo selecionado.

[00068] Agora, em referência à Figura 6B, após receber as informações iniciais relacionadas ao usuário e antes de receber informações relacionadas ao usuário subsequentes, em 640, o método 600 pode incluir receber informações relacionadas ao usuário intermediárias do sensor selecionado. Em 644, o método 600 pode incluir determinar se as informações relacionadas ao usuário intermediárias correspondem a um pré-evento de um subconjunto da pluralidade de pré-eventos. Em 648, em que as informações relacionadas ao usuário intermediárias correspondem a um pré-evento do subconjunto da pluralidade de pré- eventos, o método 600 pode incluir operar o sensor selecionado em uma terceira taxa de sondagem que é mais rápida que a primeira taxa de sondagem e é mais lenta que a segunda taxa de sondagem.

[00069] Em 652, o método 600 pode incluir receber informações relacionadas ao usuário subsequentes do sensor selecionado. Em 656, em que as informações relacionadas ao usuário subsequentes correspondem ao evento-alvo selecionado dentre os eventos-alvo possíveis diferentes, o método 600 pode incluir fornecer retroalimentação associada ao evento-alvo selecionado para o usuário por meio do dispositivo de exibição. Em 660, o evento-alvo selecionado pode compreender um gesto de mão. Em 664, em que as informações relacionadas ao usuário subsequentes correspondem a um pré-evento predi- tivo que não é o evento-alvo selecionado, o método 600 pode incluir determinar um tempo de execução estimado no qual o evento-alvo se-lecionado ocorrerá. Em 668, o método pode incluir fornecer a retroalimentação associada ao evento-alvo selecionado para o usuário tanto no tempo de execução estimado quanto antes do tempo de execução estimado.

[00070] Será observado que o método 600 é fornecido a título de exemplificação e não se destina a ser limitante. Portanto, deve ser entendido que o método 600 pode incluir etapas adicionais e/ou alternativas que aquelas ilustradas nas Figuras 6A e 6B. Adicionalmente, deve ser entendido que o método 600 pode ser executado em qualquer ordem adequada. Ainda adicionalmente, deve ser entendido que uma ou mais etapas podem ser omitidas do método 600 sem se afastar do escopo dessa descrição.

[00071] A Figura 7 mostra esquematicamente uma modalidade não limitante de um sistema de computação 700 que pode executar um ou mais dos métodos e processos descritos acima. O dispositivo de computação 22 pode assumir a forma de sistema de computação 700. O sistema de computação 700 é mostrado de forma simplificada. Deve- se entender que virtualmente qualquer arquitetura de computador pode ser usada sem se afastar do âmbito desta descrição. Em modalidades diferentes, o sistema de computação 700 pode assumir a forma de um computador principal, computador de servidor, computador do tipo desktop, computador do tipo laptop, computador do tipo tablet, computador de entretenimento doméstico, rede dispositivo de computação, dispositivo de computação móvel, dispositivo de comunicação móvel, dispositivo de jogos, etc. Conforme verificado acima, em alguns exem-plos, o sistema de computação 700 pode ser integrado a um dispositivo de HMD.

[00072] Conforme mostrado na Figura 7, o sistema de computação 700 inclui um subsistema de lógica 704 e um subsistema de armazenamento 708. O sistema de computação 700 pode incluir opcionalmente um subsistema de exibição 712, um subsistema de comunicação 716, um subsistema de sensor 720, um subsistema de entrada 722 e/ou outros subsistemas e componentes não mostrados na Figura 7. O sistema de computação 700 também pode incluir meio legível por computador, com o meio legível por computador que inclui meio de armazenamento legível por computador e meio de comunicação legível por computador. O sistema de computação 700 também pode incluir opcionalmente outro dispositivo de entrada de usuários como teclados, mouse, controladores de jogos e/ou telas sensíveis ao toque, por exemplo. Adicionalmente, em algumas modalidades, os métodos e processos descritos no presente documento podem ser implantados como um aplicativo de computador, serviço de computador, API de computador, biblioteca de computador e/ou outro produto de programa de computador em um sistema de computação que inclui um ou mais computadores.

[00073] O subsistema de lógica 704 pode incluir um ou mais dispositivos físicos configurados para executar uma ou mais instruções. Por exemplo, o subsistema de lógica 704 pode ser configurado para executar uma ou mais instruções são partes de uma ou mais aplicações, serviços, programas, rotinas, bibliotecas, objetos, componentes, estruturas de dados, ou outras construções lógicas. Tais instruções podem ser implantadas para executar uma tarefa, implantar um tipo de dados, transformar o estado de um ou mais dispositivos ou, de outro modo, chegar a um resultado desejado.

[00074] O subsistema de lógica pode incluir um ou mais processadores que são configurados para executar instruções de software. Adicional ou alternativamente, o subsistema de lógica pode incluir uma ou mais máquinas de lógica de firmware ou hardware para configuradas para executar instruções de hardware ou de firmware. Processadores do subsistema de lógica podem ser de único núcleo ou múltiplos núcleos e os programas executados nos mesmos podem ser configurados para processamento de distribuição ou paralelo. O subsistema de lógica pode opcionalmente incluir componentes individuais que são distribuídos por dois ou mais dispositivos, os quais podem ser remotamente localizados e/ou configurados para processamento coordenado. Um ou mais aspectos do subsistema de lógica podem ser virtuali- zados e executados por dispositivos de computação em rede remotamente acessíveis em uma configuração de computação em nuvem.

[00075] O subsistema de armazenamento 708 pode incluir um ou mais dispositivos persistentes físicos configurados para manter os dados e/ou instruções executáveis pelo subsistema de lógica 704 para implantar os métodos e processos descritos no presente documento. Quando tais métodos e processos são implantados, o estado do subsistema de armazenamento 708 pode ser transformado (por exemplo, para manter dados diferentes).

[00076] O subsistema de armazenamento 708 pode incluir meio removível e/ou dispositivos embutidos. O subsistema de armazenamento 708 pode incluir dispositivos de memória óptica (por exemplo, CD, DVD, HD-DVD, Disco de Blu-Ray, etc.), dispositivos de memória semicondutora (por exemplo, RAM, EPROM, EEPROM, etc.) e/ou dispositivos de memória magnética (por exemplo, unidade de disco rígido, unidade de disco flexível, unidade de fita, MRAM, etc.) dentre outros. O subsistema de armazenamento 708 pode incluir dispositivos com uma ou mais dentre as seguintes características: volátil, não volátil, dinâmico, estático, leitura/escrita, apenas leitura, acesso aleatório, acesso sequencial, localização endereçável, arquivo endereçável e conteúdo endereçável.

[00077] Em algumas modalidades, aspectos de subsistema de lógica 704 e subsistema de armazenamento 708 podem ser integrados a um ou mais dispositivos comuns através dos quais a funcionalidade descrita no presente documento pode ser promulgada, pelo menos em parte. Tais componentes de lógica de hardware podem incluir arranjos de porta programável em campo (FPGAs), circuitos integrados específicos de aplicativo e programa (PASIC / ASICs), produtos padrão específicos de aplicativo e programa (PSSP / ASSPs), sistemas de sistema em um chip (SOC) e dispositivos de lógica programáveis complexos (CPLDs), por exemplo.

[00078] A Figura 7 também mostra um aspecto do subsistema de armazenamento 708 sob a forma de meio de armazenamento legível por computador removível 724, que pode ser usado para armazenar dados e/ou instruções executáveis para implantar os métodos e processos descritos no presente documento. Um meio de armazenamento legível por computador removível 724 pode ter uma forma de CDs, DVDs, HD-DVDs, Discos de Blu-Ray, EEPROMs e/ou discos flexíveis, entre outras.

[00079] Deve-se observar que o subsistema de armazenamento 708 inclui um ou mais dispositivos persistentes físicos. Em contrapartida, em algumas modalidades, aspectos das instruções descritas no presente documento podem ser propagadas de uma maneira transitória por um sinal puro (por exemplo, um sinal eletromagnético, um sinal óptico, etc.) que não é mantido por um dispositivo físico por pelo menos uma duração finita. Ademais, dados e/ou outras formas de informações referentes à presente descrição podem ser propagadas por um sinal puro por meio de meio de comunicação legível por computador.

[00080] Quando incluído, o subsistema de exibição 712 pode ser usado para apresentar uma representação visual de dados mantidos pelo subsistema de armazenamento 708. Conforme os métodos e processos descritos acima alteram os dados mantidos pelo subsistema de armazenamento 708 e, desse modo, transformam o estado do subsistema de armazenamento, o estado do subsistema de exibição 712 pode, do mesmo modo, ser transformado para representar de modo vi sual as alterações nos dados subjacentes. O subsistema de exibição 712 pode incluir um ou mais dispositivos de exibição que utilizam virtualmente qualquer tipo de tecnologia. Tais dispositivos de exibição podem ser combinados com subsistema de lógica 704 e/ou o subsistema de armazenamento 708 em um compartimento compartilhado, ou tais dispositivos de exibição podem ser dispositivos de exibição periféricos. O subsistema de exibição 712 pode incluir, por exemplo, o sistema de exibição 56 e visor transparente 54 do dispositivo de HMD 42.

[00081] Quando incluído, o subsistema de comunicação 716 pode ser configurado para acoplar de modo comunicativo o sistema de computação 700 com uma ou mais redes e/ou um ou mais outros dispositivos de comunicação. O subsistema de computação 716 pode incluir dispositivos de comunicação com ou sem fio com um ou mais protocolos de comunicação diferentes. Como exemplos não limitantes, o subsistema de comunicação 716 pode ser configurado para comunicação por meio de uma rede de telefone sem fio, uma rede de área local sem fio, uma rede de área local com fio, uma rede de área ampla sem fio, uma rede de área ampla com fio, etc. Em algumas modalidades, o subsistema de comunicação pode permitir que o sistema de computação 700 envie e/ou receba mensagens para e/ou de outros dispositivos por meio de uma rede tal como a Internet.

[00082] O subsistema de sensor 720 pode incluir um ou mais sensores configurados para constatar fenômenos físicos diferentes (por exemplo, luz visível, luz infravermelha, som, aceleração, orientação, posição, etc.) e/ou processos fisiológicos, funções, medições e/ou estados, conforme descrito acima. Por exemplo, o subsistema de sensor 720 pode compreender um ou mais sensores de rastreamento ocular, sensores de imagem, microfones, sensores de movimento como ace- lerômetros, bússolas, teclados sensíveis ao toque, telas sensíveis ao toque, monitores de frequência cardíaca, oxímetros de pulso, sensores de resposta eletrodermal, monitores eletroencefalográficos (EEG) e/ou quaisquer outros sensores adequados.

[00083] Em algumas modalidades, o subsistema de sensor 720 pode incluir uma câmera de profundidade. A câmera de profundidade pode incluir câmeras esquerda e direita de um sistema de visão estereoscópica, por exemplo. As imagens de resolução no tempo de ambas as câmeras podem ser registradas umas para as outras e combinadas para render vídeo de resolução profunda. Em outras modalidades, a câmera de profundidade pode ser uma câmera de profundidade de luz estruturada ou uma câmera de tempo de voo, conforme descrito acima. Em algumas modalidades, o subsistema de sensor 720 pode incluir uma câmera de luz visível, como uma câmera digital. Virtualmente, qualquer tipo de tecnologia de câmera digital pode ser usado sem se afastar do escopo dessa descrição. Como um exemplo não limitante, a câmera de luz visível pode incluir um sensor de imagem de dispositivo acoplado de carga.

[00084] O subsistema de sensor 720 pode ser configurado para fornecer dados de sensor ao subsistema de lógica 704, por exemplo. Conforme descrito acima, tais dados podem incluir informações de ras- treamento ocular, informações de imagem, informações de áudio, informações de iluminação de ambiente, informações de profundidade, informações de posição, informações de movimento, informações de localização de usuário, informações de parâmetro biométrico e/ou quaisquer outros dados de sensor adequados que podem ser usados para executar os métodos e processos descritos acima.

[00085] Quando incluído, o subsistema de entrada 722 pode compreender ou fazer interface com um ou mais sensores ou dispositivos de entrada de usuário, como um controlador de jogos, dispositivo de detecção de entrada de gesto, reconhecedor de voz, unidade de medição de inércia, teclado, mouse ou tela sensível ao toque. Em algumas modalidades, o subsistema de entrada 722 pode compreender ou fazer interface com conjunto de componentes de entrada de usuário natural (NUI) selecionado. Tal conjunto de componentes pode ser integrado ou periférico e a transdução e/ou processamento de ações de entrada pode ser tratado integrado ou não integrado. O conjunto de componentes NUI exemplificativo pode incluir um microfone para fala e/ou reconhecimento de voz; um infravermelho, cor, estereoscópico e/ou câmera de profundidade para visão de máquina e/ou reconhecimento de gesto; um rastreador de cabeça, rastreador de olho, acele- rômetro e/ou giroscópio para detecção de movimento e/ou reconhecimento de intenção; bem como conjunto de componentes de constatação de campo elétrico para avaliar atividade cerebral.

[00086] O termo "programa" pode ser usado para descrever um aspecto do sistema de reconhecimento de evento adaptativo 10 que é implantado para executar uma ou mais funções particulares. Em alguns casos, tal programa pode ser instanciado por meio de subsistema de lógica 704 que executa instruções mantidas por subsistema de armazenamento 708. Deve ser entendido que programas diferentes podem ser instanciados a partir da mesma aplicação, serviço, bloco de código, objeto, biblioteca, rotina, API, função, etc. Do mesmo modo, o mesmo programa pode ser instanciado por aplicativos diferentes, serviços, blocos de código, objetos, rotinas, APIs, funções, etc. O termo "programa" deve abranger arquivos executáveis individuais ou de grupos, arquivos de dados, bibliotecas, acionadores, scripts, registros de bando de dados, etc.

[00087] Deve-se entender que as configurações e/ou abordagens descritas no presente documento são de natureza exemplificativa, e que essas modalidades específicas ou exemplos não devem considerados em um sentido limitante, porque inúmeras variações são possíveis. As rotinas ou métodos específicos descritos no presente docu- mento podem representar uma ou mais dentre várias estratégias de processamento. Como tal, vários atos ilustrados podem ser executados na sequência ilustrada, em outras sequências, em paralelo ou, em alguns casos, omitidos. Igualmente, a ordem dos processos descritos acima pode ser mudada.

[00088] A matéria da presente descrição inclui todas as combinações inovadoras e não óbvias e subcombinações dos vários processos, sistemas e configurações, e outros recursos, funções, atos, e/ou propriedades reveladas no presente documento, assim como qualquer um e todos os equivalentes dos mesmos.

Claims (10)

1. Sistema de reconhecimento de evento adaptativo que compreende: um dispositivo de exibição (42) conectado de modo operacional a um dispositivo de computação (22), em que o dispositivo de exibição (42) inclui um sistema de exibição (56) e uma pluralidade de sensores de entrada (60-70); e um programa de reconhecimento de evento adaptativo (14) executado por um processador (30) do dispositivo de computação (22), em que o programa de reconhecimento de evento adaptativo (14) é configurado para: operar um sensor selecionado (62) a partir da pluralidade de sensores de entrada (60-70) em uma primeira taxa de sondagem que corresponde a uma latência potencial mais elevada; receber informações relacionadas a usuário iniciais do sensor selecionado (62); determinar se as informações relacionadas a usuário iniciais correspondem a um (510) dentre uma pluralidade de pré-eventos (506, 510, 514, 518), em que cada um dentre os pré-eventos (506, 510, 514, 518) corresponde a um ou mais padrões diferentes de pré- eventos (522, 526, 530), e cada um dos padrões leva a um evento- alvo possível diferente (534, 538, 542), em que as informações iniciais relacionadas ao usuário correspondem aos movimentos das mãos (304) executados pelo usuário que levam a um evento alvo (534) compreendendo um gesto de mão alvo (330); onde as informações relacionadas a usuário iniciais correspondem a um dentre a pluralidade de pré-eventos (510-550), operar o sensor selecionado (62) em uma segunda taxa de sondagem que é mais rápida que a primeira taxa de sondagem e que corresponde a uma latência potencial inferior que é menor que a latência potencial mais elevada; receber informações relacionadas a usuário subsequentes do sensor selecionado (62), em que as informações subsequentes re-lacionadas ao usuário correspondem a outros movimentos das mãos (304) executados pelo usuário; caracterizado pelo fato de que onde as informações relacionadas a usuário subsequentes correspondem a um pré-evento preditivo (554) que corresponde a uma probabilidade predeterminada de que o evento alvo único (534) selecionado dentre os eventos-alvos possíveis diferentes irá ocorrer de modo subsequente: determinar um tempo de execução estimado (340) no qual o evento alvo único (534) ocorrerá que corresponde à conclusão do gesto de mão alvo (330) realizado pelo usuário; e fornecer retroalimentação associada ao evento alvo único (534) através do dispositivo de exibição para o usuário antes do tempo de execução estimado.

2. Sistema de reconhecimento de evento adaptativo, de acordo com a reivindicação 1, caracterizado pelo fato de que fornecer retroalimentação associada ao evento alvo único (534) através do dispositivo de exibição para o usuário antes do tempo estimado de execução é usado para compensar pelo menos um dentre os atrasos de sistema e processamento associados ao fornecimento de retroalimentação para o usuário.

3. Sistema de reconhecimento de evento adaptativo, de acordo com a reivindicação 1, caracterizado pelo fato de que o programa de reconhecimento de evento adaptativo é configurado adicionalmente para, após receber as informações iniciais relacionadas a usuário, pré-buscar pelo menos uma porção da retroalimentação associada aos possíveis eventos alvo (534).

4. Sistema de reconhecimento de evento adaptativo, de acordo com a reivindicação 1, caracterizado pelo fato de que o dispositivo de exibição é um dispositivo de exibição montado na parte superior.

5. Método para reconhecer um evento alvo (534) que compreende as etapas de: em um dispositivo de exibição (42) que compreende uma pluralidade de sensores de entrada (60-70), operando (604) um sensor selecionado (62) da pluralidade de sensores de entrada (60-70) em uma primeira taxa de sondagem que corresponde a uma latência potencial mais elevada; receber (616) informações iniciais relacionadas ao usuário do sensor selecionado (62); determinar (624) se as informações iniciais relacionadas ao usuário correspondem a um (510) dentre uma pluralidade de pré- eventos (506, 510, 514, 518), em que cada um dentre os pré-eventos (506, 510, 514, 518) corresponde a um ou mais padrões diferentes de pré-eventos (522, 526, 530), e cada um dos padrões leva a um evento- alvo possível diferente, em que as informações iniciais relacionadas ao usuário correspondem aos movimentos das mãos (304) executados pelo usuário que levam a um evento alvo (534) compreendendo um gesto de mão alvo (330); onde as informações relacionadas a usuário iniciais correspondem a um dentre a pluralidade de pré-eventos (510-550), operar (632) o sensor selecionado (62) em uma segunda taxa de sondagem que é mais rápida que a primeira taxa de sondagem, e que corresponde a uma latência potencial inferior que é menor que a latência potencial mais elevada; receber informações relacionadas a usuário subsequentes do sensor selecionado (62), em que as informações subsequentes re- lacionadas ao usuário correspondem a outros movimentos das mãos (304) executados pelo usuário; caracterizado pelo fato de que onde as informações relacionadas a usuário subsequentes correspondem a um pré-evento preditivo (554) que corresponde a uma probabilidade predeterminada de que o evento alvo único (534) dentre os eventos-alvos possíveis diferentes irá ocorrer de modo subsequente, o método ainda compreende: determinar (664) um tempo de execução estimado no qual o evento alvo único (534) irá ocorrer que corresponde à conclusão do gesto de mão alvo (330) realizado pelo usuário; e fornecer (668) retroalimentação associada ao evento alvo único (534) através do dispositivo de exibição para o usuário antes do tempo de execução estimado.

6. Método, de acordo com a reivindicação 5, caracterizado pelo fato de que ainda compreende: após receber as informações relacionadas a usuário iniciais e antes de receber as informações relacionadas a usuário subsequentes, receber informações relacionadas a usuário intermediárias do sensor selecionado; determinar se as informações relacionadas a usuário inter-mediárias correspondem a um pré-evento de um subconjunto da pluralidade de pré-eventos; onde as informações relacionadas a usuário intermediárias correspondem a um pré-evento do subconjunto da pluralidade de pré- eventos, operar o sensor selecionado em uma terceira taxa de sondagem que é mais rápida que a primeira taxa de sondagem e é menor que a segunda taxa de sondagem.

7. Método, de acordo com a reivindicação 5, caracterizado pelo fato de que ainda compreende, onde as informações relaciona- das a usuário iniciais não são recebidas dentro de um período de tempo predeterminado, controlar o sensor selecionado para operar em uma taxa de sondagem de tempo expirado que é mais lenta que a primeira taxa de sondagem.

8. Método, de acordo com a reivindicação 5, caracterizado pelo fato de que cada um dos padrões compreende uma sequência diferente dos pré-eventos.

9. Método, de acordo com a reivindicação 5, caracterizado pelo fato de que a pluralidade de sensores de entrada é selecionada a partir do grupo que consiste em sensores de imagem, sensores de posição, microfones, sensores de rastreamento ocular e sensores bi- ométricos.

10. Meio legível por computador, caracterizado pelo fato de que tem o método conforme definido em qualquer uma das reivindicações 5 a 9.

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US13/927,051 US8988345B2 (en) | 2013-06-25 | 2013-06-25 | Adaptive event recognition |

| US13/927,051 | 2013-06-25 | ||

| PCT/US2014/043307 WO2014209773A1 (en) | 2013-06-25 | 2014-06-20 | Adaptive event recognition |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| BR112015032026A2 BR112015032026A2 (pt) | 2017-07-25 |

| BR112015032026A8 BR112015032026A8 (pt) | 2019-12-31 |

| BR112015032026B1 true BR112015032026B1 (pt) | 2022-04-26 |

Family

ID=51210776

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| BR112015032026-0A BR112015032026B1 (pt) | 2013-06-25 | 2014-06-20 | Sistema de reconhecimento de evento adaptativo, método para reconhecer um evento alvo e meio legível por computador |

Country Status (11)

| Country | Link |

|---|---|

| US (1) | US8988345B2 (pt) |

| EP (1) | EP3014391B1 (pt) |

| JP (1) | JP6348176B2 (pt) |

| KR (1) | KR102272968B1 (pt) |

| CN (1) | CN105393191B (pt) |

| AU (1) | AU2014302875B2 (pt) |

| BR (1) | BR112015032026B1 (pt) |

| CA (1) | CA2914061C (pt) |

| MX (1) | MX352773B (pt) |

| RU (1) | RU2684189C2 (pt) |

| WO (1) | WO2014209773A1 (pt) |

Families Citing this family (83)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9158116B1 (en) | 2014-04-25 | 2015-10-13 | Osterhout Group, Inc. | Temple and ear horn assembly for headworn computer |

| US9400390B2 (en) | 2014-01-24 | 2016-07-26 | Osterhout Group, Inc. | Peripheral lighting for head worn computing |

| US9715112B2 (en) | 2014-01-21 | 2017-07-25 | Osterhout Group, Inc. | Suppression of stray light in head worn computing |

| US9952664B2 (en) | 2014-01-21 | 2018-04-24 | Osterhout Group, Inc. | Eye imaging in head worn computing |

| US9298007B2 (en) | 2014-01-21 | 2016-03-29 | Osterhout Group, Inc. | Eye imaging in head worn computing |

| US9229233B2 (en) | 2014-02-11 | 2016-01-05 | Osterhout Group, Inc. | Micro Doppler presentations in head worn computing |

| US9965681B2 (en) | 2008-12-16 | 2018-05-08 | Osterhout Group, Inc. | Eye imaging in head worn computing |

| US10234942B2 (en) | 2014-01-28 | 2019-03-19 | Medibotics Llc | Wearable and mobile brain computer interface (BCI) device and method |

| US11172859B2 (en) | 2014-01-28 | 2021-11-16 | Medibotics | Wearable brain activity device with auditory interface |

| US10130277B2 (en) | 2014-01-28 | 2018-11-20 | Medibotics Llc | Willpower glasses (TM)—a wearable food consumption monitor |

| US9814426B2 (en) | 2012-06-14 | 2017-11-14 | Medibotics Llc | Mobile wearable electromagnetic brain activity monitor |

| US9968297B2 (en) | 2012-06-14 | 2018-05-15 | Medibotics Llc | EEG glasses (electroencephalographic eyewear) |

| US11662819B2 (en) | 2015-05-12 | 2023-05-30 | Medibotics | Method for interpreting a word, phrase, and/or command from electromagnetic brain activity |

| US9428072B2 (en) * | 2014-01-09 | 2016-08-30 | Ford Global Technologies, Llc | Method and system for extending battery life |

| US9829707B2 (en) | 2014-08-12 | 2017-11-28 | Osterhout Group, Inc. | Measuring content brightness in head worn computing |

| US11227294B2 (en) | 2014-04-03 | 2022-01-18 | Mentor Acquisition One, Llc | Sight information collection in head worn computing |

| US9575321B2 (en) | 2014-06-09 | 2017-02-21 | Osterhout Group, Inc. | Content presentation in head worn computing |

| US9841599B2 (en) | 2014-06-05 | 2017-12-12 | Osterhout Group, Inc. | Optical configurations for head-worn see-through displays |