WO2025041288A1 - 情報処理装置、情報処理方法および記録媒体 - Google Patents

情報処理装置、情報処理方法および記録媒体 Download PDFInfo

- Publication number

- WO2025041288A1 WO2025041288A1 PCT/JP2023/030242 JP2023030242W WO2025041288A1 WO 2025041288 A1 WO2025041288 A1 WO 2025041288A1 JP 2023030242 W JP2023030242 W JP 2023030242W WO 2025041288 A1 WO2025041288 A1 WO 2025041288A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- user

- mindfulness

- state

- image

- image content

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- G—PHYSICS

- G16—INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR SPECIFIC APPLICATION FIELDS

- G16H—HEALTHCARE INFORMATICS, i.e. INFORMATION AND COMMUNICATION TECHNOLOGY [ICT] SPECIALLY ADAPTED FOR THE HANDLING OR PROCESSING OF MEDICAL OR HEALTHCARE DATA

- G16H20/00—ICT specially adapted for therapies or health-improving plans, e.g. for handling prescriptions, for steering therapy or for monitoring patient compliance

Definitions

- This disclosure relates to information processing devices, etc.

- Mindfulness is practiced to maintain a good mental and physical state through meditation or exercise.

- Mindfulness is, for example, an activity that involves meditation or exercise to improve one's mental and physical state.

- a person who practices meditation as a form of mindfulness improves their internal state to one that is appropriate for life or work through meditation.

- Mindfulness-related actions may also be supported by an information processing device.

- the content and schedule of mindfulness-related actions are presented by an application program running on the information processing device.

- the mood change support device of Patent Document 1 outputs an image showing the contents of mindfulness during the worker's mood change period.

- the worker refers to the image and performs an action related to mindfulness.

- the present disclosure aims to provide an information processing system etc. that can make it easier for users to take actions to improve their condition in order to solve the above problems.

- the information processing device disclosed herein includes a determination means for determining the state of a user who uses image content, a determination means for determining the content of image content that encourages the user to behave in a mindfulness-related manner based on the user's state, and an output means for outputting the determined content of image content.

- the information processing method disclosed herein determines the state of a user who is using image content, determines the content of image content that will encourage the user to engage in mindfulness-related behavior based on the user's state, and outputs the determined content of the image content.

- the recording medium disclosed herein is a recording medium that non-temporarily records a program that causes a computer to execute a process of determining the state of a user who uses image content, a process of determining the content of image content that encourages the user to behave in a mindfulness-related manner based on the user's state, and a process of outputting the content of the determined image content.

- This disclosure makes it easier for users to take action to improve their condition.

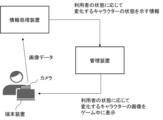

- FIG. 1 is a diagram illustrating an example of a configuration of an information processing system according to the present disclosure.

- FIG. 2 is a diagram illustrating an example of a data flow in the present disclosure.

- FIG. 1 is a diagram illustrating an example of a configuration of an information processing device according to the present disclosure.

- FIG. 2 is a diagram showing an example of a display screen in the present disclosure.

- FIG. 2 is a diagram showing an example of a display screen in the present disclosure.

- FIG. 2 is a diagram showing an example of a display screen in the present disclosure.

- FIG. 2 is a diagram showing an example of a display screen in the present disclosure.

- FIG. 11 is a diagram illustrating an example of an operation flow of an information processing device according to the present disclosure.

- FIG. 2 is a diagram illustrating an example of a hardware configuration according to the present disclosure.

- FIG. 1 is a diagram showing an example of the configuration of an information processing system.

- the action support system includes, for example, an information processing device 10, a terminal device 20, a sensor 30, and a management device 40.

- the information processing device 10 is connected to the management device 40, for example, via a network.

- the information processing device 10 is connected to the sensor 30, for example, via a network.

- the terminal device 20 is connected to the management device 40, for example, via a network.

- the information processing device 10 may also be connected to the terminal device 20 via a network.

- the number of terminal devices 20 and sensors 30 may be set as appropriate.

- the terminal devices 20 and sensors 30 may also be an integrated system.

- the information processing system is, for example, a system in which a user uses image content.

- the user is, for example, a person who uses image content by operating the terminal device 20.

- the image content is, for example, an entertaining image.

- the image may include a moving image, i.e., a video.

- the image content is used to provide entertainment to the user, for example, by using an image of a character.

- the image content is, for example, a game.

- the image content is a game

- the user is, for example, a person who plays the game. That is, when the image content is a game, the user is a player of the game.

- the image content may be an image that is displayed other than when the game is being played.

- the game may be a game played using equipment installed in an amusement facility.

- the image content may be an image displayed on the standby screen or standby screen of the terminal device 20.

- the image displayed on the standby screen or standby screen is, for example, an image displayed when the user is not operating the terminal device 20.

- the image content may be displayed on the display screen when a condition for displaying the image content is met.

- the image content may be an image that is constantly displayed on a part of the display screen or on the background. Image content is not limited to the above.

- the information processing system is a system that supports a user's mindfulness-related behavior using, for example, image content.

- Mindfulness for example, means maintaining a good mental and physical state.

- mindfulness-related behavior is, for example, behavior that a user performs to maintain his or her own mental and physical state in a good state.

- the mental and physical state is, for example, an inner state or a physical state.

- maintaining a good inner state means, for example, removing distracting thoughts. Maintaining a good inner state means, for example, reducing stress. Also, maintaining a good inner state means, for example, maintaining a calm mood.

- the user when a user is feeling down, the user performs a mindfulness-related behavior to restore the user's emotions to a normal state.

- mindfulness-related behavior may be one that calms the user's emotions when the user is feeling excited.

- the physical state is, for example, a physical state that can affect the inner state. For example, when a user is tired, the user is likely to feel down. In this case, the user's fatigue is a physical state that can affect the inner state.

- the user's actions related to mindfulness are, for example, actions that themselves lead to mindfulness, and actions that prepare for mindfulness.

- Actions that themselves lead to mindfulness are, for example, at least one of meditation, walking, exercise, yoga, and eating.

- meditation includes, for example, breathing control.

- Actions that themselves lead to mindfulness may include sleeping.

- actions that themselves lead to mindfulness are not limited to the above.

- actions that prepare for mindfulness include, for example, acquiring items to be used in mindfulness.

- An example of acquiring items to be used in mindfulness is purchasing items to be used in mindfulness.

- An example of actions that prepare for mindfulness may include researching items to be purchased.

- an example of actions that prepare for mindfulness is signing up for a service related to mindfulness.

- An example of actions that prepare for mindfulness may include researching a service to be signed up for.

- an example of actions that prepare for mindfulness is not limited to the above.

- Supporting mindfulness-related behavior means, for example, encouraging a user to perform mindfulness-related behavior.

- Supporting mindfulness-related behavior using image content means, for example, presenting a user with an image that motivates the user to perform mindfulness-related behavior.

- Supporting mindfulness-related behavior means, for example, presenting an image that encourages the user to perform mindfulness-related behavior.

- An image that encourages mindfulness-related behavior is, for example, an image of a game character that changes according to the user's mindfulness-related behavior.

- Supporting mindfulness-related behavior may also mean making an event appear within the game that encourages the user to perform mindfulness-related behavior. If the image that encourages mindfulness-related behavior is other than a game character, for example, an image that the user likes is used as the image that encourages mindfulness-related behavior.

- the image that encourages mindfulness-related behavior may be a character from an animation work that the user likes.

- the image that encourages mindfulness-related behavior may be a character depicting an animal that the user likes. Images that encourage mindfulness-related behavior are not limited to the above.

- FIG. 2 is a diagram that shows a schematic example of the flow of data in an information processing system.

- the example in FIG. 2 is a diagram that shows a state in which a user is playing a game by operating a terminal device 20 and accessing a management device 40.

- a camera captures an image of a user who is a player of the game.

- the camera is an example of a sensor 30.

- the camera for example, outputs captured image data to the information processing device 10.

- the information processing device 10 judges the state of the user based on the acquired image data.

- the information processing device 10 determines the state of a character in the game based on the state of the user, for example.

- the state of a character in the game changes depending on the state of the user, for example.

- the information processing device 10 outputs information indicating the determined state of the character to, for example, the management device 40. That is, the information processing device 10 outputs information indicating the state of the character that changes depending on the state of the user to the management device 40.

- the management device 40 outputs, for example, an image generated based on the state of the character acquired from the information processing device 10 to the terminal device 20 as an image of the character in the game. That is, the management device 40 displays an image of a character that changes depending on the state of the user during the game.

- a user playing a game looks at an image of a character displayed as a game character on a display device (not shown) of the terminal device 20 and performs a mindfulness-related behavior.

- the user's fatigue is reflected in the state of the character in the game. For example, an image of the character in a tired state is displayed on the game screen. For example, by seeing the image of the character in a tired state, the user recognizes that it is a good time to take action related to mindfulness. Then, when the user takes action related to mindfulness, the character's state returns to normal. In this way, reflecting the user's state and actions related to mindfulness in the game character can motivate the user to take action related to mindfulness.

- FIG. 3 is a diagram showing an example of the configuration of the information processing device 10.

- the information processing device 10 basically includes a judgment unit 12, a decision unit 14, and an output unit 16.

- the information processing device 10 also includes, for example, an acquisition unit 11, an estimation unit 13, a generation unit 15, and a storage unit 17.

- the acquisition unit 11 acquires, for example, data related to the user's condition.

- the acquisition unit 11 acquires, for example, data related to the user's condition from the sensor 30.

- the acquisition unit 11 may acquire data related to the user's condition from the sensor 30 via the terminal device 20.

- the acquisition unit 11 may also acquire data related to the user's condition from the sensor 30 via the management device 40.

- the data related to the user's condition is, for example, data used to determine the user's condition.

- the user's condition is, for example, the mental and physical condition of the user.

- the data related to the user's condition is data related to at least one of the user's inner state and physical state.

- the data related to the user's condition is, for example, data used to determine at least one of the user's inner state and physical state.

- the acquisition unit 11 acquires, for example, the user's condition when the user is performing an action related to mindfulness.

- the acquisition unit 11 may also acquire the user's condition when the user has completed an action related to mindfulness.

- the acquisition unit 11 may acquire the user's status at least one of the timings when the terminal device 20 is started and when the operation is terminated.

- the acquisition unit 11 may also acquire the user's status at least one of the timings when the use of the terminal device 20 is started and when the use is terminated.

- the timing of acquiring the user's status is not limited to the above.

- the data relating to the user's condition is, for example, image data of a photograph of the user.

- the sensor 30 is, for example, a camera that captures at least one of the user's facial expressions and body movements.

- the data relating to the user's condition is, for example, image data of a photograph of the user playing the game.

- the data relating to the user's condition may be, for example, the user's biometric data.

- the user's biometric data is, for example, measurement data that may be affected by the user's internal and physical conditions.

- the biometric data is, for example, at least one of the following measurement data: body temperature, pulse rate, heart rate, blood pressure, and sweat rate.

- the biometric data is not limited to the above.

- the user's biometric data is, for example, measured by a sensor 30 worn by the user. Also, a smartwatch worn by the user may be equipped with a sensor 30 that measures the biometric data.

- the data relating to the user's condition may be data on the user's speech and behavior.

- the user's speech and behavior data is, for example, data that reflects the user's inner state.

- the user's speech and behavior data is, for example, at least one of the following data: the voice of a conversation the user is having with another person, the voice input to a voice recognition device, and the voice emitted by the user for live commentary.

- the user's speech and behavior data is not limited to the above.

- the sensor 30 is a microphone that collects the user's voice.

- the data on the user's status is data on the operation status of the device by the user.

- the data on the operation status of the device by the user is, for example, a log of the operation of the device by the user.

- the operation log of the device by the user is, for example, a log of operations in which the manner of operation may change depending on the user's internal state.

- the operation log of the device by the user may be a log of at least one of the following items: the interval between operations, the speed of the operation, the strength of the operation, operation errors, and redoing of operations.

- the strength of the operation is, for example, the strength of the force applied by the user to the device for operation.

- the operation log of the device by the user is not limited to the above.

- the data on the operation status of the device by the user is collected by, for example, the terminal device 20. Then, the acquisition unit 11 acquires the data on the operation status of the device by the user from the terminal device 20.

- the determination unit 12 determines the state of the user who is using the image content.

- the determination of the user's state is, for example, determining the degree of the state that may affect the user's life or work. For example, if the user is highly fatigued, the user may feel depressed and this may interfere with the user's life. In this case, the determination unit 12 determines the degree of fatigue of the user, for example, based on image data of the user.

- the determination unit 12 determines, for example, at least one of the user's physical state and inner state.

- the user's physical state is at least one of posture, degree of fatigue, load, movement of each body part, speed of movement, accuracy of movement, and rhythm of movement.

- the user's physical state is not limited to the above.

- the user's inner state is at least one of the state of mind, emotion, concentration, mood, motivation, relief, tension, fear, favorability, and interest. The user's inner state is not limited to the above.

- the determination unit 12 determines the user's condition based on at least one of the user's image data, biometric data, voice data, and operation log, for example.

- the determination unit 12 may further determine the user's condition based on a purchase history. Also, the determination unit 12 may determine the user's condition based only on a purchase history.

- the data used by the determination unit 12 to determine the user's condition is not limited to the above.

- the determination unit 12 may determine the user's condition before and after the user's mindfulness-related behavior in a chronological order. By determining the user's condition before and after the user's mindfulness-related behavior in a chronological order, it is possible to determine, for example, the effect of improving the user's condition by performing a mindfulness-related behavior.

- the determination unit 12 determines at least one of the user's physical condition and inner state, for example, using an image recognition model.

- the image recognition model is, for example, a machine learning model that estimates the user's condition from image data.

- the image recognition model is, for example, a machine learning model that can recognize the emotions and degree of fatigue of a person whose face appears in an image included in a video based on a video of a person.

- the image recognition model recognizes the emotions and degree of fatigue of a person appearing in an image based on changes in feature points set on the face of the person appearing in the image.

- the image recognition model may recognize the emotions and degree of fatigue of a person appearing in an image based on changes in feature points set on a body part of the person appearing in the image.

- the image recognition model is generated, for example, by learning the relationship between an image that shows at least one of the user's face and the user's body, and the user's condition in the image.

- the determination unit 12 determines at least one of the user's physical condition and inner state, for example, using a voice recognition model.

- the voice recognition model is a machine learning model that estimates the user's condition from the voice data of the user's words and actions.

- the voice recognition model estimates the user's condition, for example, based on changes in voice speed, pitch, and strength contained in the voice data.

- the voice recognition model is generated, for example, by learning the relationship between the voice data of the user's words and actions and the user's condition.

- the determination unit 12 determines the mindfulness-related behavior performed by the user according to the content of the output image content.

- the determination unit 12, for example, determines whether the user is performing a mindfulness-related behavior based on image data of the user.

- the determination unit 12 may determine what kind of mindfulness-related behavior the user is performing based on image data of the user. That is, the determination unit 12 may determine the type of mindfulness-related behavior the user is performing based on image data of the user. Determining the type of mindfulness-related behavior means, for example, determining which behavior the user is performing from among meditation, exercise, yoga, eating, reciting, speaking, singing, and conversation.

- the determination unit 12 uses a determination model based on image data of the user to determine whether the user is meditating.

- the determination unit 12 may use a determination model based on image data of the user to determine the length of time the user has meditated.

- the determination unit 12 may further use a determination model to determine at least one of the facial expression and body movement of the user when the user is meditating, for example, based on image data of the user.

- the determination unit 12 may use a determination model to estimate the user's level of concentration on meditation based on image data of the user.

- the determination unit 12 may estimate the user's level of concentration on meditation based on, for example, body movement when the user is meditating.

- the determination unit 12 may estimate the user's level of calmness when the user is meditating, based on image data of the user.

- the determination unit 12 estimates the user's level of calmness, for example, based on the facial expression when the user is meditating.

- the determination unit 12 may determine the user's status at least one of the timings when the terminal device 20 is started and when the operation is terminated. The determination unit 12 may also determine the user's status at least one of the timings when the use of the terminal device 20 is started and when the use is terminated. The timing for determining the user's status is not limited to the above.

- the estimation unit 13 estimates a mindfulness behavior method suitable for the user, for example, based on the state of the user.

- the mindfulness behavior method suitable for the user is, for example, at least one of the timing when the user needs to perform a mindfulness-related behavior and the form of mindfulness-related behavior suitable for the user.

- the estimation unit 13 does not need to estimate a mindfulness behavior method suitable for the user.

- the estimation unit 13 estimates a suitable timing for the user to perform a mindfulness-related behavior, for example, based on the state of the user.

- the estimation unit 13 estimates a suitable timing for the user to perform a mindfulness-related behavior, for example, based on at least one of the user's internal state and physical state. For example, when the user's fatigue level exceeds a standard for which it is better to perform a mindfulness-related behavior, the estimation unit 13 estimates that it is better to perform a mindfulness-related behavior immediately. Furthermore, when the user's level of fatigue is increasing, the estimation unit 13 estimates, for example, the user's level of fatigue from the present time onward. The estimation unit 13 then estimates the timing at which the user will need to take an action related to mindfulness.

- the estimation unit 13 estimates behaviors related to mindfulness that are suitable for the user.

- the estimation unit 13 estimates the type of mindfulness behavior that is suitable for the user based on the state of the user, for example.

- estimating the type of mindfulness behavior that is suitable for the user means estimating which of meditation, exercise, yoga, eating, reciting, speaking, singing, and conversation is suitable for the user, for example.

- the estimation unit 13 may further estimate at least one of the number of times, time, frequency of repetition, intensity of load, and intake amount of the mindfulness behavior that is suitable for the user.

- the relationship between the state of the user and the type of mindfulness behavior suitable for the user is set, for example, using a table.

- the estimation unit 13, for example, refers to the table and estimates the form of mindfulness behavior suitable for the user based on the state of the user.

- the estimation unit 13 may also estimate the form of mindfulness behavior suitable for the user using an estimation model based on the state of the user.

- the estimation model is, for example, a learning model that estimates the form of mindfulness behavior suitable for the user using the state of the user as input data.

- the estimation model is generated, for example, by learning the relationship between the state of the user and the form of mindfulness behavior suitable for the user.

- the estimation model is generated, for example, by deep learning using a neural network.

- the learning model that generates the estimation model is not limited to the above.

- the estimation model is also generated, for example, in a system external to the information processing device 10.

- the estimation unit 13 estimates that meditating to calm the user is a mindfulness-related behavior suitable for the user. Also, when the determination unit 12 determines that the user has a tendency to have high blood pressure, the estimation unit 13 estimates that consuming foods that lower blood pressure is a mindfulness-related behavior suitable for the user.

- the estimation unit 13 estimates a form of mindfulness-related behavior suitable for the user, for example, based further on the user's purchasing history.

- the estimation unit 13 may estimate a form of mindfulness-related behavior suitable for the user, for example, based only on the user's purchasing history. For example, if the user purchases a supplement and the supplement is suitable for mindfulness, the estimation unit 13 estimates, for example, that taking the supplement is suitable as a mindfulness-related behavior.

- the estimation unit 13 may also estimate a form of mindfulness-related behavior suitable for the user from among behaviors that the user can perform, based on the user's purchasing history.

- the estimation unit 13 may estimate a form of mindfulness-related behavior suitable for the user from among events that are actually taking place.

- the estimation unit 13 estimates a form of mindfulness-related behavior suitable for the user based on, for example, the state of the user and a schedule of events taking place in the user's residential area. For example, when the user is emotionally unstable and a zazen event is being held at a temple, the estimation unit 13 estimates that going to the temple to do zazen is a form of mindfulness-related behavior suitable for the user.

- the determination unit 14 estimates that participating in radio calisthenics is a form of mindfulness-related behavior suitable for the user.

- the estimation unit 13 may estimate a form of mindfulness-related behavior suitable for the user from among affiliated events or products. Products may include services.

- An affiliated event or product is, for example, an event or product provided to a user by an affiliate of a business providing image content.

- the estimation unit 13 associates taking supplements provided by the affiliated business as a form of mindfulness-related behavior suitable for the user.

- the estimation unit 13 associates going to a gym operated by the affiliated business as a form of mindfulness-related behavior suitable for the user.

- the estimation unit 13 estimates going to an event held by the affiliated business as a form of mindfulness-related behavior suitable for the user.

- the estimation unit 13 estimates going to eat a healthy menu provided by the affiliated restaurant as a form of mindfulness-related behavior suitable for the user.

- the estimation unit 13 estimates that participation in a trekking event held by the affiliated business is a form of mindfulness-related behavior suitable for the user.

- Events that are to be estimated as forms of mindfulness-related behavior are not limited to the above.

- the estimation unit 13 may estimate a form of mindfulness-related behavior suitable for a user based on the state of the user at at least one of the timings when the terminal device 20 is started and when the operation is ended. Also, the estimation unit 13 may estimate a form of mindfulness-related behavior suitable for a user based on the state of the user at at least one of the timings when the use of the terminal device 20 is started and when the use is ended.

- the estimation unit 13 may estimate a form of mindfulness-related behavior suitable for the user based on the state of the user at at least one of the timings of starting and ending the game. Also, for example, when the terminal device 20 is a terminal device used for work, the estimation unit 13 estimates a form of mindfulness-related behavior that can improve work efficiency based on the state of the user when the terminal device 20 is started. Also, for example, when the terminal device 20 is a terminal device used for work, the estimation unit 13 estimates a form of mindfulness-related behavior that can reduce the user's fatigue based on the state of the user when the terminal device 20 ends its operation.

- the estimation unit 13 may estimate the need for mindfulness-related behavior based on the state of the user at at least one of the timings of starting up the terminal device 20 and ending its operation.

- the estimation unit 13 may, for example, estimate a form of mindfulness-related behavior that is suitable for the user when it estimates that mindfulness-related behavior is necessary.

- the determination unit 14 determines the content of the image content that encourages the user to behave in relation to mindfulness based on the state of the user.

- the determination unit 14, determines at least one of the state of the character appearing in the image content and the event in the image content as the content of the image content that encourages the user to behave in relation to mindfulness.

- Image content that encourages the user to behave in relation to mindfulness is, for example, image content that encourages behavior that improves the user's state.

- Improving the user's state means, for example, improving at least one of the user's inner state and physical state.

- improving the user's state may include maintaining at least one of the user's inner state and physical state in a good state.

- the determination unit 14 determines at least one of the character's state and event to be displayed as image content that encourages behavior that improves the user's inner state and physical state based on at least one of the user's inner state and physical state.

- the determination unit 14, for example, determines at least one of the character's state and event to be displayed as image content that encourages behavior that improves the user's inner state and physical state based on the user's state.

- the determination unit 14 determines, for example, at least one of a character's state and an event that encourages the user to behave in a mindfulness-related manner based on at least one of the user's internal state and physical state.

- the user's internal state is, for example, at least one of the following: mental fatigue level, emotions, emotional stability, and degree of concentration.

- the user's internal state is not limited to the above.

- the user's physical state is, for example, at least one of the user's posture, body temperature, pulse rate, heart rate, blood pressure, and amount of sweat.

- the determination unit 14 may also determine at least one of the character's state and event that reflects the type of mindfulness-related behavior estimated by the estimation unit 13.

- the relationship between the user's state and the character's state and event displayed in the image content is set, for example, as table data.

- the determination unit 14 determines the content of the image content that encourages the user to take actions related to mindfulness, for example, based on table data that associates the user's inner state or physical state with the character's state.

- the determination unit 14 determines the character's state, for example, based on table data that associates the user's inner state or physical state with the character's state.

- the character's state is, for example, how the character appears on the image of the image content and the characteristics of the character in the image content.

- the determination unit 14 also determines an event, for example, based on table data that associates the user's inner state or physical state with an event.

- An event refers, for example, to image content with content that is different from normal.

- the determination unit 14 uses, for example, a determination model to determine at least one of the character's state and event to be displayed as image content that encourages actions to improve the user's state.

- the determination model is, for example, a learning model that determines the character's state and event to be output in the image content based on the user's state.

- the decision model is generated, for example, by learning the relationship between the user's state and the character's state and events.

- the decision model is generated, for example, by deep learning using a neural network.

- the decision model is generated, for example, in a system external to the information processing device 10.

- the determination unit 14 determines the state of the character operated by the user based on the state of the user, for example.

- the determination unit 14 determines the state of the character operated by the user, for example, so that the state of the character operated by the user varies according to the state of the user. For example, when the user is tired, the determination unit 14 determines the state of the character so that the character operated by the user is in a tired state. Furthermore, when the user is not performing an action related to mindfulness, the determination unit 14 may determine the state of the character so that the character operated by the user is in a tired state. Furthermore, for example, when the user is emotionally calm, the determination unit 14 determines the state of the character so that the character operated by the user is emotionally calm.

- the determination unit 14 may determine at least one of the character's level, stage that can be entered, scenario, weapon that can be used, item that can be used, spell that can be used, vehicle that can be ridden, and person that can be spoken to, based on the state of the user who is a player of the game. For example, the determination unit 14 determines the weapon that the character will use so that the higher the level of the inner state of the user is as a result of performing an action related to mindfulness, the better weapon the character can use. Also, for example, the determination unit 14 may determine the range of characters with which the character operated by the user can talk, so that the more calm the user's emotions are as a result of performing an action related to mindfulness, the more characters the character can talk to.

- the presence or absence of emotional calm is determined, for example, based on the range of fluctuation of biometric data. Also, for example, the determination unit 14 may determine an event in which the character will act in a special stage when the user is emotionally calm as a result of performing an action related to mindfulness.

- the determination unit 14 may determine the content of the image content based on the quality of the mindfulness-related behavior performed by the user according to the content of the output image content. For example, the determination unit 14 determines at least one of the character state and the event based on the result of the improvement of the inner state or the physical state due to the user performing the mindfulness-related behavior. The determination unit 14 determines at least one of the character state and the event based on the degree of improvement of the inner state or the physical state due to the user performing the mindfulness-related behavior, for example. The degree of improvement of the inner state or the physical state may be set in multiple stages. The determination unit 14 determines at least one of the character state and the event based on the stage of the degree of improvement of the inner state or the physical state, for example.

- the degree of improvement of the inner state or the physical state is greater than the standard, at least one of the special character state and the special event may be determined.

- the standard for determining the special character state and the special event is set, for example, so as to motivate the user to practice mindfulness by aiming for it.

- the generation unit 15 generates, for example, an image of a character or an instruction related to an image of a character.

- the character is, for example, a character in a game played by the user.

- the generation unit 15 When generating an image of a character in the information processing device 10, the generation unit 15 generates an image of the character based on, for example, the state of the character determined by the determination unit 14.

- the generation unit 15 generates an image of the character by, for example, reflecting the state of the character determined by the determination unit 14 in the image of the character. For example, when the character is in a tired state, the generation unit 15 generates an image of the character in a tired state.

- the generation unit 15 selects image parts according to the character's type and appearance from an image database in which each part constituting a character is stored. The generation unit 15 then generates an image of the character by combining the selected images.

- the generation unit 15 may output an image of a character that reflects the state of the user prior to a mindfulness-related action.

- the output unit 16 may also generate an animated image of the character that reflects the change in the state of the user due to a mindfulness-related action.

- the generation unit 15 may generate a character image using an image generation model.

- the image generation model is, for example, a learning model that uses the type of character and the state of the character as input data and outputs an image of the character.

- the image generation model is generated, for example, using GAN (Generative Adversarial Networks).

- the learning algorithm for generating the image generation model is not limited to the above.

- the image generation model is generated, for example, in a system external to the information processing device 10.

- the generation unit 15 When a character image is generated in the terminal device 20 or the management device 40, the generation unit 15 generates instructions regarding the character image based on, for example, the state of the character determined by the determination unit 14.

- the instructions regarding the character image are, for example, information indicating criteria regarding image generation.

- the instructions regarding the character image include information regarding one or more items, for example, the selection criteria for the character image, the adjustment value of the indicator indicating the character's state, and the amount of change in the character's movement.

- the instructions regarding the character image are not limited to the above.

- the adjustment value of the indicator indicating the character's status is, for example, the recovery value of the character's stamina as a result of performing an action related to mindfulness.

- the adjustment value of the indicator indicating the character's status may be a recovery value other than stamina.

- the adjustment value of the indicator indicating the character's status may indicate a change in the character's level in the game.

- the adjustment value of the indicator indicating the character's status may indicate an item that has become available in the game as a result of performing an action related to mindfulness.

- the adjustment value of the indicator indicating the character's status is not limited to the above.

- the amount of change in the character's movement is, for example, information regarding the amount of change in one or more of the following items as a result of performing an action related to mindfulness: change in the character's posture, change in stride length, change in movement speed, and change in jump height.

- the amount of change in the character's movement is not limited to the above.

- the generating unit 15 may generate an event screen or a generation criterion for an event screen within the image content.

- the generating unit 15 When generating an event image in the information processing device 10, the generating unit 15 generates an event screen, for example, based on the event determined by the determining unit 14.

- the generating unit 15 selects image parts to be used in the event from an image database in which each part constituting the event screen is stored, for example, based on the content of the event.

- the generating unit 15 then generates the event screen by combining the selected images.

- the generation unit 15 may generate an event screen using a screen generation model.

- the screen generation model is generated using, for example, a GAN.

- the learning algorithm for generating the screen generation model is not limited to the above.

- the screen generation model is generated, for example, in a system external to the information processing device 10.

- the generation unit 15 When a character image is generated in the terminal device 20 or the management device 40, the generation unit 15 generates design criteria for the event screen and rules for the event, for example, based on the event determined by the determination unit 14. For example, when the image content is a game, the generation unit 15 generates criteria for items to be placed on the event screen and characters that appear. The generation unit 15 also sets the conditions for achieving the event and the incentives to be given to the user when the event is achieved as rules. The relationship between the event, the design criteria for the event screen, and the rules for the event is set, for example, in a table. The generation unit 15 may also generate information that identifies the event, for example, based on the event determined by the determination unit 14. When generating information that identifies the event, the relationship between the content of the event and the information that identifies the event is shared between the information processing device 10 and the terminal device 20 or the management device 40.

- the output unit 16 outputs the content of the image content determined by the determination unit 14. For example, if the image content is a game, the output unit 16 outputs the content of the image content determined by the determination unit 14 so that the content of the image content is displayed on the game screen.

- the output unit 16 outputs, for example, the content of the image content determined by the determination unit 14.

- the output unit 16 outputs at least one of the character state and the event determined by the determination unit 14 as the content of the image content.

- the output unit 16 outputs, for example, the content of the image content determined by the determination unit 14 to the terminal device 20.

- the output unit 16 may output the content of the image content determined by the determination unit 14 to the management device 40.

- the output unit 16 may also output the content of the image content determined by the determination unit 14 based on the timing suitable for the mindfulness-related behavior estimated by the estimation unit 13.

- the output unit 16 may also output instructions regarding the character image generated by the generation unit 15 or generation criteria for the event screen as the content of the image content.

- the output unit 16 outputs instructions regarding the character image generated by the generation unit 15 or generation criteria for the event screen as the content of the image content, for example, to the terminal device 20 or the management device 40.

- the output unit 16 may also output the character image or event screen generated by the generation unit 15 as the content of the image content.

- the output unit 16 outputs the character image or event screen generated by the generation unit 15 as the content of the image content, for example, to the terminal device 20 or the management device 40.

- the output unit 16 may further output a character that provides instructions for mindfulness-related behavior.

- the output unit 16 may output an animated image of a character that reflects the movements of the user in the mindfulness-related behavior that the user is performing according to the content of the output image content.

- the output unit 16 may further output time series data of the user's state determined by the determination unit 12.

- the output unit 16 may output a history of mindfulness-related actions taken by the user according to the content of the output image content.

- the output unit 16 may also output the improvement effect of the user's state together with the history of mindfulness-related actions taken by the user.

- the output unit 16 may further output the improvement effect of the user's state using an image of a character.

- the output unit 16 may, for example, output an image of a character that reflects the state of the user before and after an action related to mindfulness.

- the output unit 16 may further output an animated image of a character that reflects the change in the user's state due to an action related to mindfulness.

- FIG. 4 is a diagram showing an example of a display screen when the user is a game player.

- the example of the display screen in FIG. 4 is a display screen of a game in which an animal character operated by the player goes on an adventure.

- the example of the display screen in FIG. 4 shows a state in which the character's stamina in the game has been reduced by being caught in the rain. In this case, it is set so that when the player performs an action related to mindfulness, the character's stamina is restored by resting.

- the determination unit 12 determines the state of the user, who is a game player, based on, for example, an image taken of the user. For example, if it is determined that the user is fatigued, the determination unit 14 determines that the state of the character is one in which the character's physical strength cannot be restored unless the character rests and meditates. The output unit 16 then outputs the determined state of the character. A screen like the example display screen of Figure 4 is displayed on the display screen of the terminal device 20.

- the determination unit 12 determines whether the user, who is a game player, has meditated, for example. When it is determined that the user has meditated, the generation unit 15 reflects the user's meditation in the character's state. The output unit 16 then outputs the character's state that reflects the user's meditation.

- FIG. 5 is an example of a display screen in which the state of the character reflects the meditation performed by the user in the state shown in the example of the display screen in FIG. 4.

- the user who is a game player, has meditated, causing the character to rest under a hole and recovering the character's stamina. With the character's stamina restored, the user can, for example, progress through the game.

- the example display screen in Figure 6 is an example of a display screen for a scene different from the display screen shown in Figure 4, among the display screens for a game in which an animal character controlled by a player goes on an adventure.

- the example display screen in Figure 6 is a screen in which the character is standing by the bank of a river.

- the example display screen in Figure 6 is in a state in which the character is unable to proceed further due to the presence of the river.

- the example display screen in Figure 6 shows a state in which the character is confused and sweating because he is unable to proceed further.

- FIG. 7 is an example of a display screen in which, when the example display screen of FIG. 6 is displayed, a boat appears as an item for moving on the water when the user performs an action relating to mindfulness.

- an item that can be obtained by performing an action relating to mindfulness is set, such as when the character meditates or rests at night, causing a boat to appear.

- the character is unable to proceed beyond the riverbank, whereas in the example display screen of FIG. 7, the character is traveling on the water in a boat. In this way, when an item is needed to progress in the game, the user can progress in the game by performing an action relating to mindfulness.

- the terminal device 20 may be, for example, a portable game machine, a stationary game machine, a smartphone, a mobile phone, a smartwatch, a tablet computer, or a personal computer.

- the terminal device 20 may also be a game machine.

- the terminal device 20 may also be combined with AR (Augmented Reality) glasses or VR (Virtual Reality) glasses.

- the terminal device 20 may also be part of a game machine.

- the terminal device 20 may also be a gaming machine installed in an amusement facility or part of the gaming machine.

- the management device 40 outputs image content to, for example, the terminal device 20.

- the management device 40 acquires an image of a character encouraging behavior related to mindfulness from the output unit 16 of the information processing device 10 as the content of the image content.

- the management device 40 then outputs image content including an image of a character encouraging behavior related to mindfulness on the display screen, for example, to the terminal device 20.

- the management device 40 also acquires an image of a character reflecting behavior related to mindfulness performed by the user from the output unit 16 of the information processing device 10 as the content of the image content.

- the management device 40 then outputs image content including an image of a character reflecting behavior related to mindfulness performed by the user on the display screen, for example, to the terminal device 20.

- the management device 40 may also have a function for generating images to be used in image content.

- the management device 40 acquires, for example, instructions regarding a character image or generation criteria for an event screen from the output unit 16 of the information processing device 10.

- the management device 40 acquires instructions regarding a character image

- the management device 40 generates an image of the character based on, for example, the instructions regarding the character image.

- the management device 40 then outputs, for example, to the terminal device 20, image content including the generated character image on the display screen.

- the management device 40 acquires generation criteria for an event screen

- the management device 40 generates an image of the event based on, for example, the generation criteria for the event screen.

- the management device 40 then outputs, for example, to the terminal device 20, image content including the event image on the display screen.

- the management device 40 stores data related to the game.

- the management device 40 also outputs the data related to the game to the terminal device 20, for example.

- the management device 40 outputs the data related to the game so that an image of a character or an event that encourages mindfulness-related behavior is displayed on the game screen.

- the management device 40 also outputs the data related to the game so that an image of a character or an event that reflects a mindfulness-related behavior performed by the user is displayed on the game screen.

- the terminal device 20 and the management device 40 may be an integrated device.

- FIG. 8 shows an example of an operational flow in the process in which the information processing device 10 determines a character to be displayed to encourage the user to behave in a mindfulness-related manner.

- the following description takes as an example a case in which the state of a user is determined based on an image of the user.

- the acquisition unit 11 acquires, for example, an image of the user (step S11).

- the acquisition unit 11 acquires, for example, an image of the user from the sensor 30.

- the determination unit 12 determines the state of the user based on the image of the user (step S12). The determination unit 12 determines, for example, whether the user is in a state requiring mindfulness.

- the output unit 16 outputs, for example, to the terminal device 20 via the management device 40, an image for encouraging the user to take action related to mindfulness (step S14). For example, when it is determined that the user is fatigued and the output unit 16 is encouraging the user to take action related to mindfulness, the output unit 16 outputs an image of a character in a tired state to the terminal device 20 via the management device 40.

- the state of the user is not limited to fatigue.

- the determination unit 12 acquires an image of the user (step S15).

- the determination unit 12 determines the state of the user based on the image of the user (step S16).

- step S17 If the user is performing a mindfulness-related behavior (Yes in step S17), the output unit 16 outputs an image of the character in an improved state to the terminal device 20, for example, via the management device 40 (step S18).

- step S13 If, in step S13, mindfulness is not required (No in step S13), the process returns to step S11 and continues acquiring images of the user and judging the user's state.

- step S17 if the user is not performing a mindfulness-related behavior (No in step S17), the output unit 16 continues to output, for example, an image of a character whose condition has worsened. If the user is not performing a mindfulness-related behavior, the output unit 16 outputs, for example, an image of a character whose condition is further worsened (step S19). After outputting the image of a character whose condition is further worsened, the process returns to step S14, and the output unit 16 outputs, for example, an image to encourage the user to perform a mindfulness-related behavior to the terminal device 20 via the management device 40.

- the information processing device 10 disclosed herein can also be applied to healthcare. Specifically, the information processing device 10 acquires, for example, vital data of a user. The information processing device 10 then judges the health condition of the user using a judgment model generated by machine learning. Instead of the mindfulness-related judgment in FIG. 9 (steps S13 and S17), the information processing device 10 outputs an image that supports decision-making regarding actions related to improving the health condition (step S14). Note that, in addition to using the machine learning model generated by machine learning to judge the user's condition and select images suitable for the user, advice from medical professionals such as doctors may also be incorporated.

- the information processing device 10 judges the state of a user who uses image content. Based on the state of the user, the information processing device 10 determines the content of the image content that will encourage the user to take actions related to mindfulness. The information processing device 10 then outputs the determined content of the image content. In this way, by outputting the content of the image content that will encourage the user to take actions related to mindfulness based on the result of the judgment of the state of the user who uses the image content, it is possible to make it easier for the user to take actions to improve their state.

- the information processing device 10 When estimating the timing at which a user needs to perform a mindfulness-related behavior, the information processing device 10 outputs, for example, an image to encourage the mindfulness-related behavior based on the estimated timing. Thus, the user can perform a mindfulness-related behavior in accordance with the timing at which the user needs to perform the mindfulness-related behavior. For this reason, by using the information processing device 10, the user can maintain a good mental and physical condition. Furthermore, when estimating a form of mindfulness-related behavior suitable for the user, the information processing device 10 outputs, for example, an image to encourage the mindfulness-related behavior based on the estimated form. Thus, the user can perform a mindfulness-related behavior suitable for himself/herself. For this reason, by using the information processing device 10, the effectiveness of performing a mindfulness-related behavior can be improved.

- the information processing device 10 judges the fatigue of a player playing the game using the terminal device 20. Then, the information processing device 10 displays an image of a character that encourages the player to act on mindfulness in the image content of the game based on the fatigue judgment result. For example, the information processing device 10 displays an image of a character with a tired expression. By seeing the image of a character with a tired expression, the player feels the need to act on mindfulness. By making the player feel the need to act on mindfulness, the player will continuously act on mindfulness. In addition, for example, the information processing device 10 performs processing with a setting such that, if the player does not perform an action related to mindfulness, the character's fatigue will not be recovered and the game scenario cannot progress.

- the game player By performing such processing, the game player will perform an action related to mindfulness in order to progress in the game. Therefore, the game player will continuously act on mindfulness. In this way, by using the information processing device 10, the user can, for example, continuously act on mindfulness. In other words, by using the information processing device 10, it becomes easier to perform an action that improves the user's condition.

- the processes in the information processing device 10 may be distributed and executed in multiple information processing devices connected via a network.

- the processes in the acquisition unit 11 and the determination unit 12 and the processes in the estimation unit 13, the decision unit 14, and the generation unit 15 may be executed in different information processing devices. It may be set as appropriate which of the multiple information processing devices each process in the information processing device 10 is executed in.

- some or all of the processes in the information processing device 10 may be executed in the terminal device 20 or the management device 40.

- FIG. 9 shows an example of the configuration of a computer 100 that executes a computer program that performs each process in the information processing device 10.

- the computer 100 comprises a CPU (Central Processing Unit) 101, memory 102, a storage device 103, an input/output I/F (Interface) 104, and a communication I/F 105.

- CPU Central Processing Unit

- the CPU 101 reads out and executes computer programs for performing each process from the storage device 103.

- the CPU 101 may be configured by a combination of multiple CPUs.

- the CPU 101 may also be configured by a combination of a CPU and another type of processor.

- the CPU 101 may be configured by a combination of a CPU and a GPU (Graphics Processing Unit).

- the memory 102 is configured by a DRAM (Dynamic Random Access Memory) or the like, and temporarily stores the computer programs executed by the CPU 101 and data being processed.

- the storage device 103 stores the computer programs executed by the CPU 101.

- the storage device 103 is configured by, for example, a non-volatile semiconductor storage device. Other storage devices such as a hard disk drive may be used for the storage device 103.

- the input/output I/F 104 is an interface that accepts input from an operator and outputs display data, etc.

- the communication I/F 105 is an interface that transmits and receives data between the terminal device 20, the management device 40, and other information processing devices.

- the terminal device 20 can also be configured in a similar manner.

- the computer programs used to execute each process can also be distributed by storing them on a computer-readable recording medium that non-temporarily records data.

- a computer-readable recording medium for example, a magnetic tape for recording data or a magnetic disk such as a hard disk can be used.

- an optical disk such as a CD-ROM (Compact Disc Read Only Memory) can also be used as the recording medium.

- a non-volatile semiconductor memory device can also be used as the recording medium.

- a determination means for determining a state of a user who uses image content A determination means for determining image content that encourages the user to take a mindfulness-related action based on the state of the user; and an output unit for outputting the determined details of the image content.

- the determining means determines at least one of a state of a character appearing in the image content and an event in the image content as the content of the image content that encourages the user to take a mindfulness-related action.

- the determining means determines an inner state of the user, and the determining means determines details of the image content that reflects the inner state of the user. 3.

- the information processing device according to claim 1 or 2.

- the system further includes a prediction means for predicting a mindfulness behavior method suitable for the user based on the state of the user. 5.

- An information processing device according to any one of claims 1 to 4.

- the estimation means estimates a timing when the user needs to perform a mindfulness-related behavior as a mindfulness behavior method suitable for the user,

- the output means outputs the determined details of the image content based on the estimated timing. 6.

- the information processing device according to claim 5.

- the estimation means estimates a form of mindfulness-related behavior suitable for the user as a mindfulness behavior method suitable for the user,

- the determination means determines the content of the image content based on the estimated behavioral form related to mindfulness. 7.

- the information processing device according to claim 5 or 6.

- the determination means determines a quality of a mindfulness-related behavior performed by the user in accordance with the content of the output image content, The determination means determines the content of the image content based on the quality of the mindfulness-related behavior performed by the user determined by the determination means.

- An information processing device according to any one of claims 1 to 7.

- Appendix 9 the determining means determines the state of the user based on at least one of image data of the user, biometric data of the user, audio data of the user's words and actions, and a log of operations by the user; 9.

- An information processing device according to any one of appendix 1 to 8.

- Appendix 11 the output means outputs an image of a character giving instructions for a behavior related to mindfulness based on the form of behavior related to mindfulness suitable for the user estimated by the estimation means. 8. An information processing device according to any one of appendix 4 to 7.

- Appendix 12 the output means outputs, as an image to be displayed in the image content, an animation image of a character reflecting the movement of the user. 12.

- An information processing device according to any one of claims 1 to 11.

- Appendix 13 The user is a player of a game, The content of the image content is at least one of a state of a character appearing in the image content and an event in the image content. 13. An information processing device according to any one of appendix 1 to 12.

- a determination means for determining a state of a user who uses image content using a determination model generated by machine learning;

- a decision means for deciding, based on the state of the user, the content of an image content for supporting the user in making a decision regarding a health care action; and an output unit for outputting the determined details of the image content.

- Appendix 15 Determining the state of a user who uses image content; determining a content of the image content that encourages the user to take a mindfulness-related action based on the state of the user; outputting the determined image content; Information processing methods.

- Appendix 16 determining at least one of a state of a character appearing in the image content and an event within the image content as the content of the image content that encourages the user to take action related to mindfulness; 16. The information processing method according to claim 15.

- Appendix 19 Predicting a mindfulness behavior method suitable for the user based on the state of the user; 19. An information processing method according to any one of appendix 15 to 18.

- Appendix 22 determining a quality of a mindfulness-related behavior performed by the user according to the previously output image content; determining the content of the image content based on the determined quality of the mindfulness-related behavior performed by the user; 22.

- An information processing method according to any one of appendix 15 to 21.

- Appendix 23 determining a state of the user based on at least one of image data of the user, biometric data of the user, audio data of the user's words and actions, and a log of operations by the user; 23.

- An information processing method according to any one of appendix 15 to 22.

- Appendix 24 determining the effect of the mindfulness based on at least one of image data of the user, biometric data of the user, audio data of the user's words and actions, and a log of operations by the user; 23.

- An information processing method according to any one of appendix 15 to 22.

- Appendix 25 outputting an image of a character giving instructions for a behavior related to mindfulness based on the estimated form of behavior related to mindfulness suitable for the user; 22.

- the information processing method according to any one of appendix 19 to 21.

- Appendix 26 outputting an animation image of a character reflecting the movement of the user as an image to be displayed in the image content; 26.

- An information processing method according to any one of appendix 15 to 25.

- Appendix 27 The user is a player of a game, The content of the image content is at least one of a state of a character appearing in the image content and an event in the image content. 27. An information processing method according to any one of appendix 15 to 26.

- Appendix 28 A process for determining a state of a user who uses image content; A process of predetermining image content that encourages the user to take mindfulness-related actions based on the state of the user; and a process of outputting the determined details of the image content.

- Appendix 29 The recording medium described in Appendix 28, which non-temporarily records a program that causes a computer to execute a process of determining at least one of the state of a character appearing in the image content and an event within the image content as content of the image content that encourages the user to engage in mindfulness-related behavior.

- Appendix 30 determining an inner state of the user; 30.

- Appendix 31 A recording medium as described in Appendix 28 or 29, which non-temporarily records a program that causes a computer to execute a process of determining the content of the image content that reflects the result of the judgment of the mindfulness-related behavior performed by the user when the mindfulness-related behavior performed by the user is judged based on the content of the output image content.

- Appendix 32 32.

- Appendix 35 A process of determining the quality of the mindfulness-related behavior performed by the user according to the content of the previously output image content;

- Appendix 36 A recording medium as described in any one of Appendices 29 to 35, non-temporarily recording a program that causes a computer to execute a process of determining the status of the user based on at least one of image data of the user, biometric data of the user, audio data of the user's words and actions, and a log of operations by the user.

- Appendix 37 36.

- Appendix 38 A recording medium described in any one of Appendices 32 to 34, non-temporarily recording a program that causes a computer to execute a process of outputting an image of a character that instructs the user to behave in a mindfulness-related manner based on the estimated form of behavior in relation to mindfulness that is suitable for the user.

- Appendix 39 A recording medium according to any one of appendices 29 to 38, non-temporarily recording a program for causing a computer to execute a process of outputting an animated image of a character reflecting the movement of the user as an image to be displayed in the image content.

- Appendix 40 The user is a player of a game, The content of the image content is at least one of a state of a character appearing in the image content and an event in the image content. 40. A recording medium according to any one of appendixes 29 to 39.

Landscapes

- Health & Medical Sciences (AREA)

- Engineering & Computer Science (AREA)

- Epidemiology (AREA)

- General Health & Medical Sciences (AREA)

- Medical Informatics (AREA)

- Primary Health Care (AREA)

- Public Health (AREA)

- Measurement Of The Respiration, Hearing Ability, Form, And Blood Characteristics Of Living Organisms (AREA)

Abstract

情報処理システムは、判定部と、決定部と、出力部を備える。判定部は、画像コンテンツを利用する利用者の状態を判定する。決定部は、利用者の状態を基に、利用者にマインドフルネスに関する行動を促すような画像コンテンツの内容を決定する。出力部は、決定した画像コンテンツの内容を出力する。

Description

本開示は、情報処理装置等に関する。

瞑想または運動を通じて心身の状態を良好に保つマインドフルネスが行われている。マインドフルネスは、例えば、瞑想または運動を行って心身の状態を向上する活動である。例えば、マインドフルネスとして瞑想を行う人物は、瞑想によって、内面状態を生活または仕事に適した状態に向上させる。また、マインドフルネスに関する行動は、情報処理装置によって支援されることがある。例えば、情報処理装置上で動作するアプリケーションプログラムによって、マインドフルネスに関する行動の内容およびスケジュールの提示が行われる。

特許文献1の気分転換支援装置では、作業者の気分転換期間中に、マインドフルネスの内容を示す画像を出力する。特許文献1の気分転換支援装置では、作業者は、画像を参照してマインドフルネスに関する行動を行う。

特許文献1の気分転換支援装置では、画像で示される行動が実際に行われるように、利用者に対して行動を促すことが難しい場合がある。

本開示は、上記の課題を解決するため、利用者の状態を向上するための行動を行われやすくすることができる情報処理システム等を提供することを目的とする。

上記の課題を解決するため、本開示の情報処理装置は、画像コンテンツを利用する利用者の状態を判定する判定手段と、利用者の状態を基に、利用者にマインドフルネスに関する行動を促すような画像コンテンツの内容を決定する決定手段と、決定した画像コンテンツの内容を出力する出力手段とを備える。

本開示の情報処理方法は、画像コンテンツを利用する利用者の状態を判定し、利用者の状態を基に、利用者にマインドフルネスに関する行動を促すような画像コンテンツの内容を決定し、決定した画像コンテンツの内容を出力する。

本開示の記録媒体は、画像コンテンツを利用する利用者の状態を判定する処理と、利用者の状態を基に、利用者にマインドフルネスに関する行動を促すような画像コンテンツの内容を決定する処理と、決定した画像コンテンツの内容を出力する処理とをコンピュータに実行させるプログラムを非一時的に記録する記録媒体。

本開示によると、利用者の状態を向上するための行動が行われやすくなる。

本開示の実施形態について図を参照して詳細に説明する。図1は、情報処理システムの構成の例を示す図である。行動支援システムは、例えば、情報処理装置10と、端末装置20と、センサ30と、管理装置40を備える。情報処理装置10は、例えば、ネットワークを介して、管理装置40と接続する。情報処理装置10は、例えば、ネットワークを介して、センサ30と接続する。端末装置20は、例えば、ネットワークを介して、管理装置40と接続する。また、情報処理装置10は、ネットワークを介して、端末装置20と接続してもよい。端末装置20、センサ30および管理装置40は、それぞれ複数であってもよい。端末装置20およびセンサ30の数は、適宜、設定され得る。また、端末装置20と、センサ30は、一体のシステムであってもよい。

情報処理システムは、例えば、利用者が画像コンテンツを利用するシステムである。利用者は、例えば、端末装置20を操作することによって、画像コンテンツを利用する人物である。また、画像コンテンツは、例えば、娯楽性を有する画像である。画像には、動画像、すなわち、映像が含まれ得る。画像コンテンツは、例えば、キャラクターの画像を用いて、利用者に対して娯楽性を提供するために用いられるものである。画像コンテンツは、例えば、ゲームである。また、画像コンテンツがゲームである場合に、利用者は、例えば、ゲームを行う人物である。すなわち、画像コンテンツがゲームである場合に、利用者は、ゲームのプレイヤーである。画像コンテンツは、ゲームの実施時以外に表示される画像であってもよい。ゲームは、アミューズメント施設内に設置されている機器を用いて行われるゲームであってもよい。また、画像コンテンツは、端末装置20の待ち受け画面または待機画面に表示される画像であってもよい。待ち受け画面または待機画面に表示される画像は、例えば、利用者が端末装置20の操作を行っていないときに表示される画像である。また、画像コンテンツは、当該画像コンテンツを表示する条件を満たしたときに、表示画面に表示されるものであってもよい。また、画像コンテンツは、表示画面の一部または背景部分に、常時、表示される画像であってもよい。画像コンテンツは、上記に限られない。

情報処理システムは、例えば、画像コンテンツを用いて、利用者のマインドフルネスに関する行動を支援するシステムである。マインドフルネスとは、例えば、心身の状態を良好に保つことである。すなわち、マインドフルネスに関する行動は、例えば、利用者が自身の心身の状態を良好な状態に保つために行う行動である。心身の状態は、例えば、内面状態または身体状態である。心身の状態が内面状態である場合に、内面状態を良好に保つとは、例えば、雑念を取り除くことである。内面状態を良好な状態に保つとは、例えば、ストレスを低減することである。また、内面状態を良好な状態に保つとは、例えば、気分を平穏な状態に保つことである。例えば、利用者の感情が落ち込んでいるときに、利用者は、マインドフルネスに関する行動を行って、感情を正常な状態に回復させる。また、マインドフルネスに関する行動は、利用者の感情が高ぶっているときに、感情を落ち着かせるものであってもよい。また、身体状態は、例えば、内面状態に影響を与え得る身体状態である。例えば、利用者が疲労していると感情が落ち込みやすい。この場合において、利用者の疲労は、内面状態に影響を与え得る身体状態である。

利用者のマインドフルネスに関する行動は、例えば、行動そのものがマインドフルネスになる行動、および、マインドフルネスの準備となる行動である。行動そのものがマインドフルネスになる行動は、例えば、瞑想、歩行、運動、ヨガおよび食事のうち少なくとも1つである。瞑想には、例えば、呼吸のコントロールが含まれる。行動そのものがマインドフルネスになる行動には、睡眠が含まれていてもよい。また、行動そのものがマインドフルネスになる行動は、上記に限られない。また、マインドフルネスの準備となる行動には、例えば、マインドフルネスに用いる物品の取得が含まれる。マインドフルネスに用いる物品を取得する行動は、例えば、マインドフルネスに用いる物品を購入する行動である。マインドフルネスの準備となる行動には、購入する物品について調べる行動が含まれ得る。また、マインドフルネスの準備となる行動には、例えば、マインドフルネスに関するサービスに申し込む行動である。マインドフルネスの準備となる行動には、申し込むサービスについて調べる行動が含まれ得る。また、マインドフルネスの準備となる行動は、上記に限られない。

マインドフルネスに関する行動の支援とは、例えば、利用者に対してマインドフルネスに関する行動を促すことをいう。画像コンテンツを用いて、マインドフルネスに関する行動を支援するとは、例えば、マインドフルネスに関する行動を行う動機づけとなるような画像を利用者に対して提示することをいう。マインドフルネスに関する行動を支援するとは、例えば、利用者に対してマインドフルネスに関する行動を促す画像を提示することをいう。マインドフルネスに関する行動を促す画像は、例えば、利用者によるマインドフルネスに関する行動に応じて変化するゲームのキャラクターの画像である。また、マインドフルネスに関する行動を支援するとは、利用者に対してマインドフルネスに関する行動を促すイベントを、ゲーム内において出現させることであってもよい。また、マインドフルネスに関する行動を促す画像がゲームのキャラクター以外である場合に、マインドフルネスに関する行動を促す画像には、例えば、利用者が好む画像が用いられる。例えば、マインドフルネスに関する行動を促す画像は、利用者が好むアニメーション作品のキャラクターであってもよい。また、マインドフルネスに関する行動を促す画像は、利用者が好む動物を描いたキャラクターであってもよい。マインドフルネスに関する行動を促す画像は、上記に限られない。

図2は、情報処理システムにおけるデータの流れの例を模式的に示す図である。図2の例は、利用者が端末装置20を操作して、管理装置40にアクセスすることによってゲームを行っている状態を模式的に示す図である。図2の例では、カメラがゲームのプレイヤーである利用者を撮影している。カメラは、センサ30の一例である。カメラは、例えば、撮影した画像データを情報処理装置10に出力する。情報処理装置10は、取得した画像データを基に、利用者の状態を判定する。そして、情報処理装置10は、例えば、利用者の状態を基に、ゲーム中のキャラクターの状態を決定する。ゲーム中のキャラクターの状態は、例えば、利用者の状態によって変化する。そして、情報処理装置10は、例えば、管理装置40に、決定したキャラクターの状態を示す情報を出力する。すなわち、情報処理装置10は、管理装置40に、利用者の状態によって変化するキャラクターの状態を示す情報を出力する。管理装置40は、例えば、端末装置20に、情報処理装置10から取得したキャラクターの状態を基に生成した画像をゲームのキャラクターの画像として出力する。すなわち、管理装置40は、利用者の状態に応じて変化するキャラクターの画像をゲーム中に表示させる。ゲームを行っている利用者は、例えば、端末装置20の図示しない表示装置にゲームのキャラクターとして表示されるキャラクターの画像を見て、マインドフルネスに関する行動を行う。

例えば、利用者がゲームのプレイヤーである場合、利用者の疲労が判定されたとき、ゲーム中のキャラクターの状態に利用者の疲労が反映される。例えば、疲れた状態のキャラクターの画像がゲームの画面中に表示される。利用者は、例えば、疲れた状態のキャラクターの画像を見ることによって、マインドフルネスに関する行動を行うことが望ましいタイミングであると認識する。そして、利用者がマインドフルネスに関する行動を行うと、キャラクターの状態が通常の状態に回復する。このように、利用者の状態およびマインドフルネスに関する行動をゲームのキャラクターに反映させることは、利用者にとってマインドフルネスに関する行動を行う動機となり得る。

ここで、情報処理装置10の構成の具体例について説明する。図3は、情報処理装置10の構成の例を示す図である。情報処理装置10は、基本構成として、判定部12と、決定部14と、出力部16を備える。また、情報処理装置10は、例えば、取得部11と、推定部13と、生成部15と、記憶部17を備える。

取得部11は、例えば、利用者の状態に関するデータを取得する。取得部11は、例えば、センサ30から、利用者の状態に関するデータを取得する。取得部11は、端末装置20を介してセンサ30から、利用者の状態に関するデータを取得してもよい。また、取得部11は、管理装置40を介してセンサ30から、利用者の状態に関するデータを取得してもよい。利用者の状態に関するデータは、例えば、利用者の状態の判定に用いるデータである。利用者の状態は、例えば、利用者の心身の状態である。例えば、利用者の状態に関するデータは、利用者の内面状態および身体状態の少なくとも一方に関するデータである。すなわち、利用者の状態に関するデータは、例えば、利用者の内面状態および身体状態の少なくとも一方の判断に用いるデータである。また、取得部11は、例えば、利用者がマインドフルネスに関する行動を行っているときの利用者の状態を取得する。また、取得部11は、利用者がマインドフルネスに関する行動を完了したときの利用者の状態を取得してもよい。

取得部11は、端末装置20の起動時および動作の終了時の少なくとも一方のタイミングにおいて、利用者の状態を取得してもよい。また、取得部11は、端末装置20の利用の開始時および利用の終了時の少なくとも一方のタイミングにおいて、利用者の状態を取得してもよい。利用者の状態を取得するタイミングは、上記に限られない。

利用者の状態に関するデータは、例えば、利用者を撮影した画像データである。利用者の状態に関するデータが利用者を撮影した画像データである場合に、センサ30は、例えば、利用者の顔の表情および身体の動きの少なくとも一方を撮影するカメラである。例えば、画像コンテンツがゲームである場合に、利用者の状態に関するデータは、例えば、ゲームを行っている利用者を撮影した画像データである。

利用者の状態に関するデータは、例えば、利用者の生体データであってもよい。利用者の生体データは、例えば、利用者の内面状態および身体状態によって影響を受け得る計測データである。生体データは、例えば、体温、脈拍、心拍、血圧および発汗量のうち少なくとも1つの計測データである。生体データは、上記に限られない。利用者の生体データは、例えば、利用者が装着するセンサ30によって計測される。また、利用者が装着するスマートウオッチが生体データを計測するセンサ30を備えてもよい。

利用者の状態に関するデータは、利用者の言動データであってもよい。利用者の言動データは、例えば、利用者の内面状態を反映したデータである。利用者の言動データは、例えば、利用者が他の人物と行っている会話の音声、音声認識装置に対して入力される音声および利用者が実況のために発している音声のうち少なくとも1つのデータである。利用者の言動データは、上記に限られない。この場合において、センサ30は、利用者の音声を収集するマイクである。