WO2016104477A1 - 画像処理方法、制御プログラムおよび画像処理装置 - Google Patents

画像処理方法、制御プログラムおよび画像処理装置 Download PDFInfo

- Publication number

- WO2016104477A1 WO2016104477A1 PCT/JP2015/085776 JP2015085776W WO2016104477A1 WO 2016104477 A1 WO2016104477 A1 WO 2016104477A1 JP 2015085776 W JP2015085776 W JP 2015085776W WO 2016104477 A1 WO2016104477 A1 WO 2016104477A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- image

- pixel

- contour

- pixels

- region

- Prior art date

Links

- 238000003672 processing method Methods 0.000 title claims abstract description 26

- 238000012545 processing Methods 0.000 title claims description 59

- 238000004364 calculation method Methods 0.000 claims abstract description 13

- 238000003384 imaging method Methods 0.000 claims description 109

- 238000000034 method Methods 0.000 claims description 55

- 239000002131 composite material Substances 0.000 claims description 49

- 230000003287 optical effect Effects 0.000 claims description 20

- 239000000203 mixture Substances 0.000 claims description 10

- 238000003708 edge detection Methods 0.000 claims description 4

- 238000000605 extraction Methods 0.000 claims description 3

- 230000002194 synthesizing effect Effects 0.000 abstract description 2

- 239000000523 sample Substances 0.000 description 55

- 210000004027 cell Anatomy 0.000 description 52

- 239000002609 medium Substances 0.000 description 27

- 230000008569 process Effects 0.000 description 17

- 239000012472 biological sample Substances 0.000 description 13

- 238000005286 illumination Methods 0.000 description 9

- 238000010586 diagram Methods 0.000 description 8

- 238000011156 evaluation Methods 0.000 description 7

- 230000005540 biological transmission Effects 0.000 description 6

- 230000008859 change Effects 0.000 description 3

- 238000012986 modification Methods 0.000 description 3

- 230000004048 modification Effects 0.000 description 3

- 229920001817 Agar Polymers 0.000 description 2

- 239000008272 agar Substances 0.000 description 2

- 238000012258 culturing Methods 0.000 description 2

- 238000009826 distribution Methods 0.000 description 2

- 230000010365 information processing Effects 0.000 description 2

- 238000003860 storage Methods 0.000 description 2

- 238000007441 Spherical agglomeration method Methods 0.000 description 1

- 238000005054 agglomeration Methods 0.000 description 1

- 230000002776 aggregation Effects 0.000 description 1

- 238000004458 analytical method Methods 0.000 description 1

- 238000013459 approach Methods 0.000 description 1

- 230000015572 biosynthetic process Effects 0.000 description 1

- 239000003153 chemical reaction reagent Substances 0.000 description 1

- 238000004891 communication Methods 0.000 description 1

- 238000007796 conventional method Methods 0.000 description 1

- 210000004748 cultured cell Anatomy 0.000 description 1

- 238000013500 data storage Methods 0.000 description 1

- 238000001514 detection method Methods 0.000 description 1

- 239000001963 growth medium Substances 0.000 description 1

- 238000005304 joining Methods 0.000 description 1

- 239000011159 matrix material Substances 0.000 description 1

- 230000005499 meniscus Effects 0.000 description 1

- 238000010899 nucleation Methods 0.000 description 1

- 230000002093 peripheral effect Effects 0.000 description 1

- 238000010187 selection method Methods 0.000 description 1

- 239000007787 solid Substances 0.000 description 1

- 230000007480 spreading Effects 0.000 description 1

- 238000003892 spreading Methods 0.000 description 1

- 239000000126 substance Substances 0.000 description 1

- 238000003786 synthesis reaction Methods 0.000 description 1

- 230000000007 visual effect Effects 0.000 description 1

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B21/00—Microscopes

- G02B21/36—Microscopes arranged for photographic purposes or projection purposes or digital imaging or video purposes including associated control and data processing arrangements

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B7/00—Mountings, adjusting means, or light-tight connections, for optical elements

- G02B7/28—Systems for automatic generation of focusing signals

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B7/00—Mountings, adjusting means, or light-tight connections, for optical elements

- G02B7/28—Systems for automatic generation of focusing signals

- G02B7/36—Systems for automatic generation of focusing signals using image sharpness techniques, e.g. image processing techniques for generating autofocus signals

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B15/00—Special procedures for taking photographs; Apparatus therefor

-

- G—PHYSICS

- G03—PHOTOGRAPHY; CINEMATOGRAPHY; ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ELECTROGRAPHY; HOLOGRAPHY

- G03B—APPARATUS OR ARRANGEMENTS FOR TAKING PHOTOGRAPHS OR FOR PROJECTING OR VIEWING THEM; APPARATUS OR ARRANGEMENTS EMPLOYING ANALOGOUS TECHNIQUES USING WAVES OTHER THAN OPTICAL WAVES; ACCESSORIES THEREFOR

- G03B7/00—Control of exposure by setting shutters, diaphragms or filters, separately or conjointly

- G03B7/08—Control effected solely on the basis of the response, to the intensity of the light received by the camera, of a built-in light-sensitive device

- G03B7/091—Digital circuits

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/50—Image enhancement or restoration using two or more images, e.g. averaging or subtraction

Definitions

- the present invention relates to an image processing method, a control program, and an image processing apparatus, and more particularly to a technique for creating an omnifocal image by image processing.

- Cross-reference to related applications The disclosures in the specification, drawings, and claims of the following Japanese application are incorporated herein by reference in their entirety: Japanese Patent Application No. 2014-265039 (filed on Dec. 26, 2014).

- a technique for imaging an imaged object and performing image processing is applied to the field of medical treatment and biochemistry, more specifically, for the purpose of observation and analysis of biological samples such as cells cultured in a medium.

- cells or cell clumps (hereinafter collectively referred to as “cells”) formed by collecting a plurality of cells in a sample that is an imaging object are three-dimensionally distributed in the medium. If it is, it may not be possible to obtain an image focused on the entirety.

- a plurality of images are captured by varying the focal position in multiple stages along the imaging direction, and only the in-focus portion is extracted from each image and synthesized, so-called Techniques for creating omnifocal images have been proposed.

- JP 2010-166247 A (for example, paragraph 0030)

- a focused sample extracted from a plurality of images having different depths of focus is connected to a specimen having a relatively clear edge and texture, and an all-focus image is created.

- a cell or the like three-dimensionally cultured in a medium does not always have a clear outline and surface texture. For this reason, there is a problem that the internal texture of cells and the like becomes unnatural when joining is performed in units of pixels as in the prior art.

- the present invention has been made in view of the above problems, and an object of the present invention is to provide an omnifocal image creation technique suitable for a three-dimensionally cultured cell or the like.

- cells with non-constant sizes and shapes are distributed three-dimensionally, that is, in the imaging direction and in the direction perpendicular to this. It is scattered in various positions in each.

- Each cell itself also has a spread in the imaging direction and a direction orthogonal thereto.

- One aspect of the present invention is an image processing method for creating an image of a sample including cells that are three-dimensionally cultured in a medium.

- the sample is placed at different focal positions in the imaging direction.

- Another aspect of the present invention is an image processing apparatus that creates an image of a sample including cells that are three-dimensionally cultured in a medium.

- An image acquisition unit that acquires a plurality of original images obtained by imaging a sample; and an image processing unit that combines the plurality of original images to create a composite image, and the image processing unit includes each of the plurality of original images.

- the edge strength of the pixels constituting the original image is calculated, the pixel having the highest edge strength is selected from among the pixels corresponding to the same position among the plurality of original images, and the contour of the object is selected from the selected pixels.

- a contour image corresponding to is specified, and a composite image is created in which pixels extracted from positions corresponding to any one of the regions of the original image are arranged in a region where the position of the contour pixel is the position of the contour. And, moreover, an area surrounded by the outline to create the composite image by placing the pixels extracted the selected pixel from most including one said original image on the region.

- the edge strengths of pixels corresponding to the same position are compared among a plurality of original images, and the pixel having the highest edge strength is selected. It is considered that the pixel thus selected belonged to the original image obtained by capturing the cell etc. most clearly at the position. That is, at the position, it can be considered that the original image including the selected pixel was captured in a state closest to the in-focus state.

- a pixel considered to correspond to the contour of the object is specified as a contour pixel representing the contour of a cell or the like.

- the contour represented by the pixels selected from a plurality of original images with different focal positions is obtained by projecting cells having a spread in a three-dimensional space onto an image plane orthogonal to the imaging direction, that is, a sufficiently large depth of field. This corresponds to the contour when the whole cell or the like is imaged in a focused state by the imaging device having the imaging device. Therefore, the outline of a cell or the like can be represented in a composite image with the same degree of accuracy as an image captured in a focused state.

- the image content of the region surrounded by the contour thus specified is taken from the original image including the most pixels selected as having the highest edge strength in the region among the original images.

- the inside of the contour maintains the texture appearing in the single original image, and the original image that is closest to the in-focus state is selected for the region.

- the pixel having the highest edge strength is selected from among the pixels corresponding to the same position among a plurality of original images, Furthermore, the contour of a cell or the like in the composite image is specified by the contour pixel. Then, the contents of the original image captured in a state in which the region of the original image is closest to the in-focus state are applied inside the contour. For this reason, the texture included in the original image appears as it is in the synthesized image.

- the composite image thus obtained is an omnifocal image obtained by capturing cells scattered at various positions with good image quality. That is, according to the above invention, an omnifocal image of a sample in which cells are three-dimensionally cultured can be created with good image quality.

- Another aspect of the present invention is an image processing method for creating an image of a sample including cells that are three-dimensionally cultured in a medium.

- the image processing method includes the focal points different from each other in the imaging direction.

- a region extracting step for extracting an object region, and a pixel in the object region extracted from each of the plurality of original images as one image and a position corresponding to the position of the pixel in the original image

- Another aspect of the present invention is an image processing apparatus that creates an image of a sample including cells that are three-dimensionally cultured in a medium.

- An image acquisition unit that acquires a plurality of original images obtained by imaging a sample; and an image processing unit that combines the plurality of original images to create a composite image, and the image processing unit includes each of the plurality of original images.

- the contour pixel corresponding to the contour of the object is specified from the pixels constituting the original image, the object region having the contour pixel as the contour is extracted, and the object region extracted from each of the plurality of original images

- each of the cells distributed at various positions can be included in any original image in a state close to the focused state. Then, an area surrounded by pixels considered to correspond to the contour of the object in each original image is extracted as the object area.

- images of the cells and the like are scattered in a relatively uniform background. Therefore, each object region surrounded by pixels having relatively high edge strength is considered to correspond to an image of a cell or the like.

- the object area detected in the one original image is closest to the in-focus state of the cell etc. It can be said that the probability of including an image captured in a state is high. For this reason, the entire pixels in the object area are applied to the pixels constituting the composite image.

- the pixel of the object region with the clearest contour is applied to the overlapping region. As a result, an image closest to the in-focus state can be reflected in the composite image.

- an object region extracted from one original image based on edge strength is extracted from another original image in view of the characteristics of cells and the like that are three-dimensionally cultured in the medium.

- the pixel in the object area is set as a pixel in the composite image. For this reason, the texture included in the original image appears as it is in the synthesized image.

- the pixel of the object area with the clearest outline is applied. Thereby, about the cell etc. corresponding to the said object area

- the overlapping area is selected based on the above-described sharpness, so that, for example, a plurality of cells having different positions in the imaging direction are captured. Even when they are overlapped when viewed from the direction, it is possible to handle the cells on the near side and the cells in the back separately.

- the synthesized image obtained in this way is an omnifocal image obtained by capturing cells scattered at various positions with good image quality. That is, according to the above invention, an omnifocal image of a sample in which cells are three-dimensionally cultured can be created with good image quality.

- Still another embodiment of the present invention is a control program for causing a computer to execute any of the image processing methods described above.

- the above-described image processing method is configured by a combination of processes that can be executed by a computer having a general calculation processing function. Therefore, by causing a computer to execute the control program of the present invention, it is possible to cause the computer to function as an image processing apparatus that executes the above-described image processing method.

- the “region having the contour pixel as the contour” and the “region having the contour pixel position as the contour position” mean a region substantially surrounded by the pixels to be the contour pixels in the image.

- the concept includes the region surrounded by the contour obtained by storing the discontinuous contour pixels by an appropriate interpolation method, the region surrounded by the contour and the image edge, and the like It is.

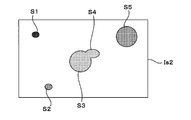

- FIG. 1 shows typically the problem which may arise when imaging a sample.

- FIG. 2nd figure shows typically the problem which may arise when imaging a sample.

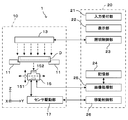

- FIG. 1 is a diagram showing an embodiment of an imaging apparatus to which an image processing method and an image processing apparatus according to the present invention can be applied.

- the imaging apparatus 1 includes an imaging unit 10 that images a biological sample carried on a sample container D as an imaging object, and a control unit 20 that controls the imaging unit 10 and performs appropriate image processing on the captured image. I have.

- the sample handled by the imaging apparatus 1 as an imaging target is one in which cells and cell colonies (cells, etc.) that are a collection thereof are cultured in a medium carried in a sample container D such as a shallow dish type dish. It is.

- a cell colony forms a spherical agglomeration

- a cell agglomeration is also called a spheroid.

- the medium includes, for example, soft agar and a culture solution, and is injected into the sample container D by a predetermined amount. Therefore, a medium layer having a certain thickness is carried on the inner bottom surface of the sample container D.

- the imaging unit 10 includes a holder 11 that supports the sample container D, an illumination unit 13 that is disposed above the holder 11, and a side opposite to the illumination unit 13 with respect to the sample container D that is supported by the holder 11, that is, the sample container. And an imaging unit 15 disposed below D.

- the holder 11 supports the sample container D in a substantially horizontal posture.

- the illumination unit 13 is arranged above the sample container D supported by the holder 11 and irradiates illumination light toward the sample container D.

- the imaging unit 15 includes an imaging unit 15 that receives the light irradiated from the illumination unit 13 and transmitted through the bottom surface of the sample container D, and images the sample inside the sample container D from below.

- an XYZ orthogonal coordinate system is set as shown in the figure.

- the XY plane represents a horizontal plane

- the Z axis represents a vertical axis.

- the imaging unit 15 includes a linear image sensor 151, an imaging optical system 152, and a sensor driving unit 17 having a function of horizontally moving them in the Y direction integrally and a function of moving them up and down in the Z direction.

- the linear image sensor 151 has a large number of minute image pickup devices arranged in the X direction perpendicular to the paper surface of FIG.

- the imaging optical system 152 has a vertical optical axis, and converges the transmitted light emitted from the bottom surface of the sample container D onto the light receiving surface of the linear image sensor 151.

- the imaging unit 15 moves in the Y direction along the bottom surface of the sample container D while receiving the transmitted light from the sample container D collected by the imaging optical system 152 by the linear image sensor.

- the imaging optical system 152 is representatively represented by a single lens, but may be configured by a combination of a plurality of lenses and optical elements.

- the control unit 20 includes functional blocks such as an input receiving unit 21, a display unit 22, a lighting control unit 23, a storage unit 24, an image processing unit 25, and a movement control unit 26.

- the illumination control unit 23 controls the operation of the illumination unit 13.

- the movement control unit 26 controls the sensor driving unit 17 to move the imaging unit 15 in a predetermined direction.

- the image processing unit 25 executes various image processing based on the image signal output from the imaging unit 15.

- the storage unit 24 stores and saves image data before and after processing and other various data.

- the input receiving unit 21 receives an operation instruction input from an operator who operates the imaging apparatus 1.

- the display unit 22 notifies the operator of the operation status of the system, processing results, and the like as visual information.

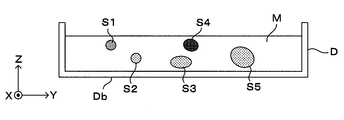

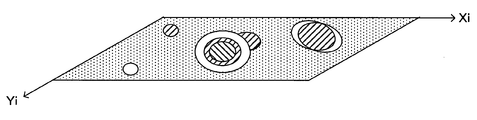

- FIG. 2A and FIG. 2B are diagrams showing examples of biological samples to be imaged. More specifically, FIGS. 2A and 2B are a side perspective view and a top view, respectively, of a sample container D carrying a biological sample.

- the biological sample to be imaged by the imaging device 1 is obtained by three-dimensionally culturing cells in a medium M injected into a sample container D called a dish, for example.

- the medium M is a semi-solid substance injected into the sample container D to a predetermined depth. For example, soft agar is used.

- a reagent is added to the medium M as necessary, and the cells are seeded and cultured under a predetermined culture condition for a certain period of time to become a biological sample.

- spheroids S1 to S5 As shown in the figure, as an example of a biological sample, cells grown in the medium M are solidified to form spheroids (cell clumps) S1 to S5. As shown in the figure, each of the spheroids S1 to S5 has a three-dimensional spread in the culture medium M, and its size and shape vary. In particular, if the cells are unstained, the outline is not always clear because it is almost colorless and transparent.

- the spheroids S1 to S5 are three-dimensionally distributed in various positions in the medium M in the horizontal direction (XY direction) and the vertical direction (Z direction). Since spheroids are distributed three-dimensionally in this way, spheroids may overlap each other depending on the viewing direction. Next, problems in imaging a biological sample having such characteristics will be described.

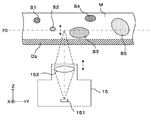

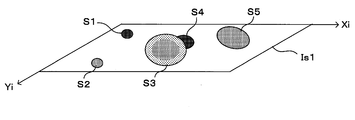

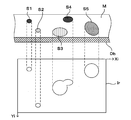

- FIG. 3A and FIG. 3B are diagrams schematically showing problems that may occur when imaging a sample.

- the sample is imaged via the bottom surface Db of the sample container D by the imaging unit 15 disposed below the sample container D.

- the depth of field of the imaging optical system 152 is not sufficiently large with respect to the depth of the medium M, all spheroids distributed in the depth direction, that is, the vertical direction (Z direction) cannot be brought into the in-focus range. There is.

- FIG. 3B is a diagram schematically showing an image IM0 when, for example, the focal position of the imaging optical system 152 is set to the depth indicated by the symbol F0 in FIG. 3A.

- the spheroid S2 whose surface is located at a depth close to the focal position F0 of the imaging optical system 152 is imaged relatively clearly.

- the spheroids S1 and S4 which are larger than the focal position and deviate from the back side are thin and blurred images.

- the spheroid S3 protruding toward the front side from the focal position also has an unclear outline. Even with a configuration in which the focal position of the imaging optical system 152 can be changed in the Z direction, it is difficult to simultaneously bring all the spheroids S1 to S5 into the in-focus range.

- the imaging apparatus 1 performs so-called focus bracket imaging, in which the focal position of the imaging optical system 152 with respect to the sample is changed and set in multiple stages in the Z direction (depth direction) and images are taken each time. Then, the imaging apparatus 1 combines the obtained plurality of original images by image processing, and creates an omnifocal image that is pseudo-focused on spheroids of various depths.

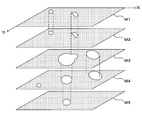

- FIGS. 4A and 4B are diagrams for explaining examples of images obtained by focus bracket imaging.

- imaging is performed by changing the focus position of the imaging optical system 152 to five stages F1 to F5 as shown in FIG. 4A.

- the focal positions F1, F2, F3, F4, and F5 correspond to the focal positions F1, F2, F3, F4, and F5, as shown in FIG. 4B.

- the symbols Xi and Yi represent the plane coordinates on each image plane as distinguished from the coordinates in the real space.

- FIG. 5 is a flowchart showing a first method for creating an omnifocal image.

- 6A to 6C are diagrams showing images created in the course of processing.

- a plurality of (five in this example) original images IM1 to IM5 having different focal positions are acquired (step S101). More specifically, when the imaging unit 15 performs imaging while changing the focal position in the imaging direction (vertical direction), these original images are acquired.

- the edge strength of each pixel constituting the original image is calculated (step S102).

- various known methods or equivalent methods can be used.

- an edge filter of four connected pixels, a difference filter, a Laplacian filter, or the like can be used.

- those having a relatively large edge strength value that can be regarded as corresponding to the contour of an image object such as a cell are referred to as “contour pixels”.

- a pixel whose edge intensity is equal to or greater than a predetermined threshold value can be regarded as a contour pixel.

- a pixel whose edge intensity difference with respect to surrounding pixels is a predetermined value or more may be used as a contour pixel.

- the closed area in the image surrounded by the contour pixels is extracted as the object area. That is, the contour pixel represents the contour of the object region.

- An image with an unclear outline due to the fact that the spheroid deviates greatly from the focal position is not treated as an object area.

- the object region is not limited to one in which all the contours are formed by continuous contour pixels, and may include a region substantially surrounded by a plurality of contour pixels.

- a closed region whose contour is a closed curve that interpolates between discontinuous contour pixels by an appropriate interpolation method a closed region surrounded by a contour specified from the contour pixel and the edge of the image, Can be considered.

- the object region specified by the contour pixel obtained above may be a region smaller than the original spheroid spread due to the unclearness of the contour of the spheroid itself.

- a region obtained by expanding a region surrounded by contour pixels by one pixel may be set as an object region.

- a mask image is created from each original image (step S103). Specifically, for each original image, a mask image is created in which the object area extracted from the original image is a transmission pattern. For example, mask images M1 to M5 shown in FIG. 6A are created from the original images IM1 to IM5 shown in FIG. 4B. Each mask image is an image showing the range and position of an object region surrounded by a relatively clear outline in each original image. By applying a corresponding mask image to one original image, an image of an object region having a clear outline can be cut out from the original image.

- a synthesized image is created by synthesizing images cut out by applying these mask images to corresponding original images.

- an image of one spheroid may appear over a plurality of original images.

- an object region corresponding to one spheroid is extracted from a plurality of original images, and as shown by a broken line in FIG. 6A, the transmission patterns appearing in the mask image may overlap on the image plane.

- a plurality of image candidates to be arranged in the composite image are generated in a portion where the object regions overlap.

- the sharpness of the contour is introduced as an index indicating the sharpness of the contour of each extracted object region.

- the definition Sh can be defined by using the edge strength of the contour of each object area as follows, for example. If the object area has a clear outline, the edge strength of the outline that is the boundary between the inside and the outside of the object area in the image is considered to be high. From this, it is possible to express the sharpness by a value obtained by appropriately normalizing the edge strength of the contour. For example, as described below, a pixel having a pixel value corresponding to the edge intensity in the contour can be virtually set, and the optical density value represented by the pixel value of the virtual pixel can be used as the sharpness value.

- the edge strength is calculated for the virtual pixel thus obtained.

- Various edge detection filter processes can be applied as the process for obtaining the edge strength.

- various filter processes such as a Sobel filter, a difference filter, a Prewitt filter, a Roberts filter, and a Laplacian filter can be suitably applied.

- Sobel filter calculation is applied as an example of the edge detection filter will be described.

- a (3 ⁇ 3) Sobel filter operation is performed on the luminance value of each virtual pixel.

- the coefficient matrix of the Sobel filter calculation in the horizontal direction (Xi direction) and the vertical direction (Yi direction) of the image can be expressed by the following equations, respectively.

- the edge intensity Se of the virtual pixel can be expressed by the following equation.

- the value Se thus obtained is a numerical value that relatively represents the edge intensity of the pixel with respect to other pixels, and the scale of the luminance value is emphasized four times on the principle of calculation. . Therefore, by dividing the value of the edge strength Se by 4, it is possible to obtain an edge strength normalized to a numerical range of the same scale as the luminance value of the pixel.

- the average value of the edge strength Se of each virtual pixel corresponding to one object region is Sa

- the value (Sa / 4) represents the average normalized edge strength of the contour of one object region, This is a value indicating the sharpness of the outline of the object area.

- the average brightness value of the surrounding area having a predetermined width surrounding the object area or the brightness of the entire area that is not set as the object area in the original image. It can be expressed by the average value of.

- the object area clearly shows the definition Sh of the object area, eliminating the influence of the background area and illumination variations, and can be compared between different object areas. It can be expressed as a simple numerical value.

- the sharpness Sh of the contour of the object region is defined in this way, the sharpness Sh is close to 1 for the object region corresponding to the spheroid whose contour is clearly visually recognized in the original image.

- the sharpness Sh approaches 0 as the unclearness of the apparent outline increases. That is, by the above definition, the sharpness of the contour of the object region can be expressed quantitatively.

- the sharpness calculated at this stage may be a considerably low value.

- an image with a high density but a sharp outline that is, in an out-of-focus state

- the region that lacks the sharpness of the contour may be excluded from the treatment as the object region in the subsequent processing.

- mask conflicts are resolved based on their sharpness. That is, when the transmission patterns overlap (partially) in a plurality of mask images, in other words, when at least some of the object regions extracted in each of the plurality of original images occupy the same coordinate position on the image plane For the overlapping portion, the object region having the highest contour definition Sh is preferentially used.

- the sharpness of the outline of the object area represents the clarity of the outline of the spheroid corresponding to the object area. Therefore, when the object area overlaps when the same spheroid is reflected in multiple original images, the original image with the highest sharpness of the outline is cut out, so that an image with a clearer outline, that is, a more integrated image. An image close to the focus state can be arranged in the composite image.

- FIG. 6B shows a state in which the mask images M1 to M5 are superimposed.

- the sharpness Sh of the contours of the overlapping object areas is compared with each other, and the object area having the highest sharpness is validated.

- the transmission pattern of the mask image to which the object region having the highest definition belongs is maintained, and the transmission patterns of the other mask images are filled. Therefore, in the overlapping portion, the content of the original image having the higher sharpness Sh of the outline of the object region is reflected in the composite image.

- the mask conflict can be resolved only for the overlapping portions.

- the contents of the original image cut out from the portion are arranged in the composite image.

- FIG. 6C shows an example of the composite image Is1 created by arranging the object regions cut out from the original images as described above at corresponding positions on one image plane.

- the original image of that part is cut out and arranged in the composite image Is1 for a part that does not overlap with other object areas.

- an image is cut out from the original image to which the object region having the highest contour sharpness Sh belongs among the overlapping object regions. Arranged at Is1.

- a partial region of the spheroid is focused on one original image.

- another partial region is focused on another original image.

- one spheroid is expressed by a combination of clear partial images cut out from a plurality of original images, an image focused on the entire spheroid can be obtained.

- images of spheroids S3 and S5 correspond to this case.

- step S104 the sharpness of the outline is obtained for the object region extracted from each original image.

- step S102 to S104 is executed independently for each of the plurality of original images IM1 to IM5.

- step S105 is calculation between pixels at the same coordinate position of a plurality of original images.

- one pixel position on the image plane is selected (step S105), and it is determined whether or not the position corresponds to any mask (step S106).

- the position is included in the object area of at least one original image, it is determined that the position corresponds to the mask (YES in step S106), and then the overlap is determined (step S107).

- the position is included in the object areas of two or more original images, it can be said that the object areas overlap at the positions.

- the sharpness Sh of the contour is evaluated between the overlapping object areas, and the pixel to be arranged at the pixel position from the original image to which the object area having the highest definition belongs. Is selected (step S108). That is, the pixel value of the pixel selected here is the pixel value that the pixel at the position in the composite image should have.

- the pixel of the original image is selected as the pixel to be arranged at the pixel position.

- step S106 When the pixel position does not correspond to any mask (NO in step S106), it can be said that the pixel position is included in a background area where no spheroid exists. Therefore, an appropriate pixel is selected from any of the original images as representing the background (step S110).

- the pixel representing the background of the spheroid for example, a pixel having the highest luminance among the original images corresponding to the pixel position can be used.

- the background area has higher brightness than the spheroid area, but the brightness of the unfocused image may be lower than that of the original background due to blurring at the periphery of the spheroid.

- the pixel having the highest luminance at the same position the original background luminance can be reflected in the synthesized image. From the same concept, for example, the pixel of the original image having the highest luminance average value of the pixels excluding the pixels in the object area may be adopted.

- one of the original images may be set as a reference image in advance, and the pixels of the reference image may be used as the background.

- one original image in this example, the original image IM3 having a focus position in the depth direction can be used as the reference image. This method is simple for applications where the background state of the spheroid is not so important.

- the pixel at the current pixel position is selected from one of the original images.

- the pixel value at the position in the composite image Is1 is determined.

- the pixel values of all the pixels constituting the composite image Is1 are determined.

- the composite image Is1 thus created is an omnifocal image synthesized from a plurality of original images having different focal positions as described above.

- the first method for creating an omnifocal image described so far an object region is extracted from each original image, and when there is an overlap of the object region between the original images, the definition is compared between the original images.

- the contour of each spheroid in the three-dimensional space is specified from a plurality of original images picked up at different focal positions, and one of the original images is included in the specified contour. By placing the image content, an omnifocal image is created.

- FIG. 7 is a flowchart showing a second method for creating an omnifocal image.

- 8A and 8B are diagrams for explaining the principle of this processing.

- a plurality of (five in this example) original images IM1 to IM5 having different focal positions are acquired (step S201). More specifically, when the imaging unit 15 performs imaging while changing the focal position in the imaging direction, these original images are acquired. Further, for each of the original images IM1 to IM5 obtained in this way, the edge intensity of each pixel constituting the original image is calculated by an appropriate calculation method (step S202). The process up to this point is the same as the first method described above.

- one pixel position on the image plane is selected (step S203), the edge intensity of the pixel corresponding to the position is compared between the original images, and the edge intensity is the maximum among the pixels corresponding to the same position of the sample.

- a pixel is selected (step S204).

- the original image to which the selected pixel belongs is also stored. This process is performed for all pixel positions (step S205).

- one spheroid When one spheroid is focused on a plurality of original images, it can be considered as follows. As shown in FIG. 8B, a case is considered in which a part of the spheroid S having a spread in the depth direction is focused on one original image IMa and the other part is focused on another original image IMb.

- One point on the contour of the spheroid S to be focused on in the original image IMa is represented by reference numeral P1a.

- the pixel located at the point P1a is considered to have a relatively high edge strength.

- the pixel of the point P2b on the contour of the spheroid S that is in focus in the original image IMb has a higher edge intensity than the pixel of the point P2a on the corresponding original image IMa. Therefore, the edge strength at the point P2b is employed at the corresponding point P2r on the contour image Ir.

- a pixel having a relatively large edge strength that can be regarded as corresponding to the contour of an object in the image is a contour pixel, and this represents the position of the contour of each spheroid. That is, a region on the composite image corresponding to the closed region substantially surrounded by the contour pixels in the contour image Ir is set as a spheroid region in the composite image.

- a region obtained by expanding a closed region surrounded by contour pixels by one pixel is a spheroid region. You may make it.

- one of the closed regions specified by the contour image is selected (step S207), and the evaluation score of the closed region is counted for each original image (step S208).

- the evaluation score is obtained by counting the number of pixels whose edge intensity is maximized in step S204 among the pixels included in the closed region in each original image.

- the pixel having the maximum edge strength that is, the pixel that can be regarded as the clearest is selected from the pixels of each original image corresponding to the same position. It can be considered that the original image including more pixels selected in this manner includes a clearer image of the closed region.

- an image cut out from the original image having the maximum evaluation score of the closed region is assigned to the synthesized image (step S209).

- all of them are processed in the same manner (step S210), and the assignment of the image to the closed region specified by the contour pixel is completed.

- an appropriate background pixel is assigned to a region other than the closed region (step S211), and a composite image is created.

- the background pixel selection method can be the same as the first method described above.

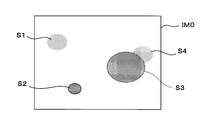

- FIG. 9 is a diagram showing an example of a composite image created by the second method.

- the composite image Is2 created by the second method of creating an omnifocal image first, the spheroid contour is specified including the depth direction. Then, an image cut out from any of the original images can be allocated inside the specified contour. The image to be assigned to the inside of the contour can be cut out from any original image, but among those images, the image with the highest evaluation score, that is, the pixel with the highest edge strength is selected and becomes the composite image. Assigned. As a result, the image content of the clearest original image in the region surrounded by the contour is reflected in the composite image. Therefore, the composite image Is2 is an omnifocal image corresponding to the spheroids S1 to S5 having different positions in the depth direction.

- the contour detection of the spheroid is performed over the depth direction component in addition to the horizontal direction component, it may not be possible to separate them when a plurality of spheroids overlap in the depth direction. is there.

- the spheroid S3 and the spheroid S4 are handled as a single body.

- this method is effective in that the outline of the spheroid is specified more clearly.

- the present method is suitable for an application in which the contour of a spheroid having a spread in the depth direction is specified with the same clarity as when an image pickup system having a large depth of field is picked up.

- the omnifocal image creation method shown in FIGS. 5 and 7 corresponds to the “image processing method” of the present invention.

- steps S101, S102 to S103 and S105 to S112 correspond to the “image acquisition process”, “region extraction process” and “image composition process” of the present invention, respectively.

- steps S201, S202, S203 to S205, and S206 to S211 correspond to the “image acquisition process”, “edge strength calculation process”, “pixel selection process”, and “image composition process” of the present invention, respectively. To do.

- the imaging device 1 corresponds to the “image processing device” of the present invention.

- the imaging unit 10 functions as the “image acquisition unit” of the present invention

- the imaging unit 15 functions as the “imaging unit” of the present invention

- the sensor driving unit 17 functions as the “focus setting unit” of the present invention. is doing.

- the control unit 20, particularly the image processing unit 25 functions as the “image processing means” of the present invention.

- the imaging device 1 includes the imaging unit 10 for capturing an original image used for creating an omnifocal image.

- the operation of imaging the imaging object is not an essential configuration. That is, an imaging device for capturing an original image and an image processing device that executes image processing to create an omnifocal image may be configured separately.

- the image processing apparatus according to the present invention may be configured to receive an original image captured by an external imaging apparatus via, for example, a communication line and perform image processing using the original image.

- the control unit 20 executes the above processing using image data provided from an external imaging device, data storage, or the like. You may do it.

- the input receiving unit 21 functions as the “image acquisition unit” of the present invention.

- the function as the “image processing apparatus” of the present invention can be realized by the control unit 20 alone.

- the configuration of the control unit 20 is the same as that of an information processing device such as a general personal computer or workstation.

- the above processing contents can also be realized by these devices by installing appropriate software. Therefore, the present invention may be provided as a control program for causing these information processing devices to execute the above-described image processing. By mounting such a control program on, for example, a control computer of an existing microscope apparatus, the microscope apparatus can be caused to function as the image processing apparatus of the present invention.

- the focal position is changed and set by moving the imaging unit 15 up and down.

- the sample container D may be moved up and down, or the focal position may be changed using the focus adjustment function of the imaging optical system.

- the imaging unit 15 having the linear image sensor 151 is scanned and moved with respect to the imaging target to obtain a two-dimensional image of the imaging target.

- imaging may be performed using an area image sensor having a function of capturing a two-dimensional image without accompanying scanning movement. Further, imaging combined with a microscopic optical system may be performed.

- the sharpness of the contour is, for example, a pixel having a pixel value corresponding to the edge strength in the contour. It can be expressed by the optical density. Further, in this case, the sharpness of the contour is determined by calculating the average value of the edge strength obtained by the edge detection filter calculation based on the luminance value of the pixel for each pixel corresponding to the contour, and adjacent to the object area specified by the contour.

- the average luminance value of the pixels in the surrounding area is Is

- the following formula: Sh log 10 ⁇ Is / (Is-Sa / 4) ⁇ Can be represented by the left side Sh.

- a region having a contour sharpness that is greater than or equal to a predetermined value among regions having a contour pixel as a contour may be set as the object region. If the evaluation is simply based on the edge strength, an area having a large density difference from the surrounding area may be used as the object area even if the outline is unclear. By adding the sharpness of the outline to the evaluation, only an image closer to the in-focus state can be extracted as the object region.

- a pixel whose edge intensity is a predetermined value or more may be a contour pixel.

- Various methods have been proposed in which a pixel having an edge strength equal to or higher than a predetermined value is regarded as the contour of an object.

- contour extraction can be performed using such a method.

- the background can be represented by arranging pixels extracted from one original image selected from a plurality of original images, for example, other than the region surrounded by the outline in the composite image.

- the pixel with the highest luminance among the pixels corresponding to the same position among a plurality of original images may be arranged as the background.

- the image acquisition means may include an imaging unit that images the sample and a focus setting unit that changes and sets the focal position of the imaging unit in multiple stages. Further, image data corresponding to a plurality of original images may be received from an external device. With any of these, it is possible to acquire a plurality of original images and create a composite image from them.

- the present invention is applicable to, for example, processing of an image obtained by imaging a sample containing cells cultured in a medium.

- an omnifocal image of a cell cluster (spheroid) three-dimensionally cultured in a medium is obtained. It is suitable for the purpose of making.

- Imaging device image processing device

- Imaging unit image acquisition means

- Sensor driving unit focus setting unit

- control unit image processing unit (image processing means)

- image processing means image processing means

Landscapes

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Optics & Photonics (AREA)

- Signal Processing (AREA)

- Theoretical Computer Science (AREA)

- Analytical Chemistry (AREA)

- Chemical & Material Sciences (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Image Processing (AREA)

- Exposure Control For Cameras (AREA)

- Focusing (AREA)

- Microscoopes, Condenser (AREA)

- Automatic Focus Adjustment (AREA)

- Studio Devices (AREA)

- Image Analysis (AREA)

Abstract

撮像方向に沿った方向に焦点位置を互いに異ならせた複数の原画像を取得する画像取得工程(ステップS201)と、複数の原画像の各々において当該原画像を構成する画素のエッジ強度を算出するエッジ強度算出工程(S202)と、複数の原画像間で同一位置に対応する画素のうち最もエッジ強度が高い画素を選出する画素選出工程(S203~S205)と、選出された画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素の位置を輪郭の位置とする領域に、原画像のいずれかの当該領域に対応する位置から抽出された画素を配した合成画像を作成する画像合成工程(S206~S210)とを備え、輪郭で囲まれる一の領域について、画素選出工程で選出された画素を当該領域内に最も多く含む一の原画像から抽出された画素を配する。

Description

この発明は、画像処理方法、制御プログラムおよび画像処理装置に関するものであり、特に画像処理によって全焦点画像を作成する技術に関する。

関連出願の相互参照

以下に示す日本出願の明細書、図面および特許請求の範囲における開示内容は、参照によりその全内容が本書に組み入れられる:

特願2014-265039(2014年12月26日出願)。

関連出願の相互参照

以下に示す日本出願の明細書、図面および特許請求の範囲における開示内容は、参照によりその全内容が本書に組み入れられる:

特願2014-265039(2014年12月26日出願)。

撮像対象物を撮像して画像処理を施す技術が、医療や生化学の分野に、より具体的には例えば培地内で培養された細胞などの生物試料の観察・分析等の目的に適用されることがある。ここで、撮像対象物である試料において細胞、または複数の細胞が集合してなる細胞集塊(以下、これらを総称して「細胞等」と称する)が培地内で三次元的に分布している場合、その全体に焦点が合った画像が得られないことがあり得る。このような問題に対応するために、撮像方向に沿って焦点位置を多段階に異ならせて複数の画像を撮像し、各画像から焦点の合った部分のみを抽出して合成することで、いわゆる全焦点画像を作成する技術が提案されている。

例えば特許文献1に記載の技術では、合焦画像においては標本(撮像対象物)のエッジ部分の輝度変化が特に大きいことに着目し、撮像方向における焦点位置の変化に伴うエッジ部分の画素の輝度変化に基づいて、当該画素における合焦位置が特定される。合焦位置にあると判定された画素(以下、「合焦画素」と称する)を配列して画像を構成することにより、全焦点画像を自動的に作成することが可能となる。

上記従来技術では、比較的明瞭なエッジおよびテクスチャを有する標本を対象物として、焦点深さの異なる複数の画像から抽出された合焦画素がつなぎ合わされて全焦点画像が作成される。しかしながら、培地中で三次元培養された細胞等では、そもそもその輪郭や表面のテクスチャが必ずしも鮮明なものとは限らない。そのため、上記従来技術のように画素単位でのつなぎ合わせを行った場合、細胞等の内部テクスチャが却って不自然になってしまうという問題があった。

この発明は上記課題に鑑みなされたものであり、三次元培養された細胞等を対象とする場合に好適な、全焦点画像の作成技術を提供することを目的とする。

培地中で三次元培養される細胞または細胞の集塊(細胞等)を含む試料では、サイズや形状が一定でない細胞等が、三次元的に分布し、つまり撮像方向およびこれに直交する方向のそれぞれにおける様々な位置に点在している。また、各細胞等自体も、撮像方向およびこれに直交する方向への広がりを有している。以下に説明する各発明は、このような特徴に鑑みて考案されたものである。

この発明の一の態様は、培地中で三次元培養された細胞を含む試料の画像を作成する画像処理方法であって、上記目的を達成するため、撮像方向において互いに異なる焦点位置で前記試料を撮像した複数の原画像を取得する画像取得工程と、前記複数の原画像の各々において当該原画像を構成する各画素のエッジ強度を算出するエッジ強度算出工程と、前記複数の原画像間で互いに同一位置に対応する画素のうち、最もエッジ強度が高い画素を選出する画素選出工程と、選出された画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素の位置を輪郭の位置とする領域に、前記原画像のいずれかの当該領域に対応する位置から抽出された画素を配した合成画像を作成する画像合成工程とを備え、前記画像合成工程では、前記輪郭で囲まれる一の領域について、前記画素選出工程において選出された画素を当該領域内に最も多く含む一の前記原画像から抽出された画素を配する。

また、この発明の他の態様は、培地中で三次元培養された細胞を含む試料の画像を作成する画像処理装置であって、上記目的を達成するため、撮像方向において互いに異なる焦点位置で前記試料を撮像した複数の原画像を取得する画像取得手段と、前記複数の原画像を合成して合成画像を作成する画像処理手段とを備え、前記画像処理手段は、前記複数の原画像の各々において、当該原画像を構成する画素のエッジ強度を算出し、前記複数の原画像間で互いに同一位置に対応する画素のうち最もエッジ強度が高い画素を選出し、選出された画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素の位置を輪郭の位置とする領域内に、前記原画像のいずれかの当該領域に対応する位置から抽出された画素を配した合成画像を作成し、しかも、前記輪郭で囲まれる一の領域について、前記選出された画素を当該領域内に最も多く含む一の前記原画像から抽出された画素を配することで前記合成画像を作成する。

上記のように構成された発明では、複数の原画像間で同一位置に対応する画素のエッジ強度が比較され、最もエッジ強度が高い画素が選出される。こうして選出される画素は当該位置において細胞等を最も鮮明に撮像した原画像に属していたものと考えられる。つまり、当該位置では、選出された画素を含む原画像が最も合焦状態に近い状態で撮像されたと考えることができる。こうして選出された画素を配置してなる仮想的な画像内で、オブジェクトの輪郭に相当すると考えられる画素が細胞等の輪郭を表す輪郭画素として特定される。

焦点位置の異なる複数の原画像から選出された画素により表される輪郭は、三次元空間に広がりを有する細胞等を撮像方向に直交する画像平面に投影した、つまり十分に大きな被写界深度を有する撮像装置により細胞等の全体を合焦状態で撮像したときの輪郭に相当するものである。したがって、細胞等の輪郭については、合焦状態で撮像された画像と同程度の精度で合成画像に表すことができる。

こうして特定される輪郭に囲まれる領域の画像内容については、各原画像のうち、当該領域内においてエッジ強度が最も高いとして選出された画素を最も多く含む原画像から採られたものとされる。これにより、輪郭内部は単一の原画像に表れたテクスチャを維持したものとなり、しかも元となる原画像は、当該領域について合焦状態に最も近いものが選ばれることになる。

このように、本発明によれば、培地中で三次元培養される細胞等の特徴に鑑みて、複数の原画像間で同一位置に対応する画素のうち最もエッジ強度の高い画素が選出され、さらに、輪郭画素によって合成画像における細胞等の輪郭が特定される。そして、当該輪郭の内部に、原画像のうち当該領域を最も合焦状態に近い状態で撮像された原画像の内容が適用される。このため、原画像に含まれるテクスチャがそのまま合成画像に表れる。このようにして得られる合成画像は、種々の位置に点在する細胞等を良好な画像品質で撮像した全焦点画像となる。すなわち、上記発明によれば、細胞が三次元培養された試料の全焦点画像を良好な画像品質で作成することができる。

また、この発明の他の態様は、培地中で三次元培養された細胞を含む試料の画像を作成する画像処理方法であって、上記目的を達成するため、撮像方向において互いに異なる焦点位置で前記試料を撮像した複数の原画像を取得する画像取得工程と、前記複数の原画像の各々において、当該原画像を構成する画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素を輪郭とするオブジェクト領域を抽出する領域抽出工程と、前記複数の原画像の各々から抽出された前記オブジェクト領域内の画素を一の画像に、かつ前記原画像内での当該画素の位置に対応する位置に配した合成画像を作成する画像合成工程とを備え、前記画像合成工程では、異なる前記原画像からそれぞれ抽出された複数の前記オブジェクト領域が少なくとも一部において前記合成画像内で重複するとき、当該重複する領域内の画素については、重複する複数の前記オブジェクト領域のうち輪郭が最も鮮明な前記オブジェクト領域の画素を配する。

また、この発明の他の態様は、培地中で三次元培養された細胞を含む試料の画像を作成する画像処理装置であって、上記目的を達成するため、撮像方向において互いに異なる焦点位置で前記試料を撮像した複数の原画像を取得する画像取得手段と、前記複数の原画像を合成して合成画像を作成する画像処理手段とを備え、前記画像処理手段は、前記複数の原画像の各々において、当該原画像を構成する画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素を輪郭とするオブジェクト領域を抽出し、前記複数の原画像の各々から抽出された前記オブジェクト領域内の画素を一の画像に、かつ前記原画像内での当該画素の位置に対応する位置に配した合成画像を作成し、しかも、異なる前記原画像からそれぞれ抽出された複数の前記オブジェクト領域が少なくとも一部において前記合成画像内で重複するとき、当該重複する領域内の画素については、重複する複数の前記オブジェクト領域のうち輪郭が最も鮮明である前記オブジェクト領域の画素を配することで前記合成画像を作成する。

上記のように構成された発明では、撮像方向に沿って焦点位置が互いに異なる複数の原画像が用いられる。このため、種々の位置に分布する細胞等の各々を、いずれかの原画像に合焦状態に近い状態で含ませることが可能である。そして、各原画像内でオブジェクトの輪郭に相当すると見なされる画素に囲まれた領域がオブジェクト領域として抽出される。培地中で培養された細胞等を撮像した画像においては、比較的均一な背景中に細胞等の像が点在している。したがって、比較的高いエッジ強度を有する画素に囲まれたオブジェクト領域の各々は、細胞等の像に対応するものと考えられる。

一の原画像でオブジェクト領域が見出され、他の原画像の同一位置に対応するオブジェクト領域がないとき、当該一の原画像で検出されたオブジェクト領域が、細胞等を最も合焦状態に近い状態で撮像した像を含む蓋然性が高いということができる。このため、当該オブジェクト領域内の画素全体が、合成画像を構成する画素に適用される。一方、複数の原画像間で同一位置にオブジェクト領域が存在するとき、互いに重複する領域については、輪郭が最も鮮明なオブジェクト領域の画素が適用される。これにより、最も合焦状態に近い像を合成画像に反映させることができる。

このように、本発明によれば、培地中で三次元培養される細胞等の特徴に鑑みて、1つの原画像からエッジ強度に基づき抽出されたオブジェクト領域が、他の原画像から抽出されたオブジェクト領域と重複しないとき、当該オブジェクト領域内の画素が合成画像における画素とされる。このため、原画像に含まれるテクスチャがそのまま合成画像に表れる。一方、オブジェクト領域の重複があるときには、そのうち輪郭が最も鮮明なオブジェクト領域の画素が適用される。これにより、当該オブジェクト領域に対応する細胞等については、最も合焦状態に近い状態で撮像された原画像のテクスチャを合成画像に含ませることができる。

また、複数の原画像間でオブジェクト領域の一部が重複する場合、重複する領域についてのみ、上記した鮮明さに基づく選択がなされることにより、例えば撮像方向に位置の異なる複数の細胞等が撮像方向から見て重なっている場合でも、手前側の細胞等と奥の細胞等とを個別に取り扱うことが可能となる。

このようにして得られる合成画像は、種々の位置に点在する細胞等を良好な画像品質で撮像した全焦点画像となる。すなわち、上記発明によれば、細胞が三次元培養された試料の全焦点画像を良好な画像品質で作成することができる。

また、この発明のさらに他の態様は、上記した画像処理方法のいずれかをコンピューターに実行させるための制御プログラムである。上記の画像処理方法は、一般的な計算処理機能を有するコンピューターにより実行可能な処理の組み合わせにより構成されている。したがって、本発明の制御プログラムをコンピューターに実行させることで、当該コンピューターを上記の画像処理方法を実行する画像処理装置として機能させることが可能となる。

上記において、「輪郭画素を輪郭とする領域」、「輪郭画素の位置を輪郭の位置とする領域」は、画像内で輪郭画素とされる画素により実質的に囲まれた領域を意味し、画像において連続する輪郭画素で囲まれる領域のほか、不連続な輪郭画素間を適宜の補間方法により保管して得られた輪郭により囲まれる領域、および輪郭と画像端とで囲まれる領域などを含む概念である。

上記のように、本発明によれば、培地中で細胞が三次元培養された試料の全焦点画像を作成するのに好適な画像処理技術を提供することができる。

この発明の前記ならびにその他の目的と新規な特徴は、添付図面を参照しながら次の詳細な説明を読めば、より完全に明らかとなるであろう。ただし、図面は専ら解説のためのものであって、この発明の範囲を限定するものではない。

図1はこの発明にかかる画像処理方法および画像処理装置を適用可能な撮像装置の一実施形態を示す図である。この撮像装置1は、試料容器Dに担持された生物試料を撮像対象物として撮像する撮像ユニット10と、撮像ユニット10を制御するとともに撮像された画像に適宜の画像処理を施す制御ユニット20とを備えている。

この撮像装置1が撮像対象物として取り扱う試料は、例えば浅皿型のディッシュのような試料容器Dに担持された培地中で、細胞やその集まりである細胞コロニー(細胞等)が培養されたものである。特に細胞コロニーが球状の集塊をなすとき、このような細胞集塊はスフェロイドとも呼ばれる。培地は例えば軟寒天と培養液とを含み、試料容器Dに所定量注入される。したがって、試料容器Dの内底面には一定の厚みの培地の層が担持される。この培地に細胞が播種され所定の培養条件で培養されることにより、撮像対象物となる生物試料が作成される。

撮像ユニット10は、試料容器Dを支持するホルダ11と、ホルダ11の上方に配置される照明部13と、ホルダ11に支持される試料容器Dに対して照明部13と反対側、つまり試料容器Dの下方に配置される撮像部15とを備える。ホルダ11は、試料容器Dを略水平姿勢に支持する。照明部13は、ホルダ11に支持される試料容器Dの上方に配置され試料容器Dに向けて照明光を照射する。撮像部15は、照明部13から照射されて試料容器Dの底面を透過してくる光を受光して、試料容器Dの内部の試料を下方から撮像する撮像部15とを備える。なお、撮像ユニット10における方向を明示するために、図のようにXYZ直交座標系を設定する。ここで、XY平面は水平面を表し、Z軸は鉛直軸を表す。

撮像部15は、リニアイメージセンサ151と、結像光学系152と、これらを一体的にY方向に水平移動させる機能とZ方向に昇降移動させる機能とを備えたセンサ駆動部17とを有する。リニアイメージセンサ151は、図1紙面に垂直なX方向を長手方向として該方向に配列された多数の微小な撮像素子を有する。結像光学系152は、鉛直方向の光軸を有し、試料容器D底面から出射されてくる透過光をリニアイメージセンサ151の受光面に収束させる。撮像部15は、結像光学系152により集光される試料容器Dからの透過光をリニアイメージセンサで受光しながら試料容器D底面に沿ってY方向に移動する。これにより、試料の二次元画像が取得される。試料の上部から下向きに入射し下方に透過する光が撮像部15に受光されて撮像が行われるので、撮像部15による撮像方向は鉛直方向である。なお、図1では撮像光学系152を単一のレンズで代表的に表現しているが、複数のレンズや光学素子の組み合わせにより構成されたものであってもよい。

制御ユニット20は、入力受付部21、表示部22、照明制御部23、記憶部24、画像処理部25、移動制御部26などの各機能ブロックを備えている。照明制御部23は照明部13の動作を制御する。移動制御部26はセンサ駆動部17を制御して撮像部15を所定の方向に移動させる。画像処理部25は、撮像部15から出力される画像信号に基づき各種の画像処理を実行する。記憶部24は、処理前後の画像データやその他の各種データを記憶保存する。入力受付部21は、この撮像装置1を操作するオペレータからの操作指示入力を受け付ける。表示部22は、システムの動作状況や処理結果等を視覚情報としてオペレータに報知する。

次に、上記のように構成された撮像装置1を用いて、試料容器D内の生物試料の全焦点画像を作成する方法について説明する。まず、撮像対象となる生物試料についてその概要を説明する。

図2Aおよび図2Bは撮像対象となる生物試料の例を示す図である。より具体的には、図2Aおよび図2Bはそれぞれ生物試料を担持する試料容器Dの側面透視図および上面図である。撮像装置1による撮像の対象となる生物試料は、例えばディッシュと称される試料容器Dに注入された培地M中で細胞が三次元培養されたものである。培地Mは試料容器Dに所定の深さまで注入された半固体状の物質であり、例えば軟寒天が用いられる。培地Mには必要に応じ試薬が添加され、細胞が播種されて所定の培養条件で一定期間培養されたものが、生物試料となる。

図では、生物試料の一例として、培地M中で増殖した細胞が固まってスフェロイド(細胞集塊)S1~S5を形成している例を示している。図に示すように、スフェロイドS1~S5の各々は培地M内で三次元的な広がりを有し、そのサイズや形状にはばらつきがある。特に細胞が非染色であれば無色透明に近いため、輪郭は必ずしも鮮明ではない。またスフェロイドS1~S5は、培地M中において水平方向(XY方向)および鉛直方向(Z方向)の種々の位置に三次元的に分布している。このようにスフェロイドが三次元的に分布するため、見る方向によってはスフェロイド同士が重なる場合もある。このような特徴を有する生物試料を撮像する場合の問題点について、次に説明する。

図3Aおよび図3Bは試料を撮像する際に生じうる問題点を模式的に示す図である。図3Aに示すように、この撮像装置1では、試料容器Dの下方に配置された撮像部15により試料容器Dの底面Dbを介して試料が撮像される。培地Mの深さに対し撮像光学系152の被写界深度が十分に大きくなければ、深さ方向、つまり鉛直方向(Z方向)に分布するスフェロイドの全てを合焦範囲に収めることができない場合がある。

図3Bは、例えば撮像光学系152の焦点位置を図3Aの符号F0で示す深さに設定したときの画像IM0を模式的に示す図である。撮像部15により試料を撮像したとき、撮像光学系152の焦点位置F0に近い深さに表面が位置するスフェロイドS2は比較的鮮明に撮像される。一方、焦点位置よりも大きく奥側に外れたスフェロイドS1,S4は薄くぼやけた像となる。また焦点位置より手前側に突出するスフェロイドS3も、輪郭が不鮮明となる。撮像光学系152の焦点位置をZ方向に変更することが可能な構成であっても、全てのスフェロイドS1~S5を同時に合焦範囲に収めることが難しい。

撮像光学系152の被写界深度を十分大きくすれば、全てのスフェロイドを合焦範囲に収めることは可能となる。しかしながら、被写界深度が培地Mの深さよりも大きい場合、例えば容器壁面などの周囲や背景、培地表面のメニスカスの影響等が画像に映り込むことがあり、画像品質の点では必ずしも好ましくない場合がある。そこで、この撮像装置1は、試料に対する撮像光学系152の焦点位置をZ方向(深さ方向)に多段階に変更設定してその都度撮像する、いわゆるフォーカスブラケット撮像を行う。そして、撮像装置1は、得られた複数の原画像を画像処理により合成して、種々の深さのスフェロイドに擬似的に焦点の合った全焦点画像を作成する。

図4Aおよび図4Bはフォーカスブラケット撮像により得られる画像の例を説明する図である。一例として、図4Aに示すように、撮像光学系152の焦点位置をF1~F5の5段階に変更して撮像した場合を考える。焦点位置F1,F2,F3,F4,F5に対応して、図4Bに示すように、5枚の原画像IM1,IM2、IM3,IM4,IM5が得られる。ここで、符号Xi,Yiは、実空間における座標と区別して各画像平面における平面座標を表したものである。

各原画像IM1~IM5においては、表面が焦点深さに近い位置にあるスフェロイドの像が鮮明に表れる一方、焦点位置から遠いスフェロイドはより不鮮明となる。例えば焦点位置F1に対応する原画像IM1では、表面が焦点位置に近いスフェロイドS1,S4が鮮明に映る一方、焦点位置から遠いスフェロイドS2,S3,S5はぼやけている。また、撮像部15側(容器底面Db側)から見たときスフェロイドS4の手前にスフェロイドS3があるため、スフェロイドS4の像の一部がスフェロイドS3の像により遮蔽されている。

また、焦点位置F3に対応する原画像IM3では、焦点面を横切るスフェロイドS5の輪郭が鮮明に映る一方、焦点位置から外れたスフェロイドS1~S4の像はより不鮮明であり、また平面視において重なり合うスフェロイドS3,S4の境界が不明確となっている。このように、焦点位置に応じて、原画像IM1~IM5への各スフェロイドS1~S5の像の表れ方が異なる。以下、このような特徴を有する原画像IM1~IM5から全焦点画像を作成する2つの具体的な方法について説明する。これらの方法は、制御ユニット20が予め記憶された制御プログラムを実行して装置各部に所定の動作を行わせることにより実現される。

図5は全焦点画像を作成する第1の方法を示すフローチャートである。また、図6Aないし図6Cは処理の過程で作成される画像を示す図である。最初に、焦点位置が互いに異なる複数の(この例では5枚の)原画像IM1~IM5が取得される(ステップS101)。より具体的には、撮像部15がその撮像方向(鉛直方向)に焦点位置を変えながら撮像を行うことにより、これらの原画像が取得される。

こうして得られた原画像IM1~IM5のそれぞれについて、当該原画像を構成する画素各々のエッジ強度が算出される(ステップS102)。エッジ強度を算出する方法としては公知のあるいはそれと同等の種々の方法を用いることができ、例えば4連結画素のエッジフィルタ、差分フィルタ、ラプラシアンフィルタなどを用いることができる。こうしてエッジ強度が求められた画素のうち、細胞等の画像オブジェクトの輪郭に相当すると見なせるような比較的大きなエッジ強度の値を有するものを「輪郭画素」と称することとする。例えばエッジ強度が予め定められた閾値以上である画素を、輪郭画素とみなすことができる。あるいは、周囲の画素に対するエッジ強度の差が所定値以上である画素を輪郭画素としてもよい。

輪郭画素により囲まれる画像内の閉領域が、オブジェクト領域として抽出される。すなわち、輪郭画素が当該オブジェクト領域の輪郭を表すものとされる。スフェロイドが焦点位置から大きく外れていることに起因して輪郭が不鮮明な像は、オブジェクト領域として扱われない。なお、オブジェクト領域は、その輪郭の全てが連続する輪郭画素で構成されるものに限定されず、複数の輪郭画素により実質的に囲まれた領域を含んでよい。例えば、不連続な輪郭画素の間を適宜の補間方法で補間する閉曲線を輪郭とする閉領域、輪郭画素から特定される輪郭と画像の端部とで囲まれる閉領域などについても、オブジェクト領域と見なすことができる。

また、スフェロイド自体が有する輪郭の不鮮明さに起因して、上記で求められた輪郭画素により特定されるオブジェクト領域が、本来のスフェロイドの広がりよりも小さい領域となる場合があることがわかっている。この問題を解消するために、例えば輪郭画素により囲まれる領域を1画素分拡張させた領域を、オブジェクト領域とするようにしてもよい。

こうして抽出されたオブジェクト領域に基づき、各原画像からマスク画像が作成される(ステップS103)。具体的には、各原画像に対して、当該原画像において抽出されたオブジェクト領域を透過パターンとするようなマスク画像が作成される。図4Bに示す原画像IM1~IM5からは、例えば図6Aに示すマスク画像M1~M5が作成される。各マスク画像は、各原画像において比較的鮮明な輪郭によって囲まれたオブジェクトの領域の範囲および位置を示す画像である。一の原画像に対し、これに対応するマスク画像を作用させることで、当該原画像から輪郭の明瞭なオブジェクト領域の画像を切り出すことができる。

全焦点画像を作成する第1の方法では原則的に、これらのマスク画像を対応する原画像に適用して切り出された画像を合成することで、合成画像が作成される。しかしながら、図4Bに示したように、1つのスフェロイドの像が複数の原画像に亘って現れることがある。このため、1つのスフェロイドに対応するオブジェクト領域が複数の原画像において抽出され、図6Aに破線で示すように、マスク画像に現れる透過パターンが画像平面上で重複することがある。その結果、オブジェクト領域が重複する部分では、合成画像に配置すべき画像の候補が複数生じてしまう。このようなマスクの競合を回避するために、抽出された各オブジェクト領域の輪郭の鮮明さを示す指標として輪郭の鮮明度が導入される。

鮮明度Shについては、例えば以下のように各オブジェクト領域の輪郭のエッジ強度を用いて定義することができる。オブジェクト領域が鮮明な輪郭を有していれば、その画像においてオブジェクト領域の内部と外部との境界である輪郭のエッジ強度が高くなると考えられる。このことから、輪郭のエッジ強度を適宜に正規化した値によって鮮明度を表すことが可能である。例えば以下に説明するように、輪郭におけるエッジ強度に対応する画素値を有する画素を仮想的に設定し、当該仮想画素の画素値が表す光学濃度の値を鮮明度の値として用いることができる。

こうして求められる仮想画素についてエッジ強度を算出する。エッジ強度を求める処理としては種々のエッジ検出フィルタ処理を適用することができる。例えばSobelフィルタ、差分フィルタ、Prewittフィルタ、Robertsフィルタ、ラプラシアンフィルタ等の各種フィルタ処理を好適に適用することが可能である。ここではエッジ検出フィルタの例としてSobelフィルタ演算を適用した場合について説明する。

各仮想画素の輝度値に対して、(3×3)のSobelフィルタ演算を行う。画像の水平方向(Xi方向)および垂直方向(Yi方向)におけるSobelフィルタ演算の係数行列については、それぞれ次式により表すことができる。

このようにして求められた値Seは、他の画素に対する当該画素のエッジ強度を相対的に表す数値であり、計算の原理上、輝度値のスケールが4倍に強調されたものとなっている。したがって、エッジ強度Seの値を4で除することにより、画素の輝度値と同じスケールの数値範囲に正規化されたエッジ強度を得ることができる。1つのオブジェクト領域に対応する仮想画素各々のエッジ強度Seの平均値をSaとすると、値(Sa/4)は、1つのオブジェクト領域の輪郭が有する平均的な正規化エッジ強度を表し、これが当該オブジェクト領域の輪郭の鮮明さを指標する値となる。

ただし、オブジェクト領域を取り巻く背景領域の濃度や照明条件のばらつき(シェーディング)の影響を排除する必要がある。そこで、仮想画素の輝度値を上記で求められる正規化エッジ強度(Sa/4)を輝度値に置き換えた、さらに仮想的な画像を考える。そして、当該仮想画像における各画素の光学濃度を、当該オブジェクト領域の鮮明度Shとして定義する。すなわち次式:

Sh=log10{Is/(Is-Sa/4)}

により鮮明度Shを定義する。ここで、値Isはオブジェクト領域の背景領域の輝度平均値であり、例えば当該オブジェクト領域を取り囲む所定幅の周囲領域の輝度の平均値や、当該原画像においてオブジェクト領域とされなかった領域全体の輝度の平均値などで表すことができる。背景領域の輝度を加味した光学濃度の次元で示すことにより、オブジェクト領域の背景領域や照明ばらつきの影響を排して各オブジェクト領域の鮮明度Shを客観的に表し、異なるオブジェクト領域間でも比較可能な数値として表すことが可能となる。

Sh=log10{Is/(Is-Sa/4)}

により鮮明度Shを定義する。ここで、値Isはオブジェクト領域の背景領域の輝度平均値であり、例えば当該オブジェクト領域を取り囲む所定幅の周囲領域の輝度の平均値や、当該原画像においてオブジェクト領域とされなかった領域全体の輝度の平均値などで表すことができる。背景領域の輝度を加味した光学濃度の次元で示すことにより、オブジェクト領域の背景領域や照明ばらつきの影響を排して各オブジェクト領域の鮮明度Shを客観的に表し、異なるオブジェクト領域間でも比較可能な数値として表すことが可能となる。

本願発明者の知見によれば、このようにオブジェクト領域の輪郭の鮮明度Shを定義した場合、原画像において輪郭が明瞭に視認されるスフェロイドに対応するオブジェクト領域については鮮明度Shが1に近い値となる一方、見た目の輪郭の不鮮明さが増すほど鮮明度Shが0に近づく値となることが確認された。すなわち、上記定義により、オブジェクト領域の輪郭の鮮明さを定量的に表現することができる。

なお、エッジ強度に基づき抽出されたオブジェクト領域であっても、この段階で算出される鮮明度が相当に低い値となる場合があり得る。エッジ強度による評価のみでは、例えば高濃度であるが輪郭の不鮮明な(つまり非合焦状態の)像をオブジェクト領域と判断してしまうことがある。したがって、オブジェクト領域とされた領域であっても、輪郭の鮮明度が不足するものについては、以後の処理においてオブジェクト領域としての扱いから除外するようにしてもよい。

各原画像の間で重複するオブジェクト領域については、それらの鮮明度に基づいてマスクの競合が解決される。すなわち、複数のマスク画像において透過パターンが(部分的に)重複するとき、言い換えれば、複数の原画像のそれぞれで抽出されたオブジェクト領域のうち少なくとも一部が画像平面上で同一座標位置を占めるとき、重複部分については、輪郭の鮮明度Shの最も高いオブジェクト領域が優先的に使用される。

上記したように、オブジェクト領域の輪郭の鮮明度は、当該オブジェクト領域に対応するスフェロイドの輪郭の明瞭さを表している。したがって、同一スフェロイドが複数の原画像に映り込むことによってオブジェクト領域が重複する場合、そのうち輪郭の鮮明度が最も高い原画像が切り出されるようにすることで、より輪郭が明瞭な像、つまりより合焦状態に近い像が合成画像に配置されることが可能となる。

図6Bは各マスク画像M1~M5を重ね合わせた状態を示している。図において斜線を付した領域において、複数マスク間で透過パターンが重複する競合が生じている。これらの領域のそれぞれでは、重複するオブジェクト領域の輪郭の鮮明度Shが相互に比較され、鮮明度が最も大きいオブジェクト領域が有効とされる。言い換えれば、鮮明度が最も大きいオブジェクト領域が属するマスク画像の透過パターンが維持され、それ以外のマスク画像の透過パターンは塗りつぶされる。したがって、重複部分では、オブジェクト領域の輪郭の鮮明度Shが高い方の原画像の内容が合成画像に反映されることになる。

なお、複数の原画像間でオブジェクト領域が互いに重複する部分がある場合、当該重複する部分についてのみマスク競合の解決が図られる。つまり、他のオブジェクト領域と部分的に重複するオブジェクト領域では、重複部分については他のオブジェクト領域との比較によって有効とするか否かが判断される一方、重複部分以外は有効なものとされ、当該部分から切り出された原画像の内容が合成画像に配置される。

図6Cは、上記のようにして各原画像から切り出されたオブジェクト領域を一の画像平面上の対応する位置に配置することにより作成される、合成画像Is1の例を示している。各原画像から抽出されるオブジェクト領域の画像のうち、他のオブジェクト領域との重複がない部分についてはその部分の原画像が切り出されて合成画像Is1に配置される。また、原画像間でオブジェクト領域が重複する部分がある場合には、当該部分については、重複オブジェクト領域のうち最も輪郭の鮮明度Shが高いオブジェクト領域が属する原画像から画像が切り出されて合成画像Is1に配置される。

これにより、各スフェロイドS1~S5のそれぞれを最も鮮明に撮像した領域が複数の原画像IM1~IM5の中から個別に切り出されて合成画像Is1が作成されることになる。そのため、この方法によれば、試料中で三次元的に分布するスフェロイドS1~S5のそれぞれに焦点の合った全焦点画像を疑似的に作成することが可能である。この場合、画像平面においてある程度の広がりを有する領域が一括して切り出され合成されるので、画素単位での合成技術とは異なり、原画像におけるスフェロイド表面のテクスチャが合成画像においても保存されている。

また、オブジェクト領域の重複がある場合、重複する部分と重複のない部分とが個別に処理される。このため、深さ方向に異なる位置にあるスフェロイドが画像上で重なっていても、これらのそれぞれについて個別に鮮明な画像を選出することが可能である。図6Cの合成画像Is1においては、スフェロイドS3,S4の像がこのケースに相当している。

なお、試料中で比較的大きな体積を有し、水平方向(XY方向)および深さ方向(Z方向)に大きな広がりを有するスフェロイドでは、当該スフェロイドの一部領域が一の原画像において合焦し、他の一部領域が別の原画像において合焦するというケースもあり得る。このような場合にも、複数の原画像から切り出された鮮明な部分画像の組み合わせで1つのスフェロイドが表現されるため、スフェロイド全体に焦点が合った画像を得ることができる。図6Cの合成画像Is1においては、スフェロイドS3,S5の像がこのケースに相当している。

具体的な処理内容について、図5を参照して説明する。上記したように、各原画像から抽出されたオブジェクト領域について、輪郭の鮮明度が求められる(ステップS104)。なお、ステップS102からS104までの処理は、複数の原画像IM1~IM5のそれぞれで独立して実行される。これに対し、ステップS105以降の処理は、複数の原画像の同一座標位置にある画素間での演算となる。

続いて、画像平面における1つの画素位置が選出され(ステップS105)、当該位置がいずれかのマスクに該当するか否かが判断される(ステップS106)。当該位置が少なくとも1つの原画像のオブジェクト領域に含まれるときマスクに該当すると判断され(ステップS106においてYES)、続いてその重複が判断される(ステップS107)。当該位置が2以上の原画像のオブジェクト領域に含まれるとき、当該位置においてオブジェクト領域が重複しているということができる。

オブジェクト領域の重複があるとき(ステップS107においてYES)、重複するオブジェクト領域間で輪郭の鮮明度Shが評価され、最も鮮明度が高いオブジェクト領域の属する原画像から、当該画素位置に配置すべき画素が選択される(ステップS108)。つまり、ここで選択された画素の画素値が、合成画像における当該位置の画素が有するべき画素値とされる。オブジェクト領域の重複がない(ステップS107においてNO)、つまり当該画素位置に対応するオブジェクト領域が1つの原画像のみにあるとき、当該原画像の画素が、該画素位置に配置すべき画素として選択される(ステップS109)。

当該画素位置がいずれのマスクにも該当しないとき(ステップS106においてNO)、当該画素位置はスフェロイドが存在しない背景領域に含まれるということができる。そこで、いずれかの原画像から、背景を表すものとして適当な画素が選択される(ステップS110)。

スフェロイドの背景を表す画素としては、例えば、当該画素位置に対応する各原画像のうち最も輝度の高いものを用いることができる。一般的に背景領域はスフェロイドの領域よりも高輝度であるが、非合焦画像ではスフェロイド周縁部のボケにより本来の背景よりも輝度が低下することがあり得る。同一位置で最も輝度の高い画素を採用することで、本来の背景の輝度を合成画像に反映させることができる。同様の考え方から、例えば、オブジェクト領域内の画素を除外した画素の輝度平均値が最も高い原画像の画素を採用するようにしてもよい。

また、原画像のうち1つが予め基準画像として設定され、該基準画像の画素が背景とされてもよい。例えば、深さ方向において焦点位置が中庸である一の原画像(この例では原画像IM3)を基準画像とすることができる。スフェロイドの背景の状態がさほど重視されない用途では、このような方法が簡単である。

以上のようにして、現在の画素位置の画素がいずれかの原画像から選出される。こうして選出された画素の画素値を画像平面上の当該画素位置に割り付けることで(ステップS111)、合成画像Is1における当該位置の画素値が決定される。全ての画素位置について上記処理が実行されることにより(ステップS112)、合成画像Is1を構成する全ての画素の画素値が決定される。こうして作成された合成画像Is1は、上記した通り、焦点位置の異なる複数の原画像から合成された全焦点画像となる。

なお、上記では各原画像からどのようにして有効な領域が切り出されるかを説明するためにマスク画像の概念を用いている。しかしながら、各原画像でのオブジェクト領域の特定および原画像間での重複の判断が適切になされて画像領域の切り出しを行うことができれば足りる。すなわち、処理の過程で実際にマスク画像を作成することを必須とするものではない。

ここまで説明した全焦点画像作成の第1の方法では、各原画像内でオブジェクト領域を抽出し、原画像間でオブジェクト領域の重複がある場合に原画像間での鮮明度の比較が行われる。一方、次に説明する第2の方法では、焦点位置を異ならせて撮像された複数の原画像から三次元空間における各スフェロイドの輪郭を特定し、特定された輪郭内にいずれかの原画像の画像内容を配置することにより、全焦点画像が作成される。

図7は全焦点画像を作成する第2の方法を示すフローチャートである。また、図8Aおよび図8Bはこの処理の原理を説明する図である。最初に、焦点位置が互いに異なる複数の(この例では5枚の)原画像IM1~IM5が取得される(ステップS201)。より具体的には、撮像部15が撮像方向に焦点位置を変えながら撮像を行うことにより、これらの原画像が取得される。また、こうして得られた原画像IM1~IM5のそれぞれについて、当該原画像を構成する画素各々のエッジ強度が適宜の算出方法により算出される(ステップS202)。ここまでは上記した第1の方法と同じである。

続いて、画像平面における1つの画素位置が選出され(ステップS203)、当該位置に対応する画素のエッジ強度が原画像間で比較され、試料の同一位置に対応する画素中でエッジ強度が最大の画素が選出される(ステップS204)。このとき、選出された画素がどの原画像に属するかが併せて記憶される。この処理が、全ての画素位置について行われる(ステップS205)。

スフェロイドの輪郭の位置に対応する画素位置では、三次元的に広がるスフェロイドの輪郭を当該画素位置で最も鮮明に捉えた画素が上記処理により選出されることが期待される。したがって、このようにして選出された画素を一の画像平面に投影したとき、エッジ強度の値が比較的大きい画素同士を結んだ曲線は、図8Aに示すように、十分に大きい被写界深度を有する撮像系により各スフェロイドを撮像したときのスフェロイドの輪郭に相当するものとなる。選出された画素を一の画像平面に投影した画像において、エッジ強度が比較的大きい、例えば所定の閾値以上である画素のみが抽出されて輪郭画像Irが作成される(ステップS206)。

1つのスフェロイドが複数の原画像で合焦する場合については次のように考えることができる。図8Bに示すように、深さ方向に広がりを有するスフェロイドSの一部が一の原画像IMaにおいて合焦し、他の一部が他の原画像IMbにおいて合焦している場合を考える。原画像IMaにおいて合焦するスフェロイドSの輪郭上の一点を、符号P1aにより表す。点P1aに位置する画素は、比較的高いエッジ強度を有すると考えられる。

一方、画像平面において点P1aと同一位置に対応する原画像IMb上の点P1bでは、スフェロイド表面に合焦していないため、当該位置の画素のエッジ強度はより低い。このため、輪郭画像Ir上の対応する点P1rでは、点P1aにおけるエッジ強度が採用される。

また、原画像IMbにおいて合焦するスフェロイドSの輪郭上の点P2bの画素は、対応する原画像IMa上の点P2aの画素よりも高いエッジ強度を有する。したがって、輪郭画像Ir上の対応する点P2rでは、点P2bにおけるエッジ強度が採用される。

輪郭画像Irでは、画像中のオブジェクトの輪郭に相当すると見なせるような比較的大きいエッジ強度を有する画素が輪郭画素とされ、これが各スフェロイドの輪郭の位置を表すものとされる。すなわち、輪郭画像Irにおいて輪郭画素により実質的に囲まれた閉領域に対応する合成画像上の領域が、合成画像におけるスフェロイドの領域とされる。なお、スフェロイド自体の輪郭の不鮮明さに起因して本来のスフェロイドよりも小さい領域が特定される問題に対応するため、例えば輪郭画素により囲まれる閉領域を1画素分拡張させた領域をスフェロイドの領域とするようにしてもよい。

図7に戻って、輪郭画像により特定される閉領域の1つが選出され(ステップS207)、当該閉領域の評価スコアが原画像ごとにカウントされる(ステップS208)。評価スコアは、各々の原画像において当該閉領域内に含まれる画素のうち、ステップS204においてエッジ強度が最大とされた画素の数をカウントしたものである。ステップS204では、同一位置に対応する各原画像の画素のうちエッジ強度が最大、つまり最も鮮明と見なせる画素が選出される。こうして選出される画素を閉領域内に多く含む原画像ほど、当該閉領域のより鮮明な像を含むものと考えることができる。

そこで、当該閉領域については、当該閉領域の評価スコアが最大の原画像から切り出した画像が合成画像に割り付けられるようにする(ステップS209)。輪郭画像において閉領域が複数存在する場合、それらの全てについて同様に処理することで(ステップS210)、輪郭画素により特定される閉領域への画像の割り付けが完了する。そして、閉領域以外の領域については適宜の背景画素を割り付けることで(ステップS211)、合成画像が作成される。背景画素の選出方法については、上記した第1の方法と同様にすることができる。

図9は第2の方法により作成される合成画像の例を示す図である。全焦点画像の作成の第2の方法で作成される合成画像Is2では、まずスフェロイドの輪郭が深さ方向も含めて特定される。そして、特定された輪郭の内部にいずれかの原画像から切り出された画像を割り付けられる。輪郭の内部に割り付けるべき画像についてはどの原画像からでも切り出すことができるが、それらの画像のうち、評価スコアが最も高い、つまりエッジ強度の高い画素を最も多く含む画像が選択されて合成画像に割り付けられる。これにより、当該輪郭に囲まれる領域において最も鮮明な原画像の画像内容が合成画像に反映される。したがって、合成画像Is2は、深さ方向に位置の異なるスフェロイドS1~S5に対応する全焦点画像となっている。

なお、この方法では、スフェロイドの輪郭検出が水平方向成分に加え深さ方向成分にも亘って行われるため、複数のスフェロイドが深さ方向に重なっている場合にこれらを分離することができない場合がある。図9の例では、スフェロイドS3とスフェロイドS4とが一体のものとして扱われている。その一方、スフェロイドの輪郭をより明瞭に特定するという点では本方法が有効である。特に、深さ方向への広がりを有するスフェロイドの輪郭を、被写界深度の大きい撮像系で撮像した場合と同様の明瞭さで特定するという用途に対し、本方法が好適であるといえる。

以上説明したように、上記実施形態においては、図5および図7に示す全焦点画像作成方法が、本発明の「画像処理方法」に相当している。図5の処理では、ステップS101、S102~S103およびS105~S112が、それぞれ本発明の「画像取得工程」、「領域抽出工程」および「画像合成工程」に相当する。図7の処理では、ステップS201、S202、S203~S205、S206~S211が、それぞれ本発明の「画像取得工程」、「エッジ強度算出工程」、「画素選出工程」および「画像合成工程」に相当する。

また、上記実施形態では、撮像装置1が本発明の「画像処理装置」に相当している。撮像装置1においては、撮像ユニット10が本発明の「画像取得手段」として機能し、撮像部15は本発明の「撮像部」として、センサ駆動部17が本発明の「焦点設定部」として機能している。また制御ユニット20、特に画像処理部25が本発明の「画像処理手段」として機能している。

なお、本発明は上記した実施形態に限定されるものではなく、その趣旨を逸脱しない限りにおいて上述したもの以外に種々の変更を行うことが可能である。例えば、上記した実施形態の撮像装置1は、全焦点画像の作成に用いられる原画像を撮像するための撮像ユニット10を有するものである。

しかしながら、本発明にかかる画像処理装置および画像処理方法においては、撮像対象物を撮像するという動作は必須の構成ではない。すなわち、原画像を撮像するための撮像装置と、画像処理を実行して全焦点画像を作成する画像処理装置とが別体として構成されてもよい。例えば本発明にかかる画像処理装置は、外部の撮像装置で撮像された原画像を例えば通信回線を介して受信し、当該原画像を用いて画像処理を行う構成であってもよい。

例えば、上記実施形態の入力受付部21を外部装置から画像データを受信する機能を有するものとして、外部の撮像装置やデータストレージ等から与えられる画像データを用いて制御ユニット20が上記処理を実行するようにしてもよい。この場合、入力受付部21が本発明の「画像取得手段」として機能することになる。

すなわち、制御ユニット20単体でも、本発明の「画像処理装置」としての機能を実現することが可能である。そして、制御ユニット20の構成は、一般的なパーソナルコンピューターやワークステーション等の情報処理機器と変わらない。また上記した処理内容も、適宜のソフトウェアが実装されることにより、これらの機器によって実現可能なものである。したがって、上記した画像処理をこれらの情報処理機器に実行させるための制御プログラムとして、本発明が提供されてもよい。このような制御プログラムを例えば既存の顕微鏡装置の制御コンピューターに実装することで、当該顕微鏡装置を本発明の画像処理装置として機能させることも可能となる。

また、上記実施形態では撮像部15を昇降させることで焦点位置が変更設定される。これに代えて、例えば試料容器Dを昇降させたり、撮像光学系の焦点調整機能を用いて、焦点位置の変更を行うようにしてもよい。また、上記実施形態ではリニアイメージセンサ151を有する撮像部15を撮像対象物に対し走査移動させることで撮像対象物の二次元画像を得ている。しかしながら、走査移動を伴わずに二次元画像を撮像する機能を有するエリアイメージセンサを用いて撮像が行われてもよい。また、顕微光学系と組み合わせた撮像が行われてもよい。

以上、具体的な実施形態を例示して説明してきたように、この発明の画像処理方法の第1の態様では、輪郭の鮮明さは、例えば当該輪郭におけるエッジ強度に対応する画素値を有する画素の光学濃度により表すことができる。さらにこの場合、輪郭の鮮明さは、輪郭に対応する各画素について画素の輝度値に基づきエッジ検出フィルタ演算によりそれぞれ求めたエッジ強度の平均値をSa、当該輪郭により特定されるオブジェクト領域に隣接する周囲領域の画素の輝度の平均値をIsとしたとき、次式:

Sh=log10{Is/(Is-Sa/4)}

の左辺Shにより表すことができる。このような手法により、定性的な輪郭の鮮明さを定量的に表現することができ、複数の原画像から抽出されるオブジェクト領域の比較を客観的かつ一義的に行うことが可能となる。

Sh=log10{Is/(Is-Sa/4)}

の左辺Shにより表すことができる。このような手法により、定性的な輪郭の鮮明さを定量的に表現することができ、複数の原画像から抽出されるオブジェクト領域の比較を客観的かつ一義的に行うことが可能となる。

また例えば、複数の原画像の各々において、輪郭画素を輪郭とする領域のうち輪郭の鮮明さが所定値以上であるものがオブジェクト領域とされてもよい。単にエッジ強度による評価のみでは、輪郭が不鮮明であっても周囲領域との濃度差の大きい領域をオブジェクト領域としてしまうことがある。輪郭の鮮明さを評価に加えることによって、より合焦状態に近い画像のみをオブジェクト領域として抽出することができる。

また、本発明にかかる画像処理方法では、例えばエッジ強度が所定値以上である画素が輪郭画素とされてもよい。エッジ強度が所定値以上である画素をオブジェクトの輪郭と見なす手法が種々提案されており、本発明においてもこのような手法を用いて輪郭抽出を行うことが可能である。

また例えば、合成画像のうち輪郭で囲まれる領域以外には、例えば複数の原画像から選出された一の原画像から抽出された画素を配することで、背景を表すことができる。この場合において、例えば複数の原画像間で同一位置に対応する画素のうち最も高輝度の画素が背景として配されるようにしてもよい。こうすることで、非合焦画像において不鮮明となるスフェロイドの周縁部が背景として合成画像に取り込まれることが防止される。

また、この発明にかかる画像処理装置において、画像取得手段は、試料を撮像する撮像部と、撮像部の焦点位置を多段階に変更設定する焦点設定部とを有するものであってもよい。また複数の原画像に対応する画像データを外部装置から受け入れるものであってもよい。これらのいずれによっても、複数の原画像を取得してこれらから合成画像を作成することが可能である。

以上、特定の実施例に沿って発明を説明したが、この説明は限定的な意味で解釈されることを意図したものではない。発明の説明を参照すれば、本発明のその他の実施形態と同様に、開示された実施形態の様々な変形例が、この技術に精通した者に明らかとなるであろう。故に、添付の特許請求の範囲は、発明の真の範囲を逸脱しない範囲内で、当該変形例または実施形態を含むものと考えられる。

本発明は、例えば培地中で培養された細胞を含む試料を撮像した画像の処理に適用可能なものであり、特に、培地中で三次元培養された細胞集塊(スフェロイド)の全焦点画像を作成する用途に好適である。

1 撮像装置(画像処理装置)

10 撮像ユニット(画像取得手段)

15 撮像部

17 センサ駆動部(焦点設定部)

20 制御ユニット

25 画像処理部(画像処理手段)

D 試料容器

IM1~IM5 原画像

M 培地

S1~S5 スフェロイド

10 撮像ユニット(画像取得手段)

15 撮像部

17 センサ駆動部(焦点設定部)

20 制御ユニット

25 画像処理部(画像処理手段)

D 試料容器

IM1~IM5 原画像

M 培地

S1~S5 スフェロイド

Claims (13)

- 培地中で三次元培養された細胞を含む試料の画像を作成する画像処理方法において、

撮像方向において互いに異なる焦点位置で前記試料を撮像した複数の原画像を取得する画像取得工程と、

前記複数の原画像の各々において当該原画像を構成する各画素のエッジ強度を算出するエッジ強度算出工程と、

前記複数の原画像間で互いに同一位置に対応する画素のうち、最もエッジ強度が高い画素を選出する画素選出工程と、

選出された画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素の位置を輪郭の位置とする領域に、前記原画像のいずれかの当該領域に対応する位置から抽出された画素を配した合成画像を作成する画像合成工程と

を備え、

前記画像合成工程では、前記輪郭で囲まれる一の領域について、前記画素選出工程において選出された画素を当該領域内に最も多く含む一の前記原画像から抽出された画素を配する画像処理方法。 - 培地中で三次元培養された細胞を含む試料の画像を作成する画像処理方法において、

撮像方向において互いに異なる焦点位置で前記試料を撮像した複数の原画像を取得する画像取得工程と、

前記複数の原画像の各々において、当該原画像を構成する画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素を輪郭とするオブジェクト領域を抽出する領域抽出工程と、

前記複数の原画像の各々から抽出された前記オブジェクト領域内の画素を一の画像に、かつ前記原画像内での当該画素の位置に対応する位置に配した合成画像を作成する画像合成工程と

を備え、

前記画像合成工程では、異なる前記原画像からそれぞれ抽出された複数の前記オブジェクト領域が少なくとも一部において前記合成画像内で重複するとき、当該重複する領域内の画素については、重複する複数の前記オブジェクト領域のうち輪郭が最も鮮明な前記オブジェクト領域の画素を配する画像処理方法。 - 前記輪郭の鮮明さは、当該輪郭におけるエッジ強度に対応する画素値を有する画素の光学濃度により表される請求項2に記載の画像処理方法。

- 前記輪郭の鮮明さは、前記輪郭に対応する各画素について画素の輝度値に基づきエッジ検出フィルタ演算によりそれぞれ求めたエッジ強度の平均値をSa、当該輪郭により特定される前記オブジェクト領域に隣接する周囲領域の画素の輝度の平均値をIsとしたとき、次式:

Sh=log10{Is/(Is-Sa/4)}

の左辺Shにより表される請求項3に記載の画像処理方法。 - 前記複数の原画像の各々において、前記輪郭画素を輪郭とする領域のうち前記輪郭の鮮明さが所定値以上であるものが、前記オブジェクト領域とされる請求項2ないし4のいずれかに記載の画像処理方法。

- エッジ強度が所定値以上である画素が前記輪郭画素とされる請求項1ないし5のいずれかに記載の画像処理方法。

- 前記合成画像のうち前記輪郭で囲まれる領域以外には、前記複数の原画像から選出された一の原画像から抽出された画素が配される請求項1ないし6のいずれかに記載の画像処理方法。

- 前記合成画像のうち前記輪郭で囲まれる領域以外には、前記複数の原画像間で同一位置に対応する画素のうち最も高輝度の画素が配される請求項1ないし6のいずれかに記載の画像処理方法。

- 請求項1ないし8のいずれかに記載の画像処理方法をコンピューターに実行させることを特徴とする制御プログラム。

- 培地中で三次元培養された細胞を含む試料の画像を作成する画像処理装置において、

撮像方向において互いに異なる焦点位置で前記試料を撮像した複数の原画像を取得する画像取得手段と、

前記複数の原画像を合成して合成画像を作成する画像処理手段と

を備え、

前記画像処理手段は、

前記複数の原画像の各々において、当該原画像を構成する画素のエッジ強度を算出し、前記複数の原画像間で互いに同一位置に対応する画素のうち最もエッジ強度が高い画素を選出し、選出された画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素の位置を輪郭の位置とする領域内に、前記原画像のいずれかの当該領域に対応する位置から抽出された画素を配した合成画像を作成し、しかも、

前記輪郭で囲まれる一の領域について、前記選出された画素を当該領域内に最も多く含む一の前記原画像から抽出された画素を配することで前記合成画像を作成する画像処理装置。 - 培地中で三次元培養された細胞を含む試料の画像を作成する画像処理装置において、

撮像方向において互いに異なる焦点位置で前記試料を撮像した複数の原画像を取得する画像取得手段と、

前記複数の原画像を合成して合成画像を作成する画像処理手段と

を備え、

前記画像処理手段は、

前記複数の原画像の各々において、当該原画像を構成する画素からオブジェクトの輪郭に相当する輪郭画素を特定し、該輪郭画素を輪郭とするオブジェクト領域を抽出し、前記複数の原画像の各々から抽出された前記オブジェクト領域内の画素を一の画像に、かつ前記原画像内での当該画素の位置に対応する位置に配した合成画像を作成し、しかも、

異なる前記原画像からそれぞれ抽出された複数の前記オブジェクト領域が少なくとも一部において前記合成画像内で重複するとき、当該重複する領域内の画素については、重複する複数の前記オブジェクト領域のうち輪郭が最も鮮明である前記オブジェクト領域の画素を配することで前記合成画像を作成する画像処理装置。 - 前記画像取得手段は、前記試料を撮像する撮像部と、前記撮像部の焦点位置を多段階に変更設定する焦点設定部とを有する請求項10または11に記載の画像処理装置。

- 前記画像取得手段は、前記複数の原画像に対応する画像データを外部装置から受け入れる請求項10または11に記載の画像処理装置。

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014265039A JP6196607B2 (ja) | 2014-12-26 | 2014-12-26 | 画像処理方法、制御プログラムおよび画像処理装置 |

| JP2014-265039 | 2014-12-26 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| WO2016104477A1 true WO2016104477A1 (ja) | 2016-06-30 |

Family

ID=56150495

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| PCT/JP2015/085776 WO2016104477A1 (ja) | 2014-12-26 | 2015-12-22 | 画像処理方法、制御プログラムおよび画像処理装置 |

Country Status (2)

| Country | Link |

|---|---|

| JP (1) | JP6196607B2 (ja) |

| WO (1) | WO2016104477A1 (ja) |

Cited By (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2018180813A1 (ja) * | 2017-03-30 | 2018-10-04 | 富士フイルム株式会社 | 細胞画像評価装置および方法並びにプログラム |

| CN111492402A (zh) * | 2017-12-28 | 2020-08-04 | 三星电子株式会社 | 用于处理图像的方法和装置及其计算机程序产品 |

Families Citing this family (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6333318B2 (ja) * | 2016-07-29 | 2018-05-30 | 株式会社Screenホールディングス | 画像処理方法、画像処理装置、および撮像装置 |

| JP6621027B2 (ja) * | 2016-09-16 | 2019-12-18 | パナソニックIpマネジメント株式会社 | 撮像装置 |

| US10699417B2 (en) * | 2016-10-03 | 2020-06-30 | Sigtuple Technologies Private Limited | Method and system for acquisition of optimal images of object in multi-layer sample |

| JP6931579B2 (ja) * | 2017-09-20 | 2021-09-08 | 株式会社Screenホールディングス | 生細胞検出方法、プログラムおよび記録媒体 |

| JP2019090892A (ja) * | 2017-11-14 | 2019-06-13 | オリンパス株式会社 | 試料観察方法および試料ホルダ |

| JP7420346B2 (ja) * | 2019-01-09 | 2024-01-23 | 国立大学法人九州大学 | 三次元形状情報生成装置、細胞判定システム |

Citations (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2007215091A (ja) * | 2006-02-13 | 2007-08-23 | Casio Comput Co Ltd | 撮像装置及びそのプログラム |

| JP2010166247A (ja) * | 2009-01-14 | 2010-07-29 | Olympus Corp | 画像処理装置、画像処理プログラムおよび画像処理方法 |

| JP2014068088A (ja) * | 2012-09-25 | 2014-04-17 | Sharp Corp | 撮像装置および撮像装置制御方法 |

-

2014