WO2014157310A1 - 携帯端末装置、記録媒体および補正方法 - Google Patents

携帯端末装置、記録媒体および補正方法 Download PDFInfo

- Publication number

- WO2014157310A1 WO2014157310A1 PCT/JP2014/058466 JP2014058466W WO2014157310A1 WO 2014157310 A1 WO2014157310 A1 WO 2014157310A1 JP 2014058466 W JP2014058466 W JP 2014058466W WO 2014157310 A1 WO2014157310 A1 WO 2014157310A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- terminal device

- walking

- user

- angular velocity

- mobile terminal

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01C—MEASURING DISTANCES, LEVELS OR BEARINGS; SURVEYING; NAVIGATION; GYROSCOPIC INSTRUMENTS; PHOTOGRAMMETRY OR VIDEOGRAMMETRY

- G01C25/00—Manufacturing, calibrating, cleaning, or repairing instruments or devices referred to in the other groups of this subclass

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01C—MEASURING DISTANCES, LEVELS OR BEARINGS; SURVEYING; NAVIGATION; GYROSCOPIC INSTRUMENTS; PHOTOGRAMMETRY OR VIDEOGRAMMETRY

- G01C21/00—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00

- G01C21/10—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration

- G01C21/12—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning

- G01C21/16—Navigation; Navigational instruments not provided for in groups G01C1/00 - G01C19/00 by using measurements of speed or acceleration executed aboard the object being navigated; Dead reckoning by integrating acceleration or speed, i.e. inertial navigation

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01C—MEASURING DISTANCES, LEVELS OR BEARINGS; SURVEYING; NAVIGATION; GYROSCOPIC INSTRUMENTS; PHOTOGRAMMETRY OR VIDEOGRAMMETRY

- G01C22/00—Measuring distance traversed on the ground by vehicles, persons, animals or other moving solid bodies, e.g. using odometers, using pedometers

- G01C22/006—Pedometers

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M2250/00—Details of telephonic subscriber devices

- H04M2250/12—Details of telephonic subscriber devices including a sensor for measuring a physical value, e.g. temperature or motion

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04M—TELEPHONIC COMMUNICATION

- H04M2250/00—Details of telephonic subscriber devices

- H04M2250/52—Details of telephonic subscriber devices including functional features of a camera

Definitions

- the present invention relates to a technique for correcting (calibrating) a sensor that measures information related to the movement of an observation object (especially a pedestrian).

- a positioning technique for measuring the position of a pedestrian a GPS (Global Positioning System) technique is generally used, in which a terminal carried by the pedestrian receives radio waves from satellites.

- GPS Global Positioning System

- a relative positioning technology using a self-contained sensor such as an acceleration sensor, an angular velocity sensor, or a magnetic sensor has been proposed.

- the relative positioning by the self-contained sensor is realized, for example, by detecting the motion of the pedestrian with the self-contained sensor, estimating the traveling direction and the traveling speed, and calculating the moving vector of the pedestrian.

- Patent Document 1 describes a technique of determining the state in which the pedestrian is at rest from the movement of the pedestrian, and performing correction of the gyro bias in a period in which the pedestrian is at rest.

- Patent Document 2 describes a technique for correcting a gyro sensor by estimating the traveling direction of a pedestrian from a map.

- Patent Document 3 the traveling direction of the vehicle is calculated from the gyro sensor, and when the amount of change in the traveling direction is equal to or less than the threshold value, the traveling direction of the vehicle is regarded as a straight line.

- the technology to do is described.

- Patent Document 4 describes a technique for estimating the position of a vehicle with reference to a white line or a road sign observed from the vehicle.

- the motion of the pedestrian does not always face the direction of travel, and fluctuates relatively widely depending on the movement of the foot or arm.

- the traveling direction in the walking motion of the pedestrian is so-called macroscopically formed by combining local and complex motions such as rotation, vibration, pendulum motion, vertical motion and the like. Therefore, the technology described in Patent Document 3 is suitable for a gyro sensor for detecting a local movement, with respect to a threshold value for appropriately evaluating the amount of change in the direction of travel of a macroscopically formed pedestrian. There is a problem that it is difficult to determine as another value.

- Patent Document 3 and Patent Document 4 are techniques applied to an object such as a vehicle having little difference between local and macroscopic viewpoints of motion, and these techniques can be used as pedestrians without modification. It is difficult to apply to

- the invention according to claim 1 is a portable terminal device carried by a user, wherein the gyro sensor measures angular velocity in movement of the portable terminal device to acquire angular velocity information;

- An acceleration sensor that measures acceleration in movement of a terminal device to acquire acceleration information, a camera that captures an image of a subject around the mobile terminal during a period in which the mobile terminal device is moving, and the image information Motion direction of the user and the camera according to the vector operation element for calculating the motion vector of the subject, the angular velocity information acquired by the gyro sensor, and the acceleration information acquired by the acceleration sensor.

- a correlation determination element that determines a relative relationship with an imaging direction; and the subject calculated by the vector operation element According to the motion vector and the correlation determined by the correlation determination element, the user walks according to a straight walk determination element that determines whether the user is in a straight movement state in a walking motion and the straight walk determination element And a correction element configured to correct angular velocity information acquired by the gyro sensor in response to the determination that the vehicle is in the straight-ahead state in the state of.

- the invention of claim 2 is the portable terminal device according to the invention of claim 1, wherein the vector computing element divides the image information into a plurality of blocks each having a first size, and the plurality of blocks Each of the blocks is divided into a plurality of subblocks each having a second size smaller than the first size, and edge amounts are detected for each of the plurality of subblocks, and edge amounts in each of the plurality of blocks

- the motion vector of the subject is calculated by determining the sub-block where is the largest as the representative sub-block of each block and calculating the motion vector of the determined representative sub-block.

- the invention according to claim 3 is the portable terminal device according to the invention according to claim 2, wherein the vector computing element averages motion vectors of the representative sub-block in units of walking cycles of the user. The motion vector of the subject is determined.

- the invention according to claim 4 is the portable terminal device according to the invention according to claim 2, wherein the vector computing element calculates the motion vector of the representative sub-block at an operation timing synchronized with the walking cycle of the user. Do.

- the invention of claim 5 is the portable terminal device according to the invention of claim 4, wherein the calculation timing is determined such that the speed of the camera is at a minimum.

- the invention of claim 6 is the portable terminal device according to the invention of claim 4, wherein the calculation timing is determined to be when the feet of the user are landing.

- the invention according to claim 7 is the portable terminal device according to the invention according to claim 2, wherein the camera is moving in a period during which the portable terminal device is moving at an imaging timing synchronized with the walking cycle of the user. Take an image of a subject around you.

- the invention of claim 8 is the portable terminal device according to the invention of claim 7, wherein the imaging timing is determined so as to be when the speed of the camera is minimum.

- the invention of claim 9 is the portable terminal device according to the invention of claim 7, wherein the imaging timing is determined so as to be when the feet of the user are landing.

- the invention according to claim 10 is the portable terminal device according to the invention according to claim 3, wherein the walking cycle corresponds to a time during which the user advances the left and right legs one step at a time in the walking operation of the user. It has been decided.

- the invention according to claim 11 is the portable terminal device according to the invention according to claim 4, wherein the walking cycle corresponds to the time during which the user advances the left and right legs one step at a time in the walking operation of the user. It has been decided.

- the invention of claim 12 is the portable terminal device according to the invention of claim 1, wherein the correlation has a relationship in which the imaging direction of the camera faces the traveling direction of the user's walking motion. included.

- the invention according to claim 13 is the portable terminal device according to the invention according to claim 12, in the case where the imaging direction of the camera is directly opposed to the traveling direction by the walking operation of the user, the straight walking

- the determination element determines that the walking motion of the user is in the straight-ahead state, when the motion vector of the subject determined by the vector operation element is radial in the image information.

- the invention according to claim 14 is a portable terminal device carried by a user, wherein the gyro sensor measures angular velocity in movement of the portable terminal device to acquire angular velocity information, and acceleration in movement of the portable terminal device.

- the user measures the acceleration to obtain acceleration information, the angular velocity information acquired by the gyro sensor, and the acceleration information acquired by the acceleration sensor, by comparing the pattern in the walking motion given in advance.

- the angular velocity acquired by the gyro sensor in response to the straight walking determination element for determining whether or not the user is in the straight movement state in the walking motion, and the determination that the user is in the straight movement state in the walking state And a correction element for correcting information.

- the invention of claim 15 is the portable terminal device according to the invention of claim 14, wherein the straight walking determination element compares the pattern with the pattern according to a walking cycle in the walking motion of the user.

- the invention according to claim 16 is the portable terminal device according to the invention according to claim 15, wherein the walking cycle corresponds to a time during which the user advances the left and right legs one step at a time in the walking operation of the user. It has been decided.

- the invention according to claim 17 is a recording medium for recording a computer readable program, wherein the program is executed by a computer to cause the computer to use an gyro sensor for angular velocity in the movement of the computer.

- a step of measuring angular velocity information by measurement a step of measuring acceleration by movement of the computer by an acceleration sensor, and acquiring acceleration information, and capturing an image of a surrounding object during a period of movement of the computer by a camera Acquiring image information, calculating a motion vector of the subject based on the image information acquired by the camera, angular velocity information acquired by the gyro sensor, and acceleration information acquired by the acceleration sensor

- a correction method is performed including a step of performing and a step of correcting angular velocity information acquired by the gyro sensor in

- the invention according to claim 18 is a recording medium for recording a computer readable program, wherein the program is executed by a computer to cause the computer to use an gyro sensor for angular velocity in movement of the computer.

- a step of measuring and acquiring angular velocity information a step of measuring acceleration by movement of the computer by an acceleration sensor, and acquiring acceleration information, angular velocity information acquired by the gyro sensor and an acceleration acquired by the acceleration sensor

- the step of determining whether the user is in the straight-ahead state in the walking motion by comparing the information with the pattern in the walking motion given in advance, and according to the determination that the user is in the straight-ahead state in the walking state

- the angular velocity information obtained to perform the correction method and a step of correcting.

- the invention according to claim 19 is a correction method, which measures angular velocity in movement of a portable terminal device by a gyro sensor to acquire angular velocity information, and measures acceleration in movement of the portable terminal device by an acceleration sensor.

- a step of acquiring acceleration information a step of imaging an object around the subject during a period in which the portable terminal device is moving by a camera to acquire image information, and based on the image information acquired by the camera

- the step of calculating the motion vector of the subject and according to the angular velocity information acquired by the gyro sensor and the acceleration information acquired by the acceleration sensor, the traveling direction by the walking motion of the user and the imaging direction of the camera Determining the relative relationship of the object and the correlation between the calculated motion vector of the subject and the correlation,

- a step of determining whether the user is in a straight movement state in a walking operation and a step of correcting angular velocity information acquired by the gyro sensor in response to the determination that the user is in a straight movement state in a walking state

- the invention according to claim 20 is a correction method, comprising: learning a feature point of a pattern in a known walking motion of a user who holds the portable terminal device; and measuring an angular velocity in movement of the portable terminal device with a gyro sensor Acquiring angular velocity information, acquiring acceleration information by measuring acceleration in movement of the portable terminal device with an acceleration sensor, and acquiring angular velocity information acquired by the gyro sensor and the acceleration sensor A step of determining whether the user is in a straight advance state in a walking operation by comparing acceleration information with feature points of the pattern, and in response to a determination that the user is in a straight advance state in a walking state And correcting the angular velocity information acquired by the gyro sensor.

- the invention according to claims 1 to 13, 17 and 19 calculates the motion vector of the subject based on the image information, and angular velocity information acquired by the gyro sensor and acceleration information acquired by the acceleration sensor According to the user's walking motion and the relative relationship between the shooting direction of the camera and the camera, and according to the calculated motion vector of the subject and the correlation, whether the user is in a straight movement state in the walking motion It is possible to accurately determine whether or not the user is in the straight movement state in the walking motion by determining

- the inventions according to claims 14 to 16, 18 and 20 compare the angular velocity information acquired by the gyro sensor and the acceleration information acquired by the acceleration sensor with the pattern in the walking motion given in advance. Thus, by determining whether the user is in the straight movement state in the walking motion, it is possible to accurately determine whether the user is in the straight movement state in the walking motion and it is not necessary to provide a camera.

- FIG. 7 is a diagram illustrating accelerations ⁇ v and ⁇ w and an angular velocity ⁇ v in human walking motion. It is a figure which shows the functional block with which the portable terminal device in other preferable embodiment is equipped with the flow of data. It is a flowchart which shows the correction process performed by the portable terminal device in other preferable embodiment. It is a flowchart which shows the straight walk detection process in other preferable embodiment.

- FIG. 1 is a diagram showing a portable terminal device 1 in a preferred embodiment.

- the mobile terminal device 1 includes an operation unit 12 and a display unit 13 and is configured as a device carried by a user.

- one step in the walking motion is a motion from when a person starts raising one foot and then takes its foot forward, the foot reaches the ground, and starts raising the next foot.

- one compound step is an operation including an operation of one step on each side.

- one multi-step time is the time taken for one multi-step.

- the operation unit 12 is hardware operated by the user to give an instruction to the mobile terminal device 1.

- the operation unit 12 for example, various buttons, keys, a rotation selector, a touch panel, etc. correspond.

- the display unit 13 is hardware having a function of providing information by displaying various information to the user.

- the display unit 13 corresponds to, for example, a lamp, an LED, a liquid crystal panel, a liquid crystal display, an organic EL display, or the like.

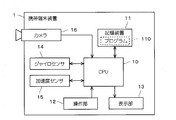

- FIG. 2 is a block diagram of the mobile terminal device 1 in the preferred embodiment.

- the portable terminal device 1 includes a CPU 10, a storage device 11, a gyro sensor 14, an acceleration sensor 15, and a camera 16 in addition to the operation unit 12 and the display unit 13 described above.

- the CPU 10 reads and executes the program 110 stored in the storage device 11, and performs operations of various data, generation of control signals, and the like.

- the CPU 10 has a function of controlling each component of the mobile terminal device 1 and calculating and creating various data. That is, the mobile terminal device 1 is configured as a general computer.

- the storage device 11 provides a function of storing various data in the mobile terminal device 1. In other words, the storage device 11 stores the electronically fixed information in the mobile terminal device 1. In particular, storage device 11 in the preferred embodiment is used to store program 110.

- the storage device 11 may be a RAM or buffer used as a temporary working area of the CPU 10, a read only ROM, a non-volatile memory (for example, a NAND memory), a hard disk for storing relatively large capacity data, a dedicated memory This corresponds to a portable storage medium (PC card, SD card, USB memory, etc.) attached to the reading device.

- a portable storage medium PC card, SD card, USB memory, etc.

- FIG. 2 it is illustrated as if the storage device 11 is a single structure.

- the storage device 11 is configured of a plurality of types of devices adopted as needed among the various devices (or media) illustrated above. That is, in the preferred embodiment, the storage device 11 is a generic name of a group of devices having a function of storing data.

- the actual CPU 10 is an electronic circuit internally provided with a RAM that can be accessed at high speed.

- the storage device included in such a CPU 10 is also included in the storage device 11 and described. That is, in the preferred embodiment, the data temporarily stored by the CPU 10 itself is also described as being stored by the storage device 11.

- the gyro sensor 14 measures the angular velocity in the movement of the mobile terminal device 1 and acquires angular velocity information 140 (see FIG. 3).

- a cycle sampling cycle in which the gyro sensor 14 acquires the angular velocity information 140 is referred to as “Ts”.

- the acceleration sensor 15 measures acceleration in movement of the mobile terminal device 1 to acquire acceleration information 150 (see FIG. 3).

- the camera 16 includes an optical element such as a lens and a mirror, and a photoelectric conversion element such as a CCD, and is configured as a general digital camera.

- the camera 16 captures an image of a subject around at least during a period in which the mobile terminal device 1 is moving, and acquires image information 160 (see FIG. 3).

- the camera 16 is configured to capture an image at a predetermined imaging timing according to a control signal from the CPU 10.

- the camera 16 in the preferred embodiment performs imaging at an imaging cycle "Tc" and acquires new image information 160.

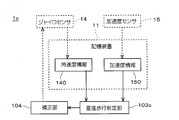

- FIG. 3 is a diagram showing functional blocks included in the mobile terminal device 1 in the preferred embodiment together with the flow of data.

- the walking cycle calculation unit 100, the vector calculation unit 101, the correlation determination unit 102, the straight walk determination unit 103, and the correction unit 104 shown in the figure are functional blocks realized by the CPU 10 operating according to the program 110.

- the walking cycle calculation unit 100 refers to the angular velocity information 140 and the acceleration information 150 to determine the walking cycle in the walking motion of the user (pedestrian).

- the walking cycle calculation unit 100 transmits the determined walking cycle to the vector calculation unit 101 and the correction unit 104.

- the walking cycle calculation unit 100 also has a function of transmitting the traveling direction of the user to the correlation determination unit 102.

- the vector operation unit 101 has a function of calculating the motion vector of the subject in the image information 160 based on the image information 160 and creating the motion vector information 111.

- the interval at which the vector computing unit 101 computes a motion vector is hereinafter referred to as a computation interval "Tv".

- the motion vector of the subject in the image information 160 is a motion vector due to the motion of the apparent subject caused by the movement of the portable terminal 1 according to the operation of the user, and the motion vector of the subject itself. It is a combination with the motion vector generated by the motion. However, in the following description, the subject is treated as stationary, and the motion vector generated by the motion of the subject itself is ignored. Also, the vector operation unit 101 in the preferred embodiment includes the walking cycle transmitted from the walking cycle operation unit 100 in the motion vector information 111.

- the correlation determination unit 102 determines the relative relationship between the traveling direction of the user's walking motion and the imaging direction of the camera 16 according to the angular velocity information 140 acquired by the gyro sensor 14 and the acceleration information 150 acquired by the acceleration sensor 15. Determine However, although the details will be described later, the correlation determination unit 102 in the preferred embodiment utilizes the traveling direction obtained in the process of the walking cycle calculation unit 100 calculating the walking cycle based on the angular velocity information 140 and the acceleration information 150.

- the determination result by the correlation determination unit 102 is stored as correlation determination information 112.

- the straight walking determination unit 103 determines whether the user is in a straight moving state in the walking motion according to the motion vector information 111 calculated by the vector calculation unit 101 and the correlation determined by the correlation determination unit 102 (correlation determination information 112). Determine if

- the correction unit 104 has a function of correcting the bias value (bv) of the gyro sensor 14 in response to the straight walking determination unit 103 determining that the user is in the straight traveling state in the walking state.

- the correction unit 104 also has a function of correcting the angular velocity information 140 already acquired retroactively to the past.

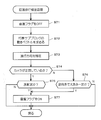

- FIG. 4 is a flow chart showing the correction process for the gyro sensor 14 in the preferred embodiment.

- another process may be performed in parallel with the process shown in FIG. 4 or sharing a part of the process.

- the other processing is, for example, positioning processing for specifying the position of the user, destination guidance processing using the result of the positioning processing, and route recording processing.

- predetermined initial setting is being performed in the mobile terminal device 1 before the process illustrated in FIG. 4 is started.

- set Ts to the measurement timer for measuring the measurement timing by the gyro sensor 14 and the acceleration sensor 15 and start Tc, and set Tc to the imaging timer for measuring the imaging timing by the camera 16.

- start processing but the operation timer is not started. This is because the process of calculating the motion vector can not be performed until at least one piece of image information 160 is acquired and a representative sub-block described later is determined.

- the initial setting includes a process of setting an initial value of the bias value (bv) of the gyro sensor 14 and a process of determining the attitude of the mobile terminal device 1 (the attitude at the start of the process).

- a method of determining the initial attitude of the portable terminal device 1 a method in which the user operates the operation unit 12 of the portable terminal device 1 to input the attitude, a method of determining the attitude by an output of a magnetic sensor not shown, etc. Be done.

- the mobile terminal device 1 When the initial setting is completed, the mobile terminal device 1 is in a state of monitoring the measurement timer, the imaging timer, and the operation timer (steps S1, S5, and S11). This state is referred to as a "monitoring state" in the following description. However, in the monitoring state, the mobile terminal device 1 may execute processing other than steps S1, S5, and S11.

- step S3 the CPU 10 determines Yes in step S1 and resets the values of the gyro sensor 14 and the acceleration sensor 15 while resetting the measurement timer to Ts (step S2). Read each one. By this, the measurement of the angular velocity and acceleration regarding the movement of the portable terminal device 1 is performed (step S3).

- the value of the gyro sensor 14 read out in step S3 is obtained based on the initial value of the bias value bv if the correction of the bias value bv (described later) has not been made. On the other hand, after the bias value bv is corrected, it is acquired as a value corrected by the value of the corrected bias value bv.

- the CPU 10 creates angular velocity information 140 and acceleration information 150 based on the read value of the gyro sensor 14 and the value of the acceleration sensor 15, and records the information in the storage device 11 (step S4).

- the angular velocity information 140 and the acceleration information 150 are recorded in the order of acquisition as a history, rather than being overwritten on past recordings.

- the portable terminal device 1 determines Yes in step S1 each time the value of the measurement timer becomes 0, and executes the processing of steps S2 to S4. Therefore, in the mobile terminal device 1, the angular velocity and the acceleration are measured for each measurement cycle Ts. In addition, if step S4 is performed, the portable terminal device 1 will return to a monitoring state again.

- step S7 the image information 160 is created, and is recorded in the storage device 11.

- step S7 it is assumed that the image information 160 is not deleted or overwritten. That is, the image information 160 is recorded in the order of imaging.

- the CPU 10 determines whether an operation timer for measuring operation timing has been started (step S8). If the arithmetic timer is not activated, the CPU 10 sets Tv in the arithmetic timer to activate (step S9), and executes representative sub-block determination processing (step S10). On the other hand, when the operation timer has already been started, steps S9 and S10 are skipped to return to the monitoring state.

- 5 and 6 are flowcharts showing representative sub-block determination processing in the preferred embodiment.

- the vector operation unit 101 acquires the latest image information 160 and divides it into a plurality of blocks (step S21).

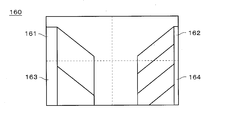

- FIG. 7 is a diagram showing how the vector information processing unit 101 divides the image information 160.

- FIG. 7 shows an example of the surrounding subject (image information 160) captured when the user travels in the aisle in which shelves for displaying goods are arranged on both sides.

- step S21 the vector operation unit 101 divides the image information 160 into a plurality of blocks each having a first size. Each block corresponds to a partial image of the image information 160. In the example shown in FIG. 7, the image information 160 is divided into four blocks of blocks 161, 162, 163, and 164.

- the vector operation unit 101 resets the value of the block counter i to "1" (step S22).

- the block counter i is a counter for identifying a block being processed. As shown in FIG. 7, since the vector operation unit 101 in the preferred embodiment divides the image information 160 into four blocks, the value of the block counter i is an integer of “1” to “4”.

- the vector operation unit 101 further divides the i-th block indicated by the block counter i into sub-blocks (step S23).

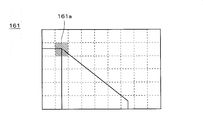

- FIG. 8 is a diagram showing how the vector operation unit 101 divides the block 161 shown in FIG. 7. Note that FIG. 8 shows the block 161 shown in FIG. 7 in an enlarged manner.

- step S23 the vector operation unit 101 divides the i-th block into a plurality of sub-blocks having a second size smaller than the first size.

- Each sub block corresponds to a partial image of the image information 160.

- the block 161 is divided into 54 subblocks.

- step S23 the vector operation unit 101 resets the value of the maximum edge amount to "0" and resets the value of the sub block counter j to "1" (step S24).

- the maximum edge amount is a variable that temporarily stores the maximum edge amount of subblocks included in the block being processed.

- the sub block counter j is a counter for identifying a sub block being processed. As shown in FIG. 8, since the vector operation unit 101 divides one block into 54 sub blocks, the value of the sub block counter j is an integer of “1” to “54”.

- the vector operation unit 101 calculates the edge amount of the j-th subblock indicated by the subblock counter j among the plurality of subblocks divided in step S23 (step S31), and determines the j-th sub obtained It is determined whether the edge amount of the block is larger than the maximum edge amount (step S32).

- step S32 the vector operation unit 101 newly sets the value of the j-th edge amount as the maximum edge amount (step S33), and sets the identifier SBi for identifying the representative sub-block in the i-th block j "is set (step S34). That is, when the edge amount of the j-th subblock is larger than the edge amounts of the first to j-1th subblocks, the edge amount of the j-th subblock is stored as the maximum edge amount. , “J” is stored in the identifier SBi.

- step S32 the vector operation unit 101 skips the processing in steps S33 and S34 because the j-th sub-block is not determined to be a representative sub-block.

- the vector operation unit 101 determines whether or not calculation and evaluation of edge amounts for all subblocks have been completed for the i-th block (step S35). In the preferred embodiment, since the number of subblocks in the i-th block is 54, for example, it may be determined whether j ⁇ 54 or not in step S35.

- step S35 If No at step S35 (if not completed for all subblocks), the vector operation unit 101 increments the value of j (step S36), and repeats the process from step S31. That is, processing for the next sub-block of the i-th block is continued.

- step S35 if the result of step S35 is Yes (if all subblocks have been completed), the vector operation unit 101 resets the value of the maximum edge amount to "0" (step S37), and the i-th block is processed. End the process. That is, the representative sub-block of the i-th block is determined to be the sub-block indicated by the identifier SBi.

- the vector operation unit 101 determines whether or not determination of a representative sub block has been completed for all blocks (step S38). In the preferred embodiment, since the number of blocks is four, for example, it may be determined whether or not i ⁇ 4 in step S38.

- step S38 If No at step S38 (if not completed for all the blocks), the vector operation unit 101 increments the value of i (step S39), and repeats the process from step S23. That is, processing for the next block is continued.

- step S38 the vector operation unit 101 ends the representative sub-block determination process, and returns to the process of FIG.

- the vector operation unit 101 detects an edge amount for each of a plurality of sub blocks, and determines a sub block having the largest edge amount in each of the plurality of blocks as a representative sub block of each block.

- the sub-block 161 a including the corner of the display shelf is determined as the representative sub-block in the block 161.

- sub blocks having the largest edge amount are also determined as representative sub blocks from among the blocks 162, 163, and 164, respectively.

- the portable terminal device 1 tries to detect the motion of the portable terminal device 1 based on the motion vector of the representative sub-block. Then, in order to calculate a motion vector, it is preferable to extract and calculate a portion (sub block) having a large amount of edges in the image.

- the vector operation unit 101 in the preferred embodiment determines a representative sub-block in each block as a sub-block in which the edge amount is maximum in the block. Therefore, the motion vector can be accurately calculated.

- the positions of the calculated motion vector in the image information 160 be dispersed. That is, it is preferable that the representative sub-block is selected from various positions in the image information 160.

- the vector operation unit 101 in the preferred embodiment divides one still image in the image information 160 into four blocks and determines representative sub-blocks from each block. It is possible to suppress the localization of subblocks for which motion vectors are to be calculated in the image information 160. Therefore, in the process to be described later, it can be accurately determined whether or not the user's traveling direction is in the straight-ahead state.

- step S11 when the operation timer becomes 0 and the operation timing comes, the CPU 10 determines Yes in step S11, and resets the operation timer to Tv (step S12) to perform straight walking detection processing Is executed (step S13).

- FIG. 9 is a flow chart showing straight walk detection processing in a preferred embodiment.

- the straight walking determination unit 103 resets the straight driving flag indicating whether the user's walking motion is straight walking to OFF (step S41).

- step S42 After the vector operation unit 101 specifies the position of each representative sub-block in the latest image information 160 and determines the representative sub-block (after the image information 160 whose representative sub-block has been determined is imaged) A motion vector of each representative sub-block in a period until the latest image information 160 is captured is obtained (step S42).

- the period from the determination of the representative sub-block to the imaging of the latest image information 160 is managed by an operation timer and is an operation cycle Tv. That is, in step S42, a motion vector between Tv is calculated.

- the imaging cycle Tc can be considered to be discrete with respect to the calculation cycle Tv, the period is n ⁇ Tc (where n ⁇ Tc ⁇ Tv ⁇ (n + 1) ⁇ Tc).

- the walking cycle calculation unit 100 obtains the walking cycle in the walking motion of the user.

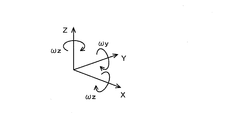

- FIG. 10 is a view showing a coordinate system of the gyro sensor 14, the acceleration sensor 15 and the camera 16.

- the gyro sensor 14, the acceleration sensor 15, and the camera 16 are all fixed. Therefore, even if the attitude of the mobile terminal device 1 changes, the relative positional relationship between the gyro sensor 14, the acceleration sensor 15, and the camera 16 does not change.

- the imaging direction of the camera 16 is taken as an X axis.

- the acceleration sensor 15 is disposed such that one of the three axes of the acceleration sensor 15 coincides with the X axis, and the other two axes are Y and Z respectively.

- the outputs of the acceleration sensor 15 become the acceleration ⁇ x in the X axis direction, the acceleration ⁇ y in the Y axis direction, and the acceleration ⁇ z in the Z axis direction.

- the gyro sensor 14 is disposed such that the three axes of the gyro sensor 14 for measuring the angular velocity around the three axes coincide with the X axis, the Y axis, and the Z axis, respectively.

- the output of the gyro sensor 14 becomes the angular velocity ⁇ x around the X axis, the angular velocity ⁇ y around the Y axis, and the angular velocity ⁇ z around the Z axis.

- the relative positional relationship (known) of the gyro sensor 14, the acceleration sensor 15, and the camera 16 does not change even if it can not be arranged in this way, so the output values of the gyro sensor 14 and the acceleration sensor 15 are known. It can be converted into values corresponding to each of the X axis, Y axis and Z axis based on the positional relationship of

- FIG. 11 is a diagram showing a coordinate system in the walking motion of the user.

- a direction opposite to gravity is taken as a V axis

- a direction in which the user travels is taken as a W axis.

- the traveling direction of the user is defined in a horizontal plane, and the V axis and the W axis are perpendicular to each other. Further, an axis perpendicular to the W axis and the V axis is taken as an S axis.

- the walking cycle calculation unit 100 estimates a gravity direction vector based on the acceleration information 150 using a conventional Kalman filter.

- the V-axis is determined as the reverse direction of the gravity direction vector thus estimated.

- the walking cycle calculation unit 100 rotates so as to align the Z-axis with the V-axis, and acquires the rotation angle ⁇ 1 at this time.

- ⁇ y and ⁇ z are calculated while rotating 360 ° around the Z axis.

- the acceleration in the W-axis direction traveling direction

- the acceleration in the S-axis direction left-right direction with respect to the traveling direction

- the rotation angle ⁇ 2 at which ⁇ z is maximum and ⁇ y is minimum is determined while the Z axis is rotated 360 °, and the X axis and Y axis at this time are determined as the W axis and the S axis, respectively.

- the walking cycle calculation unit 100 can convert the output value of the XYZ coordinate system into the WSV coordinate system. That is, the acceleration ⁇ w in the W-axis direction, the acceleration ⁇ s in the S-axis direction, and the acceleration ⁇ v in the V-axis direction can be obtained from the accelerations ⁇ x, ⁇ y, ⁇ z. Similarly, the angular velocity ⁇ w around the W axis, the angular velocity ⁇ s around the S axis, and the angular velocity ⁇ v around the V axis can be determined from the angular velocity ⁇ x, ⁇ y, ⁇ z.

- FIG. 12 is a diagram illustrating the accelerations ⁇ v and ⁇ w and the angular velocity ⁇ v in human walking motion.

- the accelerations ⁇ v and ⁇ w have one step cycle

- the angular velocity ⁇ v has one multiple step cycle. Therefore, it can be said that it is appropriate to adopt one multi-step cycle as the cycle of the walking motion.

- the angular velocity ⁇ v changes relatively complicatedly, it is also understood that it is better to use the acceleration ⁇ v or the acceleration ⁇ w to determine the walking cycle.

- the period from when the acceleration ⁇ w takes the minimum value to when it takes the minimum value twice is one compound walking time, which is the walking cycle.

- the walking cycle computing unit 100 determines the walking cycle based on the angular velocity information 140 and the acceleration information 150. For the detection of the minimum value, for example, a zero crossing method can be employed.

- the walking cycle computing unit 100 transmits the obtained walking cycle to the vector computing unit 101. Then, the vector operation unit 101 averages the motion vector obtained in step S42 on a walking cycle basis (step S44), and sets it as a motion vector of the subject. In this manner, the vector operation unit 101 can suppress the influence of motions other than the motion in the traveling direction by obtaining the motion vector of the subject.

- the correlation determination unit 102 obtains the traveling direction of the user (step S45).

- the traveling direction is determined as the W-axis direction by the walking cycle computing unit 100 when step S43 is executed. Therefore, the correlation determination unit 102 in the preferred embodiment does not obtain the traveling direction from the angular velocity information 140 and the acceleration information 150 again in step S45, but uses the W-axis direction transmitted from the walking cycle calculation unit 100.

- step S45 the correlation determination unit 102 determines whether the camera 16 is directly facing the traveling direction from the relationship between the X axis (the direction of the camera 16) and the W axis (the traveling direction).

- the determination result is stored in the storage device 11 as the correlation determination information 112 (step S46).

- the correlation determination information 112 is referred to by the straight walking determination unit 103.

- step S46 the straight walking determination unit 103 determines whether the motion vector of the subject obtained by the vector calculation unit 101 in step S44 is radial from the center of the image information 160. (Step S47). Then, if it is radial (Yes in step S47), it is determined that the user's walking motion is straight ahead, and the straight ahead flag is set to ON (step S49), and the straight ahead walking detection processing is ended. If it is not radial (No in step S47), it is determined that the user's walking motion is not in the straight movement state, and the straight movement flag is kept OFF and the straight walking detection processing is ended.

- the straight walking determination unit 103 determines that the motion vector of the subject determined by the vector calculation unit 101 in step S44 is opposite to the traveling direction, and the walking motion It is determined whether or not the magnitude is substantially constant in a period in which there is no change in (step S48). Then, in the case of Yes in step S48, the straight walking determination unit 103 determines that the user's walking motion is in the straight driving state, sets the straight driving flag to ON (step S49), and ends the straight walking detection processing. In the case of No in step S48, the straight walking determination unit 103 determines that the user's walking motion is not in the straight driving state, and maintains the straight driving flag as OFF, and ends the straight walking detection processing.

- the straight walking determination unit 103 transmits the state of the straight traveling flag to the correction unit 104. Then, based on this, the correction unit 104 determines whether the walking state of the user is the straight going state (step S14).

- the correction unit 104 corrects the bias value of the gyro sensor 14 (Step S15).

- the principle of the correction unit 104 correcting the bias value of the gyro sensor 14 in step S15 will be described.

- an angular velocity ⁇ v which is a basis for determining the traveling direction, is one multi-step cycle. Therefore, the correction unit 104 first obtains the amount of change ( ⁇ W) in the direction of travel per multiple steps.

- step S15 is executed, and the bias value bv of the gyro sensor 14 is corrected by the correction unit 104. Therefore, thereafter, the angular velocity information 140 output from the gyro sensor 14 is corrected.

- the angular velocity information 140 is determined while the straight walking determination unit 103 determines that the walking operation of the user is in the straight traveling state. It is preferable to record the amount of change in the traveling direction as “0” without referring to the acceleration information 150.

- step S14 when the user's walking motion is not in the straight-ahead state, the correction unit 104 skips step S15 and does not correct the bias value bv of the gyro sensor 14. Therefore, when the traveling direction is recorded in order to execute the positioning process and the route recording process, the traveling direction is recorded based on the angular velocity information 140 and the acceleration information 150. However, ⁇ W may be calculated by the same calculation as step S15, and the traveling direction may be calculated by adding this.

- step S16 the vector operation unit 101 executes representative sub-block determination processing to determine a new representative sub-block (step S16).

- the representative sub-block determination process in step S16 can be performed in the same manner as step S10, and thus the description thereof is omitted.

- step S16 the mobile terminal device 1 returns to the monitoring state again.

- the portable terminal device 1 measures the angular velocity in the movement of the portable terminal device 1 to obtain the angular velocity information 140, and measures the acceleration in the movement of the portable terminal device 1.

- Motion vector of the subject based on the image information 160 and the acceleration sensor 15 for acquiring the acceleration information 150, the camera 16 for capturing the image of the subject around the mobile terminal 1 while moving, and the image information 160

- the vector operation unit 101 that calculates the information 111, the angular velocity information 140 acquired by the gyro sensor 14, and the acceleration information 150 acquired by the acceleration sensor 15, the traveling direction by the user's walking motion and the imaging direction of the camera

- the correlation determination unit 102 that determines the relative relationship between According to the motion vector information 111 of the subject and the correlation determined by the correlation determination unit 102, the user is determined by the straight walk determination unit 103 which determines whether or not the user is in the straight movement state in the walking motion;

- the correction unit 104 is configured to correct the angular velocity information 140 acquired by the gyro

- the vector operation unit 101 divides the image information 160 into a plurality of blocks each having a first size, and a plurality of sub-blocks each having a second size smaller than the first size. Divided into subblocks, edge amounts are detected for each of a plurality of subblocks, and a subblock having the largest edge amount in each of the plurality of blocks is determined as a representative subblock of each block, and the motion vector of the determined representative subblock.

- the motion vector information 111 of the subject is calculated by calculating As a result, it is possible to suppress the localization of subblocks to be calculated for the motion vector information 111 in the image information. Therefore, it can be accurately determined whether or not the traveling direction of the pedestrian is straight ahead.

- the vector operation unit 101 obtains the motion vector information 111 of the subject by averaging the motion vectors of the representative sub-block on a walking cycle basis of the user. Therefore, it is possible to suppress the influence of the movement other than the movement in the traveling direction.

- the walking cycle is determined according to the time (one double walking time) in which the user advances the left and right legs one step at a time, so that the cycle unit of the angular velocity ⁇ v around the V axis is determined. It can be processed and the accuracy is improved.

- the correlation determined by the correlation determination unit 102 includes the relationship in which the imaging direction of the camera 16 faces the traveling direction of the user's walking motion, the straight traveling state can be easily determined.

- the straight walking determination unit 103 determines that the motion vector of the subject determined by the vector calculation unit 101 is radial in the image information 160. When it is determined, it is determined that the walking operation of the user is in the straight-ahead state. Thus, the straight traveling state can be determined efficiently.

- sub blocks located in the peripheral portion of the image information 160 are determined to be representative sub blocks, it is also conceivable that the subject corresponding to the representative sub block is out of the imaging range due to the user's movement. In that case, there is a possibility that the motion vector can not be obtained. Therefore, when determining a representative sub-block, sub-blocks located at the periphery in the image information 160 may be excluded from the candidates. Alternatively, it may be determined which subblock is to be excluded from candidates according to the predicted user motion (direction or speed).

- the influence of motion other than the motion in the traveling direction is suppressed by averaging the motion vectors of the representative sub-blocks in the walking cycle.

- the method of suppressing the influence of movement other than the movement in the traveling direction is not limited to this.

- FIG. 13 is a diagram showing functional blocks included in the portable terminal device 1a according to another preferred embodiment together with the flow of data.

- symbol is attached

- the portable terminal device 1 a includes a walking cycle computing unit 100 a instead of the walking cycle computing unit 100 and a vector computing unit 101 a instead of the vector computing unit 101. Are different from the portable terminal device 1.

- the walking cycle computing unit 100a computes the operation timing and transmits it to the vector computing unit 101a instead of the walking cycle.

- the vector computing unit 101a creates the motion vector information 111 as the motion vector of the subject as it is, instead of averaging the motion vectors of the representative sub-blocks in the walking cycle. Further, the calculation timing by the vector calculation unit 101a is not determined by the calculation timer, but is notified from the walking cycle calculation unit 100.

- FIG. 14 is a flowchart showing the correction process performed by the mobile terminal device 1a in another preferred embodiment.

- the portable terminal device 1a in another preferred embodiment is in a monitoring state after the same initial setting as that of the portable terminal device 1 in the preferred embodiment is performed. Further, in the monitoring state, the mobile terminal device 1a monitors the arrival of the measurement timing, the arrival of the imaging timing, and the arrival of the calculation timing (steps S51, S55, and S60).

- the portable terminal device 1a determines Yes in step S51, and executes the processing of steps S52 to S54.

- steps S52 to S54 are the same as the processes of steps S2 to S4 in the preferred embodiment, and thus the description thereof will be omitted.

- step S55 the portable terminal device 1a determines Yes in step S55, and executes the processing of steps S56 and S57.

- step S56 S57 is the same as the process of step S6, S7 in preferable embodiment, description is abbreviate

- step S57 the vector operation unit 101a determines whether a representative sub-block has already been determined (step S58). Then, if the representative sub-block has not been determined yet, the representative sub-block determination process (step S59) is performed, and then the state returns to the monitoring state. On the other hand, if the representative sub-block has already been determined, step S59 is skipped to return to the monitoring state.

- the representative sub-block determination process at step S59 is the same as the process at step S10 in the preferred embodiment, and thus the description thereof is omitted.

- the configuration corresponding to the operation timer Tv is not provided, and the process of starting the operation timer Tv (the process corresponding to step S9) is not executed.

- step S60 In the monitoring state, when the operation timing comes, the CPU 10 determines Yes in step S60. In the preferred embodiment, whether or not the operation timing has come is determined with reference to the value of the operation timer. However, in another preferred embodiment, since the operation timer is not provided, the determination of step S60 can not be executed based on the value of the operation timer.

- the same walking state is repeated for each walking cycle. Therefore, by comparing the image information 160 captured in the same state, it is possible to efficiently cancel the movement other than the movement in the traveling direction. That is, by synchronizing the calculation timing with the walking cycle so that the calculation timing comes for each walking cycle, it is possible to suppress the influence of the movement other than the movement in the traveling direction.

- the portable terminal device 1a is configured to determine that the calculation timing has arrived when the speed of the camera 16 is minimum.

- the motion vector can be calculated by the image information 160 in the state in which camera shake is the least, and the accuracy is improved.

- the timing at which the speed of the camera 16 is minimum can be determined based on the accelerations ⁇ w, ⁇ s, and ⁇ v.

- the vector operation unit 101a determines that the operation timing has arrived at the timing at which the speed of the camera 16 arrives at each walking cycle is minimum, and determines Yes in step S60. Such timing is detected by the walking cycle calculation unit 100a and transmitted to the vector calculation unit 101a.

- the walking cycle calculation unit 100a in another preferred embodiment can obtain the walking cycle in step S60 in the same manner as step S43 (FIG. 9) in the preferred embodiment. Further, since the accelerations ⁇ w, ⁇ s and ⁇ v are obtained in the process of obtaining the walking cycle in step S60, the timing at which the speed of the camera 16 is minimum can also be determined based on these, and this is transmitted to the vector operation unit 101a Do. Thus, in the portable terminal device 1a according to another preferred embodiment, the arrival of the operation timing is detected.

- step S60 If it determines with Yes in step S60, the portable terminal device 1a will perform a straight walk detection process (step S61).

- FIG. 15 is a flow chart showing straight walk detection processing in another preferred embodiment.

- the straight walking determination unit 103 turns off the straight traveling flag (step S71).

- the vector operation unit 101a obtains the motion vector of the representative sub block, creates motion vector information 111, and stores the motion vector information 111 in the storage device 11 (step S72).

- the process of obtaining the walking cycle is already performed at the stage of step S60, so the process corresponding to step S43 in the preferred embodiment is not performed in the other preferred embodiment. .

- the motion vector of the representative sub-block is calculated in synchronization with the walking cycle, the influence of the motion other than the motion in the traveling direction has already been cancelled. Therefore, it is not necessary to average the motion vector of the representative sub-block in the walking cycle, and the processing corresponding to step S44 in the preferred embodiment is not executed in other preferred embodiments. Then, the motion vector of the representative sub-block determined in step S72 is stored in the motion vector information 111 as the motion vector of the subject as it is.

- step S72 When step S72 is executed, the mobile terminal device 1a executes step S73.

- steps S73 to S77 are the same as the processes of steps S45 to S49 in the preferred embodiment, and thus the description thereof is omitted.

- step S62 When the straight-ahead walking detection process of step S61 is completed, the mobile terminal device 1a executes step S62.

- the process after step S62 is performed is the same as the process after step S14 in the preferred embodiment is performed, the description will be omitted.

- the vector operation unit 101a calculates the motion vector of the representative sub-block at the operation timing synchronized with the walking cycle of the user. Therefore, even if it does not average to a walk cycle unit, the influence by movement other than movement to a direction of movement can be removed.

- the calculation timing is determined so that the speed of the camera 16 is minimum. Therefore, while being able to suppress the influence by motions other than the motion to the advancing direction, the blurring of image information can also be suppressed.

- the calculation timing may be determined to be when the feet of the user are landing. In this case, since the motion vector at the moment when the user's body is most stable can be obtained, the influence of the motion other than the motion in the traveling direction can also be suppressed.

- the timing at which the user's feet land can be detected by the walking cycle calculation unit 100 a based on the angular velocities ⁇ w, ⁇ s, ⁇ v and the accelerations ⁇ w, ⁇ s, ⁇ v.

- the walking cycle calculated by the walking cycle calculation unit 100a is set to the same configuration as the calculation timer in the preferred embodiment, and the timing when the calculation timer becomes zero. It can also be realized by monitoring the arrival of at step S60.

- the operation cycle of the vector operation becomes relatively long.

- the amount of movement in the image of the subject included in the representative sub-block becomes large, and there is a concern that the search area of the representative sub-block may be expanded.

- the amount of movement in the image of the representative sub-block can be estimated based on the angular velocities ⁇ w, ⁇ s, ⁇ v, and the accelerations ⁇ w, ⁇ s, ⁇ v, thus suppressing such a problem. be able to. This is the same as in the other preferred embodiments described below.

- the method of suppressing the influence of movement other than the movement in the advancing direction is not limited to the method shown in the preferred embodiment and other preferred embodiments.

- FIG. 16 is a diagram showing functional blocks included in the portable terminal 1b according to still another preferred embodiment, together with the flow of data.

- the same components as those of the portable terminal device 1 in the preferable embodiment are denoted by the same reference numerals, and the description thereof will be appropriately omitted.

- the portable terminal device 1 b includes a camera 16 b instead of the camera 16, a walking period computing unit 100 b instead of the walking cycle computing unit 100, and a vector computing unit

- the mobile terminal device 1 is different from the mobile terminal device 1 in that a vector operation unit 101 b is provided instead of 101.

- the camera 16 b performs imaging according to the imaging timing notified from the walking cycle calculation unit 100 b and acquires the image information 160.

- the walking cycle calculation unit 100b calculates the walking cycle based on the angular velocity information 140 and the acceleration information 150, determines the imaging timing at the timing synchronized with the walking cycle, and transmits it to the camera 16b. On the other hand, the walking cycle computing unit 100b does not transmit the walking cycle to the vector computing unit 101b.

- the vector operation unit 101b does not determine the operation timing by the operation timer, but executes the operation of the motion vector with the timing when the new image information 160 is acquired as the operation timing.

- FIG. 17 is a flowchart showing the correction process performed by the portable terminal device 1b in still another preferred embodiment.

- the monitoring state is entered after the initial setting similar to that of the portable terminal device 1 according to the preferred embodiment is performed.

- the imaging timer is not provided in the mobile terminal device 1b, the process of activating the imaging timer is not included in the initial setting.

- the mobile terminal device 1b monitors the arrival of the measurement timing and the arrival of the imaging timing (steps S81 and S85).

- the portable terminal device 1b determines Yes in step S81, and executes the processing of steps S82 to S84.

- steps S82 to S84 are the same as the processes of steps S2 to S4 in the preferred embodiment, and thus the description thereof will be omitted.

- the portable terminal device 1b determines Yes in step S85. In the preferred embodiment, whether or not the imaging timing has arrived is determined with reference to the value of the imaging timer. However, in still another preferred embodiment, since the imaging timer is not provided, the determination in step S85 can not be executed based on the value of the imaging timer.

- the same walking state is repeated every walking cycle. Therefore, by comparing the image information 160 captured in the same state, it is possible to efficiently cancel the movement other than the movement in the traveling direction. That is, by synchronizing the imaging timing with the walking cycle so that the imaging timing comes for each walking cycle, only the image information 160 captured in the same state can be obtained, and the movement other than the movement in the traveling direction It is possible to suppress the influence of

- the portable terminal device 1 b is configured to determine that the imaging timing has arrived when the speed of the camera 16 is minimum.

- the motion vector can be calculated by the image information 160 in the state of least camera shake, and the accuracy is improved.

- the mobile terminal device 1a is configured to calculate the motion vector using the image information 160 of the optimum timing by adjusting the calculation timing

- the mobile terminal device 1b has an image of the optimum timing. Only the information 160 is configured to be imaged. As a result, the number of times of imaging by the camera 16 can be significantly reduced, the processing load is reduced, and the power consumption is also suppressed.

- the portable terminal device 1b determines that the imaging timing has arrived at the timing at which the speed of the camera 16 arrives at each walking cycle is minimum, and determines Yes in step S85. Such timing is detected by the walking cycle computing unit 100b in the same manner as the walking cycle computing unit 100a in another preferred embodiment, and transmitted to the camera 16b.

- step S85 If the determination in step S85 is YES, the camera 16b performs imaging, and new image information 160 is stored in the storage device 11 (step S86).

- vector operation unit 101b determines whether or not the representative sub-block has already been determined (step S87). If the representative sub-block has not yet been determined (No in step S87) And the representative sub-block determination process (step S91) is performed to return to the monitoring state.

- the representative sub-block determination process at step S91 is the same as the process at step S10 in the preferred embodiment, and thus the description thereof is omitted.

- step S88 the straight walk detection process in step S88 is the same as the straight walk detection process (FIG. 15) in another preferable embodiment, the description will be omitted.

- step S89 the portable terminal device 1b executes step S89.

- the process after step S89 is performed is the same as the process after step S14 in the preferred embodiment is performed, the description will be omitted.

- the camera 16b captures an object around the mobile terminal device 1b during a moving period at an imaging timing synchronized with the walking cycle of the user. Do. As a result, since imaging is performed when the posture is constant in the walking motion (variation in posture at the time of imaging can be suppressed), the influence of motion vectors other than the movement in the traveling direction can be removed. Moreover, the power consumption by the camera 16b can be suppressed by imaging intermittently.

- the imaging timing is determined such that the speed of the camera 16b is minimum. Therefore, while being able to suppress the influence by motions other than the motion to the advancing direction, the blurring of image information can also be suppressed.

- the imaging timing may be determined so as to be when the feet of the user are landing. In this case, since the motion vector at the moment when the user's body is most stable can be obtained, the influence of the motion other than the motion in the traveling direction can also be suppressed.

- the timing at which the user's feet land can be detected by the walking cycle calculation unit 100b based on the angular velocities ⁇ w, ⁇ s, ⁇ v and the accelerations ⁇ w, ⁇ s, ⁇ v.

- the walking cycle calculated by the walking cycle calculation unit 100b is set to the same configuration as the imaging timer in the preferred embodiment, and the timing when the imaging timer becomes zero. It can also be realized by monitoring the arrival of at step S85.

- the camera 16b performs imaging during a fixed time before and after the timing synchronized with the walking cycle comes, and of the image information 160 acquired during that time, the camera 16b is actually imaged when the speed is minimum.

- the image information 160 may be used to calculate a motion vector.

- the walking motion of a person is not a constant walking cycle, but some variation occurs. Therefore, the predicted walking cycle may not actually be in the same state, and the state may be shifted only by the image information 160 captured by the predicted walking cycle.

- the user's rectilinear state in the walking state is determined by analyzing the image information 160 captured by the cameras 16, 16b.

- the method of determining the straight traveling state in the walking state of the user is not limited to this.

- FIG. 18 is a block diagram of a portable terminal device 1c in still another preferred embodiment.

- the same components as those of the portable terminal device 1 in the preferable embodiment are denoted by the same reference numerals, and the description thereof will be appropriately omitted.

- the portable terminal device 1 c differs from the portable terminal device 1 in that the camera 16 is not provided.

- FIG. 19 is a diagram showing functional blocks included in the portable terminal 1 c according to still another preferred embodiment, together with the flow of data.

- the portable terminal device 1 c includes a straight walking determination unit 103 c and a correction unit 104.

- the straight walking determination unit 103 c and the correction unit 104 are functional blocks implemented by the CPU 10 operating according to the program 110.

- the straight walking determination unit 103c compares the angular velocity information 140 acquired by the gyro sensor 14 and the acceleration information 150 acquired by the acceleration sensor 15 with the pattern in the walking motion given in advance, to allow the user to go straight in the walking motion It is determined whether or not.

- the straight walking determination unit 103c converts the angular velocity information 140 and the acceleration information 150 into a coordinate system (W axis, S axis and V axis) indicating the walking motion of the user, as in the walking cycle calculation unit 100 in the preferred embodiment.

- the angular velocity ⁇ w, ⁇ s, ⁇ v and the accelerations ⁇ w, ⁇ s, ⁇ v are obtained. It also has a function to calculate the walking cycle according to these values.

- the accelerations ⁇ w and ⁇ v and the angular velocity ⁇ s reflect the forward movement in walking motion.

- the angular velocity ⁇ w, ⁇ v and the acceleration ⁇ s reflect the turning motion in the walking motion.

- the accelerations ⁇ w and ⁇ v have a period of one step unit

- the angular velocity ⁇ v has a period of one multiple step unit.

- straight walk determination is made by extracting feature points in units of one or more steps for the pattern of walking motion whose walking state is known in advance and inputting it to a machine learning device (for example, a support vector machine or neural network) to learn.

- a machine learning device for example, a support vector machine or neural network

- the function of the unit 103c can be realized. That is, also in another preferred embodiment, the walking cycle is one multiple walking cycle.

- the pattern of the walking state to be learned is assumed to be straight, right turn, left turn, etc. Moreover, the pattern by the difference in a holding state is also assumed to the pattern of the walking state to learn. For example, a state in which the portable terminal device 1c is held in a hand (hand gesture state), a state in which the display unit 13 is viewed, a state in which it is put in a pocket or the like, a state in which a call is made, and the like are assumed.

- FIG. 20 is a flow chart showing a correction process performed by the mobile terminal device 1c in still another preferred embodiment.

- the initial setting includes a process of setting Ts to a measurement timer for measuring the measurement timing by the gyro sensor 14 and the acceleration sensor 15 to start, and a process of setting an initial value of the bias value (bv) of the gyro sensor 14 And a process of determining the attitude of the mobile terminal device 1 (the attitude at the start of the process).

- a method of determining the initial attitude of the portable terminal device 1 a method in which the user operates the operation unit 12 of the portable terminal device 1c to input the attitude, a method of determining the attitude by the output of a magnetic sensor not shown, etc. Be done.

- the mobile terminal device 1c When the initial setting is completed, the mobile terminal device 1c is in a state of monitoring the measurement timer and whether one step time has elapsed (steps S101 and S105). This state is referred to as a "monitoring state" in the following description. However, in the monitoring state, the mobile terminal device 1 may execute processing other than steps S101 and S105.

- step S101 the CPU 10 determines Yes in step S101 and resets the values of the gyro sensor 14 and the acceleration sensor 15 while resetting the measurement timer to Ts (step S102). Read each one. As a result, the measurement of the angular velocity and the acceleration related to the movement of the mobile terminal device 1c is performed (step S103).

- the value of the gyro sensor 14 read out in step S103 is acquired based on the initial value of the bias value bv if the correction of the bias value bv (described later) has not been made.

- the bias value bv is corrected, it is acquired as a value corrected by the value of the corrected bias value bv. That is, the correction unit 104 corrects the angular velocity information 140 by correcting the bias value bv of the gyro sensor 14.

- the CPU 10 creates angular velocity information 140 and acceleration information 150 based on the read value of the gyro sensor 14 and the value of the acceleration sensor 15 and records the information in the storage device 11 (step S104).

- the angular velocity information 140 and the acceleration information 150 are recorded in the order of acquisition as a history, rather than being overwritten on past recordings.

- the portable terminal device 1c determines Yes in step S101 each time the value of the measurement timer becomes 0, and executes the processing of steps S102 to S104. Therefore, in the mobile terminal device 1c, the angular velocity and the acceleration are measured at each measurement cycle Ts. In addition, if step S104 is performed, the portable terminal device 1c will return to a monitoring state again.

- the straight walking determination unit 103c determines whether the walking state of the user is the straight state (step S106). In yet another preferred embodiment, the determination in step S105 is Yes each time one multistep time has elapsed. Therefore, the portable terminal device 1c (straight walk determination unit 103c) performs pattern recognition processing based on the angular velocity information 140 and the acceleration information 150 measured during that period, and the user's walking state during this period is straight ahead It is determined whether or not it was.

- step S107 the correction unit 104 corrects the bias value of the gyro sensor 14 (step S107).

- the principle of the correction unit 104 correcting the bias value of the gyro sensor 14 in step S107 is the same as step S15 in the preferred embodiment, and thus the description thereof is omitted.

- the straight walking determination unit 103c determines that the walking operation of the user is straight ahead It is preferable to record the amount of change in the traveling direction as “0” without referring to the angular velocity information 140 or the acceleration information 150 during the interval.

- step S106 if the user's walking motion is not in the straight-ahead state, the correction unit 104 skips step S107 and returns to the monitoring state. Therefore, in this case, the correction unit 104 does not correct the bias value bv of the gyro sensor 14. Therefore, when the traveling direction is recorded in order to execute the positioning process and the route recording process, the traveling direction is recorded based on the angular velocity information 140 and the acceleration information 150. However, ⁇ W may be calculated by the same calculation as step S15, and the traveling direction may be calculated by adding this.

- the portable terminal device 1c measures the angular velocity in the movement of the portable terminal device 1c to obtain the angular velocity information 140, and the acceleration in the movement of the portable terminal device 1c.

- the acceleration sensor 15 obtains acceleration information 150 by measuring the angular velocity information 140 acquired by the gyro sensor 14 and the acceleration information 150 acquired by the acceleration sensor 15 by comparing with the pattern in the walking motion given in advance.

- a correction unit 104 that corrects the angular velocity information 140 Provided.

- the straight walking determination unit 103c compares the pattern with the pattern according to the walking cycle in the walking motion of the user.

- feature points can be efficiently extracted by focusing on a walking cycle that is configured as a continuous motion and dividing it into walking cycles, and pattern recognition can be realized by a relatively short time operation. Can. Therefore, it is possible to introduce pattern recognition to the walking motion which is a continuous motion for a relatively long time, and the accuracy of detecting the straight movement state is improved. Also, it is not necessary to provide the cameras 16, 16b as in the first to further preferred embodiments.

- the walking cycle is determined in accordance with the time (one double walking time) in which the user advances the left and right legs one step at a time in the walking operation of the user.

- each step shown in the above-described preferred embodiment is merely an example, and the present invention is not limited to the order or contents shown above. That is, the order and content may be changed as appropriate, as long as the same effect is obtained.