WO2012098790A1 - 画像処理装置及び画像処理方法 - Google Patents

画像処理装置及び画像処理方法 Download PDFInfo

- Publication number

- WO2012098790A1 WO2012098790A1 PCT/JP2011/079031 JP2011079031W WO2012098790A1 WO 2012098790 A1 WO2012098790 A1 WO 2012098790A1 JP 2011079031 W JP2011079031 W JP 2011079031W WO 2012098790 A1 WO2012098790 A1 WO 2012098790A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- line

- unit

- determination

- deblocking filter

- image

- Prior art date

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/102—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or selection affected or controlled by the adaptive coding

- H04N19/117—Filters, e.g. for pre-processing or post-processing

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/134—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or criterion affecting or controlling the adaptive coding

- H04N19/136—Incoming video signal characteristics or properties

- H04N19/14—Coding unit complexity, e.g. amount of activity or edge presence estimation

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/169—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/169—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding

- H04N19/17—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding the unit being an image region, e.g. an object

- H04N19/176—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding the unit being an image region, e.g. an object the region being a block, e.g. a macroblock

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/60—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using transform coding

- H04N19/61—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using transform coding in combination with predictive coding

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/80—Details of filtering operations specially adapted for video compression, e.g. for pixel interpolation

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/85—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using pre-processing or post-processing specially adapted for video compression

- H04N19/86—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using pre-processing or post-processing specially adapted for video compression involving reduction of coding artifacts, e.g. of blockiness

Definitions

- the present disclosure relates to an image processing apparatus and an image processing method.

- H. is one of the standard specifications for image coding.

- a deblocking filter is applied to a block boundary for each block of 4 ⁇ 4 pixels, for example, in order to suppress deterioration in image quality due to block distortion that occurs during image coding.

- the amount of processing required for this deblocking filter is enormous, and for example, it is said that it may occupy 50% of the total amount of processing when decoding an image.

- JCTVC-A119 In the standardization work of HEVC (High Efficiency Video Coding), the next-generation image encoding method, a deblock filter is applied to each block of 8 ⁇ 8 pixels or more in JCTVC-A119 (see Non-Patent Document 1 below). It has been proposed to do. In the method proposed in JCTVC-A119, the block size of the minimum unit to which the deblocking filter is applied is expanded. Even in this method, H.C. Similar to H.264 / AVC, the necessity of applying the deblocking filter is determined in units of blocks.

- JCT-VC Video coding technology proposal by Tandberg, Nokia, and Ericsson

- JCT-VC Documents of the team of the int on Video Coding

- image quality degradation due to block distortion does not necessarily appear uniformly in the block. That is, there is a possibility that the image quality of a part of the block determined to be applied with the deblocking filter is already good. In addition, there is a possibility that the image quality of a part of the block that is determined not to apply the deblocking filter actually deteriorates. If a deblocking filter is applied to a portion having good image quality, the image quality may be impaired. Further, the image quality is not improved unless the deblocking filter is applied to the portion having the degraded image quality.

- a decoding unit that decodes an encoded stream to generate an image, and a line that is orthogonal to the boundary in adjacent blocks that are adjacent to each other across the boundary in the image generated by the decoding unit.

- An image processing apparatus comprising: a line determination unit that determines whether to apply a deblocking filter to each line; and a filtering unit that applies a deblocking filter to each line determined to be applied by the line determination unit Is provided.

- the image processing apparatus can typically be realized as an image decoding apparatus that decodes an image.

- an image is generated by decoding an encoded stream, and for each line orthogonal to the boundary in adjacent blocks that are adjacent to each other with the boundary in the generated image.

- An image processing method including determining whether to apply a deblocking filter and applying the deblocking filter to each line determined to apply the deblocking filter is provided.

- a deblocking filter is provided for each line orthogonal to the boundary in adjacent blocks that are adjacent to each other across the boundary in the locally decoded image when the encoding target image is encoded.

- a line determination unit that determines whether to apply a deblocking filter, a filtering unit that applies a deblocking filter to each line determined to apply a deblocking filter by the line determination unit, and an image filtered by the filtering unit.

- an image processing apparatus including an encoding unit that encodes the encoding target image.

- the image processing apparatus can typically be realized as an image encoding apparatus that encodes an image.

- a deblocking filter is provided for each line orthogonal to the boundary in adjacent blocks that are adjacent to each other across the boundary in the locally decoded image when the encoding target image is encoded. Applying the deblocking filter to each line determined to apply the deblocking filter, and encoding the encoding target image using the filtered image. , An image processing method is provided.

- the image processing apparatus and the image processing method according to the present disclosure can more appropriately determine the range to which the deblocking filter is applied.

- FIG. 1 is a block diagram illustrating an example of a configuration of an image encoding device 10 according to an embodiment.

- an image encoding device 10 includes an A / D (Analogue to Digital) conversion unit 11, a rearrangement buffer 12, a subtraction unit 13, an orthogonal transformation unit 14, a quantization unit 15, a lossless encoding unit 16, Accumulation buffer 17, rate control unit 18, inverse quantization unit 21, inverse orthogonal transform unit 22, addition unit 23, deblock filter 24a, frame memory 25, selector 26, intra prediction unit 30, motion search unit 40, and mode selection Part 50 is provided.

- a / D Analogue to Digital

- the A / D converter 11 converts an image signal input in an analog format into image data in a digital format, and outputs a series of digital image data to the rearrangement buffer 12.

- the rearrangement buffer 12 rearranges the images included in the series of image data input from the A / D conversion unit 11.

- the rearrangement buffer 12 rearranges the images according to the GOP (Group of Pictures) structure related to the encoding process, and then outputs the rearranged image data to the subtraction unit 13, the intra prediction unit 30, and the motion search unit 40. To do.

- GOP Group of Pictures

- the subtraction unit 13 is supplied with image data input from the rearrangement buffer 12 and predicted image data selected by the mode selection unit 50 described later.

- the subtraction unit 13 calculates prediction error data that is a difference between the image data input from the rearrangement buffer 12 and the prediction image data input from the mode selection unit 50, and sends the calculated prediction error data to the orthogonal transformation unit 14. Output.

- the orthogonal transform unit 14 performs orthogonal transform on the prediction error data input from the subtraction unit 13.

- the orthogonal transformation performed by the orthogonal transformation part 14 may be discrete cosine transformation (Discrete Cosine Transform: DCT) or Karoonen-Labe transformation, for example.

- the orthogonal transform unit 14 outputs transform coefficient data acquired by the orthogonal transform process to the quantization unit 15.

- the quantization unit 15 is supplied with transform coefficient data input from the orthogonal transform unit 14 and a rate control signal from the rate control unit 18 described later.

- the quantizing unit 15 quantizes the transform coefficient data and outputs the quantized transform coefficient data (hereinafter referred to as quantized data) to the lossless encoding unit 16 and the inverse quantization unit 21.

- the quantization unit 15 changes the bit rate of the quantized data input to the lossless encoding unit 16 by switching the quantization parameter (quantization scale) based on the rate control signal from the rate control unit 18.

- the lossless encoding unit 16 includes quantized data input from the quantization unit 15, and intra prediction or inter prediction generated by the intra prediction unit 30 or the motion search unit 40 described later and selected by the mode selection unit 50.

- Information about is provided.

- the information regarding intra prediction may include, for example, prediction mode information indicating an optimal intra prediction mode for each block.

- the information regarding inter prediction may include, for example, prediction mode information for motion vector prediction for each block, differential motion vector information, reference image information, and the like.

- the lossless encoding unit 16 generates an encoded stream by performing lossless encoding processing on the quantized data.

- the lossless encoding by the lossless encoding unit 16 may be variable length encoding or arithmetic encoding, for example.

- the lossless encoding unit 16 multiplexes the above-described information related to intra prediction or information related to inter prediction in a header (for example, a block header or a slice header) of an encoded stream. Then, the lossless encoding unit 16 outputs the generated encoded stream to the accumulation buffer 17.

- the accumulation buffer 17 temporarily accumulates the encoded stream input from the lossless encoding unit 16.

- the accumulation buffer 17 outputs the accumulated encoded stream at a rate corresponding to the bandwidth of the transmission path (or the output line from the image encoding device 10).

- the rate control unit 18 monitors the free capacity of the accumulation buffer 17. Then, the rate control unit 18 generates a rate control signal according to the free capacity of the accumulation buffer 17 and outputs the generated rate control signal to the quantization unit 15. For example, the rate control unit 18 generates a rate control signal for reducing the bit rate of the quantized data when the free capacity of the storage buffer 17 is small. For example, when the free capacity of the accumulation buffer 17 is sufficiently large, the rate control unit 18 generates a rate control signal for increasing the bit rate of the quantized data.

- the inverse quantization unit 21 performs an inverse quantization process on the quantized data input from the quantization unit 15. Then, the inverse quantization unit 21 outputs transform coefficient data acquired by the inverse quantization process to the inverse orthogonal transform unit 22.

- the inverse orthogonal transform unit 22 restores the prediction error data by performing an inverse orthogonal transform process on the transform coefficient data input from the inverse quantization unit 21. Then, the inverse orthogonal transform unit 22 outputs the restored prediction error data to the addition unit 23.

- the addition unit 23 generates decoded image data by adding the restored prediction error data input from the inverse orthogonal transform unit 22 and the predicted image data input from the mode selection unit 50. Then, the adder 23 outputs the generated decoded image data to the deblock filter 24 a and the frame memory 25.

- the deblocking filter 24a performs a filtering process for reducing block distortion that occurs during image encoding. More specifically, the deblocking filter 24 a determines whether or not filtering is necessary for each block boundary in the decoded image data input from the adding unit 23. Then, the deblocking filter 24a applies the deblocking filter to the line determined to be applied with the filter. When the block boundary is a vertical boundary, the line corresponds to a row orthogonal to the vertical boundary. When the block boundary is a horizontal boundary, the line corresponds to a column orthogonal to the horizontal boundary.

- the deblocking filter 24a In addition to the decoded image data from the adding unit 23, information (for example, mode information, transform coefficient information, and motion vector information) used for determining whether filtering is necessary is input to the deblocking filter 24a. Thereafter, the deblocking filter 24 a outputs the decoded image data after filtering from which block distortion has been removed to the frame memory 25. The processing by the deblocking filter 24a will be described in detail later.

- the frame memory 25 stores the decoded image data input from the adder 23 and the decoded image data after filtering input from the deblocking filter 24a.

- the selector 26 reads out the decoded image data before filtering used for intra prediction from the frame memory 25 and supplies the read decoded image data to the intra prediction unit 30 as reference image data. Further, the selector 26 reads out the filtered decoded image data used for inter prediction from the frame memory 25 and supplies the read decoded image data to the motion search unit 40 as reference image data.

- the intra prediction unit 30 performs an intra prediction process in each intra prediction mode based on the image data to be encoded input from the rearrangement buffer 12 and the decoded image data supplied via the selector 26. For example, the intra prediction unit 30 evaluates the prediction result in each intra prediction mode using a predetermined cost function. Then, the intra prediction unit 30 selects an intra prediction mode in which the cost function value is minimum, that is, an intra prediction mode in which the compression rate is the highest as the optimal intra prediction mode. Further, the intra prediction unit 30 outputs information related to intra prediction including prediction mode information representing the optimal intra prediction mode, predicted image data, and a cost function value to the mode selection unit 50.

- the motion search unit 40 performs inter prediction processing (interframe prediction processing) based on the image data to be encoded input from the rearrangement buffer 12 and the decoded image data supplied via the selector 26. For example, the motion search unit 40 evaluates the prediction result in each prediction mode using a predetermined cost function. Next, the motion search unit 40 selects a prediction mode with the smallest cost function value, that is, a prediction mode with the highest compression rate, as the optimum prediction mode. Further, the motion search unit 40 generates predicted image data according to the optimal prediction mode. Then, the motion search unit 40 outputs information related to inter prediction including prediction mode information indicating the selected optimal prediction mode, predicted image data, and a cost function value to the mode selection unit 50.

- inter prediction processing interframe prediction processing

- the mode selection unit 50 compares the cost function value related to intra prediction input from the intra prediction unit 30 with the cost function value related to inter prediction input from the motion search unit 40. And the mode selection part 50 selects the prediction method with few cost function values among intra prediction and inter prediction.

- the mode selection unit 50 outputs information on the intra prediction to the lossless encoding unit 16 and outputs the predicted image data to the subtraction unit 13 and the addition unit 23.

- the mode selection unit 50 outputs the above-described information regarding inter prediction to the lossless encoding unit 16 and outputs the predicted image data to the subtraction unit 13 and the addition unit 23.

- FIG. 2 is a block diagram illustrating an example of the configuration of the image decoding device 60 according to an embodiment.

- the image decoding device 60 includes an accumulation buffer 61, a lossless decoding unit 62, an inverse quantization unit 63, an inverse orthogonal transform unit 64, an addition unit 65, a deblock filter 24b, a rearrangement buffer 67, a D / A (Digital to Analogue) conversion unit 68, frame memory 69, selectors 70 and 71, intra prediction unit 80, and motion compensation unit 90 are provided.

- the accumulation buffer 61 temporarily accumulates the encoded stream input via the transmission path.

- the lossless decoding unit 62 decodes the encoded stream input from the accumulation buffer 61 according to the encoding method used at the time of encoding. In addition, the lossless decoding unit 62 decodes information multiplexed in the header area of the encoded stream.

- the information multiplexed in the header area of the encoded stream can include, for example, information related to intra prediction and information related to inter prediction in a block header.

- the lossless decoding unit 62 outputs information related to intra prediction to the intra prediction unit 80. Further, the lossless decoding unit 62 outputs information related to inter prediction to the motion compensation unit 90.

- the inverse quantization unit 63 performs inverse quantization on the quantized data decoded by the lossless decoding unit 62.

- the inverse orthogonal transform unit 64 generates prediction error data by performing inverse orthogonal transform on the transform coefficient data input from the inverse quantization unit 63 according to the orthogonal transform method used at the time of encoding. Then, the inverse orthogonal transform unit 64 outputs the generated prediction error data to the addition unit 65.

- the addition unit 65 adds the prediction error data input from the inverse orthogonal transform unit 64 and the prediction image data input from the selector 71 to generate decoded image data. Then, the addition unit 65 outputs the generated decoded image data to the deblock filter 24b and the frame memory 69.

- the deblocking filter 24b performs a filtering process for reducing block distortion appearing in the decoded image. More specifically, the deblocking filter 24b determines whether or not filtering is necessary for each block boundary in the decoded image data input from the adding unit 65. Then, the deblocking filter 24a applies the deblocking filter to the line determined to be applied with the filter. In addition to the decoded image data from the adding unit 65, information used for determining whether filtering is necessary is input to the deblocking filter 24b. Thereafter, the deblocking filter 24 b outputs the decoded image data after filtering from which block distortion has been removed to the rearrangement buffer 67 and the frame memory 69. The processing by the deblocking filter 24b will be described in detail later.

- the rearrangement buffer 67 generates a series of image data in time series by rearranging the images input from the deblocking filter 24b. Then, the rearrangement buffer 67 outputs the generated image data to the D / A conversion unit 68.

- the D / A converter 68 converts the digital image data input from the rearrangement buffer 67 into an analog image signal. Then, the D / A conversion unit 68 displays an image by outputting an analog image signal to a display (not shown) connected to the image decoding device 60, for example.

- the frame memory 69 stores the decoded image data before filtering input from the adding unit 65 and the decoded image data after filtering input from the deblocking filter 24b.

- the selector 70 switches the output destination of the image data from the frame memory 69 between the intra prediction unit 80 and the motion compensation unit 90 for each block in the image according to the mode information acquired by the lossless decoding unit 62. .

- the selector 70 outputs the decoded image data before filtering supplied from the frame memory 69 to the intra prediction unit 80 as reference image data.

- the selector 70 outputs the decoded image data after filtering supplied from the frame memory 69 to the motion compensation unit 90 as reference image data.

- the selector 71 sets the output source of the predicted image data to be supplied to the adding unit 65 for each block in the image according to the mode information acquired by the lossless decoding unit 62 between the intra prediction unit 80 and the motion compensation unit 90. Switch between. For example, the selector 71 supplies the prediction image data output from the intra prediction unit 80 to the adding unit 65 when the intra prediction mode is designated. The selector 71 supplies the predicted image data output from the motion compensation unit 90 to the adding unit 65 when the inter prediction mode is designated.

- the intra prediction unit 80 performs in-screen prediction of pixel values based on information related to intra prediction input from the lossless decoding unit 62 and reference image data from the frame memory 69, and generates predicted image data. Then, the intra prediction unit 80 outputs the generated predicted image data to the selector 71.

- the motion compensation unit 90 performs motion compensation processing based on the inter prediction information input from the lossless decoding unit 62 and the reference image data from the frame memory 69, and generates predicted image data. Then, the motion compensation unit 90 outputs the generated predicted image data to the selector 71.

- the processing by the deblocking filter in the existing image coding scheme such as H.264 / AVC or HEVC includes two types of processing: filtering necessity determination processing and filtering processing.

- filtering necessity determination processing and filtering processing.

- the filtering necessity determination process is a process for determining whether or not a deblocking filter should be applied for each block boundary in the input image.

- the block boundary includes a vertical boundary between adjacent blocks on the left and right and a horizontal boundary between adjacent blocks on the upper and lower sides.

- the block size of 8 ⁇ 8 pixels is the smallest processing unit.

- there are four 8 ⁇ 8 pixel blocks in a 16 ⁇ 16 pixel macroblock, one (left) vertical boundary and one (top) horizontal boundary per block, ie 4 + 4 Eight boundaries are subject to determination.

- the term “macroblock” includes a coding unit (CU) in the context of HEVC.

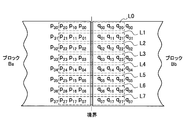

- FIG. 3 is an explanatory diagram illustrating an example of pixels in two blocks Ba and Bb that are adjacent to each other across a boundary.

- blocks adjacent to each other across the boundary are referred to as adjacent blocks.

- a vertical boundary will be described as an example, but it should be understood that the matters described here are equally applicable to a horizontal boundary.

- the pixels in the block Ba are indicated by the symbol p ij .

- i is a column index and j is a row index.

- the column index i is numbered 0, 1, 2, 3 in order from the column close to the vertical boundary (from right to left).

- the row index j is numbered 0, 1, 2,..., 7 from top to bottom. Note that the left half of the block Ba is omitted in the figure.

- the pixels in the block Bb are indicated by the symbol q kj .

- k is a column index and j is a row index.

- the column index k is numbered 0, 1, 2, 3 in order from the column close to the vertical boundary (from left to right).

- the right half of the block Bb is also omitted in the drawing.

- Whether the deblocking filter should be applied to the vertical boundary between the blocks Ba and Bb shown in FIG. 3 can be determined according to the following conditions:

- Condition A (A1) Block Ba or Bb is the intra prediction mode; (A2) Block Ba or Bb has a non-zero orthogonal transform coefficient; or (A3)

- the motion vector of the block Ba with Qpel (1/4 pixel) accuracy is (MVAx, MVAy), and the motion vector of the block Bb is (MVBx, MVBy).

- ⁇ in the condition B is an edge determination threshold value. The initial value of ⁇ is given according to the quantization parameter. Also, the value of ⁇ can be specified by the user with a parameter in the slice header.

- the second and fifth of each block The pixels in the 1st row (the top row is 0th) are referenced. Then, the deblocking filter is applied to the blocks on the left and right of the vertical boundary where it is determined that the deblocking filter should be applied according to the determination condition described above. Similarly, in the filtering necessity determination process for the horizontal boundary, the pixels in the second and fifth columns of each block (not shown in FIG. 4) are referred to. Then, the deblocking filter is applied to the blocks above and below the vertical boundary for which it is determined that the deblocking filter should be applied according to the above-described determination conditions.

- Luminance component filtering-Intensity selection Select filter intensity for each row (or for each column). A strong filter is selected if all of the following conditions C1 to C3 are satisfied, and a weak filter is selected if any one of the following conditions is not satisfied: (C1) d ⁇ ( ⁇ >> 2) (C2) (

- j is a row index for a vertical boundary and a column index for a horizontal boundary.

- ⁇ Clip ( ⁇ t C , t C , (13 (q 0j ⁇ p 0j ) +4 (q 1j ⁇ p 1j ) ⁇ 5 (q 2j ⁇ p 2j ) +16) >> 5))

- p 0j Clip 0-255 (p 0j + ⁇ )

- q 0j Clip 0-255 (q 0j - ⁇ )

- p 1j Clip 0-255 (p 1j + ⁇ / 2)

- q 1j Clip 0-255 (q 1j - ⁇ / 2)

- p 0j Clip 0-255 ((p 2j + 2p 1j + 2p 0j + 2q 0j + q 1j +4) >> 3)

- q 0j Clip 0-255 ((p 1j + 2p 0j + 2q 0j + 2q 1j + q 2j +4) >> 3)

- p 1j Clip 0-255 ((p 2j + p 1j + p 0j + q 0j +2) >> 2)

- q 1j Clip 0-255 ((p 0j + q 0j + q 1j + q 2j +2) >> 2)

- p 2j Clip 0-255 ((2p 3j + 3p 2j + p 1j + p 0j + q 0j +4) >> 3)

- q 2j Clip 0-255 ((p 0j + q 0j + 3q 2j + 2q 3j +4) >> 3)

- Clip (a, b, c) is a process of clipping the value c in the range of a ⁇ c ⁇ b

- Clip 0-255 (c) is a process of clipping the value c in the range of 0 ⁇ c ⁇ 255.

- ⁇ Clip ( ⁇ t C , t C , ((((q 0j ⁇ p 0j ) ⁇ 2) + p 1j ⁇ q 1j +4) >> 3))

- p 0j Clip 0-255 (p 0j + ⁇ )

- q 0j Clip 0-255 (q 0j - ⁇ )

- the filtering of the luminance component and the color difference component is performed for all the rows or columns of the blocks Ba and Bb (that is, for all integers j where 0 ⁇ j ⁇ 7). That is, as shown in FIG. 5, when it is determined that filtering is necessary for a certain vertical boundary, one or more pixel values of all lines L0 to L7 orthogonal to the vertical boundary are updated. Similarly, when it is determined that filtering is necessary for a certain horizontal boundary, one or more pixel values of all the lines L0 to L7 orthogonal to the horizontal boundary are updated.

- the necessity of filtering is determined for each boundary between two adjacent blocks in the image.

- a determination in units of blocks For certain boundaries, no determination is made that filtering is partially necessary. Therefore, even if image quality degradation due to block distortion appears only in some of the pixels in the block, it is only possible to choose between filtering the entire block or not filtering the entire block. .

- This is due to two adverse effects, such as a reduction in image quality due to the use of a useless deblocking filter on a portion having good image quality, and a loss of an opportunity to improve image quality due to the fact that the deblocking filter is not applied to a portion having deteriorated image quality. Is included. Therefore, in the two embodiments of the deblocking filter described below, in order to eliminate such an adverse effect, the range to which the deblocking filter should be applied is determined with a smaller granularity.

- the block determination unit 110 performs determination on the determination condition for the block unit as a process before the line determination unit 120 performs the line unit determination.

- the determination condition for each block is typically a condition based on at least one of a transform coefficient and a coding parameter of two adjacent blocks that sandwich the boundary.

- the transform coefficient may be, for example, an orthogonal transform coefficient.

- the encoding parameter may be, for example, one or both of the prediction mode and the motion vector.

- the determination condition for each block may be, for example, the determination condition A of the luminance component determination condition and the determination condition A1 of the color difference component in the existing method described above.

- the block determination unit 110 is supplied with determination information about adjacent blocks adjacent to each other across each boundary.

- the determination information supplied here includes, for example, mode information, conversion coefficient information, and motion vector information.

- the block determination part 110 determines whether the following conditions A are satisfy

- the block determination unit 110 causes the line determination unit 120 to further perform determination on a line basis for the boundary that satisfies the condition A. On the other hand, the block determination unit 110 causes the line determination unit 120 to skip line-by-line determination for a boundary that does not satisfy the condition A.

- the block determination unit 110 determines whether or not the following condition A1 is satisfied as the determination of the color difference component in units of blocks for each boundary: -Condition A1: For the color difference component in which the block Ba or Bb is in the intra prediction mode, the line determination unit 120 does not have to perform determination in units of lines. In this case, for the boundary satisfying the condition A1, the color difference components of all the lines of the boundary are filtered by the filtering unit 140. For the boundary that does not satisfy the condition A1, the color difference components of all the lines of the boundary are not filtered.

- the determination in units of blocks by the block determination unit 110 described here is merely an example. That is, a determination condition in block units different from the determination conditions described above may be used. For example, any one of the determination conditions A1 to A3 may be omitted, or another condition may be added. Further, for the color difference component, determination in units of lines as described below may be performed without being omitted.

- the line determination unit 120 determines, for each line orthogonal to each boundary, whether or not to apply the deblocking filter to two adjacent blocks adjacent to each other with the boundary interposed therebetween.

- d is a determination parameter

- ⁇ is the above-described edge determination threshold.

- I is an index of a line. If the size of each block is 8 ⁇ 8 pixels, i is an integer of 0 ⁇ i ⁇ 7.

- the line determination unit 120 calculates the value of the determination parameter d from only the reference pixel values belonging to the one line of the two adjacent blocks Ba and Bb according to the condition B ′. To do. Then, the line determination unit 120 compares the calculated determination parameter d with the determination threshold ( ⁇ >> 1). In this way, by referring to only the line when determining a certain line, it is possible to realize determination for each line with a relatively simple configuration in which each line is sequentially accessed.

- the line determination unit 120 causes, for example, filter strength selection by the strength selection unit 130 and filtering by the filtering unit 140 to be performed on a line that satisfies the condition B ′. On the other hand, the line determination unit 120 skips the filter strength selection by the strength selection unit 130 and the filtering by the filtering unit 140 for lines that do not satisfy the condition B ′.

- the intensity selection unit 130 selects the deblocking filter strength applied to each line by the filtering unit 140 for each line. More specifically, the strength selecting unit 130 selects the filter strength as follows for each line determined by the line determining unit 120 to apply the deblocking filter: -Intensity selection: Select filter strength for each line.

- a strong filter is selected if all of the following conditions C1 'to C3 are satisfied, and a weak filter is selected if any one of the following conditions is not satisfied: (C1 ′) d ⁇ ( ⁇ >> 3) (C2) (

- d is a determination parameter calculated in the determination of the condition B ′ described above. Note that such filter strength selection can be performed only for the luminance component. Then, the strength selection unit 130 outputs information indicating the selected filter strength (for example, a flag indicating one of the strong filter and the weak filter) to the filtering unit 140 for each line.

- the filtering unit 140 applies a deblocking filter to each line of two adjacent blocks that are adjacent to each other across each boundary according to the determination results by the block determination unit 110 and the line determination unit 120.

- the configuration of the filter of the filtering unit 140 may be the same as the existing method described above.

- the filtering unit 140 calculates the pixel value after filtering for each line determined to be applied with the deblocking filter by the line determination unit 120 as follows.

- ⁇ Clip ( ⁇ t C , t C , (13 (q 0i ⁇ p 0i ) +4 (q 1i ⁇ p 1i ) ⁇ 5 (q 2i ⁇ p 2i ) +16) >> 5))

- p 0i Clip 0-255 (p 0i + ⁇ )

- q 0i Clip 0-255 (q 0i - ⁇ )

- p 1i Clip 0-255 (p 1i + ⁇ / 2)

- q 1i Clip 0-255 (q 1i - ⁇ / 2)

- p 0i Clip 0-255 ((p 2i + 2p 1i + 2p 0i + 2q 0i + q 1i +4) >> 3)

- q 0i Clip 0-255 ((p 1i + 2p 0i + 2q 0i + 2q 1i + q 2i +4) >> 3)

- p 1i Clip 0-255 ((p 2i + p 1i + p 0i + q 0i +2) >> 2)

- q 1i Clip 0-255 ((p 0i + q 0i + q 1i + q 2i +2) >> 2)

- p 2i Clip 0-255 ((2p 3i + 3p 2i + p 1i + p 0i + q 0i +4) >> 3)

- q 2i Clip 0-255 ((p 0i + q 0i + q 1i + 3q 2i +4) >> 3)

- ⁇ Clip ( ⁇ t C , t C , ((((q 0i ⁇ p 0i ) ⁇ 2) + p 1i ⁇ q 1i +4) >> 3))

- p 0i Clip 0-255 (p 0i + ⁇ )

- q 0i Clip 0-255 (q 0i - ⁇ )

- the filtering unit 140 sequentially outputs the pixel value after filtering for the pixel to which the filter is applied and the pixel value of the input image for the other pixels as the pixel value of the output image.

- the determination control unit 150 controls whether the block determination unit 110 and the line determination unit 120 need to apply the deblocking filter. For example, the determination control unit 150 makes a line-by-line determination to the line determination unit 120 for a boundary determined by the block determination unit 110 that the deblocking filter is not applied based on the transform coefficient or coding parameter of the adjacent block. Let me skip.

- the determination control unit 150 may dynamically switch the granularity of determination, that is, the size of the determination unit. More specifically, the determination control unit 150 may cause the block determination unit 110 to perform only block-based determination for a certain image. Further, the determination control unit 150 may cause the line determination unit 120 to perform determination in units of lines regardless of the determination result in units of blocks by the block determination unit 110.

- the determination control unit 150 may select a determination in units of blocks.

- the determination control unit 150 may dynamically switch the granularity of determination based on, for example, a parameter included in a sequence parameter set, a picture parameter set, or a slice header. For example, a parameter that designates either block unit determination or line unit determination can be specified in the header described above. The parameter may be specified according to the requirements of each user who develops the device, for example. Instead, the determination control unit 150 may switch the determination granularity according to other conditions such as the size of the input image, for example.

- FIG. 7 is a flowchart illustrating an example of a process flow by the deblocking filter 24 according to the first embodiment. The processing from step S102 to step S112 in FIG. 7 is repeated for each of all the boundaries (including the vertical boundary and the horizontal boundary) in the input image.

- the block determination unit 110 determines whether one boundary to be processed (hereinafter referred to as an attention boundary) satisfies a determination condition (for example, the above-described determination condition A) in units of blocks (step S102). If the determination condition for each block is not satisfied, the subsequent processing from step S104 to step S110 is skipped. On the other hand, if the determination condition for each block is satisfied, the process proceeds to step S104.

- a determination condition for example, the above-described determination condition A

- step S104 the line determination unit 120 determines whether one processing target line (hereinafter referred to as a target line) satisfies a line-by-line determination condition (for example, the above-described determination condition B ′) (step S104). ).

- a target line a line-by-line determination condition

- step S104 determines whether one processing target line (hereinafter referred to as a target line) satisfies a line-by-line determination condition (for example, the above-described determination condition B ′) (step S104).

- a line-by-line determination condition for example, the above-described determination condition B ′

- step S106 the strength selection unit 130 selects the strength of the filter to be applied to the target line according to, for example, the above-described conditions C1 ′ to C3 (step S106).

- the filtering unit 140 applies a deblocking filter to the target line (step S108).

- step S110 If no unprocessed line remains at the boundary of interest, the process proceeds to step S112.

- step S112 when an unprocessed boundary remains in the input image, a new attention boundary is set, and the process returns to step S102 (step S112). If there is no unprocessed boundary left, the process for the input image ends.

- step S104 in the flowchart of FIG. 7 may be omitted.

- step S104 and step S106 in the flowchart of FIG. 7 can be skipped.

- FIG. 8 is a block diagram illustrating an example of a detailed configuration of the deblocking filter 24 according to the second embodiment.

- the deblocking filter 24 includes a block determination unit 110, a line determination section 220, an intensity selection section 230, a filtering section 240, and a determination control unit 150.

- the processing by the line determination section 220 can be performed for each of the boundaries determined by the block determination unit 110 as satisfying the determination condition for each block.

- the first line determination unit 222-1 determines whether or not the deblocking filter needs to be applied to the first line out of the lines orthogonal to each boundary, for example, according to the determination condition B ′ described above. Then, when it is determined that the first line satisfies the determination condition B ′, the first line determination unit 222-1 selects the first filter strength by the first intensity selection unit 232-1 and the first line for the first line. Filtering is performed by the filtering unit 242-1.

- the second line determination unit 222-2 determines whether or not the deblocking filter needs to be applied to the second line among the lines orthogonal to each boundary, for example, according to the determination condition B ′ described above. Then, when it is determined that the second line satisfies the determination condition B ′, the second line determination unit 222-2 selects the filter strength by the second intensity selection unit 232-2 and the second line for the second line. Filtering is performed by the filtering unit 242-2.

- the nth line determination unit 222-n determines whether or not the deblocking filter needs to be applied to the nth line among the lines orthogonal to each boundary, for example, according to the determination condition B ′ described above. Then, when it is determined that the nth line satisfies the determination condition B ′, the nth line determination unit 222-n selects the filter strength and the nth line for the nth line by the nth strength selection unit 232-n. Filtering is performed by the filtering unit 242-n.

- the intensity selection section 230 includes a plurality of intensity selection units 232-1 to 232-n.

- Each intensity selection unit 232 selects the intensity of the deblocking filter applied to the corresponding line, for example, according to the above-described conditions C1 ′ to C3.

- Each strength selection unit 232 then outputs information indicating the selected filter strength (for example, a flag indicating one of the strong filter and the weak filter) to the corresponding filtering unit 242 in the filtering section 240.

- the processing by the intensity selectors 232-1 to 232-n for a certain boundary can be performed in parallel.

- the filtering section 240 includes a plurality of filtering units 242-1 to 242-n.

- Each filtering unit 242 applies a deblocking filter to the corresponding lines of two adjacent blocks that are adjacent to each other across each boundary according to the determination results by the block determination unit 110 and the corresponding line determination unit 222.

- the filter configuration of each filtering unit 242 may be the same as the existing method described above. Then, each filtering unit 242 outputs the pixel value after filtering for the pixel to which the filter is applied, and the pixel value of the input image as the pixel value of the output image for the other pixels. Processing by the filtering units 242-1 to 242-n for a certain boundary can be performed in parallel.

- the determination of whether or not to apply the deblocking filter by the block determination unit 110 and the line determination section 220 may be controlled by the determination control unit 150 as in the first embodiment.

- the determination control unit 150 may control the line determination section 220 so as to determine in parallel whether to apply the deblocking filter to a plurality of lines in adjacent blocks.

- FIG. 9 is a flowchart illustrating an example of a processing flow by the deblocking filter 24 according to the second embodiment. The processing from step S202 to step S212 in FIG. 9 is repeated for each of all the boundaries (including the vertical boundary and the horizontal boundary) in the input image.

- the block determination unit 110 determines whether or not one attention boundary satisfies a determination condition (for example, the determination condition A described above) in units of blocks (step S202). If the determination condition for each block is not satisfied, the subsequent processing from step S204 to step S208 is skipped. On the other hand, if the determination condition for each block is satisfied, the process proceeds to step S204.

- a determination condition for example, the determination condition A described above

- the line determination units 222-1 to 222-n determine whether or not each line at the boundary of interest satisfies the determination condition for each line (for example, the determination condition B ′ described above) (step S204).

- the intensity selectors 232-1 to 232-n determine the intensity of the filter to be applied to each of the lines determined to be filtered by the line determination units 222-1 to 222-n among the lines of the boundary of interest. For example, the selection is performed according to the above-described conditions C1 ′ to C3 (step S206).

- the filtering units 242-1 to 242-n apply the deblocking filter to each of the lines of the boundary of interest determined as needing filtering by the line determination units 222-1 to 222-n (step S208). ).

- step S212 If there is no unprocessed boundary left, the process for the input image ends.

- step S204 in the flowchart of FIG. 9 may be omitted.

- step S204 and step S206 in the flowchart of FIG. 9 can be skipped.

- FIG. 10 is a block diagram illustrating an example of a detailed configuration of the deblocking filter 24 according to the third embodiment.

- the deblock filter 24 includes a block determination unit 110, a line determination unit 320, an intensity selection unit 330, a filtering unit 140, a control unit 350, and a parameter estimation unit 360.

- the parameter estimator 360 determines the value of the determination parameter for at least one line orthogonal to each boundary, out of the determination parameters used when the line determination unit 320 performs line-by-line determination. calculate. Then, the parameter estimation unit 360 estimates the determination parameter values for the other lines from the values calculated for the at least one line. Further, the parameter estimation unit 360 calculates and estimates the value of the strength selection parameter used when the strength selection unit 330 selects the filter strength in the same manner as the determination parameter.

- the at least one line serving as a basis for estimating parameter values for other lines is referred to as a basic line

- a line where parameter values are estimated is referred to as an estimated line.

- the estimation of the parameter value from the basic line to the estimation line may be performed by, for example, linear or nonlinear interpolation or extrapolation according to the line position.

- linear or nonlinear interpolation or extrapolation according to the line position.

- three examples of parameter estimation processing by the parameter estimation unit 360 will be described with reference to FIGS. 11A to 11C.

- FIG. 11A Two blocks Ba and Bb adjacent to each other across a boundary are shown.

- the basic lines are two lines L3 and L4 that are orthogonal to the boundary at the center of the boundary.

- the estimated lines are lines L0, L1, L2, L5, L6 and L7 other than the basic line.

- d3 i

- the parameter estimation unit 360 estimates the parameter value d2 j (j is 0 to 2, 5 to 7) for each estimation line using the calculated values of the intensity selection parameters d2 3 and d2 4 . Further, the parameter estimation unit 360 estimates the parameter value d3 j (j is 0 to 2, 5 to 7) for each estimation line using the calculated values of the intensity selection parameters d3 3 and d3 4 .

- the parameter estimation unit 360 determines the determination parameter d1 i (i is 0, 2, 4, or 6) for evaluating the above-described line-unit determination condition B ′ in relation to the first example. Calculate according to the formula described. Then, the parameter estimation unit 360 estimates the determination parameter d1 j (j is 1, 3, 5, or 7) for each estimated line by interpolation or extrapolation using the calculated determination parameter value. Similarly, the parameter estimation unit 360 calculates the parameters d2 i and d3 i for selecting the filter strength for the basic line. Then, the parameter estimation unit 360 estimates the intensity selection parameters d2 j and d3 j for each estimated line by interpolation or extrapolation using the calculated intensity selection parameter value.

- the basic lines are lines L0, L3, L4, and L7.

- the estimated lines are lines L1, L2, L5, and L6 other than the basic line.

- the parameter estimation unit 360 determines the determination parameter d1 i (i is 0, 3, 4, or 7) for evaluating the above-described line-unit determination condition B ′ in relation to the first example. Calculate according to the formula described. Then, the parameter estimation unit 360 estimates the determination parameter d1 j (j is 1, 2, 5, or 6) for each estimated line by interpolation using the calculated determination parameter value. Similarly, the parameter estimation unit 360 calculates the parameters d2 i and d3 i for selecting the filter strength for the basic line. Then, the parameter estimation unit 360 estimates the intensity selection parameters d2 j and d3 j for each estimation line by interpolation using the calculated intensity selection parameter value.

- the parameter estimation unit 360 outputs the value of the determination parameter calculated and estimated according to any of these three examples to the line determination unit 320, for example. Further, the parameter estimation unit 360 outputs the value of the intensity selection parameter calculated and estimated in the same manner to the intensity selection unit 330.

- the basic line set in the first example is a line perpendicular to the boundary at the center of the boundary.

- the pixel values of the pixels belonging to these basic lines are not updated by the deblocking filter applied along the same direction as the boundary.

- the difference in the line position between the basic line and the estimated line is smaller, so the parameter value can be estimated with higher accuracy. Can be realized.

- estimation accuracy can be further improved by estimating the parameter value for the estimated line only by interpolation.

- the line determination unit 320 determines, for each line orthogonal to each boundary, whether or not to apply the deblocking filter to two adjacent blocks adjacent to each other with the boundary interposed therebetween. In the present embodiment, the determination by the line determination unit 320 is performed using the determination parameter calculated or estimated by the parameter estimation unit 360.

- the determination condition for each line may be the same condition as the determination condition B ′ described above. -Condition B ': d1 i ⁇ ( ⁇ >> 1) If the size of each block is 8 ⁇ 8 pixels, i is an integer of 0 ⁇ i ⁇ 7.

- the line determination unit 320 may cause the strength selection unit 330 to select the filter strength for only the line that satisfies the condition B ′, for example. Instead, the determination by the line determination unit 320 and the selection of the filter strength by the strength selection unit 330 may be performed in parallel. The line determination unit 320 skips filtering by the filtering unit 140 for lines that do not satisfy the condition B ′.

- the intensity selection unit 330 selects the strength of the deblocking filter applied to each line by the filtering unit 140 for each line.

- the intensity selection by the intensity selection unit 330 is performed using the intensity selection parameter calculated or estimated by the parameter estimation unit 360. For example, for each line, the intensity selection unit 330 selects a strong filter when all of the following conditions C1 ′ to C3 are satisfied, and selects a weak filter when any one of the conditions is not satisfied.

- the determination parameter d1 i described above is also an intensity selection parameter in this case.

- the strength selection unit 330 outputs information representing the selected filter strength to the filtering unit 140 for each line.

- the control unit 350 controls parameter estimation processing by the parameter estimation unit 360 in addition to the control described in relation to the determination control unit 150 of the first and second embodiments. For example, the control unit 350 recognizes the line position of the processing target line and identifies whether each line is a basic line or an estimated line. The control unit 350 first causes the parameter estimation unit 360 to calculate the basic line determination parameter d1 and the basic line intensity selection parameters d2 and d3 from the pixel values of the basic line. Thereafter, the control unit 350 causes the parameter estimation unit 360 to estimate the estimation line determination parameter d1 and the estimation line intensity selection parameters d2 and d3 from the parameter values calculated for the basic line.

- FIG. 12 is a flowchart illustrating an example of a processing flow by the deblocking filter 24 according to the third embodiment. The processing from step S302 to step S318 in FIG. 12 is repeated for each of all the boundaries (including the vertical boundary and the horizontal boundary) in the input image.

- the block determination unit 110 determines whether or not one target boundary satisfies a determination unit for each block (for example, the above-described determination condition A) (step S302). If the determination condition for each block is not satisfied, the subsequent processing from step S304 to step S316 is skipped. On the other hand, if the determination condition for each block is satisfied, the process proceeds to step S304.

- a determination unit for each block for example, the above-described determination condition A

- step S304 the parameter estimation unit 360 calculates the determination parameter and the intensity selection parameter for the basic line orthogonal to the target boundary using the pixel values of the pixels belonging to the basic line (step S304).

- the basic line may be, for example, one or more lines set as in any of the three examples shown in FIGS. 11A to 11C.

- step S306 The processing from step S306 to step S316 is repeated for each target line, with each line orthogonal to the target boundary as the target line.

- the control unit 350 recognizes the line position of the target line and determines whether the target line is an estimated line (step S306). If the target line is an estimated line, the parameter estimation unit 360 estimates the determination parameter and the intensity selection parameter for the target line using the parameters calculated for the basic line, respectively (step S308). On the other hand, if the target line is a basic line, the process of step S308 is skipped.

- the line determination unit 320 uses the determination parameter calculated or estimated by the parameter estimation unit 360 to determine whether or not the line of interest satisfies the determination condition for each line (for example, the determination condition B ′ described above). Is determined (step S310).

- the determination condition for each line is not satisfied, the subsequent processing of step S312 and step S314 may be skipped.

- the process proceeds to step S312.

- step S312 the intensity selection unit 330 uses the intensity selection parameter calculated or estimated by the parameter estimation unit 360 to select the intensity of the filter to be applied to the target line, for example, according to the above-described conditions C1 ′ to C3. (Step S312).

- the filtering unit 140 applies the deblocking filter having the filter strength selected by the strength selecting unit 330 to the attention line (step S314).

- step S316 If no unprocessed line remains at the boundary of interest, the process proceeds to step S318.

- step S318 if an unprocessed boundary remains in the input image, a new attention boundary is set, and the process returns to step S302 (step S318). If there is no unprocessed boundary left, the process for the input image ends.

- the image encoding device 10 and the image decoding device 60 include a transmitter or a receiver in satellite broadcasting, cable broadcasting such as cable TV, distribution on the Internet, and distribution to terminals by cellular communication,

- the present invention can be applied to various electronic devices such as a recording apparatus that records an image on a medium such as an optical disk, a magnetic disk, and a flash memory, or a reproducing apparatus that reproduces an image from the storage medium.

- a recording apparatus that records an image on a medium such as an optical disk, a magnetic disk, and a flash memory

- a reproducing apparatus that reproduces an image from the storage medium.

- FIG. 13 shows an example of a schematic configuration of a television apparatus to which the above-described embodiment is applied.

- the television apparatus 900 includes an antenna 901, a tuner 902, a demultiplexer 903, a decoder 904, a video signal processing unit 905, a display unit 906, an audio signal processing unit 907, a speaker 908, an external interface 909, a control unit 910, a user interface 911, And a bus 912.

- Tuner 902 extracts a signal of a desired channel from a broadcast signal received via antenna 901, and demodulates the extracted signal. Then, the tuner 902 outputs the encoded bit stream obtained by the demodulation to the demultiplexer 903. In other words, the tuner 902 serves as a transmission unit in the television apparatus 900 that receives an encoded stream in which an image is encoded.

- the demultiplexer 903 separates the video stream and audio stream of the viewing target program from the encoded bit stream, and outputs each separated stream to the decoder 904. In addition, the demultiplexer 903 extracts auxiliary data such as EPG (Electronic Program Guide) from the encoded bit stream, and supplies the extracted data to the control unit 910. Note that the demultiplexer 903 may perform descrambling when the encoded bit stream is scrambled.

- EPG Electronic Program Guide

- the decoder 904 decodes the video stream and audio stream input from the demultiplexer 903. Then, the decoder 904 outputs the video data generated by the decoding process to the video signal processing unit 905. In addition, the decoder 904 outputs audio data generated by the decoding process to the audio signal processing unit 907.

- the video signal processing unit 905 reproduces the video data input from the decoder 904 and causes the display unit 906 to display the video.

- the video signal processing unit 905 may cause the display unit 906 to display an application screen supplied via a network.

- the video signal processing unit 905 may perform additional processing such as noise removal on the video data according to the setting.

- the video signal processing unit 905 may generate a GUI (Graphical User Interface) image such as a menu, a button, or a cursor, and superimpose the generated image on the output image.

- GUI Graphic User Interface

- the display unit 906 is driven by a drive signal supplied from the video signal processing unit 905, and displays a video or an image on a video screen of a display device (for example, a liquid crystal display, a plasma display, or an OLED).

- a display device for example, a liquid crystal display, a plasma display, or an OLED.

- the audio signal processing unit 907 performs reproduction processing such as D / A conversion and amplification on the audio data input from the decoder 904, and outputs audio from the speaker 908.

- the audio signal processing unit 907 may perform additional processing such as noise removal on the audio data.

- the external interface 909 is an interface for connecting the television apparatus 900 to an external device or a network.

- a video stream or an audio stream received via the external interface 909 may be decoded by the decoder 904. That is, the external interface 909 also has a role as a transmission unit in the television apparatus 900 that receives an encoded stream in which an image is encoded.

- the control unit 910 has a processor such as a CPU (Central Processing Unit) and a memory such as a RAM (Random Access Memory) and a ROM (Read Only Memory).

- the memory stores a program executed by the CPU, program data, EPG data, data acquired via a network, and the like.

- the program stored in the memory is read and executed by the CPU when the television device 900 is activated, for example.

- the CPU controls the operation of the television device 900 according to an operation signal input from the user interface 911, for example, by executing the program.

- the user interface 911 is connected to the control unit 910.

- the user interface 911 includes, for example, buttons and switches for the user to operate the television device 900, a remote control signal receiving unit, and the like.

- the user interface 911 detects an operation by the user via these components, generates an operation signal, and outputs the generated operation signal to the control unit 910.

- the bus 912 connects the tuner 902, the demultiplexer 903, the decoder 904, the video signal processing unit 905, the audio signal processing unit 907, the external interface 909, and the control unit 910 to each other.

- the decoder 904 has the function of the image decoding apparatus 60 according to the above-described embodiment. Accordingly, when decoding an image in the television apparatus 900, it is possible to more appropriately determine the range to which the deblocking filter is applied, and improve the image quality.

- FIG. 14 shows an example of a schematic configuration of a mobile phone to which the above-described embodiment is applied.

- a mobile phone 920 includes an antenna 921, a communication unit 922, an audio codec 923, a speaker 924, a microphone 925, a camera unit 926, an image processing unit 927, a demultiplexing unit 928, a recording / reproducing unit 929, a display unit 930, a control unit 931, an operation A portion 932 and a bus 933.

- the antenna 921 is connected to the communication unit 922.

- the speaker 924 and the microphone 925 are connected to the audio codec 923.

- the operation unit 932 is connected to the control unit 931.

- the bus 933 connects the communication unit 922, the audio codec 923, the camera unit 926, the image processing unit 927, the demultiplexing unit 928, the recording / reproducing unit 929, the display unit 930, and the control unit 931 to each other.

- the mobile phone 920 has various operation modes including a voice call mode, a data communication mode, a shooting mode, and a videophone mode, and is used for sending and receiving voice signals, sending and receiving e-mail or image data, taking images, and recording data. Perform the action.

- the analog voice signal generated by the microphone 925 is supplied to the voice codec 923.

- the audio codec 923 converts an analog audio signal into audio data, A / D converts the compressed audio data, and compresses it. Then, the audio codec 923 outputs the compressed audio data to the communication unit 922.

- the communication unit 922 encodes and modulates the audio data and generates a transmission signal. Then, the communication unit 922 transmits the generated transmission signal to a base station (not shown) via the antenna 921. In addition, the communication unit 922 amplifies a radio signal received via the antenna 921 and performs frequency conversion to acquire a received signal.

- the communication unit 922 demodulates and decodes the received signal to generate audio data, and outputs the generated audio data to the audio codec 923.

- the audio codec 923 expands the audio data and performs D / A conversion to generate an analog audio signal. Then, the audio codec 923 supplies the generated audio signal to the speaker 924 to output audio.

- the control unit 931 generates character data constituting the e-mail in response to an operation by the user via the operation unit 932.

- the control unit 931 causes the display unit 930 to display characters.

- the control unit 931 generates e-mail data in response to a transmission instruction from the user via the operation unit 932, and outputs the generated e-mail data to the communication unit 922.

- the communication unit 922 encodes and modulates email data and generates a transmission signal. Then, the communication unit 922 transmits the generated transmission signal to a base station (not shown) via the antenna 921.

- the communication unit 922 amplifies a radio signal received via the antenna 921 and performs frequency conversion to acquire a received signal.

- the communication unit 922 demodulates and decodes the received signal to restore the email data, and outputs the restored email data to the control unit 931.

- the control unit 931 displays the content of the electronic mail on the display unit 930 and stores the electronic mail data in the storage medium of the recording / reproducing unit 929.

- the recording / reproducing unit 929 has an arbitrary readable / writable storage medium.

- the storage medium may be a built-in storage medium such as a RAM or a flash memory, or an externally mounted storage medium such as a hard disk, a magnetic disk, a magneto-optical disk, an optical disk, a USB memory, or a memory card. May be.

- the camera unit 926 images a subject to generate image data, and outputs the generated image data to the image processing unit 927.

- the image processing unit 927 encodes the image data input from the camera unit 926 and stores the encoded stream in the storage medium of the recording / playback unit 929.

- the demultiplexing unit 928 multiplexes the video stream encoded by the image processing unit 927 and the audio stream input from the audio codec 923, and the multiplexed stream is the communication unit 922. Output to.

- the communication unit 922 encodes and modulates the stream and generates a transmission signal. Then, the communication unit 922 transmits the generated transmission signal to a base station (not shown) via the antenna 921.

- the communication unit 922 amplifies a radio signal received via the antenna 921 and performs frequency conversion to acquire a received signal.

- These transmission signal and reception signal may include an encoded bit stream.

- the communication unit 922 demodulates and decodes the received signal to restore the stream, and outputs the restored stream to the demultiplexing unit 928.

- the demultiplexing unit 928 separates the video stream and the audio stream from the input stream, and outputs the video stream to the image processing unit 927 and the audio stream to the audio codec 923.

- the image processing unit 927 decodes the video stream and generates video data.

- the video data is supplied to the display unit 930, and a series of images is displayed on the display unit 930.

- the audio codec 923 decompresses the audio stream and performs D / A conversion to generate an analog audio signal. Then, the audio codec 923 supplies the generated audio signal to the speaker 924 to output audio.

- the image processing unit 927 has the functions of the image encoding device 10 and the image decoding device 60 according to the above-described embodiment. Accordingly, when encoding and decoding an image with the mobile phone 920, it is possible to more appropriately determine a range to which the deblocking filter is applied, and to improve the image quality.

- FIG. 15 shows an example of a schematic configuration of a recording / reproducing apparatus to which the above-described embodiment is applied.

- the recording / reproducing device 940 encodes audio data and video data of a received broadcast program and records the encoded data on a recording medium.

- the recording / reproducing device 940 may encode audio data and video data acquired from another device and record them on a recording medium, for example.

- the recording / reproducing device 940 reproduces data recorded on the recording medium on a monitor and a speaker, for example, in accordance with a user instruction. At this time, the recording / reproducing device 940 decodes the audio data and the video data.

- the recording / reproducing device 940 includes a tuner 941, an external interface 942, an encoder 943, an HDD (Hard Disk Drive) 944, a disk drive 945, a selector 946, a decoder 947, an OSD (On-Screen Display) 948, a control unit 949, and a user interface. 950.

- Tuner 941 extracts a signal of a desired channel from a broadcast signal received via an antenna (not shown), and demodulates the extracted signal. Then, the tuner 941 outputs the encoded bit stream obtained by the demodulation to the selector 946. That is, the tuner 941 has a role as a transmission unit in the recording / reproducing apparatus 940.

- the external interface 942 is an interface for connecting the recording / reproducing apparatus 940 to an external device or a network.

- the external interface 942 may be, for example, an IEEE 1394 interface, a network interface, a USB interface, or a flash memory interface.

- video data and audio data received via the external interface 942 are input to the encoder 943. That is, the external interface 942 serves as a transmission unit in the recording / reproducing device 940.

- the encoder 943 encodes video data and audio data when the video data and audio data input from the external interface 942 are not encoded. Then, the encoder 943 outputs the encoded bit stream to the selector 946.

- the HDD 944 records an encoded bit stream in which content data such as video and audio is compressed, various programs, and other data on an internal hard disk. Also, the HDD 944 reads out these data from the hard disk when playing back video and audio.

- the disk drive 945 performs recording and reading of data to and from the mounted recording medium.

- the recording medium loaded in the disk drive 945 may be, for example, a DVD disk (DVD-Video, DVD-RAM, DVD-R, DVD-RW, DVD + R, DVD + RW, etc.) or a Blu-ray (registered trademark) disk. .

- the selector 946 selects an encoded bit stream input from the tuner 941 or the encoder 943 when recording video and audio, and outputs the selected encoded bit stream to the HDD 944 or the disk drive 945. In addition, the selector 946 outputs the encoded bit stream input from the HDD 944 or the disk drive 945 to the decoder 947 during video and audio reproduction.

- the decoder 947 decodes the encoded bit stream and generates video data and audio data. Then, the decoder 947 outputs the generated video data to the OSD 948. The decoder 904 outputs the generated audio data to an external speaker.

- the OSD 948 reproduces the video data input from the decoder 947 and displays the video. Further, the OSD 948 may superimpose a GUI image such as a menu, a button, or a cursor on the video to be displayed.

- a GUI image such as a menu, a button, or a cursor

- the control unit 949 includes a processor such as a CPU and memories such as a RAM and a ROM.

- the memory stores a program executed by the CPU, program data, and the like.

- the program stored in the memory is read and executed by the CPU when the recording / reproducing apparatus 940 is activated, for example.

- the CPU controls the operation of the recording / reproducing device 940 according to an operation signal input from the user interface 950, for example, by executing the program.

- the user interface 950 is connected to the control unit 949.

- the user interface 950 includes, for example, buttons and switches for the user to operate the recording / reproducing device 940, a remote control signal receiving unit, and the like.

- the user interface 950 detects an operation by the user via these components, generates an operation signal, and outputs the generated operation signal to the control unit 949.

- the encoder 943 has the function of the image encoding apparatus 10 according to the above-described embodiment.

- the decoder 947 has the function of the image decoding device 60 according to the above-described embodiment.

- FIG. 16 illustrates an example of a schematic configuration of an imaging apparatus to which the above-described embodiment is applied.

- the imaging device 960 images a subject to generate an image, encodes the image data, and records it on a recording medium.

- the imaging device 960 includes an optical block 961, an imaging unit 962, a signal processing unit 963, an image processing unit 964, a display unit 965, an external interface 966, a memory 967, a media drive 968, an OSD 969, a control unit 970, a user interface 971, and a bus. 972.

- the optical block 961 is connected to the imaging unit 962.

- the imaging unit 962 is connected to the signal processing unit 963.

- the display unit 965 is connected to the image processing unit 964.

- the user interface 971 is connected to the control unit 970.

- the bus 972 connects the image processing unit 964, the external interface 966, the memory 967, the media drive 968, the OSD 969, and the control unit 970 to each other.

- the optical block 961 includes a focus lens and a diaphragm mechanism.

- the optical block 961 forms an optical image of the subject on the imaging surface of the imaging unit 962.

- the imaging unit 962 includes an image sensor such as a CCD or a CMOS, and converts an optical image formed on the imaging surface into an image signal as an electrical signal by photoelectric conversion. Then, the imaging unit 962 outputs the image signal to the signal processing unit 963.

- the signal processing unit 963 performs various camera signal processing such as knee correction, gamma correction, and color correction on the image signal input from the imaging unit 962.

- the signal processing unit 963 outputs the image data after the camera signal processing to the image processing unit 964.