KR20180062399A - 동화상 편집 장치 및 동화상 편집 방법 - Google Patents

동화상 편집 장치 및 동화상 편집 방법 Download PDFInfo

- Publication number

- KR20180062399A KR20180062399A KR1020170161463A KR20170161463A KR20180062399A KR 20180062399 A KR20180062399 A KR 20180062399A KR 1020170161463 A KR1020170161463 A KR 1020170161463A KR 20170161463 A KR20170161463 A KR 20170161463A KR 20180062399 A KR20180062399 A KR 20180062399A

- Authority

- KR

- South Korea

- Prior art keywords

- editing

- moving image

- emotion

- temporal

- processing

- Prior art date

Links

- 238000000034 method Methods 0.000 title claims description 62

- 230000008451 emotion Effects 0.000 claims abstract description 133

- 230000002123 temporal effect Effects 0.000 claims description 86

- 238000012545 processing Methods 0.000 claims description 69

- 230000000694 effects Effects 0.000 claims description 17

- 230000008909 emotion recognition Effects 0.000 abstract description 39

- 238000012986 modification Methods 0.000 description 12

- 230000004048 modification Effects 0.000 description 12

- 238000004891 communication Methods 0.000 description 9

- 238000010586 diagram Methods 0.000 description 6

- 238000004458 analytical method Methods 0.000 description 3

- 230000005540 biological transmission Effects 0.000 description 3

- 230000003247 decreasing effect Effects 0.000 description 3

- 238000005401 electroluminescence Methods 0.000 description 2

- 230000002996 emotional effect Effects 0.000 description 2

- 230000006870 function Effects 0.000 description 2

- 230000006835 compression Effects 0.000 description 1

- 238000007906 compression Methods 0.000 description 1

- 238000013461 design Methods 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 230000007935 neutral effect Effects 0.000 description 1

- 239000007787 solid Substances 0.000 description 1

- 230000002194 synthesizing effect Effects 0.000 description 1

- 230000000007 visual effect Effects 0.000 description 1

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/47—End-user applications

- H04N21/472—End-user interface for requesting content, additional data or services; End-user interface for interacting with content, e.g. for content reservation or setting reminders, for requesting event notification, for manipulating displayed content

- H04N21/47205—End-user interface for requesting content, additional data or services; End-user interface for interacting with content, e.g. for content reservation or setting reminders, for requesting event notification, for manipulating displayed content for manipulating displayed content, e.g. interacting with MPEG-4 objects, editing locally

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T11/00—2D [Two Dimensional] image generation

- G06T11/60—Editing figures and text; Combining figures or text

-

- G—PHYSICS

- G11—INFORMATION STORAGE

- G11B—INFORMATION STORAGE BASED ON RELATIVE MOVEMENT BETWEEN RECORD CARRIER AND TRANSDUCER

- G11B27/00—Editing; Indexing; Addressing; Timing or synchronising; Monitoring; Measuring tape travel

- G11B27/02—Editing, e.g. varying the order of information signals recorded on, or reproduced from, record carriers

- G11B27/031—Electronic editing of digitised analogue information signals, e.g. audio or video signals

-

- G—PHYSICS

- G11—INFORMATION STORAGE

- G11B—INFORMATION STORAGE BASED ON RELATIVE MOVEMENT BETWEEN RECORD CARRIER AND TRANSDUCER

- G11B27/00—Editing; Indexing; Addressing; Timing or synchronising; Monitoring; Measuring tape travel

- G11B27/10—Indexing; Addressing; Timing or synchronising; Measuring tape travel

- G11B27/19—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier

- G11B27/22—Means responsive to presence or absence of recorded information signals

-

- G—PHYSICS

- G11—INFORMATION STORAGE

- G11B—INFORMATION STORAGE BASED ON RELATIVE MOVEMENT BETWEEN RECORD CARRIER AND TRANSDUCER

- G11B27/00—Editing; Indexing; Addressing; Timing or synchronising; Monitoring; Measuring tape travel

- G11B27/10—Indexing; Addressing; Timing or synchronising; Measuring tape travel

- G11B27/19—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier

- G11B27/28—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier by using information signals recorded by the same method as the main recording

-

- G—PHYSICS

- G11—INFORMATION STORAGE

- G11B—INFORMATION STORAGE BASED ON RELATIVE MOVEMENT BETWEEN RECORD CARRIER AND TRANSDUCER

- G11B27/00—Editing; Indexing; Addressing; Timing or synchronising; Monitoring; Measuring tape travel

- G11B27/10—Indexing; Addressing; Timing or synchronising; Measuring tape travel

- G11B27/19—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier

- G11B27/28—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier by using information signals recorded by the same method as the main recording

- G11B27/32—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier by using information signals recorded by the same method as the main recording on separate auxiliary tracks of the same or an auxiliary record carrier

- G11B27/322—Indexing; Addressing; Timing or synchronising; Measuring tape travel by using information detectable on the record carrier by using information signals recorded by the same method as the main recording on separate auxiliary tracks of the same or an auxiliary record carrier used signal is digitally coded

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L25/00—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00

- G10L25/48—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use

- G10L25/51—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use for comparison or discrimination

- G10L25/63—Speech or voice analysis techniques not restricted to a single one of groups G10L15/00 - G10L21/00 specially adapted for particular use for comparison or discrimination for estimating an emotional state

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Health & Medical Sciences (AREA)

- Signal Processing (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- Psychiatry (AREA)

- Computational Linguistics (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Hospice & Palliative Care (AREA)

- General Health & Medical Sciences (AREA)

- Acoustics & Sound (AREA)

- Child & Adolescent Psychology (AREA)

- Databases & Information Systems (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Television Signal Processing For Recording (AREA)

- Management Or Editing Of Information On Record Carriers (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

Abstract

동화상 편집 장치(100)에 있어서, 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 감정 인식부(107c)와, 감정 인식부(107c)에 의해 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 동화상을 편집하는 시간적 부분을 특정하는 특정부(107d)와, 특정부(107d)에 의해서 특정된 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 편집 처리부(107e)를 구비한다.

Description

본 발명은 동화상 편집 장치 및 동화상 편집 방법에 관한 것이다.

근래, 음성 데이터로부터 사람의 감정을 분석하는 감정 분석 기술이 실용화 레벨로 되고 있다. 그리고, 일본국 특허공개공보 제2009-288446호에 기재되어 있는 바와 같이, 이 감정 분석 기술을 이용하는 것에 의해, 예를 들면 가창자와 듣는 사람이 찍혀 있는 가라오케의 영상으로부터 듣는 사람의 감정을 추정하고, 그 감정에 따라 원래의 가라오케의 영상에 텍스트나 화상을 합성한다는 기술이 제안되어 있다.

그러나, 상기 특허문헌 1에 개시되어 있는 기술의 경우, 텍스트나 화상을 합성하는 것이기는 하지만, 편집의 효과가 약하다는 문제가 있다.

본 발명은 이러한 문제를 감안해서 이루어진 것으로서, 동화상을 더욱 효과적으로 편집하는 것을 목적으로 한다.

본 발명에 관한 동화상 편집 장치는 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 소정의 감정을 인식하는 인식 수단과, 상기 인식 수단에 의해 상기 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 상기 동화상을 편집하는 시간적 부분을 특정하는 특정 수단과, 상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 편집 수단을 구비한다.

또, 본 발명에 관한 동화상 편집 장치는 편집 대상의 동화상에 포함되는 음성만으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 인식 수단과, 상기 인식 수단에 의한 인식 결과에 따라, 상기 동화상을 편집하는 시간적 부분을 특정하는 특정 수단과, 상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 편집 수단을 구비한다.

또, 본 발명에 관한 동화상 편집 장치는 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 인식 수단과, 상기 인식 수단에 의한 인식 결과에 따라, 상기 동화상을 편집하는 시간적 부분을 특정하는 특정 수단과, 상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에, 편집의 효과가 시간적으로 변화하는 편집 처리를 실시하는 편집 수단을 구비한다.

또, 본 발명에 관한 동화상 편집 방법은 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 소정의 감정을 인식하는 처리와, 상기 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 상기 동화상을 편집하는 시간적 부분을 특정하는 처리와, 특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 처리를 포함한다.

또, 본 발명에 관한 동화상 편집 방법은 편집 대상의 동화상에 포함되는 음성으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 처리와, 상기 인물의 감정의 인식 결과에 따라, 상기 동화상을 편집하는 시간적 부분을 특정하는 처리와, 특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 처리를 포함한다.

또, 본 발명에 관한 동화상 편집 방법은 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 처리와, 상기 인물의 감정의 인식 결과에 따라, 상기 동화상을 편집하는 시간적 부분을 특정하는 처리와, 특정된 상기 동화상을 편집하는 시간적 부분에, 편집의 효과가 시간적으로 변화하는 편집 처리를 실시하는 처리를 포함한다.

본 발명에 의하면, 동화상을 더욱 효과적으로 편집할 수 있다.

도 1은 본 발명을 적용한 실시형태의 동화상 편집 장치의 개략 구성을 나타내는 도면이다.

도 2a는 제 1 테이블의 일예를 나타내는 도면이다.

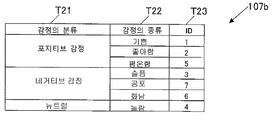

도 2b는 제 2 테이블의 일예를 나타내는 도면이다.

도 3은 동화상 편집 처리에 관한 동작의 일예를 나타내는 흐름도이다.

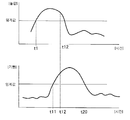

도 4a는 감정의 인식 개시 위치와 인식 종료 위치의 일예를 나타내는 도면이다.

도 4b는 감정의 인식 개시 위치와 인식 종료 위치의 그 밖의 예를 나타내는 도면이다.

도 2a는 제 1 테이블의 일예를 나타내는 도면이다.

도 2b는 제 2 테이블의 일예를 나타내는 도면이다.

도 3은 동화상 편집 처리에 관한 동작의 일예를 나타내는 흐름도이다.

도 4a는 감정의 인식 개시 위치와 인식 종료 위치의 일예를 나타내는 도면이다.

도 4b는 감정의 인식 개시 위치와 인식 종료 위치의 그 밖의 예를 나타내는 도면이다.

이하에, 본 발명에 대해, 도면을 이용해서 구체적인 양태를 설명한다. 단, 발명의 범위는 도시예에 한정되지 않는다.

도 1은 본 발명을 적용한 실시형태의 동화상 편집 장치(100)의 개략 구성을 나타내는 블럭도이다.

도 1에 나타내는 바와 같이, 본 실시형태의 동화상 편집 장치(100)는 중앙 제어부(101)와, 메모리(102)와, 기록부(103)와, 표시부(104)와, 조작 입력부(105)와, 통신 제어부(106)와, 동화상 편집부(107)를 구비하고 있다.

또, 중앙 제어부(101), 메모리(102), 기록부(103), 표시부(104), 조작 입력부(105), 통신 제어부(106) 및 동화상 편집부(107)는 버스 라인(108)을 통해 접속되어 있다.

중앙 제어부(101)는 동화상 편집 장치(100)의 각 부를 제어하는 것이다. 구체적으로는 중앙 제어부(101)는 도시는 생략하지만, CPU(Central Processing Unit) 등을 구비하며, 동화상 편집 장치(100)용의 각종 처리 프로그램(도시 생략)에 따라 각종 제어 동작을 실행한다.

메모리(102)는 예를 들면, DRAM(Dynamic Random Access Memory) 등에 의해 구성되며, 중앙 제어부(101), 동화상 편집부(107) 등에 의해서 처리되는 데이터 등을 일시적으로 저장한다.

기록부(103)는 예를 들면, SSD(Solid State Drive) 등으로 구성되며, 도시하지 않은 화상 처리부에 의해 소정의 압축 형식(예를 들면, JPEG 형식, MPEG 형식 등)으로 부호화된 정지 화상이나 동화상의 화상 데이터를 기록한다. 또한, 기록부(103)는 예를 들면, 기록 매체(도시 생략)가 착탈 자유롭게 구성되며, 장착된 기록 매체로부터의 데이터의 리드나 기록 매체에 대한 데이터의 라이트를 제어하는 구성이어도 좋다. 또, 기억부(103)는 후술하는 통신 제어부(106)를 통해 네트워크에 접속되어 있는 상태에서, 소정의 서버 장치의 기억 영역을 포함하는 것이어도 좋다.

표시부(104)는 표시 패널(104a)의 표시 영역에 화상을 표시한다.

즉, 표시부(104)는 도시하지 않은 화상 처리부에 의해 복호된 소정 사이즈의 화상 데이터에 의거하여, 동화상이나 정지 화상을 표시 패널(104a)의 표시 영역에 표시한다.

또한, 표시 패널(104a)은 예를 들면, 액정 표시 패널이나 유기 EL(Electro-Luminescence) 표시 패널 등으로 구성되어 있지만, 일예이며 이들에 한정되는 것은 아니다.

조작 입력부(105)는 동화상 편집 장치(100)의 소정 조작을 실행하기 위한 것이다. 구체적으로는 조작 입력부(105)는 전원의 ON/OFF 조작에 관한 전원 버튼, 각종 모드나 기능 등의 선택 지시에 관한 버튼 등(모두 도시 생략)을 구비하고 있다.

그리고, 유저에 의해 각종 버튼이 조작되면, 조작 입력부(105)는 조작된 버튼에 따른 조작 지시를 중앙 제어부(101)에 출력한다. 중앙 제어부(101)는 조작 입력부(105)로부터 출력되고 입력된 조작 지시에 따라 소정의 동작(예를 들면, 동화상의 편집 처리 등)을 각 부에 실행시킨다.

또, 조작 입력부(105)는 표시부(104)의 표시 패널(104a)과 일체로 되어 마련된 터치 패널(105a)을 갖고 있다.

통신 제어부(106)는 통신 안테나(106a) 및 통신 네트워크를 통해 데이터의 송수신을 실행한다.

동화상 편집부(107)는 제 1 테이블(107a)과, 제 2 테이블(107b)과, 감정 인식부(107c)와, 특정부(107d)와, 편집 처리부(107e)를 구비하고 있다.

또한, 동화상 편집부(107)의 각 부는 예를 들면, 소정의 로직 회로로 구성되어 있지만, 해당 구성은 일예이며 이것에 한정되는 것은 아니다.

제 1 테이블(107a)은 도 2a에 나타내는 바와 같이, 편집 내용을 식별하기 위한 「ID」 T11, 편집의 개시 위치를 나타내는 「편집의 개시 위치」 T12, 편집의 종료 위치를 나타내는 「편집의 종료 위치」 T13, 편집 처리의 내용을 나타내는 「편집 처리의 내용」 T14의 항목을 갖는다.

제 1 테이블(107a)에 있어서, 예를 들면 「ID」 T11의 항목의 번호 「1」에 대응하는 편집의 개시 위치는 「감정의 인식 개시 위치의 소정 시간 전」이며, 편집의 종료 위치는 「감정의 피크 위치」이다. 즉, 감정 인식부(107c)에 의해 소정의 감정(예를 들면, 기쁨의 감정)이 인식된 시간적 위치, 즉 해당 소정의 감정의 인식 개시 위치에서 인식 종료 위치까지의 시간의 길이와는 다른 시간의 길이의 부분(시간적 위치)이 동화상을 편집하는 시간적 부분으로서 특정되도록 되어 있다.

제 2 테이블(107b)은 도 2b에 나타내는 바와 같이, 감정의 분류를 나타내는 「감정의 분류」 T21, 감정의 종류를 나타내는 「감정의 종류」 T22, 편집 내용을 특정하기 위한 번호를 나타내는 「ID」 T23의 항목을 갖는다. 여기서, 「ID」 T23의 항목이 나타내는 번호는 제 1 테이블(107a)의 「ID」 T11이 나타내는 번호와 대응하도록 구성되어 있다. 즉, 감정 인식부(107c)에 의해 감정이 인식되고 해당 감정의 종류가 특정되는 것에 의해서, 편집 내용(편집의 개시 위치, 편집의 종료 위치, 편집 처리의 내용)이 특정되도록 되어 있다.

감정 인식부(인식 수단)(107c)는 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식한다. 또한, 본 실시형태에서는 감정을 인식하는 인물은 1인으로서, 이하 설명을 실행한다.

구체적으로는 감정 인식부(107c)는 편집 대상의 동화상에 포함되는 음성 데이터(음성 부분)에 의거하여, 「기쁨」, 「좋아함」 「평온함」, 「슬픔」 「공포」, 「화남」 「놀람」의 각 감정의 정도를 시계열을 따라 나타낸 시계열 그래프를 생성한다. 여기서, 각 감정에는 해당 각 감정에 대응하는 임계값이 미리 설정되어 있다. 또한, 각 감정의 정도의 산출 처리는 공지의 음성 해석 기술을 사용함으로써 실현 가능하기 때문에, 상세한 설명은 생략한다.

그리고, 감정 인식부(107c)는 생성된 상기 시계열 그래프를 이용하여, 하기 (1)∼(4)의 수순에 따라 감정을 순차 인식한다.

(1) 도 4a에 나타내는 바와 같이, 감정(예를 들면, 「놀람」의 감정)의 정도가 해당 감정에 대응하는 임계값을 넘었다고 판별된 시점 t1을 감정의 인식 개시 위치로 한다. 단, 도 4b에 나타내는 바와 같이, 감정(예를 들면, 「기쁨」의 감정)의 정도가 해당 감정에 대응하는 임계값을 넘었다고 판별된 시점 t11이고, 이미 다른 감정(예를 들면, 「놀람」의 감정)의 정도가 해당 다른 감정에 대응하는 임계값을 넘고 있는 경우에는 해당 감정의 정도가 해당 다른 감정의 정도를 상회한 시점 t12를 감정의 인식 개시 위치로 한다.

(2) (1)에서 인식의 개시가 보인 감정의 종류를 판별한다.

(3) (1)에서 인식의 개시가 보인 감정의 정도가 해당 감정에 대응하는 임계값을 하회할 때까지의 기간, 또는 (1)에서 인식의 개시가 보인 감정의 정도가 해당 감정에 대응하는 임계값을 하회하기 전에, 해당 감정과는 다른 감정의 인식이 개시된 경우에는 이 해당 다른 감정의 인식이 개시될 때까지의 기간에 걸쳐, 순차 감정의 정도의 피크값을 갱신한다.

(4) 도 4a에 나타내는 바와 같이,(1)에서 인식의 개시가 보인 감정의 정도가 해당 감정에 대응하는 임계값을 하회했다고 판별된 시점 t10을 감정의 인식 종료 위치로 한다. 단, 도 4b에 나타내는 바와 같이, (1)에서 인식의 개시가 보인 감정(예를 들면, 「놀람」의 감정)의 정도가 해당 감정에 대응하는 임계값을 하회하기 전에, 해당 감정과는 다른 감정(예를 들면, 「기쁨」의 감정)의 인식이 개시된 경우에는 이 해당 다른 감정의 인식 개시 위치 t12를 해당 감정의 인식 종료 위치로 한다.

그리고, 감정 인식부(107c)는 음성 데이터의 최초부터 마지막까지 감정을 다 인식하면, 인식된 감정마다 감정의 인식 개시 위치, 인식 종료 위치, 종류, 피크값을 메모리(102)에 일시적으로 기록한다.

특정부(특정 수단)(107d)는 감정 인식부(107c)에 의한 감정의 인식 결과에 의거하여, 동화상을 편집하는 시간적 부분을 특정한다.

구체적으로는 특정부(107d)는 제 1 테이블(107a) 및 제 2 테이블(107b)과 메모리(102)에 일시적으로 기록되어 있는 감정의 인식 개시 위치, 인식 종료 위치, 종류, 피크값을 이용하여, 동화상을 편집하는 시간적 부분을 특정한다. 예를 들면, 감정 인식부(107c)에 의해서 「기쁨」의 감정이 인식되어 있는 경우, 특정부(107d)는 제 2 테이블(107b)을 참조하여, 메모리(102)에 일시적으로 기록되어 있는 감정의 종류 「기쁨」에 대응하는 편집 내용을 특정하기 위한 번호 「1」을 「ID」 T23의 항목으로부터 취득한다. 다음에, 특정부(107d)는 제 1 테이블(107a)을 참조하여, 취득한 편집 내용을 특정하기 위한 번호 「1」에 대응하는 편집 내용을 「편집의 개시 위치」 T12, 「편집의 종료 위치」 T13 및 「편집 처리의 내용」 T14의 항목으로부터 취득하는 것에 의해, 동화상을 편집하는 시간적 부분을 특정한다. 구체적으로는 이러한 경우, 「편집의 개시 위치」 T12의 항목으로부터, 편집의 개시 위치로서, 「감정(기쁨의 감정)의 인식 개시 위치의 소정 시간 전」이 특정되게 된다. 또, 「편집의 종료 위치」 T13의 항목으로부터, 편집의 종료 위치로서, 「감정(기쁨의 감정)의 피크 위치」가 특정되게 된다. 즉, 특정부(107d)는 감정 인식부(107c)에 의해서 인식된 감정의 종류에 대응하는 특정 양태에 의거하여, 동화상을 편집하는 시간적 부분을 특정한 것으로 된다. 또, 「편집 처리의 내용」 T14의 항목으로부터, 편집 처리의 내용으로서, 「얼굴을 검출하고 줌인, 편집의 종료 위치까지 유지」 및 「감정의 정도에 따라 줌 배율을 설정」이 특정되게 된다.

편집 처리부(편집 수단)(107e)는 감정 인식부(107c)에 의해서 인식된 감정의 종류에 대응하는 편집 양태에 의거하여, 특정부(107d)에 의해서 특정된 동화상을 편집하는 시간적 부분(「편집의 개시 위치」 T12에서 「편집의 종료 위치」 T13까지의 영상의 시간적 부분)에 편집 처리(「편집 처리의 내용」 T14)를 실시한다. 그리고, 편집 처리부(107e)는 편집 처리를 실시한 시간적 부분을 원래의 동화상의 해당 편집 처리의 대상으로서 특정된 시간적 부분과 치환한다.

구체적으로는 편집 처리부(107e)는 상술한 바와 같이, 감정 인식부(107c)에 의해서 「기쁨」의 감정이 인식되어 있는 경우, 특정부(107d)에 의해서 특정된 동화상을 편집하는 시간적 부분, 즉 「기쁨」의 감정의 인식 개시 위치의 소정 시간 전부터 피크 위치까지의 시간적 부분에 있어서, 검출된 얼굴에 줌인 처리를 실시하는 동시에, 편집의 종료 위치까지 줌인된 상태를 유지하는 처리를 실시한다. 또, 줌인 처리를 실시할 때의 줌 배율은 「기쁨」의 감정의 정도에 따른 줌 배율로 설정한다.

또, 편집 처리부(107e)는 예를 들면, 감정 인식부(107c)에 의해서 「놀람」의 감정이 인식되어 있는 경우(「ID」 T11, T23 「4」), 특정부(107d)에 의해서 특정된 동화상을 편집하는 시간적 부분, 즉 「놀람」의 감정의 피크 위치로부터 소정 시간이 경과할 때까지의 시간적 부분에 있어서, 동화상을 일시정지시키는 처리를 실시한다. 또, 일시정지시키는 시간은 「놀람」의 감정의 정도에 따른 시간으로 설정한다. 또, 편집 처리부(107e)는 예를 들면, 감정 인식부(107c)에 의해서 「공포」의 감정이 인식되어 있는 경우(「ID」 T11, T23 「7」), 특정부(107d)에 의해서 특정된 동화상을 편집하는 시간적 부분, 즉 「공포」의 감정의 인식 개시 위치에서 인식 종료 위치까지의 시간적 부분에 있어서, 동화상의 재생 속도를 느리게 하는 처리를 실시한다. 이러한 경우, 영상의 재생 속도를 느리게 하는 것에 수반하여 음성의 재생 속도도 느려진다. 이 때문에, 음성의 높이가 낮아지는 것에 의해 편집의 효과가 높아진다. 또, 이 때의 동화상의 재생 속도는 「공포」의 감정의 정도에 따른 속도로 설정한다.

여기서, 편집 처리부(107e)는 특정부(107d)에 의해서 특정된 동화상을 편집하는 시간적 부분에, 편집의 효과가 시간적으로 변화하는 편집 처리를 실시한 것으로 된다. 또, 편집 처리부(107e)는 편집의 효과가 시간적으로 변화하는 편집 처리로서, 해당 효과가 점차 변화하는 편집 처리, 또는 편집하는 원래의 동화상과는 다른 시간의 흐름으로 되는 편집 처리를 실시한 것으로 된다. 또한, 편집 처리부(107e)는 특정부(107d)에 의해서 특정된 동화상을 편집하는 시간적 부분에, 감정 인식부(107c)에 의해서 인식된 감정의 정도에 따른 편집 처리를 실시한 것으로 된다.

<동화상 편집 처리>

다음에, 동화상 편집 장치(100)에 의한 동화상 편집 처리에 대해, 도 3을 참조해서 설명한다. 도 3은 동화상 편집 처리에 관한 동작의 일예를 나타내는 흐름도이다. 이 흐름도에 기술되어 있는 각 기능은 판독 가능한 프로그램 코드의 형태로 저장되어 있고, 이 프로그램 코드에 따른 동작이 순차 실행된다. 또, 통신 제어부(106)에 의해 네트워크 등의 전송 매체를 통해 전송되어 온 상술의 프로그램 코드에 따른 동작을 순차 실행할 수도 있다. 즉, 기록 매체 이외에 전송 매체를 통해 외부 공급된 프로그램/데이터를 이용해서 본 실시형태 특유의 동작을 실행할 수도 있다.

도 3에 나타내는 바와 같이, 우선, 기록부(103)에 기록되어 있는 동화상 중, 유저에 의한 조작 입력부(105)의 소정 조작에 의거하여 편집 대상으로 되는 동화상이 지정되면(스텝 S1), 감정 인식부(107c)는 지정된 동화상을 기록부(103)로부터 읽어내고, 해당 동화상의 음성 데이터를 이용하여 해당 음성 데이터의 최초부터 마지막까지 감정을 순차 인식한다(스텝 S2).

다음에, 감정 인식부(107c)는 음성 데이터의 최초부터 마지막까지 감정의 인식이 완료했는지의 여부를 판정한다(스텝 S3).

스텝 S3에 있어서, 음성 데이터의 최초부터 마지막까지 감정의 인식이 완료되어 있지 않다고 판정된 경우(스텝 S3; NO)는 스텝 S2로 되돌리고 그 이후의 처리를 반복 실행한다. 한편, 음성 데이터의 최초부터 마지막까지 감정의 인식이 완료했다고 판정된 경우(스텝 S3; YES), 감정 인식부(107c)는 인식된 감정마다 해당 감정의 인식 개시 위치, 인식 종료 위치, 종류, 피크값을 메모리(102)에 일시적으로 기록한다(스텝 S4).

다음에, 특정부(107d)는 제 1 테이블(107a) 및 제 2 테이블(107b)과 메모리(102)에 일시적으로 기록되어 있는 감정의 인식 개시 위치, 인식 종료 위치, 종류, 피크값을 이용하여, 동화상을 편집하는 시간적 부분과 내용을 특정한다(스텝 S5).

다음에, 편집 처리부(107e)는 특정부(107d)에 의해서 특정된 동화상을 편집하는 시간적 부분에 대해, 마찬가지로 특정부(107d)에 의해서 특정된 동화상의 편집 내용에 따라 편집 처리를 실시하고, 해당 편집 처리를 실시한 시간적 부분을 원래의 동화상의 해당 편집 처리의 대상으로서 특정된 시간적 부분과 치환하여(스텝 S6), 동화상 편집 처리를 종료한다.

이상과 같이, 본 실시형태의 동화상 편집 장치(100)는 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하고, 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 해당 동화상을 편집하는 시간적 부분을 특정하고, 특정된 해당 동화상을 편집하는 시간적 부분에 편집 처리를 실시한 것으로 된다.

이 때문에, 본 실시형태의 동화상 편집 장치(100)에 의하면, 소정의 감정이 인식된 시간적 위치에 구애되는 일 없이, 해당 소정의 감정에 알맞은 동화상의 편집을 실행할 수 있으므로, 더욱 효과적인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 편집 대상의 동화상에 포함되는 음성 부분으로부터 해당 동화상에 기록되어 있는 인물의 감정을 인식하고, 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 해당 동화상을 편집하는 영상의 시간적 부분을 특정하고, 특정된 해당 동화상을 편집하는 영상의 시간적 부분에 편집 처리를 실시한 것으로 된다. 이 때문에, 본 실시형태의 동화상 편집 장치(100)에 의하면, 더욱 효과적이고 또한 비주얼인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 편집 대상의 동화상에 포함되는 음성만으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하고, 해당 인물의 감정의 인식 결과에 따라, 해당 동화상을 편집하는 시간적 부분을 특정하고, 특정된 해당 동화상을 편집하는 시간적 부분에 편집 처리를 실시한 것으로 된다. 이 때문에, 본 실시형태의 동화상 편집 장치(100)에 의하면, 동화상에 인물이 찍혀 있지 않은 경우에도, 해당 인물의 감정을 인식할 수 있다. 따라서, 인물의 감정을 인식하는 기회를 늘릴 수 있으므로, 해당 인물의 감정의 인식 결과에 따른 동화상을 편집하는 시간적 부분도 증가하고, 더욱 효과적인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하고, 해당 인물의 감정의 인식 결과에 따라, 해당 동화상을 편집하는 시간적 부분을 특정하고, 특정된 해당 동화상을 편집하는 시간적 부분에, 편집의 효과가 시간적으로 변화하는 편집 처리를 실시한 것으로 된다. 이 때문에, 본 실시형태의 동화상 편집 장치(100)에 의하면, 편집의 효과가 시간적으로 변화한다는 동화상에 적합한 편집을 실행할 수 있으므로, 더욱 효과적인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 소정의 감정이 인식된 시간의 길이와는 다른 시간의 길이의 시간적 부분을, 동화상을 편집하는 시간적 부분으로서 특정하므로, 해당 소정의 감정이 인식된 시간의 길이에 구애되는 일 없이, 해당 소정의 감정에 알맞은 동화상의 편집을 실행할 수 있으므로, 더욱 효과적인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 인식할 수 있는 감정이 복수 종류 설정되어 있는 동시에, 해당 감정의 종류에 따른 동화상을 편집하는 시간적 부분의 특정 양태가 설정되어 있고, 감정을 인식했을 때의 해당 감정의 종류를 또한 인식하고, 인식된 감정의 종류에 대응하는 특정 양태에 의거하여, 동화상을 편집하는 시간적 부분을 특정한 것으로 된다. 이 때문에, 본 실시형태의 동화상 편집 장치(100)에 의하면, 인식할 수 있는 감정에 따라, 동화상을 편집하는 시간적 부분의 특정 양태를 다양화시킬 수 있으므로, 더욱 효과적인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 인식할 수 있는 감정이 복수 종류 설정되어 있는 동시에, 해당 감정의 종류에 따른 동화상의 편집 양태가 설정되어 있고, 감정을 인식했을 때의 해당 감정의 종류를 또한 인식하고, 인식된 감정의 종류에 대응하는 편집 양태에 의거하여, 특정된 동화상을 편집하는 시간적 부분에 편집 처리를 실시한 것으로 된다. 이 때문에, 본 실시형태의 동화상 편집 장치(100)에 의하면, 인식할 수 있는 감정에 따라, 동화상을 편집하는 시간적 부분의 편집 양태에 대해서도 다양화를 도모할 수 있으므로, 가일층 효과적인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 감정을 인식했을 때의 해당 감정의 정도를 또한 인식하고, 특정된 동화상을 편집하는 시간적 부분에, 인식된 감정의 정도에 따른 편집 처리를 실시하므로, 가일층 효과적인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 편집의 효과가 시간적으로 변화하는 편집 처리로서, 해당 효과가 점차 변화하는 편집 처리, 또는 편집하는 원래의 동화상과는 다른 시간의 흐름으로 되는 편집 처리를 실시한 것으로 된다. 이 때문에, 본 실시형태의 동화상 편집 장치(100)에 의하면, 동화상을 편집하는 시간적 부분의 편집 양태를 또한 다양화할 수 있으므로, 가일층 효과적인 편집을 실행할 수 있다.

또, 본 실시형태의 동화상 편집 장치(100)는 동화상 중의 편집 처리를 실시한 시간적 부분을, 원래의 동화상의 해당 편집 처리의 대상으로서 특정된 시간적 부분과 치환하므로, 편집 처리가 실시된 시간적 부분을 일련의 동화상 중에서 볼 수 있다.

[변형예]

계속해서, 상기 실시형태의 변형예에 대해 설명한다. 또한, 상기 실시형태와 마찬가지의 구성요소에는 동일한 부호를 붙이고, 그 설명을 생략한다.

본 변형예의 동화상 편집 장치(200)는 동화상을 편집하는 영상의 부분에 편집 처리를 실시하는 동시에, BGM를 추가하는 BGM 편집을 실시하는 점에서, 상기 실시형태와 다르다.

구체적으로는 본 변형예의 제 1 테이블(207a)(도시 생략)은 「ID」 T11, 「편집의 개시 위치」 T12, 「편집의 종료 위치」 T13, 「편집 처리의 내용」 T14의 항목에 부가하여, 「BGM 편집의 개시 위치」 T15, 「BGM 편집의 종료 위치」 T16, 「BGM의 종류」 T17, 「BGM 편집 처리의 내용」 T18의 항목을 갖는다.

「BGM 편집의 개시 위치」 T15에는 「ID」 T11의 식별 번호, 즉 인식된 감정의 종류에 따라 예를 들면, 「감정의 인식 개시 위치」, 「감정의 인식 개시 위치의 소정 시간 전」, 「감정의 인식 개시 위치의 소정 시간 후」 등의 사항이 설정되어 있다.

또, 「BGM 편집의 종료 위치」 T16에는 「ID」 T11의 식별 번호에 따라, 예를 들면, 「감정의 인식 종료 위치」, 「감정의 인식 종료 위치의 소정 시간 전」, 「감정의 인식 종료 위치의 소정 시간 후」등의 사항이 설정되어 있다.

또, 「BGM의 종류」 T17에는 「ID」 T11의 식별 번호에 따라, 예를 들면, 「밝은 곡」, 「어두운 곡」, 「조용한 곡」 등의 사항이 설정되어 있다.

또, 「BGM 편집 처리의 내용」 T18에는 「ID」 T11의 식별 번호에 따라, 예를 들면, 「BGM 편집의 개시 위치에서 종료 위치를 향해 서서히 음량을 올림/내림」 「BGM 편집의 개시 위치에서 감정의 피크 위치를 향해 서서히 음량을 올림/내림」 「감정의 피크 위치에서 BGM 편집의 종료 위치를 향해 서서히 음량을 내림/올림」 등의 사항이 설정되어 있다.

이에 따라, 본 변형예의 특정부(207d)는 본 변형예의 제 1 테이블(207a)을 참조하고, 인식된 감정의 종류에 따라, 동화상의 편집의 개시 위치, 동화상의 편집의 종료 위치, 동화상의 편집 처리의 내용, BGM 편집의 개시 위치, BGM 편집의 종료 위치, BGM의 종류, BGM 편집 처리의 내용을 특정하는 것으로 된다.

그리고, 본 변형예의 편집 처리부(207e)는 상기 특정부(207d)에 의해서 특정된 내용에 의거하여, 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 동시에, 대상 부분에 BGM 편집 처리를 실시하는 것으로 된다.

또한, 본 발명은 상기 실시형태에 한정되지 않으며, 본 발명의 취지를 이탈하지 않는 범위에 있어서, 각종 개량과 설계의 변경을 실행해도 좋다.

상기 실시형태나 상기 변형예에 있어서는 제 1 테이블(107a, 207a)의 「편집 처리의 내용」 T14의 항목에 열거된 편집 처리의 내용에 따라 편집 처리가 실시되는 구성으로 했지만, 해당 편집 처리의 내용은 열거된 편집 처리의 내용에 한정되는 것은 아니다. 예를 들면, 화면 전환시의 속도를 바꾸거나 혹은 화면 전환시의 편집 효과의 종류를 바꾸는 등의 편집 처리가 실시되도록 해도 좋다.

또, 상기 실시형태나 상기 변형예에 있어서는 예를 들면, 인식된 감정의 종류에 따른 폰트의 텔롭을 넣는다는 편집 처리가 실시되도록 해도 좋다.

또, 상기 실시형태나 상기 변형예에 있어서는 인식된 감정의 종류에 따라, 편집 처리의 내용을 특정하도록 했지만, 이것에 한정되는 것은 아니며, 예를 들면, 인식된 감정의 분류(포지티브 감정, 네거티브 감정, 뉴트럴)에 따라, 편집 처리의 내용을 특정하도록 해도 좋다.

또, 상기 실시형태나 상기 변형예에 있어서는 편집 대상의 동화상에 포함되는 음성이 복수인에 의한 것인 경우, 예를 들면, 음량이 가장 큰 음성만을 대상으로 하여, 감정의 인식을 실행하도록 해도 좋다.

또, 상기 실시형태나 상기 변형예에 있어서는 예를 들면, 미리 특정의 인물의 음성을 녹음한 샘플 데이터를 기억시켜 둔다. 그리고, 감정 인식부(107c)에 의해서 감정을 인식하는 경우, 상기 샘플 데이터에 의거하는 특정 인물의 음성과 적합한 음성만을 대상으로 하여, 동화상에 기록되어 있는 인물의 감정을 인식하도록 해도 좋다. 이러한 경우에는 감정 인식부(107c)에 의해서 특정 인물의 감정만을 인식 가능하게 된다.

또, 상기 실시형태나 상기 변형예에 있어서는 편집 처리에 의해서 새로이 생성된 동화상에 대한 그 후의 처리에 대해서는 특히 언급하지 않는다. 그러나, 이와 같이 편집된 동화상은 새로운 동화상으로서 기록부(102)에 저장해도 좋다. 또, 외부로부터의 지시에 따라 편집 처리를 개시하고, 편집 후의 동화상을 메모리(102)에 일시적으로 저장하고, 재생 출력한 후에 소정의 지시 혹은 소정 시간의 경과 후, 메모리(102)로부터 소거하도록 해도 좋다.

본 발명의 실시형태를 설명했지만, 본 발명의 범위는 상술한 실시형태에 한정되는 것은 아니며, 청구의 범위에 기재된 발명의 범위와 그 균등의 범위를 포함한다.

100; 동화상 편집 장치

101; 중앙 제어부

102; 메모리 103; 기록부

104; 표시부 105; 조작 입력부

106; 통신 제어부 107; 동화상 편집부

108; 버스 라인 104a; 표시 패널

105a; 터치 패널 106a; 통신 안테나

107a; 제 1 테이블 107b; 제 2 테이블

107c; 감정 인식부 107d; 특정부

107e; 편집 처리부

102; 메모리 103; 기록부

104; 표시부 105; 조작 입력부

106; 통신 제어부 107; 동화상 편집부

108; 버스 라인 104a; 표시 패널

105a; 터치 패널 106a; 통신 안테나

107a; 제 1 테이블 107b; 제 2 테이블

107c; 감정 인식부 107d; 특정부

107e; 편집 처리부

Claims (15)

- 동화상 편집 장치로서,

편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 소정의 감정을 인식하는 인식 수단과,

상기 인식 수단에 의해 상기 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 상기 동화상을 편집하는 시간적 부분을 특정하는 특정 수단과,

상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 편집 수단을 구비하는 것을 특징으로 하는 동화상 편집 장치. - 제 1 항에 있어서,

상기 인식 수단은 상기 편집 대상의 동화상에 포함되는 음성 부분으로부터 해당 동화상에 기록되어 있는 인물의 감정을 인식하고,

상기 특정 수단은 상기 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 상기 동화상을 편집하는 영상의 시간적 부분을 특정하고,

상기 편집 수단은 상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 영상의 시간적 부분에 편집 처리를 실시하는 것을 특징으로 하는 동화상 편집 장치. - 동화상 편집 장치로서,

편집 대상의 동화상에 포함되는 음성으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 인식 수단과,

상기 인식 수단에 의한 인식 결과에 따라, 상기 동화상을 편집하는 시간적 부분을 특정하는 특정 수단과,

상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 편집 수단을 구비하는 것을 특징으로 하는 동화상 편집 장치. - 제 3 항에 있어서,

상기 특정 수단은 상기 인식 수단에 의해 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 상기 동화상을 편집하는 영상의 시간적 부분을 특정하고,

상기 편집 수단은 상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 영상의 시간적 부분에 편집 처리를 실시하는 것을 특징으로 하는 동화상 편집 장치. - 동화상 편집 장치로서,

편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 인식 수단과,

상기 인식 수단에 의한 인식 결과에 따라, 상기 동화상을 편집하는 시간적 부분을 특정하는 특정 수단과,

상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에, 편집의 효과가 시간적으로 변화하는 편집 처리를 실시하는 편집 수단을 구비하는 것을 특징으로 하는 동화상 편집 장치. - 제 1 항에 있어서,

상기 특정 수단은 상기 인식 수단에 의해 소정의 감정이 인식된 시간의 길이와는 다른 시간의 길이의 시간적 부분을, 상기 동화상을 편집하는 시간적 부분으로서 특정하는 것을 특징으로 하는 동화상 편집 장치. - 제 1 항에 있어서,

상기 인식 수단에 의해서 인식할 수 있는 감정이 복수 종류 설정되어 있는 동시에, 해당 감정의 종류에 따른 상기 동화상을 편집하는 시간적 부분의 특정 양태가 설정되어 있고,

상기 인식 수단은 상기 감정을 인식했을 때의 해당 감정의 종류를 또한 인식하고,

상기 특정 수단은 상기 인식 수단에 의해서 인식된 상기 감정의 종류에 대응하는 상기 특정 양태에 의거하여, 상기 동화상을 편집하는 시간적 부분을 특정하는 것을 특징으로 하는 동화상 편집 장치. - 제 1 항에 있어서,

상기 인식 수단에 의해서 인식할 수 있는 감정이 복수 종류 설정되어 있는 동시에, 해당 감정의 종류에 따른 동화상의 편집 양태가 설정되어 있고,

상기 인식 수단은 상기 감정을 인식했을 때의 해당 감정의 종류를 또한 인식하고,

상기 편집 수단은 상기 인식 수단에 의해서 인식된 상기 감정의 종류에 대응하는 상기 편집 양태에 의거하여, 상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 것을 특징으로 하는 동화상 편집 장치. - 제 1 항에 있어서,

상기 인식 수단은 상기 감정을 인식했을 때의 해당 감정의 정도를 또한 인식하고,

상기 편집 수단은 상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에, 상기 인식 수단에 의해서 인식된 상기 감정의 정도에 따른 편집 처리를 실시하는 것을 특징으로 하는 동화상 편집 장치. - 제 1 항에 있어서,

상기 편집 수단은 상기 특정 수단에 의해서 특정된 상기 동화상을 편집하는 시간적 부분에, 편집의 효과가 시간적으로 변화하는 편집 처리를 실시하는 것을 특징으로 하는 동화상 편집 장치. - 제 5 항에 있어서,

상기 편집 수단은 상기 편집의 효과가 시간적으로 변화하는 편집 처리로서, 해당 효과가 점차 변화하는 편집 처리, 또는 편집하는 원래의 동화상과는 다른 시간의 흐름으로 되는 편집 처리를 실시하는 것을 특징으로 하는 동화상 편집 장치. - 제 1 항에 있어서,

상기 편집 수단은 상기 동화상 중의 상기 편집 처리를 실시한 시간적 부분을, 원래의 동화상의 해당 편집 처리의 대상으로서 특정된 시간적 부분과 치환하는 것을 특징으로 하는 동화상 편집 장치. - 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 소정의 감정을 인식하는 처리와,

상기 소정의 감정이 인식된 시간적 위치와는 다른 시간적 위치인, 상기 동화상을 편집하는 시간적 부분을 특정하는 처리와,

특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 처리를 포함하는 것을 특징으로 하는 동화상 편집 방법. - 편집 대상의 동화상에 포함되는 음성만으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 처리와,

상기 인물의 감정의 인식 결과에 따라, 상기 동화상을 편집하는 시간적 부분을 특정하는 처리와,

특정된 상기 동화상을 편집하는 시간적 부분에 편집 처리를 실시하는 처리를 포함하는 것을 특징으로 하는 동화상 편집 방법. - 편집 대상의 동화상으로부터, 해당 동화상에 기록되어 있는 인물의 감정을 인식하는 처리와,

상기 인물의 감정의 인식 결과에 따라, 상기 동화상을 편집하는 시간적 부분을 특정하는 처리와,

특정된 상기 동화상을 편집하는 시간적 부분에, 편집의 효과가 시간적으로 변화하는 편집 처리를 실시하는 처리를 포함하는 것을 특징으로 하는 동화상 편집 방법.

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016232019A JP6589838B2 (ja) | 2016-11-30 | 2016-11-30 | 動画像編集装置及び動画像編集方法 |

| JPJP-P-2016-232019 | 2016-11-30 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20180062399A true KR20180062399A (ko) | 2018-06-08 |

Family

ID=62190323

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020170161463A KR20180062399A (ko) | 2016-11-30 | 2017-11-29 | 동화상 편집 장치 및 동화상 편집 방법 |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US20180151198A1 (ko) |

| JP (1) | JP6589838B2 (ko) |

| KR (1) | KR20180062399A (ko) |

| CN (1) | CN108122270A (ko) |

Families Citing this family (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| AU2011231565B2 (en) | 2010-03-26 | 2014-08-28 | Dolby International Ab | Method and device for decoding an audio soundfield representation for audio playback |

| US11601715B2 (en) * | 2017-07-06 | 2023-03-07 | DISH Technologies L.L.C. | System and method for dynamically adjusting content playback based on viewer emotions |

| CN109063163B (zh) * | 2018-08-14 | 2022-12-02 | 腾讯科技(深圳)有限公司 | 一种音乐推荐的方法、装置、终端设备和介质 |

Family Cites Families (18)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP4407198B2 (ja) * | 2003-08-11 | 2010-02-03 | ソニー株式会社 | 記録再生装置、再生装置、記録再生方法および再生方法 |

| JP4525437B2 (ja) * | 2005-04-19 | 2010-08-18 | 株式会社日立製作所 | 動画処理装置 |

| JP4085130B2 (ja) * | 2006-06-23 | 2008-05-14 | 松下電器産業株式会社 | 感情認識装置 |

| US20080068397A1 (en) * | 2006-09-14 | 2008-03-20 | Carey James E | Emotion-Based Digital Video Alteration |

| JP2009141516A (ja) * | 2007-12-04 | 2009-06-25 | Olympus Imaging Corp | 画像表示装置,カメラ,画像表示方法,プログラム,画像表示システム |

| JP2009278202A (ja) * | 2008-05-12 | 2009-11-26 | Nippon Telegr & Teleph Corp <Ntt> | 映像編集装置及び方法及びプログラム及びコンピュータ読み取り可能な記録媒体 |

| JP2009288446A (ja) * | 2008-05-28 | 2009-12-10 | Nippon Telegr & Teleph Corp <Ntt> | カラオケ映像編集装置及び方法及びプログラム |

| US8237742B2 (en) * | 2008-06-12 | 2012-08-07 | International Business Machines Corporation | Simulation method and system |

| JP2010011409A (ja) * | 2008-06-30 | 2010-01-14 | Nippon Telegr & Teleph Corp <Ntt> | 映像ダイジェスト装置及び映像編集プログラム |

| KR20130102368A (ko) * | 2012-03-07 | 2013-09-17 | 삼성전자주식회사 | 동영상 특징 정보를 가이드하기 위한 동영상 편집 장치 및 방법 |

| US20140153900A1 (en) * | 2012-12-05 | 2014-06-05 | Samsung Electronics Co., Ltd. | Video processing apparatus and method |

| JP6172990B2 (ja) * | 2013-03-27 | 2017-08-02 | オリンパス株式会社 | 画像記録装置、画像記録処理の制御方法及びそのプログラム |

| US20150318020A1 (en) * | 2014-05-02 | 2015-11-05 | FreshTake Media, Inc. | Interactive real-time video editor and recorder |

| US9251405B2 (en) * | 2013-06-20 | 2016-02-02 | Elwha Llc | Systems and methods for enhancement of facial expressions |

| US9734869B2 (en) * | 2014-03-11 | 2017-08-15 | Magisto Ltd. | Method and system for automatic learning of parameters for automatic video and photo editing based on user's satisfaction |

| JP2016046705A (ja) * | 2014-08-25 | 2016-04-04 | コニカミノルタ株式会社 | 会議録編集装置、その方法とプログラム、会議録再生装置、および会議システム |

| CN104994000A (zh) * | 2015-06-16 | 2015-10-21 | 青岛海信移动通信技术股份有限公司 | 一种图像动态呈现的方法和装置 |

| TWI597980B (zh) * | 2015-08-10 | 2017-09-01 | 宏達國際電子股份有限公司 | 影音管理方法及其系統 |

-

2016

- 2016-11-30 JP JP2016232019A patent/JP6589838B2/ja not_active Expired - Fee Related

-

2017

- 2017-11-20 US US15/818,254 patent/US20180151198A1/en not_active Abandoned

- 2017-11-28 CN CN201711223401.3A patent/CN108122270A/zh active Pending

- 2017-11-29 KR KR1020170161463A patent/KR20180062399A/ko unknown

Also Published As

| Publication number | Publication date |

|---|---|

| JP6589838B2 (ja) | 2019-10-16 |

| CN108122270A (zh) | 2018-06-05 |

| US20180151198A1 (en) | 2018-05-31 |

| JP2018088655A (ja) | 2018-06-07 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US9786326B2 (en) | Method and device of playing multimedia and medium | |

| US9685199B2 (en) | Editing apparatus and editing method | |

| CN111612873B (zh) | Gif图片生成方法、装置及电子设备 | |

| US9064538B2 (en) | Method and system for generating at least one of: comic strips and storyboards from videos | |

| US8494338B2 (en) | Electronic apparatus, video content editing method, and program | |

| EP3217254A1 (en) | Electronic device and operation method thereof | |

| CN108632555B (zh) | 动态图像处理装置、动态图像处理方法以及记录介质 | |

| KR101296152B1 (ko) | 섬네일 생성 장치 및 섬네일 생성 방법 | |

| JP2009075999A (ja) | 画像認識装置、画像認識方法、画像認識プログラム | |

| KR20180062399A (ko) | 동화상 편집 장치 및 동화상 편집 방법 | |

| EP2659486A1 (en) | Method, apparatus and computer program product for emotion detection | |

| JP2007288382A (ja) | 画像表示制御装置ならびにそれらの制御方法およびそれらの制御プログラム | |

| JP2007101945A (ja) | 音声付き映像データ処理装置、音声付き映像データ処理方法及び音声付き映像データ処理用プログラム | |

| JP5317710B2 (ja) | 画像処理装置、その制御方法、プログラム及び記録媒体 | |

| CN113806570A (zh) | 图像生成方法和生成装置、电子设备和存储介质 | |

| JP2010016678A (ja) | 画像合成装置、画像合成プログラム及び画像合成方法 | |

| KR100775187B1 (ko) | 썸네일 재생 방법 및 이를 이용한 단말기 | |

| CN113709548B (zh) | 基于图像的多媒体数据合成方法、装置、设备及存储介质 | |

| CN113794927A (zh) | 信息显示方法、装置及电子设备 | |

| JP2017004193A (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| JP2007078985A (ja) | データ検索装置及びその制御方法 | |

| CN112272330B (zh) | 显示方法、装置和电子设备 | |

| CN113377478B (zh) | 文娱行业数据标注方法、装置、存储介质及设备 | |

| WO2016175011A1 (ja) | 画像再生装置 | |

| JP2009259120A (ja) | 情報処理装置及びその制御方法、プログラム、記録媒体 |