KR20170017786A - 가이드된 어셈블리 환경에서 머신비전 좌표공간과 함께 묶기 위한 시스템 및 방법 - Google Patents

가이드된 어셈블리 환경에서 머신비전 좌표공간과 함께 묶기 위한 시스템 및 방법 Download PDFInfo

- Publication number

- KR20170017786A KR20170017786A KR1020160099392A KR20160099392A KR20170017786A KR 20170017786 A KR20170017786 A KR 20170017786A KR 1020160099392 A KR1020160099392 A KR 1020160099392A KR 20160099392 A KR20160099392 A KR 20160099392A KR 20170017786 A KR20170017786 A KR 20170017786A

- Authority

- KR

- South Korea

- Prior art keywords

- location

- workpiece

- image

- feature

- coordinate space

- Prior art date

Links

- 238000000034 method Methods 0.000 title claims abstract description 111

- 230000008569 process Effects 0.000 claims description 45

- 238000012937 correction Methods 0.000 claims description 18

- 238000009877 rendering Methods 0.000 claims description 16

- 230000009466 transformation Effects 0.000 claims description 16

- 238000013507 mapping Methods 0.000 claims description 15

- 238000012545 processing Methods 0.000 claims description 4

- 238000000605 extraction Methods 0.000 claims description 2

- XLYOFNOQVPJJNP-UHFFFAOYSA-N water Substances O XLYOFNOQVPJJNP-UHFFFAOYSA-N 0.000 claims description 2

- 238000005516 engineering process Methods 0.000 abstract description 2

- 238000012549 training Methods 0.000 description 10

- 238000011960 computer-aided design Methods 0.000 description 8

- 238000010586 diagram Methods 0.000 description 6

- 238000003384 imaging method Methods 0.000 description 6

- 230000026676 system process Effects 0.000 description 5

- 230000000875 corresponding effect Effects 0.000 description 4

- 230000009471 action Effects 0.000 description 3

- 238000004519 manufacturing process Methods 0.000 description 3

- 230000007246 mechanism Effects 0.000 description 3

- 230000003252 repetitive effect Effects 0.000 description 2

- 238000012546 transfer Methods 0.000 description 2

- 238000007792 addition Methods 0.000 description 1

- 230000003466 anti-cipated effect Effects 0.000 description 1

- 238000013459 approach Methods 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 230000002596 correlated effect Effects 0.000 description 1

- 238000011438 discrete method Methods 0.000 description 1

- 230000005484 gravity Effects 0.000 description 1

- 238000003702 image correction Methods 0.000 description 1

- 238000005259 measurement Methods 0.000 description 1

- 238000012986 modification Methods 0.000 description 1

- 230000004048 modification Effects 0.000 description 1

- 238000000053 physical method Methods 0.000 description 1

- 230000001052 transient effect Effects 0.000 description 1

- 230000000007 visual effect Effects 0.000 description 1

Images

Classifications

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B25—HAND TOOLS; PORTABLE POWER-DRIVEN TOOLS; MANIPULATORS

- B25J—MANIPULATORS; CHAMBERS PROVIDED WITH MANIPULATION DEVICES

- B25J9/00—Programme-controlled manipulators

- B25J9/16—Programme controls

- B25J9/1679—Programme controls characterised by the tasks executed

- B25J9/1692—Calibration of manipulator

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/0002—Inspection of images, e.g. flaw detection

- G06T7/0004—Industrial image inspection

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B25—HAND TOOLS; PORTABLE POWER-DRIVEN TOOLS; MANIPULATORS

- B25J—MANIPULATORS; CHAMBERS PROVIDED WITH MANIPULATION DEVICES

- B25J19/00—Accessories fitted to manipulators, e.g. for monitoring, for viewing; Safety devices combined with or specially adapted for use in connection with manipulators

- B25J19/02—Sensing devices

- B25J19/021—Optical sensing devices

- B25J19/023—Optical sensing devices including video camera means

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B25—HAND TOOLS; PORTABLE POWER-DRIVEN TOOLS; MANIPULATORS

- B25J—MANIPULATORS; CHAMBERS PROVIDED WITH MANIPULATION DEVICES

- B25J9/00—Programme-controlled manipulators

- B25J9/16—Programme controls

- B25J9/1679—Programme controls characterised by the tasks executed

- B25J9/1687—Assembly, peg and hole, palletising, straight line, weaving pattern movement

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B25—HAND TOOLS; PORTABLE POWER-DRIVEN TOOLS; MANIPULATORS

- B25J—MANIPULATORS; CHAMBERS PROVIDED WITH MANIPULATION DEVICES

- B25J9/00—Programme-controlled manipulators

- B25J9/16—Programme controls

- B25J9/1694—Programme controls characterised by use of sensors other than normal servo-feedback from position, speed or acceleration sensors, perception control, multi-sensor controlled systems, sensor fusion

- B25J9/1697—Vision controlled systems

-

- G06T3/0012—

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T3/00—Geometric image transformations in the plane of the image

- G06T3/04—Context-preserving transformations, e.g. by using an importance map

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/0002—Inspection of images, e.g. flaw detection

- G06T7/0004—Industrial image inspection

- G06T7/001—Industrial image inspection using an image reference approach

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/30—Determination of transform parameters for the alignment of images, i.e. image registration

- G06T7/33—Determination of transform parameters for the alignment of images, i.e. image registration using feature-based methods

- G06T7/337—Determination of transform parameters for the alignment of images, i.e. image registration using feature-based methods involving reference images or patches

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/30—Determination of transform parameters for the alignment of images, i.e. image registration

- G06T7/33—Determination of transform parameters for the alignment of images, i.e. image registration using feature-based methods

- G06T7/344—Determination of transform parameters for the alignment of images, i.e. image registration using feature-based methods involving models

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

- G06T7/74—Determining position or orientation of objects or cameras using feature-based methods involving reference images or patches

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/80—Analysis of captured images to determine intrinsic or extrinsic camera parameters, i.e. camera calibration

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/90—Arrangement of cameras or camera modules, e.g. multiple cameras in TV studios or sports stadiums

-

- G—PHYSICS

- G05—CONTROLLING; REGULATING

- G05B—CONTROL OR REGULATING SYSTEMS IN GENERAL; FUNCTIONAL ELEMENTS OF SUCH SYSTEMS; MONITORING OR TESTING ARRANGEMENTS FOR SUCH SYSTEMS OR ELEMENTS

- G05B2219/00—Program-control systems

- G05B2219/30—Nc systems

- G05B2219/39—Robotics, robotics to robotics hand

- G05B2219/39039—Two cameras detect same reference on workpiece to define its position in space

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30108—Industrial image inspection

- G06T2207/30164—Workpiece; Machine component

-

- Y—GENERAL TAGGING OF NEW TECHNOLOGICAL DEVELOPMENTS; GENERAL TAGGING OF CROSS-SECTIONAL TECHNOLOGIES SPANNING OVER SEVERAL SECTIONS OF THE IPC; TECHNICAL SUBJECTS COVERED BY FORMER USPC CROSS-REFERENCE ART COLLECTIONS [XRACs] AND DIGESTS

- Y10—TECHNICAL SUBJECTS COVERED BY FORMER USPC

- Y10S—TECHNICAL SUBJECTS COVERED BY FORMER USPC CROSS-REFERENCE ART COLLECTIONS [XRACs] AND DIGESTS

- Y10S901/00—Robots

- Y10S901/46—Sensing device

- Y10S901/47—Optical

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Robotics (AREA)

- Mechanical Engineering (AREA)

- Quality & Reliability (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Manipulator (AREA)

- Image Processing (AREA)

- Length Measuring Devices By Optical Means (AREA)

- Image Analysis (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

- Control Of Position Or Direction (AREA)

Abstract

본 발명은 캘리브레이션 타켓 대신에 런타임 워크피스의 특징을 이용하여 캘리브레이션 시간 동안 두 개의 위치에서 좌표공간을 묶는 시스템 및 방법에 관한 것이다. 여기에 세 가지 시나리오 고려될 수 있다.

첫 번째는 동일한 워크피스 특징이 두 위치에서 이미지되고 식별되는 것이다. 두 번째는 런타이 워크피스의 이미지 특징을 각 위치에서 구별하는 것이다(이용가능한 캐드 또는 측정된 워크피스 렌디션을 가지고). 세 번째는 모션 스테이지를 포함하는 제1 위치가 핸드-아이 캘리브레이션을 이용하여 모션 스테이지로 캘리브레이트 되고, 제2 위치가 위치 사이에 앞뒤로 런타임을 전송하여 동일한 모션 스테이지로 캘리브레이트 되는 것이다.

실례로 첫 번째의 두 가지 기술의 특성은 다른 포즈, 각 위치에서 특징을 도출하고 모으면, 그리고 두 개의 좌표 공간을 묶어서 모아진 특징을 이용하면 다중 런타임 워크피스를 실행하여 개선될 수 있다.

첫 번째는 동일한 워크피스 특징이 두 위치에서 이미지되고 식별되는 것이다. 두 번째는 런타이 워크피스의 이미지 특징을 각 위치에서 구별하는 것이다(이용가능한 캐드 또는 측정된 워크피스 렌디션을 가지고). 세 번째는 모션 스테이지를 포함하는 제1 위치가 핸드-아이 캘리브레이션을 이용하여 모션 스테이지로 캘리브레이트 되고, 제2 위치가 위치 사이에 앞뒤로 런타임을 전송하여 동일한 모션 스테이지로 캘리브레이트 되는 것이다.

실례로 첫 번째의 두 가지 기술의 특성은 다른 포즈, 각 위치에서 특징을 도출하고 모으면, 그리고 두 개의 좌표 공간을 묶어서 모아진 특징을 이용하면 다중 런타임 워크피스를 실행하여 개선될 수 있다.

Description

관련 출원

본 출원은, 전체 내용이 본 명세서에 병합된, 2015년 8월 6일에 출원된 발명의 명칭이 "SYSTEM AND METHOD FOR TYING TOGETHER MACHINE VISION COORDINATE SPACES IN A GUIDED ASSEMBLY ENVIRONMENT"인 공동-계류 중인 미국 가출원 일련 번호 62/201,723의 이익을 주장한다.

기술 분야

본 발명은 머신 비전 시스템(machine vision system)에 관한 것으로, 보다 상세하게는 제조 및 가이드 조립 환경에서 작업물 및 다른 물체의 조립을 가이드하는데 사용되는 비전 시스템에 관한 것이다.

(본 명세서에서 "비전 시스템"이라고도 언급되는) 머신 비전 시스템에서, 하나 이상의 카메라를 사용하여 이미징된 장면 내 물체 또는 표면에 비전 시스템 프로세스를 수행한다. 이 프로세스는 검사, 기호의 디코딩(decoding of symbology), 정렬 및 다양한 다른 자동화된 태스크(task)를 포함할 수 있다. 보다 구체적으로, 비전 시스템은 이미징된 장면을 통과하는 편평한 물체를 검사하는데 사용될 수 있다. 이 장면은 연관된 비전 시스템 프로세스를 동작시켜 결과를 생성하는 내부 또는 외부 비전 시스템 프로세서를 포함할 수 있는 하나 이상의 비전 시스템 카메라에 의해 일반적으로 이미징된다. 하나 이상의 카메라를 교정하여 충분한 정밀도로 신뢰성 있게 비전 태스크(들)를 수행할 수 있다. 교정 판(calibration plate)을 사용하여 카메라(들)를 교정하고 모든 카메라의 픽셀 장소(pixel location)를 좌표 공간에서 연관된 점으로 맵핑(mapping)하는 (좌표 "시스템"이라고도 언급되는) 공통 (전체) 좌표 공간을 수립하여, 임의의 카메라에서 이미징된 특징을 이 좌표 공간에 위치시킬 수 있다. 물체의 조립을 가이드하는 모션 스테이지(motion stage)를 사용하는 응용에서 교정 프로세스(calibration process)는 ("모션 좌표 공간"이라고도 언급되는) 모션 스테이지와 공통 좌표 공간 사이에 관계를 수립하는 것을 포함할 수 있다. 이러한 교정은 알려진 "손-눈(hand-eye)" 교정 기술을 사용하여 달성될 수 있다.

비전 시스템에 중요한 태스크는, 조립 장소(assembly location)에서 작업물을 정밀하게 지지하는 이동 플랫폼(모션 스테이지)과, "조립 모션"에서 다른 작업물을, 이 작업물에 조립되는 상부에 있는 정렬 장소(alignment location)로 이동시키는 조작기(manipulator)(예를 들어 모션 디바이스(motion device)/모션 스테이지의 "픽업-앤-배치" 동작(pick-and-place operation) 또는 다른 유형을 수행하는 로봇 손 또는 팔)를 포함할 수 있는 자동 조립 기구에 의해 ("작업물"이라고도 언급되는) 물체의 조립을 가이드하고 검증하는 것을 지원하는 것이다. 특정 픽업 및 배치 동작은 하나의 작업물을 다른 작업물과 정렬하는 것을 수반한다. 예를 들어, 터치 스크린은 픽업-앤-배치 동작에서 모션 스테이지에 존재하는 셀폰(cell phone)의 웰(well) 위로 그리고 웰 내로 조작기에 의해 조작될 수 있고, 여기서 각 터치 스크린은 픽업 장소(pick location)로부터 이동되고, 대기하는 셀폰 몸체 상의 (종종 "스테이션(station)"이라고 언급되는) 배치 장소(place location)에 적재(deposited)된다. 셀폰 몸체와 터치 스크린을 적절히 정밀하게 정렬하는 것이 매우 바람직하다.

일부 예시적인 시스템은 각 작업물이 시스템의 실행시간(runtime) 동작 동안 다른 작업물과 올바르게 정렬되도록 초기에 트레이닝된다. 트레이닝 시간 동안, 작업물은 각 장소/스테이션에 위치되고, 조립될 때, 조립된 작업물이 원하는 상호 위치 관계를 구비하게 된다. 트레이닝 이후, 실행시간 동안, 하나 또는 두 개의 작업물은 임의의 배치 또는 크기 변동을 고려하기 위하여 각 장소에서 연관된 모션 스테이지의 제어 하에 비전 시스템을 사용하여 각 장소에 재위치되고 나서 조립된다. 스테이지를 조절하는 것에 의해, 작업물은 작업물이 트레이닝 시간에 있을 때 동일한 상호 (예상되는) 위치 관계에 배치된다. 다른 예시적인 시스템에서 - 예를 들어, 제1 직사각형 물체가 제2 직사각형 물체에 센터링되는 것과 같은, 조립되는 부품의 기하학적 형상이 실행시간 동안 사용될 수 있는 시스템에서, 트레이닝은 생략될 수 있다.

작업물로 장면을 이미징한 후, 각 작업물에 속하는 특징이 추출되고 나서, 이 특징은 원하는 조립을 생성할 수 있는 스테이지 모션 파라미터를 최종적으로 연산하는 프로세스의 일부로서 공통 좌표 공간으로 맵핑된다. 공통 좌표 공간으로 맵핑하는 것은 교정 프로세스로 인한 것이다. 많은 조립 시스템에서, 교정 프로세스는 부품을 전달하는 반복가능한 조작기를 사용하여 두 장소들 사이에 특별한 교정 타깃을 전달하는 것과, 두 장소에서 교정 타깃을 이미징하는 것을 포함한다. 이 기술은 여러 단점을 구비한다. 예를 들어, 부품을 전달하는 픽업-앤-배치 파지기(gripper)는 작업물 대.(versus) 교정 타깃의 형상, 중량 또는 다른 특성의 차이로 인해 교정 타깃을 전달할 수 없을 수 있다. 즉, 교정 타깃은 파지기의 파라미터에 맞지 않다. 이러한 시스템에서, 파라미터를 공통 좌표 공간으로 맵핑하는 것은 사용자 입력을 통해 수동으로 지정되어야 하는데, 이는 종종 최적이 아닌 교정을 초래한다. 나아가, 교정 동안 대. 실행시간 동안 픽업-앤-배치 조작기에 의해 추종되는 모션 경로는, 두께 또는 다른 특성의 차이와 같은, 부품과 교정 타깃의 특성의 차이로 인해 상이할 수 있다. 이것은 모션 경로가 조작기에 의해 취해진 실행시간 모션 단계 대. 트레이닝 시간 모션 단계로부터 변동을 요구하기 때문에 교정 에러를 도입할 수 있다. 보다 일반적으로, 사용자가 추가적인 셋업 단계 등으로 인해 교정 시간 동안 별개의 교정 타깃을 사용하는 것은 추가적으로 불편하다.

또한 단점으로는, 종래 교정 기술은 한계를 구비하고 및/또는 구현하는 것이 불편하고, 구현하는데 시간을 소비하는 특정 기계적인 및/또는 반복적인 시행 착오 원리에 의존한다. 예를 들어, 하나의 기술에서 기계적인 시스템은 제1 장소에서의 좌표 공간과 제2 장소에서의 좌표 공간 사이의 관계가 알려지고 수립되도록 구성될 수 있다. 이 기술은 융통성을 제한하고 시간에 따라 있을 수 있는 움직임 또는 위치의 변경을 고려하지 않는다. 다른 기술에서, 2개의 장소들 사이의 관계의 초기 추정이 이루어지고, 조립되는 부품의 품질을 사용하는 것에 의해 반복적으로 개선(refined)된다. 이 기술은 시간을 소비하고, 원하는 정밀도를 달성하는데 다수회 반복하는 것에 의존한다.

본 발명은 실행시간 작업물에 있는 특징을 사용하여 교정 시간 동안 2개의 장소에서의 좌표 공간들을 함께 묶는 교정 시스템 및 방법을 제공하는 것에 의해 픽업 장소와 배치 장소 사이에 조작기(및 연관된 파지기)에 의해 교정 타깃을 전달하는 것으로부터 발생하는 문제와 관련된 종래 기술의 단점을 극복한다. 본 시스템 및 방법은 적어도 3개의 상이한 시나리오/기술, 즉 - 동일한 특징이 두 장소에서 이미징되고 식별될 수 있는 기술; 실행시간 작업물의 이미징된 특징이 (작업물의 CAD 또는 측정된 렌디션이 이용가능한) 각 장소에서 상이한 기술; 및 모션 스테이지를 포함하는 제1 장소가 손-눈 교정을 사용하여 모션 스테이지로 교정되고 제2 장소가 두 장소들 사이에 앞뒤로 실행시간 부품을 전달하는 것에 의해 동일한 모션 스테이지로 손-눈 교정되는 기술을 포함한다. 예시적으로, 처음 2개의 기술의 품질은 상이한 포즈(pose)를 각각 갖는 다수의 실행시간 작업물을 실행하는 것, 각 장소에서 특징을 추출하고 이러한 특징을 누적하는 것; 및 누적된 특징들을 사용하여 2개의 좌표 공간들을 묶는 것에 의해 개선될 수 있다. 보다 일반적으로, 이 시스템 및 방법은 두 장소들을 독립적으로 교정하고, 조립하는 동안 조작기가 전달되도록 구성되고 배열되고/적응된 작업물을 전달하고, 교정 판의 특징을 사용하는 것이 아니라 이 작업물의 특징을 사용하는 것에 의해 두 장소의 좌표 공간들을 함께 묶는다.

예시적인 실시예에서, 제1 장소에 있는 제1 작업물이 조작기에 의해 제2 장소로 전달되는 환경에서 비전 시스템을 교정하는 시스템 및 방법이 제공된다. 상기 제1 장소와 상기 제2 장소의 좌표 공간들을 함께 묶는 것에 의존하는 동작이 제1 작업물에 수행된다. 적어도 하나의 비전 시스템 카메라는 제1 작업물이 상기 제1 장소에 위치된 때 제1 작업물을 이미징하고 상기 제2 장소에 위치된 때 제1 작업물을 이미징하도록 배열된다. 적어도 하나의 비전 시스템 카메라는 상기 제1 장소에 대해 교정되어 제1 좌표 공간을 한정하는 제1 교정 데이터를 유도하고, 적어도 하나의 비전 시스템 카메라(가능하게는 동일한 카메라(들))는 제2 장소에 대해 교정되어 제2 좌표 공간을 한정하는 제2 교정 데이터를 유도한다. 적어도 상기 제1 작업물의 특징은 상기 제1 장소에서 상기 제1 작업물의 제1 이미지로부터 식별된다. 상기 제1 이미지에서 식별된 특징에 기초하여 상기 제1 작업물은 상기 제1 장소에 대한 상기 제1 좌표 공간에 대해 위치된다. 상기 제1 작업물은 상기 조작기에 의해 파지되어, 적어도 한번, 상기 제2 장소에서 미리 결정된 조작기 위치로 이동되고, 상기 제1 작업물의 제2 이미지가 상기 제2 장소에서 취득된다. 상기 제2 이미지에서 식별된 특징에 기초하여, 상기 제1 작업물이 상기 제2 장소에 대한 상기 제2 좌표 공간에 대해 위치된다. 상기 제1 좌표 공간과 상기 제2 좌표 공간은 이에 의해 함께 묶인다. 예시적으로, 상기 제1 이미지에서 식별된 특징들이 상기 제2 이미지에서 식별된 특징들과 동일한 경우, 상기 시스템 및 방법은 (a) 상기 제1 교정 데이터에 대해 상기 제1 이미지에서 식별된 특징의 장소를 맵핑하는 단계, (b) 상기 제2 교정 데이터에 대해 상기 제2 이미지에서 식별된 특징의 장소를 맵핑하는 단계, 및 (c) 상기 제2 장소에서 맵핑된 특징을 상기 제1 장소에서 맵핑된 특징으로 맵핑하는 변환을 연산하는 단계를 더 포함한다. 대안적으로, 상기 제1 이미지에서 식별된 특징들 중 일부가 상기 제2 이미지에서 식별된 특징과 상이한 경우, 상기 시스템 및 방법은 (a) 상기 제1 교정 데이터에 대해 상기 제1 이미지에서 식별된 특징의 장소를 맵핑하는 단계, (b) 상기 제1 작업물의 특징 장소의 저장된 사양에 대해 변환을 연산하는 단계, (c) 상기 제2 교정 데이터에 대해 상기 제2 이미지에서 식별된 특징의 장소를 맵핑하는 단계, (d) 단계 (b)에서 연산된 변환을 사용하여 상기 작업물이 상기 제1 장소에 위치된 때 상기 제1 좌표 공간에서 상기 제2 이미지로부터 상기 식별된 특징의 장소를 유도하는 단계, 및 (e) 상기 제2 장소에서 상기 맵핑된 특징을 상기 제1 장소에서 대응하는 변환된 특징으로 맵핑하는 변환을 연산하는 단계를 더 포함한다. 상기 제1 작업물의 사양은 상기 제1 작업물의 CAD 모델 또는 상기 제1 작업물의 측정된 모델(예를 들어 CMM-생성된 측정)에 기초할 수 있다. 예시적으로, 상기 시스템 및 방법은, (a) 상기 제1 장소 또는 상기 제2 장소에서 모션 렌더링 디바이스(motion rendering device)로 상기 제1 작업물을 복수의 상이한 포즈(pose)로 반복적으로 이동하는 단계, (b) 상기 제1 장소와 상기 제2 장소의 각각에서 각 상기 포즈에서 특징을 식별하는 단계, 및 (c) 정밀도를 향상시키기 위해 상기 식별된 특징 정보를 누적시키는 단계를 더 포함할 수 있고, 상기 제1 작업물은 동일한 작업물이거나 또는 복수의 이산 작업물 중 하나의 작업물이다. 여러 실시예에서, 상기 시스템 및 방법은 상기 제1 장소에서 이미지 좌표 시스템으로부터 교정 좌표 시스템으로 맵핑하는 것을 포함하고, 상기 맵핑하는 것은 단위(unity) 맵핑이다. 실시예에서, 상기 제2 장소는 상기 제1 작업물이 상기 제2 작업물과 원하는 정렬로 맞물려 배치된 제2 작업물을 구비하고, 및/또는 상기 제2 작업물은 상기 제1 작업물을 더 처리하기 위해 부품, 컨테이너 또는 프레임워크일 수 있다. 추가적으로, 여러 실시예에서, 상기 동작은 다른 물체에 대한 정렬 동작, 제1 작업물에 인쇄 동작, 및 제1 작업물에 적용 동작 중 적어도 하나일 수 있고, 이 동작은 상기 제1 장소 및 상기 제2 장소로부터 원격 장소에서 적어도 부분적으로 수행될 수 있다.

다른 예시적인 실시예에서, 제1 장소에 있는 제1 작업물이 조작기에 의해 제2 장소로 전달되는 환경에서 비전 시스템을 교정하는 시스템 및 방법으로서, 상기 제1 작업물에 수행되는 동작은 상기 제1 장소와 상기 제2 장소의 좌표 공간들을 함께 묶는 것에 의존하고, 상기 장소들 중 적어도 하나의 장소는 손-눈 교정을 받는다. 적어도 하나의 비전 시스템 카메라는 상기 제1 장소에서 상기 제1 작업물을 이미징하고 상기 제2 장소를 이미징하도록 배열된다. 상기 비전 시스템 카메라는 상기 제1 장소에 대해 손-눈 교정되어 제1 교정 데이터를 유도하고, 상기 제1 작업물은 상기 제1 장소에 위치된다. 예시적으로, 상기 제1 작업물은 상기 조작기에 의해 상기 제1 장소로부터 상기 제2 장소로 이동되고, 상기 제1 작업물 상의 특징들이 위치된 이미지가 취득된다. 상기 제1 작업물은 이후 상기 조작기에 의해 상기 제2 장소로부터 상기 제1 장소로 이동되고, 상기 제1 작업물의 포즈는 모션 렌더링 디바이스를 새로운 알려진 포즈로 이동시키는 것에 의해 상기 제1 장소에서 변경된다. 상기 모션 렌더링 디바이스는 어느 장소에 위치될 수 있고, 상기 모션 렌더링 디바이스를 통해 포즈를-변경하는 것은 상기 조작기에 의해 상기 제2 장소로부터 제1 장소로 이동하기 전이나 후에 일어날 수 있다.

상기 단계들은, 손-눈 교정과 관련된 특징 장소 및 다른 데이터가 누적되고 저장될 때까지 반복되고, 이후 상기 누적된 데이터를 사용하여 상기 제2 장소에 대해 적어도 하나의 비전 시스템 카메라를 손-눈 교정한다. 이것으로 상기 모션 렌더링 디바이스에 대해 상기 손-눈 교정으로 획득된 상기 공통 좌표 공간에 의해 상기 제1 좌표 공간과 상기 제2 좌표 공간을 함께 묶을 수 있다. 예시적으로, 상기 제2 장소는 상기 제1 작업물이 상기 제2 작업물과 원하는 정렬로 맞물려 배치된 제2 작업물을 상기 모션 렌더링 디바이스에 구비한다. 상기 제2 작업물은 상기 제1 작업물을 더 처리하기 위해 부품, 컨테이너 또는 프레임워크일 수 있고, 상기 동작은 다른 물체에 대한 정렬 동작, 상기 제1 작업물에 인쇄 동작, 및 상기 제1 작업물에 적용 동작 중 적어도 하나일 수 있다.

아래 본 발명의 상세한 설명은 첨부 도면을 참조하여 설명된다,

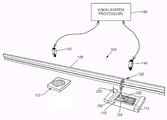

도 1은 배치 장소로 운반할 작업물을 추출하기 위해 픽업 장소에 위치된 픽업-앤-배치 조작기 - 여기서 픽업 장소와 배치 장소 중 하나의 장소는 작업물 조립 시스템과 함께 사용되는 예시적인 모션 스테이지를 포함한다 - , 및 교정 동작, 트레이닝 동작, 및 실행시간 동작을 위한 연관된 도구 및 프로세스를 갖는 비전 프로세서를 보여주는, 예시적인 픽업-앤-배치 조립 환경에 대해 배열된 다중-카메라 비전 시스템을 도시하는 도면;

도 2는, 배치 장소에 위치되고 제1 픽업된 작업물을 상기 제2 작업물에배치하는 픽업-앤-배치 조작기를 보여주는, 작업물이 다른 작업물과 정렬되어 있는, 예시적인 픽업-앤-배치 조립 배열에 대해 배열된 2개의-카메라 비전 시스템을 도시하는 도면;

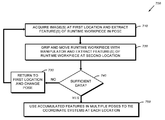

도 3은, 카메라 시스템이 픽업 장소와 배치 장소 중 하나의 장소에 대해 교정된, 각 장소에서 조작기에 의해 파지되는 실행시간 작업물을 이미징한 것에 기초하여 제1 장소에 있는 제1 좌표 공간을 제2 장소에 있는 제2 좌표 공간으로 묶는 방법의 일반화된 개요를 도시하는 흐름도;

도 4는 각 장소에서의 특징들이 동일한 경우 각 장소에서 실행시간 작업물 이미지(들)의 특징을 사용하여 제1 장소의 좌표 공간을 제2 장소의 좌표 공간으로 묶는, 도 3에 일반적으로 설명된 방법의 보다 상세한 흐름도;

도 5는 각 장소에서의 특징들 중 적어도 일부가 각 해당 시야(field of view)에서 가시상의 차이로 인해 상이한 경우 각 장소에서 실행시간 작업물 이미지(들)의 특징을 사용하여 제1 장소의 좌표 공간을 제2 장소의 좌표 공간으로 묶는, 도 3에 일반적으로 설명 방법의 보다 상세한 흐름도;

도 6은 제1 장소와 제2 장소에서 별개의 손-눈 교정을 수행하는 것에 의해 제1 장소의 좌표 공간을 제2 장소의 좌표 공간으로 묶는 방법의 흐름도; 및

도 7은 다수의 미지의 포즈에서 특징들이 추출되고 이 누적된 특징들을 사용하여 각 장소에서 좌표 공간들을 묶는, 도 4 및 도 5의 방법에 대해 추가적인 프로세스의 흐름도.

도 1은 배치 장소로 운반할 작업물을 추출하기 위해 픽업 장소에 위치된 픽업-앤-배치 조작기 - 여기서 픽업 장소와 배치 장소 중 하나의 장소는 작업물 조립 시스템과 함께 사용되는 예시적인 모션 스테이지를 포함한다 - , 및 교정 동작, 트레이닝 동작, 및 실행시간 동작을 위한 연관된 도구 및 프로세스를 갖는 비전 프로세서를 보여주는, 예시적인 픽업-앤-배치 조립 환경에 대해 배열된 다중-카메라 비전 시스템을 도시하는 도면;

도 2는, 배치 장소에 위치되고 제1 픽업된 작업물을 상기 제2 작업물에배치하는 픽업-앤-배치 조작기를 보여주는, 작업물이 다른 작업물과 정렬되어 있는, 예시적인 픽업-앤-배치 조립 배열에 대해 배열된 2개의-카메라 비전 시스템을 도시하는 도면;

도 3은, 카메라 시스템이 픽업 장소와 배치 장소 중 하나의 장소에 대해 교정된, 각 장소에서 조작기에 의해 파지되는 실행시간 작업물을 이미징한 것에 기초하여 제1 장소에 있는 제1 좌표 공간을 제2 장소에 있는 제2 좌표 공간으로 묶는 방법의 일반화된 개요를 도시하는 흐름도;

도 4는 각 장소에서의 특징들이 동일한 경우 각 장소에서 실행시간 작업물 이미지(들)의 특징을 사용하여 제1 장소의 좌표 공간을 제2 장소의 좌표 공간으로 묶는, 도 3에 일반적으로 설명된 방법의 보다 상세한 흐름도;

도 5는 각 장소에서의 특징들 중 적어도 일부가 각 해당 시야(field of view)에서 가시상의 차이로 인해 상이한 경우 각 장소에서 실행시간 작업물 이미지(들)의 특징을 사용하여 제1 장소의 좌표 공간을 제2 장소의 좌표 공간으로 묶는, 도 3에 일반적으로 설명 방법의 보다 상세한 흐름도;

도 6은 제1 장소와 제2 장소에서 별개의 손-눈 교정을 수행하는 것에 의해 제1 장소의 좌표 공간을 제2 장소의 좌표 공간으로 묶는 방법의 흐름도; 및

도 7은 다수의 미지의 포즈에서 특징들이 추출되고 이 누적된 특징들을 사용하여 각 장소에서 좌표 공간들을 묶는, 도 4 및 도 5의 방법에 대해 추가적인 프로세스의 흐름도.

도 1은 일 실시예에 따라 제2 장소에서 제2 작업물로 조립하기 위해 실행시간 동작에 조작기에 의해 조작되는 (장소/스테이션들 사이에서 전달되는) 물체(제1 작업물)를 사용하여 교정하는 시스템 및 방법을 사용할 수 있는 예시적인 픽업-앤-배치 (조작기) 기구(120)를 갖는 조립 시스템(100)을 도시한다. 제1 장소와 제2 장소는, 특히 전달될 실행시간 작업물(124)이 초기에 위치된 픽업 장소(122)와, 제1 작업물(124)이 조립되는 제2 작업물(112)이 위치된 픽업 장소(110)를 포함한다. 조작기는 제1 작업물(124)과 선택적으로 맞물리는 (예를 들어) 흡입 컵(125)을 포함할 수 있는 파지기를 포함할 수 있다. 조작기(120)는 제1 작업물(124)을 선택적으로 픽업하고(화살표 130) 제1 작업물을 제2 작업물(112) 상의 정렬 위치(126)로 전달(화살표 132)한다. 이 예에서, 레일(128)은 반복가능한 경로를 따라 조작기(120)를 가이드하기 위해 제공된다. 이 레일은 선택적인 것이고, 픽업 장소와 배치 장소 사이에서 조작기(120)를 반복적으로 이동시킬 수 있는 임의의 방식이 명시적으로 고려된다. 예시를 위하여, 조작기는 축(Xm, Ym 및 Zm)을 특징으로 하는 좌표 공간(134)을 한정하고 여기서 조작기(120)는 적어도 축(Ym)을 따라 그리고 축(Zm)으로 픽업/배치 방향을 따라 이동한다. 축(Zm) 주위로 회전(θzm)이 또한 도시되어 있지만, 조작기에 의해 수행될 수도 있고 또는 수행되지 않을 수도 있다. 조작기에 의해 수행되는 모션은 임의적인 것이고, 비전 시스템은 예시를 위하여 도시된 이 모션과 일반적으로 독립적으로 동작한다.

픽업 장소(122) 및/또는 배치 장소(110)는 픽업/배치 동작 전에 각 작업물(124 및 112)이 위치되어 있는 플랫폼을 각각 한정한다. 작업물(124, 112)은, 임의의 허용가능한 기술에 의해 - 예를 들어 작업물의 소스로부터 컨베이어, 로봇 조작기, 사용자에 의한 수동 배치 등에 의해, 장소/플랫폼(각각, 122, 110)에 적재될 수 있다. 다른 실시예에서, 작업물(124)은 제1 장소(110)에서 조작기에 의해 유지될 수 있고, 장소/플랫폼(122)에 적재되지 않는다. 예시적인 시스템에서, 장소/플랫폼(122, 110)들 중 어느 하나는 원하는 정밀도로 하나 이상의 자유도로 이동하는 모션 스테이지를 포함할 수 있다. 이러한 스테이지 모션은 반복가능한 픽업 및 배치 모션 전에 또는 후에 작업물들 사이에 정렬을 수립하도록 제공된다. 즉, 작업물들 중 하나는 모션 스테이지에 의해 미리-정렬되고, 이후 픽업/배치 동작은 모션 스테이지가 한정된 경로를 통해 이동할 때 미리 결정된 정렬을 유지한다. 대안적으로, 픽업/배치 동작이 작업물을 이동시킨 후, 작업물을 최종적으로 정렬하는 것은 조립/배치 모션 바로 전에 일어날 수 있다. 각 플랫폼(어느 것은 모션 스테이지를 포함할 수 있음)은, 장소의 국부적 교정된 좌표 공간으로 고려될 수 있는 고유 좌표 공간을 한정한다. 즉, 픽업 플랫폼(122)은 제1 좌표 공간(Xs1, Ys1, Zs1)(직교 축(135))을 한정하고, 배치 플랫폼(110)은 제2 좌표 공간(Xs2, Ys2, Zs2)(직교 축(137))을 한정한다. 어느 플랫폼이 모션 스테이지를 포함하는 경우, 이러한 모션은 도시된 좌표 축들 중 하나 이상의 축을 따라 일어날 수 있고, 선택적으로, 적어도 하나의 회전 자유도(즉, 도시된 바와 같이, θzs1 또는 θzs2을 따라)로 일어날 수 있다.

이 예시적인 시스템 환경/배열(100)에서, 적어도 하나의 카메라(142, 140)가 각 장소(122, 110)를 각각 이미징한다. 대안적으로, 단일 카메라 또는 다수의 카메라가 단일 시야(FOV)에서 두 장소를 이미징할 수 있다. 일반적으로 그리고 본 명세서에서 설명된 바와 같이, 작업물이 이 장소에 위치될 때 작업물의 동일한 특징들이거나 또는 상이한 특징들이 각 장소에서 하나 이상의 카메라에 보이는 것으로 고려된다. 카메라(140, 142)는 비전 프로세스(프로세서)(160)에 상호 연결된다. 하나 또는 두 개의 장소(122, 110)는 (점선으로 도시된) 추가적인 카메라(144)를 선택적으로 포함할 수 있다. 비전 프로세스(프로세서)(160)는 또한 스테이지 및 연관된 작업물의 물리적 위치를 결정하는데 사용되는 모션 정보(예를 들어 인코더 또는 스테퍼(stepper) 거리/펄스 정보)(172)를 프로세서(160)에 제공하는 연관된 장소에서 스테이지 모션 제어기(170)에 동작가능하게 상호 연결된다. 모션 스테이지는 어느 장소(122 또는 110)에 선택적으로 위치될 수 있으므로, 제어기(170) 및 연관된 모션 정보(172)는 두 장소에 대해 유사하게 도시된다. (아래에 더 설명된) 손-눈 교정 동안, 스테이지는 모션 정보가 레코딩되고 나서 취득된 이미지(들)와 상관되는 동안 이동된다.

카메라(140, 142, 144)는, 하나 이상의 카메라 하우징(들) 내에 주문(custom) 비전 프로세서 회로로 전체적으로 또는 부분적으로 통합되거나, 또는 셋업 (교정) 동작, 트레이닝 동작, 및/또는 실행시간 동작을 지원하는 적절한 그래픽 유저 인터페이스(GUI - 예를 들어 디스플레이 및/또는 터치스크린(182), 키보드(184), 및/또는 마우스(186))를 구비하는 PC, 랩탑, 태블릿, 스마트폰 등을 포함하지만 이들로 제한되지 않는 상호 연결된 컴퓨팅 디바이스(180) 내에 제공될 수 있는 비전 시스템 프로세서 및 연관된 비전 시스템 프로세스(160)에 각 동작가능하게 연결된다. 하나를 초과하는 카메라를 사용하는 조립 시스템에서, 각 카메라는 이 이미지로부터 추출된 취득된 이미지 또는 정보를 중심 프로세서로 송신하도록 적응된다는 것이 주목된다. 중심 프로세서는 이후 조립 동안 여러 카메라로부터 정보를 통합한다. 비전 프로세스(프로세서)(160)는 에지 파인더(edge finder), 얼룩(blob) 분석기, 검색 도구, 캘리퍼 도구(caliper tool) 등과 같은 여러 비전 도구(162)를 포함하는 다양한 비전 시스템 프로세스(또는 요소/모듈)를 수행한다. 예시적으로, 비전 프로세스(프로세서)(160)는 아래에 더 설명된 방식으로 2개의 작업물로부터 이미지 데이터를 정렬하는 정렬 프로세스(프로세서)(164)를 포함한다. 교정 프로세스(프로세서)(166)는 아래에 더 설명된 카메라 교정과 손-눈 교정을 수행하는 것을 제공한다. 예시적으로, 트레이닝 프로세스(프로세서)(168)는 본 명세서에서 고려되는 여러 트레이닝 절차를 수행하여 제1 작업물에 대해 제2 작업물을 정밀하게 조립하기 위해 작업물을 재위치시킨다. 비전 프로세서(160)는 복수의 상호 연결된 카메라 프로세서(또는 다른 디바이스)로 수립되거나, 또는 단일 카메라 조립체(또는 원격 컴퓨팅 디바이스)에서 중심 프로세서로 수립될 수 있다는 것이 주목된다.

또한 본 명세서에서 여러 실시예에 도시된 물리적인 작업물 조립 배열은 플랫폼/모션 스테이지의 여러 구역을 이미징하는 임의의 개수의 카메라를 포함하는 것으로 이해된다. 각 장소(및/또는 전체적인 조립 환경)를 이미징하는데 사용되는 카메라의 수는 대안적인 배열에서 매우 가변적이다. 마찬가지로, 조작기가 태스크를 수행하는 전체적인 시스템에서 장소의 개수는 매우 가변적이다.

나아가, 도시된 조립 환경은, 제1 작업물이 (예를 들어) 반복가능한 조작기에 의해 제1 장소로부터 다른 장소로 전달되고 다른 장소에서 동작이 제1 작업물에 수행되는 다양한 배열의 일 예시인 것으로 고려되는 것이 명백하다. 이 동작은 원하는 정렬로 제2 작업물과 맞물리는 것을 포함하거나 또는 적절한 기구를 사용하여 제1 작업물에 직접 수행될 수 있다. 예를 들어, 제2 작업물은, 제1 작업물이 조립되는 부품, 제1 작업물이 배치되는 컨테이너/박스, 및/또는 제1 작업물이 - 예를 들어 키트 배열(kitting arrangement)의 일부로 - 배치되는 프레임워크일 수 있다. 이 배치에 더하여, 동작은 제1 작업물에 인쇄를 수행하거나 이 제1 작업물에 전사를 수행하고, 이 제1 작업물을 작업물을 변경하는 레이저, 커터, 도구 헤드 또는 다른 디바이스 및/또는 임의의 다른 프로세스에 노출하는 것을 더 포함할 수 있다. 동작 및 제2 작업물에 대한 추가적인 정의는 아래에 제공된다. 일반적으로, 시스템 및 방법은 제1 장소와 제2 장소를 이미징하는 카메라(들)의 좌표 공간들을 함께 묶어 바람직한 방식으로 동작을 구현할 수 있는 것으로 주로 고려된다.

예시적인 시스템 및 방법의 상세를 더 설명하기 전에, 본 명세서에서 제시되는 개념을 독자들이 이해하는데 도움을 주는 다음 표 1의 정의를 참조한다:

정의

| "교정된 좌표 공간" | 카메라 교정, 손-눈 교정, 또는 다른 교정 프로세스 동안 사용되는 교정 타깃에 의해 한정된 좌표 공간. |

| "공통 좌표 공간" | 실행시간에, 시스템 내 카메라에 의해 취득되는 특징들은 이 공간으로 맵핑된다. 공통 좌표 공간은 장소들에 걸쳐 공유된다. |

| "이미지 좌표 공간" | 취득된 이미지의 좌표 공간 또는 변환된 이미지의 좌표 공간. |

| "모션 좌표 공간" | 모션 렌더링 디바이스(예를 들어 모션 스테이지)와 연관된 네이티브 좌표 공간. |

| "작업물 좌표 공간" | 작업물과 연관된 좌표 공간. 이 좌표 공간의 가능한 소스는 작업물의 CAD 사양 또는 CMM 렌디션이다. |

| "이미지 로부터 교정된 으로 변환" | 이미지 좌표 공간으로부터 교정된 좌표 공간으로 점들을 맵핑하는 변환. |

| "카메라 교정" | 이미지 좌표 공간과 교정된 좌표 공간들 사이에 변환을 수립하는 프로세스. |

| "손-눈 교정" | 이미지 좌표 공간, 교정된 좌표 공간, 및 모션 좌표 공간 사이에 변환을 수립하는, 이 기술 분야에 통상의 지식을 가진 자에 알려진 프로세스. |

| "모든" 카메라 | 본 명세서에서 조립 태스크에서 시스템에 의해 사용되는 모든 카메라를 말한다. 그렇지 않은 경우 장면을 이미징할 수 있는 비전 시스템(또는 다른 프로세스)에 의해 사용되는 일부 카메라는 조립 태스크로부터 생략될 수 있는 것으로 명확히 고려된다. (동일한 카메라일 수 있는) 하나 이상의 (적어도 하나의) 카메라(들)는 조립에서 각 장소를 이미징하고 공통 좌표 시스템 공간으로 교정되는 것이 주로 고려된다. |

| "동작" | 제1 장소, 제2 장소 또는 제1 장소와 제2 장소로부터 적어도 부분적으로 원격 장소에서 제1 작업물에 수행되거나 이 제1 작업물에 대해 수행되는 프로세스를 말한다. 동작은 (예를 들어) 제2 작업물에 대한 조립 동작이거나, 박스 또는 프레임워크(즉, 키트)에 제1 작업물을 배치하는 동작이거나, 또는 적절한 기구를 사용하여 인쇄, 전사 응용, 접착제 도포 등과 같은 제1 작업물에 변형을 수행하는 동작일 수 있다. |

| "제1 작업물" | 조작기 시스템(예를 들어 조립 시스템)의 실제 실행시간 동작에 사용되는 부품 또는 다른 물체 - "실행시간 작업물"이라고도 언급됨 - 를 말한다. 제1 작업물은 제조 또는 다른 실행시간 프로세스, 후-교정 및 트레이닝의 일부가 아닌 시스템 셋업/트레이닝에 사용되는 교정 타깃/판 또는 다른 물체를 명확히 배제한다. |

| "제2 작업물" | (예를 들어) 제1 장소 또는 제2 장소에서 모션 렌더링 디바이스(모션 스테이지)를 사용하여 달성될 수 있는 정렬에 기초하여 제1 작업물이 조립되는 제2 장소에 위치된 작업물을 말한다. 제2 작업물은 또한 제1 작업물이 배치되는 컨테이너(박스) 또는 프레임워크를 말할 수 있다. |

도 2를 간략히 참조하면, 조작기(120)는 파지기(150) 내에 제1 작업물(124)을 가지고 레일(180)을 따라 제1 장소(122)로부터 제2 장소(110)로 이동하는 것으로 도시된다. 조작기(120)는 제1 작업물(126)을 제2 작업물(112)에 있는 정렬된 수용 장소(126)로 정밀하게 배치하는 (화살표 250) 것으로 도시된다. 이 정렬은 공통 좌표 공간에 기초하여 모션 스테이지를 이동시키는 것에 의해 카메라(140, 142) 및 연관된 비전 시스템 프로세스(프로세서)(160)에 의해 수립된다. 이 공통 좌표 공간은 이제 아래에 설명된 바와 같이 2개의 장소(122, 110)들 각각의 장소의 교정된 좌표 공간을 함께 묶는 것에 의해 교정 동안 수립된다.

특정 교정 원리를 일반적으로 이해하는 것에 의해, 교정 타깃과 같은 강성의 몸체에 대해, 모션은 한 쌍의 포즈, 즉: 모션 바로 직전의 출발 포즈, 및 모션 바로 직후의 종료 포즈로 특징지어질 수 있고 - 본 명세서에서 "포즈"는 일부 기초가 되는 좌표 공간에서 임의의 하나의 특정 시각에서 몸체의 위치와 배향 - 몸체의 가상 특성화 - 을 나타내는 수치값의 세트로 한정된다. 예를 들어, 2차원에서, 포즈는 3개의 수: X에서 병진이동, Y에서 병진이동, 및 회전(R)(또는 θ)으로 특징지어질 수 있다. 교정 타깃의 상황에서 포즈는 교정 타깃이 카메라(들)에 제시되는 방법을 나타낸다. 일반적으로, 표준 소위 "손-눈 교정"에서, 교정 타깃은 모션 렌더링 디바이스에 의해 카메라(들)에 대해 다수의 상이한 포즈로 이동되고, 각 카메라는 각 포즈에서 교정 타깃의 이미지를 취득한다. 이러한 손-눈 교정의 목표는 카메라(들)의 포즈, 교정 타깃의 포즈, 및 "교정된 좌표 공간"이라고 언급될 수 있는 단일 좌표 공간에서 모션 렌더링 디바이스의 포즈를 결정하는 것이다. 일반적으로, "모션"은 물리적 모션, 예를 들어, 로봇 팔 또는 모션 스테이지 또는 갠트리(gantry)를 렌더링할 수 있는 물리적 디바이스에 의해 제공된다. 타깃은 하나 이상의 정지 카메라(들)에 대해 이동할 수 있고, 또는 카메라가 모션을 제공하는 물리적 디바이스에 장착될 때 카메라(들)는 정지 타깃에 대해 이동할 수 있는 것으로 이해된다. 이러한 모션-렌더링 디바이스의 제어기는 수치값(즉, 포즈)을 사용하여 임의의 원하는 모션을 렌더링할 것을 디바이스에 명령하고, 이 값은 이 디바이스에 대해 본 명세서에서 "모션 좌표 공간"이라고 언급되는 네이티브 좌표 공간(native coordinate space)에서 해석된다. 이제 도 3을 참조하면, 장소들 사이에 조작기에 의해 이동되는 실행시간 작업물을 사용하여 2개의 이산 장소(예를 들어 픽업 장소와 배치 장소)의 좌표 공간들을 묶는 전체적인 교정 프로세스(300)가 설명된다. 특히, 실행시간 작업물을 사용하는 것은 교정 타깃의 사용과 연관된 단점을 회피하고, 이에 의해 사용자는 조작기가 실행시간 동작에서 처리되는 것이 예상되는 것과 동일한 구조를 편의상 사용할 수 있다. 프로세스(300)는 단계(310)에서 제1 장소와 제2 장소를 이미징하도록, 즉 제1 장소와 제2 장소의 이미지(들)를 취득하도록 하나 이상의 카메라를 배열하는 것에 의해 시작된다. 카메라(들)는 각 장소에서 실행시간 작업물의 특징(들)을 보는데 - 여기서 아 특징들은, 전체적으로 또는 부분적으로 각 장소에서 동일하거나 또는 각 장소에서 상이할 수 있다. 단계(320)에서, 제1 장소 또는 제2 장소에서 특징들을 보는 카메라(들)는 각 교정된 좌표 공간으로 교정된다. 이것은, 스테이지에 의해 교정 타깃을 이동시키고 나서 스테이지에 의해 제공되는 모션 정보와 연관하여 이 모션에 기초하여 좌표 공간을 수립하는 것에 의해 손-눈 교정을 수행하는 것을 포함할 수 있다. 대안적으로, 이것은, 체커 격자 교정 판과 같은 특별한 교정 타깃의 이미지(들)를 사용하여 달성될 수 있는 교정 프로세스를 포함할 수 있고, 이에 의해 이 장소에서 모든 카메라를 각 좌표 공간으로 묶을 수 있다. 단계(330)에서, 실행시간 작업물의 이미지는 제1 장소에서 작업물을 보는 하나 이상의 카메라(들)에 의해 취득되고, 실행시간 작업물에 있는 특징들의 장소들은 제1 장소에서 식별/추출된다. 식별/추출된 특징들은 - 일반적으로 단계(340)에서 제1 장소와 관련된 제1 교정된 좌표 공간에 대해 작업물을 연관시키는데 사용된다. 이 특징들은 작업물에 있는 임의의 식별가능한 시각적 요소일 수 있고, 특히 작업물의 배향과 장소를 단독으로 또는 조합으로 고유하게 한정하는 요소일 수 있다. 따라서, 에지(edge)와 코너(corner)가 식별된 특징으로 사용되는 경우, 이 에지와 코너는 전체적인 작업물에 있는 특정 장소(예를 들어 작업물의 일측에 있는 노치(notch))에 고유할 수 있다. 특징 추출은 이 기술 분야에 통상의 지식에 따라 여러 비전 시스템 도구(예를 들어, 에지 검출기, 블랍 분석기 등)(162)(도 1)를 사용하여 달성될 수 있다.

단계(350)에서, 실행시간 작업물은 (예를 들어 흡입 컵(125)을 도 1에서 실행시간 작업물(124)에 적용하는 것에 의해) 조작기에 의해 파지되고, 작업물은 제2 장소로 이동된다. 이 모션은 적어도 한번 일어난다(그리고 아래 도 7을 참조하여 설명된 바와 같이 상이한 포즈를 사용하여 다수회 일어날 수 있다). 이후, 단계(360)에서, 제2 장소에서 (작업물 특징을 보는) 카메라(들)는 (이미지 좌표 공간에서) 작업물의 하나 이상의 이미지를 취득한다. 제1 장소에서 본 특징과 동일한 특징이거나, 또는 상이한 특징은 제2 장소에서 작업물에서 장소를 찾기 위해 제2 장소에서 사용된다. 특징들이 동일한 것인 경우, 2개의 좌표 공간들은 직접 묶일 수 있다. 특징들이 상이한 경우, (즉, 작업물을 측정하고 크기를 저장하는 좌표 측정 기계(CMM)를 사용하여) CAD 드로잉 또는 측정된 표현/렌디션과 같은 작업물의 사양에 의해 각 장소에서 특징들은 비전 시스템 교정 프로세스에 의해 대응될 수 있다. 대응되는 특징에 의해 각 좌표 공간은 함께 묶일 수 있다. 장소들 중 하나의 장소가 단계(320)를 통해 손-눈 교정되는 경우, 연산된 공통 좌표 공간은 모션 스테이지의 모션 좌표 공간과 동일한 것일 수 있는 것으로 주목된다.

도 4 및 도 5는 도 3의 일반화된 프로세스에 따라 제1 장소와 제2 장소에서의 좌표 공간들을 함께 묶는 2개의 이산 방법/프로세스(400 및 500)를 각각 보다 상세히 설명하는 도면이다. 도 4에서, 프로세스(400)는 하나 이상의 카메라가 2개의 장소를 이미징하도록 배열되는 단계(410)를 포함하고, 여기서 하나의 카메라는 모션 스테이지를 포함할 수 있다. 전술된 바와 같이, 선택적인 손-눈 교정은 모션 스테이지로 장소를 보는 카메라(들)에 의해 수행되어 교정된 좌표 공간을 수립할 수 있다. 보다 일반적으로, 단계(420)와 단계(430)에서, 제1 장소와 제2 장소를 이미징하는 카메라(들)는 적절한 교정 타깃을 사용하여 교정될 수 있다. 단계(440)에서, 카메라(들)는 제1 장소에서 작업물의 하나 이상의 이미지를 취득하고, 이미지는 적절한 비전 시스템 도구를 사용하여 작업물에서 특징(특징이미지1)을 찾는데 사용된다(단계(450)). 이 특징들은 제1 장소에서 교정된 좌표 공간으로 맵핑될 수 있다(특징교정된1 = 이미지1로부터교정된1 * 특징이미지1). 실행시간 작업물은 이후 조작기에 의해 파지되어 제2 장소로 이동된다. 여기서 카메라(들)가 실행시간 물체의 이미지(들)를 취득한다(단계(460)). 이 기술에서, 동일한 특징(특징이미지1)은 또한 제2 장소에서 카메라(들)에 의해서도 보인다(특징이미지2). 단계(470)에서, 제2 장소에서 카메라(들)는, 따라서, 실행시간 작업물에서 동일한 특징을 찾고 프로세스(400)는 제2 장소에서 교정 데이터에 기초하여 장소를 맵핑한다(특징교정된2 = 이미지2로부터교정된2 * 특징이미지2). 이후, 단계(480)에서, 프로세스(400)는 변환(교정된2로부터교정된1)을 연산하고, 특징교정된2를 (단계(450)로부터) 특징교정된1로 맵핑한다. 이 변환은 다음 관계에 따라 2개의 장소에서 좌표 공간들을 묶는데 사용된다:

특징교정된1 = 교정된2로부터교정된1 * 특징교정된2

스테이지를 포함하는 장소가 선택적으로 손-눈 교정된 경우, 변환(교정된2로부터교정된1)이 손-눈 교정 결과와 조합하여 사용되어 실행시간 동안 부품의 조립을 가이드할 수 있다.

도 5에서, 프로세스(500)는 하나의 장소가 모션 스테이지를 포함할 수 있는 2개의 장소를 이미징하도록 하나 이상의 카메라를 배열하는 단계(510)를 포함한다. 전술된 바와 같이, 선택적인 손-눈 교정은 모션 스테이지로 장소를 보는 카메라(들)에 의해 수행되어 교정된 좌표 공간을 수립할 수 있다. 단계(520)와 단계(530)에서, 제1 장소와 제2 장소는 적절한 교정 타깃을 사용하여 교정될 수 있다. 단계(540)에서, 카메라(들)는 제1 장소에서 작업물의 하나 이상의 이미지를 취득하고, 이미지는 적절한 비전 시스템 도구를 사용하여 작업물에서 특징(특징이미지1)을 찾는데 사용된다. 단계(550)에서, 이 특징은 제1 장소에서 교정된 좌표 공간(특징교정된1)으로 맵핑될 수 있다. 단계(560)에서 프로세스(500)는 제1 장소에서 (단계(550)로부터) 제1 교정된 좌표 공간에서의 작업물 특징(특징교정된1)을 저장된 작업물 좌표 공간으로 다음 관계에 따라 맵핑하는 변환(교정된1로부터작업물)을 연산한다:

특징작업물 = 교정된1로부터작업물 * 특징교정된1

작업물 좌표 공간은 특징 파라미터의 표현을 포함하는 작업물의 CAD (computer aided design) 모델에 기초하여 수립된다. 대안적으로, 실행시간 작업물 좌표 공간의 사양은 - 이 기술 분야에 통상의 지식에 따라 예를 들어 좌표 측정 기계(CMM)를 사용하여 - 작업물의 물리적 측정에 의해 수립될 수 있다. 파라미터는 맵핑 프로세스에 의해 사용을 위해 저장된다.

실행시간 작업물은 이후 조작기에 의해 파지되어 제2 장소로 이동된다. 여기서 카메라(들)가 실행시간 물체의 이미지(들)를 취득한다(단계(570)). 이 기술에서, 제2 장소에서 본 특징들 중 하나 이상은 제1 장소에서 본/이미징된 특징과는 상이할 수 있다. 이것은 동일한 특징들이 장애물로 인해 두 장소에서 카메라(들)에 보이지 않을 때, 카메라(들)의 시야(FOV) 등에 보이지 않을 초래될 수 있다. 단계(580)에서, 제2 장소에서 카메라(들)는, 실행시간 작업물에서 보이는 특징특징(featVisIn2이미지2)을 찾고, 장소들은 제2 장소에서 교정 데이터에 기초하여 맵핑(featVisIn2교정된2 = 이미지2로부터교정된2 * featVisIn2이미지2)된다. 작업물 좌표 공간에서 대응하는 점(featVisIn2작업물)들이 발견되었다. 이후, 단계(590)에서, 프로세스(500)는 단계(560)로부터 역변환(교정된1로부터작업물)을 사용하여 제2 장소에서 보이는 특징들이 제1 장소에 있었을 때 제1 교정된 공간에서 제2 장소에서 보이는 특징들의 장소를 연산한다:

featVisIn2교정된1 = 작업물로부터교정된1 * featVisIn2작업물.

단계(592)에서, 제1 장소로부터 연산된 특징 장소와, 제2 장소에서 대응하는 검출된 특징 장소를 사용하여 다음 관계에 따라 각 장소에서 좌표 공간들을 묶는다:

featVisIn2교정된1 = 교정된2로부터교정된1 * featVisIn2교정된2

스테이지를 포함하는 장소가 손-눈 교정된 경우, 변환(교정된2로부터교정된1)은 손-눈 교정 결과와 조합하여 사용되어 실행시간 동안 부품의 조립을 가이드할 수 있다.

여러 실시예에서, 제1 장소에서 이미지 좌표 공간으로부터 교정 좌표 공간으로 맵핑하는 것은 단위 맵핑일 수 있는 것이 명시적으로 고려된다. 이 기술은 제2 장소가 교정되는 배열을 포함하고, 제1 장소에서 이미지 특징들은 도 3 내지 도 5에 설명된 바와 같이 제2 장소에서 교정 좌표 공간으로 맵핑된다.

도 6은 제1 장소 카메라(들)와 제2 장소 카메라(들)가 교정되지 않은 2개의 이산 장소들의 좌표 공간들을 함께 묶는 다른 고려되는 기술에 따른 방법/프로세스(600)를 상술한다. 이 배열에서 각 장소는 별개로 손-눈 교정될 수 있고, 두 장소는 모션 스테이지에 대해 동일한 공통 좌표 공간으로 묶이는 것으로 고려된다. 단계(610)에서, 카메라(들)는 각 장소를 이미징하도록 배열된다. 모션 스테이지를 포함하는 장소(즉, 제1 장소)는 단계(620)에서 손-눈 교정된다. 실행시간 작업물은 단계(630)에서 스테이지를 포함하는 제1 장소에 배치된다. 실행시간 작업물은 이후 단계(640)에서 파지되어 제2 장소로 이동되고, 여기서 하나 이상의 이미지들이 카메라(들)에 의해 취득된다. 작업물에서 특징들이 단계(650)에서 발견된다. 선택적으로 작업물의 CAD 또는 CMM 사양이 이용가능한 경우, 이러한 특징들은 작업물 좌표 공간의 CAD 또는 CMM 표현에 대해 대응할 수 있다. 이 특징들로부터 유도된 포즈는 리스트(X11)에 저장된다. 작업물은 단계(660)에서 다시 파지되고 제1 장소/스테이지 장소로 되이동된다. 스테이지가 이동될 때, 단계(640, 650 및 660)는 반복되고, 충분한 데이터가 캡처되어 리스트(X11)에 저장될 때까지, 각 반복(단계(680))에서 새로운 포즈를 수립한다. 프로세스(600)는 (판정 단계(670)를 통해) 단계(690)로 진행하여 단계(650)로부터 누적된 데이터(리스트(X11))를 사용하여 제2 장소에서 카메라(들)를 손-눈 교정한다. 두 장소에서 카메라 교정된 좌표 공간들이 이에 따라 모션 스테이지에 대해 공통 좌표 공간에 의해 함께 묶여진다.

방법/프로세스(400 및 500)(도 4에서 단계(450, 470) 및 도 5에서 단계(550 및 580))는 실행시간 작업물로부터 특징을 추출하는 것을 반복적으로 수행하는 것에 의해 향상될 수 있다. 이 향상된 프로세스(700)의 개요는 도 7에 설명된다. 단계(710)에서, 하나 이상의 이미지가 제1 장소에서 실행시간 작업물에 대해 취득되고, 특징들이 추출/식별된다. 작업물은 이후 단계(720)에서 조작기에 의해 파지되어 이동되고, 특징(전술된 바와 같이 동일하거나 또는 상이한 특징)들이 추출/식별된다. 조작기는 작업물을 제1 장소로 반복적으로 리턴하고, 그 때마다 대략 포즈를 변경하거나(단계(730)) 또는 대략 상이한 포즈를 갖는 다수의 작업물을 전달한다. 즉, 교정 정밀도와 강력함이 장소들 사이에 모션 사이클을 통해 각 실행되는 일련의 상이한 작업물의 동일한 작업물에 있는 특징을 추출하고 이 특징을 누적하는 것을 다수회 반복하는 것을 통해 향상될 수 있다. 각 반복 동안, 제1 장소와 제2 장소에 있는 이미지로부터 특징들이 충분한 특징 데이터가 획득될 때까지 단계(710)와 단계(720)를 통해 추출된다. 그 임계값은 설정된 횟수의 반복 또는 다른 메트릭에 기초할 수 있다. 프로세스(700)는 (판정 단계(740)를 통해) 단계(750)로 진행하고 여기서 다수의 포즈로부터 누적된 특징 데이터를 사용하여 일반적으로 전술된 바와 같이 각 장소에서의 좌표 공간들을 함께 묶는다.

실행시간 작업물을 사용하여 조립 프로세스에서 2개의 이산 장소에 있는 좌표 공간들을 함께 묶는 전술된 기술은 교정 타깃을 사용하는 것과 연관된 단점을 회피하는 것이 명백하다. 이 기술은 카메라들이 각 장소에 대해 배열되는 방식에 융통성을 제공한다. 이 기술은 또한 특징을 추출하는 것과 같은 여러 단계를 반복하는 것을 통해 정밀도를 향상/개선할 수 있다. 이 기술은 또한 알려진 기계적인 배열 또는 반복적인 시행 착오 접근법에 의존하는 전술된 선행 기술의 단점을 회피한다.

상기 사항은 본 발명의 예시적인 실시예의 상세한 설명이다. 본 발명의 사상과 범위를 벗어남이 없이 여러 변형과 추가가 이루어질 수 있다. 상기 설명된 여러 실시예들 각각의 특징은 연관된 새로운 실시예에서 다수의 특징적 조합을 제공하기 위하여 적절한 경우 다른 설명된 실시예의 특징과 결합될 수 있다. 나아가, 상기 사항은 본 발명의 장치 및 방법의 다수의 별개의 실시예를 설명하지만, 본 명세서에서 설명된 것은 본 발명의 원리를 적용하는 단지 하나의 예시일 뿐이다. 예를 들어, 본 명세서에서 사용된 바와 같이 "프로세스" 및/또는 "프로세서"라는 용어는 다양한 전자 하드웨어 및/또는 소프트웨어 기반 기능과 성분(및 대안적으로 기능적 "모듈" 또는 "요소"라고 언급될 수 있다)을 포함하도록 넓게 해석되어야 한다. 나아가, 도시된 프로세스 또는 프로세서는 다른 프로세스 및/또는 프로세서와 결합되거나 또는 여러 서브-프로세스 또는 프로세서로 분할될 수 있다. 이러한 서브-프로세스 및/또는 서브-프로세서는 본 명세서에서 실시예에 따라 다양하게 결합될 수 있다. 마찬가지로, 본 명세서에서 임의의 기능, 프로세스 및/또는 프로세서는 전자 하드웨어, 프로그램 명령의 비-일시적인 컴퓨터-판독가능한 매체로 구성된 소프트웨어, 또는 하드웨어와 소프트웨어의 조합을 사용하여 구현될 수 있는 것으로 명확히 고려된다. 추가적으로, 본 명세서에서 사용된 바와 같이 "수직", "수평", "업", "다운", "바텀", "탑", "측면", "전방", "후방", "좌측", "우측" 등과 같은 여러 방향성 및 배향성 용어는 상대적인 규약으로 사용된 것일 뿐, 중력의 작용 방향과 같은 고정된 좌표 공간 또는 시스템에 대해 절대적 배향으로 사용된 것이 아니다. 예시적으로, 하나의 장소는 장소 스테이지를 포함하지만, 다수의 장소는 스테이지를 포함할 수 있고 - 예를 들어 제1 모션 스테이지는 하나의 축을 따라 작업물을 이동시키고 제2 스테이지는 다른 직교 축을 따라 작업물을 이동시키는 (또는 제1 스테이지에 의해 회전은 제공되지 않는다) 것이 고려된다. 따라서, 본 상세한 설명은 단지 예로서 제시된 것일 뿐, 본 발명의 범위를 제한하려고 의도된 것이 아니다.

Claims (20)

- 제1 장소(location)에 있는 제1 작업물이 조작기(manipulator)에 의해 제2 장소로 전달되는 환경에서 비전 시스템(vision system)을 교정하는 방법으로서, 상기 제1 작업물에서 수행되는 동작은 상기 제1 장소와 상기 제2 장소의 좌표 공간들을 함께 묶는 것에 의존하고, 상기 방법은,

상기 제1 작업물이 상기 제1 장소에 위치된 때 상기 제1 작업물을 이미징하고, 상기 제2 장소에 위치된 때 상기 제1 작업물을 이미징하도록 적어도 하나의 비전 시스템 카메라를 배열하는 단계;

상기 제1 장소에 대해 적어도 하나의 비전 시스템 카메라를 교정하여 제1 좌표 공간을 한정하는 제1 교정 데이터(calibration data)를 유도하고, 상기 제2 장소에 대해 적어도 하나의 비전 시스템 카메라를 교정하여 제2 좌표 공간을 한정하는 제2 교정 데이터를 유도하는 단계;

상기 제1 장소에서 상기 제1 작업물의 제1 이미지로부터 적어도 상기 제1 작업물의 특징을 식별하는 단계;

상기 제1 이미지에서 식별된 특징에 기초하여 상기 제1 장소에 대한 상기 제1 좌표 공간에 대해 상기 제1 작업물을 찾는 단계;

상기 조작기에 의해, 상기 제1 작업물을 파지하고, 적어도 한번, 상기 제2 장소에 있는 미리 결정된 조작기 위치로 이동시키는 단계;

상기 제2 장소에 있는 상기 제1 작업물의 제2 이미지를 취득하는 단계; 및

상기 제2 이미지에서 식별된 특징에 기초하여, 상기 제2 장소에 대한 상기 제2 좌표 공간에 대해 상기 제1 작업물을 찾고, 상기 제1 좌표 공간과 상기 제2 좌표 공간을 함께 묶는 단계를 포함하는 것을 특징으로 하는 방법. - 제1항에 있어서, 상기 제1 이미지에서 식별된 특징은 상기 제2 이미지에서 식별된 특징과 동일하고, 상기 방법은, (a) 상기 제1 교정 데이터에 대해 상기 제1 이미지에서 식별된 특징의 장소를 맵핑하는 단계, (b) 상기 제2 교정 데이터에 대해 상기 제2 이미지에서 식별된 특징의 장소를 맵핑하는 단계, 및 (c) 상기 제2 장소에서 맵핑된 특징을 상기 제1 장소에서 맵핑된 특징으로 맵핑하는 변환을 연산하는 단계를 더 포함하는 것을 특징으로 하는 방법.

- 제1항에 있어서, 상기 제1 이미지에서 식별된 특징들 중 일부는 상기 제2 이미지에서 식별된 특징들과는 상이하고, 상기 방법은, (a) 상기 제1 교정 데이터에 대해 상기 제1 이미지에서 식별된 특징의 장소를 맵핑하는 단계, (b) 상기 제1 작업물의 특징 장소의 저장된 사양에 대해 변환을 연산하는 단계, (c) 상기 제2 교정 데이터에 대해 상기 제2 이미지에서 식별된 특징의 장소를 맵핑하는 단계, (d) 단계 (b)에서 연산된 변환을 사용하여 상기 작업물이 상기 제1 장소에 위치된 때 상기 제1 좌표 공간에서 상기 제2 이미지로부터 상기 식별된 특징의 장소를 유도하는 단계, 및 (e) 상기 제2 장소에서 상기 맵핑된 특징을 상기 제1 장소에서 대응하는 변환된 특징으로 맵핑하는 변환을 연산하는 단계를 더 포함하는 것을 특징으로 하는 방법.

- 제3항에 있어서, 상기 사양은 상기 제1 작업물의 CAD 모델에 기초하는 것을 특징으로 하는 방법.

- 제3항에 있어서, 상기 사양은 상기 제1 작업물의 측정된 모델에 기초하는 것을 특징으로 하는 방법.

- 제1항에 있어서, (a) 상기 제1 장소 또는 상기 제2 장소에서 모션 렌더링 디바이스(motion rendering device)로 상기 제1 작업물을 복수의 상이한 포즈(pose)로 반복적으로 이동하는 단계, (b) 상기 제1 장소와 상기 제2 장소의 각각에서 각 상기 포즈에서 특징을 식별하는 단계, 및 (c) 정밀도를 향상시키기 위해 상기 식별된 특징 정보를 누적시키는 단계를 더 포함하고, 상기 제1 작업물은 동일한 작업물이거나 또는 복수의 이산 작업물 중 하나의 작업물인 것을 특징으로 하는 방법.

- 제1항에 있어서, 이미지 좌표 시스템으로부터 상기 제1 장소에서 교정 좌표 시스템으로 맵핑을 제공하는 단계를 더 포함하고, 상기 맵핑은 단위 맵핑인 것을 특징으로 하는 방법.

- 제1항에 있어서, 상기 제2 장소는 상기 제1 작업물이 상기 제2 작업물과 원하는 정렬로 맞물려 배치된 제2 작업물을 구비하는 것을 특징으로 하는 방법.

- 제8항에 있어서, 상기 제2 작업물은 상기 제1 작업물을 더 처리하기 위해 부품, 컨테이너 또는 프레임워크인 것을 특징으로 하는 방법.

- 제1항에 있어서, 상기 동작은 다른 물체에 대한 정렬 동작, 상기 제1 작업물에 인쇄 동작, 및 상기 제1 작업물에 적용 동작 중 적어도 하나인 것을 특징으로 하는 방법.

- 제10항에 있어서, 상기 동작은 상기 제1 장소와 상기 제2 장소로부터 원격 장소에서 적어도 부분적으로 수행되는 것을 특징으로 하는 방법.

- 제1 장소에서 제1 작업물이 조작기에 의해 제2 장소로 전달되는 환경에서 비전 시스템을 교정하는 방법으로서, 상기 제1 작업물에 수행되는 동작은 상기 제1 장소와 상기 제2 장소의 좌표 공간들을 함께 묶는 것에 의존하고, 상기 방법은,

(a) 상기 제1 장소에서 상기 제1 작업물을 이미징하고 상기 제2 장소에서 상기 제1 작업물을 이미징하도록 적어도 하나의 비전 시스템 카메라를 배열하는 단계;

(b) 상기 제1 장소에 대해 적어도 하나의 비전 시스템 카메라를 손-눈(hand-eye)으로 교정하여 제1 교정 데이터를 유도하는 단계;

(c) 상기 제1 장소에서 상기 제1 작업물을 위치시키는 단계;

(d) 상기 제1 장소로부터 상기 제2 장소로 상기 제1 작업물을 이동시키는 단계;

(e) 상기 제1 작업물에 대한 이미지를 취득하고 상기 제1 작업물에서 특징을 찾는 단계;

(f) 상기 제1 작업물을 상기 제2 장소로부터 상기 제1 장소로 이동시키고, 모션 렌더링 디바이스를 새로운 알려진 포즈로 이동시키는 것에 의해 상기 제1 장소에서 상기 제1 작업물의 포즈를 변경하는 단계;

(g) 손-눈 교정과 관련된 특징 장소 및 다른 데이터가 누적될 때까지 단계 (d) 내지 단계(f)를 반복하는 단계; 및

(h) 상기 누적된 데이터를 사용하여 상기 제2 장소에 대해 적어도 하나의 비전 시스템 카메라를 손-눈 교정하고, 상기 손-눈 교정으로부터 획득된 상기 모션 렌더링 디바이스에 대해 상기 공통 좌표 공간에 의해 상기 제1 좌표 공간과 상기 제2 좌표 공간을 함께 묶는 단계를 포함하는 것을 특징으로 하는 방법. - 제12항에 있어서, 상기 제2 장소는 상기 제1 작업물이 상기 제2 작업물과 원하는 정렬로 맞물려 배치된 제2 작업물을 상기 모션 렌더링 디바이스에 구비하는 것을 특징으로 하는 방법.

- 제13항에 있어서, 상기 제2 작업물은 상기 제1 작업물을 더 처리하기 위해 부품, 컨테이너 또는 프레임워크인 것을 특징으로 하는 방법.

- 제12항에 있어서, 상기 동작은 다른 물체에 대한 정렬 동작, 상기 제1 작업물에 인쇄 동작, 및 상기 제1 작업물에 적용 동작 중 적어도 하나의 동작인 것을 특징으로 하는 방법.

- 제1 장소에서 제1 작업물이 조작기에 의해 제2 장소로 전달되는 환경에서 비전 시스템을 교정하는 시스템으로서, 상기 제1 작업물에 수행되는 동작은 상기 제1 장소와 상기 제2 장소의 좌표 공간들을 함께 묶는 것에 의존하고,

상기 제1 작업물이 상기 제1 장소에 위치된 때 상기 제1 작업물을 이미징하고, 상기 제2 장소에 위치된 때 상기 제1 작업물을 이미징하도록 배열된 적어도 하나의 비전 시스템 카메라;

상기 제1 장소에 대해 적어도 하나의 비전 시스템 카메라를 교정하여 제1 교정 데이터를 유도하고, 상기 제2 장소에 대해 상기 적어도 하나의 비전 시스템 카메라를 교정하여 제2 교정 데이터를 유도하는 교정 프로세스;

상기 제1 작업물의 제1 이미지로부터 상기 제1 장소에서 적어도 상기 제1 작업물의 특징을 식별하고, 상기 제1 이미지에서 식별된 특징에 기초하여, 상기 제1 장소에 대한 제1 좌표 공간에 대해 상기 제1 작업물을 찾고, 제2 장소에서 제2 이미지에서 식별된 특징에 기초하여, 상기 제2 장소에 대한 제2 좌표 공간에 대해 상기 제1 작업물을 찾는 특징 추출 프로세스; 및

상기 제1 좌표 공간과 상기 제2 좌표 공간을 함께 묶는 교정 프로세스를 포함하는 것을 특징으로 하는 시스템. - 제16항에 있어서, 상기 제2 장소는 상기 제1 작업물이 상기 제2 작업물과 원하는 정렬로 맞물려 배치된 제2 작업물을 구비하는 것을 특징으로 하는 시스템.

- 제16항에 있어서, 상기 제1 이미지에서 식별된 특징들 중 일부는 상기 제2 이미지에서 식별된 특징들과는 상이하고, 상기 교정 프로세스는, (a) 상기 제1 교정 데이터에 대해 상기 제1 이미지에서 식별된 특징의 장소를 맵핑하고, (b) 상기 제1 작업물의 특징 장소의 저장된 사양에 대해 변환을 연산하고, (c) 상기 제2 교정 데이터에 대해 상기 제2 이미지에서 식별된 특징의 장소를 맵핑하고, (d) 단계 (b)에서 연산된 변환을 사용하여 상기 작업물이 상기 제1 장소에 위치된 때 상기 제1 좌표 공간에서 상기 제2 이미지로부터 식별된 특징의 장소를 유도하고, 및 (e) 상기 제2 장소에서 상기 맵핑된 특징을 상기 제1 장소에서 대응하는 변환된 특징으로 맵핑하는 변환을 연산하도록 구성되고 배열된 것을 특징으로 하는 시스템.

- 제18항에 있어서, 상기 사양은 상기 제1 작업물의 CAD 모델에 기초하거나 또는 상기 제1 작업물의 측정된 모델에 기초하는 것을 특징으로 하는 시스템.

- 제16항에 있어서, 상기 제2 장소는 상기 제1 작업물이 상기 제2 작업물과 원하는 정렬로 맞물려 배치된 제2 작업물을 구비하는 것을 특징으로 하는 시스템.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020180129472A KR102661635B1 (ko) | 2015-08-06 | 2018-10-29 | 가이드된 어셈블리 환경에서 머신비전 좌표공간과 함께 묶기 위한 시스템 및 방법 |

Applications Claiming Priority (4)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US201562201723P | 2015-08-06 | 2015-08-06 | |

| US62/201,723 | 2015-08-06 | ||

| US15/223,436 US10290118B2 (en) | 2015-08-06 | 2016-07-29 | System and method for tying together machine vision coordinate spaces in a guided assembly environment |

| US15/223,436 | 2016-07-29 |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020180129472A Division KR102661635B1 (ko) | 2015-08-06 | 2018-10-29 | 가이드된 어셈블리 환경에서 머신비전 좌표공간과 함께 묶기 위한 시스템 및 방법 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20170017786A true KR20170017786A (ko) | 2017-02-15 |

Family

ID=57853991

Family Applications (2)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020160099392A KR20170017786A (ko) | 2015-08-06 | 2016-08-04 | 가이드된 어셈블리 환경에서 머신비전 좌표공간과 함께 묶기 위한 시스템 및 방법 |

| KR1020180129472A KR102661635B1 (ko) | 2015-08-06 | 2018-10-29 | 가이드된 어셈블리 환경에서 머신비전 좌표공간과 함께 묶기 위한 시스템 및 방법 |

Family Applications After (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020180129472A KR102661635B1 (ko) | 2015-08-06 | 2018-10-29 | 가이드된 어셈블리 환경에서 머신비전 좌표공간과 함께 묶기 위한 시스템 및 방법 |

Country Status (6)

| Country | Link |

|---|---|

| US (2) | US10290118B2 (ko) |

| JP (3) | JP6685199B2 (ko) |

| KR (2) | KR20170017786A (ko) |

| CN (2) | CN111452040B (ko) |

| DE (1) | DE102016114337B4 (ko) |

| TW (3) | TWI816056B (ko) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20190070875A (ko) * | 2017-12-13 | 2019-06-21 | 코그넥스코오포레이션 | 비전-기반 조작 시스템들의 교정 및 동작 |

Families Citing this family (35)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US10290118B2 (en) * | 2015-08-06 | 2019-05-14 | Cognex Corporation | System and method for tying together machine vision coordinate spaces in a guided assembly environment |

| JP2018094648A (ja) * | 2016-12-09 | 2018-06-21 | セイコーエプソン株式会社 | 制御装置、ロボットおよびロボットシステム |

| CN107543497B (zh) * | 2017-03-23 | 2019-10-01 | 四川精视科技有限公司 | 一种非重叠视域双目视觉测量站坐标关联方法 |

| FI127555B (en) | 2017-04-05 | 2018-08-31 | Oy Mapvision Ltd | Computer vision systems that include coordinate correction |

| JP6777604B2 (ja) * | 2017-08-28 | 2020-10-28 | ファナック株式会社 | 検査システムおよび検査方法 |

| US11830131B2 (en) * | 2018-02-06 | 2023-11-28 | Veo Robotics, Inc. | Workpiece sensing for process management and orchestration |

| JP6879238B2 (ja) * | 2018-03-13 | 2021-06-02 | オムロン株式会社 | ワークピッキング装置及びワークピッキング方法 |

| CN108436909A (zh) * | 2018-03-13 | 2018-08-24 | 南京理工大学 | 一种基于ros的相机和机器人的手眼标定方法 |

| DE102018003434A1 (de) | 2018-04-27 | 2019-10-31 | Sms Group Gmbh | Schrägwalzwerk mit hydraulischer Walzenanstellung |

| EP3788319A1 (en) | 2018-04-30 | 2021-03-10 | Path Robotics, Inc. | Reflection refuting laser scanner |

| US11040452B2 (en) * | 2018-05-29 | 2021-06-22 | Abb Schweiz Ag | Depth sensing robotic hand-eye camera using structured light |

| CN110539299B (zh) * | 2018-05-29 | 2021-08-17 | 北京京东尚科信息技术有限公司 | 机器手作业方法、控制器以及机器手系统 |

| CN109079777B (zh) * | 2018-08-01 | 2021-09-10 | 北京科技大学 | 一种机械臂手眼协调作业系统 |

| US11263780B2 (en) * | 2019-01-14 | 2022-03-01 | Sony Group Corporation | Apparatus, method, and program with verification of detected position information using additional physical characteristic points |

| CN109993800B (zh) * | 2019-03-18 | 2023-01-03 | 五邑大学 | 一种工件尺寸的检测方法、装置及存储介质 |

| DE102019107417A1 (de) * | 2019-03-22 | 2020-09-24 | Günther Battenberg | Verfahren zur Durchführung von zumindest einem Tätigkeitsprozess mittels eines Roboters |

| CN110335310B (zh) * | 2019-07-09 | 2021-07-02 | 中国大恒(集团)有限公司北京图像视觉技术分公司 | 一种非共同视野下的标定方法 |

| CN111791226B (zh) * | 2019-12-31 | 2021-12-03 | 深圳市豪恩声学股份有限公司 | 通过机器人实现组装的方法、装置及机器人 |

| TWI731548B (zh) * | 2020-01-10 | 2021-06-21 | 廣達國際機械有限公司 | 鋼構之截角加工規劃方法 |

| CN113155097B (zh) * | 2020-01-22 | 2024-01-26 | 台达电子工业股份有限公司 | 具有位姿补偿功能的动态追踪系统及其位姿补偿方法 |

| TWI727628B (zh) * | 2020-01-22 | 2021-05-11 | 台達電子工業股份有限公司 | 具有位姿補償功能的動態追蹤系統及其位姿補償方法 |

| CN111152229B (zh) * | 2020-02-24 | 2023-08-25 | 群滨智造科技(苏州)有限公司 | 3d机械视觉的机械手引导方法和装置 |

| CN111331604A (zh) * | 2020-03-23 | 2020-06-26 | 北京邮电大学 | 一种基于机器视觉的阀门旋拧柔顺作业方法 |

| CN111625001B (zh) * | 2020-05-28 | 2024-02-02 | 珠海格力智能装备有限公司 | 机器人的控制方法及装置、工业机器人 |

| WO2022016152A1 (en) | 2020-07-17 | 2022-01-20 | Path Robotics, Inc. | Real time feedback and dynamic adjustment for welding robots |

| JP7526940B2 (ja) * | 2020-09-11 | 2024-08-02 | パナソニックIpマネジメント株式会社 | 情報処理方法及び情報処理装置 |

| CN112577423B (zh) * | 2020-10-13 | 2022-09-09 | 武汉凌云光电科技有限责任公司 | 包含在运动中进行机器视觉位置定位的方法及其应用 |

| KR20220087623A (ko) * | 2020-12-17 | 2022-06-27 | 삼성전자주식회사 | 기판 처리 장치 |

| CN112879401A (zh) * | 2020-12-30 | 2021-06-01 | 富泰华精密电子(成都)有限公司 | 工件加工方法 |

| CN112853835B (zh) * | 2021-01-04 | 2022-04-19 | 中铁四局集团有限公司 | 一种用于钢轨铺设的自动控制方法与系统 |

| WO2022182894A1 (en) | 2021-02-24 | 2022-09-01 | Path Robotics Inc. | Autonomous welding robots |

| US11912513B1 (en) * | 2021-04-14 | 2024-02-27 | Amazon Technologies, Inc. | Robotic system camera calibration and localization using robot-mounted registered patterns |

| CN114378825B (zh) * | 2022-01-21 | 2023-05-12 | 四川长虹智能制造技术有限公司 | 一种多相机视觉定位方法、系统及电子设备 |

| CN115599092B (zh) * | 2022-09-07 | 2024-09-24 | 格力电器(武汉)有限公司 | 一种工件搬运控制方法、装置、设备及存储介质 |

| CN115383749B (zh) * | 2022-10-25 | 2023-03-24 | 国网瑞嘉(天津)智能机器人有限公司 | 带电作业设备的标定方法、装置、控制器及存储介质 |

Family Cites Families (63)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US4380696A (en) * | 1980-11-12 | 1983-04-19 | Unimation, Inc. | Method and apparatus for manipulator welding apparatus with vision correction for workpiece sensing |

| US4568816A (en) * | 1983-04-19 | 1986-02-04 | Unimation, Inc. | Method and apparatus for manipulator welding apparatus with improved weld path definition |

| US4655596A (en) * | 1983-10-28 | 1987-04-07 | Levi Strauss & Co. | Workpiece centering apparatus and method |

| EP0205628B1 (en) | 1985-06-19 | 1990-06-13 | International Business Machines Corporation | Method for identifying three-dimensional objects using two-dimensional images |

| US4841460A (en) | 1987-09-08 | 1989-06-20 | Perceptron, Inc. | Method and apparatus for calibrating a non-contact gauging sensor with respect to an external coordinate system |

| US4845639A (en) | 1987-12-11 | 1989-07-04 | Robotic Vision Systems, Inc. | Robotic sealant calibration |

| US4959898A (en) | 1990-05-22 | 1990-10-02 | Emhart Industries, Inc. | Surface mount machine with lead coplanarity verifier |

| US5547537A (en) | 1992-05-20 | 1996-08-20 | Kulicke & Soffa, Investments, Inc. | Ceramic carrier transport for die attach equipment |

| US6419680B1 (en) | 1993-06-10 | 2002-07-16 | Sherwood Services Ag | CT and MRI visible index markers for stereotactic localization |

| JPH08201021A (ja) | 1995-01-23 | 1996-08-09 | Mazda Motor Corp | キャリブレーション方法 |

| US6078846A (en) | 1996-02-06 | 2000-06-20 | Perceptron, Inc. | Calibration and compensation of robot-based gauging system |

| US6858826B2 (en) | 1996-10-25 | 2005-02-22 | Waveworx Inc. | Method and apparatus for scanning three-dimensional objects |

| US5960125A (en) | 1996-11-21 | 1999-09-28 | Cognex Corporation | Nonfeedback-based machine vision method for determining a calibration relationship between a camera and a moveable object |

| US5933523A (en) | 1997-03-18 | 1999-08-03 | Cognex Corporation | Machine vision method and apparatus for determining the position of generally rectangular devices using boundary extracting features |

| NL1007068C2 (nl) * | 1997-09-18 | 1999-03-22 | Nl Laser Res | Laserbewerkingsapparaat. |

| JP4387476B2 (ja) * | 1998-07-13 | 2009-12-16 | 株式会社明電舎 | ビンピッキング位置データ較正装置 |

| JP2001284899A (ja) | 2000-04-03 | 2001-10-12 | Yamagata Casio Co Ltd | 部品搭載座標補正方法 |

| US6950548B1 (en) | 2000-05-17 | 2005-09-27 | Cognex Corporation | Creating geometric model descriptions for use in machine vision inspection systems |

| US6493574B1 (en) | 2000-09-28 | 2002-12-10 | Koninklijke Philips Electronics, N.V. | Calibration phantom and recognition algorithm for automatic coordinate transformation in diagnostic imaging |

| US6819789B1 (en) | 2000-11-08 | 2004-11-16 | Orbotech Ltd. | Scaling and registration calibration especially in printed circuit board fabrication |

| US6466841B2 (en) * | 2001-02-14 | 2002-10-15 | Xerox Corporation | Apparatus and method for determining a reference position for an industrial robot |

| CH696103A5 (de) * | 2003-06-06 | 2006-12-15 | Esec Trading Sa | Halbleiter-Montageeinrichtung. |

| US7324682B2 (en) * | 2004-03-25 | 2008-01-29 | Mitutoyo Corporation | System and method for excluding extraneous features from inspection operations performed by a machine vision inspection system |

| JP4515814B2 (ja) * | 2004-04-28 | 2010-08-04 | パナソニック株式会社 | 装着精度測定方法 |

| US6901673B1 (en) | 2004-05-20 | 2005-06-07 | The Boeing Company | Tie-in device for the correlation of coordinate systems |

| EP1612843A1 (de) * | 2004-07-02 | 2006-01-04 | Unaxis International Trading Ltd | Verfahren und Einrichtung fuer die Montage von Halbleiterchips |

| US7583852B2 (en) * | 2004-10-26 | 2009-09-01 | Mitutoyo Corporation | Method of filtering an image for high precision machine vision metrology |

| US20060241432A1 (en) | 2005-02-15 | 2006-10-26 | Vanderbilt University | Method and apparatus for calibration, tracking and volume construction data for use in image-guided procedures |

| US8482732B2 (en) * | 2007-10-01 | 2013-07-09 | Maskless Lithography, Inc. | Alignment system for various materials and material flows |

| WO2009047214A2 (en) | 2007-10-09 | 2009-04-16 | Oerlikon Assembly Equipment Ag, Steinhausen | Method for picking up semiconductor chips from a wafer table and mounting the removed semiconductor chips on a substrate |

| CH698334B1 (de) | 2007-10-09 | 2011-07-29 | Esec Ag | Verfahren für die Entnahme und Montage von auf einem Wafertisch bereitgestellten Halbleiterchips auf einem Substrat. |

| CN101149836B (zh) | 2007-11-05 | 2010-05-19 | 中山大学 | 一种三维重构的双摄像机标定方法 |

| US8264697B2 (en) | 2007-11-27 | 2012-09-11 | Intelligrated Headquarters, Llc | Object detection device |

| ES2384245B9 (es) | 2008-03-21 | 2013-07-08 | Brett BORDYN | Sistema externo para mejora de la precisión robótica. |

| US8106349B2 (en) * | 2008-07-16 | 2012-01-31 | Delta Design, Inc. | Vision alignment with multiple cameras and common coordinate at contactor for IC device testing handlers |

| US7686631B1 (en) * | 2008-12-12 | 2010-03-30 | J.S.T. Corporation | Electrical connector with a latch mechanism |

| US11699247B2 (en) * | 2009-12-24 | 2023-07-11 | Cognex Corporation | System and method for runtime determination of camera miscalibration |

| JP5455123B2 (ja) * | 2010-03-03 | 2014-03-26 | 富士機械製造株式会社 | 部品実装機の撮像画像処理装置 |

| US8368762B1 (en) | 2010-04-12 | 2013-02-05 | Adobe Systems Incorporated | Methods and apparatus for camera calibration based on multiview image geometry |

| US9393694B2 (en) | 2010-05-14 | 2016-07-19 | Cognex Corporation | System and method for robust calibration between a machine vision system and a robot |

| US9508148B2 (en) * | 2010-08-27 | 2016-11-29 | Abb Research Ltd. | Vision-guided alignment system and method |

| US9021344B2 (en) | 2010-08-31 | 2015-04-28 | New River Kinematics, Inc. | Off-line graphical user interface system and method for three-dimensional measurement |

| JP5744587B2 (ja) | 2011-03-24 | 2015-07-08 | キヤノン株式会社 | ロボット制御装置、ロボット制御方法、プログラム及び記録媒体 |

| KR101591579B1 (ko) * | 2011-03-29 | 2016-02-18 | 퀄컴 인코포레이티드 | 증강 현실 시스템들에서 실세계 표면들에의 가상 이미지들의 앵커링 |

| US9188973B2 (en) | 2011-07-08 | 2015-11-17 | Restoration Robotics, Inc. | Calibration and transformation of a camera system's coordinate system |

| EP2729850A4 (en) | 2011-08-11 | 2015-07-08 | Siemens Healthcare Diagnostics | METHOD AND DEVICE FOR CALIBRATING AN ALIGNMENT OF A ROBOT GRIPPER AND A CAMERA |

| JP5924134B2 (ja) * | 2012-05-30 | 2016-05-25 | セイコーエプソン株式会社 | 侵入検出装置,ロボットシステム,侵入検出方法および侵入検出プログラム |

| CN102922521B (zh) | 2012-08-07 | 2015-09-09 | 中国科学技术大学 | 一种基于立体视觉伺服的机械臂系统及其实时校准方法 |

| US10664994B2 (en) * | 2013-02-25 | 2020-05-26 | Cognex Corporation | System and method for calibration of machine vision cameras along at least three discrete planes |

| US10477154B2 (en) * | 2013-03-07 | 2019-11-12 | Cognex Corporation | System and method for aligning two work pieces with a vision system in the presence of occlusion |

| US10032273B2 (en) | 2013-03-15 | 2018-07-24 | Cognex Corporation | Machine vision system calibration using inaccurate calibration targets |

| US9958854B2 (en) | 2013-06-10 | 2018-05-01 | The Boeing Company | Systems and methods for robotic measurement of parts |

| US9305231B2 (en) | 2013-08-01 | 2016-04-05 | Cognex Corporation | Associating a code with an object |

| US9211643B1 (en) | 2014-06-25 | 2015-12-15 | Microsoft Technology Licensing, Llc | Automatic in-situ registration and calibration of robotic arm/sensor/workspace system |

| JP5911934B2 (ja) * | 2014-09-18 | 2016-04-27 | ファナック株式会社 | 輪郭線計測装置およびロボットシステム |

| CN104268876B (zh) | 2014-09-26 | 2017-05-03 | 大连理工大学 | 基于分块的摄像机标定方法 |

| CN104625268A (zh) | 2015-01-16 | 2015-05-20 | 哈尔滨飞机工业集团有限责任公司 | 一种线切割薄板装夹装置 |

| US10223589B2 (en) * | 2015-03-03 | 2019-03-05 | Cognex Corporation | Vision system for training an assembly system through virtual assembly of objects |

| CN104819690B (zh) | 2015-04-21 | 2017-05-31 | 上海瑞伯德智能系统股份有限公司 | 一种表面贴装元件的双相机机器视觉定位方法 |

| US10290118B2 (en) * | 2015-08-06 | 2019-05-14 | Cognex Corporation | System and method for tying together machine vision coordinate spaces in a guided assembly environment |

| JP6540472B2 (ja) * | 2015-11-18 | 2019-07-10 | オムロン株式会社 | シミュレーション装置、シミュレーション方法、およびシミュレーションプログラム |

| JP6514156B2 (ja) * | 2016-08-17 | 2019-05-15 | ファナック株式会社 | ロボット制御装置 |

| US11072074B2 (en) * | 2017-12-13 | 2021-07-27 | Cognex Corporation | Calibration and operation of vision-based manipulation systems |

-

2016

- 2016-07-29 US US15/223,436 patent/US10290118B2/en active Active

- 2016-08-02 TW TW109134770A patent/TWI816056B/zh active

- 2016-08-02 JP JP2016152273A patent/JP6685199B2/ja active Active

- 2016-08-02 TW TW105124422A patent/TWI708215B/zh active

- 2016-08-02 TW TW108108676A patent/TWI708216B/zh active

- 2016-08-03 DE DE102016114337.5A patent/DE102016114337B4/de active Active

- 2016-08-04 KR KR1020160099392A patent/KR20170017786A/ko active Application Filing

- 2016-08-05 CN CN202010183812.XA patent/CN111452040B/zh active Active

- 2016-08-05 CN CN201610639067.9A patent/CN106426161B/zh active Active

-

2018

- 2018-05-21 JP JP2018097467A patent/JP7292829B2/ja active Active

- 2018-10-29 KR KR1020180129472A patent/KR102661635B1/ko active IP Right Grant

-

2019

- 2019-05-13 US US16/410,672 patent/US11049280B2/en active Active

-

2023

- 2023-01-07 JP JP2023001405A patent/JP2023052266A/ja active Pending

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20190070875A (ko) * | 2017-12-13 | 2019-06-21 | 코그넥스코오포레이션 | 비전-기반 조작 시스템들의 교정 및 동작 |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2017037642A (ja) | 2017-02-16 |

| TWI816056B (zh) | 2023-09-21 |

| US20170132807A1 (en) | 2017-05-11 |

| JP6685199B2 (ja) | 2020-04-22 |

| TW202119356A (zh) | 2021-05-16 |

| DE102016114337A1 (de) | 2017-02-09 |

| TWI708216B (zh) | 2020-10-21 |

| KR20180120647A (ko) | 2018-11-06 |

| TW201923706A (zh) | 2019-06-16 |

| CN111452040B (zh) | 2024-02-20 |

| JP2023052266A (ja) | 2023-04-11 |

| TW201706091A (zh) | 2017-02-16 |

| KR102661635B1 (ko) | 2024-04-26 |

| JP7292829B2 (ja) | 2023-06-19 |

| US11049280B2 (en) | 2021-06-29 |

| CN111452040A (zh) | 2020-07-28 |

| US20200065995A1 (en) | 2020-02-27 |

| US10290118B2 (en) | 2019-05-14 |

| CN106426161B (zh) | 2020-04-07 |

| DE102016114337B4 (de) | 2019-08-14 |

| TWI708215B (zh) | 2020-10-21 |

| JP2018169403A (ja) | 2018-11-01 |

| CN106426161A (zh) | 2017-02-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR102661635B1 (ko) | 가이드된 어셈블리 환경에서 머신비전 좌표공간과 함께 묶기 위한 시스템 및 방법 | |

| US10223589B2 (en) | Vision system for training an assembly system through virtual assembly of objects | |

| US20200238525A1 (en) | System and method for automatic hand-eye calibration of vision system for robot motion | |

| US6816755B2 (en) | Method and apparatus for single camera 3D vision guided robotics | |

| JP6180087B2 (ja) | 情報処理装置及び情報処理方法 | |

| KR102276259B1 (ko) | 비전-기반 조작 시스템들의 교정 및 동작 | |

| JP2018169403A5 (ko) | ||

| US12002240B2 (en) | Vision system for a robotic machine | |

| US20140121836A1 (en) | Object pickup device and method for picking up object | |

| CN112276936B (zh) | 三维数据生成装置以及机器人控制系统 | |

| JP2012030320A (ja) | 作業システム、作業ロボット制御装置および作業プログラム | |

| JP2016170050A (ja) | 位置姿勢計測装置、位置姿勢計測方法及びコンピュータプログラム | |

| JPWO2018043524A1 (ja) | ロボットシステム、ロボットシステム制御装置、およびロボットシステム制御方法 | |

| CN118305790A (zh) | 一种机器人视觉定位方法、标定方法、装置、设备及介质 | |

| CN118700211A (zh) | 一种用于测量机器人手眼标定精度的装置及方法 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A201 | Request for examination | ||

| E902 | Notification of reason for refusal | ||

| E601 | Decision to refuse application | ||

| A107 | Divisional application of patent | ||

| J201 | Request for trial against refusal decision | ||

| J301 | Trial decision |

Free format text: TRIAL NUMBER: 2018101004436; TRIAL DECISION FOR APPEAL AGAINST DECISION TO DECLINE REFUSAL REQUESTED 20181029 Effective date: 20190927 |