KR20160120810A - 투명 헤드 마운티드 디스플레이들에 대한 사용자 인터페이스 상호작용 - Google Patents

투명 헤드 마운티드 디스플레이들에 대한 사용자 인터페이스 상호작용 Download PDFInfo

- Publication number

- KR20160120810A KR20160120810A KR1020167028028A KR20167028028A KR20160120810A KR 20160120810 A KR20160120810 A KR 20160120810A KR 1020167028028 A KR1020167028028 A KR 1020167028028A KR 20167028028 A KR20167028028 A KR 20167028028A KR 20160120810 A KR20160120810 A KR 20160120810A

- Authority

- KR

- South Korea

- Prior art keywords

- user

- display area

- transparent display

- hmd

- active

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/012—Head tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/013—Eye tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/0304—Detection arrangements using opto-electronic means

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/0304—Detection arrangements using opto-electronic means

- G06F3/0325—Detection arrangements using opto-electronic means using a plurality of light emitters or reflectors or a plurality of detectors forming a reference frame from which to derive the orientation of the object, e.g. by triangulation or on the basis of reference deformation in the picked up image

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0481—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance

- G06F3/04817—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance using icons

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0481—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance

- G06F3/0482—Interaction with lists of selectable items, e.g. menus

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0484—Interaction techniques based on graphical user interfaces [GUI] for the control of specific functions or operations, e.g. selecting or manipulating an object, an image or a displayed text element, setting a parameter value or selecting a range

- G06F3/04842—Selection of displayed objects or displayed text elements

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/014—Head-up displays characterised by optical features comprising information/image processing systems

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0179—Display position adjusting means not related to the information to be displayed

- G02B2027/0187—Display position adjusting means not related to the information to be displayed slaved to motion of at least a part of the body of the user, e.g. head, eye

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F2203/00—Indexing scheme relating to G06F3/00 - G06F3/048

- G06F2203/048—Indexing scheme relating to G06F3/048

- G06F2203/04808—Several contacts: gestures triggering a specific function, e.g. scrolling, zooming, right-click, when the user establishes several contacts with the surface simultaneously; e.g. using several fingers or a combination of fingers and pen

Landscapes

- Engineering & Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Human Computer Interaction (AREA)

- Optics & Photonics (AREA)

- User Interface Of Digital Computer (AREA)

- Processing Or Creating Images (AREA)

- Controls And Circuits For Display Device (AREA)

Abstract

본 발명의 실시형태들은 사용자가 HMD 에 의해 디스플레이되는 그래픽 사용자 인터페이스 (GUI) 와 빠르게 상호작용하는 것을 가능하게 하는 것을 지향한다. 본 명세서에서 제공된 기술들을 이용하여, HMD 에 의해 디스플레이되는 시각적 요소들을 선택하기 위해 손 또는 다른 객체가 이용될 수 있다. 시각적 요소들은 보다 큰 활성 구역들 내에 위치될 수 있어, 사용자로 하여금 시각적 요소가 배치되는 활성 구역을 선택함으로써 시각적 요소를 보다 쉽게 선택할 수 있도록 허용한다.

Description

투시 헤드 마운티드 디스플레이 (head-mounted display; HMD) 는, 사용자의 시야 내에 투명 디스플레이 영역을 제공할 수 있고, 이 투명 디스플레이 영역에서, 사용자는 사용자의 주위환경에서의 물리적 객체들 및 디스플레이 상의 가상적 객체들 양자 모두를 볼 수 있다. 일부 HMD 들은, 물리적 객체들과 연관되거나 예를 들어 사용자의 위치 및/또는 상황과 연관된 (텍스트, 화상들, 및/또는 비디오와 같은) 디지털 콘텐츠와 사용자에 의해 보여지는 물리적 객체들을 중첩시킴으로써, "증강 현실 (augmented reality)" 기능을 제공할 수 있다. 이러한 HMD 들에 대한 입력은 통상적으로 버튼들, 터치 패드, 또는 다른 간단한 입력 디바이스들로 제한된다. 이들 입력 디바이스들은 부피가 크고 비효율적이다.

본 발명의 실시형태들은 사용자가 손 및/또는 다른 객체들을 이용하여 헤드 마운티드 디스플레이 (HMD) 에 의해 디스플레이되는 그래픽 사용자 인터페이스 (graphical user interface; GUI) 와 빠르게 상호작용 (interact) 하는 것을 가능하게 하는 것을 지향한다. 본 명세서에서 제공된 기술들을 이용하여, HMD 에 의해 디스플레이되는 시각적 요소들을 선택하기 위해 손 또는 다른 객체가 이용될 수 있다. 시각적 요소들은 보다 큰 활성 구역들 내에 위치될 수 있어, 사용자로 하여금 시각적 요소가 배치되는 활성 구역을 선택함으로써 시각적 요소를 보다 쉽게 선택할 수 있도록 허용한다.

본 개시물에 따른, 헤드 마운티드 디스플레이 (HMD) 에서 사용자 인터페이스를 제공하는 예시적인 방법은, 제 1 시각적 요소 (visual element) 가 HMD 의 투명 디스플레이 영역에서 표시되도록 하는 단계를 포함한다. 제 1 시각적 요소는 HMD 의 사용자에 의해 선택가능하다. 이 방법은 또한, 제 1 시각적 요소가 제 1 활성 구역 (active region) 의 일부분 내에 배치되도록, 제 1 시각적 요소보다 더 큰, 투명 디스플레이 영역의 제 1 활성 구역을 정의하는 단계, 및 사용자의 시각 (perspective) 으로부터, 투명 디스플레이 영역 내에 나타나는 물리적 객체 (physical object) 를 추적 (tracking) 하는 단계를 포함한다. 이 방법은, 제 1 시각적 요소의 선택을 나타내는, 사용자의 시각으로부터 물리적 객체의 적어도 일부분이 제 1 활성 구역 내에 나타나는 것을 결정하는 단계, 및 그 선택에 기초하여, 프로세싱 유닛으로 사용자 인터페이스를 조작 (manipulating) 하는 단계를 더 포함한다.

본 개시물에 따른 예시적인 HMD 는, 투명 디스플레이 영역을 갖는 디스플레이, HMD 의 사용자에 의해 투명 디스플레이 영역을 통해 볼 수 있는 객체들 (objects) 에 관한 데이터를 제공하도록 구성된 센서, 디스플레이 및 센서와 통신가능하게 커플링된 (communicatively coupled) 프로세싱 유닛을 포함한다. 프로세싱 유닛은, 디스플레이로 하여금 사용자에 의해 선택가능한 제 1 시각적 요소를 투명 디스플레이 영역에서 보여주도록 하는 것, 및 제 1 시각적 요소가 제 1 활성 구역의 일부분 내에 배치되도록 투명 디스플레이 영역의 제 1 활성 구역을 정의하는 것을 포함하는 기능들을 수행하도록 구성된다. 프로세싱 유닛은, 사용자의 시각으로부터, 투명 디스플레이 영역 내에 나타나는 물리적 객체를 추적하기 위해 센서로부터의 데이터를 이용하도록 더 구성된다. 더욱이, 프로세싱 유닛은, 제 1 시각적 요소의 선택을 나타내는, 사용자의 시각으로부터 물리적 객체의 적어도 일부분이 제 1 활성 구역 내에 나타나는 것을 결정하고, 그 선택에 기초하여 디스플레이 상에 표시되는 하나 이상의 요소들을 조작하도록 또한 구성된다.

본 개시물에 따른, 예시적인 컴퓨터 판독가능 저장 매체는, HMD 로 하여금, HMD 의 사용자에 의해 선택가능한 제 1 시각적 요소가 HMD 의 투명 디스플레이 영역에서 표시되도록 하는 것, 및 제 1 시각적 요소가 제 1 활성 구역의 일부분 내에 배치되도록, 제 1 시각적 요소보다 더 큰, 투명 디스플레이 영역의 제 1 활성 구역을 정의하는 것을 포함하는 기능들을 수행하게 하기 위한 명령들로 인코딩된다. 이 명령들은 또한, HMD 로 하여금, 사용자의 시각으로부터, 투명 디스플레이 영역 내에 나타나는 물리적 객체를 추적하게 하고, 그리고, 제 1 시각적 요소의 선택을 나타내는, 사용자의 시각으로부터 물리적 객체의 적어도 일부분이 제 1 활성 구역 내에 나타나는 것을 결정하게 한다. 이 명령들은 추가로 HMD 로 하여금, 그 선택에 기초하여, 투명 디스플레이 영역에서 표시되는 하나 이상의 요소들을 조작하게 한다.

본 개시물에 따른 예시적인 장치는, HMD 의 사용자에 의해 선택가능한 제 1 시각적 요소가 HMD 의 투명 디스플레이 영역에서 표시되도록 하는 수단을 포함한다. 이 장치는 또한, 제 1 시각적 요소가 제 1 활성 구역의 일부분 내에 배치되도록, 투명 디스플레이 영역의 제 1 활성 구역을 정의하는 수단, 및 사용자의 시각으로부터, 투명 디스플레이 영역 내에 나타나는 물리적 객체를 추적하는 수단을 포함한다. 이 장치는 추가로, 제 1 시각적 요소의 선택을 나타내는, 사용자의 시각으로부터 물리적 객체의 적어도 일부분이 제 1 활성 구역 내에 나타나는 것을 결정하는 수단, 및 그 선택에 기초하여, 프로세싱 유닛으로 하나 이상의 요소들을 조작하는 수단을 더 포함한다.

본 명세서에서 설명된 항목들 및/또는 기술들은 다음의 능력들 중 하나 이상 뿐만 아니라 다른 언급되지 않은 능력들을 제공할 수도 있다. 이 기술들은 큰 활성 구역들 내에 시각적 요소들을 제공함으로써 GUI 를 쉽게 내비게이팅하는 것을 제공할 수 있다. 또한, 선택된 시각적 요소 및 대응하는 활성 구역은 추가적인 상호작용을 위해 추가적인 시각적 요소들 및 대응하는 활성 구역들 (예를 들어 하위 메뉴를 제공) 로 대체될 수도 있다. 이들 및 다른 실시형태들은, 많은 그것의 이점들 및 특징들과 함께, 이하의 문장 및 첨부된 도면들과 함께 보다 자세히 설명된다.

다양한 실시형태들의 성질 및 이점들의 추가적인 이해는 이하의 도면들을 참조하여 실현될 수도 있다. 첨부된 도면들에서, 유사한 컴포넌트들 또는 특징들은 동일한 참조 레벨을 가질 수도 있다. 또한, 동일 유형의 다양한 컴포넌트들은, 유사한 컴포넌트들 사이에 구분하는 대시 및 제 2 라벨이 참조 라벨 다음에 옴으로써 구별될 수도 있다. 오직 제 1 참조 라벨만이 명세서에서 사용되는 경우, 설명은 제 2 참조 라벨에 관계없이 동일한 제 1 참조 라벨을 갖는 유사한 컴포넌트들 중 임의의 것에 적용가능하다.

도 1 은, 일 실시형태에 따라, 헤드 마운티드 디스플레이 (HMD) 를 추적하는 객체의 단순화된 예시이다.

도 2 는 본 명세서에서 제공된 기술들을 활용할 수 있는 HMD 의 다양한 실시형태들의 예시이다.

도 3 은 일 실시형태에 따라, 사용자의 시각으로부터 HMD 를 통한 뷰를 나타낸다.

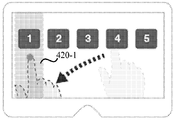

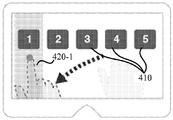

도 4a 내지 도 4e 는, 일 실시형태에 따라, 어떻게 물리적 객체의 추적이 사용자가 HMD 의 사용자 인터페이스를 통해 빠르게 내비게이트하는 것을 가능하게 할 수 있는지를 보여주는 일련의 예시들이다.

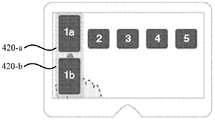

도 5a 내지 도 5c 는 어떻게 그래픽 사용자 인터페이스 (GUI) 가 사용자 상호작용에 응답하는지에 관한 다른 실시형태를 나타낸다.

도 6a 및 도 6b 는 일 실시형태에 따라 활성 구역들의 레이아웃 (layout) 을 보여주는 예시들이다.

도 7a 및 도 7b 는 일 실시형태에 따라 활성 구역들의 레이아웃을 보여주는 예시들이다.

도 8a 내지 도 8c 는, 일 실시형태에 따라, 어떻게 GUI 가 객체의 검출된 이동에 응답할 수도 있는지를 보여주는 예시들이다.

도 9 는 HMD 와의 사용자 상호작용을 가능하게 하는 방법의 일 실시형태를 나타내는 흐름도이다.

도 10 은 HMD 내에 통합 및/또는 HMD 와 통신가능하게 커플링될 수 있는 컴퓨터 시스템의 일 실시형태의 단순화된 블록도이다.

도 1 은, 일 실시형태에 따라, 헤드 마운티드 디스플레이 (HMD) 를 추적하는 객체의 단순화된 예시이다.

도 2 는 본 명세서에서 제공된 기술들을 활용할 수 있는 HMD 의 다양한 실시형태들의 예시이다.

도 3 은 일 실시형태에 따라, 사용자의 시각으로부터 HMD 를 통한 뷰를 나타낸다.

도 4a 내지 도 4e 는, 일 실시형태에 따라, 어떻게 물리적 객체의 추적이 사용자가 HMD 의 사용자 인터페이스를 통해 빠르게 내비게이트하는 것을 가능하게 할 수 있는지를 보여주는 일련의 예시들이다.

도 5a 내지 도 5c 는 어떻게 그래픽 사용자 인터페이스 (GUI) 가 사용자 상호작용에 응답하는지에 관한 다른 실시형태를 나타낸다.

도 6a 및 도 6b 는 일 실시형태에 따라 활성 구역들의 레이아웃 (layout) 을 보여주는 예시들이다.

도 7a 및 도 7b 는 일 실시형태에 따라 활성 구역들의 레이아웃을 보여주는 예시들이다.

도 8a 내지 도 8c 는, 일 실시형태에 따라, 어떻게 GUI 가 객체의 검출된 이동에 응답할 수도 있는지를 보여주는 예시들이다.

도 9 는 HMD 와의 사용자 상호작용을 가능하게 하는 방법의 일 실시형태를 나타내는 흐름도이다.

도 10 은 HMD 내에 통합 및/또는 HMD 와 통신가능하게 커플링될 수 있는 컴퓨터 시스템의 일 실시형태의 단순화된 블록도이다.

이하의 설명은, 동일한 참조 부호들은 전체에 걸쳐 동일한 엘리먼트들을 지칭하기 위해 사용되는, 도면들을 참조하여 제공된다. 하나 이상의 기술들의 다양한 상세들이 본 명세서에서 설명되지만, 다른 기술들이 또한 가능하다. 일부 경우들에서, 구조들 및 디바이스들은 다양한 기술들을 설명하는 것을 용이하게 하기 위해 블록도 형태로 나타난다.

본 발명의 실시형태들은 헤드 마운티드 디스플레이 (HMD) 와의 사용자 상호작용을 가능하게 하는 것을 지향한다. HMD 들은 디바이스를 착용하는 사용자에게 정보를 디스플레이할 수 있는 디바이스들이다. 또한, 이들 디바이스들은 사용자의 머리에 착용되기 때문에, HMD 들은 다른 디스플레이들에서 달성될 수 없는 능력들을 가질 수 있다. 예를 들어, HMD 들은, 사용자가 물리적 객체들 및 디스플레이 상의 가상 객체들 양자 모두를 볼 수 있는 사용자의 시야 (field of view) 내의 투명 디스플레이 영역을 제공할 수 있다. 일부 실시형태들은, 물리적 객체들과 연관되거나 예를 들어 사용자의 위치 및/또는 상황과 연관된 (텍스트, 화상들, 및/또는 비디오와 같은) 디지털 콘텐츠와 사용자에 의해 보여지는 물리적 객체들을 중첩시킴으로써, "증강 현실" 기능을 제공할 수 있다. 본 발명의 실시형태들은 추가로, 사용자에 의해 보이는 및/또는 조작된 물리적 객체가, HMD 에 의해 디스플레이되는 사용자 인터페이스 (예를 들어, 그래픽 사용자 인터페이스, 또는 "GUI") 에서 항목들을 빨리 선택하고, 및/또는, 그 사용자 인터페이스와의 다른 상호작용들을 수행하는 것을 가능하게 한다.

비록 본 명세서에서 제공된 예들은 HMD 와 상호작용하기 위해 사용되는 단일 물리적 객체 (예를 들어, 손, 손가락 등) 를 논의하지만, 본 명세서에서 제공되는 기술들은 사용자가 2 개 이상의 물리적 객체들로 HMD 에 의해 디스플레이되는 사용자 인터페이스와 상호작용하는 것을 쉽게 허용할 수 있다. 또한, 본 명세서에서는 HMD 에 대해 실시형태들이 설명되지만, 당해 기술분야에서 통상의 지식을 가진 자 (이하, '통상의 기술자' 라 함) 라면, 다른 디스플레이들 또는 다른 형태들의 헤드-업 (heads-up) 디스플레이들이 이용될 수도 있다는 것을 이해할 것이다. 예를 들어, 본 명세서에서 설명된 실시형태들은, 사용자가 착용하고 및/또는 사용자가 그것을 통해 시야를 지각할 수도 있는 다른 형태의 디스플레이에서 구현될 수도 있는 하나 이상의 콘택트 렌즈들에 대해 구현될 수도 있다.

도 1 은 일 실시형태에 따른, 사용자 인터페이스 상호작용을 위해 객체를 추적하도록 구성된 HMD (120) 의 단순화된 예시 (100) 이다. 이 실시형태에서, 사용자 (110) 에 의해 착용되는 HMD (120) 는 그것을 이용하여 사용자의 손 (130) 과 같은 객체가 추적될 수도 있는 데이터를 제공하는 카메라 및/또는 다른 센서(들) (예를 들어, 광, 열, 초음파, 무선 주파수 (RF) 신호들 등을 감지할 수 있는 센서들) 를 갖는다. 그렇게 함으로써, HMD (120) 는 HMD (120) 에 의해 표시되는 GUI 를 조작할 수 있어, 사용자 입력을 수신하기 위한 별개의 인터페이스 (예를 들어, 터치 패드, 버튼들 등) 에 대한 필요성을 제거할 수 있다. 그렇기는 하지만, 원하는 기능성에 따라, 다른 인터페이스들이 HMD (120) 내에 통합되고 및 또는 HMD (120) 와 통신가능하게 커플링될 수 있다. 또한, 하나 이상의 요소들의 표시 및/또는 GUI 의 현시 (presentation) 는 일부 실시형태들에서 생략될 수도 있다. 예를 들어, 사용자로부터 입력을 받아들일 때 아무런 시각적 요소도 표시되지 않는 실시형태들이 아래에서 설명된다. 또한, 사용자 입력에 의해 야기되거나 선택된 기능성은 성질상 시각적일 수도 있거나 시각적이 아닐 수도 있다. 본 명세서에서 설명된 기능들을 수행하기 위해, HMD (120) 는 도 10 과 관련하여 아래에서 설명되는 것과 같이, 컴퓨터 시스템을 통합 및/또는 컴퓨터 시스템과 통신할 수도 있다.

도 2 는 본 명세서에서 제공된 기술들을 이용할 수 있는 HMD (120) 의 다양한 실시형태들의 예시이다. 도시된 실시형태들은 디스플레이들 (220) 및 하나 또는 그 이상의 카메라들 (210) 을 포함한다. 이들 실시형태들은, 사용자의 눈들의 앞쪽에 디스플레이들 (220) 을 위치시키는, 사용자의 코 및 귀들 상에 걸칠 수 있는 안경과 유사한 프레임을 포함한다.

디스플레이들 (220) 의 적어도 일부분은 투명하여, 사용자가 그 디스플레이들 (220) 상에서 보이는 시각적 요소들 뿐만 아니라 사용자의 주위환경에서의 물리적 객체들도 보는 것을 가능하게 하는 투명 디스플레이 영역을 제공한다. 디스플레이들 (220) 상에서 보이는 시각적 요소들의 투명도의 레벨은, 디스플레이들 (220) 의 원하는 기능성, 디스플레이들 (220) 상에서 보이는 GUI 의 셋팅들, 및/또는 HMD (120) 에 의해 실행되는 소프트웨어 애플리케이션 (예컨대, 비디오, 지도, 인터넷 브라우저 등) 에 따라 변화할 수도 있다. 도 2 에 도시된 실시형태들은 안경-유사 프레임에 위치된 디스플레이들 (220) 을 예시하지만, 투명 디스플레이 영역을 제공할 수 있는 다른 기술들 (예를 들어, 망막 프로젝터, 콘택트 렌즈(들), 또는 다른 광학적 시스템) 이 다른 실시형태들에서 이용될 수 있다.

바깥 쪽으로 향하는 카메라(들) (210) 은, HMD (120) 에 대한 입력을 제공하기 위해 사용자 (110) 에 의해 제어될 수 있는 사용자의 손 (130) 및/또는 다른 객체들을 포함하는, 사용자의 주위환경의 이미지들을 캡처할 수 있다. 도 2 에 나타낸 바와 같이, 카메라들은 RGB (적, 녹, 청) 및/또는 RGBD (적, 녹, 청, 플러스 심도 (depth)) 카메라들일 수도 있지만, 다른 실시형태들은, HMD (120) 가 사용자의 앞에 물리적 객체를 추적하는 것을 가능하게 하는, 프로세싱 유닛에 이미지들 및/또는 다른 정보를 제공하는 다른 유형들의 카메라들 및/또는 센서들을 포함할 수도 있다. 일 실시형태에서, 예를 들어, HMD (120) 는 물리적 객체의 수직적 및 수평적 포지션을 추적하기 위해 단일 RGB 카메라 (210) 를 이용할 수 있다. 다른 실시형태들은, 다중 카메라들 (210), 및/또는 물리적 객체의 깊이 역시 추적하기 위해 심도를 결정할 수 있는 카메라들 (210) (예를 들어, 깊이 카메라 (time-of-flight ranging camera)) 을 채용할 수 있다. 카메라(들) (210) 은 HMD (120) 가 사용자의 시각으로부터 투명 디스플레이 영역 내에 나타나는 물리적 객체를 추적하는 것을 가능하게 하는 시야를 가질 수 있다. 실시형태들은, 물리적 객체가 사용자 (110) 의 시각으로부터 투명 디스플레이 영역 내에 있지 않을 때 저전력 모드로 전환할 수도 있다. 몇몇 실시형태들에서, 카메라(들) (210) 은 HMD (120) 로 하여금, (사용자 (110) 의 시각으로부터) 물리적 객체가 투명 디스플레이 영역에 접근하고 있다고 HMD (120) 가 결정할 때 객체-추적을 실행하기 시작 및/또는 확대하도록 허용하기 위해, 투명 디스플레이 영역보다 더 넓은 시야를 가질 수 있다.

도 3 은 사용자 (110) 의 시각으로부터 디스플레이 (220) 를 통한 결과적인 뷰 (view) (300) 를 나타낸다. 상기 나타낸 바와 같이, 투명 디스플레이 영역 (310) 은 사용자 (110) 가, 투명 디스플레이 영역 (310) 에서 보이는 시각적 요소들 뿐만 아니라 사용자의 주위환경에서의 물리적 객체들 양자 모두를 보는 것을 가능하게 할 수 있다. 도 3 의 예시적인 뷰 (300) 에서, 예를 들어, 사용자는 날짜 및 시간을 나타내는 표시된 시각적 요소들 (330) 뿐만 아니라 사용자의 손 (130) 을 볼 수 있다.

HMD (120) 는 카메라(들) (210) 로부터 이미지들을 수신하고 어떤 인식된 객체들을 추적하는 추적 알고리즘들을 실행할 수 있다. 또한, 카메라(들) (210) 및 추적 알고리즘들은, 사용자 (110) 의 시각으로부터 투명 디스플레이 영역 (310) 에서 나타나는 바와 같이 물리적 객체들 상에 추적 포인트 (320) 의 위치를 결정하도록 교정될 수 있다. 도 3 에 도시된 뷰 (300) 에서, 이 추적 포인트 (320) 는 사용자의 손 (130) 의 손가락끝에 대응한다. 물리적 객체 (예를 들어, 사용자의 손 (130)) 의 조작 및 추적 포인트 (320) 의 대응하는 이동은 사용자 (110) 가 GUI 및/또는 투명 디스플레이 영역 (310) 에서 보이는 다른 시각적 요소들과 상호작용하는 것을 가능하게 할 수 있다. 추적 포인트 (320) 는, 원하는 기능성에 따라, 투명 디스플레이 영역 (310) 에서 강조될 수도 있거나 강조되지 않을 수도 있다.

사용자의 손(들), 특수한 장치, 및/또는 HMD 에 의해 인식가능한 임의의 다른 객체와 같은, 사용자가 GUI 와 상호작용할 수 있도록 허용하기 위해 임의의 다양한 객체들이 이용될 수 있다. HMD 의 사용자 설정들은 사용자가 GUI 상호작용에 이용하기 위한 객체(들)를 지정하는 것을 허용할 수도 있다. 이하 보다 자세히 설명되는 바와 같이, 객체 추적은, 객체의 다양한 특성들, 예컨대, 형상, 색상, 및/또는 이동을 결정하는 것을 수반할 수도 있는 임의의 다양한 시각적 추적 방법들을 이용할 수 있다. 일부 실시형태들에서, 심도 필터링은 GUI 상호작용을 위해 추적된 물체가 사용자에 의해 제어되는 것을 보장하는 것을 돕기 위해 이용될 수 있다. 따라서, HMD 는, 객체가 HMD 로부터 임계 거리 내에 있다고 HMD 가 결정한 후에 GUI 상호작용을 허용할 것이다. 이 결정을 행하기 위한 수단은, 카메라(들) (예컨대, 입체 카메라들, 깊이 카메라들 등), 근접도 센서들 등과 같은, 거리들을 결정할 수 있는 센서들과 센서들과 커플링된 프로세싱 유닛을 포함할 수 있다.

도 4a 내지 도 4e 는 어떻게 물리적 객체의 추적이 사용자로 하여금 HMD (120) 의 GUI 를 통해 빨리 내비게이트 (navigate) 하는 것을 가능하게 할 수 있는지를 보여주는 일련의 도시들이다. 도 4a 는, HMD (120) 가, GUI 및/또는 다른 애플리케이션이 비활성일 때 표시할 수도 있는 날짜 및 시간과 같은 디폴트 시각적 요소들 (330) 을 갖는 투명 디스플레이 영역 (310) 을 나타낸다. 도 4a 내지 도 4e 에서는 도시되지 않았지만, 사용자의 주위환경에서의 객체들이 투명 디스플레이 영역 (310) 을 통해 보일 수도 있다.

도 4b 에서, HMD (120) 는 GUI 상호작용을 위해 물리적 객체를 인식하고 추적 포인트 (320) 를 확립한다. 이전에 논의된 바와 같이, 추적 포인트 (320) 는 투명 디스플레이 영역 (310) 에서 강조 (또는 그외에 지시) 될 수도 있고 또는 되지 않을 수도 있다. 물리적 객체는 HMD (120) 에 의해 인식되고 추적될 수 있는 임의의 물리적 객체 (예를 들어, 신체 부분, 포인팅 디바이스 등) 일 수 있다. 일부 실시형태들은 사용자 (110) 가 어느 물리적 객체가 HMD 의 GUI 와 상호작용하기 위해 이용될 수 있는지를 지정하는 것을 허용할 수도 있다.

일부 실시형태들에서, HMD (120) 는, 트리거링 이벤트 (triggering event) 가 발생할 때까지는 사용자 상호작용을 위한 HMD (120) 의 GUI를 유발 및/또는 추적 포인트 (320) 를 확립 (제 1 셋트의 시각적 요소들 및/또는 옵션들을 표시) 하지 않을 수도 있다. 이것은 의도하지 않은 사용자의 GUI 와의 상호작용을 방지하는 것을 도울 수 있다. 일부 실시형태들에서, 트리거링 이벤트는, (도 4b 에서 도시된 바와 같이) 연장된 가리키는 손가락을 갖는 손과 같이 객체가 어떤 자세를 취하고 있는 것일 수 있을 것이다. 다른 실시형태들에서, 트리거링 이벤트는, 인식된 물리적 객체가 투명 디스플레이 영역 (310) 에서 적어도 임계량의 시간 동안 나타나는 것일 수 있을 것이다. 일부 실시형태들은 양자 모두를 요구할 수 있을 것이다. 예를 들어, HMD (120) 는, 사용자의 손이 접촉유지 자세로 연장된 가리키는 손가락을 가지고, 사용자의 시각으로부터 투명 디스플레이 영역 (310) 의 시야 내에서 적어도 2 초 동안 위치된 것을 결정한 후에 사용자 상호작용을 위한 GUI 를 활성화시킬 수 있을 것이다. 다른 실시형태들은, 원하는 기능성에 따라, 2 초보다 길거나 짧은 시간의 기간들 후에 GUI 를 활성화시킬 수도 있다. 일부 실시형태들에서, 트리거링 이벤트는, 사용자의 손 및/또는 손가락이 디스플레이 영역 (310) 의 특별한 또는 미리결정된 부분에, 예를 들어, 디스플레이 영역 (310) 의 에지 부근에 또는 특별한 모서리에, 위치되는 것을 포함한다. 다양한 다른 트리거링 이벤트들이 이용될 수 있다.

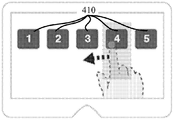

도 4c 에서, HMD (120) 의 GUI 는 사용자 (110) 가 선택할 수 있는 옵션들 (options) 에 대응하는 시각적 요소들 (410) 의 셋트를 표시한다. 각 시각적 요소는 각기의 활성 구역 (420) 과 연관될 수 있고 및/또는 각기의 활성 구역 (420) 에 의해 둘러싸일 수 있다. 일부 실시형태들에서, 요소들 (410) 및/또는 구역 (420) 은 사용자에 대해 가상 평면에서 표시될 수도 있다. 활성 구역들 (420) 은, 사용자로 하여금, 추적 포인트 (320) 를 각기의 활성 구역 (420) 에 이동시킴으로써 시각적 요소에 대응하는 옵션을 선택할 수 있도록 허용한다. 시각적 요소들 (410) 의 배치 및 활성 구역들 (420) 의 원하는 사이즈 및 형상에 따라, 활성 구역의 하나 이상의 경계들은 투명 디스플레이 영역 (310) 의 에지 (edge) 까지 연장될 수도 있다. 또한, 사용자는 디스플레이 영역 (310) 의 하부 또는 상부에 보다 가까운 특정 위치에 그의 손 또는 손가락을 위치시켜야 하는 것 보다는 선택할 요소를 지정하기 위해 그의 손을 전후로 이동시키는 것이 더 쉬울 수도 있다. 또한, 일부 실시형태들에서 이러한 선택 영역들은 구역 (420) 을 선택하기 위해 필요한 정밀도가 요소 (410) 를 선택하기 위해 필요한 정밀도보다 적을 수도 있기 때문에 사용자가 걷고 있거나 사용자의 손이 정적이지 않을 때에도 종종 사용될 수도 있다. 일부 실시형태들에서, 사용자의 손을 특정 요소 (410) 를 터치하는데 반해 구역 (420) 의 임의의 부분에 있는 것으로서 식별하는 것은 더 적은 프로세싱 전력 및/또는 레이턴시 (latency) 및/또는 보다 낮은 해상도를 갖는 이미지들을 이용할 수도 있다. 일부 실시형태들에서, 시각적 요소들 (410) 은 도 4c 및 도 4d 에서 도시된 바와 같이 대략 일치하는 수직 높이로 디스플레이되지 않는다. 예를 들어, 요소들 (410) 중 하나 이상은, 실질적으로 기둥인 각기의 구역 (420) 내에 여전히 위치되면서 수직 위치에서 변화할 수도 있다.

비록 활성 구역들 (420) 은 다양한 형상들 및 사이즈들을 취할 수도 있지만, 칼럼들 (columns) 은 쉬운 GUI 상호작용을 촉진함에 있어서 특히 도움이 될 수 있다. 이는, 투명 디스플레이 영역 (310) 이 칼럼들로 구획되는 경우, 시각적 요소들 (410) 은, 사용자가 시각적 요소들 (410) 을 쉽게 볼 수 있도록 허용하는, 투명 디스플레이 영역 (310) 의 수직으로 중앙 위치에 위치될 수 있기 때문이다. 추가적으로, 사용자의 손은 하부 에지로부터 투명 디스플레이 영역 (310) 에 진입할 가능성이 크기 때문에, 칼럼-형상의 활성 구역들 (420) 은, 그들이 투명 디스플레이 영역 (310) 의 하부 에지를 향해 하방으로 연장될 수 있기 때문에 선택을 용이하게 할 수 있다. 일부 구성들에서, 칼럼-형상의 활성 구역들 (420) 은 하부 에지까지 완전히 연장될 수 있다.

활성 영역들이 나타나는 방식은 실시형태에 따라 변화할 수 있고, 이는 하나 이상의 사용자 설정들에 의해 결정될 수도 있다. 예를 들어, 일부 실시형태들은 활성 구역들 (420) 의 전부가 한번에 보이도록 허용할 수도 있다. 즉, 각각의 시각적 요소 (410) 에 대한 활성 구역 (420) 이 나타난다 (예를 들어, 강조, 보이는 경계 등). 다른 실시형태들에서, 특정 활성 구역 (420) 은, (예를 들어, 도 4c 및 도 4d 에서 도시된 바와 같이) 추적 포인트 (320) 가 그 구역에 진입할 때까지 나타나지 않을 수도 있다. 일부 실시형태들에서, 구역들 (420) 은 모두 나타나지 않을 수도 있지만, 사용자 선택을 결정하기 위해 이용된다.

도 4d 는 어떻게 이러한 선택이 이루어지는지를 나타낸다. 예시된 바와 같이, 추적 포인트 (320) 가 사용자의 시각으로부터 "1" 이라는 라벨이 붙은 시각적 요소가 위치된 활성 구역 (420-1) 내에 위치되도록 사용자는 객체를 이동시킬 수 있다. 사용자는, 단순히 추적 포인트 (320) 를 활성 구역 (420-1) 내에 임계량의 시간 동안 유지하는 것, 물리적 객체를 "선택" 자세 (예를 들어, 주먹 쥐는 것, 가리키는 손가락을 뒤로 끌어당기는 것 등) 에 관여시키는 것 등과 같은 다양한 방식들로 대응하는 시각적 요소의 선택을 나타낼 수 있다. 이러한 실시형태들에서, HMD 는, 진행 바, 카운터, 모래시계 등과 같은, 추적 포인트 (320) 가 활성 구역 내에 위치되는 시간의 길이를 나타내는 아이콘을 표시할 수도 있다. 또한, HMD 가 객체의 심도를 추적할 수 있는 실시형태들에서, 물리적 객체를 사용자를 향하는 방향 또는 사용자로부터 멀어지는 방향으로 이동시킴으로써 (예를 들어, "밀기" 및/또는 "당기기" 모션을 행하는 것에 의해) 선택이 이루어질 수 있다. 원하는 기능성에 따라, 선택의 방법은 예를 들어 사용자 선호 메뉴 방식으로 사용자에 의해 결정될 수도 있다.

도 4e 는 일단 선택이 이루어지면 어떻게 GUI 가 시각적 요소들 (430) 의 제 2 셋트를 표시할 수 있는지를 나타낸다. HMD (120) 의 기능성 및 선택된 옵션들에 의존하여, 임의의 다양한 시각적 요소들이 표시될 수 있다. 예를 들어, HMD (120) 는, 아주 다양한 특징들 및/또는 애플리케이션들 중 어느 것을 선택하기 위해 사용자가 다양한 폴더들, 메뉴 스크린들, 및/또는 다른 선택 스크린들을 통해 내비게이트하는 것을 가능하게 하는 GUI 를 포함할 수도 있다. 이러한 애플리케이션들은 예를 들어, 오디오 플레이어, 비디오 플레이어, 내비게이션 프로그램, 카메라/캠코더 프로그램, 증강 현실 애플리케이션, 인터넷 브라우저 등을 포함할 수 있다. 더욱이, HMD (120) 는, 사용자가 GUI 및/또는 HMD (120) 에 의해 실행되고 투명 디스플레이 영역 (310) 에서 나타나는 애플리케이션들과 더 상호작용하는 것을 허용할 수 있는, 마이크로폰, 터치패드, 키보드 등과 같은 다른 입력 디바이스들을 포함할 수도 있다.

도 5a 내지 도 5c 는 어떻게 GUI 가 사용자 상호작용에 응답할 수도 있는지의 대안적인 실시형태들을 나타낸다. 도 5a 에서는, 도 4c 및 도 4d 에서와 같이, 사용자는 다수의 선택가능한 시각적 요소들 (410) 을 제공받을 수도 있다. 하지만, 여기서, 사용자가 (예를 들어, 그 또는 그녀의 손을 제 1 활성 구역 (420-1) 내에 일정 기간 동안 위치시킴으로써) 제 1 시각적 요소 "1" 을 선택한 후에, 시각적 요소 "1" 는 도 5b 에서 도시된 바와 같이 추가적인 시각적 요소들 "1a" 및 "1b" 로 대체된다. 이들 추가적인 시각적 요소들은 GUI 의 메뉴에 또 다른 계층의 심도를 제공하는 서브-메뉴 항목들을 나타낼 수 있다. 추가적인 시각적 요소들 "1a" 및 "1b" 은, 사용자가 그 시각적 요소들 "1a" 및 "1b" 을 선택할 수 있는 대응하는 활성 구역들 (420-a 및 420-b) 을 각각 갖는다. 비록 도 5a 의 시각적 요소 "1" 을 대체하기 위해 도 5b 및 도 5c 에서 오직 2 개의 시각적 요소들이 도시되었지만, (대응하는 수의 활성 구역들 (420) 을 갖는) 임의의 수의 시각적 요소들 (410) 이 사용될 수도 있다. 이 수는 선택되는 시각적 요소 (410), 원하는 기능성, 및/또는 다른 인자들에 의존할 수도 있다. 일부 시각적 요소들 (410) 은 추가적인 시각적 요소들을 전혀 유발하지 않고 대신에 애플리케이션들 및/또는 다른 기능을 유발할 수도 있다.

도 5c 는 더 큰 시각적 요소들 "1a" 및 "1b" 을 나타내는, 도 5b 의 선택적 변형을 나타낸다. 사실, 상이한 실시형태들은 도면들의 실시형태들에 나타난 것들보다 더 큰 또는 더 작은 시각적 요소들 (410) 을 가질 수도 있다. 더욱이, 일부 시각적 요소들 (410) 은 그들의 각기의 활성 구역들 (420) 의 오직 작은 부분만을 점유할 수도 있는 한편, 다른 시각적 요소들 (410) 은 그들의 각기의 활성 구역들 (420) 의 전부 또는 거의 전부를 점유할 수도 있다. 또한, 비록 도 5b 및 도 5c 는 시각적 요소 "1" 의 활성 구역 (420-1) 과 동일한 폭의 활성 구역들 (420-a 및 420-b) 내에 시각적 요소들 "1a" 및 "1b" 를 도시하고 있지만, 실시형태들은 그렇게 제한되지 않는다. 예를 들어, 메뉴 선택에서 보다 낮은 정밀도를 허용하기 위해, 시각적 요소들 "1a" 및 "1b" 및/또는 대응하는 활성 구역들 (420-a 및 420-b) 은 디스플레이를 수평으로, 부분적으로 또는 완전히 가로질러 연장될 수도 있다.

시각적 요소 (410) 가 다수의 시각적 요소들로 대체될 수도 있는 GUI 의 일예로서, 최상위-레벨 메뉴는 도 5a 에 도시된 바와 같이, 멀티미디어, 인터넷 검색, 내비게이션, 웹 브라우저 등과 같은 HMD 의 상이한 기능들을 나타내는 다수의 시각적 요소들 (410) 을 포함할 수 있고, 여기서, 각각의 시각적 요소 (410) 는 칼럼-형상의 활성 구역 (420) 내에 위치된다. 사용자가 웹 브라우저 시각적 요소를 선택하는 경우, 웹 브라우저 애플리케이션이 호출될 수도 있다. 하지만, 사용자가 멀티미디어 시각적 요소를 선택하는 경우, 멀티미디어 시각적 요소가 위치되었던 칼럼-형상의 활성 구역은 다수의 구역들로 쪼개질 수도 있고, 그 각각은 비디오들 및 음악과 같은 멀티미디어의 유형을 나타내는 그 자신의 시각적 요소를 갖는다. 또한, 이들 추가적인 시각적 요소들의 각각 (및 각기의 활성 구역들) 은, 다중 레벨들의 서브메뉴들이 존재하도록 유사한 방식으로 비디오들 또는 음악의 유형들 (예를 들어, 장르들, 플레이리스트들, 영화들, TV 쇼들 등) 로 더 추가로 쪼개질 수도 있다. 각각의 서브메뉴는 추가적인 레벨의 정확도를 필요로할 수도 있기 때문에, 서브메뉴 레벨들의 양은 선택된 옵션들 및/또는 원하는 기능성에 의존할 수도 있다. 예를 들어, 영화들은 음악보다 사용자로부터 보다 많은 주의를 필요로 하도록 예상되기 때문에, 영화들은 음악보다 더 많은 레벨들의 서브메뉴들 (이는 선택하기 위해 보다 나은 정확도를 필요로 할 수도 있다) 을 가질 수도 있다. 또한, 서브메뉴들의 레벨들은 수직 및 수평 정렬들 사이에서 전환할 수도 있다. 예를 들어, 사용자가 시각적 요소 "1b" 를 선택하고 1b 와 연관된 서브메뉴 항목들이 존재하는 경우에, 그들 서브메뉴 항목은 다시 (도 5a 와 유사하게) 수평으로 분포될 수도 있는 등이다.

물론, 도 5a 내지 도 5c 에서 나타낸 기능성은 디스플레이로부터 선택되지 않은 시각적 요소들 (410) 을 제거함이 없이 사용자가 어떻게 메뉴 및 서브메뉴 옵션들을 통해 네비게이트할 수도 있는지의 예로서 제공된다. 대안적으로, 시각적 요소 (410) 의 선택은 원래 메뉴를 완전히 대체하는 서브메뉴를 나타내는 시각적 요소들 (410) 의 새로운 셋트를 유발할 수도 있다.

비록 활성 구역들 (420) 은 투명 디스플레이 영역 (310) 의 칼럼들로서 본 명세서에서 나타났지만, 실시형태들은 그렇게 제한되지 않는다. 도 6a 내지 도 7b 는 활성 구역들 (420) 이 어떻게 시각적 요소들 (410) 의 레이아웃에 따라 변화할 수 있는지를 나타낸다. 도 6a 및 도 6b 는 예를 들어 어떻게 활성 구역들 (420) 이 투명 디스플레이 영역 (310) 의 상부, 하부, 좌측, 및 우측 사분면들 (quadrants) 에 위치될 수 있는지를 나타낸다. 시각적 요소의 선택은 이전에 설명된 실시형태들과 유사할 수도 있다. 다른 실시형태들은, 상이하게 (예를 들어, 격자, 원, 또는 다른 방식으로) 위치될 수도 있는, 보다 많은 시각적 요소들 (410) 또는 보다 적은 시각적 요소들 (410) 을 가질 수도 있다. 이러한 실시형태들에서, 활성 구역들은 시각적 요소들 (410) 을 대응하여 포함하도록 위치된다. 또한, 실시형태들은, 임의의 시각적 요소 (410) 와 대응하거나 선택이 이루어지게 하지 않을 수도 있는, 활성 구역들 (420) 사이의 공간들을 포함할 수도 있고, 이는 시각적 요소 선택을 보다 쉽게 만들 수도 있다.

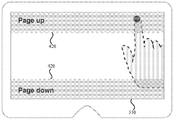

도 7a 및 도 7b 는 투명 디스플레이 영역 (310) 의 에지들에서, 또는 그 부근에서의 활성 구역들 (420) 이 어떻게 "뒤로", "앞으로", "페이지 업 (page up)", 및/또는 "페이지 다운 (page down)" 과 같은 사용자 인터페이스를 내비게이트하기 위해 어떤 기능들과 연관될 수 있는지를 나타낸다. 여기서, 활성 구역들 (420) 은 표시된 시각적 요소 (410) (미도시) 에 대응하지 않을 수도 있다. 일부 실시형태들에서, 뒤로, 앞으로, 페이지 업, 및/또는 페이지 다운 라벨들의 하나 이상은 투명 디스플레이 영역 (310) 에서 보이지 않을 수도 있다. 예를 들어, 도 6b 에서의 상부 구역 (420) 은 아무런 글 또는 라벨도 존재하지 않는 일부 실시형태들에서의 페이지 업 명령에 대응할 수도 있다. 다양한 활성 구역들 (420) 을 상이한 내비게이션 기능들 및/또는 다른 명령들에 연관시키는 수많은 다른 구성들이 이용될 수 있다.

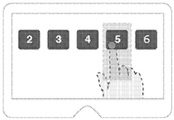

추적 포인트 (320) 의 위치를 추적하는 것에 추가하여, HMD (120) 는 추적 포인트 (320) 의 모션 (motion) 을 추적하도록 더 구성될 수도 있다. 이러한 기능성은 사용자 (110) 가 "휘두르기 (swipes)", "뒤집기 (flips)" 등과 같은 어떤 모션들을 이용하는 것을 가능하게 할 수 있다. 이것은 사용자가, 위치 추적만을 통한 내비게이션에 의한 것보다 훨씬 더 효율적으로 메뉴 항목들 및/또는 다른 콘텐츠를 통해 내비게이트하는 것을 가능하게 할 수 있다. 도 8a 내지 도 8c 는 이러한 실시형태를 나타낸다.

도 8a 에서, 사용자는, 예를 들어 전체 손으로 또는 단지 하나 이상의 손가락들로 시각적 요소 (410) 를 선택하고 어떤 방향들로 "휘두르기" 함으로써 하나 이상의 시각적 요소들 (410) 을 이동시킬 수 있고, 이 경우에 HMD (120) 는 도 8b 에 도시된 바와 같이 시각적 요소 (410) 가 휘둘린 방향으로 대응하여 이동하게 한다. 선택적으로, 사용자는 시각적 요소 (410) 에 대응하는 활성 구역 (420) 에서의 어디에서든 단순히 휘두를 수도 있다. 도시된 바와 같이, 다른 시각적 요소들 (410) 도 역시 대응하여 이동하여 사용자가 쉽게 다수의 시각적 요소들을 통해 스크롤 (scroll) 하는 것을 허용할 수도 있다. 비록 도 8a 내지 도 8c 는 사용자가 모든 시각적 요소들 (410) 을 좌측으로 하나의 위치 이동시키는 것 (즉, 시각적 요소들 "1" - "5" 를 시각적 요소들 "2" - "6" 을 보기 위해 좌측 하나의 위치로 이동시키는 것) 을 보여주고 있지만, 휘두르기는 속도, 모션, 및/또는 그 휘두르기의 다른 특성들에 의존하여, 시각적 요소들 (410) 의 더 큰 이동을 초래할 수도 있다. 또한, 휘두르기는 일부 실시형태들에서 스크린의 임의의 영역에서 행해질 수도 있고, 이는 기능성에 영향을 미칠 수도 있다. 예를 들어, 사용자가 시각적 요소들 (410) 중 하나를 선택하기보다 그들을 통해 스크롤하기를 원하는 것을 HMD (120) 에 대해 나타내기 위해 사용자는 표시된 시각적 요소들 (410) 아래에서 휘두를 수도 있다. 사용자가 시각적 요소 (410) (또는 활성 구역 (420)) 상에 손가락을 위치시키고 그 다음 휘두르는 실시형태들에서, 휘두르기/스크롤을 활성화하기 위한 (손가락을 정지상태로 유지하는) 시간은 시각적 요소 (410) 를 선택하기 위한 (손가락을 정지상태로 유지하는) 시간보다 더 적을 수도 있다.

이들 GUI-상호작용 기술들은 사용자가 물리적 객체에 관련된 증강 현실 콘텐츠의 조각과 상호작용하는 것을 가능하게 하는 증강 현실 시나리오들로 연장될 수 있다. 이러한 증강 현실 시나리오는, HMD (120) 가 카메라 (210) 및/또는 다른 센서들을 이용하여 물리적 위치, 객체, 표면, 텍스처 (texture), 이미지 등을 식별할 때 발생할 수 있다. HMD (120) 는 그러면 물리적 위치, 객체, 표면, 텍스처, 이미지 등을 분석하고 그것을 증강 현실 및/또는 시각적 검색 애플리케이션에서 로컬 또는 온라인 데이터베이스와 비교할 수 있다. 분석은, 사용자의 시각으로부터 식별된 위치, 객체, 표면, 텍스처, 이미지 등에 물리적 근접도로 나타나도록 HMD (120) 가 표시하는 디지털 콘텐츠를 리턴 (return) 할 수 있다. 일부 실시형태들에서, 디지털 콘텐츠는 식별된 객체, 표면 등에 정착된 (anchored) 것으로 또는 거기 상에 표시되는 것으로 나타난다. 디지털 콘텐츠는, 사용자가 표시된 디지털 콘텐츠와 상호작용하는 것을 가능하게 하는, 스크린의 활성 구역들에 의해 둘러싸인 또는 그 활성 구역들을 포함하는 상호작용성 요소들을 가질 수 있다. 예를 들어, 디지털 콘텐츠는 "더 많은 정보를 위해 저를 눌러 주세요" 라고 말하는 버튼을 포함할 수 있다. 일부 실시형태들에서, 활성 구역은, 전술한 실시형태들의 어떤 것들과 유사하게, 버튼 너머의 영역에서 연장되도록, 및/또는, 버튼으로부터 HMD (120) 의 디스플레이의 에지까지 실질적으로 연장하도록 버튼 주위에서 정의될 수도 있다. 일부 실시형태들에서, 버튼 및/또는 활성 구역들은 활성 구역 및/또는 버튼이 연관되는 객체, 표면 등에 정착되는 것으로 또는 거기 상에 표시되는 것으로 보인다.

HMD (120) 는 사용자의 손 (또는 다른 객체) 을 추적할 수 있어, 사용자가 디지털 콘텐츠의 임의의 상호작용성 요소(들)와 상호작용하는 것을 가능하게 한다. 예를 들어, 사용자는, 사용자의 손가락 위치를 그것이 (사용자의 시각으로부터) 상호작용성 요소와 중첩되도록 이동시키는 것, "선택" 자세로 관여시키는 것, 미리결정된 이동을 수행하는 것, 및/또는 손가락 (또는 다른 객체) 을 임계량의 시간 동안 그 요소의 부근에 유지하는 것에 의해 등과 같이 다양한 방식들 중 하나 이상으로 상호작용성 요소를 선택할 수 있다. HMD (120) 는, 상호작용성 요소의 선택을 인식한 후에, 디지털 콘텐츠의 렌더링 (rendering) 을 변경 및/또는 디지털 콘텐츠의 제 2 셋트를 론치 (launch) 할 수 있다. 원하는 기능성에 의존하여, 디지털 콘텐츠의 제 2 셋트는 또한 (사용자의 시각으로부터) 식별된 물리적 위치, 객체, 표면, 텍스처, 이미지 등에 정착될 수도 있다.

이 증강 현실 기능은 사용자가 사용자의 주위환경에 관해 보다 많이 습득하는 것을 가능하게 하기 위한 무수한 시나리오들에서 이용될 수 있다. 예를 들어, HMD (120) 가 사용자의 시야 내에서 영화 포스터를 인식하는 경우, 가상 "플레이 트레일러 (play trailer)" 버튼이 HMD 의 디스플레이에서 나타날 수 있고, 이는 손가락 누름으로 활성화될 수 있다. 다른 예에서, 사용자는 손으로 넘김으로써 잡지 커버 상으로 증강된 가상 3D 모델을 돌릴 수 있다. 또 다른 예에서, 사용자는 광고게시판을 볼 수 있고, 물리적 광고게시판과 정렬된 미디어 재생이 보일 수 있다. 무수한 다른 시나리오들이 고려된다. 따라서, 투명 디스플레이에 정착된 2D GUI 를 내비게이팅하는 것에 추가하여, 본 명세서에서 제공된 기술들은, 사용자의 시각으로부터 물리적 세계에 정착될 수 있는 디지털 콘텐츠의 요소들과의 상호작용들을 가능하게 하는, 다른 증강 현실 시나리오들에 확장될 수 있다. 이들 상호작용성 요소들은, 사용자의 주위환경에서의 물리적 객체들에 얽매이기 때문에, HMD 의 디스플레이 상의 대응하는 활성 구역 구역들은 사용자의 시점에 관해 물리적 객체의 위치에 상대적으로 이동 및 스케일링될 수도 있다.

도 9 는 HMD 와의 사용자 상호작용을 가능하게 하는 방법 (900) 의 일 실시형태를 나타내는 흐름도이다. 방법 (900) 의 상이한 양태들은 본 명세서에서 설명되는 바와 같은 HMD 에 의해, 및/또는, HMD 를 제어하는 디바이스에 의해 수행될 수 있다. 따라서, 방법 (900) 의 각 단계를 수행하는 수단은, 프로세싱 유닛, 메모리, 투명 디스플레이 영역, 카메라, 소프트웨어 애플리케이션, 오퍼레이팅 시스템, 및/또는 HMD 에 포함되고/되거나 통신가능하게 커플링된 다른 컴포넌트들과 같은 하드웨어 및/또는 소프트웨어 컴포넌트들을 포함할 수 있다. HMD 의 또는 HMD 를 제어하도록 구성된 디바이스의 하드웨어 및 소프트웨어 양태들의 실시형태가 도 10 에서 도시되고 아래에서 보다 자세히 설명된다.

블록 905 에서, 시각적 요소가 HMD 의 투명 디스플레이 영역에서 표시된다. 상기 나타낸 바와 같이, 투명 디스플레이 영역은 디스플레이 상에 보이는 시각적 요소 뿐만 아니라 사용자의 주위환경에서의 물리적 객체도 사용자가 볼 수 있도록 허용하도록 구성된 HMD 의 디스플레이 및/또는 표시 수단의 적어도 일부분일 수 있다. 몇몇 실시형태들에서, 망막 프로젝터를 이용하는 것들과 같이, 투명 디스플레이 영역은 반드시 물리적 디스플레이 또는 스크린 상의 영역에 대응할 필요가 없을 수도 있는 사용자의 시야 내의 영역일 수 있다. 시각적 요소는 예를 들어 HMD 의 GUI 의 일부로서 표시된 시각적 요소일 수 있다. 블록 905 의 기능을 수행하기 위한 수단은 오퍼레이팅 시스템, 소프트웨어 애플리케이션, 프로세서, 디스플레이, 및/또는 도 10 에 대해 이하 설명되는 바와 같은 다른 수단을 포함할 수 있다.

여기서, 시각적 요소가 HMD 의 투명 디스플레이 영역에 표시되기 전에, HMD (및/또는 그것과 통신가능하게 커플링된 디바이스) 는 예를 들어 애플리케이션, 데이터베이스, 애플리케이션 프로그래밍 인터페이스 (API) 등으로부터 디스플레이하기 위한 선택가능한 시각적 요소들의 셋트를 결정할 수도 있다는 것이 주목될 수 있다. HMD 는 또한 (예를 들어, 칼럼들, 사분면들 등을 이용하는) 시각적 요소들의 레이아웃을 결정할 수도 있고, 이는 애플리케이션 유형, 시각적 요소의 수, 사용자 설정들 등과 같은 임의의 다양한 인자들에 기초할 수도 있다. 일부 실시형태들에서, 레이아웃은 하나 이상의 사용자 설정 (예를 들어, 사분면들보다는 칼럼들에 대한 사용자의 선호 또는 설정) 에 기초하여 결정될 수도 있고, 그 다음, 결정된 레이아웃이 이용될 수도 있도록 디스플레이 상에 시각적 항목들의 셋트가 배열된다. 다른 실시형태들에서, 레이아웃은 셋트에서의 시각적 요소들의 유형, 표시 특성들, 또는 양에 기초하여 자동적으로 결정될 수도 있다. 일부 실시형태들에서, 레이아웃은, 예를 들어 사용자에 대해 표시되는 시각적 요소들의 가시성을 최대화하기 위해 사용자의 시야에 기초하여 자동적으로 결정될 수도 있다.

블록 910 에서, 투명 디스플레이 영역 내의 활성 구역은, 시각적 요소가 활성 구역의 일부분 내에 배치되도록 정의된다. 활성 구역은 예를 들어 투명 디스플레이 영역 상에 보이는 사용자-선택가능 시각적 요소를 둘러싸는 구역일 수 있다. 활성 구역 그 자체는 투명 디스플레이 영역에서 강조 및/또는 그 외에 지시되거나 되지 않을 수도 있다. 활성 구역을 정의하는 것은, 예를 들어 프로세싱 유닛, 메모리, 및/또는 HMD 내에 통합된 및/또는 HMD 와 통신가능하게 커플링된 컴퓨팅 시스템의 일부일 수 있는 다른 컴퓨팅 수단에 의해 수행될 수도 있다. 활성 구역들은 복수의 구성들 중 어느 것으로 정의될 수도 있다. 예를 들어, 디스플레이는, 일부 실시형태들에서 전체 디스플레이 또는 시야를 실질적으로 점유하는 복수의 구역들로 (예를 들어 도 4 내지 도 7b 에서 도시된 바와 같이) 하위분할될 수도 있다. 이들 실시 형태들에서의 활성 구역들은 형상 및/또는 사이즈에서 실질적으로 균일할 수도 있거나 변화할 수도 있다. 활성 구역들은 (예를 들어, 도 4 내지 도 7b 에서 도시된 바와 같이) 아이콘 또는 다른 표시 요소로부터 실질적으로 스크린의 에지까지 연장되는 것으로서 정의될 수도 있다. 블록 910 의 기능을 수행하는 수단은 오퍼레이팅 시스템, 소프트웨어 애플리케이션, 프로세서, 디스플레이, 및/또는 도 10 과 관련하여 이하 설명되는 다른 수단을 포함할 수 있다.

전술한 바와 같이, 활성 구역들은 칼럼들, 행들, 또는 다른 형상들일 수도 있다. 활성 구역들은, 관심 대상의 객체가 표시되고 있지 않은 영역을 포함하는 구역들로서 특성화될 수도 있다 (예를 들어, 활성 구역들은 시각적 요소들이 표시되고 있지 않은 영역들을 포함할 수도 있다). 이러한 실시형태들에서, 활성 구역들은 아이콘 또는 다른 시각적 요소에 관하여 정의될 수도 있거나, 별도로 정의될 수도 있다. 활성 구역들이 아이콘 또는 다른 시각적 요소에 관하여 정의되는 실시형태들에서, 활성 구역들은 아이콘 또는 시각적 요소보다 실질적으로 더 큰 영역을 포함하도록 정의될 수도 있다. 예를 들어, 활성 구역은 아이콘 또는 표시 요소보다 2 배 더 크도록 (또는 3, 5, 또는 10 배 더 크거나 다른 사이즈) 정의될 수도 있고, 아이콘 또는 시각적 요소가 얼마나 큰지에 관계 없이, 사용자에 의해 보일 때 임계 사이즈보다 더 크도록 표시될 수도 있다. 또한, 일부 실시형태들에서, 활성 구역들은 증강 현실 또는 다른 소프트웨어 애플리케이션에서 상호작용성 요소들, 디지털 콘텐츠, 및/또는 물리적 객체들과 연관될 수도 있다. 이러한 활성 구역들은 예를 들어 사용자가 물리적 객체에 대해 이동함에 따라 디스플레이 영역 내에서 사이즈, 형상, 및 위치가 변화할 수도 있다. 활성 구역들의 다른 구성들이 또한 구현 및/또는 정의될 수도 있다. 또한, 결정된 또는 정의된 활성 구역들 내에 시각적 요소를 표시하기 위한 영역은 변화할 수도 있다. 예를 들어, 기둥형 활성 구역들이 사용되고 있는 경우에, HMD 는 각기의 시각적 요소를 표시하기 위해 각 칼럼 내에 수직적 위치를 결정할 수도 있거나, 활성 구역 내에 시각적 요소의 사이즈 또는 형상을 변화시키도록 결정할 수도 있다.

블록 915 에서, (사용자의 시각으로부터) 디스플레이 영역 내에 나타나는 물리적 객체가 추적된다. 추적하는 수단은, 카메라, 센서, 및/또는 이미지 및/또는 위치 측정들을 캡처하도록 구성되고 프로세싱 유닛, 메모리, 및/또는 이미지 및/또는 위치 측정들에 기초하여 위치를 결정하도록 구성된 다른 컴퓨팅 수단과 통신가능하게 커플링된 다른 컴포넌트들에 의해 수행될 수 있다. 이러한 수단은 도 10 과 관련하여 이하 추가적으로 상세히 설명된다.

상기 나타낸 바와 같이, 물리적 객체를 추적하기 위한 컴포넌트들은 투명 디스플레이 영역에서 시각적 요소들을 디스플레이하기 위한 컴포넌트들로 규정될 수 있어, HMD 가 사용자가 무엇을 보는지를 결정하는 것을 가능하게 한다. 대응하여, 블록 920 에서, 방법 (900) 은, 사용자의 시각으로부터, 디스플레이 영역의 활성 구역 내에 물리적 객체의 적어도 일부분이 나타나는 것을 결정하는 것을 포함한다. 여기서 다시, 이 결정을 행하기 위한 수단은 프로세싱 유닛, 메모리, 및/또는 도 10 에 관해 설명되는 바와 같은 다른 컴퓨팅 수단을 포함할 수 있고, 이하 설명되는 추적 수단을 채용할 수도 있다. 일 실시형태에서, 범위의 극값 또는 다른 종단은 추적 포인트 (320) 로서 검출될 수도 있다. 일 실시형태에서, 추적된 객체가 구역의 대부분 또는 큰 부분을 차지하는 경우 활성 구역이 선택된다. 예를 들어, 도 4d 에서, 사용자의 손가락 및/또는 손은, 활성 구역 (420-1) 의 적어도 하반부 (bottom half) 와 같이 활성 구역 (420-1) 의 실질적인 부분을 점유한다. 일부 실시형태들에서, 활성 구역들은 항목들을 선택 또는 그 외에 GUI 를 제어하기 위해 사용되는 객체의 형상을 실질적으로 미러링하도록 구성될 수도 있다; 예를 들어, 활성 구역들은, 길게 연장된 제어 객체 또는 손가락과 같은 선택 객체가 이용될 때 칼럼들을 포함할 수도 있다.

추적 수단은 임의의 다양한 추적 알고리즘을 관여시킬 수도 있다. 어떤 추적 알고리즘은 단일 포인트 (예를 들어, 투명 디스플레이 영역 상의 좌표) 및/또는 객체 및/또는 객체 상의 위치 (예를 들어 손가락 끝) 와 연관된 구역을 단순히 추적할 수도 있다. 보다 복잡한 추적 알고리즘들은, (예를 들어, 관여 자세를 인식하기 위한) 객체의 형상, (예를 들어, 사용자가 버튼을 "눌렀는지" 여부를 결정하기 위한) 거리, 및 더 많은 것들과 같은 다른 특징들을 추적할 수도 있다. 실시형태들은 GUI 상호작용을 위해 다수의 및/또는 상이한 물리적 객체들을 추적하는 것이 가능할 수도 있다. 또한, 실시형태들은 어느 하나의 방법에 제한되지 않는다. 일부 실시형태들에서, HMD 는 오직 일정 객체들로부터의 입력들만 수용하도록 구성될 수도 있다. 예를 들어, HMD 는, 객체가 손가락 또는 손인지 여부를 검출하고, 후속하여 손가락 또는 손으로부터의 입력들을 수용하며, 다른 객체들로부터의 입력들을 거절하도록 구성될 수도 있다. 추가적으로 또는 대안적으로, HMD 는 손가락 및/또는 손 추적과 함께 이용될 수도 있는 눈 추적 (또는 "응시 (gaze)" 추적) 을 포함할 수도 있다. 이것은, 사용자의 응시가 아마도 그 구역을 보고 선택을 확인할 것이기 때문에 사용자가 객체 또는 구역을 선택하는 것을 시도하고 있다는 확신을 증가시킬 수 있다. 선택적으로, 사용자가 그의 또는 그녀의 손가락을 보고 있을 가능성이 큰 경우의 시나리오들에서, 손가락의 추적된 위치의 확신을 증가시키기 위해 사용자의 응시가 또한 추적될 수도 있다.

블록 925 에서, 블록 920 에서 이루어진 결정에 기초하여 사용자 인터페이스가 조작된다. 여기서 다시, 사용자 인터페이스를 조작하는 수단은 프로세싱 유닛, 메모리, 및/또는 사용자 인터페이스 (예를 들어, GUI) 를 보여주는 디스플레이에 커플링된 다른 컴퓨팅 수단을 포함할 수 있다.

도 9 에 예시된 특정 단계들은 HMD 와의 사용자 상호작용을 가능하게 하는 방법 (900) 의 일예를 제공한다는 것을 이해하여야 한다. 대안적인 실시형태들은 나타난 실시형태들에 대한 변경들을 포함할 수도 있다. 예를 들어, 대안적인 실시형태들은 방법 (900) 동안 상이한 포인트에서 투명 디스플레이 영역 내에 활성 구역을 정의하는 것을 포함할 수도 있다. 또 다른 실시형태들은 HMD 의 디스플레이 컴포넌트로 물리적 객체 추적 컴포넌트들을 교정하기 위한 액션들 (actions) 을 수행하는 것을 포함할 수도 있다. 또한, 특정 애플리케이션들에 따라 추가적인 특징들이 부가, 제거, 또는 결합될 수도 있다. 통상의 기술자는 많은 변화들, 변형들, 및 대안들을 인식할 것이다.

도 10 은 HMD 내에 통합 및/또는 HMD 와 통신가능하게 커플링될 수도 있는, 컴퓨터 시스템 (1000) 의 일 실시형태를 나타낸다. 컴퓨터 시스템 (1000) 의 하나 이상의 컴포넌트들은, HMD, 스마트 폰, 태블릿, 퍼스널 컴퓨터, 또는 다른 컴퓨팅 디바이스와 같은 상이한 디바이스들 사이에 공유될 수 있을 것이다. 일부 실시형태들에서, 소프트웨어 및 다른 애플리케이션들이 디스플레이에 통신가능하게 연결된 별개의 디바이스 상에서 실행될 수 있을 것이다. 다른 실시형태들에서, HMD 는 그것과 통합된 컴퓨터 시스템 (1000) 의 일부 또는 전부를 가질 수도 있다.

도 10 은 다양한 다른 실시형태들에 의해 제공되는 방법들을 수행할 수 있는 컴퓨터 시스템 (1000) 의 일 실시형태의 개략적 도시를 제공한다. 도 10 은 다양한 컴포넌트들의 일반화된 도시를 제공하는 것으로만 의미되는 것에 유의하여야 하고, 그것의 어느 것 또는 전부는 적절하게 이용될 수도 있다. 도 10 은 따라서, 어떻게 개별 시스템 엘리먼트들이 비교적 분리된 또는 비교적 보다 통합된 방식으로 구현될 수도 있는지를 넓게 나타낸다.

컴퓨터 시스템 (1000) 은 버스 (1005) 를 통해 전기적으로 커플링될 수 있는 (또는 그 외에 적절하게 통신할 수도 있는) 하드웨어 엘리먼트들을 포함하는 것으로 도시된다. 하드웨어 엘리먼트들은, 전술한 바와 같이 도 9 와 관련하여 설명된 것과 같은 다양한 단계들을 수행하기 위해 이용될 수 있는, 하나 이상의 범용 프로세서들, 하나 이상의 특수 용도 프로세서들 (예컨대, 디지털 신호 프로세서들, 그래픽 가속 프로세서들, 및/또는 기타), 및/또는 다른 프로세싱 수단을 제한 없이 포함할 수 있는 프로세서(들) (1010) 과 같은 프로세싱 유닛을 포함할 수도 있다. 하드웨어 엘리먼트들은 또한, 본 명세서에서 설명된 바와 같이 물리적 객체를 추적하기 위한 추적 수단으로서 프로세서(들) (1010) 과 함께 포함 및/또는 그 외에 이용될 수 있는, 하나 이상의 카메라들, 센서들 (예를 들어, 광, 열, 초음파, RF, 및/또는 객체를 추적하기 위한 데이터를 제공할 수 있는 다른 센서들), 및/또는 다른 추적 디바이스들을 제한 없이 포함할 수 있는 하나 이상의 입력 디바이스들 (1015) 을 포함할 수도 있다. 터치 패드, 키보드, 마이크로폰, 및/또는 기타와 같은 다른 디바이스들이 또한 포함될 수도 있다. 하나 이상의 출력 디바이스들 (1020) 이 또한 포함된다. 이들 출력 디바이스들은, 도 9 와 관련하여 설명된 바와 같은 하나 이상의 단계들을 수행하기 위해 이용될 수도 있는, 하나 이상의 투명 디스플레이 디바이스들 및/또는 다른 디스플레이 수단 뿐만 아니라 스피커들 및/또는 다른 디바이스들을 포함할 수 있다. 예를 들어, 시스템 (1000) 이 HMD 에서 구현되는 경우, 출력 디바이스 (1020) 는 투명 또는 반투명 디스플레이를 포함할 수도 있다. 디바이스 (1000) 가 전화, 또는 HMD 를 제어하는 다른 디바이스에서 구현되는 실시형태들에서, 출력 디바이스 (1020) 는 터치스크린을 포함할 수도 있거나 생략될 수도 있다.

컴퓨터 시스템 (1000) 은 추가로, 로컬 및/또는 네트워크 액세스가능한 스토리지를 제한 없이 포함할 수 있고, 및/또는, 디스크 드라이브, 드라이브 어레이, 광학 저장 디바이스, 프로그래머블일 수 있는 랜덤 액세스 메모리 ("RAM") 및/또는 판독 전용 메모리 ("ROM") 와 같은 솔리드 스테이트 저장 디바이스, 플래시-업데이트가능물 및/또는 기타를 제한 없이 포함할 수 있는, 하나 이상의 비-일시적 저장 디바이스들 (1025) 을 더 포함할 (및/또는 그와 통신할) 수도 있다. 그러한 저장 디바이스들은 다양한 파일 시스템들, 데이터베이스 구조들, 및/또는 기타를 제한 없이 포함하는 임의의 적절한 데이터 스토어들을 구현하도록 구성될 수도 있다.

컴퓨터 시스템 (1000) 은 또한, 모뎀, (무선 또는 유선) 네트워크 카드, 적외선 통신 디바이스, 무선 통신 디바이스 및/또는 (블루투스™ 디바이스, 1002.11 디바이스, 와이파이 디바이스, 와이맥스 디바이스, 셀룰러 통신 설비들 등과 같은) 칩셋, 및/또는 기타를 제한없이 포함할 수 있는, 통신 서브시스템 (1030) 을 포함할 수도 있을 것이다. 통신 서브시스템 (1030) 은 데이터가 네트워크, 다른 컴퓨터 시스템들, 및/또는 임의의 다른 전기적 디바이스들/주변장치들과 상호교환되는 것을 허용하기 위한 하나 이상의 입력 및/또는 출력 통신 인터페이스들을 포함할 수도 있다. 다수의 실시형태들에서, 컴퓨터 시스템 (1000) 은 추가로, 전술된 바와 같이, RAM 또는 ROM 디바이스를 포함할 수 있는 작업 메모리 (1035) 를 포함할 것이다.

컴퓨터 시스템 (1000) 은 또한, 오퍼레이팅 시스템 (1040), 디바이스 드라이버들, 실행가능 라이브러리들, 및/또는 다른 코드, 예컨대, 다양한 실시형태들에 의해 제공된 컴퓨터 프로그램들을 포함할 수도 있고, 및/또는 본 명세서에 설명된 것과 같이 다른 실시형태들에 의해 제공된, 방법들을 구현하고 및/또는 시스템들을 구성하도록 설계될 수도 있는 하나 이상의 애플리케이션(들) (1045) 을 포함하는, 작업 메모리 (1035) 내에 현재 로케이팅되고 있는 것으로 도시된 소프트웨어 엘리먼트들을 포함할 수 있다. 단지 예로서, 도 9 와 관련하여 설명된 방법 (900) 과 같은, 앞서 논의된 방법(들)에 대하여 설명된 하나 이상의 절차들의 일부분은 컴퓨터 (및/또는 컴퓨터 내의 프로세싱 유닛) 에 의해 실행가능한 코드 및/또는 명령들로서 구현될 수도 있을 것이고; 그러면, 일 양태에서, 그러한 코드 및/또는 명령들은 설명된 방법들에 따라 하나 이상의 동작들을 수행하도록 범용 컴퓨터 (또는 다른 디바이스) 를 구성 및/또는 적응시키는데 사용될 수 있다.

이들 명령들 및/또는 코드의 셋트는 전술된 저장 디바이스(들) (1025) 과 같은 비-일시적 컴퓨터 판독가능 저장 매체 상에 저장될 수도 있을 것이다. 일부 경우들에서, 저장 매체는 컴퓨터 시스템 (1000) 과 같은 컴퓨터 시스템 내에 통합될 수도 있을 것이다. 다른 실시형태들에서, 저장 매체는 컴퓨터 시스템 (예컨대, 광학 디스크와 같은 탈착가능한 매체) 로부터 분리될 수도 있을 것이고, 및/또는 설치 패키지에 제공될 수도 있을 것이며, 따라서 저장 매체는 저장된 명령들/코드로 범용 컴퓨터를 프로그래밍, 구성, 및/또는 적응시키는데 사용될 수 있다. 이들 명령들은 컴퓨터 시스템 (1000) 에 의해 실행가능한 실행가능 코드의 형태를 취할 수도 있을 것이고, 및/또는 (예컨대, 다양한 일반적으로 이용가능한 컴파일러들, 설치 프로그램들, 압축/압축해제 유틸리티들 등을 이용하여) 컴퓨터 시스템 (1000) 상에 컴필레이션 및/또는 설치 시에, 실행가능 코드의 형태를 취하는 소스 및/또는 설치가능 코드의 형태를 취할 수도 있을 것이다.

특정 요건들에 따라, 실질적인 변화들이 이루어질 수도 있다는 것은 통상의 기술자에게 있어 명백할 것이다. 예를 들어, 커스터마이징된 하드웨어가 또한 사용될 수도 있을 것이고, 및/또는 특정 엘리먼트들은 하드웨어, (애플릿들 등과 같은 휴대용 소프트웨어를 포함하는) 소프트웨어, 또는 이들 양자에서 구현될 수도 있을 것이다. 또한, 네트워크 입력/출력 디바이스들과 같은 다른 컴퓨팅 디바이스들에 대한 접속이 채용될 수도 있다.

전술한 바와 같이, 일 양태에서, 일부 실시형태들은 본 발명의 다양한 실시형태들에 따라 방법들을 수행하기 위해 (컴퓨터 시스템 (1000) 과 같은) 컴퓨터 시스템을 채용할 수도 있다. 실시형태들의 셋트에 따르면, 이러한 방법들의 절차들 중 일부 또는 전부는 작업 메모리 (1035) 에 포함된 (오퍼레이팅 시스템 (1040) 및/또는 애플리케이션 프로그램 (1045) 과 같은 다른 코드에 통합될 수도 있는) 하나 이상의 명령들의 하나 이상의 시퀀스들을 실행하는 프로세서 (1010) 에 응답하여 컴퓨터 시스템 (1000) 에 의해 수행된다. 그러한 명령들은 저장 디바이스(들) (1025) 중 하나 이상과 같은 다른 컴퓨터 판독가능 매체로부터 작업 메모리 (1035) 내로 읽혀질 수도 있다. 단지 예로서, 작업 메모리 (1035) 에 포함된 명령들의 시퀀스들의 실행은 프로세서(들) (1010) 로 하여금 본 명세서에 설명된 방법들의 하나 이상의 절차들을 수행하게 할 수도 있을 것이다. 추가적으로 또는 대안적으로, 본 명세서에 설명된 방법들의 부분들은 특수한 하드웨어를 통해 실행될 수도 있다.

본 명세서에서 사용되는 바와 같은 용어 "머신 판독가능 매체" 및 "컴퓨터 판독가능 매체" 는 머신으로 하여금 특정 방식으로 동작하게 하는 데이터를 제공하는데 참여하는 임의의 매체를 지칭한다. 컴퓨터 시스템 (1000) 을 이용하여 구현된 실시형태에서, 다양한 컴퓨터 판독가능 매체는 실행을 위해 명령들/코드를 프로세서(들) (1010) 에 제공하는데 수반될 수도 있을 것이고, 및/또는 그러한 명령들/코드를 저장 및/또는 운반하는데 사용될 수도 있을 것이다. 다수의 구현들에서, 컴퓨터 판독가능 매체는 물리적인 및/또는 유형의 저장 매체이다. 그러한 매체는 비-휘발성 매체, 휘발성 매체의 형태를 취할 수도 있다. 비-휘발성 매체는 예를 들어, 저장 디바이스(들) (1025) 과 같은 광학 및/또는 자기 디스크들을 포함한다. 휘발성 매체는 작업 메모리 (1035) 와 같은 동적 메모리를 제한없이 포함한다.

물리적인 및/또는 유형의 컴퓨터 판독가능 매체의 일반적인 형태들은 예컨대, 플로피 디스크, 플렉시블 디스크, 하드 디스크, 자기 테이프, 또는 임의의 다른 자기 매체, CD-ROM, 임의의 다른 광학 매체, 홀들의 패턴들을 갖는 임의의 다른 물리적 매체, RAM, PROM, EPROM, FLASH-EPROM, 임의의 다른 메모리 칩 또는 카트리지, 또는 컴퓨터가 명령들 및/또는 코드를 판독할 수 있는 임의의 다른 매체를 포함한다.

컴퓨터 판독가능 매체의 다양한 형태들은 실행을 위해 하나 이상의 명령들의 하나 이상의 시퀀스들을 프로세서(들) (1010) 에 전달하는데 수반될 수도 있다. 단지 예로서, 명령들은 초기에 원격 컴퓨터의 자기 디스크 (disk) 및/또는 광학 디스크 (disc) 에 전달될 수도 있다. 원격 컴퓨터는 명령들을 그것의 동적 메모리에 로딩하고, 그 명령들을 컴퓨터 시스템 (1000) 에 의해 수신 및/또는 실행되도록 송신 매체를 통해 신호들로서 전송할 수도 있을 것이다.

통신 서브시스템 (1030) (및/또는 그것의 컴포넌트들) 은 일반적으로 신호들을 수신할 것이고, 그 다음 버스 (1005) 는 프로세서(들) (1010) 이 명령들을 취출하여 실행하는 작업 메모리 (1035) 에 신호들 (및/또는 신호들에 의해 전달된 데이터, 명령들 등) 을 전달할 수도 있을 것이다. 작업 메모리 (1035) 에 의해 수신된 명령들은 선택적으로, 프로세서(들) (1010) 에 의한 실행 전 또는 후 중 어느 일방에서 비-일시적 저장 디바이스 (1025) 에 저장될 수도 있다.

상기 논의된 방법들, 시스템들, 및 디바이스들은 예들이다. 다양한 구성들이 다양한 절차들 또는 컴포넌트들을 적절하게 생략, 치환, 또는 부가할 수도 있다. 예를 들어, 대안적인 구성들에 있어서, 방법들은 설명된 것과 상이한 순서로 수행될 수도 있고/있거나 다양한 스테이지들이 부가, 생략, 및/또는 결합될 수도 있다. 또한, 특정 구성들에 대해 설명된 특징들은 다양한 다른 구성들에서 결합될 수도 있다. 구성들의 상이한 양태들 및 엘리먼트들이 유사한 방식으로 결합될 수도 있다. 또한, 기술은 진화하고, 따라서 다수의 엘리먼트들은 예들이고, 본 개시물 또는 청구항들의 범위를 제한하지 않는다.

특정 상세들이 (구현들을 포함하는) 예시적인 구성의 철저한 이해를 제공하기 위해 상세한 설명에서 주어진다. 그러나, 구성들은 이들 특정 상세들 없이도 실시될 수도 있다. 예를 들어, 잘 알려진 회로들, 프로세스들, 알고리즘들, 구조들, 및 기술들은, 구성들을 모호하게 하는 것을 회피하기 위해 불필요한 상세없이 도시되었다. 이 설명은 오직 예시적인 구성들을 제공하고, 청구항들의 범위, 적용가능성, 또는 구성들을 제한하지 않는다. 오히려, 구성들의 이전 설명은 설명된 기술들을 구현하기 위해 가능한 설명을 통상의 기술자에게 제공할 것이다. 본 개시물의 사상 및 범위로부터의 벗어남이 없이 엘리먼트들의 기능 및 배열에 있어서 다양한 변경들이 이루어질 수도 있다.

또한, 구성들은 플로우 다이어그램들 또는 블록 다이어그램들로서 도시된 프로세스로서 설명될 수도 있다. 각각이 동작들을 순차적인 프로세스로서 기술할 수도 있지만, 동작들 중 다수는 병렬로 또는 동시에 수행될 수 있다. 또한, 동작들의 순서는 재배열될 수도 있다. 프로세스는, 도면에 포함되지 않은 추가적인 단계들을 가질 수도 있다. 더욱이, 방법들의 예들은 하드웨어, 소프트웨어, 펌웨어, 미들웨어, 마이크로코드, 하드웨어 디스크립션 언어들, 또는 이들의 임의의 조합에 의해 구현될 수도 있다. 소프트웨어, 펌웨어, 미들웨어, 또는 마이크로코드로 구현되는 경우, 필요한 작업들을 수행하기 위한 프로그램 코드 또는 코드 세그먼트들은 저장 매체와 같은 비-일시적 컴퓨터 판독가능 매체에 저장될 수도 있다. 프로세서들은 설명된 작업들을 수행할 수도 있다.

몇몇 예시적인 구성들을 설명하였고, 다양한 변형들, 대안적인 구성들, 및 균등물들이 본 개시물의 사상으로부터 벗어남이 없이 이용될 수도 있다. 예를 들어, 상기 엘리먼트들은 더 큰 시스템의 컴포넌트들일 수도 있으며, 여기서, 다른 규칙들이 본 발명의 애플리케이션에 우선할 수도 있거나, 그 외에 본 발명의 애플리케이션을 변형할 수도 있다. 또한, 다수의 단계들이, 상기 엘리먼트들이 고려되기 전, 동안, 또는 후에 착수될 수도 있다. 따라서, 상기 설명은 청구항들의 범위를 한정하지 않는다.

Claims (20)

- 헤드 마운티드 디스플레이 (HMD) 에서 사용자 인터페이스를 제공하는 방법으로서,

물리적 객체가, 상기 사용자의 시각 (perspective) 으로부터, 상기 HMD 의 투명 디스플레이 영역 내에서 나타났다는 결정에 기초하여, 트리거링 이벤트가 발생했다고 결정하는 단계;

상기 트리거링 이벤트가 발생했다는 결정에 응답하여, 제 1 시각적 요소를 포함하는 복수의 시각적 요소들이 상기 투명 디스플레이 영역에서 표시되도록 하는 단계로서, 상기 복수의 시각적 요소들의 각각의 시각적 요소는 상기 HMD 의 사용자에 의해 선택가능한, 상기 제 1 시각적 요소를 포함하는 복수의 시각적 요소들이 상기 투명 디스플레이 영역에서 표시되도록 하는 단계;

복수의 활성 구역들을 정의하는 단계로서, 상기 복수의 시각적 요소들의 각각의 시각적 요소에 대해, 상기 시각적 요소가 상기 활성 구역의 부분 내에 배치되도록 상기 시각적 요소보다 더 큰 상기 투명 디스플레이 영역의 대응하는 활성 구역이 정의되고, 상기 제 1 시각적 요소의 활성 구역은 제 1 활성 구역을 포함하는, 상기 복수의 활성 구역들을 정의하는 단계;

상기 사용자의 시각으로부터, 상기 투명 디스플레이 영역 내에 나타나는 상기 물리적 객체를 추적하는 단계;

상기 사용자의 시각으로부터, 상기 물리적 객체의 적어도 일부분이, 상기 제 1 시각적 요소의 선택을 나타내는, 상기 제 1 활성 구역 내에 나타난다는 것을 결정하는 단계; 및

상기 선택에 기초하여, 프로세싱 유닛으로 상기 사용자 인터페이스를 조작하는 단계를 포함하는, HMD 에서 사용자 인터페이스를 제공하는 방법. - 제 1 항에 있어서,

상기 트리거링 이벤트는,

상기 물리적 객체가, 상기 사용자의 시각으로부터, 임계 기간 동안 상기 HMD 의 상기 투명 디스플레이 영역 내에서 나타나는 것,

상기 물리적 객체가 소정의 포즈에 관여하는 것,

상기 물리적 객체가, 상기 사용자의 시각으로부터, 상기 HMD 의 상기 투명 디스플레이 영역의 소정 부분에서 나타나는 것, 또는

이들의 임의의 조합

중 적어도 하나를 포함하는, HMD 에서 사용자 인터페이스를 제공하는 방법. - 제 1 항에 있어서,

상기 제 1 활성 구역의 경계는 상기 투명 디스플레이 영역의 에지까지 연장되는, HMD 에서 사용자 인터페이스를 제공하는 방법. - 제 1 항에 있어서,

상기 추적에 기초하여, 상기 제 1 활성 구역이 상기 투명 디스플레이 영역에서 표시되도록 하는 단계를 더 포함하는, HMD 에서 사용자 인터페이스를 제공하는 방법. - 제 1 항에 있어서,

상기 복수의 활성 구역들의 각각의 활성 구역이 상기 투명 디스플레이 영역에서 표시되도록 하는 단계를 더 포함하는, HMD 에서 사용자 인터페이스를 제공하는 방법. - 제 1 항에 있어서,

상기 복수의 활성 구역들은, 상기 사용자의 시각으로부터, 상기 투명 디스플레이 영역 내에 배치된 일련의 칼럼들을 포함하는, HMD 에서 사용자 인터페이스를 제공하는 방법. - 제 1 항에 있어서,

상기 물리적 객체는 상기 사용자의 손을 포함하는, HMD 에서 사용자 인터페이스를 제공하는 방법. - 제 1 항에 있어서,

상기 물리적 객체가 상기 HMD 로부터 임계 거리 내에 있는 것을 결정하는 단계를 더 포함하는, HMD 에서 사용자 인터페이스를 제공하는 방법. - 헤드 마운티드 디스플레이 (HMD) 로서,

투명 디스플레이 영역을 갖는 디스플레이;

상기 HMD 의 사용자에 의해 상기 투명 디스플레이 영역을 통해 볼 수 있는 객체들에 관한 데이터를 제공하도록 구성된 센서; 및

상기 디스플레이 및 상기 센서와 통신가능하게 커플링된 프로세싱 유닛을 포함하고,

상기 프로세싱 유닛은,

물리적 객체가, 상기 사용자의 시각 (perspective) 으로부터, 상기 HMD 의 투명 디스플레이 영역 내에서 나타났다는 결정에 기초하여, 트리거링 이벤트가 발생했다고 결정하는 것;

상기 트리거링 이벤트가 발생했다는 결정에 응답하여, 상기 디스플레이로 하여금, 제 1 시각적 요소를 포함하는 복수의 시각적 요소들을 상기 투명 디스플레이 영역에서 보여주게 하는 것으로서, 상기 복수의 시각적 요소들의 각각의 시각적 요소는 상기 HMD 의 사용자에 의해 선택가능한, 상기 제 1 시각적 요소를 포함하는 복수의 시각적 요소들을 상기 투명 디스플레이 영역에서 보여주게 하는 것;

복수의 활성 구역들을 정의하는 것으로서, 상기 복수의 시각적 요소들의 각각의 시각적 요소에 대해, 상기 시각적 요소가 상기 활성 구역의 부분 내에 배치되도록 상기 투명 디스플레이 영역의 대응하는 활성 구역이 정의되고, 상기 제 1 시각적 요소의 활성 구역은 제 1 활성 구역을 포함하는, 상기 복수의 활성 구역들을 정의하는 것;

상기 사용자의 시각으로부터, 상기 투명 디스플레이 영역 내에 나타나는 상기 물리적 객체를 추적하기 위해 상기 센서로부터의 상기 데이터를 이용하는 것;

상기 사용자의 시각으로부터, 상기 물리적 객체의 적어도 일부분이, 상기 제 1 시각적 요소의 선택을 나타내는, 상기 제 1 활성 구역 내에 나타난다는 것을 결정하는 것; 및

상기 선택에 기초하여 상기 디스플레이 상에 표시되는 하나 이상의 요소들을 조작하는 것

을 포함하는 기능들을 수행하도록 구성되는, HMD. - 제 9 항에 있어서,

상기 프로세싱 유닛은,

상기 물리적 객체가, 상기 사용자의 시각으로부터, 임계 기간 동안 상기 HMD 의 상기 투명 디스플레이 영역 내에서 나타나는 것,

상기 물리적 객체가 소정의 포즈에 관여하는 것,

상기 물리적 객체가, 상기 사용자의 시각으로부터, 상기 HMD 의 상기 투명 디스플레이 영역의 소정 부분에서 나타나는 것, 또는

이들의 임의의 조합

을 포함하는 트리거링 이벤트를 식별하도록 구성되는, HMD. - 제 9 항에 있어서,

상기 프로세싱 유닛은, 상기 제 1 활성 구역의 경계가 상기 투명 디스플레이 영역의 에지까지 연장되도록 상기 제 1 활성 구역의 경계를 정의하도록 구성되는, HMD. - 제 9 항에 있어서,

상기 프로세싱 유닛은, 상기 디스플레이로 하여금, 추적된 상기 물리적 객체에 기초하여 상기 제 1 활성 구역을 보여주게 하도록 구성되는, HMD. - 제 9 항에 있어서,

상기 프로세싱 유닛은, 상기 디스플레이로 하여금, 상기 복수의 활성 구역들의 각각의 활성 구역을 보여주게 하도록 구성되는, HMD. - 제 9 항에 있어서,

상기 프로세싱 유닛은, 상기 디스플레이로 하여금, 상기 복수의 활성 구역들이 상기 사용자의 시각으로부터 상기 투명 디스플레이 영역 내에 배치된 일련의 칼럼들을 포함하도록 상기 복수의 활성 구역들을 보여주게 하도록 구성되는, HMD. - 제 9 항에 있어서,

상기 프로세싱 유닛은, 상기 물리적 객체가 상기 HMD 로부터 임계 거리 내에 있는 것을 결정하도록 더 구성되는, HMD. - 비-일시적 컴퓨터 판독가능 저장 매체로서,

물리적 객체가, 사용자의 시각 (perspective) 으로부터, 헤드 마운티드 디스플레이 (HMD) 의 투명 디스플레이 영역 내에서 나타났다는 결정에 기초하여, 트리거링 이벤트가 발생했다고 결정하는 것;

상기 트리거링 이벤트가 발생했다는 결정에 응답하여, 제 1 시각적 요소를 포함하는 복수의 시각적 요소들이 상기 투명 디스플레이 영역에서 표시되도록 하는 것으로서, 상기 복수의 시각적 요소들의 각각의 시각적 요소는 상기 HMD 의 사용자에 의해 선택가능한, 상기 제 1 시각적 요소를 포함하는 복수의 시각적 요소들이 상기 투명 디스플레이 영역에서 표시되도록 하는 것;

복수의 활성 구역들을 정의하는 것으로서, 상기 복수의 시각적 요소들의 각각의 시각적 요소에 대해, 상기 시각적 요소가 상기 활성 구역의 부분 내에 배치되도록 상기 시각적 요소보다 더 큰 상기 투명 디스플레이 영역의 대응하는 활성 구역이 정의되고, 상기 제 1 시각적 요소의 활성 구역은 제 1 활성 구역을 포함하는, 상기 복수의 활성 구역들을 정의하는 것;

상기 사용자의 시각으로부터, 상기 투명 디스플레이 영역 내에 나타나는 상기 물리적 객체를 추적하는 것;

상기 사용자의 시각으로부터, 상기 물리적 객체의 적어도 일부분이, 상기 제 1 시각적 요소의 선택을 나타내는, 상기 제 1 활성 구역 내에 나타난다는 것을 결정하는 것; 및

상기 선택에 기초하여, 상기 투명 디스플레이 영역에서 표시되는 하나 이상의 요소들을 조작하는 것

을 포함하는 기능들을 상기 HMD 로 하여금 수행하게 하기 위한 명령들로 인코딩되는, 비-일시적 컴퓨터 판독가능 저장 매체. - 물리적 객체가, 사용자의 시각 (perspective) 으로부터, 헤드 마운티드 디스플레이 (HMD) 의 투명 디스플레이 영역 내에서 나타났다는 결정에 기초하여, 트리거링 이벤트가 발생했다고 결정하는 수단;

상기 트리거링 이벤트가 발생했다는 결정에 응답하여, 제 1 시각적 요소를 포함하는 복수의 시각적 요소들이 상기 투명 디스플레이 영역에서 표시되도록 하는 수단으로서, 상기 복수의 시각적 요소들의 각각의 시각적 요소는 상기 HMD 의 사용자에 의해 선택가능한, 상기 제 1 시각적 요소를 포함하는 복수의 시각적 요소들이 상기 투명 디스플레이 영역에서 표시되도록 하는 수단;

복수의 활성 구역들을 정의하는 수단으로서, 상기 복수의 시각적 요소들의 각각의 시각적 요소에 대해, 상기 시각적 요소가 상기 활성 구역의 부분 내에 배치되도록 상기 시각적 요소보다 더 큰 상기 투명 디스플레이 영역의 대응하는 활성 구역이 정의되고, 상기 제 1 시각적 요소의 활성 구역은 제 1 활성 구역을 포함하는, 상기 복수의 활성 구역들을 정의하는 수단;

상기 사용자의 시각으로부터, 상기 투명 디스플레이 영역 내에 나타나는 상기 물리적 객체를 추적하는 수단;

상기 사용자의 시각으로부터, 상기 물리적 객체의 적어도 일부분이, 상기 제 1 시각적 요소의 선택을 나타내는, 상기 제 1 활성 구역 내에 나타난다는 것을 결정하는 수단; 및

상기 선택에 기초하여, 프로세싱 유닛으로 하나 이상의 요소들을 조작하는 수단을 포함하는, 장치. - 제 17 항에 있어서,

상기 트리거링 이벤트가 발생했다고 결정하는 수단은,

상기 물리적 객체가, 상기 사용자의 시각으로부터, 임계 기간 동안 상기 HMD 의 상기 투명 디스플레이 영역 내에서 나타난 것,

상기 물리적 객체가 소정의 포즈에 관여한 것,

상기 물리적 객체가, 상기 사용자의 시각으로부터, 상기 HMD 의 상기 투명 디스플레이 영역의 소정 부분에서 나타난 것, 또는

이들의 임의의 조합

중 적어도 하나를 결정하는 수단을 포함하는, 장치. - 제 17 항에 있어서,

상기 복수의 활성 구역들의 각각의 활성 구역이 상기 투명 디스플레이 영역에서 표시되도록 하는 수단을 더 포함하는, 장치. - 제 17 항에 있어서,

상기 물리적 객체가 상기 HMD 로부터 임계 거리 내에 있는 것을 결정하는 수단을 더 포함하는, 장치.

Applications Claiming Priority (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US201261659914P | 2012-06-14 | 2012-06-14 | |

| US61/659,914 | 2012-06-14 | ||

| US13/800,329 US9389420B2 (en) | 2012-06-14 | 2013-03-13 | User interface interaction for transparent head-mounted displays |

| US13/800,329 | 2013-03-13 | ||

| PCT/US2013/041647 WO2013188054A1 (en) | 2012-06-14 | 2013-05-17 | User interface interaction for transparent head-mounted displays |

Related Parent Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020157000625A Division KR101845217B1 (ko) | 2012-06-14 | 2013-05-17 | 투명 헤드 마운티드 디스플레이들에 대한 사용자 인터페이스 상호작용 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20160120810A true KR20160120810A (ko) | 2016-10-18 |

Family

ID=49755393

Family Applications (2)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020157000625A KR101845217B1 (ko) | 2012-06-14 | 2013-05-17 | 투명 헤드 마운티드 디스플레이들에 대한 사용자 인터페이스 상호작용 |

| KR1020167028028A KR20160120810A (ko) | 2012-06-14 | 2013-05-17 | 투명 헤드 마운티드 디스플레이들에 대한 사용자 인터페이스 상호작용 |

Family Applications Before (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020157000625A KR101845217B1 (ko) | 2012-06-14 | 2013-05-17 | 투명 헤드 마운티드 디스플레이들에 대한 사용자 인터페이스 상호작용 |

Country Status (8)

| Country | Link |

|---|---|

| US (2) | US9389420B2 (ko) |

| EP (2) | EP2862042B1 (ko) |

| JP (3) | JP6039801B2 (ko) |

| KR (2) | KR101845217B1 (ko) |

| CN (1) | CN104335142B (ko) |

| BR (1) | BR112014030606A8 (ko) |

| IN (1) | IN2014MN02353A (ko) |

| WO (1) | WO2013188054A1 (ko) |

Families Citing this family (115)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9977496B2 (en) * | 2010-07-23 | 2018-05-22 | Telepatheye Inc. | Eye-wearable device user interface and augmented reality method |

| US20120257035A1 (en) * | 2011-04-08 | 2012-10-11 | Sony Computer Entertainment Inc. | Systems and methods for providing feedback by tracking user gaze and gestures |

| US9389420B2 (en) * | 2012-06-14 | 2016-07-12 | Qualcomm Incorporated | User interface interaction for transparent head-mounted displays |

| US9389682B2 (en) * | 2012-07-02 | 2016-07-12 | Sony Interactive Entertainment Inc. | Methods and systems for interaction with an expanded information space |

| JP5962403B2 (ja) * | 2012-10-01 | 2016-08-03 | ソニー株式会社 | 情報処理装置、表示制御方法及びプログラム |

| EP2908919A1 (en) | 2012-10-22 | 2015-08-26 | Longsand Limited | Collaborative augmented reality |

| US9202313B2 (en) * | 2013-01-21 | 2015-12-01 | Microsoft Technology Licensing, Llc | Virtual interaction with image projection |

| US20140267581A1 (en) | 2013-03-15 | 2014-09-18 | John Cronin | Real time virtual reality leveraging web cams and ip cams and web cam and ip cam networks |

| US20140280506A1 (en) | 2013-03-15 | 2014-09-18 | John Cronin | Virtual reality enhanced through browser connections |

| US20140280502A1 (en) | 2013-03-15 | 2014-09-18 | John Cronin | Crowd and cloud enabled virtual reality distributed location network |

| US9262865B2 (en) * | 2013-03-15 | 2016-02-16 | Daqri, Llc | Content creation tool |

| US9239661B2 (en) | 2013-03-15 | 2016-01-19 | Qualcomm Incorporated | Methods and apparatus for displaying images on a head mounted display |

| US9495748B2 (en) * | 2013-03-15 | 2016-11-15 | Daqri, Llc | Segmentation of content delivery |

| US9240075B2 (en) * | 2013-03-15 | 2016-01-19 | Daqri, Llc | Campaign optimization for experience content dataset |

| US20140280644A1 (en) | 2013-03-15 | 2014-09-18 | John Cronin | Real time unified communications interaction of a predefined location in a virtual reality location |

| US9838506B1 (en) | 2013-03-15 | 2017-12-05 | Sony Interactive Entertainment America Llc | Virtual reality universe representation changes viewing based upon client side parameters |

| US20140280503A1 (en) | 2013-03-15 | 2014-09-18 | John Cronin | System and methods for effective virtual reality visitor interface |

| US20140280505A1 (en) | 2013-03-15 | 2014-09-18 | John Cronin | Virtual reality interaction with 3d printing |

| US10152495B2 (en) * | 2013-08-19 | 2018-12-11 | Qualcomm Incorporated | Visual search in real world using optical see-through head mounted display with augmented reality and user interaction tracking |

| US10089786B2 (en) * | 2013-08-19 | 2018-10-02 | Qualcomm Incorporated | Automatic customization of graphical user interface for optical see-through head mounted display with user interaction tracking |

| TWI505135B (zh) * | 2013-08-20 | 2015-10-21 | Utechzone Co Ltd | 顯示畫面的控制系統、輸入裝置及控制方法 |

| USD748646S1 (en) * | 2013-08-30 | 2016-02-02 | Samsung Electronics Co., Ltd. | Display screen or portion thereof with graphical user interface |

| US9934611B2 (en) | 2013-09-11 | 2018-04-03 | Qualcomm Incorporated | Structural modeling using depth sensors |

| CN105899996B (zh) * | 2013-12-06 | 2019-04-23 | 瑞典爱立信有限公司 | 光学头戴式显示器、电视入口模块和用于控制图形用户界面的方法 |

| WO2015107625A1 (ja) * | 2014-01-15 | 2015-07-23 | 日立マクセル株式会社 | 情報表示端末、情報表示システム及び情報表示方法 |

| US10649220B2 (en) | 2014-06-09 | 2020-05-12 | Mentor Acquisition One, Llc | Content presentation in head worn computing |

| US9575321B2 (en) * | 2014-06-09 | 2017-02-21 | Osterhout Group, Inc. | Content presentation in head worn computing |

| US9437159B2 (en) | 2014-01-25 | 2016-09-06 | Sony Interactive Entertainment America Llc | Environmental interrupt in a head-mounted display and utilization of non field of view real estate |

| US9588343B2 (en) * | 2014-01-25 | 2017-03-07 | Sony Interactive Entertainment America Llc | Menu navigation in a head-mounted display |

| EP2919096B8 (en) * | 2014-02-14 | 2019-12-25 | Omron Corporation | Gesture recognition apparatus and control method of gesture recognition apparatus |

| JP6349800B2 (ja) | 2014-03-12 | 2018-07-04 | オムロン株式会社 | ジェスチャ認識装置およびジェスチャ認識装置の制御方法 |

| KR20150102589A (ko) * | 2014-02-28 | 2015-09-07 | 삼성메디슨 주식회사 | 의료 영상 처리 장치, 의료 영상 처리 방법, 및 컴퓨터 판독가능 기록매체 |

| DE102014103195A1 (de) * | 2014-03-11 | 2015-09-17 | Amazonen-Werke H. Dreyer Gmbh & Co. Kg | Assistenzsystem für eine landwirtschaftliche Arbeitsmaschine und Verfahren zur Unterstützung einer Bedienperson |

| US10802582B1 (en) * | 2014-04-22 | 2020-10-13 | sigmund lindsay clements | Eye tracker in an augmented reality glasses for eye gaze to input displayed input icons |

| US10663740B2 (en) * | 2014-06-09 | 2020-05-26 | Mentor Acquisition One, Llc | Content presentation in head worn computing |

| US9766806B2 (en) | 2014-07-15 | 2017-09-19 | Microsoft Technology Licensing, Llc | Holographic keyboard display |

| US9858720B2 (en) | 2014-07-25 | 2018-01-02 | Microsoft Technology Licensing, Llc | Three-dimensional mixed-reality viewport |

| US10416760B2 (en) | 2014-07-25 | 2019-09-17 | Microsoft Technology Licensing, Llc | Gaze-based object placement within a virtual reality environment |

| US10311638B2 (en) | 2014-07-25 | 2019-06-04 | Microsoft Technology Licensing, Llc | Anti-trip when immersed in a virtual reality environment |

| US9904055B2 (en) | 2014-07-25 | 2018-02-27 | Microsoft Technology Licensing, Llc | Smart placement of virtual objects to stay in the field of view of a head mounted display |

| US10451875B2 (en) | 2014-07-25 | 2019-10-22 | Microsoft Technology Licensing, Llc | Smart transparency for virtual objects |

| US9865089B2 (en) | 2014-07-25 | 2018-01-09 | Microsoft Technology Licensing, Llc | Virtual reality environment with real world objects |

| US9766460B2 (en) | 2014-07-25 | 2017-09-19 | Microsoft Technology Licensing, Llc | Ground plane adjustment in a virtual reality environment |

| WO2016017956A1 (en) | 2014-07-30 | 2016-02-04 | Samsung Electronics Co., Ltd. | Wearable device and method of operating the same |

| KR102397397B1 (ko) * | 2014-07-30 | 2022-05-13 | 삼성전자주식회사 | 웨어러블 디바이스 및 웨어러블 디바이스의 동작 방법 |

| US9971501B2 (en) * | 2014-08-07 | 2018-05-15 | Verizon New Jersey Inc. | Method and system for providing adaptive arrangement and representation of user interface elements |

| KR20160024168A (ko) * | 2014-08-25 | 2016-03-04 | 삼성전자주식회사 | 전자 장치의 디스플레이 제어 방법 및 전자 장치 |

| KR102271833B1 (ko) * | 2014-09-01 | 2021-07-01 | 삼성전자주식회사 | 전자 장치, 그 제어 방법 및 기록 매체 |

| US10067561B2 (en) * | 2014-09-22 | 2018-09-04 | Facebook, Inc. | Display visibility based on eye convergence |

| KR102358548B1 (ko) | 2014-10-15 | 2022-02-04 | 삼성전자주식회사 | 디바이스를 이용한 화면 처리 방법 및 장치 |

| CN105635776B (zh) * | 2014-11-06 | 2019-03-01 | 深圳Tcl新技术有限公司 | 虚拟操作界面遥控控制方法及系统 |

| WO2016073986A1 (en) * | 2014-11-07 | 2016-05-12 | Eye Labs, LLC | Visual stabilization system for head-mounted displays |

| KR20160063812A (ko) * | 2014-11-27 | 2016-06-07 | 삼성전자주식회사 | 화면 구성 방법, 전자 장치 및 저장 매체 |

| GB2532954A (en) | 2014-12-02 | 2016-06-08 | Ibm | Display control system for an augmented reality display system |

| US10248192B2 (en) | 2014-12-03 | 2019-04-02 | Microsoft Technology Licensing, Llc | Gaze target application launcher |

| US10152119B2 (en) * | 2014-12-11 | 2018-12-11 | Htc Corporation | Head-mounted display apparatus and calibration method thereof |

| JP2016180955A (ja) * | 2015-03-25 | 2016-10-13 | 株式会社ソニー・インタラクティブエンタテインメント | ヘッドマウントディスプレイ、表示制御方法及び位置制御方法 |

| JP6596883B2 (ja) * | 2015-03-31 | 2019-10-30 | ソニー株式会社 | ヘッドマウントディスプレイ及びヘッドマウントディスプレイの制御方法、並びにコンピューター・プログラム |

| EP3079041B1 (de) * | 2015-04-10 | 2018-06-27 | Airbus Defence and Space GmbH | Verfahren und system zur bereitstellung einer virtual-reality-umgebung für passagiere von land- und luftfahrzeugen |

| US9760790B2 (en) | 2015-05-12 | 2017-09-12 | Microsoft Technology Licensing, Llc | Context-aware display of objects in mixed environments |

| US9442575B1 (en) * | 2015-05-15 | 2016-09-13 | Atheer, Inc. | Method and apparatus for applying free space input for surface constrained control |

| KR20160138806A (ko) * | 2015-05-26 | 2016-12-06 | 엘지전자 주식회사 | 글래스타입 단말기 및 그 제어방법 |

| US9959677B2 (en) * | 2015-05-26 | 2018-05-01 | Google Llc | Multidimensional graphical method for entering and exiting applications and activities in immersive media |

| US10318225B2 (en) | 2015-09-01 | 2019-06-11 | Microsoft Technology Licensing, Llc | Holographic augmented authoring |

| JP6536350B2 (ja) * | 2015-10-26 | 2019-07-03 | 船井電機株式会社 | 入力装置 |

| CN105892630A (zh) * | 2015-11-02 | 2016-08-24 | 乐视致新电子科技(天津)有限公司 | 列表内容显示方法及装置 |

| KR102450416B1 (ko) | 2015-11-04 | 2022-10-05 | 삼성전자주식회사 | 전자 장치, 웨어러블 장치 및 전자 장치에서 디스플레이되는 객체를 제어하는 방법 |

| US20170131874A1 (en) * | 2015-11-09 | 2017-05-11 | Livetiles Llc | Software Design Tool For A User Interface And The Administration Of Proximity Responsive Information Displays In Augmented Reality Or Virtual Reality Environments |

| CN105892636A (zh) * | 2015-11-20 | 2016-08-24 | 乐视致新电子科技(天津)有限公司 | 一种应用于头戴设备的控制方法及头戴设备 |

| JP6716897B2 (ja) * | 2015-11-30 | 2020-07-01 | 富士通株式会社 | 操作検出方法、操作検出装置、及び操作検出プログラム |

| CN108700991A (zh) * | 2015-12-01 | 2018-10-23 | 量子界面有限责任公司 | 用于为移动设备建立3轴坐标系并且利用虚拟键盘进行写入的基于运动的系统、装置和方法 |

| US20190019308A1 (en) * | 2016-01-12 | 2019-01-17 | Suncorporation | Image display device |

| US10353463B2 (en) * | 2016-03-16 | 2019-07-16 | RaayonNova LLC | Smart contact lens with eye driven control system and method |

| JP2019113881A (ja) * | 2016-03-23 | 2019-07-11 | 株式会社ソニー・インタラクティブエンタテインメント | 頭部装着装置 |

| JP2017182413A (ja) * | 2016-03-30 | 2017-10-05 | セイコーエプソン株式会社 | 頭部装着型表示装置およびその制御方法、並びにコンピュータープログラム |

| US20170289533A1 (en) * | 2016-03-30 | 2017-10-05 | Seiko Epson Corporation | Head mounted display, control method thereof, and computer program |

| US10643390B2 (en) | 2016-03-30 | 2020-05-05 | Seiko Epson Corporation | Head mounted display, method for controlling head mounted display, and computer program |

| EP3457251A1 (en) * | 2016-04-27 | 2019-03-20 | Rovi Guides, Inc. | Methods and systems for displaying additional content on a heads up display displaying a virtual reality environment |

| US10025376B2 (en) | 2016-04-27 | 2018-07-17 | Rovi Guides, Inc. | Methods and systems for displaying additional content on a heads up display displaying a virtual reality environment |

| JP6238381B1 (ja) * | 2016-06-30 | 2017-11-29 | 株式会社コナミデジタルエンタテインメント | 端末装置、及びプログラム |

| JP2018049267A (ja) * | 2016-09-16 | 2018-03-29 | 株式会社半導体エネルギー研究所 | 表示システム、電子機器および表示方法 |

| US20180096506A1 (en) * | 2016-10-04 | 2018-04-05 | Facebook, Inc. | Controls and Interfaces for User Interactions in Virtual Spaces |

| KR102649729B1 (ko) | 2016-11-02 | 2024-03-22 | 삼성디스플레이 주식회사 | 표시장치 |

| US10867445B1 (en) * | 2016-11-16 | 2020-12-15 | Amazon Technologies, Inc. | Content segmentation and navigation |

| US10430647B2 (en) * | 2017-01-13 | 2019-10-01 | Microsoft Licensing Technology, LLC | Tailored illumination profile for articulated hand tracking |

| US10438399B2 (en) * | 2017-02-10 | 2019-10-08 | Sony Interactive Entertainment LLC | Paired local and global user interfaces for an improved augmented reality experience |

| CN110462690B (zh) * | 2017-03-27 | 2024-04-02 | Sun电子株式会社 | 图像显示系统 |

| US10290152B2 (en) | 2017-04-03 | 2019-05-14 | Microsoft Technology Licensing, Llc | Virtual object user interface display |

| JP6610602B2 (ja) * | 2017-04-07 | 2019-11-27 | 京セラドキュメントソリューションズ株式会社 | 表示入力装置 |

| WO2019005586A1 (en) * | 2017-06-29 | 2019-01-03 | Apple Inc. | FINGER-FITTED DEVICE WITH SENSORS AND HAPTIC TECHNOLOGY |

| CN107346175B (zh) * | 2017-06-30 | 2020-08-25 | 联想(北京)有限公司 | 一种手势位置校正方法和增强现实显示设备 |

| US10782793B2 (en) * | 2017-08-10 | 2020-09-22 | Google Llc | Context-sensitive hand interaction |

| US11199946B2 (en) * | 2017-09-20 | 2021-12-14 | Nec Corporation | Information processing apparatus, control method, and program |

| CN111201771B (zh) * | 2017-10-19 | 2022-08-30 | 索尼公司 | 电子仪器 |

| US10895913B1 (en) * | 2018-01-05 | 2021-01-19 | Amazon Technologies, Inc. | Input control for augmented reality applications |

| WO2019160955A1 (en) * | 2018-02-13 | 2019-08-22 | SentiAR, Inc. | Augmented reality display sharing |

| US10726765B2 (en) | 2018-02-15 | 2020-07-28 | Valve Corporation | Using tracking of display device to control image display |

| JP7457453B2 (ja) * | 2018-07-27 | 2024-03-28 | 株式会社栗本鐵工所 | 仮想オブジェクト触覚提示装置およびプログラム |

| US10748344B2 (en) * | 2018-09-12 | 2020-08-18 | Seiko Epson Corporation | Methods and devices for user interaction in augmented reality |

| US10855978B2 (en) * | 2018-09-14 | 2020-12-01 | The Toronto-Dominion Bank | System and method for receiving user input in virtual/augmented reality |

| US11487359B2 (en) | 2018-11-29 | 2022-11-01 | Maxell, Ltd. | Video display apparatus and method |

| EP3669748A1 (en) * | 2018-12-19 | 2020-06-24 | Koninklijke Philips N.V. | A mirror assembly |

| JP7024702B2 (ja) * | 2018-12-27 | 2022-02-24 | 株式会社デンソー | ジェスチャ検出装置、およびジェスチャ検出方法 |

| US11188148B2 (en) * | 2018-12-27 | 2021-11-30 | Facebook Technologies, Llc | User interaction in head-mounted display with eye tracking |

| DE102019202512A1 (de) * | 2019-01-30 | 2020-07-30 | Siemens Aktiengesellschaft | Verfahren und Anordnung zur Ausgabe eines HUD auf einem HMD |

| US11853533B1 (en) * | 2019-01-31 | 2023-12-26 | Splunk Inc. | Data visualization workspace in an extended reality environment |

| US11644940B1 (en) | 2019-01-31 | 2023-05-09 | Splunk Inc. | Data visualization in an extended reality environment |

| US11036464B2 (en) * | 2019-09-13 | 2021-06-15 | Bose Corporation | Spatialized augmented reality (AR) audio menu |

| EP3851939A1 (en) * | 2020-01-14 | 2021-07-21 | Apple Inc. | Positioning a user-controlled spatial selector based on extremity tracking information and eye tracking information |

| US11354026B1 (en) * | 2020-01-28 | 2022-06-07 | Apple Inc. | Method and device for assigning an operation set |

| WO2021173390A1 (en) * | 2020-02-27 | 2021-09-02 | Qsinx Management Llc | Connecting spatially distinct settings |

| US11796801B2 (en) * | 2021-05-24 | 2023-10-24 | Google Llc | Reducing light leakage via external gaze detection |

| JPWO2023276058A1 (ko) * | 2021-06-30 | 2023-01-05 | ||

| US11808945B2 (en) * | 2021-09-07 | 2023-11-07 | Meta Platforms Technologies, Llc | Eye data and operation of head mounted device |

| US20240054733A1 (en) * | 2022-08-12 | 2024-02-15 | State Farm Mutual Automobile Insurance Company | Systems and methods for enhanced outdoor displays via augmented reality |

Family Cites Families (24)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0778055A (ja) * | 1993-06-25 | 1995-03-20 | Casio Comput Co Ltd | データ処理装置 |

| JPH086708A (ja) * | 1994-04-22 | 1996-01-12 | Canon Inc | 表示装置 |

| US6847336B1 (en) * | 1996-10-02 | 2005-01-25 | Jerome H. Lemelson | Selectively controllable heads-up display system |

| KR100317632B1 (ko) * | 1997-07-21 | 2002-02-19 | 윤종용 | 메뉴 선택 제어방법 |

| US6819345B1 (en) | 1998-02-17 | 2004-11-16 | Microsoft Corporation | Managing position and size for a desktop component |

| JP2005056059A (ja) * | 2003-08-01 | 2005-03-03 | Canon Inc | 撮像部を備えた頭部搭載型ディスプレイを用いた入力装置および方法 |

| KR100800859B1 (ko) * | 2004-08-27 | 2008-02-04 | 삼성전자주식회사 | Hmd 정보 단말기에서 키를 입력하는 장치 및 방법 |

| US20080016463A1 (en) | 2006-07-14 | 2008-01-17 | Madentec (Usa) Inc. | Systems and methods for using a switch to control a computer |

| US9891435B2 (en) | 2006-11-02 | 2018-02-13 | Sensics, Inc. | Apparatus, systems and methods for providing motion tracking using a personal viewing device |

| JP2008210276A (ja) * | 2007-02-27 | 2008-09-11 | Canon Inc | 三次元モデル情報の生成方法及び装置 |

| JP2009245392A (ja) * | 2008-03-31 | 2009-10-22 | Brother Ind Ltd | ヘッドマウントディスプレイ及びヘッドマウントディスプレイシステム |

| JP5293154B2 (ja) * | 2008-12-19 | 2013-09-18 | ブラザー工業株式会社 | ヘッドマウントディスプレイ |

| JP5262681B2 (ja) * | 2008-12-22 | 2013-08-14 | ブラザー工業株式会社 | ヘッドマウントディスプレイ及びそのプログラム |

| JP2010204870A (ja) | 2009-03-03 | 2010-09-16 | Funai Electric Co Ltd | 入力装置 |

| US8472120B2 (en) * | 2010-02-28 | 2013-06-25 | Osterhout Group, Inc. | See-through near-eye display glasses with a small scale image source |

| US20120113223A1 (en) * | 2010-11-05 | 2012-05-10 | Microsoft Corporation | User Interaction in Augmented Reality |

| JP5977922B2 (ja) * | 2011-02-24 | 2016-08-24 | セイコーエプソン株式会社 | 情報処理装置および情報処理装置の制御方法、透過型頭部装着型表示装置 |

| US8860805B2 (en) | 2011-04-12 | 2014-10-14 | Lg Electronics Inc. | Electronic device and method of controlling the same |

| US20130021269A1 (en) * | 2011-07-20 | 2013-01-24 | Google Inc. | Dynamic Control of an Active Input Region of a User Interface |

| US8217856B1 (en) | 2011-07-27 | 2012-07-10 | Google Inc. | Head-mounted display that displays a visual representation of physical interaction with an input interface located outside of the field of view |

| US8963805B2 (en) * | 2012-01-27 | 2015-02-24 | Microsoft Corporation | Executable virtual objects associated with real objects |

| US9147111B2 (en) * | 2012-02-10 | 2015-09-29 | Microsoft Technology Licensing, Llc | Display with blocking image generation |

| US9116666B2 (en) * | 2012-06-01 | 2015-08-25 | Microsoft Technology Licensing, Llc | Gesture based region identification for holograms |

| US9389420B2 (en) * | 2012-06-14 | 2016-07-12 | Qualcomm Incorporated | User interface interaction for transparent head-mounted displays |

-

2013

- 2013-03-13 US US13/800,329 patent/US9389420B2/en active Active

- 2013-05-17 EP EP13731529.7A patent/EP2862042B1/en active Active

- 2013-05-17 CN CN201380029494.XA patent/CN104335142B/zh active Active

- 2013-05-17 WO PCT/US2013/041647 patent/WO2013188054A1/en active Application Filing

- 2013-05-17 IN IN2353MUN2014 patent/IN2014MN02353A/en unknown

- 2013-05-17 JP JP2015517269A patent/JP6039801B2/ja not_active Expired - Fee Related

- 2013-05-17 KR KR1020157000625A patent/KR101845217B1/ko active IP Right Grant

- 2013-05-17 EP EP17156084.0A patent/EP3185107A1/en not_active Ceased

- 2013-05-17 KR KR1020167028028A patent/KR20160120810A/ko not_active Application Discontinuation

- 2013-05-17 BR BR112014030606A patent/BR112014030606A8/pt active Search and Examination

-

2016

- 2016-05-26 US US15/165,222 patent/US9547374B2/en active Active

- 2016-08-15 JP JP2016159144A patent/JP2016197461A/ja active Pending

-

2018

- 2018-07-04 JP JP2018127405A patent/JP2018165994A/ja active Pending

Also Published As

| Publication number | Publication date |

|---|---|

| JP2016197461A (ja) | 2016-11-24 |

| JP2015519673A (ja) | 2015-07-09 |

| KR20150023702A (ko) | 2015-03-05 |

| CN104335142B (zh) | 2018-04-03 |

| KR101845217B1 (ko) | 2018-04-04 |

| EP3185107A1 (en) | 2017-06-28 |

| US9547374B2 (en) | 2017-01-17 |

| EP2862042B1 (en) | 2017-03-29 |

| CN104335142A (zh) | 2015-02-04 |

| BR112014030606A2 (pt) | 2017-06-27 |

| WO2013188054A1 (en) | 2013-12-19 |

| US20130335303A1 (en) | 2013-12-19 |

| JP6039801B2 (ja) | 2016-12-07 |

| BR112014030606A8 (pt) | 2021-05-25 |

| US9389420B2 (en) | 2016-07-12 |

| IN2014MN02353A (ko) | 2015-08-14 |

| US20160274671A1 (en) | 2016-09-22 |

| JP2018165994A (ja) | 2018-10-25 |

| EP2862042A1 (en) | 2015-04-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR101845217B1 (ko) | 투명 헤드 마운티드 디스플레이들에 대한 사용자 인터페이스 상호작용 | |

| US11262835B2 (en) | Human-body-gesture-based region and volume selection for HMD | |

| JP6674703B2 (ja) | ヘッドマウントディスプレイにおけるメニューナビゲーション | |

| US11099637B2 (en) | Dynamic adjustment of user interface | |

| CN108780360B (zh) | 虚拟现实导航 | |

| EP2959361B1 (en) | Context-aware augmented reality object commands | |

| US9977492B2 (en) | Mixed reality presentation | |

| US10133407B2 (en) | Display apparatus, display system, method for controlling display apparatus, and program | |

| US20180143693A1 (en) | Virtual object manipulation | |

| KR20160150565A (ko) | 헤드 마운트 디스플레이를 위한 3차원 사용자 인터페이스 | |

| US20130155108A1 (en) | Augmented Reality User Interaction Methods, Computing Devices, And Articles Of Manufacture | |

| AU2014302873A1 (en) | User interface navigation | |

| CN106796810B (zh) | 在用户界面上从视频选择帧 | |

| CN110546601A (zh) | 信息处理装置、信息处理方法和程序 | |

| US12032754B2 (en) | Information processing apparatus, information processing method, and non-transitory computer readable medium | |

| US20130201095A1 (en) | Presentation techniques |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A107 | Divisional application of patent | ||

| A201 | Request for examination | ||

| E902 | Notification of reason for refusal | ||

| E601 | Decision to refuse application |