KR20150126738A - 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 - Google Patents

화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 Download PDFInfo

- Publication number

- KR20150126738A KR20150126738A KR1020157031390A KR20157031390A KR20150126738A KR 20150126738 A KR20150126738 A KR 20150126738A KR 1020157031390 A KR1020157031390 A KR 1020157031390A KR 20157031390 A KR20157031390 A KR 20157031390A KR 20150126738 A KR20150126738 A KR 20150126738A

- Authority

- KR

- South Korea

- Prior art keywords

- quantization parameter

- block

- sub

- block quantization

- unit

- Prior art date

Links

- 238000000034 method Methods 0.000 title description 105

- 238000013139 quantization Methods 0.000 claims abstract description 677

- 238000004364 calculation method Methods 0.000 claims abstract description 27

- 230000008569 process Effects 0.000 description 74

- 238000010586 diagram Methods 0.000 description 22

- 230000006870 function Effects 0.000 description 19

- 230000009466 transformation Effects 0.000 description 16

- 238000004590 computer program Methods 0.000 description 15

- 230000008859 change Effects 0.000 description 14

- 238000000926 separation method Methods 0.000 description 13

- 238000006243 chemical reaction Methods 0.000 description 4

- 230000000694 effects Effects 0.000 description 4

- 230000001419 dependent effect Effects 0.000 description 2

- 230000004048 modification Effects 0.000 description 2

- 238000012986 modification Methods 0.000 description 2

- 238000005192 partition Methods 0.000 description 2

- 230000002093 peripheral effect Effects 0.000 description 2

- 230000008929 regeneration Effects 0.000 description 2

- 238000011069 regeneration method Methods 0.000 description 2

- 238000000638 solvent extraction Methods 0.000 description 2

- 230000002776 aggregation Effects 0.000 description 1

- 238000004220 aggregation Methods 0.000 description 1

- 238000003491 array Methods 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 238000005457 optimization Methods 0.000 description 1

- 230000001131 transforming effect Effects 0.000 description 1

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/50—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/44—Decoders specially adapted therefor, e.g. video decoders which are asymmetric with respect to the encoder

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/102—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or selection affected or controlled by the adaptive coding

- H04N19/124—Quantisation

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/134—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or criterion affecting or controlling the adaptive coding

- H04N19/167—Position within a video image, e.g. region of interest [ROI]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/169—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding

- H04N19/17—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding the unit being an image region, e.g. an object

- H04N19/176—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the coding unit, i.e. the structural portion or semantic portion of the video signal being the object or the subject of the adaptive coding the unit being an image region, e.g. an object the region being a block, e.g. a macroblock

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/42—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals characterised by implementation details or hardware specially adapted for video compression or decompression, e.g. dedicated software implementation

- H04N19/436—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals characterised by implementation details or hardware specially adapted for video compression or decompression, e.g. dedicated software implementation using parallelised computational arrangements

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/46—Embedding additional information in the video signal during the compression process

- H04N19/463—Embedding additional information in the video signal during the compression process by compressing encoding parameters before transmission

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/60—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using transform coding

- H04N19/61—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using transform coding in combination with predictive coding

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/90—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using coding techniques not provided for in groups H04N19/10-H04N19/85, e.g. fractals

- H04N19/91—Entropy coding, e.g. variable length coding [VLC] or arithmetic coding

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Computing Systems (AREA)

- Theoretical Computer Science (AREA)

- Compression Or Coding Systems Of Tv Signals (AREA)

- Compression, Expansion, Code Conversion, And Decoders (AREA)

Abstract

화상 처리 장치는, 양자화 제어를 받는 복수의 서브블록들로 입력 화상을 분할하도록 구성된 분할 유닛, 서브블록들 각각의 양자화 파라미터를 산출하도록 구성된 서브블록 양자화 파라미터 산출 유닛, 적어도 2개의 서브블록들을 포함하는 기초 블록을 설정하고 기초 블록의 양자화 파라미터를 산출하도록 구성된 기초 블록 양자화 파라미터 산출 유닛, 기초 블록의 양자화 파라미터 및 기초 블록에 포함된 각각의 서브블록의 양자화 파라미터 간의 차분값을 산출하도록 구성된 차분값 산출 유닛, 및 차분값을 코딩하도록 구성된 차분값 코딩 유닛을 포함한다.

Description

본 발명은 화상 코딩 장치, 화상 코딩 방법, 화상 코딩 프로그램, 화상 디코딩 장치, 화상 디코딩 방법, 및 화상 디코딩 프로그램에 관한 것이다. 특히, 본 발명은 화상의 양자화 파라미터들을 예측 코딩하는 방법에 관한 것이다.

동화상을 압축 및 기록하는 방법으로서, H.264/MEPG-4AVC(이후부터 H.264라고 함)가 공지되어 있다(ISO/IEC 14496-10;2004 Information technology(정보 기술) - 오디오-비주얼 객체들의 코딩(Coding of audio-visual obejcts) - Part 10: 어드밴스드 비디오 코딩(Advanced Video Coding)). H.264는 1-세그먼트 지상파 디지털 방송에 널리 사용된다.

H.264는 mb_qp_delta 코드를 사용해서 매크로블록 유닛들(16×16 픽셀들)의 양자화 파라미터들의 변경을 가능케 한다. 상술된 문서에서 논의된 공식 7-23은 상이한 값 mb_qp_delta를 최종 디코딩된 매크로블록의 양자화 파라미터 QPYPREV에 추가하여 매크로블록 유닛들(16×16 픽셀들)의 양자화 파라미터들을 변경한다.

최근에, 고효율 비디오 코딩(HEVC)을 국제적으로 표준화하기 위한 활동이 시작되었다. (HEVC는 H.264를 계승한 여전히 더 높은 효율의 코딩 방법이다.) 이 활동은, 스크린 크기의 증가에 따라, 종래의 매크로블록들(16×16 픽셀들)보다 더 많은 블록 크기들에 의한 분할을 생각한다. JCT-VC contribution JCTVC-A205.doc에 따라, 더 큰 크기를 가진 기초 블록을 최대 코딩 트리 블록(LCTB)이라고 한다. 고려 사항은 64×64 픽셀들의 크기를 전제로 한다(JCT-VC contribution JCTVC-A205.doc <http://wftp3.itu.int/av-arch/jctvc-site/2010_04_A_Dresden/>). LCTB는 복수의 서브블록들, 즉, 변형 및 양자화를 받는 코딩 트리 블록들(CTBs)로 더 분할된다. 분할 방법으로서, 영역 사분목 구조가 사용되어 블록을 4개의 서브블록들(수직으로 둘, 수평으로 둘)로 분할한다.

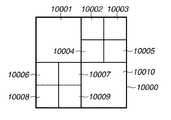

도 2a는 영역 사분목 구조를 도시한다. 굵은 프레임(10000)은 설명을 간략하게 하기 위해 64×64 픽셀들로 형성된 기초 블록을 나타낸다. 서브블록들 10001 및 10010 각각은 16×16 픽셀들로 형성된다. 서브블록들 10002 내지 10009 각각은 8×8 픽셀들로 형성된다. 서브블록들은 이러한 방법으로 형성되어 변형 및 다른 코딩 처리에 사용된다.

HEVC의 경우, 양자화 파라미터 제어가 H.264의 매크로블록들과 유사한 방법으로 기초 블록 단위로 실행된다고 생각된다. 그러나, 화상 품질의 관점에서 볼 때, 서브블록 단위로 양자화 파라미터 제어를 실행하는 것이 실제로 바람직하다. 이 경우에, 더 작은 유닛들의 양자화가 서브블록 단위로 양자화 파라미터 제어를 통해 실행될 것으로 예상된다.

그러나, 더 작은 유닛들의 양자화가 가능하더라도, 처리는 영역 사분목 구조 단위로 실행된다. 따라서, 서브블록 단위로 병렬 처리를 효율적으로 실행할 수 없어서, 코딩 및 디코딩 처리 속도의 향상이 불가능하다. 구체적으로, 도 2a를 참조하면, 서브블록 10001(16×16 픽셀들), 서브블록들 10002 내지 10009(8×8 픽셀들), 및 서브블록 10010(16×16 픽셀들)은 이 순서로 처리된다. 서브블록 양자화 파라미터들 각각이 예측 값으로서 선행 서브블록의 양자화 파라미터로부터의 차분값을 사용해서 산출되기에, 이 양자화 파라미터들은 연속 처리를 받을 필요가 있어서, 서브블록 단위의 효율적인 병렬 처리가 불가능하게 한다.

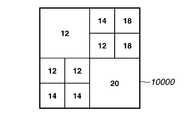

또한, 양자화 파라미터 최적화가 각각의 서브블록에 대해 시도될 때, 양자화 파라미터 차분값을 획득하기 위한 처리가 영역 사분목 구조 단위로 실행되기에, 차분값들은 변할 것이다. 예를 들어, 도 2b는 각각의 서브블록의 중심에 표시된 양자화 파라미터 값을 도시한다. 도 2b의 일례는 양자화 파라미터 값들이 상부 좌측으로부터 하부 우측으로 서서히 변하는 경우를 가정한다. 이 현상은 보통의 자연 화상들에서 나타날 것 같다. 서브블록 10001이 양자화 파라미터 12를 갖고 서브블록 10002가 양자화 파라미터 14를 가지기에, 서브블록 10002는 서브블록 10001로부터 +2라는 차분값을 가진다. 다음 차분값들은 +4, -6, +6, -6, +-0, +2, +4, 및 +2이다. 이러한 방법으로 영역 사분목 구조에 따라 차분값들을 획득하는 것은 차분값들을 무작위로 변동시켜서, 큰 코드들이 생성되는 문제점을 야기한다.

본 발명은 고속 처리뿐만 아니라 고효율 양자화 파라미터 코딩 및 디코딩을 달성하기 위해 각각의 서브블록의 코딩 및 디코딩이 동시에 실행될 수 있게 하는 것에 관한 것이다.

본 발명의 일 양상에 따라, 화상 코딩 장치는, 양자화 제어를 받는 복수의 서브블록들로 입력 화상을 분할하도록 구성된 분할 수단; 서브블록들 각각의 양자화 파라미터를 산출하도록 구성된 서브블록 양자화 파라미터 산출 수단; 2개 이상의 서브블록들을 포함하는 기초 블록을 설정하고 기초 블록의 양자화 파라미터를 산출하도록 구성된 기초 블록 양자화 파라미터 산출 수단; 기초 블록의 양자화 파라미터 및 기초 블록에 포함된 각각의 서브블록의 양자화 파라미터 간의 차분값을 산출하도록 구성된 차분값 산출 수단; 및 차분값을 코딩하도록 구성된 차분값 코딩 수단을 포함한다.

본 발명의 일례의 실시예에 따라, 서브블록 단위로 기초 블록 양자화 파라미터에 기초하여 각각의 서브블록 양자화 파라미터를 독립적으로 코딩 및 디코딩해서, 서브블록 단위로 병렬 처리를 용이하게 할 수 있다. 또한, 예측 오류를 억제하여, 고효율 양자화 파라미터 코딩 및 디코딩을 가능케 한다.

본 발명의 다른 특징들 및 양상들은 첨부 도면들을 참조해서 일례의 실시예들의 이하의 상세한 설명으로부터 명백해질 것이다.

본 명세서에 포함되고 본 명세서의 일부를 구성하는 첨부 도면들은 본 발명의 일례의 실시예들, 특징들, 및 양상들을 도시하고, 본 설명과 함께, 본 발명의 원리들을 설명하도록 돕는다.

도 1은 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치의 구성을 도시한 블록도이다.

도 2a는 일례의 블록 분할을 도시한다.

도 2b는 일례의 블록 분할을 도시한다.

도 3은 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치의 양자화 파라미터 코딩 유닛을 도시한 상세한 블록도이다.

도 4는 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다.

도 5a는 코딩 시의 병렬 처리를 도시한다.

도 5b는 코딩 시의 병렬 처리를 도시한다.

도 6은 본 발명의 제2 일례의 실시예에 따른 화상 디코딩 장치의 구성을 도시한 블록도이다.

도 7은 본 발명의 제2 일례의 실시예에 따른 양자화 파라미터 디코딩 유닛을 도시한 상세한 블록도이다.

도 8은 본 발명의 제2 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리를 도시한 흐름도이다.

도 9a는 디코딩의 병렬 처리를 도시한다.

도 9b는 디코딩의 병렬 처리를 도시한다.

도 10은 본 발명의 제3 일례의 실시예에 따른 화상 코딩 장치의 구성을 도시한 블록도이다.

도 11은 본 발명의 제3 일례의 실시예에 따른 화상 코딩 장치의 양자화 파라미터 코딩 유닛을 도시한 상세한 블록도이다.

도 12는 본 발명의 제3 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다.

도 13은 본 발명의 제4 일례의 실시예에 따른 화상 디코딩 장치의 구성을 도시한 블록도이다.

도 14는 본 발명의 제4 일례의 실시예에 따른 화상 디코딩 장치의 양자화 파라미터 디코딩 유닛을 도시한 상세한 블록도이다.

도 15는 본 발명의 제4 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리를 도시한 흐름도이다.

도 16 본 발명의 제5 일례의 실시예에 따른 화상 코딩 장치의 양자화 파라미터 코딩 유닛을 도시한 상세한 블록도이다.

도 17은 본 발명의 제5 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다.

도 18은 본 발명의 제6 일례의 실시예에 따른 화상 디코딩 장치의 양자화 파라미터 디코딩 유닛을 도시한 상세한 블록도이다.

도 19는 본 발명의 제6 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리를 도시한 흐름도이다.

도 20은 본 발명의 일례의 실시예들에 따른 화상 코딩 장치 및 화상 디코딩 장치에 적용되는 컴퓨터의 일례의 하드웨어 구성을 도시한 블록도이다.

도 1은 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치의 구성을 도시한 블록도이다.

도 2a는 일례의 블록 분할을 도시한다.

도 2b는 일례의 블록 분할을 도시한다.

도 3은 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치의 양자화 파라미터 코딩 유닛을 도시한 상세한 블록도이다.

도 4는 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다.

도 5a는 코딩 시의 병렬 처리를 도시한다.

도 5b는 코딩 시의 병렬 처리를 도시한다.

도 6은 본 발명의 제2 일례의 실시예에 따른 화상 디코딩 장치의 구성을 도시한 블록도이다.

도 7은 본 발명의 제2 일례의 실시예에 따른 양자화 파라미터 디코딩 유닛을 도시한 상세한 블록도이다.

도 8은 본 발명의 제2 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리를 도시한 흐름도이다.

도 9a는 디코딩의 병렬 처리를 도시한다.

도 9b는 디코딩의 병렬 처리를 도시한다.

도 10은 본 발명의 제3 일례의 실시예에 따른 화상 코딩 장치의 구성을 도시한 블록도이다.

도 11은 본 발명의 제3 일례의 실시예에 따른 화상 코딩 장치의 양자화 파라미터 코딩 유닛을 도시한 상세한 블록도이다.

도 12는 본 발명의 제3 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다.

도 13은 본 발명의 제4 일례의 실시예에 따른 화상 디코딩 장치의 구성을 도시한 블록도이다.

도 14는 본 발명의 제4 일례의 실시예에 따른 화상 디코딩 장치의 양자화 파라미터 디코딩 유닛을 도시한 상세한 블록도이다.

도 15는 본 발명의 제4 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리를 도시한 흐름도이다.

도 16 본 발명의 제5 일례의 실시예에 따른 화상 코딩 장치의 양자화 파라미터 코딩 유닛을 도시한 상세한 블록도이다.

도 17은 본 발명의 제5 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다.

도 18은 본 발명의 제6 일례의 실시예에 따른 화상 디코딩 장치의 양자화 파라미터 디코딩 유닛을 도시한 상세한 블록도이다.

도 19는 본 발명의 제6 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리를 도시한 흐름도이다.

도 20은 본 발명의 일례의 실시예들에 따른 화상 코딩 장치 및 화상 디코딩 장치에 적용되는 컴퓨터의 일례의 하드웨어 구성을 도시한 블록도이다.

본 발명의 각종 일례의 실시예들, 특징들, 및 양상들은 도면들을 참조해서 상세히 후술될 것이다.

도 1은 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치를 도시한 블록도이다. 도 1을 참조하면, 화상 코딩 장치는 단자(1000)로부터 화상 데이터를 입력한다.

블록 분할 유닛(1001)은 입력 화상을 복수의 기초 블록들로 분할하고, 즉, 복수의 회수로 입력 화상으로부터 기초 블록을 클리핑하고, 필요한 경우, 각각의 기초 블록을 복수의 서브블록들로 더 분할한다. 화상 코딩 장치는 서브블록 단위로 양자화 제어를 실행한다. 설명을 간략하게 하기 위해 입력 화상이 8-비트 픽셀 값들을 가진다고 가정되더라도, 픽셀 값은 그렇게 제한되지는 않는다. 기초 블록의 크기는 64×64 픽셀들이고, 서브블록의 최소 크기는 8×8 픽셀들이다. 이 경우에, 기초 블록은 4개의 서브블록들을 포함한다. 블록 분할이 한 블록을 4개의 서브블록들(수직으로 둘, 수평으로 둘)로 분할하는 방법에 기초하여 후술될 것이지만, 블록들의 형태 및 크기는 그렇게 제한되지는 않는다. 기초 블록은 적어도 2개의 서브블록들을 포함할 필요가 있다. 서브블록 분할은 임의의 특정 방법으로 제한되지 않는다. 예를 들어, 전체 화상은 에지량 산출 및 클러스터링 후에 복수의 서브블록들로 분할될 수 있다. 구체적으로, 작은 서브블록들은 다수의 에지들이 있는 부분에 배치되고, 큰 서브블록들은 평평한 부분에 배치된다. 양자화 파라미터 결정 유닛(1002)은 각각의 기초 블록의 양자화 파라미터 및 각각의 서브블록의 양자화 파라미터를 결정한다.

블록 예측 유닛(1003)은 각각의 서브블록에 대한 예측 오류를 산출하기 위해 블록 분할 유닛(1001)에 의해 형성된 서브블록 단위로 예측을 실행한다. 블록 예측 유닛(1003)은 정지 화상 및 동화상의 인트라-프레임들에 인트라-예측을 적용하고, 동화상에 움직임 보상 예측을 또한 적용한다. 블록 변환 유닛(1004)은 각각의 서브블록에 대한 예측 오류에 직교 변환을 적용하여 직교 변환 계수를 산출한다. 직교 변환은 임의의 특정 방법으로 제한되지 않으며, 이산 코사인 변환 및 아다마르 변환에 기초할 수 있다. 블록 양자화 유닛(1005)은 양자화 파라미터 결정 유닛(1002)에 의해 결정된 각각의 서브블록 양자화 파라미터에 기초하여 상술된 직교 변환 계수를 양자화한다. 이 양자화는 양자화 계수의 획득을 가능케 한다. 블록 코딩 유닛(1006)은 양자화 계수 코드 데이터를 생성하기 위해 이러한 방법으로 획득된 각각의 서브블록에 대한 양자화 계수에 가변-길이 코딩을 적용한다. 코딩은 임의의 특정 방법으로 제한되지 않으며, 허프만 코드 또는 산술 코드에 기초할 수 있다. 블록 재생 화상 생성 유닛(1007)은 블록 예측 유닛(1003)에 의한 처리의 결과에 기초하여 기초 블록의 디코딩된 화상을 생성하기 위해 블록 양자화 유닛(1005) 및 블록 변환 유닛(1004)의 역 동작을 실행함으로써 예측 오류를 재생한다. 재생된 화상 데이터는 저장되어, 블록 예측 유닛(1003)에 의한 예측에 사용된다.

양자화 파라미터 코딩 유닛(1008)은 양자화 파라미터 코드 데이터를 생성하기 위해 양자화 파라미터 결정 유닛(1002)에 의해 결정된 기초 블록 양자화 파라미터 및 각각의 서브블록 양자화 파라미터를 인코딩한다.

통합 및 코딩 유닛(1009)은 헤더 정보를 생성하고 예측과 관련해서 인코딩하며, 양자화 파라미터 코딩 유닛(1008)에 의해 생성된 양자화 파라미터 코드 데이터 및 블록 코딩 유닛(1006)에 의해 생성된 양자화 계수 코드 데이터를 통합한다. 통합 및 코딩 유닛(1009)은 생성된 비트스트림을 단자(1010)를 통해 밖으로 출력한다.

본 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리가 후술될 것이다. 본 일례의 실시예에서, 동화상 데이터가 프레임 유닛들로 입력되더라도, 한 프레임에 대한 정지 화상 데이터가 입력될 수도 있다.

블록 분할 유닛(1001)은 단자(1000)로부터 한 프레임에 대한 화상 데이터를 입력하고, 화상 데이터를 복수의 기초 블록들로 분할하며, 각각의 기초 블록은 64×64 픽셀들로 형성된다. 필요한 경우, 블록 분할 유닛(1001)은 각각의 기초 블록을 복수의 서브블록들로 더 분할하며, 각각의 서브블록은 적어도 8×8 픽셀들로 형성된다. 양자화 파라미터 결정 유닛(1002) 및 블록 예측 유닛(1003)은 서브블록들로의 분할에 대한 정보 및 분할된 화상 데이터를 입력한다.

블록 예측 유닛(1003)은 블록 재생 화상 생성 유닛(1007)에 저장된 재생 화상과 관련된 예측을 실행하고, 예측 오류를 생성하며, 생성된 예측 오류를 블록 변환 유닛(1004) 및 블록 재생 화상 생성 유닛(1007)에 출력한다. 블록 변환 유닛(1004)은 입력 예측 오류에 직교 변환을 적용하고, 직교 변환 계수를 산출하며, 산출된 직교 변환 계수를 블록 양자화 유닛(1005)에 출력한다.

각각의 서브블록에서 발생하는 입력 코드들의 양을 고러하여, 양자화 파라미터 결정 유닛(1002)은 서브블록 단위로 화상 품질 및 코드들의 양 간의 균형에 기초하여 최적 양자화 파라미터를 결정한다. 예를 들어, 일본 특허 출원 공보 제4-323961호에 기술된 기술이 사용될 수 있다. 양자화 파라미터 결정 유닛(1002)은 결정된 서브블록 양자화 파라미터들 각각을 블록 양자화 유닛(1005), 블록 재생 화상 생성 유닛(1007), 및 양자화 파라미터 코딩 유닛(1008)에 출력한다.

블록 양자화 유닛(1005)은 양자화 파라미터 결정 유닛(1002)에 의해 결정된 각각의 양자화 파라미터에 기초하여 (블록 변환 유닛(1004)으로부터의 입력된) 직교 변환 계수를 양자화하여 양자화 계수를 생성한다. 블록 양자화 유닛(1005)은 생성된 양자화 계수를 블록 코딩 유닛(1006) 및 블록 재생 화상 생성 유닛(1007)에 출력한다. 블록 재생 화상 생성 유닛(1007)은 양자화 계수를 입력하고, 양자화 파라미터 결정 유닛(1002)에 의해 결정된 각각의 양자화 파라미터에 기초하여 직교 변환 계수를 재생한다. 블록 재생 화상 생성 유닛(1007)은 재생된 직교 변환 계수에 역 직교 변환을 적용하여 예측 오류를 재생하고, 재생된 예측 오류 및 예측 시와 관련된 픽셀 값에 기초하여 재생된 화상을 생성하며, 재생된 화상을 저장한다. 블록 코딩 유닛(1006)은 양자화 계수를 인코딩하여 양자화 계수 코드 데이터를 생성하고, 생성된 양자화 계수 코드 데이터를 통합 및 코딩 유닛(1009)에 출력한다.

양자화 파라미터 코딩 유닛(1008)은 양자화 파라미터 결정 유닛(1002)에 의해 결정된 양자화 파라미터들을 기초 블록 단위로 인코딩한다.

도 3은 양자화 파라미터 코딩 유닛(1008)을 도시한 상세한 블록도이다. 도 3을 참조하면, 양자화 파라미터 코딩 유닛(1008)은 단자(1)를 통해 도 1의 양자화 파라미터 결정 유닛(1002)으로부터의 각각의 서브블록 양자화 파라미터를 입력한다. 양자화 파라미터 저장 유닛(2)은 입력 서브블록 양자화 파라미터들을 한번 저장한다. 기초 블록 양자화 파라미터 결정 유닛(3)은 양자화 파라미터 저장 유닛(2)에 저장된 각각의 서브블록 양자화 파라미터에 기초하여 기초 블록 양자화 파라미터를 결정한다. 기초 블록 양자화 파라미터 코딩 유닛(4)은 기초 블록 양자화 파라미터를 인코딩하여 기초 블록 양자화 파라미터 코드를 생성한다. 기초 블록 양자화 파라미터 코딩 유닛(4)은 도 1의 통합 및 코딩 유닛(1009)에 생성된 기초 블록 양자화 파라미터 코드를 단자(5)를 통해 출력한다. 서브블록 양자화 파라미터 차분 유닛(6)은 기초 블록 양자화 파라미터 및 각각의 서브블록 양자화 파라미터 간의 차분을 획득한다. 서브블록 양자화 파라미터 코딩 유닛(7)은 차분을 인코딩하여 서브블록 양자화 파라미터 차분값 코드를 생성한다. 서브블록 양자화 파라미터 코딩 유닛(7)은 단자(8)를 통해 생성된 서브블록 양자화 파라미터 차분값 코드를 도 1의 통합 및 코딩 유닛(1009)에 출력한다.

상술된 구성에 따라, 양자화 파라미터 저장 유닛(2)은 기초 블록 단위로 단자(1)로부터 입력된 서브블록 양자화 파라미터들을 저장한다. 모든 서브블록 양자화 파라미터들이 양자화 파라미터 저장 유닛(2)에 저장될 때, 기초 블록 양자화 파라미터 결정 유닛(3)은 기초 블록 양자화 파라미터를 산출한다. 본 일례의 실시예에 따라, 기초 블록 양자화 파라미터 결정 유닛(3)은 서브블록 양자화 파라미터들의 평균을 산출한다. 도 2b를 참조하면, 평균은 14.6이다. 양자화 파라미터 코딩이 정수 단위로 실행될 때, 기초 블록 양자화 파라미터 결정 유닛(3)은 평균 14.6을 반올림해서, 기초 블록 양자화 파라미터를 15로 설정한다. 기초 블록 양자화 파라미터 결정 유닛(3)은 결정된 기초 블록 양자화 파라미터를 기초 블록 양자화 파라미터 코딩 유닛(4) 및 서브블록 양자화 파라미터 차분 유닛(6)에 출력한다. 기초 블록 양자화 파라미터 코딩 유닛(4)은 콜롱 코딩을 통해 입력 기초 블록 양자화 파라미터를 인코딩하여 기초 블록 양자화 파라미터 코드를 생성하고, 생성된 기초 블록 양자화 파라미터 코드를 단자(5)를 통해 밖으로 출력한다.

서브블록 양자화 파라미터 차분 유닛(6)은 각각의 서브블록 양자화 파라미터 및 기초 블록 양자화 파라미터 간의 차분을 산출한다. 도 2b를 참조하면, 차분값들은 영역 사분목 구조 순으로 -3, -1, +3, -3, +3, -3, -3, -1, -1, 및 +5이다. 서브블록 양자화 파라미터 차분 유닛(6)은 서브블록 양자화 파라미터 코딩 유닛(7)에 이 차분값들을 출력한다. 서브블록 양자화 파라미터 코딩 유닛(7)은 변경의 존재 또는 부재와 함께 이 차분값들을 인코딩한다. 제1 서브블록 10001의 양자화 파라미터는 기초 블록 양자화 파라미터 또는 15와 상이하다. 서브블록 양자화 파라미터 코딩 유닛(7)은 변경을 나타내는 1-비트 값 "1" 및 차분값 "-3"을 콜롱 코딩을 통해 인코딩하고, 결과 코드를 서브블록 양자화 파라미터 차분값 코딩 데이터로서 단자(8)를 통해 밖으로 출력한다. 그 후, 서브블록 양자화 파라미터 코딩 유닛(7)은 제2 서브블록 10002의 서브블록 양자화 파라미터 차분값을 인코딩한다. 이 차분값이 기초 블록 양자화 파라미터와 상이하기 때문에, 서브블록 양자화 파라미터 코딩 유닛(7)은 변경을 나타내는 1-비트 값 "1" 및 서브블록 양자화 파라미터 차분값 "-1"로 구성된 콜롱 코드를 단자(8)를 통해 밖으로 출력한다. 이어서, 상술된 바와 유사한 방법으로, 서브블록 양자화 파라미터 코딩 유닛(7)은 변경을 나타내는 1-비트 값 "1" 및 서브블록 양자화 파라미터 차분값을 인코딩하여 서브블록 양자화 파라미터 차분값 코딩 데이터를 생성한다.

도 1을 다시 참조하면, 통합 및 코딩 유닛(1009)은 화상 시퀀스, 프레임 헤더, 및 다른 코드들을 생성한다. 각각의 기초 블록에 대해, 통합 및 코딩 유닛(1009)은 블록 예측 유닛(1003)으로부터 예측 모드 등의 정보를 획득하고, 정보를 인코딩한다. 그 후, 통합 및 코딩 유닛(1009)은 양자화 파라미터 코딩 유닛(1008)으로부터 기초 블록 양자화 파라미터 코드를 입력한다. 그 후, 통합 및 코딩 유닛(1009)은 각각의 서브블록에 대한 서브블록 양자화 파라미터 차분값 코딩 데이터 및 양자화 계수 코드 데이터를 통합하고, 통합된 데이터를 비트스트림으로서 단자(1010)를 통해 밖으로 출력한다.

도 4는 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다. 단계 S001에서, 통합 및 코딩 유닛(1009)은 시퀀스, 프레임 헤더, 및 다른 코드들을 생성하고, 생성된 코드들을 단자(1010)를 통해 밖으로 출력한다.

단계 S002에서, 블록 분할 유닛(1001)은 상부 좌측 코너에서 시작해서 입력 화상으로부터 각각의 기초 블록을 순차적으로 클리핑한다.

단계 S003에서, 블록 분할 유닛(1001)은 각각의 기초 블록을 복수의 서브블록들로 더 분할한다.

단계 S004에서, 양자화 파라미터 결정 유닛(1002)은 서브블록 양자화 파라미터들을 결정한다. 단계 S005에서, 화상 코딩 장치는 단계 S004에서 결정된 서브블록 양자화 파라미터들에 기초하여 기초 블록 양자화 파라미터를 결정한다. 설명을 간략하게 하기 위해, 본 일례의 실시예에 따른 화상 코딩 장치는 기초 블록 양자화 파라미터로서 기초 블록의 서브블록들의 양자화 파라미터들의 평균을 산출한다.

단계 S006에서, 화상 코딩 장치는 콜롱 코딩을 통해 (단계 S005에서 결정된) 기초 블록 양자화 파라미터를 인코딩하고, 결과 코드를 기초 블록 양자화 파라미터 코드로서 출력한다.

단계 S007에서, 화상 코딩 장치는 서브블록 단위로 서브블록 양자화 파라미터를 인코딩한다. 영역 사분목 구조의 순으로 기초 블록 양자화 파라미터와 동일한 양자화 파라미터를 사용할 때, 화상 코딩 장치는 1-비트 코드 "0"을 출력한다. 상이한 양자화 파라미터를 사용할 때, 화상 코딩 장치는 1-비트 코드 "1" 및 각각의 서브블록 양자화 파라미터 및 기초 블록 양자화 파라미터 간의 차분을 출력한다.

단계 S008에서, 화상 코딩 장치는 서브블록 화상 데이터에 대한 예측을 실행하여 예측 오류를 획득하고, 직교 변환 및 양자화를 예측 오류에 적용하며, 획득된 양자화 계수를 인코딩하고, 양자화 계수 코드 데이터를 출력한다.

단계 S009에서, 화상 코딩 장치는 획득된 양자화 계수에 역 양자화 및 역변환을 적용하여, 예측 오류를 산출한다. 화상 코딩 장치는 예측 오류 및 재생 화상으로부터 획득된 예측 값에 기초하여 관련 서브블록의 재생 화상을 생성한다.

단계 S010에서, 화상 코딩 장치는 기초 블록의 모든 서브블록들에 대해 코딩 처리가 완료되었는 지를 결정한다. 코딩 처리가 모든 서브블록들에 대해 완료될 때(단계 S010에서 예), 처리는 단계 S011로 진행한다. 그렇지 않으면, 코딩 처리가 모든 서브블록들에 대해 완료되지 않았을 때(단계 S010에서 아니오), 처리는 단계 S007로 복귀하여 그 다음 서브블록을 처리한다.

단계 S011에서, 화상 코딩 장치는 모든 기초 블록들에 대해 코딩 처리가 완료되었는 지를 결정한다. 코딩 처리가 모든 기초 블록들에 대해 완료되었을 때(단계 S011에서 예), 처리는 종료한다. 그렇지 않으면, 코딩 처리가 모든 기초 블록들에 대해 완료되지 않았을 때(단계 S011에서 아니오), 처리는 단계 S002로 복귀하여 그 다음 기초 블록을 처리한다.

특히 단계들 S005 내지 S009에서, 상술된 구성 및 동작들은 기초 블록 양자화 파라미터를 사용해서 각각의 서브블록 양자화 파라미터 차분값의 코딩을 가능케 해서, 생성된 코드들의 양을 억제한다.

본 일례의 실시예에서, 서브블록 양자화 파라미터들의 평균이 있는 그대로 기초 블록 양자화 파라미터로서 사용되더라도, 기초 블록 양자화 파라미터는 그렇게 제한되지는 않으며, 평균에 가장 가까운 실제 서브블록 양자화 파라미터 값일 수 있다. 예를 들어, 평균이 도 2b의 일례에서 14.6이면, 평균에 가장 가까운 실제 서브블록 양자화 파라미터 값, 즉, 14가 평균을 반올림함으로써 획득된 값 대신 사용될 수 있다. 이러한 방법으로 서브블록 양자화 파라미터를 획득하여, 변경을 나타내는 코드를 "0"으로 설정하는 것이 가능해지며, 송신될 서브블록 양자화 파라미터 차분값들의 수를 감소시킨다.

상술된 구성은 예측, 양자화, 변환, 및 코딩을 동시에 효율적으로 실행하는 것을 더 가능케 하여, 고속 처리를 달성한다.

도 5a는 및 도 5b는 양자화, 변환, 및 코딩 처리를 도 2a에 도시된 기초 블록 10000의 서브블록들 10001 내지 10005에 적용하기 위한 일례의 병렬 처리를 도시한다. 이 경우에, 설명을 간략하게 하기 위해, 3개의 프로세서들이 코딩 처리에 사용된다고 가정된다. 프로세서들 A 및 C는 각각의 서브블록 양자화 파라미터(QP)를 산출하고, 각각의 서브블록 양자화 파라미터 차분값(.delta.QP)을 산출 및 코딩하며, 직교 변환 및 양자화를 예측 오류에 적용하고, 양자화 계수를 코딩한다. 이 경우에, 이 코드들은 다른 프로세서에 의해 통합된다.

도 5a는 일례의 종래의 병렬 처리를 도시한다. 우선, 화상 코딩 장치는 프로세서 A에 서브블록 10001의 처리를 할당하고, 프로세서 B에 서브블록 10002의 처리를 할당하며, 프로세서 C에 서브블록 10003의 처리를 할당한다. QP 산출을 위한 처리 시간은 블록 크기 및 화상 복잡성에 좌우된다. 더 큰 블록 크기를 가진 서브블록 10001의 양자화 파라미터 산출이 서브블록들 10002 및 10003의 양자화 파라미터 산출보다 더 긴 시간이 걸리는 경향이 있다.

양자화 파라미터 산출에 이어서, 화상 코딩 장치는 양자화 파라미터 차분값들을 산출한다. 서브블록 10001에 대한 서브블록 양자화 파라미터 산출은 서브블록 10002에 대한 서브블록 양자화 파라미터 차분값 산출을 시작하기 위해 완료될 필요가 있다. 이는 프로세서 A가 서브블록 10001에 대한 서브블록 양자화 파라미터 산출을 완료할 때까지 프로세서 B가 대기함을 의미한다. 서브블록 10003의 양자화 파라미터를 산출하는 것보다 서브블록 10002의 양자화 파라미터를 산출하는데 더 긴 시간이 걸리면, 서브블록 10002에 대한 서브블록 양자화 파라미터 산출은 서브블록 10003에 대한 서브블록 양자화 파라미터 차분값 산출을 시작하기 위해 완료될 필요가 있다. 프로세서 B가 서브블록 10002에 대한 서브블록 양자화 파라미터 산출을 완료할 때까지 프로세서 C는 대기한다.

도 5b는 본 일례의 실시예에 따른 일례의 병렬 처리를 도시한다. 종래의 경우와 유사하게, 화상 코딩 장치는 프로세서 A에 서브블록 10001의 처리를 할당하고, 프로세서 B에 서브블록 10002의 처리를 할당하며, 프로세서 C에 서브블록 10003의 처리를 할당한다. 서브블록 양자화 파라미터 산출에 이어서, 화상 코딩 장치는 서브블록 양자화 파라미터 차분값들을 산출한다. 기초 블록 양자화 파라미터 산출이 완료된 이후에, 서브블록 10002에 대한 서브블록 양자화 파라미터 차분값 산출이 서브블록 양자화 파라미터 산출 직후에 시작될 수 있다. 따라서, 본 발명은 효율적인 병렬 처리를 달성한다. 특히, 복수의 크기들을 가진 서브블록들이 존재할 때, 본 발명은 처리 간격을 감소시키는 엄청난 효과를 제공한다.

본 일례의 실시예에서, 기초 블록 양자화 파라미터 값 자체가 코딩되더라도, 예측은 이전에 처리된 기초 블록 양자화 파라미터를 사용해서 실행될 수 있다.

본 일례의 실시예에서, 기초 블록이 64×64 픽셀들로 형성되고, 서브블록이 8×8 픽셀들로 형성되더라도, 픽셀 구성은 그렇게 제한되지는 않는다. 예를 들어, 기초 블록의 블록 크기는 128×128 픽셀들로 변경될 수 있다. 기초 블록 및 서브블록의 형태는 정사각형으로 제한되지 않으며, 8×4 픽셀들 등의 사각형일 수도 있다. 본 발명의 본질은 여전히 변경되지 않는다.

본 일례의 실시예에서, 서브블록 양자화 파라미터들의 평균이 기초 블록 양자화 파라미터로서 생각되더라도, 기초 블록 양자화 파라미터는 그렇게 제한되지는 않는다. 물론, 예를 들어, 기초 블록 양자화 파라미터가 서브블록 양자화 파라미터들의 중간값, 또는 가장 빈번한 서브블록 양자화 파라미터 값일 수 있음이 가능하다. 물론, 이러한 방법으로 복수의 산출 방법들을 예비하고, 가장 효율적인 기초 블록 양자화 파라미터를 선택할 수 있다.

변경을 나타내는 1-비트 코드가 서브블록 양자화 파라미터 차분값 코딩 데이터에 제공되더라도, 처리는 그렇게 제한되지는 않는다. 물론, 변경이 없더라도 서브블록 양자화 파라미터 차분값을 인코딩할 수 있다.

본 일례의 실시예에서, 기초 블록 양자화 파라미터, 서브블록 양자화 파라미터 차분값, 및 양자화 계수를 인코딩하는데 콜롱 코딩이 사용되더라도, 처리는 그렇게 제한되지는 않는다. 물론, 예를 들어, 허프만 코딩 및 다른 산술 코딩 방법들을 사용하고, 코딩 없이 있는 그대로 상술된 값들을 출력할 수 있다.

본 일례의 실시예가 구체적으로 인트라-예측을 사용해서 프레임들에 기초하여 기술되었지만, 본 일례의 실시예는 예측시 움직임 보상을 수반하는 인터-예측을 사용할 수 있는 프레임들에도 또한 적용될 수 있음이 명백하다.

본 발명의 제2 일례의 실시예가 본 발명의 제1 일례의 실시예에 따른 코딩 방법을 사용해서 코딩된 코드 데이터를 디코딩하기 위한 화상 디코딩 방법에 기초하여 후술될 것이다. 도 6은 본 발명의 제2 일례의 실시예에 따른 화상 디코딩 장치의 구성을 도시한 블록도이다.

화상 디코딩 장치는 단자(1100)로부터 코딩된 비트스트림을 입력한다. 디코딩 및 분리 유닛(1101)은 비트스트림의 헤더 정보를 디코딩하고, 비트스트림으로부터 요구된 코드들을 분리하며, 분리된 코드들을 다음 스테이지에 출력한다. 디코딩 및 분리 유닛(1101)은 도 1의 통합 및 코딩 유닛(1009)의 역 동작을 실행한다. 양자화 파라미터 디코딩 유닛(1102)은 양자화 파라미터 코딩 데이터를 디코딩한다. 블록 디코딩 유닛(1103)은 각각의 서브블록 양자화 계수 코드를 디코딩하여 양자화 계수를 재생한다. 블록 역 양자화 유닛(1104)은 양자화 파라미터 디코딩 유닛(1102)에 의해 재생된 서브블록 양자화 파라미터에 기초하여 양자화 계수에 역 양자화를 적용하여 직교 변환 계수를 재생한다. 블록 역변환 유닛(1105)은 도 1의 블록 변환 유닛(1004)의 역 직교 변환을 실행하여 예측 오류를 재생한다. 블록 재생 유닛(1106)은 예측 오류 및 디코딩 화상 데이터에 기초하여 서브블록 화상 데이터를 재생한다. 블록 결합 유닛(1107)은 재생된 서브블록 화상 데이터를 각각의 위치들에 배열하여 기초 블록 화상 데이터를 재생한다.

본 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리가 후술될 것이다. 제2 일례의 실시예에서, 제1 일례의 실시예에 따른 화상 코딩 장치에 의해 생성된 동화상 비트스트림이 프레임 유닛들로 입력되더라도, 1 프레임에 대한 정지 화상 비트스트림이 입력될 수 있다.

도 6을 참조하면, 디코딩 및 분리 유닛(1101)은 단자(1100)로부터 한 프레임에 대한 스트림 데이터를 입력하고, 화상을 재생하는데 필요한 헤더 정보를 디코딩한다. 그 후, 디코딩 및 분리 유닛(1101)은 양자화 파라미터 디코딩 유닛(1102)에 기초 블록 양자화 파라미터 코드를 출력한다. 그 후, 디코딩 및 분리 유닛(1101)은 서브블록 양자화 파라미터 차분값 코드를 양자화 파라미터 디코딩 유닛(1102)에 또한 출력한다.

도 7은 양자화 파라미터 디코딩 유닛(1102)을 도시한 상세한 블록도이다. 양자화 파라미터 디코딩 유닛(1102)은 도 6의 디코딩 및 분리 유닛(1101)으로부터 기초 블록 양자화 파라미터 코드를 단자(101)를 통해 입력한다. 양자화 파라미터 디코딩 유닛(1102)은 도 6의 디코딩 및 분리 유닛(1101)으로부터 서브블록 양자화 파라미터 차분 코딩 데이터를 단자(102)를 통해 입력한다. 기초 블록 양자화 파라미터 디코딩 유닛(103)은 기초 블록 양자화 파라미터 코드를 입력하고, 기초 블록 양자화 파라미터 코드를 디코딩하여, 기초 블록 양자화 파라미터를 재생한다. 서브블록 양자화 파라미터 디코딩 유닛(104)은 서브블록 양자화 파라미터 차분값 코딩 데이터를 디코딩하여, 각각의 서브블록 양자화 파라미터 차분값을 재생한다. 서브블록 양자화 파라미터 추가 유닛(105)은 재생된 기초 블록 양자화 파라미터 및 각각의 서브블록 양자화 파라미터 차분값을 추가하여, 각각의 서브블록 양자화 파라미터를 재생한다. 서브블록 양자화 파라미터 추가 유닛(105)은 단자(106)를 통해 각각의 재생된 서브블록 양자화 파라미터를 도 6의 블록 역 양자화 유닛(1104)에 출력한다.

기초 블록 양자화 파라미터 디코딩 유닛(103)은 단자(101)로부터 기초 블록 양자화 파라미터 코드를 입력하고, 콜롱 코드를 사용해서 기초 블록 양자화 파라미터 코드를 디코딩하여 기초 블록 양자화 파라미터를 재생하며, 결과 코드를 저장한다.

서브블록 양자화 파라미터 디코딩 유닛(104)은 단자(102)로부터 서브블록 양자화 파라미터 차분값 코딩 데이터를 입력하고, 콜롱 코드를 사용해서 서브블록 양자화 파라미터 차분값 코딩 데이터를 디코딩하여 서브블록 양자화 파라미터 차분값을 재생한다. 구체적으로 서브블록 양자화 파라미터 디코딩 유닛(104)은 기초 블록 양자화 파라미터에 대한 변경의 존재 또는 실재를 나타내는 1-비트 코드를 디코딩한다. 변경이 없을 때, 서브블록 양자화 파라미터 디코딩 유닛(104)은 서브블록 양자화 파라미터 차분값으로서 0을 서브블록 양자화 파라미터 추가 유닛(105)에 출력한다. 변경이 있을 때, 서브블록 양자화 파라미터 디코딩 유닛(104)은 이어서 서브블록 양자화 파라미터 차분값을 디코딩하고, 결과 값을 서브블록 양자화 파라미터 추가 유닛(105)에 출력한다. 서브블록 양자화 파라미터 추가 유닛(105)은 재생된 기초 블록 양자화 파라미터에 서브블록 양자화 파라미터 차분값을 추가하여 서브블록 양자화 파라미터를 재생하고, 재생된 서브블록 양자화 파라미터를 단자(106)를 통해 밖으로 출력한다.

도 6을 다시 참조하면, 블록 디코딩 유닛(1103)은 디코딩 및 분리 유닛(1101)에 의해 비트스트림으로부터 분리된 서브블록 양자화 계수 코드 데이터를 입력하고, 콜롱 코드를 사용해서 입력 서브블록 양자화 계수 코드 데이터를 디코딩하여 각각의 서브블록 양자화 계수를 재생하며, 재생된 서브블록 양자화 계수를 블록 역 양자화 유닛(1104)에 출력한다. 블록 역 양자화 유닛(1104)은 입력 서브블록 양자화 계수 및 서브블록 양자화 파라미터에 역 양자화를 적용하여 직교 변환 계수를 재생하고, 재생된 직교 변환 계수를 블록 역변환 유닛(1105)에 출력한다. 블록 역변환 유닛(1105)은 재생된 직교 변환 계수에 역변환을 적용하여 예측 오류를 재생하고, 재생된 예측 오류를 블록 재생 유닛(1106)에 출력한다. 블록 재생 유닛(1106)은 재생된 예측 오류를 입력하고, 주변 디코딩 픽셀 데이터 또는 선행 프레임 픽셀 데이터에 기초하여 예측을 실행하여 서브블록 화상 데이터를 재생하고, 재생된 서브블록 화상 데이터를 블록 결합 유닛(1107)에 출력한다. 블록 결합 유닛(1107)은 재생된 서브블록 화상 데이터를 각각의 위치들에 배열하여 기초 블록 화상 데이터를 재생하고, 재생된 기초 블록 화상 데이터를 단자(1108)를 통해 밖으로 출력한다. 블록 결합 유닛(1107)은 예측 값 산출을 위해 재생된 기초 블록 화상 데이터를 블록 재생 유닛(1106)에 또한 출력한다.

도 8은 본 발명의 제2 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리를 도시한 흐름도이다. 단계 S101에서, 디코딩 및 분리 유닛(1101)은 헤더 정보를 디코딩한다.

단계 S102에서, 기초 블록 양자화 파라미터 디코딩 유닛(103)은 기초 블록 양자화 파라미터 코드를 디코딩하여 기초 블록 양자화 파라미터를 재생한다.

단계 S103에서, 서브블록 양자화 파라미터 디코딩 유닛(104)은 서브블록 양자화 파라미터 차분값 코딩 데이터를 디코딩하여, 서브블록 양자화 파라미터 차분값을 재생한다. 서브블록 양자화 파라미터 추가 유닛(105)은 기초 블록 양자화 파라미터를 서브블록 양자화 파라미터 차분값에 추가하여, 서브블록 양자화 파라미터를 재생한다.

단계 S104에서, 화상 디코딩 장치는 서브블록 양자화 계수 코드 데이터를 디코딩하여 양자화 계수를 재생하고, 디코딩된 서브블록 양자화 계수 코드 데이터에 역 양자화 및 역 직교 변환을 적용하여 예측 오류를 재생한다. 화상 디코딩 장치는 주변 디코딩 픽셀 데이터 또는 선행 프레임 픽셀 데이터에 기초하여 예측을 더 실행하여 서브블록 디코딩 화상을 재생한다.

단계 S105에서, 화상 디코딩 장치는 서브블록 디코딩 화상을 기초 블록 디코딩 화상에 배열한다. 단계 S106에서, 화상 디코딩 장치는 디코딩 처리가 관련 기초 블록의 모든 서브블록들에 대해 완료되었는 지를 결정한다. 디코딩 처리가 모든 서브블록들에 대해 완료되었을 때(단계 S106에서 예), 처리는 단계 S107로 진행한다. 디코딩 처리가 모든 서브블록들에 대해 완료되지 않았을 때(단계 S106에서 아니오), 처리는 단계 S103으로 복귀하여 다음 서브블록을 처리한다.

단계 S107에서, 화상 디코딩 장치는 기초 블록 디코딩 화상을 프레임 디코딩 화상에 배열한다. 단계 S108에서, 화상 디코딩 장치는 디코딩 처리가 모든 기초 블록들에 대해 완료되었는 지를 결정한다. 디코딩 처리가 모든 기초 블록들에 대해 완료되었을 때(단계 S108에서 예), 화상 디코딩 장치는 모든 동작들을 정지하여 처리를 종료한다. 디코딩 처리가 모든 기초 블록들에 대해 완료되지 않았을 때(단계 S108에서 아니오), 처리는 다음 기초 블록을 위해 단계 S102로 복귀한다.

상술된 구성 및 동작들은 제1 일례의 실시예에서 생성된, 감소된 양의 코드들을 가진 비트스트림을 디코딩하여, 재생된 화상을 획득할 수 있게 한다.

코드 식별이 구획 문자를 사용해서 각각의 서브블록에 대해 가능하면, 상이한 동작들,즉, 서브블록 양자화 파라미터들의 재생, 재생된 서브블록들에 대한 역 양자화 및 역변환의 적용, 및 화상 데이터의 재생을 동시에 효율적으로 실행할 수 있어서, 고속 디코딩을 달성할 수 있다.

도 9a는 및 도 9b는 예측 오류들을 재생하기 위해 도 2a에 도시된 기초 블록 10000의 서브블록들 10001 내지 10006에 디코딩, 역 양자화, 및 역변환 처리를 적용하는 일례의 병렬 처리를 도시한다. 본 발명의 제1 일례의 실시예에 따른 도 5a 및 도 5b와 유사하게, 설명을 간략하게 하기 위해, 3개의 프로세서들이 사용된다고 가정된다. 본 일례에서, 3개의 프로세서들은 각각의 서브블록 양자화 파라미터 차분값(.delta.QP)을 디코딩하여 양자화 파라미터(QP)를 재생하고, 양자화 계수를 디코딩하며, 양자화 계수에 역 양자화 및 역 직교 변환을 적용한다. 이 경우에, 다른 프로세서는 이 코드들을 분리한다.

도 9a는 일례의 종래의 병렬 처리를 도시한다. 우선, 화상 디코딩 장치는 프로세서 A에 서브블록 10001의 처리를 할당하고, 프로세서 B에 서브블록 10002의 처리를 할당하며, 프로세서 C에 서브블록 10003의 처리를 할당한다. 그 후, 프로세서 A는, 제1 프로세서로서, 서브블록 양자화 파라미터 자체를 디코딩한다. 프로세서들 B 및 C는 각각의 서브블록 양자화 파라미터 차분값을 디코딩하고, 그 후, 서브블록 양자화 파라미터를 재생한다. 상술된 처리는 서브블록 양자화 파라미터 예측 값이 되기 전에 서브블록들의 서브블록 양자화 파라미터, 및 서브블록 양자화 파라미터 차분값을 추가함으로써 달성된다.

서브블록 10001의 양자화 파라미터의 디코딩은 서브블록 10002에 대한 서브블록 양자화 파라미터 재생을 시작하기 위해 완료될 필요가 있다. 이는 프로세서 A가 서브블록 10001에 대한 서브블록 양자화 파라미터 재생을 완료할 때까지 프로세서 B가 대기함을 의미한다.

이는 서브블록 10002에 대한 양자화 파라미터 재생에도 적용된다. 프로세서 B가 서브블록 10002에 대한 양자화 파라미터 재생을 완료할 때까지 프로세서 C는 대기한다. 그 후, 처리를 완료한 프로세서들 각각은 영역 사분목 구조의 순으로, 즉, 서브블록 10004, 서브블록 10005, 및 서브블록 10006의 순으로 서브블록들을 처리한다. 서브블록 10005에 대한 양자화 파라미터 재생은 서브블록 10006에 대한 서브블록 양자화 파라미터 재생을 시작하기 위해 완료될 필요가 있다. 이는 프로세서 A가 서브블록 10005에 대한 양자화 파라미터 재생을 완료할 때까지 프로세서 C가 대기함을 의미한다.

도 9b는 본 일례의 실시예에 따른 일례의 병렬 처리를 도시한다. 먼저, 프로세서 A는 기초 블록 양자화 파라미터를 디코딩 및 저장한다. 그 후, 종래의 경우와 유사하게, 화상 디코딩 장치는 프로세서 A에 서브블록 10001의 처리를 할당하고, 프로세서 B에 서브블록 10002의 처리를 할당하며, 프로세서 C에 서브블록 10003의 처리를 할당한다. 서브블록 양자화 파라미터 차분값을 디코딩한 후에, 화상 디코딩 장치는 서브블록 양자화 파라미터를 재생한다. 기초 블록 양자화 파라미터가 재생된 이후에, 서브블록 10002에 대한 양자화 파라미터 재생이 서브블록 양자화 파라미터 차분값 디코딩 직후에 시작될 수 있다. 본 발명은 효율적인 병렬 처리를 달성한다. 특히, 복수의 크기들을 가진 서브블록들이 존재할 때, 본 발명은 처리 간격을 감소시키는데 엄청난 효과를 제공한다.

도 2a의 오직 서브블록 10008만이 화상 데이터로부터 일부분을 클리핑하기 위한 편집 애플리케이션을 사용해서 클리핑되는 경우를 가정해 보라. 종래의 경우에 따라, 서브블록들 10001 내지 10007이 디코딩될 필요가 있다. 본 발명에 따라, 오직 서브블록들 10001 내지 10006만을 디코딩하여, 인트라-예측을 포함하는 필요한 디코딩 처리를 가능케 한다. 따라서, 디코딩 처리를 건너뜀으로써 처리 속도가 향상될 수 있다.

본 발명의 제1 일례의 실시예와 유사하게, 블록 크기, 처리 유닛 크기, 픽셀 배열들과 관련된 처리 유닛들, 및 코드들이 그렇게 제한되지는 않는다.

제2 일례의 실시예에서, 기초 블록 양자화 파라미터, 서브블록 양자화 파라미터 차분값, 및 양자화 계수를 디코딩하는데 콜롱 코드가 사용되더라도, 처리는 그렇게 제한되지는 않는다. 물론, 예를 들어, 허프만 코딩 및 다른 산술 코딩 방법들을 사용하고, 코딩 없이 있는 그대로 상술된 값들을 출력할 수 있다.

제2 일례의 실시예가 구체적으로 인트라-예측을 사용해서 프레임들에 기초하여 기술되었지만, 본 일례의 실시예는 예측시 움직임 보상을 수반하는 인터-예측을 사용할 수 있는 프레임들에도 또한 적용될 수 있음이 명백하다.

도 10은 본 발명의 제3 일례의 실시예에 따른 화상 코딩 장치의 구성을 도시한 블록도이다. 제3 일례의 실시예에서, 제1 서브블록의 양자화 파라미터(이후부터 제1 서브블록 양자화 파라미터라고 함)가 기초 블록 양자화 파라미터로서 생각되고, 기초 블록 양자화 파라미터는 개별적으로 인코딩되지 않는다. 본 발명의 제1 일례의 실시예와 달리, 제3 일례의 실시예는 변경의 존재 또는 부재를 나타내는 코드를 사용하지 않는다. 그러나, 본 발명의 제1 일례의 실시예와 유사하게, 코딩은 변경의 존재 또는 부재를 나타내는 코드를 사용해서 실행될 수 있다. 도 10을 참조하면, 제1 일례의 실시예(도 1)와 동일한 기능을 가진 요소들에 동일한 참조 부호들이 할당되며, 중복된 설명은 생략될 것이다.

양자화 파라미터 코딩 유닛(1208)은 서브블록 양자화 파라미터를 인코딩하여 양자화 파라미터 코드 데이터를 생성한다. 통합 및 코딩 유닛(1209)은 헤더 정보 및 예측과 관련된 코드를 생성하고, 양자화 파라미터 코딩 유닛(1208)에 의해 생성된 양자화 파라미터 코드 데이터 및 블록 코딩 유닛(1006)에 의해 생성된 양자화 계수 코드 데이터를 통합한다.

도 11은 양자화 파라미터 코딩 유닛(1208)을 도시한 상세한 블록도이다. 도 11을 참조하면, 제1 일례의 실시예(도 3)와 동일한 기능을 가진 요소들에 동일한 참조 부호들이 할당되며, 중복된 설명은 생략될 것이다.

선택기(200)는 입력 서브블록 양자화 파라미터에 대한 서브블록 위치에 좌우되는 목적지를 선택한다. 기초 블록 양자화 파라미터 저장 유닛(203)은 기초 블록의 영역 사분목 구조의 순으로 기초 블록 양자화 파라미터로서 제1 서브블록 양자화 파라미터를 저장한다. 서브블록 양자화 파라미터 차분 유닛(206)은 다음 서브블록 양자화 파라미터들 각각 및 기초 블록 양자화 파라미터 간의 차분값을 산출한다. 서브블록 양자화 파라미터 코딩 유닛(207)은 제1 서브블록 양자화 파라미터 및 각각의 서브블록 양자화 파라미터 차분값을 인코딩한다.

제1 일례의 실시예와 유사하게, 상술된 구성을 가진 양자화 파라미터 코딩 유닛(1208)은 영역 사분목 구조의 순으로 단자(1)로부터 서브블록 양자화 파라미터들을 입력한다. 선택기(200)는 영역 사분목 구조의 순으로 기초 블록 양자화 파라미터 저장 유닛(203)에 제1 서브블록 양자화 파라미터를 출력한다. 선택기(200)는 다음 서브블록 양자화 파라미터들을 서브블록 양자화 파라미터 차분 유닛(206)에 출력한다.

기초 블록 양자화 파라미터 저장 유닛(203)은 제1 서브블록 양자화 파라미터를 기초 블록 양자화 파라미터로서 저장한다. 그 후, 서브블록 양자화 파라미터 차분 유닛(206)은 제1 서브블록 양자화 파라미터를 또한 입력한다. 관련 서브블록 양자화 파라미터가 기초 블록의 제1 서브블록 양자화 파라미터이기에, 다음 스테이지에서 서브블록 양자화 파라미터 차분 유닛(206)은 차분을 산출하지 않고 관련 서브블록 양자화 파라미터를 있는 그대로 서브블록 양자화 파라미터 코딩 유닛(207)에 출력한다. 서브블록 양자화 파라미터 코딩 유닛(207)은 콜롱 코딩을 통해 입력 서브블록 양자화 파라미터를 인코딩하고, 서브블록 양자화 파라미터 코딩 데이터로서 결과 코드를 단자(8)를 통해 밖으로 출력한다.

그 후, 서브블록 양자화 파라미터 차분 유닛(206)은 영역 사분목 구조의 순으로 서브블록 양자화 파라미터들을 선택기(200)를 통해 단자(1)로부터 입력한다. 서브블록 양자화 파라미터 차분 유닛(206)은 각각의 입력 서브블록 양자화 파라미터 및 기초 블록 양자화 파라미터 저장 유닛(203)에 저장된 기초 블록 양자화 파라미터 간의 차분값을 산출한다. 서브블록 양자화 파라미터 코딩 유닛(207)은 콜롱 코딩을 통해 서브블록 양자화 파라미터 차분값을 인코딩하여 서브블록 양자화 파라미터 차분값 코딩 데이터를 생성하고, 생성된 서브블록 양자화 파라미터 차분값 코딩 데이터를 서브블록 양자화 파라미터 코딩 데이터로서 단자(8)를 통해 밖으로 출력한다. 그 후, 서브블록 양자화 파라미터 코딩 유닛(207)은 기초 블록의 각각의 서브블록의 서브블록 양자화 파라미터 차분값을 획득 및 인코딩한다.

도 12는 본 발명의 제3 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다. 도 12를 참조하면, 제1 일례의 실시예(도 4)와 동일한 기능을 가진 요소들에 동일한 참조 부호들이 할당되며, 중복된 설명은 생략될 것이다.

단계들 S001 내지 S004에서, 본 발명의 제1 일례의 실시예와 유사하게, 화상 코딩 장치는 기초 블록을 클리핑하고, 기초 블록을 복수의 서브블록들로 분할하며, 서브블록 양자화 파라미터들을 결정한다.

단계 S205에서, 화상 코딩 장치는 제1 서브블록 양자화 파라미터를 기초 블록 양자화 파라미터로서 저장한다.

단계 S206에서, 화상 코딩 장치는 입력 서브블록이 기초 블록의 제1 서브블록인 지를 결정한다. 입력 서브블록이 제1 서브블록일 때, 처리는 단계 S208로 진행한다(단계 S206에서 예). 그렇지 않으면, 입력 서브블록이 제1 서브블록이 아닐 때(단계 S206에서 아니오), 처리는 단계 S207로 진행한다. 단계 S207에서, 화상 코딩 장치는 단계 S205에 저장된 기초 블록 양자화 파라미터 및 입력 서브블록 양자화 파라미터 간의 차분을 산출한다.

단계 S208에서, 화상 코딩 장치는 콜롱 코딩을 통해 입력 서브블록 양자화 파라미터 또는 서브블록 양자화 파라미터 차분값을 인코딩하고, 결과 코드를 서브블록 양자화 파라미터 코딩 데이터로서 출력한다.

단계들 S008 및 S009에서, 화상 코딩 장치는 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치와 유사한 처리를 실행한다. 단계 S210에서, 화상 코딩 장치는 코딩 처리가 기초 블록의 모든 서브블록들에 대해 완료되었는 지를 결정한다. 코딩 처리가 모든 서브블록들에 대해 완료되지 않았을 때(단계 S210에서 아니오), 처리는 단계 S206으로 진행하여 다음 서브블록을 처리한다. 코딩 처리가 모든 서브블록들에 대해 완료되었을 때(단계 S210에서 예), 처리는 단계 S011로 진행한다. 그 후, 화상 코딩 장치는 본 발명의 제1 일례의 실시예에 따른 화상 코딩 장치와 유사한 전체 화상에 대한 코딩 처리를 실행한다. 상술된 구성 및 동작들에 따라, 제1 서브블록 양자화 파라미터를 기초 블록 양자화 파라미터로서 간주하여, 기초 블록 양자화 파라미터를 전송할 필요성을 제거하여, 향상된 코딩 효율을 야기한다.

상술된 구성 및 동작들은 본 발명의 제1 일례의 실시예와 유사한 효과적인 병렬 처리를 또한 가능케 한다. 구체적으로, 도 5a를 참조하면, 병렬 처리의 제1 스테이지에서, 프로세서 A가 제1 서브블록 양자화 파라미터 산출을 완료할 때까지 프로세서들 B 및 C는 대기할 필요가 있다. 그러나, 그 후, 프로세서들 B 및 C는 프로세서 A가 서브블록 10004의 처리를 완료할 때까지 대기하지 않고 서브블록 10005의 양자화 파라미터 차분값을 산출할 수 있다.

물론, 제1 일례의 실시예의 기초 블록 양자화 파라미터의 코딩 방법 및 본 일례의 실시예의 기초 블록 양자화 파라미터로서 제1 서브블록 양자화 파라미터를 간주하는 방법 간의 전환을 위한 코드를 제공하고, 어느 방법이든 더 높은 코딩 효율을 가진 방법을 선택할 수 있다.

동일한 코딩 방법이 제1 서브블록 양자화 파라미터(기초 블록 양자화 파라미터) 및 다음 서브블록 양자화 파라미터 차분값들에 적용되더라도, 처리는 그렇게 제한되지는 않는다. 물론, 상이한 코딩 방법들을 제1 서브블록 양자화 파라미터 및 다음 서브블록 양자화 파라미터 차분값들에 적용할 수 있다.

제3 일례의 실시예에서, 기초 블록 양자화 파라미터, 서브블록 양자화 파라미터 차분값, 및 양자화 계수가 콜롱 코딩을 통해 인코딩되더라도, 처리는 그렇게 제한되지는 않는다. 물론, 예를 들어, 허프만 코딩 및 다른 산술 코딩 방법들을 사용할 수 있다.

제3 일례의 실시예가 구체적으로 인트라-예측을 사용해서 프레임들에 기초하여 기술되었지만, 본 일례의 실시예는 예측시 움직임 보상을 수반하는 인터-예측을 사용할 수 있는 프레임들에도 또한 적용될 수 있음이 명백하다.

본 발명의 제4 일례의 실시예가 본 발명의 제3 일례의 실시예에 따른 코딩 방법을 사용해서 코딩된 코드 데이터를 디코딩하기 위한 화상 디코딩 방법에 기초하여 후술될 것이다. 도 13은 본 발명의 제3 일례의 실시예에 따른 코딩 방법을 사용해서 코딩된 코드 데이터를 디코딩하기 위한 화상 디코딩 장치를 도시한 블록도이다. 도 13을 참조하면, 제2 일례의 실시예(도 6)와 동일한 기능을 가진 요소들에 동일한 참조 부호들이 할당되며, 중복된 설명은 생략될 것이다.

도 13을 참조하면, 디코딩 및 분리 유닛(1301)은 비트스트림의 헤더 정보를 디코딩하고, 비트스트림으로부터 요구된 코드들을 분리하며, 분리된 코드들을 다음 스테이지에 출력한다. 양자화 파라미터 디코딩 유닛(1302)은 서브블록 양자화 파라미터를 재생한다. 디코딩 및 분리 유닛(1301) 및 양자화 파라미터 디코딩 유닛(1302)은, 각각, 제2 일례의 실시예에 따른, 디코딩 및 분리 유닛(1101) 및 양자화 파라미터 디코딩 유닛(1102)(도 6)과 양자화 파라미터 코드 데이터라는 면에서 상이하다.

본 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리가 후술될 것이다. 본 일례의 실시예에서, 제3 일례의 실시예에 따른 화상 코딩 장치에 의해 생성된 동화상 비트스트림이 프레임 유닛들로 입력되더라도, 1 프레임에 대한 정지 화상 비트스트림이 입력될 수 있다.

제2 일례의 실시예와 유사하게, 디코딩 및 분리 유닛(1301)은 단자(1100)로부터 1 프레임에 대한 스트림 데이터를 입력하고, 화상을 재생하는데 필요한 헤더 정보를 디코딩한다. 그 후, 양자화 파라미터 디코딩 유닛(1302)은 영역 사분목 구조의 순으로 서브블록 양자화 파라미터 코딩 데이터를 입력한다.

도 14는 양자화 파라미터 디코딩 유닛(1302)을 도시한 상세한 블록도이다. 도 14를 참조하면, 제2 일례의 실시예(도 7)와 동일한 기능을 가진 요소들에 동일한 참조 부호들이 할당되며, 중복된 설명은 생략될 것이다.

서브블록 양자화 파라미터 디코딩 유닛(304)은 서브블록 양자화 파라미터 및 서브블록 양자화 파라미터 차분값 코딩 데이터를 디코딩하여 각각의 서브블록 양자화 파라미터 차분값을 재생한다. 선택기(300)는 입력 서브블록 양자화 파라미터에 대한 서브블록 위치에 좌우되는 목적지를 선택한다. 기초 블록 양자화 파라미터 저장 유닛(310)은 처음으로 디코딩된 서브블록 양자화 파라미터를 기초 블록 양자화 파라미터로서 저장한다. 서브블록 양자화 파라미터 추가 유닛(305)은 기초 블록 양자화 파라미터 및 각각의 서브블록 양자화 파라미터 차분값을 추가하여 각각의 서브블록 양자화 파라미터를 재생한다.

상술된 구성에 따라, 선택기(300)는 기초 블록의 디코딩이 시작될 때 목적지로서 기초 블록 양자화 파라미터 저장 유닛(310)을 선택한다. 서브블록 양자화 파라미터 디코딩 유닛(304)은 단자(102)로부터 기초 블록의 제1 서브블록의 서브블록 양자화 파라미터 코딩 데이터를 입력하고, 콜롱 코드를 사용해서 서브블록 양자화 파라미터 코딩 데이터를 디코딩하여 서브블록 양자화 파라미터를 재생한다. 기초 블록 양자화 파라미터 저장 유닛(310)은 선택기(300)를 통해 제1 서브블록 양자화 파라미터를 입력하고, 관련 기초 블록의 처리 중에 서브블록 양자화 파라미터를 저장한다. 그 후, 서브블록 양자화 파라미터 추가 유닛(305)은 제1 서브블록 양자화 파라미터를 또한 입력한다. 차분값이 제1 서브블록에 대해 존재하지 않기에, 서브블록 양자화 파라미터 추가 유닛(305)은 재생된 서브블록 양자화 파라미터를 있는 그대로 단자(106)를 통해 밖으로 출력한다. 기초 블록 양자화 파라미터 저장 유닛(310)이 제1 서브블록 양자화 파라미터를 저장할 때, 선택기(300)는 목적지로서 서브블록 양자화 파라미터 추가 유닛(305)을 선택한다.

그 후, 서브블록 양자화 파라미터 디코딩 유닛(304)은 제2 및 다음 서브블록 양자화 파라미터 차분값 코딩 데이터를 입력한다. 서브블록 양자화 파라미터 디코딩 유닛(304)은 콜롱 코드를 사용해서 입력 서브블록 양자화 파라미터 차분값 코딩 데이터를 디코딩하여 서브블록 양자화 파라미터 차분값을 재생한다. 서브블록 양자화 파라미터 추가 유닛(305)은 (선택기(300)를 통해 입력된) 서브블록 양자화 파라미터 차분값을 기초 블록 양자화 파라미터 저장 유닛(310)에 저장된 기초 블록 양자화 파라미터에 추가한다. 서브블록 양자화 파라미터 추가 유닛(305)은 이러한 방법으로 서브블록 양자화 파라미터를 재생하고, 재생된 서브블록 양자화 파라미터를 단자(106)를 통해 밖으로 출력한다. 그 후, 양자화 파라미터 디코딩 유닛(1302)은 기초 블록의 각각의 서브블록의 서브블록 양자화 파라미터를 디코딩하고, 서브블록 양자화 파라미터 차분값을 산출하며, 산출된 서브블록 양자화 파라미터 차분값을 기초 블록 양자화 파라미터에 추가하여 서브블록 양자화 파라미터를 재생한다.

도 15는 본 발명의 제4 일례의 실시예에 따른 화상 디코딩 처리를 도시한 흐름도이다. 도 15를 참조하면, 제2 일례의 실시예(도 8)와 동일한 기능을 가진 요소들에 동일한 참조 부호들이 할당되며, 중복된 설명은 생략될 것이다.

단계 S101에서, 화상 디코딩 장치는 본 발명의 제2 일례의 실시예에 따른 화상 디코딩 장치와 유사한 헤더 정보를 디코딩한다. 단계 S310에서, 화상 디코딩 장치는 디코딩을 겪은 서브블록이 기초 블록의 제1 서브블록인 지를 결정한다. 디코딩을 겪은 서브블록이 제1 서브블록일 때(단계 S310에서 예), 처리는 단계 S311로 진행한다. 그렇지 않으면, 디코딩을 겪은 서브블록이 제1 서브블록이 아닐 때(단계 S310에서 아니오), 처리는 단계 S303으로 진행한다.

단계 S311에서, 화상 디코딩 장치는 입력 서브블록 양자화 파라미터와 관련된 코드, 즉, 서브블록 양자화 파라미터 코딩 데이터를 콜롱 코드를 사용해서 디코딩하고, 결과 코드를 기초 블록 양자화 파라미터로서 저장한다. 그 후, 처리는 단계 S104로 진행하여 제1 서브블록의 디코딩된 화상을 생성한다.

단계 S303에서, 화상 디코딩 장치는 입력 서브블록 양자화 파라미터와 관련된 코드, 즉, 서브블록 양자화 파라미터 차분값 코딩 데이터를 콜롱 코드를 사용해서 디코딩하여 서브블록 양자화 파라미터 차분값을 재생한다. 화상 디코딩 장치는 재생된 서브블록 양자화 파라미터 차분값을 단계 S311에서 저장된 기초 블록 양자화 파라미터에 추가하고, 추가 결과를 서브블록 양자화 파라미터로서 사용한다. 처리는 단계 S104로 진행하여 제2 다음 서브블록들의 디코딩된 화상들을 생성한다.

그 후, 본 발명의 제2 일례의 실시예와 유사하게, 화상 디코딩 장치는 서브블록 디코딩된 화상을 생성하고 프레임 화상을 재생한다.

상술된 구성 및 동작들은, 기초 양자화 파라미터를 개별적으로 인코딩하지 않고, 제3 일례의 실시예에서 생성된 감소된 양의 코드들을 가진 코딩 데이터를 디코딩할 수 있게 한다.

상술된 구성 및 동작들은 본 발명의 제2 일례의 실시예와 유사한 효과적인 병렬 처리를 또한 가능케 한다. 구체적으로, 도 9b를 참조하면, 프로세서 A는 기초 블록 양자화 파라미터 디코딩 대신 기초 블록에 대한 제1 서브블록 양자화 파라미터 디코딩을 실행한다. 이 처리는 기초 블록 양자화 파라미터 디코딩 및 제1 서브블록 양자화 파라미터 차분값 디코딩을 대체한다. 이는, 병렬 처리의 제1 스테이지에서, 프로세서 A가 제1 서브블록 양자화 파라미터의 디코딩을 완료할 때까지 프로세서들 B 및 C는 대기할 필요가 있음을 의미한다. 그 후, 프로세서들 B 및 C는 프로세서 A가 다른 서브블록들의 처리를 완료할 때까지 대기하지 않고 모든 서브블록 양자화 파라미터들의 재생을 시작할 수 있다.

제4 일례의 실시예에서, 기초 블록 양자화 파라미터, 서브블록 양자화 파라미터 차분값, 및 양자화 계수를 디코딩하는데 콜롱 코드가 사용되더라도, 처리는 그렇게 제한되지는 않는다. 물론, 예를 들어, 허프만 코딩 및 다른 산술 코딩 방법들을 사용할 수 있다.

제3 일례의 실시예의 기초 블록 양자화 파라미터의 코딩 방법 및 제4 일례의 실시예의 제1 서브블록 양자화 파라미터를 기초 블록 양자화 파라미터로서 간주하는 방법 간의 전환을 위한 코드가 제공될 때, 화상 디코딩 장치는 코드를 해석하고 도 8의 단계 S102를 실행한다. 대안으로, 화상 디코딩 장치는 도 15의 단계들 S310, S311, 및 S303이 실행될 것인 지를 양호하게 선택한다.

제4 일례의 실시예가 구체적으로 인트라-예측을 사용해서 프레임들에 기초하여 기술되었지만, 본 일례의 실시예는 예측시 움직임 보상을 수반하는 인터-예측을 사용할 수 있는 프레임들에도 또한 적용될 수 있음이 명백하다.

본 발명의 제5 일례의 실시예가 최종 기초 블록의 서브블록 양자화 파라미터를 사용한 기초 블록 양자화 파라미터의 결정에 기초하여 후술될 것이다.

제5 일례의 실시예에 따른 화상 코딩 장치는 본 발명의 제3 일례의 실시예(도 10)에 따른 화상 코딩 장치와 유사한 구성을 가지며, 양자화 파라미터 코딩 유닛(1208)의 구성은 상이하다.

도 16 본 발명의 제5 일례의 실시예에 따른 양자화 파라미터 코딩 유닛(1208)의 상세한 구성을 도시한 블록도이다.

도 16을 참조하면, 선택기(400)는 입력 서브블록 양자화 파라미터에 대한 기초 블록 위치에 좌우되는 소스를 선택한다. 서브블록 양자화 파라미터 저장 유닛(410)은 선행 기초 블록의 서브블록 양자화 파라미터들을 저장한다. 기초 블록 양자화 파라미터 결정 유닛(403)은 서브블록 양자화 파라미터 저장 유닛(410)에 저장된 서브블록 양자화 파라미터들에 기초하여 코딩을 겪은 기초 블록의 기초 블록 양자화 파라미터를 결정한다. 서브블록 양자화 파라미터 차분 유닛(406)은 기초 블록 양자화 파라미터 및 각각의 서브블록 양자화 파라미터 간의 차분값을 산출한다. 서브블록 양자화 파라미터 코딩 유닛(407)은 제1 서브블록 양자화 파라미터 및 각각의 서브블록 양자화 파라미터 간의 차분값을 인코딩한다.

상술된 구성에 따라, 제3 일례의 실시예와 유사하게, 블록 분할 유닛(1001)은 (단자(1000)로부터 입력된) 화상 데이터를 복수의 서브블록들로 분할하고, 양자화 파라미터 결정 유닛(1002)은 각각의 서브블록 양자화 파라미터를 결정한다. 양자화 파라미터 결정 유닛(1002)은 각각의 결정된 서브블록을 양자화 파라미터 코딩 유닛(1208)에 출력한다.

도 16을 참조하면, 입력 서브블록 양자화 파라미터가 화상 데이터의 제1 기초 블록의 제1 서브블록 양자화 파라미터일 때, 선택기(400)는 단자(1)로부터 입력을 선택한다. 기초 블록 양자화 파라미터 결정 유닛(403)은 서브블록 양자화 파라미터 저장 유닛(410), 서브블록 양자화 파라미터 차분 유닛(406), 및 선택기(400)를 통해 서브블록 양자화 파라미터를 입력한다. 서브블록 양자화 파라미터 저장 유닛(410)은 다음 기초 블록의 처리를 위한 서브블록 양자화 파라미터를 저장한다. 제3 일례의 실시예에 따른 기초 블록 양자화 파라미터 저장 유닛(203)과 유사하게, 기초 블록 양자화 파라미터 결정 유닛(403)은 입력 서브블록 양자화 파라미터를 기초 블록 양자화 파라미터로서 저장한다. 본 발명의 제3 일례의 실시예에 따른 서브블록 차분 유닛(206)과 유사하게, 서브블록 양자화 파라미터 차분 유닛(406)은 서브블록 양자화 파라미터를 있는 그대로 서브블록 양자화 파라미터 코딩 유닛(407)에 출력한다. 서브블록 양자화 파라미터 코딩 유닛(407)은 콜롱 코딩을 통해 제1 서브블록 양자화 파라미터를 인코딩하고, 결과 코드를 단자(8)를 통해 밖으로 출력한다.

그 후, 서브블록 양자화 파라미터 저장 유닛(410) 및 서브블록 양자화 파라미터 차분 유닛(406)은 단자(1)로부터 화상 데이터의 제1 기초 블록의 다른 서브블록 양자화 파라미터들을 입력한다. 서브블록 양자화 파라미터 차분 유닛(406)은 기초 블록 양자화 파라미터 결정 유닛(403)으로부터 출력된 기초 블록 양자화 파라미터 및 입력 서브블록 양자화 파라미터 간의 차분값을 산출한다. 서브블록 양자화 파라미터 코딩 유닛(407)은 차분값을 입력하고, 제3 일례의 실시예와 유사한 차분값을 인코딩하여, 결과 코드를 단자(8)를 통해 밖으로 출력한다.

제1 기초 블록이 아닌, 화상의 다음 입력 기초 블록들에 대한 처리가 후술될 것이다. 기초 블록의 코딩 처리 전에, 선택기(400)는 소스로서 서브블록 양자화 파라미터 저장 유닛(410)을 선택한다. 기초 블록 양자화 파라미터 결정 유닛(403)은 저장된 서브블록 양자화 파라미터들의 평균을 산출하고, 평균을 기초 블록 양자화 파라미터로서 간주한다. 그 후, 서브블록 양자화 파라미터 차분 유닛(406)은 단자(1)로부터 관련 기초 블록의 서브블록 양자화 파라미터들을 입력한다. 서브블록 양자화 파라미터 차분 유닛(406)은 기초 블록 양자화 파라미터 결정 유닛(403)으로부터 출력된 기초 블록 양자화 파라미터 및 각각의 입력 서브블록 양자화 파라미터 간의 차분값을 산출한다. 서브블록 양자화 파라미터 코딩 유닛(407)은 차분값을 입력하고, 제3 일례의 실시예와 유사한 차분값을 인코딩하여, 결과 코드를 단자(8)에 출력한다.

도 17은 본 발명의 제5 일례의 실시예에 따른 화상 코딩 장치에 의한 화상 코딩 처리를 도시한 흐름도이다. 도 17을 참조하면, 제1 일례의 실시예(도 4)와 동일한 기능을 가진 요소들에 동일한 참조 부호들이 할당되며, 중복된 설명은 생략될 것이다.

단계들 S001 내지 S003에서, 제1 일례의 실시예에 따른 화상 코딩 장치와 유사하게, 화상 코딩 장치는 헤더 정보를 인코딩하고, 화상 데이터로부터 기초 블록을 클리핑하며, 기초 블록을 복수의 서브블록들로 분할한다. 단계 S401에서, 화상 코딩 장치는 관련 기초 블록이 화상의 제1 기초 블록인 지를 결정한다. 관련 기초 블록이 제1 기초 블록일 때(단계 S401에서 예), 처리는 단계 S402로 진행한다. 그렇지 않으면, 관련 기초 블록이 제1 기초 블록이 아닐 때(단계 S401에서 아니오), 처리는 단계 S409로 진행한다. 단계 S402에서, 화상 코딩 장치는 관련 서브블록이 제1 기초 블록의 제1 서브블록인 지를 결정한다. 관련 서브블록이 제1 서브블록일 때(단계 S402에서 예), 처리는 단계 S403으로 진행한다. 그렇지 않으면, 관련 서브블록이 제1 서브블록이 아닐 때(단계 S402에서 아니오), 처리는 단계 S406으로 진행한다.

단계 S403에서, 화상 코딩 장치는 제1 기초 블록의 제1 서브블록 양자화 파라미터를 결정하고, 다음 기초 블록의 처리 중에 참조되도록 제1 서브블록 양자화 파라미터를 저장한다. 단계 S404에서, 화상 코딩 장치는 단계 S403에서 결정된 서브블록 양자화 파라미터를 기초 블록 양자화 파라미터로서 저장한다. 단계 S405에서, 화상 코딩 장치는 단계 S403에서 결정된 서브블록 양자화 파라미터를 인코딩하고, 처리는 단계 S008로 진행한다. 단계 S406에서, 화상 코딩 장치는 관련 서브블록의 서브블록 양자화 파라미터를 결정하고, 다음 기초 블록의 처리 중에 참조되도록 결정된 서브블록 양자화 파라미터를 저장한다.

단계 S407에서, 화상 코딩 장치는 단계 S406에서 결정된 서브블록 양자화 파라미터로부터 단계 S404에서 저장된 기초 블록 양자화 파라미터를 제해서 관련 서브블록의 서브블록 양자화 파라미터 차분값을 산출한다. 단계 S408에서, 화상 코딩 장치는 단계 S407에서 산출된 서브블록 양자화 파라미터 차분값을 인코딩하여 양자화 파라미터 차분값 코딩 데이터를 생성하고, 처리는 단계 S008로 진행한다. 단계 S409에서, 화상 코딩 장치는 관련 서브블록이 제2 다음 기초 블록의 제1 서브블록인 지를 결정한다. 관련 서브블록이 제1 서브블록일 때(단계 S409에서 예), 처리는 단계 S410으로 진행한다. 그렇지 않으면, 관련 서브블록이 제1 서브블록이 아닐 때(단계 S409에서 아니오), 처리는 단계 S406으로 진행한다. 단계 S410에서, 단계 S403 또는 S406에서 저장된 선행 기초 블록의 서브블록 양자화 파라미터들을 참조하여, 화상 코딩 장치는 관련 기초 블록의 기초 블록 양자화 파라미터를 산출한다. 본 일례의 실시예에서, 화상 코딩 장치는 상술된 서브블록 양자화 파라미터들의 평균을 산출하고, 평균을 기초 블록 양자화 파라미터로서 간주한다. 단계 S411에서, 화상 코딩 장치는 관련 서브블록의 서브블록 양자화 파라미터를 결정하고, 다음 기초 블록의 처리 중에 참조되도록 서브블록 양자화 파라미터를 저장한다.

단계 S412에서, 화상 코딩 장치는 단계 S411에서 결정된 서브블록 양자화 파라미터로부터 단계 S410에서 산출된 기초 블록 양자화 파라미터를 제하여 관련 서브블록의 서브블록 양자화 파라미터 차분값을 산출한다.

단계 S413에서, 화상 코딩 장치는 단계 S412에서 산출된 서브블록 양자화 파라미터 차분값을 인코딩하여 양자화 파라미터 차분값 코딩 데이터를 생성하고, 처리는 단계 S008로 진행한다. 단계 S414에서, 화상 코딩 장치는 코딩 처리가 관련 기초 블록의 모든 서브블록들에 대해 완료되었는 지를 결정한다. 코딩 처리가 모든 서브블록들에 대해 완료되었을 때(단계 S414에서 예), 처리는 단계 S011로 진행한다. 그렇지 않으면, 코딩 처리가 모든 서브블록들에 대해 완료되지 않았을 때(단계 S414에서 아니오), 처리는 단계 S401로 복귀하여 다음 서브블록을 처리한다. 단계들 S008, S009, 및 S011에서, 화상 코딩 장치는 제1 일례의 실시예와 유사한 처리를 실행하여 전체 화상을 인코딩한다.

상술된 구성 및 동작들에 따라, 선행 기초 블록의 서브블록 양자화 파라미터들을 사용해서 기초 블록 양자화 파라미터를 결정하여, 관련 기초 블록의 처리 시작 직후에 관련 기초 블록의 기초 블록 양자화 파라미터를 결정할 수 있게 해서, 최소화된 처리 지연이 야기된다. 또한, 선행 기초 블록의 서브블록 양자화 파라미터들에 기초하여 기초 블록 양자화 파라미터를 산출하여, 기초 블록 양자화 파라미터를 전송할 필요성을 제거하여, 향상된 코딩 효율이 야기된다.

상술된 구성 및 동작들은 본 발명의 제1 일례의 실시예와 유사한 효과적인 병렬 처리를 또한 가능케 한다. 구체적으로, 도 5b를 참조하면, 코딩 처리 전에, 기초 블록 양자화 파라미터가 선행 기초 블록의 서브블록 양자화 파라미터들에 기초하여 산출된다. 이는 각각의 개별 서브블록의 처리의 완료를 대기하지 않고 모든 서브블록들의 양자화 파라미터 차분값들을 산출할 수 있게 한다.

제5 일례의 실시예에서, 제1 서브블록 양자화 파라미터가 화상의 오직 제1 기초 블록에 대해서만 인코딩되더라도, 처리는 그렇게 제한되지는 않는다. 구체적으로, 복수의 기초 블록들로 구성된 슬라이스형 구성을 제공하고, 제1 기초 블록과 유사한 처리를 적용할 수 있다.

제5 일례의 실시예에서, 기초 블록 양자화 파라미터가 선행 기초 블록의 서브블록 양자화 파라미터들을 참조하여 결정되더라도, 처리는 그렇게 제한되지는 않는다. 선행 기초 블록의 최종 서브블록 양자화 파라미터들이 관련 기초 블록의 기초 블록 양자화 파라미터로서 간주될 수 있다. 물론, 서브블록 양자화 파라미터들 또는 주변 기초 블록들의 기초 블록 양자화 파라미터를 참조할 수 있다.

제5 일례의 실시예에서, 선행 기초 블록의 서브블록 양자화 파라미터들의 평균이 기초 블록 양자화 파라미터로서 간주되더라도, 처리는 그렇게 제한되지는 않는다. 물론, 예를 들어, 기초 블록 양자화 파라미터가 서브블록 양자화 파라미터들의 중간값, 또는 가장 빈번한 서브블록 양자화 파라미터 값일 수 있음이 가능하다. 물론, 이러한 방법으로 복수의 산출 방법들을 예비하고, 가장 효율적인 기초 블록 양자화 파라미터를 선택하며, 관련 산출 방법을 나타내는 코드를 사용해서 코딩을 실행할 수 있다.

제5 일례의 실시예가 구체적으로 인트라-예측을 사용해서 프레임들에 기초하여 기술되었지만, 본 일례의 실시예는 예측시 움직임 보상을 수반하는 인터-예측을 사용할 수 있는 프레임들에도 또한 적용될 수 있음이 명백하다.

본 발명의 제6 일례의 실시예가 본 발명의 제5 일례의 실시예에 따른 코딩 방법을 사용해서 코딩된 코드 데이터를 디코딩하기 위한 화상 디코딩 방법에 기초하여 후술될 것이다. 제6 일례의 실시예에 따른 화상 코딩 장치는 본 발명의 제4 일례의 실시예(도 13)에 따른 화상 코딩 장치와 유사한 구성을 가지며, 양자화 파라미터 디코딩 유닛(1302)의 구성은 상이하다.

도 18은 본 발명의 제6 일례의 실시예에 따른 양자화 파라미터 디코딩 유닛(1302)의 구성을 도시한 블록도이다. 도 18을 참조하면, 제4 일례의 실시예(도 14)와 동일한 기능을 가진 요소들에 동일한 참조 부호들이 할당되며, 중복된 설명은 생략될 것이다.

선택기(500)는 입력 서브블록 양자화 파라미터에 대한 서브블록 위치 및 관련 서브블록에 대한 기초 블록 위치에 좌우되는 목적지를 선택한다. 서브블록 양자화 파라미터 디코딩 유닛(501)은 서브블록 양자화 파라미터 자체의 코드를 디코딩하여 서브블록 양자화 파라미터를 재생한다. 서브블록 양자화 파라미터 차분값 디코딩 유닛(502)은 서브블록 양자화 파라미터 차분값의 코드를 디코딩하여 서브블록 양자화 파라미터 차분값을 재생한다. 선택기(503)는 입력 서브블록 양자화 파라미터에 대한 서브블록 위치 및 관련 서브블록에 대한 기초 블록 위치에 좌우되는 소스를 선택한다. 기초 블록 양자화 파라미터 결정 유닛(504)은 기초 블록 양자화 파라미터를 결정한다. 서브블록 양자화 파라미터 추가 유닛(505)은 결정된 기초 블록 양자화 파라미터 및 각각의 서브블록 양자화 파라미터 차분값을 추가하여 각각의 서브블록 양자화 파라미터를 재생한다. 선택기(506)는 입력 서브블록 양자화 파라미터에 대한 서브블록 위치 및 관련 서브블록에 대한 기초 블록 위치에 좌우되는 소스를 선택한다. 서브블록 양자화 파라미터 저장 유닛(507)은 재생된 서브블록 양자화 파라미터들을 저장한다.

화상 디코딩 장치에 의한 디코딩 처리가 후술될 것이다. 본 일례의 실시예에서, 동화상 비트스트림이 프레임 유닛들로 입력되더라도, 1 프레임에 대한 정지 화상 비트스트림이 입력될 수 있다.

1 프레임에 대한 비트스트림의 디코딩 처리 전에, 선택기(500)는 목적지로서 서브블록 양자화 파라미터 디코딩 유닛(501)을 선택하고, 선택기(503)는 소스로서 서브블록 양자화 파라미터 디코딩 유닛(501)을 선택한다. 선택기(505)는 소스로서 서브블록 양자화 파라미터 디코딩 유닛(501)을 선택한다.

서브블록 양자화 파라미터 디코딩 유닛(501)은 선택기(500)를 통해 제1 기초 블록의 서브블록 양자화 파라미터 코딩 데이터를 입력한다. 서브블록 양자화 파라미터 디코딩 유닛(501)은 콜롱 코드를 사용해서 코딩 데이터를 디코딩하여 서브블록 양자화 파라미터를 재생한다. 기초 블록 양자화 파라미터 결정 유닛(504)은 선택기(503)를 통해 서브블록 양자화 파라미터를 입력한다. 서브블록 양자화 파라미터의 서브블록이 제1 기초 블록의 제1 서브블록이기에, 기초 블록 양자화 파라미터 결정 유닛(504)은 입력 서브블록 양자화 파라미터를 있는 그대로 기초 블록 양자화 파라미터로서 저장한다. 서브블록 양자화 파라미터 디코딩 유닛(501)은 재생된 서브블록 양자화 파라미터를 선택기(505) 및 단자(106)를 통해 밖으로 출력한다. 서브블록 양자화 파라미터 저장 유닛(507)은 서브블록 양자화 파라미터를 저장한다.

그 후, 선택기(500)는 목적지로서 서브블록 양자화 파라미터 차분값 디코딩 유닛(502)을 선택하고, 선택기(503)는 소스로서 서브블록 양자화 파라미터 저장 유닛(507)을 선택한다. 선택기(505)는 소스로서 서브블록 양자화 파라미터 추가 유닛(305)을 선택한다.

양자화 파라미터 디코딩 유닛(1302)이 다음 서브블록의 서브블록 양자화 파라미터 차분값 코딩 데이터를 입력할 때, 서브블록 양자화 파라미터 차분값 디코딩 유닛(502)은 선택기(500)를 통해 서브블록 양자화 파라미터 차분값 코딩 데이터를 입력한다. 서브블록 양자화 파라미터 차분값 디코딩 유닛(502)은 서브블록 양자화 파라미터 차분값 코딩 데이터를 디코딩하여 서브블록 양자화 파라미터 차분값을 재생한다. 서브블록 양자화 파라미터 추가 유닛(305)은 서브블록 차분값을 기초 블록 양자화 파라미터에 추가하여 서브블록 양자화 파라미터를 재생하고, 재생된 서브블록 양자화 파라미터를 단자(106)를 통해 밖으로 출력한다. 서브블록 양자화 파라미터 저장 유닛(507)은 서브블록 양자화 파라미터를 저장한다.

그 후, 양자화 파라미터 디코딩 유닛(1302)은 다음 기초 블록의 서브블록 양자화 파라미터 차분값 코딩 데이터를 입력한다. 이 경우에, 기초 블록 양자화 파라미터 결정 유닛(504)은 서브블록 양자화 파라미터 저장 유닛(507)으로부터 선행 기초 블록의 서브블록 양자화 파라미터들을 판독하고, 판독된 서브블록 양자화 파라미터들의 평균을 산출하여, 평균을 관련 기초 블록의 기초 블록 양자화 파라미터로서 간주한다.

서브블록 양자화 파라미터 차분값 디코딩 유닛(502)은 입력 서브블록 양자화 파라미터 차분값 코딩 데이터를 디코딩하여 서브블록 양자화 파라미터 차분값을 재생한다. 서브블록 양자화 파라미터 추가 유닛(305)은 서브블록 양자화 파라미터를 재생하고, 재생된 서브블록 양자화 파라미터를 단자(106)를 통해 밖으로 출력한다. 서브블록 양자화 파라미터 저장 유닛(507)은 재생된 서브블록 양자화 파라미터를 저장한다.

그 후, 양자화 파라미터 디코딩 유닛(1302)은 다음 서브블록 양자화 파라미터 차분값 코딩 데이터를 입력하고, 서브블록 양자화 파라미터 차분값을 유사하게 재생하며, 그 후, 서브블록 양자화 파라미터를 재생한다. 양자화 파라미터 디코딩 유닛(1302)은 재생된 서브블록 양자화 파라미터를 단자(106)를 통해 밖으로 출력한다. 서브블록 양자화 파라미터 저장 유닛(507)은 서브블록 양자화 파라미터를 저장한다.

도 19는 본 발명의 제6 일례의 실시예에 따른 화상 디코딩 장치에 의한 화상 디코딩 처리를 도시한 흐름도이다.

단계 S101에서, 본 발명의 제2 일례의 실시예와 유사하게, 화상 디코딩 장치는 헤더 정보를 디코딩한다. 단계 S501에서, 화상 디코딩 장치는 디코딩을 겪은 서브블록의 기초 블록이 화상의 제1 기초 블록인 지를 결정한다. 관련 기초 블록이 제1 기초 블록일 때(단계 S501에서 예), 처리는 단계 S502로 진행한다. 그렇지 않으면, 관련 기초 블록이 제1 기초 블록이 아닐 때(단계 S501에서 아니오), 처리는 단계 S504로 진행한다.

단계 S502에서, 화상 디코딩 장치는 디코딩을 겪은 서브블록이 기초 블록의 제1 서브블록인 지를 결정한다. 관련 서브블록이 제1 서브블록일 때(단계 S502에서 예), 처리는 단계 S503으로 진행한다. 그렇지 않으면, 관련 서브블록이 제1 서브블록이 아닐 때(단계 S502에서 아니오), 처리는 단계 S506으로 진행한다. 단계 S503에서, 화상 디코딩 장치는 입력 서브블록 양자화 파라미터와 관련된 코드, 즉, 서브블록 양자화 파라미터 코딩 데이터를 콜롱 코드를 사용해서 디코딩하여 서브블록 양자화 파라미터를 재생한다. 화상 디코딩 장치는 결과 코드를 기초 블록 양자화 파라미터로서 저장한다. 동시에, 화상 디코딩 장치는 다음 기초 블록의 기초 블록 양자화 파라미터의 결정 중에 참조되도록 결과 코드를 따로 저장한다. 그 후, 처리는 제1 서브블록의 디코딩 화상 생성을 위해 단계 S104로 진행한다.

단계 S504에서, 화상 디코딩 장치는 디코딩을 겪은 서브블록이 기초 블록의 제1 서브블록인 지를 결정한다. 디코딩을 겪은 서브블록이 제1 서브블록일 때(단계 S504에서 예), 처리는 단계 S505로 진행한다. 그렇지 않으면, 디코딩을 겪은 서브블록이 제1 서브블록이 아닐 때(단계 S504에서 아니오), 처리는 단계 S506으로 진행한다.

단계 S505에서, 화상 디코딩 장치는 선행 기초 블록의 저장된 서브블록 양자화 파라미터들의 평균을 산출하고, 평균을 기초 블록 양자화 파라미터로서 간주한다. 그 후, 처리는 단계 S506으로 진행한다.

단계 S506에서, 화상 디코딩 장치는 입력 서브블록 양자화 파라미터와 관련된 코드, 즉, 서브블록 양자화 파라미터 차분값 코딩 데이터를 콜롱 코드를 사용해서 디코딩하여 서브블록 양자화 파라미터 차분값을 재생한다. 화상 디코딩 장치는 재생된 서브블록 양자화 파라미터 차분값을 단계 S503 또는 S505에서 저장 또는 산출된 기초 블록 양자화 파라미터에 추가하여 서브블록 양자화 파라미터를 획득한다. 그 후, 처리는 서브블록의 디코딩 화상 생성을 위해 단계 S104로 진행한다. 그 후, 본 발명의 제4 일례의 실시예와 유사하게, 화상 디코딩 장치는 서브블록 디코딩 화상을 생성하고 프레임 화상을 재생한다.

상술된 구성 및 동작들은 제5 일례의 실시예에 따른 화상 코딩 장치에 의해 생성된 기초 블록 양자화 파라미터 값이 코딩되지 않은 비트스트림의 디코딩을 가능케 한다.

상술된 구성 및 동작들은 본 발명의 제2 일례의 실시예와 유사한 효과적인 병렬 처리를 또한 가능케 한다. 구체적으로, 도 9b를 참조하면, 기초 블록 양자화 파라미터 디코딩 대신, 프로세서 A는 선행 기초 블록의 서브블록 양자화 파라미터들을 사용해서 기초 블록 양자화 파라미터 산출을 실행한다. 이는 프로세서 A가 다른 서브블록들에 대한 처리의 완료를 대기하지 않고 모든 서브블록들에 대한 양자화 파라미터 재생을 시작할 수 있게 한다.

제6 일례의 실시예에서, 선행 기초 블록의 서브블록 양자화 파라미터들의 평균이 기초 블록 양자화 파라미터로서 간주되더라도, 제5 일례의 실시예에 따른 기초 블록 양자화 파라미터의 산출 방법이 사용되는 한, 처리는 그렇게 제한되지는 않는다. 물론, 예를 들어, 기초 블록 양자화 파라미터는 서브블록 양자화 파라미터들의 중간값, 또는 가장 빈번한 서브블록 양자화 파라미터 값일 수 있음이 가능하다. 물론, 이러한 정보 조각들은 서브블록 양자화 파라미터 저장 유닛(507)에 저장된 서브블록 양자화 파라미터들로부터 유도될 수 있다.

복수의 산출 방법들이 코딩 측에서 이러한 방법으로 예비되며, 가장 효율적인 기초 블록 양자화 파라미터가 선택되고, 코딩이 관련 산출 방법을 나타내는 코드에 기초하여 실행되더라도, 서브블록 양자화 파라미터가 디코딩을 통해 유사하게 산출될 수 있다.

제6 일례의 실시예가 구체적으로 인트라-예측을 사용해서 프레임들에 기초하여 기술되었지만, 본 일례의 실시예는 예측시 움직임 보상을 수반하는 인터-예측을 사용할 수 있는 프레임들에도 또한 적용될 수 있음이 명백하다.

도 1, 3, 6, 7, 10, 11, 13, 14, 16, 및 18에 도시된 처리 유닛들이 하드웨어로 구현된다는 전제하에 상술된 일례의 실시예들이 구체적으로 기술되었지만, 이 처리 유닛들에 의해 실행된 처리는 소프트웨어(컴퓨터 프로그램)로 구현될 수도 있다.

도 20은 본 발명의 상술된 일례의 실시예들에 따른 화상 디스플레이 유닛에 적용되는 컴퓨터의 일례의 하드웨어 구성을 도시한 블록도이다.

중앙 처리 장치(CPU)(1401)는 랜덤 액세스 메모리(RAM)(1402) 및 판독 전용 메모리(ROM)(1403)에 저장된 컴퓨터 프로그램들 및 데이터를 사용해서 전체 컴퓨터를 제어하고, 상술된 일례의 실시예들에 따른 화상 처리 장치로서 상술된 각각의 조각의 처리를 실행한다. 구체적으로, CPU(1401)는 도 1, 3, 6, 7, 10, 11, 13, 14, 16, 및 18에 도시된 처리 유닛들로서 작용한다.

RAM(1402)은 외부 기억 장치(1406)로부터 로드된 컴퓨터 프로그램 및 데이터, 및 인터페이스(I/F)(1407)를 통해 외부로부터 획득된 데이터를 일시적으로 기억하기 위한 영역을 포함한다. RAM(1402)은 각종 처리 조각들을 실행하기 위해 CPU(1401)에 의해 사용된 작업 영역들을 더 포함한다. 예를 들어, RAM(1402)은 요구되는 대로 프레임 메모리 및 다른 각종 타입들의 영역들로 사용될 수 있다.

ROM(1403)은 컴퓨터의 세팅 데이터 및 부팅 프로그램을 저장한다. 조작 유닛(1404)에 키보드, 마우스 등이 제공된다. 컴퓨터의 사용자는 조작 유닛(1404)을 조작하여 각종 명령들을 CPU(1401)에 제공한다. 출력 유닛(1405)은 CPU(1401)에 의해 실행된 처리의 결과를 디스플레이한다. 출력 유닛(1405)은 액정 디스플레이(LCD) 등의 홀드-타입 디스플레이 유닛 또는 전계 방출형 디스플레이 유닛 등의 임펄스-타입 디스플레이 유닛으로 구성된다.

외부 기억 장치(1406)는 하드 디스크 드라이브 유닛으로 표현된 대용량 기억 장치이다. 외부 기억 장치(1406)는 도 1, 3, 6, 7, 10, 11, 13, 14, 16, 및 18에 도시된 처리 유닛들의 기능들을 구현하기 위해 CPU(1401)에 의해 실행된 운영 체제(OS) 및 컴퓨터 프로그램들을 저장한다. 외부 기억 장치(1406)는 처리될 화상 데이터를 또한 저장할 수 있다.

CPU(1401)는 외부 기억 장치(1406)에 저장된 컴퓨터 프로그램 및 데이터를 RAM(1402)에 적합하게 로드하고, 컴퓨터 프로그램을 실행한다. 근거리 통신망(LAN) 및 인터넷 등의 네트워크들, 영사기, 디스플레이 장치, 다른 장치들이 I/F(1407)에 연결될 수 있다. 컴퓨터는 I/F(1407)를 통해 각종 정보 조각들을 획득 및 송신할 수 있다. 버스(1408)는 상술된 각종 장치들을 상호 연결한다.

상술된 구성들에 따른 동작들은 CPU(1401)가 상술된 흐름도들의 처리를 제어할 때 달성된다.

또한, CPU(1401)가 멀티-코어 구성을 가질 때, 효율적인 병렬 처리가 처리의 각각의 조각의 스레드를 각각의 코어에 할당함으로써 달성될 수 있다.

상술된 기능들을 구현하기 위한 컴퓨터 프로그램 코드들을 기록한 기억 매체가 시스템에 제공되고, 시스템이 컴퓨터 프로그램 코드들을 로드 및 실행할 때, 본 발명이 또한 달성된다. 이 경우에, 기억 매체로부터 로드된 컴퓨터 프로그램 코드들은 일례의 실시예들의 기능들을 구현하고, 컴퓨터 프로그램 코드들을 저장한 기억 매체는 본 발명을 구성한다. 또한, 본 발명은 컴퓨터에서 동작하는 운영 체제(OS)가 컴퓨터 프로그램 코드들의 명령들에 기초하여 실제 처리의 일부 또는 전체를 실행하고, 상술된 기능들이 컴퓨터 프로그램 코드들의 처리에 의해 구현되는 경우를 더 포함한다.

또한, 본 발명은 이하의 형태로 달성될 수 있다. 구체적으로, 본 발명은 기억 매체로부터 로드된 컴퓨터 프로그램 코드들이 컴퓨터에 삽입된 기능 확장 카드 또는 컴퓨터에 연결된 기능 확장 유닛에 제공된 메모리에 기록되는 경우를 더 포함한다. 본 발명은 기능 확장 카드 또는 기능 확장 유닛에 제공된 CPU가 상술된 기능들을 구현하기 위해 컴퓨터 프로그램 코드들의 명령들에 기초하여 실제 처리의 일부 또는 전체를 실행하는 경우를 더 포함한다.

본 발명을 상술된 기억 매체에 적용할 때, 기억 매체는 상술된 흐름도들에 대응하는 컴퓨터 프로그램 코드들을 저장한다.

본 발명이 일례의 실시예들을 참조해서 기술되었지만, 본 발명은 기술된 일례의 실시예들로 제한되지 않음을 알 것이다. 이하의 청구항들의 범위는 모든 수정들, 동등한 구조들, 및 기능들을 망라하도록 가장 광범위한 해석에 부합될 것이다.

본 출원은, 본 명세서에 그 전체가 참조용으로 인용된, 2011년 3월 9일에 출원된 일본 특허 출원 제2011-051267호의 우선권을 주장한다.

Claims (1)

- 화상 코딩 장치로서,

양자화 제어를 받는 복수의 서브블록들로 입력 화상을 분할하도록 구성된 분할 수단;

상기 서브블록들 각각의 양자화 파라미터를 산출하도록 구성된 서브블록 양자화 파라미터 산출 수단;

2개 이상의 서브블록들을 포함하는 기초 블록을 설정하고 상기 기초 블록의 양자화 파라미터를 산출하도록 구성된 기초 블록 양자화 파라미터 산출 수단;

상기 기초 블록의 양자화 파라미터 및 상기 기초 블록에 포함된 각각의 서브블록의 양자화 파라미터 간의 차분값을 산출하도록 구성된 차분값 산출 수단; 및

상기 차분값을 코딩하도록 구성된 차분값 코딩 수단

을 포함하는, 화상 코딩 장치.

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2011051267A JP5875236B2 (ja) | 2011-03-09 | 2011-03-09 | 画像符号化装置、画像符号化方法及びプログラム、画像復号装置、画像復号方法及びプログラム |

| JPJP-P-2011-051267 | 2011-03-09 | ||

| PCT/JP2012/001319 WO2012120823A1 (en) | 2011-03-09 | 2012-02-27 | Image coding apparatus, method for coding image, program therefor, image decoding apparatus, method for decoding image, and program therefor |

Related Parent Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020137025782A Division KR101757960B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020177036582A Division KR101914897B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20150126738A true KR20150126738A (ko) | 2015-11-12 |

Family

ID=46797799

Family Applications (6)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020137025782A KR101757960B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

| KR1020187031165A KR102043580B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

| KR1020187031166A KR102043581B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

| KR1020177036582A KR101914897B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

| KR1020157031390A KR20150126738A (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

| KR1020187031164A KR102043579B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

Family Applications Before (4)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020137025782A KR101757960B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

| KR1020187031165A KR102043580B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

| KR1020187031166A KR102043581B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

| KR1020177036582A KR101914897B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

Family Applications After (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020187031164A KR102043579B1 (ko) | 2011-03-09 | 2012-02-27 | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 |

Country Status (15)

| Country | Link |

|---|---|

| US (6) | US9277221B2 (ko) |

| EP (5) | EP3253060B1 (ko) |

| JP (1) | JP5875236B2 (ko) |

| KR (6) | KR101757960B1 (ko) |

| CN (6) | CN107371037B (ko) |

| BR (1) | BR112013022033B1 (ko) |

| ES (4) | ES2726324T3 (ko) |

| HR (2) | HRP20240876T1 (ko) |

| HU (3) | HUE043625T2 (ko) |

| PL (4) | PL3253060T3 (ko) |

| PT (2) | PT4114003T (ko) |

| RS (2) | RS65679B1 (ko) |

| RU (5) | RU2603500C2 (ko) |

| TR (1) | TR201907745T4 (ko) |

| WO (1) | WO2012120823A1 (ko) |

Families Citing this family (16)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20120016980A (ko) | 2010-08-17 | 2012-02-27 | 한국전자통신연구원 | 영상 부호화 방법 및 장치, 그리고 복호화 방법 및 장치 |

| JP5875236B2 (ja) * | 2011-03-09 | 2016-03-02 | キヤノン株式会社 | 画像符号化装置、画像符号化方法及びプログラム、画像復号装置、画像復号方法及びプログラム |

| KR101442127B1 (ko) | 2011-06-21 | 2014-09-25 | 인텔렉추얼디스커버리 주식회사 | 쿼드트리 구조 기반의 적응적 양자화 파라미터 부호화 및 복호화 방법 및 장치 |

| JP6080375B2 (ja) * | 2011-11-07 | 2017-02-15 | キヤノン株式会社 | 画像符号化装置、画像符号化方法及びプログラム、画像復号装置、画像復号方法及びプログラム |

| US9661329B2 (en) * | 2014-04-30 | 2017-05-23 | Intel Corporation | Constant quality video coding |

| US10715833B2 (en) * | 2014-05-28 | 2020-07-14 | Apple Inc. | Adaptive syntax grouping and compression in video data using a default value and an exception value |

| US10091530B2 (en) | 2014-10-01 | 2018-10-02 | Qualcomm Incorporated | Pipelined intra-prediction hardware architecture for video coding |

| US10499056B2 (en) * | 2016-03-09 | 2019-12-03 | Sony Corporation | System and method for video processing based on quantization parameter |

| US10244167B2 (en) | 2016-06-17 | 2019-03-26 | Gopro, Inc. | Apparatus and methods for image encoding using spatially weighted encoding quality parameters |

| JP6871727B2 (ja) * | 2016-11-29 | 2021-05-12 | キヤノン株式会社 | 撮像装置、画像処理方法、及び、プログラム |

| RU2648581C1 (ru) * | 2016-12-08 | 2018-03-26 | федеральное государственное бюджетное образовательное учреждение высшего образования "Национальный исследовательский университет "МЭИ" (ФГБОУ ВО "НИУ "МЭИ") | Способ кодирования и декодирования видеоинформации пониженной, стандартной и высокой четкости |

| WO2018143289A1 (ja) * | 2017-02-02 | 2018-08-09 | シャープ株式会社 | 画像符号化装置及び画像復号装置 |

| US10750175B2 (en) * | 2017-05-04 | 2020-08-18 | Sony Corporation | Quantization partitioning for enhanced image compression |

| CN107888917B (zh) * | 2017-11-28 | 2021-06-22 | 北京奇艺世纪科技有限公司 | 一种图像编解码方法及装置 |

| CN109660803A (zh) * | 2019-01-22 | 2019-04-19 | 西安电子科技大学 | 一种编码块的量化方法及用于hevc编码的量化方法 |

| JP7524906B2 (ja) * | 2019-10-31 | 2024-07-30 | 株式会社ソシオネクスト | 動画像符号化方法、符号化処理方法、動画像符号化装置および符号化処理装置 |

Family Cites Families (46)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3109854B2 (ja) | 1991-04-23 | 2000-11-20 | キヤノン株式会社 | 画像符号化方法及び装置 |

| KR0183688B1 (ko) | 1994-01-12 | 1999-05-01 | 김광호 | 영상부호화방법 및 장치 |

| JP2001275116A (ja) * | 2000-03-24 | 2001-10-05 | Sharp Corp | 画像処理装置 |

| JP3643777B2 (ja) * | 2001-02-28 | 2005-04-27 | 三洋電機株式会社 | 動画像復号装置および動画像復号方法 |

| KR100450939B1 (ko) * | 2001-10-23 | 2004-10-02 | 삼성전자주식회사 | 이미지 축소를 위한 스케일-다운 기능을 가지는 압축비디오 복호화기 및 방법 |

| US20030123738A1 (en) * | 2001-11-30 | 2003-07-03 | Per Frojdh | Global motion compensation for video pictures |

| JP3715283B2 (ja) * | 2003-02-04 | 2005-11-09 | 株式会社半導体理工学研究センター | 動画像の画像圧縮符号化方法及び装置 |

| KR100965881B1 (ko) * | 2003-10-10 | 2010-06-24 | 삼성전자주식회사 | 비디오 데이터 인코딩 시스템 및 디코딩 시스템 |

| EP1745653B1 (en) * | 2004-01-30 | 2017-10-18 | Thomson Licensing DTV | Encoder with adaptive rate control for h.264 |

| US7460596B2 (en) * | 2004-04-29 | 2008-12-02 | Mediatek Incorporation | Adaptive de-blocking filtering apparatus and method for MPEG video decoder |

| KR100654436B1 (ko) * | 2004-07-07 | 2006-12-06 | 삼성전자주식회사 | 비디오 코딩 방법과 디코딩 방법, 및 비디오 인코더와디코더 |

| CN101069432B (zh) * | 2004-12-02 | 2015-10-21 | 汤姆逊许可公司 | 用于视频编码器速率控制的量化参数的确定方法和设备 |

| JP4146444B2 (ja) * | 2005-03-16 | 2008-09-10 | 株式会社東芝 | 動画像符号化の方法及び装置 |

| KR100677446B1 (ko) * | 2005-03-31 | 2007-02-02 | 엘지전자 주식회사 | 휴대단말기의 영상신호 압축 코딩장치 및 방법 |

| JP4916125B2 (ja) | 2005-04-26 | 2012-04-11 | 株式会社リコー | 画素クロック生成装置、パルス変調装置、および画像形成装置 |

| CN100448295C (zh) * | 2005-05-27 | 2008-12-31 | 中国科学院自动化研究所 | 一种低复杂度的积分码率控制方法 |

| RU2368095C1 (ru) * | 2005-07-22 | 2009-09-20 | Мицубиси Электрик Корпорейшн | Кодер изображения и декодер изображения, способ кодирования изображения и способ декодирования изображения, программа кодирования изображения и программа декодирования изображения и компьютерно-считываемый носитель записи, на котором записана программа кодирования изображения, и компьютерно-считываемый носитель записи, на котором записана программа декодирования изображения |

| WO2007058515A1 (en) * | 2005-11-21 | 2007-05-24 | Electronics And Telecommunications Research Institute | Method and apparatus for controlling bitrate of scalable video stream |

| US20070230564A1 (en) | 2006-03-29 | 2007-10-04 | Qualcomm Incorporated | Video processing with scalability |

| US7911538B2 (en) * | 2006-04-06 | 2011-03-22 | Samsung Electronics Co., Ltd. | Estimation of block artifact strength based on edge statistics |

| US20070280552A1 (en) * | 2006-06-06 | 2007-12-06 | Samsung Electronics Co., Ltd. | Method and device for measuring MPEG noise strength of compressed digital image |

| JP4928176B2 (ja) * | 2006-06-27 | 2012-05-09 | キヤノン株式会社 | 映像符号化装置及び映像符号化方法 |

| TWI311443B (en) * | 2006-07-12 | 2009-06-21 | Novatek Microelectronics Corp | Method of block coding of an image |

| BRPI0621935A2 (pt) * | 2006-07-28 | 2016-09-13 | Toshiba Kk Toshiba Corp | método e aparelho para codificar e decodificar imagem |

| KR101356734B1 (ko) * | 2007-01-03 | 2014-02-05 | 삼성전자주식회사 | 움직임 벡터 트랙킹을 이용한 영상의 부호화, 복호화 방법및 장치 |

| JP4901450B2 (ja) | 2006-12-19 | 2012-03-21 | 株式会社東芝 | 動画像符号化装置 |

| JP2008193627A (ja) * | 2007-01-12 | 2008-08-21 | Mitsubishi Electric Corp | 画像符号化装置、画像復号装置、および画像符号化方法、画像復号方法 |

| WO2008126135A1 (ja) * | 2007-03-20 | 2008-10-23 | Fujitsu Limited | 動画像符号化方法及び装置並びに動画像復号装置 |

| WO2008120577A1 (ja) | 2007-03-29 | 2008-10-09 | Kabushiki Kaisha Toshiba | 画像符号化及び復号化の方法及び装置 |

| US8295633B2 (en) * | 2007-04-04 | 2012-10-23 | Samsung Electronics Co., Ltd. | System and method for an adaptive de-blocking filter after decoding of compressed digital video |

| CN101184221A (zh) * | 2007-12-06 | 2008-05-21 | 上海大学 | 基于视觉关注度的视频编码方法 |

| US20090154567A1 (en) * | 2007-12-13 | 2009-06-18 | Shaw-Min Lei | In-loop fidelity enhancement for video compression |

| EP2081155B1 (en) * | 2008-01-21 | 2011-11-16 | Telefonaktiebolaget LM Ericsson (publ) | Prediction-based image processing |

| US8542730B2 (en) * | 2008-02-22 | 2013-09-24 | Qualcomm, Incorporated | Fast macroblock delta QP decision |

| KR101431545B1 (ko) * | 2008-03-17 | 2014-08-20 | 삼성전자주식회사 | 영상의 부호화, 복호화 방법 및 장치 |

| JP5007259B2 (ja) * | 2008-03-27 | 2012-08-22 | ルネサスエレクトロニクス株式会社 | 画像符号化装置 |

| US8897359B2 (en) * | 2008-06-03 | 2014-11-25 | Microsoft Corporation | Adaptive quantization for enhancement layer video coding |

| CN101309422B (zh) * | 2008-06-23 | 2010-09-29 | 北京工业大学 | 宏块级量化参数处理方法及装置 |

| JP2010035025A (ja) * | 2008-07-30 | 2010-02-12 | Canon Inc | 符号化装置およびその方法 |

| CN101365142B (zh) * | 2008-09-23 | 2011-07-20 | 浙江大学 | 基于图像旋转的深度图像编码方法 |

| KR101458471B1 (ko) * | 2008-10-01 | 2014-11-10 | 에스케이텔레콤 주식회사 | 영상 부호화/복호화 방법 및 장치 |

| JP5094760B2 (ja) * | 2009-02-13 | 2012-12-12 | 三菱電機株式会社 | 動画像符号化装置 |

| CN101783951B (zh) * | 2010-03-02 | 2012-01-04 | 西安交通大学 | 基于人类视觉系统的视频编码帧间预测模式快速确定方法 |

| KR20120016980A (ko) | 2010-08-17 | 2012-02-27 | 한국전자통신연구원 | 영상 부호화 방법 및 장치, 그리고 복호화 방법 및 장치 |

| JP5875236B2 (ja) * | 2011-03-09 | 2016-03-02 | キヤノン株式会社 | 画像符号化装置、画像符号化方法及びプログラム、画像復号装置、画像復号方法及びプログラム |

| JP6415637B2 (ja) | 2017-05-25 | 2018-10-31 | キヤノン株式会社 | 復号装置、復号方法、プログラム及び記憶媒体 |

-

2011

- 2011-03-09 JP JP2011051267A patent/JP5875236B2/ja active Active

-

2012

- 2012-02-27 CN CN201710289107.6A patent/CN107371037B/zh active Active

- 2012-02-27 KR KR1020137025782A patent/KR101757960B1/ko active IP Right Grant

- 2012-02-27 PL PL17176381T patent/PL3253060T3/pl unknown

- 2012-02-27 US US14/003,776 patent/US9277221B2/en active Active

- 2012-02-27 WO PCT/JP2012/001319 patent/WO2012120823A1/en active Application Filing

- 2012-02-27 CN CN201710289109.5A patent/CN107371038B/zh active Active

- 2012-02-27 HR HRP20240876TT patent/HRP20240876T1/hr unknown

- 2012-02-27 HU HUE17176381A patent/HUE043625T2/hu unknown

- 2012-02-27 ES ES17176381T patent/ES2726324T3/es active Active

- 2012-02-27 PL PL22187097.5T patent/PL4114002T3/pl unknown

- 2012-02-27 HU HUE19154507A patent/HUE060431T2/hu unknown

- 2012-02-27 TR TR2019/07745T patent/TR201907745T4/tr unknown

- 2012-02-27 CN CN201710288404.9A patent/CN107197265B/zh active Active

- 2012-02-27 PL PL19154507.8T patent/PL3512199T3/pl unknown

- 2012-02-27 ES ES22187098T patent/ES2974535T3/es active Active

- 2012-02-27 CN CN201710288401.5A patent/CN107371035B/zh active Active

- 2012-02-27 RS RS20240739A patent/RS65679B1/sr unknown

- 2012-02-27 RU RU2015113430/08A patent/RU2603500C2/ru active

- 2012-02-27 KR KR1020187031165A patent/KR102043580B1/ko active IP Right Grant

- 2012-02-27 HU HUE22187098A patent/HUE066522T2/hu unknown

- 2012-02-27 CN CN201280012470.9A patent/CN103416057B/zh active Active

- 2012-02-27 EP EP17176381.6A patent/EP3253060B1/en active Active

- 2012-02-27 EP EP12755119.0A patent/EP2684368B1/en active Active

- 2012-02-27 KR KR1020187031166A patent/KR102043581B1/ko active IP Right Grant

- 2012-02-27 RU RU2013145086/08A patent/RU2551800C2/ru active

- 2012-02-27 ES ES12755119.0T patent/ES2641826T3/es active Active

- 2012-02-27 EP EP22187098.3A patent/EP4114003B1/en active Active

- 2012-02-27 EP EP19154507.8A patent/EP3512199B1/en active Active

- 2012-02-27 CN CN201710288744.1A patent/CN107371036B/zh active Active

- 2012-02-27 PL PL22187098.3T patent/PL4114003T3/pl unknown

- 2012-02-27 ES ES19154507T patent/ES2928850T3/es active Active

- 2012-02-27 RS RS20240473A patent/RS65462B1/sr unknown

- 2012-02-27 PT PT221870983T patent/PT4114003T/pt unknown

- 2012-02-27 HR HRP20240575TT patent/HRP20240575T1/hr unknown

- 2012-02-27 BR BR112013022033A patent/BR112013022033B1/pt active IP Right Grant

- 2012-02-27 KR KR1020177036582A patent/KR101914897B1/ko active IP Right Grant

- 2012-02-27 PT PT221870975T patent/PT4114002T/pt unknown

- 2012-02-27 KR KR1020157031390A patent/KR20150126738A/ko active Application Filing

- 2012-02-27 EP EP22187097.5A patent/EP4114002B1/en active Active

- 2012-02-27 KR KR1020187031164A patent/KR102043579B1/ko active IP Right Grant

-

2016

- 2016-02-03 US US15/014,394 patent/US9716895B2/en active Active

- 2016-10-21 RU RU2016141332A patent/RU2663353C2/ru active

-

2017

- 2017-06-21 US US15/629,475 patent/US9979979B2/en active Active

-

2018

- 2018-05-18 US US15/983,912 patent/US10237568B2/en active Active

- 2018-07-20 RU RU2018126779A patent/RU2686027C1/ru active

- 2018-07-20 RU RU2018126778A patent/RU2688266C1/ru active

-

2019

- 2019-02-14 US US16/276,297 patent/US10567785B2/en active Active

- 2019-02-14 US US16/275,988 patent/US10554995B2/en active Active

Also Published As

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR101914897B1 (ko) | 화상 코딩 장치, 화상을 코딩하는 방법, 화상 디코딩 장치, 화상을 디코딩하는 방법 및 컴퓨터 판독가능 매체 | |

| JP6415637B2 (ja) | 復号装置、復号方法、プログラム及び記憶媒体 | |

| JP6686095B2 (ja) | 復号装置、復号方法、プログラムおよび記憶媒体 | |

| JP6953576B2 (ja) | 符号化装置、符号化方法、プログラムおよび記憶媒体 | |

| JP6150912B2 (ja) | 画像符号化装置、画像符号化方法及びプログラム、画像復号装置、画像復号方法及びプログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A107 | Divisional application of patent | ||

| E902 | Notification of reason for refusal | ||

| E601 | Decision to refuse application | ||

| A107 | Divisional application of patent |