KR20150032789A - 어떤 대상의 자기 동작 추정을 위한 방법 - Google Patents

어떤 대상의 자기 동작 추정을 위한 방법 Download PDFInfo

- Publication number

- KR20150032789A KR20150032789A KR20140123438A KR20140123438A KR20150032789A KR 20150032789 A KR20150032789 A KR 20150032789A KR 20140123438 A KR20140123438 A KR 20140123438A KR 20140123438 A KR20140123438 A KR 20140123438A KR 20150032789 A KR20150032789 A KR 20150032789A

- Authority

- KR

- South Korea

- Prior art keywords

- motion

- top view

- matching

- moving

- image

- Prior art date

Links

- 230000033001 locomotion Effects 0.000 title claims abstract description 125

- 238000000034 method Methods 0.000 title claims abstract description 98

- 239000013598 vector Substances 0.000 claims description 46

- 238000013519 translation Methods 0.000 claims description 40

- 238000004364 calculation method Methods 0.000 claims description 13

- 230000009466 transformation Effects 0.000 claims description 12

- 238000006243 chemical reaction Methods 0.000 claims description 9

- 239000002131 composite material Substances 0.000 claims description 6

- 230000014616 translation Effects 0.000 description 37

- 238000013459 approach Methods 0.000 description 14

- 238000010586 diagram Methods 0.000 description 14

- 230000007704 transition Effects 0.000 description 11

- 238000012937 correction Methods 0.000 description 7

- 239000011159 matrix material Substances 0.000 description 7

- 230000006399 behavior Effects 0.000 description 4

- 230000008901 benefit Effects 0.000 description 4

- 230000000007 visual effect Effects 0.000 description 4

- 238000007796 conventional method Methods 0.000 description 3

- 238000000605 extraction Methods 0.000 description 3

- 230000006870 function Effects 0.000 description 3

- 230000014509 gene expression Effects 0.000 description 3

- 238000012545 processing Methods 0.000 description 3

- 230000009471 action Effects 0.000 description 2

- 230000008859 change Effects 0.000 description 2

- 230000010354 integration Effects 0.000 description 2

- 238000013507 mapping Methods 0.000 description 2

- 230000000877 morphologic effect Effects 0.000 description 2

- 230000008569 process Effects 0.000 description 2

- 239000007787 solid Substances 0.000 description 2

- 230000002159 abnormal effect Effects 0.000 description 1

- 230000008878 coupling Effects 0.000 description 1

- 238000010168 coupling process Methods 0.000 description 1

- 238000005859 coupling reaction Methods 0.000 description 1

- 238000001514 detection method Methods 0.000 description 1

- 230000000694 effects Effects 0.000 description 1

- 238000009434 installation Methods 0.000 description 1

- 230000004807 localization Effects 0.000 description 1

- 238000005259 measurement Methods 0.000 description 1

- 238000010606 normalization Methods 0.000 description 1

- 238000011045 prefiltration Methods 0.000 description 1

- 230000009467 reduction Effects 0.000 description 1

- 230000003252 repetitive effect Effects 0.000 description 1

- 230000004044 response Effects 0.000 description 1

- 230000011664 signaling Effects 0.000 description 1

- 239000013589 supplement Substances 0.000 description 1

- 239000000725 suspension Substances 0.000 description 1

- 230000001131 transforming effect Effects 0.000 description 1

- 230000001052 transient effect Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T3/00—Geometric image transformations in the plane of the image

- G06T3/40—Scaling of whole images or parts thereof, e.g. expanding or contracting

- G06T3/4038—Image mosaicing, e.g. composing plane images from plane sub-images

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/20—Analysing

- G06F18/22—Matching criteria, e.g. proximity measures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T11/00—2D [Two Dimensional] image generation

- G06T11/60—Editing figures and text; Combining figures or text

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G06T7/223—Analysis of motion using block-matching

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G06T7/246—Analysis of motion using feature-based methods, e.g. the tracking of corners or segments

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G06T7/262—Analysis of motion using transform domain methods, e.g. Fourier domain methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/50—Context or environment of the image

- G06V20/56—Context or environment of the image exterior to a vehicle by using sensors mounted on the vehicle

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20048—Transform domain processing

- G06T2207/20056—Discrete and fast Fourier transform, [DFT, FFT]

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20068—Projection on vertical or horizontal image axis

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30248—Vehicle exterior or interior

- G06T2207/30252—Vehicle exterior; Vicinity of vehicle

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Multimedia (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Data Mining & Analysis (AREA)

- Mathematical Physics (AREA)

- Bioinformatics & Cheminformatics (AREA)

- Bioinformatics & Computational Biology (AREA)

- Artificial Intelligence (AREA)

- Evolutionary Biology (AREA)

- Evolutionary Computation (AREA)

- General Engineering & Computer Science (AREA)

- Life Sciences & Earth Sciences (AREA)

- Image Analysis (AREA)

- Closed-Circuit Television Systems (AREA)

- Image Processing (AREA)

Abstract

어떤 표면 위에서 움직이는 어떤 대상의 자기 동작을 추정하기 위한 방법, 상기 표면 위에서 이동하는 상기 대상의 최소한 한 대의 온보드 비디오 카메라가 제공하는 비디오 프레임을 기반으로 한 표면에 대한 최소한 두 합성 톱뷰 영상에서의 생성 (S1)을 포함하는 방법; 상기 이동 대상의 글로벌 동작 매개변수를 추출하기 위해 연속적 톱뷰 영상 사이의 구역 매칭 실행 (S2); 상기 이동 대상의 추출한 글로벌 동작 매개변수에서 상기 이동 대상의 자기 동작 계산 (S3).

Description

본 발명은 어떤 표면 위에서 움직이고 있는 어떤 대상의 자기 동작 추정을 위한 방법과 장치에 관한 것으로서, 특히 온보드 비디오 카메라에서 나온 차량의 자기 동작 추정을 위한 방법에 관한 것이다.

차량과 같은 어떤 대상의 자기 동작은 보통 순간 회전 행렬과 병진 벡터에 의해 표현되는 바, 이러한 요소에서 순간 속도나 평균 속도, 총회전각이나 예상 휠 경로와 같은 그 대상의 사용 분야에서 고유한 다른 특성을 계산할 수 있다.

기존의 시각적인 주행거리 측정은 영상 데이터의 시각적 관찰에서 나온 대상의 동작 정보를 제공한다. 이러한 동작 정보는 속도센서와 조향센서 또는 GPS 시스템과 같은 다른 데이터 시스템에서 나온 데이터를 보완할 수 있다. 지금까지 사용된 영상 주행기록계 추정의 기본적인 접근 방법은 스테레오 카메라에 기반을 둔 동작 기반 구조(Structure-from-motion: SfM)나 동시적 위치 측정 및 매핑(simultaneous localisation and mapping: SLAM), 단안적 SfM이나 SLAM, 직접적인 평면 동작 추정이다.

기존의 스테레오 기반 접근법은 표준 컴퓨터 비전 파이프라인을 사용하여 관찰한 3D 정보 데이터에서 나온 카메라 포즈를 복구한다. 이 접근법을 사용하여서도 3D 포인트 클라우드 사이에서의 변환을 견실하게 있게 추정함으로써 상이한 시점에 카메라 간의 정보를 복구할 수 있다. 스테레오 기반 접근법은 장면 중첩이 낮거나 없는 서라운드 뷰 카메라나 표준 후방 주차 카메라와 같은 단안형 카메라를 사용할 때 적합하지 않다. 이러한 경우에는 대개 단안식 알고리즘이 적용된다. 이러한 단안식 알고리즘은 소위 말하는 동작 기반 스테레오(stereo-from-motion) 접근법을 따르는 바, 이 접근법에서는 장면 포인트의 3D 좌표가 추적 기능에 의해 얻어지고 이때 시간 전체에 걸쳐 분배되는 스테레오 지오메트리를 적용한다. 미지의 변수에 대한 스테레오 보정은, 이 보정이 자기 동작의 다른 해석을 실행하므로, 비율이 없는 스테레오 지오메트리가 되고 따라서 다중 프레임 스테레오 알고리즘을 사용하여 국소적으로 일정한 메트릭 3D 구조를 획득한다. 단안식 카메라는 본질적으로 사영적이기 때문에 장면과 카메라 동작을 일정한 비율로 복구할 수 있다. 그러므로 동작 매개변수의 편차를 보상하기 위해 루프 결합과 같은 여러 동작 구속이 필요하다. 하지만 자동차 분야에서는 대개의 경우 그러한 구속이 사용되지 않는다. 다른 구속은 카메라 사이의 시각적 기능 연합을 요구하는 다중 카메라 설치에서 나오는 바, 이러한 기능 연합은 저중첩 서라운드 뷰 카메라 시스템으로는 실행할 수 없기 때문이다. 또 다른 동작 구속은 장면에 있는 기지의 보정 대상에 의해 나올 수 있다. 자동차 분야에서 널리 사용된 보정 대상은 도로의 표면이다. 도로의 형태를 감지하여 추적하고 평면 동작 구속을 적용함으로써 단안적 SfM 또는 SLAM 알고리즘은 메트릭 자기 동작 데이터를 제공할 수 있다. 도로의 형태 추적에 내재된 또 다른 난점은 도로면의 극히 부정확한 보기로 인한 저급한 구조 정보와 상당히 큰 비율 및 거리 변동이다.

직접적인 평면 동작 추정은 도로 형태의 고급 추적이 극히 어렵기 때문에 기존의 많은 시스템에서 사용되었다. 직접적인 평면 동작 추정법은 영상 정합을 사용하는 바, 이때 어느 한 프레임에서 다른 프레임으로 왜곡시키고 화소 오류를 최소화하는 변환 매개변수를 찾는다. 왜곡을 위해 사용되는 영상 변환은 차량의 자기 동작과 도로면의 사영적 변환으로 만들어진다. 반복적 영상 차이 최소화 알고리즘은 낮은 도로 구조 변동이라는 일반적인 경우에도 미지의 자기 동작을 찾을 수 있는 바, 여기서 형태에 기반한 방법은 충분한 수의 형태를 찾지 못한다. 더 나아가, 기존의 직접적인 평면 동작 추정법의 단점은 장애물에 의해 어두워지거나 움직이는 그림자에 의해 원래의 형태가 훼손되는 도로의 전체 영역을 사용하기 때문에 발생한다. 이러한 경우, 실행된 추정은 국소 최소화 문제에 직면하므로 매개변수의 양호한 초기 근사값이 필요하다.

따라서 표면 위에서 움직이는 어떤 대상의 자기 동작을 추정하는 방법과 장치를 제공하는 것이, 즉 위에서 언급한 단점을 극복하며 어떤 표면 위에서 움직이는 대상의, 특히 차량의 자기 동작을 추정하기 위한 견실하고 신뢰할 수 있는 방법을 제공하는 것이 발명의 목적이다.

이러한 목적은 청구항 1의 특징을 포함하는 방법에 의해 달성된다.

본 발명에 첫 번째 특징에 의해 어떤 표면 위에서 움직이는 어떤 대상의 자기 동작을 추정하기 위한 방법이 제공되는 바, 이에는 다음의 방법이 포함되어 있다:

상기 표면 위에서 움직이는 상기 대상의 최소한 하나의 온보드 비디오 카메라가 제공한 비디오 프레임을 기반으로 한 최소한 두 개의 표면에 대한 합성 톱뷰 영상 생성;

움직이는 대상의 글로벌 동작 매개변수를 추출하는 연속적인 톱뷰 영상 간의 구역 매칭 실행 및

움직이는 대상의 추출한 글로벌 동작 매개변수에서 움직이는 대상의 자기 동작 계산.

본 발명의 첫 번째 측면에 따른 방법에 의해 실현할 수 있는 시스템에 의해, 연속적인 톱뷰 영상 간의 구역 매칭은 형태 매칭으로 이루어진다.

본 발명의 첫 번째 측면에 따른 방법에 의해 다르게 실현할 수 있는 시스템에 의해, 연속적인 톱뷰 영상 간의 구역 매칭은 블록 매칭으로 이루어진다.

본 발명의 첫 번째 측면에 따른 방법에 의해 또 다르게 실현할 수 있는 시스템에 의해, 구역 매칭에 사용된 1D 적분 영상을 제공하는 1D 적분 변환을 실행함으로써 톱뷰 영상이 처리된다.

본 발명의 첫 번째 측면에 따른 방법에 의해 또 다르게 실현할 수 있는 시스템에 의해, 움직이는 대상의 추출한 글로벌 동작 매개변수는 움직이는 대상의 병진 및 회전으로 이루어진다.

본 발명의 첫 번째 측면에 따른 방법에 의해 또 다르게 실현할 수 있는 시스템에 의해, 톱뷰 영상에 있는 어떤 형태의 동작은 큰 톱뷰 구역에서 추정한 글로벌 병진 벡터의 합계와 각 형태를 둘러싼 작은 구역에서 추정한 로컬 병진 벡터의 합계로 분해된다.

본 발명의 첫 번째 측면에 따른 방법에 의해 또 다르게 실현할 수 있는 시스템에 의해, 톱뷰 영상은 표면 위에 있는 샘플 간의 사전에 결정된 거리가 있는 직교 격자에 의해 구성되고 화소값을 구하기 위해 각 샘플을 카메라 영상으로 사영함으로써 구성된 표면의 메트릭 톱뷰 영상에 의해 형성된다.

본 발명의 첫 번째 측면에 따른 방법에 따라 또 다르게 실현할 수 있는 시스템에 의해, 글로벌 동작 매개변수는 상기 구역 매칭이 제공하고 추정자가 선택한 정상값 집합에서 계산된다.

본 발명의 첫 번째 측면에 따른 방법에 따라 또 다르게 실현할 수 있는 시스템에 의해, 이 대상은 평평한 표면 위에서 움직이는 차량에 의해 형성된다.

본 발명은 또한 청구항 9의 특징을 포함하는 장치를 제공한다.

두 번째 측면에 의해, 본 발명은 표면 위에서 움직이는 어떤 대상의 자기 동작을 추정하기 위한 장치를 제공하는 바, 여기에는

표면의 비디오 프레임을 제공하기 위해 조절한, 상기 대상에 부착한 최소한 하나의 온보드 비디오 카메라,

비디오 프레임을 기반으로 표면의 합성 톱뷰 영상을 생성하기 위해 조절한 생성 장치,

상기 대상의 글로벌 동작 매개변수를 추출하는 연속적인 톱뷰 영상 간의 구역 매칭 실행하기 위해 조절한 구역 매칭 장치 및

움직이는 대상의 자기 동작을 상기 이동 대상의 추출한 글로벌 동작 매개변수에서 계산하기 위해 조절한 계산 장치가 포함된다.

본 발명의 두 번째 측면에 따라 실현할 수 있는 장치에서, 이 장치에는 상기 구역 매칭 장치에 의한 구역 매칭에 사용하기 위해 버퍼에 저장한 ID 적분 영상을 제공하는 톱뷰 영상의 1D 적분 변환을 실행하기 위해 조절한 변환 장치도 있다.

본 발명의 두 번째 측면에 따라 실현할 수 있는 또 다른 장치에서는, 글로벌 동작 매개변수가 상기 매칭 장치에 의해 실행된 상기 구역 매칭이 제공하고 추정자가 선택한 정상값 집합에서 계산된다.

본 발명의 두 번째 측면에 따라 실현할 수 있는 장치에서, 이 추정자는 RANSAC 추정자이다.

본 발명의 두 번째 측면에 따라 실현할 수 있는 또 다른 장치에서, 온보드 비디오 카메라는 단안식 카메라이다.

또한 본 발명은 세 번째 측면에 따라 청구항 14의 특징을 포함하는 차량을 제공한다.

본 발명의 이 측면에 의해 차량은, 표면 위에서 움직일 수 있는 경우, 본 발명의 두 번째 측면에 따른 장치를 포함한다.

본 발명의 세 번째 측면에 따라 실현할 수 있는 차량에서, 이 차량은 도로 위에서 움직이는 승용차나 화물차이다.

본 발명의 세 번째 측면에 따라 실현할 수 있는 또 다른 차량에서, 이 차량은 평평한 표면 위에서 움직이는 로봇이다.

이하에서 본 발명의 다른 측면에 따라 실현할 수 있는 시스템을 첨부한 도면을 이용하며 보다 더 자세히 설명하겠다.

도 1은 본 발명의 첫 번째 측면에 따른 어떤 대상의 자기 동작을 추정하기 위한 실현할 수 있는 어떤 방법에 대한 흐름도를 나타낸다;

도 2는 본 발명의 두 번째 측면에 따른 어떤 대상의 자기 동작을 추정하기 위한 실현할 수 있는 어떤 장치에 대한 블록 구성도를 나타낸다;

도 3는 본 발명의 두 번째 측면에 따른 어떤 대상의 자기 동작을 추정하기 위한 실현할 수 있는 어떤 장치에 대한 블록 구성도를 나타낸다;

도 4는 도 3에 도시한 실현된 장치 내에서의 어떤 글로벌 병진 추정 블록을 도시한 도면이다;

도 5는 도 3에 도시한 실현된 장치 내에서의 로컬 병진 추정 블록을 도시한 도면이다;

도 6은 주차 거동 중 본 발명에 따른 방법으로 추정한 자기 동작의 예를 도시하기 위한 도면이다;

도 7은 본 발명에 따라 실현할 수 있는 방법과 장치를 도시하기 위해 서라운드 뷰 카메라의 대표적인 배치에서 나온 톱뷰 부분의 레이아웃이다;

도 8은 본 발명에 따라 실현할 수 있는 방법과 장치에 의해 실행된 바와 같은 형태 매칭을 도시하기 위한 도면이다;

도 9는 본 발명에 따라 실현할 수 있는 장치 및 방법에 의해 실행된 바와 같은 우세한 병진에 의한 톱뷰 구역 동작의 근사값을 도시하기 위한 도면이다;

도 10는 본 발명에 따라 실현할 수 있는 장치 및 방법에서 상이한 시점에서의 톱뷰 구역 간의 추이 추정을 도시하기 위한 도면이다;

도 11은 본 발명에 따라 실현할 수 있는 장치 및 방법에서 실행된 바와 같은 로컬 동작 벡터의 계산을 도시하기 위한 도면이다;

도 1은 본 발명의 첫 번째 측면에 따른 어떤 대상의 자기 동작을 추정하기 위한 실현할 수 있는 어떤 방법에 대한 흐름도를 나타낸다;

도 2는 본 발명의 두 번째 측면에 따른 어떤 대상의 자기 동작을 추정하기 위한 실현할 수 있는 어떤 장치에 대한 블록 구성도를 나타낸다;

도 3는 본 발명의 두 번째 측면에 따른 어떤 대상의 자기 동작을 추정하기 위한 실현할 수 있는 어떤 장치에 대한 블록 구성도를 나타낸다;

도 4는 도 3에 도시한 실현된 장치 내에서의 어떤 글로벌 병진 추정 블록을 도시한 도면이다;

도 5는 도 3에 도시한 실현된 장치 내에서의 로컬 병진 추정 블록을 도시한 도면이다;

도 6은 주차 거동 중 본 발명에 따른 방법으로 추정한 자기 동작의 예를 도시하기 위한 도면이다;

도 7은 본 발명에 따라 실현할 수 있는 방법과 장치를 도시하기 위해 서라운드 뷰 카메라의 대표적인 배치에서 나온 톱뷰 부분의 레이아웃이다;

도 8은 본 발명에 따라 실현할 수 있는 방법과 장치에 의해 실행된 바와 같은 형태 매칭을 도시하기 위한 도면이다;

도 9는 본 발명에 따라 실현할 수 있는 장치 및 방법에 의해 실행된 바와 같은 우세한 병진에 의한 톱뷰 구역 동작의 근사값을 도시하기 위한 도면이다;

도 10는 본 발명에 따라 실현할 수 있는 장치 및 방법에서 상이한 시점에서의 톱뷰 구역 간의 추이 추정을 도시하기 위한 도면이다;

도 11은 본 발명에 따라 실현할 수 있는 장치 및 방법에서 실행된 바와 같은 로컬 동작 벡터의 계산을 도시하기 위한 도면이다;

도 1은 본 발명의 첫 번째 측면에 따라 어떤 표면 위에서 움직이는 어떤 대상의 자기 동작을 추정하기 위한 어떤 방법의 가능한 모범적 실현에 대한 흐름도를 나타낸다; 도 1에서 볼 수 있는 바와 같이 이 방법은 여러 단계로 이루어져 있다. 첫 번째 단계 S1에서는, 표면 위에서 움직이는 대상의 최소한 하나의 온보드 비디오 카메라가 제공한 비디오 프레임을 기반으로 한 최소한 두 개의 표면에 대한 합성 톱뷰 영상이 생성된다. 이 움직이는 대상은 본 발명에 따라 실현할 수 있는 시스템에서 도로 표면 위에서 움직이는 차량일 수 있다. 또한 이 움직이는 대상은 예컨대 평평한 표면 위에서 움직이는 로봇일 수 있다. 차량이나 로봇과 같은 움직이는 대상에는 온보드 비디오 카메라가 있는 바, 이 카메라는 단계 S1에서 각 표면에 대해 최소한 두 개의 합성 톱뷰 영상을 생성한다.

그 다음의 단계 S2에서는, 움직이는 대상의 글로벌 동작 매개변수를 추출하기 위한 연속적인 톱뷰 영상 간에서 구역 매칭이 실행된다. 본 발명에 따라 실현할 수 있는 시스템에서, 움직이는 대상의 추출된 글로벌 동작 매개변수는 움직이는 각 대상의 병진 및 회전으로 이루어질 수 있다. 본 발명에 따라 구현될 수 있는 시스템에서, 단계 S2에서 실행된 연속적 톱뷰 영상 간의 구역 매칭은 형태 매칭이나 블록 매칭으로 이루어질 수 있다.

그 다음 단계 S3에서, 움직이는 대상의 자기 동작은 움직이는 대상의 추출한 글로벌 동작 매개변수에서 계산될 수 있다.

도 2는 본 발명의 두 번째 측면에 따른 해당 장치 1의 블록 구성도를 나타낸다. 도 2의 블록 구성도에서 볼 수 있는 바와 같이, 어떤 표면 위에서 움직이는 대상의 자기 동작을 추정하기 위해 제공된 본 발명의 두 번째 측면에 따른 장치 1에는 상기 대상에 부착되고, 각 대상이 움직이는 표면에 대한 비디오 프레임을 제공하기 위해 조절된 최소한 하나의 온보드 카메라 2가 있다. 또한 장치 1에는 수신한 비디오 프레임을 기반으로 표면의 합성 톱뷰 영상을 생성하기 위해 조절한 생성 장치 3이 있다. 또한 장치 1에는 이동 대상의 글로벌 동작 매개변수를 추출하는 연속적인 톱뷰 영상 간의 구역 매칭을 실행하기 위해 조절한 구역 매칭 장치 4가 있다. 도 2에서 본 바와 같이, 도시한 구현된 시스템에서 본 발명의 두 번째 측면에 따른 장치 1에는 이동 대상의 자기 동작을 이동 대상의 추출한 글로벌 동작 매개변수에서 계산하기 위해 조절한 계산 장치 5가 있다.

도 3은 본 발명의 두 번째 측면에 따라 어떤 표면 위에서 움직이는 어떤 대상의 자기 동작을 추정하기 위한 장치 1의 어떤 모범적 구현된 시스템을 도시한다. 도 3의 모범적 구현된 시스템에서, 장치 1에는 서라운드 뷰 시스템의 네 온보드 카메라 2-1, 2-2, 2-3 및 2-4가 있다. 움직이는 대상 근처의 표면을 관찰하는 온보드 비디오 카메라의 대수 2-i는 다를 수 있다. 움직이는 대상 근처의 표면 또는 도로를 관찰하는 보정된 카메라의 대수는 얼마만큼이라도 적절할 수 있다. 도 3에서 도시한 실현된 시스템에서는, 해당 스위치 6-1, 6-2, 6-3 및 6-4를 사용하여 온보드 비디오 카메라를 도 3에 도시된 바와 같이 카메라 보정 장치 8에 연결될 수 있는 톱뷰 변환 장치 7로 전환시킬 수 있다. 각 온보드 비디오 카메라 2-i는 톱뷰 영상의 각 부분을 생성한다. 이 부분 간의 중첩은 필요하지 않다. 그러므로 영상 해상도가 가장 좋은 영역을 선택할 수 있다. 이에 대한 요건은 각 톱뷰 부분이 표면 또는 도로면에 있는 글로벌 그리드에 맞추어 조절되는 것이다. 본 발명에 따라 구현할 수 있는 시스템에서, i 번째 톱뷰 부분 Pi의 (n, m) 번째 화소는 도로면이나 표면에 있는 3D 점에 해당한다:

여기서 (ni,mi)은 톱뷰 부분의 원점에 대한 정수 좌표이고, Ni, Mi은 톱뷰 부분의 크기이며, d는 톱뷰 영상 화소의 지상 해상도이다. 이 3D 점은 다음의 등식에 의한 보정 매개변수를 사용하여 지상 영상에 사영되는 바, 이 등식에 대해서는 아래에서 자세히 기술하겠다:

사영된 화소의 보간된 화소값은 톱뷰 화소 p로 지정된다. 본 발명에 따른 가능한 구현에서는 매개변수를 다음과 같이 선택할 수 있다:

d = 1cm

N1 = N4 = 512; M1 = M4 = 256;

N2 = N3 = 256; M2 = M3 = 512.

모서리 (ni,mi)의 위치는 영상이 최고의 해상도를 갖도록 하기 위해 카메라를 그 구역 위의 중앙에 놓는다. 고속 푸리에 변환 FFT에 의한 구역 매칭 알고리즘을 가장 빠르게 실행하기 위해 상수 Ni를 선택한다.

본 발명에 의해 실현할 수 있는 또 다른 시스템에서는 톱뷰 영상이 사용자 인터페이스의 구성품으로서 장착된 기존의 서라운드 뷰 시스템에 의해 만들어진다. 이렇게 실현된 시스템에서는 합성 톱뷰 영상이 직사각형 형태이고 알고리즘에 의해 사용된 구역은 합성 톱뷰 영상에서 가져온 것이다.

도 7은 움직이는 승용차에 장착된 서라운드 뷰 카메라의 전형적인 배치에서 나온 톱뷰 부분의 레이아웃이다. 도 7의 검은색 삼각형은 온보드 비디오 카메라 2-i의 모범적인 가능한 위치를 나타낸다. 7에 도시한 직사각형은 해당 톱뷰 부분을 가리킨다.

각 온보드 비디오 카메라 2-i에서 톱뷰 영상을 생성한 후 신뢰할 수 있는 형태 매칭을 보증하도록 영상의 질을 향상시키기 위해 기존의 방법을 사용할 수 있다. 이러한 기존의 방법 중 하나는 로컬 히스토그램 균등법이지만, 이와 유사한 다른 알고리즘도 사용할 수 있다. 도 3에 도시된 바와 같이 톱뷰 변환 장치 7이 1D 적분 영상을 제공하는 톱뷰 영상의 1D 적분 변환을 실행하기 위해 조절된 변환 장치 9에 연결되어 있는 바, 이 적분 영상을 버퍼 10에 저장하여 이 영상을 장치 1의 구역 매칭 장치 4에 의한 구역 매칭에 사용할 수 있다. 변환 장치 9는 신속한 형태 추출과 매칭에 필요한 톱뷰 영상의 다른 식을 만들기 위해 처리 단계를 실행한다. 이하에서는, 이 식만을 1D 적분 영상 집합으로서 사용하므로 본 발명에 따른 가능한 실현에서 원래의 톱뷰 영상을 폐기할 수 있다. 본 발명에 따라 구현된 또 다른 시스템에서는 톱뷰 영상을 위한 메모리를 할당하지 않고 적분 영상을 계산할 수 있다. 본 발명에 따라 실현할 수 있는 시스템에서는, 톱뷰의 각 후속 화소를 계산한 후 아래에 설명한 바와 같이 적분 영상을 업데이트하기 위해 직접 이 계산을 사용할 수 있다.

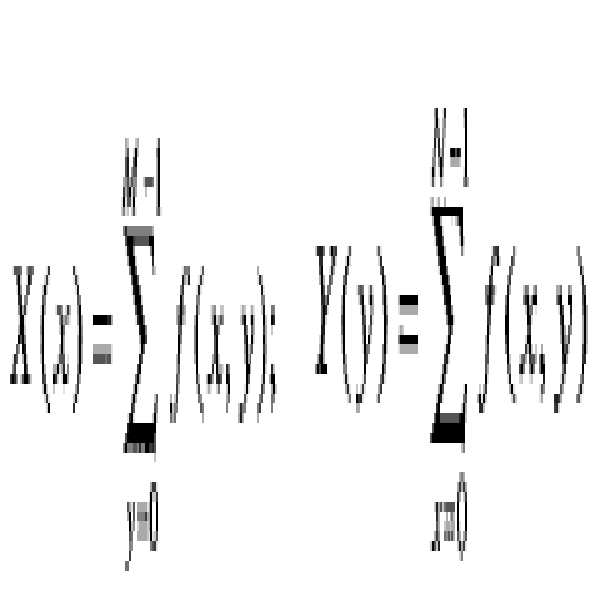

1D 적분 영상은 기존의 2D 적분 영상과 유사하다. 1D 적분 영상에는 현재의 화소를 포함하여 현재의 영상까지 행이나 열에 있는 합계를 포함하고 있다. 행 형태 및 열 형태의 적분 영상을 다음과 같이 정의할 수 있다:

여기서 f(x,y)는 입력 영상, 톱뷰 영상이고 Ir(-1,y) = Ic(x,-1) = 0이다. 기존의 2D 적분 영상과 유사하게 이 1D 적분 영상은 행이나 열에 있는 화소의 합계를 신속하게 계산하는데 사용된다:

본 발명에 따라 실현할 수 있는 시스템에서, 적분 영상을 적분 영상 저장소 10에 저장할 수 있는 바, 이 저장소는 길이 r의 링 버퍼에 의해 형성될 수 있으므로 각 프레임 n에서 프레임 n과 n-k 간의 형태 매칭을 위해 이전 프레임 n-1, n-2 ..., n-r+1의 식을 회복할 수 있다.

도 3에 도시한 바와 같이 이전 프레임 n-k과 현재 프레임 n을 구역 매칭 장치 4에 공급한다. 장치 1의 구역 매칭 장치 4는 이동 대상의 글로벌 동작 매개변수를 추출하는 연속적인 톱뷰 영상 간의 구역 매칭을 실행하기 위해 조절된다. 변환 장치 9는 매칭 장치 4에 의해 사용되도록 버퍼 10에 저장된 1D 적분 영상을 제공하기 위해 톱뷰 영상의 1D 적분 변환을 실행한다. 본 발명에 따라 실현할 수 있는 장치에서는, 상기 구역 매칭 장치 4가 제공하고 구역 매칭 장치 4의 출력 부에 연결된 추정자 11이 선택한 정상값 집합에서 글로벌 동작 매개변수를 계산한다. 본 발명에 따라 실현할 수 있는 시스템에서 추정자 11은 RANSAC 추정자이다. 장치 1의 계산 장치 5는 추정자 11이 제공한 움직이는 대상의 추출한 글로벌 동작 매개변수에서 움직이는 대상의 자기 동작을 계산하기 위해 조절된다.

이하에서 본 발명에 따른 방법과 장치에서 채용한 자기 동작 추정 전략을 좀 더 자세히 기술하겠다.

톱뷰 영상의 동작은 세 요소로 구성되어 있는 바, 이 요소는 차량의 정향 축에 따라 움직이는 차량 동작에 의한 병진, 순간 회전축의 중심으로 한 회전 및 차량의 수직 동작에 의한 왜곡으로 이루어져 있다.

본 발명에 따른 방법과 장치에서는 차량의 평면 동작에 의해 그 동작의 왜곡 요소를 무시할 수 있는 것으로 간주된다. 도 8b에서 도시한 바와 같이, 선회하는 차량의 평면 동작을 순간 회전 중심을 중심으로 한 원형 동작으로 기술할 수 있다. 또한 차량의 직선 동작을 반경이 무한한 원형 동작으로서 해석할 수도 있다. 차량이 원형 동작을 하는 동안, 상이한 톱뷰 부분이 순간 회전 중심을 중심으로 회전하고 상이한 거리로 이동하는 바, 즉 도 8에 도시한 바와 같이 외측 부분이 내측 부분보다 더 많이 이동한다. 이러한 경우, 형태/블록 매칭 알고리즘을 위한 일반적인 매개변수를 사용하면 틀린 로컬 동작 벡터가 많이 나오게 된다. 예를 들어, 너무 멀리 이동하지 않는 내측 부분 (도 8b의 좌측 구역)에 대한 넓은 검색 영역을 고려할 때 형태/블록은 틀린 매칭의 개연성을 높이는 더 많은 후보에 매칭되어야 한다.

도 8a는 상이한 시점(프레임 n-1 및 n)에 해당하는 톱뷰 영상을 나타낸다. 자기 동작에 대한 사전 지식 없이 프레임 n-1(도 8a에서 원으로 표시)에서 프레임 n에서의 형태를 찾기 위해서는 넓은 검색 영역을 사용해야 한다 (도 8a의 점선 직사각형으로 표시).

도 8b는 차량의 회전에 대한 톱뷰 구역의 평면 동작을 나타낸다. 실선 직사각형과 점선 직사각형은 각각 톱뷰 구역의 처음 위치 및 새 위치를 나타낸다. 상이한 톱뷰 구역은 상이한 거리를 이동한다. 그러므로 잠재적인 오매칭을 배제하기 위해 본 발명에 따른 가능한 실현에서는 형태 매칭을 위한 검색 영역을 각 톱뷰 구역에 대해 개별적으로 조절할 수 있다.

속도 및 정확성 문제에 대처하기 위해 본 발명에 따른 방법과 장치에서는 구역 매칭 접근법을 사용하는 바, 이 접근법은 다음의 요소로 이루어져 있다. 한 요소는 독립된 구역을 사용하는 것인 바, 즉 각 톱뷰 부분의 동작이 (도 8a에 도시된 바와 같이) 독립적으로 접근하여 짧게 이동하는 부분이 멀리 이동하는 부분을 제한하지 않도록 하고 그 역인 경우도 마찬가지가 되도록 하는 것이다. 구역 매칭 접근법의 또 다른 요소는 대략 대 정밀 매칭 접근법의 사용이다. 첫째 (도 8에 표시한 바와 같이) 톱뷰 부분 전체를 사용하여 우세한 병진을 계산한 다음 도 11에 도시한 바와 같이 보다 더 작은 블록을 사용하여 로컬 동작 벡터를 반복적으로 개선한다. 구역 매칭 접근법의 또 다른 요소는 블록 매칭의 사용이다. 사전에 결정된 위치를 형태 위치로서 사용하고, 계산의 측면에서 비용이 많이 드는 관심점 기반 형태 추출 알고리즘을 피하는 적분 기술자를 계산하기 위해 직사각형 영상 패치를 사용한다. 끝으로 구역 매칭 접근법은 제한된 검색 구역을 사용한다. 도 8b와 도 11에서 도시한 바와 같이 가능한 오매칭을 방지하기 위해 블록 크기와 같은 작은 검색 영역을 사용한다.

도 9a 및 9b는 우세한 병진에 의한 톱뷰 구역 동작의 접근을 도시한다. 도 9b에서 알 수 있는 바와 같이 프레임 n-1(실선 직사각형)에 있는 각 구역의 알려지지 않은 동작이 병진에 의해 접근하여 (화살표로 도시) 다음 프레임 n에 있는 구역의 위치가 점선 직사각형에 도시한 바와 같이 프레임 n-1의 좌표계에서 대체적으로 알려진다. 중첩 영역(회색 직사각형)에는 이 두 프레임에서 보이는 형태가 있다.

도 9b에 표시한 바와 같이 프레임 n-1에서 나온 형태의 위치(원으로 표시)는 우세한 병진을 사용하여 프레임 n에서 대체로 알려진다. 형태를 정확하게 매치하기 위해 도 8a와 비교하여 더 작은 검색 영역 (도 9b의 굵은 실선 직사각형)이 필요하다. 겹친 구역(회색 직사각형)에서 나온 형태만을 고려한다.

본 발명에 따라 구현할 수 있는 시스템에서는 블록 매칭을 실행하기 위해 위상 상관법을 채용한다. 비디오에서 사영 기반의 병진적 동작 추정의 효율성은 널리 알려져 있다. 빠른 카메라 동작에 의해 영상이 흐린 경우와 독립된 로컬 동작이 있는 경우에도 신뢰할 수 있는 결과를 얻는다. 예를 들어 영상 크기가 NxM인 영상 f(x,y)에 대해 1D 사영을 다음과 계산할 수 있다:

영상 f1과 f2 사이의 병진 벡터의 요소를 해당 사영 사이의 추이로서 독립적으로 얻을 수 있다. 본 발명에 따라 실현할 수 있는 시스템에서는 위상 상관법 PCM의 1D 변종에 의해 X1(x)와 X2(x) 사이의 그러한 추이 Δx를 계산할 수 있다. 위상 상관법 PCM은 푸리에 변환의 추이 정리를 사용한 X1(x) = X2(x + Δx)라는 가정에서 유도된다. 위상 상관법 PCM에서는 신호 사이의 미지의 추이를 다음과 같이 계산할 수 있다:

여기서 FFT와 IFFT는 각각 순방향 및 역방향 푸리에 변환이고, *는 켤레 복소수이며 w(X)는 비주기적 신호에 의한 주파수 가공물을 줄이기 위해 흔히 사용되는 신호 창구화(windowing)이다. 신호에 대한 모든 연산, 즉 곱셈, 나눗셈 및 등급 지정을 샘플 방식으로 실행할 수 있다. 다른 쌍의 사영 Y1(y)와 Y2(y)를 사용하여 다른 추이 요소 Δy를 이와 유사하게 결정할 수 있다.

도 10은 다른 시점에 실행한 톱뷰 구역 간의 추이 추정을 도시한다. fn-1과 fn은 비디오 프레임 n-1과 n에 해당하는 톱뷰 영상이다. Yn-1과 Yn은 그 사영, 예컨대 수직 사영이다. 도 10의 우측에서 알 수 있는 바와 같이 사영 사이의 추이는 그 위상 상관의 글로벌 최대의 위치에서 감지된다. 글로벌 및 로컬 구역 매칭을 위해 동일한 방법을 사용할 수 있다.

본 발명에 따라 실현할 수 있는 방법 및 장치에서는 적분 영상을 사용함으로써 위상 상관법 PCM을 확장하여 그 사영을 다음과 같이 효율적으로 계산할 수 있다:

이와 유사하게 화소 g(x,y)의 직사각형 블록에 대해,

0 ≤ x1 ≤ x ≤ x2 ≤ N-1, 0 ≤ y1 ≤ y ≤ y2 ≤ M-1:

위상 상관법 PCM의 다른 변형은 상기 등식의 등가적 식에서 나온다:

여기서 D(X)와 D(Y)는 블록 사영의 정상화된 푸리에 변환을 표시하는 블록 기술자이다:

이러한 블록 기술자의 장점은 향후 계산할 때 다시 사용할 수 있다는 점이다. 수신되는 신호 X1, X2 및 X3을 매치할 수 있으면 그 기술자 D(X1), D(X2) 및 D(X3),... 등을 한 번에 계산하여 도 3에 표시한 링 버퍼 10에 저장할 수 있다. 추이값을 계산하기 위해 버퍼 10에서 블록 기술자를 회복하여 하나의 푸리에 변환과 기존의 직접적인 접근법과 비교하는 그 정상화를 저장할 수 있다.

위상 상관법 PCM이 사용한 블록 매칭에는 어떤 검색 전략이 필요하지 않다. 특정한 블록 g1에 대해 단 하나의 단일 블록 g2만을 사용하여 추이값의 범위를 블록 크기로 제한한다. 그러한 제한 없이 로컬 동작 벡터를 계산할 수 있도록 하기 위해, 본 발명에 따른 방법과 장치의 가능한 실현에서는 대략 대 정밀 전략을 사용한다. 첫째 톱뷰 부분 전체를 사용하여 우세한 병진을 계산한 다음 도 9와 11에 도시한 바와 같이 보다 더 작은 블록을 사용하여 로컬 동작 벡터를 반복적으로 개선한다.

본 발명에 따른 방법 및 장치에서 선호하는 가장 빠른 실행에서는 작은 비중첩 블록으로 단 하나의 반복적인 개선만을 사용하는 바, 예를 들어 32×32 화소를 사용한다. 또한 이러한 접근법은 순간 차량 병진이 그 정향에 맞추어 조절된다는 것을 의미하는 비홀로노믹 동작 구속에서 나온다.

도 11a와 11b는 본 발명에 따른 장치 1의 구역 매칭 장치 4가 실행한 바와 같은 로컬 동작 벡터 계산을 도시한다. 도 11b에서 볼 수 있는 바와 같이, 중첩 구역(회색 직사각형)은 블록의 직교 격자로 나누어질 수 있다. 글로벌 병진 보상에 의해 해당 블록이 이미 프레임 n-1과 n에서 조절될 수 있다. 동작 벡터의 계산이 끝나면 블록 내에서의 로컬 병진의 추정이 이루어진다.

도 11b에서 볼 수 있는 바와 같이 최종적인 동작 벡터는 글로벌 동작 벡터와 로컬 동작 벡터의 합계이다. 글로벌 벡터는 중첩 구역이 병진하게 하므로 프레임 n-1(직교 격자의 실선 직사각형)에서 나온 모든 블록은 동일한 벡터에 의해 새 위치(점선 직사각형)으로 이동한다. 로컬 병진은 블록을 예측한 위치에서 프레임 n(비직교 격자의 실선 직사각형)의 실제 위치로 이동시킨다.

우세한 병진은 중첩의 직사각형 영역을 결정하고 이 영역 내에서만 로컬 동작 벡터를 계산한다. 본 발명에 따른 방법과 장치에서는 도 11에서 도시한 바와 같이 중첩 영역에 위치한 블록의 직교 격자를 사용하므로 영역 전체가 동작 추정 과정에 사용되는 것을 보장하게 된다. 대개의 경우 변하지 않는 영상 구역에서 나온 비정보적 블록은 틀린 동작 벡터가 된다. 단순한 임계 기준을 사용하여 그러한 블록을 일정한 신호(잡음까지)에 사영하는 것을 감지하여 여과할 수 있다.

여기서 t는 임계값이다.

도 4는 본 발명에 따른 장치 1의 구역 매칭 장치 4 내부에서 글로벌 병진 추정 블록의 가능한 실현에 관한 블록 구성도이다. 표시한 실현된 시스템에서 글로벌 병진 추정 블록에는 블록 기술자 D를 저장하는 기술자 저장소에 대한 접근로가 있다. 도 4에 도시한 바와 같은 글로벌 병진 추정 블록은 구역 사영 계산과 구역 기술자 계산을 실행하기 위해 조절된 다음 블록 기술자가 도 4에 도시한 바와 같이 기술자 보관소에 저장된다. 사영 상관 후 상관 최대 검색이 실행된다.

도 5는 본 발명에 따른 장치의 구역 매칭 장치 4의 내부에서 로컬 병진 추정 블록의 가능한 실현에 관한 블록 구성도이다. 도 5에서 볼 수 있는 바와 같이, 구역 사영 계산이 먼저 실행된 다음 구역 기술자를 계산한다. 그 다음 각 구역이 동일한지 점검한다. 각 구역이 동일하지 않으면 사영 상관을 실행한 후 상관 최대 검색이 이루어진다. 각 구역이 동일한 것으로 감지되면 이는 동작이 없다는 것을 의미한다.

사용할 수 있는 각 톱뷰 부분에서 동작 벡터를 독립적으로 추출한 후 모든 벡터를 사용하여 글로벌 동작을 복구한다. 독립적으로 움직이는 대상에 기인하거나 신뢰할 수 없는 블록 매칭으로 인해 동작 벡터에 대개 이상값이 포함된다. 이상값은 예컨대 도로의 측면에 있는 지주에 의해 야기될 수 있다. 비디오에서 글로벌 동작을 복구하는 기존의 방법은 동작 모델을 각 동작 벡터에 맞추어 확실히 조절하는 것이다. 본 발명에 따른 방법과 장치의 가능한 실현에서, 두 개의 자기 동작 모델을 사용하는 바, 이에는 순수한 병진 모델과 회전 병진 모델이 포함된다. 본 발명에 따른 방법과 장치로 정상값의 개수를 최대화하는 하나의 모델을 최종 결과로서 선택할 수 있다. 본 발명에 따라 실현할 수 있는 시스템에서는 도 3에 표시한 RANSAC 추정자 11이 임의의 표준 벡터에서 계산한 동작 매개변수와 일치하는 정상값을 효율적으로 선택할 수 있다. 가장 작은 표본 크기를 사용하는 바, 즉 순수한 병진에 대해서는 하나의 벡터를, 그리고 회전 병진에 대해서는 두 개의 벡터를 사용한다.

평면 동작 모델을 사용하고 도로면이 알려진 거리와 방향을 향하여 위치해 있기 때문에 사용한 모델에 적합한 알고리즘이 큰 이상값 대상을 인식하지 않을 수 있다. 이 경우, 그 모델은 자기 동작의 출력 매개변수를 차례로 왜곡할 수 있는 두 도로 및 비도로 동작 벡터에 맞추어 조절된다. 그러한 상황의 예는 도로면 위에 있는 보행자의 보행과 연석일 수 있다. 보행자의 보행에서 나온 큰 동작 벡터는 톱뷰 영상의 한쪽 면에 집중되어 있는 바, 이 영상도 도 8b와 유사하게 회전 동작으로서 해석할 수 있다. RANSAC 추정자 11은 동작 벡터를 과잉으로 맞추어 큰 회전 성분을 출력할 수 있다. 본 발명에 따라 실현할 수 있는 시스템에서, 모델화된 대상이 확실히 감지되어 그 동작 벡터가 동작 추정에서 배제된다. 예를 들어 응용 알고리즘을 사용하여 연석 감지를 실행할 수 있다. 예를 들어 차량과 같이 움직이는 대상이 직선을 따라 이동하고 있지만 추정된 자기 동작이 연석으로 인해 편향되면, 보행자의 보행에 있는 큰 동작 벡터를 회전 동작으로서 해석할 수 있다. 해당 온보드 비디오 카메라 2을 꺼서 연석 구역을 처리에서 배제할 수 있다. 정밀한 자기 동작을 모든 온보드 비디오 카메라 2에서 추출할 수 있다. 본 발명에 따른 가능한 실현에서 해당 시스템이 연석을 자동으로 감지하고 그 영역을 자기 동작의 계산에서 배제할 수 있다.

본 발명에 따라 실현할 수 있는 시스템에서는 위상 상관법 PCM을 사용하여, 예를 들어 도 3에 도시한 장치 1의 구역 매칭 장치 4 내에 있는 글로벌 병진 블록에 의해 톱뷰 부분 사이의 우세한 병진을 계산할 수 있다. 이 계산 단계는 각 쌍의 톱뷰 구역에 대해 사영이 현재의 프레임 n에 대해 적분 영상을 사용하여 구역 전체에서 계산되는 것을 포함한다. 그 다음 향후 사용하기 위해 글로벌 병진 추정 장치가 구역 기술자를 계산하여 저장할 수 있다. 이전 프레임 n-1의 구역 기술자를 회복할 수 있으며 글로벌 병진 추정 장치에 의해 구역 사영 사이의 위상 상관을 실행할 수 있다. 마지막으로 위상 상관 곡선의 위치를 검색하여 구역 사이의 수평 및 수직 추이를 획득할 수 있다.

중첩 영역에서 나온 정보 블록을 선택하고 PCM을 사용하여 로컬 동작 벡터를 계산한다. 구역 매칭 장치 4의 로컬 병진 블록에 의해 위상 상관 점수가 낮은 동작 벡터를 버린다. 도 5에서도 도시한 이러한 절차는 도 4에서 도시한 글로벌 병진 추정과 유사한 바, 이 도면에는 그 구역이 동일한가를 점검하는 정보 블록 선택이라는 추가적인 단계가 있다.

로컬 동작 벡터를 이용하여 톱뷰 부분의 글로벌 병진이 합산되어 최종적인 동작 벡터를 구한다. RANSAC 추정자 11은 사용할 수 있는 모든 톱뷰 부분에서 동작 벡터에 대한 추정을 실행함으로써 이상값을 감지한다. 추정자 11은 RANSAC 정상값을 사용하여 글로벌 동작 매개변수의 추정을 실행한다.

본 발명에 따라 선택적으로 구현할 수 있는 시스템에서는, 도로 외 영역에서 나온 동작 벡터를 배제하기 위해 연석 가정이나 수직 대상 위치와 같은 다른 감지기에서 나온 입력 정보를 포함시킬 수 있다. 본 발명에 따라 실현할 수 있는 이러한 시스템에서 감지기 12는 도 3에서 도시한 바와 같이 장착된다. 더 나아가 본 발명에 따라 선택적으로 구현할 수 있는 시스템에서는 톱뷰 부분 사이의 중첩 영역을 다시 추정하기 위해 글로벌 동작 변환을 사용할 수 있다. 이는 도 3에 도시한 구역 매칭 장치 4 내에 있는 예측 블록에 의해 실행될 수 있다. 톱뷰 영상의 평면 동작 행렬을 복구한 후 그 역행렬이 움직이는 대상의 자기 동작을 나타낸다.

본 발명의 여러 측면에 따른 방법과 장치는 온보드 카메라 2-i가 자신의 위치에서 포착한 비디오 프레임을 사용하여 인접한 두 대상 위치 사이에 있는 2D 변환의 메트릭 매개변수를 추정할 수 있다. 본 발명에 따른 방법과 장치의 장점은 너무 많은 컴퓨터 계산 자원을 사용하지 않고 신뢰할 수 있으며 빠른 추정을 할 수 있도록 한다는 점이다.

따른 발명에 따라 구현할 수 있는 시스템에서 온보드 비디오 카메라 2-i는 단안식 카메라이다. 따라서 본 발명에 따른 방법에서는 더 비싼 스테레오 장비 대신 단안식 카메라를 사용할 수 있다. 본 발명에 따라 실현할 수 있는 시스템에서, 본 발명에 따른 방법과 장치는 단지 두 비디오 프레임에서 나온 메트릭 자기 동작 매개변수를 제공하는 바, 따라서 로컬 병진 비율과 글로벌 모델 비율을 추정하기 위해 컴퓨터 계산을 많이 해야 하는 멀티 프레임 SfM이나 SLAM 알고리즘을 사용하지 않는다.

본 발명에 따른 방법과 장치는 직접 영상 등록을 사용하지 않으므로 컴퓨터 계산을 많이 해야 하는 반복적 영상 왜곡 방법을 사용하지 않는다.

더 나아가 본 발명에 따른 방법과 장치에서는 여러 대의 카메라를 이용할 수 있으므로 여러 방향에서 나온 시각 데이터를 융합하여 추정된 매개변수의 질을 개선할 수 있다. 여러 온보드 카메라 2-i의 카메라 뷰 사이에 중첩 구역이 있어야 할 필요가 없다. 그러므로 각 이동 대상에 이미 장착된 기존의 서라운드 뷰 카메라를 어떤 카메라라도 사용할 수 있다.

본 발명에 따른 방법과 장치에서는 도로면이나 표면의 방정식이 각 온보드 카메라의 좌표계에 있는 이동 대상의 근처에서 알려진다고 가정한다. 이는 표면에 있는 어떤 3D 지점 P = (X,Y,Z)를 카메라의 센서 면에 사영하여 그 화소 좌표 p = (x,y)를 구할 수 있다는 것을 의미한다. 본 발명에 따라 구현할 수 있는 시스템에서는 온보드 카메라의 외재적 및/또는 내재적 보정에 의해 이 방정식에 도달할 수 있다:

여기서 Rc는 도로면을 고려한 카메라 센서면의 3×3 회전 행렬이고, tc 는 차량 좌표계의 원점을 고려한 카메라 중심의 병진이며 Kc은 카메라의 중심에서 나온 광선을 이 센서의 화소에 매핑하는 내재적 보정 함수이다. 핀홀 카메라의 경우, 이것은 상삼각행렬과의 곱셈이다. 어안 카메라의 경우, 이것은 비선형 다항 함수이다.

본 발명에 따라 가능한 시스템에서는, 차량 응용 프로그램에서 수평적 도로면 Z = 0을 고려한 카메라 2-i의 보정을 실행하는 것이 편리하다. 주행 중 이러한 상태가 차량 아래와 그 인근에서 유지되며, 따라서 그러한 도로 부분을 카메라 2-i가 관찰할 수 있다. 본 발명에 따라 가능한 시스템에서, 이는 하향주시형 카메라(예: 표준 후방 주차 카메라)나 시야각이 넓은 서라운드 뷰 어안 카메라에 의해 실현될 수 있다.

본 발명에 따른 방법과 장치에서는 대상의 동작이 평면적이라고 가정한다. 그러므로 동작의 수직 요소는 모델화되지 않고 추정되지 않는다. 이 가정에서는 기존의 모델에서 나온 도로 시설물(과속 방지턱)의 서스펜션 효과를 배제한다. 수직 3D 좌표를 배제함으로써 본 방법의 출력은 다음과 같이 두 위치 Pk-1 및 Pk 사이의 2D 변환 Tk로 도시된다:

Pk = TKPK-1

여기서 Pk는 다음과 같이 동일한 좌표에서 Pk = [Xk Yk 1]T이고, 변환 행렬 Tk는 2D 회전 Rk과 병진 tk로 구성된다:

차량이 이동하는 동안 차량 지점 P0의 메트릭 경로에서 나온 이러한 항은 이동하는 대상(차량)의 로컬 좌표계에 주어진다. 도 6은 차량이 주차 거동을 하는 동안의 자기 동작을 본 발명에 따른 방법으로 추정한 예를 나타낸다. 도 6에서 차량의 윤곽은 톱뷰 사영을 사용한 직사각형으로 표시된다. 최초의 차량 직사각형 P0는 구성된 자기 동작 행렬 Tk,k-1에 의해 변형된다. 이미 어느 한 프레임에서 다른 프레임으로의 파라메트릭 변형을 계산하는 방법이 있다. 기존의 이 방법과 본 발명에 따른 방법의 차이점은 기존의 방법이 카메라 동작의 메트릭 정보를 제공하지 않는다는 점이다. 기존의 방법에서는 픽셀 필드의 동작만을 계산한다. 기존의 직접 동작 모델을 채용할 방법에서는 영상 사이의 전반적인 오류를 최소화함으로써 동작 매개변수를 반복적으로 개선한다. 이러한 기존의 방법에서는 컴퓨터 계산을 많이 한다. 더 나아가 이러한 방법은 국소 최소화 문제에 직면하므로 매개변수의 양호한 초기 근사값이 필요하다.

또한 로컬 동작에 기반을 둔 방법은 두 종류로, 즉 형태 매칭과 블록 매칭으로 나누어질 수 있다. 형태 매칭은 관심점 추출과 두 지점 집합 사이의 대응 확립에 근거를 두고 있다. 대개의 경우 관심점에 집중한 영상창 사이의 가장 큰 상관 계수가 형태 대응과 로컬 동작 벡터를 결정한다.

블록 매칭은 이와 반대로 비디오 프레임을 동등한 작은 블록으로 분할하는 것에 근거를 둔다. 어느 한 프레임에서 가장 잘 매칭된 블록을 검색창 내의 다른 프레임에 나온 각 블록에서 검색한다.

본 발명에 따라 구현된 시스템에서는 컴퓨터 계산의 효율성으로 인해 PCM에 기반을 둔 블록 매칭법을 사용한다. 본 발명에 따른 구현된 또 다른 시스템에서는 형태 매칭법이나 블록 매칭법과 형태 매칭법을 결합한 방법을 사용할 수 있다.

로컬 동작 벡터에 기반을 둔 동작 추정법의 주요 쟁점은 속도, 견실도 및 정밀도이다. 동작 벡터의 수는 대략 수백 개일 수 있다. 그러므로 본 발명에 따라 효율적으로 구현된 시스템에서는 추정법을 실행하기에 충분한 속도를 제공하는 실시간 실행이 필요하다. 또한 동작 벡터 집합에는 독립적으로 움직이는 대상이나 신뢰할 수 없는 매칭으로 인해 대개의 경우 많은 이상값이 있다. 이러한 이상값은 글로벌 동작과 일치하지 않으므로 이 방법의 견실도를 향상시키기 위해 동작 매개변수를 계산하기 전 RANSAC 추정자 11과 같은 견실한 추정자로 이러한 이상값을 식별해야 한다.

모든 동작 벡터가 서로 근사하면, 작은 오류는 그 오류가 넓게 분산되어 있을 때보다 더 많이 외삽된다. 그러므로 동작 매개변수를 정밀하게 추정하기 위해서는 동작 벡터에 의한 완전한 영상 영역이 필요하다.

차량과 같은 움직이는 대상의 자기 동작은 이동 대상의 바로 아래에 위치한 표면의 역동작이다. 움직이는 대상의 아래에 위치한 표면의 동작을 움직이는 대상의 근처에 있으며 움직이는 대상의 가용 온보드 카메라 2에서 보이는 도로 부분에서 추정할 수 있다.

본 발명에 따른 방법으로 행렬식 동작 매개변수가 표면의 특별히 구성된 메트릭 영상에서 복구된다. 본 발명에 따라 구현할 수 있는 시스템에서는, 각 표면에 있는 샘플 사이의 알려진 실제 거리가 있는 직교 격자를 만들고 화소값을 구하기 위해 각 샘플을 카메라 영상으로 사용함으로써 톱뷰라고도 하는 이 메트릭 영상이 구성된다.

연속적인 톱뷰 영상 사이의 형상 매칭은 도로 동작이나 표면 동작의 다중 가설을 제공한다. 이러한 가설 중 몇몇은 올바르고(정상값), 다른 몇몇은 올바르지 않다(이상값). 이상값은 대개의 경우 독립적으로 움직이는 대상과 신뢰할 수 없는 형태 매칭에서 나온다. 본 발명에 따라 구현할 수 있는 시스템에서는 견실한 표준 추정자가, 특히 RANSAC 추정자가 선택한 정상값 집합에서 표면 동작의 정확한 매개변수를 계산할 수 있다.

본 발명에 따라 구현할 수 있는 시스템에서는 비홀로노믹 동작 구속(순간 차량 병진이 그 정향에 맞추어 조절된다는 것을 의미)을 조사하여 톱뷰 영상에 있는 로컬 형태의 동작을 큰 톱뷰 구역에서 추정된 글로벌 병진 벡터와 형태 주변의 작은 구역에서 추정된 로컬 병진 벡터의 합계로 분해하여 여러 프레임에 있는 작은 구역을 추정된 글로벌 병진에 의해 조절할 수 있다. 따라서 본 발명에 따른 방법에서는 영상 병진과 회전을 실행하며 컴퓨터 계산을 더 많이 하는 형태 매칭은 두 단계의 병진 추정으로 대체된다. 더 나아가 이 방법은 반대되는 두 방법의, 즉 사용할 수 있는 모든 정보를 사용하며 큰 구역에서 실행하는 직접 동작 추정 및 있을 수 있는 도로 외부의 대상을 피하는 형태 기반 추정의 특성과 공통점이 있다.

본 발명에서 사용하는 글로벌 및 로컬 병진 추정자는 입력 구역의 크기에 의해서만 차이가 있으므로 동일한 추정 원리를 사용할 수 있다. 본 발명에 따라 실현할 수 있는 시스템에서는 큰 구역 사이에서의 병진을 신속하게 추정할 수 있도록 하기 위해 영상 사영에 기반을 둔 방법을 선호한다. 2D 영상 구역은 수직 사영과 수평 사양으로 이루어진 두 개의 1D 사영으로 축소되는 바, 여기서 각 사영은 각각 그 열과 행을 따라 연속되는 구역 화소의 합계이다. 구역 사이에서의 2D 병진은 그 1D 사영 사이에서의 독립적 병진으로서 추정된다. 선호하는 바는 1D 사이에서의 추이를 1D 위상 상관법으로 계산하는 것이다. 위에서 설명한 실행에서는 하나의 2D 영상 매칭의 작업을 1D 신호 매칭의 두 작업으로 대체하므로 필요한 연산 수는 O(NMlog(N×M))에서 O(Nlog(N)) 및 O(Mlog(M))로 상당히 감소하는 바, 여기서 N, M은 영상의 크기이다.

구역 사영을 신속하게 계산할 수 있도록 하기 위해, 본 발명에 따라 실현할 수 있는 시스템에서는 원래의 톱뷰 영상을 1D 적분 변환 장치 9로 전처리하는 바, 이로 인해 수직 및 수평 영상으로 구성된 두 적분 영상이 되므로 수평 적분 영상의 각 화소는 현재의 행까지에 이르는 행의 모든 화소를 합한 화소이다. 이와 유사하게 수직 적분 영상의 각 화소는 현재의 열까지에 이르는 열의 모든 화소를 합한 화소이다. 적분 영상에서 구역 사영은 구역 경계 화소에서만 계산되므로 필요한 연산의 수가 상당히 감소한다.

본 발명에 따라 선택적으로 실현할 수 있는 시스템에서는, 신뢰할 수 없는 매칭을 사전에 필터링하기 위해 구역 사영 내에 있는 최소값과 최대값을 계산하고 이 값 사이의 절대값 차이가 임계값보다 작은가를 점검함으로써 동등한 구역을 그 과정에서 배제할 수 있다.

더 나아가 본 발명에 따라 선택적으로 실현할 수 있는 시스템에서는, 글로벌 병진 추정을 이미 추정한 완전 동작 모델의 사용으로 대체하여 비홀로노믹 동작 구속의 조사를 사용함으로써 도로 동작을 반복하여 개선할 수 있다. 반복적 절차를 사용하는 이유는 글로벌 병진 대신 더 정밀한 동작 근사값의 사용함으로 인해 정상값의 수를 늘릴 수 있는 개연성이 있기 때문이다. 정상값의 수가 증가하면 더 정밀한 동작 추정이 이루어진다.

본 발명에 따라 실현할 수 있는 또 다른 시스템에서는 정밀도를 더욱 더 향상시키기 위해, 연석 감지기나 수직 물체 감지기와 같은 다른 컴퓨터 비전 알고리즘의 출력을 수용함으로써 도로 외 구역을 분석에서 제외할 수 있다.

본 발명에 따른 방법과 장치에는 적어도 두 프레임에서 하나의 메트릭 자기 동작을 제공하는 장점이 있다. 이러한 방법과 장치는 기존의 서라운드 뷰 시스템의 처리 파이프라인에 통합하기에 적합하다. 그러한 기존의 시스템에는 사용자 인터페이스의 요소와 같은 톱뷰 영상 표시가 이미 있다. 따라서 본 발명에 따른 방법은 기존의 사용자 보기 영상에서 작동할 수 있으며 운전자에게 더 많은 시각 정보를, 예를 들어 외삽된 차량 경로를 추가할 수 있다. 컴퓨터 계산을 많이 하는 2D 도메인에서 1D 도메인 집합으로 영상 매칭 연산을 변환함으로써 달성한 복잡한 컴퓨터 계산의 감소로 인해 복잡하지 않고 자원이 많이 필요하지 않은 계산 수단을 사용하여 본 발명에 따른 방법을 실행할 수 있는 바, 여기서 1D 알고리즘은 널리 사용되는 표준 2D 알고리즘에 필요한 시간의 일부만을 사용하며, 이때 고정된 영상 변환을 사용하고 주파수 영역에서 빠른 신호 매칭 알고리즘을 사용한다. 고정 영상 변환을 사용함으로써 각 화소의 톱뷰 사영을 초기화 단계에서 계산하고, 이 사영은 알고리즘을 실행하는 동안 변화하지 않는다. 모든 화소의 사영을 고정된 점 형식으로 된 룩업 테이블에 저장할 수 있다. 온라인으로 실행하는 동안 사영된 좌표를 복구하여 톱뷰 변형을 계산하기 위해 빠른 정수 전용 알고리즘을 사용한다. 주파수 영역에서 빠른 신호 매칭 알고리즘을 사용함으로써 신호의 길이를 조절하여 푸리에 변형을 가장 빨리 실행하기 위한 두 힘 중의 한 힘이 될 수 있다.

어느 한 표면 위에서 이동하는 어떤 대상, 특히 차량이나 평평한 표면에서 움직이는 로봇의 자기 동작을 추정하기 위해 발명에 따른 방법과 장치를 사용할 수 있다.

Claims (15)

- 어떤 표면 위에서 움직이는 어떤 대상의 자기 동작을 추정하기 위한 방법으로서,

(a) 상기 표면 위에서 움직이는 상기 대상의 최소한 하나의 온보드 비디오 카메라가 제공한 비디오 프레임을 기반으로 한 최소한 두 개의 표면에 대한 합성 톱뷰 영상을 생성하는 단계 (S1);

(b) 상기 움직이는 대상의 글로벌 동작 매개변수를 추출하는 연속적인 톱뷰 영상 간의 구역 매칭을 실행하는 단계 (S2);

(c) 상기 움직이는 대상의 추출한 글로벌 동작 매개변수에서 상기 이동 대상의 자기 동작을 계산하는 단계 (S3)

로 구성되는, 자기 동작을 추정하기 위한 방법. - 제 1 항에 있어서,

연속적 톱뷰 영상 사이의 상기 구역 매칭은 형태 매칭이나 블록 매칭으로 이루져 있는, 자기 동작을 추정하기 위한 방법. - 제 1 항 또는 제 2 항에 있어서,

톱뷰 영상은 구역 매칭에 사용된 1D 적분 영상을 제공하는 1D 적분 변환을 실행함으로써 처리되는, 자기 동작을 추정하기 위한 방법. - 제 1 항 내지 제 3 항 중 어느 한 항에 있어서,

상기 이동 대상의 추출한 글로벌 동작 매개변수는 이동 대상의 병진과 회전으로 이루어져 있는, 자기 동작을 추정하기 위한 방법. - 제 1 항 내지 제 4 항 중 어느 한 항에 있어서,

톱뷰 영상에 있는 어떤 형태의 동작은 큰 톱뷰 구역에서 추정한 글로벌 병진 벡터의 합계와 각 형태를 둘러싼 작은 구역에서 추정한 로컬 병진 벡터의 합계로 분해되는, 자기 동작을 추정하기 위한 방법. - 제 1 항 내지 제 5 항 중 어느 한 항에 있어서,

톱뷰 영상은 표면 위에 있는 샘플 간의 사전에 결정된 거리가 있는 직교 격자에 의해 구성되고 화소값을 구하기 위해 각 샘플을 카메라 영상으로 사영함으로써 구성된 표면의 메트릭 톱뷰 영상에 의해 형성되는, 자기 동작을 추정하기 위한 방법. - 제 1 항 내지 제 6 항 중 어느 한 항에 있어서,

상기 구역 매칭이 제공하고 추정자가 선택한 정상값 집합에서 글로벌 동작 매개변수를 계산하는, 자기 동작을 추정하기 위한 방법. - 제 1 항 내지 제 7 항 중 어느 한 항에 있어서,

대상은 평평한 표면 위에서 이동하는 차량에 의해 형성되는, 자기 동작을 추정하기 위한 방법. - 표면 위에서 움직이는 대상의 자기 동작을 추정하기 위한 장치 (1)로서,

- 표면의 비디오 프레임을 제공하기 위해 조절한, 상기 대상에 부착한 최소한 하나의 온보드 비디오 카메라 (2);

- 비디오 프레임을 기반으로 표면의 합성 톱뷰 영상을 생성하기 위해 조절한 생성 장치 (3);

- 상기 이동 대상의 글로벌 동작 매개변수를 추출하는 연속적인 톱뷰 영상 간의 구역 매칭 실행하기 위해 조절한 구역 매칭 장치 (4); 및

- 상기 이동 대상의 자기 동작을 상기 이동 대상의 추출한 글로벌 동작 매개변수에서 계산하기 위해 조절한 계산 장치 (5)

로 구성되는, 자기 동작을 추정하기 위한 장치. - 제 9 항에 있어서,

상기 구역 매칭 장치 (4)에 의한 구역 매칭에 사용하기 위해 버퍼 (10)에 저장한 ID 적분 영상을 제공하는 톱뷰 영상의 1D 적분 변환을 실행하기 위해 조절한 변환 장치 (9) 가 또한 있는, 자기 동작을 추정하기 위한 장치. - 제 9 항 또는 제 10 항에 있어서,

글로벌 동작 매개변수가 상기 매칭 장치 (4)에 의해 실행된 상기 구역 매칭이 제공하고 추정자 (11)이 선택한 정상값 집합에서 계산되는, 자기 동작을 추정하기 위한 장치. - 제 11 항에 있어서,

추정자 (11)는 RANSAC 추정자인, 자기 동작을 추정하기 위한 장치. - 제 9 항 내지 제 12 항 중 어느 한 항에 있어서,

온보드 비디오 카메라 (2)는 단안식 카메라인, 자기 동작을 추정하기 위한 장치. - 제 9 항 내지 제 13 항 중 어느 한 항에 기재된 장치 (1)로 이루어진 어떤 표면 위에서 이동할 수 있는 차량.

- 제 14 항에 있어서,

차량이란 도로의 표면에서 움직이는 승용차나 평평한 표면 위에서 움직이는 로봇으로 이루어져 있는, 차량.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020210108894A KR20210107570A (ko) | 2013-09-20 | 2021-08-18 | 어떤 대상의 자기 동작 추정을 위한 방법 |

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| EP13185423.4A EP2851870B1 (en) | 2013-09-20 | 2013-09-20 | Method for estimating ego motion of an object |

| EPEP13185423 | 2013-09-20 |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020210108894A Division KR20210107570A (ko) | 2013-09-20 | 2021-08-18 | 어떤 대상의 자기 동작 추정을 위한 방법 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| KR20150032789A true KR20150032789A (ko) | 2015-03-30 |

| KR102462278B1 KR102462278B1 (ko) | 2022-11-01 |

Family

ID=49212701

Family Applications (2)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020140123438A KR102462278B1 (ko) | 2013-09-20 | 2014-09-17 | 어떤 대상의 자기 동작 추정을 위한 방법 |

| KR1020210108894A KR20210107570A (ko) | 2013-09-20 | 2021-08-18 | 어떤 대상의 자기 동작 추정을 위한 방법 |

Family Applications After (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020210108894A KR20210107570A (ko) | 2013-09-20 | 2021-08-18 | 어떤 대상의 자기 동작 추정을 위한 방법 |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US9158977B2 (ko) |

| EP (1) | EP2851870B1 (ko) |

| JP (1) | JP6562607B2 (ko) |

| KR (2) | KR102462278B1 (ko) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20180112010A (ko) * | 2016-03-15 | 2018-10-11 | 코너트 일렉트로닉스 리미티드 | 자동차의 도로변의 물체를 검출하는 방법, 컴퓨팅 장치, 운전자 보조 시스템 및 자동차 |

Families Citing this family (25)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR102077498B1 (ko) * | 2013-05-13 | 2020-02-17 | 한국전자통신연구원 | 상호 기하 관계가 고정된 카메라 군의 이동 경로 추출 장치 및 방법 |

| RU2628420C1 (ru) * | 2014-02-24 | 2017-08-16 | Ниссан Мотор Ко., Лтд. | Устройство вычисления собственного местоположения и способ вычисления собственного местоположения |

| US11051000B2 (en) * | 2014-07-14 | 2021-06-29 | Mitsubishi Electric Research Laboratories, Inc. | Method for calibrating cameras with non-overlapping views |

| US10339389B2 (en) * | 2014-09-03 | 2019-07-02 | Sharp Laboratories Of America, Inc. | Methods and systems for vision-based motion estimation |

| EP3001272B1 (en) * | 2014-09-26 | 2017-04-12 | Volvo Car Corporation | Method of trajectory planning for yielding manoeuvres |

| US10163220B2 (en) * | 2015-08-27 | 2018-12-25 | Hrl Laboratories, Llc | Efficient hybrid method for ego-motion from videos captured using an aerial camera |

| WO2018009567A1 (en) | 2016-07-05 | 2018-01-11 | Nauto Global Limited | System and method for automatic driver identification |

| US10209081B2 (en) | 2016-08-09 | 2019-02-19 | Nauto, Inc. | System and method for precision localization and mapping |

| US20180068459A1 (en) * | 2016-09-08 | 2018-03-08 | Ford Global Technologies, Llc | Object Distance Estimation Using Data From A Single Camera |

| US10733460B2 (en) | 2016-09-14 | 2020-08-04 | Nauto, Inc. | Systems and methods for safe route determination |

| US9928432B1 (en) | 2016-09-14 | 2018-03-27 | Nauto Global Limited | Systems and methods for near-crash determination |

| US10318826B2 (en) | 2016-10-07 | 2019-06-11 | Ford Global Technologies, Llc | Rear obstacle detection and distance estimation |

| US10246014B2 (en) | 2016-11-07 | 2019-04-02 | Nauto, Inc. | System and method for driver distraction determination |

| KR102071720B1 (ko) * | 2017-02-22 | 2020-01-30 | 한국전자통신연구원 | 차량용 레이다 목표 리스트와 비전 영상의 목표물 정합 방법 |

| WO2018229548A2 (en) | 2017-06-16 | 2018-12-20 | Nauto Global Limited | System and method for contextualized vehicle operation determination |

| WO2018229550A1 (en) | 2017-06-16 | 2018-12-20 | Nauto Global Limited | System and method for adverse vehicle event determination |

| WO2018229549A2 (en) | 2017-06-16 | 2018-12-20 | Nauto Global Limited | System and method for digital environment reconstruction |

| WO2019169031A1 (en) | 2018-02-27 | 2019-09-06 | Nauto, Inc. | Method for determining driving policy |

| US10845818B2 (en) * | 2018-07-30 | 2020-11-24 | Toyota Research Institute, Inc. | System and method for 3D scene reconstruction of agent operation sequences using low-level/high-level reasoning and parametric models |

| KR20200016627A (ko) * | 2018-08-07 | 2020-02-17 | 삼성전자주식회사 | 자체 운동 추정 방법 및 장치 |

| EP3776485B1 (en) * | 2018-09-26 | 2022-01-26 | Coherent Logix, Inc. | Any world view generation |

| US20200104977A1 (en) * | 2018-09-30 | 2020-04-02 | Augentix Inc. | Method of Adaptive Image Stitching and Image Processing Device |

| IL296197B2 (en) | 2019-02-19 | 2024-05-01 | Edgy Bees Ltd | Real-time video data stream latency estimation |

| JP7217577B2 (ja) | 2019-03-20 | 2023-02-03 | フォルシアクラリオン・エレクトロニクス株式会社 | キャリブレーション装置、キャリブレーション方法 |

| CN112017215B (zh) * | 2020-08-06 | 2023-08-25 | 影石创新科技股份有限公司 | 图像处理方法、装置、计算机可读存储介质及计算机设备 |

Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20100057775A (ko) * | 2007-06-14 | 2010-06-01 | 포토네이션 아일랜드 리미티드 | 고속 모션 추정 방법 |

| KR20110072426A (ko) * | 2009-12-22 | 2011-06-29 | 삼성전자주식회사 | 실시간 카메라 모션 추정을 이용한 물체 검출/추적 방법 및 단말 |

Family Cites Families (10)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3181201B2 (ja) * | 1995-07-10 | 2001-07-03 | 名古屋電機工業株式会社 | 移動体検出方法 |

| GB2363506B (en) * | 2000-06-15 | 2004-08-18 | Decoi Architects Ltd | Display system |

| JP3838884B2 (ja) * | 2001-03-29 | 2006-10-25 | 株式会社デンソー | 車両周辺表示装置、プログラムおよび記録媒体 |

| GB0404269D0 (en) * | 2004-02-26 | 2004-03-31 | Leuven K U Res & Dev | Time-dependent three-dimensional musculo-skeletal modeling based on dynamic surface measurements of bodies |

| JP2007078358A (ja) * | 2005-09-09 | 2007-03-29 | Sumitomo Electric Ind Ltd | 移動体計測装置、信号制御システム、移動体計測方法及びコンピュータプログラム |

| JP2009129001A (ja) * | 2007-11-20 | 2009-06-11 | Sanyo Electric Co Ltd | 運転支援システム、車両、立体物領域推定方法 |

| US8213706B2 (en) * | 2008-04-22 | 2012-07-03 | Honeywell International Inc. | Method and system for real-time visual odometry |

| US8847739B2 (en) * | 2008-08-04 | 2014-09-30 | Microsoft Corporation | Fusing RFID and vision for surface object tracking |

| US8903127B2 (en) * | 2011-09-16 | 2014-12-02 | Harman International (China) Holdings Co., Ltd. | Egomotion estimation system and method |

| DE102011088332B4 (de) * | 2011-12-13 | 2021-09-02 | Robert Bosch Gmbh | Verfahren zur Verbesserung der Objektdetektion bei Multikamerasystemen |

-

2013

- 2013-09-20 EP EP13185423.4A patent/EP2851870B1/en active Active

-

2014

- 2014-08-15 US US14/460,629 patent/US9158977B2/en active Active

- 2014-09-16 JP JP2014187424A patent/JP6562607B2/ja active Active

- 2014-09-17 KR KR1020140123438A patent/KR102462278B1/ko active IP Right Grant

-

2021

- 2021-08-18 KR KR1020210108894A patent/KR20210107570A/ko not_active Application Discontinuation

Patent Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20100057775A (ko) * | 2007-06-14 | 2010-06-01 | 포토네이션 아일랜드 리미티드 | 고속 모션 추정 방법 |

| KR20110072426A (ko) * | 2009-12-22 | 2011-06-29 | 삼성전자주식회사 | 실시간 카메라 모션 추정을 이용한 물체 검출/추적 방법 및 단말 |

Non-Patent Citations (1)

| Title |

|---|

| Jose Molineros et al ,"Monocular Rear-View Obstacle Detection Using Residual Flow",Computer Vision ECCV2012,pp.504-514,(2012.10.31.) * |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20180112010A (ko) * | 2016-03-15 | 2018-10-11 | 코너트 일렉트로닉스 리미티드 | 자동차의 도로변의 물체를 검출하는 방법, 컴퓨팅 장치, 운전자 보조 시스템 및 자동차 |

Also Published As

| Publication number | Publication date |

|---|---|

| JP6562607B2 (ja) | 2019-08-21 |

| KR102462278B1 (ko) | 2022-11-01 |

| US20150086078A1 (en) | 2015-03-26 |

| KR20210107570A (ko) | 2021-09-01 |

| US9158977B2 (en) | 2015-10-13 |

| EP2851870A1 (en) | 2015-03-25 |

| JP2015060595A (ja) | 2015-03-30 |

| EP2851870B1 (en) | 2019-01-23 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR102462278B1 (ko) | 어떤 대상의 자기 동작 추정을 위한 방법 | |

| US9864927B2 (en) | Method of detecting structural parts of a scene | |

| US9846812B2 (en) | Image recognition system for a vehicle and corresponding method | |

| JP6107081B2 (ja) | 画像処理装置、画像処理方法及びプログラム | |

| US20180322646A1 (en) | Gaussian mixture models for temporal depth fusion | |

| Akolkar et al. | Real-time high speed motion prediction using fast aperture-robust event-driven visual flow | |

| US8903127B2 (en) | Egomotion estimation system and method | |

| US5777690A (en) | Device and method for detection of moving obstacles | |

| WO2016035324A1 (en) | Method for estimating motion, mobile agent and non-transitory computer-readable medium encoded with a computer program code for causing a processor to execute a method for estimating motion | |

| EP3193306B1 (en) | A method and a device for estimating an orientation of a camera relative to a road surface | |

| EP2757527B1 (en) | System and method for distorted camera image correction | |

| CN109300143B (zh) | 运动向量场的确定方法、装置、设备、存储介质和车辆 | |

| Zhou et al. | Moving object detection and segmentation in urban environments from a moving platform | |

| US9098750B2 (en) | Gradient estimation apparatus, gradient estimation method, and gradient estimation program | |

| KR20190030474A (ko) | 신뢰도에 기초하여 깊이 맵을 산출하는 방법 및 장치 | |

| CN115187941A (zh) | 目标检测定位方法、系统、设备及存储介质 | |

| JP2017517727A (ja) | 三次元情報の規模測定 | |

| KR20100066952A (ko) | 스테레오 비전을 이용하여 장애물을 추적하는 장치 및 방법 | |

| KR20200102108A (ko) | 차량의 객체 검출 장치 및 방법 | |

| Contreras et al. | A Stereo Visual Odometry Framework with Augmented Perception for Dynamic Urban Environments | |

| JP2011209070A (ja) | 画像処理装置 | |

| Lim et al. | Integrated position and motion tracking method for online multi-vehicle tracking-by-detection | |

| US20130142388A1 (en) | Arrival time estimation device, arrival time estimation method, arrival time estimation program, and information providing apparatus | |

| Pagel | Robust monocular egomotion estimation based on an iekf | |

| US20230281862A1 (en) | Sampling based self-supervised depth and pose estimation |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A201 | Request for examination | ||

| E902 | Notification of reason for refusal | ||

| AMND | Amendment | ||

| E902 | Notification of reason for refusal | ||

| E601 | Decision to refuse application | ||

| X091 | Application refused [patent] | ||

| AMND | Amendment | ||

| E902 | Notification of reason for refusal | ||

| X601 | Decision of rejection after re-examination | ||

| J201 | Request for trial against refusal decision | ||

| J301 | Trial decision |

Free format text: TRIAL NUMBER: 2021101002145; TRIAL DECISION FOR APPEAL AGAINST DECISION TO DECLINE REFUSAL REQUESTED 20210818 Effective date: 20220728 |

|

| GRNO | Decision to grant (after opposition) | ||

| GRNT | Written decision to grant |