KR20140041570A - 사용자의 눈 이동으로 동작가능한 컴퓨터 장치 및 컴퓨터 장치를 동작하는 방법 - Google Patents

사용자의 눈 이동으로 동작가능한 컴퓨터 장치 및 컴퓨터 장치를 동작하는 방법 Download PDFInfo

- Publication number

- KR20140041570A KR20140041570A KR1020137033858A KR20137033858A KR20140041570A KR 20140041570 A KR20140041570 A KR 20140041570A KR 1020137033858 A KR1020137033858 A KR 1020137033858A KR 20137033858 A KR20137033858 A KR 20137033858A KR 20140041570 A KR20140041570 A KR 20140041570A

- Authority

- KR

- South Korea

- Prior art keywords

- eye movement

- user

- movement pattern

- display

- period

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

- G06F3/013—Eye tracking input arrangements

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B17/00—Surgical instruments, devices or methods, e.g. tourniquets

- A61B2017/00017—Electrical control of surgical instruments

- A61B2017/00216—Electrical control of surgical instruments with eye tracking or head position tracking control

-

- A—HUMAN NECESSITIES

- A61—MEDICAL OR VETERINARY SCIENCE; HYGIENE

- A61B—DIAGNOSIS; SURGERY; IDENTIFICATION

- A61B3/00—Apparatus for testing the eyes; Instruments for examining the eyes

- A61B3/10—Objective types, i.e. instruments for examining the eyes independent of the patients' perceptions or reactions

- A61B3/113—Objective types, i.e. instruments for examining the eyes independent of the patients' perceptions or reactions for determining or recording eye movement

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/30—Image reproducers

- H04N13/366—Image reproducers using viewer tracking

- H04N13/383—Image reproducers using viewer tracking for tracking with gaze detection, i.e. detecting the lines of sight of the viewer's eyes

Abstract

본 발명은 사용자의 눈 이동으로 컴퓨터 장치를 동작시키는 방법에 관한 것이다. 방법은 사용자의 눈 이동을 검출하는 단계, 검출된 사용자의 눈 이동 내의 눈 이동 패턴 및 눈 이동 패턴을 완료한 기간을 특정하기 위하여 사용자의 눈 이동을 분석하는 단계, 눈 이동 패턴 및 기간의 조합과 연관된 명령을 결정하는 단계, 및 명령에 따라 장치를 동작시키는 단계를 포함한다.

Description

본 발명은 사용자의 눈 이동으로 동작가능한 컴퓨터 장치 및 사용자의 눈 이동으로 컴퓨터 장치를 동작시키는 방법에 관한 것이다.

전자책(또한, 이-북(e-Book), 이북(eBook) 또는 디지털 북이라 함)은 컴퓨터 또는 다른 디지털 장치 상에서 생성되고, 발행되고 읽을 수 있는 디지털 형태의 텍스트 및 이미지 기반 출판물로 알려져 있다. 이북은 통상 이리더(eReader) 또는 이북 장치로 알려진 전용 하드웨어 장치 상에서 읽는다. 스마트폰 등의 컴퓨터 장치가 또한 이북을 읽는데 사용될 수 있다.

더 많은 사람들이 이북을 읽는데 컴퓨터 장치를 이용함에 따라 컴퓨터 장치를 동작시키는 더 편리한 동작이 기대된다.

눈 추적(eye tracking)은 리서치 핫스팟 중의 하나이다. 눈 추적은 머리에 대한 사용자의 눈의 모션 및 시선점(point of eye gaze)을 측정하는 프로세스이다. 눈 이동을 측정하는 많은 방법이 존재한다. 가장 인기 있는 변형은 눈 위치가 추출되는 비디오 이미지를 사용한다. 시선(eye gaze)의 검출은 많은 인간-컴퓨터 상호작용 애플리케이션에 이용된다. 시선을 추정하는 침투형(intrusive) 및 비침투형(nonintrusive) 어프로치가 존재한다. 침투형 기술에서, 사용자는 헤드기어 카메라를 쓰고 카메라 상의 스크린의 뷰에 눈의 위치를 고정하거나 카메라 상의 적외선을 이용하여 눈을 검출할 필요가 있다. 비침투형 어프로치에서, 사용자는 사용자의 눈을 촬영하는 간단한 카메라만을 필요로 하고 임의의 다른 장치를 착용하지 않는다. 현재 스마트폰 및 휴대용 전자 게임 머신 등의 컴퓨터 장치의 대부분은 사용자를 촬영할 수 있는 카메라가 제공되고 이리더(eReader)로서 사용될 수 있다.

MPA(Movement Pattern Analysis)는 비언어 행동의 훈련된 분석에 기초하여 의사 결정 프로세스에서 개인의 핵심적인 동기를 평가하는 종합 시스템이다.

사용자의 눈 이동 패턴을 인식하는 눈 추적 장치는 US20080143674A1에 기재된다.

본 발명의 목적은 컴퓨터 장치를 동작시키기 위하여 사용자의 눈 이동에 의해 더 편리한 동작을 제공하는 것이다.

발명의 개요

본 발명의 형태에 따르면, 사용자의 눈 이동으로 동작가능한 컴퓨터 장치가 제공된다. 컴퓨터 장치는 사용자의 눈 이동을 검출하는 수단, 검출된 사용자의 눈 이동 내의 눈 이동 패턴 및 눈 이동 패턴을 완료한 기간을 특정하기 위하여 사용자의 눈 이동을 분석하는 수단, 눈 이동 패턴 및 기간의 조합과 연관된 명령(command)을 결정하는 수단, 및 명령에 따라 장치를 동작시키는 수단을 포함한다.

본 발명의 다른 형태에 따르면, 사용자의 눈 이동으로 컴퓨터 장치를 동작시키는 방법이 제공된다. 방법은 사용자의 눈 이동을 검출하는 단계, 검출된 사용자의 눈 이동 내의 눈 이동 패턴 및 눈 이동 패턴을 완료한 기간을 특정하기 위하여 사용자의 눈 이동을 분석하는 단계, 눈 이동 패턴 및 기간의 조합과 연관된 명령을 결정하는 단계, 및 명령에 따라 장치를 동작시키는 단계를 포함한다.

본 발명의 이들 및 다른 형태, 특징 및 이점은 첨부된 도면과 결합한 다음의 설명으로부터 명백해질 것이다.

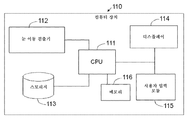

도 1은 본 발명의 실시예에 따른 컴퓨터 장치의 예시적인 블록도.

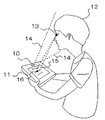

도 2a는 본 발명의 실시예에 따른 컴퓨터 장치의 사용의 기본 환경을 나타내는 도면.

도 2b는 추가된 광 라인(optical lines)을 제외하고 도 2a에 도시된 것과 동일한 기본 환경을 나타내는 도면.

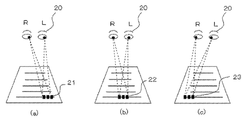

도 3(a) 내지 3(c)는 텍스트 라인의 좌측으로부터 우측으로 컴퓨터 장치의 디스플레이 상에 제시된 페이지 상의 하나의 텍스트 라인을 읽는 기본 읽기 프로세스를 나타내는 도면.

도 4(a) 내지 4(c)는 페이지의 상부로부터 하부로 컴퓨터 장치의 디스플레이 상에 제시된 페이지를 읽는 기본 읽기 프로세스를 나타내는 도면.

도 5는 도 4(a) 내지 4(c)에 도시된 컴퓨터 장치의 디스플레이 상에 제시된 페이지를 읽는 읽기 프로세스의 결과로서 검출된 눈 이동 패턴을 나타내는 도면.

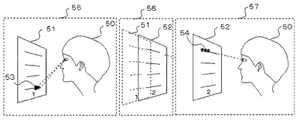

도 6은 컴퓨터 장치의 디스플레이 상에 도시된 페이지가 도 5에 도시된 눈 이동 패턴에 따라 다음 페이지로 어떻게 스크롤되는지를 나타내는 도면.

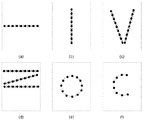

도 7(a) 내지 7(f)는 눈 이동 패턴 및 눈 이동 패턴을 완료하는 기간의 상이한 종류의 조합 - 조합은 본 발명에 따라 컴퓨터 장치를 동작시키는 상이한 종류의 명령을 생성함 - 을 나타내는 도면.

도 8(a) 내지 8(c)는 디스플레이 상의 상이한 위치에서 추적된 눈 이동 패턴을 나타내는 도면.

도 9는 본 발명의 실시예에 따라 사용자의 눈 이동으로 컴퓨터 장치를 동작시키는 방법을 나타내는 플로우챠트.

도 1은 본 발명의 실시예에 따른 컴퓨터 장치의 예시적인 블록도.

도 2a는 본 발명의 실시예에 따른 컴퓨터 장치의 사용의 기본 환경을 나타내는 도면.

도 2b는 추가된 광 라인(optical lines)을 제외하고 도 2a에 도시된 것과 동일한 기본 환경을 나타내는 도면.

도 3(a) 내지 3(c)는 텍스트 라인의 좌측으로부터 우측으로 컴퓨터 장치의 디스플레이 상에 제시된 페이지 상의 하나의 텍스트 라인을 읽는 기본 읽기 프로세스를 나타내는 도면.

도 4(a) 내지 4(c)는 페이지의 상부로부터 하부로 컴퓨터 장치의 디스플레이 상에 제시된 페이지를 읽는 기본 읽기 프로세스를 나타내는 도면.

도 5는 도 4(a) 내지 4(c)에 도시된 컴퓨터 장치의 디스플레이 상에 제시된 페이지를 읽는 읽기 프로세스의 결과로서 검출된 눈 이동 패턴을 나타내는 도면.

도 6은 컴퓨터 장치의 디스플레이 상에 도시된 페이지가 도 5에 도시된 눈 이동 패턴에 따라 다음 페이지로 어떻게 스크롤되는지를 나타내는 도면.

도 7(a) 내지 7(f)는 눈 이동 패턴 및 눈 이동 패턴을 완료하는 기간의 상이한 종류의 조합 - 조합은 본 발명에 따라 컴퓨터 장치를 동작시키는 상이한 종류의 명령을 생성함 - 을 나타내는 도면.

도 8(a) 내지 8(c)는 디스플레이 상의 상이한 위치에서 추적된 눈 이동 패턴을 나타내는 도면.

도 9는 본 발명의 실시예에 따라 사용자의 눈 이동으로 컴퓨터 장치를 동작시키는 방법을 나타내는 플로우챠트.

다음의 설명에서, 본 발명의 실시예의 다양한 형태가 기재된다. 설명의 목적으로, 철저한 이해를 제공하기 위하여 특정 구성 및 세부사항이 기재된다. 그러나, 본 발명은 여기에 제시된 특정한 세부사항없이 실행될 수 있음은 당업자에게 자명하다.

도 1은 본 발명의 실시예에 따른 컴퓨터 장치(110)의 예시적인 블록도이다. 컴퓨터 장치(110)는 태블릿, 스마트폰, 이북 리더 등일 수 있다. 컴퓨터 장치(110)는 중앙 처리 장치(CPU)(111), 눈 이동 검출기(112), 스토리지(113), 디스플레이(114) 및 사용자 입력 모듈(115)을 포함한다. 도 1에 도시된 바와 같이 랜덤 액세스 메모리(RAM) 등의 메모리(116)가 CPU(111)에 접속될 수 있다.

눈 이동 검출기(112)는 장치(110)의 사용자의 눈을 검출하고 눈 및 시선의 모션을 모니터하는 엘리먼트이다. 눈 이동 검출기(112)는 또한 디스플레이(114) 상의 시선 위치를 검출 및 수집하고 각 시선에 대한 시간을 측정하도록 구성된다. 눈 이동 검출기(112)는 시선 추적 목적으로 많은 상이한 타입의 기술을 채용할 수 있다. 예를 들어, 눈 이동 검출기(112)는 시선 추적을 실현하는 3개의 단계를 채용할 수 있는데, 제1 단계에서, 사용자의 얼굴 상의 눈은 하르-라이크 특징(Haar-like feature)에 기초하여 검출되고, 제2 단계에서, 눈의 모션의 추적은 루카스 캐나드(Lucas Kanade) 알고리즘을 이용하여 수행되고, 제3 단계에서, 시선이 가우스 프로세스를 이용하여 검출된다. 당업자는 상술한 기술만이 시선 추적을 위한 솔류션이 아니고 많은 다른 기술이 시선 추적에 사용될 수 있음을 인식할 것이다.

디스플레이(114)는 장치(110)의 사용자에게 텍스트, 이미지, 비디오 및 임의의 다른 콘텐츠를 시각적으로 제시하도록 구성된다. 디스플레이(114)는 사용자 입력 모듈(115)에 더하여 디스플레이(114) 상에서 사용자가 장치(110)를 동작할 가능성을 제공할 수 있도록 터치스크린일 수 있다.

사용자 입력 모듈(115)은 문자 또는 명령을 입력하는 장치(110) 상의 키 또는 버튼을 포함할 수 있고 키 또는 버튼으로 입력된 문자 또는 명령을 인식하는 기능을 포함할 수 있다. 사용자 입력 모듈(115)은 디스플레이(114)가 터치스크린인 경우 선택적일 수 있고, 장치(110)는 디스플레이(114) 상에 문자 또는 명령이 입력될 수 있도록 구성된다.

스토리지(113)는 이하에서 설명하는 바와 같이 CPU(111)에 대한 소프트웨어 프로그램 및 데이터를 저장하여 눈 이동 검출기(112), 디스플레이(114) 및 사용자 입력 모듈(115)을 구동 및 동작시키도록 구성된다.

도 2a는 본 발명의 실시예에 따른 컴퓨터 장치의 사용의 기본 환경을 나타낸다. 도 2b는 추가된 광 라인을 제외하고 도 2a에 도시된 것과 동일한 기본 환경을 나타낸다. 도 2a 및 2b에서, 도 1에 도시된 컴퓨터 장치(110)는 참조 번호 "11"로 지시된다.

도 2a 및 2b는 사용자(12)가 장치(11)의 디스플레이 상에 제시된 콘텐츠를 읽거나 브라우징하고 있다는 것을 도시한다. 장치(11)에는, 사용자(12)의 얼굴을 촬영하여 사용자(12)의 눈을 검출하고 눈 및 시선의 모션을 모니터하는 카메라(10)가 갖추어져 있다. 카메라(10)는 사용자(12)의 얼굴을 촬영하고 사용자(12)의 시선점(16)을 검출한다. 카메라(10)는 도 1에 도시된 눈 이동 검출기(112)의 엘리먼트일 수 있다.

도 2b에서, 점선(14)은 카메라(10)의 시야 또는 범위를 나타낸다. 사용자의 주목을 끄는 일반적인 영역은 2개의 점선(15)으로 대략적으로 도시된다.

도 3(a) 내지 3(c)는 텍스트 라인의 좌측으로부터 우측으로 장치(11)의 디스플레이 상에 제시된 페이지 상의 하나의 텍스트 라인을 읽는 기본 읽기 프로세스를 나타낸다. 사용자의 좌측 및 우측 눈(20)은 읽기 프로세스 동안 이동한다. 도 3(a)에 도시된 바와 같이, 시선점(21)은 읽기 프로세스의 시작시에 텍스트 라인의 앞에 위치한다. 그 후, 시선점(22)은 도 3(b)에 도시된 바와 같이 텍스트 라인의 중간으로 이동하고 마지막으로 시선점(23)은 도 3(c)에 도시된 바와 같이 텍스트 라인의 끝으로 이동한다. 이들의 눈 이동이 검출되고 텍스트 라인 상의 각 시선에 대한 기간은 눈 이동 검출기(112)(도 1)에 의해 측정된다. 하나의 텍스트 라인을 읽는 총 시간은 도 1에 도시된 CPU(111)에 의해 텍스트 라인 상의 각 시선에 대한 기간을 합산함으로써 대략적으로 산출된다.

도 4(a) 내지 4(c)는 페이지의 상부로부터 하부로 장치(11)의 디스플레이 상에 제시된 전체 페이지를 읽는 기본 읽기 프로세스를 나타낸다. 도 4(a)에 도시된 바와 같이, 먼저, 사용자(30)는 텍스트 라인(31)의 좌측으로부터 우측으로 페이지 상의 첫번째 텍스트 라인(31)을 읽는다. 그 후, 사용자(30)는 텍스트 라인(32)의 좌측으로부터 우측으로 제2 텍스트 라인(32)을 읽고, 다른 텍스트 라인에 대하여 동일한 읽기 프로세스를 반복한다(도 4(b)). 마지막으로, 사용자(30)는 텍스트 라인(33)의 좌측으로부터 우측으로 마지막 텍스트 라인(33)을 읽는다(도 4(c)). 도 3(a) 내지 3(c)를 참조하여 설명한 것과 동일한 방식으로, 사용자(30)가 페이지 상의 텍스트 라인을 읽는 동안의 눈 이동이 검출되고 텍스트 라인 상의 각 시선에 대한 기간이 눈 이동 검출기(112)(도 1)에 의해 측정된다. 페이지를 읽는 총 시간은 CPU(111)(도 1)에 의해 텍스트 라인 상의 각 시선에 대한 기간을 합산함으로써 대략적으로 산출된다.

도 4(a) 내지 4(c)에 도시된 장치의 디스플레이 상에 제시된 페이지를 읽는 읽기 프로세스의 결과로서, 도 5에 도시된 눈 이동 패턴이 장치에 의해 검출된다. 도 5에 도시된 각 블랙점은 사용자의 시선점을 나타낸다. 화살표는 사용자의 시선점의 이동 방향을 의미한다. 도 5에서 알 수 있는 바와 같이, 사용자의 시선점은 각 텍스트 라인의 좌측으로부터 우측으로 및 상부 텍스트 라인으로부터 하부 텍스트 라인으로 지그재그 형상으로 이동한다.

도 4(a) 내지 4(c)에 도시된 기본 읽기 프로세스에서, 예를 들어, 장치(11)(도 2a 및 2b)는 사용자가 처음부터 끝까지 디스플레이 상의 페이지를 읽으면 디스플레이 상에 제시된 페이지를 다음 페이지로 플립(flip)하도록 구성된다.

디스플레이 상의 페이지를 플립하는 동작 메카니즘은 도 1, 5 및 6을 참조하여 설명한다. 장치(110)의 스토리지(113)에 눈 이동 패턴 및 명령을 포함하는 표가 저장된다. 표에는, 각 명령이 각각의 눈 이동 패턴과 연관된다. 사용자(50)가 도 6의 모듈(55)에 도시된 바와 같이 처음부터 끝(53)까지 페이지(51)를 읽으면, 도 5에 도시된 지그재그 형상 눈 이동 패턴이 CPU(111) 및 눈 이동 검출기(112)를 이용하여 검출된다. 그 후, CPU(111)는 검출된 눈 이동 패턴을 스토리지(113)에 저장된 표 내의 눈 이동 패턴과 비교한다. 검출된 눈 이동 패턴에 매칭되는 눈 이동 패턴을 표에서 찾으면, CPU(111)는 표에서 매칭된 눈 이동 패턴과 연관된 명령을 실행한다. 명령이 "디스플레이 상의 페이지를 플립하는" 것이면, 디스플레이 상의 페이지(51)는 도 6의 모듈(56)에 도시된 바와 같이 CPU(111)에 의해 다음 페이지(52)로 스크롤된다. 본 발명의 실시예에 따르면, 장치의 디스플레이 상에 제시된 페이지(51)는 상술한 바와 같이 카메라(10)(도 2a 및 2b)를 포함할 수 있는 눈 이동 검출기(112)(도 1)에 의해 검출된 사용자의 눈 이동에 의해 플립될 수 있고, 그 후, 사용자(50)는 도 6의 모듈(57)에 도시된 바와 같이 다음 페이지(52)를 처음(54)부터 읽기 시작할 수 있다.

도 7(a) 내지 7(f)는 눈 이동 패턴 및 눈 이동 패턴을 완료하는 기간의 상이한 종류의 조합을 나타내는 도면으로, 조합은 본 발명에 따라 컴퓨터 장치를 동작시키는 상이한 종류의 명령을 생성한다.

도 7(a)는 시선점이 좌측으로부터 우측으로 이동하는 눈 이동 패턴을 나타낸다. "좌측(LEFT)" 명령은 이 눈 이동 패턴 및 이 눈 이동 패턴을 완료한 문턱 기간(threshold time period)(T)의 조합과 연관된다. 이 눈 이동 패턴이 검출되고 눈 이동 패턴을 완료한 기간(t)이 미리 결정된 문턱 기간(T)보다 작으면, "좌측" 명령이 실행되어 이북 등의 콘텐츠의 이전 페이지가 좌측으로부터 와서 디스플레이 상에 나타낸다.

도 7(b)는 시선점이 상부로부터 하부로 이동하는 눈 이동 패턴을 나타낸다. "다음(NEXT)" 명령은 이 눈 이동 패턴과 이 눈 이동 패턴을 완료하는 문턱 기간(T)의 조합과 연관된다. 이 눈 이동 패턴이 검출되고 눈 이동 패턴을 완료한 기간(t)이 미리 결정된 문턱 기간(T)보다 작으면, "다음" 명령이 실행되어 디스플레이 상에 콘텐츠의 다음 페이지를 나타낸다.

도 7(c) 내지 7(f)는 또 다른 상이한 눈 이동 패턴을 나타낸다. 도 7(a) 및 7(b)에 도시된 경우와 마찬가지로, 명령은 눈 이동 패턴 및 눈 이동 패턴을 완료하는 문턱 기간(T)의 조합과 연관되고, 도 7(c) 내지 7(f)에 도시된 눈 이동 패턴 중의 임의의 하나가 검출되고 눈 이동 패턴을 완료하는 기간(t)이 미리 결정된 문턱 기간(T)보다 작으면 대응 명령이 실행된다. 이 예에서, 도 7(c)의 눈 이동 패턴은 디스플레이 상에 제시된 콘텐츠의 버전을 나타내는 "버전(VERSION)" 명령과 연관될 수 있고, 도 7(d)의 눈 이동 패턴은 콘텐츠의 마지막 페이지로 점프하는 "엔드(END)" 명령과 연관될 수 있고, 도 7(e)의 눈 이동 패턴은 콘텐츠의 처음 페이지로 점프하는 "홈(HOME)" 명령과 연관될 수 있고 도 7(f)의 눈 이동 패턴은 디스플레이 상에 제시된 콘텐츠를 회전하는 "회전(ROTATE)" 명령과 연관될 수 있다. 이들 명령 및 눈 이동 패턴 및 문턱 기간의 조합은 서로 연관되어 스토리지(113)(도 1)에 저장된다.

상술한 예에서, 기간(t)이 T 이상이면 어떤 명령도 실행되지 않는다. 기간(t)이 T≤t를 만족하면 사용자가 디스플레이 상의 콘텐츠를 방금 읽거나 본 것으로 인식된다.

더 많은 상이한 문턱 기간이 눈 이동 패턴과 연관될 수 있음에 주의해야 한다. 예로서 도 7(a)를 참조하면, 상술한 문턱 기간(T)에 더하여 문턱 기간(T/2)이 눈 이동 패턴과 연관될 수 있다. 이 예에서, 검출된 눈 이동 패턴을 완료한 기간(t)이 t<T/2를 만족하면 2개 이상의 이전 페이지가 좌측으로부터 와서 디스플레이 상에 페이지를 나타내고 기간(t)이 2/T≤t<T를 만족하면 단일 이전 페이지가 좌측으로부터 와서 디스플레이 상에 나타나도록 "좌측" 명령이 실행되될 수 있다. 이들 예에서 알 수 있는 바와 같이, 복수의 문턱 기간을 단일 눈 이동 패턴과 연관시킴으로써 단일 눈 이동 패턴을 이용하여 복수의 명령을 생성할 수 있다.

또한, 문턱 기간(들)에 더하여 디스플레이 상에서 추적될 눈 이동 패턴의 상이한 위치가 눈 이동 패턴과 연관될 수 있음을 주의해야 한다.

도 8(a) 내지 8(c)는 디스플레이 상의 상이한 위치에서 추적된 눈 이동 패턴을 나타낸다. 눈 이동 패턴이 디스플레이의 좌측(도 8(a)), 디스플레이의 중간(도 8(b)) 및 디스플레이의 우측(도 8(c)) 상에서 추적되는 것을 나타낸다.

문턱 기간(T)이 시선점이 상부로부터 하부로 이동하는 눈 이동 패턴과 연관되면, 예를 들어, "폰트 사이즈" 명령은 눈 이동 패턴, 이 눈 이동 패턴을 완료한 문턱 기간(T) 및 디스플레이 상에서 추적된 눈 이동 패턴의 위치의 조합(도 8(a)에 도시된 좌측 위치)과 연관될 수 있고, "다음" 명령은 눈 이동 패턴, 이 눈 이동 패턴을 완료한 문턱 기간(T) 및 디스플레이 상에서 추적된 눈 이동 패턴의 위치의 조합(도 8(b)에 도시된 중간 위치)과 연관될 수 있고, "줌" 명령은 눈 이동 패턴, 이 눈 이동 패턴을 완료한 문턱 기간(T) 및 디스플레이 상에서 추적된 눈 이동 패턴의 위치의 조합(도 8(c)에 도시된 우측 위치)과 연관될 수 있다.

도 8(a) 내지 8(c)에 도시된 눈 이동 패턴이 검출되고 눈 이동 패턴을 완료한 기간(t)이 미리 결정된 문턱 기간(T)보다 작은 조건에서,

1) 도 8(a)에 도시된 바와 같이 눈 이동 패턴이 디스플레이의 좌측 상에서 추적되면, "폰트 사이즈" 명령이 실행되어 사용자가 디스플레이 상의 폰트 사이즈를 조절하도록 하고,

2) 도 8(b)에 도시된 바와 같이 눈 이동 패턴이 디스플레이의 중간 상에서 추적되면, "다음" 명령이 실행되어 디스플레이 상에 콘텐츠의 다음 페이지를 나타내고,

3) 도 8(c)에 도시된 바와 같이 눈 이동 패턴이 디스플레이의 우측 상에서 추적되면, "줌" 명령이 실행되어 디스플레이 상의 콘텐츠를 확대한다.

물론, 더 많은 상이한 문턱 기간이 눈 이동 패턴의 상이한 위치의 각각과 연관될 수 있다. 눈 이동 패턴의 상이한 위치 또는 상이한 문턱 기간 중의 어느 하나가 단일 눈 이동 패턴과 연관되는 경우와 비교하여, 디스플레이 상의 눈 이동 패턴의 상이한 위치 및 상이한 문턱 기간을 단일 눈 이동 패턴과 연관시킴으로써 단일 눈 이동 패턴을 이용하여 더 많은 명령이 생성될 수 있다.

눈 이동 패턴 및 문턱 기간의 상이한 조합은 스토리지(113)(도 1)에 저장된다. 각 조합은 디스플레이 상의 눈 이동 패턴의 위치를 포함할 수 있다. 또한, 상이한 명령은 상이한 명령이 스토리지(113) 내의 각각의 조합과 연관된 상태에서 스토리지(113)에 저장된다. 이들 상이한 조합 및 그 연관된 명령은 스토리지에 표의 형태로 저장될 수 있다.

사용자에 의해 디스플레이 상에 형성된 눈 이동 패턴은 도 7 및 8에 지시된 눈 이동 패턴 중의 하나와 정확히 동일하지 않을 수 있고, 본 발명의 상술한 실시예에서, 눈 이동 패턴은 눈 이동 패턴이 그 기준 눈 이동 패턴과 비교하여 소정의 허용가능 범위 내에서 변형되더라도 검출될 수 있다는 점에 유의한다.

디스플레이의 사이즈에 대하여 도 7 및 8에 도시된 각 눈 이동 패턴의 상대 사이즈는 도 7 및 8에 도시된 예로 한정되지 않음에 주의해야 한다. 디스플레이 상의 눈 이동 패턴은 눈 이동 패턴이 장치에 의해 검출될 수 있는 한 임의의 사이즈일 수 있다.

도 9는 본 발명의 실시예에 따라 사용자의 눈 이동으로 컴퓨터 장치를 동작시키는 방법을 나타내는 플로우챠트이다. 컴퓨터 장치를 동작시키는 방법은 도 1 및 9를 참조하여 이하에서 설명한다.

단계(S102)에서, 컴퓨터 장치(110)의 사용자의 눈 이동은 장치(110)의 눈 이동 검출기(112)에 의해 검출된다. 이 단계에서, 장치(110)의 사용자의 눈이 검출되고 눈 및 시선의 모션은 눈 이동 검출기(112)에 의해 모니터된다. 또한, 디스플레이(114) 상의 각각의 시선 위치가 검출되고 각 시선에 대한 시간이 눈 이동 검출기(112)에 의해 측정된다.

단계(S104)에서, 사용자의 검출된 눈 이동은 장치(110)의 CPU(111)에 의해 분석된다. 이 단계에서, 검출된 눈 이동에 포함된 눈 이동 패턴 및 눈 이동 패턴을 완료한 기간이 장치(110)의 CPU(111)에 의해 특정된다. CPU(111)는 검출된 눈 이동을 스토리지(113)에 저장된 눈 이동 패턴을 비교함으로써 눈 이동 패턴을 결정한다. 눈 이동 패턴이 특정되면, CPU(111)는 특정된 눈 이동 패턴에 대한 총 시선 시간을 산출함으로써 특정된 눈 이동 패턴을 완료하는 기간을 특정한다. 이 단계에서, 디스플레이(114) 상의 특정된 눈 이동 패턴의 위치는 또한 CPU(111)에 의해 특정될 수 있다.

단계(S106)에서, 눈 이동 패턴 및 눈 이동 패턴에 대한 문턱 기간의 조합과 연관된 명령은 CPU(111)에 의해 결정된다. 이 단계에서, CPU(111)는 스토리지(113)를 검색하여 특정된 눈 이동 패턴이 매칭되는 눈 이동 패턴을 찾는다. 그 후, CPU(111)는 특정된 눈 이동 패턴을 완료한 특정 기간이 매칭된 눈 이동 패턴과 연관된 미리 결정된 문턱 기간을 만족하는지를 결정한다. 특정된 기간이 미리 결정된 문턱 기간을 만족하면, 매칭된 눈 이동 패턴 및 매칭된 눈 이동 패턴에 대한 미리 결정된 문턱 기간의 조합과 연관된 명령이 CPU(111)에 의해 결정된다.

단계(S106)에서, 디스플레이 상의 눈 이동 패턴의 위치가 눈 이동 패턴 및 문턱 기간의 조합과 연관되고 디스플레이(114) 상의 특정된 눈 이동 패턴의 위치가 CPU(111)에 의해 특정되면, 매칭된 눈 이동 패턴, 매칭된 눈 이동 패턴에 대한 문턱 기간 및 디스플레이 상의 매칭된 눈 이동 패턴의 위치를 포함하는 3개의 엘리먼트의 조합과 연관된 명령이 CPU(111)에 의해 결정된다.

단계(S108)에서, CPU(111)는 결정된 명령을 실행하고, 그 후, 컴퓨터 장치(110)는 명령에 따라 동작한다.

본 원리의 이들 및 다른 특징 및 이점은 여기에 기재된 사상에 기초하여 당업자에 의해 용이하게 확인될 수 있다. 본 원리의 사상은 하드웨어, 소프트웨어, 펌웨어, 특수 목적 프로세서 또는 그 조합의 다양한 형태로 구현될 수 있다는 것이 이해될 것이다.

더 바람직하게, 본 원리의 사상은 하드웨어 및 소프트웨어의 조합으로서 구현될 수 있다. 또한, 소프트웨어는 프로그램 스토리지 유닛 상에서 유형(tangibly)으로 구현되는 애플리케이션 프로그램으로서 구현될 수 있다. 애플리케이션 프로그램은 임의의 적절한 아키텍쳐를 포함하는 머신에 업로드되어 실행될 수 있다. 바람직하게, 머신은 하나 이상의 중앙 처리 장치(CPU), 랜덤 액세스 메모리(RAM) 및 입출력(I/O) 인터페이스 등의 하드웨어를 갖는 컴퓨터 플랫폼 상에서 구현된다. 컴퓨터 플랫폼은 또한 오퍼레이팅 시스템 및 마이크로명령어 코드를 포함할 수 있다. 여기에 기재된 다양한 프로세스 및 기능은 CPU에 의해 실행될 수 있는 마이크로 명령어 코드의 일부 또는 애플리케이션 프로그램의 일부 또는 그 임의의 조합일 수 있다. 또한, 다양한 다른 주변 유닛은 추가의 데이터 저장 유닛 등의 컴퓨터 플랫폼에 접속될 수 있다.

첨부된 도면에 도시된 구성 시스템 컴포넌트 및 방법의 일부는 소프트웨어에서 바람직하게 구현되기 때문에, 시스템 컴포넌트 또는 프로세스 기능 블록 간의 실제 접속은 본 원리가 프로그래밍되는 방법에 따라 달라질 수 있다는 점이 이해될 것이다. 본 사상을 고려하면, 당업자는 본 원리의 이들 및 유사한 구현예 및 구성을 예상할 수 있다.

예시적인 실시예는 첨부된 도면을 참조하여 설명하지만, 본 원리는 이들 정밀한 실시예로 한정되지 않고, 본 원리의 범위 또는 사상을 벗어나지 않고 당업자에 의해 다양하게 변형 및 수정될 수 있다. 이러한 모든 변형 및 수정은 첨부된 청구범위에 기재된 바와 같이 본 원리의 범위 내에 포함된다.

Claims (13)

- 사용자의 눈 이동으로 동작가능한 컴퓨터 장치(110)로서,

상기 사용자의 눈 이동을 검출하는 수단(112);

상기 검출된 사용자의 눈 이동 내의 눈 이동 패턴 및 상기 눈 이동 패턴을 완료한 기간을 특정하기 위하여 상기 사용자의 눈 이동을 분석하는 수단(111);

상기 눈 이동 패턴 및 상기 기간의 조합과 연관된 명령(command)을 결정하는 수단(111); 및

상기 명령에 따라 상기 장치를 동작시키는 수단(111)

을 포함하는 컴퓨터 장치. - 제1항에 있어서,

상기 장치(110)는 눈 이동 패턴 및 상기 눈 이동 패턴에 대한 기간의 상이한 조합들 및 각각의 조합과 연관된 상이한 명령들을 저장하는 수단(113)을 더 포함하는 컴퓨터 장치. - 제2항에 있어서,

상기 검출하는 수단(112)은 사용자의 시선 위치(eye gaze positions)를 수집하도록 구성되고,

상기 분석하는 수단(111)은 상기 수집된 사용자의 시선 위치가 상기 저장하는 수단(113)에 저장된 상이한 조합들 내의 임의의 눈 이동 패턴과 일치하는지를 결정하고 상기 눈 이동 패턴을 완료한 기간을 결정하도록 구성되는 컴퓨터 장치. - 제2항에 있어서,

상기 장치(110)는 디스플레이(114)를 더 포함하고, 상기 분석하는 수단(111)은 상기 디스플레이 상의 검출된 눈 이동 패턴의 위치를 식별하도록 구성되고, 상기 각각의 조합은 상기 디스플레이 상의 눈 이동 패턴의 위치를 더 포함하고,

상기 검출하는 수단(112)은 상기 사용자의 시선 위치를 수집하도록 구성되고,

상기 분석하는 수단(111)은 상기 수집된 사용자의 시선 위치가 상기 저장하는 수단(113)에 저장된 상이한 조합들 내의 임의의 눈 이동 패턴과 일치하는지를 결정하고 상기 눈 이동 패턴을 완료한 기간을 결정하도록 구성되고,

상기 결정하는 수단(111)은 상기 눈 이동 패턴, 상기 기간 및 상기 디스플레이 상의 눈 이동 패턴의 위치의 조합과 연관된 명령을 결정하는 컴퓨터 장치. - 사용자의 눈 이동으로 동작가능한 컴퓨터 장치(110)로서,

상기 사용자의 눈 이동을 검출하는 검출기(112); 및

상기 검출된 사용자의 눈 이동 내의 눈 이동 패턴 및 상기 눈 이동 패턴을 완료한 기간을 특정하기 위하여 상기 사용자의 눈 이동을 분석하고, 상기 눈 이동 패턴 및 상기 기간의 조합과 연관된 명령을 결정하고, 상기 명령에 따라 상기 장치를 동작시키도록 구성되는 프로세서(111)

를 포함하는 컴퓨터 장치. - 제5항에 있어서, 상기 장치는 눈 이동 패턴 및 상기 눈 이동 패턴에 대한 기간의 상이한 조합들 및 각각의 조합과 연관된 상이한 명령들을 저장하는 스토리지(113)를 더 포함하는 컴퓨터 장치.

- 제6항에 있어서,

상기 검출기(112)는 상기 사용자의 시선 위치를 수집하도록 구성되고,

상기 프로세서(111)는 상기 수집된 사용자의 시선 위치가 상기 스토리지(113)에 저장된 상이한 조합들 내의 임의의 눈 이동 패턴과 일치하는지를 결정하고 상기 눈 이동 패턴을 완료한 기간을 결정하도록 더 구성되는 컴퓨터 장치. - 제6항에 있어서,

상기 장치는 디스플레이(114)를 더 포함하고,

상기 프로세서(111)는 상기 디스플레이 상의 상기 검출된 눈 이동 패턴의 위치를 식별하도록 구성되고, 상기 각각의 조합은 상기 디스플레이 상의 눈 이동 패턴의 위치를 더 포함하고,

상기 검출기(112)는 상기 사용자의 시선 위치를 수집하도록 구성되고,

상기 프로세서(111)는 상기 수집된 사용자의 시선 위치가 상기 스토리지(113)에 저장된 상이한 조합들 내의 임의의 눈 이동 패턴과 일치하는지를 결정하고, 상기 눈 이동 패턴을 완료한 기간을 결정하고, 상기 눈 이동 패턴, 상기 기간 및 상기 디스플레이 상의 눈 이동 패턴의 위치의 조합과 연관된 명령을 결정하도록 더 구성되는 컴퓨터 장치. - 사용자의 눈 이동으로 컴퓨터 장치를 동작시키는 방법으로서,

상기 사용자의 눈 이동을 검출하는 단계(S102);

상기 검출된 사용자의 눈 이동 내의 눈 이동 패턴 및 상기 눈 이동 패턴을 완료한 기간을 특정하기 위하여 상기 사용자의 눈 이동을 분석하는 단계(S104);

상기 눈 이동 패턴 및 상기 기간의 조합과 연관된 명령을 결정하는 단계(S106); 및

상기 명령에 따라 상기 장치를 동작시키는 단계(S108)

를 포함하는 방법. - 제9항에 있어서,

상기 장치는 스토리지를 포함하고, 눈 이동 패턴 및 상기 눈 이동 패턴에 대한 기간의 상이한 조합들 및 각각의 조합과 연관된 상이한 명령들이 상기 스토리지에 저장되는 방법. - 제10항에 있어서,

상기 검출하는 단계(S102)는 사용자의 시선 위치를 수집하는 단계를 포함하고,

상기 분석하는 단계(S104)는,

상기 수집된 사용자의 시선 위치가 상기 스토리지에 저장된 상이한 조합들 내의 임의의 눈 이동 패턴과 일치하는지를 결정하는 단계, 및

상기 눈 이동 패턴을 완료한 기간을 결정하는 단계를 포함하는 방법. - 제10항에 있어서,

상기 장치는 디스플레이를 포함하고,

상기 분석하는 단계(S104)는 상기 디스플레이 상의 검출된 눈 이동 패턴의 위치를 더 식별하고, 상기 각각의 조합은 상기 디스플레이 상의 눈 이동 패턴의 위치를 더 포함하고,

상기 검출하는 단계(S102)는 상기 사용자의 시선 위치를 수집하는 단계를 포함하고,

상기 분석하는 단계(S104)는,

상기 수집된 사용자의 시선 위치가 상기 스토리지에 저장된 상이한 조합들 내의 임의의 눈 이동 패턴과 일치하는지를 결정하는 단계, 및

상기 눈 이동 패턴을 완료한 기간을 결정하는 단계

를 포함하고,

상기 결정하는 단계(S106)는 상기 눈 이동 패턴, 상기 기간 및 상기 디스플레이 상의 눈 이동 패턴의 위치의 조합과 연관된 명령을 결정하는 단계를 포함하는 방법. - 컴퓨터에 의해 판독가능한 저장 매체로서 - 상기 저장 매체는 사용자의 눈 이동으로 동작가능한 컴퓨터 장치(110)에 대한 프로그램을 저장함 - ,

상기 장치는,

상기 사용자의 눈 이동을 검출하는 검출기(112); 및

프로세서(111)

를 포함하고,

상기 프로그램은, 상기 프로세서(111)로 하여금,

상기 검출기에 의해 상기 사용자의 눈 이동을 검출하고(S102);

상기 검출된 사용자의 눈 이동 내의 눈 이동 패턴 및 상기 눈 이동 패턴을 완료한 기간을 특정하기 위하여 상기 사용자의 눈 이동을 분석하고(S104);

상기 눈 이동 패턴 및 상기 기간의 조합과 연관된 명령을 결정하고(S106); 및

상기 명령에 따라 상기 장치를 동작(S108)시키도록 하는, 저장 매체.

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| PCT/CN2011/076288 WO2012174743A1 (en) | 2011-06-24 | 2011-06-24 | Computer device operable with user's eye movement and method for operating the computer device |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20140041570A true KR20140041570A (ko) | 2014-04-04 |

Family

ID=47422002

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020137033858A KR20140041570A (ko) | 2011-06-24 | 2011-06-24 | 사용자의 눈 이동으로 동작가능한 컴퓨터 장치 및 컴퓨터 장치를 동작하는 방법 |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US9411416B2 (ko) |

| EP (1) | EP2724209B1 (ko) |

| JP (1) | JP5885835B2 (ko) |

| KR (1) | KR20140041570A (ko) |

| CN (1) | CN103782251A (ko) |

| WO (1) | WO2012174743A1 (ko) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20190078690A (ko) * | 2017-12-13 | 2019-07-05 | 현대자동차주식회사 | 사용자 사용 언어 방향에 따라 디스플레이 환경을 구성하는 디스플레이 제어 장치 및 그 방법 |

Families Citing this family (21)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2013091245A1 (en) * | 2011-12-23 | 2013-06-27 | Thomson Licensing | Computer device with power-consumption management and method for managing power-consumption of computer device |

| WO2014111924A1 (en) | 2013-01-15 | 2014-07-24 | Poow Innovation Ltd. | Dynamic icons |

| JP2015014938A (ja) * | 2013-07-05 | 2015-01-22 | 由田新技股▲分▼有限公司 | 車内アイコントロール方法、およびその方法を実現する電子デバイス |

| JP6213027B2 (ja) * | 2013-08-06 | 2017-10-18 | 富士通株式会社 | 精読判断装置、精読判断方法及び精読判断プログラム |

| US10686972B2 (en) | 2013-09-03 | 2020-06-16 | Tobii Ab | Gaze assisted field of view control |

| US10310597B2 (en) | 2013-09-03 | 2019-06-04 | Tobii Ab | Portable eye tracking device |

| CN108209857B (zh) * | 2013-09-03 | 2020-09-11 | 托比股份公司 | 便携式眼睛追踪设备 |

| US10026095B2 (en) * | 2013-09-10 | 2018-07-17 | Chian Chiu Li | Systems and methods for obtaining and utilizing user reaction and feedback |

| JP6115418B2 (ja) * | 2013-09-11 | 2017-04-19 | 富士通株式会社 | 情報処理装置、方法及びプログラム |

| TWI550438B (zh) * | 2013-10-04 | 2016-09-21 | 由田新技股份有限公司 | 記錄閱讀行爲的方法及裝置 |

| US10878446B2 (en) * | 2014-08-18 | 2020-12-29 | Chian Chiu Li | Systems and methods for obtaining and utilizing user reaction and feedback |

| JP6038089B2 (ja) * | 2014-09-22 | 2016-12-07 | 京セラドキュメントソリューションズ株式会社 | 文書閲覧装置、文書閲覧装置の制御方法 |

| CN104317396B (zh) * | 2014-10-10 | 2017-11-17 | 宇龙计算机通信科技(深圳)有限公司 | 一种屏幕自动形变的方法、装置及终端设备 |

| US9529432B2 (en) * | 2014-12-22 | 2016-12-27 | Rakuten Kobo, Inc. | Progressive page transition feature for rendering e-books on computing devices |

| CN104793732A (zh) * | 2015-01-04 | 2015-07-22 | 北京君正集成电路股份有限公司 | 一种智能眼镜的操作方法及智能眼镜 |

| EP3276618A4 (en) * | 2015-03-23 | 2018-11-07 | Sony Corporation | Information processing system and information processing method |

| US11470365B2 (en) | 2016-03-17 | 2022-10-11 | Melanie Schulz | Video reader with music word learning feature |

| CN106528689B (zh) * | 2016-10-24 | 2019-11-01 | 北京小米移动软件有限公司 | 页面内容的展示方法及装置、电子设备 |

| US11544359B2 (en) * | 2016-11-08 | 2023-01-03 | Proprius Technolgies S.A.R.L | Unique patterns extracted from involuntary eye motions to identify individuals |

| US20220253136A1 (en) * | 2021-02-11 | 2022-08-11 | Apple Inc. | Methods for presenting and sharing content in an environment |

| US11775060B2 (en) * | 2021-02-16 | 2023-10-03 | Athena Accessible Technology, Inc. | Systems and methods for hands-free scrolling |

Family Cites Families (39)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US4973149A (en) * | 1987-08-19 | 1990-11-27 | Center For Innovative Technology | Eye movement detector |

| WO1993014454A1 (en) * | 1992-01-10 | 1993-07-22 | Foster-Miller, Inc. | A sensory integrated data interface |

| US5360971A (en) * | 1992-03-31 | 1994-11-01 | The Research Foundation State University Of New York | Apparatus and method for eye tracking interface |

| US5517021A (en) * | 1993-01-19 | 1996-05-14 | The Research Foundation State University Of New York | Apparatus and method for eye tracking interface |

| JP3359948B2 (ja) * | 1993-03-31 | 2002-12-24 | 株式会社東芝 | 資料呈示装置及び方法 |

| US5835083A (en) * | 1996-05-30 | 1998-11-10 | Sun Microsystems, Inc. | Eyetrack-driven illumination and information display |

| JP2000010722A (ja) * | 1998-06-18 | 2000-01-14 | Mr System Kenkyusho:Kk | 視線ユーザ・インタフェース装置、そのインタフェース方法、コンピュータ装置、その制御方法、およびプログラム記憶媒体 |

| JP3567084B2 (ja) | 1998-06-30 | 2004-09-15 | シャープ株式会社 | 電子ブック装置 |

| US6106119A (en) * | 1998-10-16 | 2000-08-22 | The Board Of Trustees Of The Leland Stanford Junior University | Method for presenting high level interpretations of eye tracking data correlated to saved display images |

| US6195640B1 (en) | 1999-01-29 | 2001-02-27 | International Business Machines Corporation | Audio reader |

| US6873314B1 (en) * | 2000-08-29 | 2005-03-29 | International Business Machines Corporation | Method and system for the recognition of reading skimming and scanning from eye-gaze patterns |

| JP2003162356A (ja) * | 2001-11-28 | 2003-06-06 | Nec Corp | スクロール制御装置及びその方法並びにそれを用いた通信端末 |

| US7365738B2 (en) | 2003-12-02 | 2008-04-29 | International Business Machines Corporation | Guides and indicators for eye movement monitoring systems |

| US7091471B2 (en) * | 2004-03-15 | 2006-08-15 | Agilent Technologies, Inc. | Using eye detection for providing control and power management of electronic devices |

| US20110077548A1 (en) * | 2004-04-01 | 2011-03-31 | Torch William C | Biosensors, communicators, and controllers monitoring eye movement and methods for using them |

| JP2006107048A (ja) | 2004-10-04 | 2006-04-20 | Matsushita Electric Ind Co Ltd | 視線対応制御装置および視線対応制御方法 |

| WO2006100645A2 (en) | 2005-03-24 | 2006-09-28 | Koninklijke Philips Electronics, N.V. | Immersive reading experience using eye tracking |

| CN1293446C (zh) | 2005-06-02 | 2007-01-03 | 北京中星微电子有限公司 | 一种非接触式目控操作系统和方法 |

| US7438414B2 (en) * | 2005-07-28 | 2008-10-21 | Outland Research, Llc | Gaze discriminating electronic control apparatus, system, method and computer program product |

| WO2007089198A1 (en) * | 2006-02-01 | 2007-08-09 | Tobii Technology Ab | Generation of graphical feedback in a computer system |

| JP5129478B2 (ja) * | 2006-03-24 | 2013-01-30 | 株式会社デンソーアイティーラボラトリ | 画面表示装置 |

| JP4685708B2 (ja) * | 2006-05-22 | 2011-05-18 | 富士通株式会社 | 携帯端末装置 |

| US10437459B2 (en) | 2007-01-07 | 2019-10-08 | Apple Inc. | Multitouch data fusion |

| CN101308400A (zh) * | 2007-05-18 | 2008-11-19 | 肖斌 | 基于眼动和头动检测的新型人机交互装置 |

| US8122384B2 (en) * | 2007-09-18 | 2012-02-21 | Palo Alto Research Center Incorporated | Method and apparatus for selecting an object within a user interface by performing a gesture |

| JP2009075937A (ja) * | 2007-09-21 | 2009-04-09 | Victor Co Of Japan Ltd | 機器動作設定装置 |

| WO2009093435A1 (ja) * | 2008-01-25 | 2009-07-30 | Panasonic Corporation | 脳波インタフェースシステム、脳波インタフェース装置、方法およびコンピュータプログラム |

| CN101291364B (zh) * | 2008-05-30 | 2011-04-27 | 华为终端有限公司 | 一种移动通信终端的交互方法、装置及移动通信终端 |

| KR20090127779A (ko) | 2008-06-09 | 2009-12-14 | 김영규 | 동공 인식을 이용한 속독 기술 |

| JP5289889B2 (ja) * | 2008-10-24 | 2013-09-11 | シャープ株式会社 | 表示装置、表示装置の制御方法、表示装置を制御するためのプログラム |

| WO2010051037A1 (en) * | 2008-11-03 | 2010-05-06 | Bruce Reiner | Visually directed human-computer interaction for medical applications |

| CN101441513B (zh) * | 2008-11-26 | 2010-08-11 | 北京科技大学 | 一种利用视觉进行非接触式人机交互的系统 |

| US20100182232A1 (en) | 2009-01-22 | 2010-07-22 | Alcatel-Lucent Usa Inc. | Electronic Data Input System |

| US8255827B2 (en) * | 2009-01-26 | 2012-08-28 | Microsoft Corporation | Dynamic feature presentation based on vision detection |

| WO2010118292A1 (en) * | 2009-04-09 | 2010-10-14 | Dynavox Systems, Llc | Calibration free, motion tolerant eye-gaze direction detector with contextually aware computer interaction and communication methods |

| WO2012036324A1 (ko) * | 2010-09-13 | 2012-03-22 | 엘지전자 주식회사 | 이동 단말기 및 그 동작 제어 방법 |

| JP5558983B2 (ja) | 2010-09-15 | 2014-07-23 | Necカシオモバイルコミュニケーションズ株式会社 | 画面表示装置、画面表示制御方法及び画面表示制御プログラム並びに情報端末装置 |

| US8655796B2 (en) * | 2011-06-17 | 2014-02-18 | Sanjay Udani | Methods and systems for recording verifiable documentation |

| US8451246B1 (en) * | 2012-05-11 | 2013-05-28 | Google Inc. | Swipe gesture classification |

-

2011

- 2011-06-24 US US14/128,625 patent/US9411416B2/en active Active

- 2011-06-24 KR KR1020137033858A patent/KR20140041570A/ko not_active Application Discontinuation

- 2011-06-24 CN CN201180071788.XA patent/CN103782251A/zh active Pending

- 2011-06-24 WO PCT/CN2011/076288 patent/WO2012174743A1/en active Application Filing

- 2011-06-24 EP EP11868364.8A patent/EP2724209B1/en active Active

- 2011-06-24 JP JP2014516161A patent/JP5885835B2/ja active Active

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| KR20190078690A (ko) * | 2017-12-13 | 2019-07-05 | 현대자동차주식회사 | 사용자 사용 언어 방향에 따라 디스플레이 환경을 구성하는 디스플레이 제어 장치 및 그 방법 |

Also Published As

| Publication number | Publication date |

|---|---|

| EP2724209B1 (en) | 2019-07-31 |

| JP5885835B2 (ja) | 2016-03-16 |

| CN103782251A (zh) | 2014-05-07 |

| EP2724209A4 (en) | 2014-11-26 |

| US20140125585A1 (en) | 2014-05-08 |

| WO2012174743A1 (en) | 2012-12-27 |

| EP2724209A1 (en) | 2014-04-30 |

| US9411416B2 (en) | 2016-08-09 |

| JP2014517429A (ja) | 2014-07-17 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR20140041570A (ko) | 사용자의 눈 이동으로 동작가능한 컴퓨터 장치 및 컴퓨터 장치를 동작하는 방법 | |

| US11650659B2 (en) | User input processing with eye tracking | |

| US9646200B2 (en) | Fast pose detector | |

| US9672421B2 (en) | Method and apparatus for recording reading behavior | |

| TWI455015B (zh) | 阻絕使用者內容的裝置、使用者偵測方法、及儲存其指令的機器可讀取儲存媒體 | |

| CN102087582B (zh) | 一种自动滚屏的方法及装置 | |

| KR101477592B1 (ko) | 카메라 기반 정보 입력 방법 및 단말 | |

| CN105631399A (zh) | 用于体育视频识别的快速对象跟踪框架 | |

| CN103336576A (zh) | 一种基于眼动追踪进行浏览器操作的方法及装置 | |

| JP2015153195A (ja) | ジェスチャ認識装置およびジェスチャ認識装置の制御方法 | |

| US9013591B2 (en) | Method and system of determing user engagement and sentiment with learned models and user-facing camera images | |

| US20140009395A1 (en) | Method and system for controlling eye tracking | |

| KR101631011B1 (ko) | 제스처 인식 장치 및 제스처 인식 장치의 제어 방법 | |

| US20130329948A1 (en) | Subject tracking device and subject tracking method | |

| EP3699808B1 (en) | Facial image detection method and terminal device | |

| CN110007748B (zh) | 终端的控制方法、处理装置、存储介质及终端 | |

| JP2014215679A (ja) | 画像処理システム、画像処理方法及びプログラム | |

| CN113743169B (zh) | 手掌平面检测方法、装置、电子设备及存储介质 | |

| EP4339756A1 (en) | Intelligent drawing method and system for human machine interaction hmi design prototype |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A201 | Request for examination | ||

| E902 | Notification of reason for refusal | ||

| E601 | Decision to refuse application |