JP7329967B2 - 画像処理装置、システム、画像処理装置の制御方法、及び、プログラム - Google Patents

画像処理装置、システム、画像処理装置の制御方法、及び、プログラム Download PDFInfo

- Publication number

- JP7329967B2 JP7329967B2 JP2019097071A JP2019097071A JP7329967B2 JP 7329967 B2 JP7329967 B2 JP 7329967B2 JP 2019097071 A JP2019097071 A JP 2019097071A JP 2019097071 A JP2019097071 A JP 2019097071A JP 7329967 B2 JP7329967 B2 JP 7329967B2

- Authority

- JP

- Japan

- Prior art keywords

- image

- subject

- predetermined position

- image processing

- tracking

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/50—Context or environment of the image

- G06V20/52—Surveillance or monitoring of activities, e.g. for recognising suspicious objects

- G06V20/53—Recognition of crowd images, e.g. recognition of crowd congestion

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G06T7/246—Analysis of motion using feature-based methods, e.g. the tracking of corners or segments

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/103—Static body considered as a whole, e.g. static pedestrian or occupant recognition

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/20—Movements or behaviour, e.g. gesture recognition

- G06V40/23—Recognition of whole body movements, e.g. for sport training

- G06V40/25—Recognition of walking or running movements, e.g. gait recognition

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/61—Control of cameras or camera modules based on recognised objects

- H04N23/611—Control of cameras or camera modules based on recognised objects where the recognised objects include parts of the human body

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/66—Remote control of cameras or camera parts, e.g. by remote control devices

- H04N23/661—Transmitting camera control signals through networks, e.g. control via the Internet

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N23/00—Cameras or camera modules comprising electronic image sensors; Control thereof

- H04N23/60—Control of cameras or camera modules

- H04N23/695—Control of camera direction for changing a field of view, e.g. pan, tilt or based on tracking of objects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30196—Human being; Person

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30232—Surveillance

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30241—Trajectory

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Signal Processing (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Human Computer Interaction (AREA)

- Health & Medical Sciences (AREA)

- General Health & Medical Sciences (AREA)

- Psychiatry (AREA)

- Social Psychology (AREA)

- Image Analysis (AREA)

- Closed-Circuit Television Systems (AREA)

Description

時間的に連続する処理対象画像において、被写体を検出し、同一の被写体を追尾する追尾手段と、

前記追尾の結果を、前記処理対象画像に含まれる1つ以上の所定位置のうちのいずれか1つと関連付ける関連付け手段と、

前記1つの所定位置と関連付けられた前記追尾の結果に基づいて、該1つの所定位置との関連で前記被写体が滞留している滞留時間を決定する決定手段と、

を備え、

前記関連付け手段は、前記1つ以上の所定位置のうちから、前記追尾の結果における前記被写体との距離又は前記被写体の向きに基づいて1つの所定位置を特定して、前記追尾の結果と関連付けることを特徴とする。

[実施形態1]

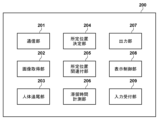

図1(A)を参照して、発明の実施形態に係るシステム構成について説明する。図1(A)は、本実施形態における画像処理システム10の構成の一例を示したブロック図である。本実施形態において、画像処理システム10は、例えば店舗、劇場、映画館、スタジアム、病院、駅構内などの所定位置にある窓口や接客カウンタ、会計レジなど人が対応を受けるような場所に対して適用される。画像処理システム10は、所定位置の窓口に並ぶ人物を撮影し、対応に要した時間を滞留時間として測定する。また、画像処理システム10は、少なくとも1台の撮像装置(ネットワークカメラ)110と画像処理装置120とがネットワーク130を介して接続されて構成される。

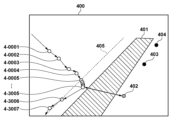

S303において、人体追尾部203は、処理対象の画像を解析して人体の向いている方向(向き)を特定することができる。人体の向きは、人体の顔や体の特徴量に基づいて判定することができる。人体の向きの情報は、例えば、画像に対して適用されるX-Y座標のX軸、或いはY軸のいずれかに対する傾き(角度、例:0度、±30度、±45度等)を表す情報として生成することができる。例えば、画像の横軸に相当するX軸を基準とする場合、人体が真横を見ていれば傾きは0度となる。また、斜め下方向を向いている場合には、傾きは-30度となる。このようにして得られた向きの情報は、位置情報と同様に、時間的に連続するフレーム画像における人体の向きの情報が人体の識別情報と関連付けられる。

本発明は、上述の実施形態の1以上の機能を実現するプログラムを、ネットワーク又は記憶媒体を介してシステム又は装置に供給し、そのシステム又は装置のコンピュータにおける1つ以上のプロセッサがプログラムを読出し実行する処理でも実現可能である。また、1以上の機能を実現する回路(例えば、ASIC)によっても実現可能である。

Claims (13)

- 処理対象画像から検出される被写体を追尾する追尾手段と、

前記追尾手段による追尾の結果を、前記処理対象画像における1つ以上の所定位置のうちのいずれか1つと関連付ける関連付け手段と、

前記関連付け手段により前記1つの所定位置と関連付けられた前記追尾の結果に基づいて、該1つの所定位置との関連で前記被写体が滞留している滞留時間を決定する決定手段と、

を備え、

前記関連付け手段は、前記1つ以上の所定位置のうち、前記被写体との距離が一番近い所定位置か、又は前記被写体の向きに基づいて特定される所定位置を前記1つの所定位置として前記追尾の結果と関連付け、

前記決定手段は、前記追尾の結果に含まれる、前記被写体が検出された時刻の情報に基づいて、前記滞留時間を決定することを特徴とする画像処理装置。 - 前記関連付け手段は、前記1つ以上の所定位置のうち、前記被写体のいずれかの位置との距離が最小となる1つの所定位置を特定して前記追尾の結果と関連付けることを特徴とする請求項1に記載の画像処理装置。

- 前記関連付け手段は、前記1つ以上の所定位置のうち、前記被写体のそれぞれの位置との距離の合計が最小となる1つの所定位置を特定して前記追尾の結果と関連付けることを特徴とする請求項1に記載の画像処理装置。

- 前記処理対象画像は、所定の領域を撮影して得られた画像であって、

前記関連付け手段は、前記処理対象画像を前記領域の空間に対応するように座標変換して得られた画像において前記距離を算出することを特徴とする請求項1から3のいずれか1項に記載の画像処理装置。 - 前記関連付け手段は、前記1つ以上の所定位置のうち、前記追尾の結果におけるそれぞれの所定位置に最も近い被写体の向きに基づき前記1つの所定位置を特定することを特徴とする請求項1に記載の画像処理装置。

- 前記関連付け手段は、前記追尾の結果において、静的な状態にあるとみなされた前記被写体の向きに基づき前記1つの所定位置を特定することを特徴とする請求項1に記載の画像処理装置。

- 前記関連付け手段は、前記1つ以上の所定位置のうち、前記追尾の結果における前記被写体のそれぞれの位置における被写体の向きに基づき前記1つの所定位置を特定することを特徴とする請求項1に記載の画像処理装置。

- 前記決定手段は、最初に前記被写体が検出された時刻から、最後に前記被写体が検出された時刻までの経過時間に基づき前記滞留時間を決定することを特徴とする請求項1に記載の画像処理装置。

- 前記決定手段は、前記被写体が移動していると判定される期間を前記滞留時間から除外することを特徴とする請求項1に記載の画像処理装置。

- 前記追尾の結果には、前記処理対象画像における前記被写体の検出位置の情報が含まれ、

前記決定手段は、前記追尾の結果に含まれる前記被写体の検出位置のうち、前記1つの所定位置から所定範囲内にある検出位置に基づき、前記滞留時間を決定することを特徴とする請求項1に記載の画像処理装置。 - 所定の領域を撮像して画像を生成する撮像装置と、

前記撮像装置により生成された画像を前記処理対象画像として処理する請求項1から10のいずれか1項に記載の画像処理装置と

を備えるシステム。 - 追尾手段が、処理対象画像から検出される被写体を追尾する工程と、

関連付け手段が、前記追尾手段によるの結果を、前記処理対象画像における1つ以上の所定位置のうちのいずれか1つと関連付ける工程と、

決定手段が、前記関連付け手段により前記1つの所定位置と関連付けられた前記追尾の結果に基づいて、該1つの所定位置との関連で前記被写体が滞留している滞留時間を決定する工程と、

を含み、

前記関連付ける工程では、前記1つ以上の所定位置のうち、前記被写体との距離が一番近い所定位置か、又は前記被写体の向きに基づいて特定される所定位置を前記1つの所定位置として前記追尾の結果と関連付け、

前記決定する工程では、前記追尾の結果に含まれる、前記被写体が検出された時刻の情報に基づいて、前記滞留時間を決定することを特徴とする画像処理装置の制御方法。 - コンピュータを請求項1から10のいずれか1項に記載の画像処理装置の各手段として機能させるためのプログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2019097071A JP7329967B2 (ja) | 2019-05-23 | 2019-05-23 | 画像処理装置、システム、画像処理装置の制御方法、及び、プログラム |

| US16/877,921 US11551455B2 (en) | 2019-05-23 | 2020-05-19 | Image processing apparatus, system, control method for image processing apparatus, and non- transitory computer-readable storage medium |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2019097071A JP7329967B2 (ja) | 2019-05-23 | 2019-05-23 | 画像処理装置、システム、画像処理装置の制御方法、及び、プログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2020191590A JP2020191590A (ja) | 2020-11-26 |

| JP2020191590A5 JP2020191590A5 (ja) | 2022-05-24 |

| JP7329967B2 true JP7329967B2 (ja) | 2023-08-21 |

Family

ID=73454769

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2019097071A Active JP7329967B2 (ja) | 2019-05-23 | 2019-05-23 | 画像処理装置、システム、画像処理装置の制御方法、及び、プログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US11551455B2 (ja) |

| JP (1) | JP7329967B2 (ja) |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP7370840B2 (ja) | 2019-12-09 | 2023-10-30 | キヤノン株式会社 | 画像処理装置、画像処理方法、コンピュータプログラム及び記憶媒体 |

| JP7279241B1 (ja) * | 2022-08-03 | 2023-05-22 | セーフィー株式会社 | システムおよびプログラム |

Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2009048229A (ja) | 2007-08-13 | 2009-03-05 | Toshiba Tec Corp | 人物行動分析装置,方法及びプログラム |

Family Cites Families (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US8098888B1 (en) * | 2008-01-28 | 2012-01-17 | Videomining Corporation | Method and system for automatic analysis of the trip of people in a retail space using multiple cameras |

| JP5789776B2 (ja) | 2014-04-28 | 2015-10-07 | パナソニックIpマネジメント株式会社 | 滞留時間測定装置、滞留時間測定システムおよび滞留時間測定方法 |

| JP6478777B2 (ja) | 2015-04-13 | 2019-03-06 | キヤノン株式会社 | 制御装置及びその制御方法、プログラム |

| JP2017147689A (ja) | 2016-02-19 | 2017-08-24 | 富士通株式会社 | 映像編集装置、映像編集方法及び映像編集用コンピュータプログラム |

| JP6256885B2 (ja) | 2016-03-31 | 2018-01-10 | パナソニックIpマネジメント株式会社 | 施設内活動分析装置、施設内活動分析システムおよび施設内活動分析方法 |

| JP7299692B2 (ja) | 2018-12-05 | 2023-06-28 | キヤノン株式会社 | 画像処理装置、画像処理システム、画像処理装置の制御方法、及び、プログラム |

-

2019

- 2019-05-23 JP JP2019097071A patent/JP7329967B2/ja active Active

-

2020

- 2020-05-19 US US16/877,921 patent/US11551455B2/en active Active

Patent Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2009048229A (ja) | 2007-08-13 | 2009-03-05 | Toshiba Tec Corp | 人物行動分析装置,方法及びプログラム |

Also Published As

| Publication number | Publication date |

|---|---|

| US20200372259A1 (en) | 2020-11-26 |

| US11551455B2 (en) | 2023-01-10 |

| JP2020191590A (ja) | 2020-11-26 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6741130B2 (ja) | 情報処理システム、情報処理方法及びプログラム | |

| US10839227B2 (en) | Queue group leader identification | |

| KR102164863B1 (ko) | 정보 처리장치 및 그 방법과, 컴퓨터 판독가능한 기억매체 | |

| US11521413B2 (en) | Information processing apparatus, method of controlling information processing apparatus, and non-transitory computer-readable storage medium | |

| JP6568374B2 (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| JP2008112401A (ja) | 広告効果測定装置 | |

| CN110199316B (zh) | 相机和相机的图像处理方法 | |

| KR102144394B1 (ko) | 영상 정합 장치 및 이를 이용한 영상 정합 방법 | |

| JP7329967B2 (ja) | 画像処理装置、システム、画像処理装置の制御方法、及び、プログラム | |

| JP4288428B2 (ja) | 映像解析システムおよび映像解析方法 | |

| JP3489491B2 (ja) | 人物行動解析装置及び人物行動解析プログラムを記録した記録媒体 | |

| KR20150093532A (ko) | 정보 관리를 위한 장치 및 방법 | |

| US10783365B2 (en) | Image processing device and image processing system | |

| JP5115763B2 (ja) | 画像処理装置、コンテンツ配信システム、画像処理方法、及びプログラム | |

| KR102050418B1 (ko) | 영상 정합 장치 및 이를 이용한 영상 정합 방법 | |

| JP2020095651A (ja) | 生産性評価システム、生産性評価装置、生産性評価方法、及びプログラム | |

| JP6939065B2 (ja) | 画像認識用コンピュータプログラム、画像認識装置及び画像認識方法 | |

| JP2013156671A (ja) | 画像監視装置 | |

| US20230215015A1 (en) | Tracking device, tracking method, and recording medium | |

| JPWO2017061239A1 (ja) | 監視システム | |

| JP2020086961A (ja) | 画像解析装置、撮影装置、画像解析方法、及び、プログラム | |

| JP7357649B2 (ja) | 識別を容易にするための方法および装置 | |

| WO2022030546A1 (ja) | 情報処理装置、情報処理方法、及びプログラム | |

| JP2016220148A (ja) | 制御装置、制御方法、システム | |

| JP2019113978A (ja) | 動線分析システム、動線分析システムの制御方法、およびプログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| RD01 | Notification of change of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7421 Effective date: 20210103 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210113 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20220516 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20220516 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20230213 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20230217 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20230414 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20230710 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20230808 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 7329967 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |