JP7038829B2 - 顔部認識方法及び装置、電子機器並びに記憶媒体 - Google Patents

顔部認識方法及び装置、電子機器並びに記憶媒体 Download PDFInfo

- Publication number

- JP7038829B2 JP7038829B2 JP2020533112A JP2020533112A JP7038829B2 JP 7038829 B2 JP7038829 B2 JP 7038829B2 JP 2020533112 A JP2020533112 A JP 2020533112A JP 2020533112 A JP2020533112 A JP 2020533112A JP 7038829 B2 JP7038829 B2 JP 7038829B2

- Authority

- JP

- Japan

- Prior art keywords

- features

- attention

- clustering

- attribute

- face recognition

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/70—Arrangements for image or video recognition or understanding using pattern recognition or machine learning

- G06V10/764—Arrangements for image or video recognition or understanding using pattern recognition or machine learning using classification, e.g. of video objects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/04—Architecture, e.g. interconnection topology

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/70—Arrangements for image or video recognition or understanding using pattern recognition or machine learning

- G06V10/82—Arrangements for image or video recognition or understanding using pattern recognition or machine learning using neural networks

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/168—Feature extraction; Face representation

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/168—Feature extraction; Face representation

- G06V40/169—Holistic features and representations, i.e. based on the facial image taken as a whole

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/168—Feature extraction; Face representation

- G06V40/171—Local features and components; Facial parts ; Occluding parts, e.g. glasses; Geometrical relationships

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/172—Classification, e.g. identification

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F18/00—Pattern recognition

- G06F18/20—Analysing

- G06F18/23—Clustering techniques

- G06F18/232—Non-hierarchical techniques

- G06F18/2323—Non-hierarchical techniques based on graph theory, e.g. minimum spanning trees [MST] or graph cuts

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/10—Human or animal bodies, e.g. vehicle occupants or pedestrians; Body parts, e.g. hands

- G06V40/16—Human faces, e.g. facial parts, sketches or expressions

- G06V40/161—Detection; Localisation; Normalisation

Landscapes

- Engineering & Computer Science (AREA)

- Health & Medical Sciences (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Health & Medical Sciences (AREA)

- Oral & Maxillofacial Surgery (AREA)

- General Physics & Mathematics (AREA)

- Multimedia (AREA)

- Human Computer Interaction (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Evolutionary Computation (AREA)

- Software Systems (AREA)

- Computing Systems (AREA)

- Artificial Intelligence (AREA)

- Medical Informatics (AREA)

- Databases & Information Systems (AREA)

- Biomedical Technology (AREA)

- Life Sciences & Earth Sciences (AREA)

- Biophysics (AREA)

- Computational Linguistics (AREA)

- Data Mining & Analysis (AREA)

- Molecular Biology (AREA)

- General Engineering & Computer Science (AREA)

- Mathematical Physics (AREA)

- Image Analysis (AREA)

Description

本願は、出願番号が201910107458.Xで、出願日が2019年2月2日である中国特許出願に基づいて提出され、且つこの中国特許出願の優先権を主張し、その開示の全てが参照によって本開示に組み込まれる。

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するステップは、前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るステップを含む。

前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るための第1補正サブモジュールを含む。

例えば、本願は以下の項目を提供する。

(項目1)

ターゲットオブジェクトを含む被処理画像に対して属性特徴抽出を行って、前記ターゲットオブジェクトのN個の属性特徴を得るステップであって、Nが1より大きい整数であるステップと、

注意メカニズムに基づいて前記被処理画像に対して注意特徴抽出を行って、前記ターゲットオブジェクトのN個の注意特徴を得るステップと、

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング注意特徴を得るステップであって、Mが正整数であり且つM<Nであるステップと、

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するステップと、を含む顔部認識方法。

(項目2)

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング注意特徴を得るステップは、

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング集合を得るステップであって、各注意特徴はM個のクラスタリング集合のうちの1つのクラスタリング集合に対応するステップと、

各クラスタリング集合のクラスタリング注意特徴をそれぞれ決定して、M個のクラスタリング注意特徴を得るステップと、を含む項目1に記載の方法。

(項目3)

前記N個の属性特徴と前記N個の注意特徴をそれぞれ乗算して、強化後のN個の属性特徴を得るステップを更に含み、

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するステップは、

前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るステップを含む項目1又は2に記載の方法。

(項目4)

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するステップは、

前記M個のクラスタリング注意特徴に基づいて前記N個の属性特徴をそれぞれ補正して、前記顔部認識結果を得るステップを含む項目1又は2に記載の方法。

(項目5)

前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るステップは、

強化後のN個の属性特徴と前記N個の属性特徴のうち少なくとも一部の属性特徴に対応する前記クラスタリング注意特徴をそれぞれ乗算して、前記顔部認識結果を得るステップを含む項目3に記載の方法。

(項目6)

前記M個のクラスタリング注意特徴に基づいて前記N個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るステップは、

前記N個の属性特徴と前記N個の属性特徴のうち少なくとも一部の属性特徴に対応する前記クラスタリング注意特徴をそれぞれ乗算して、前記顔部認識結果を得るステップを含む項目4に記載の方法。

(項目7)

前記方法はニューラルネットワークによって実現され、前記ニューラルネットワークは、前記被処理画像に対して属性特徴抽出を行うためのマルチタスク畳み込みネットワークと、前記被処理画像に対して注意特徴抽出を行うための複数の単独注意ネットワークと、前記N個の注意特徴に対してクラスタリング処理を行うためのクラスタリングネットワークと、を含む項目1~6のいずれか一項に記載の方法。

(項目8)

前記ニューラルネットワークを訓練する過程で、前記クラスタリングネットワークのネットワーク損失に基づいて、複数の単独注意ネットワークのネットワークパラメータを調整するステップを更に含む項目7に記載の方法。

(項目9)

前記クラスタリング処理は、スペクトラルクラスタリングを含み、前記M個のクラスタリング注意特徴はそれぞれ前記M個のクラスタリング集合のクラスタ中心である項目1~8のいずれか一項に記載の方法。

(項目10)

ターゲットオブジェクトを含む被処理画像に対して属性特徴抽出を行って、前記ターゲットオブジェクトのN個の属性特徴を得るための属性抽出モジュールであって、Nが1より大きい整数である属性抽出モジュールと、

注意メカニズムに基づいて前記被処理画像に対して注意特徴抽出を行って、前記ターゲットオブジェクトのN個の注意特徴を得るための注意抽出モジュールと、

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング注意特徴を得るためのクラスタリングモジュールであって、Mが正整数であり且つM<Nであるクラスタリングモジュールと、

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するための結果決定モジュールと、を含む顔部認識装置。

(項目11)

前記クラスタリングモジュールは、

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング集合を得るためのクラスタリングサブモジュールためのクラスタリングサブモジュールであって、各注意特徴はM個のクラスタリング集合のうちの1つのクラスタリング集合に対応するクラスタリングサブモジュールと、

各クラスタリング集合のクラスタリング注意特徴をそれぞれ決定して、M個のクラスタリング注意特徴を得るための特徴決定サブモジュールと、を含む項目10に記載の装置。

(項目12)

前記N個の属性特徴と前記N個の注意特徴をそれぞれ乗算して、強化後のN個の属性特徴を得るための属性強化モジュールを更に含み、

前記結果決定モジュールは、

前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るための第1補正サブモジュールを含む項目10又は11に記載の装置。

(項目13)

前記結果決定モジュールは、

前記M個のクラスタリング注意特徴に基づいて前記N個の属性特徴をそれぞれ補正して、前記顔部認識結果を得るための第2補正サブモジュールを含む項目10又は11に記載の装置。

(項目14)

前記第1補正サブモジュールは、

強化後のN個の属性特徴と各前記属性特徴に対応する前記クラスタリング注意特徴をそれぞれ乗算して、前記顔部認識結果を得るための第1乗算サブモジュールを含む項目12に記載の装置。

(項目15)

前記第2補正サブモジュールは、

前記N個の属性特徴と各前記属性特徴に対応する前記クラスタリング注意特徴をそれぞれ乗算して、前記顔部認識結果を得るための第2乗算サブモジュールを含む項目13に記載の装置。

(項目16)

前記装置はニューラルネットワークによって実現され、前記ニューラルネットワークは、前記被処理画像に対して属性特徴抽出を行うためのマルチタスク畳み込みネットワークと、前記被処理画像に対して注意特徴抽出を行うための複数の単独注意ネットワークと、前記N個の注意特徴に対してクラスタリング処理を行うためのものクラスタリングネットワークと、を含む項目10~15のいずれか一項に記載の装置。

(項目17)

前記ニューラルネットワークを訓練する過程で、前記クラスタリングネットワークのネットワーク損失に基づいて、複数の単独注意ネットワークのネットワークパラメータを調整するためのパラメータ調整モジュールを更に含む項目16に記載の装置。

(項目18)

前記クラスタリング処理は、スペクトラルクラスタリングを含み、前記M個のクラスタリング注意特徴はそれぞれ前記M個のクラスタリング集合のクラスタ中心である項目10~17のいずれか一項に記載の装置。

(項目19)

プロセッサと、

プロセッサ実行可能コマンドを記憶するためのメモリと、を含み、

前記プロセッサが項目1~9のいずれか一項に記載の方法を実行するように構成される電子機器。

(項目20)

コンピュータプログラムコマンドが記憶されているコンピュータ読取可能記憶媒体であって、前記コンピュータプログラムコマンドがプロセッサにより実行される時に項目1~9のいずれか一項に記載の方法を実現するコンピュータ読取可能記憶媒体。

(項目21)

プロセッサにより実行されると、項目1~9のいずれか一項に記載の方法を実現するコンピュータプログラム製品。

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング集合を得るステップであって、各注意特徴はM個のクラスタリング集合のうちの1つのクラスタリング集合に対応するステップと、

各クラスタリング集合のクラスタリング注意特徴をそれぞれ決定して、M個のクラスタリング注意特徴を得るステップと、を含んでよい。

前記M個のクラスタリング注意特徴に基づいて前記N個の属性特徴をそれぞれ補正して、前記顔部認識結果を得るステップを含んでよい。つまり、M個のクラスタリング注意特徴を用いてN個の属性特徴をそれぞれ直接補正してよい。

ステップ108は、前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るステップを含んでよい。

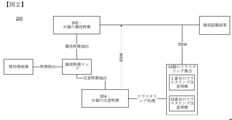

ターゲットオブジェクトを含む被処理画像に対して属性特徴抽出を行って、前記ターゲットオブジェクトのN個の属性特徴を得るためのものであって、Nが1より大きい整数である属性抽出モジュール41と、

注意メカニズムに基づいて前記被処理画像に対して注意特徴抽出を行って、前記ターゲットオブジェクトのN個の注意特徴を得るための注意抽出モジュール42と、

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング注意特徴を得るためのクラスタリングモジュール43であって、Mが正整数であり且つM<Nであるクラスタリングモジュール43と、

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するための結果決定モジュール44と、を含む。

前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るための第1補正サブモジュールを含む。

Claims (13)

- ターゲットオブジェクトを含む被処理画像に対して属性特徴抽出を行って、前記ターゲットオブジェクトのN個の属性特徴を得るステップであって、Nが1より大きい整数であるステップと、

注意メカニズムに基づいて前記被処理画像に対して注意特徴抽出を行って、前記ターゲットオブジェクトのN個の注意特徴を得るステップであって、前記注意特徴は、指定された、抽出する必要がある特徴であり、前記注意特徴は前記属性特徴に属する、ステップと、

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング注意特徴を得るステップであって、Mが正整数であり且つM<Nであるステップと、

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するステップと、を含む顔部認識方法。 - 前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング注意特徴を得るステップは、

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング集合を得るステップであって、各注意特徴はM個のクラスタリング集合のうちの1つのクラスタリング集合に対応するステップと、

各クラスタリング集合のクラスタリング注意特徴をそれぞれ決定して、M個のクラスタリング注意特徴を得るステップと、を含む請求項1に記載の方法。 - 前記N個の属性特徴と前記N個の注意特徴をそれぞれ乗算して、強化後のN個の属性特徴を得るステップを更に含み、

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するステップは、

前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るステップを含む請求項1又は2に記載の方法。 - 前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するステップは、

前記M個のクラスタリング注意特徴に基づいて前記N個の属性特徴をそれぞれ補正して、前記顔部認識結果を得るステップを含む請求項1又は2に記載の方法。 - 前記M個のクラスタリング注意特徴に基づいて強化後のN個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るステップは、

強化後のN個の属性特徴と前記N個の属性特徴のうち少なくとも一部の属性特徴に対応する前記クラスタリング注意特徴をそれぞれ乗算して、前記顔部認識結果を得るステップを含む請求項3に記載の方法。 - 前記M個のクラスタリング注意特徴に基づいて前記N個の属性特徴をそれぞれ補正して、前記ターゲットオブジェクトの顔部認識結果を得るステップは、

前記N個の属性特徴と前記N個の属性特徴のうち少なくとも一部の属性特徴に対応する前記クラスタリング注意特徴をそれぞれ乗算して、前記顔部認識結果を得るステップを含む請求項4に記載の方法。 - 前記方法はニューラルネットワークによって実現され、前記ニューラルネットワークは、前記被処理画像に対して属性特徴抽出を行うためのマルチタスク畳み込みネットワークと、前記被処理画像に対して注意特徴抽出を行うための複数の単独注意ネットワークと、前記N個の注意特徴に対してクラスタリング処理を行うためのクラスタリングネットワークと、を含む請求項1~6のいずれか一項に記載の方法。

- 前記ニューラルネットワークを訓練する過程で、前記クラスタリングネットワークのネットワーク損失に基づいて、複数の単独注意ネットワークのネットワークパラメータを調整するステップを更に含む請求項7に記載の方法。

- 前記クラスタリング処理は、スペクトラルクラスタリングを含み、前記M個のクラスタリング注意特徴はそれぞれ前記M個のクラスタリング集合のクラスタ中心である請求項1~8のいずれか一項に記載の方法。

- ターゲットオブジェクトを含む被処理画像に対して属性特徴抽出を行って、前記ターゲットオブジェクトのN個の属性特徴を得るための属性抽出モジュールであって、Nが1より大きい整数である属性抽出モジュールと、

注意メカニズムに基づいて前記被処理画像に対して注意特徴抽出を行って、前記ターゲットオブジェクトのN個の注意特徴を得るための注意抽出モジュールであって、前記注意特徴は、指定された、抽出する必要がある特徴であり、前記注意特徴は前記属性特徴に属する、注意抽出モジュールと、

前記N個の注意特徴に対してクラスタリング処理を行って、M個のクラスタリング注意特徴を得るためのクラスタリングモジュールであって、Mが正整数であり且つM<Nであるクラスタリングモジュールと、

前記N個の属性特徴及び前記M個のクラスタリング注意特徴に基づいて、前記ターゲットオブジェクトの顔部認識結果を決定するための結果決定モジュールと、を含む顔部認識装置。 - プロセッサと、

プロセッサ実行可能コマンドを記憶するためのメモリと、を含み、

前記プロセッサが請求項1~9のいずれか一項に記載の方法を実行するように構成される電子機器。 - コンピュータプログラムコマンドが記憶されているコンピュータ読取可能記憶媒体であって、前記コンピュータプログラムコマンドがプロセッサにより実行される時に請求項1~9のいずれか一項に記載の方法を実現するコンピュータ読取可能記憶媒体。

- プロセッサに、請求項1~9のいずれか一項に記載の方法を実行させるコンピュータプログラム。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| CN201910107458.X | 2019-02-02 | ||

| CN201910107458.XA CN109800737B (zh) | 2019-02-02 | 2019-02-02 | 面部识别方法及装置、电子设备和存储介质 |

| PCT/CN2019/100859 WO2020155606A1 (zh) | 2019-02-02 | 2019-08-15 | 面部识别方法及装置、电子设备和存储介质 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2021514497A JP2021514497A (ja) | 2021-06-10 |

| JP2021514497A5 JP2021514497A5 (ja) | 2021-12-23 |

| JP7038829B2 true JP7038829B2 (ja) | 2022-03-18 |

Family

ID=66561887

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2020533112A Active JP7038829B2 (ja) | 2019-02-02 | 2019-08-15 | 顔部認識方法及び装置、電子機器並びに記憶媒体 |

Country Status (7)

| Country | Link |

|---|---|

| US (1) | US11455830B2 (ja) |

| JP (1) | JP7038829B2 (ja) |

| KR (1) | KR102390580B1 (ja) |

| CN (1) | CN109800737B (ja) |

| SG (1) | SG11202006192YA (ja) |

| TW (1) | TWI717923B (ja) |

| WO (1) | WO2020155606A1 (ja) |

Families Citing this family (18)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN109800737B (zh) | 2019-02-02 | 2021-06-25 | 深圳市商汤科技有限公司 | 面部识别方法及装置、电子设备和存储介质 |

| CN110210572B (zh) * | 2019-06-10 | 2023-02-07 | 腾讯科技(深圳)有限公司 | 图像分类方法、装置、存储介质及设备 |

| CN110458052B (zh) * | 2019-07-25 | 2023-04-07 | Oppo广东移动通信有限公司 | 基于增强现实的目标对象识别方法、装置、设备、介质 |

| CN111339813B (zh) * | 2019-09-30 | 2022-09-27 | 深圳市商汤科技有限公司 | 人脸属性识别方法、装置、电子设备和存储介质 |

| CN111950643B (zh) * | 2020-08-18 | 2022-06-28 | 创新奇智(上海)科技有限公司 | 图像分类模型训练方法、图像分类方法及对应装置 |

| CN112580694B (zh) * | 2020-12-01 | 2024-04-19 | 中国船舶重工集团公司第七0九研究所 | 基于联合注意力机制的小样本图像目标识别方法及系统 |

| CN112560756A (zh) * | 2020-12-24 | 2021-03-26 | 北京嘀嘀无限科技发展有限公司 | 识别人脸的方法、装置、电子设备和存储介质 |

| CN112733652B (zh) * | 2020-12-31 | 2024-04-19 | 深圳赛安特技术服务有限公司 | 图像目标识别方法、装置、计算机设备及可读存储介质 |

| CN113049084B (zh) * | 2021-03-16 | 2022-05-06 | 电子科技大学 | 一种基于注意力机制的Resnet的分布式光纤传感信号识别方法 |

| CN113052175B (zh) * | 2021-03-26 | 2024-03-29 | 北京百度网讯科技有限公司 | 目标检测方法、装置、电子设备及可读存储介质 |

| CN113177533B (zh) * | 2021-05-28 | 2022-09-06 | 济南博观智能科技有限公司 | 一种人脸识别方法、装置及电子设备 |

| CN113553905B (zh) * | 2021-06-16 | 2024-04-26 | 北京百度网讯科技有限公司 | 图像识别方法、装置及系统 |

| CN113392263A (zh) * | 2021-06-24 | 2021-09-14 | 上海商汤科技开发有限公司 | 一种数据标注方法及装置、电子设备和存储介质 |

| CN113470827A (zh) * | 2021-06-30 | 2021-10-01 | 上海商汤智能科技有限公司 | 分类方法及装置、电子设备和存储介质 |

| CN113688729B (zh) * | 2021-08-24 | 2023-04-07 | 上海商汤科技开发有限公司 | 一种行为识别方法及装置、电子设备和存储介质 |

| CN114495294A (zh) * | 2021-12-03 | 2022-05-13 | 华中科技大学鄂州工业技术研究院 | 一种地铁闸机无感支付方法、装置及存储介质 |

| KR102458179B1 (ko) | 2022-06-20 | 2022-10-24 | 주식회사 한국공간데이터 | 얼굴 속성을 이용한 얼굴 인식 방법 및 얼굴 인식 장치 |

| CN117437684B (zh) * | 2023-12-14 | 2024-04-16 | 深圳须弥云图空间科技有限公司 | 一种基于修正注意力的图像识别方法和装置 |

Citations (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003346151A (ja) | 2002-05-29 | 2003-12-05 | Fuji Photo Film Co Ltd | 画像認識方法および装置並びにプログラム |

| CN106845421A (zh) | 2017-01-22 | 2017-06-13 | 北京飞搜科技有限公司 | 基于多区域特征与度量学习的人脸特征识别方法及系统 |

| JP2017157138A (ja) | 2016-03-04 | 2017-09-07 | キヤノン株式会社 | 画像認識装置、画像認識方法及びプログラム |

Family Cites Families (14)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2013003635A (ja) * | 2011-06-13 | 2013-01-07 | Sony Corp | 情報処理装置、情報処理方法及びプログラム |

| TWI528331B (zh) * | 2014-10-06 | 2016-04-01 | 由田新技股份有限公司 | 注意力偵測裝置、方法、電腦可讀取紀錄媒體、及其電腦程式產品 |

| CN105096420A (zh) * | 2015-07-31 | 2015-11-25 | 北京旷视科技有限公司 | 门禁系统以及用于其的数据处理方法 |

| CN105678304B (zh) * | 2015-12-30 | 2020-04-10 | 浙江宇视科技有限公司 | 一种车标识别方法及装置 |

| US10831827B2 (en) * | 2016-04-01 | 2020-11-10 | International Business Machines Corporation | Automatic extraction of user mobility behaviors and interaction preferences using spatio-temporal data |

| CN106611421B (zh) * | 2016-12-30 | 2019-06-21 | 西安电子科技大学 | 基于特征学习和素描线段约束的sar图像分割方法 |

| CN108229674B (zh) * | 2017-02-21 | 2021-03-02 | 北京市商汤科技开发有限公司 | 聚类用神经网络的训练方法和装置、聚类方法和装置 |

| CN107909059A (zh) * | 2017-11-30 | 2018-04-13 | 中南大学 | 一种面向复杂城市场景中协同仿生视觉的交通标志牌检测与识别方法 |

| CN108875521A (zh) * | 2017-12-20 | 2018-11-23 | 北京旷视科技有限公司 | 人脸检测方法、装置、系统和存储介质 |

| CN108960331A (zh) * | 2018-07-10 | 2018-12-07 | 重庆邮电大学 | 一种基于行人图像特征聚类的行人再识别方法 |

| CN109255369B (zh) * | 2018-08-09 | 2020-10-16 | 杭州易现先进科技有限公司 | 利用神经网络识别图片的方法及装置、介质和计算设备 |

| CN109145867B (zh) * | 2018-09-07 | 2021-08-10 | 北京旷视科技有限公司 | 人体姿态估计方法、装置、系统、电子设备、存储介质 |

| CN109800737B (zh) * | 2019-02-02 | 2021-06-25 | 深圳市商汤科技有限公司 | 面部识别方法及装置、电子设备和存储介质 |

| US11256960B2 (en) * | 2020-04-15 | 2022-02-22 | Adobe Inc. | Panoptic segmentation |

-

2019

- 2019-02-02 CN CN201910107458.XA patent/CN109800737B/zh active Active

- 2019-08-15 KR KR1020207018821A patent/KR102390580B1/ko active IP Right Grant

- 2019-08-15 WO PCT/CN2019/100859 patent/WO2020155606A1/zh active Application Filing

- 2019-08-15 JP JP2020533112A patent/JP7038829B2/ja active Active

- 2019-08-15 SG SG11202006192YA patent/SG11202006192YA/en unknown

- 2019-11-29 TW TW108143797A patent/TWI717923B/zh active

-

2020

- 2020-06-22 US US16/907,406 patent/US11455830B2/en active Active

Patent Citations (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003346151A (ja) | 2002-05-29 | 2003-12-05 | Fuji Photo Film Co Ltd | 画像認識方法および装置並びにプログラム |

| JP2017157138A (ja) | 2016-03-04 | 2017-09-07 | キヤノン株式会社 | 画像認識装置、画像認識方法及びプログラム |

| CN106845421A (zh) | 2017-01-22 | 2017-06-13 | 北京飞搜科技有限公司 | 基于多区域特征与度量学习的人脸特征识别方法及系统 |

Also Published As

| Publication number | Publication date |

|---|---|

| TW202030638A (zh) | 2020-08-16 |

| CN109800737B (zh) | 2021-06-25 |

| TWI717923B (zh) | 2021-02-01 |

| US20200320281A1 (en) | 2020-10-08 |

| KR20200096565A (ko) | 2020-08-12 |

| US11455830B2 (en) | 2022-09-27 |

| SG11202006192YA (en) | 2020-11-27 |

| KR102390580B1 (ko) | 2022-04-26 |

| CN109800737A (zh) | 2019-05-24 |

| WO2020155606A1 (zh) | 2020-08-06 |

| JP2021514497A (ja) | 2021-06-10 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP7038829B2 (ja) | 顔部認識方法及び装置、電子機器並びに記憶媒体 | |

| WO2019184471A1 (zh) | 图像标签确定方法、装置及终端 | |

| TWI747325B (zh) | 目標對象匹配方法及目標對象匹配裝置、電子設備和電腦可讀儲存媒介 | |

| CN110909815B (zh) | 神经网络训练、图像处理方法、装置及电子设备 | |

| TW202105199A (zh) | 資料更新方法、電子設備和儲存介質 | |

| JP7152598B2 (ja) | 画像処理方法及び装置、電子機器並びに記憶媒体 | |

| CN110598504B (zh) | 图像识别方法及装置、电子设备和存储介质 | |

| JP7165818B2 (ja) | ニューラルネットワークのトレーニング方法及び装置並びに画像生成方法及び装置 | |

| CN109981787B (zh) | 用于展示信息的方法和装置 | |

| CN110458218B (zh) | 图像分类方法及装置、分类网络训练方法及装置 | |

| CN111242303B (zh) | 网络训练方法及装置、图像处理方法及装置 | |

| CN109165738B (zh) | 神经网络模型的优化方法及装置、电子设备和存储介质 | |

| CN111241887B (zh) | 目标对象关键点识别方法及装置、电子设备和存储介质 | |

| JP2021518956A (ja) | 画像処理方法及び装置、電子機器並びにコンピュータ可読記憶媒体 | |

| CN109858614B (zh) | 神经网络训练方法及装置、电子设备和存储介质 | |

| JP7074877B2 (ja) | ネットワーク最適化方法及び装置、画像処理方法及び装置、記憶媒体及びコンピュータプログラム | |

| JP2022522551A (ja) | 画像処理方法及び装置、電子機器並びに記憶媒体 | |

| CN109920016B (zh) | 图像生成方法及装置、电子设备和存储介质 | |

| JP2022516452A (ja) | データ処理方法および装置、電子機器ならびに記憶媒体 | |

| CN110121106A (zh) | 视频播放方法及装置 | |

| CN109977860A (zh) | 图像处理方法及装置、电子设备和存储介质 | |

| WO2023185671A1 (zh) | 风格图像生成方法、装置、设备及介质 | |

| CN109447258B (zh) | 神经网络模型的优化方法及装置、电子设备和存储介质 | |

| CN109903252B (zh) | 图像处理方法及装置、电子设备和存储介质 | |

| CN112259122A (zh) | 音频类型识别方法、装置及存储介质 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200616 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20200616 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20210901 |

|

| A524 | Written submission of copy of amendment under article 19 pct |

Free format text: JAPANESE INTERMEDIATE CODE: A524 Effective date: 20211110 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20220302 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20220308 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 7038829 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |