JP6996450B2 - 画像処理装置、画像処理方法、およびプログラム - Google Patents

画像処理装置、画像処理方法、およびプログラム Download PDFInfo

- Publication number

- JP6996450B2 JP6996450B2 JP2018153334A JP2018153334A JP6996450B2 JP 6996450 B2 JP6996450 B2 JP 6996450B2 JP 2018153334 A JP2018153334 A JP 2018153334A JP 2018153334 A JP2018153334 A JP 2018153334A JP 6996450 B2 JP6996450 B2 JP 6996450B2

- Authority

- JP

- Japan

- Prior art keywords

- hand

- virtual

- distance

- real

- space

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/20—Editing of 3D images, e.g. changing shapes or colours, aligning objects or positioning parts

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2219/00—Indexing scheme for manipulating 3D models or images for computer graphics

- G06T2219/20—Indexing scheme for editing of 3D models

- G06T2219/2016—Rotation, translation, scaling

Landscapes

- Engineering & Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Computer Graphics (AREA)

- Computer Hardware Design (AREA)

- Software Systems (AREA)

- Architecture (AREA)

- Human Computer Interaction (AREA)

- Processing Or Creating Images (AREA)

- User Interface Of Digital Computer (AREA)

Description

[原理]

まず、本実施形態で説明する技術の原理を説明する。ここでは、観察者のリアルな手に基づくバーチャルな手の大きさをリアルな手の大きさと異ならせて知覚させる場合について説明する。

次に、第1実施形態を説明する。第1実施形態では、上述した原理を画像処理システムで実現するために、リアルな手の位置および奥行き距離を取得し、バーチャルな手がバーチャルな巨人の手であると観察者に認知させたい場合には、リアルな手の奥行き距離より長い距離をバーチャルな手の奥行き距離として決定し、バーチャルな手がバーチャルな小人の手であると観察者に認知させたい場合には、リアルな手の奥行き距離より短い距離をバーチャルな手の奥行き距離として決定し、この距離の位置に配置されたバーチャルな手の視角がリアルな手の視角と同じになるように、バーチャルな手のモデルの大きさを決定し、決定した奥行き距離と決定した大きさのバーチャルな手を含むVR空間をヘッドマウントディスプレイの右眼用ディスプレイと左眼用ディスプレイで提示する例を示す。

図1に例示するように、本実施形態の画像処理システム1は、実空間画像取得装置10、実空間位置取得装置11、画像処理装置12、および画像提示装置13を有する。実空間画像取得装置10は、実空間に存在する対象の画像を取得する装置である。実空間位置取得装置11は、実空間に存在する対象の位置の情報を取得する装置である。例えば、実空間画像取得装置10はカメラ(例えば、RGBカメラ)を備える装置であり、実空間位置取得装置11は位置センサ(例えば、深度センサ)を備える装置である。例えば、Leap Motion(登録商標)やKinect(登録商標)などの奥行カメラを実空間画像取得装置10および実空間位置取得装置11として用いることができる。本実施形態で例示する画像処理装置12は、実座標計算部121、実距離計算部122、仮想距離計算部123、仮想座標計算部124、仮想サイズ計算部126、画像処理部127、および提示用画像生成部128を有する装置である。実座標計算部121、実距離計算部122、仮想距離計算部123、仮想座標計算部124、仮想サイズ計算部126、および画像処理部127が、リアルな手を拡大または縮小したバーチャルな手を生成する処理部(視対象生成部)である。画像提示装置13は、観察者にVR空間を知覚させるための画像を提示する装置である。画像提示装置13の例は、右眼用画像と左眼用画像とを提示するヘッドマウントディスプレイである。

本実施形態の処理を説明する。

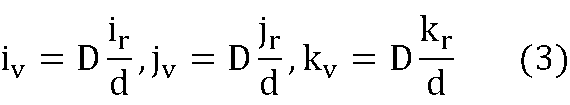

実空間位置取得装置11は、観察者のリアルな手の位置を表す位置情報prを取得して出力する。画像処理装置12の実座標計算部121は、この位置情報prを入力とし、観察者のリアルな手の実空間における位置R[ir,jr,kr]を表す座標値ir,jr,krを出力する。本実施形態で例示する座標値ir,jr,krは、観察者の目の位置を原点R[0,0,0]とした実空間の直交座標系R[x,y,z]におけるリアルな手の位置R[ir,jr,kr]を表す。各実施形態では、便宜上、観察者の左眼または右眼の何れか一方の目(例えば、左眼)の原点Oを原点R[0,0,0]とする例を説明する。ここでir,jr,krは、それぞれ実空間の直交座標系の水平軸、垂直軸、奥行軸上の座標値である。例えば、実空間位置取得装置11で得られたリアルな手の位置情報prが、実空間位置取得装置11が備える位置センサを原点とした座標系で表現される位置情報である場合、実座標計算部121は、入力された位置センサを原点とした座標系で表現されるリアルな手の位置情報を、座標系R[x,y,z]におけるリアルな手の座標値ir,jr,krに変換して出力する。位置R[ir,jr,kr]は、例えば、リアルな手の3次元的な中心点である。また、仮想サイズ計算部126は、位置情報prを入力とし、リアルな手の大きさSd(例えば、図4のLからL’までの線形寸法)を求めて出力する。

実距離計算部122は、座標値ir,jr,krを入力とし、観察者の目の位置(原点R[0,0,0])から、座標値ir,jr,krが表すリアルな手の位置までの距離dを計算して出力する。本実施形態の座標値ir,jr,krは座標系R[x,y,z]におけるリアルな手の位置R[ir,jr,kr]を表すため、実距離計算部122は、距離dを以下の式(1)で計算すればよい。

仮想距離計算部123は、パラメータαおよび上述した距離dを入力とし、以下の式(2)で表される、VR空間におけるカメラの位置からバーチャルな手までの距離Dを得て出力する。

D=α×d (2)

ただし、パラメータαは、バーチャルな手の見かけ上の大きさをリアルな手の大きさの何倍にするかを特定する正の実数である。バーチャルな手をリアルな手よりも大きく見せる場合、すなわちバーチャルな巨人の手を提示する場合にはα>1とし、バーチャルな手をリアルな手よりも小さく見せる場合、すなわちバーチャルな小人の手を提示する場合は0<α<1とする。バーチャルな手をリアルな手と同じ大きさに見せる場合にはα=1とする。パラメータαは、外部から画像処理装置12に入力されたものであってもよいし、画像処理装置12の記憶部(図示せず)から読み出されたものであってもよい。本実施形態では、大きさ恒常性を用い、バーチャルな手の質感をリアルな手の質感と大きく異ならせずに、バーチャルな手の見かけ上の大きさをリアルな手の大きさのα倍にするために、式(2)のように距離dのα倍を距離Dにする。

図7Aおよび図7Bを用いてバーチャルな手の大きさの決定処理を説明する。実空間の原点O(つまり原点R[0,0,0])から距離dにある(つまり図7Aにおいて位置Pr2にある)リアルな手の大きさをSdとし、実空間の原点Oで当該原点Oから距離dにあるリアルな手のなす視角をθとし、視角θを二等分した視角をθhalf=θ/2とする。この場合、このリアルな手の大きさSdは以下の関係式を満たす。

Sd=2×d×tanθhalf (4)

ここで、VR空間において、原点OI(つまり原点V[0,0,0])から距離Dにある(つまり図7Bにおいて位置Pv2にある)バーチャルな手の視角が、実空間の原点Oで当該原点Oから距離dにあるリアルな手のなす視角θと同じになるようにするためには、バーチャルな手の大きさSDが以下の関係式を満たす必要がある。

SD=2×D×tanθhalf (5)

なお、図7BはD>dの場合を例示しているが、D≦dの場合であってもバーチャルな手の大きさSDが式(5)を満たす必要がある。以上より、原点OIから距離Dの位置にバーチャルな手を配置し、その視角をリアルな手のなす視角θと同一にするためには、式(5)を満たすバーチャルな手の大きさSDとすればよい。仮想サイズ計算部126は、上述した式(4)と式(5)を満たすバーチャルな手の大きさSDを得て出力する。例えば、仮想サイズ計算部126は、実空間位置取得装置11で得られた位置情報pr、実距離計算部122から出力された距離d、および仮想距離計算部123から出力された距離Dを入力とし、式(4)と式(5)を満たすバーチャルな手の大きさSDを得て出力する。一例を示すと、仮想サイズ計算部126は、位置情報prに基づいてtanθhalfを求め(例えば、前述のように位置情報prに基づいてSdを求め、Sdとdとを用いて式(4)に従ってtanθhalfを求め)、tanθhalfとDと用いて式(5)に従ってSDを求めて出力する。

画像処理部127から出力された画像pvは提示用画像生成部128に入力される。提示用画像生成部128は、画像pvを用い、VR空間においてカメラの位置(例えば、原点OIや結像面I)から見えるバーチャルな手(リアルな手を拡大または縮小したものに対応するバーチャルな手であって、位置V[iv,jv,kv]に配置され、大きさがSDであるバーチャルな手)を観察者に提示するための提示用画像Pを生成して出力する。提示用画像Pは、静止画像であってもよいし、動画像(動画)であってもよい。提示用画像Pの一例は、規定のフレームレート(例えば30Hz)の動画像である。提示用画像Pは、例えば、観察者の右眼と左眼にそれぞれ提示する右眼用画像と左眼用画像とを有する。この例の場合、提示用画像生成部128は、右眼用画像と左眼用画像とを取得するために、画像pvが表示されたVR空間に2つのカメラをそれらの撮影方向が平行に同方向を向くように設置し、これらのカメラでVR空間を撮影する撮影シミュレーションを行う。この撮影シミュレーションでは、例えば、これら2つのカメラの各結像面Iが同一直線上に配置され、カメラ間の水平距離を人間の眼間距離(約6.5cm)またはその近傍に合わせる。左側に配置されたカメラで撮影した画像を左眼用画像とし、右側に配置されたカメラで撮影した画像を右眼用画像とする。撮影シミュレーションには、上述した3Dモデリング/レンダリングソフトウェアなどの周知の技術を用いればよい。

第1実施形態では、仮想サイズ計算部126が式(5)に従ってSDを求めて出力した。上述した、式(4)と式(5)を満たすことは、下記の式(6A)や式(6B)を満たすことと等価である。

SD/Sd=D/d (6A)

SD=Sd×D/d (6B)

また、式(2)から分かる通りD/d=αであるので、式(6A)と式(6B)は下記の式(6C)と式(6D)と等価である。

SD/Sd=α (6C)

SD=Sd×α (6D)

したがって、第1実施形態では仮想サイズ計算部126が式(4)と式(5)に従ってSDを求めて出力したが、仮想サイズ計算部126がSdをD/d倍した値をSDとして出力してもよいし、仮想サイズ計算部126がSdをα倍した値をSDとして出力してもよい。例えば、仮想サイズ計算部126が、入力された位置情報prに基づいてSdを求め、求めたSdと入力されたαと乗算したものをSDとして出力してもよい。あるいは、仮想サイズ計算部126が、入力された位置情報prに基づいてSdを求め、求めたSdと入力されたDおよびdを用いて式(6B)によってSDを計算して出力してもよい。

バーチャルリアリティを実現するソフトウェアでは、VR空間内の対象のモデルの大きさを、基準となる対象の大きさに対する比率で設定することができる。このようなソフトウェアを用いてバーチャルな手の大きさをリアルな手の大きさのα倍にしてもよい。ただし、このような既存のソフトウェアは、対象の視角を保ちつつ、対象のモデルの大きさを変更するものではない。第2実施形態ではこのようなソフトウェア(「VRソフトウェア」と呼ぶことにする)の機能を用いる。以降、これまで説明した事項との相違点を中心に説明し、既に説明した事項については同じ参照番号を引用して説明を簡略化する。

図8に例示するように、本実施形態の画像処理システム2は、実空間画像取得装置10、実空間位置取得装置11、画像処理装置22、および画像提示装置13を有する。画像処理装置22は、実座標計算部121、仮想座標計算部224、画像処理部227、および提示用画像生成部128を有する装置である。実座標計算部121、仮想座標計算部224、および画像処理部227が、リアルな手を拡大または縮小したバーチャルな手を生成する処理部(視対象生成部)である。

本実施形態の処理を説明する。

≪リアルな手の位置の計測≫

第1実施形態と同じである。すなわち、実空間位置取得装置11は、実空間における観察者のリアルな手の位置を表す位置情報prを取得して出力する。実座標計算部121は、この位置情報prを入力とし、観察者のリアルな手の位置R[ir,jr,kr]を表す座標値ir,jr,krを得て出力する。

α=D/dであるため、式(3)は以下の式(7)に変形できる。

仮想座標計算部224は、実座標計算部121で得られた位置R[ir,jr,kr]の座標値ir,jr,krおよび入力されたパラメータαを入力とし、式(7)に従って、バーチャルな手の位置V[iv,jv,kv]の座標値iv,jv,kvを得て出力する。バーチャルな手の位置V[iv,jv,kv]の例は、バーチャルな手の3次元的な中心点である。

実空間画像取得装置10は、観察者のリアルな手の画像を表す画像情報grを取得して出力する。画像処理部227には、入力されたパラメータα、実空間画像取得装置10で得られた画像情報gr、および仮想座標計算部224で得られた座標値iv,jv,kvが入力される。画像処理部227は、VR空間において、画像情報grで特定されるリアルな手を模したバーチャルな普通の手を拡大または縮小したバーチャルな手であって、座標値iv,jv,kvの位置V[iv,jv,kv]に配置され(例えば、位置V[iv,jv,kv]を中心点とし)、大きさがバーチャルな普通の手のα倍であるバーチャルな手を含む画像pvを生成して出力する。ここで、大きさがバーチャルな普通の手のα倍であるバーチャルな手を生成するためには、前述したVRソフトウェアにおいてαを指定すればよい。リアルな手の大きさをDdとすると、このように生成されるバーチャルな手の大きさSDも式(6)の関係を満たす。

第1実施形態と同じである。

第1実施形態、第1実施形態の変形例、および第2実施形態において、パラメータαの値を変化させてもよい。これにより、バーチャルな手の質感を大きく変化させることなく、バーチャルな手の見かけの大きさを変化させることができる。図9に、VR空間において、実空間の原点Oでリアルな手のなす視角がθである場合にパラメータαを変化させ、バーチャルな手の奥行き距離kvを変化させた様子を例示する。ここで、α=1の場合のバーチャルな手の奥行き距離kvをDα=1とし、α=δの場合のバーチャルな手の奥行き距離kvをDα=δとし、α=λの場合のバーチャルな手の奥行き距離kvをDα=λとする。ただし、0<λ<1<δである。原点OIから距離Dα=1にある(つまり図9において位置Pα=1にある)バーチャルな手の大きさをSDα=1とし、原点OIから距離Dα=δにある(つまり図9において位置Pα=δにある)バーチャルな手の大きさをSDα=δとし、原点OIから距離Dα=λにある(つまり図9において位置Pα=λにある)バーチャルな手の大きさをSDα=λとする。ここで、SD=SDα=1とし、D=Dα=1とすると、前述の式(5)の関係を満たす。同様に、SD=SDα=δとし、D=Dα=δとすると、前述の式(5)の関係を満たし、SD=SDα=λとし、D=Dα=λとすると、前述の式(5)の関係を満たす。図9に例示するように、αの値を増加させることにより、視角θを保ったままバーチャルな手の奥行き距離および大きさが共に大きくなる。具体的には、αの値がδ倍になると、視角θを保ったままバーチャルな手の奥行き距離kvおよび大きさも共にδ倍になる。逆に、αの値を減少させることにより、視角θを保ったままバーチャルな手の奥行き距離kvおよび大きさが共に小さくなる。具体的には、αの値がλ倍になると、視角θを保ったままバーチャルな手の奥行き距離kvおよび大きさも共にλ倍になる。これにより、バーチャルな手の質感を大きく変化させることなく、バーチャルな手の見かけの大きさを変化させることができる。例えば、α=1をα=δに変更することで、バーチャルな手の質感を大きく変化させることなく、バーチャルな普通の手をバーチャルな巨人の手に変更することができる。また、α=1をα=λに変更することで、バーチャルな手の質感を大きく変化させることなく、バーチャルな普通の手をバーチャルな小人の手に変更することができる。あるいは、α=δまたはα=λをα=1に変更することで、バーチャルな手の質感を大きく変化させることなく、バーチャルな巨人の手やバーチャルな小人の手をバーチャルな普通の手に変更することができる。

FNC(kr)=1+(α0-1)×(kr-κ1)/(κmax-κ1) (8)

例えば、0≦kr≦κ1であるときにα=1とされ、κ1<κ2=krであるときにα=FNC(κ2)とされ、かつ、FNC(κ2)がκ2の増加に対して単調増加する例の場合、バーチャルな手は以下のように見える。すなわち、リアルな手の奥行き距離krがκ1以下(例えば目から30cm以下)であるときには、バーチャルな手が、リアルな手と同じ奥行き(例えば目から30cm)に、リアルな手と同じ大きさで見える(α=1)。一方、リアルな手の奥行き距離krがκ1を超えるときには、リアルな手が目から遠ざかるにつれて、バーチャルな手はリアルな手より遠くに、リアルな手より大きく見える(krが大きくなるにつれてαがだんだん大きくなる)。

なお、本発明は上述の実施形態およびその変形例に限定されるものではない。例えば、上述の実施形態およびその変形例では、実空間における原点Oからリアルな手の3次元形状の中心点までの距離をdとし、VR空間におけるカメラの原点OIからバーチャルな手の3次元形状の中心点までの距離をDとする例を示した。しかしながら、原点Oからリアルな手の3次元形状の他の任意の一点までの距離をdとしてもよいし、原点OIからバーチャルな手の3次元形状の他の任意の一点までの距離をDとしてもよい。その他、原点Oからリアルな手の3次元形状の各点までの距離に基づいて、原点OIからバーチャルな手の3次元形状の各点の距離を定めてよい。また、上述の実施形態およびその変形例では、目の水晶体内部に位置する点を原点Oとする例を示したが、目の他の位置または目の近傍の位置を原点Oとしてもよい。また、上述の実施形態およびその変形例では、目の原点Oを原点R[0,0,0]とする例を説明したが、目の原点Oの近傍を原点R[0,0,0]としてもよいし、目の原点Oに対する相対位置が固定されたその他の点を原点R[0,0,0]としてもよい。同様に、上述の実施形態およびその変形例では、VR空間のカメラの結像面Iの焦点を原点OIとする例を示したが、カメラの結像面Iの他の位置または結像面Iの近傍の位置を原点OIとしてもよい。また、上述の実施形態およびその変形例では、原点OIを原点V[0,0,0]とする例を示したが、原点OIの近傍を原点V[0,0,0]としてもよいし、原点OIに対する相対位置が固定されたその他の点を原点V[0,0,0]としてもよい。また、上述の実施形態およびその変形例では、画像処理部127が、位置V[iv,jv,kv]を中心点とするバーチャルな手を含む画像pvを生成する例を示した。しかし、位置V[iv,jv,kv]をバーチャルな手の他の位置としてもよいし、位置V[iv,jv,kv]をバーチャルな手に対する相対位置としてもよい。また、上述の実施形態およびその変形例では、便宜上、手右手親指の先端から右手小指の付け根までの距離を基準距離とした。しかし、手の他の部位の距離を基準距離としてもよい。

上述した各実施形態およびその変形例をまとめる。

上述したように、画像処理装置は、実空間または仮想現実空間における「第1対象」を拡大または縮小して仮想現実空間(VR空間)における視対象である「第2対象」を生成する。「第1対象」の例は、リアルな手その他の「実空間」における視対象、「実空間」における視対象を模したバーチャルな3D形状物、「実空間」に存在しない視対象を表したバーチャルな3D形状物などである。「第2対象」の例は、バーチャルな手、バーチャルな3D形状物などである。

上記の画像処理装置は、例えば、CPU(central processing unit)等のプロセッサ(ハードウェア・プロセッサ)およびRAM(random-access memory)・ROM(read-only memory)等のメモリ等を備える汎用または専用のコンピュータが所定のプログラムを実行することで構成される。このコンピュータは1個のプロセッサやメモリを備えていてもよいし、複数個のプロセッサやメモリを備えていてもよい。このプログラムはコンピュータにインストールされてもよいし、予めROM等に記録されていてもよい。また、CPUのようにプログラムが読み込まれることで機能構成を実現する電子回路(circuitry)ではなく、プログラムを用いることなく処理機能を実現する電子回路を用いて一部またはすべての処理部が構成されてもよい。1個の装置を構成する電子回路が複数のCPUを含んでいてもよい。

12,22 画像処理装置

Claims (8)

- 実空間または仮想現実空間における第1対象を拡大または縮小して、前記仮想現実空間における視対象である第2対象を生成する視対象生成部を有し、

前記実空間における実観察位置または前記仮想現実空間における仮想観察位置で前記第1対象のなす視角または推定視角である第1視角は、前記仮想観察位置で前記第2対象のなす視角である第2視角と同一または略同一であり、

前記第2対象が前記第1対象を拡大したものである場合には、前記仮想観察位置から前記第2対象までの距離である第2距離は、前記実観察位置または前記仮想観察位置から前記第1対象までの距離または推定距離である第1距離よりも大きく、

前記第2対象が前記第1対象を縮小したものである場合には、前記第2距離は前記第1距離よりも小さい、画像処理装置。 - 請求項1の画像処理装置であって、

前記第1距離に対する前記第2距離の比率は、前記第1対象の線形寸法に対する前記第2対象の線形寸法の比率と同一または略同一である、画像処理装置。 - 請求項1または2の画像処理装置であって、

前記視対象生成部は、前記第2視角を同一または略同一に保ったまま、前記仮想現実空間における前記第2対象の大きさおよび前記第2距離を変化させる、画像処理装置。 - 請求項1または2の画像処理装置であって、

前記第1対象は、前記実空間における視対象または前記実空間における視対象を模したものであり、

前記第1対象のなす視角は、前記実観察位置で前記実空間における視対象のなす視角であり、

前記第1距離は、前記実観察位置から前記実空間における視対象までの距離であり、

所定距離に対する前記第1距離の上回り分が第1値であるときの前記第1距離に対する前記第2距離の比率は、前記所定距離に対する前記第1距離の上回り分が第2値であるときの前記第1距離に対する前記第2距離の比率よりも大きく、

前記第1値は前記第2値よりも大きい、画像処理装置。 - 請求項1から4の何れかの画像処理装置であって、

前記第1対象は、前記実空間における視対象または前記実空間における視対象を模したものであり、

前記第1対象のなす視角は、前記実観察位置で前記実空間における視対象のなす視角であり、

前記第1距離は、前記実観察位置から前記実空間における視対象までの距離である、画像処理装置。 - 請求項1から5の何れかの画像処理装置であって、

前記仮想現実空間において前記仮想観察位置から見える前記第2対象を観察者に提示するための提示用画像を生成する提示用画像生成部をさらに有する、画像処理装置。 - 実空間または仮想現実空間における第1対象を拡大または縮小して前記仮想現実空間における視対象である第2対象を生成する視対象生成ステップを有し、

前記実空間における実観察位置または前記仮想現実空間における仮想観察位置で前記第1対象のなす視角または推定視角である第1視角は、前記仮想観察位置で前記第2対象のなす視角である第2視角と同一または略同一であり、

前記第2対象が前記第1対象を拡大したものである場合には、前記仮想観察位置から前記第2対象までの距離である第2距離は、前記実観察位置または前記仮想観察位置から前記第1対象までの距離または推定距離である第1距離よりも大きく、

前記第2対象が前記第1対象を縮小したものである場合には、前記第2距離は前記第1距離よりも小さい、画像処理方法。 - 請求項1から6の何れかの画像処理装置としてコンピュータを機能させるためのプログラム。

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2018153334A JP6996450B2 (ja) | 2018-08-17 | 2018-08-17 | 画像処理装置、画像処理方法、およびプログラム |

| PCT/JP2019/031286 WO2020036114A1 (ja) | 2018-08-17 | 2019-08-08 | 画像処理装置、画像処理方法、およびプログラム |

| US17/268,059 US11403830B2 (en) | 2018-08-17 | 2019-08-08 | Image processing device, image processing method, and program |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2018153334A JP6996450B2 (ja) | 2018-08-17 | 2018-08-17 | 画像処理装置、画像処理方法、およびプログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2020027555A JP2020027555A (ja) | 2020-02-20 |

| JP6996450B2 true JP6996450B2 (ja) | 2022-01-17 |

Family

ID=69525479

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2018153334A Active JP6996450B2 (ja) | 2018-08-17 | 2018-08-17 | 画像処理装置、画像処理方法、およびプログラム |

Country Status (3)

| Country | Link |

|---|---|

| US (1) | US11403830B2 (ja) |

| JP (1) | JP6996450B2 (ja) |

| WO (1) | WO2020036114A1 (ja) |

Families Citing this family (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US11687154B2 (en) * | 2021-05-28 | 2023-06-27 | International Institute Of Information Technology, Hyderabad | System and method for generating a limitless path in virtual reality environment for continuous locomotion |

| CN113852838B (zh) * | 2021-09-24 | 2023-08-11 | 北京字跳网络技术有限公司 | 视频数据生成方法、装置、电子设备及可读存储介质 |

| CN118552704B (zh) * | 2024-07-29 | 2024-10-01 | 江西格如灵科技股份有限公司 | 一种基于Unity场景下的图形处理方法及系统 |

Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2017084215A (ja) | 2015-10-30 | 2017-05-18 | キヤノンマーケティングジャパン株式会社 | 情報処理システム、その制御方法、及びプログラム |

Family Cites Families (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH11195140A (ja) * | 1997-12-27 | 1999-07-21 | Canon Inc | データ処理方法及び装置並びに記憶媒体 |

| US9978202B2 (en) * | 2014-02-14 | 2018-05-22 | Igt Canada Solutions Ulc | Wagering gaming apparatus for detecting user interaction with game components in a three-dimensional display |

| US10354446B2 (en) * | 2016-04-13 | 2019-07-16 | Google Llc | Methods and apparatus to navigate within virtual-reality environments |

-

2018

- 2018-08-17 JP JP2018153334A patent/JP6996450B2/ja active Active

-

2019

- 2019-08-08 US US17/268,059 patent/US11403830B2/en active Active

- 2019-08-08 WO PCT/JP2019/031286 patent/WO2020036114A1/ja not_active Ceased

Patent Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2017084215A (ja) | 2015-10-30 | 2017-05-18 | キヤノンマーケティングジャパン株式会社 | 情報処理システム、その制御方法、及びプログラム |

Also Published As

| Publication number | Publication date |

|---|---|

| WO2020036114A1 (ja) | 2020-02-20 |

| JP2020027555A (ja) | 2020-02-20 |

| US20210319624A1 (en) | 2021-10-14 |

| US11403830B2 (en) | 2022-08-02 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN114730094B (zh) | 具有人工现实内容的变焦显示的人工现实系统 | |

| AU2021290132C1 (en) | Presenting avatars in three-dimensional environments | |

| JP6632443B2 (ja) | 情報処理装置、情報処理システム、および情報処理方法 | |

| EP3057066B1 (en) | Generation of three-dimensional imagery from a two-dimensional image using a depth map | |

| WO2022108662A1 (en) | Multiple device sensor input based avatar | |

| US9607439B2 (en) | Information processing apparatus and information processing method | |

| JP2023513980A (ja) | 画面上の話者のフューショット合成 | |

| US20190026935A1 (en) | Method and system for providing virtual reality experience based on ultrasound data | |

| US12141339B2 (en) | Image generation apparatus and information presentation method | |

| CN109598796A (zh) | 将真实场景与虚拟物体进行3d融合显示的方法和装置 | |

| EP3128413A1 (en) | Sharing mediated reality content | |

| KR101892735B1 (ko) | 직관적인 상호작용 장치 및 방법 | |

| KR101950934B1 (ko) | 가상현실영상 제공장치, 입체감 향상을 위한 가상공간 크기 조절방법 및 프로그램 | |

| CN116137801A (zh) | 使用交替采样的眼睛跟踪 | |

| JP6996450B2 (ja) | 画像処理装置、画像処理方法、およびプログラム | |

| JP6682624B2 (ja) | 画像処理装置 | |

| WO2017191703A1 (ja) | 画像処理装置 | |

| US20210327121A1 (en) | Display based mixed-reality device | |

| JP2020031413A (ja) | 表示装置、移動体、移動体制御システム、これらの製造方法、および映像の表示方法 | |

| CN114371779A (zh) | 一种视线深度引导的视觉增强方法 | |

| JP6726016B2 (ja) | 情報処理装置、情報処理方法 | |

| JP7760355B2 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| KR101212223B1 (ko) | 촬영장치 및 깊이정보를 포함하는 영상의 생성방법 | |

| JP2012085172A (ja) | コミュニケーション装置、コミュニケーション方法、及びプログラム | |

| JP7467748B1 (ja) | 表示制御装置、表示システム及びプログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20210113 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20211116 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20211129 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6996450 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| S533 | Written request for registration of change of name |

Free format text: JAPANESE INTERMEDIATE CODE: R313533 |

|

| R350 | Written notification of registration of transfer |

Free format text: JAPANESE INTERMEDIATE CODE: R350 |