JP6980802B2 - 拡張現実を提供するための方法、装置及びコンピュータプログラム - Google Patents

拡張現実を提供するための方法、装置及びコンピュータプログラム Download PDFInfo

- Publication number

- JP6980802B2 JP6980802B2 JP2019548040A JP2019548040A JP6980802B2 JP 6980802 B2 JP6980802 B2 JP 6980802B2 JP 2019548040 A JP2019548040 A JP 2019548040A JP 2019548040 A JP2019548040 A JP 2019548040A JP 6980802 B2 JP6980802 B2 JP 6980802B2

- Authority

- JP

- Japan

- Prior art keywords

- plane

- terminal

- information

- augmented reality

- sensor

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 230000003190 augmentative effect Effects 0.000 title claims description 106

- 238000000034 method Methods 0.000 title claims description 25

- 238000004590 computer program Methods 0.000 title claims description 15

- 239000013598 vector Substances 0.000 claims description 66

- 238000004364 calculation method Methods 0.000 claims description 39

- 238000009877 rendering Methods 0.000 claims description 12

- 230000001133 acceleration Effects 0.000 claims description 9

- 238000002716 delivery method Methods 0.000 claims 1

- 230000005484 gravity Effects 0.000 description 8

- 230000006870 function Effects 0.000 description 5

- 238000012545 processing Methods 0.000 description 5

- 230000003287 optical effect Effects 0.000 description 3

- 238000010586 diagram Methods 0.000 description 2

- 230000000694 effects Effects 0.000 description 2

- 239000000284 extract Substances 0.000 description 2

- 238000005259 measurement Methods 0.000 description 2

- PEDCQBHIVMGVHV-UHFFFAOYSA-N Glycerine Chemical compound OCC(O)CO PEDCQBHIVMGVHV-UHFFFAOYSA-N 0.000 description 1

- 238000004891 communication Methods 0.000 description 1

- 238000013461 design Methods 0.000 description 1

- 230000005358 geomagnetic field Effects 0.000 description 1

- 238000009434 installation Methods 0.000 description 1

- 238000004519 manufacturing process Methods 0.000 description 1

- 238000004088 simulation Methods 0.000 description 1

- 230000003068 static effect Effects 0.000 description 1

- 230000009466 transformation Effects 0.000 description 1

- 238000000844 transformation Methods 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01B—MEASURING LENGTH, THICKNESS OR SIMILAR LINEAR DIMENSIONS; MEASURING ANGLES; MEASURING AREAS; MEASURING IRREGULARITIES OF SURFACES OR CONTOURS

- G01B11/00—Measuring arrangements characterised by the use of optical techniques

- G01B11/02—Measuring arrangements characterised by the use of optical techniques for measuring length, width or thickness

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01P—MEASURING LINEAR OR ANGULAR SPEED, ACCELERATION, DECELERATION, OR SHOCK; INDICATING PRESENCE, ABSENCE, OR DIRECTION, OF MOVEMENT

- G01P13/00—Indicating or recording presence, absence, or direction, of movement

- G01P13/02—Indicating direction only, e.g. by weather vane

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01P—MEASURING LINEAR OR ANGULAR SPEED, ACCELERATION, DECELERATION, OR SHOCK; INDICATING PRESENCE, ABSENCE, OR DIRECTION, OF MOVEMENT

- G01P15/00—Measuring acceleration; Measuring deceleration; Measuring shock, i.e. sudden change of acceleration

- G01P15/18—Measuring acceleration; Measuring deceleration; Measuring shock, i.e. sudden change of acceleration in two or more dimensions

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S17/00—Systems using the reflection or reradiation of electromagnetic waves other than radio waves, e.g. lidar systems

- G01S17/02—Systems using the reflection of electromagnetic waves other than radio waves

- G01S17/06—Systems determining position data of a target

- G01S17/08—Systems determining position data of a target for measuring distance only

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S17/00—Systems using the reflection or reradiation of electromagnetic waves other than radio waves, e.g. lidar systems

- G01S17/02—Systems using the reflection of electromagnetic waves other than radio waves

- G01S17/06—Systems determining position data of a target

- G01S17/42—Simultaneous measurement of distance and other co-ordinates

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S17/00—Systems using the reflection or reradiation of electromagnetic waves other than radio waves, e.g. lidar systems

- G01S17/86—Combinations of lidar systems with systems other than lidar, radar or sonar, e.g. with direction finders

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S7/00—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00

- G01S7/48—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00 of systems according to group G01S17/00

- G01S7/4802—Details of systems according to groups G01S13/00, G01S15/00, G01S17/00 of systems according to group G01S17/00 using analysis of echo signal for target characterisation; Target signature; Target cross-section

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0346—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of the device orientation or free movement in a 3D space, e.g. 3D mice, 6-DOF [six degrees of freedom] pointers using gyroscopes, accelerometers or tilt-sensors

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/30—Determination of transform parameters for the alignment of images, i.e. image registration

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/50—Depth or shape recovery

- G06T7/521—Depth or shape recovery from laser ranging, e.g. using interferometry; from the projection of structured light

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

-

- G—PHYSICS

- G01—MEASURING; TESTING

- G01S—RADIO DIRECTION-FINDING; RADIO NAVIGATION; DETERMINING DISTANCE OR VELOCITY BY USE OF RADIO WAVES; LOCATING OR PRESENCE-DETECTING BY USE OF THE REFLECTION OR RERADIATION OF RADIO WAVES; ANALOGOUS ARRANGEMENTS USING OTHER WAVES

- G01S15/00—Systems using the reflection or reradiation of acoustic waves, e.g. sonar systems

- G01S15/02—Systems using the reflection or reradiation of acoustic waves, e.g. sonar systems using reflection of acoustic waves

- G01S15/06—Systems determining the position data of a target

- G01S15/08—Systems for measuring distance only

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2219/00—Indexing scheme for manipulating 3D models or images for computer graphics

- G06T2219/008—Cut plane or projection plane definition

Description

Claims (18)

- 端末から前記端末周囲の複数のポイントまでの距離を測定し、複数のポイントを含む平面の方向情報である平面情報を、前記端末の方向を基準として獲得する段階と、

方向センサによって測定された端末の方向情報、及び前記平面情報を利用して、前記平面のノーマルベクトルを獲得する段階であって、前記平面の方向情報の基準を、前記端末の方向から前記方向センサの基準方向に変換し、前記ノーマルベクトルを獲得する段階と、

前記ノーマルベクトルに基づいて、空間を限定する所定の複数の属性のうち前記平面の属性が何であるかを決定し、前記平面に表示するオブジェクトの動きが、前記平面の決定された属性に応じているように、前記オブジェクトのパラメータを決定する段階と、

前記端末の表示部に、前記決定されたパラメータにより、前記オブジェクトを表示する段階と、

を含む拡張現実提供方法をコンピュータに実行させるコンピュータプログラム。 - 赤外線センサから測定された前記赤外線センサから複数のポイントまでの距離及び方向を獲得する段階をさらに含み、

前記平面情報を獲得する段階は、前記測定された距離及び方向を利用し、前記平面情報を獲得することを特徴とする請求項1に記載のコンピュータプログラム。 - 前記方向センサは、加速度センサ及びジャイロセンサのうち1以上を含むことを特徴とする請求項1又は2に記載のコンピュータプログラム。

- 前記空間を限定する所定の複数の属性は、天井、壁、及び床を含むことを特徴とする請求項1〜3のうちの何れか1項に記載のコンピュータプログラム。

- 前記決定する段階は、前記属性に基づいて、前記オブジェクトの第1パラメータを決定し、前記平面の方向情報に基づいて、前記オブジェクトの第2パラメータを決定することを特徴とする請求項4に記載のコンピュータプログラム。

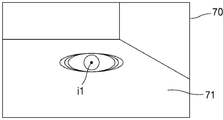

- 前記決定する段階は、前記属性に基づいて、前記オブジェクトの種類を決定し、前記平面の方向情報に基づいて、前記オブジェクトのレンダリング方向を決定し、

前記表示する段階は、前記オブジェクトを表示するための三次元情報を、前記レンダリング方向に沿って、二次元にレンダリングして表示することを特徴とする請求項4又は5に記載のコンピュータプログラム。 - 前記表示する段階は、前記端末に具備されるカメラによって撮影される映像と、前記オブジェクトとを重畳して表示することを特徴とする請求項1〜6のうちの何れか1項に記載のコンピュータプログラム。

- 前記距離は、前記端末に具備される距離センサによって測定され、

前記カメラ及び前記距離センサは、同一方向に向けて設置されることを特徴とする請求項7に記載のコンピュータプログラム。 - 前記パラメータは、前記オブジェクトの大きさ、方向、色相、及び前記オブジェクトに適用されるアニメーションのうち少なくとも一つを含むことを特徴とする請求項1〜8のうちの何れか1項に記載のコンピュータプログラム。

- 端末から前記端末周囲の複数のポイントまでの距離を測定し、複数のポイントを含む平面の方向情報である平面情報を、前記端末の方向を基準として獲得する段階と、

方向センサによって測定された端末の方向情報、及び前記平面情報を利用して、前記平面のノーマルベクトルを獲得する段階であって、前記平面の方向情報の基準を、前記端末の方向から前記方向センサの基準方向に変換し、前記ノーマルベクトルを獲得する段階と、

前記ノーマルベクトルに基づいて、空間を限定する所定の複数の属性のうち前記平面の属性が何であるかを決定し、前記平面に表示するオブジェクトの動きが、前記平面の決定された属性に応じているように、前記オブジェクトのパラメータを決定する段階と、

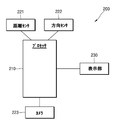

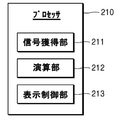

前記端末の表示部に、前記決定されたパラメータにより、前記オブジェクトを表示する段階と、を含む拡張現実提供方法。 - 距離センサによって測定された端末から前記端末周囲の複数のポイントまでの距離、及び方向センサによって測定された端末の方向情報を獲得する信号獲得部と、

前記距離を利用し、前記複数のポイントを含む平面の方向情報である平面情報を、前記端末の方向を基準として獲得し、前記端末の方向情報、及び前記平面情報を利用し、前記平面のノーマルベクトルを獲得し、前記ノーマルベクトルを考慮し、前記平面に表示するオブジェクトのパラメータを決定する演算部と、

前記端末の表示部に、前記決定されたパラメータにより、前記オブジェクトを表示する表示制御部と、を含み、

前記演算部は、前記平面の方向情報の基準を前記端末の方向から前記方向センサの基準方向に変換することにより獲得したノーマルベクトルに基づいて、空間を限定する所定の複数の属性のうち前記平面の属性が何であるかを決定し、前記平面に表示するオブジェクトの動きが、前記平面の決定された属性に応じているように、前記オブジェクトのパラメータを決定する、拡張現実提供装置。 - 前記拡張現実提供装置は、

加速度センサ及びジャイロセンサのうち1以上を含む前記方向センサをさらに含むことを特徴とする請求項11に記載の拡張現実提供装置。 - 前記空間を限定する所定の複数の属性は、天井、壁、及び床を含むことを特徴とする請求項11又は12に記載の拡張現実提供装置。

- 前記演算部は、前記属性に基づいて、前記オブジェクトの第1パラメータを決定し、前記平面の方向情報に基づいて、前記オブジェクトの第2パラメータを決定することを特徴とする請求項13に記載の拡張現実提供装置。

- 前記演算部は、前記属性に基づいて、前記オブジェクトの種類を決定し、前記平面の方向情報に基づいて、前記オブジェクトのレンダリング方向を決定し、

前記表示制御部は、前記オブジェクトを表示するための三次元情報を、前記レンダリング方向に沿って、二次元にレンダリングして表示することを特徴とする請求項13又は14に記載の拡張現実提供装置。 - 前記表示制御部は、前記端末に具備されるカメラによって撮影される映像と、前記オブジェクトとを重畳して表示することを特徴とする請求項11〜15のうちの何れか1項に記載の拡張現実提供装置。

- 前記拡張現実提供装置は、

前記カメラと、

前記距離センサと、をさらに含み、

前記カメラ及び前記距離センサは、同一方向に向けて設置されることを特徴とする請求項16に記載の拡張現実提供装置。 - 前記パラメータは、前記オブジェクトの大きさ、方向、色相、及び前記オブジェクトに適用されるアニメーションのうち少なくとも一つを含むことを特徴とする請求項11〜17のうちの何れか1項に記載の拡張現実提供装置。

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| PCT/KR2017/002373 WO2018164287A1 (ko) | 2017-03-06 | 2017-03-06 | 증강현실 제공 방법, 장치 및 컴퓨터 프로그램 |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2020509505A JP2020509505A (ja) | 2020-03-26 |

| JP2020509505A5 JP2020509505A5 (ja) | 2020-11-05 |

| JP6980802B2 true JP6980802B2 (ja) | 2021-12-15 |

Family

ID=63448162

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2019548040A Active JP6980802B2 (ja) | 2017-03-06 | 2017-03-06 | 拡張現実を提供するための方法、装置及びコンピュータプログラム |

Country Status (5)

| Country | Link |

|---|---|

| US (2) | US11120629B2 (ja) |

| EP (1) | EP3594906B1 (ja) |

| JP (1) | JP6980802B2 (ja) |

| CN (2) | CN110313021B (ja) |

| WO (1) | WO2018164287A1 (ja) |

Families Citing this family (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN110930488B (zh) * | 2019-11-15 | 2023-06-06 | 深圳市瑞立视多媒体科技有限公司 | 鱼体行为模拟方法、装置、设备及存储介质 |

| CN111582418B (zh) * | 2020-05-20 | 2022-03-08 | 郝杰 | 一种ar虚拟说明书的滑动展示方法 |

| KR20210158695A (ko) * | 2020-06-24 | 2021-12-31 | 삼성전자주식회사 | 영상에서 평면을 검출하는 전자 장치 및 그 동작 방법 |

Family Cites Families (26)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0518940A (ja) * | 1991-07-09 | 1993-01-26 | Aloka Co Ltd | 超音波三次元画像表示装置 |

| JPH0998323A (ja) * | 1995-09-29 | 1997-04-08 | Matsushita Electric Ind Co Ltd | ビデオカメラ |

| JP2004192653A (ja) * | 1997-02-28 | 2004-07-08 | Toshiba Corp | マルチモーダルインタフェース装置およびマルチモーダルインタフェース方法 |

| JP2002366976A (ja) * | 2001-06-08 | 2002-12-20 | Fujitsu Ltd | オブジェクト表示プログラムおよびオブジェクト表示装置 |

| US8970690B2 (en) * | 2009-02-13 | 2015-03-03 | Metaio Gmbh | Methods and systems for determining the pose of a camera with respect to at least one object of a real environment |

| JP5232911B2 (ja) * | 2009-03-26 | 2013-07-10 | 京セラ株式会社 | 携帯電子機器 |

| KR100982768B1 (ko) | 2009-09-21 | 2010-09-20 | (주)올라웍스 | 단말기의 각도에 따라 서로 다른 영상 정보를 제공하기 위한 방법, 단말기 및 컴퓨터 판독 가능한 기록 매체 |

| US8963954B2 (en) * | 2010-06-30 | 2015-02-24 | Nokia Corporation | Methods, apparatuses and computer program products for providing a constant level of information in augmented reality |

| JP5799521B2 (ja) * | 2011-02-15 | 2015-10-28 | ソニー株式会社 | 情報処理装置、オーサリング方法及びプログラム |

| JP5724543B2 (ja) * | 2011-03-31 | 2015-05-27 | ソニー株式会社 | 端末装置、オブジェクト制御方法及びプログラム |

| KR101971948B1 (ko) * | 2011-07-28 | 2019-04-24 | 삼성전자주식회사 | 평면 특성 기반 마커리스 증강 현실 시스템 및 그 동작 방법 |

| CN103733229A (zh) * | 2011-08-24 | 2014-04-16 | 索尼公司 | 信息处理设备、信息处理方法及程序 |

| KR101837107B1 (ko) * | 2011-09-01 | 2018-03-09 | 에스케이 텔레콤주식회사 | 증강 현실을 이용하여 실내 위치 기반 서비스를 제공하는 단말기 및 컴퓨터로 읽을 수 있는 기록매체 |

| JP2013225245A (ja) * | 2012-04-23 | 2013-10-31 | Sony Corp | 画像処理装置、画像処理方法及びプログラム |

| KR101546654B1 (ko) * | 2012-06-26 | 2015-08-25 | 한국과학기술원 | 웨어러블 증강현실 환경에서 증강현실 서비스 제공 방법 및 장치 |

| US9317972B2 (en) * | 2012-12-18 | 2016-04-19 | Qualcomm Incorporated | User interface for augmented reality enabled devices |

| KR20140145217A (ko) * | 2013-05-30 | 2014-12-23 | (주)브이알엑스 | 공간정보를 이용한 3차원 가상 모델링 시스템 및 그 방법 |

| US9432636B2 (en) * | 2013-11-26 | 2016-08-30 | Microsoft Technology Licensing, Llc | Large-scale surface reconstruction that is robust against tracking and mapping errors |

| CN105765494B (zh) * | 2013-12-19 | 2019-01-22 | 麦克赛尔株式会社 | 投影型影像显示装置和投影型影像显示方法 |

| US9953111B2 (en) * | 2014-06-06 | 2018-04-24 | Matterport, Inc. | Semantic understanding of 3D data |

| US10659750B2 (en) * | 2014-07-23 | 2020-05-19 | Apple Inc. | Method and system for presenting at least part of an image of a real object in a view of a real environment, and method and system for selecting a subset of a plurality of images |

| US20160191877A1 (en) * | 2014-12-25 | 2016-06-30 | Panasonic Intellectual Property Management Co., Ltd. | Projector device and projection method |

| JP2016139199A (ja) * | 2015-01-26 | 2016-08-04 | 株式会社リコー | 画像処理装置、画像処理方法、およびプログラム |

| JP6723798B2 (ja) * | 2015-05-20 | 2020-07-15 | キヤノン株式会社 | 情報処理装置、方法、プログラム |

| KR20170014451A (ko) * | 2015-07-30 | 2017-02-08 | 삼성에스디에스 주식회사 | 시야 확보 시스템, 방법 및 이를 수행하기 위한 단말 |

| US9858683B2 (en) * | 2015-08-05 | 2018-01-02 | Intel Corporation | Method and system of planar surface detection objects in 3d space generated from captured images for image processing |

-

2017

- 2017-03-06 CN CN201780086884.9A patent/CN110313021B/zh active Active

- 2017-03-06 CN CN202310837824.3A patent/CN116863107A/zh active Pending

- 2017-03-06 WO PCT/KR2017/002373 patent/WO2018164287A1/ko unknown

- 2017-03-06 JP JP2019548040A patent/JP6980802B2/ja active Active

- 2017-03-06 EP EP17899941.3A patent/EP3594906B1/en active Active

-

2019

- 2019-07-11 US US16/508,830 patent/US11120629B2/en active Active

-

2021

- 2021-08-05 US US17/395,083 patent/US11562545B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| US11120629B2 (en) | 2021-09-14 |

| EP3594906B1 (en) | 2022-10-19 |

| EP3594906A1 (en) | 2020-01-15 |

| CN110313021A (zh) | 2019-10-08 |

| CN116863107A (zh) | 2023-10-10 |

| CN110313021B (zh) | 2023-07-25 |

| US11562545B2 (en) | 2023-01-24 |

| US20210366199A1 (en) | 2021-11-25 |

| WO2018164287A1 (ko) | 2018-09-13 |

| JP2020509505A (ja) | 2020-03-26 |

| US20190333282A1 (en) | 2019-10-31 |

| EP3594906A4 (en) | 2020-11-04 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US10789776B2 (en) | Structural modeling using depth sensors | |

| US9898844B2 (en) | Augmented reality content adapted to changes in real world space geometry | |

| CN105493154B (zh) | 用于确定增强现实环境中的平面的范围的系统和方法 | |

| US8970586B2 (en) | Building controllable clairvoyance device in virtual world | |

| US11263457B2 (en) | Virtual item display simulations | |

| CN103914876B (zh) | 用于在3d地图上显示视频的方法和设备 | |

| US20150185825A1 (en) | Assigning a virtual user interface to a physical object | |

| US9805509B2 (en) | Method and system for constructing a virtual image anchored onto a real-world object | |

| US20180033203A1 (en) | System and method for representing remote participants to a meeting | |

| US20150187137A1 (en) | Physical object discovery | |

| US9268410B2 (en) | Image processing device, image processing method, and program | |

| US20140002443A1 (en) | Augmented reality interface | |

| US20160034137A1 (en) | Reality capture graphical user interface | |

| CN110473293B (zh) | 虚拟对象处理方法及装置、存储介质和电子设备 | |

| US9160979B1 (en) | Determining camera position for a photograph having a displaced center of projection | |

| US11562545B2 (en) | Method and device for providing augmented reality, and computer program | |

| CN104360729A (zh) | 基于Kinect和Unity3D的多交互方法与装置 | |

| US20230037750A1 (en) | Systems and methods for generating stabilized images of a real environment in artificial reality | |

| Afif et al. | Orientation control for indoor virtual landmarks based on hybrid-based markerless augmented reality | |

| US9881419B1 (en) | Technique for providing an initial pose for a 3-D model | |

| US11562538B2 (en) | Method and system for providing a user interface for a 3D environment | |

| KR20140001152A (ko) | 증강현실 기반의 실시간 관심 컨텍스트 등록 시스템 및 그 방법 | |

| KR20180090499A (ko) | 증강현실과 가상현실 쇼핑을 위한 상품의 3d모델 적용방법 | |

| US20230326147A1 (en) | Helper data for anchors in augmented reality | |

| Lue et al. | 3D whiteboard: collaborative sketching with 3D-tracked smart phones |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20200217 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20200917 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20210413 |

|

| RD03 | Notification of appointment of power of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7423 Effective date: 20210414 |

|

| A711 | Notification of change in applicant |

Free format text: JAPANESE INTERMEDIATE CODE: A712 Effective date: 20210412 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210601 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20211019 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20211117 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6980802 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| S111 | Request for change of ownership or part of ownership |

Free format text: JAPANESE INTERMEDIATE CODE: R313111 |

|

| S533 | Written request for registration of change of name |

Free format text: JAPANESE INTERMEDIATE CODE: R313533 |

|

| R350 | Written notification of registration of transfer |

Free format text: JAPANESE INTERMEDIATE CODE: R350 |