JP6444886B2 - ニアアイ・ディスプレイのディスプレイ更新時間の低減 - Google Patents

ニアアイ・ディスプレイのディスプレイ更新時間の低減 Download PDFInfo

- Publication number

- JP6444886B2 JP6444886B2 JP2015550679A JP2015550679A JP6444886B2 JP 6444886 B2 JP6444886 B2 JP 6444886B2 JP 2015550679 A JP2015550679 A JP 2015550679A JP 2015550679 A JP2015550679 A JP 2015550679A JP 6444886 B2 JP6444886 B2 JP 6444886B2

- Authority

- JP

- Japan

- Prior art keywords

- image data

- display

- data

- user

- eye

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 230000009467 reduction Effects 0.000 title description 3

- 210000001508 eye Anatomy 0.000 claims description 123

- 238000004891 communication Methods 0.000 claims description 120

- 238000000034 method Methods 0.000 claims description 109

- 230000005540 biological transmission Effects 0.000 claims description 77

- 238000012937 correction Methods 0.000 claims description 26

- 239000013598 vector Substances 0.000 claims description 16

- 238000005516 engineering process Methods 0.000 claims description 11

- 230000004044 response Effects 0.000 claims description 5

- 238000012545 processing Methods 0.000 description 62

- 238000013507 mapping Methods 0.000 description 53

- 230000003287 optical effect Effects 0.000 description 53

- 210000001525 retina Anatomy 0.000 description 35

- 210000001747 pupil Anatomy 0.000 description 20

- 239000000872 buffer Substances 0.000 description 19

- 238000001514 detection method Methods 0.000 description 17

- 230000004438 eyesight Effects 0.000 description 15

- 230000033001 locomotion Effects 0.000 description 15

- 230000008569 process Effects 0.000 description 15

- 238000010586 diagram Methods 0.000 description 13

- 210000003128 head Anatomy 0.000 description 13

- 230000003190 augmentative effect Effects 0.000 description 11

- 230000009471 action Effects 0.000 description 9

- 230000008859 change Effects 0.000 description 9

- 230000006870 function Effects 0.000 description 9

- 238000005286 illumination Methods 0.000 description 9

- 230000000007 visual effect Effects 0.000 description 9

- 241000282412 Homo Species 0.000 description 6

- 239000003086 colorant Substances 0.000 description 6

- 238000007906 compression Methods 0.000 description 6

- 230000006835 compression Effects 0.000 description 6

- 230000000694 effects Effects 0.000 description 5

- 238000012549 training Methods 0.000 description 5

- 210000004087 cornea Anatomy 0.000 description 4

- 230000001413 cellular effect Effects 0.000 description 3

- 230000001419 dependent effect Effects 0.000 description 3

- 239000011521 glass Substances 0.000 description 3

- 230000004297 night vision Effects 0.000 description 3

- 230000008447 perception Effects 0.000 description 3

- 238000013459 approach Methods 0.000 description 2

- 230000004397 blinking Effects 0.000 description 2

- 210000005252 bulbus oculi Anatomy 0.000 description 2

- 239000002131 composite material Substances 0.000 description 2

- 230000007423 decrease Effects 0.000 description 2

- 230000004424 eye movement Effects 0.000 description 2

- 210000000887 face Anatomy 0.000 description 2

- 230000004927 fusion Effects 0.000 description 2

- 238000007373 indentation Methods 0.000 description 2

- 239000000463 material Substances 0.000 description 2

- 210000004279 orbit Anatomy 0.000 description 2

- 238000003909 pattern recognition Methods 0.000 description 2

- 238000001228 spectrum Methods 0.000 description 2

- 238000012546 transfer Methods 0.000 description 2

- 210000000707 wrist Anatomy 0.000 description 2

- RYGMFSIKBFXOCR-UHFFFAOYSA-N Copper Chemical compound [Cu] RYGMFSIKBFXOCR-UHFFFAOYSA-N 0.000 description 1

- 230000001133 acceleration Effects 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 210000004556 brain Anatomy 0.000 description 1

- 230000009172 bursting Effects 0.000 description 1

- 230000015556 catabolic process Effects 0.000 description 1

- 229910052802 copper Inorganic materials 0.000 description 1

- 239000010949 copper Substances 0.000 description 1

- 230000008878 coupling Effects 0.000 description 1

- 238000010168 coupling process Methods 0.000 description 1

- 238000005859 coupling reaction Methods 0.000 description 1

- 238000006731 degradation reaction Methods 0.000 description 1

- 238000013461 design Methods 0.000 description 1

- 230000009977 dual effect Effects 0.000 description 1

- 210000005069 ears Anatomy 0.000 description 1

- 230000004418 eye rotation Effects 0.000 description 1

- 230000001815 facial effect Effects 0.000 description 1

- 238000001914 filtration Methods 0.000 description 1

- 238000003331 infrared imaging Methods 0.000 description 1

- 238000005259 measurement Methods 0.000 description 1

- 230000007246 mechanism Effects 0.000 description 1

- 238000005192 partition Methods 0.000 description 1

- 230000002093 peripheral effect Effects 0.000 description 1

- 230000005043 peripheral vision Effects 0.000 description 1

- 239000000047 product Substances 0.000 description 1

- 230000002207 retinal effect Effects 0.000 description 1

- 230000035945 sensitivity Effects 0.000 description 1

- 238000000638 solvent extraction Methods 0.000 description 1

- 238000000547 structure data Methods 0.000 description 1

- 239000013589 supplement Substances 0.000 description 1

- 238000012360 testing method Methods 0.000 description 1

- 238000013519 translation Methods 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

-

- H—ELECTRICITY

- H03—ELECTRONIC CIRCUITRY

- H03M—CODING; DECODING; CODE CONVERSION IN GENERAL

- H03M13/00—Coding, decoding or code conversion, for error detection or error correction; Coding theory basic assumptions; Coding bounds; Error probability evaluation methods; Channel models; Simulation or testing of codes

- H03M13/03—Error detection or forward error correction by redundancy in data representation, i.e. code words containing more digits than the source words

-

- H—ELECTRICITY

- H03—ELECTRONIC CIRCUITRY

- H03M—CODING; DECODING; CODE CONVERSION IN GENERAL

- H03M13/00—Coding, decoding or code conversion, for error detection or error correction; Coding theory basic assumptions; Coding bounds; Error probability evaluation methods; Channel models; Simulation or testing of codes

- H03M13/35—Unequal or adaptive error protection, e.g. by providing a different level of protection according to significance of source information or by adapting the coding according to the change of transmission channel characteristics

- H03M13/356—Unequal error protection [UEP]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/234318—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements by decomposing into objects, e.g. MPEG-4 objects

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/234345—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements the reformatting operation being performed only on part of the stream, e.g. a region of the image or a time segment

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/234354—Processing of video elementary streams, e.g. splicing of video streams, manipulating MPEG-4 scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements by altering signal-to-noise ratio parameters, e.g. requantization

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/238—Interfacing the downstream path of the transmission network, e.g. adapting the transmission rate of a video stream to network bandwidth; Processing of multiplex streams

- H04N21/2383—Channel coding or modulation of digital bit-stream, e.g. QPSK modulation

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/0127—Head-up displays characterised by optical features comprising devices increasing the depth of field

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/0101—Head-up displays characterised by optical features

- G02B2027/014—Head-up displays characterised by optical features comprising information/image processing systems

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/01—Head-up displays

- G02B27/017—Head mounted

- G02B2027/0178—Eyeglass type

-

- G—PHYSICS

- G02—OPTICS

- G02B—OPTICAL ELEMENTS, SYSTEMS OR APPARATUS

- G02B27/00—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00

- G02B27/0093—Optical systems or apparatus not provided for by any of the groups G02B1/00 - G02B26/00, G02B30/00 with means for monitoring data relating to the user, e.g. head-tracking, eye-tracking

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/134—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or criterion affecting or controlling the adaptive coding

- H04N19/167—Position within a video image, e.g. region of interest [ROI]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/65—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using error resilience

- H04N19/67—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using error resilience involving unequal error protection [UEP], i.e. providing protection according to the importance of the data

Description

Claims (4)

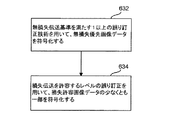

- ニアアイ・ディスプレイ・デバイスの3次元(3D)視野における3D距離ベクトルを決定するステップであって、前記3D距離ベクトルは、前記ニアアイ・ディスプレイ・デバイス上の予め定められた基準点と、前記ニアアイ・ディスプレイ・デバイスのユーザの一方の眼と、のうちの1つから、前記ユーザの3D注目点へと伸びるものであり、前記一方の眼は、前記ニアアイ・ディスプレイ・デバイスから離間しており前記ニアアイ・ディスプレイ・デバイスと接しておらず、前記ユーザの前記3D注目点は、前記ニアアイ・ディスプレイ・デバイスを超えており、前記3D視野内に存在する、ステップと、

前記ユーザの前記3D注目点へと伸びる前記の決定された3D距離ベクトルと、予め定められた低知覚基準と、に基づいて、前記3D視野を表す画像データの少なくとも一部が、前記低知覚基準を満たさない無損失優先画像データとして適しているかどうかを判定するステップと、

前記の決定された3D距離ベクトルに基づいて、前記3D視野を表す前記画像データの他の少なくとも一部が、前記低知覚基準を満たす損失許容画像データとして適しているかどうかを判定するステップと、

前記画像データの他の少なくとも一部が損失許容画像データとして適していることに応じて、損失伝送を許容する1以上の通信技術を用いて、第1の更新データとして前記損失許容画像データを前記ニアアイ・ディスプレイ・デバイスに送信する第1送信ステップと、

前記画像データの少なくとも一部が前記無損失優先画像データとして適していることに応じて、無損失伝送基準を満たす1以上の通信技術を用いて、第2の更新データとして前記無損失優先画像データを前記ニアアイ・ディスプレイ・デバイスに送信する第2送信ステップと、

を含む、方法であって、

前記無損失優先画像データを前記ニアアイ・ディスプレイ・デバイスに送信することは、

無損失伝送基準を満たす1以上の通信技術を用いるコンピュータ・システムの使用を含み、

前記方法は、

無損失伝送基準を満たす1以上の誤り訂正技術を用いて、前記無損失優先画像データを符号化するステップ

をさらに含み、

損失伝送を許容する1以上の通信技術を用いて、前記コンピュータ・システムから前記ニアアイ・ディスプレイ・デバイスに前記損失許容画像データを送信することは、

パケットの1以上のデータ完全性ヘッダ・ビットを設定し、損失伝送を許容するレベルの誤り訂正により、前記損失許容画像データの少なくとも一部のための冗長データを含めないことにより、前記損失許容画像データの前記少なくとも一部を符号化すること

を含む、方法。 - 無損失伝送基準を満たす前記1以上の通信技術は、順方向誤り訂正(FEC)を含む、請求項1記載の方法。

- 前記無損失優先画像データは、ユーザ焦点領域内に表示するためのユーザ焦点領域画像データを含み、

前記損失許容画像データは、前記ユーザ焦点領域外に表示するための少なくとも何らかのセカンダリ画像データを含み、

前記セカンダリ画像データは、前記ユーザ焦点領域画像データよりも低い画像解像度を有する、請求項1記載の方法。 - 前記セカンダリ画像データは、前記ユーザ焦点領域画像データとは異なるディスプレイ更新速度を有する、請求項3記載の方法。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US13/728,892 | 2012-12-27 | ||

| US13/728,892 US10514541B2 (en) | 2012-12-27 | 2012-12-27 | Display update time reduction for a near-eye display |

| PCT/US2013/076705 WO2014105654A1 (en) | 2012-12-27 | 2013-12-19 | Display update time reduction for a near-eye display |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2016510525A JP2016510525A (ja) | 2016-04-07 |

| JP2016510525A5 JP2016510525A5 (ja) | 2017-01-19 |

| JP6444886B2 true JP6444886B2 (ja) | 2018-12-26 |

Family

ID=50023850

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2015550679A Active JP6444886B2 (ja) | 2012-12-27 | 2013-12-19 | ニアアイ・ディスプレイのディスプレイ更新時間の低減 |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US10514541B2 (ja) |

| EP (1) | EP2939432B1 (ja) |

| JP (1) | JP6444886B2 (ja) |

| KR (1) | KR102192927B1 (ja) |

| CN (1) | CN105340279A (ja) |

| WO (1) | WO2014105654A1 (ja) |

Families Citing this family (79)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN104246864B (zh) * | 2013-02-22 | 2016-06-29 | 索尼公司 | 头戴式显示器和图像显示装置 |

| KR20150045637A (ko) * | 2013-10-21 | 2015-04-29 | 삼성전자주식회사 | 사용자 인터페이스 운용 방법 및 그 전자 장치 |

| US10203762B2 (en) * | 2014-03-11 | 2019-02-12 | Magic Leap, Inc. | Methods and systems for creating virtual and augmented reality |

| US9971153B2 (en) * | 2014-03-29 | 2018-05-15 | Frimory Technologies Ltd. | Method and apparatus for displaying video data |

| US10852838B2 (en) | 2014-06-14 | 2020-12-01 | Magic Leap, Inc. | Methods and systems for creating virtual and augmented reality |

| AU2015284303B2 (en) * | 2014-07-02 | 2019-07-25 | Covidien Lp | System and method for detecting trachea |

| US9977495B2 (en) * | 2014-09-19 | 2018-05-22 | Utherverse Digital Inc. | Immersive displays |

| US10061486B2 (en) * | 2014-11-05 | 2018-08-28 | Northrop Grumman Systems Corporation | Area monitoring system implementing a virtual environment |

| US9804669B2 (en) * | 2014-11-07 | 2017-10-31 | Eye Labs, Inc. | High resolution perception of content in a wide field of view of a head-mounted display |

| US10825069B2 (en) * | 2014-11-14 | 2020-11-03 | The Joan and Irwin Jacobs Technion-Cornell Institute | System and method for intuitive content browsing |

| US10824987B2 (en) | 2014-11-14 | 2020-11-03 | The Joan and Irwin Jacobs Technion-Cornell Institute | Techniques for embedding virtual points of sale in electronic media content |

| CN104469344B (zh) * | 2014-12-03 | 2017-03-01 | 北京智谷技术服务有限公司 | 光场显示控制方法和装置、光场显示设备 |

| WO2016090282A1 (en) | 2014-12-05 | 2016-06-09 | Cowbyt Technologies Llc | Autonomous navigation system |

| US20160180762A1 (en) * | 2014-12-22 | 2016-06-23 | Elwha Llc | Systems, methods, and devices for controlling screen refresh rates |

| US20220005587A1 (en) * | 2015-03-17 | 2022-01-06 | Raytrx, Llc | System, method, and non-transitory computer-readable storage media related to correction of vision defects using a visual display |

| JP2018523147A (ja) | 2015-05-08 | 2018-08-16 | ビ−エイイ− システムズ パブリック リミテッド カンパニ−BAE SYSTEMS plc | ディスプレイにおける、および、ディスプレイに関連する改良 |

| DE102015213376A1 (de) | 2015-07-16 | 2017-01-19 | Robert Bosch Gmbh | Projektionsvorrichtung für eine Datenbrille, Datenbrille und Verfahren zum Betreiben einer Projektionsvorrichtung für eine Datenbrille |

| US9900602B2 (en) * | 2015-08-20 | 2018-02-20 | Citrix Systems, Inc. | Optimizing remote graphics delivery and presentation |

| US20170094227A1 (en) * | 2015-09-25 | 2017-03-30 | Northrop Grumman Systems Corporation | Three-dimensional spatial-awareness vision system |

| US9880384B2 (en) * | 2015-11-27 | 2018-01-30 | Fove, Inc. | Gaze detection system, gaze point detection method, and gaze point detection program |

| WO2017138458A1 (ja) | 2016-02-09 | 2017-08-17 | 株式会社ソニー・インタラクティブエンタテインメント | 映像表示システム |

| US10334224B2 (en) | 2016-02-19 | 2019-06-25 | Alcacruz Inc. | Systems and method for GPU based virtual reality video streaming server |

| US10540007B2 (en) * | 2016-03-04 | 2020-01-21 | Rockwell Collins, Inc. | Systems and methods for delivering imagery to head-worn display systems |

| CN108701227B (zh) * | 2016-03-07 | 2022-01-14 | 奇跃公司 | 用于生物安全的蓝光调节 |

| US10797977B2 (en) | 2016-03-22 | 2020-10-06 | Citrix Systems, Inc. | Robust suspension and resumption of desktop virtualization |

| GB2548860A (en) | 2016-03-31 | 2017-10-04 | Nokia Technologies Oy | Multi-camera image coding |

| US10460704B2 (en) * | 2016-04-01 | 2019-10-29 | Movidius Limited | Systems and methods for head-mounted display adapted to human visual mechanism |

| EP3440495A1 (en) * | 2016-04-08 | 2019-02-13 | Google LLC | Encoding image data at a head mounted display device based on pose information |

| US10134198B2 (en) | 2016-04-19 | 2018-11-20 | Adobe Systems Incorporated | Image compensation for an occluding direct-view augmented reality system |

| JP6533761B2 (ja) * | 2016-05-18 | 2019-06-19 | 株式会社ソニー・インタラクティブエンタテインメント | 情報処理装置、情報処理システム、および情報処理方法 |

| CN107404641A (zh) * | 2016-05-18 | 2017-11-28 | 中兴通讯股份有限公司 | 视频处理方法、视频播放方法、机顶盒以及vr设备 |

| JP6499993B2 (ja) * | 2016-05-18 | 2019-04-10 | 株式会社ソニー・インタラクティブエンタテインメント | 情報処理装置、情報処理システム、および情報処理方法 |

| EP3472806A4 (en) | 2016-06-17 | 2020-02-26 | Immersive Robotics Pty Ltd | IMAGE COMPRESSION METHOD AND DEVICE |

| KR101713492B1 (ko) | 2016-06-27 | 2017-03-07 | 가천대학교 산학협력단 | 영상 복호화 방법, 영상 부호화 방법, 영상 복호화 장치, 및 영상 부호화 장치 |

| US10373592B2 (en) | 2016-08-01 | 2019-08-06 | Facebook Technologies, Llc | Adaptive parameters in image regions based on eye tracking information |

| US10042421B2 (en) * | 2016-08-24 | 2018-08-07 | Disney Enterprises, Inc. | System and method of latency-aware rendering of a focal area of an animation |

| US10255714B2 (en) * | 2016-08-24 | 2019-04-09 | Disney Enterprises, Inc. | System and method of gaze predictive rendering of a focal area of an animation |

| US10438318B2 (en) * | 2016-08-30 | 2019-10-08 | Intel IP Corporation | Blind spot rendering optimizations for eye tracking head mounted displays |

| KR102650215B1 (ko) * | 2016-10-18 | 2024-03-21 | 삼성전자주식회사 | 영상 처리 방법 및 장치 |

| WO2018092147A1 (en) * | 2016-11-21 | 2018-05-24 | Karma Touch 2016 Ltd. | Compressing and decompressing an image based on gaze point |

| EP3548987A4 (en) * | 2016-12-01 | 2020-05-20 | Shanghai Yunyinggu Technology Co., Ltd. | ZONE-BASED DISPLAY DATA PROCESSING AND TRANSMISSION |

| US10120442B2 (en) * | 2016-12-21 | 2018-11-06 | Oculus Vr, Llc | Eye tracking using a light field camera on a head-mounted display |

| US10121337B2 (en) * | 2016-12-30 | 2018-11-06 | Axis Ab | Gaze controlled bit rate |

| EP3579941A4 (en) | 2017-02-08 | 2020-10-28 | Immersive Robotics Pty Ltd | ANTENNA CONTROL FOR COMMUNICATION BETWEEN MOBILE DEVICES |

| CN106951153B (zh) * | 2017-02-21 | 2020-11-20 | 联想(北京)有限公司 | 一种显示方法及电子设备 |

| US20180262758A1 (en) * | 2017-03-08 | 2018-09-13 | Ostendo Technologies, Inc. | Compression Methods and Systems for Near-Eye Displays |

| US10277943B2 (en) * | 2017-03-27 | 2019-04-30 | Microsoft Technology Licensing, Llc | Selective rendering of sparse peripheral displays based on user movements |

| US10979685B1 (en) | 2017-04-28 | 2021-04-13 | Apple Inc. | Focusing for virtual and augmented reality systems |

| CN116456097A (zh) | 2017-04-28 | 2023-07-18 | 苹果公司 | 视频流水线 |

| GB2562490A (en) * | 2017-05-16 | 2018-11-21 | Nokia Technologies Oy | An apparatus, a method and a computer program for video coding and decoding |

| US10665209B2 (en) * | 2017-05-18 | 2020-05-26 | Synaptics Incorporated | Display interface with foveal compression |

| US20200145696A1 (en) * | 2017-06-05 | 2020-05-07 | Immersive Robotics Pty Ltd | Digital Content Stream Compression |

| US10477105B2 (en) * | 2017-06-08 | 2019-11-12 | Futurewei Technologies, Inc. | Method and system for transmitting virtual reality (VR) content |

| CN107239144B (zh) | 2017-06-09 | 2020-02-07 | 歌尔股份有限公司 | 一种设备的输入方法和装置 |

| CN107333119A (zh) | 2017-06-09 | 2017-11-07 | 歌尔股份有限公司 | 一种显示数据的处理方法和设备 |

| GB2563832B (en) * | 2017-06-23 | 2021-11-10 | Sony Interactive Entertainment Inc | Display method and apparatus |

| US10861142B2 (en) | 2017-07-21 | 2020-12-08 | Apple Inc. | Gaze direction-based adaptive pre-filtering of video data |

| US10976811B2 (en) * | 2017-08-11 | 2021-04-13 | Microsoft Technology Licensing, Llc | Eye-tracking with MEMS scanning and reflected light |

| CN107317987B (zh) * | 2017-08-14 | 2020-07-03 | 歌尔股份有限公司 | 虚拟现实的显示数据压缩方法和设备、系统 |

| GB201713843D0 (en) * | 2017-08-30 | 2017-10-11 | Nokia Technologies Oy | A method, device and a system for enhanced field of view |

| AU2018372561B2 (en) | 2017-11-21 | 2023-01-05 | Immersive Robotics Pty Ltd | Image compression for digital reality |

| US11553187B2 (en) | 2017-11-21 | 2023-01-10 | Immersive Robotics Pty Ltd | Frequency component selection for image compression |

| US10949947B2 (en) | 2017-12-29 | 2021-03-16 | Intel Corporation | Foveated image rendering for head-mounted display devices |

| US10770023B2 (en) | 2018-05-29 | 2020-09-08 | Synaptics Incorporated | Dynamic overdrive for liquid crystal displays |

| US10916040B2 (en) * | 2018-07-24 | 2021-02-09 | Apical Ltd. | Processing image data using different data reduction rates |

| US11048464B2 (en) * | 2018-07-31 | 2021-06-29 | Dell Products, L.P. | Synchronization and streaming of workspace contents with audio for collaborative virtual, augmented, and mixed reality (xR) applications |

| US10930049B2 (en) * | 2018-08-27 | 2021-02-23 | Apple Inc. | Rendering virtual objects with realistic surface properties that match the environment |

| WO2020044916A1 (ja) * | 2018-08-29 | 2020-03-05 | ソニー株式会社 | 情報処理装置、情報処理方法及びプログラム |

| US10762866B2 (en) * | 2018-08-30 | 2020-09-01 | Synaptics Incorporated | Display rescan |

| JP7093418B2 (ja) * | 2018-09-20 | 2022-06-29 | 富士フイルム株式会社 | 情報処理装置、情報処理システム、情報処理方法、及びプログラム |

| KR102055824B1 (ko) * | 2018-10-25 | 2019-12-13 | 에스케이텔레콤 주식회사 | 증강현실 영상의 디스플레이 방법 및 이에 사용되는 장치 |

| US10860104B2 (en) | 2018-11-09 | 2020-12-08 | Intel Corporation | Augmented reality controllers and related methods |

| US11644940B1 (en) | 2019-01-31 | 2023-05-09 | Splunk Inc. | Data visualization in an extended reality environment |

| US11853533B1 (en) * | 2019-01-31 | 2023-12-26 | Splunk Inc. | Data visualization workspace in an extended reality environment |

| US20220417568A1 (en) * | 2019-11-26 | 2022-12-29 | Sony Group Corporation | Image transmission apparatus and display apparatus |

| US20210327121A1 (en) * | 2020-04-15 | 2021-10-21 | Sirisilp Kongsilp | Display based mixed-reality device |

| DE102020215285A1 (de) | 2020-12-03 | 2022-06-09 | Robert Bosch Gesellschaft mit beschränkter Haftung | Verfahren zur Parallaxeregelung und binokulare Datenbrille mit einer Recheneinheit zu einem Durchführen des Verfahrens |

| WO2022158611A1 (ko) * | 2021-01-19 | 2022-07-28 | 주식회사 포에스텍 | 초음파 센서를 활용한 수중 환경 영상의 보정 방법 |

| CN112791399B (zh) * | 2021-02-08 | 2021-08-31 | 腾讯科技(深圳)有限公司 | 云游戏画面的显示方法及装置、系统、介质、电子设备 |

Family Cites Families (31)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0820933B2 (ja) | 1990-04-20 | 1996-03-04 | ダイキン工業株式会社 | データ書き込み方法およびその装置 |

| EP0863431B1 (en) | 1992-06-02 | 2004-10-20 | Canon Kabushiki Kaisha | Optical apparatus for detecting rotation of an eyeball of an observer |

| JPH06284449A (ja) | 1993-03-25 | 1994-10-07 | Kyocera Corp | 視差を利用した映像信号の帯域圧縮回路および画像符号化装置 |

| JPH0846836A (ja) | 1994-07-29 | 1996-02-16 | Canon Inc | 視線検出方法及び装置並びに撮像装置 |

| JPH08234141A (ja) | 1994-12-01 | 1996-09-13 | Olympus Optical Co Ltd | 頭部装着型映像表示装置 |

| FI120711B (fi) | 1995-02-06 | 2010-01-29 | Adc Telecommunications Inc | Monipiste-pisteeseen tietoliikennejärjestelmä |

| JPH09224267A (ja) | 1996-02-16 | 1997-08-26 | Olympus Optical Co Ltd | 立体映像作成装置及び立体映像表示装置並びにシステム |

| CN1175373C (zh) | 1998-03-20 | 2004-11-10 | 三菱电机株式会社 | 有损失/无损失感兴趣区域图像编码的方法和系统 |

| SE521021C2 (sv) | 1998-06-18 | 2003-09-23 | Ericsson Telefon Ab L M | Förfarande och anordning vid överförande av bilder |

| GB0000573D0 (en) | 2000-01-12 | 2000-03-01 | Nokia Mobile Phones Ltd | Receiver based isochronous transmissions |

| US6975655B2 (en) * | 2000-04-07 | 2005-12-13 | Broadcom Corporation | Method of controlling data sampling clocking of asynchronous network nodes in a frame-based communications network |

| US6603491B2 (en) * | 2000-05-26 | 2003-08-05 | Jerome H. Lemelson | System and methods for controlling automatic scrolling of information on a display or screen |

| US7679622B2 (en) * | 2000-07-28 | 2010-03-16 | Alcatel-Lucent Usa Inc. | Foveation-based error resilience algorithm |

| US6909753B2 (en) | 2001-12-05 | 2005-06-21 | Koninklijke Philips Electronics, N.V. | Combined MPEG-4 FGS and modulation algorithm for wireless video transmission |

| US7010169B2 (en) | 2002-04-15 | 2006-03-07 | Sbc Technology Resources, Inc. | Multi-point predictive foveation for bandwidth reduction of moving images |

| US7401920B1 (en) | 2003-05-20 | 2008-07-22 | Elbit Systems Ltd. | Head mounted eye tracking and display system |

| US7492821B2 (en) | 2005-02-08 | 2009-02-17 | International Business Machines Corporation | System and method for selective image capture, transmission and reconstruction |

| EP1720357A1 (de) | 2005-05-04 | 2006-11-08 | Swisscom Mobile AG | Verfahren und Vorrichtung zur Übermittlung von Videodaten mit Komprimierung basierend auf Blickrichtung nach Augenverfolgungsverfahren |

| EP2168297A1 (en) * | 2007-06-08 | 2010-03-31 | QUALCOMM Incorporated | Hierarchical modulation for communication channels in single-carrier frequency division multiple access |

| US7556377B2 (en) | 2007-09-28 | 2009-07-07 | International Business Machines Corporation | System and method of detecting eye fixations using adaptive thresholds |

| US20090096927A1 (en) | 2007-10-15 | 2009-04-16 | Camp Jr William O | System and method for video coding using variable compression and object motion tracking |

| US8786675B2 (en) | 2008-01-23 | 2014-07-22 | Michael F. Deering | Systems using eye mounted displays |

| JP5415948B2 (ja) | 2008-02-28 | 2014-02-12 | パナソニック株式会社 | 視線検出装置及び視線検出方法 |

| US9200901B2 (en) * | 2008-06-19 | 2015-12-01 | Microsoft Technology Licensing, Llc | Predictive services for devices supporting dynamic direction information |

| JP5254122B2 (ja) | 2009-04-24 | 2013-08-07 | パナソニック株式会社 | カメラ、映像送信装置、映像受信装置及び映像通信システム |

| US8884984B2 (en) | 2010-10-15 | 2014-11-11 | Microsoft Corporation | Fusing virtual content into real content |

| US9304319B2 (en) | 2010-11-18 | 2016-04-05 | Microsoft Technology Licensing, Llc | Automatic focus improvement for augmented reality displays |

| US9213405B2 (en) | 2010-12-16 | 2015-12-15 | Microsoft Technology Licensing, Llc | Comprehension and intent-based content for augmented reality displays |

| US8983555B2 (en) | 2011-01-07 | 2015-03-17 | Microsoft Technology Licensing, Llc | Wireless communication techniques |

| US10972680B2 (en) | 2011-03-10 | 2021-04-06 | Microsoft Technology Licensing, Llc | Theme-based augmentation of photorepresentative view |

| US8184069B1 (en) | 2011-06-20 | 2012-05-22 | Google Inc. | Systems and methods for adaptive transmission of data |

-

2012

- 2012-12-27 US US13/728,892 patent/US10514541B2/en active Active

-

2013

- 2013-12-19 EP EP13824559.2A patent/EP2939432B1/en active Active

- 2013-12-19 WO PCT/US2013/076705 patent/WO2014105654A1/en active Application Filing

- 2013-12-19 JP JP2015550679A patent/JP6444886B2/ja active Active

- 2013-12-19 CN CN201380068578.4A patent/CN105340279A/zh active Pending

- 2013-12-19 KR KR1020157017002A patent/KR102192927B1/ko active IP Right Grant

Also Published As

| Publication number | Publication date |

|---|---|

| KR20150102026A (ko) | 2015-09-04 |

| EP2939432B1 (en) | 2020-04-15 |

| US20140184475A1 (en) | 2014-07-03 |

| US10514541B2 (en) | 2019-12-24 |

| CN105340279A (zh) | 2016-02-17 |

| JP2016510525A (ja) | 2016-04-07 |

| EP2939432A1 (en) | 2015-11-04 |

| KR102192927B1 (ko) | 2020-12-18 |

| WO2014105654A1 (en) | 2014-07-03 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6444886B2 (ja) | ニアアイ・ディスプレイのディスプレイ更新時間の低減 | |

| US11838518B2 (en) | Reprojecting holographic video to enhance streaming bandwidth/quality | |

| US11061240B2 (en) | Head-mountable apparatus and methods | |

| US20200142480A1 (en) | Immersive displays | |

| US10643389B2 (en) | Mechanism to give holographic objects saliency in multiple spaces | |

| US9256987B2 (en) | Tracking head movement when wearing mobile device | |

| US9035970B2 (en) | Constraint based information inference | |

| US20140146394A1 (en) | Peripheral display for a near-eye display device | |

| JP2022502800A (ja) | 拡張現実のためのシステムおよび方法 | |

| US11277603B2 (en) | Head-mountable display system | |

| KR20180038552A (ko) | 가상 및 증강 현실 시스템들 및 방법들 | |

| US20140002495A1 (en) | Multi-node poster location | |

| US20230403386A1 (en) | Image display within a three-dimensional environment | |

| CN116941239A (zh) | 三维环境内的图像显示 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20161130 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20161130 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20180206 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20180501 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20181030 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20181128 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6444886 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |