JP6435581B2 - 転移学習装置、転移学習システム、転移学習方法およびプログラム - Google Patents

転移学習装置、転移学習システム、転移学習方法およびプログラム Download PDFInfo

- Publication number

- JP6435581B2 JP6435581B2 JP2015016125A JP2015016125A JP6435581B2 JP 6435581 B2 JP6435581 B2 JP 6435581B2 JP 2015016125 A JP2015016125 A JP 2015016125A JP 2015016125 A JP2015016125 A JP 2015016125A JP 6435581 B2 JP6435581 B2 JP 6435581B2

- Authority

- JP

- Japan

- Prior art keywords

- transfer

- learning

- output

- data

- transfer destination

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/08—Learning methods

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/04—Architecture, e.g. interconnection topology

- G06N3/0464—Convolutional networks [CNN, ConvNet]

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/08—Learning methods

- G06N3/082—Learning methods modifying the architecture, e.g. adding, deleting or silencing nodes or connections

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/08—Learning methods

- G06N3/09—Supervised learning

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/08—Learning methods

- G06N3/091—Active learning

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/08—Learning methods

- G06N3/096—Transfer learning

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Health & Medical Sciences (AREA)

- Computing Systems (AREA)

- Biomedical Technology (AREA)

- Biophysics (AREA)

- Computational Linguistics (AREA)

- Data Mining & Analysis (AREA)

- Evolutionary Computation (AREA)

- Life Sciences & Earth Sciences (AREA)

- Molecular Biology (AREA)

- Artificial Intelligence (AREA)

- General Engineering & Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Mathematical Physics (AREA)

- Software Systems (AREA)

- Health & Medical Sciences (AREA)

- Image Analysis (AREA)

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

Description

本発明者らは、背景技術の欄において記載した、非特許文献1に開示される転移学習に関し、学習効果を損ない得るいくつかの問題に気づいた。

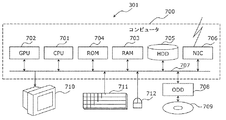

実施の形態を説明するための準備として、ニューラルネットワーク装置に関する一般的な事項について説明する。

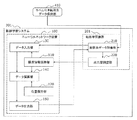

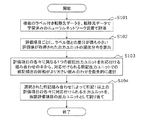

実施の形態1に係る転移学習装置は、複数の転移元データで学習済のニューラルネットワーク装置の構成や荷重値をそのまま使用しつつ、転移先データの評価項目の各々の評価値を出力するための出力ユニットの割り当てによって、転移先データに適応するための転移学習を行う転移学習装置である。

実施の形態2に係る転移学習装置は、実施の形態1で説明した出力ユニットの割り当てに加えて、前記ニューラルネットワーク装置における荷重値を、複数の転移元データで学習済みの荷重値を初期値として、複数のラベル付き転移先データを用いた教師付き学習によって更新する転移学習装置である。

実施の形態3に係る転移学習装置は、実施の形態1で説明した出力ユニットの割り当てに加えて、前記ニューラルネットワーク装置における荷重値を、複数の転移元データで学習済みの荷重値を初期値として、転移先データの評価項目との関連性が高い転移元データのラベルのみを用いた再学習によって更新する転移学習装置である。

実施の形態4に係る転移学習装置は、実施の形態1で説明した出力ユニットの割り当て、及び実施の形態2で説明した転移先データでの学習に加えて、前記ニューラルネットワーク装置において、少なくとも転移先データに適応するための転移学習が不足していることを検出する転移学習装置である。実施の形態4では、学習不足が検出されたときに行われる追加学習についても説明する。

101 入力層

102、102a、102b 隠れ層

103 出力層

105 ユニット

110 構成情報保持部

120 荷重保持部

130 データ入力部

140 データ演算部

150 データ出力部

201、202、203、204 転移学習装置

210 転移先データ評価部

220 出力層調整部

230、232、233、234 荷重調整部

240 学習不足検出部

250 正解取得部

301、302、303、304 転移学習システム

410 ラベル付き転移先データ保持部

420 ラベル付き転移元データ保持部

430 ラベルなし転移先データ保持部

440 ユーザーインターフェース部

Claims (13)

- 各々に1以上の評価項目ごとのラベルが付された複数のラベル付き転移先データを、前記評価項目と同数以上の出力ユニットを出力層に有しかつ複数のラベル付き転移元データで学習済みのニューラルネットワーク装置に入力することにより、前記出力ユニットから出力された評価値を取得する転移先データ評価部と、

前記1以上の評価項目の各々の評価値を出力するための出力ユニットとして、前記出力ユニットのうち当該評価項目のラベルとの差分が最も小さい評価値が取得された頻度がより高い出力ユニットを優先的に割り当てる出力層調整部と、

を備える転移学習装置。 - 前記出力層調整部は、

前記1以上の評価項目の各々について、前記複数のラベル付き転移先データにわたって当該評価項目のラベルとの差分が最も小さい評価値が取得された前記出力ユニットの頻度分布を算出し、

前記1以上の評価項目の各々に異なる1つの前記出力ユニットを対応付ける組み合わせの中から、対応付けられる前記出力ユニットの前記頻度の総和がより大きい組み合わせを優先的に選択し、

選択された前記組み合わせによって前記1以上の評価項目の各々に対応付けられる出力ユニットを、当該評価項目の出力ユニットとして割り当てる、

請求項1に記載の転移学習装置。 - 前記ニューラルネットワーク装置における荷重値を、前記複数のラベル付き転移元データで学習済みの荷重値を初期値として、前記複数の転移先データを用いた教師付き学習によって更新する荷重調整部を、さらに備える、

請求項1又は2に記載の転移学習装置。 - 前記荷重調整部は、前記ニューラルネットワーク装置が有する全てのユニットの荷重値を更新の対象とする、

請求項3に記載の転移学習装置。 - 前記ラベル付き転移元データには、前記出力ユニットの各々に対応するラベルが付されており、

前記荷重調整部は、さらに、前記ニューラルネットワーク装置における荷重値を、前記複数のラベル付き転移元データに付されたラベルのうち、前記出力層調整部によって割り当てられた出力ユニットに対応するラベルのみを用いた教師付き学習によって更新する、

請求項3から4の何れか1項に記載の転移学習装置。 - 前記荷重調整部は、前記教師付き学習を行う前に、前記ニューラルネットワーク装置が有する1以上の隠れ層の各々で教師なし学習を行う、

請求項3から5の何れか1項に記載の転移学習装置。 - 前記ニューラルネットワーク装置は、前記評価項目の数よりも多くの出力ユニットを前記出力層に有しており、

前記転移学習装置は、

1以上のラベルなし転移先データを前記ニューラルネットワーク装置に入力することにより、前記出力層調整部によって割り当てられなかった出力ユニットから出力された評価値を取得し、当該評価値が基準範囲から逸脱することにより学習不足を検出する学習不足検出部を、さらに備える、

請求項3から6の何れか1項に記載の転移学習装置。 - 前記転移学習装置は、

前記ラベルなし転移先データについて前記学習不足が検出された場合、前記ラベルなし転移先データに対応するラベルをユーザーから受け付ける正解取得部を、さらに備え、

前記荷重調整部は、前記ユーザーから受け付けた前記ラベルと前記ラベルなし転移先データとを用いた教師付き学習によって前記ニューラルネットワーク装置の荷重値を更新する、

請求項7に記載の転移学習装置。 - 前記正解取得部は、前記出力層調整部によって割り当てられなかった同じ1つの出力ユニットから出力された評価値が前記基準範囲から逸脱する複数のラベルなし転移先データに共通するラベルを前記ユーザーから受け付け、

前記荷重調整部は、前記ユーザーから受け付けた前記ラベルと前記複数のラベルなし転移先データとを用いた教師付き学習によって前記ニューラルネットワーク装置の荷重値を更新する、

請求項8に記載の転移学習装置。 - 前記複数のラベル付き転移先データの各々には、さらに連想データが付されており、

前記正解取得部は、前記ラベルなし転移先データに関する連想データを前記ユーザーから受け付け、

前記荷重調整部は、前記ユーザーから受け付けた前記連想データが付されたラベル付き転移先データのラベルと前記ラベルなし転移先データとを用いて前記教師付き学習を行う、

請求項8又は9に記載の転移学習装置。 - 前記ニューラルネットワーク装置と、

当該ニューラルネットワーク装置において転移学習を行うための、請求項1から10の何れか1項に記載の転移学習装置と、

を備える転移学習システム。 - 各々に1以上の評価項目ごとのラベルが付された複数のラベル付き転移先データを、前記評価項目と同数以上の出力ユニットを出力層に有しかつ前記ラベル付き転移先データとは評価項目が異なる複数のラベル付き転移元データで学習済みのニューラルネットワーク装置に入力することにより、前記出力ユニットから出力された評価値を取得し、

前記1以上の評価項目の各々の評価値を出力するための出力ユニットとして、前記出力ユニットのうち当該評価項目のラベルとの差分が最も小さい評価値が取得された頻度がより高い出力ユニットを優先的に割り当てる、

転移学習方法。 - 請求項12に記載の転移学習方法をコンピュータに実行させるためのプログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2015016125A JP6435581B2 (ja) | 2015-01-29 | 2015-01-29 | 転移学習装置、転移学習システム、転移学習方法およびプログラム |

| US14/997,539 US10832128B2 (en) | 2015-01-29 | 2016-01-17 | Transfer learning apparatus, transfer learning system, transfer learning method, and recording medium |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2015016125A JP6435581B2 (ja) | 2015-01-29 | 2015-01-29 | 転移学習装置、転移学習システム、転移学習方法およびプログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2016143094A JP2016143094A (ja) | 2016-08-08 |

| JP6435581B2 true JP6435581B2 (ja) | 2018-12-12 |

Family

ID=56553191

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2015016125A Active JP6435581B2 (ja) | 2015-01-29 | 2015-01-29 | 転移学習装置、転移学習システム、転移学習方法およびプログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US10832128B2 (ja) |

| JP (1) | JP6435581B2 (ja) |

Families Citing this family (47)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9940575B2 (en) * | 2015-06-04 | 2018-04-10 | Yahoo Holdings, Inc. | Image searching |

| US9940577B2 (en) * | 2015-07-07 | 2018-04-10 | Adobe Systems Incorporated | Finding semantic parts in images |

| US10664722B1 (en) * | 2016-10-05 | 2020-05-26 | Digimarc Corporation | Image processing arrangements |

| JP6662746B2 (ja) * | 2016-10-07 | 2020-03-11 | ファナック株式会社 | 機械学習部を備えた作業補助システム |

| JP6718405B2 (ja) | 2017-03-31 | 2020-07-08 | 三菱重工業株式会社 | 情報提供装置、情報提供システム、情報提供方法及びプログラム |

| JP6832783B2 (ja) * | 2017-04-20 | 2021-02-24 | 株式会社日立製作所 | データ分析装置、データ分析方法、およびデータ分析プログラム |

| JP6911498B2 (ja) | 2017-05-01 | 2021-07-28 | オムロン株式会社 | 学習装置、学習方法、及び学習プログラム |

| CN107341146B (zh) * | 2017-06-23 | 2020-08-04 | 上海交大知识产权管理有限公司 | 基于语义槽内部结构的可迁移口语语义解析系统及其实现方法 |

| JP7044398B2 (ja) * | 2017-08-08 | 2022-03-30 | 国立大学法人横浜国立大学 | ニューラルネットワークシステム、機械学習方法及びプログラム |

| JP6898562B2 (ja) * | 2017-09-08 | 2021-07-07 | 富士通株式会社 | 機械学習プログラム、機械学習方法、および機械学習装置 |

| JP6898561B2 (ja) * | 2017-09-08 | 2021-07-07 | 富士通株式会社 | 機械学習プログラム、機械学習方法、および機械学習装置 |

| JP2021507428A (ja) * | 2017-10-13 | 2021-02-22 | エーアイ テクノロジーズ インコーポレイテッド | 眼科疾病及び障害の深層学習に基づく診断及び紹介 |

| CN108229652B (zh) * | 2017-11-28 | 2021-05-04 | 北京市商汤科技开发有限公司 | 神经网络模型迁移方法和系统、电子设备、程序和介质 |

| JP7066385B2 (ja) * | 2017-11-28 | 2022-05-13 | キヤノン株式会社 | 情報処理方法、情報処理装置、情報処理システム及びプログラム |

| US11803741B2 (en) * | 2018-02-14 | 2023-10-31 | Syntiant | Offline detector |

| US10657377B2 (en) | 2018-06-12 | 2020-05-19 | At&T Intellectual Property I, L.P. | Model-driven learning for video analytics |

| US10635943B1 (en) * | 2018-08-07 | 2020-04-28 | General Electric Company | Systems and methods for noise reduction in medical images with deep neural networks |

| CN109034367A (zh) * | 2018-08-22 | 2018-12-18 | 广州杰赛科技股份有限公司 | 神经网络更新方法、装置、计算机设备和可读存储介质 |

| US20200104710A1 (en) * | 2018-09-27 | 2020-04-02 | Google Llc | Training machine learning models using adaptive transfer learning |

| JP7325942B2 (ja) * | 2018-10-19 | 2023-08-15 | キヤノンメディカルシステムズ株式会社 | 画像処理装置及びプログラム |

| US20200388287A1 (en) * | 2018-11-13 | 2020-12-10 | CurieAI, Inc. | Intelligent health monitoring |

| KR102057649B1 (ko) * | 2018-12-13 | 2019-12-19 | 주식회사 알고리고 | 상위계층 인공신경망을 이용한 전기차 충전소 점유 예측 장치 및 방법 |

| KR102209505B1 (ko) * | 2018-12-13 | 2021-02-01 | 재단법인대구경북과학기술원 | 데이터 빈도수 분석을 통한 인공지능 학습 방법 및 장치 |

| CN109800796A (zh) * | 2018-12-29 | 2019-05-24 | 上海交通大学 | 基于迁移学习的船舶目标识别方法 |

| WO2020159638A1 (en) * | 2019-01-30 | 2020-08-06 | Hrl Laboratories, Llc | System and method for unsupervised domain adaptation via sliced-wasserstein distance |

| KR102905033B1 (ko) | 2019-05-08 | 2025-12-26 | 삼성전자 주식회사 | 학습을 수행하는 뉴럴 네트워크 시스템, 그것의 학습 방법 및 뉴럴 네트워크 프로세서의 전이 학습 방법 |

| CN110210556B (zh) * | 2019-05-29 | 2022-09-06 | 中国科学技术大学 | 行人再识别数据生成方法 |

| JP7326926B2 (ja) * | 2019-06-27 | 2023-08-16 | トヨタ自動車株式会社 | 学習装置、リハビリ支援システム、方法、プログラム、及び学習済みモデル |

| CN110599401A (zh) * | 2019-08-19 | 2019-12-20 | 中国科学院电子学研究所 | 遥感图像超分辨率重建方法、处理装置及可读存储介质 |

| CN110489567B (zh) * | 2019-08-26 | 2022-03-22 | 重庆邮电大学 | 一种基于跨网络特征映射的节点信息获取方法及其装置 |

| CN110738107A (zh) * | 2019-09-06 | 2020-01-31 | 上海衡道医学病理诊断中心有限公司 | 一种具备模型迁移功能的显微图像识别分割方法 |

| CN110751207B (zh) * | 2019-10-18 | 2022-08-05 | 四川大学 | 基于深度卷积域对抗迁移学习的故障诊断方法 |

| CN110929877B (zh) * | 2019-10-18 | 2023-09-15 | 平安科技(深圳)有限公司 | 基于迁移学习的模型建立方法、装置、设备及存储介质 |

| US12367200B2 (en) | 2019-10-30 | 2025-07-22 | International Business Machines Corporation | Ranking image sources for transfer learning |

| WO2021118173A1 (en) | 2019-12-09 | 2021-06-17 | Samsung Electronics Co., Ltd. | Electronic device and controlling method of electronic device |

| JP7413011B2 (ja) | 2019-12-27 | 2024-01-15 | キヤノンメディカルシステムズ株式会社 | 医用情報処理装置 |

| JP7055259B2 (ja) | 2020-03-04 | 2022-04-15 | 三菱電機株式会社 | ラベリング装置及び学習装置 |

| US11087883B1 (en) * | 2020-04-02 | 2021-08-10 | Blue Eye Soft, Inc. | Systems and methods for transfer-to-transfer learning-based training of a machine learning model for detecting medical conditions |

| EP3893064A1 (en) * | 2020-04-07 | 2021-10-13 | GF Machining Solutions AG | Method for predicting status of machining operation |

| CN112949904B (zh) * | 2021-01-28 | 2022-06-07 | 华中科技大学 | 一种基于特征选择与多层级深度迁移学习的风电场短期功率预测方法 |

| CN115714915A (zh) | 2021-08-12 | 2023-02-24 | 蒂普爱可斯有限公司 | 基于人工智能的图像稳定化方法及其相机模块 |

| CN116266221A (zh) * | 2021-12-14 | 2023-06-20 | 中国科学院软件研究所 | 神经网络的鲁棒性评估方法、装置、设备及存储介质 |

| US12394186B2 (en) * | 2022-03-25 | 2025-08-19 | Arizona Board Of Regents On Behalf Of Arizona State University | Systems, methods, and apparatuses for implementing self-supervised domain-adaptive pre-training via a transformer for use with medical image classification |

| JP2023144562A (ja) | 2022-03-28 | 2023-10-11 | 富士通株式会社 | 機械学習プログラム,データ処理プログラム,情報処理装置,機械学習方法およびデータ処理方法 |

| PL4343691T3 (pl) * | 2022-07-29 | 2025-02-10 | Contemporary Amperex Technology (Hong Kong) Limited | Sposób i urządzenie do szkolenia modelu wykrywania defektów ogniw |

| US12417230B2 (en) * | 2022-12-09 | 2025-09-16 | International Business Machines Corporation | Annotating and collecting data-centric AI quality metrics considering user preferences |

| JP2025107723A (ja) * | 2024-01-09 | 2025-07-22 | Jfeスチール株式会社 | 材料品質推定モデルの作成方法、材料品質推定方法、材料品質推定モデルの作成装置、材料品質推定装置および材料品質推定モデルの作成システム |

Family Cites Families (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH04114264A (ja) * | 1990-09-04 | 1992-04-15 | Sharp Corp | 自己組織化ニューラルネットワークにおける出力ノードのラベル付け方法 |

| JPH0589076A (ja) * | 1991-09-30 | 1993-04-09 | Sharp Corp | ニユーラルネツトワークの追加学習方法 |

| JP3337597B2 (ja) * | 1995-09-28 | 2002-10-21 | 松下電器産業株式会社 | 学習型認識判断装置 |

| DE60130742T2 (de) * | 2001-05-28 | 2008-07-17 | Honda Research Institute Europe Gmbh | Mustererkennung mit hierarchischen Netzen |

| US6819790B2 (en) * | 2002-04-12 | 2004-11-16 | The University Of Chicago | Massive training artificial neural network (MTANN) for detecting abnormalities in medical images |

| US8345962B2 (en) * | 2007-11-29 | 2013-01-01 | Nec Laboratories America, Inc. | Transfer learning methods and systems for feed-forward visual recognition systems |

| JP2009282686A (ja) * | 2008-05-21 | 2009-12-03 | Toshiba Corp | 分類モデル学習装置および分類モデル学習方法 |

| US9412064B2 (en) * | 2011-08-17 | 2016-08-09 | Qualcomm Technologies Inc. | Event-based communication in spiking neuron networks communicating a neural activity payload with an efficacy update |

-

2015

- 2015-01-29 JP JP2015016125A patent/JP6435581B2/ja active Active

-

2016

- 2016-01-17 US US14/997,539 patent/US10832128B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| US20160224892A1 (en) | 2016-08-04 |

| US10832128B2 (en) | 2020-11-10 |

| JP2016143094A (ja) | 2016-08-08 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6435581B2 (ja) | 転移学習装置、転移学習システム、転移学習方法およびプログラム | |

| TWI768216B (zh) | 用於血液透析的脫水量預測方法與使用該方法的電子裝置 | |

| JP6004084B2 (ja) | モデル更新方法、装置、およびプログラム | |

| JP7298825B2 (ja) | 学習支援装置、学習装置、学習支援方法及び学習支援プログラム | |

| WO2020181805A1 (zh) | 糖尿病的预测方法及装置、存储介质、计算机设备 | |

| CN110363229A (zh) | 一种基于改进RReliefF和mRMR相结合的人体特征参数选择方法 | |

| WO2019176989A1 (ja) | 検査システム、識別システム、及び学習データ生成装置 | |

| US20210124740A1 (en) | Information processing apparatus, information processing method, and computer program | |

| CN111446002A (zh) | 一种基于人工智能的新型冠状病毒患者病况分类系统 | |

| CN109191451A (zh) | 异常检测方法、装置、设备和介质 | |

| JP6941309B2 (ja) | 遺伝子変異の評価装置、評価方法、プログラム、および記録媒体 | |

| JP7276018B2 (ja) | 学習方法、推定方法および学習プログラム | |

| CN111414930B (zh) | 深度学习模型训练方法及装置、电子设备及存储介质 | |

| US10467750B2 (en) | Display control apparatus, display control method, and recording medium | |

| JP7152357B2 (ja) | 正解データ作成支援システムおよび正解データ作成支援方法 | |

| CN111295715B (zh) | 目标管理系统、目标管理服务器、目标管理程序以及目标管理终端装置 | |

| CN114267440B (zh) | 医疗订单信息处理方法、装置和计算机可读存储介质 | |

| JP7566705B2 (ja) | 学習方法、学習プログラム、および学習装置 | |

| JP7364206B2 (ja) | 学習装置、学習方法、及び制御プログラム | |

| CN111684539B (zh) | 改善临床工作流程的系统 | |

| JP2019049889A (ja) | 学習装置、および学習方法 | |

| CN114359133A (zh) | 基于特征提取的手骨影像分析方法及相关设备 | |

| JP2022106064A (ja) | 認知症兆候判別プログラム | |

| JP7628939B2 (ja) | 情報処理システム及び情報処理方法 | |

| KR102702222B1 (ko) | 건강검진 데이터 처리 방법 및 장치 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20170822 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20180828 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20180904 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20180921 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20181016 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20181025 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 6435581 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |