JP6201770B2 - ジェスチャui装置、ジェスチャui方法及びプログラム - Google Patents

ジェスチャui装置、ジェスチャui方法及びプログラム Download PDFInfo

- Publication number

- JP6201770B2 JP6201770B2 JP2014005218A JP2014005218A JP6201770B2 JP 6201770 B2 JP6201770 B2 JP 6201770B2 JP 2014005218 A JP2014005218 A JP 2014005218A JP 2014005218 A JP2014005218 A JP 2014005218A JP 6201770 B2 JP6201770 B2 JP 6201770B2

- Authority

- JP

- Japan

- Prior art keywords

- cursor

- area

- gesture

- region

- moving

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0481—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance

- G06F3/04812—Interaction techniques based on cursor appearance or behaviour, e.g. being affected by the presence of displayed objects

Landscapes

- Engineering & Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- User Interface Of Digital Computer (AREA)

- Position Input By Displaying (AREA)

Description

空間ジェスチャでは、容易にモード変更を行う手段を有しない。ここで、「モード」とは、操作中及び非操作中を示すシステムの状態のことで、例えば、同一のカーソル操作をしても、操作中の場合は画面操作を実行し、非操作中の場合は画面操作を実行しないとする。

まず、本発明の一実施形態に係るジェスチャUI装置1の概要について、図3を参照しながら説明する。図3は、一実施形態に係るジェスチャUI装置1の概要を示した図である。ジェスチャUI装置1としては、例えば、PCやTV等の画面を有する端末が挙げられる。ジェスチャUI装置1は、身振りや手振り等のユーザの動作でPCやTVなどの画面を操作可能な装置である。ユーザが手やユーザの身体の一部を特定の位置へ移動することや特定の移動軌跡で動かすこと(空間ジェスチャ)を、以下「ジェスチャ」ともいう。

まず、一実施形態にかかるジェスチャUI装置1の機能構成の一例について説明する。図4は、一実施形態にかかるジェスチャUI装置1の機能構成の一例を示した図である。

(第2の操作対象の表示例)

配置部42は、ユーザにカーソルの移動方向を誘導するように第2の操作対象を表示することが好ましい。例えば、配置部42は、軌跡検出部40が検出する移動軌跡を画面21上に表示してもよい。最も単純な表示方法は、配置部42が画面21上に検出する移動軌跡をそのまま表示することである。例えば、移動軌跡を一つ表示する例としては、配置部42が図9(a)の矢印fを画面21上に表示したり、図9(b)の円弧Fを画面21上に表示したりすることが挙げられる。また、移動軌跡を複数表示する例としては、配置部42が、図9(a)の矢印a、e、fの二つ以上を画面21上に表示したり、図9(b)の円弧E,Fを画面21上に表示したりすることが挙げられる。

次に、本発明の一実施形態に係るジェスチャUI処理を含むドラッグ命令発行処理について、図11を参照しながら説明する。図11は、本実施形態に係るドラッグ命令発行処理を示したフローチャートである。

次に、本発明の一実施形態に係るジェスチャUI処理を含む削除命令発行処理について、図13を参照しながら説明する。図13は、本実施形態に係る削除命令発行処理を示したフローチャートである。

最後に、上記実施形態の変形例について説明する。まず、非操作領域又は非移動領域の算出方法についての変形例である変形例1〜3について、図15〜図17を参照しながら説明する。

まず、非移動領域の算出方法の変形例1について、図15を参照して説明する。図15では、画面21上に複数のドラッグ対象70a、70bが表示されている。変形例1では、カーソル55で指示しているドラッグ対象70a以外のドラッグ対象70bをボタン・メニュー50と同じ第1の操作対象とみなして、非移動領域Rが算出される。具体的には、非操作領域算出部35は、ボタン・メニュー50が配置された領域に基づき、ボタン・メニュー50を操作するためにカーソル移動が行われやすい領域を特定し、それ以外の領域を意図せずに行われ難い非操作領域R1として算出する。非操作領域算出部35は、カーソルにより指示されていないドラッグ対象70bが配置された領域に基づき、ドラッグ対象70bを操作するためにカーソル移動が行われやすい領域を特定し、それ以外の領域を意図せずに行われ難い非操作領域rとして算出する。非移動領域算出部37は、非操作領域R1と非操作領域rとの和の領域を非移動領域とする。この結果、変形例1においても、ジェスチャによる入力においてドラッグ対象を含む第1の操作対象に対するカーソル移動のためのジェスチャと、第2の操作対象に関連づいた命令を実行するためのジェスチャとを区別することができる。これにより、ジェスチャによる入力において誤動作を防止することができる。

次に、非移動領域の算出方法の変形例2,3について、図16及び図17を参照して説明する。図16には、画面21上に選択頻度が異なるボタン・メニュー50、52が表示されている。ボタン・メニュー52は、ボタン・メニュー50よりも選択頻度が低い。

次に、軌跡算出結果の表示にかかる変形例である変形例4について、図18を参照しながら説明する。図18では、軌跡算出の結果、カーソル55の位置から8方向に矢印a〜hが表示されている。変形例4では、移動軌跡を示す矢印に優先順位をつけ、優先順位の高い矢印を表示する。

最後に、軌跡算出の変形例である変形例5について、図19を参照しながら説明する。変形例5では、移動軌跡が限定的な場合の簡易的な軌跡算出方法を説明する。図19の点線は、画面21上に表示されている各ボタン・メニュー50を選択する際のカーソルの移動軌跡の代表線(点線)を示す。代表線で示されるように、軌跡算出部38が算出する移動軌跡が、単純で候補が限定的な場合には、先述のような非操作領域R1と非進行領域R2とを算出しなくても、上記実施形態の場合と等価な算出結果を簡易な算出方法で得ることができる。

最後に、ジェスチャUI装置1のハードウェア構成例について簡単に説明する。図20は、本実施形態にかかるジェスチャUI装置1のハードウェア構成例を示す図である。ジェスチャUI装置1は、入力装置101、表示装置102、外部I/F103、RAM(Random Access Memory)104、ROM(Read Only Memory)105、CPU(Central Processing Unit)106、通信I/F107及びHDD(Hard Disk Drive)108を備え、それぞれがバスBで相互に接続されている。

(付記1)

ジェスチャによる入力に応じて画面操作を行うジェスチャUI装置であって、

第1の操作対象が表示されている画面上のカーソルの移動方向を予測し、前記予測したカーソルの移動方向に基づき前記カーソルが移動していかないと予測される非移動領域を算出する非移動領域算出部と、

前記非移動領域の境界上を含む内側に前記第1の操作対象以外の第2の操作対象を配置する配置部と、

を有するジェスチャUI装置。

(付記2)

前記配置部は、

前記第2の操作対象としてカーソルの移動方向を誘導する開口又は線を有する図形を表示する、

付記1に記載のジェスチャUI装置。

(付記3)

前記第1の操作対象に対するカーソルの位置に基づき、前記第1の操作対象を操作する際には前記カーソルが移動していかないと予測される非操作領域を算出する非操作領域算出部と、

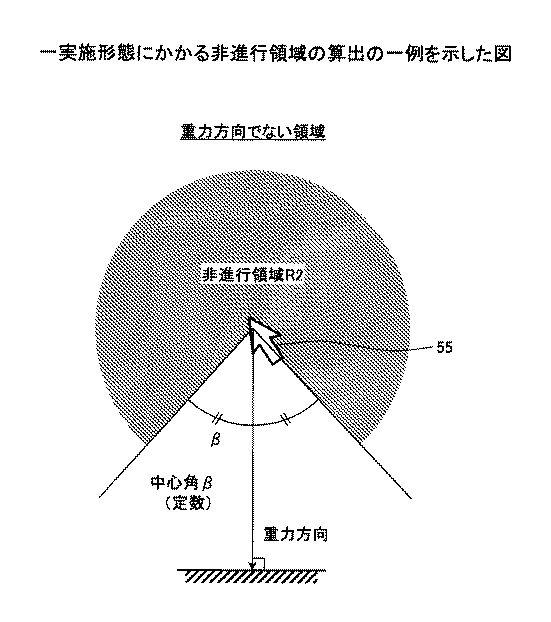

カーソルの位置と向きとに基づき、前記カーソルが進行していかないと予測される非進行領域を算出する非進行領域算出部と、を有し、

前記非移動領域算出部は、

前記非操作領域と前記非進行領域とから前記非移動領域を算出する、

付記1又は2に記載のジェスチャUI装置。

(付記4)

前記非進行領域算出部は、

カーソルの向きと重力方向との少なくともいずれかに基づき、前記カーソルが進行していかないと予測される非進行領域を算出する、

付記3に記載のジェスチャUI装置。

(付記5)

ジェスチャによる入力に応じて画面操作を行うジェスチャUI方法であって、

第1の操作対象が表示されている画面上のカーソルの移動方向を予測し、前記予測したカーソルの移動方向に基づき前記カーソルが移動していかないと予測される非移動領域を算出し、

前記非移動領域の境界上を含む内側に前記第1の操作対象以外の第2の操作対象を配置する、

処理をコンピュータが実行するジェスチャUI方法。

(付記6)

前記第2の操作対象としてカーソルの移動方向を誘導する開口又は線を有する図形を表示する、

付記5に記載のジェスチャUI方法。

(付記7)

前記非移動領域を算出する処理は、

前記第1の操作対象に対するカーソルの位置に基づき、前記第1の操作対象を操作する際には前記カーソルが移動していかないと予測される非操作領域(R1,図5)を算出する処理と、

カーソルの位置と向きとに基づき、前記カーソルが進行していかないと予測される非進行領域を算出する処理と、を含み、

前記非操作領域と前記非進行領域とから前記非移動領域を算出する、

付記5又は6に記載のジェスチャUI方法。

(付記8)

前記非進行領域を算出する処理は、

カーソルの向きと重力方向との少なくともいずれかに基づき、前記カーソルが進行していかないと予測される非進行領域を算出する、

付記7に記載のジェスチャUI方法。

(付記9)

ジェスチャによる入力に応じて画面操作を行う処理をコンピュータが実行するプログラムであって、

第1の操作対象が表示されている画面上のカーソルの移動方向を予測し、前記予測したカーソルの移動方向に基づき前記カーソルが移動していかないと予測される非移動領域を算出し、

前記非移動領域の境界上を含む内側に前記第1の操作対象以外の第2の操作対象を配置する、

プログラム。

(付記10) 前記第2の操作対象としてカーソルの移動方向を誘導する開口又は線を有する図形を表示する、

付記9に記載のプログラム。

(付記11)

前記非移動領域を算出する処理は、

前記第1の操作対象に対するカーソルの位置に基づき、前記第1の操作対象を操作する際には前記カーソルが移動していかないと予測される非操作領域を算出する処理と、

カーソルの位置と向きとに基づき、前記カーソルが進行していかないと予測される非進行領域を算出する処理と、を含み、

前記非操作領域と前記非進行領域とから前記非移動領域を算出する、

付記9又は10に記載のプログラム。

(付記12)

前記非進行領域を算出する処理は、

カーソルの向きと重力方向との少なくともいずれかに基づき、前記カーソルが進行していかないと予測される非進行領域を算出する、

付記11に記載のプログラム。

10:カメラ

20:ディスプレイ

31:位置取得部

32:位置蓄積部

33:操作対象取得部

34:指示判定部

35:非操作領域算出部

36:非進行領域算出部

37:非移動領域算出部

38:軌跡算出部

39:境界算出部

40:軌跡検出部

41:操作部

42:配置部

Claims (5)

- ジェスチャによる入力に応じて画面操作を行うジェスチャUI装置であって、

第1の操作対象に対するカーソルの位置に基づき、前記第1の操作対象を操作する際には前記カーソルが移動していかないと予測される非操作領域を算出する非操作領域算出部と、

カーソルの位置と速度ベクトルとに基づき、前記カーソルが進行していかないと予測される非進行領域を算出する非進行領域算出部と、

前記非操作領域と前記非進行領域とから、前記カーソルが移動していかないと予測される非移動領域を算出する非移動領域算出部と、

前記非移動領域の境界上を含む内側に前記第1の操作対象以外の第2の操作対象を配置する配置部と、

を有するジェスチャUI装置。 - 前記配置部は、

前記第2の操作対象としてカーソルの移動方向を誘導する開口又は線を有する図形を表示する、

請求項1に記載のジェスチャUI装置。 - 前記非進行領域算出部は、

カーソルの速度ベクトルと重力方向との少なくともいずれかに基づき、前記カーソルが進行していかないと予測される非進行領域を算出する、

請求項1または2に記載のジェスチャUI装置。 - ジェスチャによる入力に応じて画面操作を行うジェスチャUI方法であって、

第1の操作対象に対するカーソルの位置に基づき、前記第1の操作対象を操作する際には前記カーソルが移動していかないと予測される非操作領域を算出し、

カーソルの位置と速度ベクトルとに基づき、前記カーソルが進行していかないと予測される非進行領域を算出し、

前記非操作領域と前記非進行領域とから、前記カーソルが移動していかないと予測される非移動領域を算出し、

前記非移動領域の境界上を含む内側に前記第1の操作対象以外の第2の操作対象を配置する、処理をコンピュータが実行するジェスチャUI方法。 - ジェスチャによる入力に応じて画面操作を行う処理をコンピュータが実行するプログラムであって、

第1の操作対象に対するカーソルの位置に基づき、前記第1の操作対象を操作する際には前記カーソルが移動していかないと予測される非操作領域を算出し、

カーソルの位置と速度ベクトルとに基づき、前記カーソルが進行していかないと予測される非進行領域を算出し、

前記非操作領域と前記非進行領域とから、前記カーソルが移動していかないと予測される非移動領域を算出し、

前記非移動領域の境界上を含む内側に前記第1の操作対象以外の第2の操作対象を配置する、

プログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014005218A JP6201770B2 (ja) | 2014-01-15 | 2014-01-15 | ジェスチャui装置、ジェスチャui方法及びプログラム |

| US14/515,778 US20150199020A1 (en) | 2014-01-15 | 2014-10-16 | Gesture ui device, gesture ui method, and computer-readable recording medium |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2014005218A JP6201770B2 (ja) | 2014-01-15 | 2014-01-15 | ジェスチャui装置、ジェスチャui方法及びプログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015133059A JP2015133059A (ja) | 2015-07-23 |

| JP6201770B2 true JP6201770B2 (ja) | 2017-09-27 |

Family

ID=53521345

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2014005218A Expired - Fee Related JP6201770B2 (ja) | 2014-01-15 | 2014-01-15 | ジェスチャui装置、ジェスチャui方法及びプログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US20150199020A1 (ja) |

| JP (1) | JP6201770B2 (ja) |

Families Citing this family (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2016017956A1 (en) * | 2014-07-30 | 2016-02-04 | Samsung Electronics Co., Ltd. | Wearable device and method of operating the same |

| US9652124B2 (en) * | 2014-10-31 | 2017-05-16 | Microsoft Technology Licensing, Llc | Use of beacons for assistance to users in interacting with their environments |

| EP3324270A1 (en) * | 2016-11-16 | 2018-05-23 | Thomson Licensing | Selection of an object in an augmented reality environment |

| KR102488580B1 (ko) * | 2017-01-12 | 2023-01-13 | 삼성전자주식회사 | 적응적인 사용자 인터페이스를 제공하기 위한 장치 및 방법 |

| EP3399733A1 (en) * | 2017-05-02 | 2018-11-07 | OCE Holding B.V. | A system and a method for dragging and dropping a digital object onto a digital receptive module on a pixel display screen |

| JP6915492B2 (ja) * | 2017-10-11 | 2021-08-04 | トヨタ自動車株式会社 | 表示制御装置 |

| JP2019139332A (ja) * | 2018-02-06 | 2019-08-22 | 富士通株式会社 | 情報処理装置、情報処理方法及び情報処理プログラム |

| USD956058S1 (en) * | 2019-02-20 | 2022-06-28 | Textio, Inc. | Display screen or portion thereof with animated graphical user interface |

| USD956059S1 (en) * | 2019-02-20 | 2022-06-28 | Textio, Inc. | Display screen or portion thereof with animated graphical user interface |

| CN114637439B (zh) * | 2022-03-24 | 2024-11-05 | 海信视像科技股份有限公司 | 显示设备和手势轨迹识别方法 |

| US12422266B2 (en) | 2022-01-19 | 2025-09-23 | Waymo Llc | Augmented reality wayfinding |

| JP2024055033A (ja) | 2022-10-06 | 2024-04-18 | キヤノン株式会社 | 情報処理装置、情報処理方法、プログラム |

Family Cites Families (15)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CA2140164A1 (en) * | 1994-01-27 | 1995-07-28 | Kenneth R. Robertson | System and method for computer cursor control |

| JPH08335140A (ja) * | 1995-06-07 | 1996-12-17 | Nec Corp | カーソル制御方式 |

| JP3511462B2 (ja) * | 1998-01-29 | 2004-03-29 | インターナショナル・ビジネス・マシーンズ・コーポレーション | 操作画像表示装置およびその方法 |

| JP3477675B2 (ja) * | 1999-06-04 | 2003-12-10 | インターナショナル・ビジネス・マシーンズ・コーポレーション | ポインタ操作の補助方法 |

| US6717600B2 (en) * | 2000-12-15 | 2004-04-06 | International Business Machines Corporation | Proximity selection of selectable item in a graphical user interface |

| US7210107B2 (en) * | 2003-06-27 | 2007-04-24 | Microsoft Corporation | Menus whose geometry is bounded by two radii and an arc |

| US8276100B2 (en) * | 2006-07-20 | 2012-09-25 | Panasonic Corporation | Input control device |

| JPWO2009128148A1 (ja) * | 2008-04-16 | 2011-08-04 | パイオニア株式会社 | 運転者用遠隔操作装置 |

| US8514251B2 (en) * | 2008-06-23 | 2013-08-20 | Qualcomm Incorporated | Enhanced character input using recognized gestures |

| US8245156B2 (en) * | 2008-06-28 | 2012-08-14 | Apple Inc. | Radial menu selection |

| JP5276576B2 (ja) * | 2009-12-03 | 2013-08-28 | 三菱電機株式会社 | 表示装置 |

| US8914305B2 (en) * | 2010-06-30 | 2014-12-16 | Trading Technologies International, Inc. | Method and apparatus for motion based target prediction and interaction |

| JP5189709B2 (ja) * | 2010-07-07 | 2013-04-24 | パナソニック株式会社 | 端末装置およびgui画面生成方法 |

| WO2013094371A1 (ja) * | 2011-12-22 | 2013-06-27 | ソニー株式会社 | 表示制御装置、表示制御方法およびコンピュータプログラム |

| JP2014137616A (ja) * | 2013-01-15 | 2014-07-28 | Fujitsu Ltd | 表示制御装置、表示制御システム及び表示制御方法 |

-

2014

- 2014-01-15 JP JP2014005218A patent/JP6201770B2/ja not_active Expired - Fee Related

- 2014-10-16 US US14/515,778 patent/US20150199020A1/en not_active Abandoned

Also Published As

| Publication number | Publication date |

|---|---|

| JP2015133059A (ja) | 2015-07-23 |

| US20150199020A1 (en) | 2015-07-16 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6201770B2 (ja) | ジェスチャui装置、ジェスチャui方法及びプログラム | |

| CN105308538B (zh) | 基于所检测到的示意动作执行装置动作的系统和方法 | |

| US9658764B2 (en) | Information processing apparatus and control method thereof | |

| US9529527B2 (en) | Information processing apparatus and control method, and recording medium | |

| US10318146B2 (en) | Control area for a touch screen | |

| JP5448370B2 (ja) | 情報処理装置及びその制御方法、プログラム、記憶媒体 | |

| KR101356368B1 (ko) | 어플리케이션 전환 장치 및 방법 | |

| US9128526B2 (en) | Operation control device, operation control method, and computer-readable recording medium for distinguishing an intended motion for gesture control | |

| US10635184B2 (en) | Information processing device, information processing method, and program | |

| US20150212683A1 (en) | Information display device and display information operation method | |

| US20150234572A1 (en) | Information display device and display information operation method | |

| US9880684B2 (en) | Information processing apparatus, method for controlling information processing apparatus, and storage medium | |

| US10402080B2 (en) | Information processing apparatus recognizing instruction by touch input, control method thereof, and storage medium | |

| US20110283212A1 (en) | User Interface | |

| KR20160058117A (ko) | 미래 사용자 입력을 예측한 상태 변화에 관한 정보를 사용하는 사용자 입력에 대한 반응을 제공하는 시스템 및 방법 | |

| KR20130105725A (ko) | 콘텐츠의 양 손 제어에 기반한 컴퓨터 비전 | |

| CN103809903B (zh) | 用于控制虚拟屏幕的方法和装置 | |

| US10126856B2 (en) | Information processing apparatus, control method for information processing apparatus, and storage medium | |

| US9569019B2 (en) | Adaptive touch panel display | |

| EP2646892B1 (en) | Instantaneous panning using a groove metaphor | |

| JP2006235832A (ja) | 処理装置、情報処理方法、およびプログラム | |

| KR101294201B1 (ko) | 휴대형 장치 및 그 조작 방법 | |

| KR102057803B1 (ko) | 인터랙션 마우스 장치, 제어방법, 프로그램 및 컴퓨터 판독가능 기록매체 | |

| KR101899916B1 (ko) | 디스플레이될 정보 엘리먼트의 에지에서 디스플레이 디바이스를 제어하기 위한 방법 | |

| JP7380103B2 (ja) | 情報処理装置及びプログラム |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20160905 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20170428 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20170509 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20170630 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20170801 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20170814 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6201770 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| LAPS | Cancellation because of no payment of annual fees |