実施例(1)−1−1のモデル処理装置を説明するためのブロック図。

音響イベントラベルおよび行動ラベル候補付き音響信号列のデータ構成を例示した図。

実施例(1)−1−2のモデル処理装置を説明するためのブロック図。

実施例(1)−1−3のモデル処理装置を説明するためのブロック図。

実施例(1)−2−1のモデル処理装置を説明するためのブロック図。

実施例(1)−2−2のモデル処理装置を説明するためのブロック図。

実施例(1)−2−3のモデル処理装置を説明するためのブロック図。

実施例(1)−3−1のモデル処理装置を説明するためのブロック図。

実施例(1)−3−2,(1)−4−2のモデル処理装置を説明するためのブロック図。

実施例(1)−3−3,(1)−4−3のモデル処理装置を説明するためのブロック図。

実施例(1)−4−1のモデル処理装置を説明するためのブロック図。

実施例(2)−1−1のモデル処理装置を説明するためのブロック図である。

音響イベントラベルおよび行動ラベル候補付き音響信号列のデータ構成を例示した図。

実施例(2)−1−2のモデル処理装置を説明するためのブロック図。

実施例(2)−1−3のモデル処理装置を説明するためのブロック図。

実施例(2)−2−1のモデル処理装置を説明するためのブロック図。

実施例(2)−2−2のモデル処理装置を説明するためのブロック図。

実施例(2)−2−3のモデル処理装置を説明するためのブロック図。

実施例(2)−3−1のモデル処理装置を説明するためのブロック図。

実施例(2)−3−2,(2)−4−2のモデル処理装置を説明するためのブロック図。

実施例(2)−3−3,(2)−4−3のモデル処理装置を説明するためのブロック図。

実施例(2)−4−1のモデル処理装置を説明するためのブロック図。

実施例(3)−1−1のモデル処理装置を説明するためのブロック図。

音響イベントラベル付き音響信号列のデータ構成を例示した図。

実施例(3)−1−2のモデル処理装置を説明するためのブロック図。

実施例(3)−1−3のモデル処理装置を説明するためのブロック図。

実施例(3)−2−1のモデル処理装置を説明するためのブロック図。

実施例(3)−2−2のモデル処理装置を説明するためのブロック図。

実施例(3)−2−3のモデル処理装置を説明するためのブロック図。

実施例(3)−3−1のモデル処理装置を説明するためのブロック図。

実施例(3)−3−2のモデル処理装置を説明するためのブロック図。

実施例(3)−3−3のモデル処理装置を説明するためのブロック図。

以下、図面を参照して本発明の実施形態を説明する。なお、同一構成要素ないし同一処理には同一符号を割り当てて重複説明を省略する。

<用語の定義>

各実施例で用いる用語を定義する。

「行動」とは、人間、動物、装置などの主体が行う何らかの行動を意味する。「行動」の具体例は「料理」「掃除」などである。また、音響信号が収録された場所や時間や場に人が何人いるか等の音響信号を発生させる状態を「行動」としてもよい。

「音響イベント」とは、行動に伴って発生する音の事象を意味する。「音響イベント」の具体例は、「包丁の音」「水が流れる音」「水音」「着火音」「火の音」「足音」「掃除機の排気音」などである。例えば、「包丁の音」「水が流れる音」等は、「料理」という行動に伴って発生する音響イベントである。

「状況」とは、音響イベントの組み合わせ、および状況そのものの遷移確率で特徴付けられた状況の種別(番号)である。言い換えると「状況」は、音響イベントおよび自身の遷移確率によって規定される潜在的な場の状況を表す。状況の生成確率は、その状況が起こる時間区間での行動または、その状況が起こる時間区間での音響信号そのものに規定され、状況は、その状況が起こる時間区間での音響イベントの生成確率を規定する。状況は、行動と、行動によって規定される生成確率、または、音響信号と、音響信号によって規定される生成確率とによって表現可能である。音響イベントは、行動と、行動によって規定される生成確率、または、状況と、状況によって規定される生成確率とによって表現可能である。なお、行動や状況の推定は長時間の音響イベントの組み合わせによって実現される。

「XがYを生成する確率」とは、事象Xが起こるという条件のもとでの事象Yが起こる確率をいう。「XがYを生成する確率」は、「XのもとでのYの条件付き確率」や「XにおけるYの条件付き確率」とも表現できる。「Xにおける、YとZとの同時事後確率」とは、事象Xが起きたという条件のもとでの、事象Yと事象Zとの同時確率をいう。

<実施例(1)−1−1:図1>

[行動の時間変化を考慮に入れた、音響イベントラベルおよび行動ラベル候補付き音響信号列から行動−音響イベント生成モデルおよび行動遷移モデルを算出し、同時に、行動を分析]

本実施例では、行動の時間変化を考慮に入れ、音響イベントラベルおよび行動ラベル候補付き音響信号から、行動−音響イベント生成モデルを算出する。同時に、行動の時間遷移を表す行動遷移モデルも算出してもよく、行動の分析も行ってもよい。

すなわち本実施例では、各時間区間の音響信号を生じさせた音響イベントの時系列の並びを表す音響イベントラベル列、ならびに、音響イベントを生じさせた行動の候補を表す行動ラベル候補を用い、「音響イベントの時系列の並びにおける、行動の候補に対応する音響イベントの組み合わせと行動の候補の時系列の並びとの同時事後確率」を最大化するための処理を行う学習処理を行う。例えば、この学習処理は、行動の時間遷移に基づく行動の出現確率と、行動に対する音響イベントの出現確率に基づいて、音響イベントの時系列の並びにおける、行動の候補に対する音響イベントの組み合わせと行動の候補の時系列の並びとの同時事後確率を最大化するための処理である。例えば、音響イベントの時系列の並びからなる音響イベントの組み合わせに対する尤度関数P(音響イベントの組み合わせ|行動の候補の時系列の並び)を最大にする処理が行われる。それにより、行動の候補が音響イベントを生成する確率P(音響イベント|行動の候補)を「行動−音響イベントの生成モデル」として得る。また、この学習処理によって、行動の候補の時系列の遷移確率を「行動遷移モデル」として得てもよい。さらに、この学習処理の過程で何れかの行動の候補を選択し、各音響イベントがどの行動によって生成されたのかを分析してもよい。この場合には選択した行動の候補を表す行動ラベルを出力してもよい。

図1に例示するように、本実施例のモデル処理装置100は、音響信号列合成部101、モデル化部102、および記憶部103を有する。モデル処理装置100は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響信号列合成部101に、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S(ただし、Sは1以上の整数)が入力される。図2に例示するように、音響イベントラベルおよび行動ラベル候補付き音響信号列は、短時間(数10msec〜数sec)の時間区間(以下単に「時間区間」という)ごとに区分された時系列の音響信号列、当該時間区間ごとに区分された音響信号列の各要素に対応する要素番号、当該時間区間ごとに決定されて付与された音響イベントラベル、および当該時間区間ごとに付与された行動ラベル候補を含む。当該時間区間ごとに複数個の行動ラベル候補が付与されてもよいし(例えば、図2の要素番号1の時間区間)、単一の行動ラベル候補が付与されてもよい(例えば、図2の要素番号iの時間区間)。音響信号列は音を表すデジタル信号列(例えば、5〜20秒程度のデジタル信号列)である。音響信号列は、例えば単一又は複数の行動がなされる環境での録音によって得られ、単一又は複数の行動によって生じた音を表す。音響信号列の各時間区間の区分を音響信号とよぶ。音響信号列は、各時間区間の音響信号の時系列の並びと解釈できる。音響イベントラベルは、それぞれ、上記の時間区間の音響信号を生じさせた音響イベントを表す。各時間区間の音響イベントラベルの時系列の並びを音響イベントラベル列と呼ぶ。音響イベントラベル列は、各時間区間の音響信号を生じさせた音響イベントの時系列の並びを表す。行動ラベル候補は、音響イベントを生じさせた行動の候補を表すラベルである。

複数個の音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S(以下、単に「ラベル付き音響信号列11−1,・・・,11−S」という)が音響信号列合成部101に入力された場合、音響信号列合成部101は、それらを時系列方向につなぎ合わせ、それによって1つの音響イベントラベルおよび行動ラベル候補付き音響信号列11(以下、単に「ラベル付き音響信号列11」という)を得て出力する(合成処理)。音響信号列合成部101に1つの音響信号列11−1のみが入力された場合、音響信号列合成部101はそれをラベル付き音響信号列11として出力する。音響信号列合成部101から出力された音響イベントラベルおよび行動ラベル候補付き音響信号列は、モデル化部102に入力される。なお、音響信号列合成部101を経由することなく、1つラベル付き音響信号列11がそのままモデル化部102に入力されてもよい。

モデル化部102は、以下の手順に従って、入力されたラベル付き音響信号列11から、行動−音響イベント生成モデル14を生成し、それを記憶部103に格納する。モデル化部102は、行動遷移モデルを生成してもよいし、行動ラベル18を生成してもよい。生成された行動遷移モデル17や行動ラベル18も記憶部103に格納される。

[行動から音響イベントが生成される過程の論理的説明]

モデル化部102は、ラベル付き音響信号列11から、行動の候補が音響イベントを生成する確率P(音響イベント|行動の候補)としたときの行動−音響イベント生成モデル14を得る。このとき、行動が音響イベントの生成確率を規定するとともに、ある時刻の行動が次時刻に生じる行動を規定すると考え、この関係を生成モデルとして記述する。この際、行動-音響イベント生成モデル14のみを得てもよいし、行動の候補の時系列の遷移確率である行動遷移モデル17を同時に得てもよい。

ラベル付き音響信号列11が有する各音響信号列が取りうる行動ラベル候補を音響信号列分並べて列とした、集合のベクトルΩ、行動ラベル候補が表す行動の候補における音響イベントの生成確率Φ、および行動ラベル候補が表す行動の候補の遷移確率Πが与えられた場合における、音響イベントの列eの生成確率P(e|Π,Φ,Ω)は以下の通りである。

ただし、Aは行動の候補の総数(行動の候補の種類の個数)、Eは音響イベントの種類の個数、eはラベル付き音響信号列11に与えられた音響イベントの列(ベクトル)、Πは各時間区間の行動の候補a(ただし、a∈{1,・・・,A})が次の時間区間で行動の候補a’(ただし、a’∈{1,・・・,A})に遷移する確率を(a,a’)要素とするA×A行列、Φは行動の候補a(ただし、a∈{1,・・・,A})が音響イベントε(ただし、ε∈{1,・・・,E})を生成する確率P(ε|a)を(a,ε)要素とするA×E行列、Ωは各音響信号列がとり得る行動ラベル候補を音響信号列分並べて列とした、集合のベクトル、e’

sは各ラベル付き音響信号列11−sに与えられた音響イベントの列(N

s次元ベクトル:N

sはラベル付き音響信号列11−sに対応する音響イベントの個数)、a

sはラベル付き音響信号列11−sに付与された行動ラベル候補が表す行動の候補の集合、Sはラベル付き音響信号列11を構成するラベル付き音響信号列11−sの個数を表す。なお、Ωとa

sの関係は以下のように表される。

Ω=[a

1,a

2,…,a

s,…,a

S]

行動の候補の集合a

s、行動の候補aの遷移確率π

aの事前分布のパラメータ(Dirichlet分布に従うものとする)γ、行動の候補aにおける音響イベントεの生成確率φ

aの事前分布のパラメータ(Dirichlet分布に従うものとする)βが与えられたときの、音響イベントの列e’

sの生成確率P(e’

s,Π,Φ|γ,β,a

s)は、以下の通りである。

ただし、e

iはラベル付き音響信号列11−sの要素番号iに対応する音響イベント、N

sはラベル付き音響信号列11−sに対応する要素数(要素番号iの最大値)、x

iはラベル付き音響信号列11−sの要素番号iに対応する行動ラベル候補が表す行動の候補、π

xi−1 xiはラベル付き音響信号列11−sの要素番号i−1に対応する行動ラベル候補が表す行動の候補x

i−1から要素番号iに対応する行動ラベル候補が表す行動の候補x

iへの遷移確率を表す。ただし、π

xi−1 xiの上付き「xi−1」はx

i−1を表し、下付き「xi」はx

iを表す。また、π

aは、ラベル付き音響信号列11に付与されたすべての行動ラベル候補を対象とした遷移確率π

xi−1 xiを(x

i−1,x

i)要素とするA×A行列、φ

aは行動の候補aが音響イベントε(ただし、ε∈{1,・・・,E})を生成する確率P(ε|a)をε番目の要素とするE次元ベクトルを表す。W−1次(Wは2以上の整数)のDirichlet分布の確率密度関数は以下の通りである。

ただし、τはτ

i(i=1,...,W)からなるパラメータ、μは確率変数、Γはガンマ関数を表す。

[生成モデルの算出過程の説明]

モデル化部102は、入力されたラベル付き音響信号列11から行動の候補が音響イベントを生成する確率P(音響イベント|行動の候補)および行動の遷移確率を算出する。また、モデル化部102は、少なくとも行動−音響イベント生成モデル14を出力し、記憶部103に格納する。また、モデル化部102は、算出された行動の候補の遷移確率を行動遷移モデル17として記憶部103に格納してもよい。行動の候補の遷移確率は、第1時間区間での行動の候補が、第1時間区間よりも後の第2時間区間での行動の候補を生成する確率P(第2時間区間での行動の候補|第1時間区間での行動の候補)である。例えば、第2時間区間は第1時間区間の直後の時間区間である。しかしながら、第1時間区間よりもξ個後(ξは2以上の整数)の時間区間が第2時間区間であってもよい。また、第1時間区間から第ξ時間区間の同時確率を考えてもよい。さらにモデル化部102は、入力されたラベル付き音響信号列11が有する行動ラベル候補から尤もらしいラベルを選択し、選択した行動ラベル候補からなる行動ラベル列18を外部に出力したり、記憶部103に格納したりしてもよい。尤もらしいラベルは、各時間区間に対して1個でもよいし、複数個でもよい。また、各時間区間において尤もらしさが閾値を超えたすべての行動ラベル候補を選択し、選択した時間区間ごとに単一または複数の行動ラベル候補からなる行動ラベル18の列を外部に出力したり、記憶部103に格納したりしてもよい。

行動−音響イベント生成モデル14および行動遷移モデル17の算出は、入力されたラベル付き音響信号列11の音響イベントの時系列の並びにおける、行動の候補に対応する音響イベントの組み合わせと行動の候補の時系列の並びとの同時事後確率を最大化する処理を用いて行われる。例えば、マルコフ連鎖モンテカルロ法(MCMC法:Markov Chain Monte Carlo methods)や変分ベイズ法(VB法:Variational Bayes methods)などの手法を用いることができる。MCMC法には、M−Hアルゴリズムやギブスサンプリングなどの手法がある。ここでは一例としてギブスサンプリングによる算出手法を説明する。

[生成モデル算出の流れの例示]

(i)モデル化部102は、ハイパパラメータとしてパラメータβおよびγを事前に決定する。

(ii)モデル化部102は、全てのラベル付き音響信号列11−s(ただしs=1,...,S)の全ての要素番号iに対応する要素に行動の候補xiをランダムに割り当てる(割り当てはラベル付き音響信号列11−sに与えられた行動ラベル候補が表す行動の候補からランダムに行う)。あるいは、要素番号iに対応する要素への行動の候補xiの割り当ては、事前にモデル化部102に設定しておいた割り当てであってもよい。

(iii)モデル化部102は、全てのラベル付き音響信号列11−s(ただしs=1,...,S)の各要素番号i(要素番号i−1またはi+1に対応する要素が存在しない要素番号iを除く)について、以下の(iii-1)および(iii-2)を規定の回数(正値であり、例えば1〜3000回程度)、もしくは、所望の結果が得られるまで(例えば、割り当ての前後において、行動の割り当て先の変化が一定の閾値(例えば0.3%)以下になるまでなど)繰り返す。

(iii-1)モデル化部102は、以下の式により、更新対象のラベル付き音響信号列の要素番号iを除いた要素番号に対応する音響信号列に対して、要素番号iの要素に行動の候補a∈Ωに割り当てられる確率分布P(x

i=a|e

i=ε,x

−i,e

−i,Ω,β,γ)を更新する。

ただし、C

εa EAは、更新対象のラベル付き音響信号列(初期値はラベル付き音響信号列11)の音響イベントεに行動の候補aが割り当てられた回数を表す。

Rxi xi+1は、更新対象のラベル付き音響信号列に対応するすべて行動の候補の並びの中で、行動の候補xi=a∈Ωと同一の候補から行動の候補xi+1と同一の候補に遷移した回数を表す。ただし、xi=a∈Ωであり、xi以外の行動の候補「・・・,xi−1,xi+1,・・・」は、(ii)でランダムに割り当てられた行動の候補〔(iii-2)が実行されていない場合〕または直前の(iii-2)で得られた行動の候補〔(iii-2)が実行されている場合〕である。xi−1からxiへの遷移「xi−1→xi」およびxiからxi+1への遷移「xi→xi+1」はRxi xi+1を得るためのカウント対象とせず、遷移「xi−1→xi」が遷移「a→xi+1」と同じになることはI(xi−1=xi)×I(xi=xi+1)によってカウントされる。ただし、I(xi−1=xi)およびI(xi=xi+1)は、xi−1=xiのときにI(xi−1=xi)=1、xi−1≠xiのときにI(xi−1=xi)=0となり、xi=xi+1のときにI(xi=xi+1)=1、xi≠xi+1iのときにI(xi=xi+1)=0となる関数である。遷移「xi−1→xi」が遷移「a→xi+1」と同じになることがI(xi−1=xi)×I(xi=xi+1)によってカウントできるのは、遷移「xi−1→xi」が遷移「a→xi+1」と同じになるのは、a=xi=xi+1かつa=xi−1=xiの場合に限られるからである。

例えば、Ω={1,2,・・・,9}であり、前回の繰り返し処理時に得られた各要素番号iに対応する行動の候補の並びが[x1,x2,x3,x4,x5,x6,x7,x8]=[1,2,1,1,2,3,1,6]であったとする。この例でi=2についてRxi xi+1を求める場合には、x2=a∈{1,2,・・・,9}とした[1,a,1,1,2,1,1,6]の中で「a→1」と遷移する回数をカウントする。ただし、遷移「x1→x2」=「1→a」および「x2→x3」=「a→1」はRxi xi+1を得るためのカウント対象としない。

x1 → x2 → x3 → x4 → x5 → x6 → x7 → x8

1 a 1 1 2 1 2 6

1

2

…

9

x2=a=1の場合、「a→1」=「1→1」であり、[1,1,1,1,2,1,2,6]の中で「1→1」と遷移するのは、「x1→x2」=「1→1」,「x2→x3」=「1→1」,「x3→x4」=「1→1」の3回である。しかしながら、「x1→x2」=「1→1」および「x2→x3」=「1→1」はRxi xi+1を得るためのカウント対象とせず、a=1およびi=2についてRxi xi+1=1とする。なお「x1→x2」=「1→1」が「x1→x2」=「1→1」と一致することは、I(x1=x2=1)×I(x2=x3=1)=1によってカウントされる。a=2の場合、「a→1」=「2→1」であり、[1,2,1,1,2,1,2,6]の中で「2→1」と遷移するのは、「x2→x3」=「2→1」,「x5→x6」=「2→1」の2回である。しかしながら、「x2→x3」=「2→1」はRxi xi+1を得るためのカウント対象とせず、a=2およびi=2についてRxi xi+1=1とする。なお「x1→x2」=「1→1」については、x1≠x2=2かつ2=x2≠x3であるため、I(x1=x2)×I(x2=x3)=0となり、カウントされない。

Σx’i+1∈ΩRxi x’i+1は、更新対象のラベル付き音響信号列に対応するすべて行動の候補の並びの中で、行動の候補xi=a∈Ωと同一の候補から遷移した行動の候補の総数を表す。この場合も、xi−1を基点とする遷移およびxi=aを基点とする遷移は、Σx’i+1∈ΩRxi x’i+1を得るためのカウント対象とせず、xi−1を基点とする遷移がxi=aを基点とする遷移となることは、I(xi−1=xi)によってカウントされる。xi−1を基点とする遷移がxi=aを基点とする遷移となることがI(xi−1=xi)によってカウントできるのは、xi−1を基点とする遷移がxi=aを基点とする遷移となるのはxi−1=aの場合、すなわちxi−1=xi=aの場合だからである。

例えば、上述の行動の候補の並びの例[x1,x2,x3,x4,x5,x6,x7,x8]=[1,2,1,1,2,3,1,6]において、i=2についてΣx’i+1∈ΩRxi x’i+1を求める場合には、x2=a∈{1,2,・・・,9}とした[1,a,1,1,2,1,1,6]の中で「a」を基点とする遷移回数をカウントする。ただし、遷移「x1→x2」=「1→a」および「x2→x3」=「a→1」はΣx’i+1∈ΩRxi x’i+1を得るためのカウント対象としない。a=1の場合、[1,1,1,1,2,1,2,6]の中でx2=1を基点として遷移するのは、「x1→x2」=「1→1」,「x2→x3」=「1→1」,「x3→x4」=「1→1」,「x6→x7」=「1→1」の4回である。しかしながら、「x1→x2」=「1→1」および「x2→x3」=「1→1」はΣx’i+1∈ΩRxi x’i+1を得るためのカウント対象とぜず、a=1およびi=2についてΣx’i+1∈ΩRxi x’i+1=2とする。なお、x1を基点とする遷移がx2=1を基点とする遷移となることは、I(x1=x2=1)=1によってカウントされる。

a=2の場合、[1,2,1,1,2,1,2,6]の中でx2=2を基点として遷移するのは、「x2→x3」=「2→1」,「x5→x6」=「2→1」,「x7→x8」=「2→6」の3回である。しかしながら、「x2→x3」=「2→1」はΣx’i+1∈ΩRxi x’i+1を得るためのカウント対象とぜず、a=2およびi=2についてΣx’i+1∈ΩRxi x’i+1=2とする。なお「x1→x2」=「1→1」については、x1≠x2=2であるため、I(x1=x2)=0となり、カウントされない。

なお、表記制約上の都合から「Cεa EA」「Rxi xi+1」と表記するが、本来は式(3)に示すように「Cεa EA」の「EA」は「εa」の上に表記され、「Rxi xi+1」の「xi」はxiを表し、「xi+1」はxi+1を表し、xiはxi+1の上に表記される。また、x−iは要素番号i以外の要素番号に対応する行動の候補からなる列、e−iは要素番号i以外の要素番号に対応する音響イベントからなる列を表す。

(iii-2)モデル化部102は、上記の更新式(3)で得られた確率分布P(xi=a|ei=ε,x−i,e−i,Ω,β,γ)に従って、各要素番号iの要素に割り当てる行動の候補xiをサンプリング(選択)する。モデル化部102は、このようにサンプリングした行動の候補xiを要素番号iの要素に割り当て、要素番号iに対応する行動の候補を更新する。これにより更新対象のラベル付き音響信号列を更新する。

(iv)モデル化部102は、上記の(iii-1)(iii-2)の繰り返しによって最終的に得られたC

εa EAおよびR

xi xi+1を用い、以下を計算する。

これによってモデル化部102は、行動の候補が音響イベントを生成する確率φεa(ただし、a∈{1,・・・,A},ε∈{1,・・・,E})の集合を得、それを行動−音響イベント生成モデル14とする。例えばモデル化部102は、確率φεaを(a,ε)要素とするA×E行列を行動−音響イベント生成モデル14とする。また、モデル化部102は、これによって行動の候補の遷移確率πxi xi+1(ただし、xi,xi+1∈{1,・・・,A})の集合を得、それを行動遷移モデル17とする。例えばモデル化部102は、xi,xi+1∈{1,・・・,A}に対応する遷移確率πxi xi+1を(xi,xi+1)要素とするA×A行列を行動遷移モデル17とする。

或いは、モデル化部102は、(iii-1)の繰り返し処理時に、式(3)の算出過程で確率φεaを1個以上サンプリング(計算)し、式(4)に代えて、サンプリングされた確率φεaの平均値を用い、行動−音響イベント生成モデル14を得てもよい。同様に、モデル化部102は、(iii-1)の繰り返し処理時に、式(3)の算出過程で遷移確率πxi xi+1を1個以上サンプリングし、式(5)に代えて、サンプリングされた遷移確率πxi xi+1の平均値を用い、行動遷移モデル17を得てもよい。

また、上記更新過程でサンプリング(選択)し、各要素番号iの要素に割り当てた行動の候補xiを分析することで、各ラベル付き音響信号列11−sの音響信号列がどの行動によって生成されたかを知ることができる。モデル化部102は、このように各要素番号iの要素に割り当てた行動の候補xiを表すラベル、またはそれらの一部を行動ラベル18として出力してもよい。

本実施例では、行動が音響イベントを生成する確率のみではなく、行動の時間遷移確率も考慮して学習処理を行うことで、遷移確率によって特徴付けられる行動も精度よくモデル化できる。また、遷移確率によって特徴付けられる行動を精度よく分析できる。

<実施例(1)−1−2:図3>

[行動ラベル候補付き音響信号列から行動−音響イベント生成モデルおよび行動遷移モデルを算出し、行動を分析]

本実施例では、行動ラベル候補付き音響信号15−1,・・・,15−Sを入力とし、行動の時間変化を考慮に入れ、行動−音響イベント生成モデル14を算出する。すなわち本実施例では、音響信号から音響特徴量を得、得られた音響特徴量を用いて音響イベントを決定し、それによって音響イベントラベル列を得てから学習処理を行い、行動−音響イベント生成モデル14を生成する。なお、この際、行動の時間遷移を表す行動遷移モデル17も算出してもよく、行動の分析を行ってもよい。

図3に例示するように、本実施例のモデル処理装置110は、特徴量算出部111、音響イベント判定部112、音響イベントモデルデータベース(DB)113、音響信号列合成部101、モデル化部102、および記憶部103を有する。モデル処理装置110は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず特徴量算出部111に行動ラベル候補付き音響信号列15−1,・・・,15−Sが入力される。各行動ラベル候補付き音響信号列15−s(ただし、s∈{1,・・・,S})は、前述の時間区間ごとに区分された時系列の音響信号列、当該時間区間ごとに区分された音響信号列の各要素に対応する要素番号、および当該時間区間ごとに付与された行動ラベル候補を含む。要素番号および行動ラベル候補は、音響信号列の要素ごとに付与される。1つの時間区間に複数種類の行動ラベル候補が対応してもよいし、1つの時間区間に複数種類の行動ラベル候補が対応してもよい。

特徴量算出部111は、各行動ラベル候補付き音響信号列15−sが含む音響信号列から、各行動ラベル候補付き音響信号列15−sに対応する音響特徴量列(ベクトル)を算出して出力する。例えば特徴量算出部111は、入力された行動ラベル候補付き音響信号15−sが含む音響信号列に対し、前述の各時間区間であるフレームごとに、音圧レベル、音響パワー、MFCC(Mel-Frequency Cepstrum Coefficient)特徴量、LPC(Linear Predictive Coding)特徴量などを算出し、これらを音響特徴量列として出力する。さらに立ち上がり特性、調波性、時間周期性など(例えば、非特許文献1参照)の音響特徴量が音響特徴量列に加えられてもよい。

立ち上がり特性とは、数十から数百ミリ秒ごとにおける、音響信号の大きさを表す指標の増加の度合いを表す指標である。ここで、音響信号の大きさを表す指標とは、例えば、音響信号の振幅の絶対値、音響信号の振幅の絶対値の対数値、音響信号のパワー又は音響信号のパワーの対数値である。例えば、以下の式(10)で得られる値が0以上であればその値が立ち上がり特性とされ、式(10)で得られる値が0未満であれば0が立ち上がり特性とされる。

ただし、kはフレームをK個の微小な時間区間(例えば1msec程度)に区分した場合の各時間区間に対応し、p ̄

kはk番目の時間区間でのサンプルの大きさを表す指標の代表値又は平均値を表す。なお、「サンプルの大きさを表す指標」の例は、サンプルの振幅、サンプルの振幅の絶対値、サンプルの振幅の対数値、サンプルのエネルギー、サンプルのパワー、又はサンプルのパワーの対数値などである。「サンプル」は音響信号列の各音響信号を表す。また、Δp ̄

kはp ̄

kの変化率を表す。例えば、Δp

− k=p

− k−p

− k−1である。Δp

− k=p

− k+1−p

− kとしてもよい。また、最小二乗法等の近似手法を用いてk番目の時間区間におけるp

− kを近似した直線を求め、その時間区間におけるその直線の傾きをΔp

− kとしてもよい。また、k番目の時間区間を含む複数の時間区間におけるp ̄

k-κ,・・・,p ̄

k-1,p

− k,p ̄

k+1,...p ̄

k-κ’の近時曲線を求め、そのk番目の時間区間に対応する点での傾き(微分値)をΔp

− kとしてもよい。またχを任意の文字として、χの右肩の「−」は、χの上付きバーを意味する。また式(10)の分子における(p ̄

n)

2を(p ̄

n)

mとし、mを任意の値としても良い。

以下に調波性を例示する。

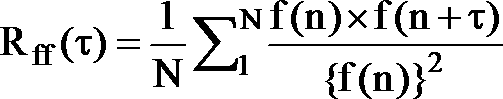

また、Nはフレームに含まれるサンプル数を表す1以上の整数、nはフレーム内の各サンプル点を表す1以上のN以下の整数、x(n)はサンプル点nでのサンプルの大きさを表す指標である。R

ff(τ)はf(n)のラグτでの自己相関係数、max{・}は「・」の最大値を表す。ラグτは1以上N以下の整数である。R

ff(τ)は、例えば以下のように定義される。

以下に時間周期性を例示する。

ただし、Lは一周期とみなすサンプル数、Mは時間周期性の度合を計算するための周期数を表す1以上の整数、p(・)はサンプルの大きさを表す指標を時間平滑化した値、p ̄はフレーム内でのサンプルの大きさを表す指標の平均値を表す。

音響イベントモデルDB113には、事前に算出された音響イベントモデルが複数保存されている。各音響イベントモデルは、音響イベントラベルが付された学習用の音響信号列から音響特徴量列を算出し、各音響イベントに対応する音響特徴量列をGMM,HMM,SVM等の周知のモデル化手法を用いてモデル化することで得られる(例えば参考文献:奥村学、高村大也、「言語処理のための機械学習入門」コロナ社)。

例えば、GMMの場合、音響イベントごとに音響特徴量の各種別に対応する音響イベントモデルが得られる。例えば、音響特徴量列がF種類(Fが1以上の整数)の音響特徴量y

ι(ただし、ι∈{1,・・・,F})からなる列y

1,・・・,y

Fである場合、各音響イベントに対応する音響イベントモデルは、それぞれ、以下のような確率モデルp(y

ι)を要素とする列p(y

1),・・・,p(y

F)となる。

ただし、y

ιは音響特徴量列(ベクトル)の要素、Jは正規分布の混合数、π

jは混合係数、N(・)は正規分布の確率密度関数、μ

jは分布の平均、Σ

jは分布の分散である。

或いは、音響イベントごとに音響特徴量列が対応付けられたものが音響イベントモデルとされてもよい。

特徴量算出部111から出力された音響特徴量列は音響イベント判定部112に入力される。音響イベント判定部112は、入力された音響特徴量列と、音響イベントモデルDB113に記憶されている複数の音響イベントモデルとをそれぞれ比較し、各フレーム(各要素番号iに対応)の音響特徴量列に対応する音響イベントを決定する。例えばGMMが音響イベントモデルとして用いられる場合、音響イベント判定部112は、フレーム(要素番号i)ごとに、入力された音響特徴量列の各要素ρι(ただし、ι∈{1,・・・,F})を各音響イベントに対応する式(13)の各確率モデルに代入し、各音響イベントに対応する確率p(ρ1)×・・・×p(ρF)を最大にする音響イベントを決定する。或いは、例えば音響イベントごとに音響特徴量列が対応付けられた音響イベントモデルの場合、音響イベント判定部112は、フレーム(要素番号i)ごとに、入力された音響特徴量列との距離(ユークリッド距離やコサイン距離)が最も近い音響イベントモデルに対応する音響イベントを選択する。

音響イベント判定部112は、各要素番号iに対して決定した音響イベントを表す音響イベントラベルを、行動ラベル候補付き音響信号列15−sの各要素番号iの要素に付与する。音響イベント判定部112は、この処理を入力された行動ラベル候補付き音響信号列15−1,・・・,15−Sのすべての要素(すべての要素番号i)について行い、その結果得られる音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sは、音響信号列合成部101に入力される。以降の処理は実施例(1)−1−1と同じである。

なお、音響信号列合成部101で音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sの合成処理を行うことに代えて、特徴量算出部111の前段で行動ラベル候補付き音響信号列15−1,・・・,15−Sの合成処理を行っても良いし、音響イベント判定部112の前段で音響特徴量列の合成処理を行っても良い。

<実施例(1)−1−3:図4>

[行動ラベル候補付き音響特徴量から行動−音響イベント生成モデルおよび行動遷移モデルを算出し、行動を分析]

本実施例では、行動の時間変化を考慮に入れ、行動ラベル候補付き音響特徴量から、行動−音響イベントの生成モデルを算出する。同時に、行動の時間遷移を表す行動遷移モデルも算出してもよく、行動の分析も行ってもよい。すなわち本実施例では、音響信号に対応する音響特徴量を用いて音響イベントを決定し、それによって音響イベントラベル列を得てから学習処理を行い、行動−音響イベント生成モデルを生成する。なお、行動の時間遷移を表す行動遷移モデルも算出してもよく、行動の分析も行ってもよい。

図4に例示するように、本実施例のモデル処理装置120は、音響イベント判定部112、音響イベントモデルデータベース(DB)113、音響信号列合成部101、モデル化部102、および記憶部103を有する。モデル処理装置120は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響イベント判定部112に、行動ラベル候補付き音響特徴量列16−1,・・・,16−Sが入力される。各行動ラベル候補付き音響特徴量列16−s(ただし、s∈{1,・・・,S})は、時間区間ごとに区分された時系列の音響信号列、時間区間ごとに区分された音響信号列の各要素に対応する要素番号、長時間(数sec以上)ごとに決定されて時間区間ごとに付与された行動ラベル(「行動情報」に相当)、および音響信号列の時間区間ごとの音響特徴量列を含む。音響特徴量列の具体例は、実施例(1)−1−2で説明した通りである。

音響イベント判定部112は、入力された行動ラベル候補付き音響特徴量列16−sの音響特徴量列と、音響イベントモデルDB113に記憶されている複数の音響イベントモデルを、実施例(1)−1−2で説明したようにそれぞれ比較し、各フレーム(各要素番号iに対応)の音響特徴量列に対応する音響イベントを決定する。音響イベント判定部112は、各要素番号iに対して決定した音響イベントを表す音響イベントラベルを、行動ラベル候補付き音響特徴量列16−sの各要素番号iの要素に付与する。音響イベント判定部112は、この処理を行動ラベル候補付き音響特徴量列16−1,・・・,16−Sのすべての要素(すべての要素番号i)について行い、その結果得られる音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sは、音響信号列合成部101に入力される。以降の処理は実施例(1)−1−1,(1)−1−2と同じである。

なお、音響信号列合成部101で音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sの合成処理を行うことに代えて、音響イベント判定部112の前段で音響特徴量列の合成処理を行っても良い。

<実施例(1)−2−1:図5>

[音響イベントラベル付き音響信号列から行動を推定]

実施例(1)−2−1では、実施例(1)−1−1〜(1)−1−3で説明したように得られた行動−音響イベント生成モデル14および/または行動遷移モデル17を用い、新たに入力された音響イベントラベル付き音響信号列から行動を推定する。

図5に例示するように、本実施例のモデル処理装置200は、記憶部103および生成モデル比較部201を有する。モデル処理装置200は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず生成モデル比較部201に音響イベントラベル付き音響信号列21が入力される。音響イベントラベル付き音響信号列21は、前述の時間区間ごとに区分された時系列の音響信号列、当該時間区間ごとに区分された音響信号列の各要素に対応する要素番号、および当該時間区間ごとに決定されて付与された音響イベントラベルを含む。要素番号および音響イベントラベルは、音響信号列の要素ごとに付与される。

生成モデル比較部201は、入力された音響イベントラベル付き音響信号列21と、記憶部103に格納された行動−音響イベント生成モデル14および/または行動遷移モデル17とを比較し、音響イベントラベル付き音響信号列21に対し、最も適切であると判断した行動、又は最も適切なものから順番に複数個の行動を決定し、それらを推定結果として出力する。以下に音響イベントラベル付き音響信号列21と各生成モデルとの比較方法を例示する。

[比較方法の例(1)−1]

音響イベントラベル付き音響信号列21が有する音響イベントの分布と、行動の候補に対応する確率P(音響イベント|行動の候補)で表される音響イベントの分布との近さに基づいて、行動が推定されてもよい。また、前時刻からの行動の候補の遷移確率に基づいて、行動が推定されてもよい。なお、行動の探索範囲は予め定められたものであってもよいし、音響イベントラベル付き音響信号列21がこの探索範囲を特定するための情報を含み、この情報によって探索範囲が定められてもよい。探索範囲を特定するための情報の例は、行動の候補を表す行動ラベル候補である。このような行動ラベル候補は、要素番号毎に設定されていてもよいし、複数の要素番号に対して共通であってもよい。この場合、探索範囲が適切に設定されていれば行動の推定精度が向上する。

音響イベントラベル付き音響信号列21が有する音響イベントの分布と、行動の候補に対応する確率P(音響イベント|行動の候補)で表される音響イベントの分布との近さに基づいて、行動が推定される例では、まず生成モデル比較部201が、入力された音響イベントラベル付き音響信号列21から、以下のようにp(ε)(ただし、ε∈{1,・・・,E})を算出する。

ただし、γは事前に設定された緩和パラメータ(例えば0.01などの非負値)を表し、C

εは、音響イベントラベル付き音響信号列21で音響イベントεを表す音響イベントラベルが付された要素の個数を表し、N

s’は音響イベントラベル付き音響信号列21が含む音響信号列の要素数を表す。N

s’=N

sであってもよいし、N

s’≠N

sであってもよい。

次に生成モデル比較部201は、p(ε)と行動−音響イベント生成モデル14とを、下記に記すカルバックライブラー情報量(Kullback-Leibler divergence: KL divergence)やイェンセンシャノン情報量(Jensen-Shannon divergence: JS divergence)などの情報量基準に基づいて比較することで、入力された音響イベントラベル付き音響信号列21に対応する行動を推定する。

式(15)又は(16)の例の場合、生成モデル比較部201は、P(ε)にp(ε)(ただし、ε∈{1,・・・,E})を代入し、Q(ε)に式(4)のφεa(ただし、ε∈{1,・・・,E),a∈{1,・・・,A})を代入する。これにより、生成モデル比較部201は、各行動の候補a∈{1,・・・,A}に対応する情報量(合計A個の情報量)を得る。行動の探索範囲が予め定められたものである場合にはAは定数である。一方、行動の探索範囲が音響イベントラベル付き音響信号列21に含まれる情報(行動ラベル候補等)によって特定される場合には、その探索範囲に属する行動の候補の総数がAとなる。

生成モデル比較部201は、各行動a∈{1,・・・,A}について算出された情報量のうち、最も小さな情報量に対応する行動、又は、最も小さな情報量から順番に選択した複数個の情報量に対応する複数個の行動を、音響イベントラベル付き音響信号列21に対応する行動として決定して出力する。

生成モデル比較部201は、以下のように、行動遷移モデル17が表す遷移確率π

xi-1 xiと前時刻(要素番号i−1の時間区間)の行動推定結果x

i−1を利用して、現時刻(要素番号iの時間区間)の行動x

i=aを推定しても良い。

[比較方法の例(1)−2]

音響イベントラベル付き音響信号列21が有する音響イベントの時系列の並びに対する、確率P(音響イベント|行動の候補)のもとでの行動の候補の尤もらしさに基づいて、行動が推定されてもよい。また、音響イベントラベル付き音響信号列21が有する音響イベントの時系列の並びに対する、確率P(音響イベント|行動の候補)のもとでの行動の候補の尤もらしさおよび、前時刻からの行動の候補の遷移確率の両方に基づいて行動が推定されても良い。ここでも上述のように、行動の探索範囲は予め定められたものであってもよいし、音響イベントラベル付き音響信号列21がこの探索範囲を特定するための情報(例えば、行動の候補を表す行動ラベル候補)を含み、この情報によって探索範囲が定められてもよい。

以下に具体例を示す。以下の例では、生成モデル比較部201が、入力されたラベル付き音響信号列21に対し、行動−音響イベント生成モデル14のもとでの行動の尤度の和や積を求める。

≪行動−音響イベント生成モデル14のもとでの行動の尤度の和の例≫

≪行動−音響イベント生成モデル14のもとでの行動の尤度の積の例≫

ただし、式(17)および(18)のeiは、入力された音響イベントラベル付き音響信号列21の要素番号iに対応する音響イベントラベルが表す音響イベントを表す。式(17)および(18)は、式(4)のφεaと、入力された音響イベントラベル付き音響信号列21のeiとから算出できる。

行動の探索範囲が予め定められたものである場合には、その探索範囲に属する各行動の候補aについて上記の尤度が算出され、行動の探索範囲が音響イベントラベル付き音響信号列21に含まれる情報(行動ラベル候補等)によって特定される場合には、その探索範囲に属する各行動の候補aについて上記の尤度が算出される。生成モデル比較部201は、各行動の候補aについて算出した尤度のうち、最も尤度の高い行動の候補、又は、最も尤度の高いものから順番に選択した複数個の行動の候補を、入力された音響イベントラベル付き音響信号列21に対応する行動として決定して出力する。

生成モデル比較部201は、以下のように、行動−音響イベント生成モデル14のもとでの行動の尤度の和や積および、行動遷移モデル17が表す遷移確率πxi-1 xiと前時刻(要素番号i−1の時間区間)の行動推定結果xi−1を利用して、現時刻(要素番号iの時間区間)の行動xi=aを推定しても良い。

≪行動−音響イベント生成モデル14のもとでの行動の尤度の和および、行動遷移モデル17と前時刻の行動推定結果を利用する場合の例≫

≪行動−音響イベント生成モデル14のもとでの行動の尤度の積および、行動遷移モデル17と前時刻の行動推定結果を利用する場合の例≫

<実施例(1)−2−2:図6>

[音響信号列から行動を推定]

本実施例では、実施例(1)−1−1〜(1)−1−3で説明したように得られた行動−音響イベント生成モデル14および/または行動遷移モデル17を用い、新たに入力された音響信号列から行動を推定する。

図6に例示するように、本実施例のモデル処理装置210は、特徴量算出部211、音響イベント判定部212、音響イベントモデルDB113、記憶部103、生成モデル比較部201を有する。モデル処理装置210は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず特徴量算出部211に音響信号列22が入力される。音響信号列22は、時間区間ごとに区分された時系列の音響信号列、および時間区間ごとに区分された音響信号列の各要素に対応する要素番号を含む。

特徴量算出部211は、音響信号列22から音響特徴量列(ベクトル)を算出して出力する。例えば特徴量算出部211は、前述した特徴量算出部111と同じ方法で音響特徴量列を算出する。

音響イベント判定部212は、前述した音響イベント判定部112と同じ方法で、特徴量算出部211から出力された音響特徴量列と、音響イベントモデルDB113に記憶されている複数の音響イベントモデルとをそれぞれ比較し、音響信号列22の全ての要素について音響イベントを決定する。音響イベント判定部212は、決定した音響イベントを表す音響イベントラベルを音響信号列22の各要素に付することで、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベル付き音響信号列21は、生成モデル比較部201に入力される。以降の処理は実施例(1)−2−1と同じである。

<実施例(1)−2−3:図7>

[音響特徴量から行動を推定]

本実施例では、実施例(1)−1−1〜(1)−1−3で説明したように得られた行動−音響イベント生成モデル14および/または行動遷移モデル17を用い、新たに入力された音響特徴量列から行動を推定する。

図7に例示するように、本実施例のモデル処理装置220は、音響イベント判定部212、音響イベントモデルDB113、記憶部103、生成モデル比較部201を有する。モデル処理装置220は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響イベント判定部212に音響特徴量列23が入力される。音響特徴量列23は、時間区間ごとに区分された時系列の音響信号列、当該時間区間ごとに区分された音響信号列の各要素に対応する要素番号、および音響信号列の音響特徴量列を含む。音響特徴量列の具体例は、実施例(1)−1−2で説明した通りである。

音響イベント判定部212は、前述した音響イベント判定部112と同じ方法で、音響特徴量列23の音響特徴量列と、音響イベントモデルDB113に記憶されている複数の音響イベントモデルとをそれぞれ比較し、音響特徴量列23が含む音響信号列の全ての要素について音響イベントを決定する。音響イベント判定部212は、決定した各要素の音響イベントを表す音響イベントラベルを、音響特徴量列23が含む音響信号列に付することで、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベル付き音響信号列21は、生成モデル比較部201に入力される。以降の処理は実施例(1)−2−1と同じである。

<実施例(1)−3−1:図8>

[音響イベントラベル付き音響信号列から行動を推定すると共に、音響イベントラベルおよび行動ラベル候補付き音響信号列から行動−音響イベント生成モデルおよび行動遷移モデルを算出]

本実施例は、実施例(1)−1−1と実施例(1)−2−1との組み合わせである。本実施例では、音響イベントラベル付き音響信号列21を入力として行動を推定することに加え、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを入力とし、行動−音響イベント生成モデル14の生成も行う。さらに行動遷移モデル17や行動ラベル18の生成を行ってもよい。さらに、推定結果である行動を表す行動ラベル候補を、音響イベントラベル付き音響信号列21が含む音響信号列の各要素に付与することで、音響イベントラベルおよび行動ラベル候補付き音響信号列を得、それを生成モデルの更新に利用することもできる。

図8に例示するように、本実施例のモデル処理装置300は、記憶部103,303、音響信号列合成部101、モデル化部102、および生成モデル比較部201を有する。モデル処理装置300は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

記憶部303には、前述した音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、および前述した音響イベントラベル付き音響信号列21が格納されている。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sは音響信号列合成部101に入力される。音響信号列合成部101およびモデル化部102は、実施例(1)−1−1で説明したように、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sから行動−音響イベント生成モデル14を生成し、それを記憶部103に格納する。また、実施例(1)−1−1で説明したように、モデル化部102が行動遷移モデル17を生成して記憶部103に格納してもよいし、行動ラベル18を生成して記憶部103に格納してもよい。

音響イベントラベル付き音響信号列21は生成モデル比較部201に入力される。音響イベントラベル付き音響信号列21は、実施例(1)−2−1で説明したように、入力された音響イベントラベル付き音響信号列21と、記憶部103に格納された行動−音響イベント生成モデル14および/または行動遷移モデル17とを比較し、音響イベントラベル付き音響信号列21に対し、最も適切であると判断した行動、又は最も適切なものから順番に複数個の行動を選択し、それらを推定結果として出力する。

さらに生成モデル比較部201は、決定した行動を表す行動ラベル候補を、音響イベントラベル付き音響信号列21の対応する各要素に付与し、それによって新たな音響イベントラベルおよび行動ラベル候補付き音響信号列21’を生成して出力してもよい。この場合、音響イベントラベルおよび行動ラベル候補付き音響信号列21’が、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sとともに音響信号列合成部101に入力されてもよい。この場合、音響信号列合成部101は、入力されたすべての音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S,21’を時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベルおよび行動ラベル候補付き音響信号列11’(「第3音響イベントラベル列」および「第3行動ラベル候補」)を得て出力する。モデル化部102は、実施例(1)−1−1のラベル付き音響信号列11(「音響イベントラベル列」および「行動ラベル候補」)に代えて、音響イベントラベルおよび行動ラベル候補付き音響信号列11’(「第3音響イベントラベル列」および「第3行動ラベル候補」)を用い、再度、実施例(1)−1−1で説明したように、行動−音響イベント生成モデル14を生成し、それを記憶部103に格納する。さらにモデル化部102が、ラベル付き音響信号列11に代えて、入力された音響イベントラベルおよび行動ラベル候補付き音響信号列11’を用い、再度、実施例(1)−1−1で説明したように、行動遷移モデル17を生成して記憶部103に格納してもよいし、行動ラベル18を生成して記憶部103に格納してもよい。

また、生成モデル比較部201の処理およびモデル化部102の処理のどちらを先に行っても良い。ただし、モデル化部102の処理を行う前に生成モデル比較部201の処理を行う場合、記憶部103に予め得られた行動−音響イベント生成モデル14および/または行動遷移モデル17が格納されている必要がある。

また、音響イベントラベルおよび行動ラベル候補付き音響信号列21’が、新たに入力された音響イベントラベルおよび行動ラベル候補付き音響信号列とともに音響信号列合成部101に入力されてもよい。音響信号列合成部101は、これらを時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベルおよび行動ラベル候補付き音響信号列(「第3音響イベントラベル列」および「第3行動ラベル候補」)を得て、モデル化部102に送出し、モデル化部102が上述の処理を行ってもよい。

その他の処理は実施例(1)−1−1および実施例(1)−2−1と同じである。

<実施例(1)−3−2:図9>

[音響信号列から行動を推定すると共に、行動ラベル候補付き音響信号列から行動−音響イベント生成モデルおよび行動遷移モデルを算出]

本実施例は実施例(1)−1−2と実施例(1)−2−2の組み合わせである。

本実施例では、行動ラベル候補付き音響信号列15−1,・・・,15−Sを入力として、学習によって、行動−音響イベント生成モデル14を算出する。さらに行動遷移モデル17や行動ラベル18の生成を行ってもよい。さらに本実施例では、行動−音響イベント生成モデル14および/または行動遷移モデル17を用い、新たに入力された音響信号列22から行動を推定する。

図9に例示するように、本実施例のモデル処理装置310は、特徴量算出部111−1,・・・,111−S,211、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および実施例(1)−3−1のモデル処理装置300(図8参照)を有する。

行動ラベル候補付き音響信号列15−1,・・・,15−Sは、それぞれ特徴量算出部111−1,・・・,111−Sに入力される。特徴量算出部111−1,・・・,111−Sは、実施例(1)−1−2で説明したように、行動ラベル候補付き音響信号列15−1,・・・,15−Sから、それぞれ音響特徴量列を得て出力する。音響イベント判定部112−1,・・・,112−Sは、それぞれ、前述の音響イベント判定部112と同様に、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを生成して出力する。

音響信号列22は特徴量算出部211に入力される。特徴量算出部211は、実施例(1)−2−2で説明したように、音響信号列22から音響特徴量列(ベクトル)を算出して出力する。音響イベント判定部212は、実施例(1)−2−2で説明したように、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21は、記憶部303(図8)に格納される。以降の処理は実施例(1)−3−1と同じである。

<実施例(1)−3−3:図10>

[音響特徴量から行動を推定すると共に、行動ラベル候補付き音響信号列から行動−音響イベント生成モデルおよび行動遷移モデルを算出]

本実施例は実施例(1)−1−3と実施例(1)−2−3との組み合わせである。

本実施例では、行動ラベル候補付き音響特徴量列16−1,・・・,16−Sを入力として、学習によって、行動−音響イベント生成モデル14を算出する。行動遷移モデル17や行動ラベル18の生成を行ってもよい。さらに本実施例では、行動−音響イベント生成モデル14を用い、新たに入力された音響特徴量列23から行動を推定する。

図10に例示するように、本実施例のモデル処理装置320は、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および前述のモデル処理装置300(図8参照)を有する。

行動ラベル候補付き音響特徴量列16−1,・・・,16−Sは、それぞれ音響イベント判定部112−1,・・・,112−Sに入力される。音響イベント判定部112−1,・・・,112−Sは、それぞれ、前述の音響イベント判定部112と同様に、行動ラベル候補付き音響特徴量列16−1,・・・,16−Sの音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを生成して出力する。

音響特徴量列23は音響イベント判定部212に入力される。音響イベント判定部212は、実施例(1)−2−3と同様に、入力された音響特徴量列23の音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21は、記憶部303(図8)に格納される。以降の処理は実施例(1)−3−1と同じである。

<実施例(1)−4−1:図11>

[音響イベントラベル付き音響信号列から行動を推定すると共に、音響イベントラベルおよび行動ラベル候補付き音響信号列から行動−音響イベント生成モデルおよび行動遷移モデルを算出。特別なシンボルを用いる]

本実施例は実施例(1)−3−1の変形である。

本実施例では、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、および音響イベントラベル付き音響信号列21を入力とし、行動−音響イベント生成モデル14を算出する。行動遷移モデル17や行動ラベル18の生成を行ってもよい。さらに、音響イベントラベル付き音響信号列21に対応する行動を推定する。さらに、推定された行動を表す行動ラベル候補を、音響イベントラベル付き音響信号列21が含む音響信号列の各要素に付与することで、音響イベントラベルおよび行動ラベル候補付き音響信号列を得、それを生成モデルの更新に利用することもできる。

図11に例示するように、本実施例のモデル処理装置400は、記憶部103、303、音響信号列合成部401、モデル化部402、および生成モデル比較部403を有する。モデル処理装置400は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

音響信号列合成部401に、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sおよび音響イベントラベル付き音響信号列21が入力される。音響信号列合成部401は、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21を時系列方向につなぎ合わせ、それによって1つの音響イベントラベルおよび行動ラベル候補付き音響信号列41(以下、単に「ラベル付き音響信号列41」という)を得て出力する。ここで前述のように、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sは、行動ラベル候補によって行動の候補が表された音響イベント(第4音響イベント)の時系列の並びを含む。一方、音響イベントラベル付き音響信号列21は、行動ラベル候補によって行動の候補が表されていない音響イベント(第5音響イベント)の時系列の並びを含む。したがって、ラベル付き音響信号列41が含む音響イベントの時系列の並びは、行動ラベル候補によって行動の候補が表された第4音響イベントの時系列の並び、および行動ラベル候補によって行動の候補が表されていない第5音響イベントの時系列の並びを含む。ラベル付き音響信号列41は、モデル化部402に入力される。なお、予め、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21からラベル付き音響信号列41が得られている場合には、音響信号列合成部401を経由することなく、ラベル付き音響信号列41がそのままモデル化部402に入力されてもよい。

モデル化部402は、実施例(1)−1−1のラベル付き音響信号列11に代えて、入力されたラベル付き音響信号列41を用い、実施例(1)−1−1のモデル化部102と同じ方法で、行動−音響イベント生成モデル14を算出する。行動遷移モデル17や行動ラベル18の生成を行ってもよい。ただし、モデル化部402は、上述の「第5音響イベント」を生じさせた行動の候補として特別なシンボルを用いて学習処理を行う。すなわちモデル化部402は、この特別なシンボルを一つの独立した特別な行動ラベル候補とみなす。この特別な行動ラベル候補は、一般的な何れの行動(料理、掃除など)を表すものでもない。例えば、この特別な行動ラベル候補が、「行動の候補が未知であること」を表してもよい。

すなわちモデル化部402は、行動の候補が音響イベントを生成する確率P(音響イベント|行動の候補)、およびこの特別なシンボルが音響イベントを生成する確率P(音響イベント|特別なシンボル)を得、それらに対応する行動−音響イベント生成モデル14を得る。行動−音響イベント生成モデル14は、記憶部103に格納される。行動遷移モデル17や行動ラベル18の生成を行った場合には、それらも記憶部103に格納される。

生成モデル比較部403には、行動−音響イベント生成モデル14および/または行動遷移モデル17が入力される。生成モデル比較部403は、入力された行動−音響イベント生成モデル14に対応する、確率P(音響イベント|行動の候補)と確率P(音響イベント|特別なシンボル)とを比較し、特別なシンボルに対応する行動の内容を推定し、それらの推定結果を出力する。また、生成モデル比較部403は、入力された行動遷移モデル17に対応する、遷移確率P(現時刻の行動の候補|前時刻の行動の候補)と遷移確率P(特別なシンボル|前時刻の行動の候補)とを比較し、特別なシンボルに対応する行動の内容を推定し、それらの推定結果を出力してもよい。例えば、生成モデル比較部403は、音響イベントラベル付き音響信号列21に対し、最も適切であると判断した行動、又は最も適切なものから順番に複数個の行動を選択し、それらを推定結果として出力する。

[比較方法の例示]

生成モデル比較部403による比較は、例えば、実施例(1)−2−1で説明した情報量基準に基づいて行うことができる。例えば、式(15)又は(16)の情報量基準を用い、確率P(音響イベント|行動の候補)と確率P(音響イベント|特別なシンボル)とを比較する場合、生成モデル比較部403は、P(ε)に式(4)のφεaのうち特別なシンボルa’∈{1,・・・,A}に対応するφεa’(ただし、ε∈{1,・・・,E)}を代入し、Q(ε)に他の行動の候補a’’≠a’(ただし、a’’∈{1,・・・,A})に対応するφεa’’(ただし、ε∈{1,・・・,E))を代入する。遷移確率P(現時刻の行動の候補|前時刻の行動の候補)と遷移確率P(特別なシンボル|前時刻の行動の候補)とを比較する場合、生成モデル比較部403は、P(ε)に特別なシンボルa’に対応するP(xi=a’|xi−1,πxi−1 xi)を代入し、Q(ε)に他の行動の候補a’’≠a’に対応するP(xi=a’’|xi−1,πxi−1 xi)を代入する。

これにより、生成モデル比較部403は、他の行動a’’≠a’(ただし、a’’∈{1,・・・,A})に対応する情報量(合計A−1個の情報量)を得る。生成モデル比較部403は、各行動a’’について算出された情報量のうち、最も小さな情報量に対応する行動の候補、又は、最も小さな情報量から順番に選択した複数個の情報量に対応する複数個の行動の候補を、音響イベントラベル付き音響信号列21に対応する行動として決定して出力する。

生成モデル比較部403は、以上のように決定した行動を表す行動ラベル候補を、音響イベントラベル付き音響信号列21の対応する各要素に付与し、それによって新たな音響イベントラベルおよび行動ラベル候補付き音響信号列41’を生成して出力してもよい。この場合、音響イベントラベルおよび行動ラベル候補付き音響信号列41’が、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sとともに音響信号列合成部401に入力されてもよい。この場合、音響信号列合成部401は、入力されたすべての音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S,41’を時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベルおよび行動ラベル候補付き音響信号列41’’を得て出力する。モデル化部402は、実施例(1)−1−1のラベル付き音響信号列11に代えて、音響イベントラベルおよび行動ラベル候補付き音響信号列41’’を用い、再度、実施例(1)−1−1で説明したように、行動−音響イベント生成モデル14を生成し、それを記憶部103に格納する。さらにモデル化部402が、入力された音響イベントラベルおよび行動ラベル候補付き音響信号列41’’を用い、再度、実施例(1)−1−1で説明したように、行動遷移モデル17を生成して記憶部103に格納してもよいし、行動ラベル18を生成して記憶部103に格納してもよい。

また、音響イベントラベルおよび行動ラベル候補付き音響信号列21’が、新たに入力された音響イベントラベルおよび行動ラベル候補付き音響信号列とともに音響信号列合成部401に入力されてもよい。音響信号列合成部401は、これらを時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベルおよび行動ラベル候補付き音響信号列を得て、モデル化部402に送出し、モデル化部102が上述の処理を行ってもよい。

その他の処理は実施例(1)−1−1、実施例(1)−2−1、および実施例(1)−3−1と同じである。

<実施例(1)−4−2:図9>

[音響信号列から行動を推定すると共に、行動ラベル候補付き音響信号列から行動−音響イベント生成モデルおよび行動遷移モデルを算出。特別なシンボルを用いる]

本実施例は実施例(1)−3−2の変形である。

本実施例では、行動ラベル候補付き音響信号列15−1,・・・,15−Sおよび音響信号列22を入力として、学習によって、行動−音響イベント生成モデル14を算出する。さらに行動遷移モデル17や行動ラベル18の生成を行ってもよい。さらに本実施例では、行動−音響イベント生成モデル14を用い、音響信号列22に対応する行動を推定する。

図9に例示するように、本実施例のモデル処理装置410は、特徴量算出部111−1,・・・,111−S,211、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および実施例(1)−4−1のモデル処理装置400(図11参照)を有する。

行動ラベル候補付き音響信号列15−1,・・・,15−Sは、それぞれ特徴量算出部111−1,・・・,111−Sに入力される。特徴量算出部111−1,・・・,111−Sは、実施例(1)−1−2で説明したように、行動ラベル候補付き音響信号列15−1,・・・,15−Sから、それぞれ音響特徴量列を得て出力する。音響イベント判定部112−1,・・・,112−Sは、それぞれ、前述の音響イベント判定部112と同様に、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを生成して出力する。

音響信号列22は特徴量算出部211に入力される。特徴量算出部211および音響イベント判定部212は、実施例(1)−2−2で説明したように、音響信号列22から音響特徴量列(ベクトル)を算出して出力する。音響イベント判定部212は、実施例(1)−2−2で説明したように、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21は、記憶部303(図11)に格納される。以降の処理は実施例(1)−3−1と同じである。

<実施例(1)−4−3:図10>

[音響特徴量から行動を推定すると共に、行動ラベル候補付き音響信号列から行動−音響イベント生成モデルおよび行動遷移モデルを算出。特別なシンボルを用いる]

本実施例は実施例(1)−3−3の変形である。

本実施例では、行動ラベル候補付き音響特徴量列16−1,・・・,16−Sおよび音響特徴量列23を入力として、学習によって、行動−音響イベント生成モデル14を算出する。行動遷移モデル17や行動ラベル18の生成を行ってもよい。さらに本実施例では、行動−音響イベント生成モデル14を用い、音響特徴量列23に対応する行動を推定する。

図10に例示するように、本実施例のモデル処理装置420は、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および前述のモデル処理装置400(図11参照)を有する。

行動ラベル候補付き音響特徴量列16−1,・・・,16−Sは、それぞれ音響イベント判定部112−1,・・・,112−Sに入力される。音響イベント判定部112−1,・・・,112−Sは、それぞれ、前述の音響イベント判定部112と同様に、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを生成して出力する。

音響特徴量列23は音響イベント判定部212に入力される。音響イベント判定部212は、実施例(1)−2−3と同様に、入力された音響特徴量列23の音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21は、記憶部303(図11)に格納される。以降の処理は実施例(1)−4−1と同じである。

<実施例(2)−1−1:図12>

[行動の時間変化および/または状況の時間変化を考慮に入れ、音響イベントラベルおよび行動ラベル候補付き音響信号から行動−音響イベント生成モデル、状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出し、同時に、行動や状況を分析]

本実施例では、行動の時間変化および/または状況の時間変化を考慮に入れ、音響イベントラベルおよび行動ラベル候補付き音響信号から、状況−音響イベント生成モデルを算出する。同時に、行動−状況生成モデルを算出してもよく、行動−音響イベント生成モデルを算出してもよく、行動の時間遷移を表す行動遷移モデルを算出してもよく、状況の時間遷移を表す状況遷移モデルを算出してもよく、行動や状況の分析も行ってもよい。

すなわち、本実施例では、各時間区間の音響信号を生じさせた音響イベントの時系列の並びを表す音響イベントラベル列、音響イベントを生じさせた行動の候補を表す行動ラベル候補、および音響イベントを生じさせた状況の候補の総数を用い、「音響イベントの時系列の並びにおける、行動の候補に対応する音響イベントの組み合わせと行動の候補の時系列の並びおよび/または状況の時系列の並びと行動の候補に対応する状況の候補の組み合わせとの同時事後確率」を最大化するための処理を行う学習処理を行う。例えば、この学習処理は、行動の時間遷移/または状況の時間遷移に基づく行動または状況の出現確率および、行動または状況による音響イベントの出現確率に基づいて、音響イベントの時系列の並びにおける、行動の候補に対する音響イベントの組み合わせと行動の候補の時系列の並びと行動に対する状況の候補の組み合わせとの同時事後確率を最大化するための処理である。例えば、音響イベントの時系列の並びからなる音響イベントの組み合わせに対する尤度関数P(音響イベントの組み合わせ|行動の候補の時系列の並びおよび/または状況の時系列の並び,行動の候補に対応する状況の候補の組み合わせ)を最大にする処理が行われる。それにより、状況の候補が音響イベントを生成する確率P(音響イベント|状況の候補)を「状況−音響イベント生成モデル」として得る。また、この学習処理によって、行動の候補が状況の候補を生成する確率P(状況の候補|行動の候補)を「行動−状況生成モデル」として得てもよいし、行動の候補が音響イベントを生成する確率P(音響イベント|行動の候補)を「行動−音響イベント生成モデル」として得てもよいし、行動の候補の時系列の遷移確率を「行動遷移モデル」として得てもよいし、状況の候補の時系列の遷移確率を「状況遷移モデル」として得てもよい。なお「状況遷移モデル」とは、状況の候補の時系列の遷移確率である。状況遷移モデルの例は、ラベル付き音響信号列11に付与されたすべての行動ラベル候補を対象とした遷移確率π’zi−1 ziを(zi−1,zi)要素とするT×T行列である。ただし、遷移確率π’zi−1 ziは、前時刻での状況の候補zi−1(要素番号i−1での状況の候補)から現時刻での状況の候補zi(要素番号iでの状況の候補)への遷移確率を表し、π’zi−1 ziの上付き「zi−1」はzi−1を表し、下付き「zi」はziを表し、Tは状況の候補の総数(状況の候補の種類の個数)を表す。さらに、この学習処理の過程で何れかの行動の候補を選択し、各音響イベントがどの行動によって生成されたのかを分析してもよい。この場合には選択した行動の候補を表す行動ラベルを出力してもよい。またさらに、この学習処理の過程で何れかの状況の候補を選択し、各音響イベントがどの状況によって生成されたのかを分析してもよい。この場合には選択した状況の候補を表す状況ラベルを出力してもよい。なお「状況の候補の総数」は、音響イベントラベル列とともに入力される値であってもよいし、予め定められた定数であってもよい。

図12に例示するように、本実施例のモデル処理装置100は、音響信号列合成部101、モデル化部1102、および記憶部1103を有する。モデル処理装置100は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響信号列合成部101に、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S(ただし、Sは1以上の整数)が入力される。図13に例示するように、音響イベントラベルおよび行動ラベル候補付き音響信号列11−s(ただし、s=1,・・・,S)は、前述の時間区間ごとに区分された時系列の音響信号列、当該時間区間ごとに区分された音響信号列の各要素に対応する要素番号i(ただし、i=1,・・・,Ns、Nsは正整数)、当該時間区間ごとに決定されて付与された音響イベントラベル、当該時間区間ごとに付与された行動ラベル候補、および響イベントラベルおよび行動ラベル候補付き音響信号列11−sに対応する音響信号列番号sを含む。上記時間区間ごとに複数個の行動ラベル候補が付与されてもよいし(例えば、図13の音響信号列番号1−要素番号1の時間区間)、単一の行動ラベル候補が付与されてもよい(例えば、図13の音響信号列番号2−要素番号1の時間区間)。

複数個の音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S(以下、単に「ラベル付き音響信号列11−1,・・・,11−S」という)が音響信号列合成部101に入力された場合、音響信号列合成部101は、それらを時系列方向につなぎ合わせ、それによって1つの音響イベントラベルおよび行動ラベル候補付き音響信号列11(以下、単に「ラベル付き音響信号列11」という)を得て出力する(合成処理)。音響信号列合成部101に1つの音響信号列11−1のみが入力された場合、音響信号列合成部101はそれをラベル付き音響信号列11として出力する。音響信号列合成部101から出力された音響イベントラベルおよび行動ラベル候補付き音響信号列は、モデル化部1102に入力される。なお、音響信号列合成部101を経由することなく、1つラベル付き音響信号列11がそのままモデル化部1102に入力されてもよい。

モデル化部1102は、以下の手順に従って、入力されたラベル付き音響信号列11から、行動−状況生成モデル12、状況−音響イベント生成モデル13、および行動−音響イベント生成モデル14の少なくとも何れかを生成し、それらを記憶部1103に格納する。モデル化部102は、行動遷移モデル17を生成してもよいし、状況遷移モデルを生成してもよいし、行動ラベル18を生成してもよいし、状況ラベル19を生成してもよい。生成された行動遷移モデル17や状況遷移モデルや行動ラベル18や状況ラベル19も記憶部1103に格納される。

[行動から音響イベントが生成される過程の論理的説明]

モデル化部1102は、ラベル付き音響信号列11から、行動の候補が状況の候補を生成する確率P(状況の候補|行動の候補)としたときの行動−状況生成モデル12と、状況の候補が音響イベントを生成する確率P(音響イベント|状況の候補)としたときの状況−音響イベント生成モデル13と、行動の候補が音響イベントを生成する確率P(音響イベント|行動の候補)としたときの行動−音響イベント生成モデル14との少なくとも何れかを算出する。つまり本実施例では、行動の候補が状況の候補の生成確率を規定し、状況の候補が音響イベントの生成確率を規定すると考え(つまり、間接的に行動の候補が音響イベントの生成確率を規定するとも考えられる)、これらの関係を各生成モデルとして記述する。また、行動の候補の時系列の遷移確率を算出し、行動遷移モデル17を得てもよい。

状況の候補における音響イベントの生成確率Φ’、ラベル付き音響信号列11が有する行動ラベル候補が表す行動の候補のすべてからなる集合Ω、行動ラベル候補が表す行動の候補における状況の候補の生成確率Θ、および行動ラベル候補が表す行動の候補の遷移確率Πおよび/または状況の候補の遷移確率Π’が与えられた場合における、音響イベントの列eの生成確率P(e|Π,Θ,Φ’,Ω),P(e|Π’,Θ,Φ’,Ω),P(e|Π,Π’,Θ,Φ’,Ω)は以下の通りである。

ただし、Aは行動の候補の総数、Tは状況の候補の総数(状況の候補の種類の個数)、Eは音響イベントの種類の個数、eはラベル付き音響信号列11に与えられた音響イベントの列(ベクトル)、Πは各時間区間の行動の候補a(ただし、a∈{1,・・・,A})が次の時間区間で行動の候補a’(ただし、a’∈{1,・・・,A})に遷移する確率を(a,a’)要素とするA×A行列、Π’は各時間区間の状況の候補t(ただし、t∈{1,・・・,T})が次の時間区間で行動の候補t’(ただし、t’∈{1,・・・,T})に遷移する確率を(t,t’)要素とするT×T行列、Θは行動の候補a(ただし、a∈{1,・・・,A})が状況の候補t(ただし、t∈{1,・・・,T})を生成する確率P(t|a)を(a,t)要素とするA×T行列、Φ’は状況の候補t(ただし、t∈{1,・・・,T})が音響イベントε(ただし、ε∈{1,・・・,E})を生成する確率P(ε|t)を(t,ε)要素とするT×E行列、Ωは各音響信号列がとり得る行動ラベル候補を音響信号列分並べて列とした、集合のベクトル、e’

sは各ラベル付き音響信号列11−sに与えられた音響イベントの列(N

s次元ベクトル:N

sはラベル付き音響信号列11−sに対応する音響イベントの個数)、a

sはラベル付き音響信号列11−sに付与され得る行動の集合、Sはラベル付き音響信号列11を構成するラベル付き音響信号列11−sの個数を表す。なお、Ωとa

sの関係は以下のように表される。

Ω=[a

1,a

2,…,a

s,…,a

S]

行動の候補の集合a

s、行動の候補aの遷移確率π

aの事前分布のパラメータ(Dirichlet分布に従うものとする)γ、行動の候補aにおける状況の候補tの生成確率θ

aの事前分布のパラメータ(Dirichlet分布に従うものとする)α、状況の候補tにおける音響イベントεの生成確率φ

tの事前分布のパラメータ(Dirichlet分布に従うものとする)β’が与えられたときの、音響イベントの列e’

sの生成確率P(e’

s,Π,Θ,Φ’|γ,α,β’,Ω)、行動の候補の集合a

s、状況の候補tの遷移確率π’

tの事前分布のパラメータ(Dirichlet分布に従うものとする)γ’、パラメータα,β’が与えられたときの、音響イベントの列e’

sの生成確率P(e’

s,Π’,Θ,Φ’|γ’,α,β’,Ω)、および行動の候補の集合a

s、パラメータγ,γ’,α,β’が与えられたときの、音響イベントの列e’

sの生成確率P(e’

s,Π,Π’,Θ,Φ’|γ,γ’,α,β’,Ω)は、以下の通りである。

ただし、e

iはラベル付き音響信号列11−sの要素番号iに対応する音響イベント、N

sはラベル付き音響信号列11−sに対応する要素数(要素番号iの最大値)、z

iはラベル付き音響信号列11−sの要素番号iに対応する音響信号が表状況の候補、x

iはラベル付き音響信号列11−sの要素番号iに対応する行動ラベル候補が表す行動の候補、π

xi−1 xiはラベル付き音響信号列11−sの要素番号i−1に対応する行動ラベル候補が表す行動の候補x

i−1から要素番号iに対応する行動ラベル候補が表す行動の候補x

iへの遷移確率を表す。また、φ

tは状況の候補tが音響イベントε(ただし、ε∈{1,・・・,E})を生成する確率P(ε|t)をε番目の要素とするE次元ベクトルを表す。θ

aは行動の候補aが状況の候補t(ただし、t∈{1,・・・,T})を生成する確率P(t|a)をt番目の要素とするT次元ベクトルを表す。

[生成モデルの算出過程の説明]

モデル化部1102は、入力されたラベル付き音響信号列11から、状況の候補が音響イベントを生成する確率P(音響イベント|状況の候補)を算出し、それを状況−音響イベント生成モデル13として記憶部1103に格納する。モデル化部1102は、行動の候補が状況の候補を生成する確率P(状況の候補|行動の候補)を算出し、それを行動−状況生成モデル12として記憶部1103に格納してもよい。また、モデル化部1102は、行動の候補が音響イベントを生成する確率P(音響イベント|行動の候補)を行動−音響イベント生成モデル14として算出してもよいし、行動の候補の遷移確率を算出し、それを行動遷移モデル17として記憶部1103に格納してもよい。

さらにモデル化部1102は、入力されたラベル付き音響信号列11が有する行動ラベル候補から尤もらしいラベルを選択し、選択した行動ラベル候補からなる行動ラベル列18を外部に出力したり、記憶部1103に格納したりしてもよい。尤もらしいラベルは、各時間区間に対して1つでもよいし、複数個でもよい。また、各時間区間において尤もらしさが閾値を超えたすべての行動ラベル候補を選択し、選択した時間区間ごとに単一または複数の行動ラベル候補からなる行動ラベル18の列を外部に出力したり、記憶部1103に格納したりしてもよい。

またモデル化部1102は、入力されたラベル付き音響信号列11に対して尤もらしい状況を表す状況ラベル19を選択して外部に出力したり、記憶部1103に格納したりしてもよい。選択される状況ラベル19は、各時間区間に対して1個でもよいし、複数個でもよい。また、各時間区間において尤もらしさが閾値を超えたすべての状況を表すラベルを状況ラベル19の列を外部に出力したり、記憶部1103に格納したりしてもよい。

行動−状況生成モデル12および状況−音響イベント生成モデル13の算出は、入力されたラベル付き音響信号列11の音響イベントの時系列の並びにおける、行動の候補に対応する音響イベントの組み合わせと、行動の候補の時系列の並びと、行動の候補に対応する状況の候補の組み合わせと、の同時事後確率を最大化する処理を用いて行われる。例えば、マルコフ連鎖モンテカルロ法(MCMC法:Markov Chain Monte Carlo methods)や変分ベイズ法(VB法:Variational Bayes methods)などの手法を用いることができる。MCMC法には,M−Hアルゴリズムやギブスサンプリングなどの手法がある。ここでは一例としてギブスサンプリングによる生成モデルの算出手法を説明する。

(i)モデル化部1102は、ハイパパラメータとしてパラメータα,β’ならびにγおよび/またはγ’を事前に決定する。

(ii)モデル化部1102は、全てのラベル付き音響信号列11−s(ただしs=1,...,S)の全ての要素番号iに対応する要素に行動の候補xiをランダムに割り当てる(割り当てはラベル付き音響信号列11−sに与えられた行動ラベル候補が表す行動の候補からランダムに行う)。あるいは、要素番号iに対応する要素への行動の候補xiの割り当ては、事前にモデル化部1102に設定しておいた割り当てであってもよい。

(iii)モデル化部1102は、全てのラベル付き音響信号列11−s(ただしs=1,...,S)の各要素番号i(要素番号i−1またはi+1に対応する要素が存在しない要素番号iを除く)について、以下の(iii-a)および(iii-b)を交互に、規定の回数(正値であり、例えば1〜3000回程度)、もしくは、所望の結果が得られるまで(例えば、割り当ての前後において、行動の割り当て先の変化が一定の閾値(例えば0.3%)以下になるまでなど)繰り返す。

(iii-a)は以下の(iii-a-1)および(iii-a-2)からなる。

(iii-a-1)モデル化部1102は、以下の式(23a−1)〜(23a−3)の何れかにより、更新対象のラベル付き音響信号列の要素番号iを除いた要素番号に対応する音響信号列に対して、要素番号iの要素に行動の候補aに割り当てられる確率分布P(x

i=a|x

−i,e,Ω,α,γ),P(x

i=a|x

−i,z

−i,e,Ω,α,γ’),P(x

i=a|x

−i,z

−i,e,Ω,α,γ,γ’)の何れかを更新する。

ただし、C

ta TAは更新対象のラベル付き音響信号列(初期値はラベル付き音響信号列11)で状況の候補tに行動の候補aが割り当てられた回数を表す。z

−iは要素番号i以外の要素番号に対応する状況からなる列を表す。なお、表記制約上の都合から「C

ta TA」と表記するが、本来は式(23a−1)〜(23a−3)に示すように「C

ta TA」の「TA」は「ta」の上に表記される。R

zi zi+1は、更新対象のラベル付き音響信号列に対応するすべて状況の候補の並びの中で、状況の候補z

i=t∈Ω”={1,・・・,T}と同一の候補から行動の候補z

i+1と同一の候補に遷移した回数を表す。その他は、前述の式(3)に用いた記号の定義と同じである。

(iii-a-2)モデル化部1102は、上記の更新式(23a−1)〜(23a−3)の何れかで得られた確率分布P(xi=a|x−i,e,Ω,α,γ),P(xi=a|x−i,z−i,e,Ω,α,γ’),P(xi=a|x−i,z−i,e,Ω,α,γ,γ’)の何れかに従って、各要素番号iの要素に割り当てる行動の候補xiをサンプリング(選択)する。モデル化部1102は、このようにサンプリングした行動の候補xiを要素番号iの要素に割り当て、要素番号iに対応する行動の候補を更新する。これにより更新対象のラベル付き音響信号列を更新する。

(iii-b-1)モデル化部1102は、以下の式により、更新対象のラベル付き音響信号列の要素番号iを除いた要素番号に対応する音響信号列に対して、要素番号iに対応する音響イベントが状況の候補tに割り当てられる確率分布P(z

i=t|z

−i,e,Ω,α,β’)を更新する。

ただし、C

εt ETは更新対象のラベル付き音響信号列で音響イベントεに状況の候補tが割り当てられた回数を表す。その他は、前述の式(23a−1)〜(23a−3)に用いた記号の定義と同じである。

(iii-b-2)モデル化部1102は、上記の更新式(23b)で得られた確率分布P(zi=t|z−i,e,Ω,α,β’)に従って、各要素番号iの要素に割り当てる状況の候補をサンプリング(選択)する。モデル化部1102は、このようにサンプリングした状況の候補を各要素番号iの要素に割り当て、更新対象のラベル付き音響信号列を更新する。

(iv)モデル化部1102は、上記の(iii−a)(iii−b)の繰り返しによって最終的に得られたC

εt ET,C

ta TAならびにR

xi xi+1および/またはR

zi zi+1を用い、以下を計算する。なお、式(26−1)および(26−2)の両方が計算されてもよいし、その何れか一方のみが計算されてもよい。

これによってモデル化部1102は、状況が音響イベントを生成する確率φεt(ただし、t∈{1,・・・,T},ε∈{1,・・・,E})の集合を得、それを状況−音響イベント生成モデル13とする。例えばモデル化部1102は、確率φεtを(t,ε)要素とするT×E行列を状況−音響イベント生成モデル13とする。また、モデル化部1102は、行動が状況を生成する確率θta(ただし、a∈{1,・・・,A},t∈{1,・・・,T})の集合を得、それを行動−状況生成モデル12とする。例えばモデル化部1102は、確率θtaを(a,t)要素とするA×T行列を行動−状況生成モデル12とする。また、モデル化部1102は、これによって行動の候補の遷移確率πxi xi+1(ただし、xi,xi+1∈{1,・・・,A})の集合を得、それを行動遷移モデル17としてもよい。例えばモデル化部102は、xi,xi+1∈{1,・・・,A}に対応する遷移確率πxi xi+1を(xi,xi+1)要素とするA×A行列を行動遷移モデル17とする。また、モデル化部1102は、これによって行動の候補の遷移確率π’zi zi+1(ただし、zi,zi+1∈{1,・・・,T})の集合を得、それを状況遷移モデルとしてもよい。例えばモデル化部102は、zi,zi+1∈{1,・・・,T}に対応する遷移確率π’zi zi+1を(zi,zi+1)要素とするT×T行列を状況遷移モデルとする。

或いは、モデル化部1102は、(iii-b-1)の繰り返し処理時に、式(23b)の算出過程で確率φεtおよび確率θtaをそれぞれ1個以上サンプリング(計算)し、式(24)(25)に代えて、サンプリングされた確率φεtの平均値および確率θtaの平均値を用い、状況−音響イベント生成モデル13および行動−状況生成モデル12を得てもよい。同様に、モデル化部1102は、(iii-1)の繰り返し処理時に、式(23a−1)〜(23a−3)の算出過程で遷移確率πxi xi+1を1個以上サンプリング(計算)し、式(26−1)に代えて、サンプリングされた遷移確率πxi xi+1の平均値を用い、行動遷移モデル17を得てもよい。同様に、モデル化部1102は、(iii-1)の繰り返し処理時に、式(23a−1)〜(23a−3)の算出過程で遷移確率π’zi zi+1を1個以上サンプリング(計算)し、式(26−2)に代えて、サンプリングされた遷移確率π’zi zi+1の平均値を用い、状況遷移を得てもよい。

さらにモデル化部1102は、以下のように周辺化することで、行動の候補a(ただし、a∈{1,・・・,A})がラベル付き音響信号列11−sに与えられた音響イベントの列e’

sを生成する確率P(e’

s|Θ,Φ,Ω)の集合を得、これらに対応する行動−音響イベント生成モデル14を得てもよい。

ただし、εは要素番号iに対応する音響イベント、a

iは要素番号iに対応する行動の候補を表す。

また、上記更新過程でサンプリング(選択)し、各要素番号iの要素に割り当てた行動の候補xiを分析することで、各ラベル付き音響信号列11−sの音響信号列がどの行動によって生成されたかを知ることができる。モデル化部1102は、このように各要素番号iの要素に割り当てた行動の候補xiを表すラベル、またはそれらの一部を行動ラベル18として出力してもよい。

また、上記更新過程でサンプリング(選択)し、各要素番号iの要素に割り当てた状況の候補ziを分析することで、各ラベル付き音響信号列11−sの音響信号列がどの状況によって生成されたかを知ることができる。モデル化部1102は、このように各要素番号iの要素に割り当てた状況の候補ziを表すラベル、またはそれらの一部を状況ラベル19として出力してもよい。

本実施例では、行動が音響イベントを生成する確率のみではなく、行動の時間遷移確率および/または状況の時間遷移確率も考慮して学習処理を行うことで、遷移確率によって特徴付けられる行動やそれに対応する状況を精度よくモデル化できる。また、遷移確率によって特徴付けられる行動やそれに対応する状況を精度よく分析できる。

<実施例(2)−1−2:図14>

[行動ラベル候補付き音響信号列から行動−音響イベント生成モデル、状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出し、行動や状況を分析]

本実施例では、行動ラベル候補付き音響信号列15−1,・・・,15−Sを入力とし、行動の時間変化および/または状況の時間変化を考慮に入れ、状況−音響イベント生成モデル13を算出する。すなわち、本実施例では、音響信号から音響特徴量を得、得られた音響特徴量を用いて音響イベントを決定し、それによって音響イベントラベル列を得てから学習処理を行い、状況−音響イベント生成モデル13を算出する。この際、行動−状況生成モデル12を算出してもよいし、状況の時間遷移を表す状況遷移モデルを算出してもよいし、行動−音響イベント生成モデル14を算出してもよいし、行動遷移モデル17を算出してもよいし、行動や状況の分析を行ってもよい。

図14に例示するように、本実施例のモデル処理装置1110は、特徴量算出部111、音響イベント判定部112、音響イベントモデルデータベース(DB)113、音響信号列合成部101、モデル化部1102、および記憶部1103を有する。モデル処理装置1110は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず特徴量算出部111に行動ラベル候補付き音響信号列15−1,・・・,15−Sが入力される。特徴量算出部111は、各行動ラベル候補付き音響信号列15−s(ただし、s∈{1,・・・,S})が含む音響信号列から、各行動ラベル候補付き音響信号列15−sに対応する音響特徴量列(ベクトル)を算出して出力する。音響特徴量列の具体例は、実施例(1)−1−2と同じである。

音響イベント判定部112は、実施例(1)−1−2で例示した方法等によって、特徴量算出部111で得られた音響特徴量を用いて各要素番号iに対して音響イベントを決定する。音響イベント判定部112は、各要素番号iに対して決定した音響イベントを表す音響イベントラベルを、行動ラベル候補付き音響信号列15−sの各要素番号iの要素に付与する。音響イベント判定部112は、この処理を入力された行動ラベル候補付き音響信号列15−1,・・・,15−Sのすべての要素(すべての要素番号i)について行い、その結果得られる音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sは、音響信号列合成部101に入力される。以降の処理は実施例(2)−1−1と同じである。

なお、音響信号列合成部101で音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sの合成処理を行うことに代えて、特徴量算出部111の前段で行動ラベル候補付き音響信号列15−1,・・・,15−Sの合成処理を行っても良いし、音響イベント判定部112の前段で音響特徴量列の合成処理を行っても良い。

<実施例(2)−1−3:図15>

[行動ラベル候補付き音響特徴量から行動−音響イベント生成モデル、状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出し、行動や状況を分析]

本実施例では、行動ラベル候補付き音響特徴量列16−1,・・・,16−Sを入力とし、行動の時間変化および/または状況の時間変化を考慮に入れ、状況−音響イベント生成モデル13を算出する。すなわち、本実施例では、入力された音響特徴量を用いて音響イベントを決定し、それによって音響イベントラベル列を得てから学習処理を行い、状況−音響イベント生成モデル13を算出する。この際、行動−状況生成モデル12を算出してもよいし、行動−音響イベント生成モデル14を算出してもよいし、行動遷移モデル17を算出してもよいし、状況の時間遷移を表す状況遷移モデルを算出してもよいし、行動や状況の分析を行ってもよい。

図15に例示するように、本実施例のモデル処理装置1120は、音響イベント判定部112、音響イベントモデルデータベース(DB)113、音響信号列合成部101、モデル化部1102、および記憶部1103を有する。モデル処理装置1120は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響イベント判定部112に、行動ラベル候補付き音響特徴量列16−1,・・・,16−Sが入力される。音響イベント判定部112は、実施例(1)−1−2で例示した方法等によって、音響特徴量列16−1,・・・,16−Sを用いて各要素番号iに対して音響イベントを決定する。音響イベント判定部112は、各要素番号iに対して決定した音響イベントを表す音響イベントラベルを、行動ラベル候補付き音響信号列16−sの各要素番号iの要素に付与する。音響イベント判定部112は、この処理を入力された行動ラベル候補付き音響信号列16−1,・・・,16−Sのすべての要素(すべての要素番号i)について行い、その結果得られる音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sは、音響信号列合成部101に入力される。以降の処理は実施例(2)−1−1と同じである。

なお、音響信号列合成部101で音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sの合成処理を行うことに代えて、音響イベント判定部112の前段で音響特徴量列の合成処理を行っても良い。

<実施例(2)−2−1:図16>

[音響イベントラベル付き音響信号列から行動や状況を推定]

本実施例では、実施例(2)−1−1〜(2)−1−3で説明したように得られた行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14および/または行動遷移モデル17および/または状況遷移モデルを用い、新たに入力された音響イベントラベル付き音響信号列から行動や状況を推定する。

図16に例示するように、本実施例のモデル処理装置1200は、記憶部1103および生成モデル比較部1201を有する。モデル処理装置1200は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず生成モデル比較部1201に音響イベントラベル付き音響信号列21が入力される。生成モデル比較部1201は、入力された音響イベントラベル付き音響信号列21と、記憶部1103に格納された行動−状況生成モデル12、状況−音響イベント生成モデル13、および行動−音響イベント生成モデル14および/または行動遷移モデル17および/または状況遷移モデルとを比較し、音響イベントラベル付き音響信号列21に対し、最も適切であると判断した行動や状況、又は最も適切なものから順番に複数個の行動や状況を決定し、それらを推定結果として出力する。以下に音響イベントラベル付き音響信号列21と各生成モデルとの比較方法を例示する。

[比較方法の例(2)−1]

音響イベントの分布と、行動の候補に対応する確率P(音響イベント|行動の候補)で表される音響イベントの分布との近さに基づいて、行動が推定されてもよい。この具体例は、実施例(1)−2−1の[比較方法の例(1)−1]で説明した通りである。

また、第2音響イベントの分布と、状況の候補に対応する確率P(音響イベント|状況の候補)で表される音響イベントの分布との近さに基づいて、状況が推定されてもよい。この場合、生成モデル比較部1201は、式(14)のp(ε)と状況−音響イベント生成モデル13とを[比較方法の例(1)−1]と同様な方法を用いて比較することにより、入力された音響イベントラベル付き音響信号列21の状況を推定することもできる。例えば、式(15)又は(16)を用いる場合、生成モデル比較部1201は、P(ε)にp(ε)(ただし、ε∈{1,・・・,E})を代入し、Q(ε)に式(24)のφεt(ただし、ε∈{1,・・・,E),t∈{1,・・・,T})を代入する。これにより、生成モデル比較部1201は、各状況t∈{1,・・・,T}に対応する情報量(合計T個の情報量)を得る。生成モデル比較部1201は、各状況t∈{1,・・・,T}について算出された情報量のうち、最も小さな情報量に対応する状況、又は、最も小さな情報量から順番に選択した複数個の情報量に対応する複数個の状況を、音響イベントラベル付き音響信号列21に対応する状況として決定して出力する。なお、状況の探索範囲は予め定められたものであってもよいし、音響イベントラベル付き音響信号列21がこの探索範囲を特定するための情報を含み、この情報によって探索範囲が定められてもよい。探索範囲を特定するための情報の例は、状況の候補の総数Tである。このような状況の候補の総数Tは、要素番号毎に特定されてもよいし、複数の要素番号に対して共通であってもよい。この場合、探索範囲が適切に設定されていれば状況の推定精度が向上する。

生成モデル比較部1201は、以下のように、状況遷移モデルが表す遷移確率π’

zi−1 ziと前時刻(要素番号i−1の時間区間)の状況推定結果z

i−1を利用して、現時刻(要素番号iの時間区間)の状況z

i=tを推定しても良い。

[比較方法の例(2)−2]

音響イベントラベル付き音響信号列21が有する音響イベントの時系列の並びに対する、確率P(音響イベント|行動の候補)のもとでの行動の候補の尤もらしさに基づいて、行動が推定されてもよい。この具体例は、実施例(1)−2−1の[比較方法の例(1)−2]で説明した通りである。

音響イベントラベル付き音響信号列21が有する音響イベントの時系列の並びに対する、確率P(音響イベント|状況の候補)のもとでの状況の候補の尤もらしさに基づいて、状況が推定されてもよい。ここでも前述のように、状況の探索範囲は予め定められたものであってもよいし、音響イベントラベル付き音響信号列21がこの探索範囲を特定するための情報(例えば、状況の候補の総数)を含み、この情報によって探索範囲が定められてもよい。

以下に具体例を示す。以下の例では、入力されたラベル付き音響信号列21に対し、状況−音響イベント生成モデル13のもとでの状況の尤度の和や積を求める。

≪状況−音響イベント生成モデル13のもとでの状況の尤度の和の例≫

≪状況−音響イベント生成モデル13のもとでの状況の尤度の積の例≫

ただし、式(28)(29)のeiは、入力された音響イベントラベル付き音響信号列21の要素番号iに対応する音響イベントラベルが表す音響イベントを表す。式(28)(29)は、式(24)(25)(27)の確率φεt,θta,P(e’s|Θ,Φ,Ω)と、入力された音響イベントラベル付き音響信号列21のeiとから算出できる。

状況の探索範囲が予め定められたものである場合には、その探索範囲に属する各状況の候補tについて上記の尤度が算出され、状況の探索範囲が音響イベントラベル付き音響信号列21に含まれる情報(例えば、状況の候補の総数等)によって特定される場合には、その探索範囲に属する各状況の候補tについて上記の尤度が算出される。生成モデル比較部1201は、各状況の候補について算出した尤度のうち、最も尤度の高い状況の候補、又は、最も尤度の高いものから順番に選択した複数個の状況の候補を、入力された音響イベントラベル付き音響信号列21に対応する状況として決定して出力する。

生成モデル比較部1201は、以下のように、行動−音響イベント生成モデル14のもとでの状況の尤度の和や積および、状況遷移モデルが表す遷移確率π’zi−1 ziと前時刻(要素番号i−1の時間区間)の状況推定結果zi−1を利用して、現時刻(要素番号iの時間区間)の状況zi=tを推定しても良い

≪行動−音響イベント生成モデル14のもとでの状況の尤度の和および、状況遷移モデルと前時刻の状況推定結果を利用する場合の例≫

≪行動−音響イベント生成モデル14のもとでの状況の尤度の積および、状況遷移モデルと前時刻の状況推定結果を利用する場合の例≫

なお、上述の行動を決定する処理と状況を決定する処理とが、互いに異なる処理部で実行されてもよい。

<実施例(2)−2−2:図17>

[音響信号列から行動および状況を推定]

本実施例では、実施例(2)−1−1〜(2)−1−3で説明したように得られた行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14および/または行動遷移モデル17および/または状況遷移モデルを用い、新たに入力された音響信号列から行動や状況を推定する。

図17に例示するように、本実施例のモデル処理装置1210は、特徴量算出部211、音響イベント判定部212、音響イベントモデルDB113、記憶部1103、生成モデル比較部1201を有する。モデル処理装置1210は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず特徴量算出部211に音響信号列22が入力される。特徴量算出部211は、音響信号列22から音響特徴量列(ベクトル)を算出して出力する。例えば特徴量算出部211は、前述した特徴量算出部111と同じ方法で音響特徴量列を算出する。

音響イベント判定部212は、前述した音響イベント判定部112と同じ方法で、特徴量算出部211から出力された音響特徴量列と、音響イベントモデルDB113に記憶されている複数の音響イベントモデルとをそれぞれ比較し、音響信号列22の全ての要素について音響イベントを決定する。音響イベント判定部212は、決定した音響イベントを表す音響イベントラベルを音響信号列22の各要素に付することで、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベル付き音響信号列21は、生成モデル比較部1201に入力される。以降の処理は実施例(2)−2−1と同じである。

<実施例(2)−2−3:図18>

[音響特徴量から行動や状況を推定]

本実施例では、実施例(2)−1−1〜(2)−1−3で説明したように得られた行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14、および/または行動遷移モデル17および/または状況遷移モデルを用い、新たに入力された音響特徴量列から行動や状況を推定する。

図18に例示するように、本実施例のモデル処理装置1220は、音響イベント判定部212、音響イベントモデルDB113、記憶部1103、生成モデル比較部1201を有する。モデル処理装置1220は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響イベント判定部212に音響特徴量列23が入力される。音響イベント判定部212は、前述した音響イベント判定部112と同じ方法で、音響特徴量列23の音響特徴量列と、音響イベントモデルDB113に記憶されている複数の音響イベントモデルとをそれぞれ比較し、音響特徴量列23が含む音響信号列の全ての要素について音響イベントを決定する。音響イベント判定部212は、決定した各要素の音響イベントを表す音響イベントラベルを、音響特徴量列23が含む音響信号列に付することで、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベル付き音響信号列21は、生成モデル比較部1201に入力される。以降の処理は実施例(2)−2−1と同じである。

<実施例(2)−3−1:図19>

[音響イベントラベル付き音響信号列から行動や状況を推定すると共に,音響イベントラベルおよび行動ラベル候補付き音響信号列から行動−音響イベント生成モデル、状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出]

本実施例は実施例(2)−1−1と実施例(2)−2−1の組み合わせである。本実施例では、音響イベントラベル付き音響信号列21を入力として行動や状況を推定することに加え、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを入力とし、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14の少なくとも何れかの算出も行う。さらに行動遷移モデル17や行動ラベル18や状況ラベル19の生成を行ってもよい。さらに、推定された行動を表す行動ラベル候補を、音響イベントラベル付き音響信号列21が含む音響信号列の各要素に付与することで、音響イベントラベルおよび行動ラベル候補付き音響信号列を得、それを生成モデルの更新に利用することもできる。

図19に例示するように、本実施例のモデル処理装置1300は、記憶部1103,1303、音響信号列合成部101、モデル化部1102、および生成モデル比較部1201を有する。モデル処理装置1300は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

記憶部303には、前述した音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、および前述した音響イベントラベル付き音響信号列21が格納されている。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sは音響信号列合成部101に入力される。音響信号列合成部101およびモデル化部1102は、実施例(2)−1−1で説明したように、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sから、行動−状況生成モデル12、状況−音響イベント生成モデル13、および行動−音響イベント生成モデル14の少なくとも何れかを生成し、それらを記憶部1103に格納する。また、実施例(2)−1−1で説明したように、モデル化部1102が行動遷移モデル17を生成して記憶部1103に格納してもよいし、行動ラベル18を生成して記憶部103に格納してもよいし、状況ラベル19を生成して記憶部1103に格納してもよい。

音響イベントラベル付き音響信号列21は生成モデル比較部1201に入力される。音響イベントラベル付き音響信号列21は、実施例(2)−2−1で説明したように、入力された音響イベントラベル付き音響信号列21と、記憶部1103に格納された行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14、および/または行動遷移モデル17および/または状況遷移モデルとを比較し、音響イベントラベル付き音響信号列21に対し、最も適切であると判断した行動や状況、又は最も適切なものから順番に複数個の行動や状況を選択し、それらを推定結果として出力する。

さらに生成モデル比較部1201は、決定した行動を表す行動ラベル候補を、音響イベントラベル付き音響信号列21の対応する各要素に付与し、それによって新たな音響イベントラベルおよび行動ラベル候補付き音響信号列21’を生成して出力してもよい。この場合、音響イベントラベルおよび行動ラベル候補付き音響信号列21’が、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sとともに音響信号列合成部101に入力されてもよい。この場合、音響信号列合成部101は、入力されたすべての音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S,21’を時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベルおよび行動ラベル候補付き音響信号列11’(「第3音響イベントラベル列」および「第3行動ラベル候補」)を得て出力する。モデル化部1102は、実施例(2)−1−1のラベル付き音響信号列11(「音響イベントラベル列」および「行動ラベル候補」)に代えて、音響イベントラベルおよび行動ラベル候補付き音響信号列11’(「第3音響イベントラベル列」および「第3行動ラベル候補」)を用い、再度、実施例(2)−1−1で説明したように、行動−状況生成モデル12、状況−音響イベント生成モデル13、および行動−音響イベント生成モデル14の少なくとも何れかを生成し、それを記憶部1103に格納する。さらにモデル化部1102が、ラベル付き音響信号列11に代えて、入力された音響イベントラベルおよび行動ラベル候補付き音響信号列11’を用い、再度、実施例(2)−1−1で説明したように、行動遷移モデル17を生成して記憶部1103に格納してもよいし、行動ラベル18や状況ラベル19を生成して記憶部1103に格納してもよい。

また、生成モデル比較部1201の処理およびモデル化部1102の処理のどちらを先に行っても良い。ただし、モデル化部1102の処理を行う前に生成モデル比較部1201の処理を行う場合、記憶部1103に予め得られた各生成モデルおよび/または行動遷移モデル17および/または状況遷移モデルが格納されている必要がある。

また、音響イベントラベルおよび行動ラベル候補付き音響信号列21’が、新たに入力された音響イベントラベルおよび行動ラベル候補付き音響信号列とともに音響信号列合成部101に入力されてもよい。音響信号列合成部101は、これらを時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベルおよび行動ラベル候補付き音響信号列(「第3音響イベントラベル列」および「第3行動ラベル候補」)を得て、モデル化部1102に送出してもよい。

その他の処理は実施例(2)−1−1および実施例(2)−2−1と同様とする。

<実施例(2)−3−2:図20>

[音響信号列から行動,状況を推定すると共に,行動ラベル候補付き音響信号列から行動−音響イベント生成モデル、状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出]

本実施例は、実施例(2)−1−2と実施例(2)−2−2の組み合わせである。

本実施例では、行動ラベル候補付き音響信号列15−1,・・・,15−Sを入力として、学習によって、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14の少なくとも何れかを算出する。さらに行動遷移モデル17や行動ラベル18や状況ラベル19の生成を行ってもよい。さらに本実施例では、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14、および/または行動遷移モデル17および/または状況遷移モデルを用い、新たに入力された音響信号列22から行動や状況を推定する。

図20に例示するように、本実施例のモデル処理装置1310は、特徴量算出部111−1,・・・,111−S,211、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および前述のモデル処理装置1300(図19参照)を有する。

行動ラベル候補付き音響信号列15−1,・・・,15−Sは、それぞれ特徴量算出部111−1,・・・,111−Sに入力される。特徴量算出部111−1,・・・,111−Sは、実施例(1)−1−2で説明したように、行動ラベル候補付き音響信号列15−1,・・・,15−Sから、それぞれ音響特徴量列を得て出力する。音響イベント判定部112−1,・・・,112−Sは、それぞれ、前述の音響イベント判定部112と同様に、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを生成して出力する。

音響信号列22は特徴量算出部211に入力される。特徴量算出部211は、実施例(1)−2−2で説明したように、音響信号列22から音響特徴量列(ベクトル)を算出して出力する。音響イベント判定部212は、実施例(1)−2−2で説明したように、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21は、記憶部1303(図19)に格納される。以降の処理は実施例(2)−3−1と同じである。

<実施例(2)−3−3:図21>

[音響特徴量から行動や状況を推定すると共に,行動ラベル候補付き音響信号列から行動−音響イベント生成モデル、状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出]

本実施例は、実施例(2)−1−3と実施例(2)−2−3の組み合わせである。

本実施例では、行動ラベル候補付き音響特徴量列16−1,・・・,16−Sを入力として、学習によって、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14の少なくとも何れかを算出する。行動遷移モデル17や行動ラベル18や状況ラベル19の生成を行ってもよい。さらに本実施例では、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14を用い、新たに入力された音響特徴量列23から行動や状況を推定する。

図21に例示するように、本実施例のモデル処理装置1320は、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および前述のモデル処理装置1300(図19参照)を有する。

行動ラベル候補付き音響特徴量列16−1,・・・,16−Sは、それぞれ音響イベント判定部112−1,・・・,112−Sに入力される。音響イベント判定部112−1,・・・,112−Sは、それぞれ、前述の音響イベント判定部112と同様に、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sを生成して出力する。

音響特徴量列23は音響イベント判定部212に入力される。音響イベント判定部212は、実施例(1)−2−3と同様に、入力された音響特徴量列23の音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列21を生成して出力する。

音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21は、記憶部303(図19)に格納される。以降の処理は実施例(2)−3−1と同じである。

<実施例(2)−4−1:図22>

[音響イベントラベル付き音響信号列から行動,状況を推定すると共に,音響イベントラベルおよび行動ラベル候補付き音響信号列から行動−音響イベント生成モデル状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出。特別なシンボルを用いる]

本実施例は実施例(2)−3−1の変形である。

本実施例では、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、および音響イベントラベル付き音響信号列21を入力とし、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14の少なくとも何れかを算出する。また行動遷移モデル17の生成や行動や状況の推定を行ってもよい。さらに、推定された行動を表す行動ラベル候補を、音響イベントラベル付き音響信号列21が含む音響信号列の各要素に付与することで、音響イベントラベルおよび行動ラベル候補付き音響信号列を得、それを生成モデルの更新に利用することもできる。

図22に例示するように、本実施例のモデル処理装置1400は、記憶部1103、1303、音響信号列合成部401、モデル化部1402、および生成モデル比較部1403を有する。モデル処理装置1400は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

音響信号列合成部401に、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sおよび音響イベントラベル付き音響信号列21が入力される。音響信号列合成部401は、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21を時系列方向につなぎ合わせ、それによって1つの音響イベントラベルおよび行動ラベル候補付き音響信号列41(以下、単に「ラベル付き音響信号列41」という)を得て出力する。実施例(1)−4−1で説明したように、ラベル付き音響信号列41が含む音響イベントの時系列の並びは、行動ラベル候補によって行動の候補が表された第4音響イベントの時系列の並び、および行動ラベル候補によって行動の候補が表されていない第5音響イベントの時系列の並びを含む。ラベル付き音響信号列41は、モデル化部1402に入力される。なお、予め、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21からラベル付き音響信号列41が得られている場合には、音響信号列合成部401を経由することなく、ラベル付き音響信号列41がそのままモデル化部1402に入力されてもよい。

モデル化部1402は、実施例(2)−1−1のラベル付き音響信号列11に代えて、ラベル付き音響信号列41を用い、実施例(2)−1−1のモデル化部1102と同じ方法で、行動−状況生成モデル12、状況−音響イベント生成モデル13、および行動−音響イベント生成モデル14の少なくとも何れかを算出する。行動遷移モデル17や行動ラベル18の生成を行ってもよい。ただし、モデル化部1402は、実施例(1)−4−1のモデル化部402と同様、上述の「第5音響イベント」を生じさせた行動の候補として特別なシンボルを用いて学習処理を行う。

すなわちモデル化部1402は、状況の候補が音響イベントを生成する確率P(音響イベント|状況の候補)、行動の候補が状況の候補を生成する確率P(状況の候補|行動の候補)、およびこの特別なシンボルが状況の候補を生成する確率P(状況の候補|特別なシンボル)を得る。またモデル化部1402は、確率P(音響イベント|状況の候補)と確率P(状況の候補|行動の候補)とから、行動の候補が音響イベントを生成する確率P(音響イベント|行動の候補)を得、確率P(音響イベント|状況の候補)と確率P(状況の候補|特別なシンボル)とから、特別なシンボルが音響イベントを生成する確率P(音響イベント|特別なシンボ)を得る。行動−状況生成モデル12は、確率P(状況の候補|行動の候補),P(状況の候補|特別なシンボル)に対応し、状況−音響イベント生成モデル13は、確率P(音響イベント|状況の候補)に対応し、行動−音響イベント生成モデル14は、確率P(音響イベント|行動の候補),P(音響イベント|特別なシンボル)に対応する。モデル化部1402で算出された、行動−状況生成モデル12、状況−音響イベント生成モデル13、および行動−音響イベント生成モデル14は、記憶部1103に格納される。行動遷移モデル17や行動ラベル18や状況ラベル19の生成を行った場合には、それらも記憶部103に格納される。

生成モデル比較部1403には、行動−音響イベント生成モデル14および/または行動遷移モデル17が入力される。生成モデル比較部1403は、入力された行動−音響イベント生成モデル14に対応する、確率P(音響イベント|行動)と確率P(音響イベント|特別なシンボル)とを比較し、特別なシンボルに対応する行動の内容を推定し、それらの推定結果を出力する。また、生成モデル比較部1403は、入力された行動遷移モデル17に対応する、遷移確率P(現時刻の行動の候補|前時刻の行動の候補)と遷移確率P(特別なシンボル|前時刻の行動の候補)とを比較し、特別なシンボルに対応する行動の内容を推定し、それらの推定結果を出力してもよい。例えば、生成モデル比較部1403は、音響イベントラベル付き音響信号列21に対し、最も適切であると判断した行動、又は最も適切なものから順番に複数個の行動を選択し、それらを推定結果として出力する。

[比較方法の例示]

生成モデル比較部1403による比較は、例えば、実施例(1)−2−1で説明した情報量基準に基づいて行うことができる。例えば、式(15)又は(16)の情報量基準を用い、確率P(音響イベント|行動の候補)と確率P(音響イベント|特別なシンボル)とを比較する場合、生成モデル比較部1403は、P(ε)に特別なシンボルai=a’∈{1,・・・,A}に対応する式(27)の確率(ただし、εi=ε∈{1,・・・,E)}を代入し、Q(ε)に他の行動ai=a’’≠a’(ただし、a’’∈{1,・・・,A})に対応する式(27)の確率(ただし、εi=ε∈{1,・・・,E))を代入する。これにより、生成モデル比較部1403は、他の行動a’’≠a’(ただし、a’’∈{1,・・・,A})に対応する情報量(合計A−1個の情報量)を得る。

生成モデル比較部1403は、各行動a’’について算出された情報量のうち、最も小さな情報量に対応する行動の候補、又は、最も小さな情報量から順番に選択した複数個の情報量に対応する複数個の行動の候補を、音響イベントラベル付き音響信号列21に対応する行動として決定して出力する。

生成モデル比較部1403は、以上のように決定した行動を表す行動ラベル候補を、音響イベントラベル付き音響信号列21の対応する各要素に付与し、それによって新たな音響イベントラベルおよび行動ラベル候補付き音響信号列41’を生成して出力してもよい。この場合、音響イベントラベルおよび行動ラベル候補付き音響信号列41’が、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−Sとともに音響信号列合成部401に入力されてもよい。この場合、音響信号列合成部401は、入力されたすべての音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S,41’を時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベルおよび行動ラベル候補付き音響信号列41’’を得て出力する。モデル化部1402は、実施例(2)−1−1のラベル付き音響信号列11に代えて、音響イベントラベルおよび行動ラベル候補付き音響信号列41’’を用い、再度、実施例(2)−1−1で説明したように、行動−状況生成モデル12、状況−音響イベント生成モデル13、および行動−音響イベント生成モデル14の少なくとも何れかを生成し、それを記憶部1103に格納する。さらにモデル化部1402が、入力された音響イベントラベルおよび行動ラベル候補付き音響信号列41’’を用い、再度、実施例(2)−1−1で説明したように、行動遷移モデル17を生成して記憶部1103に格納してもよいし、行動ラベル18や状況ラベル19を生成して記憶部1103に格納してもよい。

また、音響イベントラベルおよび行動ラベル候補付き音響信号列21’が、新たに入力された音響イベントラベルおよび行動ラベル候補付き音響信号列とともに音響信号列合成部401に入力されてもよい。音響信号列合成部401は、これらを時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベルおよび行動ラベル候補付き音響信号列を得て、モデル化部1402に送出し、モデル化部102が上述の処理を行ってもよい。

その他の処理は実施例(2)−1−1、実施例(2)−2−1、および実施例(2)−3−1と同じである。

<実施例(2)−4−2:図20>

[音響信号列から行動、状況を推定すると共に、行動ラベル候補付き音響信号列から行動−音響イベント生成モデル、状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出。特別なシンボルを用いる]

本実施例は実施例(2)−3−2の変形である。

本実施例では、行動ラベル候補付き音響信号列15−1,・・・,15−Sおよび音響信号列22を入力として、学習によって、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14の少なくとも何れかを算出する。さらに行動遷移モデル17や行動ラベル18の生成を行ってもよい。さらに本実施例では、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14を用い、音響信号列22に対応する行動や状況を推定する。

図20に例示するように、本実施例のモデル処理装置1410は、特徴量算出部111−1,・・・,111−S,211、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および前述のモデル処理装置1400(図22参照)を有する。

行動ラベル候補付き音響信号列15−1,・・・,15−Sは、それぞれ特徴量算出部111−1,・・・,111−Sに入力され、音響信号列22は特徴量算出部211に入力される。特徴量算出部111−1,・・・,111−S,211、音響イベント判定部112−1,・・・,112−S,212は、実施例(2)−3−2で説明したように、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21を生成して出力する。音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21は、記憶部1303(図22)に格納される。以降の処理は実施例(2)−4−1と同じである。

<実施例(2)−4−3:図21>

[音響特徴量から行動,状況を推定すると共に,行動ラベル候補付き音響信号列から行動−音響イベント生成モデル、状況−音響イベント生成モデル、行動−状況生成モデル、および行動遷移モデルを算出。特別なシンボルを用いる]

本実施例は実施例(2)−3−3の変形である。

本実施例では、行動ラベル候補付き音響特徴量列16−1,・・・,16−Sおよび音響特徴量列23を入力として、学習によって、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14の少なくとも何れかを算出する。行動遷移モデル17や行動ラベル18や状況ラベル19の生成を行ってもよい。さらに本実施例では、行動−状況生成モデル12、状況−音響イベント生成モデル13、行動−音響イベント生成モデル14を用い、音響特徴量列23に対応する行動や状況を推定する。

図21に例示するように、本実施例のモデル処理装置1420は、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および前述のモデル処理装置1400(図22参照)を有する。

行動ラベル候補付き音響特徴量列16−1,・・・,16−Sは、それぞれ音響イベント判定部112−1,・・・,112−Sに入力され、音響特徴量列23は、音響イベント判定部212に入力される。音響イベント判定部112−1,・・・,112−S,212は、実施例(2)−3−3で説明したように、音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21を生成して出力する。音響イベントラベルおよび行動ラベル候補付き音響信号列11−1,・・・,11−S、音響イベントラベル付き音響信号列21は、記憶部1303(図22)に格納される。以降の処理は実施例(2)−4−1と同じである。

<実施例(3)−1−1:図23>

[音響イベントラベル付き音響信号から音響信号-状況生成モデルおよび状況-音響イベントの生成モデルを、状況の時間変化を考慮に入れて算出し、同時に、状況を分析]

本実施例では、状況の時間変化を考慮に入れ、音響イベントラベル付き音響信号から、状況−音響イベント生成モデルを算出する。同時に、音響信号−状況生成モデルを算出してもよく、状況の時間遷移を表す状況遷移モデルを算出してもよく、状況の分析も行ってもよい。

すなわち、本実施例では、各時間区間の音響信号を生じさせた音響イベントの時系列の並びを表す音響イベントラベル列、および音響イベントを生じさせた状況の候補の総数を用い、「音響イベントの時系列の並びにおける、状況の候補に対応する音響イベントの組み合わせと状況の候補の時系列の並びとの同時事後確率」を最大化するための処理を含む学習処理を行う。例えば、この学習処理は、状況の時間遷移に基づく状況の出現確率および、状況における音響イベントの出現確率に基づいて、音響イベントの時系列の並びにおける、状況の候補に対する音響イベントの組み合わせと状況の候補の時系列の並びとの同時事後確率を最大化するための処理である。例えば、音響イベントの時系列の並びからなる音響イベントの組み合わせに対する尤度関数P(音響イベントの組み合わせ|状況の候補の時系列の並び)を最大にする処理が行われる。それにより、状況の候補が音響イベントを生成する確率P(音響イベント|状況の候補)を「状況−音響イベント生成モデル」として得る。また、この学習処理によって、音響信号列が状況を生成する確率P(状況|音響信号列)を「音響信号−状況生成モデル」として得てもよいし、状況の候補の時系列の遷移確率を「状況遷移モデル」として得てもよい。また、この学習処理の過程で何れかの状況の候補を選択し、各音響イベントがどの状況によって生成されたのかを分析してもよい。この場合には選択した状況の候補を表す状況ラベルを出力してもよい。

図23に例示するように、本実施例のモデル処理装置2100は、音響信号列合成部2101、モデル化部2102、および記憶部2103を有する。モデル処理装置2100は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響信号列合成部2101に、音響イベントラベル付き音響信号列2011−1,・・・,2011−S(ただし、Sは1以上の整数)が入力される。各音響イベントラベル付き音響信号列2011−s(ただし、s∈{1,・・・,S})は、時系列の音響信号列2011a−s、各音響信号列2011a−sに対応する音響信号列番号、前述の時間区間ごとに区分された音響信号列の各要素に対応する要素番号、および当該時間区間ごとに決定されて付与された音響イベントラベルを含む。各音響信号列2011a−sは音を表すデジタル信号列である。音響イベントラベルは、音響信号列の各要素に対応する音響イベントを表すラベルであり、音響信号列の要素ごとに付与される。1個の音響信号列番号には、1個以上の要素番号が対応する。

複数個の音響イベントラベル付き音響信号列2011−1,・・・,2011−S(以下、単に「ラベル付き音響信号列2011−1,・・・,2011−S」という)が音響信号列合成部2101に入力された場合、音響信号列合成部2101は、それらを時系列方向につなぎ合わせ、それによって1つの音響イベントラベル付き音響信号列2011(以下、単に「ラベル付き音響信号列2011」という)を得て出力する(合成処理)。音響信号列合成部2101に1つの音響信号列2011−1のみが入力された場合、音響信号列合成部2101はそれをラベル付き音響信号列2011として出力する。音響信号列合成部2101から出力された音響イベントラベル付き音響信号列は、モデル化部2102に入力される。なお、音響信号列合成部2101を経由することなく、1つラベル付き音響信号列2011がそのままモデル化部2102に入力されてもよい。また、ラベル付き音響信号列2011が含む合成された音響信号列2011a−1,・・・,2011a−Sの並びを音響信号列2011aと表記する。

モデル化部2102は、以下の手順に従って、入力されたラベル付き音響信号列2011から、音響信号−状況生成モデル12、および状況−音響イベント生成モデル13の少なくとも何れかを生成し、それらを記憶部2103に格納する。モデル化部102は、状況の候補の遷移を表す状況遷移モデル2017を生成してもよいし、状況ラベル19を生成してもよい。生成された状況遷移モデル2017や状況ラベル19も記憶部2103に格納される。

[状況から音響イベントが生成される過程の論理的説明]

モデル化部2102は、ラベル付き音響信号列2011から、音響信号列が状況の候補を生成する確率P(状況の候補|音響信号列)としたときの音響信号−状況生成モデル12と、状況の候補が音響イベントを生成する確率P(音響イベント|状況の候補)としたときの状況−音響イベント生成モデル13の少なくとも何れかを算出する。つまり本実施例では、音響信号列が潜在的な場の状況の生成確率を規定し、状況が音響イベントの生成確率を規定すると考え、これらの関係を各生成モデルとして記述する。また、状況の候補の時系列の遷移確率を算出し、状況遷移モデル2017を得てもよい。

合成された音響信号列における状況の候補の生成確率Θ’、状況の候補における音響イベントの生成確率Φ’、音響信号列の集合Ω’が与えられた場合における、音響イベントの列eの生成確率P(e|Π’,Θ’,Φ’,Ω’)は以下の通りである。

ただし、Sは合成された音響信号列2011aに含まれる音響信号列2011a−s(ただし、s∈{1,・・・,S})の個数、Tは状況の候補の総数、Eは音響イベントの総数(音響イベントの種類の個数)、eはラベル付き音響信号列2011に与えられた音響イベントの列(ベクトル)、Π’は各時間区間の状況の候補t(ただし、t∈{1,・・・,T})が次の時間区間で状況の候補t’(ただし、t’∈{1,・・・,T})に遷移する確率を(t,t’)要素とするT×T行列、Θ’は音響信号列2011a−s(ただし、s∈{1,・・・,S})が状況の候補t(ただし、t∈{1,・・・,T})を生成する確率P(t|s)を(s,t)要素とするS×T行列、Φ’は状況の候補t(ただし、t∈{1,・・・,T})が音響イベントε(ただし、ε∈{1,・・・,E})を生成する確率P(ε|t)を(t,ε)要素とするT×E行列、e’

sは音響信号列2011a−sに与えられた音響イベントの列(N

s次元ベクトル:N

sは音響信号列2011a−sに対応する音響イベントの個数)、Ω’は音響信号列2011aと成り得る列の集合を表す。

ラベル付き音響信号列2011に対応する状況の候補tの遷移確率π

tの事前分布のパラメータ(Dirichlet分布に従うものとする)γ’、各音響信号列2011a−sにおける状況の候補tの生成確率θ

sの事前分布のパラメータ(Dirichlet分布に従うものとする)α’、状況の候補tにおける音響イベントεの生成確率φ

tの事前分布のパラメータ(Dirichlet分布に従うものとする)β’が与えられたときの、音響イベントの列e’

sの生成確率P(e’

s,Π’,Θ’,Φ’|γ’,α’,β’)は、以下の通りである。

ただし、e

iはラベル付き音響信号列2011−sの要素番号iに対応する音響イベントラベルが表す音響イベント、N

sはラベル付き音響信号列2011−sの要素数(要素番号iの最大値)、z

iは音響信号列2011a−sの要素番号iに対応する音響信号が表す状況の候補、π’

ti−1 tiは音響信号列2011a−sの要素番号i−1に対応する音響信号が表す状況の候補t

i−1から要素番号iに対応する音響信号が表す状況の候補t

iへの遷移確率を表す。また、φ

tは状況の候補tが音響イベントε(ただし、ε∈{1,・・・,E})を生成する確率P(ε|t)をε番目の要素とするE次元ベクトルを表す。θ

sは音響信号列2011a−sが状況の候補t(ただし、t∈{1,・・・,T})を生成する確率P(t|s)をt番目の要素とするT次元ベクトルを表す。

[生成モデルの算出過程の説明]

モデル化部2102は、入力されたラベル付き音響信号列2011から、音響信号列が状況の候補を生成する確率P(状況の候補|音響信号列)を算出し、それを音響信号−状況生成モデル12として記憶部2103に格納する。モデル化部2102は、状況の候補が音響イベントを生成する確率P(音響イベント|状況の候補)を算出し、それを状況−音響イベント生成モデル13として記憶部2103に格納してもよい。また、モデル化部2102は、状況の候補の遷移確率を算出し、それを状況遷移モデル2017として記憶部2103に格納してもよい。

さらにモデル化部2102は、入力されたラベル付き音響信号列2011に対して尤もらしい状況を表す状況ラベル19を選択して外部に出力したり、記憶部2103に格納したりしてもよい。選択される状況ラベル19は、各時間区間に対して1個でもよいし、複数個でもよい。また、各時間区間において尤もらしさが閾値を超えたすべての状況を表すラベルを状況ラベル19の列を外部に出力したり、記憶部2103に格納したりしてもよい。

音響信号−状況生成モデル12および状況−音響イベント生成モデル13の算出は、入力されたラベル付き音響信号列2011の音響イベントの時系列の並びにおける、状況の候補に対応する音響イベントの組み合わせと状況の候補の時系列の並びとの同時事後確率を最大化する処理を用いて行われる。例えば、マルコフ連鎖モンテカルロ法(MCMC法:Markov Chain Monte Carlo methods)や変分ベイズ法(VB法:Variational Bayes methods)などの手法を用いることができる。MCMC法には,M−Hアルゴリズムやギブスサンプリングなどの手法がある。ここでは一例としてギブスサンプリングによる生成モデルの算出手法を説明する。

[生成モデルの算出方法の例示]

(i)モデル化部2102は、ハイパパラメータとしてパラメータα’,β’およびγ’を事前に決定する。

(ii)モデル化部2102は、全ての音響信号列2011a−s(ただしs=1,...,S)の全ての要素番号iに対応する要素に状況の候補tiをランダムに割り当てる。また、要素番号iに対応する要素への状況の候補tiの割り当ては、事前にモデル化部2102に設定しておいた割り当てであってもよい。

(iii)モデル化部2102は、全ての音響信号列2011a−s(ただしs=1,...,S)の各要素番号i(要素番号i−1またはi+1に対応する要素が存在しない要素番号iを除く)について、以下の(iii-1)および(iii-2)を交互に、規定の回数(正値であり、例えば1〜3000回程度)、もしくは、所望の結果が得られるまで(例えば、割り当ての前後において、状況の割り当て先の変化が一定の閾値(例えば0.3%)以下になるまでなど)繰り返す。

(iii-1)モデル化部2102は、以下の式により、更新対象のラベル付き音響信号列の要素番号iを除いた要素番号に対応する音響信号列に対して、要素番号iの要素に状況の候補z

iに割り当てられる確率分布P(z

i|z

−i,e

−i,α’,β’,γ’)を更新する。

ただし、C

εt ETは更新対象のラベル付き音響信号列(初期値はラベル付き音響信号列2011)で音響イベントεに状況tが割り当てられた回数を表し、C

ts TSは更新対象のラベル付き音響信号列で状況tが更新対象の音響信号列(初期値は音響信号列2011a−s)に割り当てられた回数を表す。なお、表記制約上の都合から「C

εt ET」「C

ts TS」と表記するが、本来は式(33)に示すように「C

εt ET」の「ET」は「εt」の上に表記され、「C

ts TS」の「TS」は「ts」の上に表記される。z

−iは要素番号i以外の要素番号に対応する状況からなる列、e

−iは要素番号i以外の要素番号に対応する音響イベントからなる列を表す。また、t

i−1=t

iのときにI(t

i−1=t

i)=1、t

i−1≠t

iのときにI(t

i−1=t

i)=0となり、t

i=t

i+1のときにI(t

i=t

i+1)=1、t

i≠t

i+1iのときにI(t

i=t

i+1)=0となる。

(iii-2)モデル化部2102は、上記の更新式(33)で得られた確率分布P(zi|z−i,e−i,α’,β’,γ’)に従って、各要素番号iの要素に割り当てる状況の候補ziをサンプリング(選択)する。モデル化部2102は、このようにサンプリングした状況の候補ziを要素番号iの要素に割り当て、要素番号iに対応する状況の候補を更新する。これにより更新対象のラベル付き音響信号列を更新する。

(iv)モデル化部2102は、上記の(iii-1)(iii-2)の繰り返しによって最終的に得られたC

εt ET,C

ts TSおよびR

ti ti+1を用い、以下を計算する。

これによってモデル化部2102は、状況が音響イベントを生成する確率φεt(ただし、t∈{1,・・・,T},ε∈{1,・・・,E})の集合を得、それを状況−音響イベント生成モデル13とする。例えばモデル化部2102は、確率φεtを(t,ε)要素とするT×E行列を状況−音響イベント生成モデル13とする。また、モデル化部2102は、音響信号列が状況を生成する確率θts(ただし、s∈{1,・・・,S},t∈{1,・・・,T})の集合を得、それを音響信号−状況生成モデル12とする。例えばモデル化部2102は、確率θtsを(s,t)要素とするS×T行列を音響信号−状況生成モデル12とする。また、モデル化部2102は、これによって状況の候補の遷移確率π’ti ti+1(ただし、ti,ti+1∈{1,・・・,T})の集合を得、それを状況遷移モデル2017とする。例えばモデル化部2102は、ti,ti+1∈{1,・・・,T}に対応する遷移確率π’ti ti+1を(ti,ti+1)要素とするT×T行列を状況遷移モデル2017とする。

或いは、モデル化部2102は、(iii-1)の繰り返し処理時に、式(33)の算出過程で確率φεt,θts,π’ti ti+1をそれぞれ1個以上サンプリング(計算)し、式(34)(35)(36)に代えて、サンプリングされた確率φεtの平均値、確率θtsの平均値、およびπ’ti ti+1の平均値を用い、それぞれ、状況−音響イベント生成モデル13、音響信号−状況生成モデル2012、および状況遷移モデル2017を得てもよい。

また、上記更新過程でサンプリング(選択)し、各要素番号iの要素に割り当てた状況の候補ziを分析することで、各ラベル付き音響信号列2011−sの音響信号列がどの状況によって生成されたかを知ることができる。モデル化部1102は、このように各要素番号iの要素に割り当てた状況の候補ziを表すラベル、またはそれらの一部を状況ラベル19として出力してもよい。

本実施例では、音響信号が状況を生成する確率や状況が音響イベントを生成する確率のみでなく、状況の時間遷移確率も考慮して学習処理を行うことで、遷移確率によって特徴付けられる状況を精度よくモデル化できる。また、遷移確率によって特徴付けられる状況を精度よく分析できる。

<実施例(3)−1−2:図25>

[音響信号列から音響信号-状況生成モデル、状況−音響イベント生成モデルおよび状況遷移モデルを算出し、状況を分析]

本実施例では、音響信号列2015−1,・・・,2015−Sを入力とし、状況の時間変化を考慮に入れ、音響信号−状況生成モデル2012、状況−音響イベント生成モデル13、状況遷移モデル2017の少なくとも何れかを得る。すなわち、本実施例では、音響信号から音響特徴量を得、得られた音響特徴量を用いて音響イベントを決定し、それによって音響イベントラベル列を得てから学習処理を行い、音響信号−状況生成モデル2012、状況−音響イベント生成モデル13、状況遷移モデル2017の少なくとも何れかを得る。また状況の分析を行ってもよい。

図25に例示するように、本実施例のモデル処理装置2110は、特徴量算出部111、音響イベント判定部112、音響イベントモデルデータベース(DB)113、音響信号列合成部2101、モデル化部2102、および記憶部2103を有する。モデル処理装置2110は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず特徴量算出部111に音響信号列2015−1,・・・,2015−Sが入力される。各音響信号列2015−s(ただし、s∈{1,・・・,S})は、前述の時間区間ごとに区分された要素からなり、各要素には要素番号が付されている。

特徴量算出部111は、各音響信号列2015−sから、それぞれに対応する音響特徴量列(ベクトル)を算出して出力する。音響特徴量列の具体例は、実施例(1)−1−2と同じである。

音響イベント判定部112は、各要素番号iに対して決定した音響イベントを表す音響イベントラベルを、音響信号列2015−sの各要素番号iの要素に付与する。音響イベント判定部112は、この処理を入力された音響信号列2015−1,・・・,2015−Sのすべての要素(すべての要素番号i)について行い、その結果得られる音響イベントラベル付き音響信号列2011−1,・・・,2011−Sを出力する。

音響イベントラベル付き音響信号列2011−1,・・・,2011−Sは、音響信号列合成部2101に入力される。以降の処理は実施例(3)−1−1と同じである。

なお、音響信号列合成部2101で音響イベントラベル付き音響信号列2011−1,・・・,2011−Sの合成処理を行うことに代えて、特徴量算出部111の前段で音響信号列2015−1,・・・,2015−Sの合成処理を行っても良いし、音響イベント判定部112の前段で音響特徴量列の合成処理を行っても良い。

<実施例(3)−1−3:図26>

[音響特徴量列から音響信号-状況生成モデル、状況−音響イベント生成モデルおよび状況遷移モデルを算出し、状況を分析]

本実施例では、音響特徴量列2016−1,・・・,2016−Sを入力とし、状況の時間変化を考慮に入れ、音響信号−状況生成モデル2012、状況−音響イベント生成モデル13、状況遷移モデル2017の少なくとも何れかを得る。すなわち、本実施例では、音響信号から音響特徴量を得、得られた音響特徴量を用いて音響イベントを決定し、それによって音響イベントラベル列を得てから学習処理を行い、音響信号−状況生成モデル2012、状況−音響イベント生成モデル13、状況遷移モデル2017の少なくとも何れかを得る。また状況の分析を行ってもよい。

図26に例示するように、本実施例のモデル処理装置2120は、音響イベント判定部112、音響イベントモデルデータベース(DB)113、音響信号列合成部2101、モデル化部2102、および記憶部2103を有する。モデル処理装置2120は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響イベント判定部112に、音響特徴量列2016−1,・・・,2016−Sが入力される。音響イベント判定部112は、実施例(1)−1−2で例示した方法等によって、音響特徴量列2016−1,・・・,2016−Sを用いて各要素番号iに対して音響イベントを決定する。音響イベント判定部112は、各要素番号iに対して決定した音響イベントを表す音響イベントラベルを、音響特徴量列2016−sの各要素番号iの要素に付与する。音響イベント判定部112は、この処理を音響特徴量列2016−1,・・・,2016−Sのすべての要素(すべての要素番号i)について行い、その結果得られる音響イベントラベル付き音響信号列2011−1,・・・,2011−Sを出力する。

音響イベントラベル付き音響信号列2011−1,・・・,2011−Sは、音響信号列合成部2101に入力される。以降の処理は実施例(3)−1−1と同じである。

なお、音響信号列合成部2101で合成処理を行うことに代えて、音響イベント判定部112の前段で音響特徴量列2016−1,・・・,2016−Sの合成処理を行っても良い。

<実施例(3)−2−1:図27>

[音響イベントラベル付き音響信号列から状況を推定]

本実施例では、実施例(3)−1−1〜(3)−1−3で説明したように得られた状況−音響イベント生成モデル13および/または状況遷移モデルを用い、新たに入力された音響イベントラベル付き音響信号列から状況を推定する。

図27に例示するように、本実施例のモデル処理装置2200は、記憶部2103および生成モデル比較部2201を有する。モデル処理装置2200は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず生成モデル比較部2201に音響イベントラベル付き音響信号列2021が入力される。音響イベントラベル付き音響信号列2021は、前述の時間区間ごとに区分された時系列の音響信号列、当該時間区間ごとに区分された音響信号列の各要素に対応する要素番号、および当該時間区間ごとに決定されて付与された音響イベントラベルを含む。要素番号および音響イベントラベルは、音響信号列の要素ごとに付与される。

生成モデル比較部2201は、入力された音響イベントラベル付き音響信号列2021と、記憶部2103に格納された状況−音響イベント生成モデル13および/または状況遷移モデルとを比較し、音響イベントラベル付き音響信号列2021に対し、最も適切であると判断した状況、又は最も適切なものから順番に複数個の状況を決定し、それらを推定結果として出力する。具体的には、例えば、実施例(2)−2−1の生成モデル比較部1201と同じ方法で、音響イベントラベル付き音響信号列2021に対応する状況の推定を行うことができる。入力された音響イベントラベル付き音響信号列2021の音響イベントの分布と、状況の候補に対応する確率P(音響イベント|状況の候補)で表される音響イベントの分布との近さに基づいて、状況が推定されてもよい。また、入力された音響イベントラベル付き音響信号列2021の音響イベントの時系列の並びに対する、確率P(音響イベント|状況の候補)のもとでの、状況の候補の尤もらしさに基づいて、状況が推定されてもよい。

<実施例(3)−2−2:図28>

[音響信号列から状況を推定]

本実施例では、実施例(3)−1−1〜(3)−1−3で説明したように得られた状況−音響イベント生成モデル13および/または状況遷移モデルを用い、新たに入力された音響信号列から状況を推定する。

図28に例示するように、本実施例のモデル処理装置2210は、特徴量算出部211、音響イベント判定部212、音響イベントモデルDB113、記憶部2103、生成モデル比較部2201を有する。モデル処理装置2210は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず特徴量算出部211に音響信号列22が入力される。特徴量算出部211は、音響信号列22から音響特徴量列(ベクトル)を算出して出力する。例えば特徴量算出部211は、前述した特徴量算出部111と同じ方法で音響特徴量列を算出する。

音響イベント判定部212は、前述した音響イベント判定部112と同じ方法で、特徴量算出部211から出力された音響特徴量列と、音響イベントモデルDB113に記憶されている複数の音響イベントモデルとをそれぞれ比較し、音響信号列22の全ての要素について音響イベントを決定する。音響イベント判定部212は、決定した音響イベントを表す音響イベントラベルを音響信号列22の各要素に付することで、音響イベントラベル付き音響信号列2021を生成して出力する。

音響イベントラベル付き音響信号列2021は、生成モデル比較部2201に入力される。以降の処理は実施例(3)−2−1と同じである。

<実施例(3)−2−3:図29>

[音響特徴量から状況を推定]

本実施例では、実施例(3)−1−1〜(3)−1−3で説明したように得られた状況−音響イベント生成モデル13および/または状況遷移モデルを用い、新たに入力された音響特徴量列から状況を推定する。

図29に例示するように、本実施例のモデル処理装置2220は、音響イベント判定部212、音響イベントモデルDB113、記憶部2103、生成モデル比較部2201を有する。モデル処理装置2220は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

まず音響イベント判定部212に音響特徴量列23が入力される。音響イベント判定部212は、前述した音響イベント判定部112と同じ方法で、音響特徴量列23の音響特徴量列と、音響イベントモデルDB113に記憶されている複数の音響イベントモデルとをそれぞれ比較し、音響特徴量列23が含む全ての要素について音響イベントを決定する。音響イベント判定部212は、決定した各要素の音響イベントを表す音響イベントラベルを、音響特徴量列23が含む音響信号列に付することで、音響イベントラベル付き音響信号列2021を生成して出力する。

音響イベントラベル付き音響信号列2021は、生成モデル比較部2201に入力される。以降の処理は実施例(3)−2−1と同じである。

<実施例(3)−3−1:図30>

[音響イベントラベル付き音響信号列から状況を推定すると共に、状況−音響イベント生成モデル、音響信号−状況生成モデル、および状況遷移モデルを算出]

本実施例は実施例(3)−1−1と実施例(3)−2−1の組み合わせである。本実施例では、音響イベントラベル付き音響信号列2021を入力として状況を推定することに加え、音響イベントラベル付き音響信号列2011−1,・・・,2011−Sを入力とし、音響信号−状況生成モデル12、および状況−音響イベント生成モデル13の少なくとも何れかの算出も行う。さらに状況遷移モデル2017や状況ラベル19の生成を行ってもよい。

図30に例示するように、本実施例のモデル処理装置2300は、記憶部2103,2303、音響信号列合成部301、モデル化部2102、および生成モデル比較部2201を有する。モデル処理装置2300は、例えば、汎用又は専用の公知のコンピュータに所定のプログラムが読み込まれることで構成される。

記憶部2303には、前述した音響イベントラベル付き音響信号列2011−1,・・・,2011−S、および前述した音響イベントラベル付き音響信号列2021が格納されている。

音響イベントラベル付き音響信号列2011−1,・・・,2011−S,2021は音響信号列合成部301に入力される。音響信号列合成部301は、音響イベントラベル付き音響信号列2011−1,・・・,2011−S,2021を時系列方向につなぎ合わせて一つの音響イベントラベル付き音響信号列を生成し、モデル化部2102に送出する。モデル化部2102は、実施例(3)−1−1で説明したように、入力された音響イベントラベル付き音響信号列から、音響信号−状況生成モデル2012、および状況−音響イベント生成モデル13を生成し、それらを記憶部2103に格納する。また、実施例(3)−1−1で説明したように、モデル化部2102が状況遷移モデル2017を生成して記憶部2103に格納してもよいし、状況ラベル19を生成して記憶部2103に格納してもよい。

音響イベントラベル付き音響信号列2021は生成モデル比較部2201に入力される。音響イベントラベル付き音響信号列2021は、実施例(3)−2−1で説明したように、入力された音響イベントラベル付き音響信号列2021と、記憶部2103に格納された状況−音響イベント生成モデル13および/または状況遷移モデルとを比較し、音響イベントラベル付き音響信号列2021に対し、最も適切であると判断した状況、又は最も適切なものから順番に複数個の状況を選択し、それらを推定結果として出力する。

さらに、音響イベントラベル付き音響信号列2021が、音響イベントラベル付き音響信号列2011−1,・・・,2011−Sとともに音響信号列合成部301に入力されてもよい。この場合、音響信号列合成部301は、入力されたすべての音響イベントラベル付き音響信号列2011−1,・・・,2011−S,2021を時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベル付き音響信号列2011’(「第3音響イベントラベル列」)を得て出力する。モデル化部1102は、実施例(3)−1−1のラベル付き音響信号列2011(「音響イベントラベル列」)に代えて、音響イベントラベル付き音響信号列2011’(「第3音響イベントラベル列」)を用い、再度、実施例(3)−1−1で説明したように、音響信号−状況生成モデル2012、および状況−音響イベント生成モデル13の少なくとも何れかを生成し、それを記憶部2103に格納する。さらにモデル化部1102が、ラベル付き音響信号列2011に代えて、入力された音響イベントラベル付き音響信号列2011’を用い、再度、実施例(3)−1−1で説明したように、状況遷移モデル2017を生成して記憶部2103に格納してもよいし、状況ラベル19を生成して記憶部2103に格納してもよい。

また、生成モデル比較部2201の処理およびモデル化部2102の処理のどちらを先に行っても良い。ただし、モデル化部2102の処理を行う前に生成モデル比較部2201の処理を行う場合、記憶部2103に予め得られた各生成モデルおよび/または状況遷移モデルが格納されている必要がある。

また、音響イベントラベル付き音響信号列2021が、新たに入力された音響イベントラベル付き音響信号列とともに音響信号列合成部301に入力されてもよい。この場合、音響信号列合成部301がこれらを時系列方向につなぎ合わせ(合成)、それによって一つの音響イベントラベル付き音響信号列(「第3音響イベントラベル列」)を得て、モデル化部2102に送出してもよい。

その他の処理は実施例(3)−1−1および実施例(3)−2−1と同様とする。

<実施例(3)−3−2:図31>

[音響信号列から状況を推定すると共に、状況−音響イベントの生成モデル、音響信号−状況生成モデル、および状況遷移モデルを算出]

本実施例は、実施例(3)−1−2と実施例(3)−2−2の組み合わせである。

本実施例では、音響信号列2015−1,・・・,2015−S,22を入力として、学習によって、音響信号−状況生成モデル12、および状況−音響イベント生成モデル13の少なくとも何れかを算出する。さらに状況遷移モデル2017や状況ラベル19の生成を行ってもよい。さらに本実施例では、状況−音響イベント生成モデル13および/または状況遷移モデルを用い、音響信号列22から状況を推定する。

図31に例示するように、本実施例のモデル処理装置310は、特徴量算出部111−1,・・・,111−S,211、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および前述のモデル処理装置2300(図30参照)を有する。

音響信号列2015−1,・・・,2015−Sは、それぞれ特徴量算出部111−1,・・・,111−Sに入力される。特徴量算出部111−1,・・・,111−Sは、実施例(1)−1−2で説明したように、音響信号列2015−1,・・・,2015−Sから、それぞれ音響特徴量列を得て出力する。音響イベント判定部112−1,・・・,112−Sは、それぞれ、前述の音響イベント判定部112と同様に、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列2011−1,・・・,2011−Sを生成して出力する。

音響信号列22は特徴量算出部211に入力される。特徴量算出部211は、実施例(1)−2−2で説明したように、音響信号列22から音響特徴量列(ベクトル)を算出して出力する。音響イベント判定部212は、実施例(1)−2−2で説明したように、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列2021を生成して出力する。

音響イベントラベル付き音響信号列2011−1,・・・,2011−S、2021は、記憶部2303(図30)に格納される。以降の処理は実施例(3)−3−1と同じである。

<実施例(3)−3−3:図32>

[音響特徴量から状況を推定すると共に、状況−音響イベント生成モデル、音響信号−状況生成モデル、および状況遷移モデルを算出]

本実施例は、実施例(3)−1−3と実施例(3)−2−3の組み合わせである。

本実施例では、音響特徴量列2016−1,・・・,2016−S,23を入力として、学習によって、音響信号−状況生成モデル12、および状況−音響イベント生成モデル13の少なくとも何れかを算出する。状況遷移モデル2017や状況ラベル19の生成を行ってもよい。さらに本実施例では、音響信号−状況生成モデル12、および状況−音響イベント生成モデル13を用い、音響特徴量列23から状況を推定する。

図32に例示するように、本実施例のモデル処理装置2320は、音響イベント判定部112−1,・・・,112−S,212、音響イベントモデルDB113、および前述のモデル処理装置2300(図30参照)を有する。

音響特徴量列2016−1,・・・,2016−Sは、それぞれ音響イベント判定部112−1,・・・,112−Sに入力される。音響イベント判定部112−1,・・・,112−Sは、それぞれ、前述の音響イベント判定部112と同様に、入力された音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列2011−1,・・・,2011−Sを生成して出力する。

音響特徴量列23は音響イベント判定部212に入力される。音響イベント判定部212は、実施例(1)−2−3と同様に、入力された音響特徴量列23の音響特徴量列と音響イベントモデルDB113に記憶されている複数の音響イベントモデルとから、音響イベントラベル付き音響信号列2021を生成して出力する。

音響イベントラベル付き音響信号列2011−1,・・・,2011−S、音響イベントラベル付き音響信号列2021は、記憶部2303(図30)に格納される。以降の処理は実施例(2)−3−1と同じである。

<変形例等>

なお、本発明は上述の実施例に限定されるものではない。例えば、モデル処理装置の処理が複数の装置で分散処理されてもよいし、上記の各実施例で記憶部やDBに格納された各データが複数の記憶部やDBに分散して格納されてもよい。例えば、行動−状況生成モデル、状況−音響イベント生成モデル、行動−音響イベント生成モデル、音響信号−状況生成モデル等の生成モデルや、行動遷移モデルや状況遷移モデル等が互いに異なる記憶部に格納されてもよい。

音響信号列を使用しない場合(例えば、実施例(1)−1−1等)には、音響イベントラベルおよび行動ラベル候補付き音響信号列に代えて、音響イベントラベルおよび行動ラベル候補列が用いられてもよい。同様に、音響信号列を使用しない場合(例えば、実施例(1)−3−1等)には、音響イベントラベル付き音響信号列に代えて、音響イベントラベル列が用いられてもよい。また、音響イベントラベル列と行動ラベル候補列とが別々に入力されてもよい。

音響イベントラベルおよび行動ラベル候補列の例は、音響イベントラベルおよび行動ラベル候補付き音響信号列から音響信号列を除いた列である。また、音響イベントラベル列の例は、音響イベントラベル付き音響信号列から音響信号列を除いた列である。

また、ラベル列が時系列の順に入力され順次処理されるのであれば、音響イベントラベル付き音響信号列、音響イベントラベルおよび行動ラベル候補付き音響信号列等が要素番号を含まなくてもよい。

また、各実施例のモデル処理装置が行動や状況の分析を行う場合には分析装置として機能する。各実施例のモデル処理装置が、生成モデルを出力することなく、行動や状況の分析のみを行い、その推定結果を出力してもよい。

上述の各種の処理は、記載に従って時系列に実行されるのみならず、処理を実行する装置の処理能力あるいは必要に応じて並列的にあるいは個別に実行されてもよい。その他、本発明の趣旨を逸脱しない範囲で適宜変更が可能であることはいうまでもない。

上述の構成をコンピュータによって実現する場合、各装置が有すべき機能の処理内容はプログラムによって記述される。このプログラムをコンピュータで実行することにより、上記処理機能がコンピュータ上で実現される。この処理内容を記述したプログラムは、コンピュータで読み取り可能な記録媒体に記録しておくことができる。コンピュータで読み取り可能な記録媒体の例は、非一時的な(non-transitory)記録媒体である。このような記録媒体の例は、磁気記録装置、光ディスク、光磁気記録媒体、半導体メモリ等である。

このプログラムの流通は、例えば、そのプログラムを記録したDVD、CD−ROM等の可搬型記録媒体を販売、譲渡、貸与等することによって行う。さらに、このプログラムをサーバコンピュータの記憶装置に格納しておき、ネットワークを介して、サーバコンピュータから他のコンピュータにそのプログラムを転送することにより、このプログラムを流通させる構成としてもよい。

このようなプログラムを実行するコンピュータは、例えば、まず、可搬型記録媒体に記録されたプログラムもしくはサーバコンピュータから転送されたプログラムを、一旦、自己の記憶装置に格納する。処理の実行時、このコンピュータは、自己の記録装置に格納されたプログラムを読み取り、読み取ったプログラムに従った処理を実行する。このプログラムの別の実行形態として、コンピュータが可搬型記録媒体から直接プログラムを読み取り、そのプログラムに従った処理を実行することとしてもよく、さらに、このコンピュータにサーバコンピュータからプログラムが転送されるたびに、逐次、受け取ったプログラムに従った処理を実行することとしてもよい。サーバコンピュータから、このコンピュータへのプログラムの転送は行わず、その実行指示と結果取得のみによって処理機能を実現する、いわゆるASP(Application Service Provider)型のサービスによって、上述の処理を実行する構成としてもよい。

上記実施形態では、コンピュータ上で所定のプログラムを実行させて本装置の処理機能が実現されたが、これらの処理機能の少なくとも一部がハードウェアで実現されてもよい。