JP5826237B2 - 画像処理装置、画像処理方法、及びプログラム - Google Patents

画像処理装置、画像処理方法、及びプログラム Download PDFInfo

- Publication number

- JP5826237B2 JP5826237B2 JP2013244327A JP2013244327A JP5826237B2 JP 5826237 B2 JP5826237 B2 JP 5826237B2 JP 2013244327 A JP2013244327 A JP 2013244327A JP 2013244327 A JP2013244327 A JP 2013244327A JP 5826237 B2 JP5826237 B2 JP 5826237B2

- Authority

- JP

- Japan

- Prior art keywords

- feature

- scene

- weight

- value

- coordinate

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Landscapes

- Facsimile Image Signal Circuits (AREA)

- Studio Devices (AREA)

Description

特許文献1には、撮影シーンを判別し、このシーン判別により、設定した補正処理条件を夜景指標に応じて補正し直す方法が記載されている。この特許文献1における夜景指標は、撮影時の撮影条件、画像の肌色画素情報、及び画像全体の平均輝度を用いて算出される。この特許文献1に記載の方法は、撮影された画像の撮影シーンを判別することによって自動的に補正条件を設定するものである。更に、夜景の撮影の場合を考慮した補正を加えることで、より適切な補正画像を得ている。

また特許文献2には、主要な被写体以外に暗い箇所がある場合であっても、誤判定することなく逆光シーンであるか否かを判定できる逆光シーン判定方法が記載されている。

また特許文献3では、撮影画像を複数の区画に分割し、分割された区画の画像の特徴量である区画特徴量を算出し、その区画特徴量から撮影画像に割り当てられる撮影シーンの確度を算定している。そして、その算定された撮影シーンの確度から撮影画像に対する補正度を決定する方法が記載されている。この特許文献3では、撮影シーンの確度を算出する方法として、例えば、逆光と順光の判定に、撮影画像の中央部に位置する区画群と周辺部に位置する区画群との輝度差を用いている。つまり、中央部の区画群の輝度が周辺部の区画群の輝度より小さい場合は逆光シーンである判断し、逆に中央部の区画群の輝度が周辺部の区画群の輝度より大きい場合は順光シーンと判断している。その際、極端な順光であるとみなされるスポット光という撮影シーンも考慮して、この逆光と順光シーンの確度の算定では、上述した輝度差に基づいて判定している。

画像データから特徴量を取得する取得手段と、

複数のシーンのそれぞれのシーンに複数の特徴量が対応づけられており、前記複数の特徴量のそれぞれに対して重みが対応付けられている特徴量空間において、前記取得手段によって取得された特徴量を示す座標と、前記複数の特徴量のうち第1の重みが対応づけられている第1の特徴量を示す座標との第1の距離と、前記取得手段によって取得された特徴量を示す座標と、前記複数の特徴量のうち第2の重みが対応づけられている第2の特徴量を示す座標との第2の距離を算出する算出手段と、

前記算出手段によって算出された複数の距離のうち、前記取得手段によって取得された特徴量を示す座標から最も距離が短い座標が示す特徴量に対応付けられているシーンを、前記画像データのシーンとして判定する判定手段と、

前記判定手段によって判定されたシーンと前記第1の重みとを用いて明るさ補正量を決定し、決定された前記補正量に基づき前記画像データの明るさを補正する補正手段とを有し、

前記最も距離が短い座標が示す特徴量は第1の特徴量であり、前記判定手段におけるシーン判定では前記第1の重みと前記第2の重みは使用しないことを特徴とする。

Cb=−0.169×R−0.331×G+0.500×B

Cr= 0.500×R−0.419×G−0.081×B ...式(1)

次にS4に進み、特徴量算出部102が、色空間変換部101から入力される画像データを解析し、明度成分及び色のばらつき成分の特徴量を算出し、その特徴量をシーン判定部103へ送信する。例えば、YCbCr色空間の画像データから、明度成分として輝度(Y)の平均値を算出する。また、色のばらつき成分として色差(Cb)の分散値を算出し、これらを特徴量とする。

以下の変換式を用いて、色差(Cb)の平均値を求めてから、色差の分散値を算出する。

色差(Cb)の分散値=Σ((色差値(Cb)−色差の平均値)の2乗)/全画素数 ...式(4)

以上の式(2)〜(4)で、Σは0〜255の総和を示している。

シーン信頼度=[{(A+B)/2}−A]/{(A+B)/2} ...式(5)

で表される。

ここで、Σは0〜255の総和を示している。

次S43に進み、算出したヒストグラムから色差Cbの平均値を算出する。

ここで、Σは0〜255の総和を示している。

ここで、Σは0〜255の総和を示している。

色差(Cb)の分散値=((1−3)の2乗×3)+((2−3)の2乗×10)+((3−3)の2乗×6)+((4−3)の2乗×6)+((5−3)の2乗×5)/(3+10+6+6+5)=48/30=1.6

次にS45に進み、S42及びS44で算出した明度成分の特徴量と色のばらつき成分の特徴量を0〜100の値に正規化する。例えば、正規化は、想定される明度成分である輝度(Y)の平均値の範囲が0〜255の値である場合、0〜255を0〜100の値に変換する。

また、例えば、色差(Cb)の分散値を正規化する場合は、0〜16384を0〜100の値に変換し、16384より大きい値は100にする。

特徴量算出部102は、明度成分の特徴量と色のばらつき成分の特徴量を正規化した値をシーン判定部103に出力する。

座標400(X0,Y0)=(60,50)

座標401(X1,Y1)=(10,40)

座標402(X2,Y2)=(30,60)

座標403(X3,Y3)=(40,80)

座標404(X4,Y4)=(20,10)

座標405(X5,Y5)=(40,20)

座標406(X6,Y6)=(80,40)

図6において、S51で、特徴量算出部102で算出した特徴量の組み合わせた値と、予め設定されている各シーンを示す複数の特徴量を組み合わせた代表値を特徴量空間座標に配置する。例えば、特徴量算出部102で算出した特徴量の組み合わせた値として座標400(図7)を配置し、各シーンを示す代表値に相当する座標401〜406(図7)を配置する。次にS52に進み、特徴量算出部102で算出した値(座標400)と、各シーンの代表値(座標401〜406)との距離を算出する。例えば、特徴量算出部102で算出した特徴量の組み合わせた値の座標(Xa,Ya)とし、各シーンを示す代表値の一つを座標(Xb,Yb)とすると、その距離は以下の式(9)で表される。

次にS53に進み、予め設定されているシーンの代表値数分の処理を行ったかどうかを判定する。前述の例では、各シーンの代表値の数は座標401〜406の6個なので、6個分の距離を算出したか否かを判定する。上述の例に従って、特徴量算出部102で算出した値である座標400と座標401〜406の距離算出結果を以下に示す。

座標400(X0,Y0)と座標402(X2、Y2)の距離=((X0−X2)の2乗+(Y0−Y2)の2乗)=((60−30)の2乗+(50−60)の2乗)=1000

座標400(X0,Y0)と座標403(X3,Y3)の距離=((X0−X3)の2乗+(Y0−Y3)の2乗)=((60−40)の2乗+(50−80)の2乗)=1300

座標400(X0,Y0)と座標404(X4,Y4)の距離=((X0−X4)の2乗+(Y0−Y4)の2乗)=((60−20)の2乗+(50−10)の2乗)=3200

座標400(X0,Y0)と座標405(X5,Y5)の距離=((X0−X5)の2乗+(Y0−Y5)の2乗)=((60−40)の2乗+(50−20)の2乗)=1300

座標400(X0,Y0)と座標406(X6,Y6)の距離=((X0−X6)の2乗+(Y0−Y6)の2乗)=((60−80)の2乗+(50−40)の2乗)=500

次にS54に進み、S52で算出した代表値との距離の中で、最も距離の短い代表値を求める。上述の例では、入力した画像の特徴量の座標400(X0,Y0)と座標406(X6,Y6)との距離(L6)が最も短いので、露出不足シーンである座標406を代表値として決定する。次にS55に進み、最も距離の短い代表値のシーンを、入力した画像のシーンであると判定する。上述の例では、最も距離の短い代表値の座標406のシーンは露出不足シーンであるため、取得画像のシーンは露出不足シーンであると決定する。

上記例では、最も短い距離(La)は、座標400(X0,Y0)と座標406(X6,Y6)との距離で「500」である。次に短い距離(Lb)は、座標400(X0,Y0)と座標402(X2,Y2)の距離で「1000」である。従って、この場合のシーン信頼度は、

シーン信頼度=[{(500+1000)/2}−500]/{(500+1000)/2}=1/3

となる。次にS57に進み、各代表値の重みを利用して、判定したシーンの重み(代表点信頼度)を算出する。例えば、各代表値の重みを以下に示す。

座標402の重み(W2)=0.8

座標403の重み(W3)=1.0

座標404の重み(W4)=1.0

座標405の重み(W5)=0.8

座標406の重み(W6)=0.6

上記例において、最も短い距離は、座標400(X0,Y0)と座標406(X6,Y6)の距離(L6)であるため、座標406の重み(W6)「0.6」を代表点信頼度として設定する。

本実施形態では、各シーンの代表値を任意に設定しているが本発明はこれに限らない。例えば、この代表値は、あるシーンの画像を設定し、その設定した画像の特徴量から求めても良い。例えば、露出不足シーン、夜景シーンの画像をそれぞれ5つ選択し、合計10の画像の明度成分、色のばらつき成分の各特徴量を算出し、その算出した値を代表値として設定してもよい。また、その代表値は、任意にシーンを指定した画像の特徴量から、そのシーンを分類できる特徴量を学習によって算出して設定しても構わない。この場合の学習方法は、ある程度の数のサンプルデータの集合を対象に画像を解析し、その解析データから有用な規則、ルール、判断基準などを抽出し、これらから得られた特徴量を代表値として設定してもよい。この学習方法は、公知技術である遺伝的アルゴリズム(Genetic Algorithm:GA)やニューラルネットワーク(Neural Network)のいずれの方法を用いてもよい。又は、教師あり学習を実行するための機械学習メタアルゴリズムの一種であるブースティングのいずれの方法を用いてもよい。また或いは、教師なし学習を実行するための機械学習メタアルゴリズムの一種である主成分分析やクラスター分析、ベクトル量子化(Vector Quantization:VQ)のいずれの方法を用いてもよい。

距離={(Xa−Xb)+(Ya−Yb)}

距離={(Xa−Xb)の2乗+(Ya−Yb)の2乗}/2

本実施形態では、最も距離の短い代表値の距離と、次に距離の短い代表値の距離との割合からシーン信頼度を算出しているが、本発明はこれに限らない。例えば、最も距離の短い代表値に設定されているシーンを求め、そのシーンと異なるシーンの代表値の中で、最も距離の短い代表値を判定するようにしても良い。また或いは、最も距離の短い代表値までの距離と、最も距離の短い代表値までの距離のシーンと異なる最も距離の短い代表値までの距離との割合からシーン信頼度を算出してもよい。

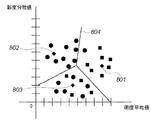

図8の例では、

座標801の代表値の重み=7/8 =0.875

座標802の代表値の重み=9/9 =1.0

座標803の代表値の重み=6/10=0.6

となる。

図8の例では、図8全体の全画像数は「27」であるため、

座標801の代表値の重み=7/27≒0.259

座標802の代表値の重み=9/27≒0.333

座標803の代表値の重み=6/27≒0.222

となる。

図8の例では、

座標801の代表値の重み=7/(7+1)=0.875

座標802の代表値の重み=9/(9+0)=1.00

座標803の代表値の重み=6/(6+4)=0.60

また本実施形態では、シーン信頼度と代表点信頼度を乗算することによって、最終的なシーン信頼度(最終シーン信頼度)を算出しているが、シーン信頼度と代表点信頼度の2つを用いて信頼度を算出すれば、これに限らない。例えば、シーン信頼度と代表点信頼度を加算した値を、最終的なシーン信頼度(最終シーン信頼度)として算出してもよい。

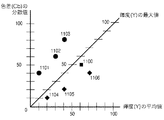

座標1100(X0,Y0,Z0)=(60,50,50)

座標1101(X1,Y1,Z1)=(10,40,20)

座標1102(X2,Y2,Z2)=(30,60,40)

座標1103(X3,Y3,Z3)=(40,80,60)

座標1104(X4,Y4,Z4)=(20,10,10)

座標1105(X5,Y5,Z5)=(40,20,20)

座標1106(X6,Y6,Z6)=(80,40,40)

特徴量算出部102で算出した値(座標1100)と、各シーンの代表値(座標1101〜1106)との距離を算出する。例えば、特徴量算出部102で算出した特徴量の組み合わせた値の座標(Xa,Ya,Zb)とし、各シーンを示す代表値の一つを座標(Xb,Yb,Zb)とすると、その距離は以下の式(15)で表される。

2次元の特徴量空間上でのシーン判定方法と同様に、3次元の特徴量空間上で算出した距離を用いてシーン判定を行う。

G'=255×{(G/255)の(1/γ)乗}

B'=255×{(B/255)の(1/γ)乗}

ここでγの値が1より大きい場合は、入力画像に対し出力画像が明るくなる。またγの値が「1」より小さいとき、入力画像に対し出力画像が暗くなる。シーン判定結果が夜景シーンである場合は、S94で、夜景シーン用の補正処理として、暗い濃度はより暗く、明るい濃度はより明るくする補正を行う。例えば、図10(A)のγ曲線1001で補正処理を行う。

なお、本発明は、前述した実施形態の機能を実現するソフトウェアのプログラムを、システム或いは装置に直接或いは遠隔から供給し、そのシステム或いは装置のコンピュータが該供給されたプログラムを読み出して実行することによっても達成され得る。その場合、プログラムの機能を有していれば、形態は、プログラムである必要はない。

Claims (9)

- 画像データから特徴量を取得する取得手段と、

複数のシーンのそれぞれのシーンに複数の特徴量が対応づけられており、前記複数の特徴量のそれぞれに対して重みが対応付けられている特徴量空間において、前記取得手段によって取得された特徴量を示す座標と、前記複数の特徴量のうち第1の重みが対応づけられている第1の特徴量を示す座標との第1の距離と、前記取得手段によって取得された特徴量を示す座標と、前記複数の特徴量のうち第2の重みが対応づけられている第2の特徴量を示す座標との第2の距離を算出する算出手段と、

前記算出手段によって算出された複数の距離のうち、前記取得手段によって取得された特徴量を示す座標から最も距離が短い座標が示す特徴量に対応付けられているシーンを、前記画像データのシーンとして判定する判定手段と、

前記判定手段によって判定されたシーンと前記第1の重みとを用いて明るさ補正量を決定し、決定された前記補正量に基づき前記画像データの明るさを補正する補正手段とを有し、

前記最も距離が短い座標が示す特徴量は第1の特徴量であり、前記判定手段におけるシーン判定では前記第1の重みと前記第2の重みは使用しないことを特徴とする画像処理装置。 - 前記取得手段によって取得された特徴量は明度値と色差値であり、前記第1の特徴量は明度値と色差値であり、前記第2の特徴量は前記明度値と前記色差値の少なくともいずれか一方とは異なる明度値と色差値であり、前記算出手段は、少なくとも明度値と色差値とを含む特徴量空間において、前記第1の距離と前記第2の距離を算出することを特徴とする請求項1に記載の画像処理装置。

- 前記補正手段は、さらに、前記第1の距離と前記第2の距離とに基づき、前記画像データの明るさを補正し、

前記特徴量空間において、前記第2の特徴量は、前記取得手段によって取得された特徴量を示す座標から2番目に距離が短い座標が示す特徴量であることを特徴とする請求項1又は2に記載の画像処理装置。 - 画像データから特徴量を取得する取得手段と、

複数の区分のそれぞれの区分に複数の特徴量が対応づけられており、前記複数の特徴量のそれぞれに対して重みが対応付けられている特徴量空間において、前記取得手段によって取得された特徴量を示す座標と、前記複数の特徴量のうち第1の重みが対応づけられている第1の特徴量を示す座標との第1の距離と、前記取得手段によって取得された特徴量を示す座標と、前記複数の特徴量のうち第2の重みが対応づけられている第2の特徴量を示す座標との第2の距離を算出する算出手段と、

前記算出手段によって算出された複数の距離のうち、前記取得手段によって取得された特徴量を示す座標から最も距離が短い座標が示す特徴量に対応付けられている区分を、前記画像データの区分として判定する判定手段と、

前記判定手段によって判定された区分と前記第1の重みとを用いて明るさ補正量を決定し、決定された補正量に基づき前記画像データの明るさを補正する補正手段とを有し、

前記最も距離が短い座標が示す特徴量は第1の特徴量であり、前記判定手段における区分判定では前記第1の重みと前記第2の重みは使用しないことを特徴とする画像処理装置。 - 前記取得手段によって取得された特徴量は明度値と色差値であり、前記第1の特徴量は明度値と色差値であり、前記第2の特徴量は前記明度値と前記色差値の少なくともいずれか一方とは異なる明度値と色差値であり、前記算出手段は、少なくとも明度値と色差値とを含む特徴量空間において、前記第1の距離と前記第2の距離を算出することを特徴とする請求項4に記載の画像処理装置。

- 前記補正手段は、さらに、前記第1の距離と前記第2の距離とに基づき、前記画像データの明るさを補正し、

前記特徴量空間において、前記第2の特徴量は、前記取得手段によって取得された特徴量を示す座標から2番目に距離が短い座標が示す特徴量であることを特徴とする請求項4又は5に記載の画像処理装置。 - 画像データから特徴量を取得する取得ステップと、

複数のシーンのそれぞれのシーンに複数の特徴量が対応づけられており、前記複数の特徴量のそれぞれに対して重みが対応付けられている特徴量空間において、前記取得ステップで取得された特徴量を示す座標と、前記複数の特徴量のうち第1の重みが対応づけられている第1の特徴量を示す座標との第1の距離と、前記取得ステップで取得された特徴量を示す座標と、前記複数の特徴量のうち第2の重みが対応づけられている第2の特徴量を示す座標との第2の距離を算出する算出ステップと、

前記算出ステップで算出された複数の距離のうち、前記取得ステップで取得された特徴量を示す座標から最も距離が短い座標が示す特徴量に対応付けられているシーンを、前記画像データのシーンとして判定する判定ステップと、

前記判定ステップによって判定されたシーンと前記第1の重みとを用いて明るさ補正量を決定し、決定された補正量に基づき前記画像データの明るさを補正する補正ステップとを有し、

前記最も距離が短い座標が示す特徴量は第1の特徴量であり、前記判定ステップにおけるシーン判定では前記第1の重みと前記第2の重みは使用しないことを特徴とする画像処理方法。 - 画像データから特徴量を取得する取得ステップと、

複数の区分のそれぞれの区分に複数の特徴量が対応づけられており、前記複数の特徴量のそれぞれに対して重みが対応付けられている特徴量空間において、前記取得ステップで取得された特徴量を示す座標と、前記複数の特徴量のうち第1の重みが対応づけられている第1の特徴量を示す座標との第1の距離と、前記取得ステップで取得された特徴量を示す座標と、前記複数の特徴量のうち第2の重みが対応づけられている第2の特徴量を示す座標との第2の距離を算出する算出ステップと、

前記算出ステップで算出された複数の距離のうち、前記取得ステップで取得された特徴量を示す座標から最も距離が短い座標が示す特徴量に対応付けられている区分を、前記画像データの区分として判定する判定ステップと、

前記判定ステップによって判定された区分と前記第1の重みとを用いて明るさ補正量を決定し、決定された補正量に基づき前記画像データの明るさを補正する補正ステップとを有し、

前記最も距離が短い座標が示す特徴量は第1の特徴量であり、前記判定ステップにおける区分判定では前記第1の重みと前記第2の重みは使用しないことを特徴とする画像処理方法。 - コンピュータを請求項1乃至6のいずれか1項に記載の画像処理装置の各手段として機能させるためのプログラム。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013244327A JP5826237B2 (ja) | 2013-11-26 | 2013-11-26 | 画像処理装置、画像処理方法、及びプログラム |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013244327A JP5826237B2 (ja) | 2013-11-26 | 2013-11-26 | 画像処理装置、画像処理方法、及びプログラム |

Related Parent Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2009123543A Division JP5424712B2 (ja) | 2009-05-21 | 2009-05-21 | 画像処理装置及びその制御方法とプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2014064313A JP2014064313A (ja) | 2014-04-10 |

| JP2014064313A5 JP2014064313A5 (ja) | 2014-05-29 |

| JP5826237B2 true JP5826237B2 (ja) | 2015-12-02 |

Family

ID=50619104

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013244327A Expired - Fee Related JP5826237B2 (ja) | 2013-11-26 | 2013-11-26 | 画像処理装置、画像処理方法、及びプログラム |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP5826237B2 (ja) |

Family Cites Families (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2001330882A (ja) * | 2000-05-24 | 2001-11-30 | Canon Inc | 被写体認識機能付きカメラ |

| JP4606828B2 (ja) * | 2003-09-25 | 2011-01-05 | 富士フイルム株式会社 | 特定シーンの画像を選別する装置、プログラムおよびプログラムを記録した記録媒体 |

| JP2005151130A (ja) * | 2003-11-14 | 2005-06-09 | Canon Inc | 画像出力装置、画像出力方法ならびに記憶媒体、プログラム |

| JP2006333205A (ja) * | 2005-05-27 | 2006-12-07 | Konica Minolta Photo Imaging Inc | 撮像装置、画像処理方法及び画像処理プログラム |

| JP2008228086A (ja) * | 2007-03-14 | 2008-09-25 | Seiko Epson Corp | 情報処理方法、情報処理装置及びプログラム |

| JP5181687B2 (ja) * | 2008-01-17 | 2013-04-10 | 株式会社ニコン | 電子カメラ |

-

2013

- 2013-11-26 JP JP2013244327A patent/JP5826237B2/ja not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| JP2014064313A (ja) | 2014-04-10 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5424712B2 (ja) | 画像処理装置及びその制御方法とプログラム | |

| JP5743384B2 (ja) | 画像処理装置及び画像処理方法とコンピュータプログラム | |

| JP5032911B2 (ja) | 画像処理装置及び画像処理方法 | |

| JP5451213B2 (ja) | 画像処理装置及び画像処理方法並びにコンピュータプログラム | |

| JP5116393B2 (ja) | 画像処理装置及び画像処理方法 | |

| JP6840957B2 (ja) | 画像類似度算出装置、画像処理装置、画像処理方法、及び記録媒体 | |

| JP4324043B2 (ja) | 画像処理装置およびその方法 | |

| US8319853B2 (en) | Image processing apparatus, image processing method, and computer program | |

| US9106876B2 (en) | Image processing device setting color conversion method to method adequate for image to be converted | |

| JP4324044B2 (ja) | 画像処理装置およびその方法 | |

| JP2009033361A (ja) | 色調整装置、画像形成装置およびプログラム | |

| EP2009900B1 (en) | Image-printing device | |

| JP5826237B2 (ja) | 画像処理装置、画像処理方法、及びプログラム | |

| JP6166768B2 (ja) | 画像処理装置及び画像処理方法とプログラム | |

| JP6343373B2 (ja) | 画像処理方法及び画像処理装置とプログラム | |

| JP5856640B2 (ja) | 画像処理装置及び画像処理方法とプログラム | |

| JP4418829B2 (ja) | 色補正方法および画像処理装置 | |

| CN113395407A (zh) | 图像处理装置、图像处理方法及计算机可读介质 | |

| JP2000105820A (ja) | モノト―ン変換装置、モノト―ン変換方法およびモノト―ン変換プログラムを記録した媒体 | |

| JP5116873B2 (ja) | 画像処理装置及び画像処理方法 | |

| JP2008147714A (ja) | 画像処理装置およびその方法 | |

| JP2006031375A (ja) | 画像処理装置およびその方法 | |

| JP2003125199A (ja) | 画像処理装置、画像処理方法および画像処理制御プログラムを記録した媒体 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20140416 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20140826 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20140829 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20141028 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20150209 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20150410 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20150914 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20151013 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 5826237 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |

|

| LAPS | Cancellation because of no payment of annual fees |