JP4906397B2 - シミュレーション装置及びシミュレーション方法 - Google Patents

シミュレーション装置及びシミュレーション方法 Download PDFInfo

- Publication number

- JP4906397B2 JP4906397B2 JP2006134148A JP2006134148A JP4906397B2 JP 4906397 B2 JP4906397 B2 JP 4906397B2 JP 2006134148 A JP2006134148 A JP 2006134148A JP 2006134148 A JP2006134148 A JP 2006134148A JP 4906397 B2 JP4906397 B2 JP 4906397B2

- Authority

- JP

- Japan

- Prior art keywords

- movement amount

- virtual

- worker

- setting

- amount vector

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 238000004088 simulation Methods 0.000 title claims description 74

- 238000000034 method Methods 0.000 title claims description 47

- 230000033001 locomotion Effects 0.000 claims description 268

- 239000013598 vector Substances 0.000 claims description 136

- 238000001514 detection method Methods 0.000 claims description 69

- 238000006243 chemical reaction Methods 0.000 claims description 64

- 238000004364 calculation method Methods 0.000 claims description 39

- 230000000638 stimulation Effects 0.000 claims description 26

- 230000008859 change Effects 0.000 claims description 25

- 230000004044 response Effects 0.000 claims description 14

- 238000003860 storage Methods 0.000 claims description 11

- 239000002699 waste material Substances 0.000 description 23

- 238000004140 cleaning Methods 0.000 description 17

- 238000005286 illumination Methods 0.000 description 16

- 239000004744 fabric Substances 0.000 description 13

- 230000008569 process Effects 0.000 description 13

- 239000010802 sludge Substances 0.000 description 10

- 125000002066 L-histidyl group Chemical group [H]N1C([H])=NC(C([H])([H])[C@](C(=O)[*])([H])N([H])[H])=C1[H] 0.000 description 9

- 230000007423 decrease Effects 0.000 description 9

- 230000000694 effects Effects 0.000 description 8

- 230000035807 sensation Effects 0.000 description 8

- 238000010586 diagram Methods 0.000 description 7

- 230000000007 visual effect Effects 0.000 description 7

- 210000004556 brain Anatomy 0.000 description 6

- 238000011156 evaluation Methods 0.000 description 6

- 230000003247 decreasing effect Effects 0.000 description 5

- 238000009826 distribution Methods 0.000 description 4

- 238000012360 testing method Methods 0.000 description 4

- 238000011109 contamination Methods 0.000 description 3

- 238000001816 cooling Methods 0.000 description 3

- 238000013459 approach Methods 0.000 description 2

- 230000006870 function Effects 0.000 description 2

- 230000036541 health Effects 0.000 description 2

- 230000006698 induction Effects 0.000 description 2

- 230000003287 optical effect Effects 0.000 description 2

- 238000012549 training Methods 0.000 description 2

- 241001391944 Commicarpus scandens Species 0.000 description 1

- 241000282412 Homo Species 0.000 description 1

- 230000002159 abnormal effect Effects 0.000 description 1

- 230000009471 action Effects 0.000 description 1

- 238000013019 agitation Methods 0.000 description 1

- 239000012141 concentrate Substances 0.000 description 1

- 238000004880 explosion Methods 0.000 description 1

- 230000004438 eyesight Effects 0.000 description 1

- 230000007774 longterm Effects 0.000 description 1

- 230000003340 mental effect Effects 0.000 description 1

- 238000002360 preparation method Methods 0.000 description 1

- 230000009467 reduction Effects 0.000 description 1

- 238000011160 research Methods 0.000 description 1

- 230000002441 reversible effect Effects 0.000 description 1

- 230000036421 sense of balance Effects 0.000 description 1

- 230000001953 sensory effect Effects 0.000 description 1

- 231100000430 skin reaction Toxicity 0.000 description 1

- 230000035900 sweating Effects 0.000 description 1

- 230000001360 synchronised effect Effects 0.000 description 1

- 238000012876 topography Methods 0.000 description 1

- 230000016776 visual perception Effects 0.000 description 1

Images

Landscapes

- Processing Or Creating Images (AREA)

- User Interface Of Digital Computer (AREA)

Description

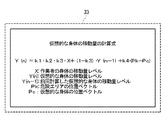

Y(n)=k1・k2・k3・X+(1−k3)・Y(n−1)+k4・(Pk−Pc)…(1)

移動量ベクトルY(n)は、右辺第1項のベクトルと、右辺第2項のベクトルと、右辺第3項のベクトルとの和として表現されている。右辺第1項のベクトルは、身体計算部33が位置検出信号26に基づいて計算した身体53の移動を示す移動量ベクトルXと、変換係数k1と、割増・割引係数k2と、時定数係数k3との積である。右辺第2項のベクトルは、身体計算部33が前回計算した仮想的な身体42の移動量ベクトルY(n−1)と(1−k3)との積である。右辺第3項のベクトルは、仮想的な身体42から危険エリアを見る方向のベクトル(Pk−Pc)と強制移動係数k4の積である。変換係数k1は、割増・割引係数k2、及び時定数係数k3が1に設定され、強制移動係数k4がゼロに設定されている場合に、作業者5から見た身体53の移動量ベクトルと作業者5から見た画像14に表示された仮想的な身体42の移動量ベクトルとが、始点、方向、大きさにおいて一致するように設定されている。ここで、表示部11が画像14を表示することは画像14を示す光を表示面11aから出力することである。したがって、変換係数k1の設定を別の言葉で表現すれば、変換係数k1は、割増・割引係数k2、及び時定数係数k3が1に設定され、強制移動係数k4がゼロに設定されている場合に、表示部11から出力され、ハーフミラー12aによって反射された画像14の中の仮想的な身体42を示す光が、作業者5が身体53を見る視線を逆方向に進むように設定されている。なお、割増・割引係数k2は、正の値をとる。時定数係数k3は、ゼロより大きく1以下の値をとる。強制移動係数k4は、ゼロ以上の値をとる。

11…表示部

11a…表示面

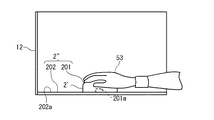

12…カバー

12a…ハーフミラー

12b…照明装置

12c…仮想的な面

13…椅子

14…画像

15…音声出力部

2…データグローブ(インターフェース)

2’…マウス(インターフェース)

2’’…タブレット式マウス(インターフェース)

201…マウス形状体

201a…位置指示器

202…位置検出板

202a…平面

21…触覚刺激部

22…位置検出部

23…姿勢検出部

24…GSR検出部

25…触覚刺激

26…位置検出信号

27…姿勢検出信号

28…GSR検出信号

3…コンピュータ

31…制御部

310…汚れに関する情報

32…物体計算部

33…身体計算部

34…画像情報生成部

35…触覚刺激指令生成部

36…記憶部

41…仮想的な物体

411…第1物体

412…回転部分

413…清掃対象部分

414…汚れ

415…ウエス

42…仮想的な身体

43…画像情報

44…触覚刺激指令

45…物体運動指令

47…身体運動指令

5…作業者

51…目

52…脳

53…身体(手)

54…視覚情報

55…身体感覚情報

56…身体動作指令

57…位置情報

58…姿勢情報

59…GSR情報

60…心拍数(脈拍)情報

61…心拍数(脈拍)検出器

62…心拍数(脈拍)検出信号

63…音声出力指令

64…汚れ情報

65…画像情報生成指令

66…照明強度指令

67…ヒューマンエラー誘引プログラム情報

68…得点情報

70…作業記録テーブル

71…作業記録情報

Claims (19)

- 作業者の現実の身体の位置情報を検出する位置検出部と、

仮想的な身体を仮想空間内に計算する身体計算部と、

前記仮想的な身体を含む前記仮想空間の画像を表示する表示部と、

制御部と

を具備し、

前記身体計算部は、前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算し、前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算し、前記第2移動量ベクトルを反映させて前記仮想的な身体を計算し、

前記表示部は、前記画像の中の前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記制御部は、前記仮想的な身体が移動する速さと前記現実の身体が移動する速さとの対応関係が変化するように、又は、前記仮想的な身体が移動する方向と前記現実の身体が移動する方向との対応関係が変化するように前記移動量変換規則の設定を前記第1設定から第2設定に変更する

シミュレーション装置。 - 作業者の現実の身体の位置情報を検出する位置検出部と、

仮想的な身体を仮想空間内に計算する身体計算部と、

前記仮想的な身体を含む前記仮想空間の画像を表示する表示部と、

制御部と

を具備し、

前記身体計算部は、前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算し、前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算し、前記第2移動量ベクトルを反映させて前記仮想的な身体を計算し、

前記表示部は、前記画像の中の前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記制御部は、前記第1移動量ベクトルの大きさと前記第2移動量ベクトルの大きさの比を変化させるように前記移動量変換規則の設定を前記第1設定から第2設定に変更する

シミュレーション装置。 - 作業者の現実の身体の位置情報を検出する位置検出部と、

仮想的な身体を仮想空間内に計算する身体計算部と、

前記仮想的な身体を含む前記仮想空間の画像を表示する表示部と、

制御部と

を具備し、

前記身体計算部は、前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算し、前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算し、前記第2移動量ベクトルを反映させて前記仮想的な身体を計算し、

前記表示部は、前記画像の中の前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記制御部は、前記第1移動量ベクトルが第1変化をする第1タイミングと前記第2移動量ベクトルが前記第1変化に応答した第2変化をする第2タイミングとのタイミング差を変化させるように前記移動量変換規則の設定を前記第1設定から第2設定に変更する

シミュレーション装置。 - 前記視線上に配置されたハーフミラーを具備し、

前記表示部は、前記ハーフミラーに向けて前記光を出力する

請求項1乃至3のいずれか1項に記載のシミュレーション装置。 - 前記作業者の生体情報を検出する生体情報検出部を具備する

請求項1乃至4のいずれか1項に記載のシミュレーション装置。 - 前記制御部は、前記生体情報の所定の変化に応答して前記移動量変換規則の設定を前記第1設定から前記第2設定に変更する

請求項5のシミュレーション装置。 - 前記生体情報を記憶する記憶部を具備し、

前記表示部は、前記記憶部に記憶された前記生体情報を表示する

請求項5又は6のシミュレーション装置。 - 作業者の現実の身体の位置情報を検出する位置検出部と、

仮想的な身体を仮想空間内に計算する身体計算部と、

前記仮想的な身体を含む前記仮想空間の画像を表示する表示部と、

制御部と、

仮想的な物体を前記仮想空間内に計算する物体計算部と、

前記仮想的な物体と接触している前記仮想的な身体の接触部位に対応した前記現実の身体の部位に触覚刺激を与える触覚刺激部と

を具備し、

前記身体計算部は、前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算し、前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算し、前記第2移動量ベクトルを反映させて前記仮想的な身体を計算し、

前記表示部は、前記画像の中の前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記制御部は、前記移動量変換規則の設定を前記第1設定から第2設定に変更し、

前記画像は前記仮想的な物体を含み、

前記物体計算部は、前記仮想的な物体が前記仮想的な身体に接触する運動をするように前記仮想的な物体を計算する

シミュレーション装置。 - 作業者に仮想空間内の仮想的な身体を自己の現実の身体であると錯覚させるステップと、

前記錯覚させるステップの後に、前記作業者に前記仮想空間内で所定の作業をさせるステップと

を具備し、

前記錯覚させるステップ及び前記作業をさせるステップは、

前記現実の身体の位置情報を検出するステップと、

前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算するステップと、

前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算するステップと、

前記第2移動量ベクトルを反映させて前記仮想的な身体を前記仮想空間内に計算するステップと、

表示部が、前記仮想的な身体を含む前記仮想空間の画像を表示するステップと

を備え、

前記表示部は、前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記錯覚させるステップにおいて、

前記移動量変換規則は前記第1設定に設定され、

前記作業をさせるステップは、

前記移動量変換規則の設定を前記第1設定から第2設定に変更するステップを備え、

シミュレーション方法。 - 作業者に仮想空間内の仮想的な身体を自己の現実の身体であると錯覚させるステップと、

前記錯覚させるステップの後に、前記作業者に前記仮想空間内で所定の作業をさせるステップと

を具備し、

前記錯覚させるステップ及び前記作業をさせるステップは、

前記現実の身体の位置情報を検出するステップと、

前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算するステップと、

前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算するステップと、

前記第2移動量ベクトルを反映させて前記仮想的な身体を前記仮想空間内に計算するステップと、

表示部が、前記仮想的な身体を含む前記仮想空間の画像を表示するステップと

を備え、

前記表示部は、前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記錯覚させるステップにおいて、

前記移動量変換規則は前記第1設定に設定され、

前記作業をさせるステップは、

前記移動量変換規則の設定を前記第1設定から第2設定に変更するステップを備え、

前記移動量変換規則の設定を前記第1設定から前記第2設定に変更するステップにおいては、前記第1移動量ベクトルの大きさと前記第2移動量ベクトルの大きさの比を変化させるように前記移動量変換規則の設定を変更する

シミュレーション方法。 - 作業者に仮想空間内の仮想的な身体を自己の現実の身体であると錯覚させるステップと、

前記錯覚させるステップの後に、前記作業者に前記仮想空間内で所定の作業をさせるステップと

を具備し、

前記錯覚させるステップ及び前記作業をさせるステップは、

前記現実の身体の位置情報を検出するステップと、

前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算するステップと、

前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算するステップと、

前記第2移動量ベクトルを反映させて前記仮想的な身体を前記仮想空間内に計算するステップと、

表示部が、前記仮想的な身体を含む前記仮想空間の画像を表示するステップと

を備え、

前記表示部は、前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記錯覚させるステップにおいて、

前記移動量変換規則は前記第1設定に設定され、

前記作業をさせるステップは、

前記移動量変換規則の設定を前記第1設定から第2設定に変更するステップを備え、

前記移動量変換規則の設定を前記第1設定から前記第2設定に変更するステップにおいては、前記第1移動量ベクトルが第1変化をする第1タイミングと前記第2移動量ベクトルが前記第1変化に応答した第2変化をする第2タイミングとのタイミング差を変化させるように前記移動量変換規則の設定を変更する

シミュレーション方法。 - 作業者に仮想空間内の仮想的な身体を自己の現実の身体であると錯覚させるステップと、

前記錯覚させるステップの後に、前記作業者に前記仮想空間内で所定の作業をさせるステップと

を具備し、

前記錯覚させるステップ及び前記作業をさせるステップは、

前記現実の身体の位置情報を検出するステップと、

前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算するステップと、

前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算するステップと、

前記第2移動量ベクトルを反映させて前記仮想的な身体を前記仮想空間内に計算するステップと、

表示部が、前記仮想的な身体を含む前記仮想空間の画像を表示するステップと

を備え、

前記表示部は、前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記錯覚させるステップにおいて、

前記移動量変換規則は前記第1設定に設定され、

前記作業をさせるステップは、

前記移動量変換規則の設定を前記第1設定から第2設定に変更するステップと、

仮想的な第1物体を前記仮想空間内に計算するステップと、

前記仮想的な第1物体を含む前記画像を表示するステップと、

前記仮想的な身体の少なくとも一部が、前記仮想的な第1物体を含むように前記仮想空間内に設定された領域に入った場合に、前記仮想的な身体が所定の運動をするように前記仮想的な身体を計算する身体強制運動ステップとを備え、

前記身体強制運動ステップにおいては、前記仮想的な身体は前記位置情報に基づかないで計算される

シミュレーション方法。 - 作業者に仮想空間内の仮想的な身体を自己の現実の身体であると錯覚させるステップと、

前記錯覚させるステップの後に、前記作業者に前記仮想空間内で所定の作業をさせるステップと

を具備し、

前記錯覚させるステップ及び前記作業をさせるステップは、

前記現実の身体の位置情報を検出するステップと、

前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算するステップと、

前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算するステップと、

前記第2移動量ベクトルを反映させて前記仮想的な身体を前記仮想空間内に計算するステップと、

表示部が、前記仮想的な身体を含む前記仮想空間の画像を表示するステップと

を備え、

前記表示部は、前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記錯覚させるステップにおいて、

前記移動量変換規則は前記第1設定に設定され、

前記作業をさせるステップは、

前記移動量変換規則の設定を前記第1設定から第2設定に変更するステップと、

前記仮想空間内における前記仮想的な身体及び前記領域の位置に基づいて、前記仮想的な身体から前記領域を見る方向への前記仮想的な身体の移動を示す強制移動量ベクトルを生成するステップと、

前記強制移動量ベクトルを反映させて前記仮想的な身体を前記仮想空間内に計算するステップを備える

シミュレーション方法。 - 前記作業をさせるステップは、

前記作業者の生体情報を検出するステップを備える

請求項9乃至13のいずれか1項に記載のシミュレーション方法。 - 前記移動量変換規則の設定を前記第1設定から前記第2設定に変更するステップ

においては、前記生体情報の所定の変化に応答して前記移動量変換規則の設定を変更する

請求項14のシミュレーション方法。 - 前記作業をさせるステップは、前記作業をさせるステップにおいて検出された前記生体情報を記憶するステップを備え、

前記作業をさせるステップの後に、前記作業をさせるステップにおいて検出された前記生体情報を表示するステップを備える

請求項14又は15のシミュレーション方法。 - 作業者に仮想空間内の仮想的な身体を自己の現実の身体であると錯覚させるステップと、

前記錯覚させるステップの後に、前記作業者に前記仮想空間内で所定の作業をさせるステップと

を具備し、

前記錯覚させるステップ及び前記作業をさせるステップは、

前記現実の身体の位置情報を検出するステップと、

前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算するステップと、

前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算するステップと、

前記第2移動量ベクトルを反映させて前記仮想的な身体を前記仮想空間内に計算するステップと、

表示部が、前記仮想的な身体を含む前記仮想空間の画像を表示するステップと

を備え、

前記表示部は、前記仮想的な身体を示す光が前記作業者と前記現実の身体とを結ぶ前記作業者の視線上を前記作業者に向かって進むように前記画像を表示し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記錯覚させるステップにおいて、

前記移動量変換規則は前記第1設定に設定され、

前記作業をさせるステップは、

前記移動量変換規則の設定を前記第1設定から第2設定に変更するステップを備え、

前記錯覚させるステップは、

仮想的な第2物体が前記仮想空間内で前記仮想的な身体に接触する第2運動をするように前記仮想的な第2物体を仮想空間内に計算するステップと、

前記仮想的な第2物体を含む前記画像を表示するステップと、

前記仮想的な第2物体と接触している前記仮想的な身体の接触部位に対応する前記現実の身体の部位に触覚刺激を与えるステップとを備える

シミュレーション方法。 - 作業者の現実の身体の位置情報を検出する位置検出部と、

仮想的な身体を仮想空間内に計算する身体計算部と、

仮想的な物体を前記仮想空間内に計算する物体計算部と、

前記仮想的な身体と前記仮想的な物体とを含む前記仮想空間の画像を表示する表示部と、

前記現実の身体を前記作業者の視界から隠す遮蔽物と、

制御部と、

前記仮想的な物体と接触している前記仮想的な身体の接触部位に対応した前記現実の身体の部位に触覚刺激を与える触覚刺激部と

を具備し、

前記物体計算部は、前記仮想的な物体が前記仮想的な身体に接触する運動をするように前記仮想的な物体を計算し、

前記身体計算部は、前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算し、前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算し、前記第2移動量ベクトルを反映させて前記仮想的な身体を計算し、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記制御部は、前記移動量変換規則の設定を前記第1設定から第2設定に変更する

シミュレーション装置。 - 作業者に仮想空間内の仮想的な身体を自己の現実の身体であると錯覚させるステップと、

前記錯覚させるステップの後に、前記作業者に前記仮想空間内で所定の作業をさせるステップと

を具備し、

前記錯覚させるステップ及び前記作業をさせるステップは、

前記現実の身体の位置情報を検出するステップと、

前記位置情報から前記現実の身体の移動を示す第1移動量ベクトルを計算するステップと、

前記第1移動量ベクトルから所定の移動量変換規則を用いて前記仮想的な身体の移動を示す第2移動量ベクトルを計算するステップと、

前記第2移動量ベクトルを反映させて前記仮想的な身体を前記仮想空間内に計算するステップと、

表示部が、前記仮想的な身体を含む前記仮想空間の画像を表示するステップと

を備え、

前記移動量変換規則は、第1設定において、前記作業者から見た前記現実の身体の移動量ベクトルと前記作業者から見た前記画像に表示された前記仮想的な身体の移動量ベクトルとが、始点、方向、及び大きさにおいて一致するように設定され、

前記錯覚させるステップにおいて、

前記移動量変換規則は前記第1設定に設定され、

前記錯覚させるステップは、

仮想的な物体が前記仮想空間内で前記仮想的な身体に接触する運動をするように前記仮想的な物体を仮想空間内に計算するステップと、

前記仮想的な物体を含む前記画像を表示するステップと、

前記仮想的な物体と接触している前記仮想的な身体の接触部位に対応する前記現実の身体の部位に触覚刺激を与えるステップとを備え、

前記作業をさせるステップは、

前記移動量変換規則の設定を前記第1設定から第2設定に変更するステップ

を備える

シミュレーション方法。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006134148A JP4906397B2 (ja) | 2006-05-12 | 2006-05-12 | シミュレーション装置及びシミュレーション方法 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006134148A JP4906397B2 (ja) | 2006-05-12 | 2006-05-12 | シミュレーション装置及びシミュレーション方法 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2007304973A JP2007304973A (ja) | 2007-11-22 |

| JP4906397B2 true JP4906397B2 (ja) | 2012-03-28 |

Family

ID=38838832

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2006134148A Active JP4906397B2 (ja) | 2006-05-12 | 2006-05-12 | シミュレーション装置及びシミュレーション方法 |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP4906397B2 (ja) |

Families Citing this family (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5324506B2 (ja) * | 2010-03-25 | 2013-10-23 | 麒麟麦酒株式会社 | 疑似体験装置 |

| JP5629144B2 (ja) * | 2010-06-28 | 2014-11-19 | 株式会社タイトー | ゲーム装置 |

| JP5934768B2 (ja) * | 2014-10-03 | 2016-06-15 | 株式会社タイトー | ゲーム装置 |

| KR102023024B1 (ko) * | 2018-11-09 | 2019-11-04 | 가천대학교 산학협력단 | 사용자의 상태정보에 따라 피드백을 제공하는 사용자의 정서 증진 및 심리파악을 위한 가상현실 시스템 |

| KR102021848B1 (ko) * | 2018-11-09 | 2019-09-17 | 가천대학교 산학협력단 | 사용자의 정서 증진 및 심리파악을 위한 가상현실 시스템 |

Family Cites Families (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2002082751A (ja) * | 2000-09-08 | 2002-03-22 | Mitsubishi Electric Corp | 仮想空間とのインタラクション装置およびこれを応用した仮想空間システム |

| JP2003330582A (ja) * | 2002-05-14 | 2003-11-21 | Univ Waseda | 視覚及び触覚を利用した感覚呈示装置 |

| JP2004013309A (ja) * | 2002-06-04 | 2004-01-15 | Canon Inc | 情報処理方法および複合現実感提示装置 |

| JP2005122233A (ja) * | 2003-10-14 | 2005-05-12 | Canon Inc | 情報処理装置および方法並びに記憶媒体 |

| JP2007219869A (ja) * | 2006-02-17 | 2007-08-30 | Nagoya Institute Of Technology | 仮想現実感呈示装置 |

-

2006

- 2006-05-12 JP JP2006134148A patent/JP4906397B2/ja active Active

Also Published As

| Publication number | Publication date |

|---|---|

| JP2007304973A (ja) | 2007-11-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| Adhanom et al. | Eye tracking in virtual reality: a broad review of applications and challenges | |

| Mayor et al. | A comparative study of virtual reality methods of interaction and locomotion based on presence, cybersickness, and usability | |

| Trepkowski et al. | The effect of narrow field of view and information density on visual search performance in augmented reality | |

| US8531354B2 (en) | Image generation system | |

| Miall et al. | Performing hand actions assists the visual discrimination of similar hand postures | |

| De Paolis et al. | The impact of the input interface in a virtual environment: the Vive controller and the Myo armband | |

| Porcino et al. | Minimizing cybersickness in head-mounted display systems: causes and strategies review | |

| JP2019515361A5 (ja) | ||

| US10304245B2 (en) | Method for operating a virtual reality system, and virtual reality system | |

| Bloomfield et al. | Collision awareness using vibrotactile arrays | |

| CN113031269A (zh) | 一种vr显示防眩晕调节系统 | |

| JP4906397B2 (ja) | シミュレーション装置及びシミュレーション方法 | |

| JP2024020292A (ja) | 動作要求システム、動作要求方法および動作要求プログラム | |

| Zhang et al. | Seeing our blind spots: smart glasses-based simulation to increase design students’ awareness of visual impairment | |

| Yokoro et al. | DecluttAR: an interactive visual clutter dimming system to help focus on work | |

| Hussain et al. | Virtual reality as a non-conventional rehabilitation for stroke: A comprehensive review | |

| EP3104764A1 (en) | Vision training method and apparatus | |

| WO2015198023A1 (en) | Ocular simulation tool | |

| EP3352052A1 (en) | Line-of-sight-based control device and medical device | |

| Kotranza et al. | Virtual multi-tools for hand and tool-based interaction with life-size virtual human agents | |

| JP6531811B1 (ja) | 物品判定教育訓練装置 | |

| KR20210063856A (ko) | 가상 현실 트레이닝 관련 추가 정보 제공 방법 및 장치 | |

| KR20170132044A (ko) | 공용 hmd장치 및 이를 구비한 게임기 | |

| WO2009022924A1 (en) | Image generation system | |

| Barbuceanu et al. | Eye tracking applications |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20090508 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20110620 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20110623 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20110815 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20110907 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20111107 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20120110 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20120110 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20150120 Year of fee payment: 3 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 4906397 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |