JP4825552B2 - 音声認識装置、周波数スペクトル取得装置および音声認識方法 - Google Patents

音声認識装置、周波数スペクトル取得装置および音声認識方法 Download PDFInfo

- Publication number

- JP4825552B2 JP4825552B2 JP2006068264A JP2006068264A JP4825552B2 JP 4825552 B2 JP4825552 B2 JP 4825552B2 JP 2006068264 A JP2006068264 A JP 2006068264A JP 2006068264 A JP2006068264 A JP 2006068264A JP 4825552 B2 JP4825552 B2 JP 4825552B2

- Authority

- JP

- Japan

- Prior art keywords

- frequency spectrum

- sound

- speech

- component

- noise

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Landscapes

- Image Analysis (AREA)

Description

音源502で発生する音s1(t)と音源504で発生する音s2(t)は統計的に独立であるから、x1(t)とx2(t)から抽出された統計的に独立な出力信号y1(t)とy2(t)は、一方が音源502で発生した音s1(t)であり、他方が音源504で発生した音s2(t)であると推定される。

例えば図6に示す例で、θ方向からの音を強調したい場合には、マイクロホン606で取得された音信号626と、マイクロホン604で取得された音信号624をΔt=dcosθ/λだけ遅延させた信号の和を算出することで、方向θからの音を強調した音信号を得ることができる。

また、マイクロホン606で取得された音信号626と、マイクロホン604で取得された音信号624をΔt=dcosθ/λだけ遅延させて正負を反転させた信号の和を算出し、この信号にスペクトル形状補正フィルタを適用することで、方向θからの音を抑圧した音信号を得ることができる。

上記のようにして、マイクロホン604、606、・・・の配置と音の方向に応じた遅延時間をそれぞれ設定しておく。そして、それぞれのマイクロホン604、606、・・・から入力される音信号を、音の方向に応じた遅延時間だけ遅延させてから和を算出する遅延和アレーを用いることで、特定の方向からの音を強調した信号を取得したり、逆に特定の方向からの音を抑圧した信号を取得したりすることができる。図7に、上記のような遅延和アレーを用いた場合の、特定の方向からの音を強調する指向特性702と、特定の方向からの音を抑圧する指向特性704の例を示す。図7では、θ=90°の方向、すなわちマイクロホン604、606、・・・の正面の方向からの音を強調したり抑圧したりする場合の指向特性を示している。

図8と図9は、マイクロホンの感度特性のばらつきが、遅延和アレーによって実現される指向特性に及ぼす影響を示している。図8はマイクロホンの感度特性のばらつきが、特定の方向からの音を強調する処理の際に用いられる指向特性に及ぼす影響を示す。分布702は全てのマイクロホンが同じ感度特性を持つ場合の理想的な指向特性を示す。分布810と分布812は、マイクロホンに感度特性のばらつきがある場合の指向特性を示す。ここでは一例として、マイクロホンの感度特性に±2dBのばらつきがある場合の指向特性を分布810で示し、マイクロホンの感度特性に±4dBのばらつきがある場合の指向特性を分布812で示す。図8から明らかなように、音声を強調する処理の際には、マイクロホンの感度特性のばらつきによって、わずかに指向特性が鈍化するものの、大きな影響はない。一方、図9はマイクロホンの感度特性のばらつきが、特定の方向からの音を抑圧する処理の際に用いられる指向特性に及ぼす影響を示す。分布704は全てのマイクロホンが同じ感度特性を持つ場合の理想的な指向特性を示す。分布910と分布912は、マイクロホンに感度特性のばらつきがある場合の指向特性を示す。ここでは一例として、マイクロホンの感度特性に±2dBのばらつきがある場合の指向特性を分布910で示し、マイクロホンの感度特性に±4dBのばらつきがある場合の指向特性を分布912で示す。図9から明らかなように、特定の方向からの音を抑圧する処理の際に用いられる指向特性は、マイクロホンの感度特性のばらつきによって、大きな影響を受ける。マイクロホン間の感度特性にばらつきがあると、特定の方向からの音について、ほとんど抑圧することができなくなってしまう。

上記の音声認識装置によれば、対話者の方向からの音声成分を強調した周波数スペクトルが基本周波数スペクトルとして取得されるため、対話者の音声成分をより鮮明に抽出することができる。言語内容の認識の精度をさらに向上することができる。

上記の音声認識装置によれば、画像データに基いて対話者の正確な方向を取得することができるため、音声成分強調手段において対話者の方向からの音声成分をより的確に強調することができる。さらに、上記の音声認識装置によれば、対話者の方向が所定の角度以上変化した時点で雑音成分推定手段のフィルタ行列の更新を行うため、不要な更新処理を行うことがなく、かつ必要な更新処理は確実に行うため、処理の負荷をさらに軽減して対話者の音声をより鮮明に抽出することができる。言語内容の認識の精度をさらに向上することができる。

すなわち、上記の音声認識装置は、対話者を繰り返し撮影し撮影された画像データを時刻と関連付ける撮像手段と、画像データから周囲の環境の変化を認識する環境認識手段をさらに備えており、更新判定手段が、周囲の環境が変化した場合にフィルタ行列の更新を行うと判定することも好ましい。

上記の音声認識装置によれば、雑音成分推定手段における独立成分分析で用いるフィルタ行列が必要な時にのみ更新されるため、雑音成分推定手段での演算の負荷が軽減される。音声認識に係る処理時間を短縮することができる。

(形態1)音声成分検出手段は、複数の原周波数スペクトルによる遅延和アレーを用いて、対話者の方向からの音声成分を強調した1の周波数スペクトルを基本周波数スペクトルとして取得する。

更新判定部204は、前回更新を行った際の対話者Vの方向を保持している。更新判定部204は、画像認識部202から新たに対話者Vの方向が入力されると、前回更新を行った際の対話者Vの方向との比較を行い、所定の角度以上変化しているか否かを評価する。対話者Vの方向が、前回の更新時点から所定の角度以上変化している場合に、更新判定部204は更新が必要であると判定する。更新が必要であると判定した場合、更新判定部204は、音声成分強調部210と雑音成分推定部212に、更新指示を出力する。

雑音成分推定部212は、マイクロホン112a、112b、112c、112d、112eおよび112fのそれぞれに対応する周波数スペクトルから、統計的に独立な2の周波数スペクトルを算出する、フィルタ行列を保持している。雑音成分推定部212は、統計的に独立な2の周波数スペクトルが算出されると、両者のうちの一方を雑音周波数スペクトルとして選択する。雑音周波数スペクトルの選択は、例えば雑音の周波数スペクトルとして典型的な周波数スペクトル形状を予め記憶しておき、その典型的な周波数スペクトル形状との類似性が高い方を、雑音周波数スペクトルとして選択することができる。雑音成分推定部212は、推定された雑音周波数スペクトルの時系列を、メル周波数変換部216へ出力する。

なお、雑音成分推定部212は、更新判定部204から更新指示が入力されると、保持されているフィルタ行列の最適化処理を行う。フィルタ行列の最適化処理は、例えばフィルタ行列によって分離される2の周波数スペクトルについてのコスト関数を最小化する手法によって行うことができる。

ステップS304では、周波数変換部208が、音データの周波数スペクトルを特定する。

ステップS306では、音声成分強調部210が、基本周波数スペクトルを算出する。

ステップS308では、雑音成分推定部212が、雑音周波数スペクトルを算出する。

なお本実施例の音声認識装置100では、ステップS306とステップS308は、ステップS304の後に、同時に並行して実施される。ステップS306とステップS308の両方の処理が終了した後、処理はステップS310へ移行する。

ステップS310では、基本周波数スペクトルと、雑音周波数スペクトルを、それぞれメル周波数に関するスペクトルに変換する。

ステップS312では、スペクトル減算部218が、基本メル周波数スペクトルから、雑音メル周波数スペクトルを減算(スペクトル・サブトラクション)して、音声メル周波数スペクトルを算出する。

ステップS314では、特徴量計算部220が、音声メル周波数スペクトルから、対話者Vの音声の特徴量であるMFCCを計算する。

ステップS316では、言語認識部222が、MFCCから言語の内容を認識して対応する文字列を特定する。

ステップS318では、応答制御部224が、特定された文字列に応じた適切な返答を生成する。

ステップS320では、スピーカ116から、返答が音声で出力される。

ステップS320の後、処理はステップS303へ移行し、上述の処理を繰り返し実行する。

ステップS404では、画像認識部202が、取得された画像データから対話者Vの方向を特定する。

ステップS406では、更新判定部204が、対話者Vの方向から、音声成分強調部210において音を強調する方向と、雑音成分推定部212におけるフィルタ行列の、更新が必要か否かを判断する。更新が必要と判定された場合(ステップS406でYESの場合)、処理はステップS408へ進む。更新が不要と判定された場合(ステップS406でNOの場合)、音声成分強調部210において音を強調する方向と、雑音成分推定部212のフィルタ行列について、更新をすることなく、図4の更新判定処理は終了する。

ステップS408では、音声成分強調部210において、音を強調する方向を更新する。

ステップS410では、雑音成分強調部212において、フィルタ行列の最適化処理を行って、フィルタ行列の更新を行う。

なお本実施例の音声認識装置100では、ステップS408とステップS410は、ステップS406で更新が必要と判定された後に、同時に並行して実施される。ステップS408とステップS410の両方の処理が終了した後、図4の更新判定処理は終了する。

また、本明細書または図面に説明した技術要素は、単独であるいは各種の組み合わせによって技術的有用性を発揮するものであり、出願時請求項記載の組み合わせに限定されるものではない。また、本明細書または図面に例示した技術は複数目的を同時に達成するものであり、そのうちの一つの目的を達成すること自体で技術的有用性を持つものである。

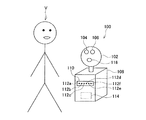

102:頭部

104:右カメラ

106:左カメラ

108:胴体部

110:集音部

112a、112b、112c、112d、112e、112f:マイクロホン

114:コントローラ

116:スピーカ

202:画像認識部

204:更新判定部

206:A/D変換部

208:周波数変換部

210:音声成分強調部

212:雑音成分推定部

214、216:メル周波数変換部

218:スペクトル減算部

220:特徴量計算部

222:言語認識部

224:応答制御部

226:D/A変換部

502、504:音源

506、508:マイクロホン

510:フィルタ行列

512:フィルタ最適化手段

602:音源

604、606:マイクロホン

610、612:経路

616、618:波面

620、622:点

624、626:音信号

702、704、810、812、910、912:指向特性の分布

1002:音データ

Claims (6)

- 対話者が話しかける音声から言語の内容を認識する音声認識装置であって、

音を入力して、音信号に変換する複数の音入力手段と、

音信号を周波数スペクトル(原周波数スペクトル)に変換する周波数変換手段と、

原周波数スペクトルから、対話者の音声成分を含む1の周波数スペクトル(基本周波数スペクトル)を取得する音声成分検出手段と、

複数の原周波数スペクトルから、フィルタ行列を用いる独立成分分析によって、雑音成分の1の周波数スペクトル(雑音周波数スペクトル)を取得する雑音成分推定手段と、

基本周波数スペクトルから雑音周波数スペクトルを減算して、対話者の音声成分の周波数スペクトル(音声周波数スペクトル)を取得するスペクトル減算手段と、

音声周波数スペクトルに基いて、対話者が話しかけた言語の内容を認識する言語内容認識手段と、

対話者の方向を取得する方向取得手段と、

フィルタ行列の更新を行うか否かを判定する更新判定手段を備えており、

更新判定手段は、対話者の方向が変化した場合に、フィルタ行列の更新を行うと判定し、

雑音成分推定手段は、更新判定手段によって更新を行うと判定された場合に、フィルタ行列の更新を行うことを特徴とする音声認識装置。 - 音声成分検出手段が、複数の原周波数スペクトルから、対話者の方向からの音声成分を強調した1の周波数スペクトルを基本周波数スペクトルとして取得することを特徴とする請求項1の音声認識装置。

- 方向取得手段が、対話者を繰り返し撮影し、撮影された画像データを時刻と関連付ける撮像手段と、画像データから、対話者の方向を特定する方向特定手段を備えることを特徴とする請求項1または2の音声認識装置。

- 更新判定手段が、対話者の方向がフィルタ行列の前回の更新時から所定の角度以上変化した場合に、フィルタ行列の更新を行うと判定することを特徴とする請求項1から3の何れか一項の音声認識装置。

- 対話者が話しかける音声の周波数スペクトルを取得する装置であって、

音を入力して、音信号に変換する複数の音入力手段と、

音信号を周波数スペクトル(原周波数スペクトル)に変換する周波数変換手段と、

原周波数スペクトルから、対話者の音声成分を含む1の周波数スペクトル(基本周波数スペクトル)を取得する音声成分検出手段と、

複数の原周波数スペクトルから、フィルタ行列を用いる独立成分分析によって、雑音成分の1の周波数スペクトル(雑音周波数スペクトル)を取得する雑音成分推定手段と、

基本周波数スペクトルから雑音周波数スペクトルを減算して、対話者の音声成分の周波数スペクトル(音声周波数スペクトル)を取得するスペクトル減算手段と、

対話者の方向を取得する方向取得手段と、

フィルタ行列の更新を行うか否かを判定する更新判定手段を備えており、

更新判定手段は、対話者の方向が変化した場合に、フィルタ行列の更新を行うと判定し、

雑音成分推定手段は、更新判定手段によって更新を行うと判定された場合に、フィルタ行列の更新を行うことを特徴とする周波数スペクトル取得装置。 - 対話者が話しかける音声から言語の内容を認識する音声認識方法であって、

複数の音入力手段によって、入力される音を音信号に変換する音入力工程と、

音信号を周波数スペクトル(原周波数スペクトル)に変換する周波数変換工程と、

原周波数スペクトルから、対話者の音声成分を含む1の周波数スペクトル(基本周波数スペクトル)を取得する音声成分検出工程と、

複数の原周波数スペクトルから、フィルタ行列を用いる独立成分分析によって、雑音成分の1の周波数スペクトル(雑音周波数スペクトル)を取得する雑音成分推定工程と、

基本周波数スペクトルから雑音周波数スペクトルを減算して、対話者の音声成分の周波数スペクトル(音声周波数スペクトル)を取得するスペクトル減算工程と、

音声周波数スペクトルに基いて、対話者が話しかけた言語の内容を認識する言語内容認識工程と、

対話者の方向を取得する方向取得工程と、

フィルタ行列の更新を行うか否かを判定する更新判定工程と、

更新判定工程において更新を行うと判定された場合に、フィルタ行列の更新を行う更新工程を備えており、

更新判定工程では、対話者の方向が変化した場合に、フィルタ行列の更新を行うと判定することを特徴とする音声認識方法。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006068264A JP4825552B2 (ja) | 2006-03-13 | 2006-03-13 | 音声認識装置、周波数スペクトル取得装置および音声認識方法 |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006068264A JP4825552B2 (ja) | 2006-03-13 | 2006-03-13 | 音声認識装置、周波数スペクトル取得装置および音声認識方法 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2007248534A JP2007248534A (ja) | 2007-09-27 |

| JP4825552B2 true JP4825552B2 (ja) | 2011-11-30 |

Family

ID=38592947

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2006068264A Active JP4825552B2 (ja) | 2006-03-13 | 2006-03-13 | 音声認識装置、周波数スペクトル取得装置および音声認識方法 |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP4825552B2 (ja) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN109850651A (zh) * | 2019-04-03 | 2019-06-07 | 东莞市达瑞电子股份有限公司 | 一种膜切机末端自动收料装置 |

Families Citing this family (12)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP4934580B2 (ja) * | 2007-12-17 | 2012-05-16 | 株式会社日立製作所 | 映像音声記録装置および映像音声再生装置 |

| JP5642339B2 (ja) * | 2008-03-11 | 2014-12-17 | トヨタ自動車株式会社 | 信号分離装置及び信号分離方法 |

| JP2010054954A (ja) * | 2008-08-29 | 2010-03-11 | Toyota Motor Corp | 音声強調装置及び音声強調方法 |

| JP2010124370A (ja) | 2008-11-21 | 2010-06-03 | Fujitsu Ltd | 信号処理装置、信号処理方法、および信号処理プログラム |

| JP5207479B2 (ja) | 2009-05-19 | 2013-06-12 | 国立大学法人 奈良先端科学技術大学院大学 | 雑音抑圧装置およびプログラム |

| JP2011002535A (ja) * | 2009-06-17 | 2011-01-06 | Toyota Motor Corp | 音声対話システム、音声対話方法、及びプログラム |

| KR101579534B1 (ko) * | 2014-10-16 | 2015-12-22 | 현대자동차주식회사 | 차량 및 그 제어방법과 이를 위한 마이크로폰 |

| JP6631694B2 (ja) * | 2016-03-17 | 2020-01-15 | 日本電気株式会社 | 捜索支援装置、捜索支援システム、捜索支援方法及びプログラム |

| CN113470621B (zh) * | 2021-08-23 | 2023-10-24 | 杭州网易智企科技有限公司 | 语音检测方法、装置、介质及电子设备 |

| CN114972868A (zh) * | 2022-05-27 | 2022-08-30 | 重庆交通大学 | 一种基于位移响应功率谱的桥梁移动荷载识别方法 |

| CN118354028B (zh) * | 2024-05-20 | 2024-09-27 | 国家电网有限公司信息通信分公司 | 基于机器学习的视频会议声音延迟检测方法及系统 |

| CN118645089B (zh) * | 2024-08-16 | 2024-12-20 | 罗普特科技集团股份有限公司 | 用于多维ai平台的语音识别方法 |

Family Cites Families (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003066986A (ja) * | 2001-08-23 | 2003-03-05 | Sharp Corp | 音声認識ロボット |

| JP4173978B2 (ja) * | 2002-08-01 | 2008-10-29 | 株式会社デンソー | 雑音除去装置、及び、音声認識装置、並びに音声通信装置 |

| JP2004133403A (ja) * | 2002-09-20 | 2004-04-30 | Kobe Steel Ltd | 音声信号処理装置 |

| JP2005031258A (ja) * | 2003-07-09 | 2005-02-03 | Canon Inc | 認識モデル学習装置及び方法 |

| JP4543731B2 (ja) * | 2004-04-16 | 2010-09-15 | 日本電気株式会社 | 雑音除去方法、雑音除去装置とシステム及び雑音除去用プログラム |

-

2006

- 2006-03-13 JP JP2006068264A patent/JP4825552B2/ja active Active

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN109850651A (zh) * | 2019-04-03 | 2019-06-07 | 东莞市达瑞电子股份有限公司 | 一种膜切机末端自动收料装置 |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2007248534A (ja) | 2007-09-27 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6520878B2 (ja) | 音声取得システムおよび音声取得方法 | |

| CN111370014B (zh) | 多流目标-语音检测和信道融合的系统和方法 | |

| US11790900B2 (en) | System and method for audio-visual multi-speaker speech separation with location-based selection | |

| JP6464449B2 (ja) | 音源分離装置、及び音源分離方法 | |

| JP4825552B2 (ja) | 音声認識装置、周波数スペクトル取得装置および音声認識方法 | |

| CN106872945B (zh) | 声源定位方法、装置和电子设备 | |

| JP6543848B2 (ja) | 音声処理装置、音声処理方法及びプログラム | |

| KR20090037692A (ko) | 혼합 사운드로부터 목표 음원 신호를 추출하는 방법 및장치 | |

| JP2006181651A (ja) | 対話型ロボット、対話型ロボットの音声認識方法および対話型ロボットの音声認識プログラム | |

| CN102388416A (zh) | 信号处理装置及信号处理方法 | |

| CN108630222B (zh) | 信号处理系统以及信号处理方法 | |

| JP2011191423A (ja) | 発話認識装置、発話認識方法 | |

| WO2007138503A1 (en) | Method of driving a speech recognition system | |

| JP7079189B2 (ja) | 音源方向推定装置、音源方向推定方法及びそのプログラム | |

| JP2004199053A (ja) | 絶対音量を使用して音声信号を処理する方法 | |

| JP2008064892A (ja) | 音声認識方法およびそれを用いた音声認識装置 | |

| WO2021206679A1 (en) | Audio-visual multi-speacer speech separation | |

| JP2023117068A (ja) | 音声認識装置、音声認識方法、音声認識プログラム、音声認識システム | |

| KR101811716B1 (ko) | 음성 인식 방법 및 그에 따른 음성 인식 장치 | |

| US20150039314A1 (en) | Speech recognition method and apparatus based on sound mapping | |

| KR102208536B1 (ko) | 음성인식 장치 및 음성인식 장치의 동작방법 | |

| CN113939871A (zh) | 讲话区间检测装置、讲话区间检测方法及讲话区间检测程序 | |

| JP5435221B2 (ja) | 音源信号分離装置、音源信号分離方法及びプログラム | |

| KR20180087038A (ko) | 화자 특성을 고려하는 음성합성 기능의 보청기 및 그 보청 방법 | |

| KR101430342B1 (ko) | 발화자의 거리 추정을 이용한 음성인식방법 및 음성인식장치 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20080709 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20101129 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20101221 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20110208 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20110906 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20110912 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 4825552 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20140916 Year of fee payment: 3 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| S111 | Request for change of ownership or part of ownership |

Free format text: JAPANESE INTERMEDIATE CODE: R313117 |

|

| R350 | Written notification of registration of transfer |

Free format text: JAPANESE INTERMEDIATE CODE: R350 |