JP2018009833A - Self-vehicle position specifying device and self-vehicle position specifying method - Google Patents

Self-vehicle position specifying device and self-vehicle position specifying method Download PDFInfo

- Publication number

- JP2018009833A JP2018009833A JP2016137478A JP2016137478A JP2018009833A JP 2018009833 A JP2018009833 A JP 2018009833A JP 2016137478 A JP2016137478 A JP 2016137478A JP 2016137478 A JP2016137478 A JP 2016137478A JP 2018009833 A JP2018009833 A JP 2018009833A

- Authority

- JP

- Japan

- Prior art keywords

- movement amount

- vehicle

- calculated

- unit

- reliability

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Granted

Links

Images

Landscapes

- Navigation (AREA)

- Image Processing (AREA)

- Image Analysis (AREA)

Abstract

【課題】地図上で特定される自車位置精度の低下を抑制することができる自車位置特定装置、及び自車位置特定方法を提供することを目的とする。【解決手段】ECU20は、特徴点の自車両を基準とする相対位置の変化を追跡し、追跡した相対位置の変化に基づいて自車両の第1の移動量を算出する移動量算出部26と、第1の移動量の信頼度を設定する信頼度設定部24とを備える。また、信頼度が閾値以上の場合に、第1の移動量に基づいて、自車両に搭載された車速検出部35の出力を補正するための車速補正値を算出する補正値算出部25と、信頼度が閾値以上の場合に、第1の移動量に基づいて、地図上の自車位置を特定する第1位置特定部26と、信頼度が閾値未満の場合に、車速補正値による補正後の車速検出部の出力により第2の移動量を算出し、算出された第2の移動量に基づいて地図上の自車位置を特定する第2位置特定部27と、を備える。【選択図】 図1An object of the present invention is to provide an own vehicle position specifying device and an own vehicle position specifying method capable of suppressing a decrease in accuracy of the own vehicle position specified on a map. An ECU (20) tracks a change in the relative position of a feature point with respect to the own vehicle, and calculates a first movement amount of the own vehicle based on the tracked change in the relative position. , and a reliability setting unit 24 for setting the reliability of the first movement amount. Further, a correction value calculation unit 25 for calculating a vehicle speed correction value for correcting the output of a vehicle speed detection unit 35 mounted on the own vehicle based on the first movement amount when the reliability is equal to or higher than the threshold; A first position identifying unit 26 that identifies the position of the vehicle on the map based on the first movement amount when the reliability is equal to or greater than the threshold; a second position specifying unit 27 that calculates a second movement amount based on the output of the vehicle speed detection unit 1 and specifies the position of the vehicle on the map based on the calculated second movement amount. [Selection diagram] Fig. 1

Description

本発明は、地図上の自車位置を特定する自車位置特定装置、及び自車位置特定方法に関する。 The present invention relates to a vehicle position specifying device and a vehicle position specifying method for specifying a vehicle position on a map.

従来、地図上の自車位置を特定する自車位置特定装置が知られている。例えば、自車位置特定装置は、自車両が備える車速センサの出力を積分することでこの自車両の移動量を算出し、算出した移動量に基づいて地図上での自車位置を特定する。 2. Description of the Related Art Conventionally, an own vehicle position specifying device that specifies an own vehicle position on a map is known. For example, the own vehicle position specifying device calculates the movement amount of the own vehicle by integrating the output of the vehicle speed sensor included in the own vehicle, and specifies the own vehicle position on the map based on the calculated movement amount.

また、自車両の周囲に存在する物体の当該自車両を基準とする相対位置の変化に基づいて、地図上の自車位置を特定する自車位置特定装置も知られている。特許文献1には、自車両が備えるステレオカメラによる撮像結果に基づいて、自車両を基準とした物体の相対位置の変化を算出し、算出した相対位置の変化に基づいて自車両の移動量を算出する。そして、この移動量を用いて地図上の自車位置を特定する。

There is also known an own vehicle position specifying device for specifying an own vehicle position on a map based on a change in relative position of an object existing around the own vehicle with respect to the own vehicle. In

車速センサの出力に基づいて算出される移動量は、車輪のスリップ等に起因して定常的に誤差を生じさせる。一方で、ステレオカメラを用いることで物体の三次元情報の変化に基づく自車両の移動量を算出することができるが、周囲の明度や物体を検出するための特徴の有無に応じて物体の検出精度が変化する場合がある。そのため、車速センサとステレオカメラとのいずれを用いて自車両の移動量を算出する場合においても、自車位置を特定するために算出される移動量の精度を低下させる場合がある。 The amount of movement calculated based on the output of the vehicle speed sensor causes an error steadily due to wheel slip or the like. On the other hand, by using a stereo camera, it is possible to calculate the amount of movement of the host vehicle based on the change in the three-dimensional information of the object, but the detection of the object according to the brightness of the surroundings and the presence of features for detecting the object The accuracy may change. Therefore, even when the movement amount of the own vehicle is calculated using either the vehicle speed sensor or the stereo camera, the accuracy of the movement amount calculated for specifying the vehicle position may be lowered.

本発明は上記課題に鑑みてなされたものであり、地図上で特定される自車位置精度の低下を抑制することができる自車位置特定装置、及び自車位置特定方法を提供することを目的とする。 The present invention has been made in view of the above problems, and an object of the present invention is to provide a vehicle position specifying device and a vehicle position specifying method that can suppress a decrease in the vehicle position accuracy specified on a map. And

上記課題を解決するために本発明では、第1撮像部と第2撮像部とによる自車周囲の撮像結果に基づいて物体の三次元情報を認識する物体認識部と、認識された前記物体の特徴点を抽出する特徴点抽出部と、前記特徴点の自車両を基準とする相対位置の変化を追跡し、追跡した前記相対位置の変化に基づいて前記自車両の第1の移動量を算出する移動量算出部と、前記第1の移動量の信頼度を設定する信頼度設定部と、前記信頼度が閾値以上の場合に、前記第1の移動量に基づいて、前記自車両に搭載された車速検出部の出力を補正するための車速補正値を算出する補正値算出部と、前記信頼度が閾値以上の場合に、前記第1の移動量に基づいて、地図上の自車位置を特定する第1位置特定部と、前記信頼度が閾値未満の場合に、前記車速補正値による補正後の前記車速検出部の出力により第2の移動量を算出し、算出された前記第2の移動量に基づいて前記地図上の前記自車位置を特定する第2位置特定部と、を備える。 In order to solve the above problem, in the present invention, an object recognition unit that recognizes three-dimensional information of an object based on an imaging result around the vehicle by the first imaging unit and the second imaging unit, and the recognized object A feature point extracting unit that extracts a feature point, a change in relative position of the feature point with respect to the own vehicle is tracked, and a first movement amount of the own vehicle is calculated based on the tracked change in the relative position Mounted on the host vehicle based on the first moving amount when the reliability is equal to or greater than a threshold value, and a reliability setting unit that sets the reliability of the first moving amount. A correction value calculation unit for calculating a vehicle speed correction value for correcting the output of the detected vehicle speed detection unit, and the vehicle position on the map based on the first movement amount when the reliability is equal to or greater than a threshold value A first position specifying unit for specifying the vehicle speed and the vehicle speed compensation when the reliability is less than a threshold value. A second position specifying unit that calculates a second movement amount based on the output of the vehicle speed detection unit after correction by a value, and specifies the vehicle position on the map based on the calculated second movement amount; .

第1撮像部と第2撮像部とによる撮像結果に基づいて自車両の移動量を算出する場合、物体の検出精度が低下することでこの物体の相対位置の変化を適正に検出できなくなる場合がある。一方で、各撮像部に代えて車速検出部からの出力に基づいて自車両の移動量を算出する場合、車輪のスリップ等により定常的に誤差が生じるものの、各撮像部による検出精度を低下させる条件の影響を受けることなく自車両の移動量を算出できるという利点がある。この点、上記構成では、特徴点の時系列での相対位置の変化により算出される第1の移動量の信頼度を算出する。そして、この信頼度が閾値以上の場合は、第1の移動量に基づいて車速検出部の出力を補正するための車速補正値を算出するとともに、第1の移動量を用いて自車位置を特定する。一方、信頼度が閾値未満の場合は、車速検出部の出力を車速補正値で補正することより算出される第2の移動量を用いて自車位置を特定することとした。この場合、各撮像部の検出精度が低下する条件下では、この条件の影響を受け難い車速検出部の補正後の出力により自車位置を特定できるため、自車位置の精度の低下を抑制することができる。 When the movement amount of the host vehicle is calculated based on the imaging results of the first imaging unit and the second imaging unit, the change in the relative position of the object may not be detected properly due to the decrease in the object detection accuracy. is there. On the other hand, when the amount of movement of the host vehicle is calculated based on the output from the vehicle speed detection unit instead of each imaging unit, the detection accuracy by each imaging unit is reduced, although errors constantly occur due to wheel slip or the like. There is an advantage that the amount of movement of the host vehicle can be calculated without being affected by conditions. In this regard, in the above configuration, the reliability of the first movement amount calculated by the change of the relative position of the feature points in time series is calculated. And when this reliability is more than a threshold value, while calculating the vehicle speed correction value for correct | amending the output of a vehicle speed detection part based on the 1st movement amount, the own vehicle position is calculated using the 1st movement amount. Identify. On the other hand, when the reliability is less than the threshold, the vehicle position is specified using the second movement amount calculated by correcting the output of the vehicle speed detection unit with the vehicle speed correction value. In this case, under conditions where the detection accuracy of each imaging unit is reduced, the vehicle position can be specified by the corrected output of the vehicle speed detection unit that is not easily affected by this condition, so that a decrease in accuracy of the vehicle position is suppressed. be able to.

本発明にかかる自車位置特定装置、及び自車位置特定方法の実施形態を図面と共に説明する。なお、以下の実施形態相互において、互いに同一もしくは均等である部分には、図中、同一符号を付しており、同一符号の部分についてはその説明を援用する。 Embodiments of a vehicle position specifying device and a vehicle position specifying method according to the present invention will be described with reference to the drawings. In the following embodiments, parts that are the same or equivalent to each other are denoted by the same reference numerals in the drawings, and the description of the same reference numerals is used.

(第1実施形態)

図1は、自車位置特定装置、及び自車位置特定方法を適用した車両制御装置100を示している。車両制御装置100は、例えば、車両に搭載される車両システムの一例であり、地図上での自車位置を特定し、特定結果に基づいて自車両の運転を支援する。

(First embodiment)

FIG. 1 shows a

図1に示すように、車両制御装置100は、各種センサ30と、自車位置特定装置として機能するECU20と、運転支援装置40と、を備えている。

As shown in FIG. 1, the

各種センサ30は、GPS受信機31、ステレオカメラ32、車速センサ35、ヨーレートセンサ36、を備えている。

The

GPS受信機31は、周知の衛星測位システム(GNSS)の一部として機能することで、衛星から送信される電波をGPS情報として受信する。GPS情報には、衛星の位置や電波が送信された時刻や、衛星の位置の誤差を示す情報であるDOP(誤差情報)が含まれている。GPS受信機31は、GPS情報を受信した受信時刻とGPS情報に含まれる発信時刻との差に基づいて、衛星から自車両CSまでの距離を算出する。そして、算出した距離と衛星の位置とをECU20に出力する。

The

ステレオカメラ32は、自車両CSの進行方向前方を撮像できるよう撮像軸を自車両CSの前方に向けた状態で車室内に設置されている。また、ステレオカメラ32は、車両横方向での位置の異なる第1撮像部33及び第2撮像部34を備えている。第1撮像部33及び第2撮像部34は、例えば、それぞれがCCDイメージセンサやCMOSイメージセンサで構成されており、車両中心から横方向(X軸方向)にそれぞれ左右にずれて配置されている。そのため、各撮像部33,34で撮像された右画像及び左画像とは、物体の見える角度が異なり、画像内の物体に対して両眼視差を生じさせている。また、各撮像部33,34で撮像された画像は、それぞれ所定周期でECU20に出力される。

The

車速センサ35は、自車両CSの車輪に動力を伝達する回転軸に設けられており、その回転軸の回転数に基づいて自車両CSの速度を検出する。ヨーレートセンサ36は、自車両CSの単位時間当たりでの向きの変化を、自車両CSに実際に発生したヨーレート、すなわち車両の重心点回りの角速度により検出する。車速センサ35が車速検出部として機能し、ヨーレートセンサ36が向き検出部として機能する。

The

ECU20は、CPU、ROM、RAMを備えたコンピュータとして構成されている。そして、CPUが、内部メモリに記憶されているプログラムを実行することにより、図1に示す各部として機能することができる。また、ECU20は、地図が記録された外部メモリ45に接続されており、この外部メモリ45から地図に記録された情報を読み出すことができる。

ECU20 is comprised as a computer provided with CPU, ROM, and RAM. The CPU can function as each unit shown in FIG. 1 by executing a program stored in the internal memory. The

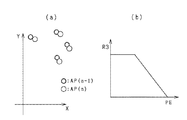

また、ECU20は、現在の地図上での自車位置CPを特定する。図2(a)は、時刻t1における自車位置CP(t1)を基準とする物体Obの相対位置Yr1と、時刻t2における自車位置CP(t2)を基準とする物体の相対位置Yr2と、を示している。物体Obの位置が移動しなければ、時刻t1から時刻t2での自車両CSの移動量TAは、時刻t1での相対位置Yr1と時刻t2での相対位置Yr2との差分と等しい関係となる。そのため、ECU20は、図2(b),(c)に示すように、ステレオカメラ32による時系列の異なる撮像結果に基づいて、物体Obの自車両CSを基準とする相対位置をそれぞれ算出する。そして、算出された相対位置の変化により、自車両CSの移動量を算出する。図2(a)の例では、時刻t1における自車位置CPに移動量TAを加えることで、時刻t2での自車位置CP(t2)を特定することができる。

Further, the

運転支援装置40は、ECU20が特定した自車位置CPに基づいて、自車両CSの走行を制御する。例えば、運転支援装置40は、自車位置CP、車速及びヨーレートにより自車両CSの将来の位置を予測し、予測した将来の位置と道路の認識結果とを用いて、自車両CSが区画白線等を逸脱するおそれがあるか否かを判断する。例えば、運転支援装置40が警報機能を有していれば、自車両が区画白線を逸脱するおそれがあると判断した場合、自車両CSが備えるディスプレイにより警告表示を行ったり、自車両CSが備えるスピーカにより警告音を発生させたりする。また、運転支援装置40が運転補助機能を有していれば、自車両CSが区画白線を逸脱するおそれがあると判断した場合、操舵装置に操舵力を加える。

The driving

上述した、ステレオカメラ32の撮像結果を用いた自車位置CPの特定において、周囲の明度や物体を検出するための特徴の有無に応じてステレオカメラ32の検出精度が低下する場合がある。物体Obの検出精度が低下することで、物体Obの自車両CSを基準とする相対位置に誤差が生じ、算出される自車両CSの移動量の精度を低下させる。一方で、車速センサ35の出力に基づいて算出される移動量は、車輪のスリップ等に起因して定常的に誤差を生じさせる。そこで、ECU20は、ステレオカメラ32の検出精度の悪化に伴う、自車位置CPの精度の低下を抑制するために、図1に示す各構成を備えている。

In the above-described specification of the vehicle position CP using the imaging result of the

図1に戻り、物体認識部21は、ステレオカメラ32による自車周囲の撮像結果に基づいて物体の三次元情報を認識する。物体認識部21は、第1撮像部33及び第2撮像部34により撮像された右画像と左画像とから、画素ブロック毎の視差情報を算出し、この視差情報に基づいて画素毎に三次元情報(X,Y,Z)を備える距離画像を生成する。そして、各画素を三次元情報に基づいてグループ化し、グループ化された各画素を物体として認識する。この時、各画素の三次元情報に加えて、各画素の輝度分布や画素毎に算出された移動方向ベクトルの向きを用いて各画素を物体としてグループ化してもよい。

Returning to FIG. 1, the

特徴点抽出部22は、物体認識部21により三次元情報が認識された物体の特徴点としてエッジ点Pを抽出する。例えば、特徴点抽出部22は、距離画像における三次元情報が認識された物体に対して周知のエッジ点抽出フィルタを用いて、濃度勾配が所定値以上の画素をエッジ点Pとして抽出する。

The feature

移動量算出部23は、三次元情報が認識された物体におけるエッジ点Pの自車両CSを基準とする相対位置の変化を追跡し、追跡した相対位置の変化に基づいて自車両CSの第1の移動量を算出する。

The movement

信頼度設定部24は、第1の移動量の信頼度を設定する。ここで、信頼度とは、第1の移動量の算出精度を示す指標値である。この信頼度が高い程、第1の移動量の算出精度が高くなり、逆に、信頼度が低い程、第1の移動量の算出精度が低くなる。信頼度の算出方法としては、例えば、第1の移動量を算出する際に用いたエッジ点Pの数や、このエッジ点Pを抽出した物体の類似度に基づいて算出される。

The

補正値算出部25は、信頼度が閾値Th1以上の場合に、第1の移動量に基づいて、自車両CSに搭載された車速センサ35の出力を補正するための補正値を算出する。この実施形態では、補正値として車速センサ35の出力におけるゲインを変更する補正係数を用いる。また、閾値Th1は、例えば、第1の移動量の算出精度として必要とされる値に基づいて、実験的に算出される値である。

The correction

第1位置特定部26は、信頼度が閾値Th1以上の場合に、第1の移動量に基づいて地図上の自車位置CPを特定する。また、第2位置特定部27は、信頼度が閾値Th1未満の場合に、車速補正値αによる補正後の車速センサ35の出力により第2の移動量を算出し、算出されたこの第2の移動量に基づいて地図上の自車位置CPを特定する。

The first

次に、ECU20により実施される地図上での自車位置CPの特定方法を、図3を用いて説明する。図3で示されるフローチャートは、ECU20により所定周期で実施される処理である。なお、以下では、ECU20が現在実施している図3の処理を今回の処理と記載し、前回の処理と区別する。

Next, a method for specifying the vehicle position CP on the map performed by the

ステップS11では、GPS情報を取得する。ECU20は、GPS受信機31で受信されたGPS情報を取得する。ステップS11が衛星情報取得部として機能する。

In step S11, GPS information is acquired. The

ステップS12では、ステップS11で取得したGPS情報の誤差を判定する。例えば、ECU20は、GPS情報に含まれるDOPに基づいてGPS情報の精度を判定する。これ以外にも、外部メモリ45に記録された地図を参照し、自車両CSの現在位置がトンネル等のGPS情報の受信精度が低下する位置である場合に、GPS情報の精度が低いと判定してもよい。

In step S12, the error of the GPS information acquired in step S11 is determined. For example, the

GPS情報の精度が高い場合(ステップS12:YES)、ステップS13に進み、GPS情報に基づいて自車両CSの地図上の位置を補正する。即ち、GPS情報の精度が高い場合は、このGPS情報に基づいて地図上での自車位置CPを特定する。そして、図3の処理を一旦終了する。 When the accuracy of the GPS information is high (step S12: YES), the process proceeds to step S13, and the position of the host vehicle CS on the map is corrected based on the GPS information. That is, when the accuracy of the GPS information is high, the vehicle position CP on the map is specified based on the GPS information. Then, the process of FIG. 3 is temporarily terminated.

一方、GPS情報の精度が低い場合(ステップS12:NO)、ステレオカメラ32又は車速センサ35の出力に基づいて、地図上での自車位置CPを特定する。まず、ステップS14では、自車両CSの周囲の物体の三次元情報を認識する。ECU20は、ステレオカメラ32の第1撮像部33と第2撮像部34とにより撮像された一対の画像に基づいて距離画像を生成し、この距離画像内での物体の三次元情報(X,Y,Z)を認識する。ステップS14が物体認識工程として機能する。

On the other hand, when the accuracy of the GPS information is low (step S12: NO), the vehicle position CP on the map is specified based on the output of the

ステップS15では、三次元情報が認識された物体におけるエッジ点Pを距離画像から抽出する。ステップS15が特徴点抽出工程として機能する。 In step S15, the edge point P in the object for which the three-dimensional information is recognized is extracted from the distance image. Step S15 functions as a feature point extraction step.

ステップS16では、ステップS15で抽出されたエッジ点Pの自車両CSを基準とする相対位置の変化を追跡し、追跡した相対位置の変化に基づいて自車両CSの第1の移動量を算出する。ステップS16が移動量算出工程として機能する。 In step S16, a change in the relative position of the edge point P extracted in step S15 with respect to the own vehicle CS is tracked, and a first movement amount of the own vehicle CS is calculated based on the tracked change in the relative position. . Step S16 functions as a movement amount calculation step.

図4は、図3のステップS16の処理を詳細に示すフローチャートである。ステップS31では、ステップS15でエッジ点Pを抽出した物体に所定の静止物が含まれているか否かを判定する。例えば、ECU20は、静止物として、電柱、ガードレール、標識、縁石等を識別するための辞書を記録しており、この辞書に基づいてエッジ点Pを抽出した物体が静止物であるか否かを判定する。これ以外にも、各物体を構成する画素の移動ベクトルを用いて物体が静止物であるか否かを判定してもよい。ステップS31が物体判定部として機能する。

FIG. 4 is a flowchart showing in detail the process of step S16 of FIG. In step S31, it is determined whether or not the object from which the edge point P is extracted in step S15 includes a predetermined stationary object. For example, the

図5(a)で一例として示す距離画像には、エッジ点Pが抽出された物体の内、ステップS31の処理において静止物として判定された物体Ob1〜Ob3が含まれている。図5(b)は、図5(a)に示す物体Ob2の一部を拡大して示しており、物体Ob2の外形やテクスチャを示す画素の濃度勾配に応じてエッジ点Pが抽出されている。 The distance image shown as an example in FIG. 5A includes objects Ob1 to Ob3 determined as stationary objects in the process of step S31 among the objects from which the edge points P are extracted. FIG. 5B is an enlarged view of a part of the object Ob2 shown in FIG. 5A, and the edge point P is extracted according to the density gradient of the pixels indicating the outer shape and texture of the object Ob2. .

エッジ点Pを抽出した物体に静止物が含まれていない場合(ステップS31:NO)、図4の処理を一旦終了する。この場合、エッジ点Pにおける相対位置の変化の探索を実施できないため、図3,4の処理を一旦終了する。 When the stationary object is not included in the object from which the edge point P is extracted (step S31: NO), the process of FIG. 4 is once ended. In this case, since the search for the change in the relative position at the edge point P cannot be performed, the processing of FIGS.

一方、静止物が含まれている場合(ステップS31:YES)、ステップS32では、今回生成された距離画像でのエッジ点Pの探索領域を設定する。例えば、ECU20は、前回特定された地図上での自車位置CPと前回算出された第1の移動量とを記録しており、各情報に基づいて今回の自車両CSの移動方向を予測する。そして、予測した自車両CSの移動方向に基づいて今回生成された距離画像におけるエッジ点Pの探索領域を設定する。図5(c)では、探索領域としてEA1〜EA3が設定されている。ステップS32が探索領域設定部として機能する。

On the other hand, if a stationary object is included (step S31: YES), in step S32, a search area for the edge point P in the distance image generated this time is set. For example, the

ステップS33〜S35では、エッジ点Pの追跡処理を実施する。この追跡処理では、図6(a)に示すように、時系列が異なる距離画像間において、エッジ点Pを対応付ける。そして、対応づけられたエッジ点Pの相対位置の変化を算出する。この実施形態では、一例として、異なる距離画像に含まれる物体間のテクスチャの類似度を判定し、類似度に応じて異なる距離画像内のエッジ点Pを対応付ける。 In steps S33 to S35, edge point P tracking processing is performed. In this tracking process, as shown in FIG. 6A, edge points P are associated between distance images having different time series. Then, a change in relative position of the associated edge point P is calculated. In this embodiment, as an example, texture similarity between objects included in different distance images is determined, and edge points P in different distance images are associated with each other according to the similarity.

まず、ステップS33では、物体のテクスチャの類似度を判定するために、前回生成された距離画像内において、各探索領域EAに含まれるエッジ点P周囲の輝度分布を示すヒストグラムを算出する。図6(b)は、前回生成された距離画像において、探索領域EA1に含まれるエッジ点Pの周囲の輝度分布を示すヒストグラムである。このヒストグラムでは、横軸を輝度B(例えば0〜255の階調数)とし、縦軸を各輝度の画素数PNとすることで、エッジ点P周囲の輝度分布を示している。 First, in step S33, in order to determine the similarity of the texture of the object, a histogram indicating the luminance distribution around the edge point P included in each search area EA is calculated in the previously generated distance image. FIG. 6B is a histogram showing the luminance distribution around the edge point P included in the search area EA1 in the previously generated distance image. In this histogram, the luminance distribution around the edge point P is shown by setting the horizontal axis as the luminance B (for example, the number of gradations of 0 to 255) and the vertical axis as the pixel number PN of each luminance.

ステップS34では、今回生成された距離画像の各探索領域EAに対して、ステップS33で算出したエッジ点Pの輝度分布に近い輝度分布の領域を探索する。例えば、ECU20は、今回生成された距離画像内の各探索領域に対して、ステップS33で算出された輝度分布との相関係数を算出する。そして、この相関係数が最も高い画素群をテクスチャの類似度が高い領域として判定し、判定した画素群に含まれるエッジ点Pを対応づける。例えば、図6(c)では、今回生成された距離画像において、探索領域EA11に含まれるエッジ点Pの周囲の輝度分布が、図6(b)に示す輝度分布と最も相関係数が高く、各画素群のエッジ点Pが対応づけられている。

In step S34, an area having a luminance distribution close to the luminance distribution of the edge point P calculated in step S33 is searched for each search area EA of the distance image generated this time. For example, the

ステップS35では、エッジ点Pの相対位置の変化を算出する。ECU20は、ステップS34において対応付けが行われた時系列が異なる距離画像内での各エッジ点Pの三次元情報の差を算出し、この差を相対位置の変化値とする。 In step S35, a change in the relative position of the edge point P is calculated. ECU20 calculates the difference of the three-dimensional information of each edge point P in the distance image from which the time series which matched in step S34 differed, and makes this difference the change value of a relative position.

各探索領域EA内での全てのエッジ点Pの追跡が実施されていない場合(ステップS36:NO)、ステップS33に戻り、エッジ点Pの追跡を継続する。一方、各探索領域EA内での全てのエッジ点Pの追跡が実施された場合(ステップS36:YES)、ステップS37に進む。 When tracking of all edge points P in each search area EA has not been performed (step S36: NO), the process returns to step S33, and the tracking of the edge points P is continued. On the other hand, when all the edge points P are tracked in each search area EA (step S36: YES), the process proceeds to step S37.

ステップS37では、ステップS35で算出された相対位置の変化に基づいて自車両CSの第1の移動量を算出する。図7に示すように、ECU20は、第1の移動量として、自車両CSの進行方向成分Vfy、横方向成分Vfx、回転方向成分Vfφ(角速度)と、を算出する。ここで、回転方向成分Vfφの算出は、例えば、ステレオカメラ32による撮像結果に基づいて自車両CSが走行する道路の中心線を認識し、この中心線を基準とする自車両CSの進行方向の傾きにより算出する。

In step S37, the first movement amount of the host vehicle CS is calculated based on the change in the relative position calculated in step S35. As shown in FIG. 7, the

なお、複数のエッジ点Pにおいて相対位置の変化の追跡が成功している場合、各エッジ点Pの相対位置の変化を平均し、平均値に基づいて第1の移動量を算出してもよい。 If tracking of changes in relative positions at a plurality of edge points P is successful, changes in relative positions of the respective edge points P may be averaged, and the first movement amount may be calculated based on the average value. .

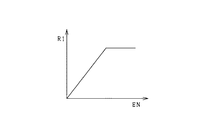

図3に戻り、ステップS17では、ステップS16で算出した移動量の信頼度を設定する。この第1実施形態では、ECU20は、ステップS16で追跡したエッジ点Pの数ENを算出し、算出したエッジ点Pの数ENが少ない程、信頼度を低く設定する。例えば、ECU20は、追跡に用いたエッジ点Pの数ENと信頼度との対応関係を規定するテーブルを記録している。図8に示すテーブルでは、追跡に用いたエッジ点Pの数ENが増加する程、信頼度R1が増加するようその値が定められている。ステップS17が信頼度設定工程として機能する。

Returning to FIG. 3, in step S17, the reliability of the movement amount calculated in step S16 is set. In the first embodiment, the

ステップS18では、ステップS17で算出した信頼度を、閾値Th1を用いて比較する。信頼度が閾値Th1以上であれば(ステップS18:YES)、ステップS19では、車速センサ35の出力を補正するための車速補正値αを算出する。例えば、車速補正値αは、下記式(1)を用いて算出される。

α=Vfy/Vpy … (1)

ここで、Vfyは、第1の移動量の内、進行方向成分の車速であり、Vpyは、車速センサの計測値(出力)である。

In step S18, the reliability calculated in step S17 is compared using a threshold value Th1. If the reliability is equal to or higher than the threshold Th1 (step S18: YES), a vehicle speed correction value α for correcting the output of the

α = Vfy / Vpy (1)

Here, Vfy is the vehicle speed of the traveling direction component in the first movement amount, and Vpy is the measurement value (output) of the vehicle speed sensor.

ステップS20では、ヨーレートセンサ36の出力を補正するための向き補正値βを算出する。例えば、向き補正値βは、下記式(2)を用いて算出される。

β=Vfφ/Vpφ … (2)

ここで、Vfφは、第1の移動量の内、回転方向成分(角速度)であり、Vpφは、ヨーレートセンサの計測値(出力)である。ステップS19,S20が補正値算出工程として機能する。

In step S20, a direction correction value β for correcting the output of the

β = Vfφ / Vpφ (2)

Here, Vfφ is a rotational direction component (angular velocity) in the first movement amount, and Vpφ is a measurement value (output) of the yaw rate sensor. Steps S19 and S20 function as a correction value calculation step.

ステップS21では、ステップS16で算出された第1の移動量に基づいて、自車位置CPを特定する。ECU20は、前回特定された自車位置CPから、ステップS16で算出された第1の移動量だけ地図上で変更した位置を今回の自車位置CPとして特定する。ステップS21が第1位置特定工程として機能する。

In step S21, the host vehicle position CP is specified based on the first movement amount calculated in step S16. The

一方、第1の移動量の信頼度が閾値Th1未満であれば(ステップS18:NO)、ステップS22に進む。この場合、信頼度が閾値Th1未満であるため、第1の移動量を自車位置CPの特定に用いると、地図上の自車位置CPの精度が低下するおそれがある。そのため、ステップS22以下では、ECU20は、車速センサ35の出力を用いて自車位置CPを特定する。

On the other hand, if the reliability of the first movement amount is less than the threshold Th1 (step S18: NO), the process proceeds to step S22. In this case, since the reliability is less than the threshold Th1, if the first movement amount is used for specifying the own vehicle position CP, the accuracy of the own vehicle position CP on the map may be lowered. Therefore, in step S22 and subsequent steps, the

ステップS22では、各補正値による補正後の車速センサ35の出力を第2の移動量として算出し、この第2の移動量に基づいて地図上の前記自車位置CPを特定する。具体的には、ECU20は、向き補正値βによる補正後のヨーレートセンサ36の出力を積分した値に基づいて、自車両CSの向きを特定する。次に、車速補正値αによる補正後の車速センサ35の主力を積分した値に基づいて、自車両CSの進行方向での移動量を算出する。例えば、補正後のヨーレートセンサ36の出力と補正後の車速センサ35の出力とは、下記式(3),(4)を用いて算出される。

In step S22, the output of the

AVpφ=βVpφ … (3)

AVpy=αVpy … (4)

ここで、Apφは、ヨーレートセンサ36の出力を向き補正値βで補正した値を示し、AVpyは、車速センサの出力を車速補正値αで補正した値を示す。

AVpφ = βVpφ (3)

AVpy = αVpy (4)

Here, Apφ represents a value obtained by correcting the output of the

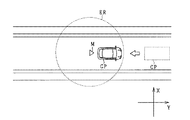

ステップS23では、ステップS22で特定された自車位置がGPS情報の誤差に基づいて算出される誤差範囲に含まれるか否かを判定する。例えば、ECU20は、ステップS11で受信したGPS情報に含まれるDOPに基づいて、GPS情報のみに基づいて特定される自車位置CPの誤差範囲を設定する。図9では、GPS情報に基づいて測位される位置を中心Mとして、同心円状に誤差範囲ERが設定されている。

In step S23, it is determined whether or not the vehicle position specified in step S22 is included in the error range calculated based on the error of the GPS information. For example, the

ステップS22で特定した自車位置CPが誤差範囲内であれば(ステップS23:YES)、図3の処理を一旦終了する。この場合、ステップS22で特定された地図上の自車位置CPは、GPS情報に基づく誤差範囲に収まるため、算出された位置を現在の自車位置CPとする。 If the own vehicle position CP specified in step S22 is within the error range (step S23: YES), the process of FIG. 3 is once ended. In this case, the own vehicle position CP on the map identified in step S22 falls within the error range based on the GPS information, and thus the calculated position is set as the current own vehicle position CP.

一方、ステップS22で特定した自車位置CPが誤差範囲を超える場合(ステップS23:NO)、ステップS24では、この自車位置CPを誤差範囲に収まるよう変更する。この場合、ECU20は、ステップS22で特定された自車位置CPをGPS情報に基づく誤差範囲の値に変更する。図9では、誤差範囲から外れていた自車位置CPが誤差範囲に収まるよう地図上での位置が変更されている。

On the other hand, when the own vehicle position CP specified in step S22 exceeds the error range (step S23: NO), in step S24, the own vehicle position CP is changed to be within the error range. In this case, the

ステップS22〜S24が第2位置特定工程として機能する。ステップS23の処理、又はステップS24の処理が終了すると、図3の処理を一旦終了する。 Steps S22 to S24 function as a second position specifying step. When the process of step S23 or the process of step S24 ends, the process of FIG. 3 is temporarily ended.

以上説明したように、この第1実施形態では、ECU20は、エッジ点Pの時系列での相対位置の変化により算出される第1の移動量の信頼度を算出する。そして、この信頼度が閾値Th1以上の場合は、第1の移動量に基づいて車速センサ35の出力を補正するための車速補正値αを算出するとともに、第1の移動量を用いて地図上での自車位置CPを特定する。一方、信頼度が閾値未満の場合は、車速補正値αによる補正後の車速センサ35の出力を第2の移動量として算出し、算出した第2の移動量に基づいて自車位置を特定することとした。この場合、各撮像部の検出精度が低下する条件下では、この条件の影響を受け難い車速センサ35の補正後の出力により自車位置CPを特定できるため、自車位置CPの精度の低下を抑制することができる。

As described above, in the first embodiment, the

ECU20は、エッジ点Pを抽出した物体が移動を伴わない所定の静止物であるか否かを判定し、静止物として判定された物体のエッジ点Pを追跡した相対位置の変化に基づいて、自車両CSの第1の移動量を算出する。静止物から抽出されるエッジ点Pの地図上の位置は変化することがないため、このエッジ点Pを追跡することで自車両CSと物体との間の相対位置の変化に起因する誤差を低減することができる。その結果、第1の移動量における信頼度の判定精度を高めることができる。

The

第1の移動量を算出するのに用いるエッジ点Pの数を比較した場合に、追跡した数が多いほど、算出される第1の移動量の頑健性が高くなり、その算出精度が向上する。この点、上記構成では、第1の移動量に対する信頼度をECU20が追跡したエッジ点Pの数に応じて設定することとした。この場合、算出精度が低い第1の移動量ほど、車速センサ35の出力を用いた第2の移動量に置き換えられ易くすることで、自車位置の精度の低下を抑制することができる。

When the number of edge points P used to calculate the first movement amount is compared, the more the number of tracked points, the higher the robustness of the calculated first movement amount and the higher the calculation accuracy. . In this regard, in the above configuration, the reliability for the first movement amount is set according to the number of edge points P tracked by the

車速センサ35で取得される計測値に対して、この計測値の補正を算出する際に用いられる移動量の向きを揃えることで、補正された車速センサ35の出力により算出される第2の移動量の精度を高めることができる。この点、上記構成では、ECU20は、第1の移動量として算出された自車両CSの進行方向成分により車速センサ35の出力を補正するための車速補正値αを算出することとした。この場合、各撮像部の検出精度が低下する条件下において、地図上での自車両CSの進行方向での位置精度の低下を抑制することができる。

The second movement calculated by the corrected output of the

車速センサ35による進行方向での移動量に加えて、ヨーレートセンサの出力により自車両CSの向きを加味することで、地図上の自車位置CPを精度良く特定することができる。この点、上記構成では、ECU20は、第1の移動量として算出された向きにより、ヨーレートセンサ36の出力を補正するための向き補正値βを算出し、車速補正値αによる補正後の車速センサ35の出力に加えて向き補正値による補正後の向き検出部の出力に基づいて、第2の移動量を算出することとした。この場合、自車両CSの移動時における向きを加味して自車位置を特定することができるため、自車両CSの走行時において向きが変化する場合でも、地図上での自車位置精度の低下を適正に抑制することができる。

In addition to the amount of movement in the traveling direction by the

衛星から送信される衛星情報に基づいて地図上での自車両CSの位置を推定し、この位置と第2の移動量とを用いて自車位置を特定する場合、特定した自車位置がこの衛星情報により求められる誤差範囲を超えて特定される可能性がある。この点、上記構成では、ECU20は、第2の移動量に基づいて特定された自車位置CPを誤差範囲と比較し、特定された自車位置CPが誤差範囲を超えている場合は、この誤差範囲に含まれるよう変更することとした。そのため、特定した自車位置CPが衛星から送信される情報の誤差以上に悪化することを抑制することができる。

When the position of the host vehicle CS on the map is estimated based on the satellite information transmitted from the satellite and the host vehicle position is specified using this position and the second movement amount, the specified host vehicle position is There is a possibility of being identified beyond the error range required by the satellite information. In this regard, in the above configuration, the

前回生成された距離画像でエッジ点Pが抽出された領域と今回生成された距離画像でエッジ点Pが抽出される領域とは近い位置となる可能性が高い。この点、上記構成では、ECU20は、前回特定された地図上の位置と前回算出された第1の移動量とに基づいて予測し、予測された自車両CSの移動方向に基づいて今回生成された距離画像において相対位置の変化を追跡するためのエッジ点Pの探索領域を設定することとした。この場合、追跡に用いるエッジ点Pの探索領域を絞り込むことができるため、第1の移動量の算出に要する時間を短縮することができる。

There is a high possibility that the region where the edge point P is extracted from the previously generated distance image and the region where the edge point P is extracted from the current generated distance image are close to each other. In this regard, in the above configuration, the

(第2実施形態)

この第2実施形態では、第1の移動量の算出の際に追跡したエッジ点Pが属する物体Obのテクスチャの類似度に応じて信頼度を設定する。

(Second Embodiment)

In the second embodiment, the reliability is set according to the texture similarity of the object Ob to which the edge point P tracked in calculating the first movement amount belongs.

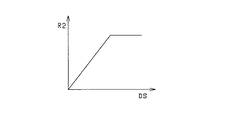

第1の移動量の算出に用いられる物体におけるテクスチャの類似度DSが高い程、ECU20によるエッジ点Pの対応づけのミスが減少する。そのため、この第2実施形態では、エッジ点Pが抽出された物体Obにおけるテクスチャの類似度DSが高い程、第1の移動量の信頼度を高く設定する。

As the texture similarity DS in the object used for the calculation of the first movement amount is higher, the mistake in associating the edge point P by the

この場合、図3のステップS17において、三次元情報を認識した時系列が異なる物体間での物体Ob間のテクスチャの類似度DSを算出し、算出した類似度DSに応じて第1の移動量の信頼度を設定する。物体Obのテクスチャの類似度DSの算出方法は、例えば、図6のステップS34で用いた輝度分布間の相関係数を算出することで行う。そして、この相関係数が小さい程、類似度DSを低い値に算出し、相関係数が大きい程、類似度DSを高い値に算出する。 In this case, in step S17 of FIG. 3, the texture similarity DS between the objects Ob between the objects having different time series in which the three-dimensional information is recognized is calculated, and the first movement amount is determined according to the calculated similarity DS. Set the confidence level. For example, the texture similarity DS of the object Ob is calculated by calculating the correlation coefficient between the luminance distributions used in step S34 in FIG. Then, the smaller the correlation coefficient, the lower the similarity DS is calculated, and the higher the correlation coefficient, the higher the similarity DS is calculated.

そして、ECU20は、テクスチャの類似度DSから第1の移動量の信頼度を算出する当たり、類似度DSと信頼度との対応関係を規定するテーブルを記録している。図10に示すテーブルでは、異なる距離画像間での物体の類似度DSが低い程、信頼度R2が低下するようその値が定められている。

The

以上説明したようにこの第2実施形態では、追跡に用いる物体のテクスチャの類似度を比較した場合、この類似度が高い程、エッジ点間の対応付けのミスが低減し、第1の移動量を適正に算出する可能性が高くなる。この点、上記構成では、ECU20は、第1の移動量に対する信頼度を第1撮像部33と第2撮像部34とによる撮像結果の異なる物体間におけるテクスチャの類似度に応じて設定することとした。この場合、エッジ点P間の対応付けのミスが高い第1の移動量ほど、第2の移動量に置き換えられ易くなるため、エッジ点Pの対応付けミスに起因する自車位置精度の低下を抑制することができる。

As described above, in the second embodiment, when the similarity of textures of objects used for tracking is compared, the higher the similarity is, the fewer correspondence errors between the edge points are, and the first movement amount. Is likely to be calculated appropriately. In this regard, in the above configuration, the

(第3実施形態)

この第3実施形態では、異なる自車位置CPから同一のエッジ点Pの位置をそれぞれ算出し、この位置のずれ量に基づいて第1の移動量の信頼度を算出する。

(Third embodiment)

In the third embodiment, the position of the same edge point P is calculated from different own vehicle positions CP, and the reliability of the first movement amount is calculated based on the shift amount of the position.

図11は、図3のステップS17で実施される処理を詳細に示すフローチャートである。図12は、第3実施形態における信頼度の算出手法を説明する図である。 FIG. 11 is a flowchart showing in detail the process performed in step S17 of FIG. FIG. 12 is a diagram illustrating a reliability calculation method according to the third embodiment.

図11のステップS41では、図3のステップS16において今回算出された第1の移動量に基づいて今回の自車位置CPを特定する。 In step S41 in FIG. 11, the current vehicle position CP is specified based on the first movement amount calculated in step S16 in FIG.

ステップS42では、前回生成された距離画像内におけるエッジ点Pの現在の相対座標上での位置AP(n−1)を算出する。ECU20は、前回の距離画像において三次元情報により認識されたエッジ点Pの相対位置を、今回特定された自車位置CP(n)を基準とする相対座標に投影することで、エッジ点Pの位置AP(n−1)を算出する。例えば、今回算出された第1の移動量に基づいて前回生成された距離画像内でのエッジ点Pの各位置を変更することで、各位置を相対座標内の位置AP(n−1)とする。ステップS41,ステップS42が位置算出部として機能する。

In step S42, a position AP (n-1) on the current relative coordinates of the edge point P in the previously generated distance image is calculated. The

ステップS43では、ステップS42で算出したエッジ点Pの相対座標上での位置AP(n−1)と、今回生成された距離画像内で抽出された同一のエッジ点Pの位置AP(n)とのずれ量を算出する。図12(a)では、各位置におけるそれぞれのエッジ点Pの相対座標上での位置を示している。ECU20は、算出された相対座標上の各エッジ点Pの位置のずれ量を、全てのエッジ点で総和する。

In step S43, the position AP (n-1) on the relative coordinates of the edge point P calculated in step S42, and the position AP (n) of the same edge point P extracted in the distance image generated this time. The amount of deviation is calculated. FIG. 12A shows the position on the relative coordinate of each edge point P at each position. The

ここで、エッジ点Pを静止物から抽出している場合、現在の相対座標上に投影される各エッジ点Pの位置は同じ位置となるはずである。そのため、相対座標上の各エッジ点Pの位置がずれている場合、ステップS41での自車位置CPの算出に用いた第1の移動量に誤差が生じている可能性が高くなる。また、第1の移動量の誤差が大きい程、地図上のエッジ点Pの位置のずれ量の総和が大きくなると考えられる。 Here, when the edge point P is extracted from a stationary object, the position of each edge point P projected on the current relative coordinate should be the same position. Therefore, when the position of each edge point P on the relative coordinates is shifted, there is a high possibility that an error has occurred in the first movement amount used for calculating the vehicle position CP in step S41. Further, it is considered that the sum of the shift amounts of the positions of the edge points P on the map increases as the error of the first movement amount increases.

そのため、ステップS44では、ステップS43で算出された各エッジ点Pのずれ量の総和に応じて、信頼度を設定する。現在の相対座標上での各エッジ点Pのずれ量の総和が大きくなる程、第1の移動量の誤差が大きいとみなし、信頼度を低い値に設定する。例えば、ECU20は、ステップS43で算出されたずれ量の総和PEと第1の移動量の信頼度R3との対応関係を規定するテーブルを記録している。図12(b)に示すテーブルでは、ずれ量の総和PEが増加する程、信頼度R3が低下するようその値が定められている。

Therefore, in step S44, the reliability is set according to the sum of the deviation amounts of the edge points P calculated in step S43. As the total sum of the shift amounts of the edge points P on the current relative coordinates increases, the first movement amount error is considered to be larger and the reliability is set to a lower value. For example, the

図3のステップS18に戻り、設定した信頼度R3に応じて、第1の移動量を用いた自車位置CPの特定、又は、第2の移動量を用いた自車位置CPの特定を行う。 Returning to step S18 in FIG. 3, the vehicle position CP using the first movement amount or the vehicle position CP using the second movement amount is specified according to the set reliability R3. .

ステップS42において、ECU20は、今回算出された第1の移動量に基づいて、前回より前のエッジ点Pの相対位置をエッジ点Pの現在の相対座標での位置として算出し、算出した位置と今回の撮像結果により抽出された同一のエッジ点Pの相対位置とのずれ量を算出してもよい。

In step S42, the

以上説明したようにこの第3実施形態では、静止物から抽出されるエッジ点Pの位置は変化することがないため、時系列の異なる距離画像内での各エッジ点Pの位置が異なる場合、自車位置CPを特定するために用いた第1の移動量に誤差が生じている可能性がある。この点、上記構成では、ECU20は、今回算出された第1の移動量に基づいて、前回又は前回より前のエッジ点Pの相対位置をエッジ点Pの現在の相対座標での位置として算出するとともに、算出した位置と今回の撮像結果により抽出された同一のエッジ点Pの相対位置とのずれ量を算出する。そして、算出されたずれ量が大きい程、信頼度を低く設定することとした。この場合、地図上の静止物から抽出されたエッジ点Pを基準とすることで、第1の移動量における信頼度の判定精度を高めることができる。

As described above, in the third embodiment, the position of the edge point P extracted from the stationary object does not change. Therefore, when the position of each edge point P in the time series different distance images is different, There is a possibility that an error has occurred in the first movement amount used for specifying the host vehicle position CP. In this regard, in the above configuration, the

(その他の実施形態)

ECU20は、GPS受信機31を備える構成としがこれに限定されず、GPS受信機31を備えていなくともよい。この場合、ECU20は、図3のステップS13で示したGPS情報により自車位置を特定する機能を有しないこととなる。

(Other embodiments)

The

自車両CSの進行方向での移動量のみに基づいて地図上の自車位置CPを特定するものであってもよい。この場合、図3のステップS22において、自車両CSの向きの特定は実施されず、車速補正値αによる補正後の車速センサ35の主力を積分した値に基づいて自車両CSの進行方向での移動量のみを算出する。

The vehicle position CP on the map may be specified based only on the amount of movement of the host vehicle CS in the traveling direction. In this case, in step S22 of FIG. 3, the direction of the host vehicle CS is not specified, and based on the value obtained by integrating the main force of the

上述した第1実施形態及び第2実施形態において、エッジ点Pを抽出する物体は所定の静止物に限定されず、隣接する走行レーンを低速で走行する他車両、又は歩行者であってもよい。例えば、低速で走行する物体から抽出したエッジ点Pに基づいて地図上の自車位置CPを特定する場合、ECU20は、物体から抽出されたエッジ点Pにより算出される物体の相対位置の変化に車速センサ35の出力を加えて、自車両の第1の移動量を算出する。そして、算出した第1の移動量に基づいて、地図上の自車位置を特定する。

In the first embodiment and the second embodiment described above, the object from which the edge point P is extracted is not limited to a predetermined stationary object, and may be another vehicle or a pedestrian traveling at a low speed on an adjacent traveling lane. . For example, when the host vehicle position CP on the map is specified based on the edge point P extracted from the object traveling at low speed, the

ECU20が参照する地図は、このECU20に接続された外部メモリ45に記録されている以外にも、ネットワークを経由して不図示のサーバーからダウンロードするものであってもよい。また、ECU20がI/Fを介してスマートフォン等の端末にアクセスできる場合に、この端末を介して地図を取得するものであってもよい。

The map referred to by the

21…物体認識部、22…特徴点抽出部、23…移動量算出部、24…信頼度設定部、25…補正値算出部、26…第1位置特定部、27…第2位置特定部、33…第1撮像部、34…第2撮像部、CP…自車位置、CS…自車両。

DESCRIPTION OF

Claims (10)

認識された前記物体の特徴点を抽出する特徴点抽出部と、

前記特徴点の自車両を基準とする相対位置の変化を追跡し、追跡した前記相対位置の変化に基づいて前記自車両の第1の移動量を算出する移動量算出部と、

前記第1の移動量の信頼度を設定する信頼度設定部と、

前記信頼度が閾値以上の場合に、前記第1の移動量に基づいて、前記自車両に搭載された車速検出部(35)の出力を補正するための車速補正値を算出する補正値算出部と、

前記信頼度が閾値以上の場合に、前記第1の移動量に基づいて、地図上の自車位置を特定する第1位置特定部と、

前記信頼度が閾値未満の場合に、前記車速補正値による補正後の前記車速検出部の出力により第2の移動量を算出し、算出された前記第2の移動量に基づいて前記地図上の前記自車位置を特定する第2位置特定部と、を備える自車位置特定装置。 An object recognizing unit for recognizing three-dimensional information of an object based on a result of imaging around the vehicle by the first imaging unit (33) and the second imaging unit (32);

A feature point extraction unit for extracting feature points of the recognized object;

A movement amount calculation unit that tracks a change in the relative position of the feature point with respect to the own vehicle and calculates a first movement amount of the own vehicle based on the tracked change in the relative position;

A reliability setting unit for setting the reliability of the first movement amount;

When the reliability is greater than or equal to a threshold value, a correction value calculation unit that calculates a vehicle speed correction value for correcting the output of the vehicle speed detection unit (35) mounted on the host vehicle based on the first movement amount. When,

A first position specifying unit for specifying a vehicle position on a map based on the first movement amount when the reliability is equal to or greater than a threshold;

When the reliability is less than a threshold value, a second movement amount is calculated based on the output of the vehicle speed detection unit after correction by the vehicle speed correction value, and the map is based on the calculated second movement amount. A host vehicle position specifying device comprising: a second position specifying unit that specifies the host vehicle position.

前記移動量算出部は、前記静止物として判定された前記物体における前記特徴点の前記相対位置の変化に基づいて、前記自車両の第1の移動量を算出する、請求項1に記載の自車位置特定装置。 An object determination unit that determines whether the object from which the feature points are extracted is a predetermined stationary object that does not move;

The said movement amount calculation part calculates the 1st movement amount of the said own vehicle based on the change of the said relative position of the said feature point in the said object determined as the said stationary object. Car location device.

前記信頼度設定部は、前記特徴点が抽出された前記物体間の前記テクスチャの類似度が低い程、前記信頼度を低く設定する、請求項1又は請求項2に記載の自車位置特定装置。 The movement amount calculation unit compares textures between the objects having different time series of the imaging results of the first imaging unit and the second imaging unit, and is extracted from each object having a similar texture By tracking the change in the relative position of the feature point, the first movement amount is calculated,

3. The own vehicle position specifying device according to claim 1, wherein the reliability setting unit sets the reliability lower as the texture similarity between the objects from which the feature points are extracted is lower. .

前記信頼度設定部は、算出された前記ずれ量が大きい程、前記信頼度を低く設定する、請求項2に記載の自車位置特定装置。 Based on the first movement amount calculated this time, the relative position of the feature point before or before the previous time is calculated as a position in the current relative coordinates of the feature point, and the calculated position and the current position A position calculation unit that calculates a deviation amount from the relative position of the same feature point extracted by the imaging result;

The vehicle position specifying device according to claim 2, wherein the reliability setting unit sets the reliability low as the calculated deviation amount increases.

前記補正値算出部は、前記移動量算出部により算出された前記進行方向成分に基づいて、前記車速補正値を算出する、請求項1から請求項5のいずれか一項に記載の自車位置特定装置。 The movement amount calculation unit calculates a traveling direction component of the host vehicle as the first movement amount,

The vehicle position according to any one of claims 1 to 5, wherein the correction value calculation unit calculates the vehicle speed correction value based on the traveling direction component calculated by the movement amount calculation unit. Specific device.

前記補正値算出部は、前記信頼度が閾値以上の場合に、前記移動量算出部により算出された前記向きに基づいて、前記自車両に搭載された向き検出部(36)の出力を補正するための向き補正値を算出し、

前記第2位置特定部は、前記車速補正値による補正後の前記車速検出部の出力と前記向き補正値による補正後の前記向き検出部の出力とに基づいて、前記第2の移動量を算出し、算出された前記第2の移動量に基づいて前記地図上の前記自車位置を特定する、請求項6に記載の自車位置特定装置。 A direction calculation unit for calculating the direction of the host vehicle;

The correction value calculation unit corrects the output of the direction detection unit (36) mounted on the host vehicle based on the direction calculated by the movement amount calculation unit when the reliability is equal to or greater than a threshold value. Calculate the orientation correction value for

The second position specifying unit calculates the second movement amount based on the output of the vehicle speed detection unit after correction by the vehicle speed correction value and the output of the direction detection unit after correction by the direction correction value. The host vehicle position specifying device according to claim 6, wherein the host vehicle position on the map is specified based on the calculated second movement amount.

前記第2位置特定部は、前記第2の移動量に基づいて特定した前記自車位置が前記誤差情報に基づいて算出した誤差範囲を超える場合に、特定した前記自車位置を前記誤差範囲に含まれるよう変更する、請求項1から請求項7のいずれか一項に記載の自車位置特定装置。 A satellite information acquisition unit that acquires satellite information including the position of the satellite transmitted from the satellite and error information of the position of the satellite;

The second position specifying unit sets the specified vehicle position as the error range when the vehicle position specified based on the second movement amount exceeds an error range calculated based on the error information. The own vehicle position specifying device according to any one of claims 1 to 7, which is changed to be included.

前記第1の移動量又は前記第2の移動量に基づいて前回特定された前記地図上での前記自車位置と前回算出された前記第1の移動量とに基づいて前記自車両の移動方向を予測し、予測した前記自車両の移動方向に基づいて、今回生成された前記距離画像に対して、前記移動量算出部が前記第1の移動量を算出するために追跡する前記特徴点の探索領域を設定する探索領域設定部を備える、請求項1から請求項8のいずれか一項に記載の自車位置特定装置。 The object recognizing unit generates a distance image to which information indicating three-dimensional information of the object is added based on each image captured by the first imaging unit and the second imaging unit, and the distance image Recognizing the three-dimensional information of the object based on

The movement direction of the host vehicle based on the host vehicle position on the map specified last time based on the first movement amount or the second movement amount and the first movement amount calculated last time. And, based on the predicted movement direction of the host vehicle, the movement amount calculation unit tracks the feature point that is tracked to calculate the first movement amount with respect to the distance image generated this time. The own vehicle position specifying device according to any one of claims 1 to 8, further comprising a search area setting unit that sets a search area.

認識された前記物体の特徴点を抽出する特徴点抽出工程と、

前記特徴点の自車両を基準とする相対位置の変化を追跡し、追跡した前記相対位置の変化に基づいて前記自車両の第1の移動量を算出する移動量算出工程と、

前記第1の移動量の信頼度を設定する信頼度設定工程と、

前記信頼度が閾値以上の場合に、前記第1の移動量に基づいて、前記自車両に搭載された車速検出部の出力を補正するための車速補正値を算出する補正値算出工程と、

前記信頼度が閾値以上の場合に、前記第1の移動量に基づいて、地図上の自車位置を特定する第1位置特定工程と、

前記信頼度が閾値未満の場合に、前記車速補正値による補正後の前記車速検出部の出力により第2の移動量を算出し、算出された前記第2の移動量に基づいて前記地図上の前記自車位置を特定する第2位置特定工程と、を備える自車位置特定方法。 An object recognition step of recognizing three-dimensional information of an object based on an imaging result around the vehicle by the first imaging unit and the second imaging unit;

A feature point extraction step of extracting feature points of the recognized object;

A movement amount calculating step of tracking a change in relative position of the feature point with respect to the own vehicle and calculating a first movement amount of the own vehicle based on the tracked change in the relative position;

A reliability setting step of setting the reliability of the first movement amount;

A correction value calculating step of calculating a vehicle speed correction value for correcting an output of a vehicle speed detection unit mounted on the host vehicle based on the first movement amount when the reliability is equal to or greater than a threshold;

A first position specifying step of specifying a vehicle position on a map based on the first movement amount when the reliability is equal to or greater than a threshold;

When the reliability is less than a threshold value, a second movement amount is calculated based on the output of the vehicle speed detection unit after correction by the vehicle speed correction value, and the map is based on the calculated second movement amount. A vehicle position specifying method comprising: a second position specifying step of specifying the vehicle position.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016137478A JP6622664B2 (en) | 2016-07-12 | 2016-07-12 | Self-vehicle position specifying device and self-vehicle position specifying method |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016137478A JP6622664B2 (en) | 2016-07-12 | 2016-07-12 | Self-vehicle position specifying device and self-vehicle position specifying method |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2018009833A true JP2018009833A (en) | 2018-01-18 |

| JP6622664B2 JP6622664B2 (en) | 2019-12-18 |

Family

ID=60995342

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2016137478A Active JP6622664B2 (en) | 2016-07-12 | 2016-07-12 | Self-vehicle position specifying device and self-vehicle position specifying method |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP6622664B2 (en) |

Cited By (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2019133318A (en) * | 2018-01-30 | 2019-08-08 | トヨタ自動車株式会社 | Position estimation system |

| WO2020137313A1 (en) * | 2018-12-28 | 2020-07-02 | パナソニックIpマネジメント株式会社 | Localization device |

| JP2020118451A (en) * | 2019-01-18 | 2020-08-06 | 株式会社デンソーテン | Moving amount calculation device |

| JP7086245B1 (en) | 2021-03-18 | 2022-06-17 | 三菱電機株式会社 | Course generator and vehicle control device |

| EP3971525A4 (en) * | 2019-05-15 | 2022-06-22 | Nissan Motor Co., Ltd. | SELF-POSITIONING CORRECTION METHOD AND SELF-POSITIONING CORRECTION DEVICE |

Citations (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0618274A (en) * | 1991-05-22 | 1994-01-25 | Nec Home Electron Ltd | Car navigation system |

| JP2007078409A (en) * | 2005-09-12 | 2007-03-29 | Mitsubishi Electric Corp | Object positioning device |

| JP2009074859A (en) * | 2007-09-19 | 2009-04-09 | Toyota Central R&D Labs Inc | Motion measuring device and position measuring device |

| JP2009266003A (en) * | 2008-04-25 | 2009-11-12 | Hitachi Ltd | Object recognizing device and object recognizing method |

| JP2010197279A (en) * | 2009-02-26 | 2010-09-09 | Aisin Aw Co Ltd | Navigation system and program for navigation |

| JP2011232168A (en) * | 2010-04-27 | 2011-11-17 | Clarion Co Ltd | Navigation device |

| JP2012168788A (en) * | 2011-02-15 | 2012-09-06 | Toyota Central R&D Labs Inc | Motion estimation device and program |

| JP2016099172A (en) * | 2014-11-19 | 2016-05-30 | 株式会社豊田中央研究所 | Vehicle position estimation apparatus and program |

-

2016

- 2016-07-12 JP JP2016137478A patent/JP6622664B2/en active Active

Patent Citations (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH0618274A (en) * | 1991-05-22 | 1994-01-25 | Nec Home Electron Ltd | Car navigation system |

| JP2007078409A (en) * | 2005-09-12 | 2007-03-29 | Mitsubishi Electric Corp | Object positioning device |

| JP2009074859A (en) * | 2007-09-19 | 2009-04-09 | Toyota Central R&D Labs Inc | Motion measuring device and position measuring device |

| JP2009266003A (en) * | 2008-04-25 | 2009-11-12 | Hitachi Ltd | Object recognizing device and object recognizing method |

| JP2010197279A (en) * | 2009-02-26 | 2010-09-09 | Aisin Aw Co Ltd | Navigation system and program for navigation |

| JP2011232168A (en) * | 2010-04-27 | 2011-11-17 | Clarion Co Ltd | Navigation device |

| JP2012168788A (en) * | 2011-02-15 | 2012-09-06 | Toyota Central R&D Labs Inc | Motion estimation device and program |

| JP2016099172A (en) * | 2014-11-19 | 2016-05-30 | 株式会社豊田中央研究所 | Vehicle position estimation apparatus and program |

Cited By (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2019133318A (en) * | 2018-01-30 | 2019-08-08 | トヨタ自動車株式会社 | Position estimation system |

| WO2020137313A1 (en) * | 2018-12-28 | 2020-07-02 | パナソニックIpマネジメント株式会社 | Localization device |

| JP2020118451A (en) * | 2019-01-18 | 2020-08-06 | 株式会社デンソーテン | Moving amount calculation device |

| US11385254B2 (en) | 2019-01-18 | 2022-07-12 | Denso Ten Limited | Movement distance calculation device |

| JP7206938B2 (en) | 2019-01-18 | 2023-01-18 | 株式会社デンソーテン | Movement amount calculator |

| EP3971525A4 (en) * | 2019-05-15 | 2022-06-22 | Nissan Motor Co., Ltd. | SELF-POSITIONING CORRECTION METHOD AND SELF-POSITIONING CORRECTION DEVICE |

| US11754403B2 (en) | 2019-05-15 | 2023-09-12 | Nissan Motor Co., Ltd. | Self-position correction method and self-position correction device |

| JP7086245B1 (en) | 2021-03-18 | 2022-06-17 | 三菱電機株式会社 | Course generator and vehicle control device |

| JP2022143640A (en) * | 2021-03-18 | 2022-10-03 | 三菱電機株式会社 | Route generation device and vehicle control device |

Also Published As

| Publication number | Publication date |

|---|---|

| JP6622664B2 (en) | 2019-12-18 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US11205284B2 (en) | Vehicle-mounted camera pose estimation method, apparatus, and system, and electronic device | |

| KR102022388B1 (en) | Calibration system and method using real-world object information | |

| JP6241422B2 (en) | Driving support device, driving support method, and recording medium for storing driving support program | |

| US8594378B2 (en) | 3D object detecting apparatus and 3D object detecting method | |

| JP6622664B2 (en) | Self-vehicle position specifying device and self-vehicle position specifying method | |

| JP6626410B2 (en) | Vehicle position specifying device and vehicle position specifying method | |

| JP5278108B2 (en) | Moving object detection system and moving object detection method | |

| JP6649859B2 (en) | Vehicle position estimation device and vehicle position estimation method | |

| JP6278791B2 (en) | Vehicle position detection device, vehicle position detection method, vehicle position detection computer program, and vehicle position detection system | |

| CN103366155B (en) | Temporal coherence in unobstructed pathways detection | |

| JP2010097561A (en) | Vehicle periphery monitoring device | |

| JP6708730B2 (en) | Mobile | |

| JP2018036067A (en) | Own vehicle position recognition device | |

| JP2017138660A (en) | Object detection method, object detection device and program | |

| CN113780050A (en) | Advanced driver assistance system and method for detecting objects therein | |

| JP2017181476A (en) | Vehicle position detection device, vehicle position detection method, and computer program for vehicle position detection | |

| JP2018017668A (en) | Information processing device and information processing program | |

| US20200193184A1 (en) | Image processing device and image processing method | |

| KR102195040B1 (en) | Method for collecting road signs information using MMS and mono camera | |

| JP2013092820A (en) | Distance estimation apparatus | |

| CN116892949A (en) | Ground object detection device, ground object detection method and computer program for ground object detection | |

| JP2014130429A (en) | Photographing device and three-dimensional object area detection program | |

| US11477371B2 (en) | Partial image generating device, storage medium storing computer program for partial image generation and partial image generating method | |

| CN120070567A (en) | Vehicle positioning method, system and storage medium | |

| US20090074247A1 (en) | Obstacle detection method |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20181217 |

|

| TRDD | Decision of grant or rejection written | ||

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20191023 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20191029 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20191122 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 6622664 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |