JP2015040939A - Image-capturing device, control method therefor, and control program - Google Patents

Image-capturing device, control method therefor, and control program Download PDFInfo

- Publication number

- JP2015040939A JP2015040939A JP2013171247A JP2013171247A JP2015040939A JP 2015040939 A JP2015040939 A JP 2015040939A JP 2013171247 A JP2013171247 A JP 2013171247A JP 2013171247 A JP2013171247 A JP 2013171247A JP 2015040939 A JP2015040939 A JP 2015040939A

- Authority

- JP

- Japan

- Prior art keywords

- subject

- framing

- detected

- area

- frame

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Abstract

Description

本発明は、所謂フレーミング支援ズーム機能を有する撮像装置、その制御方法、および制御プログラムに関し、特に、人物を撮影の際の合焦精度を向上する制御方法に関する。 The present invention relates to an imaging apparatus having a so-called framing assist zoom function, a control method thereof, and a control program, and more particularly, to a control method for improving focusing accuracy when a person is photographed.

一般に、デジタルカメラなどの撮像装置には、ズームレンズの駆動によって光学的な変倍を行う光学ズーム機能と、撮像の結果得られた画像領域の一部を拡大して電子的な変倍を行う電子ズーム機能を備えたものがある。このようなズーム機能を用いて、望遠端(望遠側)で撮影する際には、撮像装置の向きを少し変更するか又は操作者の手ぶれなどによって、しばしば被写体がフレームアウトしてしまうことがある。 In general, in an imaging apparatus such as a digital camera, an optical zoom function that performs optical scaling by driving a zoom lens, and electronic scaling is performed by enlarging a part of an image area obtained as a result of imaging. Some have an electronic zoom function. When shooting at the telephoto end (telephoto side) using such a zoom function, the subject is often out of frame due to a slight change in the orientation of the imaging device or camera shake of the operator. .

このようなフレームアウトを防止するため、つまり、被写体がフレームアウトした際に即座に被写体を捉え直すため、フレーミングアシストズーム(フレーミング支援ズーム)と呼ばれる機能を備える撮像装置がある(特許文献1参照)。さらに、画像における被写体を検出して、当該検出情報に応じてズーム位置を変更する所謂オートズーム機能を備える撮像装置がある。 In order to prevent such a frame-out, that is, to capture the subject immediately when the subject is out of the frame, there is an imaging apparatus having a function called framing assist zoom (framing assist zoom) (see Patent Document 1). . Furthermore, there is an imaging apparatus having a so-called auto zoom function that detects a subject in an image and changes a zoom position according to the detection information.

また、被写体が画面における特定領域の限界位置に達すると、ズーム位置を広角方向にズームアウトさせるようにした撮像装置がある(特許文献2参照)。加えて、被写体が画面の中央部分にいる場合にズーム位置を望遠方向にズームインさせるようにした撮像装置がある(特許文献3参照)。 In addition, there is an imaging apparatus that zooms out the zoom position in the wide-angle direction when the subject reaches the limit position of the specific area on the screen (see Patent Document 2). In addition, there is an imaging device that zooms in on the zoom position in the telephoto direction when the subject is in the center of the screen (see Patent Document 3).

一方、撮像装置におけるオートフォーカス(以下AFという)制御において、撮像素子の所定領域(以下AF枠という)における被写体像に応じて得られた映像信号に基づいて画像の鮮鋭度を検出するようにしたものがある。ここでは、当該鮮鋭度をAF評価値とし、AF評価値が最大となるフォーカスレンズ位置(以下ピント位置ともいう)にフォーカスレンズを駆動制御して焦点調節を行うようにしている。 On the other hand, in autofocus (hereinafter referred to as AF) control in an image pickup apparatus, the sharpness of an image is detected based on a video signal obtained according to a subject image in a predetermined area (hereinafter referred to as an AF frame) of the image pickup device. There is something. Here, the sharpness is used as an AF evaluation value, and the focus lens is driven and controlled at a focus lens position where the AF evaluation value is maximized (hereinafter also referred to as a focus position) to perform focus adjustment.

特に、主被写体として人物を撮影する場合に画像に含まれる顔領域を検出して、その検出結果に応じてAF制御を行う撮像装置が知られている。例えば、検出された顔領域を含むようにしてAF枠を設定し、AF制御を行う撮像装置がある(特許文献4参照)。 In particular, there is known an imaging apparatus that detects a face area included in an image when a person is photographed as a main subject and performs AF control according to the detection result. For example, there is an imaging apparatus that performs AF control by setting an AF frame so as to include a detected face area (see Patent Document 4).

ところで、上述のように主被写体の顔領域を検出してAF制御を行う場合には、常に、検出された顔領域に追従してAF枠を設定してAF制御が行われる。しかしながら、例えば、主被写体が横を向いてしまった場合、目を閉じてしまった場合、又は他の被写体が一時的に主被写体を覆ってしまった場合などにおいては、連続的に主被写体の顔領域を検出するのが困難となる。つまり、常に顔領域が検出されるとは限らない。 By the way, when the AF control is performed by detecting the face area of the main subject as described above, the AF control is always performed by setting the AF frame following the detected face area. However, for example, when the main subject turns sideways, when the eyes are closed, or when another subject temporarily covers the main subject, the face of the main subject is continuously displayed. It becomes difficult to detect the region. That is, the face area is not always detected.

このため、顔領域が検出されている間においては、検出された顔領域に追従するように設定されたAF枠でAF制御を行い、顔が検出されなくなると、直前の顔領域が検出されていた状態で設定されていたAF枠を用いてAF制御を行うようにすることがある。 For this reason, while the face area is detected, AF control is performed with the AF frame set to follow the detected face area, and when no face is detected, the previous face area is detected. In some cases, AF control is performed using the AF frame set in the above state.

ところが、上記の手法では、主被写体が動いている場合などにおいては、直前の状態と同一の位置に顔領域が存在するとは限らず、設定されたAF枠が実際の顔領域の位置に追従できずに、AF制御の結果合焦状態から外れてしまうことがある。 However, with the above method, when the main subject is moving, the face area does not always exist at the same position as the previous state, and the set AF frame can follow the actual position of the face area. Without being in focus as a result of AF control.

特に、前述のフレーミングアシストズームを用いて主被写体のフレームアウトを防止しようとする場合、継続して主被写体に焦点を合わせることができなければ、主被写体のフレームアウトを防止することが困難となってしまう。 In particular, when trying to prevent the main subject from being out of frame using the framing assist zoom described above, it is difficult to prevent the main subject from being out of frame unless the main subject can be continuously focused. End up.

従って、本発明の目的は、フレーミング支援ズームを用いた撮像装置において、被写体の撮影の際の合焦精度を向上させることのできる撮像装置、その制御方法、および制御プログラムを提供することにある。 Accordingly, it is an object of the present invention to provide an imaging apparatus capable of improving the focusing accuracy in photographing an object, an control method thereof, and a control program in an imaging apparatus using a framing assist zoom.

上記の目的を達成するため、本発明のよる撮像装置は、少なくともズームレンズおよびフォーカスレンズを備える結像光学系を介して被写体を撮像する撮像装置であって、前記ズームレンズを前記結像光学系の光軸に沿って移動して撮影画像においてその撮影画角に前記被写体をフレーミングするフレーミング手段と、前記撮影画像における一部の領域に対応する画像データに応じて前記フォーカスレンズを前記光軸に沿って移動して焦点調節を行う焦点調節手段と、前記撮影画像において前記被写体を検出する被写体検出手段と、前記被写体検出手段によって前記被写体が検出されている状態から前記被写体が検出されない状態となった際、前記フレーミング手段によるフレーミングが実行中であると、前記一部の領域を前記撮影画像の予め定められた第1の領域に枠領域として設定する設定手段と、を有することを特徴とする。 In order to achieve the above object, an imaging apparatus according to the present invention is an imaging apparatus that images a subject via an imaging optical system including at least a zoom lens and a focus lens, and the zoom lens is connected to the imaging optical system. A framing means for framing the subject at the shooting angle of view in the captured image by moving along the optical axis of the image, and the focus lens on the optical axis according to image data corresponding to a partial area in the captured image. A focus adjustment unit that moves along the focus, a subject detection unit that detects the subject in the captured image, and a state in which the subject is not detected from a state in which the subject is detected by the subject detection unit. When the framing by the framing means is being executed, the partial area is preliminarily recorded in the captured image. A setting unit configured to set as a frame region in a first area defined, and having a.

本発明による制御方法は、少なくともズームレンズおよびフォーカスレンズを備える結像光学系を介して被写体を撮像する撮像装置の制御方法であって、前記ズームレンズを前記結像光学系の光軸に沿って移動して撮影画像においてその撮影画角に前記被写体をフレーミングするフレーミングステップと、前記撮影画像における一部の領域に対応する画像データに応じて前記フォーカスレンズを前記光軸に沿って移動して焦点調節を行う焦点調節ステップと、前記撮影画像において前記被写体を検出する被写体検出ステップと、前記被写体検出ステップで前記被写体が検出されている状態から前記被写体が検出されない状態となった際、前記フレーミングステップによるフレーミングが実行中であると、前記一部の領域を前記撮影画像の予め定められた第1の領域に枠領域として設定する設定ステップと、を有することを特徴とする。 A control method according to the present invention is a control method of an imaging apparatus that images a subject via an imaging optical system including at least a zoom lens and a focus lens, and the zoom lens is moved along an optical axis of the imaging optical system. A framing step of moving and framing the subject at the shooting angle of view in the captured image, and moving the focus lens along the optical axis according to image data corresponding to a part of the region of the captured image. A focus adjustment step for adjusting, a subject detection step for detecting the subject in the captured image, and a framing step when the subject is not detected from the state in which the subject is detected in the subject detection step. If the framing by And having a setting step of setting as a frame region in the first region is because, the.

本発明による制御プログラムは、少なくともズームレンズおよびフォーカスレンズを備える結像光学系を介して被写体を撮像する撮像装置で用いられる制御プログラムであって、前記撮像装置が備えるコンピュータに、前記ズームレンズを前記結像光学系の光軸に沿って移動して撮影画像においてその撮影画角に前記被写体をフレーミングするフレーミングステップと、前記撮影画像における一部の領域に対応する画像データに応じて前記フォーカスレンズを前記光軸に沿って移動して焦点調節を行う焦点調節ステップと、前記撮影画像において前記被写体を検出する被写体検出ステップと、前記被写体検出ステップで前記被写体が検出されている状態から前記被写体が検出されない状態となった際、前記フレーミングステップによるフレーミングが実行中であると、前記一部の領域を前記撮影画像の予め定められた第1の領域に枠領域として設定する設定ステップと、を実行させることを特徴とする。 A control program according to the present invention is a control program used in an imaging apparatus that images a subject via an imaging optical system including at least a zoom lens and a focus lens, and the zoom lens is installed in a computer included in the imaging apparatus. A framing step of moving along the optical axis of the imaging optical system and framing the subject at the shooting angle of view in a captured image, and the focus lens according to image data corresponding to a partial area in the captured image A focus adjustment step of moving along the optical axis to adjust the focus, a subject detection step of detecting the subject in the captured image, and detecting the subject from a state in which the subject is detected in the subject detection step When the framing step is not performed, When ring is running, characterized in that to execute setting steps, the setting the partial region as a frame region in a first area defined in advance in the captured image.

本発明によれば、被写体が検出されている状態から被写体が検出されない状態となった際にフレーミングが実行中であると、焦点調節を行う際に設定される枠領域(AF枠)を撮影画像の予め定められた第1の領域に設定するようにした。これにより、フレーミングを行っている際においても被写体の撮影の際の合焦精度を向上させることができる。 According to the present invention, if the framing is being executed when the subject is not detected from the state in which the subject is detected, the frame area (AF frame) set when performing the focus adjustment is captured. The first area is set in advance. As a result, even when framing is being performed, it is possible to improve the focusing accuracy when shooting the subject.

[第1の実施形態]

図1は、本発明の第1の実施形態による撮像装置の一例についてその構成を示すブロック図である。

[First Embodiment]

FIG. 1 is a block diagram showing the configuration of an example of an imaging apparatus according to the first embodiment of the present invention.

<撮像装置の全体構成>

図示の撮像装置は、例えば、デジタルカメラ(以下単にカメラと呼ぶ)であり、システム制御部115を有している。システム制御部115はカメラ全体の制御を司り、例えば、CPU、RAM、およびROMを有している。そして、CPUはROMに予め記録されたプログラムに従ってRAMを作業領域として用い、カメラの動作を制御する。

<Overall configuration of imaging device>

The illustrated imaging apparatus is, for example, a digital camera (hereinafter simply referred to as a camera) and includes a

撮影レンズユニット(以下単に撮影レンズと呼ぶ)100は、ズーム機能を備えている。ズームレンズ制御部101は、システム制御部115の制御下で焦点距離を変化させるズームレンズを駆動制御する。

The taking lens unit (hereinafter simply referred to as a taking lens) 100 has a zoom function. The zoom

絞り・シャッタ制御部102は、システム制御部115の制御下で光量を調節する絞りとシャッタとを駆動制御する。フォーカスレンズ制御部103は、システム制御部115の制御下でフォーカスレンズを駆動制御して、撮像素子104の受光面(撮像面ともいう)に焦点を合わせる。

The aperture /

なお、図示はしないが、ズームレンズ制御部101、絞り・シャッタ制御部102、およびフォーカスレンズ制御部103は、レンズなどの光学要素、絞り・シャッタなどの機構、そして、これらを駆動するために必要な各種装置を備えている。各種装置には、光学要素および上記の機構を駆動するためのアクチュエータ、当該アクチュエータを制御するための回路、およびD/A変換器などが含まれる。

Although not shown, the zoom

撮像素子104は、入射光(光学像)に応じた電気信号(アナログ信号)出力する。例えば、撮像素子104は、CCD又はCMOSイメージセンサであり、複数の光電変換素子を備えて、入射光を光電変換してアナログ信号である撮像信号(画像信号)を生成する。

The

撮像処理部105は、CDS(相関2重サンプリング)回路、非線形増幅回路、およびA/D変換部を備えている。CDS回路は、撮像素子104の出力である撮像信号におけるノイズを相関2重サンプリングによって除去する。非線形増幅回路は、ノイズが除去された撮像信号について信号増幅(ゲイン制御)を行う。そして、A/D変換部は、信号増幅された撮像信号をデジタル信号(画像データ)に変換する。

The

なお、撮像素子104および撮像処理部105が被写体の撮像によって画像データを得る撮像部として機能する。

Note that the

画像処理部106は、画像データについてガンマ補正および輪郭補正などの所定の画像処理を行う。さらに、画像処理部106は画像データに対してホワイトバランス処理を行う。フォーマット変換部107は、画像処理部106の出力である処理済み画像データを、記録および表示に適合するフォーマットにフォーマット変換する。

The

DRAM(ランダムアクセスメモリ)108は、高速の内蔵メモリであって、フォーマット変換された画像データ(変換済み画像データ)を一時的に記憶する高速バッファとして用いられる。また、DRAM108は、変換済み画像データを圧縮・伸張する際の作業用メモリとしても用いられる。画像記録部109は、メモリカードなどの記録媒体およびインターフェースを備えており、画像記録部109にはDRAM108に記憶された変換済み画像データが記録される。

A DRAM (random access memory) 108 is a high-speed built-in memory, and is used as a high-speed buffer that temporarily stores image data that has undergone format conversion (converted image data). The

AFゲート部110は、撮像処理部105の出力である画像データについて撮像素子104の全画素のうち自動焦点調整(AF)に用いられる領域(撮影画像の一部の領域)に対応する信号のみを領域画像データとして選択的に通過させる。

The

なお、以下の説明では、AFに用いられる領域(AF信号取得領域)をAF枠と呼ぶ。つまり、AF枠はAFの際に画像データの評価を行なう評価値枠である。 In the following description, an area used for AF (AF signal acquisition area) is referred to as an AF frame. That is, the AF frame is an evaluation value frame for evaluating image data during AF.

AF処理部112は、AFゲート部110の出力である領域画像データをバンドパスフィルタ処理して高周波成分を抽出する。そして、AF処理部112は、当該高周波成分に応じて領域画像データにおける輝度レベルの最大値と最小値との差分である輝度差成分を生成し、当該輝度差成分に基づいて焦点信号を生成する。

The

ここで、焦点信号は、領域画像データの鮮鋭度(コントラスト)を表す信号である。鮮鋭度は、撮像光学系の焦点状態によって変化するので、鮮鋭度を表す焦点信号は撮像光学系のAF評価値として用いられる。 Here, the focus signal is a signal representing the sharpness (contrast) of the area image data. Since the sharpness changes depending on the focus state of the imaging optical system, a focus signal representing the sharpness is used as an AF evaluation value of the imaging optical system.

さらに、システム制御部115は、AF処理部112によって算出されたAF評価値に基づいて合焦位置(焦点位置ともいう)を特定する。そして、システム制御部115は、フォーカスレンズ制御部103を制御してフォーカスレンズを光軸に沿って移動させてAF制御を行う。

Further, the

VRAM(画像表示用メモリ)116には、フォーマット変換された画像データ(ここでは、表示用画像データ)が記録される。操作表示部117は、システム制御部115の制御下で画像表示、操作補助のための表示、およびカメラ状態の表示を行う。操作表示部117には、撮影の際にはVRAM116に一時的に記録された画像データに応じた画像が撮影画面として表示される。

A VRAM (image display memory) 116 records format-converted image data (here, display image data). The

操作部118は、電源をON/OFFするためのメインスイッチの他、ズームレバー又はズームスイッチなどのズーム操作部材を備えている。このズーム操作部材はユーザによって操作され、ユーザはズーム操作部材によってシステム制御部115にズーミングを指示する。

The

システム制御部115はズーム操作部材の操作量およびその操作方向に基づいてズーム駆動速度および駆動方向を求めて、ズームレンズ制御部101によってズームレンズを光軸に沿って駆動制御する。さらに、操作部118にはフレーミングを支援するフレーミングアシストズーム機能(以下FAズーム機能とという)の開始および終了を指示するFAズームスイッチが備えられている。

The

上記のFAズームスイッチによってFAズーム機能の開始が指示されると、システム制御部115は顔検出部111によって撮像画面において被写体である人物(例えば、顔領域)を検出する。システム制御部115は、顔検出部111によって検出された顔領域の撮像画面における位置および大きさ(サイズ)を求める。

When the FA zoom switch is instructed to start the FA zoom function, the

システム制御部115は顔領域の位置およびサイズに応じて当該顔領域が撮像画面に納まらなくなると、撮像画面における画角が広角となるようにズームレンズ制御部101によってズームレンズを光軸に沿って駆動制御する。

When the face area does not fit on the imaging screen according to the position and size of the face area, the

さらに、システム制御部115は撮像画面における顔領域の大きさが所定の大きさよりも大きくなると、撮像画面における画角が広角となるようにズームレンズ制御部101によってズームレンズを光軸に沿って駆動制御する。

Further, the

一方、システム制御部115は、撮像画面における顔領域の大きさが所定の大きさよりも小さくなると、撮像画面における画角が望遠となるようにズームレンズ制御部101によってズームレンズを光軸に沿って駆動制御する。

On the other hand, when the size of the face area on the imaging screen is smaller than a predetermined size, the

これによって、ユーザである操作者はズーム操作を気にすることなく、被写体である人物を撮像画面に収めるようにカメラを動かすだけでよい。そして、万が一、フレームアウトしそうになっても自動的にズーム位置が変更されるので、簡単に画角合わせを行うことができる。 As a result, the operator who is a user only has to move the camera so that the person who is the subject is placed on the imaging screen without worrying about the zoom operation. Since the zoom position is automatically changed even if the frame is almost out, the angle of view can be easily adjusted.

顔検出部111は、画像処理部106の出力である処理済み画像データについて、既知の顔認識処理を施して、撮像画面における人物の顔領域を検出する。顔検出部111は、例えば、1フレーム周期又は数フレーム周期などの所定の周期で顔検出処理を行う。

The

前述のように、顔検出部111による顔領域の検出結果はシステム制御部115に送られる。なお、顔検出部111は、顔検認処理としては、例えば、処理済み画像データにおける各画素の階調色に基づいて肌色領域を抽出して、当該肌色領域と予め設定された顔の輪郭プレートとのマッチング度によって顔領域を検出する。

As described above, the detection result of the face area by the

さらに、既知のパターン認識を用いて、顔検出部111は目、鼻、および口などの顔の特徴点を抽出することによって顔検出を行うようにしてもよい。なお、顔検出処理の手法については、上述の手法に限らず他の手法を用いるようにしてよい。

Furthermore, the

システム制御部115は顔領域の検出結果に基づいてAFゲート部110を制御して、撮像画面における顔領域を含む位置にAF枠を設置する。また、システム制御部115は、AF処理部112の出力であるAF評価値に基づいてフォーカスレンズ制御部103を制御してフォーカスレンズを光軸に沿って駆動制御しAFを行う。

The

なお、図1に示す第1のスイッチ(SW1)113は、AFおよびAEなどの撮影スタンバイ動作(撮影準備動作)を行うためのスイッチである。また、第2のスイッチ(SW2)114は、第1のスイッチ113が操作された後、撮像を行う際に操作されるスイッチである。

A first switch (SW1) 113 shown in FIG. 1 is a switch for performing a shooting standby operation (shooting preparation operation) such as AF and AE. The second switch (SW2) 114 is a switch that is operated when imaging is performed after the

<FAズーム機能>

図2は、図1に示すカメラで行われるFAズームの一例を説明するためのフローチャートである。なお、図2に示すフローチャートにおける処理は、システム制御部115においてROMに予め記憶されたプログラムに従ってCPUが実行する。

<FA zoom function>

FIG. 2 is a flowchart for explaining an example of the FA zoom performed by the camera shown in FIG. 2 is executed by the CPU according to a program stored in advance in the ROM in the

カメラの電源がオンされると、システム制御部115は、操作部118からFAズーム機能の実行をする指示(実行指示)の有無を取得する(ステップS201)。そして、システム制御部115は実行指示があるか否かを判定する(ステップS202)。

When the camera is turned on, the

実行指示がないと(ステップS202において、NO)、システム制御部115はステップS201の処理に戻る。一方、実行指示があると(ステップS202において、YES)、システム制御部115は顔検出部111によって最新の撮影画像について顔検出処理を行って顔領域の有無(つまり、顔検出結果の有無)を取得する(ステップS203)。

If there is no execution instruction (NO in step S202), the

続いて、システム制御部115は、顔検出結果が存在するか否か、つまり、顔検出に成功したか否かを判定する(ステップS204)。顔検出に成功しないと(ステップS204において、NO)、システム制御部115はステップS204の処理に戻る。

Subsequently, the

顔検出に成功すると(ステップS204において、YES)、システム制御部115は、顔検出部111によって検出された顔領域の大きさが第1の所定サイズよりも大きいか否かを判定する(ステップS205)。顔領域の大きさが第1の所定サイズよりも大きいと、システム制御部115は撮影画像(つまり、撮像画面)の画角が広角になる方向に、ズームレンズ制御部101によってズームレンズを光軸に沿って駆動制御する(ステップS206)。

If the face detection is successful (YES in step S204), the

この際、システム制御部115は内蔵ROMに予め設計値として格納されたズームレンズの移動量だけズームレンズを駆動する。そして、システム制御部115はステップS201の処理に戻る。

At this time, the

顔領域の大きさが第1の所定サイズ以下であると、システム制御部115は顔領域の大きさが第2の所定サイズよりも小さいか否かを判定する(ステップS207)。ここで、第1の所定サイズ>第2の所定サイズである。

If the size of the face area is equal to or smaller than the first predetermined size, the

顔領域の大きさが第2の所定サイズ以上であると(ステップS207において、NO)、システム制御部115はステップS201の処理に戻る。一方、顔領域の大きさが第2の所定サイズよりも小さいと(ステップS207において、YES)、システム制御部115は撮影画像の画角が望遠になる方向に、ズームレンズ制御部101によってズームレンズを光軸に沿って駆動制御する(ステップS208)。

If the size of the face area is greater than or equal to the second predetermined size (NO in step S207),

この際、システム制御部115は内蔵ROMに予め設計値として格納されたズームレンズの移動量だけズームレンズを駆動する。そして、システム制御部115はステップS201の処理に戻る。

At this time, the

このようにして、FAズームを行うと、撮影対象である被写体がカメラに向かって近づいてくるなどして被写体の大きさが変化した場合であっても、自動的にズームレンズの位置(つまり、撮影画角)が変更されて、フレーミング操作を容易に行うことができる。 In this way, when the FA zoom is performed, even when the subject to be photographed approaches the camera and the size of the subject changes, the position of the zoom lens (that is, the subject automatically) The shooting angle of view is changed, and the framing operation can be easily performed.

なお、ここでは、顔検出部111で検出された顔領域を用いて被写体の大きさを判定するようにしたが。他の手法を用いて被写体の大きさを判定するようにしてもよい。

Here, the size of the subject is determined using the face area detected by the

<AF制御>

図3は、図1に示すカメラで行われるAF制御の一例を説明するためのフローチャートである。なお、図3に示すフローチャートにおける処理は、システム制御部115においてROMに予め記憶されたプログラムに従ってCPUが実行する。

<AF control>

FIG. 3 is a flowchart for explaining an example of AF control performed by the camera shown in FIG. Note that the processing in the flowchart shown in FIG. 3 is executed by the CPU in accordance with a program stored in advance in the ROM in the

AF制御を開始すると、システム制御部115は操作部118からFAズーム機能を実行する実行指示の有無を取得して実行指示があるか否かを判定する。つまり、システム制御部115はFAズームが実行中であるか否かを判定することになる(ステップS301)。

When the AF control is started, the

FAズーム機能の実行指示がないと(ステップS301において、NO)、システム制御部115は、後述する通常AFシーケンスを実行して(ステップS302)、ステップS301の処理に戻る。一方、FAズーム機能の実行指示があると(ステップS301において、YES)、システム制御部115は、後述するFAズーム用AFシーケンスを実行して(ステップS303)、ステップS301の処理に戻る。

If there is no FA zoom function execution instruction (NO in step S301), the

<通常用AFシーケンス>

図4は、図3に示す通常用AFシーケンスの一例を説明するためフローチャートである。

<Normal AF sequence>

FIG. 4 is a flowchart for explaining an example of the normal AF sequence shown in FIG.

通常用AFシーケンスを開始すると、システム制御部115は、顔検出部111によって最新の撮影画像について顔検出処理を行って顔領域の有無(つまり、顔検出結果の有無)を取得する(ステップS401)。そして、システム制御部115は、顔検出結果が存在するか否か、つまり、顔検出に成功したか否かを判定する(ステップS402)。

When the normal AF sequence is started, the

顔検出に成功すると(ステップS402において、YES)、検出された顔領域の撮像画面上の位置(位置情報)に応じて、当該顔領域を含む被写体に追従して移動するAF枠(以下顔枠と呼ぶ)を、AFゲート部110に設定する(ステップS403)。 If the face detection is successful (YES in step S402), an AF frame (hereinafter referred to as a face frame) that moves following the subject including the face area according to the position (position information) of the detected face area on the imaging screen. Is set in the AF gate unit 110 (step S403).

ここでは、位置情報として、顔領域が検出されたエリアの中心位置を用いてもよく、目、鼻、および口などの顔の特徴点の位置を用いるようにしてもよい。 Here, the center position of the area where the face area is detected may be used as the position information, and the positions of facial feature points such as eyes, nose and mouth may be used.

図5は、図1に示す顔検出部111によって検出された顔領域に応じた顔枠の設定を説明するための図である。そして、図5(a)は顔検出結果に応じた顔枠設定の一例を示す図であり、図5(b)は顔検出結果に応じた顔枠設定の他の例を示す図である。また、図5(c)は画角の中心部に設定された顔枠の一例を示す図である。

FIG. 5 is a diagram for explaining the setting of a face frame corresponding to the face area detected by the

図5(a)に示すように、システム制御部115は顔領域の位置情報に応じて、撮影画面上に顔枠600を設定する。図示の例では、顔領域603は正面(カメラの方向)を向いており、この顔枠600は顔領域603を含む位置に設定される。

As shown in FIG. 5A, the

再び図4を参照して、システム制御部115はAF処理部112を制御して、顔枠600で規定された領域(エリア)における画像データに基づいて生成されたAF評価値を取得する(ステップS404)。そして、システム制御部115は、顔領域が検出された状態であることを示すフラグ(以下顔検出中フラグと呼ぶ)を、内蔵RAMにセットする(ステップS405)。続いて、システム制御部115は、後述する顔非検出時間をクリアして初期値(つまり、ゼロ)に設定する(ステップS406)。

Referring to FIG. 4 again, the

顔検出に失敗すると(ステップS402において、NO)、システム制御部115は顔検出中フラグが内蔵RAMにセットされているか否かを判定する(ステップS407)。顔検出中フラグがセットされていると(ステップS407において、YES)、システム制御部115は顔枠を保持する時間である顔枠保持時間(第1の時間閾値)を設定する(ステップS408)。

If face detection fails (NO in step S402), the

なお、この顔枠保持時間は、システム制御部115に内蔵されたROMに予め設計値として記憶されている固定値である。

This face frame holding time is a fixed value stored in advance as a design value in the ROM built in the

次に、システム制御部115は、顔領域を検出できない状態が継続する継続時間としてカウントアップされた顔非検出時間が顔枠保持時間よりも小さいか否かを判定する(ステップS409)。顔非検出時間が顔枠保持時間よりも小さいと(ステップS409において、YES)、システム制御部115は、ステップS403で設定した顔枠(つまり、顔枠の位置)を保持する(ステップS410)。

Next, the

この結果、図5(b)に示すように、被写体604が動いても、顔枠601の位置は顔枠600と同一に位置に表示されることになる。つまり、被写体が顔領域を横向きとして動いて、顔領域が検出不可となっても、顔非検出時間<顔枠保持時間であれば、顔枠601の位置は顔枠600と同一に位置に表示される。

As a result, as shown in FIG. 5B, even if the subject 604 moves, the position of the

再び図4を参照して、システム制御部115はAF処理部112を制御して、顔枠601で規定された領域(エリア)における画像データに基づいて生成されたAF評価値を取得する(ステップS411)。そして、システム制御部115は顔非検出時間をカウントアップする(ステップS412)。

Referring to FIG. 4 again, the

顔検出中フラグがセットされていないと(ステップS407において、NO)、システム制御部115は被写体に追従しないAF枠(以下通常枠と呼ぶ)を設定する。つまり、システム制御部115は顔枠(通常枠)を撮像画面の所定の位置に設定する(ステップS413)。

If the face detection flag is not set (NO in step S407),

例えば、システム制御部115は、内蔵ROMに予め設計値として記憶された所定の大きさでAF枠(通常枠)をAFゲート部110に設定して、通常枠を撮像画面の所定の位置に表示する。

For example, the

ここでは、通常枠を表示する位置および大きさは予め設計値として設定するようにしたが、操作部118によってユーザが通常枠を設定する位置および大きさを指示するようにしてもよい。

Here, the position and size for displaying the normal frame are set as design values in advance. However, the user may instruct the position and size for setting the normal frame by the

続いて、システム制御部115は、AF処理部112を制御して、所定の位置に設定された通常枠で規定された領域(エリア)における画像データに基づいて生成されたAF評価値を取得する(ステップS414)。そして、システム制御部115は顔検出中フラグをクリアする(ステップS415)。

Subsequently, the

なお、顔非検出時間が顔枠保持時間以上であると(ステップS409において、NO)、システム制御部115は、ステップS413の処理に進んで通常枠を設定する。

If the face non-detection time is equal to or longer than the face frame holding time (NO in step S409), the

ステップS406、S412、又はS415の処理に続いて、システム制御部115は上述のようにして取得されたAF評価値に基づいて後述するAF処理を実行する(ステップS416)。その後、システム制御部115は、ステップS401の処理に戻る。

Subsequent to step S406, S412, or S415, the

ステップS416で行われるAF処理には、既知の手法が用いられる。例えば、システム制御部115は、AF評価値をモニタしつつAF評価値が最大となるように、フォーカスレンズ制御部103によってフォーカスレンズを駆動制御して合焦を行う。つまり、システム制御部115はフォーカスレンズ制御部103によってフォーカスレンズを駆動制御してAF評価値のピーク値を探索して合焦を行う。

A known method is used for the AF process performed in step S416. For example, the

なお、当該AF処理には、合焦が得られた状態においてフォーカスレンズを再駆動させる必要性の有無を判定するため、AF評価値の低下があったか否かを確認するなどの合焦を維持するための処理も含まれる。 In this AF process, in order to determine whether or not it is necessary to re-drive the focus lens in a state where the focus is obtained, the focus is maintained such as whether or not the AF evaluation value has been reduced. Processing is also included.

上述のようにして、通常用AFシーケンスにおいては、顔検出に失敗してから所定時間の間、顔枠を保持した状態でAF制御を行うようにしている。これによって、被写体の顔状態の変化(例えば、横を向いてしまったなど)又はユーザの手プレに起因する顔検出の失敗などの影響によってAF枠(顔枠)が頻繁に切り替わってしまう事態を防止することができる。 As described above, in the normal AF sequence, AF control is performed with the face frame held for a predetermined time after face detection failure. As a result, a situation in which the AF frame (face frame) is frequently switched due to an influence such as a change in the face state of the subject (for example, it turned sideways) or a face detection failure caused by the user's hand play. Can be prevented.

<FAズーム用AFシーケンス>

図6は、図3に示すFAズーム用AFシーケンスの一例を説明するためフローチャートである。

<FA zoom AF sequence>

FIG. 6 is a flowchart for explaining an example of the AF sequence for FA zoom shown in FIG.

FAズーム用AFシーケンスを開始すると、システム制御部115は、顔検出部111によって最新の撮影画像について顔検出処理を行って顔領域の有無(つまり、顔検出結果の有無)を取得する(ステップS501)。そして、システム制御部115は、顔検出結果が存在するか否か、つまり、顔検出に成功したか否かを判定する(ステップS502)。

When the FA zoom AF sequence is started, the

顔検出に成功すると(ステップS502において、YES)、検出された顔領域の撮像画面上の位置(位置情報)に応じて、当該顔領域を含む被写体に追従して移動する顔枠(AF枠)を、AFゲート部110に設定する(ステップS503)。 If the face detection is successful (YES in step S502), a face frame (AF frame) that moves following the subject including the face area according to the position (position information) of the detected face area on the imaging screen. Is set in the AF gate unit 110 (step S503).

なお、前述のように、位置情報として、顔領域が検出されたエリアの中心位置を用いてもよく、目、鼻、および口などの顔の特徴点の位置を用いるようにしてもよい。そして、ステップS503の処理による顔枠の設定によって、図5(a)に示すように撮影画面上に顔枠600が設定される。

As described above, as the position information, the center position of the area where the face area is detected may be used, or the positions of facial feature points such as eyes, nose, and mouth may be used. Then, the

続いて、システム制御部115はAF処理部112を制御して、顔枠600で規定された領域(エリア)における画像データに基づいて生成されたAF評価値を取得する(ステップS504)。そして、システム制御部115は顔検出中フラグ内蔵RAMにセットする(ステップS505)。

Subsequently, the

顔検出に失敗すると(ステップS402において、NO)、システム制御部115は顔検出中フラグが内蔵RAMにセットされているか否かを判定する(ステップS506)。顔検出中フラグがセットされていると(ステップS506において、YES)、システム制御部115は撮影画角の中心部(第1の領域)に所定の大きさでAF枠(枠領域)を通常枠としてAFゲート部110に設定する(ステップS507)。

If the face detection fails (NO in step S402), the

ここでは、通常枠を表示する大きさは予め設計値として設定するが、操作部118によってユーザが通常枠を設定する大きさを指示するようにしてもよい。

Here, the size for displaying the normal frame is set as a design value in advance, but the user may instruct the size for setting the normal frame by the

図5(c)に示すように、顔枠(通常枠)602は画角の中央部に設定される。図示の例では、被写体604が顔領域を横向きとして動いて、撮像画面の中央部に達しているので、顔枠602のエリアに顔領域が含まれている。

As shown in FIG. 5C, the face frame (normal frame) 602 is set at the center of the angle of view. In the example shown in the figure, the subject 604 moves with the face area facing sideways and reaches the center of the imaging screen, so the area of the

再び図6を参照して、システム制御部115はAF処理部112を制御して、顔枠602で規定された領域(エリア)における画像データに基づいて生成されたAF評価値を取得する(ステップS508)。

Referring to FIG. 6 again, the

顔検出中フラグがセットされていないと(ステップS506において、NO)、システム制御部115は被写体に追従しない通常枠を設定する。つまり、システム制御部115は顔枠(通常枠)を撮像画面の所定の位置に設定する(ステップS509)。

If the face detection flag is not set (NO in step S506),

前述のように、システム制御部115は、内蔵ROMに予め設計値として記憶された所定の大きさで通常枠をAFゲート部110に設定して、通常枠を撮像画面の所定の位置に表示する。ここでは、通常枠を表示する位置および大きさは予め設計値として設定するようにしたが、操作部118によってユーザが通常枠を設定する位置および大きさを指示するようにしてもよい。

As described above, the

続いて、システム制御部115は、AF処理部112を制御して、所定の位置に設定された通常枠で規定された領域(エリア)における画像データに基づいて生成されたAF評価値を取得する(ステップS510)。そして、システム制御部115は顔検出中フラグをクリアする(ステップS511)。

Subsequently, the

ステップS505、S508、又はS511の処理に続いて、システム制御部115は上述のようにして取得されたAF評価値に基づいて、ステップS416と同様にしてAF処理を実行する(ステップS512)。その後、システム制御部115は、ステップS501の処理に戻る。

Subsequent to step S505, S508, or S511, the

上述のようにして、FAズーム用AFシーケンスにおいては、顔検出に失敗すると、撮影画角の中央部にAF枠を設定してAF制御が行われる。 As described above, in the FA zoom AF sequence, when face detection fails, an AF frame is set at the center of the shooting angle of view and AF control is performed.

ところで、FAズーム機能は、ユーザが特定の被写体を撮影する際にフレーミングを容易にする機能である。よって、ユーザによってFAズーム機能の実行が指示されている際には、撮影画角の範囲には被写体がフレーミングされている可能性が高い。つまり、FAズームの実施中に、仮に顔検出に失敗したとしても、被写体がフレームアウトしている可能性は低い。この場合には、何らかの理由によって顔検出に失敗した可能性が高い。 By the way, the FA zoom function is a function that facilitates framing when a user photographs a specific subject. Therefore, when the execution of the FA zoom function is instructed by the user, there is a high possibility that the subject is framed within the shooting field angle range. That is, even if face detection fails during the FA zoom, the possibility that the subject is out of frame is low. In this case, there is a high possibility that face detection has failed for some reason.

さらに、撮影中の被写体がカメラに近づいてくるなどして、撮影中の被写体の大きさが変わるような場面では、ユーザはできる限り被写体を撮影画角の中央付近にフレーミングさせるようにカメラの撮影方向を調整するはずである。 Furthermore, when the subject being photographed approaches the camera and the size of the subject being photographed changes, the user shoots the camera to frame the subject as close to the center of the field of view as possible. The direction should be adjusted.

従って、FAズーム機能を実行が指示されている際のAF制御、つまり、FAズーム用AFシーケンスにおいては、顔検出に失敗した場合にAF枠を撮影画角の中央部に設定すれば、撮影中の被写体に合焦できる可能性を高めることができる。 Therefore, in AF control when the execution of the FA zoom function is instructed, that is, in the FA zoom AF sequence, if the AF frame is set at the center of the shooting angle of view when face detection fails, shooting is in progress. It is possible to increase the possibility of focusing on the subject.

このように、本発明の第1の実施形態では、FAズーム機能の実行が指示されていない場合のAF制御、つまり、通常用AFシーケンスでは、顔検出に失敗してから所定時間の間、顔枠を保持した状態でAF制御を行う。これによって、被写体の顔状態の変化(例えば、横を向いてしまった場合)又はユーザの手ブレに起因する顔検出の失敗などの影響によってAF枠が頻繁に切り替わってしまう事態を防止することができる。 As described above, in the first embodiment of the present invention, in the AF control when the execution of the FA zoom function is not instructed, that is, in the normal AF sequence, the face is detected for a predetermined time after the face detection fails. AF control is performed with the frame held. This prevents a situation where the AF frame is frequently switched due to a change in the face state of the subject (for example, when the subject is turned sideways) or a face detection failure due to a camera shake of the user. it can.

一方、FAズーム機能の実行が指示されている場合のAF制御、つまり、FAズーム用AFシーケンスでは、顔検出に失敗した際には、AF枠を撮影画角の中央部に設定しているので、撮影中の被写体に合焦させる可能性を高めることができる。 On the other hand, in the AF control when the execution of the FA zoom function is instructed, that is, in the AF sequence for FA zoom, when face detection fails, the AF frame is set at the center of the shooting angle of view. The possibility of focusing on the subject being shot can be increased.

[第2の実施形態]

次に、本発明の第2の実施形態によるカメラの一例について説明する。なお、第2の実施形態によるカメラの構成は図1に示すカメラと同様であるので、ここでは説明を省略する。また、第2の実施形態によるカメラで行われるFAズームは、図2で説明した処理と同様である。

[Second Embodiment]

Next, an example of a camera according to the second embodiment of the present invention will be described. The configuration of the camera according to the second embodiment is the same as that of the camera shown in FIG. The FA zoom performed by the camera according to the second embodiment is the same as the process described in FIG.

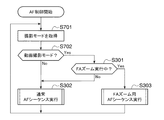

<AF制御>

図7は、本発明の第2の実施形態によるカメラで行われるAF制御を説明するためのフローチャートである。なお、図7に示すフローチャートにおける処理は、システム制御部115においてROMに予め記憶されたプログラムに従ってCPUが実行する。

また、図7に示すフローチャートおいて、図3に示すフローチャートと同一のステップについては同一の参照符号を付して説明を省略する。

<AF control>

FIG. 7 is a flowchart for explaining AF control performed by the camera according to the second embodiment of the present invention. Note that the processing in the flowchart shown in FIG. 7 is executed by the CPU according to a program stored in advance in the ROM in the

Further, in the flowchart shown in FIG. 7, the same steps as those in the flowchart shown in FIG.

AF制御を開始すると、システム制御部115は操作部118からユーザ操作による撮影モードを取得する(ステップS701)。そして、システム制御部115は撮影モードが静止画撮影モードであるか又は動画撮影モードであるかを判定する(ステップS702)。

When the AF control is started, the

撮影モードが動画撮影モードであると(ステップS702において、YES)、システム制御部115は前述のステップS301の処理に進んで、FAズームが実行中であるか否かを判定する。そして、FAズームが実行中であれば、システム制御部115はステップS303の処理に進んで、FAズーム用AFシーケンスを実行する。一方、FAズームが実行中でないと、システム制御部115はステップS302の処理に進んで、通常AFシーケンスを実行する。

If the shooting mode is the moving image shooting mode (YES in step S702),

撮影モードが動画撮影モードでないと(ステップS702において、NO)、つまり、撮影モードが静止画撮影モードである、システム制御部115はステップS302の処理に進んで、通常AFシーケンスを実行する。

If the shooting mode is not the moving image shooting mode (NO in step S702), that is, the shooting mode is the still image shooting mode, the

このように、本発明の第2の実施形態では、撮影モードが静止画撮影モードである場合および撮影モードが動画撮影モードでかつFAズーム機能の実行が指示されていない場合には、AF制御として通常用AFシーケンスを行う。つまり、顔検出に失敗してから所定時間の間、顔枠を保持した状態でAF制御を行う。 As described above, in the second embodiment of the present invention, AF control is performed when the shooting mode is the still image shooting mode and when the shooting mode is the moving image shooting mode and the execution of the FA zoom function is not instructed. A normal AF sequence is performed. That is, AF control is performed with the face frame held for a predetermined time after face detection failure.

これによって、被写体の顔状態の変化又はユーザの手ブレによる顔検出の失敗などの影響によってAF枠が頻繁に切り替わってしまう事態を防止することができる。 Accordingly, it is possible to prevent a situation in which the AF frame is frequently switched due to an influence of a change in the face state of the subject or a face detection failure due to a user's camera shake.

一方、撮影モードが動画撮影モードでかつFAズーム機能の実行が指示されている場合には、AF制御としてFAズーム用AFシーケンスを行う。つまり、顔検出に失敗した場合には、AF枠を撮影画角の中央部に設定するので、撮影中の被写体に合焦させる可能性を高めることができる。 On the other hand, when the shooting mode is the moving image shooting mode and execution of the FA zoom function is instructed, an AF sequence for FA zoom is performed as AF control. That is, when face detection fails, the AF frame is set at the center of the shooting angle of view, so that the possibility of focusing on the subject being shot can be increased.

なお、上述の実施の形態では、FAズーム用AFシーケンスでは、顔検出に失敗した際にAF枠を撮影画角の中央部に設定するものとした。例えば、システム制御部115は顔検出に成功している間において被写体の動きベクトルに応じて被写体の動き量(動き方向を含む)を常に算出するようにしてもよい。そして、システム制御部115は当該動き量を一時的にメモリなどに保存する。システム制御部115は顔検出に失敗した後、メモリに保存した動き量(動き方向を含む)に応じて被写体の位置(顔の位置)を推定して、当該推定位置にAF枠を設定するようにしてもよい。

In the above embodiment, in the AF sequence for FA zoom, the AF frame is set at the center of the shooting angle of view when face detection fails. For example, the

上述の説明から明らかなように、図1に示す例においては、撮像処理部105、画像処理部106、顔検出部111、システム制御部115、およびズームレンズ制御部101がフレーミング手段として機能する。また、撮像処理部105、画像処理部106、顔検出部111、システム制御部115、AFゲート110、AF処理部112、およびフォーカスレンズ制御部103が焦点調節手段として機能する。

As is clear from the above description, in the example shown in FIG. 1, the

さらに、顔検出部111は被写体検出手段として機能し、システム制御部115、AF処理部112、およびAFゲート110は設定手段として機能する。そして、操作部118およびシステム制御部115は撮影モード選択手段として機能し、撮像処理部105およびシステム制御部115は動き検出手段および推定手段として機能する。

Further, the

なお、図1に示す撮影レンズ100、ズームレンズ、絞り、シャッタ、フォーカスレンズは結像光学系を構成する。

The

以上、本発明について実施の形態に基づいて説明したが、本発明は、これらの実施の形態に限定されるものではなく、この発明の要旨を逸脱しない範囲の様々な形態も本発明に含まれる。 As mentioned above, although this invention was demonstrated based on embodiment, this invention is not limited to these embodiment, Various forms of the range which does not deviate from the summary of this invention are also contained in this invention. .

例えば、上記の実施の形態の機能を制御方法として、この制御方法を撮像装置に実行させるようにすればよい。また、上述の実施の形態の機能を有するプログラムを制御プログラムとして、当該制御プログラムを撮像装置が備えるコンピュータに実行させるようにしてもよい。なお、制御プログラムは、例えば、コンピュータに読み取り可能な記録媒体に記録される。 For example, the function of the above embodiment may be used as a control method, and this control method may be executed by the imaging apparatus. Further, a program having the functions of the above-described embodiments may be used as a control program, and the control program may be executed by a computer included in the imaging apparatus. The control program is recorded on a computer-readable recording medium, for example.

上記の制御方法および制御プログラムの各々は、少なくともフレーミングステップ、焦点調節ステップ、被写体検出ステップ、および設定ステップを有している。 Each of the above control method and control program has at least a framing step, a focus adjustment step, a subject detection step, and a setting step.

また、本発明は、以下の処理を実行することによっても実現される。つまり上述した実施形態の機能を実現するソフトウェア(プログラム)を、ネットワーク又は各種の記録媒体を介してシステム或いは装置に供給し、そのシステム或いは装置のコンピュータ(またはCPUやMPUなど)がプログラムを読み出して実行する処理である。 The present invention can also be realized by executing the following processing. That is, software (program) that realizes the functions of the above-described embodiments is supplied to a system or apparatus via a network or various recording media, and a computer (or CPU, MPU, or the like) of the system or apparatus reads the program. It is a process to be executed.

100 撮影レンズユニット

101 ズームレンズ制御部

103 フォーカスレンズ制御部

104 撮像素子

105 撮像処理部

106 画像処理部

110 AFゲート部

111 顔検出部

112 AF処理部

115 システム制御部

DESCRIPTION OF

Claims (9)

前記ズームレンズを前記結像光学系の光軸に沿って移動して撮影画像においてその撮影画角に前記被写体をフレーミングするフレーミング手段と、

前記撮影画像における一部の領域に対応する画像データに応じて前記フォーカスレンズを前記光軸に沿って移動して焦点調節を行う焦点調節手段と、

前記撮影画像において前記被写体を検出する被写体検出手段と、

前記被写体検出手段によって前記被写体が検出されている状態から前記被写体が検出されない状態となった際、前記フレーミング手段によるフレーミングが実行中であると、前記一部の領域を前記撮影画像の予め定められた第1の領域に枠領域として設定する設定手段と、

を有することを特徴とする撮像装置。 An imaging apparatus that images a subject via an imaging optical system including at least a zoom lens and a focus lens,

Framing means for moving the zoom lens along the optical axis of the imaging optical system and framing the subject at a shooting angle of view in a captured image;

Focus adjusting means for adjusting the focus by moving the focus lens along the optical axis in accordance with image data corresponding to a partial area in the captured image;

Subject detection means for detecting the subject in the captured image;

When the subject is not detected from the state in which the subject is detected by the subject detection unit, if the framing by the framing unit is being executed, the partial area of the captured image is determined in advance. Setting means for setting the first area as a frame area;

An imaging device comprising:

前記撮影モード選択手段によって前記動画撮影が選択される際、前記設定手段は、前記被写体検出手段によって前記被写体が検出されている状態から前記被写体が検出されない状態となると、前記フレーミング手段によるフレーミングが実行中である場合に、前記第1の領域を前記枠領域として設定することを特徴とする請求項1〜3のいずれか1項に記載の撮像装置。 A shooting mode selection means for selecting one of still image shooting and moving image shooting when imaging the subject;

When the moving image shooting is selected by the shooting mode selection unit, the setting unit performs framing by the framing unit when the subject is not detected from the state where the subject is detected by the subject detection unit. The imaging apparatus according to any one of claims 1 to 3, wherein the first area is set as the frame area when it is in the middle.

前記被写体検出手段によって前記被写体が検出されない状態となると、前記メモリに保存された動き情報に応じて前記撮影画像における前記被写体の位置を推定する推定手段とを有し、

前記設定手段は、前記推定手段によって推定された位置に前記枠領域を設定することを特徴とする請求項1〜6のいずれか1項に記載の撮像装置。 Motion detection means for obtaining a motion amount and a motion direction of the subject as motion information according to a motion vector of the subject and storing the motion information in a memory in a state where the subject is detected by the subject detection means;

Estimation means for estimating the position of the subject in the captured image according to the motion information stored in the memory when the subject detection means is in a state where the subject is not detected;

The imaging apparatus according to claim 1, wherein the setting unit sets the frame region at a position estimated by the estimation unit.

前記ズームレンズを前記結像光学系の光軸に沿って移動して撮影画像においてその撮影画角に前記被写体をフレーミングするフレーミングステップと、

前記撮影画像における一部の領域に対応する画像データに応じて前記フォーカスレンズを前記光軸に沿って移動して焦点調節を行う焦点調節ステップと、

前記撮影画像において前記被写体を検出する被写体検出ステップと、

前記被写体検出ステップで前記被写体が検出されている状態から前記被写体が検出されない状態となった際、前記フレーミングステップによるフレーミングが実行中であると、前記一部の領域を前記撮影画像の予め定められた第1の領域に枠領域として設定する設定ステップと、

を有することを特徴とする制御方法。 A method for controlling an imaging apparatus that images a subject via an imaging optical system including at least a zoom lens and a focus lens,

A framing step of moving the zoom lens along the optical axis of the imaging optical system and framing the subject at a shooting angle of view in a captured image;

A focus adjustment step of performing focus adjustment by moving the focus lens along the optical axis in accordance with image data corresponding to a partial region in the captured image;

A subject detection step of detecting the subject in the captured image;

When the subject is not detected from the state in which the subject is detected in the subject detection step, if the framing by the framing step is being executed, the partial area is determined in advance in the captured image. A setting step for setting the first region as a frame region;

A control method characterized by comprising:

前記撮像装置が備えるコンピュータに、

前記ズームレンズを前記結像光学系の光軸に沿って移動して撮影画像においてその撮影画角に前記被写体をフレーミングするフレーミングステップと、

前記撮影画像における一部の領域に対応する画像データに応じて前記フォーカスレンズを前記光軸に沿って移動して焦点調節を行う焦点調節ステップと、

前記撮影画像において前記被写体を検出する被写体検出ステップと、

前記被写体検出ステップで前記被写体が検出されている状態から前記被写体が検出されない状態となった際、前記フレーミングステップによるフレーミングが実行中であると、前記一部の領域を前記撮影画像の予め定められた第1の領域に枠領域として設定する設定ステップと、

を実行させることを特徴とする制御プログラム。 A control program used in an imaging apparatus that images a subject via an imaging optical system including at least a zoom lens and a focus lens,

In the computer provided in the imaging device,

A framing step of moving the zoom lens along the optical axis of the imaging optical system and framing the subject at a shooting angle of view in a captured image;

A focus adjustment step of performing focus adjustment by moving the focus lens along the optical axis in accordance with image data corresponding to a partial region in the captured image;

A subject detection step of detecting the subject in the captured image;

When the subject is not detected from the state in which the subject is detected in the subject detection step, if the framing by the framing step is being executed, the partial area is determined in advance in the captured image. A setting step for setting the first region as a frame region;

A control program characterized by causing

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013171247A JP2015040939A (en) | 2013-08-21 | 2013-08-21 | Image-capturing device, control method therefor, and control program |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013171247A JP2015040939A (en) | 2013-08-21 | 2013-08-21 | Image-capturing device, control method therefor, and control program |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2015040939A true JP2015040939A (en) | 2015-03-02 |

| JP2015040939A5 JP2015040939A5 (en) | 2016-09-29 |

Family

ID=52695144

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013171247A Pending JP2015040939A (en) | 2013-08-21 | 2013-08-21 | Image-capturing device, control method therefor, and control program |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP2015040939A (en) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2016200702A (en) * | 2015-04-09 | 2016-12-01 | キヤノン株式会社 | Focus detection device, control method therefor, program, and storage medium |

Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2010183291A (en) * | 2009-02-04 | 2010-08-19 | Olympus Imaging Corp | Tracking apparatus and tracking method |

| JP2011223139A (en) * | 2010-04-06 | 2011-11-04 | Canon Inc | Imaging device and method of controlling imaging device |

-

2013

- 2013-08-21 JP JP2013171247A patent/JP2015040939A/en active Pending

Patent Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2010183291A (en) * | 2009-02-04 | 2010-08-19 | Olympus Imaging Corp | Tracking apparatus and tracking method |

| JP2011223139A (en) * | 2010-04-06 | 2011-11-04 | Canon Inc | Imaging device and method of controlling imaging device |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2016200702A (en) * | 2015-04-09 | 2016-12-01 | キヤノン株式会社 | Focus detection device, control method therefor, program, and storage medium |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5409189B2 (en) | Imaging apparatus and control method thereof | |

| JP4873762B2 (en) | IMAGING DEVICE AND IMAGING DEVICE CONTROL METHOD | |

| JP2006208558A (en) | Imaging device | |

| KR101728042B1 (en) | Digital photographing apparatus and control method thereof | |

| JP2011039344A (en) | Imaging apparatus and method | |

| JP6391304B2 (en) | Imaging apparatus, control method, and program | |

| JP4645413B2 (en) | Imaging device | |

| JP2010183559A (en) | Image capturing apparatus, control method thereof, and program | |

| JP2010279054A (en) | Image pickup device, image processing device, image pickup method, and image processing method | |

| JP5335408B2 (en) | Focus adjustment apparatus and method | |

| JP2008301162A (en) | Photography device, and photographing method | |

| JP5196768B2 (en) | Imaging device | |

| JP5448868B2 (en) | IMAGING DEVICE AND IMAGING DEVICE CONTROL METHOD | |

| JP5257969B2 (en) | Focus position control device, focus position control method, focus position control program | |

| US11523048B2 (en) | Electronic device, control method of electronic device, and non-transitory computer readable medium | |

| JP5383361B2 (en) | Imaging apparatus, control method therefor, and program | |

| JP6584259B2 (en) | Image blur correction apparatus, imaging apparatus, and control method | |

| JP2015040939A (en) | Image-capturing device, control method therefor, and control program | |

| JP5832618B2 (en) | Imaging apparatus, control method thereof, and program | |

| JP6294607B2 (en) | IMAGING DEVICE, ITS CONTROL METHOD, PROGRAM, AND STORAGE MEDIUM | |

| JP4810440B2 (en) | IMAGING DEVICE, ITS CONTROL METHOD, PROGRAM, AND STORAGE MEDIUM | |

| JP6729574B2 (en) | Image processing apparatus and image processing method | |

| JP2008048152A (en) | Moving picture processing apparatus, moving picture photographing apparatus and moving picture photographing program | |

| JP2021019255A (en) | Imaging device and method of controlling the same | |

| JP5759127B2 (en) | Focus adjustment device and focus adjustment method |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20160812 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20160812 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20170519 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20170606 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20171212 |