JP2005293431A - マルチメディアデータ統合装置、マルチメディアデータ統合方法およびマルチメディアデータ統合プログラム - Google Patents

マルチメディアデータ統合装置、マルチメディアデータ統合方法およびマルチメディアデータ統合プログラム Download PDFInfo

- Publication number

- JP2005293431A JP2005293431A JP2004110479A JP2004110479A JP2005293431A JP 2005293431 A JP2005293431 A JP 2005293431A JP 2004110479 A JP2004110479 A JP 2004110479A JP 2004110479 A JP2004110479 A JP 2004110479A JP 2005293431 A JP2005293431 A JP 2005293431A

- Authority

- JP

- Japan

- Prior art keywords

- multimedia data

- video

- processing

- integrated

- format

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Granted

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/238—Interfacing the downstream path of the transmission network, e.g. adapting the transmission rate of a video stream to network bandwidth; Processing of multiplex streams

- H04N21/23805—Controlling the feeding rate to the network, e.g. by controlling the video pump

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F16/00—Information retrieval; Database structures therefor; File system structures therefor

- G06F16/40—Information retrieval; Database structures therefor; File system structures therefor of multimedia data, e.g. slideshows comprising image and additional audio data

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/21—Server components or server architectures

- H04N21/222—Secondary servers, e.g. proxy server, cable television Head-end

- H04N21/2225—Local VOD servers

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/234—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs

- H04N21/2343—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements

- H04N21/234363—Processing of video elementary streams, e.g. splicing of video streams or manipulating encoded video stream scene graphs involving reformatting operations of video signals for distribution or compliance with end-user requests or end-user device requirements by altering the spatial resolution, e.g. for clients with a lower screen resolution

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/236—Assembling of a multiplex stream, e.g. transport stream, by combining a video stream with other content or additional data, e.g. inserting a URL [Uniform Resource Locator] into a video stream, multiplexing software data into a video stream; Remultiplexing of multiplex streams; Insertion of stuffing bits into the multiplex stream, e.g. to obtain a constant bit-rate; Assembling of a packetised elementary stream

- H04N21/23608—Remultiplexing multiplex streams, e.g. involving modifying time stamps or remapping the packet identifiers

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/41—Structure of client; Structure of client peripherals

- H04N21/414—Specialised client platforms, e.g. receiver in car or embedded in a mobile appliance

- H04N21/41407—Specialised client platforms, e.g. receiver in car or embedded in a mobile appliance embedded in a portable device, e.g. video client on a mobile phone, PDA, laptop

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/45—Management operations performed by the client for facilitating the reception of or the interaction with the content or administrating data related to the end-user or to the client device itself, e.g. learning user preferences for recommending movies, resolving scheduling conflicts

- H04N21/462—Content or additional data management, e.g. creating a master electronic program guide from data received from the Internet and a Head-end, controlling the complexity of a video stream by scaling the resolution or bit-rate based on the client capabilities

- H04N21/4621—Controlling the complexity of the content stream or additional data, e.g. lowering the resolution or bit-rate of the video stream for a mobile client with a small screen

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/16—Analogue secrecy systems; Analogue subscription systems

- H04N7/173—Analogue secrecy systems; Analogue subscription systems with two-way working, e.g. subscriber sending a programme selection signal

- H04N7/17309—Transmission or handling of upstream communications

- H04N7/17318—Direct or substantially direct transmission and handling of requests

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/16—Analogue secrecy systems; Analogue subscription systems

- H04N7/173—Analogue secrecy systems; Analogue subscription systems with two-way working, e.g. subscriber sending a programme selection signal

- H04N7/17309—Transmission or handling of upstream communications

- H04N7/17336—Handling of requests in head-ends

-

- Y—GENERAL TAGGING OF NEW TECHNOLOGICAL DEVELOPMENTS; GENERAL TAGGING OF CROSS-SECTIONAL TECHNOLOGIES SPANNING OVER SEVERAL SECTIONS OF THE IPC; TECHNICAL SUBJECTS COVERED BY FORMER USPC CROSS-REFERENCE ART COLLECTIONS [XRACs] AND DIGESTS

- Y10—TECHNICAL SUBJECTS COVERED BY FORMER USPC

- Y10S—TECHNICAL SUBJECTS COVERED BY FORMER USPC CROSS-REFERENCE ART COLLECTIONS [XRACs] AND DIGESTS

- Y10S707/00—Data processing: database and file management or data structures

- Y10S707/99941—Database schema or data structure

- Y10S707/99944—Object-oriented database structure

- Y10S707/99945—Object-oriented database structure processing

-

- Y—GENERAL TAGGING OF NEW TECHNOLOGICAL DEVELOPMENTS; GENERAL TAGGING OF CROSS-SECTIONAL TECHNOLOGIES SPANNING OVER SEVERAL SECTIONS OF THE IPC; TECHNICAL SUBJECTS COVERED BY FORMER USPC CROSS-REFERENCE ART COLLECTIONS [XRACs] AND DIGESTS

- Y10—TECHNICAL SUBJECTS COVERED BY FORMER USPC

- Y10S—TECHNICAL SUBJECTS COVERED BY FORMER USPC CROSS-REFERENCE ART COLLECTIONS [XRACs] AND DIGESTS

- Y10S707/00—Data processing: database and file management or data structures

- Y10S707/99941—Database schema or data structure

- Y10S707/99948—Application of database or data structure, e.g. distributed, multimedia, or image

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Databases & Information Systems (AREA)

- General Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- Physics & Mathematics (AREA)

- Data Mining & Analysis (AREA)

- General Physics & Mathematics (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

- Multi Processors (AREA)

- Computer And Data Communications (AREA)

- Information Transfer Between Computers (AREA)

Abstract

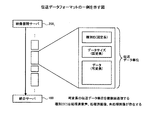

【解決手段】統合サーバ100の処理分担比率算出部121が統合サーバ100と各映像蓄積サーバとの間での画像形式変換処理の最適な処理分担比率を算出し、処理分担比率算出部121により算出された処理分担比率に基づいて統合サーバ100の画像形式変換処理部122と各映像蓄積サーバの画像形式変換処理部が画像形式変換処理を分散して行う。

【選択図】 図4

Description

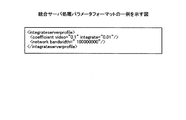

統合対象蓄積サーバ数:m=3

変換前画像ビットレート(bps):Vbit(1)=Vbit(2)=Vbit(3)=384000

変換後画像ビットレート(bps):V'bit(1)=V'bit(2)=V'bit(3)=64000

変換後音声ビットレート(bps):A'bit(1)=A'bit(2)=A'bit(3)=8000

変換前画像フレームレート(fps):Frate(1)=Frate(2)=Frate(3)=15

demux係数:Cdemux(1)=Cdemux(2)=Cdemux(3)=0.1

画像変換処理係数:Cvideo(1)=Cvideo(2)=Cvideo(3)=0.33

音声変換処理係数:Caudio(1)=Caudio(2)=Caudio(3)=0.23

統合処理係数:Cintegrate(1)=Cintegrate(2)=Cintegrate(3)=0.01

全要求映像長(ms):Lall(1)=Lall(2)=Lall(3)=10000

統合サーバ処理映像長(ms):LI(1)、LI(2)、LI(3) いずれも未知数

画像変換処理係数:CvideoI=0.33

実効ネットワーク帯域(bps):N=20000000

bps:ネットワーク帯域もしくは動画像において、1秒間に転送できるビット量(bits per second)

fps:動画像において、1秒間に表示する画像の枚数(frame per second)

ms:ミリ秒(millisecond)

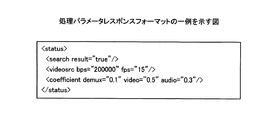

TI(3)=MAX(TS(3),0.33LI(1)+0.33LI(2)+0.33LI(3),MAX(TI(2),0.1LI(3))+100) ・・・(a)

TS(3)=MAX(MAX(2300,0.1LI(3)+4)+32−0.0032LI(3),−0.23LI(3)+3300) ・・・(b)

TI(2)=MAX(TS(2),0.33LI(1)+0.33LI(2),MAX(TI(1),0.1LI(2))+100) ・・・(c)

TS(2)=MAX(MAX(2300,0.1LI(2)+4)+32−0.0032LI(2),−0.23LI(2)+3300) ・・・(d)

TI(1)=MAX(TS(1),0.33LI(1),0.1LI(1)+100) ・・・ (e)

TS(1)=MAX(MAX(2300,0.1LI(1)+4)+32−0.0032LI(1),−0.23LI(1)+3300) ・・・(f)

各マルチメディアデータ蓄積装置に蓄積されたマルチメディアデータのうち統合マルチメディアデータの作成に使用されるマルチメディアデータを前記異なるデータ形式に変換する変換処理を各マルチメディアデータ蓄積装置とマルチメディアデータ統合装置とで分担して行う処理分担比率を算出する処理分担比率算出手段と、

前記処理分担比率算出手段により算出された処理分担比率を各マルチメディアデータ蓄積装置に送信する処理分担比率送信手段と、

前記処理分担比率送信手段により送信された処理分担比率に基づいて各マルチメディアデータ蓄積装置により部分的に変換処理がおこなわれたマルチメディアデータを受信するデータ受信手段と、

前記データ受信手段により受信されたマルチメディアデータのうち変換処理が行われていないマルチメディアデータのデータ形式の変換処理を行う変換処理手段と、

前記データ受信手段により受信されたマルチメディアデータのうち各マルチメディアデータ蓄積装置により変換処理が行われたマルチメディアデータと前記変換処理手段により変換処理が行われたマルチメディアデータとを統合して前記統合マルチメディアデータを作成する統合手段と、

を備えたことを特徴とするマルチメディアデータ統合装置。

前記処理分担比率算出手段は、マルチメディアデータ統合装置および各マルチメディアデータ蓄積装置の計算能力に加えて前記ネットワークのネットワーク帯域および各マルチメディア蓄積装置に蓄積されたデータ形式に基づいて前記処理分担比率を算出することを特徴とする付記2に記載のマルチメディアデータ統合装置。

前記処理分担比率算出手段は、前記計算能力取得手段により取得された計算能力を用いて前記処理分担比率を算出することを特徴とする付記2または3に記載のマルチメディアデータ統合装置。

前記処理分担比率算出手段は、画像のデータ形式の変換処理について各マルチメディアデータ蓄積装置で行われる変換処理とマルチメディアデータ統合装置で行われる変換処理の比率を前記処理分担比率として算出することを特徴とする付記1、2または3に記載のマルチメディアデータ統合装置。

前記処理分担比率算出手段は、各マルチメディアデータ蓄積装置で変換処理が行われる映像の再生時間とマルチメディアデータ統合装置で変換処理が行われる映像の再生時間との比率を前記処理分担比率として算出することを特徴とする付記1、2または3に記載のマルチメディアデータ統合装置。

前記変換手段は、前記データ受信手段により受信されたフラグに基づいてマルチメディアデータのデータ形式の変換処理を行うことを特徴とする付記1、2または3に記載のマルチメディアデータ統合装置。

各マルチメディアデータ蓄積装置に蓄積されたマルチメディアデータのうち統合マルチメディアデータの作成に使用されるマルチメディアデータを前記異なるデータ形式に変換する変換処理を各マルチメディアデータ蓄積装置とマルチメディアデータ統合装置とで分担して行う処理分担比率を算出する処理分担比率算出工程と、

前記処理分担比率算出工程により算出された処理分担比率を各マルチメディアデータ蓄積装置に送信する処理分担比率送信工程と、

前記処理分担比率送信工程により送信された処理分担比率に基づいて各マルチメディアデータ蓄積装置により部分的に変換処理がおこなわれたマルチメディアデータを受信するデータ受信工程と、

前記データ受信工程により受信されたマルチメディアデータのうち変換処理が行われていないマルチメディアデータのデータ形式の変換処理を行う変換処理工程と、

前記データ受信工程により受信されたマルチメディアデータのうち各マルチメディアデータ蓄積装置により変換処理が行われたマルチメディアデータと前記変換処理工程により変換処理が行われたマルチメディアデータとを統合して前記統合マルチメディアデータを作成する統合工程と、

を含んだことを特徴とするマルチメディアデータ統合方法。

各マルチメディアデータ蓄積装置に蓄積されたマルチメディアデータのうち統合マルチメディアデータの作成に使用されるマルチメディアデータを前記異なるデータ形式に変換する変換処理を各マルチメディアデータ蓄積装置とマルチメディアデータ統合装置とで分担して行う処理分担比率を算出する処理分担比率算出手順と、

前記処理分担比率算出手順により算出された処理分担比率を各マルチメディアデータ蓄積装置に送信する処理分担比率送信手順と、

前記処理分担比率送信手順により送信された処理分担比率に基づいて各マルチメディアデータ蓄積装置により部分的に変換処理がおこなわれたマルチメディアデータを受信するデータ受信手順と、

前記データ受信手順により受信されたマルチメディアデータのうち変換処理が行われていないマルチメディアデータのデータ形式の変換処理を行う変換処理手順と、

前記データ受信手順により受信されたマルチメディアデータのうち各マルチメディアデータ蓄積装置により変換処理が行われたマルチメディアデータと前記変換処理手順により変換処理が行われたマルチメディアデータとを統合して前記統合マルチメディアデータを作成する統合手順と、

をコンピュータに実行させることを特徴とするマルチメディアデータ統合プログラム。

20 インターネット

30 専用ネットワーク

100 統合サーバ

111 ネットワークI/F

112 配信要求受付部

113 Webインターフェース生成部

114 映像生成全体制御部

115 パラメータ解析部

116 フォーマット生成部

117 フォーマット蓄積部

118 映像蓄積サーバ通信部

119 処理可否判定部

120 処理パラメータ蓄積部

121 処理分担比率算出部

122 画像形式変換処理部

123 統合処理部

2001〜200m 映像蓄積サーバ

201 ネットワークI/F

202 パラメータ要求受付部

203 フォーマット解析部

204 映像ファイル検索部

205 映像蓄積部

206 処理パラメータ蓄積部

207 フォーマット生成部

208 フォーマット蓄積部

209 変換要求受付部

210 時間切り出し画像音声分離部

211 画像形式変換処理部

212 音声形式変換処理部

300,311 コンピュータシステム

301 本体部

302 ディスプレイ

302a 表示画面

303 キーボード

304 マウス

306 LAN

307 公衆回線

308 フロッピィディスク

309 CD−ROM

312 サーバ

313 プリンタ

321 CPU

322 RAM

323 ROM

324 ハードディスクドライブ

325 CD−ROMドライブ

326 フロッピィディスクドライブ

327 I/Oインターフェース

328 LANインターフェース

329 モデム

Claims (5)

- マルチメディアデータを蓄積する複数のマルチメディアデータ蓄積装置からマルチメディアデータを受信し、該受信した複数のマルチメディアデータを統合してマルチメディアデータ蓄積装置に蓄積されたデータ形式とは異なるデータ形式の統合マルチメディアデータを作成するマルチメディアデータ統合装置であって、

各マルチメディアデータ蓄積装置に蓄積されたマルチメディアデータのうち統合マルチメディアデータの作成に使用されるマルチメディアデータを前記異なるデータ形式に変換する変換処理を各マルチメディアデータ蓄積装置とマルチメディアデータ統合装置とで分担して行う処理分担比率を算出する処理分担比率算出手段と、

前記処理分担比率算出手段により算出された処理分担比率を各マルチメディアデータ蓄積装置に送信する処理分担比率送信手段と、

前記処理分担比率送信手段により送信された処理分担比率に基づいて各マルチメディアデータ蓄積装置により部分的に変換処理がおこなわれたマルチメディアデータを受信するデータ受信手段と、

前記データ受信手段により受信されたマルチメディアデータのうち変換処理が行われていないマルチメディアデータのデータ形式の変換処理を行う変換処理手段と、

前記データ受信手段により受信されたマルチメディアデータのうち各マルチメディアデータ蓄積装置により変換処理が行われたマルチメディアデータと前記変換処理手段により変換処理が行われたマルチメディアデータとを統合して前記統合マルチメディアデータを作成する統合手段と、

を備えたことを特徴とするマルチメディアデータ統合装置。 - 前記処理分担比率算出手段は、マルチメディアデータ統合装置および各マルチメディア蓄積装置の計算能力に基づいて統合マルチメディアデータの作成に要する時間が最小となるように前記処理分担比率を算出することを特徴とする請求項1に記載のマルチメディアデータ統合装置。

- 前記複数のマルチメディアデータ蓄積装置およびマルチメディアデータ統合装置はネットワークで接続され、

前記処理分担比率算出手段は、マルチメディアデータ統合装置および各マルチメディアデータ蓄積装置の計算能力に加えて前記ネットワークのネットワーク帯域および各マルチメディア蓄積装置に蓄積されたデータ形式に基づいて前記処理分担比率を算出することを特徴とする請求項2に記載のマルチメディアデータ統合装置。 - マルチメディアデータを蓄積する複数のマルチメディアデータ蓄積装置からマルチメディアデータを受信し、該受信した複数のマルチメディアデータを統合してマルチメディアデータ蓄積装置に蓄積されたデータ形式とは異なるデータ形式の統合マルチメディアデータを作成するマルチメディアデータ統合装置のマルチメディアデータ統合方法であって、

各マルチメディアデータ蓄積装置に蓄積されたマルチメディアデータのうち統合マルチメディアデータの作成に使用されるマルチメディアデータを前記異なるデータ形式に変換する変換処理を各マルチメディアデータ蓄積装置とマルチメディアデータ統合装置とで分担して行う処理分担比率を算出する処理分担比率算出工程と、

前記処理分担比率算出工程により算出された処理分担比率を各マルチメディアデータ蓄積装置に送信する処理分担比率送信工程と、

前記処理分担比率送信工程により送信された処理分担比率に基づいて各マルチメディアデータ蓄積装置により部分的に変換処理がおこなわれたマルチメディアデータを受信するデータ受信工程と、

前記データ受信工程により受信されたマルチメディアデータのうち変換処理が行われていないマルチメディアデータのデータ形式の変換処理を行う変換処理工程と、

前記データ受信工程により受信されたマルチメディアデータのうち各マルチメディアデータ蓄積装置により変換処理が行われたマルチメディアデータと前記変換処理工程により変換処理が行われたマルチメディアデータとを統合して前記統合マルチメディアデータを作成する統合工程と、

を含んだことを特徴とするマルチメディアデータ統合方法。 - マルチメディアデータを蓄積する複数のマルチメディアデータ蓄積装置からマルチメディアデータを受信し、該受信した複数のマルチメディアデータを統合してマルチメディアデータ蓄積装置に蓄積されたデータ形式とは異なるデータ形式の統合マルチメディアデータを作成するマルチメディアデータ統合プログラムであって、

各マルチメディアデータ蓄積装置に蓄積されたマルチメディアデータのうち統合マルチメディアデータの作成に使用されるマルチメディアデータを前記異なるデータ形式に変換する変換処理を各マルチメディアデータ蓄積装置とマルチメディアデータ統合装置とで分担して行う処理分担比率を算出する処理分担比率算出手順と、

前記処理分担比率算出手順により算出された処理分担比率を各マルチメディアデータ蓄積装置に送信する処理分担比率送信手順と、

前記処理分担比率送信手順により送信された処理分担比率に基づいて各マルチメディアデータ蓄積装置により部分的に変換処理がおこなわれたマルチメディアデータを受信するデータ受信手順と、

前記データ受信手順により受信されたマルチメディアデータのうち変換処理が行われていないマルチメディアデータのデータ形式の変換処理を行う変換処理手順と、

前記データ受信手順により受信されたマルチメディアデータのうち各マルチメディアデータ蓄積装置により変換処理が行われたマルチメディアデータと前記変換処理手順により変換処理が行われたマルチメディアデータとを統合して前記統合マルチメディアデータを作成する統合手順と、

をコンピュータに実行させることを特徴とするマルチメディアデータ統合プログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004110479A JP4549717B2 (ja) | 2004-04-02 | 2004-04-02 | マルチメディアデータ統合装置、マルチメディアデータ統合方法およびマルチメディアデータ統合プログラム |

| US10/937,254 US7451160B2 (en) | 2004-04-02 | 2004-09-10 | Method and apparatus for integrating multimedia data, and computer product |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2004110479A JP4549717B2 (ja) | 2004-04-02 | 2004-04-02 | マルチメディアデータ統合装置、マルチメディアデータ統合方法およびマルチメディアデータ統合プログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2005293431A true JP2005293431A (ja) | 2005-10-20 |

| JP4549717B2 JP4549717B2 (ja) | 2010-09-22 |

Family

ID=35055634

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2004110479A Expired - Fee Related JP4549717B2 (ja) | 2004-04-02 | 2004-04-02 | マルチメディアデータ統合装置、マルチメディアデータ統合方法およびマルチメディアデータ統合プログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US7451160B2 (ja) |

| JP (1) | JP4549717B2 (ja) |

Cited By (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2009118424A (ja) * | 2007-11-09 | 2009-05-28 | Canon Inc | 転送元描画装置、転送先描画装置及び情報処理方法 |

| JP2021153218A (ja) * | 2020-03-24 | 2021-09-30 | 大日本印刷株式会社 | 動画作成システム、動画作成装置、ドローンおよびプログラム |

Families Citing this family (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP1851644A4 (en) * | 2005-02-12 | 2010-10-06 | Teresis Media Man Inc | METHOD AND DEVICE FOR SUPPORTING THE MANUFACTURE OF MEDIA WORKS AND SIMILAR |

| US8135222B2 (en) * | 2009-08-20 | 2012-03-13 | Xerox Corporation | Generation of video content from image sets |

| US10284433B2 (en) * | 2015-06-25 | 2019-05-07 | International Business Machines Corporation | Data synchronization using redundancy detection |

Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH08174956A (ja) * | 1994-12-22 | 1996-07-09 | Canon Inc | 印刷装置及びその制御方法及び印刷システム |

| JP2002251610A (ja) * | 2001-02-26 | 2002-09-06 | Matsushita Electric Ind Co Ltd | 並列画像処理装置 |

Family Cites Families (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US6965569B1 (en) * | 1995-09-18 | 2005-11-15 | Net2Phone, Inc. | Flexible scalable file conversion system and method |

| JP4116286B2 (ja) | 2001-12-13 | 2008-07-09 | 株式会社不二工機 | レシーバドライヤ |

-

2004

- 2004-04-02 JP JP2004110479A patent/JP4549717B2/ja not_active Expired - Fee Related

- 2004-09-10 US US10/937,254 patent/US7451160B2/en not_active Expired - Fee Related

Patent Citations (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH08174956A (ja) * | 1994-12-22 | 1996-07-09 | Canon Inc | 印刷装置及びその制御方法及び印刷システム |

| JP2002251610A (ja) * | 2001-02-26 | 2002-09-06 | Matsushita Electric Ind Co Ltd | 並列画像処理装置 |

Cited By (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2009118424A (ja) * | 2007-11-09 | 2009-05-28 | Canon Inc | 転送元描画装置、転送先描画装置及び情報処理方法 |

| JP2021153218A (ja) * | 2020-03-24 | 2021-09-30 | 大日本印刷株式会社 | 動画作成システム、動画作成装置、ドローンおよびプログラム |

| JP7505219B2 (ja) | 2020-03-24 | 2024-06-25 | 大日本印刷株式会社 | 動画作成システム、動画作成装置、およびプログラム |

Also Published As

| Publication number | Publication date |

|---|---|

| JP4549717B2 (ja) | 2010-09-22 |

| US7451160B2 (en) | 2008-11-11 |

| US20050223033A1 (en) | 2005-10-06 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP7103402B2 (ja) | 情報処理装置および情報処理方法 | |

| JP6981257B2 (ja) | 情報処理装置および情報処理方法 | |

| JP6570646B2 (ja) | オーディオビデオファイルのライブストリーミング方法、システム及びサーバー | |

| KR101484900B1 (ko) | 코덱이 적용된 프레임 크기로의 오디오 분할 | |

| JP2003114845A (ja) | メディア変換方法およびメディア変換装置 | |

| JP6642427B2 (ja) | 情報処理装置および方法 | |

| US20030122862A1 (en) | Data processing apparatus, data processing server, data processing system, method of controlling data processing apparatus, method of controlling data processing server, computer program, and computer readable storage medium | |

| US20060140591A1 (en) | Systems and methods for load balancing audio/video streams | |

| WO2005086009A1 (ja) | メディア配信装置及びメディア受信装置 | |

| JP4598627B2 (ja) | コンテンツ編集装置及びその再生装置 | |

| JP2003153254A (ja) | データ処理装置及びデータ処理方法、並びにプログラム、記憶媒体 | |

| JP4549717B2 (ja) | マルチメディアデータ統合装置、マルチメディアデータ統合方法およびマルチメディアデータ統合プログラム | |

| JP2008153886A (ja) | 複合コンテンツファイルの編集方法および装置並びに再生装置 | |

| WO2018142946A1 (ja) | 情報処理装置および方法 | |

| WO2013005478A1 (ja) | コンテンツ配信システム、コンテンツ配置決定装置、コンテンツ配置決定方法およびプログラム | |

| JP4315914B2 (ja) | 画像再生装置及び画像再生方法 | |

| KR101272876B1 (ko) | 미디어 스트리밍 서버와 이 서버의 미디어 데이터 관리 방법 | |

| JP4691173B2 (ja) | 画像再生装置及び画像再生方法 | |

| CN111869225A (zh) | 信息处理装置、信息处理装置及程序 | |

| CN111837401A (zh) | 信息处理设备、信息处理设备和程序 | |

| JP2005176094A (ja) | データ処理装置及びデータ処理方法、並びにプログラム、記憶媒体 | |

| JP2008172629A (ja) | コンテンツ統合サーバ | |

| JP2024542586A (ja) | 適応型ストリーミングパラメータ化のための拡張可能要求シグナリング | |

| JP5557070B2 (ja) | 送信装置及び方法、並びに受信装置及び方法 | |

| JP2008219589A (ja) | メディア多重データの同期蓄積再生方法および装置 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20070315 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20091216 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20100105 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20100308 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20100706 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20100707 |

|

| R150 | Certificate of patent or registration of utility model |

Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130716 Year of fee payment: 3 |

|

| LAPS | Cancellation because of no payment of annual fees |