BR112013014287B1 - Método e aparelho para reconhecimento de gesto - Google Patents

Método e aparelho para reconhecimento de gesto Download PDFInfo

- Publication number

- BR112013014287B1 BR112013014287B1 BR112013014287-1A BR112013014287A BR112013014287B1 BR 112013014287 B1 BR112013014287 B1 BR 112013014287B1 BR 112013014287 A BR112013014287 A BR 112013014287A BR 112013014287 B1 BR112013014287 B1 BR 112013014287B1

- Authority

- BR

- Brazil

- Prior art keywords

- gesture

- subgestion

- possible commands

- fact

- recognized

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0484—Interaction techniques based on graphical user interfaces [GUI] for the control of specific functions or operations, e.g. selecting or manipulating an object, an image or a displayed text element, setting a parameter value or selecting a range

- G06F3/0486—Drag-and-drop

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0487—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser

- G06F3/0488—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures

- G06F3/04883—Interaction techniques based on graphical user interfaces [GUI] using specific features provided by the input device, e.g. functions controlled by the rotation of a mouse with dual sensing arrangements, or of the nature of the input device, e.g. tap gestures based on pressure sensed by a digitiser using a touch-screen or digitiser, e.g. input of commands through traced gestures for inputting data by handwriting, e.g. gesture or text

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/20—Movements or behaviour, e.g. gesture recognition

- G06V40/28—Recognition of hand or arm movements, e.g. recognition of deaf sign language

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V40/00—Recognition of biometric, human-related or animal-related patterns in image or video data

- G06V40/60—Static or dynamic means for assisting the user to position a body part for biometric acquisition

- G06V40/67—Static or dynamic means for assisting the user to position a body part for biometric acquisition by interactive indications to the user

Abstract

INTERFACE DE USUÁRIO, APARELHO E MÉTODO PARA RECONHECIMENTO DE GESTO Interface de usuário, aparelho e método para o reconhecimento de gesto compreendendo: prever um ou mais comandos possíveis para o aparelho com base em um ou mais gestos complementares executados por um usuário anteriormente, indicar o comando ou comandos possíveis.

Description

A presente invenção refere-se, em geral, ao reconhecimento de gestos, e mais particularmente, a uma interface de usuário, aparelho e método para o reconhecimento de gesto em um sistema eletrônico.

À medida que aumenta a faixa de atividades que se realizam com um computador, maneiras novas e inovadoras para proporcionar uma interface entre o usuário e a máquina são frequentemente desenvolvidas para proporcionar uma experiência mais natural para o usuário. Por exemplo, uma tela sensível ao toque pode permitir a um usuário o fornecimento de informações para um computador sem um mouse e/ou teclado, de maneira que não há necessidade de área com uma mesa para operar o computador. O reconhecimento do gesto também está recebendo mais e mais atenções devido ao seu uso potencial no reconhecimento de linguagem por sinais, interação homem-computador multimodal, realidade virtual e controle de robôs.

O reconhecimento de gestos é uma área que está se desenvolvendo rapidamente no mundo do computador, que permite que um dispositivo reconheça determinados gestos com a mão feitos por usuário, de modo que certas funções do dispositivo podem ser realizadas com base no gesto. Os sistemas de reconhecimento de gesto com base na visão pelo computador são propostos para facilitar uma interface usuário-máquina mais “natural”, eficiente e efetiva. Não visão pelo computador, para se aumentar a exatidão no reconhecimento do gesto, é necessário exibir o vídeo capturado relacionado da câmera na tela. E esse tipo de vídeo pode ajudar a indicar ao usuário se é possível que seu gesto vá ser reconhecido corretamente e se ele precisa fazer algum ajuste para a sua posição ou não. Entretanto, a exibição de vídeo capturado da câmera vai normalmente ter um impacto negativo para o usuário que está assistindo o programa em exibição na tela. Portanto, é necessário encontrar uma maneira que possa minimizar a alteração no programa em exibição na tela, e, ao mesmo tempo manter a alta precisão no reconhecimento.

Por outro lado, recentemente, mais e mais gestos compostos (tais como pegar e largar) são aplicados em UI (interface de usuário). Esses gestos compostos normalmente incluem subgestos e são mais difíceis de serem reconhecidos do que um único gesto. A Patente US20100050133 “Compound Gesture Recognition” de H. kieth Nishihara e outros, depositada em 22 de agosto de 2008, propõe um método que inclui múltiplas câmeras e tenta detectar e traduzir os diferentes subgestos em diferente informação para um dispositivo diferente. Entretanto, o custo e a distribuição de múltiplas câmeras limitam a aplicação desse método em usos domésticos.

Portanto, é importante estudar o reconhecimento de gesto composto no sistema de interface do usuário.

A invenção se refere a uma interface de usuário em um sistema de reconhecimento de gesto compreendendo: uma janela de exibição adaptada para indicar um subgesto de pelo menos um comando por gesto, de acordo com um ou mais subgestos realizados por um usuário e recebidos pelo sistema de reconhecimento de gesto previamente.

A invenção também se refere a um aparelho compreendendo: uma unidade de previsão de gesto configurada para prever um ou mais comandos possíveis para o aparelho com base em um ou mais subgestos realizados por um usuário anteriormente; um visor configurado para indicar o comando ou comando possíveis.

A invenção também se refere a um método para reconhecimento de gesto compreendendo: prever um ou mais comandos possíveis para o aparelho com base em um ou mais subgestos realizados por um usuário anteriormente; indicar o comando ou comandos possíveis.

Esses e outros aspectos, características e vantagens da presente invenção se tornarão evidentes a partir da descrição a seguir de uma modalidade em conexão com os desenhos anexos:

A Figura 1 é um diagrama de blocos mostrando um exemplo de um sistema de reconhecimento de gesto de acordo com uma modalidade da invenção;

A Figura 2 mostra um diagrama de gestos manuais usados para explicar a invenção;

A Figura 3 é um diagrama mostrando exemplos da janela de exibição da interface de usuário de acordo com a modalidade da invenção;

A Figura 4 é diagrama mostrando uma região de interface de usuário na tela de exibição de acordo com a modalidade;

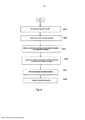

A Figura 5 é um fluxograma mostrando um método de controle da opacidade da janela de exibição;

A Figura 6 é um fluxograma mostrando um método para o reconhecimento de gesto de acordo com a modalidade da invenção.

Deve ser entendido que os desenhos têm o propósito de ilustrar os conceitos da divulgação e não são necessariamente a única configuração possível para ilustrar a divulgação.

Na descrição detalhada a seguir, uma interface de usuário, um aparelho e um método para reconhecimento de gesto estão descritos para proporcionar um completo entendimento da presente invenção. Entretanto, será reconhecido pelo especialista na técnica que a presente invenção pode ser praticada sem esses detalhes específicos ou com equivalentes dos mesmos. Em outros casos, métodos, procedimentos, componentes e circuitos bem conhecidos não foram descritos em detalhes para não desviar desnecessariamente a atenção dos aspectos da presente invenção.

Um usuário pode proporcionar informações simuladas para um computador, TV ou outro dispositivo eletrônico. Deve ser entendido que as informações simuladas podem ser proporcionadas por um gesto composto, um único gesto, ou mesmo qualquer gesto corporal realizado pelo usuário. Por exemplo, o usuário poderia proporcionar gestos que incluem um movimento pré-definido em um ambiente de reconhecimento de gesto. O usuário proporciona as informações de gesto, por exemplo, por uma ou por ambas as mãos do usuário; por um bastão, por uma agulha, por uma vareta pontiaguda; ou por uma variedade de outros dispositivos com os quais o usuário pode gesticular. As informações simuladas poderiam ser, por exemplo, informações simuladas de mouse, para estabelecer, por exemplo, uma referência para o teor visual exibido e executar um comando em porções do teor visual com as quais a referência se relaciona.

A Figura 1 é um diagrama de blocos mostrando um exemplo de um sistema de reconhecimento de gesto 100 de acordo com uma modalidade da invenção. Como mostrado na Figura 1, o sistema de reconhecimento de gesto 100 inclui uma câmera 101, uma tela de exibição 102, uma tela 108-1, uma tela 108-2, um controlador de exibição 104, um previsor de gesto 105, uma unidade de reconhecimento de gesto 106 e uma base de dados de gestos 107. Para exemplificar, a câmera 101 é montada acima da tela de exibição 102, e as telas 108-1 e 108-2 estão localizadas respectivamente nos lados esquerdo e direito da tela de exibição 102.

O usuário que está em frente à tela de exibição 102 pode proporcionar informações simuladas para o sistema de reconhecimento de gesto 100 por um objeto de entrada. Na modalidade, o objeto de entrada é demonstrado como sendo a mão de um usuário, de modo que as informações simuladas possam ser proporcionadas através de gestos com as mãos. Deve ser entendido que o uso da mão para proporcionar informações simuladas por gestos das mãos é apenas uma implementação de exemplo do sistema de reconhecimento de gesto 100. Além disso, no exemplo de se realizarem os gestos tendo a mão do usuário como objeto de informação para proporcionar informações simuladas, a mão do usuário pode incorporar uma luva e/ou sensores para a ponta ou junta dos dedos ou pode ser a mão nua de um usuário.

Na modalidade da Figura 1, a câmera 101 pode tirar rapidamente imagens fotográficas do gesto de mão dos usuários a, por exemplo, trinta vezes por segundo, e as imagens ao proporcionadas para a unidade de reconhecimento de gesto 106 para identificar o gesto do usuário. O reconhecimento do gesto está recebendo mais e mais atenção recentemente devido ao seu uso potencial no reconhecimento de linguagem de sinais, interação homem-computador multimodal, realidade virtual, e controle de robôs. A maioria dos métodos de reconhecimento de gesto da técnica anterior junta sequências de imagens observadas com amostras de treinamento ou com um modelo. A sequência de informação é classificada como sendo a classe cujas amostras ou modelos melhor se encaixam na mesma. Variação Temporal Dinâmica (DTW), Programação Dinâmica Contínua (CDP), Modelo Oculto de Markov (HMM) e Campo Aleatório Condicional (CRF) são métodos exemplificativos dessa categoria na técnica anterior. HMM é a técnica mais amplamente usada para o reconhecimento de gesto. O método de reconhecimento detalhado para subgestos não será descrito aqui.

A unidade de reconhecimento de gesto 106, o previsor de gesto 105, o controlador de exibição 104 e a base de dados de gestos 107 podem estar localizados, por exemplo, dentro de um computador (não ilustrado) ou em processadores embutidos, de modo a processarem as respectivas imagens associadas ao objeto de entrada para gerar a instrução de controle indicada em uma janela de exibição 103 da tela de exibição 102.

De acordo com a modalidade, entradas de um só gesto e de gestos compostos por parte de usuários podem ser identificadas. Um gesto composto pode ser um gesto com o qual múltiplos subgestos podem ser empregados para proporcionar múltiplas entradas de dispositivos relacionados. Por exemplo, um primeiro subgesto pode ser um gesto de referência para se relacionar a uma porção do teor visual e um segundo subgesto pode ser um gesto de execução que pode ser realizado imediatamente após o primeiro subgesto, de modo a executar um comando na porção do teor visual com o qual se relaciona o primeiro subgesto. O gesto único inclui apenas um subgesto, e é realizado imediatamente após o subgesto ser identificado. A Figura 2 mostra o gesto manual exemplificativo usado para explicar a invenção.

Como mostrado na Figura 2, um gesto composto inclui diversos subgestos (ou gestos subsequentes), e depende de qual função ele representa. Chamamos o primeiro subgesto de gesto principal e o último de gesto de terminação. Em 3D UI (interface tridimensional de usuário), existem muitas funções que compartilham esse mesmo primeiro gesto. Por exemplo, um gesto composto típico é o de “pegar e largar”. Nesse caso, um usuário pode pegar uma cena de um programa de TV utilizando seu gesto de mão e largá- la em um quadro próximo ou tela de dispositivo fazendo um gesto de mão que significa LARGAR. Aqui, a definição de gesto composto inclui três porções (subgestos): pegar, largar e onde largar. Por exemplo, na sala de estar do usuário existem um aparelho de TV e dois tablets que estão colocados respectivamente no lado esquerdo e direito direito da TV respectivamente como mostrado na Figura 1. E esses dois tablets já se registraram no sistema e se conectaram com a base de dados de gestos 107. Assim, os gestos compostos de “pegar e largar” incluem dois tipos. Um tem dois subgestos “pegar e largar à esquerda” como mostrado na Figura 2(b), o que quer dizer que o conteúdo de tela indicado pelo usuário será deixado no tablet à esquerda, e transmitido para o tablet à esquerda 108- 1 pela base de dados 107, e outro tipo tem “pegar e largar à direita” como mostrado na Figura 2(a), o que quer dizer que o conteúdo de tela indicado pelo usuário será deixado no tablet à direita, e transmitido para o tablet à direita 108-2 pela base de dados 107. Esses dois tipos têm em comum o mesmo primeiro subgesto “pegar”. Certamente, se o segundo subgesto ainda for “pegar”, que é o mesmo primeiro gesto “pegar” como mostrado na Figura 2(c), e a seguir “pegar” é mantido por mais de um segundo, isto significa que esse gesto composto contém apenas um subgesto de “pegar” e o conteúdo na tela será armazenado ou largado localmente.

Voltando à Figura 1, o previsor de gesto 105 do sistema de reconhecimento de gesto 100 é configurado para prever um ou mais comandos gestuais possíveis para o aparelho com base no gesto ou gestos de usuário anteriormente reconhecidos pela unidade de reconhecimento de gesto 106 e sua sequência ou ordem. Para realizar o prognóstico, outra base de dados de gesto composto 107 é necessária, a qual é configurada para armazenar os gestos pré-definidos com uma função de comando específica.

Quando as imagens de gesto obtidas pela câmera 101 são reconhecidas pela unidade de reconhecimento de gesto 106, o resultado do reconhecimento, por exemplo, um subgesto pré-definido será alimentado para o previsor de gesto 105. Então, consultando-se a base de dados de gestos 107 com base no resultado do reconhecimento, o previsor de gesto 105 vai prever um ou mais comandos gestuais possíveis e o subgesto seguinte dos comandos gestuais possíveis será mostrado como uma indicação em uma janela de exibição 103. Por exemplo, quando o primeiro subgesto “pegar” é reconhecido, consultando-se a base de dados 107, o previsor pode tirar uma conclusão de que existem três possíveis candidatos para esse gesto composto “pegar e largar à esquerda”, “pegar e largar à direita” e “só pegar”.

Na base de dados 107, existem ainda subgestos simples e compostos como: quando o subgesto principal é “acenar mão direita”, os gestos de terminação podem ser respectivamente “acenar mão direita”, “acenar as duas mãos”, “’levantar a mão direita”, ou “ficar parado”. Por exemplo, o gesto principal significa ligar o aparelho de TV. Se o gesto de terminação for “acenar mão direita”, isto quer dizer que o aparelho de TV exibe o programa set-to-box. Se o gesto de terminação for “acenar as duas mãos”, isto significa que o aparelho de TV exibe o programa a partir de um servidor de mídia. Se o gesto de terminação for “levantar a mão direita”, isto significa que o aparelho de TV exibe o programa a partir de um DVD (disco de vídeo digital). Se o gesto de terminação for “acenar as duas mãos”, isto significa que o aparelho de TV exibe o programa a partir de um servidor de mídia. Se o gesto de terminação for “ficar parado”, isto significa que o aparelho de TV não vai exibir nenhum programa. Embora a invenção seja explicada tomando-se o gesto composto “pegar e largar” e subgestos em duas etapas como exemplo, isto não pode ser considerado um limite para a invenção.

De acordo com a modalidade, a janela de exibição 103 apresentando uma interface de usuário do sistema de reconhecimento de gesto 100 é usada para indicar o seguinte subgesto do comando ou comandos possíveis obtidos pelo previsor de gesto 105, juntamente com informação sobre como desempenhar um gesto seguinte de um comando completo possível. A Figura 3 é um diagrama mostrando exemplos da janela de exibição 103 de acordo com a modalidade da invenção. Aqui, o tamanho e a localização da janela de exibição podem ser selecionados por um especialista na técnica conforme exigido, e podem cobrir a imagem em toda a tela na tela de exibição 102 ou serem transparentes para a imagem.

A janela de exibição 103 na tela de exibição 102 é controlada pelo controlador de exibição 104. O controlador de exibição 104 irá proporcionar algumas indicações ou instruções sobre como desempenhar o subgesto seguinte para cada gesto composto previsto pelo previsor de gesto 105 de acordo com os gestos pré-definidos na lista de base de dados 107, e essas indicações ou instruções são mostradas na janela de exibição 103 por sugestões juntamente com informação sobre os comandos. Por exemplo, a janela de exibição 103 na tela de exibição 102 poderia destacar uma região na tela como janela de exibição para ajudar o usuário ou a usuária a continuar com seus subgestos seguintes. Nessa região, diversas sugestões, por exemplo, linhas pontilhadas com flecha ou linhas pontilhadas curvas são usadas para mostrar o subgesto seguinte de comandos possíveis. A informação sobre os comandos inclui “pegar e largar à esquerda” para guiar o usuário a mover a mão esquerda, “pegar e largar à direita” para guiar o usuário a mover a mão direita, e “só pegar” para guiar o usuário a manter esse gesto de pegar. Além disso, uma indicação do subgesto recebida pelo sistema de reconhecimento de gesto 100 também é mostrada em um local correspondente para as sugestões na janela de exibição 103. A indicação pode ser a imagem recebida pelo sistema ou quaisquer imagens que representam o subgesto. Adobe Flash®, Microsoft Silverlight® e Java FX® podem todos ser usados pelo controlador de exibição para implementar esse tipo de aplicativo como a indicação na janela de exibição 103. Além disso, as sugestões não se limitam às descritas acima, e podem ser implementadas como quaisquer outras indicações conforme necessário por um especialista na técnica apenas se as sugestões puderem ajudar os usuários a seguir uma delas para completar o comando por gesto.

A Figura 4 é um diagrama mostrando uma região na tela de exibição 102 de acordo com a modalidade. Como mostrado na Figura 4, a opacidade da exibição da indicação e instruções acima é um parâmetro-chave para ajudar o processo de reconhecimento de gesto a tornar-se gradualmente mais claro. Por exemplo, o valor Alfa em tecnologia “RGBA” (Vermelho Verde Azul Alfa) é um valor de mistura (0 ~ 1), o qual é usado para descrever o valor de opacidade (0 ~ 1) da região para refletir o progresso do reconhecimento de gesto e ajudar o processo de reconhecimento de gesto a tornar-se gradualmente mais claro. Por exemplo, um primeiro subgesto de pegar foi reconhecido e as sugestões são mostradas na janela de exibição, a seguir o usuário está executando o gesto composto “pegar e largar à esquerda” seguindo uma das sugestões, que também é reconhecido pela unidade de reconhecimento, as sugestões dos gestos “pegar e largar à esquerda” e “só pegar” na janela de exibição vão desaparecer, como mostrado na Figura 4(a). Ao mesmo tempo, a opacidade da janela de exibição vai diminuir com o progresso na execução do gesto “pegar e largar à esquerda” como mostrado na Figura 4(b).

A Figura 5 é um fluxograma mostrando um método de controle para a opacidade da janela de exibição usada pelo controlador de exibição 104 tomando o gesto composto “pegar e largar” como exemplo. Na etapa 501, é implementada a decisão de se ver se um gesto de pegar é executado pelo usuário, o que significa se o gesto de pegar é reconhecido pela unidade de reconhecimento. Se a resposta for não, o método vai para a etapa 510, e o controlador se mantém em stand by. Por outro lado, o valor de mistura alfa das linhas de direção ou sugestões de onde largar para todas as etapas de subgesto adjacentes e etapa de subgesto corrente são todos ajustados para ser 1 na etapa 502. Isto significa que toda informação na janela de exibição é exibida com clareza. Então, na etapa 503, julgar se o gesto de agarrar fica parado por um tempo específico de acordo com o resultado da unidade de reconhecimento, e se a resposta for afirmativa, isto significa que está sendo executado “pegar apenas”, e então o valor de mistura alfa das linhas de direção ou sugestões de onde largar para todas as etapas de subgesto adjacentes são todos ajustados para ser 0 na etapa 506. Isso significa que todos os subgestos adjacentes vão desaparecer na janela. E se a resposta na etapa 503 for não, então o método vai para a etapa 505 para julgar a direção do movimento do gesto de pegar. Se o gesto se move para uma direção de acordo com o resultado do reconhecimento, o valor de mistura alfa das linhas de direção ou sugestões de onde largar para outras direções são todos ajustados para ser 0 na etapa 507. Então, se o gesto de largar é executado de acordo com o resultado do reconhecimento na etapa 508, o valor de mistura alfa das linhas de direção ou sugestões de onde largar para a direção naquele momento também vão ser ajustados para ser 0 ou diminuídos gradualmente até 0 na etapa 509. Por outro lado, se está sendo executado o gesto de “só pegar”, e a etapa de largar ou armazenar está sendo implementada, o valor de mistura alfa de sua sugestão será também ajustado em zero ou gradualmente diminuído até zero.

A Figura 6 é um fluxograma mostrando um método para o reconhecimento de gesto de acordo com a modalidade da invenção. De acordo com a modalidade da invenção, quando o primeiro subgesto é reconhecido com base na localização da mão e outras características da mão, a estimativa sobre quais gestos manuais serão feitos pode ser conseguida com base no conhecimento de toda a definição de gestos na base de dados. Então uma janela vai surgir na tela de exibição para mostrar o gesto e as sugestões para os comandos por gestos avaliados. Então quando o segundo subgesto for reconhecido, o número de resultados de estimativa para os comandos por gesto com base no resultado do reconhecimento do primeiro e segundo subgestos vai mudar. Normalmente, o número será inferior ao que é baseado apenas no primeiro subgesto. Da mesma forma que na descrição no parágrafo acima, o novo resultado de estimativa será analisado e as sugestões de como terminar o subgesto seguinte dos comandos serão dadas. Além disso, se o número de resultados de estimativa diminuir, a opacidade da janela vai diminuir também. A mudança na opacidade da janela pode ser vista como outro tipo de sugestão para identificação do gesto composto.

Como mostrado na Figura 6, o gesto do usuário, tal como o primeiro subgesto, é identificado pela unidade de identificação de gesto 106 na etapa 601. Então, na etapa 602 o previsor 105 vai prever um ou mais comandos possíveis para o sistema com base no subgesto ou subgestos reconhecidos na etapa 601, e o subgesto seguinte de pelo menos um comando possível é indicado por uma interface de usuário em uma janela de exibição na etapa 603. Então, quando outro subgesto de um comando está sendo executado, outros desaparecerão da interface de usuário na etapa 604, e a opacidade da janela de exibição será diminuída na etapa 605. Então, quando o usuário tiver terminado o comando por gesto, a janela de exibição também vai desaparecer na etapa 606.

Embora a modalidade seja descrita com base no primeiro e segundo subgestos, outro reconhecimento de subgesto e as sugestões de seu subgesto seguinte de comandos mostradas na interface de usuário também são aplicáveis na modalidade da invenção. Se não for recebido outro subgesto ou o gesto de comando terminou, a janela de exibição vai desaparecer da tela.

O que foi descrito apenas ilustra a modalidade da invenção, e, portanto, será apreciado que os especialistas na técnica poderão pensar em numerosos arranjos alternativos que, embora não explicitamente descritos aqui, incorporam os princípios da invenção e estão dentro do seu espírito e escopo.

Claims (9)

1. Aparelho, compreendendo: uma unidade de previsão de gesto configurada para prever um ou mais comandos possíveis ao aparelho baseados em um ou mais subgestos e uma ordem de um ou mais subgestos anteriormente executados por um usuário e reconhecidos pelo aparelho; um visor configurado para exibir uma indicação de um subgesto seguinte de um ou mais comandos possíveis em uma interface de usuário em uma janela de exibição, CARACTERIZADO pelo fato de que a janela de exibição tem uma opacidade, e após uma previsão inicial, a opacidade da janela de exibição é reduzida quando o número de um ou mais comandos possíveis diminui em comparação ao número de um ou mais comandos possíveis anteriormente previstos.

2. Aparelho, de acordo com a reivindicação 1, CARACTERIZADO pelo fato de que o visor também é configurado para indicar um subgesto seguinte na interface de usuário por uma sugestão juntamente com informação sobre como executar o gesto seguinte para completar os comandos.

3. Aparelho, de acordo com a reivindicação 1 ou 2, CARACTERIZADO pelo fato de que o visor também é configurado para indicar um ou mais subgestos reconhecidos pelo aparelho.

4. Aparelho, de acordo com qualquer uma das reivindicações 1 a 3, CARACTERIZADO pelo fato de que quando o subgesto seguinte de um ou mais comandos possíveis é executado pelo usuário e reconhecido pelo aparelho, o visor também sendo também configurado para fazer os subgestos seguintes de outros comandos possíveis desaparecer na interface de usuário.

5. Aparelho, de acordo com qualquer uma das reivindicações 1 a 4, CARACTERIZADO pelo fato de que a unidade de previsão de gestos é configurada para prever o um ou mais comandos possíveis utilizando o um ou mais subgestos reconhecidos e a ordem do um ou mais subgestos para buscar em uma base de dados, em que a base de dados compreende definição de gestos de pelo menos um comando por gesto, cada comando por gesto compreende pelo menos um subgesto em uma ordem pré-definida.

6. Método para o reconhecimento de gesto em um aparelho, compreendendo: prever um ou mais comandos possíveis ao aparelho baseados em um ou mais subgestos e uma ordem de um ou mais subgestos anteriormente reconhecidos pelo aparelho; indicar um subgesto seguinte do um ou mais comandos possíveis por uma interface de usuário em uma indicação em uma janela de exibição, CARACTERIZADO pelo fato de que a janela de exibição tem uma opacidade, e após a previsão inicial, a opacidade da janela de exibição é reduzida quando o número de um ou mais comandos possíveis diminui em comparação com o número de um ou mais comandos possíveis anteriormente previstos.

7. Método, de acordo com a reivindicação 6, CARACTERIZADO pelo fato de que o subgesto seguinte é indicado por uma sugestão mostrada na interface de usuário, e uma indicação de um ou mais subgestos reconhecidos pelo aparelho também é mostrada na 5 interface de usuário.

8. Método, de acordo com a reivindicação 6 ou 7, CARACTERIZADO pelo fato de que um ou mais comandos possíveis são previstos utilizando o um ou mais subgestos reconhecidos e a ordem do um ou mais subgestos para buscar em uma base de dados, em que a base de dados compreende a definição de gesto do pelo menos um comando por 10 gesto, cada comando por gesto compreende pelo menos um subgesto em uma ordem pré- definida.

9. Método, de acordo com a reivindicação 7, CARACTERIZADO pelo fato de que a sugestão é mostrada juntamente com informação sobre como executar o subgesto seguinte para completar o pelo menos um comando.

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| PCT/CN2010/002206 WO2012088634A1 (en) | 2010-12-30 | 2010-12-30 | User interface, apparatus and method for gesture recognition |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| BR112013014287A2 BR112013014287A2 (pt) | 2016-09-20 |

| BR112013014287B1 true BR112013014287B1 (pt) | 2020-12-29 |

Family

ID=46382154

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| BR112013014287-1A BR112013014287B1 (pt) | 2010-12-30 | 2010-12-30 | Método e aparelho para reconhecimento de gesto |

Country Status (8)

| Country | Link |

|---|---|

| US (1) | US20130283202A1 (pt) |

| EP (1) | EP2659336B1 (pt) |

| JP (1) | JP5885309B2 (pt) |

| KR (1) | KR101811909B1 (pt) |

| CN (1) | CN103380405A (pt) |

| AU (1) | AU2010366331B2 (pt) |

| BR (1) | BR112013014287B1 (pt) |

| WO (1) | WO2012088634A1 (pt) |

Families Citing this family (24)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5585505B2 (ja) * | 2011-03-17 | 2014-09-10 | セイコーエプソン株式会社 | 画像供給装置、画像表示システム、画像供給装置の制御方法、画像表示装置、及び、プログラム |

| KR101322465B1 (ko) | 2011-11-17 | 2013-10-28 | 삼성전자주식회사 | 셀프 카메라 촬영을 위한 방법 및 장치 |

| SE537553C2 (sv) | 2012-08-03 | 2015-06-09 | Crunchfish Ab | Förbättrad identifiering av en gest |

| KR101984683B1 (ko) * | 2012-10-10 | 2019-05-31 | 삼성전자주식회사 | 멀티 디스플레이 장치 및 그 제어 방법 |

| US20140215382A1 (en) * | 2013-01-25 | 2014-07-31 | Agilent Technologies, Inc. | Method for Utilizing Projected Gesture Completion to Improve Instrument Performance |

| JP6212918B2 (ja) * | 2013-04-18 | 2017-10-18 | オムロン株式会社 | 遊技機 |

| US20150007117A1 (en) * | 2013-06-26 | 2015-01-01 | Microsoft Corporation | Self-revealing symbolic gestures |

| US9740923B2 (en) * | 2014-01-15 | 2017-08-22 | Lenovo (Singapore) Pte. Ltd. | Image gestures for edge input |

| DE102014001183B4 (de) | 2014-01-30 | 2022-09-22 | Audi Ag | Verfahren und System zum Auslösen wenigstens einer Funktion eines Kraftwagens |

| CN103978487B (zh) * | 2014-05-06 | 2017-01-11 | 宁波易拓智谱机器人有限公司 | 一种基于手势的通用机器人末端位置的操控方法 |

| CN104615984B (zh) * | 2015-01-28 | 2018-02-02 | 广东工业大学 | 基于用户任务的手势识别方法 |

| US20160257198A1 (en) | 2015-03-02 | 2016-09-08 | Ford Global Technologies, Inc. | In-vehicle component user interface |

| WO2016167331A1 (ja) * | 2015-04-17 | 2016-10-20 | 三菱電機株式会社 | ジェスチャー認識装置、ジェスチャー認識方法、及び情報処理装置 |

| US9914418B2 (en) | 2015-09-01 | 2018-03-13 | Ford Global Technologies, Llc | In-vehicle control location |

| US9967717B2 (en) | 2015-09-01 | 2018-05-08 | Ford Global Technologies, Llc | Efficient tracking of personal device locations |

| US10046637B2 (en) | 2015-12-11 | 2018-08-14 | Ford Global Technologies, Llc | In-vehicle component control user interface |

| WO2017104525A1 (ja) * | 2015-12-17 | 2017-06-22 | コニカミノルタ株式会社 | 入力装置、電子機器及びヘッドマウントディスプレイ |

| US10082877B2 (en) * | 2016-03-15 | 2018-09-25 | Ford Global Technologies, Llc | Orientation-independent air gesture detection service for in-vehicle environments |

| US9584653B1 (en) * | 2016-04-10 | 2017-02-28 | Philip Scott Lyren | Smartphone with user interface to externally localize telephone calls |

| US9914415B2 (en) | 2016-04-25 | 2018-03-13 | Ford Global Technologies, Llc | Connectionless communication with interior vehicle components |

| DE102016212240A1 (de) * | 2016-07-05 | 2018-01-11 | Siemens Aktiengesellschaft | Verfahren zur Interaktion eines Bedieners mit einem Modell eines technischen Systems |

| CN108520228A (zh) * | 2018-03-30 | 2018-09-11 | 百度在线网络技术(北京)有限公司 | 手势匹配方法及装置 |

| CN112527093A (zh) * | 2019-09-18 | 2021-03-19 | 华为技术有限公司 | 手势输入方法及电子设备 |

| CN110795015A (zh) * | 2019-09-25 | 2020-02-14 | 广州视源电子科技股份有限公司 | 操作提示方法、装置、设备及存储介质 |

Family Cites Families (25)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CA2323856A1 (en) * | 2000-10-18 | 2002-04-18 | 602531 British Columbia Ltd. | Method, system and media for entering data in a personal computing device |

| US7343566B1 (en) * | 2002-07-10 | 2008-03-11 | Apple Inc. | Method and apparatus for displaying a window for a user interface |

| US7665041B2 (en) * | 2003-03-25 | 2010-02-16 | Microsoft Corporation | Architecture for controlling a computer using hand gestures |

| US7466859B2 (en) * | 2004-12-30 | 2008-12-16 | Motorola, Inc. | Candidate list enhancement for predictive text input in electronic devices |

| KR100687737B1 (ko) * | 2005-03-19 | 2007-02-27 | 한국전자통신연구원 | 양손 제스쳐에 기반한 가상 마우스 장치 및 방법 |

| JP4684745B2 (ja) * | 2005-05-27 | 2011-05-18 | 三菱電機株式会社 | ユーザインタフェース装置及びユーザインタフェース方法 |

| JP4602166B2 (ja) * | 2005-06-07 | 2010-12-22 | 富士通株式会社 | 手書き情報入力装置。 |

| WO2007052382A1 (ja) * | 2005-11-02 | 2007-05-10 | Matsushita Electric Industrial Co., Ltd. | 表示オブジェクト透過装置 |

| US8972902B2 (en) * | 2008-08-22 | 2015-03-03 | Northrop Grumman Systems Corporation | Compound gesture recognition |

| JP4267648B2 (ja) * | 2006-08-25 | 2009-05-27 | 株式会社東芝 | インターフェース装置及びその方法 |

| KR101304461B1 (ko) * | 2006-12-04 | 2013-09-04 | 삼성전자주식회사 | 제스처 기반 사용자 인터페이스 방법 및 장치 |

| US20090049413A1 (en) * | 2007-08-16 | 2009-02-19 | Nokia Corporation | Apparatus and Method for Tagging Items |

| US20090100383A1 (en) * | 2007-10-16 | 2009-04-16 | Microsoft Corporation | Predictive gesturing in graphical user interface |

| JP2010015238A (ja) * | 2008-07-01 | 2010-01-21 | Sony Corp | 情報処理装置、及び補助情報の表示方法 |

| TW201009650A (en) * | 2008-08-28 | 2010-03-01 | Acer Inc | Gesture guide system and method for controlling computer system by gesture |

| US7983450B2 (en) * | 2009-03-16 | 2011-07-19 | The Boeing Company | Method, apparatus and computer program product for recognizing a gesture |

| US8285499B2 (en) * | 2009-03-16 | 2012-10-09 | Apple Inc. | Event recognition |

| JP5256109B2 (ja) * | 2009-04-23 | 2013-08-07 | 株式会社日立製作所 | 表示装置 |

| CN101706704B (zh) * | 2009-11-06 | 2011-05-25 | 谢达 | 一种会自动改变不透明度的用户界面显示方法 |

| US8622742B2 (en) * | 2009-11-16 | 2014-01-07 | Microsoft Corporation | Teaching gestures with offset contact silhouettes |

| JP2011204019A (ja) * | 2010-03-25 | 2011-10-13 | Sony Corp | ジェスチャ入力装置、ジェスチャ入力方法およびプログラム |

| TWI514194B (zh) * | 2010-06-18 | 2015-12-21 | Prime View Int Co Ltd | 電子閱讀器及其顯示方法 |

| JP5601045B2 (ja) * | 2010-06-24 | 2014-10-08 | ソニー株式会社 | ジェスチャ認識装置、ジェスチャ認識方法およびプログラム |

| DE112011102383T5 (de) * | 2010-08-17 | 2013-04-25 | Google Inc. | Berührungsbasierte Gestenerfassung für eine berührungsempfindliche Vorrichtung |

| US8701050B1 (en) * | 2013-03-08 | 2014-04-15 | Google Inc. | Gesture completion path display for gesture-based keyboards |

-

2010

- 2010-12-30 JP JP2013546543A patent/JP5885309B2/ja not_active Expired - Fee Related

- 2010-12-30 WO PCT/CN2010/002206 patent/WO2012088634A1/en active Application Filing

- 2010-12-30 US US13/977,070 patent/US20130283202A1/en not_active Abandoned

- 2010-12-30 AU AU2010366331A patent/AU2010366331B2/en not_active Ceased

- 2010-12-30 CN CN2010800710250A patent/CN103380405A/zh active Pending

- 2010-12-30 BR BR112013014287-1A patent/BR112013014287B1/pt not_active IP Right Cessation

- 2010-12-30 EP EP10861473.6A patent/EP2659336B1/en not_active Not-in-force

- 2010-12-30 KR KR1020137017091A patent/KR101811909B1/ko active IP Right Grant

Also Published As

| Publication number | Publication date |

|---|---|

| BR112013014287A2 (pt) | 2016-09-20 |

| KR20140014101A (ko) | 2014-02-05 |

| KR101811909B1 (ko) | 2018-01-25 |

| CN103380405A (zh) | 2013-10-30 |

| JP2014501413A (ja) | 2014-01-20 |

| JP5885309B2 (ja) | 2016-03-15 |

| AU2010366331B2 (en) | 2016-07-14 |

| EP2659336A4 (en) | 2016-09-28 |

| EP2659336B1 (en) | 2019-06-26 |

| EP2659336A1 (en) | 2013-11-06 |

| US20130283202A1 (en) | 2013-10-24 |

| AU2010366331A1 (en) | 2013-07-04 |

| WO2012088634A1 (en) | 2012-07-05 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| BR112013014287B1 (pt) | Método e aparelho para reconhecimento de gesto | |

| JP6038898B2 (ja) | エッジ・ジェスチャー | |

| US10127011B2 (en) | Device and method for performing functions | |

| KR102151286B1 (ko) | 애플리케이션과의 상호작용으로서의 다모드 사용자 표현 및 사용자 인텐서티 검출 기법 | |

| RU2604993C2 (ru) | Жест от границы | |

| US10275122B2 (en) | Semantic card view | |

| CN106687889A (zh) | 显示器便捷式文本输入和编辑 | |

| US20150177843A1 (en) | Device and method for displaying user interface of virtual input device based on motion recognition | |

| US20180321739A1 (en) | Electronic device and method for controlling display | |

| US20150234567A1 (en) | Information processing apparatus, information processing method and computer program | |

| JP2016192122A (ja) | 情報処理装置、情報処理方法、およびプログラム | |

| JP2016053768A (ja) | 情報処理装置、情報処理方法およびプログラム | |

| KR20160101605A (ko) | 제스처 입력 처리 방법 및 이를 지원하는 전자 장치 | |

| CN106796810A (zh) | 在用户界面上从视频选择帧 | |

| US20220221970A1 (en) | User interface modification | |

| WO2018004200A1 (en) | Electronic device and information providing method thereof | |

| US10580382B2 (en) | Power and processor management for a personal imaging system based on user interaction with a mobile device | |

| JP2015035120A5 (pt) | ||

| US20160274723A1 (en) | Mobile gesture reporting and replay with unresponsive gestures identification and analysis | |

| Spano | Developing touchless interfaces with gestit | |

| US11093122B1 (en) | Graphical user interface for displaying contextually relevant data | |

| KR20180055638A (ko) | 전자 장치 및 음성 인식을 이용한 전자 장치의 제어 방법 | |

| CN116382469A (zh) | 双手手势识别方法、交互界面显示方法和头戴式显示设备 | |

| JP2012003723A (ja) | 動作解析装置、動作解析方法、およびプログラム | |

| BR112012005342B1 (pt) | Método para controlar a operação de um sistema operacional e programa de aplicativos associados |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| B06F | Objections, documents and/or translations needed after an examination request according [chapter 6.6 patent gazette] | ||

| B25G | Requested change of headquarter approved |

Owner name: THOMSON LICENSING (FR) |

|

| B06U | Preliminary requirement: requests with searches performed by other patent offices: procedure suspended [chapter 6.21 patent gazette] | ||

| B25A | Requested transfer of rights approved |

Owner name: INTERDIGITAL CE PATENT HOLDINGS (FR) |

|

| B09A | Decision: intention to grant [chapter 9.1 patent gazette] | ||

| B16A | Patent or certificate of addition of invention granted [chapter 16.1 patent gazette] |

Free format text: PRAZO DE VALIDADE: 20 (VINTE) ANOS CONTADOS A PARTIR DE 30/12/2010, OBSERVADAS AS CONDICOES LEGAIS. |

|

| B21F | Lapse acc. art. 78, item iv - on non-payment of the annual fees in time |

Free format text: REFERENTE A 12A ANUIDADE. |

|

| B24J | Lapse because of non-payment of annual fees (definitively: art 78 iv lpi, resolution 113/2013 art. 12) |

Free format text: EM VIRTUDE DA EXTINCAO PUBLICADA NA RPI 2703 DE 25-10-2022 E CONSIDERANDO AUSENCIA DE MANIFESTACAO DENTRO DOS PRAZOS LEGAIS, INFORMO QUE CABE SER MANTIDA A EXTINCAO DA PATENTE E SEUS CERTIFICADOS, CONFORME O DISPOSTO NO ARTIGO 12, DA RESOLUCAO 113/2013. |