WO2020044630A1 - 検出器生成装置、モニタリング装置、検出器生成方法及び検出器生成プログラム - Google Patents

検出器生成装置、モニタリング装置、検出器生成方法及び検出器生成プログラム Download PDFInfo

- Publication number

- WO2020044630A1 WO2020044630A1 PCT/JP2019/010187 JP2019010187W WO2020044630A1 WO 2020044630 A1 WO2020044630 A1 WO 2020044630A1 JP 2019010187 W JP2019010187 W JP 2019010187W WO 2020044630 A1 WO2020044630 A1 WO 2020044630A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- detector

- face image

- learning data

- data sets

- learning

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

Definitions

- the present invention relates to a detector generation device, a monitoring device, a detector generation method, and a detector generation program.

- an organ of the driver's face is detected from an image obtained by photographing the driver.

- the state of the driver can be estimated based on the positional relationship between the detected organs. For example, if each eye is detected from the face image and the position of each eye can be specified, the gaze direction of the driver can be estimated based on the specified positional relationship of each eye.

- Patent Literature 1 proposes an apparatus for detecting a facial organ by using a convolutional neural network (Convolutional Neural Network). Specifically, the apparatus extracts a feature point candidate related to a facial organ from face image data using a convolutional neural network, and performs a geometric correction process on each extracted candidate. By doing so, the position of each feature point is determined. Thus, the device can recognize the target person based on the determined positions of the feature points.

- Convolutional Neural Network Convolutional Neural Network

- a detector constituted by a learning model such as a neural network may be employed.

- This detector can detect the position of the facial organ from the input face image by machine learning.

- a face image in which the face appears and position information indicating the positions of the facial organs are prepared.

- the parameters of the detector are adjusted so as to output an output value corresponding to the position information.

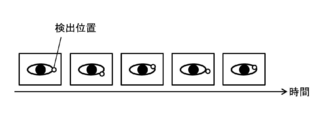

- FIG. 1 schematically illustrates an example of a scene in which the position of a facial organ is detected by a conventional method.

- FIG. 1 illustrates a scene in which an eye (specifically, an outer corner of the eye) is detected as an example of a facial organ.

- the detector has the ability to output the same output value for the same face image, in other words, the ability to answer the same position to the same face image as the detection position of the target organ. To win. Therefore, if the driver does not move the facial organ, the detection position of the organ that is answered by the detector should be constant.

- a plurality of continuously acquired images such as moving images may randomly include noise according to the performance of the imaging device, the imaging environment, and the like. Due to the effects of this random noise, it is difficult to obtain completely identical images, and each image may be slightly different. Due to the subtle differences between the images, the detected positions of the organs answered by the detector are blurred even though the driver does not move the facial organs. That is, as shown in FIG. 1, the detection position of the organ varies between face images due to the influence of noise included in each face image even though the organ (the outer corner of the eye) is not moved. The present inventors have found that can occur.

- the estimation result of the gaze direction of the driver fluctuates because the detection position of each eye is blurred even though the driver has not changed his / her gaze. Will be. This may result in the system erroneously recognizing the driver's state, for example, recognizing that the driver is looking aside while the driver is gazing ahead. Occurs.

- this problem is not a scene for detecting the facial organ of the driver as described above, but, for example, a scene for detecting a facial organ of a target person other than the driver, an object other than the facial organ of the target person.

- This can occur in any scene where an object is detected, such as a scene where the object is detected.

- a method using a conventional detector uses a method using a plurality of images even when the object is not moving. There may be a problem that the detection position of the object is blurred.

- the present invention in one aspect, has been made in view of such circumstances, and a purpose thereof is to provide a technique for generating a detector that is robust to the influence of noise and that can detect an object with higher accuracy. It is to provide.

- the present invention employs the following configuration in order to solve the above-described problems.

- the detector generation device uses a combination of a first face image in which the face of a subject driving a vehicle is captured and position information indicating the position of the facial organ in the first face image.

- a learning data acquisition unit that acquires a plurality of learning data sets configured respectively, and a learning processing unit that performs machine learning of a detector using the plurality of learning data sets. Then, performing the machine learning of the detector includes inputting the first face image of each of the learning data sets to the detector to generate a first output of each of the learning data sets for the first face image.

- the detector generation device acquires a plurality of learning data sets each configured by a combination of the first face image and the position information, and uses the acquired plurality of learning data sets to perform machine learning of the detector. Is carried out.

- the first face image corresponds to training data (input data)

- the position information corresponds to correct answer data (teacher data).

- the detector is configured to receive an input of a face image and output an output value corresponding to a result of detecting the position of a facial organ (for example, a coordinate value of the organ) in the input facial image.

- the detector generation device obtains a first output value by inputting a first face image to the detector in a process of machine learning, and obtains an organ specified based on the obtained first output value.

- a total value of a first error between the first detection position and the position indicated by the position information is calculated.

- the total value of the first error corresponds to a loss between the result of detecting the organ from the first face image by the detector and the correct answer of the position of the organ specified by the position information. Therefore, the detector generation device according to the above configuration trains the detector so that the total value of the first errors becomes small.

- a detector that has acquired the ability to detect an organ from the first face image is constructed so as to match the correct answer indicated by the position information.

- the detector generation device generates a second face image by adding noise to the first face image, and inputs the generated second face image to the detector to generate a second output value. To get. Then, the detector generation device according to the above configuration calculates a total value of a second error between the first detection position and the second detection position of the organ specified based on the acquired second output value.

- the total value of the second error is a blur of the detection result of the organ by the detector, and corresponds to a loss of the blur caused by the presence or absence of the noise. Therefore, the detector generation device according to the above configuration trains the detector such that the total value of the second error is reduced together with the total value of the first error. Thereby, it is possible to construct a detector in which the detection result of the organ is hardly affected by the noise.

- the detector generating apparatus having the above configuration, the organ is detected from the first face image so as to coincide with the correct answer indicated by the position information, and the detection result is hardly affected by noise.

- a constructed detector can be constructed. Therefore, it is possible to generate a detector that is robust against the influence of noise and that can detect an object (a facial organ in the above-described aspect) with higher accuracy.

- the detector is composed of a learning model that can execute machine learning.

- a detector may be constituted by a neural network, for example.

- the type of organ detected from the face image is not particularly limited as long as it is some part included in the face, and may be appropriately selected according to the embodiment.

- the organ to be detected may be selected from, for example, eyes, nose, mouth, eyebrows, chin, and combinations thereof.

- the organ to be detected may include the contour of the face.

- performing the machine learning of the detector includes applying a predetermined geometric transformation to the first face image of each of the learning data sets, so that each of the learning data sets Generating a third face image for the first face image, and inputting each of the third face images to the detector to obtain a third output value for each of the third face images.

- the first detection position specified based on the first output value obtained for the first face image of each of the learning data sets and the first detection position generated for the first face image Calculating a total value of a third error between the organ and a third detection position specified based on the third output value obtained for the third face image.

- the learning Management unit the sum of the first error may be trained sum and the detector so that the total value of the third error is smaller in the second error.

- the present inventors have found that, in addition to the influence of random noise generated in the image, the problem that the detection position of the organ fluctuates due to the following reasons. That is, the position information used as the correct answer data of the machine learning may include noise. That is, the position information has an instability that the position of the target organ is not always accurately indicated according to a certain reference. For example, when the position information is input by a human, if the person who inputs the position information is different, the position specified as the position where the organ exists may be different. Even if the same person inputs the position information, it is difficult to specify a position that completely matches the same face image a plurality of times.

- the input position information always indicates the position of the target organ in accordance with a certain standard. Is not always shown exactly. That is, the position at which the organ indicated by the position information exists may vary.

- position information including such noise is used as correct data for machine learning

- the detector learns not only to reproduce the position of a given organ with respect to the face image but also to reproduce this noise. .

- the detected position of the organ that is answered by the learned detector is blurred. That is, as illustrated in FIG. 1 above, even though the organ (the outer corner of the eye) is not moved, the effect of learning the noise included in the position information used for the machine learning can be reduced between the face images. There may be a problem that the detection position fluctuates.

- the detector generation device generates a third face image by applying a predetermined geometric transformation to the first face image, and inputs the generated third face image to the detector. Obtains the third output value. Then, the detector generation device according to the configuration calculates a total value of a third error between the first detection position and the third detection position of the organ specified based on the acquired third output value.

- the detector constructed can capture some characteristic of the target organ corresponding to a certain criterion and accurately detect the position of the target organ. Therefore, the detector can also accurately detect the position of the target organ based on the characteristics of the third face image generated by performing the geometric transformation on the first face image.

- the detector constructed by machine learning based on the first error can accurately detect the above features. Cannot detect it, and the position where the target organ is detected is blurred. Therefore, there is a high possibility that this detector cannot accurately detect the position of the target organ with respect to the third face image generated by geometrically transforming the first face image.

- the position information given to each first face image does not indicate the position of the target organ according to a certain standard is, for example, in spite of the fact that the position of the face is shifted in each first face image. In this case, position information indicating a fixed position for each face image is added to each first face image.

- the total value of the third error is a blur of the detection result of the organ by the detector, and corresponds to a loss of the blur caused by the influence of the geometric noise in the face image. Therefore, the detector generation device according to the configuration trains the detector so that the total value of the third error is reduced together with the total value of the first error and the second error. This makes it possible to construct a detector that is robust against the influence of image noise and geometric noise included in position information.

- the predetermined geometric transformation may be, for example, translation, rotation, inversion, enlargement, reduction, or a combination thereof.

- the predetermined geometric transformation may be a transformation involving translation and rotation. This makes it possible to construct a detector that is robust to the effects of the parallel movement and the rotational movement.

- the position information of each of the learning data sets is obtained by inputting the first face image combined with the position information to another detector on which machine learning has been performed. May be provided based on output values obtained from the other detectors. According to this configuration, since the detection result of the other detector is used as the position information, it is possible to prevent the artificial noise from being included in the position information. This makes it possible to construct a detector that is robust to the influence of noise that may be included in the position information.

- the other detector may be a temporary detector generated in the process of obtaining a final detector by machine learning. That is, the detector generation device may alternately and repeatedly execute a process of constructing a detector by machine learning using a learning data set and a process of updating position information by the constructed detector. In order to construct a detector that is robust to the influence of the artificial noise, only a part that alternately executes a process of constructing the detector and a process of updating the position information is extracted, and according to a new mode.

- a detector generation device may be configured.

- the detector generation device is configured by a combination of a face image showing a face of a subject driving a vehicle and first position information indicating a position of the facial organ shown in the face image.

- a learning data acquisition unit that acquires a plurality of first learning data sets to be performed, and machine learning of a first detector using the plurality of first learning data sets, thereby obtaining each of the first learning data sets.

- a learning processing unit configured to construct a first detector that outputs an output value corresponding to the first position information combined with the input face image when the set of face images is input. Then, the learning data obtaining unit inputs the face image of each of the first learning data sets and the face image to the constructed first detector, thereby obtaining an output value obtained from the first detector.

- the learning processing unit performs machine learning of a second detector using the plurality of second learning data sets, so that the face image of each of the second learning data sets is input. And constructing a second detector that outputs an output value corresponding to the second position information combined with the input face image.

- the first detector is an example of the above “other detector”, that is, a temporary detector.

- the second detector constructed in one step is used as the first detector in the next step.

- the second detector constructed last is an example of the above “detector”, that is, an example of a final detector.

- the monitoring device has already performed machine learning by a data acquisition unit that acquires a face image of a face of a driver driving a vehicle and a detector generation device according to any one of the above embodiments.

- a detection unit that obtains from the detector an output value corresponding to a result of detecting the facial organ of the driver, and a detector of the driver's face.

- An output unit that outputs information on a result of detecting the organ.

- the detector generation device and the monitoring device according to each of the above-described embodiments are not only used to detect a facial organ of a driver of a vehicle, but also to detect a facial organ of a worker of a production line.

- the present invention may be applied to any scene where a facial organ of a subject other than the subject is detected.

- the detector generation device and the monitoring device according to each of the above-described embodiments detect not only a scene for detecting a facial organ of a subject, but also, for example, a position of some characteristic (for example, a scratch) of a product flowing on a production line.

- the present invention may be applied to any scene, such as a scene, in which the position of an object other than a person is detected from an image of the object.

- the detector generation device is configured by a combination of a first face image in which a face of a subject is captured and position information indicating a position of the face organ in the first face image.

- a learning data acquisition unit that acquires a plurality of learning data sets; and a learning processing unit that performs machine learning of the detector using the plurality of learning data sets. Then, performing the machine learning of the detector includes inputting the first face image of each of the learning data sets to the detector to generate a first output of each of the learning data sets for the first face image.

- the detector generation device includes a plurality of images each of which is configured by a combination of a first image in which an object is captured and position information indicating a position of the object in the first image.

- a learning data acquisition unit that acquires a learning data set; and a learning processing unit that implements machine learning of a detector using the plurality of learning data sets. Then, performing the machine learning of the detector includes inputting the first image of each of the learning data sets to the detector, thereby obtaining a first output value of each of the learning data sets for the first image. Acquiring from the detector, a first detection position of the target object specified based on the first output value obtained for the first image of each of the learning data sets, and the first image.

- the detector generation device includes a plurality of face images each including a face image of a subject's face and first position information indicating a position of the facial organ in the face image.

- a learning data acquisition unit for acquiring a first learning data set; and machine learning of a first detector using the plurality of first learning data sets, thereby obtaining the face of each of the first learning data sets.

- a learning processing unit configured to construct a first detector that outputs an output value corresponding to the first position information combined with the input face image when an image is input. Then, the learning data obtaining unit inputs the face image of each of the first learning data sets and the face image to the constructed first detector, thereby obtaining an output value obtained from the first detector.

- the learning processing unit performs machine learning of a second detector using the plurality of second learning data sets, so that the face image of each of the second learning data sets is input. And constructing a second detector that outputs an output value corresponding to the second position information combined with the input face image.

- the detector generation device may include a plurality of first detectors each configured by a combination of an image of an object and first position information indicating a position of the object in the image.

- a learning data acquisition unit that acquires a learning data set; and machine learning of a first detector using the plurality of first learning data sets, whereby the image of each of the first learning data sets is input.

- a learning processing unit configured to construct a first detector that outputs an output value corresponding to the first position information combined with the input image. Then, the learning data acquisition unit is configured to input the image of each of the first learning data sets and the image to the constructed first detector, and to output the image based on an output value obtained from the first detector.

- a plurality of second learning data sets each constituted by a combination of the second position information given by the second learning unit. Further, the learning processing unit performs machine learning of a second detector using the plurality of second learning data sets, and when the image of each of the second learning data sets is input, A second detector is further configured to output an output value corresponding to the second position information combined with the input image.

- Training the detector is to adjust the parameters of the detector.

- the parameters of the detector are used in an arithmetic process for detecting (obtaining an output value) any object from an image.

- the parameters are, for example, the weight of the connection between each neuron, the threshold value of each neuron, and the like.

- the type of the target object is not particularly limited as long as it can be captured in an image, and may be appropriately selected according to the embodiment.

- the target object When an image of a person is acquired as the first image, the target object may be, for example, a facial organ, a face itself, or a body part other than the face.

- the target object When an image of a product produced on the production line is obtained as the first image, the target object may be, for example, the product itself, or some feature (for example, a scratch) included in the product.

- Each detection position is a position at which the detector detects an object for each image.

- the second error corresponds to a difference between the detection position of the target with respect to the noise image (the second face image and the second image) and the detection position of the target with respect to the original image (the first face image and the first image).

- the third error is a relative difference between the detection position of the target with respect to the geometrically transformed image (the third face image and the third image) and the detection position of the target with respect to the original image (the first face image and the first image). Is equivalent to The third error may be derived by calculating a difference between a position obtained by applying the inverse transform of the geometric transformation to the position detected from the geometrically transformed image and a position detected from the original image.

- the third error may be derived by calculating a difference between a position detected from the geometrically transformed image and a position obtained by applying the geometric transformation to the position detected from the original image.

- calculating “the third error between the first detection position of the organ specified based on the first output value and the third detection position of the organ specified based on the third output value” is equivalent to performing the geometric transformation. Calculating the difference between the position obtained by applying the inverse transformation of the geometric transformation to the position detected from the image and the position detected from the original image, and detecting from the position detected from the geometrically transformed image and the original image And calculating a difference from the position obtained by applying the geometric transformation to the set position.

- the detector may be referred to as a “learner”.

- the detector after machine learning may be referred to as a “learned learning device”.

- the format of the position information need not be particularly limited, and may be appropriately determined according to the embodiment.

- the position information may be constituted by, for example, coordinate values of the object, or may be constituted by information indicating an area of the object.

- one aspect of the present invention may be an information processing method or a program for realizing each of the above configurations.

- a computer-readable storage medium storing such a program may be used.

- a storage medium readable by a computer or the like is a medium that stores information such as a program by electrical, magnetic, optical, mechanical, or chemical action.

- a detection system according to one aspect of the present invention may be configured by the detector generation device and the monitoring device according to any one of the above-described embodiments.

- the computer may include a first face image in which a face of a subject driving a vehicle is captured, and position information indicating a position of the face organ in the first face image.

- Detector Acquiring, the first detection position specified based on the first output value obtained for the first face image of each of the learning data sets, and the first detection position specified for the first face image. Calculating a total value of a second error between the second detection position of the organ specified based on the second output value obtained for the second face image, and a total value of the first error Training the detector such that the sum of the second errors is small.

- the detector generation program indicates to a computer a first face image in which a face of a subject driving a vehicle is captured, and a position of an organ of the face in the first face image.

- the step of performing machine learning of the detector includes inputting the first face image of each of the learning data sets to the detector, thereby outputting a first output of each of the learning data sets for the first face image.

- Detector Acquiring, the first detection position specified based on the first output value obtained for the first face image of each of the learning data sets, and the first detection position specified for the first face image. Calculating a total value of a second error between the second detection position of the organ specified based on the second output value obtained for the second face image, and a total value of the first error Training the detector such that the sum of the second errors is small.

- the present invention it is possible to generate a detector that is robust to the influence of noise and that can detect an object with higher accuracy.

- FIG. 1 is a diagram for explaining a problem that occurs in a conventional detector.

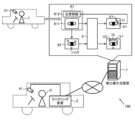

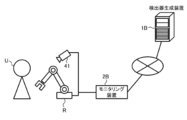

- FIG. 2 schematically illustrates an example of a scene to which the present invention is applied.

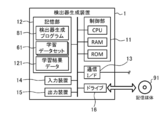

- FIG. 3 schematically illustrates an example of a hardware configuration of the detector generation device according to the embodiment.

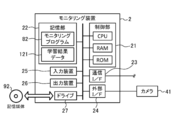

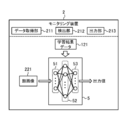

- FIG. 4 schematically illustrates an example of a hardware configuration of the monitoring device according to the embodiment.

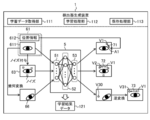

- FIG. 5 schematically illustrates an example of a software configuration of the detector generation device according to the embodiment.

- FIG. 6 schematically illustrates an example of a software configuration of the monitoring device according to the embodiment.

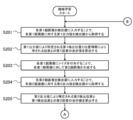

- FIG. 7 illustrates an example of a processing procedure of the detector generation device according to the embodiment.

- FIG. 8A illustrates an example of a processing procedure of machine learning according to the embodiment.

- FIG. 8A illustrates an example of a processing procedure of machine learning according to the embodiment.

- FIG. 8B illustrates an example of a processing procedure of machine learning according to the embodiment.

- FIG. 9 schematically illustrates an example of a scene in which machine learning is repeatedly performed.

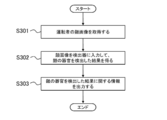

- FIG. 10 illustrates an example of a processing procedure of the monitoring device according to the embodiment.

- FIG. 11 schematically illustrates an example of a software configuration of a detector generation device according to a modification.

- FIG. 12 schematically illustrates another example of a scene to which the present invention is applied.

- FIG. 13 schematically illustrates another example of a scene to which the present invention is applied.

- FIG. 14 schematically illustrates an example of a software configuration of a detector generation device according to a modification.

- FIG. 15 schematically illustrates an example of a software configuration of a detector generation device according to a modification.

- the present embodiment will be described with reference to the drawings.

- the present embodiment described below is merely an example of the present invention in every respect. It goes without saying that various improvements and modifications can be made without departing from the scope of the invention. That is, in implementing the present invention, a specific configuration according to the embodiment may be appropriately adopted.

- the data appearing in the present embodiment is described in a natural language, more specifically, it is specified in a pseudo language, a command, a parameter, a machine language, and the like that can be recognized by a computer.

- FIG. 2 schematically illustrates an example of an application scene of the detection system 100 according to the present embodiment.

- a face of a driver driving a vehicle is photographed, and a facial organ is detected from an obtained face image.

- the face image is an example of the “image” of the present invention

- the facial organ is an example of the “object” of the present invention.

- the application target of the present invention is not limited to such an example, and is applicable to any scene in which an object is detected from an image.

- the detection system 100 includes a detector generation device 1 and a monitoring device 2 connected to each other via a network, and includes a detector for detecting a facial organ.

- the generated and configured detector is configured to detect a facial organ of the driver.

- the type of network between the detector generation device 1 and the monitoring device 2 may be appropriately selected from, for example, the Internet, a wireless communication network, a mobile communication network, a telephone network, a dedicated network, and the like.

- the detector generation device 1 is a computer configured to construct a detector 5 for detecting a facial organ from a face image by performing machine learning. Specifically, the detector generation device 1 uses a combination of a first face image 611 showing the face of the subject T driving the vehicle and position information 612 indicating the position A1 of the facial organ shown in the first face image 611. A plurality of learning data sets 61 configured respectively are acquired.

- the first face image 611 is obtained, for example, by the camera 31 installed at a position in the vehicle where the face of the subject T can be photographed.

- the first face image 611 corresponds to training data (input data) in machine learning

- the position information 612 corresponds to correct answer data (teacher data).

- the detector generation device 1 performs machine learning of the detector 5 using such a plurality of learning data sets 61.

- the detector generation device 1 first inputs the first face image 611 of each learning data set 61 to the detector 5 so that the first face image of each learning data set 61

- the first output value for 611 is obtained from the detector 5.

- the detector 5 is configured to receive an input of a face image and output an output value corresponding to a result of detecting a position of a facial organ appearing in the input face image. That is, the first output value corresponds to the result of the detector 5 detecting the position of the facial organ of the subject T appearing in the first face image 611.

- Such a detector 5 is configured by a learning model capable of performing machine learning.

- the detector 5 is configured by a neural network described later.

- the detector generation device 1 determines the first detection position V1 of the organ specified based on the first output value obtained for the first face image 611 of each learning data set 61 and the first face image

- the total value of the first error 71 from the position A1 indicated by the position information 612 combined with 611 is calculated. That is, for each learning data set 61, the detector generation device 1 calculates the difference between the first detection position V1 obtained for the first face image 611 and the position A1 indicated by the corresponding position information 612 as the first error.

- the total value of the first errors 71 is calculated by adding the calculated first errors 71 to each other.

- the detector generation device 1 generates a second face image 63 for the first face image 611 of each learning data set 61 by adding noise to the first face image 611 of each learning data set 61. . Subsequently, the detector generation device 1 acquires the second output value for each second face image 63 from the detector 5 by inputting each generated second face image 63 to the detector 5. Further, the detector generation device 1 determines the first detection position V1 specified based on the first output value obtained for the first face image 611 of each of the learning data sets 61 and the first detection image V11. A total value of the second error 72 between the second detection position V2 of the specified organ and the second specified position is calculated based on the second output value obtained for the second face image 63 generated as described above.

- the detector generation device 1 obtains the first detection position V1 obtained for the first face image 611 and the second detection position V1 obtained for the corresponding second face image 63.

- the difference between the positions V2 is calculated as the second errors 72, and the calculated second errors 72 are added to calculate the total value of the second errors 72.

- the detector generation device 1 trains the detector 5 so that the total value of the first error 71 and the total value of the second error 72 become small.

- Training the detector 5 is, in particular, adjusting the parameters of the detector 5.

- the parameters of the detector 5 are used for arithmetic processing for detecting (obtaining an output value) any object from an image.

- the detector 5 is configured by a neural network described later. Therefore, this parameter is, for example, the weight of the connection between each neuron, the threshold value of each neuron, and the like.

- a known learning algorithm such as an error back propagation method may be used.

- the total value of the first errors 71 corresponds to the loss between the result of detecting the organ from the first face image 611 by the detector 5 and the correct answer of the position of the organ specified by the position information 612.

- the total value of the second errors 72 is the blur of the detection result of the organ by the detector 5, and corresponds to the blur loss caused by the presence or absence of noise in the first face image 611. Therefore, by the machine learning, the detector generation device 1 detects the organ from the first face image 611 so as to match the correct answer indicated by the position information 612, and the detection result is less likely to be affected by noise.

- the trained (learned) detector 5 can be constructed (generated).

- the monitoring device 2 uses the learned detector 5 constructed by the detector generation device 1 to detect the facial organ of the driver D driving the vehicle from the face image.

- the monitoring device 2 acquires a face image in which the face of the driver D driving the vehicle is captured.

- the face image is obtained, for example, by the camera 41 installed at a position in the vehicle where the driver D can photograph the face.

- the monitoring device 2 inputs the acquired face image to the detector 5 on which the machine learning has been performed by the detector generation device 1 and outputs an output value corresponding to the result of detecting the facial organ of the driver D. From the detector 5. Then, the monitoring device 2 outputs information on the result of detecting the facial organ of the driver D. For example, the monitoring device 2 can estimate the state of the driver D such as the line of sight based on the detected position of the facial organ. Therefore, the monitoring device 2 may output, as information on the detection result, a result of estimating the state of the driver D based on the detection result. Thereby, the monitoring device 2 can monitor the state of the driver D.

- the detector 5 is built robustly to the effects of noise. Therefore, the monitoring device 2 can detect the facial organ of the driver D with high accuracy by using the detector 5. Therefore, the monitoring device 2 can accurately estimate, for example, the state of the driver D's line of sight during the driving operation.

- the detector generation device 1 and the monitoring device 2 are separate computers.

- the configuration of the detection system 100 need not be limited to such an example.

- the detector generation device 1 and the monitoring device 2 may be configured by an integrated computer. Further, the detector generation device 1 and the monitoring device 2 may each be configured by a plurality of computers. Further, the detector generation device 1 and the monitoring device 2 need not be connected to a network. In this case, data exchange between the detector generation device 1 and the monitoring device 2 may be performed via a storage medium such as a nonvolatile memory.

- FIG. 2 illustrates an eye (specifically, an outer corner of the eye) as an example of a facial organ to be detected.

- the facial organs to be detected need not be limited to the eyes.

- the facial organ to be detected may be selected from, for example, eyes, nose, mouth, eyebrows, chin, and combinations thereof.

- the organ to be detected may include the contour of the face. The same applies to FIGS. 5 and 11 described later.

- FIG. 3 schematically illustrates an example of hardware of the detector generation device 1 according to the present embodiment.

- the detector generation device 1 includes a computer in which a control unit 11, a storage unit 12, a communication interface 13, an input device 14, an output device 15, and a drive 16 are electrically connected. It is.

- the communication interface is described as “communication I / F”.

- the control unit 11 includes a CPU (Central Processing Unit) as a hardware processor, a RAM (Random Access Memory), a ROM (Read Only Memory), and the like, and is configured to execute information processing based on programs and various data.

- the storage unit 12 is an example of a memory, and includes, for example, a hard disk drive, a solid state drive, and the like. In the present embodiment, the storage unit 12 stores various information such as a detector generation program 81, a plurality of learning data sets 61, learning result data 121, and the like.

- the detector generation program 81 is a program for causing the detector generation device 1 to execute machine learning information processing (FIGS. 7, 8A, and 8B) to be described later to construct the learned detector 5.

- the detector generation program 81 includes a series of instructions for this information processing.

- Each learning data set 61 includes the first face image 611 and position information 612.

- the learning result data 121 is data for setting the learned detector 5 constructed by machine learning using each learning data set 61.

- the learning result data 121 is generated as an execution result of the detector generation program 81. Details will be described later.

- the communication interface 13 is, for example, a wired LAN (Local Area Network) module, a wireless LAN module, or the like, and is an interface for performing wired or wireless communication via a network.

- the detector generation device 1 can perform data communication via the network with another information processing device (for example, the monitoring device 2) by using the communication interface 13.

- the input device 14 is a device for inputting, for example, a mouse and a keyboard.

- the output device 15 is a device for outputting, for example, a display, a speaker, and the like. The operator can operate the detector generation device 1 by using the input device 14 and the output device 15.

- the drive 16 is, for example, a CD drive, a DVD drive, or the like, and is a drive device for reading a program stored in the storage medium 91.

- the type of the drive 16 may be appropriately selected according to the type of the storage medium 91.

- At least one of the detector generation program 81 and the plurality of learning data sets 61 may be stored in the storage medium 91.

- the storage medium 91 stores information such as a program by an electrical, magnetic, optical, mechanical, or chemical action so that a computer or other device or machine can read the information such as a recorded program. It is a medium for storing.

- the detector generation device 1 may acquire at least one of the detector generation program 81 and the plurality of learning data sets 61 from the storage medium 91.

- FIG. 3 illustrates a disk-type storage medium such as a CD or a DVD as an example of the storage medium 91.

- the type of the storage medium 91 is not limited to the disk type, and may be other than the disk type.

- Examples of the storage medium other than the disk type include a semiconductor memory such as a flash memory.

- the control unit 11 may include a plurality of hardware processors.

- the hardware processor may include a microprocessor, a field-programmable gate array (FPGA), a digital signal processor (DSP), and the like.

- the storage unit 12 may be configured by a RAM and a ROM included in the control unit 11. At least one of the communication interface 13, the input device 14, the output device 15, and the drive 16 may be omitted.

- the detector generation device 1 may further include an external interface for connecting to the camera 31. This external interface may be configured similarly to an external interface 24 of the monitoring device 2 described below.

- the detector generation device 1 may be composed of a plurality of computers. In this case, the hardware configuration of each computer may or may not match.

- the detector generation device 1 may be a general-purpose server device, a personal computer (PC), or the like, in addition to an information processing device designed specifically for a provided service.

- FIG. 4 schematically illustrates an example of a hardware configuration of the monitoring device 2 according to the present embodiment.

- the monitoring device 2 includes a control unit 21, a storage unit 22, a communication interface 23, an external interface 24, an input device 25, an output device 26, and a drive 27, which are electrically connected.

- Computer In FIG. 4, the communication interface and the external interface are described as “communication I / F” and “external I / F”, respectively.

- the control unit 21 to the communication interface 23 and the input device 25 to the drive 27 of the monitoring device 2 may be configured similarly to the control unit 11 to the drive 16 of the detector generation device 1, respectively. That is, the control unit 21 includes a hardware processor such as a CPU, a RAM, a ROM, and the like, and is configured to execute various types of information processing based on programs and data.

- the storage unit 22 includes, for example, a hard disk drive, a solid state drive, and the like. The storage unit 22 stores various information such as the monitoring program 82 and the learning result data 121.

- the monitoring program 82 is a program for causing the monitoring device 2 to execute information processing (FIG. 10) described below for monitoring the state of the driver D using the learned detector 5.

- the monitoring program 82 includes a series of instructions for this information processing. Details will be described later.

- the communication interface 23 is, for example, a wired LAN module, a wireless LAN module, or the like, and is an interface for performing wired or wireless communication via a network.

- the monitoring device 2 can perform data communication via a network with another information processing device (for example, the detector generation device 1) by using the communication interface 23.

- the external interface 24 is, for example, a USB (Universal Serial Bus) port, a dedicated port, or the like, and is an interface for connecting to an external device.

- the type and number of external interfaces 24 may be appropriately selected according to the type and number of external devices to be connected.

- the monitoring device 2 is connected to the camera 41 via the external interface 24.

- the camera 41 is used to obtain a face image by photographing the face of the driver D.

- the type and location of the camera 41 need not be particularly limited, and may be appropriately determined according to the embodiment.

- a known camera such as a digital camera and a video camera may be used.

- the camera 41 may be arranged, for example, above and in front of the driver's seat such that at least the upper body of the driver D is set as a shooting range.

- the monitoring device 2 may be connected to the camera 41 via the communication interface 23 instead of the external interface 24.

- the input device 25 is a device for inputting, for example, a mouse and a keyboard.

- the output device 26 is, for example, a device for outputting a display, a speaker, or the like.

- the operator such as the driver D can operate the monitoring device 2 by using the input device 25 and the output device 26.

- the drive 27 is, for example, a CD drive, a DVD drive, or the like, and is a drive device for reading a program stored in the storage medium 92. At least one of the monitoring program 82 and the learning result data 121 may be stored in the storage medium 92. In addition, the monitoring device 2 may acquire at least one of the monitoring program 82 and the learning result data 121 from the storage medium 92.

- the control unit 21 may include a plurality of hardware processors.

- the hardware processor may be constituted by a microprocessor, an FPGA, a DSP, or the like.

- the storage unit 22 may be configured by a RAM and a ROM included in the control unit 21. At least one of the communication interface 23, the external interface 24, the input device 25, the output device 26, and the drive 27 may be omitted.

- the monitoring device 2 may be composed of a plurality of computers. In this case, the hardware configuration of each computer may or may not match.

- a general-purpose server device a general-purpose desktop PC, a notebook PC, a tablet PC, a mobile phone including a smartphone, or the like may be used in addition to the information processing device designed exclusively for the provided service.

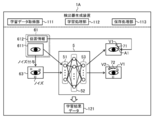

- FIG. 5 schematically illustrates an example of a software configuration of the detector generation device 1 according to the present embodiment.

- the control unit 11 of the detector generation device 1 expands the detector generation program 81 stored in the storage unit 12 in the RAM. Then, the control unit 11 controls the components by interpreting and executing the detector generation program 81 expanded in the RAM by the CPU.

- the detector generation device 1 operates as a computer including the learning data acquisition unit 111, the learning processing unit 112, and the storage processing unit 113 as software modules. That is, in the present embodiment, each software module of the detector generation device 1 is realized by the control unit 11 (CPU).

- the learning data acquisition unit 111 includes a plurality of sets each including a combination of a first face image 611 in which the face of the subject T driving the vehicle is captured and position information 612 indicating a position of a facial organ in the first face image 611.

- the learning data set 61 is obtained.

- the target organ may be selected from, for example, eyes, nose, mouth, eyebrows, chin, and combinations thereof. Further, the target organ may include a face outline.

- the learning processing unit 112 performs machine learning of the detector 5 using the plurality of learning data sets 61. Specifically, as a process of machine learning, the learning processing unit 112 first inputs the first face image 611 of each learning data set 61 to the detector 5 so that the first face image of each learning data set 61 The first output value for 611 is obtained from the detector 5. Subsequently, the learning processing unit 112 determines the first detection position V1 of the organ specified based on the first output value obtained for the first face image 611 of each learning data set 61 and the first face image 611 Is calculated with respect to the position A1 indicated by the position information 612 combined with the first error 71.

- the learning processing unit 112 generates a second face image 63 for the first face image 611 of each learning data set 61 by adding noise to the first face image 611 of each learning data set 61. Subsequently, the learning processing unit 112 acquires the second output value for each second face image 63 from the detector 5 by inputting each of the generated second face images 63 to the detector 5. Then, the learning processing unit 112 determines the first detection position V1 specified based on the first output value obtained for the first face image 611 of each learning data set 61 and the first face image 611. Based on the second output value obtained for the generated second face image 63, the total value of the second error 72 with the second detection position V2 of the specified organ is calculated.

- the learning processing unit 112 applies a predetermined geometric transformation to the first face image 611 of each of the learning data sets 61 to thereby perform the first face image 611 of each of the learning data sets 61 on the first face image 611.

- a three-face image 66 is generated.

- the predetermined geometric transformation may be, for example, translation, rotation, inversion, enlargement, reduction, or a combination thereof.

- the predetermined geometric transformation may be a transformation involving translation and rotation. In the example of FIG. 5, a scene in which a transformation involving translation and rotation is applied to the first face image 611 is illustrated.

- the learning processing unit 112 acquires a third output value for each third face image 66 from the detector 5 by inputting each generated third face image 66 to the detector 5. Then, the learning processing unit 112 generates a first detection position specified based on the first output value obtained for the first face image 611 of each learning data set 61 and generates the first detection position for the first face image 611. Based on the third output value obtained for the obtained third face image 66, the total value of the third error 73 with the third detection position of the specified organ is calculated.

- the learning processing unit 112 sets the coordinate axes of the first face image 611 and the coordinate axes of the third face image 66. And performs a conversion process to match.

- the learning processing unit 112 specifies the third detection position V30 of the organ on the coordinate axis of the third face image 66 based on the third output value acquired from the detector 5.

- the learning processing unit 112 applies an inverse transformation of a predetermined geometric transformation to the specified detection position V30, matches the coordinate axis of the third face image 66 with the coordinate axis of the first face image 611, and The third detection position V31 on the coordinate axis 611 is specified.

- the learning processing unit 112 calculates the difference between the third detection position V31 and the first detection position V1 as a third error 73, and adds the third error 73 for each learning data set 61 to obtain the third error.

- the total value of the errors 73 is calculated.

- the method of calculating the total value of the third errors between the first detection position and the third detection position is not limited to such an example.

- the learning processing unit 112 applies a predetermined inverse transformation to the first detection position V1 on the coordinate axis of the first face image 611, so that the coordinate axis of the first face image 611 matches the coordinate axis of the third face image 66. Good. Then, the learning processing unit 112 may calculate the difference between the first detection position and the third detection position V30 on the coordinate axis of the third face image 66 as the third error 73.

- the learning processing unit 112 trains the detector 5 so that the total value of the first error 71, the total value of the second error 72, and the total value of the third error 73 become small. Accordingly, the learning processing unit 112 constructs the learned detector 5 for detecting the facial organ of the driver.

- the detector 5 is configured by a neural network.

- the detector 5 is configured by a multilayered neural network used for so-called deep learning, and includes an input layer 51, an intermediate layer (hidden layer) 52, and an output layer 53.

- the neural network constituting the detector 5 includes one intermediate layer 52, the output of the input layer 51 is input to the intermediate layer 52, and the output of the intermediate layer 52 is output to the output layer. 53 has been input.

- the configuration of the detector 5 need not be limited to such an example.

- the number of the intermediate layers 52 may not be limited to one layer.

- the detector 5 may include two or more intermediate layers 52.

- Each of the layers 51 to 53 has one or more neurons.

- the number of neurons in the input layer 51 may be set according to the number of pixels of the first face image 611.

- the number of neurons in the intermediate layer 52 may be appropriately set according to the embodiment.

- the number of neurons in the output layer 53 may be set according to the number of organs to be detected, the position expression, and the like.

- each neuron in adjacent layers is appropriately connected to each other, and a weight (connection weight) is set for each connection.

- connection weight is set for each connection.

- each neuron is connected to all neurons in an adjacent layer.

- the connection of the neurons is not limited to such an example, and may be appropriately set according to the embodiment.

- a threshold is set for each neuron, and basically, the output of each neuron is determined by whether or not the sum of the product of each input and each weight exceeds the threshold. That is, the weight of the connection between these neurons and the threshold value of each neuron are examples of the parameters of the detector 5 used for the arithmetic processing.

- the learning processing unit 112 inputs each face image (611, 63, 66) to the input layer 51, and executes the arithmetic processing of the detector 5 using these parameters.

- the learning processing unit 112 acquires each output value from the output layer 53 as a detection result of an organ for each face image (611, 63, 66). Subsequently, the learning processing unit 112 calculates the total value of the errors 71 to 73 based on the obtained output values as described above. Then, the learning processing unit 112 adjusts the parameters of the detector 5 so as to reduce the total value of the errors 71 to 73 as the training process. Thereby, the learned detector 5 for detecting the facial organ of the driver is constructed.

- the storage processing unit 113 includes a configuration of the constructed learned detector 5 (for example, the number of layers of the neural network, the number of neurons in each layer, a connection relationship between neurons, a transfer function of each neuron), and an operation parameter (for example, , Information indicating the weight of the connection between each neuron and the threshold value of each neuron) is stored in the storage unit 12 as the learning result data 121.

- the constructed learned detector 5 for example, the number of layers of the neural network, the number of neurons in each layer, a connection relationship between neurons, a transfer function of each neuron

- an operation parameter for example, Information indicating the weight of the connection between each neuron and the threshold value of each neuron

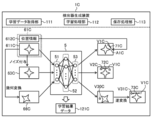

- FIG. 6 schematically illustrates an example of a software configuration of the monitoring device 2 according to the present embodiment.

- the control unit 21 of the monitoring device 2 loads the monitoring program 82 stored in the storage unit 22 into the RAM. Then, the control unit 21 interprets and executes the monitoring program 82 loaded on the RAM by the CPU, and controls each component. Accordingly, as illustrated in FIG. 6, the monitoring device 2 according to the present embodiment operates as a computer including the data acquisition unit 211, the detection unit 212, and the output unit 213 as software modules. That is, in the present embodiment, each software module of the monitoring device 2 is also realized by the control unit 21 (CPU), similarly to the detector generation device 1.

- the data acquisition unit 211 acquires a face image 221 that shows the face of the driver D who drives the vehicle. For example, the data acquisition unit 211 acquires the face image 221 by photographing the face of the driver D using the camera 41.

- the detection unit 212 includes the learned detector 5 by holding the learning result data 121. Specifically, the detection unit 212 sets the learned detector 5 with reference to the learning result data 121. Then, by inputting the acquired face image 221 to the detector 5, the detection unit 212 acquires from the detector 5 an output value corresponding to a result of detecting the facial organ of the driver D from the face image 221. .

- the output unit 213 outputs information on the result of detecting the facial organ of the driver D.

- each software module of the detector generation device 1 and the monitoring device 2 will be described in detail in an operation example described later.

- an example is described in which each software module of the detector generation device 1 and the monitoring device 2 is realized by a general-purpose CPU.

- some or all of the above software modules may be implemented by one or more dedicated processors.

- the omission, replacement, and addition of software modules may be performed as appropriate according to the embodiment.

- FIG. 7 is a flowchart illustrating an example of a processing procedure of the detector generation device 1 according to the present embodiment.

- the processing procedure described below is an example of the “detector generation method” of the present invention.

- the processing procedure described below is merely an example, and each processing may be changed as much as possible. Further, in the processing procedure described below, steps can be omitted, replaced, and added as appropriate according to the embodiment.

- Step S101 the control unit 11 operates as the learning data acquisition unit 111, and acquires a plurality of learning data sets 61 each configured by a combination of the first face image 611 and the position information 612.

- the method of acquiring the plurality of learning data sets 61 is not particularly limited and may be appropriately selected according to the embodiment.

- a plurality of first face images 611 including the face of the subject T are obtained by preparing a vehicle equipped with the camera 31 and the subject T and photographing the subject T driving the vehicle under various conditions using the camera. Can be.

- the number of vehicles and the number of subjects T to be prepared may be appropriately determined according to the embodiment.

- the learning data sets 61 can be generated by combining the obtained first face images 611 with the position information 612 indicating the position of the target organ shown in each first face image 611.

- the organ of interest may be selected from, for example, eyes, nose, mouth, eyebrows, jaws, and combinations thereof.

- the target organ may include a face outline.

- Each of the learning data sets 61 may be automatically generated or manually generated. Further, generation of each learning data set 61 may be performed by the detector generation device 1 or may be performed by a computer other than the detector generation device 1.

- the control unit 11 acquires each first face image 611 from the camera 31 via an external interface, a network, a storage medium 91, and the like. Next, the control unit 11 generates position information 612 to be given to each first face image 611.

- the control unit 11 accepts designation of the position of the organ via the input device 14 by the operator. Subsequently, the control unit 11 generates position information 612 indicating the position of the designated organ according to the operation of the input device 14 by the operator.

- the control unit 11 detects the position of the target organ from each first face image 611.

- control unit 11 For this detection, a known image processing method such as edge detection and pattern matching may be used, or a tentatively generated detector described later may be used. Subsequently, the control unit 11 generates position information 612 indicating the position of the detected organ. Then, the control unit 11 generates each learning data set 61 by combining the generated position information 612 with the first face image 611. Thereby, the control unit 11 may acquire a plurality of learning data sets 61.

- each learning data set 61 is generated by another computer

- the control unit 11 transmits a plurality of learning data sets 61 generated by another computer via a network, a storage medium 91, or the like. May be obtained.

- each learning data set 61 may be generated in the same manner as in the detector generation device 1.

- the data formats of the first face image 611 and the position information 612 may be appropriately selected according to the embodiment.

- the position information 612 may indicate the position of the organ by a point using coordinate values or the like, or may indicate the position of the organ by an area.

- the number of learning data sets 61 to be acquired is not particularly limited, and may be appropriately determined to the extent that machine learning of the detector 5 can be performed.

- the control unit 11 proceeds to the next step S102.

- Step S102 the control unit 11 operates as the learning processing unit 112, and performs machine learning of the detector 5 using the plurality of learning data sets 61 acquired in step S101.

- the processing procedure of machine learning will be described later.

- the control unit 11 proceeds to the next step S103.

- Step S103 the control unit 11 operates as the storage processing unit 113, and generates information indicating the configuration and the operation parameters of the detector 5 constructed by machine learning as learning result data 121. Then, the control unit 11 stores the generated learning result data 121 in the storage unit 12. Thus, the control unit 11 ends the process according to the operation example.

- the storage destination of the learning result data 121 is not limited to the storage unit 12.

- the control unit 11 may store the learning result data 121 in a data server such as a NAS (Network Attached Storage). After constructing the learned detector 5, the control unit 11 may transfer the generated learning result data 121 to the monitoring device 2 at an arbitrary timing.

- a data server such as a NAS (Network Attached Storage).

- the monitoring device 2 may acquire the learning result data 121 by accepting the transfer from the detector generation device 1, or may acquire the learning result data 121 by accessing the detector generation device 1 or the data server. Good.

- the learning result data 121 may be incorporated in the monitoring device 2 in advance.

- step S102 is a flowcharts illustrating an example of a processing procedure of machine learning by the detector generation device 1 according to the present embodiment.

- the process of step S102 according to the present embodiment includes the following processes of steps S201 to S210.

- the processing procedure described below is merely an example, and each processing may be changed as much as possible. Further, in the processing procedure described below, steps can be omitted, replaced, and added as appropriate according to the embodiment.

- the control unit 11 Before starting the process of step S201, the control unit 11 prepares a neural network (the detector 5 before learning) to be subjected to machine learning.

- the configuration of the neural network to be prepared and each parameter may be provided by a template or may be provided by an operator input.

- the control unit 11 may prepare a neural network based on the learning result data 121 to be re-learned.

- the control unit 11 starts the process of step S201.

- step S201 the control unit 11 inputs the first face image 611 of each learning data set 61 to the detector 5, and executes a calculation process of the detector 5. Specifically, the control unit 11 inputs each of the first face images 611 to the input layer 51 of the detector 5 and determines firing of each neuron included in each of the layers 51 to 53 in order from the input side. Thereby, the control unit 11 acquires the first output value for each first face image 611 from the output layer 53. Each first output value corresponds to a result of detection of the position of an organ from each first face image 611 by the detector 5 at the current stage. When acquiring the first output values, the control unit 11 proceeds to the next step S202.

- the output value of the detector 5 is not particularly limited as long as the output value of the detector 5 can indicate the position at which the organ is detected, and is appropriately selected according to the embodiment. May be.

- the output value of the detector 5 may directly indicate the position of the organ, such as a coordinate value.

- the output value of the detector 5 may indirectly indicate the position of the organ, and information indicating the position of the organ may be obtained by applying some arithmetic processing to the output value of the detector 5. Regardless of the format, the output value of the detector 5 can be handled similarly. Therefore, in the following, for convenience of explanation, the output value of the detector 5 will be treated as directly indicating the position of the organ.

- step S202 the control unit 11 calculates a total value of the first errors 71 between the first detection position V1 of the organ specified based on each first output value and the position A1 indicated by the corresponding position information 612. . Specifically, for each learning data set 61, the control unit 11 calculates the difference between the first detection position V1 obtained for each first face image 611 and the position A1 indicated by the corresponding position information 612. It is calculated as one error 71. Then, the control unit 11 calculates the total value of the first errors 71 by adding the calculated first errors 71.

- the difference between the first detection position V1 and the position A1 may be appropriately calculated according to a format for specifying the position of the organ. For example, when the position of the organ is designated by a point, the control unit 11 may calculate the distance (norm) between the first detection position V1 and the position A1 as a difference. Further, for example, when the position of the organ is specified by the region, the control unit 11 may calculate the difference between the first detection position V1 and the position A1 using an index such as IoU (Intersection Over Union). Good. After calculating the total value of the first errors 71, the control unit 11 proceeds to the next step S203.

- IoU Intersection Over Union

- Step S203 the control unit 11 generates each second face image 63 by adding noise to the first face image 611 of each learning data set 61.

- the type of noise given to each first face image 611 is not particularly limited and may be appropriately selected according to the embodiment.

- the noise for example, Gaussian noise, Poisson noise, noise based on uniform random numbers, or the like may be used.

- the control unit 11 may add random Gaussian noise to each first face image 611.

- the control unit 11 may apply noise to each first face image 611 by applying a filter such as a local average filter to each first face image 611.

- the type of noise given to each first face image 611 may be the same or different.

- control unit 11 may add noise to a position where the detection by the detector 5 is likely to change so as to form a hostile example (Adversarial example). Whether or not the detection is likely to change can be determined, for example, based on a comparison between the amount of change in the detection position due to the addition of noise and a threshold. After generating each second face image 63, the control unit 11 proceeds to the next step S204.

- Step S204 the control unit 11 inputs each of the generated second face images 63 to the detector 5, and executes the arithmetic processing of the detector 5.

- the calculation process of the detector 5 may be the same as that in step S201.

- the control unit 11 obtains the second output value for each second face image 63 from the output layer 53 of the detector 5.

- Each second output value corresponds to the result of detection of the position of an organ from each second face image 63 by the detector 5 at this stage.

- the control unit 11 proceeds to the next step S205.

- Step S205 the control unit 11 is specified based on the second output value obtained for the second face image 63 corresponding to the first detection position V1 of the organ specified based on each first output value. Then, the total value of the second errors 72 between the second detection position V2 and the second detection position V2 is calculated. Specifically, for each learning data set 61, the control unit 11 calculates the second detection result V1 obtained for each first face image 611 and the second detection result V1 obtained for the second face image 63 corresponding to the first detection image V1. The difference from the detection position V2 is calculated as a second error 72. The method of calculating this difference may be the same as in step S202. Then, the control unit 11 calculates the total value of the second errors 72 by adding the calculated second errors 72. After calculating the total value of the second errors 72, the control unit 11 proceeds to the next step S206.

- Step S206 the control unit 11 generates each third face image 66 by applying a predetermined geometric transformation to the first face image 611 of each learning data set 61.

- the geometric transformation applied to each first face image 611 may be, for example, translation, rotation, inversion, enlargement, reduction, or a combination thereof.

- the geometric transformation applied to each first face image 611 may be a transformation involving translation and rotation.

- the geometric transformation applied to each third face image 66 may be the same or different.

- the control unit 11 may generate each of the third face images 66 while randomly changing the parameters of the geometric transformation.

- the parameters of the geometric transformation are, for example, each transformation amount (parallel movement amount, rotation amount, etc.).

- Step S207 the control unit 11 inputs each of the generated third face images 66 to the detector 5, and executes the arithmetic processing of the detector 5.

- the calculation process of the detector 5 may be the same as that in step S201.

- the control unit 11 acquires the third output value for each third face image 66 from the output layer 53 of the detector 5.

- Each third output value corresponds to the result of detection of the position of an organ from each third face image 66 by the detector 5 at the present stage.

- the control unit 11 proceeds to the next step S208.

- step S208 the control unit 11 is specified based on the third output value obtained for the third face image 66 corresponding to the first detection position of the organ specified based on each first output value.

- the total value of the third error 73 from the third detection position of the organ is calculated.

- the control unit 11 applies the inverse transformation of the geometric transformation to the third detection position V30 derived from the third output value obtained for each first face image 611, and performs the third detection position V31 is calculated.

- the control unit 11 sets the third detection position V31 obtained for the third face image 66 corresponding to the first detection position V1 obtained for each first face image 611. Is calculated as a third error 73.

- control unit 11 may calculate the difference between the position derived by applying the geometric transformation to the first detection position V1 and the third detection position V30 as the third error 73. Then, the control unit 11 calculates the total value of the third errors 73 by adding the calculated third errors 73. After calculating the total value of the third errors 73, the control unit 11 proceeds to the next step S209.

- Step S209 the control unit 11 determines whether or not the sum of the calculated errors 71 to 73 is equal to or smaller than a threshold.

- the threshold value is a criterion for determining whether or not the detector 5 has been sufficiently trained to appropriately detect the organ from the face image. This threshold may be set as appropriate.

- the control unit 11 ends the machine learning process according to the present operation example (that is, completes the process of step S102). The process proceeds to step S103.

- the control unit 11 proceeds to the next step S210.

- Step S210 the control unit 11 performs training of the detector 5 so that the total value of the errors 71 to 73 becomes small. Specifically, the control unit 11 adjusts the parameters of the detector 5 so that the total value of the errors 71 to 73 decreases.

- a known method such as an error back propagation method may be used for adjusting the parameter. That is, the control unit 11 calculates the error of each parameter such as the weight of connection between each neuron and the threshold value of each neuron in order from the output layer 53 using the total value of each error 71 to 73. Then, the control unit 11 updates the value of each parameter based on the calculated error.

- the learning rate that determines the update width of each parameter may be set as appropriate.

- the control unit 11 repeats the processing from step S201.

- the control unit 11 optimizes the parameters of the detector 5 by repeating the processes of steps S201 to S210 such that the total value of the errors 71 to 73 is sufficiently small.