WO2017057173A1 - 対話装置及び対話方法 - Google Patents

対話装置及び対話方法 Download PDFInfo

- Publication number

- WO2017057173A1 WO2017057173A1 PCT/JP2016/077975 JP2016077975W WO2017057173A1 WO 2017057173 A1 WO2017057173 A1 WO 2017057173A1 JP 2016077975 W JP2016077975 W JP 2016077975W WO 2017057173 A1 WO2017057173 A1 WO 2017057173A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- conversation

- content information

- information

- unit

- sentence

- Prior art date

Links

- 238000000034 method Methods 0.000 title claims description 79

- 230000003993 interaction Effects 0.000 title abstract description 9

- 238000012545 processing Methods 0.000 claims description 54

- 230000002452 interceptive effect Effects 0.000 claims description 38

- 238000004891 communication Methods 0.000 claims description 37

- 230000008859 change Effects 0.000 claims description 14

- 230000007704 transition Effects 0.000 claims description 8

- 230000008569 process Effects 0.000 description 60

- 230000006870 function Effects 0.000 description 22

- 230000010365 information processing Effects 0.000 description 19

- 238000003384 imaging method Methods 0.000 description 12

- 238000010586 diagram Methods 0.000 description 7

- 230000004044 response Effects 0.000 description 7

- 230000004048 modification Effects 0.000 description 6

- 238000012986 modification Methods 0.000 description 6

- 230000037007 arousal Effects 0.000 description 5

- 238000001514 detection method Methods 0.000 description 5

- 239000000284 extract Substances 0.000 description 3

- 230000000877 morphologic effect Effects 0.000 description 3

- 230000009471 action Effects 0.000 description 2

- 238000004458 analytical method Methods 0.000 description 2

- 230000015572 biosynthetic process Effects 0.000 description 2

- 238000000605 extraction Methods 0.000 description 2

- 238000010191 image analysis Methods 0.000 description 2

- 230000005061 slumber Effects 0.000 description 2

- 238000003786 synthesis reaction Methods 0.000 description 2

- 206010062519 Poor quality sleep Diseases 0.000 description 1

- 206010041349 Somnolence Diseases 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 238000006243 chemical reaction Methods 0.000 description 1

- 238000005352 clarification Methods 0.000 description 1

- 238000012937 correction Methods 0.000 description 1

- 230000000694 effects Effects 0.000 description 1

- 238000011156 evaluation Methods 0.000 description 1

- 210000000744 eyelid Anatomy 0.000 description 1

- 230000008921 facial expression Effects 0.000 description 1

- 238000010295 mobile communication Methods 0.000 description 1

- 230000000474 nursing effect Effects 0.000 description 1

- 230000008520 organization Effects 0.000 description 1

- 230000008447 perception Effects 0.000 description 1

- 230000007958 sleep Effects 0.000 description 1

- 238000012360 testing method Methods 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F40/00—Handling natural language data

- G06F40/20—Natural language analysis

- G06F40/237—Lexical tools

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L13/00—Speech synthesis; Text to speech systems

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/28—Constructional details of speech recognition systems

- G10L15/30—Distributed recognition, e.g. in client-server systems, for mobile phones or network applications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L15/00—Speech recognition

- G10L15/22—Procedures used during a speech recognition process, e.g. man-machine dialogue

- G10L2015/223—Execution procedure of a spoken command

Definitions

- the present disclosure relates to a dialogue apparatus and a dialogue method for performing a conversation with a user.

- Patent Document 1 discloses a response system that can acquire information such as news from an information source on the Internet. This response system obtains the latest news information from the Internet in response to a user's question such as "Tell me some latest news", and generates a response sentence that is uttered to the user using the acquired news information .

- the present inventor is not considering a dialogue device that responds to a single question like the response system of Patent Document 1, but a dialogue device that can develop a relatively long conversation such as a chat with a user. It has been repeated.

- the inventor of the present application has come up with a configuration capable of continuing a conversation with a user while changing information such as news used for generating a conversation sentence.

- One of the purposes of the present disclosure is that, in view of such circumstances, even if the information used in the conversation sentence can be changed for continuous conversation with the user, the user feels unnatural. It is an object of the present invention to provide an interactive apparatus and an interactive method capable of generating a difficult conversation sentence.

- An interactive apparatus is an interactive apparatus that performs a conversation with a user using a conversation sentence generated from content information, an information acquisition unit that acquires content information from an information source, and a conversation sentence generation A conversation execution unit that continues the conversation with the user while changing the content information to be used; an attribute setting unit that sets a plurality of attribute information for the specific content information used for generating a conversation sentence in the conversation execution unit; An acquisition control unit that causes the information acquisition unit to acquire other content information in which at least some of the attribute information is the same as the specific content information, as candidates for use in a conversation sentence next to the specific content information; Is provided.

- the dialogue apparatus According to this dialogue apparatus, at least a part of the attribute information in the specific content information can be the same as the attribute information of other content information used in the conversation sentence next to the content information. Therefore, a connection can be secured between the conversation sentences generated from these pieces of content information. According to the above, even if the content information used in the conversation sentence can be changed for continuous conversation with the user, the dialogue apparatus generates a conversation sentence that does not make the user feel unnatural. be able to.

- An interactive method is an interactive method in which content information is acquired from an information source by an information acquisition unit, and a conversation with a user is performed using a conversation sentence generated from the content information.

- the content information used for generating the conversation sentence is changed, the conversation execution step for continuing the conversation with the user, and the specific content information used for generating the conversation sentence in the conversation execution step.

- an attribute setting step for setting a plurality of attribute information and other content information in which at least a part of the attribute information is the same as the specific content information are used in the conversation sentence after the specific content information.

- An acquisition control step for causing the information acquisition unit to acquire the candidate as a candidate.

- a program for causing at least one processor to execute the interactive method is provided.

- This program also provides the above effects.

- the program may be provided via a telecommunication line, or may be provided by being stored in a non-transitory storage medium.

- FIG. 1 is a block diagram illustrating an overall configuration of an interactive apparatus according to an embodiment.

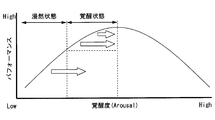

- FIG. 2 is a diagram schematically showing the Yerkes-Dodson Law for explaining the correlation between the driver's arousal level and the driving performance.

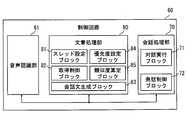

- FIG. 3 is a diagram for explaining functional blocks and sub-blocks constructed in the control circuit.

- FIG. 4 is a diagram for explaining the transition of changes in attribute information accompanying changes in content information, and is a diagram listing a plurality of threads defined for content information.

- FIG. 5 is a flowchart showing a conversation start process performed by the control circuit.

- FIG. 1 is a block diagram illustrating an overall configuration of an interactive apparatus according to an embodiment.

- FIG. 2 is a diagram schematically showing the Yerkes-Dodson Law for explaining the correlation between the driver's arousal level and the driving performance.

- FIG. 3 is a diagram for explaining functional blocks and sub-blocks constructed in the control circuit.

- FIG. 4 is a diagram for explaining the

- FIG. 6 is a flowchart showing a conversation execution process performed by the control circuit.

- FIG. 7 is a flowchart showing a fixed thread setting process performed by the control circuit.

- FIG. 8 is a flowchart showing content information setting processing executed by the control circuit.

- FIG. 9 is a block diagram showing an overall configuration of a dialog system according to a modification.

- the interaction device 100 can actively interact mainly with the driver among the passengers of the vehicle. As shown in FIG. 2, the dialogue apparatus 100 has a conversation with the driver so that a normal awakening state that can show high driving performance is maintained in the driver. In addition, the conversation device 100 can play a role of bringing back the arousal level of the driver who has fallen into a sleepy state and the driver who has fallen into a dozing state into a normal awakening state by talking with the driver.

- the interactive device 100 is electrically connected to the vehicle-mounted state detector 10, the voice recognition operation switch 21, the voice input device 23, and the voice playback device 30.

- the interactive device 100 is connected to the Internet, and can acquire information from outside the vehicle through the Internet.

- the on-vehicle state detector 10 is various sensors and electronic devices mounted on the vehicle.

- the in-vehicle state detector 10 includes at least a steering angle sensor 11, an accelerator position sensor 12, a GNSS receiver 14, an in-vehicle image capturing unit 16, an in-vehicle image capturing unit 17, and an in-vehicle ECU group 19.

- the steering angle sensor 11 detects the steering angle of the steering wheel steered by the driver, and outputs the detection result to the dialogue device 100.

- the accelerator position sensor 12 detects the amount of depression of the accelerator pedal operated by the driver, and outputs a detection result to the dialogue device 100.

- a GNSS (Global Navigation Satellite System) receiver 14 receives position signals transmitted from a plurality of positioning satellites, thereby acquiring position information indicating the current position of the vehicle.

- the GNSS receiver 14 outputs the acquired position information to the interactive device 100, a navigation ECU (described later), and the like.

- the in-vehicle imaging unit 16 has, for example, a near infrared camera combined with a near infrared light source.

- the near-infrared camera is attached to the interior of the vehicle, and mainly captures the driver's face with light emitted from the near-infrared light source.

- the in-vehicle image capturing unit 16 extracts, from the captured image, the line-of-sight direction of the driver's eyes and the degree of eye (eyelid) opening by image analysis.

- the in-vehicle imaging unit 16 outputs the extracted information such as the driver's line-of-sight direction and the degree of eye opening to the dialogue apparatus 100.

- the in-vehicle imaging unit 16 includes a plurality of near-infrared cameras, visible light cameras, and the like, so that, for example, a range other than the driver's face can be photographed to detect hand and body movements.

- the outside imaging unit 17 is a visible light camera that is attached to the inside and outside of the vehicle, for example, in a posture facing the periphery of the vehicle.

- the vehicle exterior imaging unit 17 captures the vehicle periphery including at least the front of the vehicle.

- the vehicle exterior imaging unit 17 extracts the road shape in the traveling direction, the degree of congestion of the road around the vehicle, and the like from the captured image by image analysis.

- the vehicle exterior imaging unit 17 outputs information indicating the road shape, the degree of congestion, and the like to the interactive device 100.

- the vehicle exterior imaging unit 17 may include a plurality of visible light cameras, a near infrared camera, a range image camera, and the like.

- the in-vehicle ECU (Electronic Control Unit) group 19 is composed mainly of a microcomputer or the like, and includes an integrated control ECU, a navigation ECU, and the like.

- passenger information indicating whether or not a passenger is seated in the passenger seat and the rear seat is output from the integrated control ECU so as to be acquirable by the dialogue apparatus 100.

- information indicating the shape of the road around the host vehicle is output from the navigation ECU.

- the voice recognition operation switch 21 is provided around the driver's seat.

- the voice recognition operation switch 21 receives an operation for switching on and off the operation of the conversation function of the interaction apparatus 100 by a vehicle occupant.

- the voice recognition operation switch 21 outputs operation information by the passenger to the interactive device 100. Note that an operation for changing a setting value related to the conversation function of the conversation apparatus 100 may be input to the voice recognition operation switch 21.

- the voice input device 23 has a microphone 24 provided in the passenger compartment.

- the microphone 24 converts the voice of the conversation uttered by the vehicle occupant into an electrical signal and outputs it as voice information to the dialogue apparatus 100.

- the microphone 24 may be configured for a telephone call provided in a communication device such as a smartphone and a tablet terminal.

- the voice data collected by the microphone 24 may be wirelessly transmitted to the dialogue apparatus 100.

- the audio playback device 30 is a device having a function of an output interface for outputting information to the passenger.

- the audio reproduction device 30 includes a display, an audio control unit 31, and a speaker 32.

- the voice control unit 31 drives the speaker 32 based on the acquired voice data.

- the speaker 32 is provided in the vehicle interior and outputs sound into the vehicle interior.

- the speaker 32 reproduces the conversation sentence so that it can be heard by the passengers of the vehicle including the driver.

- the audio playback device 30 may be a simple acoustic device, or a communication robot or the like installed on the upper surface of the instrument panel. Further, a communication device such as a smartphone and a tablet terminal connected to the interactive device 100 may fulfill the function of the audio playback device 30.

- the dialogue apparatus 100 includes an input information acquisition unit 41, a voice information acquisition unit 43, a communication processing unit 45, an information output unit 47, a state information processing circuit 50, a control circuit 60, and the like.

- the input information acquisition unit 41 is connected to the voice recognition operation switch 21.

- the input information acquisition unit 41 acquires the operation information output from the voice recognition operation switch 21 and provides it to the control circuit 60.

- the voice information acquisition unit 43 is an interface for voice input connected to the microphone 24.

- the audio information acquisition unit 43 acquires the audio information output from the microphone 24 and provides it to the control circuit 60.

- the communication processing unit 45 has an antenna for mobile communication.

- the communication processing unit 45 transmits / receives information to / from a base station outside the vehicle via an antenna.

- the communication processing unit 45 can be connected to the Internet through a base station.

- the communication processing unit 45 can acquire various content information through the Internet.

- the content information includes, for example, news information, column article information, blog article information, traffic information such as congestion information indicating the degree of congestion around the current location where the host vehicle is traveling, and popular spots, events, and weather around the current location. Includes regional information such as forecasts.

- the content information is acquired from, for example, at least one news distribution site NDS on the Internet.

- the information output unit 47 is an interface for audio output connected to the audio reproduction device 30.

- the information output unit 47 outputs the audio data generated by the control circuit 60 toward the audio reproduction device 30.

- the audio data output from the information output unit 47 is acquired by the audio control unit 31 and reproduced by the speaker 32.

- the state information processing circuit 50 mainly estimates the driver's state by acquiring the information output from the in-vehicle state detector 10.

- the state information processing circuit 50 is mainly configured by a microcomputer having a processor 50a, a RAM, and a flash memory.

- the state information processing circuit 50 is provided with a plurality of input interfaces for receiving signals from the in-vehicle state detector 10.

- the state information processing circuit 50 can realize a load determination function and a wakefulness determination function by executing a predetermined program by the processor 50a.

- the load determination function is a function for determining whether or not the driver's driving load is high on the road on which the vehicle is currently traveling.

- the state information processing circuit 50 acquires detection results output from the steering angle sensor 11 and the accelerator position sensor 12. The state information processing circuit 50 determines that the current driving load is high when it is estimated that the driver is busy operating at least one of the steering and the accelerator pedal based on the transition of the acquired detection result.

- the state information processing circuit 50 acquires information on the shape of the road on which the vehicle is traveling, traffic information indicating the degree of congestion around the host vehicle, and the like.

- the road shape information can be acquired from the vehicle exterior imaging unit 17 and the navigation ECU.

- the traffic information can be acquired from the vehicle exterior imaging unit 17 and the communication processing unit 45.

- the state information processing circuit 50 determines that the current driving load is high when the road in the traveling direction has a curved shape and when it is estimated that the vehicle is traveling in a traffic jam.

- the state information processing circuit 50 determines that the current driving load is low when the vehicle is traveling on a substantially straight road and there are few other vehicles and pedestrians traveling around. . In addition, the state information processing circuit 50 can determine that the driving load is low even when the operation amount of the steering and the accelerator pedal is slightly changed.

- the awake state determination function is a function for determining whether or not the driver is in a slumber or doze state.

- the state information processing circuit 50 detects a slow operation of the steering or the accelerator pedal or a large correction operation that is sometimes input based on the transition of the detection result acquired from each of the sensors 11 and 12, the state information processing circuit 50 It is determined that the subject is in a state or a dozing state.

- the state information processing circuit 50 acquires information such as the line-of-sight direction of the driver's eyes and the degree of eye opening from the in-vehicle imaging unit 16.

- the state information processing circuit 50 is operated when the parallax of both eyes is unstable or the state is not appropriate for the perception of the object in the traveling direction, or when the low eye opening state continues. It is determined that the person is in a slumber or doze state.

- the control circuit 60 is a circuit that integrally controls conversations with the user.

- the control circuit 60 is mainly configured by a microcomputer having a processor 60a, a RAM, and a flash memory.

- the control circuit 60 is provided with an input / output interface connected to other components of the interactive apparatus 100.

- the control circuit 60 constructs a speech recognition unit 61, a sentence processing unit 80, and a conversation processing unit 70 as shown in FIG. 3 as functional blocks by executing a predetermined program by the processor 60a.

- the voice recognition unit 61 acquires the content of the user's utterance.

- the voice recognition unit 61 is connected to the voice information acquisition unit 43 and acquires voice data from the voice information acquisition unit 43.

- the voice recognition unit 61 reads the acquired voice data and converts it into text data.

- the voice recognizing unit 61 converts the words uttered by the passengers including the driver in the passenger compartment into text data such as user questions, user monologues, conversations between users, etc. To provide.

- the sentence processing unit 80 acquires content information through the communication processing unit 45, and generates a conversation sentence used for a conversation with the user using the acquired content information.

- the sentence processing unit 80 can acquire the content of the user's utterance converted into text data from the speech recognition unit 61 and generate a conversational sentence having content corresponding to the user's utterance.

- the sentence processing unit 80 includes a thread setting block 81, an acquisition control block 82, a priority setting block 84, and a similarity calculation block 85 as sub blocks together with a conversation sentence generation block 83 that generates a conversation sentence from content information. .

- the content information used for generating the conversation sentence in the conversation sentence generation block 83 is described as “specific content information”.

- the thread setting block 81 defines a plurality of threads for specific content information. Items used as threads are keywords, major categories of genres, details of genres, dates and times, places, news distribution sites NDS that provide content information, and the like (see FIG. 4).

- the thread setting block 81 sets attribute information corresponding to the content and history of the content information in each of the plurality of threads. For example, in a keyword thread, a proper noun such as a name of a person, an organization, a place name, an event name, an article name, and a facility name appearing in news information and an important word in news information are set as attribute information. Attribute information such as sports, economy, politics, and performing arts is set in the major classification of genres.

- the attribute information may be set by analyzing the title and text of the content information, or may be set based on tag information provided at the news distribution site NDS.

- a method for setting the attribute information by analyzing the text for example, a specific expression obtained by morphological analysis and specific expression extraction is used. Alternatively, a tfidf value (term frequency-inverse document frequency) may be calculated for a word in a sentence, and a word having a high score may be extracted.

- the acquisition control block 82 controls the acquisition of content information by the communication processing unit 45.

- the acquisition control block 82 causes the communication processing unit 45 to acquire other content information as candidates for use in a conversation sentence next to specific content information.

- the acquisition control block 82 causes the communication processing unit 45 to search for other content information in which at least a part of attribute information is the same as the specific content information and a part of the attribute information is different from the specific content information.

- the acquisition control block 82 designates a fixed thread that fixes attribute information among a plurality of threads. Among the plurality of threads, other threads not designated as fixed threads become transition threads in which attribute information changes.

- the acquisition control block 82 causes the communication processing unit 45 to acquire other content information related to the attribute information stored in the fixed thread.

- the acquisition control block 82 can change the thread designated as the fixed thread every time the candidate content information used for the conversation sentence is acquired next time. In addition, the acquisition control block 82 can change the number of threads designated as fixed threads. The acquisition control block 82 sets a large number of fixed threads when the user is interested in a conversation based on specific content information. On the other hand, the acquisition control block 82 sets the number of fixed threads to be small when the user's interest in the conversation is low.

- the acquisition control block 82 analyzes the content of the user's utterance acquired through the voice recognition unit 61 and extracts words related to each attribute information set for specific content information.

- the acquisition control block 82 can use the extracted word together with the attribute information of the fixed thread as a search word when acquiring other content information.

- the acquisition control block 82 can cause the communication processing unit 45 to acquire other content information that has a specific connection with specific content information and that has a high probability of attracting the user's interest and interest. .

- the priority setting block 84 sets the priority of threads selected as fixed threads.

- a thread with a high priority set in the priority setting block 84 is designated as a fixed thread in the acquisition control block 82.

- the priority setting block 84 can adjust the priority order of threads based on the user's utterance history acquired by the voice recognition unit 61.

- the priority setting block 84 lowers the priority of the thread related to the extracted word and sets the attribute information by the extracted word. Update is enabled (see S148 in FIG. 7). Further, the priority setting block 84 adjusts to raise the priority for the genre detail thread when the user is interested in the conversation based on the specific content information (FIG. 7). (See S146). As a result, since the thread with the details of the genre is easily designated as the fixed thread, the topic in which the user is interested is continued.

- the priority setting block 84 performs adjustment to lower the priority for the details of the genre and each thread of the provider (see S144 in FIG. 7).

- conversation topics can be changed.

- a dictionary that calculates positive / negative values of words, and interest from the positive degree of user utterances obtained by comparing user utterance contents with the dictionary.

- the degree of interest of the user may be determined in cooperation with a facial expression evaluation function using a camera. The degree of interest can be acquired by estimating the type of utterance from the morphological information of the user's utterance and creating a rule that the user is not interested if the conflict continues.

- the similarity calculation block 85 calculates the similarity between the specific content information and the content information acquired as a candidate used for generation of the next conversation sentence (see S162 in FIG. 8).

- the similarity calculation block 85 calculates the similarity by comparing characteristic words included in each content information.

- a method of acquiring a characteristic word included in content information for example, there is a method of using a specific expression obtained by morphological analysis and specific expression extraction.

- a tfidf value may be calculated for a word in a sentence, and a word with a high score may be extracted. Similarity can be calculated using 2-gram values calculated from a large amount of text data in advance. Alternatively, the similarity may be calculated using word2vec.

- Content information whose similarity calculated in the similarity calculation block 85 is higher than a preset threshold is excluded from candidates used for the conversation sentence by the acquisition control block 82 (see S164 in FIG. 8).

- the conversation sentence generation block 83 can generate a plurality of conversation sentences from one piece of content information by summarizing the title of the content information and the content of the text acquired under the control of the acquisition control block 82.

- the endings of each conversation sentence are in the form of “ ⁇ Dayo”, “ ⁇ Dayone”, “ ⁇ Daiyo” that can be felt naturally as spoken language.

- the conversation sentence generation block 83 can recognize the user's utterance acquired by the voice recognition unit 61 and generate a conversation sentence that responds to the user's question.

- the conversation sentence generation block 83 outputs text data of the generated conversation sentence to the conversation processing unit 70.

- the conversation sentence generation block 83 can change the content information used for generating the conversation sentence in order to continue the conversation with the user.

- the conversation sentence generation block 83 inserts a connection sentence at the beginning of the first conversation sentence generated from the changed content information.

- the connecting sentence includes attribute information such as “ ⁇ keyword> is ...” and “ ⁇ date and time> is ...”.

- the conversation sentence generation block 83 inserts a connection sentence that suggests a transition thread whose attribute information has been changed.

- the conversation sentence generation block 83 inserts a connection sentence that suggests a fixed thread in which attribute information is maintained.

- the conversation processing unit 70 performs a conversation with the user using the conversation sentence generated by the sentence processing unit 80.

- the conversation processing unit 70 includes a dialog execution block 71 and an utterance control block 72 as sub-blocks for controlling a conversation performed with the user.

- the dialogue execution block 71 acquires the text data of the conversation sentence generated by the conversation sentence generation block 83 and synthesizes the acquired voice data of the conversation sentence.

- the dialogue execution block 71 may perform speech synthesis using a syllable connection method, or may perform speech synthesis using a corpus-based method.

- the dialogue execution block 71 generates prosodic data for utterance from the text data of the conversation sentence.

- the dialogue execution block 71 connects the speech waveform data according to the prosodic data from the speech waveform database stored in advance.

- the dialogue execution block 71 can convert the text data of the conversation sentence into voice data.

- the conversation execution block 71 causes the speaker 32 to utter the conversation sentence by outputting the voice data of the conversation sentence from the information output unit 47 to the voice control unit 31.

- the utterance control block 72 controls the execution of the conversation by the dialogue execution block 71. For example, when an instruction to turn off the conversation function of the dialogue apparatus 100 is input by an operation on the voice recognition operation switch 21, the utterance control block 72 puts the dialogue execution block 71 in a stopped state.

- the utterance control block 72 switches the operation status of the dialogue execution block 71 between the prohibited state and the allowed state according to the load determination by the state information processing circuit 50. Specifically, the dialogue execution block 71 sets the operation status of the dialogue execution block 71 to a prohibited state in which the start of utterance is prohibited when the load determination function determines that the driving load is high. On the other hand, when it is determined by the load determination function that the driving load is low, the utterance control block 72 sets the operation status of the dialogue execution block 71 to a permissible state that allows the start of the utterance.

- the speech control block 72 sets the operation status of the dialogue execution block 71 to the permissible state if the preset prohibition condition is satisfied even when the load determination function determines that the driving load is low. And keep it in a prohibited state.

- the prohibition conditions can be set as appropriate.

- the speech control block 72 can establish the prohibition condition when it is determined that there is a passenger other than the driver based on the passenger information output from the integrated ECU.

- Dialogue device “Did you know the news that ⁇ tennis player ND> is V, strong game strength?” User: “I didn't know” Dialogue device: “It looks like ⁇ Tennis player ND> won the fifth victory at the Australian Open for the first time in two years.” User: “Who was the final opponent?” Dialogue device: “It was ⁇ Tennis player AM>. The best 4 seems to be all big 4.” User: “How was the lost ⁇ tennis player AM>?”

- the control circuit 60 estimates that the user has shown a high interest in the conversation.

- the control circuit 60 changes the content information used for generating the conversation sentence from news 1 to news 2 in order to continue the topic of the current conversation (see FIG. 4).

- a keyword thread that can set attribute information ⁇ tennis player AM> is set as a transition thread. Therefore, a connecting sentence that suggests a keyword thread is inserted at the beginning of the next conversation sentence.

- Dialogue device “Speaking of ⁇ tennis player AM>, it seems that the quasi-V ⁇ tennis player AM> is“ not ashamed ””.

- Dialogue device “ ⁇ Tennis player AM> was the Australian Open final, 2010 was defeated by ⁇ tennis player RF>, and 2011 and 2013 were defeated by ⁇ tennis player ND>. I want to come and expect a slightly different result in the final, ”he said, and received great applause from the audience.”

- the control circuit 60 changes the content information used for generating the conversation sentence from news 2 to news 3 in order to change the conversation topic. Change (see FIG. 4).

- the general category thread and the date and time thread are fixed threads. Therefore, a connection sentence that suggests a thread of the date and time is inserted at the beginning of the next conversation sentence.

- Dialogue device “There was F1 news yesterday that ⁇ F1 Team RB> was testing with a new camouflaged car?” (Continued conversation)

- Each step of the conversation start process shown in FIG. 5 is mainly performed by the conversation processing unit 70.

- the conversation start process is started based on the vehicle being turned on, and is repeatedly started until the vehicle is turned off.

- S101 as an initial setting, the operation status of the dialogue execution block 71 is set to a prohibited state, and the process proceeds to S102.

- S102 the determination result of the load determination by the state information processing circuit 50 (see FIG. 1) is acquired, and it is determined whether or not the driving load for the current user is low. If it is determined in S102 that the current driving load is high, the process proceeds to S107. On the other hand, if it is determined in S102 that the driving load is low, the process proceeds to S103.

- S103 it is determined whether the prohibition condition is satisfied. On the other hand, if it is determined in S103 that none of the prohibition conditions is satisfied, the process proceeds to S104. In S104, the operation status of the dialogue execution block 71 is switched from the prohibited state to the permitted state, and the process proceeds to S105.

- the conversation start condition is, for example, a condition that the user is in a sloppy or dozing state, or whether there is newly arrived content information that belongs to a category that the driver likes. If it is determined in S105 that the conversation start condition is not satisfied, the conversation start process is temporarily ended. On the other hand, if it is determined in S105 that the conversation start condition is satisfied, the process proceeds to S106.

- a conversation execution process (see FIG. 6) is started as a conversation start process subroutine, and the process proceeds to S107.

- S107 it is determined whether the conversation execution process is being performed. If it is determined in S107 that the conversation execution process is continuing, the end of the conversation execution process is awaited by repeating the determination in S107. If it is determined that the conversation execution process has ended, the conversation start process is temporarily ended.

- a conversation with the user is started, and the process proceeds to S122.

- the dialogue apparatus 100 (see FIG. 1) speaks to the user with a conversation sentence such as “Did you know?”.

- a conversation with the user is realized by cooperation of a conversation sentence generation block 83 that generates a conversation sentence and a dialog execution block 71 that converts the generated conversation sentence into voice data.

- the conversation end condition is, for example, a condition that the user is in an awake state, an utterance instructing the end of the conversation from the user, or an increase in driving load. If it is determined in S122 that the conversation end condition is satisfied, the process proceeds to S129, and the conversation started in S121 is ended. On the other hand, if it is determined in S122 that the conversation end condition is not satisfied, the process proceeds to S123.

- S123 it is determined whether or not a conversation sentence can be generated continuously from the current specific content information. If it is determined in S123 that the generation of the conversation sentence can be continued, the determination in S122 and S123 is repeated to wait until it becomes difficult to continue the generation of the conversation sentence. If almost all the information included in the content information is used as a conversation sentence and it becomes difficult to generate a further conversation sentence, the process proceeds to S124.

- S124 a plurality of threads are defined for specific content information, and the process proceeds to S125.

- S125 attribute information corresponding to the content information is stored in each thread, and the process proceeds to S126.

- S126 a fixed thread setting process (see FIG. 7) as a subroutine is started, and the process proceeds to S127.

- a content information setting process (see FIG. 8) as a subroutine is started, and the process proceeds to S128.

- the content information used for generating the conversation sentence in the conversation sentence generation block 83 is changed to the content information set in S127. And the conversation with a user is continued using the conversation sentence based on new content information.

- each of the plurality of threads is set to either a fixed thread or a transition thread.

- Each step of the fixed thread setting process is mainly performed by each sub-block of the sentence processing unit 80.

- the initial setting value of the priority is read, and the process proceeds to S142.

- the initial set value may be a randomly set order, or may be a pre-set order by a user operation input. Furthermore, an initial setting value may be set based on a conversation history with the user.

- S142 it is estimated from the content of the user's utterance acquired from the voice recognition unit 61 whether or not the user is highly interested in the specific content information used in the latest conversation. Specifically, in S142, for example, when the user shows a response such as “soft” or “hump” or when there is no user response, it is determined that the user's interest is low. If it is determined in S142 that the interest is low, the process proceeds to S143.

- the number of fixed threads is set to a predetermined low interest predetermined value, and the process proceeds to S144.

- the predetermined value of low interest is set to a value that is, for example, a majority of the number of threads so that the topic of conversation changes greatly.

- the low interest predetermined value of the present embodiment is preset to “4”.

- S144 the details of the genre and adjustment for lowering the priority of each thread of the provider are performed, and the process proceeds to S149. By adjusting the priority order in S144, the details of the genre and the attribute information stored in the provider thread are easily changed.

- the process proceeds to S145.

- the number of fixed threads is set to a predetermined value of high interest, and the process proceeds to S146.

- the predetermined value of high interest is set to a value less than a majority of the number of threads, for example, so that conversation topics are continued.

- the predetermined value of high interest in this embodiment is preset to “1”.

- the high interest predetermined value is set to a value smaller than the low interest predetermined value.

- adjustment is performed to increase the priority for the thread with details of the genre, and the process proceeds to S147.

- S147 it is determined whether or not the word related to the attribute information set in S125 (see FIG. 6) of the conversation execution process is uttered by the user. If the word related to the attribute information is not extracted from the user's utterance in S147, the process proceeds to S149. On the other hand, when a word related to the attribute information is extracted from the user's utterance in S147, the process proceeds to S148. For example, when the name of ⁇ tennis player ND> is set as attribute information in the keyword thread, the names of other prominent tennis players correspond to words related to the attribute information (see FIG. 4).

- the priority order of the thread related to the extracted word is adjusted to the lowest level, and the attribute information of the thread is updated with the extracted word.

- the priority of the keyword thread is the lowest, and the attribute information of the thread is ⁇ tennis player ND>.

- a fixed thread is designated based on the number of fixed threads set in S143 or S145 and the priority set in S144 or S146 to S148.

- the content information setting process started in S127 (see FIG. 6) will be described based on FIG. 8 with reference to FIG.

- the content information setting process the content information used for the next generation of the conversation sentence is set.

- Each step of the content information setting process is mainly performed by each sub block of the sentence processing unit 80.

- S161 content information such that the attribute information of the fixed thread specified in S149 (see FIG. 7) is the same is acquired from the Internet, and the process proceeds to S162.

- S161 when a word related to the attribute information is extracted from the user's utterance in the acquisition control block 82, content information highly related to the extracted word is acquired.

- S162 the similarity between the content information acquired in S161 and the latest specific content information is calculated, and the process proceeds to S163.

- S163 it is determined whether or not the similarity calculated in S162 is less than a preset threshold value. If it is determined in S163 that the similarity is greater than or equal to the threshold value, the process proceeds to S164.

- S164 the content information acquired in immediately preceding S161 is excluded from the candidates used for the conversation sentence, and the process returns to S161 again.

- S161 again the content information in which each attribute information becomes the same is searched again.

- the process proceeds to S165.

- the content information acquired in the immediately preceding S161 is set as the content information to be used next for generating a conversation sentence, and the process proceeds to S166.

- S166 a connection sentence that suggests a thread that has updated attribute information or a thread in which attribute information is maintained is generated, and the content information setting process ends.

- At least part of the attribute information in the specific content information can be the same as the attribute information of other content information used in the conversation sentence next to the content information. Therefore, a detailed connection can be ensured between each conversation sentence generated from a plurality of pieces of content information such as the above-described news 1 to 3 (see FIG. 4). According to the above, even if the content information used in the conversation sentence can be changed for continuous conversation with the user, the dialogue apparatus 100 generates a conversation sentence that does not make the user feel unnatural. can do.

- the thread setting block 81 can change the fixed thread each time the communication processing unit 45 acquires other content information used for the next conversation sentence.

- the topic of conversation changes step by step by repeatedly changing the content information used for the conversation sentence. Therefore, the dialogue apparatus 100 can develop a natural conversation with gradually changing topics with the user.

- the priority setting block 84 adjusts the priority order of the threads that are fixed threads, thereby controlling the change in the content information used in the conversation sentence.

- the priority setting block 84 can adjust the priority order of threads to be fixed threads based on the user's utterance history. According to the above, the interactive device 100 can increase the conversation so that the user's interest is not lost by changing the content information in accordance with the user's reaction, for example.

- the conversation sentence generation block 83 inserts a connection sentence at the beginning of the conversation sentence generated from the changed content information.

- the bridging sentence may imply to the user a detailed relationship between the two pieces of content information before and after the change by suggesting a thread in which the attribute information is updated or a thread in which the attribute information is maintained.

- the acquisition control block 82 converts other content information indicating the same event as the specific content information based on the similarity calculated by the similarity calculation block 85 into the next conversation sentence. Can be excluded from According to the above, a situation in which conversation sentences informing the same event are continuously generated and the user's willingness to use is lost is avoided.

- the dialogue apparatus 100 can attract the user's interest by changing the topic significantly and providing fresh information.

- the communication processing unit 45 corresponds to an “information acquisition unit”

- the speech recognition unit 61 corresponds to an “utterance acquisition unit”

- the dialogue execution block 71 and the conversation sentence generation block 83 are “conversation execution unit”.

- the thread setting block 81 corresponds to an “attribute setting unit”

- the acquisition control block 82 corresponds to an “acquisition control unit”

- the priority setting block 84 corresponds to a “priority setting unit”

- a similarity calculation block 85 corresponds to the “similarity calculation unit”.

- the news distribution site NDS corresponds to an “information source”

- S125 corresponds to an “attribute setting step”

- S128 corresponds to a “conversation execution step”

- S161 corresponds to an “acquisition control step”.

- the interactive device can expand conversations with the user by gradually changing the topic while maintaining the connection of the topic by controlling appropriately changing the thread designated as the fixed thread. Met.

- the dialogue apparatus can gradually change the topic while maintaining the connection of the topic by controlling appropriately changing the attribute information to be maintained without defining a thread for the content information.

- the interactive device inserts a connecting sentence at the beginning of the conversation sentence when changing the content information used to generate the conversation sentence.

- a connection sentence is not limited to the example of the above embodiment as long as it is a word that can naturally connect conversations, and can be changed as appropriate. Further, it is not necessary to insert a connection sentence.

- the dialogue apparatus calculates the similarity between two pieces of content information, and when the similarity exceeds a threshold, the acquired content information is excluded from candidates used for generating a conversation sentence.

- the content information selection process based on the similarity may be omitted.

- the determination based on the similarity may be performed only when the news distribution site NDS that is the content information provider is changed.

- the conversation start condition (see S105 in FIG. 5) in the above embodiment can be changed as appropriate.

- a dialogue device can be used by a driver who is aware of a state of illness to input a dialogue start switch provided in the vicinity of the driver's seat, throwing a driver's “let's chat”, or a specific keyword by a passenger Chatting to the user can be started with the utterance as a trigger.

- the number of fixed threads is increased as the user's interest increases.

- the number specified for the fixed thread may be constant regardless of the level of interest of the user.

- the thread designated as the fixed thread may be changed every time the content information is acquired regardless of the user's utterance.

- a notification sound for notifying the user of the conversation start may be output from the speaker 32.

- the notification sound can direct the user's consciousness to the voice of the conversation. As a result, it is difficult for the user to hear the beginning of the conversation thrown from the dialogue apparatus 100.

- the state of sleep and the dozing state are estimated from the state of the driver's face.

- the in-vehicle imaging unit for example, it is based on the action of rubbing the eyes and face with the hand and the action of frequently changing the sitting position and posture.

- a dozing state may be estimated.

- the dialogue apparatus performs a non-task-oriented conversation for the purpose of dialogue itself.

- the dialogue apparatus can perform not only conversations such as chats described above but also task-oriented conversations such as replying to questions asked by passengers and reserving shops designated by passengers. Furthermore, it is possible to temporarily hold a task-oriented conversation during a non-task-oriented conversation.

- each function related to conversation execution provided by the processor 60a of the control circuit 60 may be realized by a dedicated integrated circuit, for example. Alternatively, a plurality of processors may cooperate to execute each process related to the execution of the conversation. Furthermore, each function may be provided by hardware and software different from those described above, or a combination thereof. Similarly, the functions related to the driving load determination and the arousal level determination provided by the processor 50a of the state information processing circuit 50 can also be provided by hardware and software different from those described above, or a combination thereof. Furthermore, the storage medium for storing the program executed by each processor 50a, 60a is not limited to the flash memory. Various non-transitional tangible storage media can be employed as a configuration for storing the program.

- the technical idea of the present disclosure can be applied to a communication control program installed in a communication device such as a smartphone and a tablet terminal, and a server outside the vehicle.

- the dialogue control program is stored as an application executable by the processor in a storage medium of a communication terminal brought into the vehicle.

- the communication terminal can interact with the driver according to the dialogue control program, and can maintain the driver's arousal state through the dialogue.

- FIG. 9 is a block diagram showing the overall configuration of the interactive system according to this modification. Since the basic configuration of the modification is the same as that of the above-described embodiment, the description of the common configuration will be omitted by referring to the preceding description, and differences will be mainly described. In addition, the same code

- the processor 60a of the interactive device 100 executes a predetermined program

- the interactive device 100 has constructed the speech recognition unit 61, the conversation processing unit 70, and the text processing unit 80 as functional blocks.

- the control server 200 causes the voice recognition unit 61b, the conversation processing unit 70b, and the sentence processing unit 80b to function blocks.

- the voice recognition unit 61b, the conversation processing unit 70b, and the text processing unit 80b provided in the remote control server 200 are the voice recognition unit 61, the conversation processing unit 70, and the text processing unit of the dialogue apparatus 100 according to the above embodiment. It is a configuration (cloud) that replaces 80 functions.

- the communication processing unit 45b of the control server 200 acquires and generates information necessary for processing of the voice recognition unit 61b, the conversation processing unit 70b, and the text processing unit 80b via a communication network such as the Internet.

- the conversation sentence is transmitted to the communication processing unit 45a of the conversation apparatus 100 and is reproduced from the voice reproduction apparatus 30.

- the communication processing unit 45b of the control server 200 acquires content information from a news distribution site NDS or the like, and in the above embodiment, the state information processing circuit 50, the input information acquisition unit 41, and the voice information of the interactive device 100.

- Various information such as vehicle and driver state information input from the acquisition unit 43 to the control unit 60 is acquired from the interactive device 100.

- the conversation sentence generated based on the acquired information is transmitted from the communication processing unit 45b of the control server 200 to the communication processing unit 45a of the interactive apparatus 100 via the communication network.

- 9 illustrates the configuration in which the control server 200 includes the voice recognition unit 61b, the sentence processing unit 80b, and the conversation processing unit 70b.

- the control server includes the voice recognition unit, the sentence processing unit, and the conversation.

- a part of the functions of the processing unit may be provided, and the interactive apparatus may include the other.

- the dialogue apparatus may include a voice recognition unit

- the control server may include a sentence processing unit and a conversation processing unit.

- the dialogue method performed by the communication device and the server that executes the dialogue control program can be substantially the same as the dialogue method performed by the dialogue device.

- the technical idea of the present disclosure is not limited to an interactive device mounted on a vehicle, but also to a device having a function of having a conversation with a user, such as an automatic teller machine, a toy, a reception robot, a nursing robot, etc. Is also applicable.

- the technical idea of the present disclosure can also be applied to a dialogue device mounted on a vehicle that performs automatic driving (autonomous vehicle).

- an automatic driving at an automation level is assumed that “the driving system automated in a specific driving mode performs driving operation of the vehicle under the condition that the driver appropriately responds to the driving operation switching request from the system”. Yes.

- a driver in such an automatic driving vehicle, a driver (operator) needs to maintain a standby state for backup of driving operation. Therefore, it is presumed that the driver in the standby state is likely to fall into a sloppy state and a dozing state. Therefore, such an interactive device is also suitable as a configuration that maintains the awakening level of the driver in a standby state as a backup of the automatic driving system.

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Computational Linguistics (AREA)

- Multimedia (AREA)

- Human Computer Interaction (AREA)

- Acoustics & Sound (AREA)

- Theoretical Computer Science (AREA)

- General Health & Medical Sciences (AREA)

- General Engineering & Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Artificial Intelligence (AREA)

- Machine Translation (AREA)

- Information Retrieval, Db Structures And Fs Structures Therefor (AREA)

- User Interface Of Digital Computer (AREA)

Abstract

コンテンツ情報から生成した会話文を用いてユーザとの会話を行う対話装置を提供する。対話装置は、情報源(NDS)からコンテンツ情報を取得する情報取得部(45)を備え、会話文の生成に用いるコンテンツ情報を変更しつつ、ユーザとの会話を継続する。対話装置は、会話文の生成に用いられる特定のコンテンツ情報に対し、複数の属性情報を設定する。対話装置は、少なくとも一部の属性情報が特定のコンテンツ情報と同一となるような他のコンテンツ情報を、この特定のコンテンツ情報の次に会話文に用いられる候補として情報取得部に取得させる。

Description

本出願は、2015年9月28日に出願された日本特許出願番号2015-189977号に基づくもので、その開示をここに参照により援用する。

本開示は、ユーザとの会話を行う対話装置及び対話方法に関する。

従来、対話装置の一種として、例えば特許文献1には、インターネット上の情報源からニュース等の情報を取得可能な応答システムが開示されている。この応答システムは、「なにか最新ニュースを教えて」といったユーザの質問に対して、インターネットから最新のニュース情報を取得し、取得したニュース情報を用いてユーザへ向けて発話される応答文を生成する。

さて、本願発明者は、特許文献1の応答システムのような単発の質問に応答する対話装置ではなく、雑談のような比較的長い会話をユーザとの間で展開可能な対話装置について、検討を重ねてきた。その過程において、本願発明者は、会話文の生成に用いるニュース等の情報を変更しつつ、ユーザとの会話を継続することが可能な構成を想到した。

しかし、ユーザとの継続的な会話において、会話文の生成に用いるニュース等の情報を不用意に変更してしまうと、変更前のニュース情報から生成される会話文と、変更後のニュース情報から生成される会話文とのつながりが希薄になる。その結果、ユーザは、対話装置によって生成される会話文に不自然さを感じる虞があった。

本開示の目的の一つは、このような事情に鑑みて、ユーザとの継続的な会話のために、会話文に用いる情報を変更可能な構成であっても、ユーザに不自然さを感じさせ難い会話文を生成可能な対話装置及び対話方法を提供することにある。

本開示の一側面の対話装置は、コンテンツ情報から生成した会話文を用いてユーザとの会話を行う対話装置であって、情報源からコンテンツ情報を取得する情報取得部と、会話文の生成に用いるコンテンツ情報を変更しつつ、ユーザとの会話を継続する会話実行部と、会話実行部にて会話文の生成に用いられる特定のコンテンツ情報に対し、複数の属性情報を設定する属性設定部と、少なくとも一部の属性情報が特定のコンテンツ情報と同一となるような他のコンテンツ情報を、この特定のコンテンツ情報の次に会話文に用いられる候補として情報取得部に取得させる取得制御部と、を備える。

この対話装置によれば、特定のコンテンツ情報における属性情報の少なくとも一部は、このコンテンツ情報の次に会話文に用いられる他のコンテンツ情報の属性情報と同一となり得る。故に、これらのコンテンツ情報から生成される各会話文の間には、つながりが確保され得る。以上によれば、ユーザとの継続的な会話のために、会話文に用いるコンテンツ情報を変更可能な構成であっても、対話装置は、ユーザに不自然さを感じさせ難い会話文を生成することができる。

また、本開示の一側面の対話方法は、情報源からコンテンツ情報を情報取得部によって取得し、コンテンツ情報から生成した会話文を用いてユーザとの会話を行う対話方法であって、少なくとも一つのプロセッサによって実施されるステップとして、会話文の生成に用いるコンテンツ情報を変更しつつ、ユーザとの会話を継続する会話実行ステップと、会話実行ステップにて会話文の生成に用いられる特定のコンテンツ情報に対し、複数の属性情報を設定する属性設定ステップと、少なくとも一部の属性情報が特定のコンテンツ情報と同一となるような他のコンテンツ情報を、この特定のコンテンツ情報の次に会話文に用いられる候補として情報取得部に取得させる取得制御ステップと、を含む。

以上の対話方法でも、変更前後のコンテンツ情報から生成される各会話文の間につながりが確保され得るので、ユーザに不自然さを感じさせ難い会話文が生成可能となる。また、本開示の他の側面によれば、上記対話方法を少なくとも一つのプロセッサに実行させるためのプログラムが提供される。このプログラムによっても上述の効果を奏する。なお、プログラムは、電気通信回線を介して提供されるものであってもよいし、非一時的記憶媒体(non-transitory storage medium)に格納されて提供されるものであってもよい。

本開示の上記および他の目的、特徴や利点は、添付図面を参照した下記の詳細な説明から、より明確になる。図面において、

図1は、一実施形態による対話装置の全体構成を示すブロック図である。

図2は、運転者における覚醒度と運転のパフォーマンスとの相関を説明するYerkes-Dodson Lawを模式的に示す図である。

図3は、制御回路に構築される機能ブロック及びサブブロックを説明する図である。

図4は、コンテンツ情報の変更に伴う属性情報の変化の推移を説明するための図であって、コンテンツ情報に対し規定される複数のスレッドをリスト化した図である。

図5は、制御回路にて実施される会話開始処理を示すフローチャートである。

図6は、制御回路にて実施される会話実行処理を示すフローチャートである。

図7は、制御回路にて実施される固定スレッド設定処理を示すフローチャートである。

図8は、制御回路にて実施されるコンテンツ情報設定処理を示すフローチャートである。

図9は、変形例による対話システムの全体構成を示すブロック図である。

図1に示す一実施形態による対話装置100は、車両に搭載されており、ユーザとなる車両の搭乗者と会話を行うことができる。対話装置100は、車両の搭乗者のうちで主に運転者と能動的に対話可能である。対話装置100は、図2に示すように、運転者において高い運転パフォーマンスを示し得る通常の覚醒状態が維持されるよう、運転者との会話を行う。加えて対話装置100は、運転者との会話により、漫然状態に陥った運転者及び居眠り状態に陥りかけた運転者の覚醒度を、通常の覚醒状態に引き戻す役割を果たすことができる。

対話装置100は、図1に示すように、車載状態検出器10、音声認識操作スイッチ21、音声入力器23、及び音声再生装置30と電気的に接続されている。加えて対話装置100は、インターネットに接続されており、インターネットを通じて車両の外部から情報を取得することができる。

車載状態検出器10は、車両に搭載された種々のセンサ及び電子機器である。車載状態検出器10には、操舵角センサ11、アクセルポジションセンサ12、GNSS受信器14、車内撮像部16、車外撮像部17、及び車載ECU群19が少なくとも含まれている。

操舵角センサ11は、運転者によって操縦されたステアリングホイールの操舵角を検出し、対話装置100へ向けて検出結果を出力する。アクセルポジションセンサ12は、運転者によって操作されたアクセルペダルの踏み込み量を検出し、対話装置100へ向けて検出結果を出力する。

GNSS(Global Navigation Satellite System)受信器14は、複数の測位衛星から送信される測位信号を受信することにより、車両の現在位置を示す位置情報を取得する。GNSS受信器14は、取得した位置情報を、対話装置100及びナビゲーションECU(後述する)等へ向けて出力する。

車内撮像部16は、例えば近赤外光源と組み合わされた近赤外カメラを有している。近赤外カメラは、車両の室内に取り付けられており、近赤外光源から照射された光によって主に運転者の顔を撮影する。車内撮像部16は、画像解析によって、運転者の両目の視線方向、及び目(まぶた)の開き具合等を、撮影した画像から抽出する。車内撮像部16は、抽出した運転者の視線方向及び目の開き具合等の情報を、対話装置100へ向けて出力する。尚、車内撮像部16は、複数の近赤外カメラ及び可視光カメラ等を有することにより、例えば運転者の顔以外の範囲を撮影し、手及び体の動きを検出することも可能である。

車外撮像部17は、例えば車両の周囲を向けた姿勢にて、車内及び車外に取り付けられた可視光カメラである。車外撮像部17は、車両前方を少なくとも含む車両周囲を撮影する。車外撮像部17は、画像解析によって、進行方向の道路形状及び車両周囲の道路の混雑具合等を、撮影した画像から抽出する。車外撮像部17は、道路形状及び混雑具合等を示す情報を、対話装置100へ向けて出力する。尚、車外撮像部17は、複数の可視光カメラ、近赤外線カメラ、及び距離画像カメラ等を有していてもよい。

車載ECU(Electronic Control Unit)群19は、それぞれマイコン等を主体に構成されており、統合制御ECU、及びナビゲーションECU等を含んでいる。例えば、統合制御ECUからは、助手席及び後部座席に搭乗者が着座しているか否かを示す同乗者情報が対話装置100によって取得可能に出力される。ナビゲーションECUからは、例えば自車両周囲の道路形状を示す情報等が出力される。

音声認識操作スイッチ21は、運転席の周囲に設けられている。音声認識操作スイッチ21には、対話装置100の会話機能について、作動のオン及びオフを切り替えるための操作が車両の搭乗者によって入力される。音声認識操作スイッチ21は、搭乗者による操作情報を、対話装置100へ出力する。尚、対話装置100の会話機能に係る設定値を変更する操作が音声認識操作スイッチ21に入力可能とされていてもよい。

音声入力器23は、車室内に設けられたマイク24を有している。マイク24は、車両の搭乗者によって発せられた会話の音声を電気信号に変換し、音声情報として対話装置100へ向けて出力する。マイク24は、例えばスマートフォン及びタブレット端末等の通信機器に設けられた通話のための構成であってもよい。またマイク24にて集音された音声データは、対話装置100へ無線送信されてもよい。

音声再生装置30は、搭乗者へ向けて情報を出力する出力インターフェースの機能を有する装置である。音声再生装置30は、表示器、音声制御部31、及びスピーカ32を有している。音声制御部31は、会話文の音声データを取得すると、取得した音声データに基づいてスピーカ32を駆動する。スピーカ32は、車室内に設けられており、車室内に音声を出力する。スピーカ32は、運転者を含む車両の搭乗者に聞き取られるよう、会話文を再生する。

尚、音声再生装置30は、単純な音響機器であってもよく、又はインスツルメントパネルの上面に設置されたコミュニケーションロボット等であってもよい。さらに、対話装置100に接続されたスマートフォン及びタブレット端末等の通信機器が、音声再生装置30の機能を果たしてもよい。

次に、対話装置100の構成を説明する。対話装置100は、入力情報取得部41、音声情報取得部43、通信処理部45、情報出力部47、状態情報処理回路50、及び制御回路60等によって構成されている。

入力情報取得部41は、音声認識操作スイッチ21と接続されている。入力情報取得部41は、音声認識操作スイッチ21から出力された操作情報を取得し、制御回路60へ提供する。音声情報取得部43は、マイク24と接続された音声入力のためのインターフェースである。音声情報取得部43は、マイク24から出力された音声情報を取得し、制御回路60へ提供する。

通信処理部45は、モバイル通信用のアンテナを有している。通信処理部45は、アンテナを介して、車両外部の基地局との間で情報の送受信を行う。通信処理部45は、基地局を通じてインターネットに接続可能である。通信処理部45は、インターネットを通じて種々のコンテンツ情報を取得可能である。コンテンツ情報には、例えばニュース情報、コラム記事情報、ブログ記事情報、自車両が走行している現在地点周辺の混雑具合を示す渋滞情報といった交通情報、並びに現在地点周辺の人気スポット、イベント、及び天気予報といった地域情報等が含まれる。コンテンツ情報は、例えばインターネット上にある少なくとも一つ以上のニュース配信サイトNDS等から取得される。

情報出力部47は、音声再生装置30と接続された音声出力のためのインターフェースである。情報出力部47は、制御回路60によって生成された音声データを音声再生装置30へ向けて出力する。情報出力部47から出力された音声データは、音声制御部31によって取得され、スピーカ32によって再生される。

状態情報処理回路50は、車載状態検出器10から出力された情報を取得することにより、主に運転者の状態を推定する。状態情報処理回路50は、プロセッサ50a、RAM、及びフラッシュメモリを有するマイクロコンピュータを主体に構成されている。状態情報処理回路50には、車載状態検出器10からの信号を受け取る複数の入力インターフェースが設けられている。状態情報処理回路50は、プロセッサ50aによる所定のプログラムの実行により、負荷判定機能及び覚醒状態判定機能を実現させることができる。

負荷判定機能は、車両が現在走行している道路について、運転者の運転負荷が高いか否かを判定する機能である。状態情報処理回路50は、操舵角センサ11及びアクセルポジションセンサ12から出力される検出結果を取得する。状態情報処理回路50は、取得した検出結果の推移に基づき、ステアリング及びアクセルペダルの少なくとも一方を運転者が忙しく操作していると推定した場合に、現在の運転負荷が高いと判定する。

加えて状態情報処理回路50は、車両が走行中の道路の形状情報、及び自車両周囲の混雑具合を示す交通情報等を取得する。道路の形状情報は、車外撮像部17及びナビゲーションECUから取得可能である。交通情報は、車外撮像部17及び通信処理部45から取得可能である。状態情報処理回路50は、進行方向の道路がカーブ形状である場合、及び車両が渋滞の中を走行していると推定される場合に、現在の運転負荷が高いと判定する。

一方、状態情報処理回路50は、車両が概ね直線状の道路を走行中であり、且つ、周囲を走行する他の車両及び歩行者も僅かである場合に、現在の運転負荷が低いと判定する。また状態情報処理回路50は、ステアリング及びアクセルペダルの操作量の変動が僅かである場合にも、運転負荷が低いと判定することができる。

覚醒状態判定機能は、運転者が漫然状態又は居眠り状態にあるか否かを判定する機能である。状態情報処理回路50は、各センサ11,12から取得した検出結果の推移に基づき、ステアリング又はアクセルペダルの緩慢な操作、及び時折入力される大きな修正操作等を検出した場合に、運転者が漫然状態又は居眠り状態にあると判定する。

加えて状態情報処理回路50は、車内撮像部16から運転者の両目の視線方向及び目の開き具合といった情報を取得する。状態情報処理回路50は、両目の視差が不安定であったり進行方向の物体の知覚に適切な状態でなかったりした場合、及び目の開度の低い状態が継続している場合等に、運転者が漫然状態又は居眠り状態にあると判定する。

制御回路60は、ユーザとの間で交わされる会話を統合的に制御する回路である。制御回路60は、プロセッサ60a、RAM、及びフラッシュメモリを有するマイクロコンピュータを主体に構成されている。制御回路60には、対話装置100の他の構成と接続される入出力インターフェースが設けられている。制御回路60は、プロセッサ60aによる所定のプログラムの実行により、図3に示すような音声認識部61、文章処理部80、及び会話処理部70を、機能ブロックとして構築する。以下、制御回路60に構築される各機能ブロックの詳細を、図3及び図1に基づき説明する。

音声認識部61は、ユーザの発話の内容を取得する。音声認識部61は、音声情報取得部43と接続されており、音声情報取得部43から音声データを取得する。音声認識部61は、取得した音声データを読み込み、テキストデータに変換する。音声認識部61は、対話装置100へ投げ掛けられたユーザの質問、ユーザの独り言、ユーザ同士の会話等、車室内にて運転者を含む搭乗者が発した言葉をテキストデータ化し、文章処理部80へ提供する。

文章処理部80は、通信処理部45を通じてコンテンツ情報を取得し、取得したコンテンツ情報を用いてユーザとの会話に用いられる会話文を生成する。文章処理部80は、テキストデータ化されたユーザの発話の内容を音声認識部61から取得し、ユーザの発言に対応した内容の会話文を生成可能である。文章処理部80は、スレッド設定ブロック81、取得制御ブロック82、優先度設定ブロック84、及び類似度算定ブロック85を、コンテンツ情報から会話文を生成する会話文生成ブロック83と共にサブブロックとして含んでいる。尚、以下の説明では、会話文生成ブロック83にて会話文の生成に用いられているコンテンツ情報を、「特定のコンテンツ情報」と記載する。

スレッド設定ブロック81は、特定のコンテンツ情報に対して、複数のスレッドを規定する。スレッドとされる項目は、キーワード、ジャンルの大分類、ジャンルの詳細、日時、場所、コンテンツ情報の提供元となるニュース配信サイトNDS等である(図4参照)。スレッド設定ブロック81は、複数のスレッドのそれぞれに、コンテンツ情報の内容及び履歴等に対応した属性情報を設定する。例えばキーワードのスレッドには、ニュース情報に登場する人名、団体名、地名、イベント名、物品名、及び施設名といった固有名詞及びニュース情報における重要語が属性情報として設定される。ジャンルの大分類には、スポーツ、経済、政治、及び芸能といった属性情報が設定される。属性情報は、コンテンツ情報のタイトル及び本文を解析することによって設定されてもよく、又はニュース配信サイトNDSにて付与されていたタグ情報に基づいて設定されてもよい。本文を解析して属性情報を設定する手法としては、例えば形態素解析と固有表現抽出で得られた固有表現を使う。また、文中にある単語に対してtfidf値(term frequency - inverse document frequency)を計算し、スコアの高いものを抽出してもよい。

取得制御ブロック82は、通信処理部45によるコンテンツ情報の取得を制御する。取得制御ブロック82は、特定のコンテンツ情報の次に会話文に用いられる候補として、他のコンテンツ情報を通信処理部45に取得させる。取得制御ブロック82は、少なくとも一部の属性情報が特定のコンテンツ情報と同一となり、一部の属性情報が特定のコンテンツ情報と異なるような他のコンテンツ情報を、通信処理部45に検索させる。

具体的に、取得制御ブロック82は、複数のスレッドのうちで、属性情報を固定する固定スレッドを指定する。複数のスレッドのうちで、固定スレッドに指定されない他のスレッドは、属性情報の変化する遷移スレッドとなる。取得制御ブロック82は、固定スレッドに格納されている属性情報に関連する他のコンテンツ情報を、通信処理部45に取得させる。

取得制御ブロック82は、次に会話文に用いられる候補のコンテンツ情報を取得させる度に、固定スレッドに指定するスレッドを変更可能である。加えて取得制御ブロック82は、固定スレッドに指定するスレッドの数を変更可能である。取得制御ブロック82は、特定のコンテンツ情報に基づく会話に対してユーザが興味や関心を示している場合には、固定スレッドの数を多く設定する。一方で、取得制御ブロック82は、会話に対するユーザの興味や関心が薄い場合には、固定スレッドの数を少なく設定する。

加えて取得制御ブロック82は、音声認識部61を通じて取得されるユーザの発話の内容を解析し、特定のコンテンツ情報に対し設定された各属性情報に関連するワードを抽出する。属性情報に関連するワードをユーザの発話から抽出した場合、取得制御ブロック82は、抽出したワードを固定スレッドの属性情報と共に、他のコンテンツ情報を取得させる際の検索ワードとして用いることができる。その結果、取得制御ブロック82は、特定のコンテンツ情報と内容的な繋がりを有し、且つ、ユーザの興味や関心を惹く確率の高い他のコンテンツ情報を、通信処理部45に取得させることができる。

優先度設定ブロック84は、固定スレッドとして選択されるスレッドの優先順位を設定する。優先度設定ブロック84にて設定される優先順位の高いスレッドが、取得制御ブロック82にて固定スレッドに指定される。優先度設定ブロック84は、音声認識部61にて取得されたユーザの発話の履歴に基づいて、スレッドの優先順位を調整可能である。

例えば優先度設定ブロック84は、属性情報に関連するワードがユーザの発話の内容から抽出された場合に、抽出されたワードに関連するスレッドの優先順位を下げて、抽出されたワードによる属性情報の更新を可能にする(図7 S148参照)。また優先度設定ブロック84は、特定のコンテンツ情報に基づく会話に対してユーザが興味や関心を示している場合には、ジャンルの詳細のスレッドについて優先順位を上げる調整を行う(図7

S146参照)。その結果、ジャンルの詳細のスレッドが固定スレッドに指定され易くなるため、ユーザの関心のある話題が継続される。一方で、会話に対するユーザの興味や関心が薄い場合には、優先度設定ブロック84は、ジャンルの詳細及び提供元の各スレッドについて、優先順位を下げる調整を行う(図7 S144参照)。その結果、会話の話題の変更が可能になる。ユーザの興味や関心を抽出する手法としては、単語のポジティブ・ネガティブの値を計算した辞書を用意しておいて、ユーザ発話内容と辞書とを対照することにより得られるユーザ発話のポジティブ度合から関心度を算出する手法がある。また、カメラを使った表情評定機能と連携し、ユーザの関心度合を決定してもよい。ユーザ発話の形態素情報から発話の種類を推定し、相槌が続けば興味がないといったルールを作成することで関心の高さを取得することもできる。

S146参照)。その結果、ジャンルの詳細のスレッドが固定スレッドに指定され易くなるため、ユーザの関心のある話題が継続される。一方で、会話に対するユーザの興味や関心が薄い場合には、優先度設定ブロック84は、ジャンルの詳細及び提供元の各スレッドについて、優先順位を下げる調整を行う(図7 S144参照)。その結果、会話の話題の変更が可能になる。ユーザの興味や関心を抽出する手法としては、単語のポジティブ・ネガティブの値を計算した辞書を用意しておいて、ユーザ発話内容と辞書とを対照することにより得られるユーザ発話のポジティブ度合から関心度を算出する手法がある。また、カメラを使った表情評定機能と連携し、ユーザの関心度合を決定してもよい。ユーザ発話の形態素情報から発話の種類を推定し、相槌が続けば興味がないといったルールを作成することで関心の高さを取得することもできる。

類似度算定ブロック85は、特定のコンテンツ情報と、次の会話文の生成に用いられる候補として取得されたコンテンツ情報との類似度を算定する(図8 S162参照)。類似度算定ブロック85は、各コンテンツ情報に含まれる特徴的なワードを比較することにより、類似度を算定する。コンテンツ情報に含まれる特徴的なワードを取得する方法としては、例えば、形態素解析と固有表現抽出で得られた固有表現を使う方法がある。また、文中にある単語に対してtfidf値を計算し、スコアの高いものを抽出してもよい。類似度は、あらかじめ大量の文章データから計算しておいた2-gram値を使って、算出することが出来る。また、word2vecを使って類似度を算出してもよい。類似度算定ブロック85にて算定される類似度が予め設定された閾値よりも高いコンテンツ情報は、取得制御ブロック82によって会話文に用いられる候補から除外される(図8 S164参照)。以上の処理により、例えば提供元のニュース配信サイトNDSが異なるものの、実質的に同一の出来事を伝えているコンテンツ情報が連続して会話文の生成に採用される事態は、回避される。

会話文生成ブロック83は、取得制御ブロック82の制御によって取得されたコンテンツ情報のタイトル及び本文の内容を要約することにより、一つのコンテンツ情報から複数の会話文を生成可能である。各会話文の語尾は、話し言葉として自然に感じられるような「~だよ」,「~だよね」,「~ですよ」といった形式とされる。ユーザによって質問が投げ掛けられた場合、会話文生成ブロック83は、音声認識部61にて取得されるユーザの発話を認識し、ユーザの質問に応答する会話文を生成することができる。会話文生成ブロック83は、生成した会話文のテキストデータを会話処理部70へ向けて出力する。

会話文生成ブロック83は、ユーザとの会話を継続させるために、会話文の生成に用いるコンテンツ情報を変更することができる。会話文生成ブロック83は、会話文の生成に用いるコンテンツ情報を変更する場合に、変更後のコンテンツ情報から生成した最初の会話文の冒頭につなぎ文を挿入する。つなぎ文は、例えば、「<キーワード>といえば・・・」,「<日時>は・・・」のように、属性情報を含んでいる。会話の話題が継続された場合、会話文生成ブロック83は、属性情報が変更された遷移スレッドを示唆するつなぎ文を挿入する。一方で、会話の話題が大きく変更された場合、会話文生成ブロック83は、属性情報が維持された固定スレッドを示唆するつなぎ文を挿入する。

会話処理部70は、文章処理部80によって生成された会話文を用いて、ユーザとの会話を行う。会話処理部70は、ユーザとの間にて行われる会話を制御するためのサブブロックとして、対話実行ブロック71及び発話制御ブロック72を含んでいる。

対話実行ブロック71は、会話文生成ブロック83によって生成された会話文のテキストデータを取得し、取得した会話文の音声データを合成する。対話実行ブロック71は、音節接続方式の音声合成を行ってもよく、又はコーパスベース方式の音声合成を行ってもよい。具体的に対話実行ブロック71は、会話文のテキストデータから、発話される際の韻律データを生成する。そして対話実行ブロック71は、予め記憶されている音声波形のデータベースから、韻律データにあわせて音声波形データをつなぎ合わせていく。以上のプロセスにより、対話実行ブロック71は、会話文のテキストデータを音声データ化することができる。対話実行ブロック71は、会話文の音声データを情報出力部47から音声制御部31へ出力させることにより、この会話文をスピーカ32によって発話させる。

発話制御ブロック72は、対話実行ブロック71による会話の実行を制御する。例えば、音声認識操作スイッチ21への操作によって、対話装置100の会話機能をオフ状態にする指示が入力されていた場合に、発話制御ブロック72は、対話実行ブロック71を停止状態にする。

また発話制御ブロック72は、状態情報処理回路50による負荷判定に応じて、対話実行ブロック71の作動ステータスを禁止状態及び許容状態とのうちで切り替える。具体的に対話実行ブロック71は、負荷判定機能によって運転負荷が高いと判定された場合に、対話実行ブロック71の作動ステータスを、発話の開始を禁止する禁止状態とする。一方、負荷判定機能によって運転負荷が低いと判定された場合、発話制御ブロック72は、対話実行ブロック71の作動ステータスを発話の開始を許容する許容状態とする。

さらに発話制御ブロック72は、負荷判定機能によって運転負荷が低いと判定された場合でも、予め設定された禁止条件が成立している場合には、対話実行ブロック71の作動ステータスを許容状態とはせずに、禁止状態に維持する。禁止条件は、適宜設定可能である。例えば発話制御ブロック72は、統合ECUから出力される同乗者情報に基づき、運転者以外の搭乗者が居ると判定されている場合に、禁止条件を成立させることができる。

ここまで説明した制御回路60によって実現されるユーザと対話装置100との会話の一例を、以下説明する。尚、実際の会話では、実存する固有名詞が当然に発話されるが、以下の説明では、直接的な明示を避けるため、下記の<>のような記載とする。

対話装置:「<テニスプレーヤND>がV、際立つ勝負強さ、っていうニュースって知ってた?」

ユーザ :「知らなかった」

対話装置:「<テニスプレーヤND>が全豪オープンで2年ぶり5度目の優勝をしたみたいだよ。」

ユーザ :「決勝の相手は誰だったの?」

対話装置:「<テニスプレーヤAM>だったよ。ベスト4はみんなビッグ4だったみたい。」

ユーザ :「負けた<テニスプレーヤAM>はどんな感じだったんだろう?」

対話装置:「<テニスプレーヤND>がV、際立つ勝負強さ、っていうニュースって知ってた?」

ユーザ :「知らなかった」

対話装置:「<テニスプレーヤND>が全豪オープンで2年ぶり5度目の優勝をしたみたいだよ。」

ユーザ :「決勝の相手は誰だったの?」

対話装置:「<テニスプレーヤAM>だったよ。ベスト4はみんなビッグ4だったみたい。」

ユーザ :「負けた<テニスプレーヤAM>はどんな感じだったんだろう?」

ここで、ユーザが<テニスプレーヤAM>の名前を発話したことにより、制御回路60は、ユーザが会話に高い関心を示したと推定する。制御回路60は、現在の会話の話題を継続させるため、会話文の生成に用いるコンテンツ情報をニュース1からニュース2へと変更する(図4参照)。この場合、<テニスプレーヤAM>という属性情報を設定可能なキーワードのスレッドのみが遷移スレッドとされる。そのため、次の会話文の冒頭には、キーワードのスレッドを示唆するつなぎ文が挿入される。

対話装置:「<テニスプレーヤAM>といえば、準Vの<テニスプレーヤAM>は『恥じることではない』って言ってたみたいだよ。」

ユーザ :「負けたといっても準優勝だからね」

対話装置:「<テニスプレーヤAM>は全豪オープンの決勝で、2010年は<テニスプレーヤRF>に、そして2011年と2013年は<テニスプレーヤND>に負けていて、『また来年も戻って来て、決勝戦ではもう少し違う結果を期待したいね。』と語り、観客から大きな拍手を受けていたよ。」

ユーザ :「結構決勝に行っているんだね」

対話装置:「そして自分にも勝てるチャンスがあったと感じていた<テニスプレーヤAM>は『明らかに最初の3セットでは自分にもチャンスがあった。第4セットは彼に全て持って行かれてしまった。ベースラインからのリターンも最高だった。』と試合を振り返っていたようなんですよ。」

ユーザ :「そっか」

対話装置:「<テニスプレーヤAM>といえば、準Vの<テニスプレーヤAM>は『恥じることではない』って言ってたみたいだよ。」

ユーザ :「負けたといっても準優勝だからね」

対話装置:「<テニスプレーヤAM>は全豪オープンの決勝で、2010年は<テニスプレーヤRF>に、そして2011年と2013年は<テニスプレーヤND>に負けていて、『また来年も戻って来て、決勝戦ではもう少し違う結果を期待したいね。』と語り、観客から大きな拍手を受けていたよ。」

ユーザ :「結構決勝に行っているんだね」

対話装置:「そして自分にも勝てるチャンスがあったと感じていた<テニスプレーヤAM>は『明らかに最初の3セットでは自分にもチャンスがあった。第4セットは彼に全て持って行かれてしまった。ベースラインからのリターンも最高だった。』と試合を振り返っていたようなんですよ。」

ユーザ :「そっか」

以上の「そっか」のように、ユーザが関心の低い返答をした場合、制御回路60は、会話の話題を変更するために、会話文の生成に用いるコンテンツ情報をニュース2からニュース3へと変更する(図4参照)。この場合、ジャンルの大分類のスレッドと日時のスレッドのみが固定スレッドとされる。そのため、次の会話文の冒頭には、日時のスレッドを示唆するつなぎ文が挿入される。

対話装置:「昨日は、<F1チームRB>、カムフラージュされた新車でテスト走行?っていうF1のニュースもあったよ。」

(以下、会話継続)

対話装置:「昨日は、<F1チームRB>、カムフラージュされた新車でテスト走行?っていうF1のニュースもあったよ。」

(以下、会話継続)

以上のような継続的な会話を実現するために、制御回路60にて実施される各処理の詳細をさらに説明する。まず、会話開始処理の詳細を、図5に基づき、図3を参照しつつ説明する。図5に示す会話開始処理の各ステップは、主に会話処理部70によって実施される。会話開始処理は、車両の電源がオン状態とされたことに基づいて開始され、車両の電源がオフ状態とされるまで、繰り返し開始される。

S101では、初期設定として、対話実行ブロック71の作動ステータスを禁止状態に設定し、S102に進む。S102では、状態情報処理回路50(図1参照)による負荷判定の判定結果を取得し、現在のユーザにおける運転負荷が低いか否かを判定する。S102にて、現在の運転負荷が高いと判定した場合、S107に進む。一方、S102にて、運転負荷が低いと判定した場合には、S103に進む。

S103では、禁止条件が成立しているか否かを判定する。一方、S103にて、いずれの禁止条件も成立していないと判定した場合には、S104に進む。S104では、対話実行ブロック71の作動ステータスを、禁止状態から許容状態へと切り替えて、S105に進む。

S105では、会話開始条件が成立しているか否かを判定する。会話開始条件は、例えばユーザが漫然状態又は居眠り状態であるか、運転者の嗜好するカテゴリに属するような新着のコンテンツ情報が有るか、といった条件である。S105にて、会話開始条件が成立していないと判定した場合、会話開始処理を一旦終了する。一方、S105にて、会話開始条件が成立していると判定した場合、S106に進む。

S106では、会話開始処理のサブルーチンとしての会話実行処理(図6参照)を開始し、S107に進む。S107では、会話実行処理が実施中か否かを判定する。S107にて、会話実行処理が継続していると判定されている場合、S107の判定を繰り返すことにより、会話実行処理の終了を待機する。そして、会話実行処理が終了していると判定した場合には、会話開始処理を一旦終了する。

次に、S106にて開始される会話実行処理の詳細を、図6に基づき、図3を参照しつつ説明する。

S121では、ユーザとの会話を開始し、S122に進む。S121により、対話装置100(図1参照)は、「~って知ってた?」というような会話文にて、ユーザに話しかける。こうしたユーザとの会話は、会話文を生成する会話文生成ブロック83と、生成された会話文を音声データに変換する対話実行ブロック71との協働によって実現される。

S122では、会話終了条件が成立しているか否かを判定する。会話終了条件は、例えばユーザが覚醒状態になった、ユーザから会話終了を指示する発話があった、運転負荷が上昇した等の条件である。S122にて、会話終了条件が成立していると判定した場合、S129に進み、S121にて開始した会話を終了する。一方、S122にて、会話終了条件が成立していないと判定した場合、S123に進む。

S123では、現在の特定のコンテンツ情報から継続して会話文を生成可能か否か判定する。S123にて、会話文の生成の継続が可能と判定した場合、S122及びS123の判定を繰り返すことにより、会話文の生成継続が困難となるのを待機する。そして、コンテンツ情報に含まれる概ね全ての情報を会話文として使用し、さらなる会話文の生成が困難となった場合には、S124に進む。

S124では、特定のコンテンツ情報に対して複数のスレッドを規定し、S125に進む。S125では、各スレッドにコンテンツ情報に対応した属性情報を格納し、S126に進む。S126では、サブルーチンとしての固定スレッド設定処理(図7参照)を開始し、S127に進む。

S127では、サブルーチンとしてのコンテンツ情報設定処理(図8参照)を開始し、S128に進む。S128では、会話文生成ブロック83にて会話文の生成に用いるコンテンツ情報を、S127にて設定されたコンテンツ情報に変更する。そして、新たなコンテンツ情報に基づく会話文を用いて、ユーザとの会話を継続する。

次に、S126にて開始される固定スレッド設定処理の詳細を、図7に基づき、図3を参照しつつ説明する。固定スレッド設定処理によれば、複数のスレッドはそれぞれ、固定スレッド及び遷移スレッドのいずれかに設定される。固定スレッド設定処理の各ステップは、主に文章処理部80の各サブブロックによって実施される。

S141では、固定スレッドとして選択されるスレッドの優先順位を設定するため、優先順位の初期設定値を読み込み、S142に進む。初期設定値は、ランダムに設定された順位であってもよく、ユーザによる操作入力によって予め設定された順位であってもよい。さらに、ユーザとの会話履歴に基づいて初期設定値が設定されてもよい。

S142では、音声認識部61から取得しているユーザの発話の内容から、最新の会話に用いられていた特定のコンテンツ情報に対するユーザの関心が高いか否かを推定する。具体的にS142では、例えばユーザが「そっか」,「ふーん」といった反応を示した場合、又はユーザの反応が無い場合、ユーザの関心が低いと判定する。S142にて、関心が低いと判定した場合には、S143に進む。

S143では、固定スレッドの数を予め設定された低関心所定値に設定し、S144に進む。低関心所定値は、会話の話題が大きく変わるように、例えばスレッドの数の過半数以上の値に設定される。本実施形態の低関心所定値は、「4」に予め設定されている。S144では、ジャンルの詳細及び提供元の各スレッドについて優先順位を下げる調整を行い、S149に進む。S144における優先順位の調整により、ジャンルの詳細及び提供元のスレッドに格納される属性情報が変更され易くなる。

一方、S142にて、ユーザの関心が高いと判定した場合には、S145に進む。S145では、固定スレッドの数を予め設定された高関心所定値に設定し、S146に進む。高関心所定値は、会話の話題が継続されるように、例えばスレッドの数の過半数未満の値に設定される。本実施形態の高関心所定値は、「1」に予め設定されている。高関心所定値は、低関心所定値よりも小さい値とされる。S146では、ジャンルの詳細のスレッドについて優先順位を上げる調整を行い、S147に進む。

S147では、会話実行処理のS125(図6参照)にて設定された属性情報に関連するワードがユーザによって発話されたか否かを判定する。S147にて、属性情報に関連するワードがユーザの発話から抽出されなかった場合、S149に進む。一方、S147にて、属性情報に関連するワードがユーザの発話から抽出された場合には、S148に進む。例えば、キーワードのスレッドに属性情報として<テニスプレーヤND>の名前が設定されている場合、他の著名なテニスプレーヤの名前が属性情報に関連するワードに該当する(図4参照)。

S148では、抽出されたワードに関連するスレッドについて優先順位を最下位へ調整し、且つ、当該スレッドの属性情報を抽出したワードにて更新する。具体的に、上述した会話のように、ユーザが<テニスプレーヤAM>の名前を発した場合には、キーワードのスレッドの優先順位が最下位とされ、当該スレッドの属性情報が、<テニスプレーヤND>から<テニスプレーヤAM>に更新される(図4参照)。S149では、S143又はS145にて設定された固定スレッドの数と、S144又はS146~S148にて設定された優先順位とに基づき、固定スレッドを指定する。

次に、S127(図6参照)にて開始されるコンテンツ情報設定処理の詳細を、図8に基づき、図3を参照しつつ説明する。コンテンツ情報設定処理によれば、次に会話文の生成に用いられるコンテンツ情報が設定される。コンテンツ情報設定処理の各ステップは、主に文章処理部80の各サブブロックによって実施される。

S161では、S149(図7参照)にて指定された固定スレッドの属性情報が同一となるようなコンテンツ情報をインターネットから取得し、S162に進む。取得制御ブロック82にて属性情報に関連するワードがユーザの発話から抽出されていた場合のS161では、抽出されたワードとも関連の高いコンテンツ情報が取得される。

S162では、S161にて取得したコンテンツ情報と、最新の特定コンテンツ情報との類似度を算定し、S163に進む。S163では、S162にて算定された類似度が予め設定された閾値未満か否かを判定する。S163にて、類似度が閾値以上であると判定した場合、S164に進む。S164では、直前のS161にて取得したコンテンツ情報を会話文に用いる候補から除外し、再びS161に戻る。再度のS161では、各属性情報が同一となるようなコンテンツ情報を再検索する。