WO2016034008A1 - 一种目标跟踪方法及装置 - Google Patents

一种目标跟踪方法及装置 Download PDFInfo

- Publication number

- WO2016034008A1 WO2016034008A1 PCT/CN2015/081920 CN2015081920W WO2016034008A1 WO 2016034008 A1 WO2016034008 A1 WO 2016034008A1 CN 2015081920 W CN2015081920 W CN 2015081920W WO 2016034008 A1 WO2016034008 A1 WO 2016034008A1

- Authority

- WO

- WIPO (PCT)

- Prior art keywords

- tracking

- tracking area

- frame image

- current frame

- area

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

- G06T7/246—Analysis of motion using feature-based methods, e.g. the tracking of corners or segments

- G06T7/251—Analysis of motion using feature-based methods, e.g. the tracking of corners or segments involving models

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30221—Sports video; Sports image

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30241—Trajectory

Definitions

- Target tracking is the basic technology for video content understanding. With the development of video processing to intelligent direction, the application of target tracking is more and more extensive, such as the analysis of motion patterns and traffic patterns of groups or individuals in video surveillance; Aspects of somatosensory games, gesture recognition and finger tracking; continuous tracking of key people in news and video, animal population tracking and behavior analysis.

- a tracking unit configured to establish a spatial structure model for each of the groups, and obtain a position of the to-be-tracked area in the next frame image according to the spatial structure model.

- a model establishing subunit configured to obtain a graph model of the current frame image according to the motion matrix of the current frame image

- an x-axis coordinate of a center point of the auxiliary tracking area is an average of x-axis coordinates of all key points in the set, the auxiliary tracking area

- the y-axis coordinate of the center point is the mean of the y-axis coordinates of all the key points in the set

- the width of the auxiliary tracking area in the x-axis direction is the standard deviation of the x-axis coordinates of all the key points in the set.

- the invariant neighborhood is: a first preset of each of the key points in a continuous preset number of frame images The intersection of the nearest neighbor key points of the number, the nearest neighbor key point being the closest key point to the key point of the invariant neighborhood to be found;

- the i-th key point and the j-th key point are both greater than the first threshold, the i-th key point and the j-th key point

- the edge G i,j 1

- the side length of the graph model Dist(i,j) is the distance between the ith key point and the jth key point

- the tracking unit includes:

- a group layering sub-unit configured to divide each group in the current frame image into two layers, where the first layer is: the tracking area of the current frame image is grouped into the group, and the second layer is Reconstructing the tracking area on the current frame image, which is the first preset number in the invariant neighborhood, for each key point included in each group, and the first in the invariant neighborhood

- the preset number is a value used to calculate a motion matrix of the tracking area of the first layer

- the embodiment of the present invention may first obtain the to-be-tracked area of the tracking target and the auxiliary tracking area for auxiliary tracking on the current frame image, and according to the motion track of the to-be-tracked area and the auxiliary tracking area,

- the to-be-tracked area and the auxiliary tracking area are divided into multiple groups, and then a spatial structure model is established for each group, and the position of the to-be-tracked area in the next frame image is obtained according to the spatial structure model, and the next frame image is obtained in the to-be-tracked area.

- After the position in the area, located in the area to be tracked The position of the tracking target in the next frame image is also obtained.

- the target tracking method provided by the embodiment of the present invention does not need offline training, thereby implementing online tracking.

- FIG. 6 is still another flowchart of a target tracking method according to an embodiment of the present invention.

- step 9 is a flow chart of step 104 in the target tracking method shown in FIG. 1;

- step 11 is a flow chart of step 105 in the target tracking method shown in FIG. 1;

- FIG. 14 is a schematic diagram of a tree structure obtained according to an embodiment of the present invention.

- the subsequent frame is a multi-frame image acquired after the current frame image, and the subsequent frame may be a preset number of preset images, and the subsequent frame may also be the online video to be tracked currently, from the current frame image to the online video playback. End the image between.

- the center position of the tracking target on the touch screen displays an initial area indicated by a square, and then Detecting two buttons for controlling the box to become larger and smaller, and detecting four direction buttons for controlling the position of the box, when detecting that the corresponding button is operated, the display terminal performs a corresponding operation to control the box, and finally The frame is framed by the tracking target, and the area enclosed by the box is the area to be tracked.

- the key point is a point in the image having significant visual features, such as corner points, edge points, and the like in the image.

- KLT Kanade-Lucas-Tomasi, key point tracking

- a preset number of frame images consecutively before the current frame image is obtained, for example, the current frame image is the t+d frame, and the previous preset image frame is t+d-1 frame, t+d-2 frame, ...

- the t-th frame that is, the continuous d-frame image before the current frame image is acquired, and d is preferably 10.

- the key points are automatically detected from the image of the t-th frame, and the detected key points are sorted according to the degree of significance of the features, and the first M key points with the most significant features are selected as the set of key points for initialization, wherein the degree of significance is in the KLT algorithm.

- a feature quantity used to measure the importance of a key point which is not explained too much;

- Step 107 Determine whether the number of tracking times is equal to the number of images to be tracked, and if not, perform step 104. And 105, if it is the end of the trace.

- steps 104 and 105 will continue to be performed to obtain the position of the tracking target in the remaining images to be tracked.

- the nearest neighbor key point is: a key point that is closest to the key point in a continuous preset number of frame images, and the second preset number is preferably 20 in the embodiment of the present invention.

- FIG. 11 is a flowchart of step 105 in the target tracking method provided by the embodiment of the present invention, which may include the following steps:

- the embodiment of the present invention further provides a target tracking device, which is shown in FIG. 19, and may include: a first acquiring unit 11, a second acquiring unit 12, and a third The acquisition unit 13, the division unit 14, and the tracking unit 15. among them,

- a preset number of frame images consecutively before the current frame image is obtained, for example, the current frame image is the t+d frame, and the previous preset image frame is t+d-1 frame, t+d-2 frame, ...

- the t-th frame that is, the continuous d-frame image before the current frame image is acquired, and d is preferably 10.

- the key points are automatically detected from the image of the t-th frame, and the detected key points are sorted according to the degree of significance of the features, and the first M key points with the most significant features are selected as the set of key points for initialization, wherein the degree of significance is in the KLT algorithm.

- a feature quantity used to measure the importance of a key point which is not explained too much;

- the structure of the third obtaining unit 13, the dividing unit 14, and the tracking unit 15 in the target tracking device provided by the embodiment of the present invention is described in detail below.

- the structure of the third obtaining unit 13 is shown in FIG. 20, and includes: a computing subunit. 131.

- a tracking area includes ten key points, wherein the motion trajectory of the two key points is the first motion trajectory, the motion trajectory of the three key points is the second motion trajectory, and the motion trajectory of the five key points is For the third motion trajectory, then the motion trajectory of the most key point marker is taken as the motion trajectory of this tracking area, that is, the third motion trajectory.

- the second layer may divide at least two tracking areas adjacent to the first layer and having occlusion into the same tracking area, thereby reducing The occlusion probability of the layer 2 tracking area.

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Image Analysis (AREA)

Abstract

本发明提供一种目标跟踪方法及装置,其中一种目标跟踪方法包括:获取跟踪目标在当前帧图像上的待跟踪区域;在所述当前帧图像中确定多个关键点,获取每个所述关键点的位置;基于所述每个所述关键点的位置,得到当前帧图像上的辅助跟踪区域;依据所述待跟踪区域和所述辅助跟踪区域的运动轨迹,将所述待跟踪区域和所述辅助跟踪区域划分成多个群组;对每个所述群组建立空间结构模型,根据所述空间结构模型得到所述待跟踪区域在下一帧图像中的位置。在得到待跟踪区域在下一帧图像中的位置后,位于待跟踪区域内的跟踪目标在下一帧图像中的位置也被得到。相对于现有基于模型的目标跟踪方法来说,本发明实施例无需离线训练,从而实现在线跟踪。

Description

本发明涉及信息处理技术领域,更具体地说,涉及一种目标跟踪方法及装置。

目标跟踪是视频内容理解的基础性技术,随着视频处理向智能化方向发展,目标跟踪的应用也愈加广泛,例如在视频监控方面对群体或个体的运动模式分析和交通模式分析;在家庭应用方面的体感游戏、手势识别和手指跟踪;新闻录影方面对关键人物的持续跟踪拍摄以及动物种群跟踪及行为分析等等。

其中目标跟踪是指输入一段包含若干个运动物体的视频,输出某个或多个指定运动物体(跟踪目标)在视频每一帧当中的位置。目前在目标跟踪方面运用的主要方法是基于模型的目标跟踪方法,包括:对视频中的每一帧建立光流场,其中光流场反映了每个图像帧中每一像素灰度的变化趋势,可以通过光流场确定当前帧上每一个像素在下一帧上相应的位置;利用光流场对场景的结构或长期的运动模式建立数学模型;利用数学模型辅助目标跟踪。

但是上述基于模型的目标跟踪方法在建立光流场时,需要将整段视频录制后再对录制后的视频进行分析来建立光流场,即现有基于模型的目标跟踪方法需要离线训练来建立光流场,无法在线跟踪目标。

发明内容

有鉴于此,本发明实施例目的在于提供一种目标跟踪方法及装置,用于在线跟踪目标。

为实现上述目的,本发明实施例提供如下技术方案:

第一方面,本发明实施例提供一种目标跟踪方法,包括:

获取跟踪目标在当前帧图像上的待跟踪区域;

在所述当前帧图像中确定多个关键点,获取每个所述关键点的位置;

基于所述每个所述关键点的位置,得到当前帧图像上的辅助跟踪区域,所述辅助跟踪区域用于辅助跟踪所述跟踪目标在后续帧上的位置;

依据所述待跟踪区域和所述辅助跟踪区域的运动轨迹,将所述待跟踪区域和所述辅助跟踪区域划分成多个群组;

对每个所述群组建立空间结构模型,根据所述空间结构模型得到所述待跟踪区域在下一帧图像中的位置。

在第一方面的第一种可行方式中,基于每个所述关键点的位置,得到当前帧图像上的辅助跟踪区域,包括:

基于每个所述关键点的位置,计算所述当前帧图像的运动矩阵;

依据所述当前帧图像的所述运动矩阵,得到所述当前帧图像的图模型;

基于所述图模型将所述关键点划分成多个集合;

为每个集合构建一个辅助跟踪区域,其中所述辅助跟踪区域的中心点的x轴坐标为所述集合内的所有关键点的x轴坐标的均值,所述辅助跟踪区域的中心点的y轴坐标为所述集合内的所有关键点的y轴坐标的均值,所述辅助跟踪区域在x轴方向的宽度为所述集合内的所有关键点的x轴坐标的标准差的N倍,所述辅助跟踪区域在y轴方向的宽度为所述集合内的所有关键点的y轴坐标的标准差的N倍,N为大于1的实数。

结合第一种可行方式,在第一方面的第二种可行方式中,基于每个所述关键点的位置,计算所述当前帧图像的运动矩阵,包括:

寻找当前帧图像中每个关键点的不变邻域,其中不变邻域是:在连续的预设数量的帧图像中每个所述关键点的第一预设个数的最近邻关键点的交集,所述最近邻关键点为距离所要寻找不变邻域的所述关键点最近的关键点;

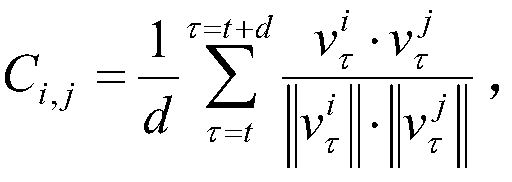

为当前帧图像构建运动矩阵,并计算运动矩阵中每个元素Ci,j的取值,其中计算步骤包括:

如果第j个关键点不属于第i个关键点的不变邻域,则Ci,j=0。

结合第二种可行方式,在第一方面的第三种可行方式中,依据所述当前帧图像的所述运动矩阵,得到当前帧图像的图模型,包括:

将当前帧图像中的所述关键点作为当前帧图像的图模型的节点;

计算任意两个节点之间的连线构成的所述图模型的边长,其中所述边长的计算步骤包括:

如果所述运动矩阵中第i行第j列的元素Ci,j和第j列第i行的元素Cj,i都大于第一阈值,则第i个关键点和第j个关键点之间的边Gi,j=1,图模型的边长dist(i,j)是第i个关键点和第j个关键点之间的距离,

结合第一种可行方式,在第一方面的第四种可行方式中,依据所述待跟踪区域和所述辅助跟踪区域的运动轨迹,将所述待跟踪区域和所述辅助跟踪区域划分成多个群组,包括:

计算当前帧图像上每个关键点的瞬时运动矢量,并基于所述瞬时运动矢量,计算每个所述关键点与第二预设个数的最近邻关键点之间的运动相关性,其中最近邻关键点是:在连续的预设数量的帧图像中与所述关键点距离最近的关键点;

当当前帧图像上任意两个所述关键点之间的运动相关性大于第二阈值时,为大于第二阈值的两个所述关键点标记为相同的运动轨迹;

将所述待跟踪区域和所述辅助跟踪区域作为跟踪区域,并获取每个所述跟踪区域的运动轨迹,所述跟踪区域的运动轨迹为所述跟踪区域内最多关键点所

标记的运动轨迹;

计算当前帧图像的连通矩阵Lt,所述连通矩阵Lt中第i行第j列元素Lt(i,j)的计算步骤为:如果第i个跟踪区域和第j个跟踪区域的运动轨迹相同,则Lt(i,j)=1,否则Lt(i,j)=0;

对第二预设时间内所有帧图像的所述连通矩阵Lt进行逐元素相加并对相加结果进行阈值化,得到当前帧图像的矩阵Lsum,矩阵Lsum中元素Lsum(i,j)的计算步骤为:如果阈值化结果大于第三阈值,则Lsum(i,j)=1,否则Lsum(i,j)=0,Lsum(i,j)=1表示第i个跟踪区域与第j个跟踪区域之间存在连接;

依据矩阵Lsum将存在连接的至少两个所述跟踪区域划分成一个群组,以得到多个群组。

结合第四种可行方式,在第一方面的第五种可行方式中,对每个所述群组建立空间结构模型,根据所述空间结构模型得到所述待跟踪区域在下一帧图像中的位置,包括:

将当前帧图像中的每个群组划分为两层,其中第1层为:当前帧图像中聚成所述群组的所述跟踪区域,第2层为:分别对每个群组中包含的关键点,以大于不变邻域中第一预设个数的数值,重新构建得到的当前帧图像上的所述跟踪区域,不变邻域中第一预设个数为计算所述第1层的跟踪区域的运动矩阵使用的数值;

对每个群组构建树型结构,所述树型结构通过对同一群组各层中的所述跟踪区域构建最小生成树,以及对同一群组不同层之间的具有重叠的跟踪区域相连接得到;

对所述树型结构进行约束,以得到所述跟踪区域在下一帧图像中的位置,对所述树型结构进行约束包括:

采用公式对所述树型结构进行表观约束,其中m表示层数,Nm为当前帧第m层的跟踪区域总数,表示第m层的第i个跟踪区域,是从中提取的视觉特征向量,是视觉特征向量

训练得到的线性支持向量机的权重,在训练线性支持向量机时,正样本为当前帧第m层的跟踪区域,负样本是正样本周围随机选择的背景区域;

采用公式 对所述树型结构进行层内空间约束,其中Em表示所述树型结构中第m层中相连接的跟踪区域对总数,和表示下一帧中第m层的第i个跟踪区域和第j个跟踪区域的位置坐标,为第一预设常数,为第i个跟踪区域和第j个跟踪区域之间的期望距离,的初始值为第i个跟踪区域与第j个跟踪区域在当前帧图像上的距离,在后续图像帧中动态更新为第i个跟踪区域与第j个跟踪区域在当前帧的距离与前一次更新得到的期望距离的均值

采用公式对所述树型结构进行层间空间约束,其中Ec表示所述树型结构中第1层和第2层之间相连接的跟踪区域对总数,和表示下一帧第1层的第i个跟踪区域和第2层相连的第j个跟踪区域的位置坐标,λij为第二预设常数,eij为第1层的第i个跟踪区域和第2层相连的第j个跟踪区域之间的期望距离,eij的初始值为第1层的第i个跟踪区域与第2层相连的第j个跟踪区域在当前帧图像上的距离,在后续图像帧中动态更新为第1层的第i个跟踪区域与第2层相连的第j个跟踪区域在当前帧的距离与前一次更新得到的期望距离的均值。

第二方面,本发明实施例提供一种目标跟踪装置,包括:

第一获取单元,用于获取跟踪目标在当前帧图像上的待跟踪区域;

第二获取单元,用于在所述当前帧图像中确定多个关键点,获取每个所述关键点的位置;

第三获取单元,用于基于所述每个所述关键点的位置,得到当前帧图像上

的辅助跟踪区域,所述辅助跟踪区域用于辅助跟踪所述跟踪目标在后续帧上的位置;

划分单元,用于依据所述待跟踪区域和所述辅助跟踪区域的运动轨迹,将所述待跟踪区域和所述辅助跟踪区域划分成多个群组;

跟踪单元,用于对每个所述群组建立空间结构模型,根据所述空间结构模型得到所述待跟踪区域在下一帧图像中的位置。

在第二方面的第一种可行方式中,所述第三获取单元包括:

计算子单元,用于基于每个所述关键点的位置,计算所述当前帧图像的运动矩阵;

模型建立子单元,用于依据所述当前帧图像的所述运动矩阵,得到所述当前帧图像的图模型;

划分子单元,用于基于所述图模型将所述关键点划分成多个集合;

构建子单元,用于为每个集合构建一个辅助跟踪区域,其中所述辅助跟踪区域的中心点的x轴坐标为所述集合内的所有关键点的x轴坐标的均值,所述辅助跟踪区域的中心点的y轴坐标为所述集合内的所有关键点的y轴坐标的均值,所述辅助跟踪区域在x轴方向的宽度为所述集合内的所有关键点的x轴坐标的标准差的N倍,所述辅助跟踪区域在y轴方向的宽度为所述集合内的所有关键点的y轴坐标的标准差的N倍,N为大于1的实数。

结合第一种可行方式,在第一方面的第二种可行方式中,所述计算子单元包括:

获取子单元,用于寻找当前帧图像中每个关键点的不变邻域,其中不变邻域是:在连续的预设数量的帧图像中每个所述关键点的第一预设个数的最近邻关键点的交集,所述最近邻关键点为距离所要寻找不变邻域的所述关键点最近的关键点;

元素取值计算子单元,用于为当前帧图像构建运动矩阵,并计算运动矩阵中每个元素Ci,j的取值,其中计算步骤包括:如果第j个关键点属于第i个关键点的不变邻域,则其中t和t+d为第二预设时间内连续

跟踪的开始帧和结束帧,表示第i个关键点在第τ帧的瞬时运动速度矢量,表示第j个关键点在第τ帧的瞬时运动速度矢量;如果第j个关键点不属于第i个关键点的不变邻域,则Ci,j=0。

结合第二种可行方式,在第二方面的第三种可行方式中,所述模型建立子单元包括:

节点获取子单元,用于将当前帧图像中的所述关键点作为当前帧图像的图模型的节点;

边长计算子单元,用于计算任意两个节点之间的连线构成的所述图模型的边长,所述边长的计算步骤包括:

如果所述运动矩阵中第i行第j列的元素Ci,j和第j列第i行的元素Cj,i都大于第一阈值,则第i个关键点和第j个关键点之间的边Gi,j=1,图模型的边长dist(i,j)是第i个关键点和第j个关键点之间的距离,

结合第一种可行方式,在第二方面的第四种可行方式中,所述划分单元包括:

第一计算子单元,用于计算当前帧图像上每个关键点的瞬时运动矢量,并基于所述瞬时运动矢量,计算每个所述关键点与第二预设个数的最近邻关键点之间的运动相关性,其中最近邻关键点是:在连续的预设数量的帧图像中与所述关键点距离最近的关键点;

标记子单元,用于当当前帧图像上任意两个所述关键点之间的运动相关性大于第二阈值时,为大于第二阈值的两个所述关键点标记为相同的运动轨迹;

轨迹获取子单元,用于将所述待跟踪区域和所述辅助跟踪区域作为跟踪区域,并获取每个所述跟踪区域的运动轨迹,所述跟踪区域的运动轨迹为所述跟

踪区域内最多关键点所标记的运动轨迹;

第二计算子单元,用于计算当前帧图像的连通矩阵Lt,所述连通矩阵Lt中第i行第j列元素Lt(i,j)的计算步骤为:如果第i个跟踪区域和第j个跟踪区域的运动轨迹相同,则Lt(i,j)=1,否则Lt(i,j)=0;

第三计算子单元,用于对第二预设时间内所有帧图像的所述连通矩阵Lt进行逐元素相加并对相加结果进行阈值化,得到当前帧图像的矩阵Lsum,矩阵Lsum中元素Lsum(i,j)的计算步骤为:如果阈值化结果大于第三阈值,则Lsum(i,j)=1,否则Lsum(i,j)=0,Lsum(i,j)=1表示第i个跟踪区域与第j个跟踪区域之间存在连接;

划分子单元,用于依据矩阵Lsum将存在连接的至少两个所述跟踪区域划分成一个群组,以得到多个群组。

结合第四种可行方式,在第二方面的第五种可行方式中,所述跟踪单元包括:

群组分层子单元,用于将当前帧图像中的每个群组划分为两层,其中第1层为:当前帧图像中聚成所述群组的所述跟踪区域,第2层为:分别对每个群组中包含的关键点,以大于不变邻域中第一预设个数的数值,重新构建得到的当前帧图像上的所述跟踪区域,不变邻域中第一预设个数为计算所述第1层的跟踪区域的运动矩阵使用的数值;

结构构建子单元,用于对每个群组构建树型结构,所述树型结构通过对同一群组各层中的所述跟踪区域构建最小生成树,以及对同一群组不同层之间的具有重叠的跟踪区域相连接得到;

跟踪子单元,用于对所述树型结构进行约束,以得到所述跟踪区域在下一帧图像中的位置,对所述树型结构进行约束包括:

采用公式对所述树型结构进行表观约束,其中m表示层数,Nm为当前帧第m层的跟踪区域总数,表示第m层的第i个跟踪区域,是从中提取的视觉特征向量,是视觉特征向量

训练得到的线性支持向量机的权重,在训练线性支持向量机时,正样本为当前帧第m层的跟踪区域,负样本是正样本周围随机选择的背景区域;

采用公式 对所述树型结构进行层内空间约束,其中Em表示所述树型结构中第m层中相连接的跟踪区域对总数,和表示下一帧中第m层的第i个跟踪区域和第j个跟踪区域的位置坐标,为第一预设常数,为第i个跟踪区域和第j个跟踪区域之间的期望距离,的初始值为第i个跟踪区域与第j个跟踪区域在当前帧图像上的距离,在后续图像帧中动态更新为第i个跟踪区域与第j个跟踪区域在当前帧的距离与前一次更新得到的期望距离的均值

采用公式对所述树型结构进行层间空间约束,其中Ec表示所述树型结构中第1层和第2层之间相连接的跟踪区域对总数,和表示下一帧第1层的第i个跟踪区域和第2层相连的第j个跟踪区域的位置坐标,λij为第二预设常数,eij为第1层的第i个跟踪区域和第2层相连的第j个跟踪区域之间的期望距离,eij的初始值为第1层的第i个跟踪区域与第2层相连的第j个跟踪区域在当前帧图像上的距离,在后续图像帧中动态更新为第1层的第i个跟踪区域与第2层相连的第j个跟踪区域在当前帧的距离与前一次更新得到的期望距离的均值。

从上述的技术方案可以看出,本发明实施例可以首先在当前帧图像上获取跟踪目标的待跟踪区域和用于辅助跟踪的辅助跟踪区域,依据待跟踪区域和辅助跟踪区域的运动轨迹,将待跟踪区域和辅助跟踪区域划分成多个群组,再对每个群组建立空间结构模型,根据空间结构模型得到待跟踪区域在下一帧图像中的位置,在得到待跟踪区域在下一帧图像中的位置后,位于待跟踪区域内的

跟踪目标在下一帧图像中的位置也被得到。相对于现有基于模型的目标跟踪方法来说,本发明实施例提供的目标跟踪方法无需离线训练,从而实现在线跟踪。

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

图1为本发明实施例提供的目标跟踪方法的一种流程图;

图2为本发明实施例所针对的当前帧图像的示意图;

图3为图2所示当前帧图像中待跟踪区域的示意图;

图4为关键点跟踪优化的示意图;

图5为本发明实施例提供的目标跟踪方法的另一种流程图;

图6为本发明实施例提供的目标跟踪方法的再一种流程图;

图7为图1所示目标跟踪方法中步骤103的流程图;

图8为图2所示当前帧图像中辅助跟踪区域的示意图;

图9为图1所示目标跟踪方法中步骤104的流程图;

图10为本发明实施例中群组的示意图;

图11为图1所示目标跟踪方法中步骤105的流程图;

图12为图10所示群组分层后的示意图;

图13为图12所示群组分层后的最小生成树的示意图;

图14为本发明实施例得到的树型结构的示意图;

图15至图18为按时间顺序抽取的前后四帧图像在采用本发明实施例提供的目标跟踪方法后得到的跟踪结果的示意图;

图19为本发明实施例提供的目标跟踪装置的结构示意图;

图20为本发明实施例提供的目标跟踪装置中第三获取单元的结构示意图;

图21为本发明实施例提供的目标跟踪装置中划分单元的结构示意图;

图22为本发明实施例提供的目标跟踪装置中跟踪单元的结构示意图;

图23为本发明实施例提供的目标跟踪设备的结构示意图。

为了使本领域技术人员更好地理解本发明实施例,下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

请参阅图1,其示出了本发明实施例提供的目标跟踪方法的一种流程图,该目标跟踪方法用于对跟踪目标进行在线跟踪,可以包括以下步骤:

101:获取跟踪目标在当前帧图像上的待跟踪区域。其中跟踪目标是当前帧图像上需要进行位置跟踪的对象,待跟踪区域是跟踪目标在当前帧图像上的所占区域,可以从当前帧图像开始跟踪所述跟踪目标在后续帧上的位置。

后续帧是在当前帧图像之后获取到的多帧图像,后续帧可以是预先指定的预设数量的图像,后续帧也可以是当前所要跟踪的在线视频中,从当前帧图像开始到在线视频播放结束之间的图像。

在本发明实施例中,待跟踪区域的一种方式是手工定位。例如在具有摄像装置的显示终端上,可以手动操作显示终端的触摸屏,用手指划定跟踪目标的待跟踪区域。在手工定位待跟踪区域过程中,还可以借助于按键来定位,具体可以是:当显示终端检测到手指指定跟踪目标时,在触摸屏上跟踪目标的中心位置显示一个方框表示的初始区域,然后检测用于控制方框变大和变小的两个按键,以及检测用于控制方框位置的四个方向按键,当检测到相应按键被操作时,显示终端执行相应操作来控制方框,并最终将方框框住跟踪目标,此时方框所框住的区域即为待跟踪区域。

待跟踪区域的另一种方式是自动定位,其实现过程是:首先预先用某一种

尺度获取跟踪目标的大量样本为正样本,非跟踪目标的大量样本为负样本,通过模式识别方法(例如支持向量机)对正负样本进行训练得到用于区分跟踪目标与非跟踪目标的分类器;其次采用不同尺度对跟踪目标所在当前帧图像进行区域划分,并将得到的不同尺度区域缩放到与训练时采用的尺度区域;然后用分类器识别出包括跟踪目标的区域,将其作为待跟踪区域。

需要说明的是:本发明实施例在训练得到分类器和采用分类器自动定位待跟踪区域时,应该针对同一个跟踪目标在同一个应用场景,比如当跟踪目标的应用场景是运动员在操场踢球,如图2所示,则训练得到分类器时采用的样本是采样该运动员以前在操场踢球的帧图像中的样本。如2所示当前帧图像在经过手工定位和自动定位后得到的待跟踪区域如图3所示,其中图3中方框所框住的区域为待跟踪区域,其所包括的对象为跟踪目标。

102:在当前帧图像中确定多个关键点,获取每个关键点的位置。在本发明实施例中,关键点是图像中具有显著视觉特征的点,比如图像中的角点、边缘点等。关键点的确定及位置获取可以通过现有算法,如KLT(Kanade-Lucas-Tomasi,关键点跟踪)算法,其算法过程如下:

首先,预先设定在当前帧图像中要确定的关键点个数M,其中M是一经验值,在跟踪目标所在场景较复杂的情况下,M的取值较大;在跟踪目标所在场景较简单的情况下,M的取值较小。一般情况下,当前帧图像中的每个对象上至少要有三个关键点;

其次,获取当前帧图像之前连续的预设数量的帧图像,如当前帧图像为第t+d帧,之前预设数帧图像为t+d-1帧、t+d-2帧、……、第t帧,即获取当前帧图像之前连续的d帧图像,d优选为10。从第t帧图像自动检测关键点,并将检测到的关键点按照特征的显著程度进行排序,从中选取特征最显著的前M个关键点作为初始化的关键点集合,其中显著程度是KLT算法中用于衡量关键点重要性的一个特征量,对此不再过多阐述;

然后,优化关键点集合:计算关键点集合中各个关键点在第t+1帧图像中的位置以及各个关键点在第t帧和第t+1帧之间的匹配程度,如果匹配程度小于匹配阈值(关键点被遮挡会导致匹配程度降低),则丢弃匹配程度小于匹配

阈值的关键点,并重新在第t+1帧上自动检测关键点,在检测到的关键点中选取特征最显著的关键点加入到关键点集合中,以保证关键点集合中关键点个数为M;

对后续第t+2帧至第t+d帧图像依次执行优化关键点集合这一步骤,从而依据相邻两帧图像中关键点的匹配程度优化关键点集合,得到第t+d帧图像上的关键点以及每个关键点的位置,即得到当前帧图像上的关键点及每个关键点的位置,如图4所示,关键点跟踪优化从第t帧开始至第t+d帧为止,其示出了从第t帧至第t+d帧关键点的变化,图中的圆点为关键点。

103:基于每个关键点的位置,得到当前帧图像上的辅助跟踪区域,辅助跟踪区域用于辅助跟踪所述跟踪目标在后续帧上的位置。

104:依据待跟踪区域和辅助跟踪区域的运动轨迹,将待跟踪区域和辅助跟踪区域划分成多个群组。

在本发明实施例中,待跟踪区域的运动轨迹可以由跟踪目标的运动轨迹决定,辅助跟踪区域的运动轨迹可以由位于该辅助跟踪区域的关键点的运动轨迹决定,跟踪目标的运动轨迹和关键点的运动轨迹可以由运动方向和运动速度指示。

在将待跟踪区域和辅助跟踪区域进行划分时,可以将具有相同运动轨迹的区域划分至一个群组中以得到多个群组,也可以综合考虑多帧图像中待跟踪区域和辅助跟踪区域的运动轨迹进行划分,具体过程可以参阅后续对步骤104的详细说明。

105:对每个群组建立空间结构模型,根据空间结构模型得到待跟踪区域在下一帧图像中的位置,其中下一帧图像是在当前帧图像之后捕获到的图像,是从捕获时间来看与当前帧图像相邻且位于当前帧图像之后的图像。

对于待跟踪目标来说,待跟踪区域内仅包括跟踪目标,因此在得到待跟踪区域在下一帧图像中的位置后,位于待跟踪区域内的跟踪目标的位置也可以得到,并且可以将待跟踪区域在下一帧图像中的位置作为跟踪目标在下一帧图像中的位置。

在本发明实施例中,每个群组的空间结构模型可以采用现有算法建立,再

利用现有动态规划算法对空间结构模型进行约束以得到待跟踪区域在下一帧图像中的位置,其中空间结构模型是得到每个群组内待跟踪区域和辅助跟踪区域的两层空间图形来展示每个群组内待跟踪区域和辅助跟踪区域的位置关系,其中两层空间图形包括:第1层待跟踪区域、第1层辅助跟踪区域、第2层待跟踪区域和第2层辅助跟踪区域。

在利用动态规划算法对空间结构模型进行约束时,可以采用循环迭代方式对空间结构模型中群组的两层空间图形进行层内优化和层间优化。进一步在进行层内优化和层间优化时,可以首先优化群组的第1层,然后将优化后的第1层的位置进行固定,再优化第1层和第2层的层间关系。由于在进行层内优化时省去了第2层的优化,所以降低了优化量,节省优化时间。

本发明实施例可以首先在当前帧图像上获取跟踪目标的待跟踪区域和用于辅助跟踪的辅助跟踪区域,依据待跟踪区域和辅助跟踪区域的运动轨迹,将待跟踪区域和辅助跟踪区域划分成多个群组,再对每个群组建立空间结构模型,根据空间结构模型得到待跟踪区域在下一帧图像中的位置,在得到待跟踪区域在下一帧图像中的位置后,位于待跟踪区域内的跟踪目标在下一帧图像中的位置也被得到。相对于现有基于模型的目标跟踪方法来说,本发明实施例提供的目标跟踪方法可以在在线视频的当前帧图像上进行操作,实现在线跟踪。

在跟踪到跟踪目标在下一帧图像中的位置后,还需要对跟踪目标继续跟踪以得到跟踪目标在后续帧中的位置,在进行后续跟踪时可以将下一帧图像作为当前帧图像,基于得到的待跟踪区域和辅助跟踪区域在下一帧图像中的位置,执行步骤104和105,以得到跟踪目标在后续帧中的位置。后续帧是在当前帧图像之后获取到的多帧图像,后续帧可以是预先指定的预设数量的图像,后续帧也可以是当前所要跟踪的在线视频中,从当前帧图像开始到在线视频播放结束之间的图像,在跟踪次数等于待跟踪图像的数量时,结束跟踪,如图5所示,在图1基础上还包括:

步骤106:获取跟踪次数,其中跟踪次数指示已对跟踪目标的位置进行评估的次数。

步骤107:判断跟踪次数是否等于待跟踪图像的数量,如果否执行步骤104

和105,如果是执行结束跟踪。

当跟踪次数等于待跟踪图像的数量时,表明已获取到跟踪目标在所有待跟踪图像中的位置,此时则可以结束跟踪;当跟踪次数小于待跟踪图像的数量时,表明仍需要继续进行跟踪,此时会继续执行步骤104和105以得到跟踪目标在剩余的待跟踪图像中的位置。

其中待跟踪图像的数量是所要跟踪图像的总数量,其可以是预先指定的某一数值,也可以是当前所跟踪的在线视频的总帧数,对此本发明实施路不再阐述。

需要说明的一点是:本发明实施例提供的目标跟踪方法虽然可以评估出跟踪目标在后续帧的位置,但是相对于跟踪目标在后续帧中的实际位置来说有一定的误差,因此为了避免误差累积,在反复执行步骤104和105一段时间后需要重新获取跟踪目标的待跟踪区域,如图6所示,本发明实施例提供的目标跟踪方法还包括:

当跟踪次数小于待跟踪图像的数量时,执行步骤108;

108:判断执行时间是否等于第一预设时间,如果否,继续执行步骤104和105;如果是,返回执行步骤101。

其中第一预设时间用于指示需要重新获取跟踪目标的待跟踪区域,且重新获取的待跟踪区域与之前获取的待跟踪区域位于不同的图像中,重新获取的待跟踪区域位于第一预设时间后的某帧图像上。第一预设时间的取值至少与所要求的跟踪精度有关,当跟踪精度要求越高,第一预设时间取值越小;当跟踪精度要求较低,第一预设时间取值越大。

经过上述图5和图6所示的目标跟踪方法,可以跟踪到跟踪目标在后续帧中的位置,并且在跟踪过程中重新获取跟踪目标在某帧图像上的实际位置,可以提高重新获取实际位置后在后续跟踪的精度。

下面则详细介绍本发明实施例提供的目标跟踪方法中的步骤103至步骤105,请参阅图7,其示出了本发明实施例提供的目标跟踪方法中步骤103的流程图,可以包括以下步骤:

1031:基于每个关键点的位置,计算当前帧图像的运动矩阵。其中当前帧

图像的运动矩阵中元素Ci,j的取值的决定因素之一为:关键点之间在当前帧图像和当前帧图像之前连续的预设数量的帧图像的位置关系,该位置关系可以为关键点的不变邻域。

不变邻域是:在连续的预设数量的帧图像中每个关键点的第一预设个数的最近邻关键点的交集,最近邻关键点为距离所要寻找不变邻域的关键点最近的关键点,在本发明实施例中第一预设个数优选为10。

连续的预设数量的帧图像为在执行步骤102确定关键点是所参考的帧图像,即获取当前帧图像之前的d帧图像,预设数量优选为10。

在查找不变邻域时可以以当前帧图像的某个关键点为寻找点,从d帧图像中获取离该寻找点距离最近的第一预设个数的关键点,且第一预设个数的关键点全部存在于d帧图像中,则这第一预设个数的关键点的交集为寻找点的不变邻域。

在寻找到不变邻域后,计算运动矩阵中每个元素Ci,j的取值,其中计算步骤包括:

如果第j个关键点属于第i个关键点的不变邻域,则其中t和t+d为第二预设时间内连续跟踪的开始帧和结束帧,表示第i个关键点在第τ帧的瞬时运动速度矢量,表示第j个关键点在第τ帧的瞬时运动速度矢量;如果第j个关键点不属于第i个关键点的不变邻域,则Ci,j=0。

瞬时运动速度矢量是一个关键点在相邻两帧上的位置差。如关键点在τ帧上的位置是(x1,y1),关键点在τ-1帧的位置为(x0,y0),则瞬时运动速度矢量是(x1-x0,y1-y0)。

1032:依据当前帧图像的运动矩阵,得到当前帧图像的图模型。其中图模型的节点为当前帧图像中的关键点,任意两个节点之间的连线构成图模型的边长,边长的计算步骤如下:

如果运动矩阵中第i行第j列的元素Ci,j和第j列第i行的元素Cj,i都大于第一阈值,则第i个关键点和第j个关键点之间的边Gi,j=1,图模型的边长

dist(i,j)是第i个关键点和第j个关键点之间的距离,如果运动矩阵中第i行第j列的元素Ci,j和/或第j列第i行的元素Cj,i小于等于第一阈值,则图模型的边长第一阈值为一经验值,具体取值可以基于应用场景设定,取值范围可以在(0.5,1)区间内,优选为0.8。

1033:基于所述图模型将所述关键点划分成多个集合。

本发明实施例对关键点进行划分时可以采用现有的基于图模型的聚类方法对关键点进行划分。在进行划分时首先将图模型中的作为节点的每个关键点各自划分为一类,并迭代计算任意两个类之间的密切程度,然后将密切程度最高的两个类划分为一个集合,当聚集度达到最大时,停止聚类,将当前聚类的结果当作划分的结果,得到划分后的多个集合。其中类间的密切程度根据构建的图模型的边进行计算,聚集度同样基于构建的图模型的边进行计算。

1034:为每个集合构建一个辅助跟踪区域,其中所述辅助跟踪区域的中心点的x轴坐标为所述集合内的所有关键点的x轴坐标的均值,所述辅助跟踪区域的中心点的y轴坐标为所述集合内的所有关键点的y轴坐标的均值,所述辅助跟踪区域在x轴方向的宽度为所述集合内的所有关键点的x轴坐标的标准差的N倍,所述辅助跟踪区域在y轴方向的宽度为所述集合内的所有关键点的y轴坐标的标准差的N倍,N为大于1的实数。

在本发明实施例中N优选为2,如图8所示,图8为N等于2时得到的辅助跟踪区域,其中圆角矩形框住的为待跟踪区域,方角矩形框住的区域为辅助跟踪区域。

请参阅图9,其示出了本发明实施例提供的目标跟踪方法中步骤104的流程图,可以包括以下步骤:

1041:计算当前帧图像上每个关键点的瞬时运动矢量,并基于瞬时运动矢量,计算每个关键点与第二预设个数的最近邻关键点之间的运动相关性,其中

最近邻关键点是:在连续的预设数量的帧图像中与所述关键点距离最近的关键点,在本发明实施例中第二预设个数优选为20。

连续的预设数量的帧图像为在执行步骤102确定关键点是所参考的帧图像,即获取当前帧图像之前的d帧图像,预设数量优选为10。

瞬时运动速度矢量是一个关键点在相邻两帧上的位置差。如关键点在τ帧上的位置是(x1,y1),关键点在τ-1帧的位置为(x0,y0),则瞬时运动速度矢量是(x1-x0,y1-y0)。运动相关性则是指两个关键点之间速度大小和方向的相似性,可以采用瞬时运动速度矢量之间的夹角余弦值表示。

1042:当当前帧图像上任意两个关键点之间的运动相关性大于第二阈值时,为大于第二阈值的两个关键点标记为相同的运动轨迹。第二阈值为一经验值,具体取值可以基于应用场景设定,例如第二阈值取值范围为(0.02,0.04)这一区间范围,对此本发明实施例不加以限制。

1043:将待跟踪区域和辅助跟踪区域作为跟踪区域,并获取每个跟踪区域的运动轨迹,跟踪区域的运动轨迹为跟踪区域内最多关键点所标记的运动轨迹。

比如某个跟踪区域中包括十个关键点,其中有两个关键点的运动轨迹为第一种运动轨迹,三个关键点的运动轨迹为第二种运动轨迹,五个关键点的运动轨迹为第三种运动轨迹,那么就取最多关键点标记的运动轨迹作为这个跟踪区域的运动轨迹,即第三种运动轨迹。

1044:计算当前帧图像的连通矩阵Lt,连通矩阵Lt中第i行第j列元素Lt(i,j)的计算步骤为:如果第i个跟踪区域和第j个跟踪区域的运动轨迹相同,则Lt(i,j)=1,否则Lt(i,j)=0。

1045:对第二预设时间内所有帧图像的连通矩阵Lt进行逐元素相加并对相加结果进行阈值化,得到当前帧图像的矩阵Lsum,矩阵Lsum中元素Lsum(i,j)的计算步骤为:如果阈值化结果大于第三阈值,则Lsum(i,j)=1,否则Lsum(i,j)=0,Lsum(i,j)=1表示第i个跟踪区域与第j个跟踪区域之间存在连接。

其中第三阈值的选取与第二预设时间内的图像总帧数有关,优选为0.7*(d+1),d+1为第二预设时间内的图像总帧数,d为在第二预设时间内除当前

帧图像之外,当前侦图像之前连续的预设数量的帧图像,在获取当前图像的矩阵Lsum所使用的第二预设时间内所有帧图像与步骤1031中寻找不变邻域所用到的所有帧图像相同。

1046:依据矩阵Lsum将存在连接的至少两个所述跟踪区域划分成一个群组,以得到多个群组。

在本发明实施例中,图8所示图像经过图9所示流程处理后,得到的群组示意图如图10所示,其中不同线条所示方框代表不同群组,这样存在连接的至少两个跟踪区域聚成一个群组。

请参阅图11,其示出了本发明实施例提供的目标跟踪方法中步骤105的流程图,可以包括以下步骤:

1051:将当前帧图像中的每个群组划分为两层,其中第1层为:当前帧图像中聚成群组的跟踪区域,第2层为:对每个群组中包含的关键点以大于不变邻域中第一预设个数的数值,重新构建得到的当前帧图像上的跟踪区域,不变邻域中第一预设个数为计算第1层的跟踪区域的运动矩阵使用的数值。在本发明实施例中第2层优选采用20个关键点重新构建跟踪区域。

经过上述群组的分层处理后,一帧图像被划分为两层,且第2层中跟踪区域的尺度大于第1层中跟踪区域的尺度,如图12所示,其示出了图10所示群组经过1051处理后得到的群组分层结果,从图12可以看出,第1层中相邻的跟踪区域容易被遮挡,而在第2层中相邻的跟踪区域被划分至一个跟踪区域中,解决跟踪区域彼此遮挡的问题,使得第2层中的跟踪区域(尺度大的跟踪区域)对遮挡具有更好的容忍度。

1052:对每个群组构建树型结构,所述树型结构通过对同一群组各层中的跟踪区域构建最小生成树,以及对同一群组不同层之间的具有重叠的跟踪区域相连接得到。在本发明实施例中,可利用现有技术,如kruskal(克鲁斯卡尔)算法或Prim(普里姆)算法构建最小生成树,图12所示群组分层所构建的最小生成树如图13所示。

并对图13所示最小生成树进行同群组不同层之间的重叠的跟踪区域相连

接,得到的树型结构如图14所示。

1053:采用公式对树型结构进行表观约束,其中m表示层数,Nm为当前帧第m层的跟踪区域总数,表示第m层的第i个跟踪区域,是从中提取的视觉特征向量,是视觉特征向量训练得到的线性支持向量机的权重,在训练线性支持向量机时,正样本为当前帧第m层的跟踪区域,负样本是正样本周围随机选择的背景区域。

1054:采用公式 对树型结构进行层内空间约束,其中Em表示树型结构中第m层中相连接的跟踪区域对总数,和表示下一帧中第m层的第i个跟踪区域和第j个跟踪区域的位置坐标,为第一预设常数,优选取值为0.001,为第i个跟踪区域和第j个跟踪区域之间的期望距离,的初始值为第i个跟踪区域与第j个跟踪区域在当前帧图像上的距离,在后续图像帧中动态更新为第i个跟踪区域与第j个跟踪区域在当前帧的距离与前一次更新得到的期望距离的均值。

1055:采用公式对树型结构进行层间空间约束,其中Ec表示树型结构中第1层和第2层之间相连接的跟踪区域对总数,和表示下一帧第1层的第i个跟踪区域和第2层相连的第j个跟踪区域的位置坐标,λij为第二预设常数,优选取值为0.001,eij为第1层的第i个跟踪区域和第2层相连的第j个跟踪区域之间的期望距离,eij的初始值为第1层的第i个跟踪区域与第2层相连的第j个跟踪区域在当前帧图像上的距离,在后续图像帧中动态更新为第1层的第i个跟踪区域与第2层相连的第j个跟

踪区域在当前帧的距离与前一次更新得到的期望距离的均值。

上述步骤1053至1055给出对树型结构的约束过程,通过上述约束过程中的公式可以得到跟踪区域在下一帧图像中的位置,而待跟踪区域为一个跟踪区域,跟踪目标位于待跟踪区域中,因此在得到跟踪区域在下一帧图像中的位置后即得到跟踪目标在下一帧图像中的位置。

在采用上述步骤1053至1055对树型结构进行优化时,可以忽略对第2层跟踪区域的层内优化,将优化后的第1层跟踪区域的位置进行固定,优化第1层跟踪区域和第2层跟踪区域之间的层间关系以完成对第2层跟踪区域的优化,这样可以降低优化量。

利用本发明实施例提供的目标跟踪方法对图2所示的真实场景进行跟踪,不同时间下跟踪结果可以参阅图15至18所示,其中图15至图18为按时间顺序抽取的前后四帧图像的跟踪结果,并且为了清楚显示跟踪结果仅给出了第1层辅助跟踪区域,圆角方框并填充灰色的部分表示跟踪目标的待跟踪区域,其它方框表示第1层的辅助跟踪区域,不同跟踪区域之间的连线表示不断演化的群组及层内的树型结构。从图15至图18可以看出在跟踪目标具有遮挡、跟踪目标与其他目标之间外观十分接近、角度等原因引起跟踪目标外观经常变化的情况下,采用本发明实施例提供的目标跟踪方法依然能得到准确的跟踪结果。

以Error(跟踪位置像素误差)和Recall(跟踪正确率,跟踪区域有50%以上和真实区域有重叠,就认为跟踪正确)作为实验指标。本发明实施例提供的目标跟踪方法的单目标跟踪Error约4.5个像素,比现有技术中的最好结果精确约19个像素;本发明实施例提供的目标跟踪方法的单目标跟踪Recall约92%,比现有技术中的最好结果提高30%。本发明实施例提供的目标跟踪方法的多目标跟踪平均Error约5.7个像素,比现有技术中的最好结果精确约10个像素;本发明实施例提供的目标跟踪方法的多目标跟踪平均Recall约89%,比现有技术中的最好结果提高16%。

与上述方法实施例相对应,本发明实施例还提供一种目标跟踪装置,其结构示意图如图19所示,可以包括:第一获取单元11、第二获取单元12、第三

获取单元13、划分单元14和跟踪单元15。其中,

第一获取单元11,用于获取跟踪目标在当前帧图像上的待跟踪区域。其中跟踪目标是当前帧图像上需要进行位置跟踪的对象,待跟踪区域是跟踪目标在当前帧图像上的所占区域,可以从当前帧图像开始跟踪跟踪目标在后续帧上的位置。后续帧是在当前帧图像之后获取到的多帧图像,后续帧可以是预先指定的预设数量的图像,后续帧也可以是当前所要跟踪的在线视频中,从当前帧图像开始到在线视频播放结束之间的图像。

在本发明实施例中,待跟踪区域的获取方式可以有手工定位和自动定位两种,具体可以参阅方法部分说明,对此装置实施例不再详述。

第二获取单元12,用于在当前帧图像中确定多个关键点,获取每个关键点的位置。在本发明实施例中,关键点是图像中具有显著视觉特征的点,比如图像中的角点、边缘点等。关键点的确定及位置获取可以通过现有算法,如KLT(Kanade-Lucas-Tomasi,关键点跟踪)算法,其算法过程如下:

首先,预先设定在当前帧图像中要确定的关键点个数M,其中M是一经验值,在跟踪目标所在场景较复杂的情况下,M的取值较大;在跟踪目标所在场景较简单的情况下,M的取值较小。一般情况下,当前帧图像中的每个对象上至少要有三个关键点;

其次,获取当前帧图像之前连续的预设数量的帧图像,如当前帧图像为第t+d帧,之前预设数帧图像为t+d-1帧、t+d-2帧、……、第t帧,即获取当前帧图像之前连续的d帧图像,d优选为10。从第t帧图像自动检测关键点,并将检测到的关键点按照特征的显著程度进行排序,从中选取特征最显著的前M个关键点作为初始化的关键点集合,其中显著程度是KLT算法中用于衡量关键点重要性的一个特征量,对此不再过多阐述;

然后,优化关键点集合:计算关键点集合中各个关键点在第t+1帧图像中的位置以及各个关键点在第t帧和第t+1帧之间的匹配程度,如果匹配程度小于匹配阈值(关键点被遮挡会导致匹配程度降低),则丢弃匹配程度小于匹配阈值的关键点,并重新在第t+1帧上自动检测关键点,在检测到的关键点中选取特征最显著的关键点加入到关键点集合中,以保证关键点集合中关键点个数

为M;

对后续第t+2帧至第t+d帧图像依次执行优化关键点集合这一步骤,从而依据相邻两帧图像中关键点的匹配程度优化关键点集合,得到第t+d帧图像上的关键点以及每个关键点的位置,即得到当前帧图像上的关键点及每个关键点的位置,如图4所示,关键点跟踪优化从第t帧开始至第t+d帧为止,其示出了从第t帧至第t+d帧关键点的变化,图中的圆点为关键点。

第三获取单元13,用于基于每个关键点的位置,得到当前帧图像上的辅助跟踪区域,辅助跟踪区域用于辅助跟踪所述跟踪目标在后续帧上的位置。

划分单元14,用于依据待跟踪区域和辅助跟踪区域的运动轨迹,将待跟踪区域和辅助跟踪区域划分成多个群组。在本发明实施例中,待跟踪区域的运动轨迹可以由跟踪目标的运动轨迹决定,辅助跟踪区域的运动轨迹可以由位于该辅助跟踪区域的关键点的运动轨迹决定,跟踪目标的运动轨迹和关键点的运动轨迹可以由运动方向和运动速度指示。

在将待跟踪区域和辅助跟踪区域进行划分时,可以将具有相同运动轨迹的区域划分至一个群组中以得到多个群组,也可以综合考虑多帧图像中待跟踪区域和辅助跟踪区域的运动轨迹进行划分。

跟踪单元15,用于对每个群组建立空间结构模型,根据空间结构模型得到待跟踪区域在下一帧图像中的位置,其中下一帧图像是在当前帧图像之后捕获到的图像,是从捕获时间来看与当前帧图像相邻且位于当前帧图像之后的图像。

对于待跟踪目标来说,待跟踪区域内仅包括跟踪目标,因此在得到待跟踪区域在下一帧图像中的位置后,位于待跟踪区域内的跟踪目标的位置也可以得到,并且可以将待跟踪区域在下一帧图像中的位置作为跟踪目标在下一帧图像中的位置。

在本发明实施例中,每个群组的空间结构模型可以采用现有算法建立,再利用现有动态规划算法对空间结构模型进行约束以得到待跟踪区域在下一帧图像中的位置,其中空间结构模型是得到每个群组内待跟踪区域和辅助跟踪区域的两层空间图形来展示每个群组内待跟踪区域和辅助跟踪区域的位置关系,

其中两层空间图形包括:第1层待跟踪区域、第1层辅助跟踪区域、第2层待跟踪区域和第2层辅助跟踪区域。

在利用动态规划算法对空间结构模型进行约束时,可以采用循环迭代方式对空间结构模型中群组的两层空间图形进行层内优化和层间优化。进一步在进行层内优化和层间优化时,可以首先优化群组的第1层,然后将优化后的第1层的位置进行固定,再优化第1层和第2层的层间关系。由于在进行层内优化时省去了第2层的优化,所以降低了优化量,节省优化时间。

本发明实施例可以首先在当前帧图像上获取跟踪目标的待跟踪区域和用于辅助跟踪的辅助跟踪区域,依据待跟踪区域和辅助跟踪区域的运动轨迹,将待跟踪区域和辅助跟踪区域划分成多个群组,再对每个群组建立空间结构模型,根据空间结构模型得到待跟踪区域在下一帧图像中的位置,在得到待跟踪区域在下一帧图像中的位置后,位于待跟踪区域内的跟踪目标在下一帧图像中的位置也被得到。相对于现有基于模型的目标跟踪方法来说,本发明实施例提供的目标跟踪方法可以在在线视频的当前帧图像上进行操作,实现在线跟踪。

下面详细介绍本发明实施例提供的目标跟踪装置中第三获取单元13、划分单元14和跟踪单元15的结构,其中第三获取单元13的结构示意图请参阅图20所示,包括:计算子单元131、模型建立子单元132、划分子单元133和构建子单元134。

计算子单元131,用于基于每个关键点的位置,计算当前帧图像的运动矩阵。其中当前帧图像的运动矩阵中元素Ci,j的取值的决定因素之一为:关键点之间在当前帧图像和当前帧图像之前连续的预设数量的帧图像的位置关系,该位置关系可以为关键点的不变邻域。

不变邻域是:在连续的预设数量的帧图像中每个关键点的第一预设个数的最近邻关键点的交集,最近邻关键点为距离所要寻找不变邻域的关键点最近的关键点,在本发明实施例中第一预设个数优选为10。连续的预设数量的帧图像为在执行步骤102确定关键点是所参考的帧图像,即获取当前帧图像之前的d帧图像,预设数量优选为10。

在本发明实施例中,计算子单元131包括:获取子单元和元素取值计算子

单元,其中,获取子单元,用于寻找当前帧图像中每个关键点的不变邻域,其中不变邻域是:在连续的预设数量的帧图像中每个关键点的第一预设个数的最近邻关键点的交集,最近邻关键点为距离所要寻找不变邻域的关键点最近的关键点。

元素取值计算子单元,用于为当前帧图像构建运动矩阵,并计算运动矩阵中每个元素Ci,j的取值,其中计算步骤包括:如果第j个关键点属于第i个关键点的不变邻域,则其中t和t+d为第二预设时间内连续跟踪的开始帧和结束帧,表示第i个关键点在第τ帧的瞬时运动速度矢量,表示第j个关键点在第τ帧的瞬时运动速度矢量。如果第j个关键点不属于第i个关键点的不变邻域,则Ci,j=0。

模型建立子单元132,用于依据当前帧图像的运动矩阵,得到当前帧图像的图模型。模型建立子单元包括:节点获取子单元和边长计算子单元,其中节点获取子单元,用于将当前帧图像中的关键点作为当前帧图像的图模型的节点。

边长计算子单元,用于计算任意两个节点之间的连线构成的图模型的边长,边长的计算步骤包括:如果运动矩阵中第i行第j列的元素Ci,j和第j列第i行的元素Cj,i都大于第一阈值,则第i个关键点和第j个关键点之间的边Gi,j=1,图模型的边长dist(i,j)是第i个关键点和第j个关键点之间的距离,如果运动矩阵中第i行第j列的元素Ci,j和/或第j列第i行的元素Cj,i小于等于第一阈值,则图模型的边长第一阈值为一经验值,具体取值可以基于应用场景设定,取值范围可以在(0.5,1)区间内,优选为0.8。

划分子单元133,用于基于图模型将关键点划分成多个集合。

本发明实施例中,划分子单元133对关键点进行划分时可以采用现有的基于图模型的聚类方法对关键点进行划分。在进行划分时首先将图模型中的作为节点的每个关键点各自划分为一类,并迭代计算任意两个类之间的密切程度,然后将密切程度最高的两个类划分为一个集合,当聚集度达到最大时,停止聚类,将当前聚类的结果当作划分的结果,得到划分后的多个集合。其中类间的密切程度根据构建的图模型的边进行计算,聚集度同样基于构建的图模型的边进行计算。

构建子单元134,用于为每个集合构建一个辅助跟踪区域,其中辅助跟踪区域的中心点的x轴坐标为集合内的所有关键点的x轴坐标的均值,辅助跟踪区域的中心点的y轴坐标为集合内的所有关键点的y轴坐标的均值,辅助跟踪区域在x轴方向的宽度为集合内的所有关键点的x轴坐标的标准差的N倍,辅助跟踪区域在y轴方向的宽度为集合内的所有关键点的y轴坐标的标准差的N倍,N为大于1的实数,优选为2。

在本发明实施例中,划分单元14的结构示意图可以参阅图21,包括:第一计算子单元141、标记子单元142、轨迹获取子单元143、第二计算子单元144、第三计算子单元145和划分子单元146,其中,

第一计算子单元141,用于计算当前帧图像上每个关键点的瞬时运动矢量,并基于瞬时运动矢量,计算每个关键点与第二预设个数的最近邻关键点之间的运动相关性,其中最近邻关键点是:在连续的预设数量的帧图像中与关键点距离最近的关键点。连续的预设数量的帧图像为在执行步骤102确定关键点是所参考的帧图像,即获取当前帧图像之前的d帧图像,预设数量优选为10。

瞬时运动速度矢量是一个关键点在相邻两帧上的位置差。如关键点在τ帧上的位置是(x1,y1),关键点在τ-1帧的位置为(x0,y0),则瞬时运动速度矢量是(x1-x0,y1-y0)。运动相关性则是指两个关键点之间速度大小和方向的相似性,可以采用瞬时运动速度矢量之间的夹角余弦值表示。

标记子单元142,用于当当前帧图像上任意两个关键点之间的运动相关性大于第二阈值时,为大于第二阈值的两个关键点标记为相同的运动轨迹。第二

阈值为一经验值,具体取值可以基于应用场景设定,例如第二阈值取值范围为(0.02,0.04)这一区间范围,对此本发明实施例不加以限制。

轨迹获取子单元143,用于将待跟踪区域和辅助跟踪区域作为跟踪区域,并获取每个跟踪区域的运动轨迹,跟踪区域的运动轨迹为跟踪区域内最多关键点所标记的运动轨迹。

比如某个跟踪区域中包括十个关键点,其中有两个关键点的运动轨迹为第一种运动轨迹,三个关键点的运动轨迹为第二种运动轨迹,五个关键点的运动轨迹为第三种运动轨迹,那么就取最多关键点标记的运动轨迹作为这个跟踪区域的运动轨迹,即第三种运动轨迹。

第二计算子单元144,用于计算当前帧图像的连通矩阵Lt,连通矩阵Lt中第i行第j列元素Lt(i,j)的计算步骤为:如果第i个跟踪区域和第j个跟踪区域的运动轨迹相同,则Lt(i,j)=1,否则Lt(i,j)=0。

第三计算子单元145,用于对第二预设时间内所有帧图像的连通矩阵Lt进行逐元素相加并对相加结果进行阈值化,得到当前帧图像的矩阵Lsum,矩阵Lsum中元素Lsum(i,j)的计算步骤为:如果阈值化结果大于第三阈值,则Lsum(i,j)=1,否则Lsum(i,j)=0,Lsum(i,j)=1表示第i个跟踪区域与第j个跟踪区域之间存在连接。

其中第三阈值的选取与第二预设时间内的图像总帧数有关,优选为0.7*(d+1),d+1为第二预设时间内的图像总帧数,d为在第二预设时间内除当前帧图像之外,当前侦图像之前连续的预设数量的帧图像,在获取当前图像的矩阵Lsum所使用的第二预设时间内所有帧图像与步骤1031中寻找不变邻域所用到的所有帧图像相同。

划分子单元146,用于依据矩阵Lsum将存在连接的至少两个跟踪区域划分成一个群组,以得到多个群组。

在本发明实施例中,跟踪单元15的结构示意图可以参阅图22所示,包括:群组分层子单元151、结构构建子单元152和跟踪子单元153,其中,

群组分层子单元151,用于将当前帧图像中的每个群组划分为两层,其中第1层为:当前帧图像中聚成群组的跟踪区域,第2层为:分别对每个群组中

包含的关键点,以大于不变邻域中第一预设个数的数值,重新构建得到的当前帧图像上的跟踪区域,不变邻域中第一预设个数为计算第1层的跟踪区域的运动矩阵使用的数值,在本发明实施例中第2层优选采用20个关键点重新构建跟踪区域。

由于第2层跟踪区域的尺度大于第1层跟踪区域的尺度,所以当第2层可能会将第1层中相邻且存在遮挡的至少两个跟踪区域划分至同一个跟踪区域中,从而降低第2层跟踪区域的遮挡概率。

结构构建子单元152,用于对每个群组构建树型结构,树型结构通过对同一群组各层中的跟踪区域构建最小生成树,以及对同一群组不同层之间的具有重叠的跟踪区域相连接得到。在本发明实施例中,可利用现有技术,如kruskal(克鲁斯卡尔)算法或Prim(普里姆)算法构建最小生成树,图12所示群组分层所构建的最小生成树如图13所示。

跟踪子单元153,用于对树型结构进行约束,以得到跟踪区域在下一帧图像中的位置,对树型结构进行约束包括:

采用公式对树型结构进行表观约束,其中m表示层数,Nm为当前帧第m层的跟踪区域总数,表示第m层的第i个跟踪区域,是从中提取的视觉特征向量,是视觉特征向量训练得到的线性支持向量机的权重,在训练线性支持向量机时,正样本为当前帧第m层的跟踪区域,负样本是正样本周围随机选择的背景区域。

采用公式 对树型结构进行层内空间约束,其中Em表示树型结构中第m层中相连接的跟踪区域对总数,和表示下一帧中第m层的第i个跟踪区域和第j个跟踪区域的位置坐标,为第一预设常数,为第i个跟踪区域和第j个跟踪区域之间的期望距离,的初始值为第i个跟踪区域与第j个跟踪区域在当前帧图像上的距离,在后续图

像帧中动态更新为第i个跟踪区域与第j个跟踪区域在当前帧的距离与前一次更新得到的期望距离的均值

采用公式对树型结构进行层间空间约束,其中Ec表示树型结构中第1层和第2层之间相连接的跟踪区域对总数,和表示下一帧第1层的第i个跟踪区域和第2层相连的第j个跟踪区域的位置坐标,λij为第二预设常数,eij为第1层的第i个跟踪区域和第2层相连的第j个跟踪区域之间的期望距离,eij的初始值为第1层的第i个跟踪区域与第2层相连的第j个跟踪区域在当前帧图像上的距离,在后续图像帧中动态更新为第1层的第i个跟踪区域与第2层相连的第j个跟踪区域在当前帧的距离与前一次更新得到的期望距离的均值。

请参阅图23,其示出了本发明实施例提供的目标跟踪设备的结构示意图,目标跟踪设备200在硬件上可包括CPU(Central Processing Unit,中央处理单元)201和存储器202。其中,CPU201通过运行存储在存储器202内的软件程序203以及调用存储在存储器202内的数据,至少可执行如下步骤:

获取跟踪目标在当前帧图像上的待跟踪区域;

在所述当前帧图像中确定多个关键点,获取每个所述关键点的位置;

基于所述每个所述关键点的位置,得到当前帧图像上的辅助跟踪区域,所述辅助跟踪区域用于辅助跟踪所述跟踪目标在后续帧上的位置;

依据所述待跟踪区域和所述辅助跟踪区域的运动轨迹,将所述待跟踪区域和所述辅助跟踪区域划分成多个群组;

对每个所述群组建立空间结构模型,根据所述空间结构模型得到所述待跟踪区域在下一帧图像中的位置。

上述各个步骤的详细执行过程参见本文前述方法的介绍,在此不作赘述。

上述存储器具体可为DDR SDRAM(Double Data Rate SDRAM,双倍速率

同步动态随机存储器)、SRAM(Static RAM,静态随机存储器)、FLASH(闪存)、SSD(Solid State Drive,固态硬盘)等,其主要包括程序存储区和数据存储区,其中,程序存储区可存储操作系统,以及至少一个功能所需的应用程序(例如上述软件程序203)等;数据存储区可存储根据CPU的执行情况而最终产生的数据,至于CPU在执行上述步骤所产生的中间数据,则存储在内存中。CPU201和存储器202可集成于同一芯片内,也可为独立的两个器件。

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。

对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

Claims (12)

- 一种目标跟踪方法,其特征在于,包括:获取跟踪目标在当前帧图像上的待跟踪区域;在所述当前帧图像中确定多个关键点,获取每个所述关键点的位置;基于所述每个所述关键点的位置,得到当前帧图像上的辅助跟踪区域,所述辅助跟踪区域用于辅助跟踪所述跟踪目标在后续帧上的位置;依据所述待跟踪区域和所述辅助跟踪区域的运动轨迹,将所述待跟踪区域和所述辅助跟踪区域划分成多个群组;对每个所述群组建立空间结构模型,根据所述空间结构模型得到所述待跟踪区域在下一帧图像中的位置。

- 根据权利要求1所述的方法,其特征在于,基于每个所述关键点的位置,得到当前帧图像上的辅助跟踪区域,包括:基于每个所述关键点的位置,计算所述当前帧图像的运动矩阵;依据所述当前帧图像的所述运动矩阵,得到所述当前帧图像的图模型;基于所述图模型将所述关键点划分成多个集合;为每个集合构建一个辅助跟踪区域,其中所述辅助跟踪区域的中心点的x轴坐标为所述集合内的所有关键点的x轴坐标的均值,所述辅助跟踪区域的中心点的y轴坐标为所述集合内的所有关键点的y轴坐标的均值,所述辅助跟踪区域在x轴方向的宽度为所述集合内的所有关键点的x轴坐标的标准差的N倍,所述辅助跟踪区域在y轴方向的宽度为所述集合内的所有关键点的y轴坐标的标准差的N倍,N为大于1的实数。

- 根据权利要求2所述的方法,其特征在于,基于每个所述关键点的位置,计算所述当前帧图像的运动矩阵,包括:寻找当前帧图像中每个关键点的不变邻域,其中不变邻域是:在连续的预设数量的帧图像中每个所述关键点的第一预设个数的最近邻关键点的交集,所述最近邻关键点为距离所要寻找不变邻域的所述关键点最近的关键点;为当前帧图像构建运动矩阵,并计算运动矩阵中每个元素Ci,j的取值,其中计算步骤包括:如果第j个关键点不属于第i个关键点的不变邻域,则Ci,j=0。

- 根据权利要求2所述的方法,其特征在于,依据所述待跟踪区域和所述辅助跟踪区域的运动轨迹,将所述待跟踪区域和所述辅助跟踪区域划分成多个群组,包括:计算当前帧图像上每个关键点的瞬时运动矢量,并基于所述瞬时运动矢量,计算每个所述关键点与第二预设个数的最近邻关键点之间的运动相关性,其中最近邻关键点是:在连续的预设数量的帧图像中与所述关键点距离最近的关键点;当当前帧图像上任意两个所述关键点之间的运动相关性大于第二阈值时,为大于第二阈值的两个所述关键点标记为相同的运动轨迹;将所述待跟踪区域和所述辅助跟踪区域作为跟踪区域,并获取每个所述跟踪区域的运动轨迹,所述跟踪区域的运动轨迹为所述跟踪区域内最多关键点所标记的运动轨迹;计算当前帧图像的连通矩阵Lt,所述连通矩阵Lt中第i行第j列元素Lt(i,j)的计算步骤为:如果第i个跟踪区域和第j个跟踪区域的运动轨迹相同,则Lt(i,j)=1,否则Lt(i,j)=0;对第二预设时间内所有帧图像的所述连通矩阵Lt进行逐元素相加并对相加结果进行阈值化,得到当前帧图像的矩阵Lsum,矩阵Lsum中元素Lsum(i,j)的计算步骤为:如果阈值化结果大于第三阈值,则Lsum(i,j)=1,否则Lsum(i,j)=0,Lsum(i,j)=1表示第i个跟踪区域与第j个跟踪区域之间存在连接;依据矩阵Lsum将存在连接的至少两个所述跟踪区域划分成一个群组,以得到多个群组。

- 根据权利要求5所述的方法,其特征在于,对每个所述群组建立空间结构模型,根据所述空间结构模型得到所述待跟踪区域在下一帧图像中的位置,包括:将当前帧图像中的每个群组划分为两层,其中第1层为:当前帧图像中聚成所述群组的所述跟踪区域,第2层为:分别对每个群组中包含的关键点,以大于不变邻域中第一预设个数的数值,重新构建得到的当前帧图像上的所述跟踪区域,不变邻域中第一预设个数为计算所述第1层的跟踪区域的运动矩阵使用的数值;对每个群组构建树型结构,所述树型结构通过对同一群组各层中的所述跟踪区域构建最小生成树,以及对同一群组不同层之间的具有重叠的跟踪区域相连接得到;对所述树型结构进行约束,以得到所述跟踪区域在下一帧图像中的位置,对所述树型结构进行约束包括:采用公式对所述树型结构进行表观约束,其中m表示层数,Nm为当前帧第m层的跟踪区域总数,表示第m层的第 i个跟踪区域,是从中提取的视觉特征向量,是视觉特征向量训练得到的线性支持向量机的权重,在训练线性支持向量机时,正样本为当前帧第m层的跟踪区域,负样本是正样本周围随机选择的背景区域;采用公式

- 一种目标跟踪装置,其特征在于,包括:第一获取单元,用于获取跟踪目标在当前帧图像上的待跟踪区域;第二获取单元,用于在所述当前帧图像中确定多个关键点,获取每个所述 关键点的位置;第三获取单元,用于基于所述每个所述关键点的位置,得到当前帧图像上的辅助跟踪区域,所述辅助跟踪区域用于辅助跟踪所述跟踪目标在后续帧上的位置;划分单元,用于依据所述待跟踪区域和所述辅助跟踪区域的运动轨迹,将所述待跟踪区域和所述辅助跟踪区域划分成多个群组;跟踪单元,用于对每个所述群组建立空间结构模型,根据所述空间结构模型得到所述待跟踪区域在下一帧图像中的位置。

- 根据权利要求7所述的装置,其特征在于,所述第三获取单元包括:计算子单元,用于基于每个所述关键点的位置,计算所述当前帧图像的运动矩阵;模型建立子单元,用于依据所述当前帧图像的所述运动矩阵,得到所述当前帧图像的图模型;划分子单元,用于基于所述图模型将所述关键点划分成多个集合;构建子单元,用于为每个集合构建一个辅助跟踪区域,其中所述辅助跟踪区域的中心点的x轴坐标为所述集合内的所有关键点的x轴坐标的均值,所述辅助跟踪区域的中心点的y轴坐标为所述集合内的所有关键点的y轴坐标的均值,所述辅助跟踪区域在x轴方向的宽度为所述集合内的所有关键点的x轴坐标的标准差的N倍,所述辅助跟踪区域在y轴方向的宽度为所述集合内的所有关键点的y轴坐标的标准差的N倍,N为大于1的实数。

- 根据权利要求8所述的装置,其特征在于,所述计算子单元包括:获取子单元,用于寻找当前帧图像中每个关键点的不变邻域,其中不变邻域是:在连续的预设数量的帧图像中每个所述关键点的第一预设个数的最近邻关键点的交集,所述最近邻关键点为距离所要寻找不变邻域的所述关键点最近的关键点;

- 根据权利要求8所述的装置,其特征在于,所述划分单元包括:第一计算子单元,用于计算当前帧图像上每个关键点的瞬时运动矢量,并基于所述瞬时运动矢量,计算每个所述关键点与第二预设个数的最近邻关键点之间的运动相关性,其中最近邻关键点是:在连续的预设数量的帧图像中与所述关键点距离最近的关键点;标记子单元,用于当当前帧图像上任意两个所述关键点之间的运动相关性大于第二阈值时,为大于第二阈值的两个所述关键点标记为相同的运动轨迹;轨迹获取子单元,用于将所述待跟踪区域和所述辅助跟踪区域作为跟踪区域,并获取每个所述跟踪区域的运动轨迹,所述跟踪区域的运动轨迹为所述跟 踪区域内最多关键点所标记的运动轨迹;第二计算子单元,用于计算当前帧图像的连通矩阵Lt,所述连通矩阵Lt中第i行第j列元素Lt(i,j)的计算步骤为:如果第i个跟踪区域和第j个跟踪区域的运动轨迹相同,则Lt(i,j)=1,否则Lt(i,j)=0;第三计算子单元,用于对第二预设时间内所有帧图像的所述连通矩阵Lt进行逐元素相加并对相加结果进行阈值化,得到当前帧图像的矩阵Lsum,矩阵Lsum中元素Lsum(i,j)的计算步骤为:如果阈值化结果大于第三阈值,则Lsum(i,j)=1,否则Lsum(i,j)=0,Lsum(i,j)=1表示第i个跟踪区域与第j个跟踪区域之间存在连接;划分子单元,用于依据矩阵Lsum将存在连接的至少两个所述跟踪区域划分成一个群组,以得到多个群组。

- 根据权利要求11所述的装置,其特征在于,所述跟踪单元包括:群组分层子单元,用于将当前帧图像中的每个群组划分为两层,其中第1层为:当前帧图像中聚成所述群组的所述跟踪区域,第2层为:分别对每个群组中包含的关键点,以大于不变邻域中第一预设个数的数值,重新构建得到的当前帧图像上的所述跟踪区域,不变邻域中第一预设个数为计算所述第1层的跟踪区域的运动矩阵使用的数值;结构构建子单元,用于对每个群组构建树型结构,所述树型结构通过对同一群组各层中的所述跟踪区域构建最小生成树,以及对同一群组不同层之间的具有重叠的跟踪区域相连接得到;跟踪子单元,用于对所述树型结构进行约束,以得到所述跟踪区域在下一帧图像中的位置,对所述树型结构进行约束包括:采用公式对所述树型结构进行表观约束,其中m表示层数,Nm为当前帧第m层的跟踪区域总数,表示第m层的第i个跟踪区域,是从中提取的视觉特征向量,是视觉特征向量训练得到的线性支持向量机的权重,在训练线性支持向量机时,正样本为当前 帧第m层的跟踪区域,负样本是正样本周围随机选择的背景区域;采用公式

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| CN201410449146.4A CN104376576B (zh) | 2014-09-04 | 2014-09-04 | 一种目标跟踪方法及装置 |

| CN201410449146.4 | 2014-09-04 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| WO2016034008A1 true WO2016034008A1 (zh) | 2016-03-10 |

Family

ID=52555466

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| PCT/CN2015/081920 WO2016034008A1 (zh) | 2014-09-04 | 2015-06-19 | 一种目标跟踪方法及装置 |

Country Status (2)

| Country | Link |

|---|---|

| CN (1) | CN104376576B (zh) |

| WO (1) | WO2016034008A1 (zh) |

Cited By (17)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN106127798A (zh) * | 2016-06-13 | 2016-11-16 | 重庆大学 | 基于自适应模型的稠密时空上下文目标跟踪方法 |

| CN108932726A (zh) * | 2017-05-22 | 2018-12-04 | 中兴通讯股份有限公司 | 一种目标跟踪方法及装置 |

| CN110378264A (zh) * | 2019-07-08 | 2019-10-25 | Oppo广东移动通信有限公司 | 目标跟踪方法及装置 |

| CN110717932A (zh) * | 2019-09-21 | 2020-01-21 | 南京鑫和汇通电子科技有限公司 | 一种实时跟踪的剪刀式刀闸状态的检测方法 |

| CN110892408A (zh) * | 2017-02-07 | 2020-03-17 | 迈恩德玛泽控股股份有限公司 | 用于立体视觉和跟踪的系统、方法和装置 |

| CN111008305A (zh) * | 2019-11-29 | 2020-04-14 | 百度在线网络技术(北京)有限公司 | 一种视觉搜索方法、装置以及电子设备 |

| CN111161321A (zh) * | 2019-12-31 | 2020-05-15 | 北京理工大学重庆创新中心 | 一种基于背景感知的相关滤波跟踪方法 |

| CN111242972A (zh) * | 2019-12-23 | 2020-06-05 | 中国电子科技集团公司第十四研究所 | 一种在线跨尺度多流体目标匹配跟踪方法 |

| CN111488774A (zh) * | 2019-01-29 | 2020-08-04 | 北京搜狗科技发展有限公司 | 一种图像处理方法、装置和用于图像处理的装置 |

| CN111898471A (zh) * | 2020-07-09 | 2020-11-06 | 北京捷通华声科技股份有限公司 | 一种行人跟踪方法和装置 |

| CN111954055A (zh) * | 2020-07-01 | 2020-11-17 | 北京达佳互联信息技术有限公司 | 视频特效的展示方法、装置、电子设备及存储介质 |

| CN111986224A (zh) * | 2020-08-05 | 2020-11-24 | 七海行(深圳)科技有限公司 | 一种目标行为预测追踪方法及装置 |

| CN112084372A (zh) * | 2020-09-14 | 2020-12-15 | 北京数衍科技有限公司 | 行人轨迹更新方法及装置 |

| CN113516017A (zh) * | 2021-04-22 | 2021-10-19 | 平安科技(深圳)有限公司 | 服药过程的监督方法、装置、终端设备及存储介质 |

| CN117633289A (zh) * | 2023-07-17 | 2024-03-01 | 邵阳航天长峰信息科技有限公司 | 基于人脸识别的信息化业务管理系统 |

| CN117853759A (zh) * | 2024-03-08 | 2024-04-09 | 山东海润数聚科技有限公司 | 一种多目标跟踪方法、系统、设备和存储介质 |

| US11989340B2 (en) | 2017-01-19 | 2024-05-21 | Mindmaze Group Sa | Systems, methods, apparatuses and devices for detecting facial expression and for tracking movement and location in at least one of a virtual and augmented reality system |

Families Citing this family (19)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN104376576B (zh) * | 2014-09-04 | 2018-06-05 | 华为技术有限公司 | 一种目标跟踪方法及装置 |

| CN105184811B (zh) * | 2015-05-25 | 2017-02-22 | 西北工业大学 | 一种基于结构支持向量机的多尺度目标跟踪方法 |

| CN106331511A (zh) * | 2016-11-16 | 2017-01-11 | 广东欧珀移动通信有限公司 | 智能终端跟踪拍摄的方法和装置 |

| CN106846362B (zh) * | 2016-12-26 | 2020-07-24 | 歌尔科技有限公司 | 一种目标检测跟踪方法和装置 |

| CN107392937B (zh) | 2017-07-14 | 2023-03-14 | 腾讯科技(深圳)有限公司 | 目标跟踪方法、装置及电子设备 |

| CN108010052A (zh) * | 2017-10-13 | 2018-05-08 | 西安天和防务技术股份有限公司 | 复杂场景中的目标跟踪方法及系统、存储介质及电子终端 |

| CN108230357B (zh) * | 2017-10-25 | 2021-06-18 | 北京市商汤科技开发有限公司 | 关键点检测方法、装置、存储介质和电子设备 |

| CN107952240B (zh) * | 2017-11-30 | 2021-01-08 | 北京奇虎科技有限公司 | 利用自拍杆实现的游戏控制方法、装置及计算设备 |

| CN108574846B (zh) * | 2018-05-18 | 2019-03-08 | 中南民族大学 | 一种视频压缩域目标跟踪方法和系统 |

| CN108834077B (zh) * | 2018-07-04 | 2020-06-05 | 北京邮电大学 | 基于用户移动特性的跟踪区划分方法、装置及电子设备 |

| CN109583391B (zh) * | 2018-12-04 | 2021-07-16 | 北京字节跳动网络技术有限公司 | 关键点检测方法、装置、设备及可读介质 |

| CN111383247A (zh) * | 2018-12-29 | 2020-07-07 | 北京易讯理想科技有限公司 | 增强金字塔lk光流算法图像跟踪稳定性的方法 |

| CN110414514B (zh) * | 2019-07-31 | 2021-12-07 | 北京字节跳动网络技术有限公司 | 图像处理方法及装置 |

| CN113269013B (zh) * | 2020-02-17 | 2024-06-07 | 京东方科技集团股份有限公司 | 对象行为分析方法、信息显示方法及电子设备 |

| CN111523447B (zh) * | 2020-04-22 | 2023-01-31 | 北京邮电大学 | 车辆跟踪方法、装置、电子设备及存储介质 |

| CN111798483B (zh) * | 2020-06-28 | 2023-04-25 | 浙江大华技术股份有限公司 | 一种抗遮挡行人跟踪的方法、装置及存储介质 |

| CN112069879B (zh) * | 2020-07-22 | 2024-06-07 | 深圳市优必选科技股份有限公司 | 一种目标人物跟随方法、计算机可读存储介质及机器人 |

| CN112070803A (zh) * | 2020-09-02 | 2020-12-11 | 安徽工程大学 | 一种基于ssd神经网络模型的无人船路径跟踪方法 |

| CN113256686B (zh) * | 2021-06-28 | 2021-10-08 | 上海齐感电子信息科技有限公司 | 视觉准确目标跟踪系统及方法 |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN101394546A (zh) * | 2007-09-17 | 2009-03-25 | 华为技术有限公司 | 视频目标轮廓跟踪方法及装置 |

| CN103455797A (zh) * | 2013-09-07 | 2013-12-18 | 西安电子科技大学 | 航拍视频中运动小目标的检测与跟踪方法 |

| CN103985136A (zh) * | 2014-03-21 | 2014-08-13 | 南京大学 | 一种基于局部特征点特征流型的目标跟踪方法 |

| CN104376576A (zh) * | 2014-09-04 | 2015-02-25 | 华为技术有限公司 | 一种目标跟踪方法及装置 |

Family Cites Families (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN102142147A (zh) * | 2010-01-29 | 2011-08-03 | 索尼公司 | 场地内容分析装置和方法及目标检测与跟踪装置和方法 |

-

2014

- 2014-09-04 CN CN201410449146.4A patent/CN104376576B/zh active Active

-

2015

- 2015-06-19 WO PCT/CN2015/081920 patent/WO2016034008A1/zh active Application Filing

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN101394546A (zh) * | 2007-09-17 | 2009-03-25 | 华为技术有限公司 | 视频目标轮廓跟踪方法及装置 |

| CN103455797A (zh) * | 2013-09-07 | 2013-12-18 | 西安电子科技大学 | 航拍视频中运动小目标的检测与跟踪方法 |

| CN103985136A (zh) * | 2014-03-21 | 2014-08-13 | 南京大学 | 一种基于局部特征点特征流型的目标跟踪方法 |

| CN104376576A (zh) * | 2014-09-04 | 2015-02-25 | 华为技术有限公司 | 一种目标跟踪方法及装置 |

Cited By (25)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN106127798A (zh) * | 2016-06-13 | 2016-11-16 | 重庆大学 | 基于自适应模型的稠密时空上下文目标跟踪方法 |

| US11989340B2 (en) | 2017-01-19 | 2024-05-21 | Mindmaze Group Sa | Systems, methods, apparatuses and devices for detecting facial expression and for tracking movement and location in at least one of a virtual and augmented reality system |

| CN110892408A (zh) * | 2017-02-07 | 2020-03-17 | 迈恩德玛泽控股股份有限公司 | 用于立体视觉和跟踪的系统、方法和装置 |

| US11991344B2 (en) | 2017-02-07 | 2024-05-21 | Mindmaze Group Sa | Systems, methods and apparatuses for stereo vision and tracking |

| CN108932726A (zh) * | 2017-05-22 | 2018-12-04 | 中兴通讯股份有限公司 | 一种目标跟踪方法及装置 |

| CN111488774A (zh) * | 2019-01-29 | 2020-08-04 | 北京搜狗科技发展有限公司 | 一种图像处理方法、装置和用于图像处理的装置 |

| CN110378264A (zh) * | 2019-07-08 | 2019-10-25 | Oppo广东移动通信有限公司 | 目标跟踪方法及装置 |

| CN110378264B (zh) * | 2019-07-08 | 2023-04-18 | Oppo广东移动通信有限公司 | 目标跟踪方法及装置 |

| CN110717932A (zh) * | 2019-09-21 | 2020-01-21 | 南京鑫和汇通电子科技有限公司 | 一种实时跟踪的剪刀式刀闸状态的检测方法 |

| CN111008305A (zh) * | 2019-11-29 | 2020-04-14 | 百度在线网络技术(北京)有限公司 | 一种视觉搜索方法、装置以及电子设备 |

| CN111008305B (zh) * | 2019-11-29 | 2023-06-23 | 百度在线网络技术(北京)有限公司 | 一种视觉搜索方法、装置以及电子设备 |

| CN111242972A (zh) * | 2019-12-23 | 2020-06-05 | 中国电子科技集团公司第十四研究所 | 一种在线跨尺度多流体目标匹配跟踪方法 |

| CN111161321A (zh) * | 2019-12-31 | 2020-05-15 | 北京理工大学重庆创新中心 | 一种基于背景感知的相关滤波跟踪方法 |

| CN111954055A (zh) * | 2020-07-01 | 2020-11-17 | 北京达佳互联信息技术有限公司 | 视频特效的展示方法、装置、电子设备及存储介质 |

| CN111898471B (zh) * | 2020-07-09 | 2024-06-07 | 北京捷通华声科技股份有限公司 | 一种行人跟踪方法和装置 |

| CN111898471A (zh) * | 2020-07-09 | 2020-11-06 | 北京捷通华声科技股份有限公司 | 一种行人跟踪方法和装置 |

| CN111986224A (zh) * | 2020-08-05 | 2020-11-24 | 七海行(深圳)科技有限公司 | 一种目标行为预测追踪方法及装置 |

| CN111986224B (zh) * | 2020-08-05 | 2024-01-05 | 七海行(深圳)科技有限公司 | 一种目标行为预测追踪方法及装置 |

| CN112084372A (zh) * | 2020-09-14 | 2020-12-15 | 北京数衍科技有限公司 | 行人轨迹更新方法及装置 |

| CN112084372B (zh) * | 2020-09-14 | 2024-01-26 | 北京数衍科技有限公司 | 行人轨迹更新方法及装置 |

| CN113516017B (zh) * | 2021-04-22 | 2023-07-11 | 平安科技(深圳)有限公司 | 服药过程的监督方法、装置、终端设备及存储介质 |

| CN113516017A (zh) * | 2021-04-22 | 2021-10-19 | 平安科技(深圳)有限公司 | 服药过程的监督方法、装置、终端设备及存储介质 |

| CN117633289A (zh) * | 2023-07-17 | 2024-03-01 | 邵阳航天长峰信息科技有限公司 | 基于人脸识别的信息化业务管理系统 |

| CN117853759A (zh) * | 2024-03-08 | 2024-04-09 | 山东海润数聚科技有限公司 | 一种多目标跟踪方法、系统、设备和存储介质 |

| CN117853759B (zh) * | 2024-03-08 | 2024-05-10 | 山东海润数聚科技有限公司 | 一种多目标跟踪方法、系统、设备和存储介质 |

Also Published As

| Publication number | Publication date |

|---|---|

| CN104376576B (zh) | 2018-06-05 |

| CN104376576A (zh) | 2015-02-25 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| WO2016034008A1 (zh) | 一种目标跟踪方法及装置 | |

| US20200151884A1 (en) | Video object tracking | |

| US9542621B2 (en) | Spatial pyramid pooling networks for image processing | |

| CN109960742B (zh) | 局部信息的搜索方法及装置 | |

| Shi et al. | Multiscale multitask deep NetVLAD for crowd counting | |

| Deng et al. | M3 csr: Multi-view, multi-scale and multi-component cascade shape regression | |

| Zhou et al. | Cascaded interactional targeting network for egocentric video analysis | |

| CN110363817B (zh) | 目标位姿估计方法、电子设备和介质 | |

| Wang et al. | Dynamic attention guided multi-trajectory analysis for single object tracking | |

| US9672634B2 (en) | System and a method for tracking objects | |

| Xia et al. | Loop closure detection for visual SLAM using PCANet features | |

| US20080240497A1 (en) | Method for tracking objects in videos using forward and backward tracking | |

| Liu et al. | Hierarchical ensemble of background models for PTZ-based video surveillance | |

| WO2015196281A1 (en) | System and method for visual event description and event analysis | |

| CN111047626B (zh) | 目标跟踪方法、装置、电子设备及存储介质 | |

| WO2021238548A1 (zh) | 区域识别方法、装置、设备及可读存储介质 | |

| CN111523463B (zh) | 基于匹配-回归网络的目标跟踪方法及训练方法 | |

| WO2023151237A1 (zh) | 人脸位姿估计方法、装置、电子设备及存储介质 | |

| JP7192143B2 (ja) | オンライン学習を利用した物体追跡のための方法およびシステム | |

| Li et al. | Depthwise nonlocal module for fast salient object detection using a single thread | |

| Huynh-The et al. | Hierarchical topic modeling with pose-transition feature for action recognition using 3D skeleton data | |

| US20210166009A1 (en) | Action localization using relational features | |

| Li et al. | Robust object tracking with discrete graph-based multiple experts | |

| Zhang et al. | Out-of-region keypoint localization for 6D pose estimation | |

| CN114495266A (zh) | 非站立姿态检测方法、装置、计算机设备及存储介质 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| 121 | Ep: the epo has been informed by wipo that ep was designated in this application |

Ref document number: 15838392 Country of ref document: EP Kind code of ref document: A1 |

|

| NENP | Non-entry into the national phase |

Ref country code: DE |

|

| 122 | Ep: pct application non-entry in european phase |

Ref document number: 15838392 Country of ref document: EP Kind code of ref document: A1 |