KR20230036282A - 이미지 센서, 이를 포함하는 이미지 처리 시스템 및 이미지 처리 방법 - Google Patents

이미지 센서, 이를 포함하는 이미지 처리 시스템 및 이미지 처리 방법 Download PDFInfo

- Publication number

- KR20230036282A KR20230036282A KR1020210118959A KR20210118959A KR20230036282A KR 20230036282 A KR20230036282 A KR 20230036282A KR 1020210118959 A KR1020210118959 A KR 1020210118959A KR 20210118959 A KR20210118959 A KR 20210118959A KR 20230036282 A KR20230036282 A KR 20230036282A

- Authority

- KR

- South Korea

- Prior art keywords

- image

- images

- exposure

- processing

- module

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Pending

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N25/00—Circuitry of solid-state image sensors [SSIS]; Control thereof

- H04N25/50—Control of the SSIS exposure

- H04N25/57—Control of the dynamic range

- H04N25/58—Control of the dynamic range involving two or more exposures

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/40—Extraction of image or video features

- G06V10/60—Extraction of image or video features relating to illumination properties, e.g. using a reflectance or lighting model

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/50—Image enhancement or restoration using two or more images, e.g. averaging or subtraction

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/70—Denoising; Smoothing

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/90—Dynamic range modification of images or parts thereof

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/90—Dynamic range modification of images or parts thereof

- G06T5/94—Dynamic range modification of images or parts thereof based on local image properties, e.g. for local contrast enhancement

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/10—Image acquisition

- G06V10/12—Details of acquisition arrangements; Constructional details thereof

- G06V10/14—Optical characteristics of the device performing the acquisition or on the illumination arrangements

- G06V10/141—Control of illumination

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/10—Image acquisition

- G06V10/12—Details of acquisition arrangements; Constructional details thereof

- G06V10/14—Optical characteristics of the device performing the acquisition or on the illumination arrangements

- G06V10/147—Details of sensors, e.g. sensor lenses

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/20—Image preprocessing

- G06V10/30—Noise filtering

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V10/00—Arrangements for image or video recognition or understanding

- G06V10/40—Extraction of image or video features

- G06V10/56—Extraction of image or video features relating to colour

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N25/00—Circuitry of solid-state image sensors [SSIS]; Control thereof

- H04N25/10—Circuitry of solid-state image sensors [SSIS]; Control thereof for transforming different wavelengths into image signals

- H04N25/11—Arrangement of colour filter arrays [CFA]; Filter mosaics

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N25/00—Circuitry of solid-state image sensors [SSIS]; Control thereof

- H04N25/60—Noise processing, e.g. detecting, correcting, reducing or removing noise

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N25/00—Circuitry of solid-state image sensors [SSIS]; Control thereof

- H04N25/70—SSIS architectures; Circuits associated therewith

- H04N25/71—Charge-coupled device [CCD] sensors; Charge-transfer registers specially adapted for CCD sensors

- H04N25/75—Circuitry for providing, modifying or processing image signals from the pixel array

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N5/00—Details of television systems

- H04N5/222—Studio circuitry; Studio devices; Studio equipment

- H04N5/262—Studio circuits, e.g. for mixing, switching-over, change of character of image, other special effects ; Cameras specially adapted for the electronic generation of special effects

- H04N5/265—Mixing

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10024—Color image

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10141—Special mode during image acquisition

- G06T2207/10144—Varying exposure

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20172—Image enhancement details

- G06T2207/20182—Noise reduction or smoothing in the temporal domain; Spatio-temporal filtering

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20172—Image enhancement details

- G06T2207/20208—High dynamic range [HDR] image processing

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20212—Image combination

- G06T2207/20221—Image fusion; Image merging

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Software Systems (AREA)

- Health & Medical Sciences (AREA)

- General Health & Medical Sciences (AREA)

- Vascular Medicine (AREA)

- Studio Devices (AREA)

- Image Processing (AREA)

Abstract

Description

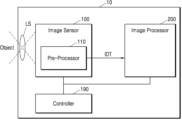

도 1은 본 개시의 예시적 실시예에 따른 이미지 처리 시스템을 나타내는 블록도이다.

도 2는 본 개시의 예시적 실시예에 따른 이미지 센서를 나타내는 블록도이다.

도 3은 본 개시의 예시적 실시예에 따른 이미지 처리 시스템을 설명하는 도면이다.

도 4a 및 도 4b는 본 개시의 예시적 실시예에 따른 이미지 처리 시스템에서 2개의 노출 이미지에 대한 HDR 처리 동작을 설명하는 도면이다.

도 5a 및 도 5b는 비교예에 따른 이미지 처리 시스템의 동작을 설명하는 도면이다.

도 6a은 본 개시의 예시적 실시예에 따른 이미지 처리 시스템에서 3개의 노출 이미지에 대한 HDR 처리 동작을 설명하는 도면이고, 도 6b는 비교예에 따른 이미지 처리 시스템에서 3개의 노출 이미지에 대한 HDR 처리 동작을 설명하는 도면이다.

도 7a 및 도 7b는 본 개시의 예시적 실시예에 따른 이미지 처리 시스템에서 혼합된 방식으로 HDR 처리를 수행하는 방법을 설명하는 도면이다.

도 8은 본 개시의 예시적 실시예에 따른 이미지 처리 방법을 설명하는 도면이다.

도 9는 본 개시의 예시적 실시예에 따른 이미지 처리 방법 중 RGB-W 이미지에 대한 HDR 처리 방법을 설명하는 도면이다.

도 10은 본 개시의 예시적 실시예에 따른 이미지 처리 방법을 설명하는 순서도이다.

도 11a는 이미지 센서의 분리 사시도이고, 도 11b는 이미지 센서의 평면도이다.

도 12는 멀티 카메라 모듈을 포함하는 전자 장치의 블록도이다.

도 13은 도 12의 카메라 모듈의 상세 블록도이다.

도 14는 본 개시의 예시적 실시예에 따른 이미지 처리 시스템을 나타내는 블록도이다.

Claims (20)

- 동일한 피사체에 대하여 노출 시간이 상이한 복수의 이미지들을 생성하는 센싱부;

상기 복수의 이미지들을 병합하여 병합 이미지를 생성하는 전처리부;

상기 복수의 이미지들 및 상기 병합 이미지 중 적어도 하나를 외부 프로세서로 출력하는 인터페이스 회로; 및

상기 복수의 이미지들의 정보에 기초하여 상기 병합 이미지가 선택적으로 생성되도록 상기 전처리부를 제어하는 컨트롤러;를 포함하는 이미지 센서. - 제1 항에 있어서,

상기 컨트롤러는 상기 복수의 이미지들의 촬영 기법 정보, 촬영 시간 간격 정보, 움직임 정보 중 적어도 하나에 기초하여 상기 전처리부에서 상기 병합 이미지 생성 여부를 판단하는 것을 특징으로 하는 이미지 센서. - 제1 항에 있어서,

상기 전처리부는 병합 이미지를 생성하기 전 상기 복수의 이미지들에 대해 사전 노이즈 처리를 수행하는 노이즈 처리 모듈을 포함하는 것을 특징으로 하는 이미지 센서. - 제3 항에 있어서,

상기 사전 노이즈 처리는 자이로 센서 데이터에 기초한 모션 보상을 포함하는 것을 특징으로 하는 이미지 센서 - 제1 항에 있어서,

상기 복수의 이미지들은 제1 노출 시간에 대응되는 장노출 이미지, 제2 노출 시간에 대응되는 중노출 이미지 및 제3 노출 시간에 대응되는 단노출 이미지를 포함하고,

상기 제1 노출 시간은 상기 제2 노출 시간보다 길고, 상기 제2 노출 시간은 상기 제3 노출 시간보다 긴 것을 특징으로 하는 이미지 센서. - 제5 항에 있어서,

상기 전처리부는 상기 중노출 이미지 및 상기 단노출 이미지에 기초하여 병합 이미지를 생성하고,

상기 인터페이스 회로는 상기 장노출 이미지 및 상기 병합 이미지를 외부 프로세서로 출력하는 것을 특징으로 하는 이미지 센서. - 제5 항에 있어서,

상기 전처리부는 상기 복수의 이미지들에 대하여 다이나믹 레인지를 증가시키는 HDR(High Dynamic Range)처리를 수행하는 제1 HDR 모듈을 포함하는 것을 특징으로 하는 이미지 센서. - 제7 항에 있어서,

상기 제1 HDR 모듈은 상기 장노출 이미지, 중노출 이미지 및 단노출 이미지의 이미지 정보에 기초하여 각각의 가중치를 결정하고, 상기 가중치에 따라 상기 장노출 이미지, 중노출 이미지 및 단노출 이미지를 병합하는 것을 특징으로 하는 이미지 센서. - 제1 항에 있어서,

상기 복수의 이미지들은 베이어 패턴 이미지, RGB-W 패턴 이미지를 포함하고,

상기 전처리부는 RGB-W 패턴 이미지를 처리하기 위한 RGB-W 패턴 처리 모듈을 더 포함하는 것을 특징으로 하는 이미지 센서. - 제1 항에 있어서,

상기 전처리부는 상기 복수의 이미지들의 일부 라인들에 해당하는 복수의 픽셀 값을 저장하는 라인 버퍼를 더 포함하고,

상기 센싱부는 라인 단위로 시분할 방식에 따라 상기 복수의 이미지를 상기 전처리부로 출력하는 것을 특징으로 하는 이미지 센서. - 동일한 피사체에 대하여 노출 시간이 상이한 복수의 이미지들을 생성하고, 상기 복수의 이미지들을 출력하는 이미지 센서;

상기 복수의 이미지들의 정보에 기초하여 병합 이미지 생성 여부를 판단하고, 상기 복수의 이미지들을 병합하여 다이나믹 레인지가 증가된 병합 이미지를 생성하는 제1 HDR 모듈; 및

상기 복수의 이미지들 또는 상기 병합 이미지를 수신하는 이미지 프로세서를 포하는 이미지 처리 시스템. - 제11 항에 있어서,

상기 제1 HDR 모듈은 상기 복수의 이미지들의 촬영 기법 정보, 촬영 시간 간격 정보, 움직임 정보 중 적어도 하나에 기초하여 병합 이미지 생성 여부를 판단하는 것을 특징으로 하는 이미지 처리 시스템. - 제11 항에 있어서,

상기 복수의 이미지들은 제1 노출 시간에 대응되는 장노출 이미지, 제2 노출 시간에 대응되는 중노출 이미지 및 제3 노출 시간에 대응되는 단노출 이미지를 포함하고,

상기 제1 노출 시간은 상기 제2 노출 시간보다 길고, 상기 제2 노출 시간은 상기 제3 노출 시간보다 긴 것을 특징으로 하는 이미지 처리 시스템. - 제13 항에 있어서,

상기 제1 HDR 모듈은 상기 중노출 이미지 및 상기 단노출 이미지에 기초하여 병합 이미지를 생성하고,

상기 이미지 프로세서는 상기 장노출 이미지 및 상기 병합 이미지를 수신하여 다이나믹 레인지 확장을 위한 영상 처리를 수행하는 것을 특징으로 하는 이미지 처리 시스템. - 제11 항에 있어서,

상기 복수의 이미지들은 베이어 패턴 이미지, RGB-W 패턴 이미지를 포함하고,

상기 RGB-W 패턴 이미지를 처리하기 위한 RGB-W 패턴 처리 모듈을 더 포함하는 것을 특징으로 하는 이미지 처리 시스템. - 동일한 피사체에 대하여 노출 시간이 상이한 복수의 이미지들을 생성하는 단계;

상기 복수의 이미지들의 정보에 기초하여 모션 보상 처리를 수행하기 전 상기 복수의 이미지들을 병합하는 제1 모드 또는 상기 모션 보상 처리를 수행하고 상기 복수의 이미지들을 병합하는 제2 모드를 판단하는 단계; 및

상기 제1 모드에서 상기 복수의 이미지들을 병합하여 다이나믹 레인지가 증가된 병합 이미지를 생성하는 단계;를 포함하는 이미지 처리 방법. - 제16 항에 있어서,

상기 판단하는 단계는 상기 복수의 이미지들의 촬영 기법 정보, 촬영 시간 간격 정보, 움직임 정보 중 적어도 하나에 기초하여 모드를 판단하는 단계를 더 포함하는 것을 특징으로 하는 이미지 처리 방법. - 제16 항에 있어서,

상기 복수의 이미지들은 제1 노출 시간에 대응되는 장노출 이미지, 제2 노출 시간에 대응되는 중노출 이미지 및 제3 노출 시간에 대응되는 단노출 이미지를 포함하고,

상기 제1 노출 시간은 상기 제2 노출 시간보다 길고, 상기 제2 노출 시간은 상기 제3 노출 시간보다 긴 것을 특징으로 하는 이미지 처리 방법. - 제18 항에 있어서,

다이나믹 레인지 처리 모드는 상기 제1 모드 및 상기 제2 모드를 모두 수행하는 제3 모드를 포함하고,

상기 제1 모드는 상기 중노출 이미지 및 상기 단노출 이미지에 기초하여 병합 이미지를 생성하고,

상기 제2 모드는 상기 장노출 이미지 및 상기 병합 이미지를 수신하여 다이나믹 레인지 확장을 위한 영상 처리를 수행하는 것을 특징으로 하는 이미지 처리 방법. - 제16 항에 있어서,

상기 복수의 이미지들은 베이어 패턴 이미지, RGB-W 패턴 이미지를 포함하고,

상기 판단하는 단계는 상기 복수의 이미지들의 패턴 정보를 판단하는 단계를 더 포함하는 것을 특징으로 하는 이미지 처리 방법.

Priority Applications (4)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020210118959A KR20230036282A (ko) | 2021-09-07 | 2021-09-07 | 이미지 센서, 이를 포함하는 이미지 처리 시스템 및 이미지 처리 방법 |

| CN202211045403.9A CN115776616A (zh) | 2021-09-07 | 2022-08-30 | 图像传感器、包括其的图像处理系统和图像处理方法 |

| TW111133691A TW202320537A (zh) | 2021-09-07 | 2022-09-06 | 影像感測器、包括影像感測器的影像處理系統以及影像處理方法 |

| US17/929,937 US12444164B2 (en) | 2021-09-07 | 2022-09-06 | Image sensor including internal pre-processor configured to generate a merged image, image processing system including the same, and image processing method |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020210118959A KR20230036282A (ko) | 2021-09-07 | 2021-09-07 | 이미지 센서, 이를 포함하는 이미지 처리 시스템 및 이미지 처리 방법 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20230036282A true KR20230036282A (ko) | 2023-03-14 |

Family

ID=85385640

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020210118959A Pending KR20230036282A (ko) | 2021-09-07 | 2021-09-07 | 이미지 센서, 이를 포함하는 이미지 처리 시스템 및 이미지 처리 방법 |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US12444164B2 (ko) |

| KR (1) | KR20230036282A (ko) |

| CN (1) | CN115776616A (ko) |

| TW (1) | TW202320537A (ko) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2025089666A1 (ko) * | 2023-10-26 | 2025-05-01 | 삼성전자 주식회사 | Hdr 이미지를 생성하는 전자 장치 및 이의 제어 방법 |

Families Citing this family (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| TWI849844B (zh) * | 2023-04-13 | 2024-07-21 | 大陸商北京集創北方科技股份有限公司 | 控制電路、光學式指紋採集裝置以及資訊處理裝置 |

| WO2024216573A1 (en) * | 2023-04-20 | 2024-10-24 | Qualcomm Incorporated | Composite image generation using motion information |

| TWI871707B (zh) * | 2023-07-21 | 2025-02-01 | 宏碁股份有限公司 | 影像感測裝置與其高動態範圍影像產生方法 |

Family Cites Families (17)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2011010108A (ja) * | 2009-06-26 | 2011-01-13 | Seiko Epson Corp | 撮像制御装置、撮像装置及び撮像制御方法 |

| US8704943B2 (en) * | 2011-01-21 | 2014-04-22 | Aptina Imaging Corporation | Systems for multi-exposure imaging |

| US9076233B2 (en) * | 2012-02-03 | 2015-07-07 | Seiko Epson Corporation | Image processing device and electronic apparatus using the same |

| JP6172967B2 (ja) | 2013-02-20 | 2017-08-02 | キヤノン株式会社 | 撮像装置、及びその制御方法 |

| US9363446B2 (en) * | 2013-04-15 | 2016-06-07 | Htc Corporation | Automatic exposure control for sequential images |

| JP6184290B2 (ja) | 2013-10-21 | 2017-08-23 | ハンファテクウィン株式会社Hanwha Techwin Co.,Ltd. | 画像処理装置および画像処理方法 |

| US20150130967A1 (en) * | 2013-11-13 | 2015-05-14 | Nvidia Corporation | Adaptive dynamic range imaging |

| KR102149187B1 (ko) * | 2014-02-21 | 2020-08-28 | 삼성전자주식회사 | 전자 장치와, 그의 제어 방법 |

| GB201509384D0 (en) * | 2015-06-01 | 2015-07-15 | Apical Ltd | Reducing bandwidth for HDR storage |

| KR102469426B1 (ko) * | 2015-10-27 | 2022-11-22 | 삼성전자주식회사 | 이미지 처리 장치 및 이의 동작 방법 |

| JP6052379B2 (ja) | 2015-12-17 | 2016-12-27 | 株式会社ニコン | 撮像装置 |

| JP6740866B2 (ja) * | 2016-11-07 | 2020-08-19 | 株式会社デンソー | 画像出力装置 |

| KR102684223B1 (ko) * | 2016-12-12 | 2024-07-11 | 삼성전자주식회사 | 광역 역광 보정 영상 촬상 방법, 이를 수행하는 영상 촬상 장치 및 이를 포함하는 전자 시스템 |

| WO2019157427A1 (en) * | 2018-02-12 | 2019-08-15 | Gopro, Inc. | Image processing |

| US20200211166A1 (en) | 2018-12-28 | 2020-07-02 | Qualcomm Incorporated | Methods and apparatus for motion compensation in high dynamic range processing |

| KR20210009255A (ko) * | 2019-07-16 | 2021-01-26 | 삼성전자주식회사 | 이미지 센서 및 이를 포함하는 이미지 처리 시스템 |

| KR102818268B1 (ko) * | 2019-11-01 | 2025-06-11 | 삼성전자주식회사 | 이미지 센서 및 이미지 신호 처리기를 포함하는 이미지 장치, 및 이미지 센서의 동작 방법 |

-

2021

- 2021-09-07 KR KR1020210118959A patent/KR20230036282A/ko active Pending

-

2022

- 2022-08-30 CN CN202211045403.9A patent/CN115776616A/zh active Pending

- 2022-09-06 US US17/929,937 patent/US12444164B2/en active Active

- 2022-09-06 TW TW111133691A patent/TW202320537A/zh unknown

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2025089666A1 (ko) * | 2023-10-26 | 2025-05-01 | 삼성전자 주식회사 | Hdr 이미지를 생성하는 전자 장치 및 이의 제어 방법 |

Also Published As

| Publication number | Publication date |

|---|---|

| US12444164B2 (en) | 2025-10-14 |

| CN115776616A (zh) | 2023-03-10 |

| US20230073138A1 (en) | 2023-03-09 |

| TW202320537A (zh) | 2023-05-16 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR20230036282A (ko) | 이미지 센서, 이를 포함하는 이미지 처리 시스템 및 이미지 처리 방법 | |

| JP6711612B2 (ja) | 画像処理装置、画像処理方法、および撮像装置 | |

| US11178372B1 (en) | Image signal processor, image signal processing method and electronic device thereof | |

| US11412197B2 (en) | Electronic device including image sensor | |

| US12028637B2 (en) | Image sensing system for converting an image signal to have a specific pattern | |

| CN111432112A (zh) | 处理图像信号的方法、图像信号处理器和图像传感器芯片 | |

| KR102518373B1 (ko) | 이미지 센서 및 이를 포함하는 전자 기기 | |

| KR20220079123A (ko) | 이미지 장치 및 이미지 장치의 동작 방법 | |

| CN112243090B (zh) | 图像传感器和图像处理系统 | |

| KR20220122008A (ko) | 이미지 신호 프로세싱 방법, 이미지 신호 프로세서 및 그 이미지 센싱 장치 | |

| TWI894469B (zh) | 畫素陣列以及包括其的影像感測器 | |

| US20220417457A1 (en) | Image processing device for noise reduction using dual conversion gain and operation method thereof | |

| US11616921B2 (en) | Image sensor and operating method thereof | |

| US11948316B2 (en) | Camera module, imaging device, and image processing method using fixed geometric characteristics | |

| US20220360712A1 (en) | Camera module and imaging device including the same | |

| TW202437772A (zh) | 影像感應器 | |

| US12219271B2 (en) | Image sensor, application processor and image sensing device | |

| US20220385841A1 (en) | Image sensor including image signal processor and operating method of the image sensor | |

| US20220329768A1 (en) | Image sensing device and operating method thereof | |

| US12118696B2 (en) | Image signal processor, method for operating image signal processor and image sensing device | |

| US20060044393A1 (en) | Camera system | |

| KR20240120481A (ko) | 이미지 프로세서 및 이를 포함하는 이미지 처리 시스템 | |

| KR20240082675A (ko) | 이미지 신호 프로세서 및 그 이미지 센싱 장치 | |

| EP4513887A1 (en) | Image sensors and image processing devices that support rolling and global shutter modes of operation | |

| KR20230135389A (ko) | 이미지 센싱 장치 및 그 이미지 신호 프로세싱 방법 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| PA0109 | Patent application |

St.27 status event code: A-0-1-A10-A12-nap-PA0109 |

|

| P22-X000 | Classification modified |

St.27 status event code: A-2-2-P10-P22-nap-X000 |

|

| P22-X000 | Classification modified |

St.27 status event code: A-2-2-P10-P22-nap-X000 |

|

| PG1501 | Laying open of application |

St.27 status event code: A-1-1-Q10-Q12-nap-PG1501 |

|

| A201 | Request for examination | ||

| PA0201 | Request for examination |

St.27 status event code: A-1-2-D10-D11-exm-PA0201 |

|

| P22-X000 | Classification modified |

St.27 status event code: A-2-2-P10-P22-nap-X000 |

|

| D21 | Rejection of application intended |

Free format text: ST27 STATUS EVENT CODE: A-1-2-D10-D21-EXM-PE0902 (AS PROVIDED BY THE NATIONAL OFFICE) |

|

| PE0902 | Notice of grounds for rejection |

St.27 status event code: A-1-2-D10-D21-exm-PE0902 |