KR20160126985A - 비디오의 방향을 결정하기 위한 방법 및 장치 - Google Patents

비디오의 방향을 결정하기 위한 방법 및 장치 Download PDFInfo

- Publication number

- KR20160126985A KR20160126985A KR1020167022482A KR20167022482A KR20160126985A KR 20160126985 A KR20160126985 A KR 20160126985A KR 1020167022482 A KR1020167022482 A KR 1020167022482A KR 20167022482 A KR20167022482 A KR 20167022482A KR 20160126985 A KR20160126985 A KR 20160126985A

- Authority

- KR

- South Korea

- Prior art keywords

- video

- rotation

- feature

- motion

- based parameters

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

-

- G06T7/004—

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/20—Analysis of motion

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30244—Camera pose

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2219/00—Indexing scheme for manipulating 3D models or images for computer graphics

- G06T2219/20—Indexing scheme for editing of 3D models

- G06T2219/2016—Rotation, translation, scaling

Landscapes

- Engineering & Computer Science (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Multimedia (AREA)

- Image Analysis (AREA)

- Studio Devices (AREA)

Abstract

비디오의 방향을 결정하기 위한 방법 및 장치가 개시된다. 본 방법은 비디오의 움직임을 추정하는 단계; 추정된 비디오의 움직임으로부터 변환-기반 파라미터들을 추출하는 단계; 및 변환 기반 파라미터들에 따라 수직 변환의 전개에 대하여 시간에 따른 수평 변환의 전개를 제공하는 적어도 하나의 피처를 계산하는 단계로서, 피처가 비디오의 방향을 결정하기 위해 사용되는, 적어도 하나의 피처를 계산하는 단계를 포함한다.

Description

본 개시는 일반적으로 이미지 처리에 관한 것이다. 특히, 본 개시는 비디오의 방향을 결정하기 위한 방법 및 장치에 관한 것이다.

비디오 콘텐츠의 컴퓨터 처리의 일부 응용들에 있어서, 주어진 비디오의 방향을 추정할 필요가 있다. 예를 들어, 그러한 응용들의 상황은 즉 사람이 비디오를 찾아서 시청하기를 원할 때, 비디오의 정확한 디스플레이를 위해 비디오의 정확한 방향을 가질 필요가 있는 경우이다. 다른 상황은, 얼굴 검출, 특정 개체 검출 및 인식, 스카이 영역 검출 및 많은 일반적인 의미 비디오 파싱과 같은 컴퓨터 비전 처리할 때이다. 이 경우의 초기 요구 사항으로서, 처리될 이미지 및 비디오들은 정확한 방향들로 제안되도록 되어 있다. 따라서, 비디오의 방향의 결정은 그러한 컴퓨터 비전 처리를 위해 처음 및 필수적인 전처리로서 적용될 수 있다.

정확한 비디오의 방향을 얻기 위한 하나의 공지된 해결 방법은 비디오의 캡처 동안 비디오 콘텐츠가 저장된 추가적인 메타 데이터를 사용하는 것이다. 예를 들어, 그러한 부가적인 메타 데이터는 Exif(Exchangeable Image File Format(교환 이미지 파일 포맷)) 표준에서 정의된 메타 데이터 태그일 수 있다. 이러한 방향의 지식은 자이로 정보(gyro info)에 의존한다. 이 경우, 이러한 메타 데이터의 존재는 사용되는 캡처 디바이스들에 의존할 것이다. 그러나, 이러한 정보는 일반적으로 저가의 디바이스들에 사용할 수 없다. 임의 모바일 폰들, 예를 들어, 아이폰들은 그러한 정보를 갖지 않지만, 저가의 스마트 폰들은 그와 같은 정보를 저장하지 않을 것이다. 또한, 비디오의 경우, 방향 정보는 비디오의 첫 번째 이미지에만 기초하여 계산되며, 캡처 동안 회전의 경우에 변경되지 않을 것이다. 따라서, 이러한 공지된 해결 방법을 사용하면, 방향 정보는 비디오의 제 1 부분에 대해서만 신뢰될 수 있다.

또 다른 알려진 해결 방법은 소위 자동 시스템이다. 다음 문서들은 정지 화상의 방향을 자동으로 검출할 수 있는 그러한 자동 시스템에 관한 것이다.

[1] Cingovska, I.; Ivanovski, Z.; Martin, F., 종래의 계층적 콘텐츠-기반 분류에 따른 자동 이미지 방향 검출, 이미지 처리(ICIP), 2011년 18회 IEEE 국제회의(IEEE International Conference), 권, 번, 2985,2988 페이지, 2011년 9월 11~14일.

[2] G. Sharma, A. Dhall, S. Chaudhury and R. Bhatt, 컨텐츠 기반 분류화 및 맞춤형 이미지의 방향을 위한 계층적 시스템, 패턴 인식 및 기계 지능, 5909권 495-500 페이지, 2009년.

[3] Jiebo Luo; Boutell, M., 저레벨 및 시메틱 규의 컨피던스-기반 통합을 통한 자동 이미지 방향 검출, 패턴 분석 및 기계 지능, IEEE 트랜젝션, 27권, 5번, 715, 726 페이지, 2005년 5월.

그러나, 상술한 것처럼, 상기 3개의 문서들의 목적들은, 시스템 처리 비디오들의 참조가 설명되어 있지 않기 때문에, 정지 화상에 대한 방향을 검출하기 위한 것으로 보인다. 정지 화상에 대해 제안된 시스템들은 통상적으로 이미지로부터 피처들의 추출 및 일부 기계 학습 기술의 사용에 기초한다. 이는 한 모델의 학습의 첫 번째 단계가 결과적으로 비용이 많이 드는 오프-라인 처리로 나타날 수 있는 주석 이미지들의 데이터베이스에 필요하다는 것을 의미한다. 또한, 가장 양호하게 수행하는 시스템은, 색상 또는 질감-관련 낮은 수준의 피처들(제 1 색 모멘트, 에지 방향 히스토그램, 등)에서 시스템의 대부분의 시간을 취하여 많은 계산량을 초래하는 높은 수준 의미의 정보(얼굴 검출, 하늘 검출, 라인들 검출, 등)까지의 범위에 있는 비디오 콘텐츠로부터 추출된 서로 다른 피처들을 사용한다. 정지 화상들에 대한 이와 같은 처리는 비디오의 각각의 프레임 또는 이들 프레임들의 서브-샘플링에 대한 프레임 단위로 적용될 수 있다. 그러나, 그 결과로서, 그러한 처리는 뷰의 계산 포인트에서 휠씬 더 비싸진다는 것이다.

따라서, 주어진 비디오의 정확한 방향을 합리적인 계산량으로 검출하고, 동시에, 검출된 방향이 비디오의 각각의 프레임에 대해 정확하게 되는 것을 보장할 필요가 있다(비디오를 캡처하기 위한 디바이스가 캡처 단계 동안 회전될 수 있다고 가정한다).

종래의 기술들에서 상술한 문제점의 관점에서, 본 개시는 비디오의 각각의 방향-동질적 부분에 대해 합리적인 계산량을 가지고 비디오의 방향을 결정하기 위한 방법 및 장치를 제공한다.

본 개시에 따라, 일부의 피처들이 비디오 장면의 추정된 움직임 (가장 유력하거나 객체-기반)에 기초하여 추출된다. 이들 움직임-기반 피처들로부터, 일부 프레임-기반 방향 정보가 방향의 잠재 변화와 함께 계산된다. 일시적인 방향 정보와 함께, 본 개시는 또한 비디오의 방향-동질적 부분들로의 관련된 세그먼테이션을 결과로서 얻는다.

본 개시의 제 1 실시예에 따라, 비디오의 방향을 결정하기 위한 방법이 제공된다. 본 방법은, 비디오의 움직임을 추정하는 단계, 추정된 비디오의 움직임으로부터 변환-기반 파라미터들을 추출하는 단계, 및 변환 기반 파라미터들에 따라 수직 변환의 전개(evolution)에 대하여 시간에 따른 수평 변환의 전개를 제공하는 적어도 하나의 피처를 계산하는 단계로서, 피처가 비디오의 방향을 결정하기 위해 사용되는, 적어도 하나의 피처를 계산하는 단계를 포함한다.

제 1 실시예에 있어서, 본 방법은 추정된 비디오의 움직임으로부터 회전-기반 파라미터들을 추출하는 단계, 회전-기반 파라미터들에 따라 검출된 회전들에 의해 분리된 적어도 하나의 세그먼트로 비디오를 분할하는 단계, 및 상기 적어도 하나의 세그먼트의 각각을 통해 상기 적어도 하나의 피처의 적분의 함수로서 비디오의 방향을 결정하는 단계를 더 포함한다.

본 개시의 제 2 실시예에 따라, 비디오의 방향을 결정하기 위한 장치가 제공된다. 본 장치는, 비디오의 움직임을 추정하고, 추정된 비디오의 움직임으로부터 변환-기반 파라미터들을 추출하고, 그리고, 변환 기반 파라미터들에 따라 수직 변환의 전개에 대하여 시간에 따른 수평 변환의 전개를 제공하는 적어도 하나의 피처를 계산하되, 피처가 비디오의 방향을 결정하기 위해 사용되는, 적어도 하나의 피처를 계산하도록 구성된 프로세서를 포함한다.

본 개시의 제 3 실시예에 따라, 통신 네트워크로부터 다운로드, 및/또는 컴퓨터에 의해 판독 가능한 매체에 기록, 및/또는 프로세서에 의해 실행 가능한 컴퓨터 프로그램 제품이 제공된다. 컴퓨터 프로그램 제품은 본 개시의 한 관점에 따른 방법의 단계들을 구현하기 위한 프로그램 코드 명령들을 포함한다.

본 개시의 제 4 실시예에 따라, 기록된 컴퓨터 프로그램 제품을 포함하고 프로세서에 의해 수행 가능한 비-일시적인 컴퓨터-판독 가능한 매체가 제공된다. 비-일시적인 컴퓨터-판독 가능한 매체는 본 개시의 한 관점에 따른 방법의 단계들을 구현하기 위한 프로그램 코드 명령들을 포함한다.

본 개시의 더 많은 관점들 및 장점은 본 명세서의 다음 상세한 설명에서 찾을 수 있다는 것을 알 수 있을 것이다.

본 개시에 따라, 비디오의 각각의 방향-동질적 부분에 대해 합리적인 계산량을 가지고 비디오의 방향을 결정하기 위한 방법 및 장치를 제공한다.

도 1은 본 개시의 실시예에 따라 비디오의 방향을 결정하기 위한 방법을 도시한 흐름도;

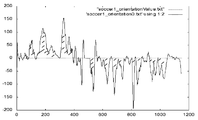

도 2는, 적분 동안, 절대적인 수평 및 수직 변환들의 차이의 전개를 도시한 다이어그램;

도 3은, 적분 동안, 회전 파라미터의 전개의 예를 도시한 다이어그램;

도 4는 본 개시의 다른 실시예에 따라 비디오의 방향을 결정하기 위한 방법을 도시한 흐름도;

도 5는 시계-방향 카메라 회전 이전 및 이후에 서로 다른 가능한 방향들(표 1의 경우 2)을 도시한 전형적인 다이어그램;

도 6은 반시계-방향 카메라 회전 이전 및 이후에 서로 다른 가능한 방향들(표 1의 경우 3)을 도시한 전형적인 다이어그램; 및

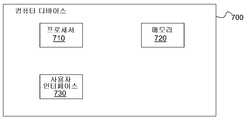

도 7은 본 개시의 실시예에 따라 비디오의 방향을 결정하기 위한 방법이 구현될 수 있는 컴퓨터 디바이스를 도시하는 블록 다이어그램이다.

도 2는, 적분 동안, 절대적인 수평 및 수직 변환들의 차이의 전개를 도시한 다이어그램;

도 3은, 적분 동안, 회전 파라미터의 전개의 예를 도시한 다이어그램;

도 4는 본 개시의 다른 실시예에 따라 비디오의 방향을 결정하기 위한 방법을 도시한 흐름도;

도 5는 시계-방향 카메라 회전 이전 및 이후에 서로 다른 가능한 방향들(표 1의 경우 2)을 도시한 전형적인 다이어그램;

도 6은 반시계-방향 카메라 회전 이전 및 이후에 서로 다른 가능한 방향들(표 1의 경우 3)을 도시한 전형적인 다이어그램; 및

도 7은 본 개시의 실시예에 따라 비디오의 방향을 결정하기 위한 방법이 구현될 수 있는 컴퓨터 디바이스를 도시하는 블록 다이어그램이다.

첨부된 도면들은 본 실시예들의 원리를 설명하기 위해 제공된 설명과 함께 본 개시의 실시예들의 추가적인 이해를 위해 포함되어 있다. 본 개시는 본 실시예들에 제한하지 않는다.

지금, 본 개시의 한 실시예를 도면과 함께 상세히 설명할 것이다. 다음 설명에 있어서, 공지된 기능 및 구성의 일부 상세한 설명은 간결함을 위해 생략될 수 있다.

본 개시의 실시예는 비디오의 방향을 결정하기 위한 방법을 제공한다. 다음, 본 개시의 실시예의 방법을 상세히 설명할 것이다.

도 1은 본 개시의 실시예에 따라 비디오의 방향을 결정하기 위한 방법을 도시한 흐름도이다.

단순화를 위해, 본 개시의 실시예들을 비디오의 각각의 플레임에 대해 0°, 90°, -90° 및 180°의 4 방향들 사이, 즉, 두 방향의 랜드스케이프 (0°, 180°) 및 포트레이트 (90°, -90°) 방향들 사이를 단지 구별하여 설명할 것이다. 따라서, 본 개시는 프레임들을 그들 4개의 클래스의 분류만을 설명하고, 더 이상의 정확한 방향 각도는 추출되지 않을 것이다. 또한, 본 개시의 일부 실시예들에 있어서, 본 시스템은, 두 개의 가능한 포트레이트 방향들 (90°, -90°) 사이와 두 개의 가능 랜드스케이프 방향들 (0°, 180°) 사이를 구별하지 않고, 포트레이트/랜드스케이프로의 제 1 분류를 제공할 것이다. 그러나, 본 개시가 더 복잡한 방향 분류를 갖는 경우들에 또한 적용될 수 있다는 것을 알 수 있다.

도 1에 도시된 것처럼, 단계(S101)에서는 비디오의 움직임을 추정한다. 비디오의 가장 유력한 움직임이 단계(S101)에서의 움직임 추정에 선호된다는 것을 주목한다. 그러나, 일부 객체-기반 움직임 추정은 비디오에서 가장 유력한 움직임이 추정되지 않을 때 의존할 수 있다. 가장 유력한 움직임 추정은, 각각의 순간에서, 비디오의 가장 유력한 움직임의 파라메트릭 근사치를 계산함으로써 실행될 수 있다. 일부 공지된 해결 방법들이 가장 유력한 움직임의 추정을 위해 사용될 수 있다. 이를 위한 최첨단 기술이 예를 들어 다음과 같은 문서가 개시되어 있다.

[4] J.M. Odobez, P. Bouthemy, 파라메트릭 움직임 모델들의 강력한 다중 해상도 추정. 비주얼 커뮤니케이션 및 이미지 표현의 학회지, 1995년 12월, 6(4): 348-365.

다음, 단계(S102)에서는 추정된 비디오의 가장 유력한 움직임으로부터 변환-기반 파라미터들 및 회전-기반 파라미터들을 추정한다.

움직임 추정기들은 추정된 움직임 모델을 출력하는데, 이러한 추정된 움직임 모델로부터, 회전의 추정과 함께 수평 및 수직 방향의 두 방향들로 변환들의 추정이 추출될 수 있다.

추정될 움직임에 따라 파라미터들을 포함할 수 있는 가장 유력한 움직임으로부터 움직임 모델이 액세스될 수 있다는 것을 알 수 있다. 본 실시예에 있어서, 6개의 파라미터들을 갖는 아핀 모델(affine model)이 아래의 매트릭스로서 고려될 수 있다.

a0 a1 a2

b0 b1 b2

상술한 모델에 있어서, 예를 들어, 첫 번째 2개의 파라미터들(a0 및 b0)은 x축 및 y축에서 변환 값들인 Tx 및 Ty에 각각 대응한다. 4개의 나머지 파라미터들은 회전 및 줌잉 움직임들에 관한 정보를 제공한다. a2 - b1의 값을 고려하여, 적용된 회전의 사이너스에 비례한 양이 액세스될 수 있다.

이 단계에 있어서, 선택적으로 변환-기반 파라미터들 및 회전-기반 파라미터들은 시간의 소정의 기간 동안 적분될 수 있다. 적분에 대해서는, 정적분을 근사치로 계산하기 위한 이미 공지된 기술인 사다리꼴 규직이 주어진 윈도우에 적용될 수 있다. 본 실시예에 있어서, 주어진 윈도우의 사이즈는 예를 들어 20 프레임들로 경험적으로 고정될 수 있다. 그러나, 이 사이즈는 상황에 따라 적응될 수 있다. 가장 유력한 움직임 추정으로부터, 단지 작은 변환 및 회전 값들이 하나의 프레임에서 다른 프레임으로 액세스될 수 있다. 이들 값으로부터, 정확하게 회전 및 변환들을 검출하는 것은 어렵다. 적분의 장점은 보다 긴 시간 주기에 보다 큰 뷰를 제공하기 위한 것이다.

다음, 단계(S103)에서는 변환 기반 파라미터들에 따라 수직 변환의 전개에 대하여 시간에 따른 수평 변환의 전개를 제공하는 적어도 하나의 피처를 계산한다. 이러한 피처는 비디오가 포트레이트 또는 랜드스케이프 모드에서 캡처되었는지의 여부에 관한 일부 단서를 제공할 수 있다. 대부분의 경우에 있어서, 가장 유력한 움직임의 변환 성분의 진폭이 수직 방향보다 수평 방향으로 실질적으로 더 클 때, 틸팅(tilting) 사용자보다 더 많은 패닝(panning) 사용자가 비디오의 장면을 캡처하는 동안 사용되는 경향이 있기 때문에, 비디오가 랜드스케이프 모드에서 캡처될 수 있다.

아래의 피처의 분석은 예를 들어 요청된 정보를 제공할 것이다.

Featuretrans(frame) = abs(tx(frame)) - abs(ty(frame))

도 2는 Tx 및 Ty의 적분 값으로부터 시간 경과에 따른 피처와 같은 전개의 예를 도시한다. 양의 값들은 비디오의 랜드스케이프 방향을 나타내는 경향이 있고, 음의 값들은 비디오의 포트레이트 방향을 나타내는 경향이 있다. 선택적인 단계에 있어서, 상술한 피처는 분석의 정확도를 개선하기 위하여 주어진 슬라이딩 타임 윈도우를 통해 스무싱될 수 있다.

단계(S103)와 나란한 단계(S104)에서는, 적분간에, 회전-기반 파라미터들에 따라 검출된 회전들에 의해 분리된 세그먼트들로 비디오를 분할한다.

회전-기반 파라미터는 결과적으로 캡처 동안 카메라가 회전되었는지의 여부에 관한 일부 정보를 제공할 것임을 알 수 있다. 세그먼테이션은 추출된 회전-기반 파라미터들의 스레스홀딩을 통해 실행될 수 있다.

도 3은 적분 이후에 회전-기반 파라미터들의 전개의 예를 도시한 다이어그램이다. 이 경우, 스레스홀딩은 3개의 세그먼트들, 즉 회전 이전의 세그먼트 1, 회전 이후의 세그먼트 3, 및 회전에 대응하는 세그먼트 2를 제공하게 되며, 이를 위해, 시스템은 본 실시에에서 임의의 방향 정보를 제공하지 않는다. 도 3은 비디오를 분할하는 예를 도시하며, 여기서, 단순한 임계치가 적용된다. 임계치 위의 영역들은 시계 방향의 회전들에 대응하고, 임계치 반대의 아래의 영역들은 반-시계 방향의 회전들에 대응하며, 그들 사이의 영역들은 회전이 없는 영역들에 대응한다. 본 예에 있어서, 임계치는 0.2의 경험 값으로 고정되었다. 그러나, 보다 많은 적응이 비디오 콘텐츠에 따라, 예를 들어, 평균-2-시그마 아래의 값을 단지 유지하게 되는 어떤 것에 따라 이루어질 수 있다. 선택적으로, 회전 경계들의 검출에 개선이 부가될 수 있다. 이러한 개선은 잠재적인 회전들의 마커들을 제공하는 보다 높은 임계값으로 시작할 것이다. 이때는 회전 파라미터의 절대값이 매우 낮은 (즉, 엡실론 값보다 낮은) 프레임에 대응하는 회전 시작을 찾기 위하여 일시적으로 후방 진행한다. 다음에는 회전 파라미터의 절대값이 엡실론보다 낮은 제 1 프레임에 대응하는 회전의 종료를 위해 전방 검색한다.

단계(S105)에서는 단계(S104)에서 획득한 각각의 세그먼트를 통해 단계(S103)에서 획득한 적어도 하나의 피처의 적분에 따라 비디오의 방향을 결정한다.

비디오의 방향은, 세그먼트 당 Featuretrans의 하나의 대표적인 단일 값을 얻기 위해, 세그먼트의 모든 프레임들에 대해서, Featuretrans를 적분함으로써 회전 이전 및 이후에 각각의 세그먼트의 방향을 계산하여 결정된다. 본 실시예에 있어서는 단순히 세그먼트들을 통해 도 2(빗금 친 영역 참조)에서 곡선 아래의 면적의 계산일 수 있다. 다른 실시예에 있어서, 추가적인 임계값(T)이 변환-기반 파라미터에 사용된다. Featuretrans >T 및 Featuretrans < -T인 연속된 부분의 개수가 카운트되며, 또한 그들 부분의 기간도 카운트된다. 이들 두 개의 카운터의 간단한 정규화된 합은 Featuretrans의 새로운 “적분된” 값을 제공할 것이다.

회전이 검출되지 않으면, 전체 비디오를 통해 또는 미리 정의된 사이즈의 윈도우들을 통해 Featuretrans의 적분된 값이 계산된다. 구체적으로, 회전이 검출되지 않았다면, 전체 비디오에 단지 하나의 큰 세그먼트가 존재한다. 이 경우, Featuretrans에 대한 동일한 적분 처리는 세그먼트에 수행되지만 전체 비디오에 수행되는 것으로 단순히 적용될 수 있다. 변형으로서, 비디오가 매우 긴 경우, 윈도우마다 처리될 수 있다. 이 경우, 적분은 한번 다시 실행되지만 미리 정의된 윈도우 사이즈를 통해 실행된다.

본 실시예에 있어서, 각각의 세그먼트의 방향은 다음과 같이 주어진다.

Featuretrans_integrated_over_segment > 0인 경우, 방향은 랜드스케이프이다.

Featuretrans_integrated_over_segment < 0인 경우, 방향은 포트레이트이다.

상술한 것처럼, 단순화를 위해, 본 개시의 실시예들은 제한된 수의 방향들 사이를 단지 구별하는 것으로 설명한다. 본 개시의 추가적인 개량에 있어서, 예를 들어 얼굴 검출과 같은 일부 추가적인 처리가 두 개의 포트레이트 또는 두 개의 랜드스케이프 방향들 사이를 더 구별하기 위해 적용될 수 있다. 본 기술에 숙련된 사람은, 사람들일 가능성이 매우 낮고 그로 인해 얼굴들이 위아래가 뒤바뀌게 될 가능성이 매우 낮은 만큼, 사진들 내의 얼굴을 검출함으로써, 한 사진의 가장 가능한 방향의 일부 정보가 획득될 수 있다는 것을 알 수 있다. 또한, 사람들이 있을 가능성이 매우 낮고 이에 따라 서있는 사람들보다는 이미지 내에 누워 있는 얼굴일 가능성이 매우 낮다. 이러한 정보는 비디오의 방향들을 구별하기 위해 더 사용될 수 있다. 본 관점에서 더 이상의 상세한 설명은 하지 않는다.

도 4는 본 개시의 다른 실시예에 따라 비디오의 방향을 결정하기 위한 방법을 도시한 흐름도이다.

도 4에 도시된 실시예에 있어서, 단계들(S401-S405)은 도 1에서의 단계들(S101-S105)과 각각 동일하다. 다른 단계(S406)가 추가되며, 이 단계에서는 회전의 각도(예를 들어, 이 각도는 단계(S402)에서 추출된 회전-기반 파라미터로부터 추출될 수 있다)에 따라 단계(S405)에서 획득된 비디오의 방향을 더 구별한다. 도 1을 참조하여 설명한 실시예의 문맥에서, 추가된 단계(S406)는 단계(S405)에서 결정된 두 개의 포트레이트들 및 두 개의 랜드스케이프 방향들 사이를 구별하는데 도움이 될 수 있다.

단계(S404)로부터, 비디오에서 회전이 발생했는지의 여부에 관한 정보가 획득될 수 있다(회전 파라미터의 절대값은 주어진 임계값보다 위에 있다). 단계(S402)에서 획득된 회전 파라미터의 부호에 따라, 회전의 방향에 대한 정보는 액세스될 수 있다(rotation_parameter > 0 인 경우, 장면은 시계 방향으로 회전, 즉 카메라는 프레임의 중심으로 상대적으로 반시계 방향으로 회전하였고, rotation_parameter < 0 인 경우, 장면은 반시계 방향으로 회전, 즉 카메라는 프레임의 중심으로 상대적으로 시계 방향으로 회전하였다. 회전에 대응하는 비디오에 대한 최종 회전 값은 세그먼트를 통해 회전 파라미터의 적분된 값일 수 있거나, 단순히 -/+ max_over_segment(abs(rotation_parameter)일 수 있다. 이 회전 값의 부호는 현재 세그먼트를 통해 회전_파라미터의 부호에 의존할 것이다.

다음 설명에서는 프레임들이 단지 3개의 클래스(0°, 90, -90°)에 속할 수 있는 단지 간단한 경우가 고려된다. 위아래가 뒤바뀌는 방향을 갖는 비디오가 매우 드믈고, 이에 따라, 다음 설명에서는 고려되지 않는다는 것을 알 수 있다. 본 개시의 개량에 있어서, 180° 방향 클래스는 유사한 추론에 따라 부가될 수 있다.

아래의 표 1은 추정된 회전 파라미터에 따라 회전 이전 및 이후에 세그먼트들에 대한 방향에 관한 정보를 도시한다(엡실론 1 > 0).

| 회전 파라미터 | 경우 1: |rot_param| < 엡실론 1 |

경우 2: rot_param < -엡실론1 카메라가 시계 방향으로 회전되었음. |

경우 3: rot_param > 엡실론1 카메라가 반시계 방향으로 회전되었음. |

| 방향 | 정보 없음 | A = (orient_before = 0 및 orient_after = 90) 또는 B = (orient_before = -90 및 orient_after = 0) |

C = (orient_before = 0 및 orient_after = -90) 또는 D = (orient_before = 90 및 orient_after = 0) |

표 1에서, orient_before 및 orient_after는 회전 이전의 모든 프레임들의 방향 및 회전 이후에 모든 프레임들의 방향을 각각 의미한다. 회전 파라미터가 각각의 컬럼에서 고려되었다. 파라미터의 부호 및 값에 따라, 회전이 발생하고, 이 경우에, 회전이 시계 방향, 반시계 방향으로 회전한다는 두 사실에 대한 일부 통찰력이 획득될 수 있다.

도 5 및 도 6은 표1에서 설명된 서로 다른 경우들을 예시한다. 도 5 및 도 6과 회전 방향으로부터, 회전 이전 및 이후에 변환에 대한 단지 몇 가지 가능성이 있다.

도 5는 시계-방향 카메라 회전 이전 및 이후에 서로 다른 가능한 방향들(표 1의 경우 2)을 도시한 전형적인 다이어그램이다. 단지 처음 두 경우가 다음 설명에서 고려된다. 도 6은 반시계-방향 카메라 회전 이전 및 이후에 서로 다른 가능한 방향들(표 1의 경우 3)을 도시한 전형적인 다이어그램이다. 유사하게 단지 처음 두 경우가 다음 설명에서 고려된다.

표 1에서 상태들(A 및 B, 또는 C 및 D) 사이의 모호성을 또한 해결하기 위하여, 만일 있다면, 단계(S405)에서 설명한 것처럼 계산된 회전 이전 및 이후에 변환 피처의 적분 값들은, 경우들에 따라, 회전 이전 및 이후에 프레임들의 제로, 하나 또는 두 개의 가능한 방향들을 획득하기 위해 다음 표 2에 따라 비교 및 혼합된다.

표 2는 변환 및 회전 파라미터들/피처들에 따라 방향 결정들을 도시한다. 경우들(1, 2, 3)은 표1에 기재되어 있다(엡실론 2는 양수).

| Before_rot --------------- After_rot |

|FeaturetransIntegrated|< 엡실론2 | FeaturetransIntegrated > 엡실론2 | FeaturetransIntegrated < -엡실론2 | |||

| |FeaturetransIntegrated|< 엡실론2 |

경우1 | 거절 | 경우1 | 방향=0 | 경우1 | 방향=90 또는 -90 |

| 경우2 | A 또는 B | 경우2 | A | 경우2 | B | |

| 경우3 | C 또는 D | 경우3 | C | 경우3 | D | |

| FeaturetransIntegrated > 엡실론2 |

경우1 | 방향=0 | 경우1 | 방향=0 | 경우1 | 거절 |

| 경우2 | B | 경우2 | A 또는 B | 경우2 | B | |

| 경우3 | D | 경우3 | C 또는 D | 경우3 | D | |

| FeaturetransIntegrated < -엡실론2 |

경우1 | 방향=90 또는 -90 | 경우1 | 거절 | 경우1 | 방향=90 또는 -90 |

| 경우2 | A | 경우2 | A | 경우2 | A 또는 B | |

| 경우3 | C | 경우3 | C | 경우3 | C 또는 D | |

Featuretrans 적분 또는 회전 값들이 너무 작은 일부의 경우에, 일부 거절 정책이 적용되며, 어떠한 방향 정보도 출력되지 않는다. 본 개시의 변형에 있어서, 정의되지 않은 경우(여러 가능한 방향들)는 거절된 경우로 변환될 수 있다.

또한, 회전 이전 및 이후 모두의 변환 파라미터들이 예를 들어 포트레이트 세그먼트와 같은 회전 이전 및 이후에 세그먼트들을 분류하는데 합의한 경우, 회전이 잘못 검출되었을 가능성이 있다. 이 경우, 단계(S406)의 부가는 잘못된 알람을 제거하는데 도움이 될 수 있다. 두 진행 절차들 사이에서 하나 또는 다른 하나를 선택하는 것은 회전 파라미터 및 변환 파라미터 둘 다에 대해 가질 수 있는 신뢰도 값에 의존할 수 있다.

여러 회전들이 비디오에서 검출된다면, 표 2에 설명된 것들과 같은 유사한 규칙들이 정의되지 않은 경우들을 해결하기 위해 비디오를 따라 유도되어 전달될 수 있다.

바람직하게는, 가장 유력한 움직임 추정으로부터 어떠한 변환이 검출되지 않을 때, 장면에서 일부 개체의 움직임은 추정될 수 있고, 이들 개체들의 일부 변환 정보는, 존재하는 경우, 가장 유력한 움직임의 것을 대신하여 사용될 수 있다.

카메라 및 개체들이 이동하는 경우에, 두 영역의 스키마 적분 변환 정보가 사용될 수 있다. 그럼에도 불구하고, 동질적 방향 비디오 세그먼트들로의 세그먼테이션에 있어서, 가장 유력한 회전은 단지 신뢰 가능한 기준으로 유지된다.

본 방법의 견고성을 확대하기 위하여, 계산량이 허락하면, 정지 화상들에 사용되는 일부 추가된 피처들이 또한 사용될 수 있다. 예를 들어, 얼굴 방향은 본 개시에 제안된 움직임-기반 피처와 병합되는 관심 큐(interesting cue)를 유지한다.

본 개시는 심지어 회전이 캡처 동안 발생하여도 주어진 비디오의 모든 프레임에 대한 방향 정보를 유리하게 제공한다. 이는 비디오에 적용된 일부 광 움직임-기반 처리에 기초하며, 이에 따라, 오프-라인 학습 프로세스를 필요로 하지 않는다. 움직임 추정의 단계는 실시간으로 실현될 수 있고, 온-라인 방향 검출 프로세스는 전체 비디오를 통해 또는 일부 미리 결정된 시간 윈도우들을 통해 움직임 추정 이후에 순간적으로 적용된다.

본 개시는 예를 들어 미리 캡처된 비디오들의 재생을 제공하는 비디오 플레이어에서 구현될 수 있다. 이러한 비디오 플레이어는 PC의 비디오 랜, 온라인 비디오 웹사이트 및 스마트 폰들을 포함할 수 있지만 이들에 제한하지 않는다.

본 개시의 실시예는 비디오의 방향을 결정하기 위한 해당 장치를 제공한다.

도 7은 본 개시의 실시예에 따라 비디오의 방향을 결정하기 위한 방법이 구현될 수 있는 컴퓨터 디바이스(700)를 도시하는 블록 다이어그램이다. 컴퓨터 디바이스(700)는 표준 퍼스널 컴퓨터(PC)와 같은 계산을 실행할 수 있는 임의의 종류의 적당한 컴퓨터 또는 디바이스일 수 있다. 디바이스(700)는 적어도 하나의 프로세서(710), RAM 메모리(720) 및 사용자와 상호 작용하기 위한 사용자 인터페이스(730)를 포함한다. 숙련된 사람은 예시된 컴퓨터가 명확성의 이유로 매우 단순화되어 있고, 또한 실제 컴퓨터가 네트워크 접속 및 영구 저장 디바이스들과 같은 피처들을 포함할 것이라는 점을 이해할 것이다.

사용자 인터페이스(730)을 사용하여, 사용자는 재생을 위한 비디오를 입력/선택할 수 있다. 비디오의 결정된 방향의 결과는, 필요한 경우, 사용자 인터페이스(730)에 의해 사용자에 출력될 수도 있다.

프로세서(710)는 비디오의 움직임을 추정하기 위한 제 1 유닛을 포함한다.

프로세서(710)는 추정된 비디오의 움직임으로부터 변환-기반 파라미터들 및 회전-기반 파라미터들을 추출하기 위한 제 2 유닛을 더 포함한다.

프로세서(710)는 변환 기반 파라미터들에 따라 수직 변환의 전개에 대하여 시간에 따른 수평 변환의 전개를 제공하는 적어도 하나의 피처를 계산하기 위한 제 3 유닛을 더 포함한다.

프로세서(710)는 회전-기반 파라미터들에 따라 검출된 회전들에 의해 분리된 세그먼트들로 비디오를 분할하기 위한 제 4 유닛을 더 포함한다.

프로세서(710)는 상기 세그먼트들의 각각을 통해 상기 적어도 하나의 피처의 적분의 함수로서 비디오의 방향을 결정하기 위한 제 5 유닛을 더 포함한다.

본 개시의 실시예는 통신 네트워크로부터 다운로드, 및/또는 컴퓨터에 의해 판독 가능한 매체에 기록, 및/또는 프로세서에 의해 실행 가능한 컴퓨터 프로그램 제품으로서, 상술한 방법의 단계들을 구현하기 위한 프로그램 코드 명령들을 포함하는 컴퓨터 프로그램 제품을 제공한다.

본 개시의 실시예는 기록된 컴퓨터 프로그램 제품을 포함하고 프로세서에 의해 수행 가능한 비-일시적인 컴퓨터-판독 가능한 매체로서, 상술한 방법의 단계들을 구현하기 위한 프로그램 코드 명령들을 포함하는 비-일시적인 컴퓨터-판독 가능한 매체를 제공한다.

본 개시는 하드웨어, 소프트웨어, 펌웨어, 특수 목적 프로세서들, 또는 이들의 조합의 다양한 형태로 구현될 수 있다는 것을 이해해야 한다. 더욱이, 소프트웨어는 프로그램 저장 디바이스 상에 구체화되는 실체 응용 프로그램으로서 바람직하게 구현된다. 응용 프로그램은 임의의 적당한 아키텍처를 포함하는 머신에 업로드되어 그 머신에 의해 실행될 수 있다. 바람직하게, 머신은 하나 이상의 중앙 처리 유닛(CPU), 랜덤 액세스 메모리 (RAM), 및 입/출력(I/O) 인터페이스(들)와 같은 하드웨어를 갖는 컴퓨터 플랫폼 상에서 구현된다. 컴퓨터 플랫폼은 또한 운영 시스템과 마이크로-인스트럭션 코드를 포함한다. 본 명세서에 설명된 다양한 프로세스 및 기능들은 운영 시스템을 통해 실행되는 애플리케이션 프로그램 (또는 그 조합)의 마이크로-인스트럭션 코드의 부분 또는 응용 시스템을 통해 수행되는 응용 프로그램의 부분(또는 그들의 조합)일 수 있다. 또한, 다양한 다른 주변 디바이스(들)는 추가적인 데이터 저장 디바이스 및 프린팅 디바이스와 같은 컴퓨터 플랫폼에 연결될 수 있다.

또한, 첨부한 도면들에 도시된 구성 시스템 구성 요소들 및 방법 단계들 중 일부는 소프트웨어로 바람직하게 구현되기 때문에, 시스템 구성 요소들(또는 프로세스 단계들) 사이의 실제 연결들은 본 개시가 프로그래밍 되는 방식에 따라 다를 수 있다는 것을 이해해야 한다. 본 명세서에 가르침이 주어지면, 관련 기술에 숙련된 사람은 이들 및 유사한 구현들 또는 본 개시의 구성들을 고려할 수 있을 것이다.

700: 컴퓨터 디바이스

710: 프로세서

720: RAM 메모리

730: 사용자 인터페이스

710: 프로세서

720: RAM 메모리

730: 사용자 인터페이스

Claims (14)

- 비디오의 방향을 결정하기 위한 방법으로서,

비디오의 움직임을 추정하는 단계(S101, S401);

추정된 비디오의 움직임으로부터 변환-기반 파라미터들을 추출하는 단계(S102, S402); 및

변환 기반 파라미터들에 따라 수직 변환의 전개에 대하여 시간에 따른 수평 변환의 전개(evolution)를 제공하는 적어도 하나의 피처를 계산하는 단계로서, 피처가 비디오의 방향을 결정하기 위해 사용되는, 적어도 하나의 피처를 계산하는 단계(S103, S403)를 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 1 항에 있어서,

추정된 비디오의 움직임으로부터 회전-기반 파라미터들을 추출하는 단계(S102, S402);

회전-기반 파라미터들에 따라 검출된 회전들에 의해 분리된 적어도 하나의 세그먼트로 비디오를 분할하는 단계(S104, S404); 및

상기 적어도 하나의 세그먼트의 각각을 통해 상기 적어도 하나의 피처의 적분의 함수로서 비디오의 방향을 결정하는 단계(S105, S405)를 더 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 1 항에 있어서,

추정하는 단계는 비디오의 가장 유력한 움직임을 추정하는 단계(S101, S401)를 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 2 항에 있어서,

결정된 방향은 비디오의 각각의 프레임에 대해 랜드스케이프 (0°, 180°) 방향 및 포트레이트 방향 (90°, -90°)을 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 1 항에 있어서,

추정하는 단계는, 각각의 순간에서, 비디오의 움직임의 파라메트릭 근사치를 계산하는 단계를 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 2 항에 있어서,

분할하는 단계는 추출된 회전-기반 파라미터들의 스레스홀딩을 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 2 항에 있어서,

결정하는 단계는 세그먼트 당 상기 적어도 하나의 피처의 하나의 대표적인 단일 값을 얻기 위해 세그먼트의 모든 프레임들에 대해 상기 적어도 하나의 피처를 적분함으로써 회전 이전 및 이후에 각각의 세그먼트의 방향을 계산하는 단계를 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 1 항에 있어서,

슬라이딩 타임 윈도우를 통해 상기 적어도 하나의 피처를 스무싱하는 단계를 더 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 2 항에 있어서,

상기 회전-기반 파라미터들의 회전 각도에 따라 결정된 결과로부터 비디오의 방향을 결정하는 단계(S405)를 더 포함하는, 비디오의 방향을 결정하기 위한 방법. - 제 9 항에 있어서,

회전 각도는 회전-기반 파라미터들의 사이너스(sinus)에 따라 결정되는, 비디오의 방향을 결정하기 위한 방법. - 제 9 항에 있어서,

결정된 방향은 비디오의 각각의 프레임에 대해 0°, 90°, -90° 및 180°의 방향을 포함하는, 비디오의 방향을 결정하기 위한 방법. - 비디오의 방향을 결정하기 위한 장치(700)로서,

비디오의 움직임을 추정하고;

추정된 비디오의 움직임으로부터 변환-기반 파라미터들을 추출하고; 및

변환 기반 파라미터들에 따라 수직 변환의 전개에 대하여 시간에 따른 수평 변환의 전개를 제공하는 적어도 하나의 피처를 계산하되, 피처가 비디오의 방향을 결정하기 위해 사용되는, 적어도 하나의 피처를 계산하도록 구성된 프로세서(710)를 포함하는, 비디오의 방향을 결정하기 위한 장치. - 통신 네트워크로부터 다운로드, 및/또는 컴퓨터에 의해 판독 가능한 매체에 기록, 및/또는 프로세서에 의해 실행 가능한 컴퓨터 프로그램 제품으로서,

제 1 항 내지 제 11 항 중 적어도 하나의 항에 따른 방법의 단계들을 구현하기 위한 프로그램 코드 명령들을 포함하는 컴퓨터 프로그램 제품. - 기록된 컴퓨터 프로그램 제품을 포함하고 프로세서에 의해 수행 가능한 비-일시적인 컴퓨터-판독 가능한 매체로서,

제 1 항 내지 제 11 항 중 적어도 한 항에 따른 방법의 단계들을 구현하기 위한 프로그램 코드 명령들을 포함하는 비-일시적인 컴퓨터-판독 가능한 매체.

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| EP14305275 | 2014-02-27 | ||

| EP14305275.1 | 2014-02-27 | ||

| PCT/EP2015/053746 WO2015128294A1 (en) | 2014-02-27 | 2015-02-23 | Method and apparatus for determining an orientation of a video |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20160126985A true KR20160126985A (ko) | 2016-11-02 |

Family

ID=50288014

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020167022482A KR20160126985A (ko) | 2014-02-27 | 2015-02-23 | 비디오의 방향을 결정하기 위한 방법 및 장치 |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US10147199B2 (ko) |

| EP (1) | EP3111419A1 (ko) |

| JP (1) | JP2017512398A (ko) |

| KR (1) | KR20160126985A (ko) |

| CN (1) | CN106030658B (ko) |

| WO (1) | WO2015128294A1 (ko) |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US11178531B2 (en) * | 2019-03-26 | 2021-11-16 | International Business Machines Corporation | Link devices using their relative positions |

| US11172132B1 (en) * | 2020-04-16 | 2021-11-09 | Lenovo (Singapore) Pte. Ltd. | Image save orientation determined based on orientation of object within image |

Family Cites Families (27)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US4209852A (en) * | 1974-11-11 | 1980-06-24 | Hyatt Gilbert P | Signal processing and memory arrangement |

| JPH08191411A (ja) * | 1994-11-08 | 1996-07-23 | Matsushita Electric Ind Co Ltd | シーン判別方法および代表画像記録・表示装置 |

| JPH09214973A (ja) * | 1996-01-30 | 1997-08-15 | Tsushin Hoso Kiko | 動画像符号化装置及び動画像復号化装置 |

| US6459822B1 (en) * | 1998-08-26 | 2002-10-01 | The United States Of America As Represented By The Administrator Of The National Aeronautics And Space Administration | Video image stabilization and registration |

| JP4328000B2 (ja) * | 2000-08-02 | 2009-09-09 | 富士通株式会社 | 動画像符号化装置および動画像の特殊効果シーン検出装置 |

| AU768455B2 (en) * | 2000-12-18 | 2003-12-11 | Canon Kabushiki Kaisha | A method for analysing apparent motion in digital video sequences |

| KR20040071945A (ko) * | 2003-02-07 | 2004-08-16 | 엘지전자 주식회사 | 부화면 조정이 가능한 영상표시기기 및 그 방법 |

| US7620202B2 (en) | 2003-06-12 | 2009-11-17 | Honda Motor Co., Ltd. | Target orientation estimation using depth sensing |

| US7312819B2 (en) * | 2003-11-24 | 2007-12-25 | Microsoft Corporation | Robust camera motion analysis for home video |

| US8279283B2 (en) * | 2005-11-18 | 2012-10-02 | Utc Fire & Security Americas Corporation, Inc. | Methods and systems for operating a video surveillance system |

| US7889794B2 (en) * | 2006-02-03 | 2011-02-15 | Eastman Kodak Company | Extracting key frame candidates from video clip |

| JP4958497B2 (ja) * | 2006-08-07 | 2012-06-20 | キヤノン株式会社 | 位置姿勢測定装置及び位置姿勢測定方法、複合現実感提示システム、コンピュータプログラム及び記憶媒体 |

| US20110255844A1 (en) * | 2007-10-29 | 2011-10-20 | France Telecom | System and method for parsing a video sequence |

| US8238612B2 (en) * | 2008-05-06 | 2012-08-07 | Honeywell International Inc. | Method and apparatus for vision based motion determination |

| JP5240044B2 (ja) * | 2009-04-23 | 2013-07-17 | ソニー株式会社 | 特徴区間判定装置、特徴区間判定方法、およびプログラム |

| US9124804B2 (en) * | 2010-03-22 | 2015-09-01 | Microsoft Technology Licensing, Llc | Using accelerometer information for determining orientation of pictures and video images |

| WO2012044218A1 (en) * | 2010-10-01 | 2012-04-05 | Saab Ab | A method and an apparatus for image-based navigation |

| US8953847B2 (en) | 2010-10-01 | 2015-02-10 | Saab Ab | Method and apparatus for solving position and orientation from correlated point features in images |

| US9082452B2 (en) * | 2011-02-21 | 2015-07-14 | Kodak Alaris Inc. | Method for media reliving on demand |

| US8879890B2 (en) * | 2011-02-21 | 2014-11-04 | Kodak Alaris Inc. | Method for media reliving playback |

| US8335350B2 (en) | 2011-02-24 | 2012-12-18 | Eastman Kodak Company | Extracting motion information from digital video sequences |

| JP6026443B2 (ja) | 2011-03-10 | 2016-11-16 | ヴィディオ・インコーポレーテッド | ビデオ・ビットストリーム中の描画方向情報 |

| US8744169B2 (en) * | 2011-05-31 | 2014-06-03 | Toyota Motor Europe Nv/Sa | Voting strategy for visual ego-motion from stereo |

| JP2013012821A (ja) * | 2011-06-28 | 2013-01-17 | Sony Corp | 画像フォーマット判別装置、画像フォーマット判別方法および電子機器 |

| US8708494B1 (en) * | 2012-01-30 | 2014-04-29 | Ditto Technologies, Inc. | Displaying glasses with recorded images |

| US9529426B2 (en) * | 2012-02-08 | 2016-12-27 | Microsoft Technology Licensing, Llc | Head pose tracking using a depth camera |

| US9367145B2 (en) * | 2013-03-14 | 2016-06-14 | Qualcomm Incorporated | Intelligent display image orientation based on relative motion detection |

-

2015

- 2015-02-23 WO PCT/EP2015/053746 patent/WO2015128294A1/en active Application Filing

- 2015-02-23 JP JP2016550835A patent/JP2017512398A/ja active Pending

- 2015-02-23 CN CN201580009769.2A patent/CN106030658B/zh not_active Expired - Fee Related

- 2015-02-23 EP EP15706783.6A patent/EP3111419A1/en not_active Withdrawn

- 2015-02-23 US US15/122,167 patent/US10147199B2/en not_active Expired - Fee Related

- 2015-02-23 KR KR1020167022482A patent/KR20160126985A/ko not_active Application Discontinuation

Also Published As

| Publication number | Publication date |

|---|---|

| EP3111419A1 (en) | 2017-01-04 |

| WO2015128294A1 (en) | 2015-09-03 |

| JP2017512398A (ja) | 2017-05-18 |

| CN106030658B (zh) | 2019-07-23 |

| US20160371828A1 (en) | 2016-12-22 |

| US10147199B2 (en) | 2018-12-04 |

| CN106030658A (zh) | 2016-10-12 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US10949952B2 (en) | Performing detail enhancement on a target in a denoised image | |

| US11430205B2 (en) | Method and apparatus for detecting salient object in image | |

| US10573018B2 (en) | Three dimensional scene reconstruction based on contextual analysis | |

| US9303525B2 (en) | Method and arrangement for multi-camera calibration | |

| US9177224B1 (en) | Object recognition and tracking | |

| WO2020018359A1 (en) | Three-dimensional living-body face detection method, face authentication recognition method, and apparatuses | |

| RU2607774C2 (ru) | Способ управления в системе захвата изображения, устройство управления и машиночитаемый носитель данных | |

| US9008366B1 (en) | Bio-inspired method of ground object cueing in airborne motion imagery | |

| EP3644599B1 (en) | Video processing method and apparatus, electronic device, and storage medium | |

| AU2016355215A1 (en) | Methods and systems for large-scale determination of RGBD camera poses | |

| US20180068451A1 (en) | Systems and methods for creating a cinemagraph | |

| CN109064504B (zh) | 图像处理方法、装置和计算机存储介质 | |

| Chen et al. | Variational fusion of time-of-flight and stereo data for depth estimation using edge-selective joint filtering | |

| CN109447022B (zh) | 一种镜头类型识别方法及装置 | |

| EP3471398A1 (en) | Image processing apparatus, image processing method, and non-transitory computer-readable storage medium | |

| CN109308704B (zh) | 背景剔除方法、装置、计算机设备及存储介质 | |

| CN110738078A (zh) | 一种人脸识别方法及终端设备 | |

| CN113239937A (zh) | 镜头偏移检测方法、装置、电子设备及可读存储介质 | |

| CN111199197B (zh) | 一种人脸识别的图像提取方法及处理设备 | |

| CN112435278B (zh) | 一种基于动态目标检测的视觉slam方法及装置 | |

| KR20160126985A (ko) | 비디오의 방향을 결정하기 위한 방법 및 장치 | |

| WO2022021287A1 (zh) | 实例分割模型的数据增强方法、训练方法和相关装置 | |

| US8953843B1 (en) | Selecting objects in a sequence of images | |

| WO2024001617A1 (zh) | 玩手机行为识别方法及装置 | |

| CN114494824B (zh) | 用于全景图像的目标检测方法、装置、设备及存储介质 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| WITB | Written withdrawal of application |