KR20150076119A - 감소현실 - Google Patents

감소현실 Download PDFInfo

- Publication number

- KR20150076119A KR20150076119A KR1020140188304A KR20140188304A KR20150076119A KR 20150076119 A KR20150076119 A KR 20150076119A KR 1020140188304 A KR1020140188304 A KR 1020140188304A KR 20140188304 A KR20140188304 A KR 20140188304A KR 20150076119 A KR20150076119 A KR 20150076119A

- Authority

- KR

- South Korea

- Prior art keywords

- target environment

- view

- images

- room

- objects

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Withdrawn

Links

- 230000003292 diminished effect Effects 0.000 title 1

- 230000003190 augmentative effect Effects 0.000 claims abstract description 48

- 230000003993 interaction Effects 0.000 claims abstract description 7

- 238000000034 method Methods 0.000 claims description 42

- 230000009467 reduction Effects 0.000 claims description 9

- 238000004590 computer program Methods 0.000 claims description 4

- 230000001052 transient effect Effects 0.000 claims 2

- 230000008569 process Effects 0.000 description 11

- 238000011960 computer-aided design Methods 0.000 description 9

- 238000003860 storage Methods 0.000 description 9

- 238000013461 design Methods 0.000 description 6

- 230000002452 interceptive effect Effects 0.000 description 6

- 238000010586 diagram Methods 0.000 description 5

- 238000005516 engineering process Methods 0.000 description 4

- 230000000712 assembly Effects 0.000 description 3

- 238000000429 assembly Methods 0.000 description 3

- 239000003086 colorant Substances 0.000 description 3

- 238000004891 communication Methods 0.000 description 3

- 230000008520 organization Effects 0.000 description 3

- 239000003973 paint Substances 0.000 description 3

- 238000012545 processing Methods 0.000 description 3

- 238000004458 analytical method Methods 0.000 description 2

- 230000001413 cellular effect Effects 0.000 description 2

- 238000004040 coloring Methods 0.000 description 2

- 238000005094 computer simulation Methods 0.000 description 2

- 230000000875 corresponding effect Effects 0.000 description 2

- 230000006870 function Effects 0.000 description 2

- 238000004519 manufacturing process Methods 0.000 description 2

- 238000000465 moulding Methods 0.000 description 2

- 230000003287 optical effect Effects 0.000 description 2

- 241000226585 Antennaria plantaginifolia Species 0.000 description 1

- 239000002390 adhesive tape Substances 0.000 description 1

- 230000006399 behavior Effects 0.000 description 1

- 238000012937 correction Methods 0.000 description 1

- 230000002596 correlated effect Effects 0.000 description 1

- 238000005034 decoration Methods 0.000 description 1

- 238000003708 edge detection Methods 0.000 description 1

- 238000009434 installation Methods 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 239000000463 material Substances 0.000 description 1

- 235000012054 meals Nutrition 0.000 description 1

- 238000005259 measurement Methods 0.000 description 1

- 230000007246 mechanism Effects 0.000 description 1

- 230000001737 promoting effect Effects 0.000 description 1

- 238000007634 remodeling Methods 0.000 description 1

- 239000004065 semiconductor Substances 0.000 description 1

- 238000006467 substitution reaction Methods 0.000 description 1

- 230000002123 temporal effect Effects 0.000 description 1

- 230000007723 transport mechanism Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T19/00—Manipulating 3D models or images for computer graphics

- G06T19/006—Mixed reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T17/00—Three dimensional [3D] modelling, e.g. data description of 3D objects

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/50—Depth or shape recovery

- G06T7/55—Depth or shape recovery from multiple images

- G06T7/564—Depth or shape recovery from multiple images from contours

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2210/00—Indexing scheme for image generation or computer graphics

- G06T2210/04—Architectural design, interior design

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Computer Graphics (AREA)

- Software Systems (AREA)

- Computer Hardware Design (AREA)

- General Engineering & Computer Science (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Geometry (AREA)

- Processing Or Creating Images (AREA)

- User Interface Of Digital Computer (AREA)

Abstract

컴퓨터 툴은 소스 이미지들로부터 대상 환경의 사용자 정의식 감소현실 이미지들을 생성한다. 감소현실 이미지들은, 소스 이미지들에서 디스플레이된 것보다 대상 환경에서 더 적은 실세계 오브젝트들을 디스플레이한다. 감소현실에서의 대상 환경의 3D 모델은 감소현실 이미지들로부터 형성된다. 3D 모델은, 현실에서 감소되고 사용자 선택식 오브젝트들의 정리/디클러터링된 대상 환경의 뷰들과의 증강현실 사용자 상호작용을 지원한다.

Description

증강현실의 도래로, 현실 이미지들과 가상 이미지 엘리먼트들의 다양한 조합들이 행해질 수도 있다. 하지만, 증강현실의 적용가능성을 제한하는 난제들 중 하나는 현실 자체이다. 리모델링될 집 내의 룸들의 현실 이미지들에 있어서, 새로운 가상의 소파를 두고 싶은 곳에 이미 소파가 존재한다. 새로운 캐비넷들을 가상화하길 필요로 하는 이미지들에 있어서 기존의 캐비넷들이 존재한다. 상이한 구성 등을 시각화하길 원하는 디스플레이된 오브젝트들이 존재한다. 매장의 현실 이미지들에 있어서, 다른 제품들을 두고 싶거나 현재 제품들을 재배열하고 싶은 선반들 상에 제품들이 존재한다. 대상 (subject) 을 새롭게 설계된 가상 상태가 되게 하기 위해 증강현실을 사용하길 원할 경우, 현실은 이미 "어디든" 존재한다.

따라서, 더 이상 요구되지 않는, 이미지에서 캡처된 상이한 현실 오브젝트들을 제거함으로써 정리된 현실 이미지들에 대한 필요성이 존재한다. 예를 들어, 부엌 캐비넷들과 같은 가상 오브젝트들의 구성들의 피팅이 적절히 분석될 수 있도록, 리모델링될 공간의 정확한 측정치들을 인지할 수 있기 위한 관련 필요성이 존재한다.

컴퓨터 보조식 기술들은, 제품 설계를 저작 (authoring) 하기 위한 소프트웨어 솔루션들과 관련된 컴퓨터 보조식 설계 또는 CAD 를 포함하도록 공지된다. 유사하게, CAE 는 컴퓨터 보조식 엔지니어링의 두문자어이며, 예를 들어, 그것은 장래 제품의 물리적인 거동을 시뮬레이팅하기 위한 소프트웨어 솔루션들과 관련된다. CAM 은 컴퓨터 보조식 제조를 나타내며, 통상적으로, 제조 프로세스들 및 동작들을 정의하기 위한 소프트웨어 솔루션들을 포함한다.

다수의 시스템들 및 프로그램들이, 제품을 형성하는 오브젝트들 (또는 부분들) 또는 오브젝트들의 어셈블리들의 설계를 위한 시장에 제공된다. 이들 CAD 시스템들은 사용자로 하여금 오브젝트들 또는 오브젝트들의 어셈블리들의 복잡한 3차원 또는 3D 모델들을 구성 및 조작하게 한다. 따라서, CAD 시스템들은 에지들 또는 라인들을 사용하여, 특정 케이스들에 있어서는 면들을 사용하여 모델링된 오브젝트들의 표현을 제공한다. 라인들 또는 에지들은 다양한 방식들로, 예를 들어, NURBS (non-uniform rational B-splines) 로 표현될 수도 있다. 이들 CAD 시스템들은 모델링된 오브젝트들의 부분들 또는 그 부분들의 어셈블리들을 관리하며, 이 모델링된 오브젝트들은 주로 지오메트리의 명세들 (specifications) 이다. 구체적으로, CAD 파일들은 명세들을 포함하고, 이 명세들로부터 지오메트리가 생성되고, 결국, 이 명세들은 표현이 생성되게 한다. 지오메트리 및 표현은 단일 CAD 파일 또는 다수의 CAD 파일들에 저장될 수도 있다. CAD 시스템들은 모델링된 오브젝트들을 설계자들에게 표현하기 위한 그래픽 툴들을 포함하고; 이들 툴들은 복잡한 오브젝트들의 디스플레이에 전용되며; CAD 시스템에 있어서 오브젝트를 표현하는 파일의 통상의 사이즈는 부분 당 일 메가바이트의 범위이고, 어셈블리는 수천개의 부분들을 포함할 수도 있다. CAD 시스템은 오브젝트들의 모델들을 관리하며, 이 오브젝트들의 모델들은 전자 파일들에 저장된다.

컴퓨터 보조식 기술들에 있어서, 그래픽 사용자 인터페이스 (GUI) 는 기술의 효율에 관하여 중요한 역할을 한다. 모델링된 오브젝트들을 조작 및/또는 네비게이팅하는데 요구된 동작들 중 대부분은 GUI 를 통해 사용자 (예를 들어, 설계자) 에 의해 수행될 수도 있다. 구체적으로, 사용자는, 제품을 형성하는 모델링된 오브젝트들을 생성, 변형, 및 삭제하고, 또한, 제품을 탐색하여, 모델링된 오브젝트들이 예를 들어 제품 구조를 통해 어떻게 상호관련되는지를 이해할 수도 있다. 통상, 이들 동작들은, GUI 의 측면들 상에 위치된 전용 메뉴들 및 아이콘들을 통해 수행된다. 최근, CAD 시스템들은 이들 동작들을 제품의 표현 인근에서 호출하는 것을 허용한다. 설계자는 마우스를 더 이상 메뉴들 및 아이콘들을 향해 이동시킬 필요가 없다. 따라서, 동작들은 마우스의 범위 내에서 이용가능하다. 부가적으로, 동작들은 의미론적으로 거동하며: 설계자에 의해 선택된 소정의 동작에 대해, CAD 시스템은, 설계자가 선택할 가능성있는 과거에 선택된 동작에 따라 새로운 동작들의 세트를 마우스의 한층더 인근에서 설계자에게 제안 (suggest) 할 수도 있다.

다양한 환경들이 본 발명의 실시형태들에서의 관심 대상일 수도 있다. 설명의 명료화를 위해, 예시적인 환경들이 도면들 및 하기 논의들에서 제시된다. 이들 예들은 본 발명의 원리들의 예시의 목적일 뿐 한정의 목적은 아니다. 대상 환경들은, 비-한정적인 예에 대해, 집 또는 사무실 내의 룸, 소매 상점의 특정 통로들 또는 다른 부분, 및 다른 사용자 구성가능 영역들일 수도 있다.

대상 환경은 상이한 스테이지들 또는 상태들을 갖는다. 룸의 예에 있어서, 빈 (bare) 스테이지는 일반적으로 "오브젝트들" 인 가구 및 비품들이 룸에 없음을 의미한다. 반대 스테이지, 즉, 풀 스테이지에서, 룸은 다수의 오브젝트들을 갖는다. 중간 스테이지들에서, 룸은 중간 개수들의 오브젝트들, 즉, 풀 스테이지에서보다는 많지 않지만 하나 이상의 피스들의 가구 및 비품들을 갖는다. 유사하게, 상점 통로의 예에 있어서, 빈 스테이지에서, 상점 통로의 선반들에는 제품/재고품이 없다 (어떠한 오브젝트들도 보유하지 않음). 또는 어떠한 선반들/선반 유닛들도 존재하지 않을 수도 있다. 중간 스테이지들에서, 선반들은 어떤 양의 제품 (중간 개수들의 오브젝트들) 을 갖는다. 풀 스테이지에서, 선반들은 대략 그 최고 개수의 오브젝트들을 갖는다. 기타 등등이다.

일반적으로, 오브젝트들은 환경에 있어서 물리적 배치 (배열/조직) 및 배향에서 변경될 수 있다. 오브젝트들은 컬러 및/또는 재료 마감 (또는 텍스처) 에서 업데이트될 수 있다. 오브젝트들은, 상이한 스타일들 및/또는 구성 (형상, 사이즈 및 다른 물리 특성들) 을 갖는 대안적인 오브젝트들과 교환되거나 대체될 수 있다.

중간 또는 풀 스테이지에서의 대상 환경의 이미지들은 다양한 오브젝트들을 캡처하고 현재 현실을 묘화한다. 이미지들을 보는 사람은 대상 환경에 있어서의 컬러 또는 마감 (텍스처) 에서 업데이트된 디스플레이된 오브젝트들 중 일부를 상상 가능할 수도 있다. 증강현실 뷰는 디스플레이된 오브젝트들의 그러한 외관들을 변경하는 것을 보조 가능할 수도 있다. 하지만, 증강현실이 있거나 없는 이미지들을 보는 사람은 통상적으로, 대상 환경에 있어서 재배열되거나 대상 환경에 있어서 대안들로부터 제거되거나 대안들로 대체된 디스플레이된 오브젝트들 중 일부를 상상할 수 없다.

본 발명의 실시형태들은 전술한 관심사들을 다루며 다음과 같이 동작한다.

예시적인 실시형태에 있어서, 현실 스테이징 엔진은 현재 환경의 이미지 뷰를 사용자-요구된 스테이지로, 예를 들어, 상기 예들에 있어서 집의 부분적으로 또는 완전히 비어있는 룸 또는 상점에서의 비어있는 선반으로 설정한다. (요구된/선택된 스테이지에서의 대상 환경의) 결과적인 뷰는 "차원 현실" 로서 지칭된다. 3D 모델링 엔진 또는 모델러는 대상 환경의 감소현실 버전의 작동 3D 모델을 생성한다.

증강현실 서브시스템은 다양한 디스플레이 엘리먼트들 (가상 엘리먼트들) 을 3D 모델 감소현실 뷰 상에 중첩(superimpose)한다. 디스플레이 엘리먼트들은, 사용자에 대한 새롭게 묘화된 증강현실 뷰에 대상 환경을 배치하는 사용자-부가된, 교환된 또는 변경된 (재배열된, 재배향된, 또는 그렇지 않으면 재구성된) 실세계 오브젝트들을 나타낸다.

전술한 바는, 동일한 참조 부호들이 상이한 도면들 전반에 걸쳐 동일한 부분들을 참조하는 첨부 도면들에서 도시된 바와 같은 본 발명의 예시적인 실시형태들의 다음의 더 상세한 설명으로부터 명백할 것이다. 도면들은 반드시 축척에 맞춰지는 것은 아니며, 대신, 본 발명의 실시형태들을 도시하는 것에 강조된다.

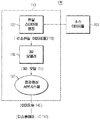

도 1 은 본 발명의 실시형태의 블록 다이어그램이다.

도 2a 내지 도 2c 는 일 실시형태에 있어서 사용자-상호작용 동작을 도시하기 위해 마크-업 (mark-up) 된 사진들이다.

도 3a 및 도 3b 는 실시형태에 있어서의 사용자-상호작용을 도시하기 위해 마크-업된 사진들이다.

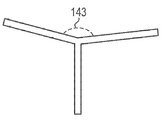

도 4a 내지 도 4d 는 실시형태들에 있어서 프로세싱 시 고려되는 이미지들에서의 각도들의 개략적 예시들이다.

도 5 는 본 발명을 구현하는 컴퓨터 시스템의 블록 다이어그램이다.

도 6 은 도 5 의 컴퓨터 시스템을 구현하는 컴퓨터 네트워크의 개략도이다.

도 1 은 본 발명의 실시형태의 블록 다이어그램이다.

도 2a 내지 도 2c 는 일 실시형태에 있어서 사용자-상호작용 동작을 도시하기 위해 마크-업 (mark-up) 된 사진들이다.

도 3a 및 도 3b 는 실시형태에 있어서의 사용자-상호작용을 도시하기 위해 마크-업된 사진들이다.

도 4a 내지 도 4d 는 실시형태들에 있어서 프로세싱 시 고려되는 이미지들에서의 각도들의 개략적 예시들이다.

도 5 는 본 발명을 구현하는 컴퓨터 시스템의 블록 다이어그램이다.

도 6 은 도 5 의 컴퓨터 시스템을 구현하는 컴퓨터 네트워크의 개략도이다.

본 발명의 예시적인 실시형태들의 설명이 뒤따른다.

본 명세서에서 인용된 모든 특허들, 공개 출원들, 및 참증들의 교시들이 전부 참조로 통합된다.

비-한정적인 예시 실시형태가 도 1 에 컴퓨터 기반 툴 (100) 로서 도시된다. 다른 컴퓨터 기반 방법들, 시스템들 및 컴퓨터 프로그램 제품들이 본 발명의 다른 실시형태들 및 구현들을 제공할 수도 있음이 이해된다. 툴 (100) 은 프로세서 실행식 현실 스테이징 엔진 (107) 및 3D 모델러 (110) 로 형성된다. 프로세서 (113) 는 툴 (100), 현실 스테이징 엔진 (107) 및 3D 모델러 (110) 를 실행하거나 그렇지 않으면 지원한다. 하기에서 명확하게 될 바와 같이, 현실 스테이징 엔진 (107) 은 소스 (105) 로부터의 (관심있는 환경의) 대상 이미지들에서의 현실을 디클러터링(declutter)하거나 정리하거나 또는 그렇지 않으면 감소시킨다. 이미지 소스 (105) 는 카메라, 2D 또는 3D 스캐너, 하나 이상의 데이터 저장부들 (이미지들의 데이터베이스), 비디오 스트림 등일 수도 있다.

소스 이미지 (105) 에서 디스플레이된 바와 같은 대상 환경에 있어서의 복수의 오브젝트들 각각에 대해, 감소현실 뷰에 있어서의 오브젝트의 디스플레이는 사용자-선택가능식이다. 이러한 방식으로, 스테이징 엔진 (107) 에 의해 생성된 이미지들 (115) 에 있어서의 감소현실 (현실의 감소) 의 정도는 사용자 정의가능식이다.

3D 모델러 (110) 는 스테이징 엔진 (107) 으로부터의 감소현실 이미지들 (115) 을 입력으로서 수신한다. 3D 모델러 (110) 는 수신된 감소현실 이미지들 (115) 의 대상 또는 콘텐츠의 3D 모델 (131) 을 생성한다. 즉, 3D 모델러 (110) 는 사용자-선택된 감소 스테이지, 예를 들어, 빈 또는 중간 스테이지에서 관심있는 환경의 3D 모델 (131) 을 생성한다. 이미지 기술로부터의 3D 모델링이 채용된다.

증강현실 서브시스템 (121) 은 다양한 가상 이미지 엘리먼트들을, 모델러 (110) 로부터의 3 모델 (131) 상에 중첩 또는 그렇지 않으면 오버랩한다. 예를 들어, 다양한 후보 엘리먼트들 (가상) 의 이미지들은, 출력 (103) 에서, 관심있는 대상 환경의 디클러터링된 또는 정리된 장면들 (감소현실) 상에 디스플레이된다. 서브시스템 (121) 의 그래픽 사용자 인터페이스는 사용자로 하여금 공지된 기술들을 사용하여 그러한 증강현실 이미지 (140) 출력과 상호작용할 수 있게 한다.

현실 스테이징 엔진 (107) 및 툴 (100) 의 추가 상세들이 다음에 제시된다.

홈의 룸들의 이미지들 (125, 127) (도 2a 내지 도 2c 그리고 도 3a 및 도 3b) 의 예는 예시하고 한정하지 않을 목적으로 이용된다. 툴 (100) 은, 전체적으로 또는 부분적으로 비어있는 룸의 3D 컴퓨터 모델 표현을 생성하기 위해 연관된 배향 데이터를 갖는 대상 비치된 룸의 하나 또는 수개의 사진들 (이미지들) 을 이용한다. 예를 들어, 현실 스테이징 엔진 (107) 은, 현재 가구의 설치 전이라도 사용자가 대체하고 싶은 장비 또는 액세서리들과 같이 룸의 초기 공간의 뷰들 (115) 을 재생한다. 구체적으로, 현실 스테이징 엔진 (107) 은 현재 룸의 하나 또는 수개의 이미지들 (125, 127) (실시간 또는 사진) 을 이미지 소스 (105) 로부터 입력으로서 획득한다. 툴 (100) 은 도 2a 및 도 3a 에서와 같이 사용자 상호작용을 위해 소스 이미지를 사용자에게 디스플레이한다. 사용자는 룸의 논리적 지오메트릭 부분들 또는 영역들 (즉, 인접 수평 벽에 대한 벽, 천장에 대한 벽들, 및 바닥에 대한 벽들) 간의 각진 경계(border)들을 나타내는 가시적인 라인 세그먼트들을 이미지들 (125, 127) 상에서 식별한다. 사용자는 이들 라인 세그먼트들을, 사용자가 실세계 오브젝트들을 나타내는 새로운 가상 엘리먼트들 (예를 들어, 새로운 또는 후보 가구, 액세서리들 등) 을 두기를 원하는 이미지 영역들에서 적어도 식별한다. 경계들 중 일부는 디스플레이될 때 소스 이미지 (125, 127) 에서의 뷰에 의존하여 은닉되어, 사용자는 오직 소정 라인의 세그먼트들만을 표시한다.

도 3b 의 예에 있어서, 사용자는 천장으로부터 디스플레이된 텔레비전 (102) 의 상부 에지 바로 위까지의 2개의 벽들의 만남을 정의하는 라인 세그먼트 (129) 를 표시한다. 텔레비전 (102) 및 스탠드 (104) 뒤의 코너 영역을 정의하는 라인 세그먼트들 (126) 은 이 뷰 (이미지 (125)) 에서 은닉되거나 차단된다. 사용자는 이들 라인 세그먼트들 (126) 을 묘화하지 않는다. 도 2c에 있어서, 사용자는 룸의 출입구 개방을 아웃라이닝한 라인 세그먼트 (123) 를 표시하였다. 유사하게, 도 3b 의 예에 있어서, 사용자는, 오직, 캐비넷들 (108) 사이의 가시적인 벽-천장 접합부의 라인 세그먼트들 (133) 을 표시하고, 디스플레이된 뷰 (이미지 (127)) 에서 가시적인 2개의 벽들이 만나는 경우를 정의하는 라인 세그먼트들 (135) 을 표시한다. 사용자는 (하기에서 명확하게 될 바와 같이) 디스플레이된 냉장고 및 캐비넷들 (108) 위의 라인 세그먼트들 (136) 을 묘화하지 않는다.

다음으로, 현실 스테이징 엔진 (107) 은 사용자로 하여금 천장, 벽들 및 바닥에 각각 적용되는 텍스처들 (139a, 139b, 139c) 을 상호작용적으로 식별할 수 있게 한다. 이는, 일 실시형태에서, 그 룸 엘리먼트 (벽, 천장 및 바닥) 의 초기 상태를 나타내는 벽, 천장 및 바닥 각각의 영역을, 디스플레이된 이미지 (125, 127) 상에 원표시하는 사용자에 의해 실행된다.

도 2b 및 도 3b 의 예들에 있어서, 사용자는 디스플레이된 이미지들 (125, 127) 에 있어서의 방해받지 않는 위치들에서의 천장들 및 벽들의 페인트 컬러들 및 텍스처들 (139a, 139b) 을 원표시한다. 유사하게, 사용자는 개별 바닥 컬러들 및 텍스처들 (139c) 을 표시하기 위해, 디스플레이된 바닥들의 방해받지 않은 대표적 영역들 (139c) 을 원표시한다.

전술한 사용자 선택들 (상호작용식 입력) 로, 현실 스테이징 엔지 (107) 은 다음의 결정을 행한다. 현실 스테이징 엔진 (107) 은 도 2b 및 도 3b 에서 사용자에 의해 개시된 경계 라인들을 완성한다. 특히, 현실 스테이징 엔진 (107) 은 도 2b, 도 2c 및 도 3b 에서 완성된 채로 도시된 바와 같은 디스플레이된 비품들 또는 다른 오브젝트들 뒤 은닉된 코너들에서 교차하는 경계 라인들을 완성한다. 현실 스테이징 엔진 (107) 은 도 2b 및 도 2c 에서의 디스플레이된 텔레비전 (102) 및 스탠드 (104) 위의 라인 세그먼트들 (126) 및 도 3b 에서의 냉장고 및 캐비넷들 (상부 및 하부) (108) 위의 라인 세그먼트들 (136) 을 묘화한다. 완성된 경계 라인들로부터, 현실 스테이징 엔진 (107) 은, 예를 들어, 그 빈 또는 비어있는 스테이지에 있어서 룸 (대상 환경) 을 결정한다.

전술한 바는 대상 환경의 수개의 소스 이미지들 (105) (룸의 예에 있어서의 이미지들 (125, 127)) 에 대해 반복된다. 상기의 각각의 반복은 상이한 소스 이미지 (105) 에 관한 것이다. 상이한 소스 이미지들 (105) 은 대상 환경 (예를 들어, 룸) 및 그 내부의 실세계 오브젝트들의 뷰의 상이한 부분들 및 상이한 각도들을 도시한다. 전술한 절차는 사용자로 하여금, 오브젝트별 기반으로, 소스 이미지들 (105) 에서 디스플레이된 바와 같은 대상 환경에 있어서의 각각의 오브젝트의 디스플레이를 선택적으로 유지 또는 제거하게 한다. 그에 따라, 작동 뷰들에 있어서의 대상 환경의 (빈/비어있는 스테이지로부터 중간 스테이지로의 범위에서) 감소현실의 정도는 툴 (100) 에 있어서 사용자-정의가능식이다.

다음으로, 현실 스테이징 엔진 (107) 은 소스 이미지들 (125, 127) 에 있어서 어디가 노출된 영역들 (즉, 벽, 천장, 몰딩, 바닥, 플린스(plinth)) 인지를 결정한다. 현실 스테이징 엔진 (107) 은 이들 영역들로부터, 사용자에 의해 원-표시된 페인트 컬러 및 텍스처를 결정한다.

전술한 결정들의 결과들은 빈 또는 비어있는 스테이지 또는 다른 사용자-선택된 중간 스테이지에 있어서 룸 (대상 환경) 의 감소현실 이미지들 (115) 을 생성한다. 도 2 및 도 3 의 룸의 예에 있어서, 감소현실 이미지들 (115) 은 바닥, 천장, 벽들, 출입구(들) 및 창문(들), 즉, 대상 환경 (룸) 의 포함 경계들을 정의하는 주면들 및 평면들을 대부분 디스플레이한다. 현실 스테이징 엔진 (107) 은 빈 스테이지 대상 환경 (즉, 도 2a 내지 도 2c 의 예에 있어서의 비어있거나 거의 비어있는 거실 및 도 3a 및 도 3b 의 예에 있어서의 비어있거나 거의 비어있는 부엌) 의 작동 3D 모델 (131) (도 1) 을 생성하기 위해 결과적인 감소현실 이미지들 (115) 을 3D 모델러 (110) 에 제공한다. 작동 3D 모델 (131) 의 각각의 영역은 소스 이미지들 (125, 127) 의 사용자-원표시 영역들에 대응하는 컬러 및 텍스처를 이용하여 전체적으로 페인팅된다. 구배들이 3D 모델 (131) 의 컬러링 및 텍스처링을 위해 사용될 수 있다. 페인트는, 도 2a 내지 도 2c 뿐 아니라 도 3a 및 도 3b 에 도시된 바와 같이, 룸의 모든 가시적인 프레임들에 대한 적절한 텍스처로 3D 작동 모델 (131) 의 각각의 영역을 커버한다.

상이한 배향들 및 위치들로부터 다중의 이미지들 (115) 이 주어지면, 3D 모델러 (110) 는 룸 (소스 이미지들 (105) 에서 캡처된 대상 환경) 의 3D 컴퓨터 모델 또는 3D 이미지 표현을, 빈 스테이지에서 또는 소스 이미지들 (125, 127) 에서 디스플레이된 것과는 적어도 상이한 스테이지에서 생성한다. 3D 모델러 (110) 는 2D 이미지-모델 기술을 활용한다. 결과적인 작동 3D 모델 (131) 은 소스 (105) 의 카메라의 배향에 독립적이다.

결과로서, 비어있는 룸 (또는 부분적으로 비어진 룸) 의 완전한 3D 모델/이미지 표현 (131) 이 생성될 수 있다. 도 2a 내지 도 2c 그리고 도 3a 및 도 3b 의 거실 및 부엌의 예에 있어서, 이들 룸들에서 가구, 편의시설 및 캐비넷류를 뺀 3D 모델 표현 (131) 이 생성된다.

3D 모델러 (110) 는 생성된 3D 모델 (131) 을, 예를 들어, 입력으로서 증강현실 서브시스템 (121) 에 출력한다. 차례로, 3D 모델 (131) 이미지들은 증강현실과 상호작용적으로 이용될 수 있다. 예를 들어, 증강현실에 있어서의 3D 모델 (131) 이미지들은 도 2a 내지 도 3c 의 예들에 있어서 새로운 부엌의 설계 또는 거실의 리모델링 또는 인테리어 장식물/비품을 확인하는데 이용될 수 있다. 다른 예들에 있어서, 소매 매장 및 선반들은 판촉 계획 및 제품 재고처리 설계를 확인하는데 이용될 수 있다. 증강현실 서브시스템 (121) 은 사용자로 하여금 빈 스테이지 대상 환경/비어있는 룸의 3D 모델 (131) 이미지들 상에 이미지 엘리먼트들을 오버레이 또는 중첩할 수 있게 한다. 이미지 엘리먼트들은 대상 룸들에 대한 가구, 비품들, 편의시설들, 액세서리들, 캐비넷류 등과 같은 타깃 또는 후보 실세계 오브젝트들의 이미지들 또는 초상일 수도 있다.

후보 오브젝트들은 소스 이미지들 (105) 에서 디스플레이된 카운터파트 오브젝트들의 치환 또는 대체일 수도 있다. 후보 오브젝트들은 소스 이미지들 (105) 에서 디스플레이된 카운터파트 오브젝트들의 재배열 또는 상이한 조직 (구성) 일 수도 있다. 후보 오브젝트들은 소스 이미지 (105) 에 있어서 어떠한 카운터파트 또는 균등물도 갖지 않을 수도 있어서, 사용자가 가상 뷰들 (140) 에 있어서 대상 환경/룸으로 새로운 오브젝트들을 도식적으로 도입할 수 있다. 이들 시나리오들의 임의의 혼합이 증강현실 서브시스템 (121) 에 의해 지원된다.

다른 실시형태들에 있어서, 상기 설명된 가상 뷰들 (140) 을 교환하는 시나리오는 다양한 공지의 컬러링 및 표면 텍스처링 툴들에 부가하거나 그 툴들과 조합될 수도 있다. 그러한 조합은 사용자로 하여금 구조 기반 오브젝트 구성들 (오브젝트 형상들, 사이즈들, 지오메트리들) 을 가상적으로 탐색할 뿐 아니라 미학 및 인테리어 설계 기반 구성들 (오브젝트 컬러들, 텍스처들, 그룹핑들 및 패턴들) 을 고려할 수 있게 한다.

이들 및 다른 이용들/어플리케이션들에 있어서, 사용자가 현실의 다른 양들 (소스 이미지 (105) 에서 디스플레이된 바와 같은 대상 환경에 있어서의 실세계 오브젝트들) 의 외관들을 차단/방해하지 않으면서 (대상 환경의) 소스 이미지의 현실의 일부 사용자 정의가능 양이 유지되게 한다.

증강현실 서브시스템 (121) 은 최종 사용자들로 하여금 증강현실 디스플레이 디바이스 (103) 로 출력 이미지 (140) 뷰를 인식할 수 있게 한다 (도 1). 실시형태들에 있어서, 증강현실 뷰 (140) 는 마커리스 (markerless) 형태로 디스플레이될 수도 있지만, 마커들의 사용자-상호작용식 수동 지정 또는 이용을 허용할 수도 있다. 다른 실시형태들이 추가의 자동화된 사용자 상호작용을 가능케 한다.

3D 모델 (131) 로부터, 증강현실 서브시스템 (121) 은 출력 이미지들 (140) 에 있어서의 대상 환경 뷰의 작동하는 또는 논리적으로 동작하는 라인들을 결정 및 정의한다. 일 실시형태에 있어서 이것을 달성하기 위한 절차는 다음과 같다.

천장 및 몰딩들로 시작함,

문들 근방의 바닥으로 계속함 (플린스들을 이용함),

벽들 사이의 수직 라인 세그먼트들을 봄,

그들 근방의 창문들 및 프레임들을 봄, 그리고

그들 근방의 문들 및 프레임들을 봄.

다음으로, 증강현실 서브시스템 (121) 은 출력 이미지들 (140) 및 대응하는 라인들을 생성한다. 먼저, 에지 검출 알고리즘이 출력 이미지 (140) 에 적용된다. 그 결과는 추가의 분석을 필요로 하는 다수의 라인들이다.

다음으로, 광학으로 인한 배럴 및 핀쿠션 왜곡들이 직선 이미지 (140) 를 생성하기 위해 제거된다. 그 결과는 메인 에지들에 대한 직선들을 갖는 클린 이미지이다. 이러한 단계는 소스 이미지 (105) 에 대한 카메라에 의해 이용된 광학의 품질에 의존하여 회피될 수도 있다.

증강현실 서브시스템 (121) 에 의해 출력된 이미지들 (140) 과 같은 이미지들은 5개의 상이한 파라미터들: 즉, 팬, 틸트, 줌, 롤 및 초점면을 갖는다. 일부 실시형태들에 있어서, 공지의 알고리즘들이 초점면을 위해 채용된다. 다른 실시형태들에 있어서, 초점면 파라미터들은 무시된다.

팬에 대한 이미지 (140) 파라미터들은, 컴파스 센서에 의해 추적되는 서브시스템 (121) 카메라의 배향에 의해 캡처될 수 있다.

이미지 (140) 줌 파라미터는 대상 환경에 있어서의 벽 또는 평탄면의 마스킹되지 않은 부분에 대한 레퍼런스를 이용함으로써 캡처될 수 있다. 예를 들어, 대각선을 따라 2개로 접혀진 종이의 표준 피스 (예를 들어, 종이의 8.5" × 11" 또는 A4 시트). 접혀진 종이는 벽/레퍼런스 표면의 마스킹되지 않은 부분에 대해, 투명 접착 테이프로 테이핑될 수 있다. 이는 증강현실 서브시스템 (121) 에 의해 인식될 것이고, 종이에 대한 줌 및 거리를 제공한다.

출력 이미지들 (140) 의 롤 파라미터는, 이미지 (140) 의 거의 수직 에지들을 보고 에지 트루 수직들을 만들기 위해 롤을 조정하는 서브시스템 (121) 에 의해 측정될 수 있다.

틸트는 이미지 (140) 의 캡처에서 서브시스템 (121) 카메라의 높이에 의존하며, 이는 이미지를 취하는 사람의 높이에 관련된다. 출력 이미지들 (140) 에 대한 틸트는 동일한 이미지 프레임 또는 복수의 상이한 이미지들 (프레임들) 에 대하여 천장 및 바닥을 커버할 것이다.

천장의 코너들을 디스플레이하는 출력 이미지 (140) 의 경우, 증강현실 서브시스템 (121) 은 각각의 벽의 천장과의 교차에 의해 생성된 2개의 라인들 간의 겉보기 각도에 의존하여 이미지를 생성 및 조정한다. 도 4a 에 도시된 바와 같이 상위 각도 (143) 가 180도 미만이면, 출력 이미지 (140) 에서의 삼면체의 교차 포인트로부터 서브시스템 (121) 카메라까지의 거리는 대상 환경에서의 삼면체와 소스 이미지 (105) 카메라 간의 거리보다 크다. 도 4b 에 도시된 바와 같이 상위 각도 (143) 가 180도 초과이면, 출력 이미지 (140) 에서의 삼면체의 교차 포인트로부터 증강현실 서브시스템 (121) 카메라까지의 거리는 대상 환경에서의 삼면체와 소스 이미지 (105) 카메라 간의 거리보다 짧다. 따라서, 증강현실 서브시스템 (121) 카메라는, 소스 이미지 (105) 가 취해졌을 경우에 소스 이미지 카메라의 카운터파트 포지션 앞에 있다.

유사하게, 바닥의 코너들을 포함하는 출력 이미지들 (140) 의 경우. 증강현실 서브시스템 (121) 은 각각의 벽의 바닥과의 교차에 의해 생성된 2개의 라인들 간의 겉보기 각도에 의존하여 이미지 (140) 를 조정한다. 도 4c 에 도시된 바와 같이 삼면체의 하위 각도 (145) 가 180도 미만이면, 출력 이미지 (140) 에서의 교차 포인트와 증강현실 서브시스템 (121) 에서의 카메라 간의 거리는, 소스 이미지 (105) 가 취해졌을 경우에 소스 이미지 카메라의 카운터파트 거리보다 크다.

도 4d 에 도시된 바와 같이 삼면체의 하위 각도 (145) 가 180도 초과이면, 출력 이미지 (140) 에서의 교차 포인트와 증강현실 서브시스템 (121) 에서의 카메라 간의 거리는, 소스 이미지 (105) 가 취해졌을 경우에 소스 이미지 카메라의 카운터파트 거리보다 가깝다 (짧다).

이들 모든 코너들에 대해, 초기 가정은 벽들의 2개의 인접한 평면들 사이에 90도의 각도가 존재한다는 점이다. 룸 주위의 벽들의 각도들의 총합이 360도와 동일하지 않으면 정정이 적용된다.

그 솔루션은, 적절한 계산 리소스들에 의해 실시간으로, 단계별로 반자동이거나 완전 자동일 수 있다.

도 5 는, 컴퓨터 시스템으로서 본 명세서에서 또한 지칭될 수도 있는 예시적인 컴퓨터 보조식 설계 스테이션 (300) 의 개략 블록 다이어그램이다. 본 명세서에서 사용된 바와 같이, 용어들 "컴퓨터 보조식 설계 스테이션" 및 "컴퓨터 시스템" 은, 일반적으로, 상기 설명된 프로세스들 및/또는 상기 설명된 것들과 관련될 수도 있는 임의의 부가적인 프로세스들을 수행하는데 이용될 수도 있는 임의의 적합한 컴퓨팅 디바이스를 지칭한다.

예시적인 실시형태에 있어서, 컴퓨터 보조식 설계 스테이션 (300) 은 상기 설명된 프로세스들 및/또는 상기 설명된 것들과 관련될 수도 있는 임의의 부가적인 프로세스들을 수행하는 하나 이상의 프로세서들 (302) (CPU) 을 포함한다. 용어 "프로세서" 는, 일반적으로, 시스템들 및 마이크로 제어기들을 포함하는 임의의 프로그램가능 시스템, 감소된 명령 세트 회로들 (RISC), 주문형 집적 회로들 (ASIC), 프로그램가능 로직 회로들, 및/또는 본 명세서에서 설명된 기능들을 실행 가능한 임의의 다른 회로 또는 프로세서를 지칭함이 이해되어야 한다. 상기 예들은 단지 예시적일 뿐이고, 따라서, 어떤 방식으로든 용어 "프로세서" 의 정의 및/또는 의미를 한정하도록 의도되지 않는다.

상기 설명된 프로세스들 및/또는 상기 설명된 것들과 관련될 수도 있는 임의의 부가적인 프로세스들의 단계들은, 예를 들어, 시스템 버스 (306) 에 의해 프로세서 (302) 에 동작가능하게 및/또는 통신가능하게 커플링된 메모리 영역 (304) 과 같은 비-일시적인 컴퓨터 판독가능 매체에, 컴퓨터 실행가능 명령들로서 저장될 수도 있다. 본 명세서에서 사용된 바와 같은 "메모리 영역" 은, 일반적으로, 감소현실 툴 (100) 을 이용하여 관심있는 환경의 감소현실 뷰들 (이미지들) 을 생성하는 것을 보조하기 위해 하나 이상의 프로세서들에 의해 실행가능한 프로그램 코드 및 명령들을 저장하는 임의의 수단을 지칭한다. 메모리 영역 (304) 은 메모리의 하나의 또는 하나 초과의 형태들을 포함할 수도 있다. 예를 들어, 메모리 영역 (304) 은 비-휘발성 RAM, 자기 RAM, 강유전체 RAM, 및/또는 다른 형태들의 RAM 을 포함할 수 있는 랜덤 액세스 메모리 (RAM) (308) 를 포함할 수도 있다. 메모리 영역 (304) 은 또한 판독 전용 메모리 (ROM) (310) 및/또는 플래시 메모리 및/또는 전기적으로 소거가능한 프로그램가능 판독 전용 메모리 (EEPROM) 를 포함할 수도 있다. 다른 형태들의 메모리 단독 또는 그와 조합하여, 하드 디스크 드라이브 (HDD) (312) 와 같은 임의의 다른 적합한 자기, 광학, 및/또는 반도체 메모리가 메모리 영역 (304) 에 포함될 수도 있다. HDD (312) 는 또한, 메시지들을 프로세서 (302) 로 송신하고 프로세서 (302) 로부터 수신하는데 사용을 위해 디스크 제어기 (314) 에 커플링될 수도 있다. 더욱이, 메모리 영역 (304) 은 또한, 적합한 카트리지 디스크, CD-ROM, DVD, 또는 USB 메모리와 같은 분리가능 또는 착탈가능 메모리 (316) 일 수도 있거나 또는 그를 포함할 수도 있다. 상기 예들은 단지 예시적일 뿐이고, 따라서, 어떤 방식으로든 용어 "메모리 영역" 의 정의 및/또는 의미를 한정하도록 의도되지 않는다.

컴퓨터 보조식 설계 스테이션 (300) 은 또한, 디스플레이 제어기 (320) 에 동작가능하게 커플링된 것과 같이 커플링된 디스플레이 디바이스 (318) 를 포함한다. 디스플레이 제어기 (320) 는 디스플레이 디바이스 (318) 에 의한 디스플레이를 위해 시스템 버스 (306) 를 통해 데이터를 수신한다. 디스플레이 디바이스 (318) 는, 한정 없이, 모니터, 텔레비전 디스플레이, 플라즈마 디스플레이, 액정 디스플레이 (LCD), 발광 다이오드들에 기초한 디스플레이 (LED), 유기 LED들에 기초한 디스플레이 (OLED), 폴리머 LED들에 기초한 디스플레이, 표면-전도 전자 방출기들에 기초한 디스플레이, 투영된 및/또는 반사된 이미지를 포함하는 디스플레이, 또는 임의의 다른 적합한 전자 디바이스 또는 디스플레이 메커니즘일 수도 있다. 더욱이, 디스플레이 디바이스 (318) 는 연관된 터치스크린 제어기를 갖는 터치스크린을 포함할 수도 있다. 상기 예들은 단지 예시적일 뿐이고, 따라서, 어떤 방식으로든 용어 "디스플레이 디바이스" 의 정의 및/또는 의미를 한정하도록 의도되지 않는다.

부가적으로, 컴퓨터 보조식 설계 스테이션 (300) 은 네트워크 (도 5 에 도시 안됨) 와 통신할 시에 사용을 위한 네트워크 인터페이스 (322) 를 포함한다. 더욱이, 컴퓨터 보조식 설계 스테이션 (300) 은 키보드 (324), 및/또는 롤러 볼, 마우스, 터치패드 등과 같은 포인팅 디바이스 (326) 와 같은 하나 이상의 입력 디바이스들을 포함한다. 입력 디바이스들은, 시스템 버스 (306) 에 추가로 커플링되는 입력/출력 (I/O) 인터페이스 (328) 에 커플링되고 그에 의해 제어된다.

디스플레이 디바이스 (318), 키보드 (324), 포인팅 디바이스 (326) 뿐만 아니라 디스플레이 제어기 (320), 디스크 제어기 (314), 네트워크 인터페이스 (322), 및 I/O 인터페이스 (328) 의 일반적인 특징들 및 기능의 설명은, 이들 특징들이 공지되어 있으므로, 간결성을 위해 본 명세서에서 생략된다.

도 6 은 상기 설명된 프로세스들 및/또는 상기 설명된 것들과 관련될 수도 있는 부가적인 프로세스들과 같은 관심있는 환경 및 그 증강현실 사용자의 디클러터링된/정리된 또는 감소된 현실 뷰의 컴퓨터 보조식 설계 시에 사용을 위한 예시적인 시스템 (400) 의 개략 블록 다이어그램이다. 예시적인 실시형태에 있어서, 메모리 영역 (402) 은 모델링된 감소현실 데이터, 및 증강현실 데이터, 및/또는 증강현실 오브젝트들과 관련된 포지셔닝 데이터와 같은 소스 이미지 데이터, CAD 데이터를 저장할 시에 사용을 위한 하나 이상의 저장 디바이스들 (404) 을 포함한다. 일부 실시형태들에 있어서, 메모리 영역 (402) 은 서버 (406) 에 커플링되며, 그 서버는 차례로 네트워크 (412) 를 통해 관리자 시스템 (408) 및/또는 사용자 시스템 (410) 에 커플링된다. 저장 디바이스들 (404) 은 하나 이상의 데이터베이스들로서 구현될 수도 있거나, 단일 또는 다중의 지리적 사이트들에 위치될 수도 있거나, 또는 서버 (406) 와 통합될 수도 있다.

인식될 수 있는 바와 같이, 네트워크 (412) 는 인터넷과 같은 공중 네트워크, 또는 LAN 또는 WAN 네트워크와 같은 사설 네트워크, 또는 이들의 임의의 조합일 수 있으며, 또한 PSTN 또는 ISDN 서브-네트워크들을 포함할 수 있다. 네트워크 (412) 는 또한 이더넷 네트워크와 같이 유선일 수 있거나, 또는 EDGE, 3G 및 4G 무선 셀룰러 시스템들을 포함한 셀룰러 네트워크와 같이 무선일 수도 있다. 무선 네트워크는 또한 WiFi, 블루투스, 또는 공지된 통신의 임의의 다른 무선 형태일 수 있다. 따라서, 네트워크 (412) 는 단지 예시적일 뿐이며, 어떤 방식으로든 본 향상물들의 범위를 한정하지 않는다.

당업자가 인식할 바와 같이, 관리자 시스템 (408) 및/또는 사용자 시스템 (410) 은 도 5 를 참조하여 상기 설명된 바와 같은 컴퓨터 보조식 설계 스테이션, 또는 공지된 임의의 다른 컴퓨팅 시스템일 수 있다. 더욱이, 관리자 시스템 (408) 및/또는 사용자 시스템 (410) 은 상기 설명된 프로세스들 및/또는 상기 설명된 것들과 관련될 수도 있는 임의의 부가적인 프로세스들을 수행하도록 구성됨이 이해되어야 한다.

서버 (406) 는 상기 설명된 프로세스들을 실행하기 위한 컴퓨터 판독가능 명령들을 저장하고, 이들 명령들을 네트워크 (412) 를 통해 관리자 시스템 (408) 및/또는 사용자 시스템 (410) 에 제공한다. 더욱이, 서버 (406) 는 또한, 필요에 따라 메모리 영역 (402) 으로부터의 데이터를 관리자 시스템 (408) 및 사용자 시스템 (410) 에 제공할 수 있다. 그에 따라, 도 6 은 클라우드 컴퓨팅, 분산 컴퓨팅 등을 통한 시스템 (400) 의 구현예들을 포함한다.

감소현실 환경 및 그 상호작용식 이미지들의 컴퓨터 보조식 설계에 사용하기 위한 시스템들, 방법들, 장치, 컴퓨터 프로그램 제품들, 및 컴퓨터 판독가능 저장 매체들의 예시적인 실시형태들이 상기에서 상세히 설명된다. 그 시스템들, 방법들, 장치, 컴퓨터 프로그램 제품들, 및 컴퓨터 판독가능 저장 매체들은 본 명세서에서 설명된 특정 실시형태들에 한정되지 않지만, 오히려, 방법들, 프로그램 제품들 및/또는 저장 매체들의 동작들 뿐만 아니라 시스템 및/또는 장치의 컴포넌트들은 본 명세서에서 설명된 다른 동작들 및/또는 컴포넌트들과는 독립적으로 그리고 별도로 활용될 수도 있다. 추가로, 설명된 동작들 및/또는 컴포넌트들은 또한 다른 시스템들, 방법들, 장치, 프로그램 제품들 및/또는 저장 매체들에서 정의되거나 또는 그들과 조합하여 사용될 수도 있으며, 오직 본 명세서에서 설명된 바와 같은 시스템들, 방법들, 장치, 프로그램 제품들 및 저장 매체들 만으로 실시하도록 한정되지 않는다.

본 명세서에서 설명된 것들과 같은 컴퓨터 또는 컴퓨터 시스템은 적어도 하나의 프로세서 또는 프로세싱 유닛 및 시스템 메모리를 포함한다. 컴퓨터 또는 컴퓨터 시스템은 통상적으로, 컴퓨터 판독가능 매체들의 적어도 일부 형태를 갖는다. 한정이 아닌 예로서, 컴퓨터 판독가능 매체들은 컴퓨터 저장 매체들 및 통신 매체들을 포함한다. 컴퓨터 저장 매체들은 컴퓨터 판독가능 명령들, 데이터 구조들, 프로그램 모듈들 또는 다른 데이터와 같은 정보의 저장을 위해 임의의 방법 또는 기술로 구현된 휘발성 및 비휘발성의 착탈가능 및 비-착탈가능 매체들을 포함한다. 통신 매체들은 통상적으로 컴퓨터 판독가능 명령들, 데이터 구조들, 프로그램 모듈들, 또는 다른 데이터를, 캐리어파 또는 다른 전송 메커니즘과 같은 변조된 데이터 신호로 구현하며, 임의의 정보 전달 매체들을 포함한다. 당업자는 변조된 데이터 신호와 친숙하며, 그 변조된 데이터 신호는 그 신호에 정보를 인코딩하는 방식으로 설정 또는 변경된 그 특성들 중 하나 이상의 특성을 갖는다. 상기의 임의의 조합들이 또한, 컴퓨터 판독가능 매체들의 범위 내에 포함된다.

상기 설명된 프로세스들에서 사용하기 위한 예시적인 비-일시적인 컴퓨터 실행가능 컴포넌트들은 (도 5 에 도시된) 프로세서 (302) 로 하여금 (도 5 에 도시된) 디스플레이 디바이스 (318) 상에 사용자 선택가능 실세계 오브젝트들을 나타내는 증강현실 이미지 엘리먼트들과 중첩되는 모델링된 감소현실 환경 (131) 을 제시하게 하는 디스플레이 컴포넌트를 포함하지만 이것만을 포함하도록 한정되진 않는다. 컴포넌트들은 또한, 프로세서 (302) 로 하여금, 예를 들어, (도 5 에 도시된) I/O 인터페이스 (328) 를 통해 사용자 입력들을 수신하게 하는 인터페이스 컴포넌트를 포함한다. 상기 설명된 바와 같이, 사용자 입력들은 오브젝트들을 디클러터링/감소하기 위한 대상 환경의 물리적 상세들을 표시하고, CAD 모델 뷰를 생성하고, 증강현실 뷰를 감소현실의 CAD 모델 뷰 상에 오버레이하고, 툴 (100) 의 인스턴스를 생성하며, 및/또는 사용자 상호작용식 증강 현실 뷰 (140) 을 포지셔닝 (정렬) 하도록 관련될 수도 있다.

더욱이, 컴포넌트들은 프로세서 (302) 로 하여금 상기 설명된 단계들을 수행하게 하는 현실 스테이징 컴포넌트 및 3D 모델링 컴포넌트를 포함한다. 3D 모델링 컴포넌트와 함께 현실 스테이징 컴포넌트는, 현실에서 감소되고 사용자 선택식의 원래 디스플레이된 오브젝트들이 디클러터링된 그리고 증강현실 뷰 (140) 에서 가상 엘리먼트들과 오버레이된 대상 환경의 CAD 모델 뷰를 생성한다. 증강현실 컴포넌트는, 그 컴포넌트와의 사용자 상호작용이, 사용자에 의해 변경 (예를 들어, 재배열, 재조직) 되고 (컬러, 텍스처 등등에서) 업데이트되며 및/또는 치환된 실세계 오브젝트들을 나타내는 가상 엘리먼트들을 업데이트할 수 있게 한다.

본 발명이 예시적인 컴퓨터 시스템 환경과 관련하여 설명되지만, 본 발명의 실시형태들은 다수의 다른 범용 또는 특수 목적 컴퓨터 시스템 환경들 또는 구성들과 운용가능하다. 컴퓨터 시스템 환경은 본 발명의 임의의 양태의 사용 또는 기능의 범위에 관한 임의의 제한을 제안하도록 의도되지 않는다. 더욱이, 컴퓨터 시스템 환경은 예시적인 동작 환경에서 예시된 컴포넌트들 중 임의의 하나 또는 그 조합에 관한 임의의 의존성 또는 요건을 갖는 것으로서 해석되지 않아야 한다. 본 발명의 양태들과 함께 사용하기에 적합할 수도 있는 널리 공지된 컴퓨터 시스템들, 환경들, 및/또는 구성들의 예들은 개인용 컴퓨터들, 서버 컴퓨터들, 핸드헬드 또는 랩탑 디바이스들, 멀티프로세서 시스템들, 마이크로프로세서 기반 시스템들, 셋탑 박스들, 프로그램가능 가전제품, 모바일 전화기들, 네트워크 PC들, 미니 컴퓨터들, 메인프레임 컴퓨터들, 상기 시스템들 또는 디바이스들 중 임의의 것을 포함하는 분산 컴퓨팅 환경들 등을 포함하지만 이에 한정되지 않는다.

본 발명의 실시형태들은 하나 이상의 컴퓨터들 또는 다른 디바이스들에 의해 실행되는 프로그램 컴포넌트들 또는 모듈들과 같은 컴퓨터 실행가능 명령들의 일반적인 컨텍스트에서 설명될 수도 있다. 본 발명의 양태들은 컴포넌트들 또는 모듈들의 임의의 수 및 조직으로 구현될 수도 있다. 예를 들어, 본 발명의 양태들은 도면들에 도시되고 본 명세서에서 설명된 특정 컴퓨터 실행가능 명령들 또는 특정 컴포넌트들 또는 모듈들에 한정되지 않는다. 본 발명의 대안적인 실시형태들은 본 명세서에서 예시된 및 설명된 것보다 더 많거나 더 적은 기능을 갖는 상이한 컴퓨터 실행가능 명령들 또는 컴포넌트들을 포함할 수도 있다.

본 명세서에서 예시되고 설명된 본 발명의 실시형태들에서의 동작들의 실행 또는 수행의 순서는, 달리 명시되지 않으며, 중요하지 않다. 즉, 동작들은, 달리 명시되지 않으면, 임의의 순서로 수행될 수도 있으며, 본 발명의 실시형태들은 본 명세서에서 개시된 동작들 보다 추가적인 또는 더 적은 동작들을 포함할 수도 있다. 예를 들어, 다른 동작 이전에, 그와 동시에, 또는 그 이후에 특정 동작을 실행 또는 수행하는 것은 본 발명의 양태들의 범위 내인 것으로 고려된다.

본 발명 또는 그 실시형태들의 양태들의 엘리먼트들을 도입할 경우, 관사들 ("일 (a)", "한 (an)", "그 (the)", 및 "상기 (said)") 은 엘리먼트들 중 하나 이상이 존재함을 의미하도록 의도된다. 용어들 "구비하는", "포함하는", 및 "갖는" 은 포괄적인 것으로 의도되며, 리스트된 엘리먼트들 이외의 추가적인 엘리먼트들이 존재할 수도 있음을 의미하도록 의도된다.

이러한 기재된 설명은 예들을 사용하여, 최상의 모드를 포함하여 본 발명을 개시하며, 또한 당업자로 하여금 임의의 디바이스들 또는 시스템들을 제조 및 이용하는 것 및 임의의 포함된 방법들을 수행하는 것을 포함하여, 본 발명을 실시할 수 있게 한다. 본 발명의 특허가능 범위는 청구항들에 의해 정의되며, 당업자들에게 떠오르는 다른 예들을 포함할 수도 있다. 그러한 다른 예들은, 청구항들의 문자 언어와는 상이하지 않은 구조적 엘리먼트들을 가지면 또는 청구항들의 문자 언어와는 크지 않은 차이들을 갖는 균등의 구조적 엘리먼트들을 포함하면, 청구항들의 범위 내에 있는 것으로 의도된다.

본 발명이 그 예시적인 실시형태들을 참조하여 특별히 도시 및 설명되었지만, 첨부된 청구항들에 의해 포함된 본 발명의 범위로부터 일탈함없이, 형태 및 상세에 있어서의 다양한 변화들이 그 내부에서 행해질 수도 있음을 당업자는 이해할 것이다.

Claims (20)

- 대상 환경을 디스플레이하는 컴퓨터 방법으로서,

대상 환경을 현재 상태 대신 조직 상태에서 묘화하는 제 1 뷰를, 상기 제 1 뷰가 상기 대상 환경의 감소현실이 되도록, 형성하는 하나 이상의 이미지들의 세트를 디지털적으로 생성하는 단계; 및

제 2 뷰를 생성하는 방식으로 상기 제 1 뷰를 형성하는 상기 이미지들의 세트와의 컴퓨터 기반 사용자 상호작용을 가능케 하는 단계를 포함하고,

상기 제 2 뷰는 상기 대상 환경의 증강현실 표현인, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 1 항에 있어서,

상기 이미지들의 세트를 디지털적으로 생성하는 단계는,

상기 현재 상태에서 상기 대상 환경을 디스플레이하는 소스 이미지를 프로세서에서 수신하는 단계;

상기 대상 환경의 경계들을 정의하는 라인 세그먼트들을 상기 소스 이미지에서 결정하는 단계; 및

상기 결정된 라인 세그먼트들로부터, 상기 대상 환경의 감소현실의 3D 모델을 디지털적으로 형성하는 단계를 포함하는, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 2 항에 있어서,

상기 제 1 뷰는, 상기 소스 이미지에서 디스플레이된 실세계 오브젝트들의 양보다 상기 대상 환경에서의 실세계 오브젝트들의 더 적은 양을 묘화하는, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 2 항에 있어서,

상기 제 1 뷰는 오브젝트들이 없는 대상 환경을 묘화하는, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 1 항에 있어서,

상기 컴퓨터 기반 사용자 상호작용을 가능케 하는 단계는 사용자 인터페이스를 증강현실 서브시스템에 제공하는 단계를 포함하는, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 1 항에 있어서,

상기 생성된 제 2 뷰는 상기 제 1 뷰 상에 하나 이상의 가상 엘리먼트들을 중첩하고, 각각의 가상 엘리먼트는 개별 실세계 오브젝트를 나타내는, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 1 항에 있어서,

상기 대상 환경은 룸이고;

상기 제 1 뷰는 상기 룸의 현재 상태에 반하여 실질적으로 비어있는 룸을 묘화하는, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 7 항에 있어서,

상기 제 2 뷰는 상기 룸의 증강현실 표현을,

상기 룸의 현재 상태에서 부재한, 상기 룸에서의 하나 이상의 오브젝트들, 및

상기 룸의 현재 상태와는 상이한, 상기 룸에서의 하나 이상의 오브젝트들

중 하나로 디스플레이하는, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 8 항에 있어서,

상기 하나 이상의 오브젝트들은 가구, 비품들, 편의시설, 및 액세서리들 중 임의의 것인, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 1 항에 있어서,

상기 대상 환경에서의 복수의 오브젝트들 각각에 대해, 상기 제 1 뷰에서의 오브젝트의 디스플레이는 사용자 선택가능식인, 대상 환경을 디스플레이하는 컴퓨터 방법. - 제 1 항에 있어서,

상기 제 1 뷰를 형성하는 상기 이미지들의 세트를 이용하여 감소현실에서 상기 대상 환경의 3D 모델을 생성하는 단계를 더 포함하고,

상기 3D 모델은 상기 대상 환경의 증강현실 표현에서 채용되는, 대상 환경을 디스플레이하는 컴퓨터 방법. - 대상 환경을 디스플레이하는 컴퓨터 장치로서,

프로세서에 의해 실행가능하고, 대상 환경을 현재 스테이지 이외의 스테이지에서 묘화하는 제 1 뷰를 형성하는 하나 이상의 이미지들의 세트를 생성하도록 구성된 현실 스테이징 엔진;

상기 현실 스테이징 엔진으로부터 상기 생성된 이미지들의 세트를 수신하도록 커플링된 3D 모델러로서, 상기 3D 모델러는 감소현실에서 상기 대상 환경의 3D 모델을 형성하도록 구성되는, 상기 3D 모델러; 및

상기 3D 모델로부터 형성된 상기 대상 환경의 증강현실 표현과의 사용자 상호작용을 가능케 하는 증강현실 인터페이스를 포함하는, 대상 환경을 디스플레이하는 컴퓨터 장치. - 제 12 항에 있어서,

상기 현실 스테이징 엔진은 추가로,

상기 현재 스테이지에서 상기 대상 환경을 디스플레이하는 하나 이상의 소스 이미지들을 수신하고; 그리고

상기 대상 환경의 경계들을 정의하는 라인 세그먼트들을 상기 소스 이미지들에서 결정하도록

구성되는, 대상 환경을 디스플레이하는 컴퓨터 장치. - 제 13 항에 있어서,

상기 3D 모델러는 상기 결정된 라인 세그먼트들로부터 상기 3D 모델을 형성하도록 구성되는, 대상 환경을 디스플레이하는 컴퓨터 장치. - 제 13 항에 있어서,

상기 제 1 뷰는, 상기 대상 환경의 상기 3D 모델에서의 실세계 오브젝트들의 양이 상기 소스 이미지들에서 디스플레이된 실세계 오브젝트들의 양보다 적도록, 상기 소스 이미지에서 디스플레이된 실세계 오브젝트들의 양보다 상기 대상 환경에서의 실세계 오브젝트들의 더 적은 양을 묘화하는, 대상 환경을 디스플레이하는 컴퓨터 장치. - 제 12 항에 있어서,

상기 증강현실 인터페이스는 상기 3D 모델의 뷰들 상에 하나 이상의 가상 엘리먼트들을 중첩하고, 각각의 가상 엘리먼트는 개별 실세계 오브젝트를 나타내는, 대상 환경을 디스플레이하는 컴퓨터 장치. - 제 12 항에 있어서,

상기 대상 환경은 룸이고,

상기 제 1 뷰는 실질적으로 비어있는 룸을 묘화하는, 대상 환경을 디스플레이하는 컴퓨터 장치. - 제 17 항에 있어서,

상기 룸의 증강현실 표현은,

상기 룸의 현재 스테이지에서 부재한, 상기 룸에서의 하나 이상의 오브젝트들, 및

상기 룸의 현재 스테이지와는 상이한, 상기 룸에서의 하나 이상의 오브젝트들

중 하나로 디스플레이되는, 대상 환경을 디스플레이하는 컴퓨터 장치. - 제 18 항에 있어서,

상기 오브젝트들은 가구, 비품들, 편의시설, 및 액세서리들 중 임의의 것을 포함하는, 대상 환경을 디스플레이하는 컴퓨터 장치. - 대상 환경을 디스플레이하기 위한, 비-일시적인 컴퓨터 판독가능 매체를 포함하는 컴퓨터 프로그램 제품으로서,

상기 비-일시적인 컴퓨터 판독가능 매체; 및

상기 컴퓨터 판독가능 매체 상에 수록된 컴퓨터 코드를 포함하고,

상기 컴퓨터 코드는,

상기 대상 환경을 상기 대상 환경의 현재 스테이지와는 상이한 사용자 선택가능 스테이지에서 묘화하는 제 1 뷰를, 상기 제 1 뷰가 상기 대상 환경의 감소현실이 되도록, 형성하는 하나 이상의 이미지들의 세트를 디지털적으로 생성하는 것; 및

제 2 뷰를 생성하는 방식으로 상기 제 1 뷰를 형성하는 상기 이미지들의 세트에 적용된 증강현실 인터페이스를 제공하는 것으로서, 상기 제 2 뷰는 상기 대상 환경의 증강현실 표현인, 상기 증강현실 인터페이스를 제공하는 것

에 의해 상기 대상 환경을 디스플레이하도록 프로세서에 의해 실행가능한, 비-일시적인 컴퓨터 판독가능 매체를 포함하는 컴퓨터 프로그램 제품.

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US14/141,243 US9514573B2 (en) | 2013-12-26 | 2013-12-26 | Diminished reality |

| US14/141,243 | 2013-12-26 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20150076119A true KR20150076119A (ko) | 2015-07-06 |

Family

ID=52338837

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020140188304A Withdrawn KR20150076119A (ko) | 2013-12-26 | 2014-12-24 | 감소현실 |

Country Status (7)

| Country | Link |

|---|---|

| US (1) | US9514573B2 (ko) |

| EP (1) | EP2889844B1 (ko) |

| JP (1) | JP6499854B2 (ko) |

| KR (1) | KR20150076119A (ko) |

| CN (1) | CN104751520B (ko) |

| CA (1) | CA2875370A1 (ko) |

| IN (1) | IN2014MU04067A (ko) |

Cited By (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US11974406B2 (en) | 2020-10-12 | 2024-04-30 | Samsung Electronics Co., Ltd. | Electronic device including flexible display |

| US12010253B2 (en) | 2020-11-06 | 2024-06-11 | Samsung Electronics Co., Ltd. | Electronic device including flexible display |

| US12026010B2 (en) | 2020-07-14 | 2024-07-02 | Samsung Electronics Co., Ltd. | Electronic device including sensing structure |

| US12073751B2 (en) | 2020-06-10 | 2024-08-27 | Samsung Electronics Co., Ltd. | Electronic device capable of folding and sliding operations |

| US12107979B2 (en) | 2020-06-10 | 2024-10-01 | Samsung Electronics Co., Ltd. | Electronic device capable of folding motion and sliding motion |

| US12181917B2 (en) | 2020-07-14 | 2024-12-31 | Samsung Electronics Co., Ltd. | Electronic device comprising display support structure |

Families Citing this family (29)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US9652895B2 (en) * | 2014-03-06 | 2017-05-16 | Disney Enterprises, Inc. | Augmented reality image transformation |

| US11410221B2 (en) | 2014-04-29 | 2022-08-09 | Vivint, Inc. | Integrated secure delivery |

| US11049343B2 (en) * | 2014-04-29 | 2021-06-29 | Vivint, Inc. | Techniques for securing a dropspot |

| US11900305B2 (en) | 2014-04-29 | 2024-02-13 | Vivint, Inc. | Occupancy identification for guiding delivery personnel |

| US9971853B2 (en) | 2014-05-13 | 2018-05-15 | Atheer, Inc. | Method for replacing 3D objects in 2D environment |

| US9727977B2 (en) * | 2014-12-29 | 2017-08-08 | Daqri, Llc | Sample based color extraction for augmented reality |

| KR102326700B1 (ko) * | 2015-06-01 | 2021-11-16 | 엘지전자 주식회사 | 이동 단말기 |

| PL3131064T3 (pl) * | 2015-08-13 | 2018-03-30 | Nokia Technologies Oy | Wyszukiwanie zawartości obrazu |

| US10620778B2 (en) * | 2015-08-31 | 2020-04-14 | Rockwell Automation Technologies, Inc. | Augmentable and spatially manipulable 3D modeling |

| US9639734B1 (en) | 2015-11-13 | 2017-05-02 | Cypress Semiconductor Corporation | Fingerprint sensor-compatible overlay material |

| US10832029B2 (en) | 2015-11-13 | 2020-11-10 | Cypress Semiconductor Corporation | Sensor-compatible overlay |

| US10282585B2 (en) | 2015-11-13 | 2019-05-07 | Cypress Semiconductor Corporation | Sensor-compatible overlay |

| WO2017106072A2 (en) | 2015-12-17 | 2017-06-22 | Technicolor Usa, Inc. | Personalized presentation enhancement using augmented reality |

| TWI588685B (zh) * | 2016-08-31 | 2017-06-21 | 宅妝股份有限公司 | 虛擬實境與擴增實境的建置系統及其方法 |

| GB2554914B (en) * | 2016-10-14 | 2022-07-20 | Vr Chitect Ltd | Virtual reality system and method |

| US10467352B2 (en) | 2017-04-03 | 2019-11-05 | Cambria Company Llc | Stone slab production methods and systems |

| US20190057180A1 (en) * | 2017-08-18 | 2019-02-21 | International Business Machines Corporation | System and method for design optimization using augmented reality |

| CN109427098A (zh) * | 2017-08-29 | 2019-03-05 | 深圳市掌网科技股份有限公司 | 一种基于增强现实的图像展示方法和系统 |

| GB2582315B (en) * | 2019-03-19 | 2023-05-17 | Sony Interactive Entertainment Inc | Method and system for generating an image |

| US10956626B2 (en) * | 2019-07-15 | 2021-03-23 | Ke.Com (Beijing) Technology Co., Ltd. | Artificial intelligence systems and methods for interior design |

| US11381710B2 (en) | 2019-09-13 | 2022-07-05 | International Business Machines Corporation | Contextual masking of objects in social photographs |

| JP7150894B2 (ja) * | 2019-10-15 | 2022-10-11 | ベイジン・センスタイム・テクノロジー・デベロップメント・カンパニー・リミテッド | Arシーン画像処理方法及び装置、電子機器並びに記憶媒体 |

| US10976806B1 (en) | 2019-12-27 | 2021-04-13 | GE Precision Healthcare LLC | Methods and systems for immersive reality in a medical environment |

| EP3872770A1 (en) * | 2020-02-28 | 2021-09-01 | Inter Ikea Systems B.V. | A computer implemented method, a device and a computer program product for augmenting a first image with image data from a second image |

| US11636628B2 (en) | 2020-05-01 | 2023-04-25 | International Business Machines Corporation | Composite imagery rendering in diminished reality environment for medical diagnosis |

| US11276206B2 (en) | 2020-06-25 | 2022-03-15 | Facebook Technologies, Llc | Augmented reality effect resource sharing |

| EP4012654A3 (en) * | 2020-10-25 | 2022-08-24 | Nishant Tomar | Feature determination, measurement, and virtualization from 2-d image capture |

| US11232643B1 (en) * | 2020-12-22 | 2022-01-25 | Facebook Technologies, Llc | Collapsing of 3D objects to 2D images in an artificial reality environment |

| WO2025074641A1 (ja) * | 2023-10-06 | 2025-04-10 | 三菱電機ビルソリューションズ株式会社 | 昇降路内機器配置支援システム |

Family Cites Families (16)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2003141567A (ja) * | 2001-11-07 | 2003-05-16 | Japan Science & Technology Corp | 3次元都市モデル生成装置及び3次元都市モデル生成方法 |

| US7301547B2 (en) * | 2002-03-22 | 2007-11-27 | Intel Corporation | Augmented reality system |

| JP2004310686A (ja) * | 2003-04-10 | 2004-11-04 | Canon Inc | 画像処理方法及び装置 |

| US7474318B2 (en) * | 2004-05-28 | 2009-01-06 | National University Of Singapore | Interactive system and method |

| US8547401B2 (en) * | 2004-08-19 | 2013-10-01 | Sony Computer Entertainment Inc. | Portable augmented reality device and method |

| DE102007045835B4 (de) * | 2007-09-25 | 2012-12-20 | Metaio Gmbh | Verfahren und Vorrichtung zum Darstellen eines virtuellen Objekts in einer realen Umgebung |

| US8140989B2 (en) * | 2009-02-19 | 2012-03-20 | Kimberly-Clark Worldwide, Inc. | Virtual room use simulator and room planning system |

| CN101520904B (zh) * | 2009-03-24 | 2011-12-28 | 上海水晶石信息技术有限公司 | 带有现实环境估算的增强现实的方法及其系统 |

| KR101669119B1 (ko) * | 2010-12-14 | 2016-10-25 | 삼성전자주식회사 | 다층 증강 현실 시스템 및 방법 |

| US9129438B2 (en) | 2011-01-18 | 2015-09-08 | NedSense Loft B.V. | 3D modeling and rendering from 2D images |

| US20120326948A1 (en) * | 2011-06-22 | 2012-12-27 | Microsoft Corporation | Environmental-light filter for see-through head-mounted display device |

| WO2013032955A1 (en) * | 2011-08-26 | 2013-03-07 | Reincloud Corporation | Equipment, systems and methods for navigating through multiple reality models |

| US9443353B2 (en) * | 2011-12-01 | 2016-09-13 | Qualcomm Incorporated | Methods and systems for capturing and moving 3D models and true-scale metadata of real world objects |

| WO2013157890A1 (en) * | 2012-04-20 | 2013-10-24 | Samsung Electronics Co., Ltd. | Method and apparatus of processing data to support augmented reality |

| US8705893B1 (en) * | 2013-03-14 | 2014-04-22 | Palo Alto Research Center Incorporated | Apparatus and method for creating floor plans |

| US8868375B1 (en) * | 2014-05-21 | 2014-10-21 | Locometric Ltd | Generation of a floor plan |

-

2013

- 2013-12-26 US US14/141,243 patent/US9514573B2/en active Active

-

2014

- 2014-12-11 JP JP2014251031A patent/JP6499854B2/ja active Active

- 2014-12-16 EP EP14198393.2A patent/EP2889844B1/en active Active

- 2014-12-18 IN IN4067MU2014 patent/IN2014MU04067A/en unknown

- 2014-12-19 CA CA2875370A patent/CA2875370A1/en not_active Abandoned

- 2014-12-24 CN CN201410818235.1A patent/CN104751520B/zh active Active

- 2014-12-24 KR KR1020140188304A patent/KR20150076119A/ko not_active Withdrawn

Cited By (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US12073751B2 (en) | 2020-06-10 | 2024-08-27 | Samsung Electronics Co., Ltd. | Electronic device capable of folding and sliding operations |

| US12107979B2 (en) | 2020-06-10 | 2024-10-01 | Samsung Electronics Co., Ltd. | Electronic device capable of folding motion and sliding motion |

| US12026010B2 (en) | 2020-07-14 | 2024-07-02 | Samsung Electronics Co., Ltd. | Electronic device including sensing structure |

| US12181917B2 (en) | 2020-07-14 | 2024-12-31 | Samsung Electronics Co., Ltd. | Electronic device comprising display support structure |

| US11974406B2 (en) | 2020-10-12 | 2024-04-30 | Samsung Electronics Co., Ltd. | Electronic device including flexible display |

| US12010253B2 (en) | 2020-11-06 | 2024-06-11 | Samsung Electronics Co., Ltd. | Electronic device including flexible display |

Also Published As

| Publication number | Publication date |

|---|---|

| CA2875370A1 (en) | 2015-06-26 |

| IN2014MU04067A (ko) | 2015-10-16 |

| US20150187136A1 (en) | 2015-07-02 |

| EP2889844B1 (en) | 2021-08-11 |

| CN104751520A (zh) | 2015-07-01 |

| CN104751520B (zh) | 2020-09-11 |

| JP2015125774A (ja) | 2015-07-06 |

| EP2889844A2 (en) | 2015-07-01 |

| US9514573B2 (en) | 2016-12-06 |

| JP6499854B2 (ja) | 2019-04-10 |

| EP2889844A3 (en) | 2016-01-13 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN104751520B (zh) | 显示主题环境的计算机方法、装置及介质 | |

| US11657419B2 (en) | Systems and methods for building a virtual representation of a location | |

| US20220319106A1 (en) | Virtual interaction with three-dimensional indoor room imagery | |

| US11287904B2 (en) | Virtual/augmented reality modeling application for architecture | |

| US9420253B2 (en) | Presenting realistic designs of spaces and objects | |

| KR102433857B1 (ko) | 혼합 현실에서 동적 가상 콘텐츠들을 생성하기 위한 디바이스 및 방법 | |

| US11734929B2 (en) | Enhanced product visualization technology with web-based augmented reality user interface features | |

| US20230177594A1 (en) | Rendering 3d model data for prioritized placement of 3d models in a 3d virtual environment | |

| CN106683177B (zh) | 基于互动漫游式房屋装修数据交互方法及装置 | |

| US12067684B2 (en) | Method, device and computer program product for manipulating virtual bounding volumes | |

| Garg et al. | Computational design of reconfigurables. | |

| US20230230326A1 (en) | System and method for creating and furnishing digital models of indoor spaces | |

| KR100434657B1 (ko) | 가상현실을 기반으로 한 3차원 주택인테리어 가공방법 및 기록매체 | |

| CA3132551A1 (en) | Systems and methods of predicting architectural materials within a space | |

| CN112800511B (zh) | 一种家装素材调整方法、装置、计算机设备和存储介质 | |

| EP2993613A1 (en) | A capture system arranged to create a 3d model from a scanned scene, a method and a graphical user interface | |

| US20180020165A1 (en) | Method and apparatus for displaying an image transition | |

| EP4202683A1 (en) | Design development, representation and display | |

| CN113496049B (zh) | 一种三维空间物品规划的方法和系统 | |

| Ishikawa et al. | Interactive indoor 3D modeling from a single photo with CV support | |

| Feng et al. | 3D Mesh Automatic Blanking and Split Technology in Urban Planning | |

| CA2860316A1 (en) | System and method for space filling regions of an image |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| PA0109 | Patent application |

Patent event code: PA01091R01D Comment text: Patent Application Patent event date: 20141224 |

|

| PG1501 | Laying open of application | ||

| PC1203 | Withdrawal of no request for examination | ||

| WITN | Application deemed withdrawn, e.g. because no request for examination was filed or no examination fee was paid |