KR20140003319A - 화상 데이터 송신 장치, 화상 데이터 송신 방법, 화상 데이터 수신 장치 및 화상 데이터 수신 방법 - Google Patents

화상 데이터 송신 장치, 화상 데이터 송신 방법, 화상 데이터 수신 장치 및 화상 데이터 수신 방법Info

- Publication number

- KR20140003319A KR20140003319A KR1020127032608A KR20127032608A KR20140003319A KR 20140003319 A KR20140003319 A KR 20140003319A KR 1020127032608 A KR1020127032608 A KR 1020127032608A KR 20127032608 A KR20127032608 A KR 20127032608A KR 20140003319 A KR20140003319 A KR 20140003319A

- Authority

- KR

- South Korea

- Prior art keywords

- stream

- image data

- elementary

- data

- related information

- Prior art date

Links

Images

Classifications

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/235—Processing of additional data, e.g. scrambling of additional data or processing content descriptors

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/194—Transmission of image signals

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/128—Adjusting depth or disparity

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/161—Encoding, multiplexing or demultiplexing different image signal components

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N13/00—Stereoscopic video systems; Multi-view video systems; Details thereof

- H04N13/10—Processing, recording or transmission of stereoscopic or multi-view image signals

- H04N13/106—Processing image signals

- H04N13/172—Processing image signals image signals comprising non-image signal components, e.g. headers or format information

- H04N13/178—Metadata, e.g. disparity information

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/46—Embedding additional information in the video signal during the compression process

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/50—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding

- H04N19/597—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using predictive coding specially adapted for multi-view video sequence encoding

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/70—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals characterised by syntax aspects related to video coding, e.g. related to compression standards

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/236—Assembling of a multiplex stream, e.g. transport stream, by combining a video stream with other content or additional data, e.g. inserting a URL [Uniform Resource Locator] into a video stream, multiplexing software data into a video stream; Remultiplexing of multiplex streams; Insertion of stuffing bits into the multiplex stream, e.g. to obtain a constant bit-rate; Assembling of a packetised elementary stream

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/20—Servers specifically adapted for the distribution of content, e.g. VOD servers; Operations thereof

- H04N21/23—Processing of content or additional data; Elementary server operations; Server middleware

- H04N21/236—Assembling of a multiplex stream, e.g. transport stream, by combining a video stream with other content or additional data, e.g. inserting a URL [Uniform Resource Locator] into a video stream, multiplexing software data into a video stream; Remultiplexing of multiplex streams; Insertion of stuffing bits into the multiplex stream, e.g. to obtain a constant bit-rate; Assembling of a packetised elementary stream

- H04N21/2362—Generation or processing of Service Information [SI]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N21/00—Selective content distribution, e.g. interactive television or video on demand [VOD]

- H04N21/40—Client devices specifically adapted for the reception of or interaction with content, e.g. set-top-box [STB]; Operations thereof

- H04N21/43—Processing of content or additional data, e.g. demultiplexing additional data from a digital video stream; Elementary client operations, e.g. monitoring of home network or synchronising decoder's clock; Client middleware

- H04N21/435—Processing of additional data, e.g. decrypting of additional data, reconstructing software from modules extracted from the transport stream

Landscapes

- Engineering & Computer Science (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Library & Information Science (AREA)

- Testing, Inspecting, Measuring Of Stereoscopic Televisions And Televisions (AREA)

- Compression Or Coding Systems Of Tv Signals (AREA)

- Two-Way Televisions, Distribution Of Moving Picture Or The Like (AREA)

Abstract

수신측에서, 엘리멘터리 스트림의 구성 변화에 적확하게 대응 가능하게 한다. 트랜스포트 스트림(TS)에 포함되는 각 엘리멘터리 스트림(ES)의 관련을 나타내는 스트림 관련 정보를, ES에 삽입한다. 이 스트림 관련 정보는, 제1의 화상 데이터를 포함하는 제1의 ES와, 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 ES와의 관련을 나타낸다. 스트림 관련 정보는, 예를 들면, 각 ES를 식별하기 위한 식별자를 이용하여, 각 ES의 관련을 나타낸다. 예를 들면, TS에, 각 ES의 식별자와, 각 ES의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계를 나타내는 기술자를 삽입하고, 각 ES의 TS 레이어에서의 등록 상태와, 스트림 관련 정보와의 연휴를 도모한다.

Description

본 기술은, 화상 데이터 송신 장치, 화상 데이터 송신 방법, 화상 데이터 수신 장치 및 화상 데이터 수신 방법에 관한 것으로, 특히, 입체 화상 데이터, 스케일러불 부호화 화상 데이터 등을 송신하는 화상 데이터 송신 장치 등에 관한 것이다.

종래, 동화상의 부호화 방식으로서, H.264/AVC(Advanced VideoCoding)가 알려져 있다(비특허 문헌 1 참조). 또한, 이 H.264/AVC의 확장 방식으로서, H.264/MVC(Multi-view Video Coding)가 알려져 있다(비특허 문헌 2 참조). MVC에서는, 멀티 뷰의 화상 데이터를 통합하여 부호화하는 구조가 채용되어 있다. MVC에서는, 멀티 뷰 화상 데이터를, 1개의 베이스 뷰(base view)의 화상 데이터와, 1개 이상의 논베이스 뷰 (non-baseview)의 화상 데이터로서 부호화한다.

또한, 이러한 H.264/AVC의 확장 방식으로서, H.264/SVC(Scalable Video Coding)도 알려져 있다(비특허 문헌 3 참조). SVC는, 화상을 계층적으로 부호화하는 기술이다. SVC에서는, 동화상을 최저한의 품질로 복호화하는데 필요한 화상 데이터를 갖는 기본 계층(최하위 계층)과, 이 기본 계층에 부가함에 의해 동화상의 품질을 높이는 화상 데이터를 갖는 확장 계층(상위 계층)으로 나뉘어져 있다.

비특허 문헌

비특허 문헌 1 : 「Draft Errata List with Revision-Marked Corrections for H.264/AVC」, JVT-1050, Thomas Wiegand et al., Joint Video Team(JVT) of ISO/IEC MPEG & ITU-T VCEG, 2003

비특허 문헌 2 : Joint Draft 4.0 on Multiview Video Coding, Joint Video Team of ISO/IEC MPEG & ITU-T VCEG, JVT-X209, July2007

비특허 문헌 3 : Heiko Schwarz, Detlev Marpe, and Thomas Wiegand, "Overview of the Scalable Video Coding Extension of the H.264/AVC Standard", IEEETRANSACTIONS ON CIRCUITS AND SYSTEMS FOR VIDEO TECHNOLOGY, VOL. 17, NO. 9, SEPTEMBER 2007, pp. 1103-1120.

AVC 스트림과 MVC 스트림이, 동적으로 전환되는 배신 환경에서, MVC에 대응하는 수신기는, 「Stream_Type=0x1B」만의 스트림인지, 「Stream_Type=0x1B」와 「Stream_Type=0x20」의 양쪽이 있는 스트림인지를 판단하여, 수신 모드의 전환을 행할 것이 기대된다.

통상의 AVC(2D)의 비디오 엘리멘터리 스트림은, PMT(Program MapTable)의 「Stream_Type=0x1B」로 보내진다. 또한, MVC의 베이스 뷰(Base view)의 비디오 엘리멘터리 스트림(Base viewsub-bitstream)은, PMT의 「Stream_Type=0x1B」로 보내지는 경우가 있다. MVC의 경우, 베이스 뷰의 화상 데이터와, 논베이스 뷰(Non base view)의 화상 데이터가 통합하여 보내지는 경우가 있다. 즉, 베이스 뷰의 화상 데이터와, 논베이스 뷰의 화상 데이터가 나뉘어서 보내지는 경우에는, MVC의 베이스 뷰의 비디오 엘리멘터리 스트림(Base view sub-bitstream)은, PMT의 「Stream_Type=0x1B」로 보내지는 일이 있다.

트랜스포트 스트림(Transport Stream)중의 섹션(Section) 부분에는, PSI(Program SpecificInformation)로서의 PMT의 레벨로, AVC 스트림인지 MVC 스트림인지를 알 수 있는 구조가 제공되어 있다. 즉, 비디오 엘리멘터리 스트림이 「Stream_Type=0x1B」만일 때는, 2DAVC 스트림인 것을 알 수 있다. 또한, 비디오 엘리멘터리 스트림이 「Stream_Type=0x1B」와 「Stream_Type=0x20」의 양쪽이 있을 때는, MVC 스트림인 것을 알 수 있다.

그러나, PMT라는 것은, 송신측 설비에 의해서는, 반드시 동적으로 갱신되지 않는 경우가 있다. 그 경우에는, 배신 내용이 입체(3D) 화상으로부터 2차원(2D)화상으로 전환될 때에, 이하의 부적합함이 생각된다. 즉, 수신기는, 스트림 타입(Stream_Type)이 「0x1B」의 엘리멘터리 스트림과 함께, 스트림 타입(Stream_Type)이 「0x20」의 스트림도 계속 수신하는 것으로 하여, 그 데이터를 계속 기다리는 것이 생각된다.

배신 내용이 2차원(2D) 화상으로 전환된 후에는, 「0x20」의 엘리멘터리 스트림은 수신되지 않는 것이지만, 수신기 내부에서는, 「0x20」의 엘리멘터리 스트림이 오는 것으로 하여, 계속 기다린다. 그 결과, 올바른 디코드에 이르지 못하여, 정상적인 표시를 할 수가 없게 될 우려가 있다. 이와 같이, 수신기가, PMT의 [Stream_type]의 종류만에 의해 스스로의 모드를 결정한 경우, 그 모드가 올바르지 않고, 올바른 스트림의 수신이 아닐 가능성이 나온다.

도 27은, 트랜스포트 스트림 내에서의 비디오 엘리멘터리 스트림과 PMT(ProgramMap Table)의 구성례를 도시하고 있다. 비디오 엘리멘터리 스트림(ES1, ES2)의 「001」 내지 「009」의 액세스 유닛(AU : Access Unit)의 기간은, 2개의 비디오 엘리멘터리 스트림이 존재하는 기간이다. 이 기간은, 예를 들면 3D 방송프로그램의 본체(本體) 기간이고, 이 2개의 스트림은 입체(3D) 화상 데이터의 스트림을 구성하고 있다.

그것에 계속해서, 비디오 엘리멘터리 스트림S1의 「010」 내지 「014」의 액세스 유닛의 기간은, 1개의 비디오 엘리멘터리 스트림만 존재하는 기간이다. 이 기간은, 예를 들면, 3D 방송프로그램의 본체 기간의 사이에 삽입되어 있는 CM 기간이고, 이1개의 스트림은 2차원 화상 데이터의 스트림을 구성하고 있다.

또한, 그것에 계속해서, 비디오 엘리멘터리 스트림(ES1, ES2)의 「0015」 내지 「016」의 액세스 유닛의 기간은, 2개의 비디오 엘리멘터리 스트림이 존재하는 기간이다. 이 기간은, 예를 들면 3D 방송프로그램의 본체 기간이고, 이 2개의 스트림은 입체(3D) 화상 데이터의 스트림을 구성하고 있다.

PMT에서의 비디오 엘리멘터리 스트림의 등록을 업데이트하는 주기(예를 들면, 100msec)는, 비디오의 프레임 주기(예를 들면, 33.3msec)에 추종할 수 없다. 트랜스포트 스트림을 구성하는 엘리멘터리 스트림 동적 변화를 PMT에 의해 알리는 방법에서는, 엘리멘터리 스트림과 PMT의 트랜스포트 스트림 내의 구성이 비동기이기 때문에, 수신기에 대해 올바른 동작을 약속시키는 것으로는 되지 않는다.

또한, 기존의 신호 규격(MPEG)에서는, 「Stream_Type=0x1B」의 MVC의 베이스 뷰의 비디오 엘리멘터리 스트림(Baseview sub-bitstream)에는, PMT의 기술자로서, 「MVC_extensiondescriptor」의 디스크립터를 삽입하는 것이 필수로 되어 있다. 이 디스크립터가 존재하면, 논베이스 뷰의 비디오 엘리멘터리 스트림(Non-Base view sub-bitstream)의 존재를 알 수 있다.

그러나, 「Stream_Type=0x1B」가 가리키는 「Elementary PID」의 비디오 엘리멘터리 스트림은, 상술한 MVC의 베이스 뷰(Base view)의 비디오 엘리멘터리 스토림(Base view sub-bitstream)이라고는 한할 수 없다. 종래의 AVC(이 경우, 대부분은 High Profile)의 스트림인 경우도 생각된다. 특히, 기존의 2D 수신기와의 호환성을 보증하기 위해, 입체(3D) 화상 데이터이지만, 베이스 뷰의 비디오 엘리멘터리 스트림이, 종래의 AVC(2D)의 비디오 엘리멘터리 스트림인 채일 것이 추천되는 경우가 있다.

이 경우, 입체 화상 데이터의 스트림은, AVC(2D)의 비디오 엘리멘터리 스트림과, 논베이스 뷰의 비디오 엘리멘터리 스트림(Non-Base view sub-bitstream)으로 구성된다. 그 경우, 「Stream_Type=0x1B」의 비디오 엘리멘터리 스트림에는, 「MVC_extension descriptor」의 기술자는 관련지여저 있지 않다. 그 때문에, 베이스 뷰의 비디오 엘리멘터리 스트림에 상당하는 AVC(2D)의 비디오 엘리멘터리 스트림 이외에, 논베이스 뷰의 비디오 엘리멘터리 스트림(Non-Base view sub-bitstream)의 존재를 알 수가 없게 된다.

또한, 상술한 바와 같이, AVC(2D) 스트림과 MVC 스트림이, 동적으로 전환되는 배신 환경에서, MVC에 대응하는 수신기는, 「Stream_Type=0x1B」만의 스트림인지, 「Stream_Type=0x1B」와 「Stream_Type=0x20」의 양쪽이 있는 스트림인지를 판단하여, 수신 모드의 전환을 행할 것이 기대된다. 통상의 AVC(2D)의 비디오 엘리멘터리 스트림은, PMT(Program Map Table)의 「Stream_Type=0x1B」로 보내진다. 또한, MVC의 베이스 뷰(Base view)의 비디오 엘리멘터리 스트림(Base viewsub-bitstream)은, PMT의 「Stream_Type=0x1B」로 보내지는 경우가 있다.

그 때, 하나의 트랜스포트 스트림(TS : Tranport Stream)중에, 복수의 비디오 엘리멘터리 스트림을 다중화하는 것이 가능하다. 그리고, 그 중의 몇개의 비디오 엘리멘터리 스트림에서, 입체 화상 데이터의 스트림이 구성되는 경우가 있다. 예를 들면, 하나의 트랜스포트 스트림에, 이하와 같은 비디오 스트림이 다중되어 있는 경우를 생각한다.

PID0 (AVC 2D) stream_type = 0x1B

PID1 (AVC 3D FrameCompatible) stream_type = 0x1B

PID2 (MVC non-base substream) stream_type = 0x20

「PID0」의 비디오 엘리멘터리 스트림은, 이 자체는 종래의 2차원(2D) 화상 데이터의 스트림 그 자체이다. 이 비디오 엘리멘터리 스트림이, 「PID2」의 논베이스 뷰의 비디오 엘리멘터리 스트림(Non-Base viewsub-bitstream)과 함께, 입체(3D) 화상 데이터의 스트림을 구성한다. 그러나, 단지, 「stream_type」만으로 3D 구성 요소로서의 비디오 스트림을 관련지울 수 있는 것은 아니다. 즉, 「stream_type=0x1B」는, 「PID1」의 비디오 엘리멘터리 스트림도 적용되기 때문이다. 또한, 「AVC 3D Frame Compatible」는, 사이드 바이 사이드 방식이나 톱 앤드 보텀 방식 등의 입체(3D) 화상 데이터를 나타내고 있다.

또한, 상술에서는, 베이스 뷰의 화상 데이터의 부호화 방식과 논베이스 뷰의 화상 데이터의 부호화 방식이 MPEG4-AVC인 예를 나타내였다. 그러나, 베이스 뷰의 화상 데이터의 부호화 방식과 논베이스 뷰의 화상 데이터의 부호화 방식이 MPEG2video 방식 등의 다른 부호화 방식인 경우, 나아가서는, 베이스 뷰의 화상 데이터의 부호화 방식과 논베이스 뷰의 화상 데이터의 부호화 방식이 동일지 않은, 다른 경우도 생각된다.

또한, 상술에서는, 트랜스포트 스트림에 포함되는 엘리멘터리 스트림 입체(3D) 화상 데이터를 구성하고 있는지 여부의 판단이 곤란한 것, 나아가서는, 트랜스포트 스트림에 포함되는 엘리멘터리 스트림중, 입체(3D) 화상 데이터를 구성하는 엘리멘터리 스트림이 어느 것인지의 특정이 곤란한 것 등을 설명하였다. 상세 설명은 생략하지만, 이들의 부적합함은, AVC 스트림과 상술한 SVC 스트림을 시분할적으로 송신하는 경우에도 생긴다.

본 기술의 목적은, 예를 들면, MVC 또는 SVC 등에 대응하는 수신기가, 배신 내용의 동적인 변화에 적확(的確)하게 대응하여, 올바른 스트림의 수신을 행할 수 있도록 하는 것에 있다.

본 기술의 개념은,

제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 생성하는 인코드부와,

상기 인코드부에서 생성된 상기 각 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 송신하는 송신부를 구비하고,

상기 인코드부는, 적어도, 상기 제1의 엘리멘터리 스트림에, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보를 삽입하는

화상 데이터 송신 장치에 있다.

본 기술에서, 인코드부에 의해, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과, 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림이 생성된다. 그리고, 송신부에 의해, 인코드부에서 생성된 각 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림이 송신된다. 이 경우, 소정수의 제2의 화상 데이터만이 존재하는 상태, 소정수의 메타 데이터만이 존재하는 상태, 나아가서는, 제2의 화상 데이터 및 메타 데이터를 합쳐서 소정수 존재하는 상태 등이 있다.

예를 들면, 제1의 엘리멘터리 스트림에 포함되는 제1의 화상 데이터의 부호화 방식과, 소정수의 제2의 엘리멘터리 스트림에 포함되는 제2의 화상 데이터의 부호화 방식으로서, 임의의 부호화 방식의 조합이 가능하게 된다. 예를 들면, 부호화 방식이 MPEG4-AVC만인 경우, 부호화 방식이 MPEG2video만인 경우 나아가서는, 그들 부호화 방식의 조합이 생각된다. 또한, 부호화 방식은, 이들 MPEG4-AVC, MPEG2video로 한정되지 않는다.

예를 들면, 제1의 화상 데이터는, 입체(3D) 화상 데이터를 구성하는 베이스 뷰의 화상 데이터이고, 제2의 화상 데이터는, 입체 화상(3D)데이터를 구성하는 베이스 뷰 이외의 뷰(논베이스 뷰)의 화상 데이터이다. 이 경우, 예를 들면, 제1의 화상 데이터는, 스테레오 입체 화상을 얻기 위한 좌안 및 우안의 한쪽의 화상 데이터이고, 제2의 화상 데이터는, 스테레오 입체 화상을 얻기 위한 좌안 및 우안의 다른쪽의 화상 데이터이다.

또한, 예를 들면, 메타 데이터는, 입체 화상 데이터에 대응한 시차 정보(시차 벡터, 깊이 데이터 등)이다. 예를 들면, 수신측에서는, 이 시차 정보를 이용하여, 수신 화상 데이터에 보간 처리(포스트 처리)를 시행하여, 소정수의 뷰의 표시 화상 데이터를 얻는 것이 가능해진다. 또한, 예를 들면, 제1의 화상 데이터는, 스케일러불 부호화 화상 데이터를 구성하는 최하위층의 부호화 화상 데이터이고, 제2의 화상 데이터는, 스케일러불 부호화 화상 데이터를 구성하는 최하위층 이외의 계층의 부호화 화상 데이터이다.

예를 들면, 스트림 관련 정보는, 이 스트림 관련 정보가 삽입된 엘리멘터리 스트림에 포함되는 화상 데이터에 의한 뷰가, 입체 표시일 때에, 멀티 뷰잉중의 어느 뷰로서 표시되어야 할 것인지를 나타내는 포지션 정보를 포함하도록 되어도 좋다.

인코드부에 의해, 적어도, 제1의 엘리멘터리 스트림에, 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입된다. 예를 들면, 스트림 관련 정보는, 각 엘리멘터리 스트림을 식별하기 위한 식별자를 이용하여, 각 엘리멘터리 스트림의 관련을 나타내도록 된다.

예를 들면, 트랜스포트 스트림에, 각 엘리멘터리 스트림의 식별자와, 각 엘리멘터리 스트림의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계를 나타내는 기술자(디스크립터)가 삽입된다. 예를 들면, 이 기술자는, 프로그램·맵·테이블의 배하에 삽입된다. 또한, 이 대응 관계가 미리 정의되어 있어도 좋다. 이에 의해, 각 엘리멘터리 스트림의 트랜스포트 스트림 레이어에서의 등록 상태와, 스트림 관련 정보와의 연휴가 취하여진다.

이와 같이, 본 기술에서는, 적어도, 제1의 엘리멘터리 스트림에, 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입된다. 그 때문에, 수신측에서는, 이 스트림 관련 정보에 의거하여, 이 트랜스포트 스트림에, 제1의 엘리멘터리 스트림과 관련되는 제2의 엘리멘터리 스트림이 포함되는지의 여부를 용이하게 판단할 수 있다. 또한, 엘리멘터리 스트림 자체에 스트림 관련 정보가 삽입되기 때문에, 수신측에서는, 이 스트림 관련 정보에 의거하여, 엘리멘터리 스트림의 구성 변화, 즉, 배신 내용의 동적인 변화에 적확하게 대응할 수 있고, 올바른 스트림의 수신을 행할 수 있다.

또한, 본 기술에서, 예를 들면, 스트림 관련 정보는, 각 엘리멘터리 스트림의 관련의 변화가 실제로 일어나기 전에, 이 변화가 일어나는 것을 알리는 예고 정보를 포함하도록 되어도 좋다. 이 예고 정보에 의거하여, 수신측에서는, 디코더 버퍼로부터의 판독 제어를 솜씨 좋게 동적으로 바꾸는 것이 가능해진다.

또한, 본 기술에서, 예를 들면, 인코드부는, 엘리멘터리 스트림에, 스트림 관련 정보를 픽처 단위 또는 GOP 단위로 삽입하도록 되어도 좋다. 이에 의해, 수신측에서는, 엘리멘터리 스트림의 구성, 예를 들면, 입체 화상 데이터의 뷰 수의 변화, 또는 스케일러불 부호화 화상 데이터의 계층수의 변화 등을, 픽처 단위 또는 GOP 단위로 관리 가능해진다.

또한, 본 기술에서, 송신부는, 트랜스포트 스트림에, 엘리멘터리 스트림에 스트림 관련 정보가 삽입되어 있는지의 여부, 또는, 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보에 변경이 있는지의 여부를 나타내는 기술자를 삽입하도록 되어도 좋다. 이 기술자에 의해, 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보의 참조를 촉구할 수 있고, 수신측에서 안정된 수신 동작이 가능해진다.

또한, 본 기술에서, 예를 들면, 스트림 관련 정보는, 제1의 화상 데이터 및 제2의 화상 데이터의 출력 해상도의 제어 정보를 또한 포함하도록 되어도 좋다. 이에 의해, 수신측에서는, 이 제어 정보에 의거하여, 제1의 화상 데이터 및 제2의 화상 데이터의 출력 해상도를 소정 해상도로 조정하는 것이 가능해진다.

또한, 본 기술에서, 예를 들면, 스트림 관련 정보는, 소정수의 제2의 화상 데이터의 각각에 대해 표시 필수로 하는지의 여부를 지정하는 제어 정보를 또한 포함하도록 되어도 좋다. 이에 의해, 수신측에서는, 이 제어 정보에 의거하여, 소정수의 제2의 화상 데이터의 어느 것이 표시 필수인지를 알 수 있고, 유저에 의한 화상 표시 양태의 선택을 제한 가능해진다.

또한, 본 기술의 다른 개념은,

제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 수신하는 수신부를 구비하고,

상기 제1의 엘리멘터리 스트림에는, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있고,

상기 스트림 관련 정보에 의거하여, 상기 수신부에서 수신된 상기 제1의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터를 취득하고, 상기 수신부에서 수신된 상기 소정수의 제2의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터에 관련된 상기 제2의 화상 데이터 및/또는 메타 데이터를 취득하는 데이터 취득부를 또한 구비하는

화상 데이터 수신 장치에 있다.

본 기술에서, 수신부에 의해, 트랜스포트 스트림이 수신된다. 이 트랜스포트 스트림은, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림 및 이 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖고 있다. 이 경우, 제1의 엘리멘터리 스트림에는, 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있다.

데이터 취득부에 의해, 수신부에서 수신된 트랜스포트 스트림으로부터 화상 데이터 및/또는 메타 데이터가 취득된다. 이 경우, 스트림 관련 정보에 의거하여, 제1의 엘리멘터리 스트림으로부터 제1의 화상 데이터가 취득되고, 또한, 소정수의 제2의 엘리멘터리 스트림으로부터 제2의 화상 데이터 및/또는 메타 데이터가 취득된다.

본 기술에서는, 트랜스포트 스트림에, 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있다. 그 때문에, 이 스트림 관련 정보에 의거하여, 이 트랜스포트 스트림에, 제1의 엘리멘터리 스트림과 관련되는 제2의 엘리멘터리 스트림이 포함되는지의 여부를 용이하게 판단할 수 있다. 또한, 엘리멘터리 스트림 자체에 스트림 관련 정보가 삽입되어 있기 때문에, 이 스트림 관련 정보에 의거하여, 엘리멘터리 스트림의 구성 변화, 즉, 배신 내용의 동적인 변화에 적확하게 대응할 수 있고, 올바른 스트림 수신을 행할 수 있다.

또한, 본 기술에서, 예를 들면, 데이터 취득부에서 취득된 제1의 화상 데이터 및 제2의 화상 데이터의 해상도를 조정하여 출력하는 해상도 조정부를 또한 구비하고, 스트림 관련 정보는, 제1의 화상 데이터 및 제2의 화상 데이터의 출력 해상도의 제어 정보를 포함하고, 해상도 조정부는, 출력 해상도의 제어 정보에 의거하여, 제1의 화상 데이터 및 제2의 화상 데이터의 해상도를 조정하도록 되어도 좋다. 이 경우, 제1의 화상 데이터 및 소정수의 제2의 화상 데이터의 해상도가 다른 경우라도, 해상도 조정부에 의하여 그들으 출력 해상도를 맞추는 것이 가능해진다.

또한, 본 기술에서, 예를 들면, 데이터 취득부에서 취득된 제1의 화상 데이터 및 제2의 화상 데이터에 의거한 화상 표시 양태를 선택하는 화상 표시 양태 선택부를 또한 구비하고, 스트림 관련 정보는, 소정수의 제2의 화상 데이터의 각각에 대해 표시 필수로 하는지의 여부를 지정하는 제어 정보를 포함하고, 화상 표시 양태 선택부는, 이 제어 정보에 의거하여 화상 표시 양태의 선택이 제한되도록 되어도 좋다.

또한, 본 기술에서, 예를 들면, 데이터 취득부에서 취득된 메타 데이터는, 입체 화상 데이터에 대응한 시차 정보이고, 이 시차 정보를 이용하여, 데이터 취득부에서 취득된 제1의 화상 데이터 및 제2의 화상 데이터에 보간 처리를 시행하여, 소정수의 뷰의 표시 화상 데이터를 얻는 포스트 처리부를 또한 구비하도록 되어도 좋다.

본 기술에 의하면, 수신측에서는, 엘리멘터리 스트림의 구성 변화, 즉, 배신 내용의 동적인 변화에 적확하게 대응할 수 있고, 스트림의 수신을 양호하게 행할 수 있다.

도 1은 본 발명의 제1의 실시의 형태로서의 화상 송수신 시스템의 구성례를 도시하는 블록도.

도 2는 프로그램이 2개의 비디오 엘리멘터리 스트림으로 구성된 예를 도시하는 도면.

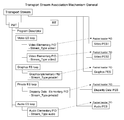

도 3은 화상 송수신 시스템을 구성하는 방송국의 송신 데이터 생성부의 구성례를 도시하는 블록도.

도 4는 비디오 엘리멘터리 스트림, 그래픽스 엘리멘터리 스트림, 오디오 엘리멘터리 스트림 등을 포함하는 일반적인 트랜스포트 스트림의 구성례를 도시하는 도면.

도 5는 엘리멘터리 스트림에 스트림 관련 정보를 삽입하고, 트랜스포트 스트림에, ES_ID 디스크립터 및 ES_association 디스크립터를 삽입하는 경우에 있어서의 트랜스포트 스트림의 구성례를 도시하는 도면.

도 6은 ES_ID 디스크립터의 구조예(Syntax)를 도시하는 도면.

도 7은 ES_association 디스크립터의 구조예(Syntax)를 도시하는 도면.

도 8은 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보와, 트랜스포트 스트림에 삽입되어 있는 ES_association 디스크립터와의 관계의 한 예를 도시하는 도면.

도 9는 부호화 방식이 MPEG4-AVC인 경우, 스트림 관련 정보가 액세스 유닛의 "SELs"의 부분에 삽입되는 것을 설명하기 위한 도면.

도 10은 「Stream Association Information SEImessage」 및 「userdata_for_stream_association()」의 구조예(Syntax)를 도시하는 도면.

도 11은 「user_data()」의 구조예(Syntax)를 도시하는 도면.

도 12는 스트림 관련 정보「Stream_association()」의 구조예(Syntax)를 도시하는 도면.

도 13은 스트림 관련 정보「Stream_association()」의 구조예(Syntax)에서의 각 정보의 내용(Semantics)를 도시하는 도면.

도 14는 트랜스포트 스트림이, MVC의 베이스 뷰(base view)의 스트림과 MVC의 논베이스 뷰(Non base view)의 스트림을 갖는 경우의 예를 도시하는 도면.

도 15는 수신측에서의 입체(3D) 표시일 때의 뷰 표시예를 도시하는 도면.

도 16은 「indication_of_selected_stream_display」의 삽입례를 도시하는 도면.

도 17은 화상 송수신 시스템을 구성하는 수신기의 구성례를 도시하는 블록도.

도 18은 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2)이 포함되는 경우의 예를 도시하는 도면.

도 19는 트랜스포트 스트림(TS)에, MPEG2video 스트림(ES1, ES2)이 포함되는 경우의 예를 도시하는 도면.

도 20은 트랜스포트 스트림(TS)에, MPEG2video 스트림(ES1)과, AVC 스트림(ES2)이 포함되는 경우의 예를 도시하는 도면.

도 21은 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2)이 포함되는 경우의 다른 예를 도시하는 도면.

도 22는 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2)이 포함되는 경우의 또다른 예를 도시하는 도면.

도 23은 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2, ES3)이 포함되는 경우의 예를 도시하는 도면.

도 24는 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2, ES3)이 포함되는 경우의 다른 예를 도시하는 도면.

도 25는 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2)과, 메타 데이터 스트림(ES3)이 포함되는 경우의 예를 도시하는 도면.

도 26은 화상 송수신 시스템을 구성하는 수신기의 다른 구성례를 도시하는 블록도.

도 27은 트랜스포트 스트림 내에서의 비디오 엘리멘터리 스트림과 PMT(ProgramMap Table)의 구성례를 도시하는 도면.

도 2는 프로그램이 2개의 비디오 엘리멘터리 스트림으로 구성된 예를 도시하는 도면.

도 3은 화상 송수신 시스템을 구성하는 방송국의 송신 데이터 생성부의 구성례를 도시하는 블록도.

도 4는 비디오 엘리멘터리 스트림, 그래픽스 엘리멘터리 스트림, 오디오 엘리멘터리 스트림 등을 포함하는 일반적인 트랜스포트 스트림의 구성례를 도시하는 도면.

도 5는 엘리멘터리 스트림에 스트림 관련 정보를 삽입하고, 트랜스포트 스트림에, ES_ID 디스크립터 및 ES_association 디스크립터를 삽입하는 경우에 있어서의 트랜스포트 스트림의 구성례를 도시하는 도면.

도 6은 ES_ID 디스크립터의 구조예(Syntax)를 도시하는 도면.

도 7은 ES_association 디스크립터의 구조예(Syntax)를 도시하는 도면.

도 8은 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보와, 트랜스포트 스트림에 삽입되어 있는 ES_association 디스크립터와의 관계의 한 예를 도시하는 도면.

도 9는 부호화 방식이 MPEG4-AVC인 경우, 스트림 관련 정보가 액세스 유닛의 "SELs"의 부분에 삽입되는 것을 설명하기 위한 도면.

도 10은 「Stream Association Information SEImessage」 및 「userdata_for_stream_association()」의 구조예(Syntax)를 도시하는 도면.

도 11은 「user_data()」의 구조예(Syntax)를 도시하는 도면.

도 12는 스트림 관련 정보「Stream_association()」의 구조예(Syntax)를 도시하는 도면.

도 13은 스트림 관련 정보「Stream_association()」의 구조예(Syntax)에서의 각 정보의 내용(Semantics)를 도시하는 도면.

도 14는 트랜스포트 스트림이, MVC의 베이스 뷰(base view)의 스트림과 MVC의 논베이스 뷰(Non base view)의 스트림을 갖는 경우의 예를 도시하는 도면.

도 15는 수신측에서의 입체(3D) 표시일 때의 뷰 표시예를 도시하는 도면.

도 16은 「indication_of_selected_stream_display」의 삽입례를 도시하는 도면.

도 17은 화상 송수신 시스템을 구성하는 수신기의 구성례를 도시하는 블록도.

도 18은 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2)이 포함되는 경우의 예를 도시하는 도면.

도 19는 트랜스포트 스트림(TS)에, MPEG2video 스트림(ES1, ES2)이 포함되는 경우의 예를 도시하는 도면.

도 20은 트랜스포트 스트림(TS)에, MPEG2video 스트림(ES1)과, AVC 스트림(ES2)이 포함되는 경우의 예를 도시하는 도면.

도 21은 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2)이 포함되는 경우의 다른 예를 도시하는 도면.

도 22는 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2)이 포함되는 경우의 또다른 예를 도시하는 도면.

도 23은 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2, ES3)이 포함되는 경우의 예를 도시하는 도면.

도 24는 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2, ES3)이 포함되는 경우의 다른 예를 도시하는 도면.

도 25는 트랜스포트 스트림(TS)에, MVC의 베이스 뷰의 스트림(ES1)과, MVC의 논베이스 뷰의 스트림(ES2)과, 메타 데이터 스트림(ES3)이 포함되는 경우의 예를 도시하는 도면.

도 26은 화상 송수신 시스템을 구성하는 수신기의 다른 구성례를 도시하는 블록도.

도 27은 트랜스포트 스트림 내에서의 비디오 엘리멘터리 스트림과 PMT(ProgramMap Table)의 구성례를 도시하는 도면.

이하, 본 기술을 실시하기 위한 형태(이하, 「실시의 형태」라고 한다)에 관해 설명한다. 또한, 설명은 이하의 순서로 행한다.

1. 실시의 형태

2. 변형례

<1. 실시의 형태>

[화상 송수신 시스템]

도 1은, 실시의 형태로서의 화상 송수신 시스템(10)의 구성례를 도시하고 있다. 이 화상 송수신 시스템(10)는, 방송국(100) 및 수신기(200)에 의해 구성되어 있다. 방송국(100)는, 트랜스포트 스트림을, 방송파에 실어서 송신한다. 트랜스포트 스트림은, 방송프로그램을 구성하는 화상 데이터나 메타 데이터를 포함하고 있다.

즉, 이 트랜스포트 스트림은, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과, 이 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖고 있다. 이 패킷은, PES(Packetized Elementary Stream) 패킷이다.

이 경우, 소정수의 제2의 화상 데이터만이 존재하는 상태, 소정수의 메타 데이터만이 존재하는 상태, 나아가서는, 제2의 화상 데이터 및 메타 데이터를 합쳐서 소정수 존재하는 상태 등이 있다. 또한, 소정수에는 0이 포함된다. 그 경우, 제1의 화상 데이터에 관련되는 제2의 화상 데이터나 메타 데이터는 존재하지 않고, 트랜스포트 스트림은, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림을 패킷화하여 얻어진 패킷만을 갖는 것이 된다.

제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림만이 존재하는 경우, 이 제1의 화상 데이터는 2차원(2D) 화상 데이터를 구성한다. 한편, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림 외에, 제2의 화상 데이터를 포함하는 단수 또는 복수의 제2의 엘리멘터리 스트림이 존재하는 경우, 이들 제1의 화상 데이터 및 소정수의 제2의 화상 데이터는 입체(3D) 화상 데이터를 구성한다. 여기서, 제1의 화상 데이터는 베이스 뷰의 화상 데이터이고, 소정수의 제2의 화상 데이터는 논베이스 뷰의 화상 데이터를 구성하고 있다.

또한, 스테레오 입체(3D) 화상 데이터의 경우, 입체 화상 데이터를 구성하는 논베이스 뷰의 화상 데이터는 단수이다. 즉, 소정수는 1이다. 이 경우, 베이스 뷰의 화상 데이터는 좌안 및 우안의 한쪽의 화상 데이터이고, 논베이스 뷰의 화상 데이터는 좌안 및 우안의 다른쪽의 화상 데이터이다.

도 2는, 방송프로그램이 복수개, 예를 들면 2개의 비디오 엘리멘터리 스트림으로 구성되는 예를 도시하고 있다. 도 2(a)는, PMT의 「Stream_Type=0x1B」로 보내지는 MVC의 베이스 뷰(base view)의 스트림과, PMT의 「Stream_Type=0x20」로 보내지는 MVC의 논베이스 뷰(Non baseview)의 스트림으로 구성되어 있다. 또한, 도 2(b)는, PMT의 「Stream_Type=0x20」로 보내지는 MPEG2video 스트림과, PMT의 「Stream_Type=0x1B」로 보내지는 AVC 스트림으로 구성되어 있다. 또한, 도 2(c)는, PMT의 「Stream_Type=0x20」로 보내지는 MPEG2video 스트림이 2개로 구성되어 있다.

적어도, 제1의 엘리멘터리 스트림에는, 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있다. 이 스트림 관련 정보는, 픽처 단위 또는 예측 화상을 포함한 표시 액세스 단위인 GOP(Group of Picture) 단위로 삽입되어 있다. 이 스트림 관련 정보의 상세 설명은 후술한다.

수신기(200)는, 방송국(100)으로부터 방송파에 실어서 보내 오는 트랜스포트 스트림을 수신한다. 이 트랜스포트 스트림은, 상술한 바와 같이, 제1의 엘리멘터리 스트림과 소정수의 제2의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖고 있다. 제1의 엘리멘터리 스트림에는, 제1의 화상 데이터가 포함되어 있다. 또한, 소정수의 제2의 엘리멘터리 스트림에는, 이 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터가 각각 포함되어 있다.

적어도, 제1의 엘리멘터리 스트림에는, 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있다. 수신기(200)는, 이 스트림 관련 정보에 의거하여, 제1의 엘리멘터리 스트림으로부터 제1의 화상 데이터를 취득하고, 소정수의 제2의 엘리멘터리 스트림으로부터 화상 데이터나 메타 데이터를 취득한다.

「송신 데이터 생성부의 구성례」

도 3은, 방송국(100)에서, 상술한 트랜스포트 스트림을 생성하는 송신 데이터 생성부(110)의 구성례를 도시하고 있다. 이 송신 데이터 생성부(110)는, 데이터 취출부(어카이브부)(111)와, 비디오 인코더(112)와, 시차 정보 인코더(113)와, 오디오 인코더(114)를 갖고 있다. 또한, 이 송신 데이터 생성부(110)는, 그래픽스 발생부(115)와, 그래픽스 인코더(116)와, 멀티플렉서(117)를 갖고 있다.

데이터 취출부(111)에는, 데이터 기록 매체(111a)가, 예를 들면, 착탈 자유롭게 장착된다. 이 데이터 기록 매체(111a)에는, 송신하여야 할 방송프로그램의 화상 데이터와 함께, 이 화상 데이터에 대응한 음성 데이터가 기록되어 있다. 예를 들면, 화상 데이터는, 방송프로그램에 응하여, 입체(3D) 화상 데이터 또는 2차원(2D) 화상 데이터로 전환된다. 또한, 예를 들면, 화상 데이터는, 방송프로그램 내에서도, 본편(本編)이나 커머셜 등의 내용에 응하여, 입체 화상 데이터 또는 2차원 화상 데이터로 전환된다. 입체 화상 데이터는, 상술한 바와 같이, 베이스 뷰의 화상 데이터와, 소정수의 논베이스 뷰의 화상 데이터로 이루어져 있다.

화상 데이터가 입체 화상 데이터인 경우, 데이터 기록 매체(111a)에는, 이 입체 화상 데이터에 대응하여, 시차 정보도 기록되어 있다. 이 시차 정보는, 베이스 뷰와 각 논베이스 뷰와의 사이의 시차를 나타내는 시차 벡터, 또는 깊이 데이터 등이다. 깊이 데이터는, 소정의 변환에 의해 시차 벡터로서 취급하는 것이 가능해진다. 시차 정보는, 예를 들면, 픽셀(화소)마다의 시차 정보, 또는 뷰(화상)를 소정수로 분할하여 얻어진 각 분할 영역의 시차 정보 등이다.

예를 들면, 이 시차 정보는, 수신측에서, 베이스 뷰 및 각 논베이스 뷰의 화상에 각각 중첩하는 동일한 중첩 정보(그래픽스 정보 등)의 위치를 조정하여 시차를 부여하기 위해 사용된다. 또한, 예를 들면, 이 시차 정보는, 수신측에서, 베이스 뷰 및 각 논베이스 뷰의 화상 데이터에 보간 처리(포스트 처리)를 시행하여 소정수의 뷰의 표시 화상 데이터를 얻기 위해 사용된다. 데이터 기록 매체(111a)는, 디스크형상(狀) 기록 매체, 반도체 메모리 등이다. 데이터 취출부(111)는, 데이터 기록 매체(111a)로부터, 화상 데이터, 음성 데이터, 시차 정보 등을 취출하여 출력한다.

비디오 인코더(112)는, 데이터 취출부(111)로부터 출력되는 화상 데이터에 대해, 예를 들면, MPEG4-AVC(MVC), MPEG2video 등의 부호화를 행하여 부호화 비디오 데이터를 얻는다. 또한, 이 비디오 인코더(112)는, 후단에 구비하는 스트림 포매터(도시 생략)에 의해, 비디오 엘리멘터리 스트림을 생성한다.

즉, 이 비디오 인코더(112)는, 화상 데이터가 2차원 화상 데이터일 때, 이 2차원 화상 데이터(제1의 화상 데이터)를 포함하는 비디오 엘리멘터리 스트림을 생성한다. 또한, 이 비디오 인코더(112)는, 화상 데이터가 입체 화상 데이터일 때, 베이스 뷰의 화상 데이터(제1의 화상 데이터)를 포함하는 비디오 엘리멘터리 스트림 및 소정수의 논베이스 뷰의 화상 데이터(제2의 화상 데이터)를 포함하는 비디오 엘리멘터리 스트림을 생성한다.

또한, 이 비디오 인코더(112)는, 적어도, 제1의 화상 데이터를 포함하는 비디오 엘리멘터리 스트림(제1의 엘리멘터리 스트림)에, 스트림 관련 정보를 삽입한다. 이 스트림 관련 정보는, 각 엘리멘터리 스트림의 관련을 나타내는 정보이다. 제2의 엘리멘터리 스트림은, 상술한 제2의 화상 데이터 및/또는 메타 데이터가 포함된다. 비디오 인코더(112)는, 이 스트림 관련 정보를, 픽처 단위 또는 예측 화상을 포함한 표시 액세스 단위인 GOP 단위로 삽입한다.

오디오 인코더(114)는, 데이터 취출부(111)로부터 출력되는 음성 데이터에 대해, MPEG2 Audio AAC 등의 부호화를 시행하여, 오디오의 엘리멘터리 스트림을 생성한다.

시차 정보 인코더(113)는, 데이터 취출부(111)로부터 출력되는 시차 정보에 대해 소정의 부호화를 시행하여, 시차 정보의 엘리멘터리 스트림을 생성한다. 또한, 시차 정보가, 상술한 바와 같이 픽셀(화소)마다의 시차 정보인 경우, 이 시차 정보를 화소 데이터와 같이 취급할 수 있다. 이 경우, 시차 정보 인코더(113)는, 시차 정보에 대해, 상술한 화상 데이터와 같은 부호화 방식으로 부호화를 시행하여, 시차 정보 엘리멘터리 스트림을 생성할 수 있다. 또한, 이 경우, 데이터 취출부(111)로부터 출력되는 시차 정보의 부호화를 비디오 인코더(112)에서 행하는 구성도 생각되고, 그 경우에는, 시차 정보 인코더(113)는 불필요하게 된다.

그래픽스 발생부(115)는, 화상에 중첩하는 그래픽스 정보(서브타이틀 정보도 포함한다)의 데이터(그래픽스 데이터)를 발생한다. 그래픽스 인코더(116)는, 그래픽스 발생부(115)에서 발생된 그래픽스 데이터를 포함하는 그래픽스 엘리멘터리 스트림을 생성한다. 여기서, 그래픽스 정보는, 중첩 정보를 구성하고 있다.

그래픽스 정보는, 예를 들면, 로고 등이다. 서브타이틀 정보는, 예를 들면, 자막이다. 이 그래픽스 데이터는, 비트맵 데이터이다. 이 그래픽스 데이터에는, 화상상의 중첩 위치를 나타내는 아이들링 오프셋 정보가 부가되어 있다. 이 아이들링 오프셋 정보는, 예를 들면, 화상의 왼쪽 위의 원점(原點)으로부터, 그래픽스 정보의 중첩 위치의 왼쪽 위의 픽셀까지의 수직 방향, 수평 방향의 오프셋 값을 나타낸다. 또한, 자막 데이터를 비트맵 데이터로서 전송한 규격은, 유럽의 디지털 방송 규격인 DVB에서 「DVB_Subtitling」로서 규격화되고, 운용되어 있다.

멀티플렉서(117)는, 비디오 인코더(112), 시차 정보 인코더(113), 오디오 인코더(114) 및 그래픽스 인코더(116)에서 생성된 각 엘리멘터리 스트림을 패킷화하여 다중하여, 트랜스포트 스트림(TS)를 생성한다.

도 3에 도시하는 송신 데이터 생성부(110)의 동작을 간단히 설명한다. 데이터 취출부(111)로부터 출력되는 화상 데이터(입체 화상 데이터 또는 2차원 화상 데이터)는, 비디오 인코더(112)에 공급된다. 이 비디오 인코더(112)에서는, 그 화상 데이터에 대해, 예를 들면 MPEG4-AVC(MVC), MPEG2video 등의 부호화가 시행되어, 부호화 비디오 데이터를 포함하는 비디오 엘리멘터리 스트림이 생성되고, 멀티플렉서(117)에 공급된다.

즉, 이 비디오 인코더(112)에서는, 화상 데이터가 2차원 화상 데이터일 때, 이 2차원 화상 데이터(제1의 화상 데이터)를 포함하는 비디오 엘리멘터리 스트림이 생성된다. 또한, 이 비디오 인코더(112)에서는, 화상 데이터가 입체(3D) 화상 데이터일 때, 베이스 뷰의 화상 데이터(제1의 화상 데이터)를 포함하는 비디오 엘리멘터리 스트림 및 소정수의 논베이스 뷰의 화상 데이터(제2의 화상 데이터)를 포함하는 비디오 엘리멘터리 스트림이 생성된다.

또한, 이 비디오 인코더(112)에서는, 픽처 단위 또는 예측 화상을 포함한 표시 액세스 단위인 GOP 단위로, 적어도, 제1의 화상 데이터를 포함하는 비디오 엘리멘터리 스트림(제1의 비디오 엘리멘터리 스트림)에, 스트림 관련 정보가 삽입된다. 이에 의해, 제1의 화상 데이터가 포함되는 제1의 엘리멘터리 스트림에 대해, 제2의 화상 데이터가 포함되는 제2의 엘리멘터리 스트림의 유무 등을 나타내는 정보가 수신측에 송신되게 된다.

또한, 데이터 취출부(111)로부터 입체 화상 데이터가 출력될 때, 이 데이터 취출부(111)로부터 그 입체 화상 데이터에 대응한 시차 정보도 출력된다. 이 시차 정보는, 시차 정보 인코더(113)에 공급된다. 시차 정보 인코더(113)에서는, 시차 정보에 대해 소정의 부호화가 시행되어, 부호화 데이터를 포함하는 시차 정보 엘리멘터리 스트림이 생성된다. 이 시차 정보 엘리멘터리 스트림은 멀티플렉서(117)에 공급된다.

또한, 데이터 취출부(111)로부터 화상 데이터가 출력될 때, 이 데이터 취출부(111)로부터 그 화상 데이터에 대응한 음성 데이터도 출력된다. 이 음성 데이터는, 오디오 인코더(114)에 공급된다. 이 오디오 인코더(114)에서는, 음성 데이터에 대해, MPEG2Audio AAC 등의 부호화가 시행되어, 부호화 오디오 데이터를 포함하는 오디오 엘리멘터리 스트림이 생성된다. 이 오디오 엘리멘터리 스트림 멀티플렉서(117)에 공급된다.

또한, 데이터 취출부(111)로부터 출력되는 화상 데이터에 대응하여 그래픽스 발생부(115)에서는, 화상(뷰)에 중첩하는 그래픽스 정보(서브타이틀 정보를 포함한다)의 데이터(그래픽스 데이터)가 발생된다. 이 그래픽스 데이터는, 그래픽스 인코더(116)에 공급된다. 그래픽스 인코더(116)에서는, 이 그래픽스 데이터에 대해 소정의 부호화가 시행되어, 부호화 데이터를 포함하는 그래픽스 엘리멘터리 스트림이 생성된다. 이 그래픽스 엘리멘터리 스트림 멀티플렉서(117)에 공급된다.

멀티플렉서(117)에서는, 각 인코더로부터 공급되는 엘리멘터리 스트림이 패킷화 되고 다중되여, 트랜스포트 스트림(TS)가 생성된다. 이 트랜스포트 스트림(TS)은, 데이터 취출부(111)로부터 입체(3D) 화상 데이터가 출력되는 기간은, 베이스 뷰의 비디오 엘리멘터리 스트림과 소정수의 논베이스 뷰의 비디오 엘리멘터리 스트림을 갖는 것으로 된다. 또한, 이 트랜스포트 스트림(TS)은, 데이터 취출부(111)로부터 2차원(2D) 화상 데이터가 출력되는 기간은, 이 2차원 화상 데이터를 포함하는 비디오 엘리멘터리 스트림 갖는 것으로 된다.

도 4는, 비디오 엘리멘터리 스트림, 오디오 엘리멘터리 스트림 등을 포함하는 일반적인 트랜스포트 스트림의 구성례를 도시하고 있다. 트랜스포트 스트림에는, 각 엘리멘터리 스트림을 패킷화하여 얻어진 PES 패킷이 포함되어 있다. 이 구성례에서는, 2개의 비디오 엘리멘터리 스트림의 PES 패킷「Video PES1」, 「Video PES2」가 포함되어 있다. 또한, 이 구성례에서는, 그래픽스 엘리멘터리 스트림의 PES 패킷「Graphics PES」 및 프라이빗 엘리멘터리 스트림의 PES 패킷「DisparityData PES」가 포함되어 있다. 또한, 이 구성례에서는, 오디오 엘리멘터리 스트림의 PES 패킷「AudioPES」가 포함되어 있다.

또한, 트랜스포트 스트림에는, PSI(Program SpecificInformation)로서, (Program Map Table)이 포함되어 있다. 이 PSI는, 트랜스포트 스트림에 포함되는 각 엘리멘터리 스트림이 어느 프로그램에 속하고 있는지를 기록한 정보이다. 또한, 트랜스포트 스트림에는, 이벤트 단위의 관리를 행하는 SI(Serviced Information)로서의 EIT(EventInformation Table)가 포함되어 있다.

PMT에는, 프로그램 전체에 관련되는 정보를 기술하는 프로그램·디스크립터(ProgramDescriptor)가 존재한다. 또한, 이 PMT에는, 각 엘리멘터리 스트림에 관련된 정보를 갖는 엘리멘터리·루프프가 존재한다. 이 구성례에서는, 비디오 엘리멘터리·루프, 그래픽스 엘리멘터리·루프, 프라이빗 엘리멘터리·루프 및 오디오 엘리멘터리·루프가 존재한다. 각 엘리멘터리·루프에는, 스트림마다, 패킷 식별자(PID), 스트림 타입(Stream_Type) 등의 정보가 배치됨과 하께, 도시하지 않지만, 그 엘리멘터리 스트림에 관련되는 정보를 기술하는 디스크립터도 배치된다.

[스트림 관련 정보]

상술한 바와 같이, 비디오 인코더(112)는, 적어도, 제1의 화상 데이터를 포함하는 비디오 엘리멘터리 스트림(제1의 엘리멘터리 스트림)에, 스트림 관련 정보를, 픽처 단위 또는 GOP 단위로 삽입한다. 이 스트림 관련 정보는, 각 엘리멘터리 스트림의 관련을 나타내는 정보이다.

이 스트림 관련 정보는, 각 엘리멘터리 스트림을 식별하기 위한 식별자를 이용하여, 각 엘리멘터리 스트림의 관련을 나타내는 것으로 된다. 이 경우, 각 엘리멘터리 스트림의 트랜스포트 스트림 레이어에서의 등록 상태와, 스트림 관련 정보와의 연휴를 취할 필요가 있다. 예를 들면, 각 엘리멘터리 스트림의 식별자와, 각 엘리멘터리 스트림의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계를 미리 정의하는 것이 생각된다.

이 실시의 형태에서, 멀티플렉서(117)는, 트랜스포트 스트림에, 각 엘리멘터리 스트림의 식별자와, 각 엘리멘터리 스트림의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계를 나타내는 기술자, 즉 ES_ID 디스크립터를 삽입한다. 멀티플렉서(117)는, 이 ES_ID 디스크립터를, 예를 들면, PMT의 배하(配下)에 삽입한다.

또한, 이 실시의 형태에서, 멀티플렉서(117)는, 트랜스포트 스트림에, 스트림 관련 정보의 존재 등을 나타내는 기술자, 즉 ES_association 디스크립터를 삽입한다. 이 기술자는, 엘리멘터리 스트림에 상술한 스트림 관련 정보가 삽입되어 있는지의 여부, 또는, 엘리멘터리 스트림에 삽입되어 있는 상술한 스트림 관련 정보에 변경이 있는지의 여부를 나타낸다. 멀티플렉서(117)는, 이 ES_association 디스크립터를, PMT의 배하, 또는 EIT의 배하에 삽입한다.

도 5는, 제1의 엘리멘터리 스트림에 스트림 관련 정보를 삽입하고, 또한, 트랜스포트 스트림에, ES_ID 디스크립터 및 ES_association 디스크립터를 삽입하는 경우에 있어서의 트랜스포트 스트림의 구성례를 도시하고 있다.

이 구성례에서는, 트랜스포트 스트림에, 베이스 뷰의 비디오 엘리멘터리 스트림(Stream_Type video1)의 PES 패킷「Video PES1」이 포함되어 있다. 또한, 이 구성례에서는, 트랜스포트 스트림에, 논베이스 뷰의 비디오 엘리멘터리 스트림(Stream_Type video2)의 PES 패킷「Video PES2」이 포함되어 있다. 또한, 이 구성례에서는, 도면의 간단화를 위해, 그 밖의 PES 패킷에 관해서는, 도시를 생략하고 있다.

이 구성례에서는, 비디오 엘리멘터리·루프에, 각 엘리멘터리 스트림의 식별자(ES_id)와, 각 엘리멘터리 스트림의 패킷 식별자(PID) 또는 컴포넌트·태그와의 대응 관계를 나타내는 ES_ID 디스크립터가 삽입되어 있다.

도 6은, ES_ID 디스크립터의 구조예(Syntax)를 도시하고 있다. 「descriptor_tag」는, 디스크립터 타입을 나타내는 8비트의 데이터이고, 여기서는, ES_ID 디스크립터인 것을 나타낸다. 「descriptor _length」는, 디스크립터의 길이(사이즈)를 나타내는 8비트의 데이터이다. 이 데이터는, 디스크립터의 길이로서, 「descriptor _length」 이후의 바이트수를 나타낸다.

「Stream_count_for_association」은, 스트림의 갯수를 나타내는 4비트의 데이터이다. 이 스트림의 갯수분만큼, for 루프를 반복한다. 「Stream_Association_ID」의 4비트 필드는, 각 엘리멘터리 스트림의 식별자(ES_ID)를 나타낸다. 또한, 「Associated_stream_Elementary_PID」의 13비트 필드는, 각 엘리멘터리 스트림의 패킷 식별자(PID)를 나타내다. 또한, 각 엘리멘터리 스트림의 식별자와, 각 엘리멘터리 스트림의 컴포넌트·태그와의 대응 관계를 나타내는 경우에는, 「Associated_stream_Elementary_PID」 대신에, 「Component_tag」가 배치되게 된다.

도 7(a)는, ES_association 디스크립터의 구조예(Syntax)를 도시하고 있다. 「descriptor_tag」는, 디스크립터 타입를 나타내는 8비트의 데이터이고, 여기서는, ES_association 디스크립터인 것을 나타낸다. 「descriptor_length」는, 디스크립터의 길이(사이즈)를 나타내는 8비트의 데이터이다. 이 데이터는, 디스크립터의 길이로서, 「descriptor _length」 이후의 바이트수를 나타낸다.

「existence_of_stream_association_info」의 1비트 필드는, 도 7(b)에 도시하는 바와 같이, 엘리멘터리 스트림에, 스트림 관련 정보가 존재하는지 등을 나타내는 플래그이다. "1"은 엘리멘터리 스트림에 스트림 관련 정보가 존재하는 것을 나타내고, "0"은, 엘리멘터리 스트림에 스트림 관련 정보가 존재하지 않는 것을 나타낸다. 또는, "1"은 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보에 변경이 있는 것을 나타내고, "0"은 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보에 변경이 없는 것을 나타낸다.

도 8은, 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보와, 트랜스포트 스트림에 삽입되어 있는 ES_association 디스크립터와의 관계의 한 예를 도시하고 있다. 스트림 관련 정보가 엘리멘터리 스트림에 존재하기 때문에, 수신측에서 그 참조를 촉구하도록, 트랜스포트 스트림의 예를 들면 PMT의 배하에 ES_association 디스크립터를 삽입하여 전송한다.

수신측의 디코더는, ES_association 디스크립터를 참조하여, 다음의 GOP로부터 각 엘리멘터리 스트림의 관련짓는 구성이 변하는 것을 사전에 검지할 수 있기 때문에, 안정된 수신 동작이 가능해진다. 또한, 방송프로그램 단위에 고정적으로 배치할 때에는, ES_association 디스크립터는, EIT 배하에 놓여진다.

또한, 도 4의 구성례에서는, 베이스 뷰의 엘리멘터리 스트림에, 이 베이스 뷰의 엘리멘터리 스트림과, 논베이스 뷰의 비디오 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입된다. 이 스트림 관련 정보는, 유저 데이터 영역을 이용하여, 픽처 단위 또는 GOP 단위로 삽입된다.

예를 들면, 부호화 방식이 MPEG4-AVC인 경우, 스트림 관련 정보는, 액세스 유닛의 "SELs"의 부분에, 「Stream Association Information SEI message」로서, 삽입된다. 도 9(a)는, GOP(Group Of Pictures)의 선두의 액세스 유닛을 도시하고 있고, 도 9(b)는, GOP의 선두 이외의 액세스 유닛을 도시하고 있다. 스트림 관련 정보가 GOP 단위로 삽입되는 경우, GOP의 선두의 액세스 유닛에만 「Stream Association Information SEI message」가 삽입된다.

도 10(a)는, 「Stream Association InformationSEI message」의 구조예(Syntax)를 도시하고 있다. 「uuid_iso_iec_11578」은, "ISO/IEC 11578 : 1996AnnexA."로 나타나는 UUID값을 갖는. 「user_data_payload_byte」의 필드에, 「userdata_for_stream_association()」가 삽입된다. 도 10(b)는, 「userdata_for_stream_association()」의 구조예(Syntax)를 도시하고 있고, 이 중에, 스트림 관련 정보로서의 「Stream_association()」가 삽입된다. 「Stream_association_id」는, 부호 없이 16비트로 나타나는 스트림 관련 정보의 식별자이다.

또한, 예를 들면, 부호화 방식이 MPEG2 video인 경우, 스트림 관련 정보는, 화상 헤더부의 유저 데이터 영역에, 유저 데이터「user_data()」로서 삽입된다. 도 11은, 「user_data()」의 구조예(Syntax)를 도시하고 있다. 「user_data_start_code」의 32비트 필드는, 유저 데이터(user_data)의 시작 코드이고, "0x000001B2"의 고정치가 된다. 이 시작 코드에 계속된 16비트 필드는, 유저 데이터의 내용을 식별한 식별자이다. 여기서는, 「Stream_Association_identifier」가 되어, 유저 데이터가, 스트림 관련 정보인 것을 식별 가능하게 한다. 이 식별자의 후의 데이터 본체로서, 스트림 관련 정보로서의 「Stream_association()」가 삽입된다.

도 12는, 스트림 관련 정보「Stream_association()」의 구조예(Syntax)를 도시하고 있다. 도 13은, 도 12에 도시하는 구조예에서의 각 정보의 내용(Semantics)를 도시하고 있다. 「Stream_association_length」의 8비트 필드는, 이 필드 이후의 전체의 바이트 사이즈를 나타낸다. 「Stream_count_for_association」의 4비트 필드는, 관련지여지는 엘리멘터리 스트림의 수를 나타내고, 0 내지 15의 값을 취한다.

「Self_ES_id」의 4비트 필드는, 본 스트림 관련 정보가 배치되는 엘리멘터리 스트림(본 엘리멘터리 스트림) 자신의 관련지움 식별자를 나타낸다. 예를 들면, 기본이 되는 엘리멘터리 스트림(제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림)의 식별자를 "0"으로 한다.

「indication_of_selected_stream_display」의 1비트 필드는, 본 엘리멘터리 스트림 이외에 디코더 출력을 표시시키는, 표시 필수의 엘리멘터리 스트림이 존재하는지의 여부를 지시하는 플래그이다. "1"은, 본 엘리멘터리 스트림 이외에 표시 필수의 엘리멘터리 스트림이 있는 것을 나타낸다. "0"은, 본 엘리멘터리 스트림 이외에 표시 필수의 엘리멘터리 스트림이 없는 것을 나타낸다. "1"인 경우, 후술하는 「display_mandatory_flag」으로 세트된 논베이스 뷰의 엘리멘터리 스트림은, 베이스 뷰의 비디오 엘리멘터리 스트림과 함께 표시 필수가 된다.

「indication_of_other_resolution_master」의 1비트 필드는, 본 엘리멘터리 스트림이 아니라, 다른 엘리멘터리 스트림이 해상도 또는 샘플링 주파수의 표시 기준인지의 여부를 나타내는 플래그이다. "1"은, 다른 엘리멘터리 스트림이 표시 기준이 되는 것을 나타낸다. "0"은, 본 엘리멘터리 스트림이 표시 기준이 되는 것을 나타낸다.

「terminating_current_association_flag」의 1비트 필드는, 엘리멘터리 스트림의 구성이 다음의 액세스 유닛(AU : Access Unit)부터 변경되는지를 나타낸다. "1"은, 다음의 액세스 유닛부터 엘리멘터리 스트림의 구성이 변경되는 것을 나타낸다. "0"은, 다음의 액세스 유닛도 현재의 액세스 유닛과 엘리멘터리 스트림의 구성이 같은 것을 나타낸다. 이 플래그 정보는, 예고 정보를 구성하고 있다.

「display_position」의 4비트 필드는, 본 엘리멘터리 스트림에 포함되는 화상 데이터에 의한 뷰가, 입체(3D) 표시일 때에, 멀티 뷰잉 중의 어느 뷰로서 표시되어야 할 것인지를 나타내고, 0 내지 15의 값을 취한다.

예를 들면, 도 14에 도시하는 바와 같이, 트랜스포트 스트림이, PMT의 「Stream_Type=0x1B」로 보내지는 MVC의 베이스 뷰(base view)의 스트림과, PMT의 「Stream_Type=0x20」로 보내지는 MVC의 논베이스 뷰(Non base view)의 스트림을 갖는 경우의 예를 생각한다. 이 경우, 베이스 뷰 스트림 내의 스트림 관련 정보에서는 「display_position=0」이고, 논베이스 뷰 스트림 내의 스트림 관련 정보에서는 「display_position=15」라고 한다.

도 15는, 그 경우에 있어서의, 수신측에서의 입체(3D) 표시일 때의 뷰 표시예를 도시하고 있다. 즉, 베이스 뷰 스트림에 포함되는 화상 데이터에 의한 뷰는 표시 포지선 「0」의 뷰로서 표시된다. 또한, 논베이스 뷰 스트림에 포함되는 화상 데이터에 의한 뷰는 표시 포지선 「15」의 뷰로서 표시된다.

도 12로 되돌아와, 「associated_ES_id」의 4비트 필드는, 본 엘리멘터리 스트림과 관련되는 엘리멘터리 스트림의 식별자(관련지움 식별자)를 나타내고, 0 내지 15의 값을 취한다. 「display_mandatory_flag」의 1비트 필드는, 「associated_ES_id」의 엘리멘터리 스트림이 표시 필수인지의 여부를 나타낸다. "1"은, 해당 엘리멘터리 스트림은 표시 필수인 것을 나타낸다. "0"은, 해당 엘리멘터리 스트림은 표시 필수가 아닌 것을 나타낸다.

「resolution_master_flag」의 1비트 필드는, 「associated_ES_id」의 엘리멘터리 스트림이 해상도 또는 샘플링 주파수의 표시 기준인지의 여부를 나타낸다. "1"은, 해당 엘리멘터리 스트림은 표시 기준인 것을 나타낸다. "0"은, 해당 엘리멘터리 스트림은 표시 기준이 아닌 것을 나타낸다.

도 16은, 「indication_of_selected_stream_display」의 삽입례를 도시하고 있다. 이 예는, 베이스 뷰의 엘리멘터리 스트림은 좌안(L) 화상 데이터를 포함하고, 우안(R) 화상 데이터 및 중앙(C) 화상 데이터를 각각 포함하는 2개의 논베이스 뷰의 엘리멘터리 스트림이 존재하는 예이다. 또한, 이 도 16에서는, 「indication_of_selected_stream_display」를 「indication_display」로, 「display_mandatory_flag」를 「mandatory_flag」으로, 약기하고 있다.

베이스 뷰외에 2개의 논베이스 뷰의 엘리멘터리 스트림을 표시 필수로 하는 경우를 생각한다. 이 경우, 「indication_of_selected_stream_display=1」이 되고, 또한, 2개의 논베이스 뷰의 엘리멘터리 스트림에 관해 「display_mandatory_flag=1」이 된다. 이 설정에 의해, 수신기에서의 표시 필수는, 좌안(L), 우안(R) 및 중앙(C)의 화상이 된다.

또한, 베이스 뷰 외에 우안(R) 화상 데이터를 포함하는 논베이스 뷰의 엘리멘터리 스트림을 표시 필수로 하는 경우를 생각한다. 이 경우, 「indication_of_selected_stream_display=1」이 되고, 또한, 우안(R) 화상 데이터를 포함하는 논베이스 뷰의 엘리멘터리 스트림에 관해서만 「display_mandatory_flag=1」이 된다. 이 설정에 의해, 수신기에서의 표시 필수는, 좌안(L) 및 우안(R)의 화상이 된다.

또한, 베이스 뷰의 엘리멘터리 스트림만을 표시 필수로 하는 경우를 생각한다. 이 경우, 「indication_of_selected_stream_display=0」이 된다. 이 설정에 의해, 수신기에서의 표시 필수는, 좌안(L)의 화상만으로 된다.

「수신기의 구성례」

도 17은, 수신기(200)의 구성례를 도시하고 있다. 이 수신기(200)는, CPU(201)와, 플래시 ROM(202)과, DRAM(203)과, 내부 버스(204)와, 리모콘 수신부(205)와, 리모콘 송신기(206)를 갖고 있다. 또한, 이 수신기(200)는, 안테나 단자(211)와, 디지털 튜너(212)와, 트랜스포트 스트림 버퍼(TS 버퍼)(213)와, 디멀티플렉서(214)를 갖고 있다.

또한, 수신기(200)는, 비디오 디코더(215)와, 뷰 버퍼(216, 216-1 내지 216-N)와, 스케일러(224, 224-1 내지 224-N)와, 비디오 중첩부(217, 217-1 내지 217-N)를 갖고 있다. 또한, 수신기(200)는, 그래픽스 디코더(218)와, 그래픽스 발생부(219)와, 시차 정보 디코더(220)와, 그래픽스 버퍼(221, 221-1 내지 221-N)와, 오디오 디코더(222)와, 채널 처리부(223)를 갖고 있다.

CPU(201)는, 수신기(200)의 각 부분의 동작을 제어한다. 플래시 ROM(202)은, 제어 소프트웨어의 격납 및 데이터의 보관을 행한다. DRAM(203)은, CPU(201)의 워크 에어리어를 구성한다. CPU(201)는, 플래시 ROM(202)로부터 판독한 소프트웨어나 데이터를 DRAM(203)상에 전개하여 소프트웨어를 기동시키고, 수신기(200)의 각 부분을 제어한다. 리모콘 수신부(205)는, 리모콘 송신기(206)로부터 송신된 리모트 콘트롤 신호(리모콘 코드)를 수신하고, CPU(201)에 공급한다. CPU(201)는, 이 리모콘 코드에 의거하여, 수신기(200)의 각 부분을 제어한다. CPU(201), 플래시 ROM(202) 및 DRAM(203)은 내부 버스(204)에 접속되어 있다.

안테나 단자(211)는, 수신 안테나(도시 생략)에서 수신된 텔레비전 방송 신호를 입력하는 단자이다. 디지털 튜너(212)는, 안테나 단자(211)에 입력된 텔레비전 방송 신호를 처리하여, 유저의 선택 채널에 대응한 소정의 트랜스포트 스트림(비트 스트림 데이터)(TS)을 출력한다. 트랜스포트 스트림 버퍼(TS 버퍼)(213)는, 디지털 튜너(212)로부터 출력된 트랜스포트 스트림(TS)을 일시적으로 축적한다.

이 트랜스포트 스트림(TS)은, 상술한 바와 같이, 비디오, 시차 정보, 그래픽스, 오디오 등의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖고 있다. 그리고, 이 경우, 이 트랜스포트 스트림(TS)은, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림을 갖고 있다. 또한, 이 트랜스포트 스트림(TS)은, 이 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 갖고 있다.

여기서, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림만이 존재하는 경우, 이 제1의 화상 데이터는 2차원(2D) 화상 데이터를 구성한다. 한편, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림 외에, 제2의 화상 데이터를 포함하는 단수 또는 복수의 제2의 엘리멘터리 스트림이 존재하는 경우, 이들 제1의 화상 데이터 및 소정수의 제2의 화상 데이터는 입체(3D) 화상 데이터를 구성한다. 여기서, 제1의 화상 데이터는 베이스 뷰의 화상 데이터를 구성하고, 소정수의 제2의 화상 데이터는 논베이스 뷰의 화상 데이터를 구성하고 있다.

상술한 바와 같이, 트랜스포트 스트림(TS)의 비디오 엘리멘터리 스트림, 적어도 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림에는, 픽처 단위 또는 GOP 단위로, 유저 데이터 영역을 이용하여, 스트림 관련 정보(도 12 참조)가 삽입되어 있다.

또한, 상술한 바와 같이, 트랜스포트 스트림(TS)에는, 예를 들면 PMT의 배하에, ES_ID 디스크립터(도 6 참조)가 삽입되어 있다. 이 ES_ID 디스크립터는, 각 엘리멘터리 스트림의 식별자와, 각 엘리멘터리 스트림의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계를 나타내는 것이다. 스트림 관련 정보는, 각 엘리멘터리 스트림을 식별하기 위한 식별자를 이용하여 각 엘리멘터리 스트림의 관련을 나타낸다. 따라서, ES_ID 디스크립터에 의해, 각 엘리멘터리 스트림의 트랜스포트 스트림 레이어에서의 등록 상태와, 스트림 관련 정보와의 연휴가 취하여진다.

또한, 상술한 바와 같이, 트랜스포트 스트림(TS)에는, 예를 들면 PMT 또는 EIT의 배하에, ES_association 디스크립터(도 7(a)참조)가 삽입되어 있다. 이 ES_association 디스크립터는, 엘리멘터리 스트림에 스트림 관련 정보가 삽입되어 있는지의 여부, 또는, 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보에 변경이 있는지의 여부를 나타내는 것이다. 따라서, 이 ES_association 디스크립터에 의해, 스트림 관련 정보의 참조가 촉구된다

디멀티플렉서(214)는, TS 버퍼(213)에 일시적으로 축적된 트랜스포트 스트림(TS)로부터, 비디오, 시차 정보, 그래픽스 및 오디오의 각 엘리멘터리 스트림을 추출한다. 시차 정보 엘리멘터리 스트림은, 트랜스포트 스트림(TS)에 입체(3D) 화상 데이터의 비디오 엘리멘터리 스트림이 포함되어 있는 경우만 추출된다.

또한, 디멀티플렉서(214)는, 트랜스포트 스트림(TS)에 포함되는 ES_ID 디스크립터 및 ES_association 디스크립터를 추출하고, CPU(201)에 공급한다. CPU(201)는, ES_ID 디스크립터에 의해, 각 엘리멘터리 스트림의 식별자와, 각 엘리멘터리 스트림의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계를 인식한다. 또한, CPU(201)는, ES_association 디스크립터에 의해, 비디오 엘리멘터리 스트림, 예를 들면 제1의 화상 데이터를 포함하는 비디오 엘리멘터리 스트림에 스트림 관련 정보가 삽입되어 있는지의 여부, 또는, 그 정보에 변경이 있는지의 여부를 인식한다.

비디오 디코더(215)는, 상술한 송신 데이터 생성부(110)의 비디오 인코더(112)와는 반대의 처리를 행한다. 즉, 이 비디오 디코더(215)는, 디멀티플렉서(214)에서 추출된 각 비디오 엘리멘터리 스트림에 포함되는 부호화 화상 데이터에 대해 복호화 처리를 행하여 복호화된 화상 데이터를 얻는다.

여기서, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림만이 존재하는 경우, 비디오 디코더(215)는, 이 제1의 화상 데이터를 2차원(2D) 화상 데이터로서 얻는다. 또한, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림 외에, 제2의 화상 데이터를 포함하는 단수 또는 복수의 제2의 엘리멘터리 스트림이 존재하는 경우, 비디오 디코더(215)는, 입체(3D) 화상 데이터를 얻는다. 즉, 제1의 화상 데이터를 베이스 뷰의 화상 데이터로서 얻음과 하께, 소정수의 제2의 화상 데이터를 논베이스 뷰의 화상 데이터로서 얻는다.

또한, 비디오 디코더(215)는, 비디오 엘리멘터리 스트림, 예를 들면 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림으로부터 스트림 관련 정보를 추출하고, CPU(201)에 공급한다. 비디오 디코더(215)는, 이 추출 처리를, CPU(201)의 제어하 행한다. CPU(201)는, 상술한 바와 같이, ES_association 디스크립터에 의해, 스트림 관련 정보가 존재하는지의 여부, 또는, 그 정보에 변경이 있는지의 여부를 인식할 수 있기 때문에, 필요에 응하여, 비디오 디코더(215)에게 추출 처리를 행하게 할 수 있다.

CPU(201)는, 비디오 디코더(215)에서 추출되는 스트림 관련 정보에 의해, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림에 관련되는 소정수의 제2의 엘리멘터리 스트림이 존재를 인식할 수 있다. CPU(201)는, 이 인식에 의거하여, 제1의 엘리멘터리 스트림과 함께, 이 제1의 엘리멘터리 스트림에 관련되는 소정수의 제2의 엘리멘터리 스트림이 추출되도록, 디멀티플렉서(214)를 제어한다.

뷰 버퍼(비디오 버퍼)(216)는, CPU(201)의 제어에 의해, 비디오 디코더(215)에서 취득되는 제1의 화상 데이터를 일시적으로 축적한다. 이 제1의 화상 데이터는, 2차원 화상 데이터, 또는 입체 화상 데이터를 구성하는 베이스 뷰의 화상 데이터이다. 또한, 뷰 버퍼(비디오 버퍼)(216-1 내지 216-N)는, CPU(201)의 제어에 의해, 비디오 디코더(215)에서 취득되는 입체 화상 데이터를 구성하는 N개의 논베이스 뷰의 화상 데이터를 각각 일시적으로 축적한다.

CPU(201)는, 뷰 버퍼(216, 216-1 내지 216-N)의 판독 제어를 행한다. CPU(201)는, 스트림 관련 정보에 포함되는 「terminating_current_association_flag」의 플래그에 의해, 엘리멘터리 스트림의 구성이 다음의 액세스 유닛(픽처)으로부터 변경되는지의 여부를 미리 알 수 있다. 그 때문에, 이들 뷰 버퍼(216, 216-1 내지 216-N)로부터의 판독 제어를 솜씨 좋게 동적으로 바꾸는 것이 가능해진다.

스케일러(224, 224-1 내지 224-N)는, CPU(201)의 제어하에, 뷰 버퍼(216, 216-1 내지 216-N)로부터 출력되는 각 뷰의 화상 데이터의 출력 해상도가, 소정의 해상도가 되도록 조정한다. 스케일러(224, 224-1 내지 224-N)는, 해상도 조정부를 구성하고 있다. 비디오 중첩부(217, 217-1 내지 217-N)에는, 해상도 조정된 각 뷰의 화상 데이터가 보내진다.

이 경우, CPU(201)는, 비디오 디코더(215)로부터, 각 뷰의 화상 데이터의 해상도 정보를 취득한다. CPU(201)는, 각 뷰의 화상 데이터의 출력 해상도가 목표 해상도가 되도록, 각 뷰의 해상도 정보에 의거하여, 스케일러(224, 224-1 내지 224-N)의 필터 설정을 실행한다. 스케일러(224, 224-1 내지 224-N)에서는, 입력 화상 데이터의 해상도가 목표 해상도와 다를 때, 보간 처리에 의해 해상도 변환이 행하여져서, 목표 해상도의 출력 화상 데이터가 얻어진다.

CPU(201)는, 스트림 관련 정보에 포함되는 「indication_of_other_resolution_master」 및 「resolution_master_flag」의 플래그에 의거하여, 목표 해상도의 설정을 행한다. 즉, 이들 플래그로 해상도 기준으로 되어 있는 엘리멘터리 스트림에 포함되는 화상 데이터의 해상도를 목표 해상도로 설정한다.

그래픽스 디코더(218)는, 상술한 송신 데이터 생성부(110)의 그래픽스 인코더(116)와는 반대의 처리를 행한다. 즉, 그래픽스 디코더(218)는, 디멀티플렉서(214)에서 추출된 그래픽스 엘리멘터리 스트림에 포함되는 부호화 그래픽스 데이터에 대해 복호화 처리를 행하여 복호화된 그래픽스 데이터(서브타이틀 데이터를 포함한다)를 얻는다.

시차 정보 디코더(220)는, 상술한 송신 데이터 생성부(110)의 시차 정보 인코더(113)와는 반대의 처리를 행한다. 즉, 시차 정보 디코더(220)는, 디멀티플렉서(214)에서 추출된 시차 정보 엘리멘터리 스트림에 포함되는 부호화 시차 정보에 대해 복호화 처리를 행하여 복호화된 시차 정보를 얻는다. 이 시차 정보는, 베이스 뷰와 각 논베이스 뷰와의 사이의 시차를 나타내는 시차 벡터, 또는 깊이 데이터 등이다. 깊이 데이터는, 소정의 변환에 의해 시차 벡터로서 취급하는 것이 가능해진다. 시차 정보는, 예를 들면, 픽셀(화소)마다의 시차 정보, 또는 뷰(화상)를 소정수로 분할하여 얻어진 각 분할 영역의 시차 정보이다.

그래픽스 발생부(219)는, CPU(201)의 제어에 의해, 그래픽스 디코더(218)에서 얻어진 그래픽스 데이터에 의거하여, 화상에 중첩하는 그래픽스 정보의 데이터를 발생한다. 그래픽스 발생부(219)는, 비디오 디코더(215)로부터 2차원 화상 데이터(제1의 화상 데이터)만이 출력될 때는, 이 2차원 화상 데이터에 중첩하는 그래픽스 정보의 데이터를 발생한다. 또한, 그래픽스 발생부(219)는, 비디오 디코더(215)로부터 입체(3D) 화상 데이터를 구성하는 각 뷰의 화상 데이터가 출력될 때는, 각 뷰의 화상 데이터에 중첩하는 그래픽스 정보의 데이터를 발생한다.

그래픽스 버퍼(221)는, CPU(201)의 제어에 의해, 그래픽스 발생부(219)에서 발생되는, 제1의 화상 데이터에 중첩하여야 할 그래픽스 정보의 데이터를 축적한다. 이 제1의 화상 데이터는, 2차원 화상 데이터, 또는 입체 화상 데이터를 구성하는 베이스 뷰의 화상 데이터이다. 또한, 그래픽스 버퍼(221-1 내지 221-N)는, 그래픽스 발생부(219)에서 발생되는, N개의 논베이스 뷰의 화상 데이터에 중첩하여야 할 그래픽스 정보의 데이터를 축적한다.

비디오 중첩부(디스플레이 버퍼)(217)는, CPU(201)의 제어에 의해, 그래픽스 정보가 중첩된 제1의 화상 데이터를 출력한다. 이 제1의 화상 데이터는, 2차원 화상 데이터(SV), 또는 입체 화상 데이터를 구성하는 베이스 뷰의 화상 데이터(BN)이다. 이 때, 비디오 중첩부(217)는, 스케일러(224)에서 해상도 조정된 제1의 화상 데이터에, 그래픽스 버퍼(221)에 축적된 그래픽스 정보의 데이터를 중첩한다.

또한, 비디오 중첩부(디스플레이 버퍼)(217-1 내지 217-N)는, CPU(201)의 제어에 의해, 그래픽스 정보가 중첩된 N개의 논베이스 뷰의 화상 데이터(NB-1 내지 NB-N)를 출력한다. 이 때, 비디오 중첩부(217-1 내지 217-N)는, 스케일러(224-1 내지 224-N)에서 해상도 조정된 베이스 뷰의 화상 데이터에, 각각 그래픽스 버퍼(221-1 내지 221-N)에 축적된 그래픽스 정보의 데이터를 중첩한다.

또한, 비디오 디코더(215)로부터 입체(3D) 화상 데이터를 구성하는 각 뷰의 화상 데이터가 출력될 때, 기본적으로는, 상술한 바와 같이, 비디오 중첩부(217, 217-1 내지 217-N)로부터 그들의 화상 데이터가 출력된다. 그러나, 유저의 선택 조작에 응하여, CPU(201)는, 논베이스 뷰의 화상 데이터의 출력을 제어한다.

단, CPU(201)는, 표시 필수로 되어 있는 논베이스 뷰의 화상 데이터에 관해서는, 유저의 선택 조작에 관계없이, 반드시 출력되도록 제어한다. CPU(201)는, 스트림 관련 정보에 포함되는 「indication_of_selected_stream_display」 및 「display_mandatory_flag」의 플래그에 의거하여, 표시 필수로 되어 있는 논베이스 뷰의 화상 데이터를 인식할 수 있다.

예를 들면, 좌안 화상 데이터를 포함하는 베이스 뷰의 비디오 엘리멘터리 스트림에 대해, 우안 화상 데이터를 포함하는 논베이스 뷰의 비디오 엘리멘터리 스트림이 관련지어져 있는 경우를 생각한다. 이 경우, 「indication_of_selected_stream_display」가 "1"이고, 논베이스 뷰의 「display_mandatory_flag」가 "1"일 때는, 유저의 선택 조작에 관계없이, 좌안 화상 데이터 및 우안 화상 데이터의 쌍방을 표시 화상 데이터로서 출력시킨다. 한편, 「indication_of_selected_stream_display」가 "0"일 때는, 유저의 선택 조작에 응하여, 좌안 화상 데이터만, 또는 좌안 화상 데이터 및 우안 화상 데이터의 쌍방을, 표시 화상 데이터로서 출력시킨다.

오디오 디코더(222)는, 상술한 송신 데이터 생성부(110)의 오디오 인코더(114)와는 반대의 처리를 행한다. 즉, 이 오디오 디코더(222)는, 디멀티플렉서(214)에서 추출된 오디오 엘리멘터리 스트림에 포함되는 부호화 음성 데이터에 대해 복호화 처리를 행하여 복호화된 음성 데이터를 얻는다. 채널 처리부(223)는, 오디오 디코더(222)로 얻어지는 음성 데이터에 대해, 예를 들면 5.1ch 서라운드 등을 실현하기 위한 각 채널의 음성 데이터(SA)를 생성하여 출력한다.

수신기(200)의 동작을 간단히 설명한다. 안테나 단자(211)에 입력된 텔레비전 방송 신호는 디지털 튜너(212)에 공급된다. 이 디지털 튜너(212)에서는, 텔레비전 방송 신호가 처리되어, 유저의 선택 채널에 대응한 소정의 트랜스포트 스트림(TS)이 출력된다. 이 트랜스포트 스트림(TS)은, TS 버퍼(213)에 일시적으로 축적된다.

디멀티플렉서(214)에서는, TS 버퍼(213)에 일시적으로 축적된 트랜스포트 스트림(TS)으로부터, 비디오, 시차 정보, 그래픽스 및 오디오의 각 엘리멘터리 스트림이 추출된다. 시차 정보 엘리멘터리 스트림은, 트랜스포트 스트림(TS)에 입체(3D) 화상 데이터의 비디오 엘리멘터리 스트림이 포함되어 있는 경우만 추출된다.

또한, 디멀티플렉서(214)에서는, 트랜스포트 스트림(TS)에 포함되는 ES_ID 디스크립터 및 ES_association 디스크립터가 추출되고, CPU(201)에 공급된다. CPU(201)에서는, ES_ID 디스크립터에 의해, 각 엘리멘터리 스트림의 식별자와, 각 엘리멘터리 스트림의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계가 인식된다. 또한, CPU(201)에서는, ES_association 디스크립터에 의해, 비디오 엘리멘터리 스트림, 예를 들면 제1의 화상 데이터를 포함하는 비디오 엘리멘터리 스트림에 스트림 관련 정보가 삽입되어 있는지의 여부, 또는, 그 정보에 변경이 있는지의 여부가 인식된다.

비디오 디코더(215)에서는, 디멀티플렉서(214)에서 추출된 각 비디오 엘리멘터리 스트림에 포함되는 부호화 화상 데이터에 대해 복호화 처리가 행하여지고, 복호화된 화상 데이터가 얻어진다. 여기서, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림만이 존재하는 경우, 비디오 디코더(215)에서는, 이 제1의 화상 데이터가 2차원(2D) 화상 데이터로서 얻어진다. 또한, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림 외에, 제2의 화상 데이터를 포함하는 단수 또는 복수의 제2의 엘리멘터리 스트림이 존재하는 경우, 비디오 디코더(215)에서는, 입체(3D) 화상 데이터가 얻어진다. 즉, 제1의 화상 데이터가 베이스 뷰의 화상 데이터로서 얻어짐과 하께, 소정수의 제2의 화상 데이터가 논베이스 뷰의 화상 데이터로서 얻어진다.

또한, 비디오 디코더(215)에서는, 비디오 엘리멘터리 스트림, 예를 들면 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림으로부터 스트림 관련 정보가 추출되고, CPU(201)에 공급된다. 비디오 디코더(215)에서는, 이 추출 처리가, CPU(201)의 제어하에 행하여진다. CPU(201)는, 상술한 바와 같이, ES_association 디스크립터에 의해, 스트림 관련 정보가 존재하는지의 여부, 또는, 그 정보에 변경이 있는지의 여부를 인식할 수 있기 때문에, 필요에 응하여, 비디오 디코더(215)에 추출 처리를 행하게 할 수 있다.

CPU(201)에서는, 비디오 디코더(215)에서 추출된 스트림 관련 정보에 의해, 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림에 관련되는 소정수의 제2의 엘리멘터리 스트림이 존재가 인식된다. CPU(201)에서는, 이 인식에 의거하여, 제1의 엘리멘터리 스트림과 함께, 이 제1의 엘리멘터리 스트림에 관련되는 소정수의 제2의 엘리멘터리 스트림이 추출되도록, 디멀티플렉서(214)의 제어가 행하여진다.

뷰 버퍼(비디오 버퍼)(216)에서는, CPU(201)의 제어에 의해, 비디오 디코더(215)에서 취득되는 제1의 화상 데이터가 일시적으로 축적된다. 이 제1의 화상 데이터는, 2차원 화상 데이터, 또는 입체 화상 데이터를 구성하는 베이스 뷰의 화상 데이터이다. 또한, 뷰 버퍼(비디오 버퍼)(216-1 내지 216-N)에서는, CPU(201)의 제어에 의해, 비디오 디코더(215)에서 취득되는 입체 화상 데이터를 구성하는 N개의 논베이스 뷰의 화상 데이터가 각각 일시적으로 축적된다.

CPU(201)에서는, 뷰 버퍼(216, 216-1 내지 216-N)의 판독 제어가 행하여진다. CPU(201)에서는, 스트림 관련 정보에 포함되는 「terminating_current_association_flag」의 플래그에 의해, 엘리멘터리 스트림의 구성이 다음의 액세스 유닛(픽처)으로부터 변경되는지의 여부가 미리 인식된다. 그 때문에, 이들 뷰 버퍼(216, 216-1 내지 216-N)로부터의 판독 제어를, 솜씨 좋게 동적으로 바꾸는 것이 가능해진다.

스케일러(224, 224-1 내지 224-N)에서는, CPU(201)의 제어하에, 뷰 버퍼(216, 216-1 내지 216-N)로부터 출력되는 각 뷰의 화상 데이터의 출력 해상도가, 소정의 해상도가 되도록 조정된다. 그리고, 비디오 중첩부(217, 217-1 내지 217-N)에는, 해상도 조정된 각 뷰의 화상 데이터가 보내진다. 이 경우, CPU(201)에서는, 비디오 디코더(215)로부터, 각 뷰의 화상 데이터의 해상도 정보가 취득된다.

그리고, CPU(201)에서는, 각 뷰의 화상 데이터의 출력 해상도가 목표 해상도가 되도록, 각 뷰의 해상도 정보에 의거하여, 스케일러(224, 224-1 내지 224-N)의 필터 설정이 행하여진다. 그 때문에, 스케일러(224, 224-1 내지 224-N)에서는, 입력 화상 데이터의 해상도가 목표 해상도와 다를 때, 보간 처리에 의해 해상도 변환이 행하여지고, 목표 해상도의 출력 화상 데이터가 얻어진다.

CPU(201)에서는, 스트림 관련 정보에 포함되는 「indication_of_other_resolution_master」 및 「resolution_master_flag」의 플래그에 의거하여, 목표 해상도의 설정이 행하여진다. 이 경우, 이들의 플래그에 의해 해상도 기준으로 되어 있는 엘리멘터리 스트림에 포함되는 화상 데이터의 해상도가 목표 해상도가 된다.

그래픽스 디코더(218)에서는, 디멀티플렉서(214)에서 추출된 그래픽스 엘리멘터리 스트림에 포함되는 부호화 그래픽스 데이터에 대해 복호화 처리가 행하여지고, 복호화된 그래픽스 데이터(서브타이틀 데이터를 포함한다)가 얻어진다.

시차 정보 디코더(220)에서는, 디멀티플렉서(214)에서 추출된 시차 정보 엘리멘터리 스트림에 포함되는 부호화 시차 정보에 대해 복호화 처리가 행하여지고, 복호화된 시차 정보가 업어진다. 이 시차 정보는, 베이스 뷰와 각 논베이스 뷰와의 사이의 시차를 나타내는 시차 벡터, 또는 깊이 데이터 등이다. 깊이 데이터는, 소정의 변환에 의해 시차 벡터로서 취급하는 것이 가능해진다.

그래픽스 발생부(219)에서는, 그래픽스 디코더(218)에서 얻어진 그래픽스 데이터에 의거하여, 화상에 중첩하는 그래픽스 정보의 데이터가 발생된다. 그래픽스 발생부(219)에서는, 비디오 디코더(215)로부터 2차원 화상 데이터(제1의 화상 데이터)만이 출력될 때는, 이 2차원 화상 데이터에 중첩하는 그래픽스 정보의 데이터가 발생된다. 또한, 그래픽스 발생부(219)에서는, 비디오 디코더(215)로부터 입체(3D) 화상 데이터를 구성하는 각 뷰의 화상 데이터가 출력될 때는, 각 뷰의 화상 데이터에 중첩한 그래픽스 정보의 데이터가 발생된다.

그래픽스 버퍼(221)에서는, 그래픽스 발생부(219)에서 발생되는, 제1의 화상 데이터에 중첩하여야 할 그래픽스 정보의 데이터가 축적된다. 이 제1의 화상 데이터는, 2차원 화상 데이터, 또는 입체 화상 데이터를 구성하는 베이스 뷰의 화상 데이터이다. 또한, 그래픽스 버퍼(221-1 내지 221-N)에서는, 그래픽스 발생부(219)에서 발생되는, N개의 논베이스 뷰의 화상 데이터에 중첩하여야 할 그래픽스 정보의 데이터가 축적된다.

비디오 중첩부(디스플레이 버퍼)(217)에서는, 스케일러(224)에서 해상도 조정된 제1의 화상 데이터에, 그래픽스 버퍼(221)에 축적된 그래픽스 정보의 데이터가 중첩된다. 그리고, 이 비디오 중첩부(217)로부터는, 그래픽스 정보가 중첩된 제1의 화상 데이터가 출력된다. 이 제1의 화상 데이터는, 2차원 화상 데이터(SV), 또는 입체 화상 데이터를 구성하는 베이스 뷰의 화상 데이터(BN)이다.

또한, 비디오 중첩부(디스플레이 버퍼)(217-1 내지 217-N)에서는, 스케일러(224-1 내지 224-N)에서 해상도 조정된 베이스 뷰의 화상 데이터에, 각각 그래픽스 버퍼(221-1 내지 221-N)에 축적된 그래픽스 정보의 데이터가 중첩된다. 그리고, 비디오 중첩부(217-1 내지 217-N)로부터는, 그래픽스 정보가 중첩된 N개의 논베이스 뷰의 화상 데이터(NB-1 내지 NB-N)가 출력된다.

오디오 디코더(222)에서는, 디멀티플렉서(214)에서 추출된 오디오 엘리멘터리 스트림에 포함되는 부호화 음성 데이터에 대해 복호화 처리가 행하여지고, 복호화된 음성 데이터가 업어진다. 채널 처리부(223)에서는, 오디오 디코더(222)에서 얻어지는 음성 데이터에 대해 처리가 행하여져서, 예를 들면 5.1ch 서라운드 등을 실현하기 위한 각 채널의 음성 데이터(SA)가 생성되어 출력된다.

이상 설명한 바와 같이, 도 1에 도시하는 화상 송수신 시스템(10)에서, 방송국(100)으로부터 수신기(200)에 송신되는 트랜스포트 스트림(TS)가 갖는 엘리멘터리 스트림에, 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입된다(도 12 참조). 이 스트림 관련 정보는, 제1의 화상 데이터(2차원 화상 데이터 또는 베이스 뷰의 화상 데이터)를 포함하는 제1의 엘리멘터리 스트림과, 소정수의 제2의 화상 데이터 및/메타 데이터를 포함하는 제2의 엘리멘터리 스트림과의 관련을 나타내는 것이다. 그 때문에, 수신기(200)에서는, 스트림 관련 정보에 의거하여, 엘리멘터리 스트림의 구성의 동적인 변화, 즉 배신 내용의 동적인 변화에 적확하게 대응할 수 있고, 올바른 스트림의 수신을 행할 수가 있다.

도 18은, 트랜스포트 스트림(TS)에, 「Stream_Type=0x1B」이고, 「PID=01」인 MVC의 베이스 뷰의 스트림(ES1)이 연속하여 포함되고, 「Stream_Type=0x20」이고, 「PID=11」인 MVC의 논베이스 뷰의 스트림(ES2)이 간헐적으로 포함되는 경우의 예를 도시하고 있다. 이 경우, 스트림(ES1)에, 스트림 관련 정보가 삽입되어 있다. 또한, 스트림(ES1)의 식별자(ES_id)는 0이고, 스트림(ES2)의 식별자(ES_id)는 1이라고 한다.

tn-1, tn+1의 기간에는, 스트림(ES1)과 함께, 스트림(ES2)이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=1」이 되어 스트림(ES1)에 관련되는 스트림이 하나 존재하고, 그 스트림의 식별자(ES_id)가 1인 것이 나타난다. 즉, 스트림 관련 정보에서, 스트림(ES1)과 스트림(ES2)이 관련지여저 있다. 그 때문에, 스트림(ES1, ES2)의 쌍방이 추출되어 디코드되고, 베이스 뷰의 화상 데이터, 예를 들면 좌안 화상 데이터와, 논베이스 뷰의 화상 데이터, 예를 들면 우안 화상 데이터가 표시 화상 데이터로서 출력되고, 입체(3D) 표시가 행하여진다.

또한, tn의 기간에는, 스트림(ES1)만이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=0」이 되어 스트림(ES1)에 관련되는 스트림이 존재하지 않는 것이 나타난다. 그 때문에, 스트림(ES1)만이 추출되어 디코드되어 2차원 화상 데이터로서 출력되고, 2차원(2D) 표시가 행하여진다.

도 19는, 트랜스포트 스트림(TS)에, 「Stream_Type=0x02」이고, 「PID=01」인 MPEG2video 스트림(ES1)이 연속하여 포함되고, 「Stream_Type=0x02」이고, 「PID=11」인 MPEG2video 스트림(ES2)이 간헐적으로 포함되는 경우의 예를 도시하고 있다. 이 경우, 스트림(ES1)에, 스트림 관련 정보가 삽입되어 있다. 또한, 스트림(ES1)의 식별자(ES_id)는 0이고, 스트림(ES2)의 식별자(ES_id)는 1이라고 한다.

tn-1, tn+1의 기간에는, 스트림(ES1)과 함께, 스트림(ES2)이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=1」이 되어 스트림(ES1)에 관련되는 스트림이 하나 존재하고, 그 스트림의 식별자(ES_id)가 1인 것이 나타난다. 즉, 스트림 관련 정보에서, 스트림(ES1)과 스트림(ES2)이 관련지여저 있다. 그 때문에, 스트림(ES1, ES2)의 쌍방이 추출되어 디코드되고, 제1의 화상 데이터, 예를 들면 좌안 화상 데이터와, 제2의 화상 데이터, 예를 들면 우안 화상 데이터가 표시 화상 데이터로서 출력되고, 입체(3D) 표시가 행하여진다.

또한, tn의 기간에는, 스트림(ES1)만이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=0」이 되어 스트림(ES1)에 관련되는 스트림이 존재하지 않는 것이 나타난다. 그 때문에, 스트림(ES1)만이 추출되어 디코드되어 2차원 화상 데이터가 출력되고, 2차원(2D) 표시가 행하여진다.

도 20은, 트랜스포트 스트림(TS)에, 「Stream_Type=0x02」이고, 「PID=01」인 MPEG2video 스트림(ES1)이 연속하여 포함되고, 「Stream_Type=0x1B」이고, 「PID=11」인 AVC 스트림(ES2)이 간헐적으로 포함되는 경우의 예를 도시하고 있다. 이 경우, 스트림(ES1)에, 스트림 관련 정보가 삽입되어 있다. 또한, 스트림(ES1)의 식별자(ES_id)는 0이고, 스트림(ES2)의 식별자(ES_id)는 1이라고 한다.

tn-1, tn+1의 기간에는, 스트림(ES1)과 함께, 스트림(ES2)이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=1」이 되어 스트림(ES1)에 관련되는 스트림이 하나 존재하고, 그 스트림의 식별자(ES_id)가 1인 것이 나타난다. 즉, 스트림 관련 정보에서, 스트림(ES1)과 스트림(ES2)이 관련지여저 있다. 그 때문에, 스트림(ES1, ES2)의 쌍방이 추출되어 디코드되고, 제1의 화상 데이터, 예를 들면 좌안 화상 데이터와, 제2의 화상 데이터, 예를 들면 우안 화상 데이터가 표시 화상 데이터로서 출력되고, 입체(3D) 표시가 행하여진다.

또한, tn의 기간에는, 스트림(ES1)만이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=0」이 되어 스트림(ES1)에 관련되는 스트림이 존재하지 않는 것이 나타난다. 그 때문에, 스트림(ES1)만이 추출되어 디코드되어 2차원 화상 데이터가 출력되고, 2차원(2D) 표시가 행하여진다.

또한, 도 1에 도시하는 화상 송수신 시스템(10)에서, 엘리멘터리 스트림에 삽입되는 스트림 관련 정보에는, 소정수의 제2의 화상 데이터의 각각에 대해 표시 필수로 하는지의 여부를 지정하는 제어 정보가 포함되어 있다. 즉, 이 스트림 관련 정보에는, 「indication_of_selected_stream_display」, 「display_mandatory_flag」가 포함되어 있다(도 12 참조). 그 때문에, 수신기(200)에서는, 이 제어 정보에 의거하여, 소정수의 제2의 화상 데이터의 어느 것이 표시 필수인지를 알 수 있고, 유저에 의한 화상 표시 양태의 선택을 제한하는 것이 가능해진다.

도 21은, 트랜스포트 스트림(TS)에, 「Stream_Type=0x1B」이고, 「PID=01」인 MVC의 베이스 뷰의 스트림(ES1)과, 「Stream_Type=0x20」이고, 「PID=11」인 MVC의 논베이스 뷰의 스트림(ES2)이, 연속적으로 포함되는 경우의 예를 도시하고 있다. 이 경우, 스트림(ES1)에, 스트림 관련 정보가 삽입되어 있다. 또한, 스트림(ES1)의 식별자(ES_id)는 0이고, 스트림(ES2)의 식별자(ES_id)는 1이라고 한다.

tn-1, tn+1의 기간에는, 스트림(ES1)과 함께, 스트림(ES2)이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=1」이 되어 스트림(ES1)에 관련되는 스트림이 하나 존재하고, 그 스트림의 식별자(ES_id)가 1인 것이 나타난다. 즉, 스트림 관련 정보에서, 스트림(ES1)과 스트림(ES2)이 관련지여저 있다.

이 기간에, 스트림 관련 정보에서, 「indication_of_selected_stream_display=1」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하는 것이 나타나 있다. 또한, 이 스트림 관련 정보에서, 스트림의 식별자(ES_id)가 1인 스트림에서는, 「display_mandatory_flag=1」이 되어, 스트림(ES2)이 표시 필수인 것이 나타나 있다. 또한, 도 21에서는, 「indication_of_selected_stream_display」가 「Selected_display」으로 약기되어 있다.

그 때문에, 이 기간에서는, 스트림(ES1, ES2)의 쌍방이 추출되어 디코드되고, 베이스 뷰의 화상 데이터, 예를 들면 좌안 화상 데이터와, 논베이스 뷰의 화상 데이터, 예를 들면 우안 화상 데이터가 표시 화상 데이터로서 출력되고, 입체(3D) 표시가 행하여진다.

또한, tn의 기간에도, tn-1의 기간과 마찬가지로, 스트림(ES1)과 함께, 스트림(ES2)이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=1」이 되어 스트림(ES1)에 관련되는 스트림이 하나 존재하고, 그 스트림의 식별자(ES_id)가 1인 것이 나타난다. 즉, 스트림 관련 정보에서, 스트림(ES1)과 스트림(ES2)이 관련지여저 있다.

이 기간, 스트림 관련 정보에서, 「indication_of_selected_stream_display=0」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하지 않는 것이 나타나 있다. 또한, 이 스트림 관련 정보에서, 스트림의 식별자(ES_id)가 1인 스트림에서는, 「display_mandatory_flag=0」이 되어, 스트림(ES2)이 표시 필수가 아닌 것이 나타나 있다.

그 때문에, 이 기간에서는, 스트림(ES1, ES2)의 쌍방이 추출되어 디코드된다. 이 경우, 스트림(ES2)이 표시 필수가 아니기 때문에, 입체(3D) 표시 외에, 유저의 선택 조작에 의해, 2차원(2D) 표시도 허가된다. 입체(3D) 표시인 경우에는, 베이스 뷰의 화상 데이터, 예를 들면 좌안 화상 데이터와, 논베이스 뷰의 화상 데이터, 예를 들면 우안 화상 데이터가 표시 화상 데이터로서 출력된다. 한편, 2차원(2D) 표시인 경우에는, 베이스 뷰의 화상 데이터만이 표시 화상 데이터로서 출력된다.

또한, 도 1에 도시하는 화상 송수신 시스템(10)에서, 엘리멘터리 스트림에 삽입되는 스트림 관련 정보에는, 각 엘리멘터리 스트림의 관련의 변화가 실제로 일어나기 전에, 이 변화가 일어나는 것을 알리는 예고 정보가 포함되어 있다. 즉, 이 스트림 관련 정보에는, 「terminating_current_association_flag」가 포함되어 있다(도 12 참조). 그 때문에, 수신기(200)에서는, 이 예고 정보에 의거하여, 디코더 버퍼로부터의 판독 제어를 솜씨 좋게 동적으로 바꾸는 것이 가능해진다.

도 22는, 트랜스포트 스트림(TS)에, 「Stream_Type=0x1B」이고, 「PID=01」인 MVC의 베이스 뷰의 스트림(ES1)이 연속적으로 포함됨과 하께, 「Stream_Type=0x20」이고, 「PID=11」인 MVC의 논베이스 뷰의 스트림(ES2)이 간헐적으로 포함되는 경우의 예를 도시하고 있다. 이 경우, 스트림(ES1)에, 스트림 관련 정보가 삽입되어 있다. 또한, 스트림(ES1)의 식별자(ES_id)는 0이고, 스트림(ES2)의 식별자(ES_id)는 1이라고 한다.

tn-1의 기간에는, 스트림(ES1)과 함께, 스트림(ES2)이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=1」이 되어 스트림(ES1)에 관련되는 스트림이 하나 존재하고, 그 스트림의 식별자(ES_id)가 1인 것이 나타난다. 즉, 스트림 관련 정보에서, 스트림(ES1)과 스트림(ES2)이 관련지여저 있다. 그 때문에, 스트림(ES1, ES2)의 쌍방이 추출되어 디코드되고, 베이스 뷰의 화상 데이터, 예를 들면 좌안 화상 데이터와, 논베이스 뷰의 화상 데이터, 예를 들면 우안 화상 데이터가 표시 화상 데이터로서 출력되고, 입체(3D) 표시가 행하여진다.

이 tn-1의 기간의 최후의 액세스 유닛에 배치된 스트림 관련 정보에서, 「terminating_current_association_flag=1」이 되어, 다음의 액세스 유닛으로부터 엘리멘터리 스트림의 구성이 변경되는 것이 나타난다. 또한, 도 22에서, 「terminating_current_association_flag」는, 「Terminating_flg」으로 약기되어 있다.

또한, tn-1의 기간에 계속된 tn의 기간에는, 스트림(ES1)만이 존재한다. 그 때문에, 스트림 관련 정보에서, 「Stream_count_for_association=0」이 되어 스트림(ES1)에 관련되는 스트림이 존재하지 않는 것이 나타난다. 그 때문에, 스트림(ES1)만이 추출되어 디코드되어 2차원 화상 데이터로서 출력되고, 2차원(2D) 표시가 행하여진다.

이 tn의 기간의 최후의 액세스 유닛에 배치된 스트림 관련 정보에서, 「terminating_current_association_flag=1」이 되어, 다음의 액세스 유닛으로부터 엘리멘터리 스트림의 구성이 변경되는 것이 나타난다.

또한, tn의 기간에 계속된 tn+1 기간에는, tn-1 기간과 같은 상태ㅏ 된다. 이 기간에서의 스트림 관련 정보의 내용은, 상술한 tn-1의 기간과 마찬가지가 된다. 그 때문에, 스트림(ES1, ES2)의 쌍방이 추출되어 디코드되고, 베이스 뷰의 화상 데이터, 예를 들면 좌안 화상 데이터와, 논베이스 뷰의 화상 데이터, 예를 들면 우안 화상 데이터가 표시 화상 데이터로서 출력되고, 입체(3D) 표시가 행하여진다.

또한, 도 1에 도시하는 화상 송수신 시스템(10)에서, 엘리멘터리 스트림에는, 스트림 관련 정보가, 픽처 단위 또는 GOP 단위로 삽입된다. 그 때문에, 수신기(200)에서는, 엘리멘터리 스트림의 구성, 예를 들면, 입체 화상 데이터의 뷰 수의 변화 등을, 픽처 단위 또는 GOP 단위로 관리 가능해진다.

또한, 도 1에 도시하는 화상 송수신 시스템(10)에서, 방송국(100)으로부터 수신기(200)에 송신되는 트랜스포트 스트림(TS)에는, 엘리멘터리 스트림에 스트림 관련 정보가 삽입되어 있는지의 여부, 또는, 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보에 변경이 있는지의 여부를 나타내는 기술자가 삽입된다. 즉, 트랜스포트 스트림(TS)에, ES_association 디스크립터가 삽입된다. 이 ES_association 디스크립터에 의해, 엘리멘터리 스트림에 삽입되어 있는 스트림 관련 정보의 참조를 촉구할 수 있고, 수신기(200)에 있어서 안정된 수신 동작이 가능해진다.

또한, 도 1에 도시하는 화상 송수신 시스템(10)에서, 엘리멘터리 스트림에 삽입되는 스트림 관련 정보에는, 제1의 화상 데이터 및 제2의 화상 데이터의 출력 해상도의 제어 정보가 포함된다. 즉, 이 스트림 관련 정보에는, 「indication_of_other_resolution_master」, 「resolution_master_flag」가 포함되어 있다. 그 때문에, 수신기(200)에서는, 이 제어 정보에 의거하여, 제1의 화상 데이터 및 제2의 화상 데이터의 출력 해상도를 표시 기준의 해상도로 조정하는 것이 가능해진다.

또한, 상술한 설명에서는, 제1의 화상 데이터(2차원 화상 데이터 또는 베이스 뷰의 화상 데이터)를 포함하는 제1의 엘리멘터리 스트림만 스트림 관련 정보가 삽입되어 있는 예를 나타내였다(도 18 등 참조). 그러나, 제2의 화상 데이터(논베이스 뷰의 화상 데이터)를 포함하는 제2의 엘리멘터리 스트림에 스트림 관련 정보를 더욱 삽입하는 것도 생각된다.

도 23은, 트랜스포트 스트림(TS)에, 「Stream_Type=0x1B」이고, 「PID=01」인 MVC의 베이스 뷰의 스트림(ES1)이 포함되고, 「Stream_Type=0x20」이고, 「PID=11」, 「PID=21」인 MVC의 논베이스 뷰의 스트림(ES2, ES3)이 포함되는 경우의 예를 도시하고 있다. 이 경우, 스트림(ES1)에, 스트림 관련 정보가 삽입되는 외에, 스트림(ES2, ES3)에도 스트림 관련 정보가 삽입되어 있다. 또한, 스트림(ES1)의 식별자(ES_id)는 0이고, 스트림(ES2)의 식별자(ES_id)는 1이고, 또한, 스트림(ES3)의 식별자(ES_id)는 2이라고 한다.

스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서는, 「Stream_count_for_association=2」가 되어, 이 스트림(ES1)에 관련되는 스트림이 2개 존재하고, 그 스트림의 식별자(ES_id)가 1, 2인 것이 나타나 있다. 스트림(ES2)에 삽입되어 있는 스트림 관련 정보에서는, 「Stream_count_for_association=1」이 되어, 이 스트림(ES2)에 관련되는 스트림이 하나 존재하고, 그 스트림의 식별자(ES_id)가 0인 것이 나타나 있다. 또한, 스트림(ES3)에 삽입되어 있는 스트림 관련 정보에서는, 「Stream_count_for_association=1」이 되어, 이 스트림(ES3)에 관련되는 스트림이 하나 존재하고, 그 스트림의 식별자(ES_id)가 0인 것이 나타나 있다.

tn-1, tn+1의 기간에서, 스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=1」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하는 것이 나타나 있다. 그리고, 스트림의 식별자(ES_id)가 1, 2인 스트림에서는, 「display_mandatory_flag=1」이 되어, 스트림(ES2, ES3)의 쌍방이 표시 필수인 것이 나타나 있다.

또한, tn의 기간에서, 스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=0」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하지 않는 것이 나타나 있다. 그리고, 스트림의 식별자(ES_id)가 1, 2인 스트림에서는, 「display_mandatory_flag=0」이 되어, 스토리에 무ES2, ES3의 쌍방 모두 표시 필수가 아닌 것이 나타나 있다.

도 24는, 도 23과 마찬가지로, 트랜스포트 스트림(TS)에, 「Stream_Type=0x1B」이고, 「PID=01」인 MVC의 베이스 뷰의 스트림(ES1)이 포함되고, 「Stream_Type=0x20」이고, 「PID=11」, 「PID=21」인 MVC의 논베이스 뷰의 스트림(ES2, ES3)이 포함되는 경우의 예를 도시하고 있다. 이 경우, 스트림(ES1)에, 스트림 관련 정보가 삽입되는 외에, 스트림(ES2, ES3)에도 스트림 관련 정보가 삽입되어 있다. 또한, 스트림(ES1)의 식별자(ES_id)는 0이고, 스트림(ES2)의 식별자(ES_id)는 1이고, 또한, 스트림(ES3)의 식별자(ES_id)는 2이라고 한다.

스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서는, 「Stream_count_for_association=2」가 되어, 이 스트림(ES1)에 관련되는 스트림이 2개 존재하고, 그 스트림의 식별자(ES_id)가 1, 2인 것이 나타나 있다. 스트림(ES2)에 삽입되어 있는 스트림 관련 정보에서는, 「Stream_count_for_association=2」가 되어, 이 스트림(ES2)에 관련되는 스트림이 2개 존재하고, 그 스트림의 식별자(ES_id)가 0, 2인 것이 나타나 있다. 또한, 스트림(ES3)에 삽입되어 있는 스트림 관련 정보에서는, 「Stream_count_for_association=2」가 되어, 이 스트림(ES3)에 관련되는 스트림이 2개 존재하고, 그 스트림의 식별자(ES_id)가 0, 1인 것이 나타나 있다.

tn-1, tn의 기간에서, 스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=1」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하는 것이 나타나 있다. 그리고, 스트림의 식별자(ES_id)가 1, 2인 스트림에서는, 「display_mandatory_flag=1」이 되어, 스트림(ES2, ES3)의 쌍방이 표시 필수인 것이 나타나 있다.

또한, tn-1, tn의 기간에서, 스트림(ES2)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=1」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하는 것이 나타나 있다. 그리고, 스트림의 식별자(ES_id)가 0, 2인 스트림에서는, 「display_mandatory_flag=1」이 되어, 스트림(ES1, ES3)의 쌍방이 표시 필수인 것이 나타나 있다.

또한, tn-1, tn의 기간에서, 스트림(ES3)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=1」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하는 것이 나타나 있다. 그리고, 스트림의 식별자(ES_id)가 0, 1인 스트림에서는, 「display_mandatory_flag=1」이 되어, 스트림(ES1, ES2)의 쌍방이 표시 필수인 것이 나타나 있다.

또한, tn의 기간에서, 스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=0」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하지 않는 것이 나타나 있다. 그리고, 스트림의 식별자(ES_id)가 1, 2인 스트림에서는, 「display_mandatory_flag=0」이 되어, 스트림(ES2, ES3)의 쌍방 함께 표시 필수가 아닌 것이 나타나 있다.

또한, 이 tn의 기간에서, 스트림(ES2, ES3)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=0」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하지 않는 것이 나타나 있다. 그러나, 상술한 바와 같이, 스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=0」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하지 않는 것이 나타나 있다. 그 때문에, 스트림(ES2, ES3)에 삽입되어 있는 스트림 관련 정보에 있어서 표시 필수의 정보는 무시된다.

<2. 변형례>

또한, 상술한 실시의 형태에서는, 화상 데이터의 부호화 방식으로서, MPEG4-AVC 및 MPEG2video의 부호화를 들고 있다. 그러나, 화상 데이터에 실시되는 부호화는 이들로 한정되지 않는다.

또한, 상술한 실시의 형태에서는, 주로, 스트림 관련 정보에 의해, 베이스 뷰 및 소정수의 논베이스 뷰의 스트림을 관련짓는 예를 나타내였다. 그러나, 이 스트림 관련 정보에 의해, 예를 들면, 베이스 뷰의 화상 데이터에 관련되는 메타 데이터도 관련짓는 것이 생각된다. 메타 데이터로서는, 예를 들면 시차 정보(시차 벡터 또는 깊이 데이터) 등이 생각된다.

도 25는, 트랜스포트 스트림(TS)에, 「Stream_Type=0x1B」이고, 「PID=01」인 MVC의 베이스 뷰의 스트림(ES1)이 포함되고, 「Stream_Type=0x20」이고, 「PID=11」인 MVC의 논베이스 뷰의 스트림(ES2)이 포함되고, 또한, 「Stream_Type=0xAB」이고, 「PID=21」인 메타 데이터 스트림(ES3)이 포함되어 있다. 또한, 스트림(ES1)의 식별자(ES_id)는 0이고, 스트림(ES2)의 식별자(ES_id)는 1이고, 또한, 스트림(ES3)의 식별자(ES_id)는 2이라고 한다.

스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서는, 「Stream_count_for_association=2」가 되어, 이 스트림(ES1)에 관련되는 스트림이 2개 존재하고, 그 스트림의 식별자(ES_id)가 1, 2인 것이 나타나 있다. 또한, 이 예에서는, 스트림(ES2, ES3)에, 스트림 관련 정보는, 삽입되어 있지 않다.

tn-1, tn+1의 기간에서, 스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=1」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하는 것이 나타나 있다. 그리고, 스트림의 식별자(ES_id)가 1인 스트림에서는, 「display_mandatory_flag=1」이 되어, 스트림(ES2)이 표시 필수인 것이 나타나 있다. 또한, tn의 기간에서, 스트림(ES1)에 삽입되어 있는 스트림 관련 정보에서, 「indication_of_selected_stream_display=0」이 되어, 자신의 스트림 이외에 표시 필수의 스트림이 존재하지 않는 것이 나타나 있다.

도 26은, 포스트 처리부를 구비하는 수신기(200A)의 구성례를 도시하고 있다. 이 도 26에서, 도 17과 대응하는 부분에는 동일 부호를 붙이고, 그 상세 설명은 생략한다. 또한, 이 수신기(200A)에서는, 스케일러(224, 224-1 내지 224-N)를 제외한 것으로 하고 있다. 이 수신기(200A)는, CPU(201)와, 플래시 ROM(202)과, DRAM(203)과, 내부 버스(204)와, 리모콘 수신부(205)와, 리모콘 송신기(206)를 갖고 있다. 또한, 이 수신기(200)는, 안테나 단자(211)와, 디지털 튜너(212)와, 트랜스포트 스트림 버퍼(TS 버퍼)(213)와, 디멀티플렉서(214)를 갖고 있다.

또한, 수신기(200A)는, 비디오 디코더(215)와, 뷰 버퍼(216, 216-1 내지 216-N)와, 비디오 중첩부(217, 217-1 내지 217-N)와, 메타 데이터 버퍼(225)와, 포스트 처리부(226)를 갖고 있다. 또한, 수신기(200)는, 그래픽스 디코더(218)와, 그래픽스 발생부(219)와, 시차 정보 디코더(220)와, 그래픽스 버퍼(221, 221-1 내지 221-N)와, 오디오 디코더(222)와, 채널 처리부(223)를 갖고 있다.

메타 데이터 버퍼(225)는, 비디오 디코더(215)에서 취득되는 픽셀(화소)마다의 시차 정보를 일시적으로 축적한다. 또한, 시차 정보가 픽셀(화소)마다의 시차 정보인 경우, 이 시차 정보를 화소 데이터와 같이 취급할 수 있다. 비디오 디코더(215)에서 픽셀(화소)마다의 시차 정보가 취득된 것에서는, 송신측에서, 시차 정보에 대해 화상 데이터와 같은 부호화 방식으로 부호화가 시행되어 시차 정보 엘리멘터리 스트림이 생성되고 있다.

포스트 처리부(226)는, 메타 데이터 버퍼(225)에 축적되어 있는 픽셀(화소)마다의 시차 정보를 이용하여, 뷰 버퍼(216, 216-1 내지 216-N)로부터 출력되는 각 뷰의 화상 데이터에 보간 처리(포스트 처리)를 시행하여, 소정수의 뷰의 표시 화상 데이터(Display View 1 내지 Display View P)를 얻는다.

도 26에 도시하는 수신기(200A)에서의 기타는, 상세 설명은 생략하지만, 도 17에 도시하는 수신기(200)와 마찬가지로 구성되고, 마찬가지로 동작한다.

또한, 상술한 실시의 형태에서는, 입체(3D) 표시를 위한 베이스 뷰와 논베이스 뷰의 화상 데이터를 포함하는 복수의 엘리멘터리 스트림에, 스트림 관련 정보에 의해 관련짓는 예를 들고 있다. 그러나, 본 기술은, SVC 스트림에도 마찬가지로 적용할 수 있다.

SVC 스트림에는, 스케일러불 부호화 화상 데이터를 구성하는 최하위층의 부호화 화상 데이터의 비디오 엘리멘터리 스트림이 포함된다. 또한, 이 SVC 스트림에는, 스케일러불 부호화 화상 데이터를 구성하는 최하위층 이외의 소정수의 상위 계층의 부호화 화상 데이터의 비디오 엘리멘터리 스트림이 포함된다. 이 SVC 스트림에, 상술한 스트림 관련 정보와 같은 정보를 삽입함으로써, 수신측에서는, SVC 스트림의 동적인 변화, 즉 배신 내용의 동적인 변화에 적확하게 대응할 수 있고, 올바른 스트림의 수신을 행하는 것이 가능해진다.

또한, 상술한 실시의 형태에서는, 트랜스포트 스트림(TS)을 방송파에 실어서 배신하는 예를 나타내였지만, 본 발명은, 이 트랜스포트 스트림(TS)을, 인터넷 등의 네트워크를 통하여 배신하는 경우에도 마찬가지로 적용할 수 있다. 한편으로, 트랜스포트 스트림(TS) 이외의 컨테이너 파일 포맷에서의 인터넷 배신의 경우에도, 상술한 연관 데이터의 구성을 적용할 수 있음은 물론이다.

또한, 본 기술은, 이하와 같은 구성도 취할 수 있다.

(1) 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 생성하는 인코드부와,

상기 인코드부에서 생성된 상기 각 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 송신하는 송신부를 구비하고,

상기 인코드부는, 적어도, 상기 제1의 엘리멘터리 스트림에, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보를 삽입하는 화상 데이터 송신 장치.

(2) 상기 스트림 관련 정보는, 상기 각 엘리멘터리 스트림의 관련의 변화가 실제로 일어나기 전에, 그 변화가 일어나는 것을 알리는 예고 정보를 포함하는 상기 (1)에 기재된 화상 데이터 송신 장치.

(3) 상기 인코드부는, 상기 엘리멘터리 스트림에, 상기 스트림 관련 정보를 픽처 단위 또는 GOP 단위로 삽입하는 상기 (1) 또는 (2)에 기재된 화상 데이터 송신 장치.

(4) 상기 스트림 관련 정보는, 상기 각 엘리멘터리 스트림을 식별하기 위한 식별자를 이용하여, 상기 각 엘리멘터리 스트림의 관련을 나타내는 상기 (1)부터 (3)의 어느 하나에 기재된 화상 데이터 송신 장치.

(5) 상기 송신부는, 상기 트랜스포트 스트림에, 상기 각 엘리멘터리 스트림의 식별자와, 그 각 엘리멘터리 스트림의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계를 나타내는 기술자를 삽입하는 상기 (4)에 기재된 화상 데이터 송신 장치.

(6) 상기 송신부는, 상기 트랜스포트 스트림에, 상기 엘리멘터리 스트림과 상기 스트림 관련 정보가 삽입되어 있는지의 여부, 또는, 상기 엘리멘터리 스트림에 삽입되어 있는 상기 스트림 관련 정보에 변경이 있는지의 여부를 나타내는 기술자를 삽입하는 상기 (1)부터 (5)의 어느 하나에 기재된 화상 데이터 송신 장치.

(7) 상기 제1의 엘리멘터리 스트림에 포함되는 제1의 화상 데이터의 부호화 방식과, 상기 소정수의 제2의 엘리멘터리 스트림에 포함되는 제2의 화상 데이터의 부호화 방식으로서, 임의의 부호화 방식의 조합이 가능하게 되어 있는 상기 (1)부터 (6)의 어느 하나에 기재된 화상 데이터 송신 장치.

(8) 상기 제1의 화상 데이터는, 입체 화상 데이터를 구성하는 베이스 뷰의 화상 데이터이고,

상기 제2의 화상 데이터는, 상기 입체 화상 데이터를 구성하는 상기 베이스 뷰 이외의 뷰의 화상 데이터인 상기 (1)부터 (7)에 기재된 화상 데이터 송신 장치.

(9) 상기 제1의 화상 데이터는, 스테레오 입체 화상을 얻기 위한 좌안 및 우안의 한쪽의 화상 데이터이고,

상기 제2의 화상 데이터는, 상기 스테레오 입체 화상을 얻기 위한 좌안 및 우안의 다른쪽의 화상 데이터인 상기 (8)에 기재된 화상 데이터 송신 장치.

(10) 상기 메타 데이터는, 상기 입체 화상 데이터에 대응한 시차 정보인 상기 (8) 또는 (9)에 기재된 화상 데이터 송신 장치.

(11) 상기 스트림 관련 정보는, 그 스트림 관련 정보가 삽입된 엘리멘터리 스트림에 포함되는 화상 데이터에 의한 뷰가, 입체 표시일 때에, 멀티 뷰잉 중의 어느 뷰로서 표시되어야 할 것인지를 나타내는 포지션 정보를 포함하는 상기 (8)부터 (10)의 어느 하나에 기재된 화상 데이터 송신 장치.

(12) 상기 제1의 화상 데이터는, 스케일러불 부호화 화상 데이터를 구성하는 최하위층의 부호화 화상 데이터이고,

상기 제2의 화상 데이터는, 상기 스케일러불 부호화 화상 데이터를 구성하는 상기 최하위층 이외의 계층의 부호화 화상 데이터인 상기 (1)부터 (11)에 기재된 화상 데이터 송신 장치.

(13) 상기 스트림 관련 정보는, 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터의 출력 해상도의 제어 정보를 또한 포함하는 상기 (1)부터 (12)에 기재된 화상 데이터 송신 장치.

(14) 상기 스트림 관련 정보는, 상기 소정수의 제2의 화상 데이터의 각각에 대해 표시 필수로 하는지의 여부를 지정하는 제어 정보를 또한 포함하는 상기 (1)부터 (13)에 기재된 화상 데이터 송신 장치.

(15) 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 생성하는 인코드 스텝과,

상기 인코드 스텝에서 생성된 상기 각 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 송신하는 송신 스텝을 구비하고,

상기 인코드 스텝에서는, 적어도, 상기 제1의 엘리멘터리 스트림에, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보를 삽입하는 화상 데이터 송신 방법.

(16) 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 수신하는 수신부를 구비하고,

적어도, 상기 제1의 엘리멘터리 스트림에는, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있고,

상기 스트림 관련 정보에 의거하여, 상기 수신부에서 수신된 상기 제1의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터를 취득하고, 상기 수신부에서 수신된 상기 소정수의 제2의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터에 관련되는 상기 제2의 화상 데이터 및/또는 메타 데이터를 취득하는 데이터 취득부를 또한 구비하는 화상 데이터 수신 장치.

(17) 상기 데이터 취득부에서 취득된 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터의 해상도를 조정하여 출력하는 해상도 조정부를 또한 구비하고,

상기 스트림 관련 정보는, 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터의 출력 해상도의 제어 정보를 포함하고,

상기 해상도 조정부는, 상기 출력 해상도의 제어 정보에 의거하여, 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터의 해상도를 조정하는 상기 (16)에 기재된 화상 데이터 수신 장치.

(18) 상기 데이터 취득부에서 취득된 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터에 의거한 화상 표시 양태를 선택하는 화상 표시 양태 선택부를 또한 구비하고,

상기 스트림 관련 정보는, 상기 소정수의 제2의 화상 데이터의 각각에 대해 표시 필수로 하는지의 여부를 지정하는 제어 정보를 포함하고,

상기 화상 표시 양태 선택부는, 상기 제어 정보에 의거하여 화상 표시 양태의 선택이 제한되는 상기 (16) 또는 (17)에 기재된 화상 데이터 수신 장치.

(19) 상기 데이터 취득부에서 취득된 상기 메타 데이터는, 상기 입체 화상 데이터에 대응한 시차 정보이고,

그 시차 정보를 이용하여, 상기 데이터 취득부에서 취득된 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터에 보간 처리를 시행하여, 소정수의 뷰의 표시 화상 데이터를 얻는 포스트 처리부를 또한 구비하는 상기 (16)부터 (18)의 어느 하나에 기재된 화상 데이터 수신 장치.

(20) 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 수신하는 수신 스텝을 구비하고,

적어도, 상기 제1의 엘리멘터리 스트림에는, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있고,

상기 스트림 관련 정보에 의거하여, 상기 수신 스텝에서 수신된 상기 제1의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터를 취득하고, 상기 수신 스텝에서 수신된 상기 소정수의 제2의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터에 관련된 상기 제2의 화상 데이터 및/또는 메타 데이터를 취득하는 데이터 취득 스텝을 또한 구비하는 화상 데이터 수신 방법.

10 : 화상 송수신 시스템

100 : 방송국

110 : 송신 데이터 생성부

111 : 데이터 취출부

111a : 데이터 기록 매체

112 : 비디오 인코더

113 : 시차 정보 인코더

114 : 오디오 인코더

115 : 그래픽스 발생부

116 : 그래픽스 인코더

117 : 멀티플렉서

200, 200A : 수신기

201 : CPU

212 : 디지털 튜너

213 : 트랜스포트 스트림 버퍼(TS 버퍼)

214 : 디멀티플렉서

215 : 비디오 디코더

216, 216-1 내지 216-N : 뷰 버퍼

217, 217-1 내지 217-N : 비디오 중첩부

218 : 그래픽스 디코더

219 : 그래픽스 발생부

220 : 시차 정보 디코더

221, 221-1 내지 221-N : 그래픽스 버퍼

222 : 오디오 디코더

223 : 채널 처리부

224, 224-1 내지 224-N : 스케일러

225 : 메타 데이터 버퍼

226 : 포스트 처리부

100 : 방송국

110 : 송신 데이터 생성부

111 : 데이터 취출부

111a : 데이터 기록 매체

112 : 비디오 인코더

113 : 시차 정보 인코더

114 : 오디오 인코더

115 : 그래픽스 발생부

116 : 그래픽스 인코더

117 : 멀티플렉서

200, 200A : 수신기

201 : CPU

212 : 디지털 튜너

213 : 트랜스포트 스트림 버퍼(TS 버퍼)

214 : 디멀티플렉서

215 : 비디오 디코더

216, 216-1 내지 216-N : 뷰 버퍼

217, 217-1 내지 217-N : 비디오 중첩부

218 : 그래픽스 디코더

219 : 그래픽스 발생부

220 : 시차 정보 디코더

221, 221-1 내지 221-N : 그래픽스 버퍼

222 : 오디오 디코더

223 : 채널 처리부

224, 224-1 내지 224-N : 스케일러

225 : 메타 데이터 버퍼

226 : 포스트 처리부

Claims (20)

- 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 생성하는 인코드부와,

상기 인코드부에서 생성된 상기 각 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 송신하는 송신부를 구비하고,

상기 인코드부는, 적어도, 상기 제1의 엘리멘터리 스트림에, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보를 삽입하는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 스트림 관련 정보는, 상기 각 엘리멘터리 스트림의 관련의 변화가 실제로 일어나기 전에, 그 변화가 일어나는 것을 알리는 예고 정보를 포함하는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 인코드부는, 상기 엘리멘터리 스트림에, 상기 스트림 관련 정보를 픽처 단위 또는 GOP 단위로 삽입하는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 스트림 관련 정보는, 상기 각 엘리멘터리 스트림을 식별하기 위한 식별자를 이용하여, 상기 각 엘리멘터리 스트림의 관련을 나타내는 것을 특징으로 하는 화상 데이터 송신 장치. - 제4항에 있어서,

상기 송신부는, 상기 트랜스포트 스트림에, 상기 각 엘리멘터리 스트림의 식별자와, 그 각 엘리멘터리 스트림의 패킷 식별자 또는 컴포넌트·태그와의 대응 관계를 나타내는 기술자를 삽입하는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 송신부는, 상기 트랜스포트 스트림에, 상기 엘리멘터리 스트림과 상기 스트림 관련 정보가 삽입되어 있는지의 여부, 또는, 상기 엘리멘터리 스트림에 삽입되어 있는 상기 스트림 관련 정보에 변경이 있는지의 여부를 나타내는 기술자를 삽입하는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 제1의 엘리멘터리 스트림에 포함되는 제1의 화상 데이터의 부호화 방식과, 상기 소정수의 제2의 엘리멘터리 스트림에 포함되는 제2의 화상 데이터의 부호화 방식으로서, 임의의 부호화 방식의 조합이 가능하게 되어 있는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 제1의 화상 데이터는, 입체 화상 데이터를 구성하는 베이스 뷰의 화상 데이터이고,

상기 제2의 화상 데이터는, 상기 입체 화상 데이터를 구성하는 상기 베이스 뷰 이외의 뷰의 화상 데이터인 것을 특징으로 하는 화상 데이터 송신 장치. - 제8항에 있어서,

상기 제1의 화상 데이터는, 스테레오 입체 화상을 얻기 위한 좌안 및 우안의 한쪽의 화상 데이터이고,

상기 제2의 화상 데이터는, 상기 스테레오 입체 화상을 얻기 위한 좌안 및 우안의 다른쪽의 화상 데이터인 것을 특징으로 하는 화상 데이터 송신 장치. - 제8항에 있어서,

상기 메타 데이터는, 상기 입체 화상 데이터에 대응한 시차 정보인 것을 특징으로 하는 화상 데이터 송신 장치. - 제8항에 있어서,

상기 스트림 관련 정보는, 그 스트림 관련 정보가 삽입된 엘리멘터리 스트림에 포함되는 화상 데이터에 의한 뷰가, 입체 표시일 때에, 멀티 뷰잉 중의 어느 뷰로서 표시되어야 할 것인지를 나타내는 포지션 정보를 포함하는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 제1의 화상 데이터는, 스케일러불 부호화 화상 데이터를 구성하는 최하위층의 부호화 화상 데이터이고,

상기 제2의 화상 데이터는, 상기 스케일러불 부호화 화상 데이터를 구성하는 상기 최하위층 이외의 계층의 부호화 화상 데이터인 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 스트림 관련 정보는, 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터의 출력 해상도의 제어 정보를 또한 포함하는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1항에 있어서,

상기 스트림 관련 정보는, 상기 소정수의 제2의 화상 데이터의 각각에 대해 표시 필수로 하는지의 여부를 지정하는 제어 정보를 또한 포함하는 것을 특징으로 하는 화상 데이터 송신 장치. - 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 생성하는 인코드 스텝과,

상기 인코드 스텝에서 생성된 상기 각 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 송신하는 송신 스텝을 구비하고,

상기 인코드 스텝에서는, 적어도, 상기 제1의 엘리멘터리 스트림에, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보를 삽입하는 것을 특징으로 하는 화상 데이터 송신 방법. - 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 수신하는 수신부를 구비하고,

적어도, 상기 제1의 엘리멘터리 스트림에는, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있고,

상기 스트림 관련 정보에 의거하여, 상기 수신부에서 수신된 상기 제1의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터를 취득하고, 상기 수신부에서 수신된 상기 소정수의 제2의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터에 관련되는 상기 제2의 화상 데이터 및/또는 메타 데이터를 취득하는 데이터 취득부를 또한 구비하는 것을 특징으로 하는 화상 데이터 수신 장치. - 제16항에 있어서,

상기 데이터 취득부에서 취득된 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터의 해상도를 조정하여 출력하는 해상도 조정부를 또한 구비하고,

상기 스트림 관련 정보는, 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터의 출력 해상도의 제어 정보를 포함하고,

상기 해상도 조정부는, 상기 출력 해상도의 제어 정보에 의거하여, 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터의 해상도를 조정하는 것을 특징으로 하는 화상 데이터 수신 장치. - 제16항에 있어서,

상기 데이터 취득부에서 취득된 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터에 의거한 화상 표시 양태를 선택하는 화상 표시 양태 선택부를 또한 구비하고,

상기 스트림 관련 정보는, 상기 소정수의 제2의 화상 데이터의 각각에 대해 표시 필수로 하는지의 여부를 지정하는 제어 정보를 포함하고,

상기 화상 표시 양태 선택부는, 상기 제어 정보에 의거하여 화상 표시 양태의 선택이 제한되는 것을 특징으로 하는 화상 데이터 수신 장치. - 제16항에 있어서,

상기 데이터 취득부에서 취득된 상기 메타 데이터는, 상기 입체 화상 데이터에 대응한 시차 정보이고,

그 시차 정보를 이용하여, 상기 데이터 취득부에서 취득된 상기 제1의 화상 데이터 및 상기 제2의 화상 데이터에 보간 처리를 시행하여, 소정수의 뷰의 표시 화상 데이터를 얻는 포스트 처리부를 또한 구비하는 것을 특징으로 하는 화상 데이터 수신 장치. - 제1의 화상 데이터를 포함하는 제1의 엘리멘터리 스트림과 상기 제1의 화상 데이터에 관련된 소정수의 제2의 화상 데이터 및/또는 메타 데이터를 각각 포함하는 소정수의 제2의 엘리멘터리 스트림을 패킷화하여 얻어진 각 패킷을 갖는 트랜스포트 스트림을 수신하는 수신 스텝을 구비하고,

적어도, 상기 제1의 엘리멘터리 스트림에는, 상기 각 엘리멘터리 스트림의 관련을 나타내는 스트림 관련 정보가 삽입되어 있고,

상기 스트림 관련 정보에 의거하여, 상기 수신 스텝에서 수신된 상기 제1의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터를 취득하고, 상기 수신 스텝에서 수신된 상기 소정수의 제2의 엘리멘터리 스트림으로부터 상기 제1의 화상 데이터에 관련되는 상기 제2의 화상 데이터 및/또는 메타 데이터를 취득하는 데이터 취득 스텝을 또한 구비하는 것을 특징으로 하는 화상 데이터 수신 방법.

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2011102370A JP2012235308A (ja) | 2011-04-28 | 2011-04-28 | 画像データ送信装置、画像データ送信方法、画像データ受信装置および画像データ受信方法 |

| JPJP-P-2011-102370 | 2011-04-28 | ||

| PCT/JP2012/060516 WO2012147596A1 (ja) | 2011-04-28 | 2012-04-18 | 画像データ送信装置、画像データ送信方法、画像データ受信装置および画像データ受信方法 |

Publications (1)

| Publication Number | Publication Date |

|---|---|

| KR20140003319A true KR20140003319A (ko) | 2014-01-09 |

Family

ID=47072117

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020127032608A KR20140003319A (ko) | 2011-04-28 | 2012-04-18 | 화상 데이터 송신 장치, 화상 데이터 송신 방법, 화상 데이터 수신 장치 및 화상 데이터 수신 방법 |

Country Status (7)

| Country | Link |

|---|---|

| US (1) | US20130088572A1 (ko) |

| EP (1) | EP2574053A4 (ko) |

| JP (1) | JP2012235308A (ko) |

| KR (1) | KR20140003319A (ko) |

| CN (1) | CN103026725A (ko) |

| BR (1) | BR112012033102A2 (ko) |

| WO (1) | WO2012147596A1 (ko) |

Families Citing this family (2)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| BR112015003707A2 (pt) * | 2012-08-27 | 2017-07-04 | Sony Corp | dispositivo e método de transmissão, e, dispositivo e método de recepção. |

| CN105409225B (zh) * | 2013-07-19 | 2019-09-17 | 皇家飞利浦有限公司 | Hdr元数据传输 |

Family Cites Families (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH10178594A (ja) * | 1996-12-19 | 1998-06-30 | Sanyo Electric Co Ltd | 3次元映像伝送方法、デジタル放送システムおよびデジタル放送システムにおけるユーザ側端末 |

| JP3731465B2 (ja) * | 2000-10-13 | 2006-01-05 | 株式会社ケンウッド | ディジタル放送受信機及びディジタル放送受信方法 |

| US7734085B2 (en) * | 2002-06-28 | 2010-06-08 | Sharp Kabushiki Kaisha | Image data delivery system, image data transmitting device thereof, and image data receiving device thereof |

| KR100657322B1 (ko) * | 2005-07-02 | 2006-12-14 | 삼성전자주식회사 | 로컬 3차원 비디오를 구현하기 위한 인코딩/디코딩 방법 및장치 |

| KR100818933B1 (ko) * | 2005-12-02 | 2008-04-04 | 한국전자통신연구원 | 디지털방송 기반 3차원 컨텐츠 서비스 제공 방법 |

| KR101245591B1 (ko) * | 2008-12-18 | 2013-03-20 | 엘지전자 주식회사 | 입체영상 디스플레이가 가능한 디지털 방송 수신방법, 및 이를 이용한 디지털 방송 수신장치 |

| US9282315B2 (en) * | 2008-12-30 | 2016-03-08 | Lg Electronics Inc. | Digital broadcast receiving method providing two-dimensional image and 3D image integration service, and digital broadcast receiving device using the same |

| WO2010095410A1 (ja) * | 2009-02-20 | 2010-08-26 | パナソニック株式会社 | 記録媒体、再生装置、集積回路 |

| JP2011066871A (ja) * | 2009-08-21 | 2011-03-31 | Sony Corp | コンテンツ伝送方法及び表示装置 |

| WO2011046338A2 (en) * | 2009-10-13 | 2011-04-21 | Lg Electronics Inc. | Broadcast receiver and 3d video data processing method thereof |

| JP5594002B2 (ja) * | 2010-04-06 | 2014-09-24 | ソニー株式会社 | 画像データ送信装置、画像データ送信方法および画像データ受信装置 |

-

2011

- 2011-04-28 JP JP2011102370A patent/JP2012235308A/ja not_active Abandoned

-

2012

- 2012-04-13 US US13/805,999 patent/US20130088572A1/en not_active Abandoned

- 2012-04-18 CN CN2012800021064A patent/CN103026725A/zh active Pending

- 2012-04-18 KR KR1020127032608A patent/KR20140003319A/ko not_active Application Discontinuation

- 2012-04-18 EP EP12776603.8A patent/EP2574053A4/en not_active Withdrawn

- 2012-04-18 WO PCT/JP2012/060516 patent/WO2012147596A1/ja active Application Filing

- 2012-04-18 BR BR112012033102A patent/BR112012033102A2/pt not_active IP Right Cessation

Also Published As

| Publication number | Publication date |

|---|---|

| WO2012147596A1 (ja) | 2012-11-01 |

| EP2574053A1 (en) | 2013-03-27 |

| EP2574053A4 (en) | 2014-07-02 |

| CN103026725A (zh) | 2013-04-03 |

| JP2012235308A (ja) | 2012-11-29 |

| BR112012033102A2 (pt) | 2016-11-22 |

| US20130088572A1 (en) | 2013-04-11 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5594002B2 (ja) | 画像データ送信装置、画像データ送信方法および画像データ受信装置 | |

| JP5577823B2 (ja) | 送信装置、送信方法、受信装置および受信方法 | |

| KR102009048B1 (ko) | 화상 데이터 송신 장치, 화상 데이터 송신 방법 및 화상 데이터 수신 장치 | |

| CA2758104C (en) | Broadcast transmitter, broadcast receiver and 3d video data processing method thereof | |

| US20160286262A1 (en) | Broadcast receiver and 3d video data processing method thereof | |

| WO2013161442A1 (ja) | 画像データ送信装置、画像データ送信方法、画像データ受信装置および画像データ受信方法 | |