KR101111521B1 - 오디오 처리 방법 및 장치 - Google Patents

오디오 처리 방법 및 장치 Download PDFInfo

- Publication number

- KR101111521B1 KR101111521B1 KR1020097014214A KR20097014214A KR101111521B1 KR 101111521 B1 KR101111521 B1 KR 101111521B1 KR 1020097014214 A KR1020097014214 A KR 1020097014214A KR 20097014214 A KR20097014214 A KR 20097014214A KR 101111521 B1 KR101111521 B1 KR 101111521B1

- Authority

- KR

- South Korea

- Prior art keywords

- signal

- downmix

- information

- downmix signal

- channel

- Prior art date

Links

- 238000012545 processing Methods 0.000 title claims abstract description 139

- 238000000034 method Methods 0.000 title claims description 51

- 230000005236 sound signal Effects 0.000 title description 56

- 239000011159 matrix material Substances 0.000 claims description 26

- 238000003672 processing method Methods 0.000 abstract description 9

- 230000000694 effects Effects 0.000 description 42

- 238000010586 diagram Methods 0.000 description 37

- 238000004091 panning Methods 0.000 description 32

- 238000009877 rendering Methods 0.000 description 30

- 238000011965 cell line development Methods 0.000 description 17

- 230000015572 biosynthetic process Effects 0.000 description 16

- 230000001276 controlling effect Effects 0.000 description 16

- 238000003786 synthesis reaction Methods 0.000 description 16

- 230000000875 corresponding effect Effects 0.000 description 12

- 230000008569 process Effects 0.000 description 10

- 230000005540 biological transmission Effects 0.000 description 7

- 238000005034 decoration Methods 0.000 description 5

- 238000013507 mapping Methods 0.000 description 4

- 238000004458 analytical method Methods 0.000 description 2

- 238000005516 engineering process Methods 0.000 description 2

- 238000012986 modification Methods 0.000 description 2

- 230000004048 modification Effects 0.000 description 2

- 230000033764 rhythmic process Effects 0.000 description 2

- 208000012927 adermatoglyphia Diseases 0.000 description 1

- 238000013459 approach Methods 0.000 description 1

- 230000002238 attenuated effect Effects 0.000 description 1

- 238000004364 calculation method Methods 0.000 description 1

- 230000008859 change Effects 0.000 description 1

- 230000002596 correlated effect Effects 0.000 description 1

- 230000001934 delay Effects 0.000 description 1

- 230000001419 dependent effect Effects 0.000 description 1

- 238000009792 diffusion process Methods 0.000 description 1

- 238000001914 filtration Methods 0.000 description 1

- 238000009499 grossing Methods 0.000 description 1

- 238000013139 quantization Methods 0.000 description 1

- 230000002194 synthesizing effect Effects 0.000 description 1

- 230000036962 time dependent Effects 0.000 description 1

- 238000012546 transfer Methods 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/008—Multichannel audio signal coding or decoding using interchannel correlation to reduce redundancy, e.g. joint-stereo, intensity-coding or matrixing

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L19/00—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis

- G10L19/04—Speech or audio signals analysis-synthesis techniques for redundancy reduction, e.g. in vocoders; Coding or decoding of speech or audio signals, using source filter models or psychoacoustic analysis using predictive techniques

- G10L19/16—Vocoder architecture

- G10L19/18—Vocoders using multiple modes

- G10L19/20—Vocoders using multiple modes using sound class specific coding, hybrid encoders or object based coding

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04S—STEREOPHONIC SYSTEMS

- H04S3/00—Systems employing more than two channels, e.g. quadraphonic

- H04S3/008—Systems employing more than two channels, e.g. quadraphonic in which the audio signals are in digital form, i.e. employing more than two discrete digital channels

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04S—STEREOPHONIC SYSTEMS

- H04S7/00—Indicating arrangements; Control arrangements, e.g. balance control

- H04S7/30—Control circuits for electronic adaptation of the sound field

- H04S7/302—Electronic adaptation of stereophonic sound system to listener position or orientation

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04S—STEREOPHONIC SYSTEMS

- H04S2420/00—Techniques used stereophonic systems covered by H04S but not provided for in its groups

- H04S2420/01—Enhancing the perception of the sound image or of the spatial distribution using head related transfer functions [HRTF's] or equivalents thereof, e.g. interaural time difference [ITD] or interaural level difference [ILD]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04S—STEREOPHONIC SYSTEMS

- H04S2420/00—Techniques used stereophonic systems covered by H04S but not provided for in its groups

- H04S2420/03—Application of parametric coding in stereophonic audio systems

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- Acoustics & Sound (AREA)

- Signal Processing (AREA)

- Multimedia (AREA)

- Computational Linguistics (AREA)

- Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Human Computer Interaction (AREA)

- Mathematical Physics (AREA)

- Stereophonic System (AREA)

- Compression, Expansion, Code Conversion, And Decoders (AREA)

- Stereo-Broadcasting Methods (AREA)

Abstract

다운믹스 신호 및 다운믹스 프로세싱 정보를 수신하는 단계; 상기 다운믹스 프로세싱 정보를 이용하여 상기 다운믹스 신호를 프로세싱 하는 단계; 상기 프로세싱하는 단계는, 상기 다운믹스 신호를 디코릴레이팅하는 단계; 및, 상기 프로세싱된 다운믹스 신호를 출력하기 위해서 상기 다운믹스 신호 및 상기 디코릴레이팅된 신호를 믹싱하는 단계를 포함하고, 상기 다운믹스 프로세싱 정보는 오브젝트 정보 및 믹스 정보를 근거로 추정된 것인 오디오 신호 처리 방법이 개시된다.

오디오, 오브젝트

Description

본 발명은 오디오 신호 처리 방법 및 장치에 관한 것으로서, 보다 구체적으로, 디지털 매체 또는 방송 신호를 통해 수신한 오디오 신호의 디코딩 방법 및 장치에 관한 것이다.

여러 개의 오디오 오브젝트를 하나 또는 두개의 신호로 다운믹스하는 과정에서, 개별 오브젝트 신호들로부터 파라미터가 추출될 수 있다. 이 파라미터들은 오디오 신호 디코더에서 사용될 수 있는데, 개별 소스들의 리포지션닝(repositioning) 및 패닝(panning)은 사용자에 선택에 의해 제어될 수 있다.

개별 오브젝트 신호를 제어하는 데 있어서, 다운믹스 신호에 포함된 개별 소스의 리포지셔닝 및 패닝은 자유롭게 수행되어야 한다.

그런데, 채널 기반 디코딩 방법(예: MPEG surround)에 관한 하향 호환성(backward compatibility)을 위해, 오브젝트 파라미터는 업믹싱 프로세스에 요구되는 멀티채널 파라미터로 자유롭게 변환되어야 한다.

따라서 본 발명은 상기와 같이 관련 기술의 제한 및 불리함 때문에 발생하는 문제점을 실질적으로 회피하는 오디오 신호 처리 방법 및 장치를 지향한다.

본 발명은 오브젝트 게인 및 패닝을 자유로이 제어하기 위한 오디오 신호 처리 방법 및 장치를 제공할 수 있다.

본 발명은 유저 선택을 기반으로 오브젝트 게인 및 패닝을 제어하기 위한 오디오 신호 처리 방법 및 장치를 제공할 수 있다.

상기와 같은 목적을 달성하기 위하여 본 발명에 따른 오디오 신호 처리 방법은 다운믹스 신호 및 다운믹스 프로세싱 정보를 수신하는 단계; 상기 다운믹스 프로세싱 정보를 이용하여 상기 다운믹스 신호를 프로세싱하는 단계; 상기 프로세싱하는 단계는, 상기 다운믹스 신호를 디코릴레이팅하는 단계; 및, 상기 프로세싱된 다운믹스 신호를 출력하기 위해서 상기 다운믹스 신호 및 상기 디코릴레이팅된 신호를 믹싱하는 단계를 포함하고, 상기 다운믹스 프로세싱 정보는 오브젝트 정보 및 믹스 정보를 근거로 추정된 것이다.

본 발명에 따르면, 상기 다운믹스 신호의 채널 수가 둘 이상에 해당하는 경우, 상기 다운믹스 신호를 프로세싱하는 단계가 수행된다.

본 발명에 따르면, 상기 프로세싱된 다운믹스 신호의 하나의 채널 신호는, 상기 다운믹스 신호의 다른 채널 신호를 포함한다.

본 발명에 따르면, 상기 프로세싱된 다운믹스 신호 중 하나의 채널 신호는, 게인 팩터로 곱해진 상기 다운믹스 신호의 다른 채널을 포함하고, 상기 게인 팩터는 상기 믹스 정보로부터 추정된 것이다.

본 발명에 따르면, 상기 다운믹스 신호가 스테레오 신호에 해당되는 경우, 상기 다운믹스 신호를 프로세싱하는 단계는, 상기 다운믹스 신호를 위한 2x2 매트릭스 오퍼레이션에 의해 수행된다.

본 발명에 따르면, 상기 2x2 매트릭스 오퍼레이션은 상기 다운믹스 프로세싱 정보에 포함된 0이 아닌 크로스 텀(non-zero cross term)을 포함한다.

본 발명에 따르면, 상기 다운믹스 신호를 디코릴레이팅하는 단계는, 2개 이상의 디코릴레이터에 의해 수행된다.

본 발명에 따르면, 상기 다운믹스 신호의 디코릴레이팅은, 2개의 디코릴레이터를 이용하여 상기 다운믹스 신호의 제1 채널 및 상기 다운믹스 신호의 제2 채널을 디코릴레이팅하는 단계를 포함한다.

본 발명에 따르면, 상기 다운믹스 신호는 스테레오 신호에 해당하고, 상기 디코렐리이팅된 신호는, 동일한 디코릴레이터를 이용하여 디코릴레이팅된 상기 제1 채널 및 상기 2채널을 포함한다.

본 발명에 따르면, 상기 다운믹스 신호를 디코릴레이팅하는 단계는, 하나의 디코릴레이터를 이용하여 상기 다운믹스 신호의 제1 채널을 디코릴레이팅하는 단계; 및, 다른 디코릴레이터를 이용하여 상기 다운믹스 신호의 제2 채널을 디코릴레이팅하는 단계를 포함한다.

본 발명에 따르면, 상기 다운믹스 신호는 스테레오 신호에 해당하고, 상기 디코릴레이팅된 신호는, 디코릴레이팅된 제1 채널 및 디코릴레이팅된 제2 채널을 포함한다.

본 발명에 따르면, 상기 다운믹스 신호가 스테레오 신호에 해당하는 경우, 상기 프로세싱된 다운믹스 신호는 스테레오 신호에 해당한다.

본 발명에 따르면, 상기 오브젝트 정보는, 오브젝트 레벨 정보 및 오브젝트 상관 정보 중 하나 이상을 포함한다.

본 발명에 따르면, 상기 믹스 정보는 오브젝트 위치 정보 및 재생 환경 정보 중 하나 이상을 이용하여 생성된다.

본 발명에 따르면, 상기 다운믹스 신호는 방송 신호를 통해 수신된다.

본 발명에 따르면, 상기 다운믹스 신호는 디지털 매체를 통해 수신된다.

본 발명의 또 다른 측면에 따르면, 다운믹스 신호 및 다운믹스 프로세싱 정보를 수신하는 단계; 상기 다운믹스 프로세싱 정보를 이용하여 상기 다운믹스 신호를 프로세싱하는 단계; 상기 프로세싱하는 단계는, 상기 다운믹스 신호를 디코릴레이팅하는 단계; 및, 상기 프로세싱된 다운믹스 신호를 출력하기 위해서 상기 다운믹스 신호 및 상기 디코릴레이팅된 신호를 믹싱하는 단계를 포함하고, 상기 다운믹스 프로세싱 정보는 오브젝트 정보 및 믹스 정보를 근거로 추정된 것이고, 프로세서가 실행될 때, 상기 프로세서에 의해 상기 동작이 수행되는 명령이 저장되어 있는, 컴퓨터로 읽을 수 있는 매체가 제공된다.

본 발명의 또 다른 측면에 따르면, 다운믹스 신호 및 다운믹스 프로세싱 정보를 수신하고, 상기 다운믹스 프로세싱 정보를 이용하여 상기 다운믹스 신호를 프로세싱하는 다운믹스 처리 유닛을 포함하고, 상기 다운믹스 처리 유닛은, 상기 다운믹스 신호를 디코릴레이팅하는 디코릴레이팅 파트; 및, 상기 프로세싱된 다운믹스 신호를 출력하기 위해서 상기 다운믹스 신호 및 상기 디코릴레이팅된 신호를 믹싱하는 믹싱 파트를 포함하고, 상기 다운믹스 프로세싱 정보는 오브젝트 정보 및 믹스 정보를 근거로 추정된 것인 오디오 신호 처리 장치가 제공된다.

본 발명의 또 다른 측면에 따르면, 복수의 오브젝트 신호를 이용하여 다운믹스 신호를 획득하는 단계; 상기 복수의 오브젝트 신호 및 상기 다운믹스 신호를 이용하여, 상기 복수의 오브젝트 신호간의 관계를 나타내는 오브젝트 정보를 생성하는 단계; 상기 시간 도메인의 다운믹스 신호 및 상기 오브젝트 정보를 전송하는 단계를 포함하고, 상기 다운믹스 신호의 채널 수가 2 이상에 해당되는 경우, 상기 다운믹스 신호는 프로세싱된 다운믹스 신호가 되는 것이 가능하고, 상기 오브젝트 정보는 오브젝트 레벨 정보 및 오브젝트 상관 정보 중 하나 이상을 포함하는 오디오 신호 처리 방법이 제공된다.

도 1은 재생 환경 및 유저 컨트롤을 기반으로 다운믹스 신호를 렌더링하는 기본 개념을 설명하기 위한 도면.

도 2는 제1 방식의 본 발명의 일 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 3은 제1 방식의 본 발명의 다른 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 4는 제2 방식의 본 발명의 일 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 5는 제2 방식의 본 발명의 다른 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 6은 제2 방식의 본 발명의 또 다른 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 7은 제3 방식의 본 발명의 일 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 8은 제3 방식의 본 발명의 다른 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 9는 렌더링 유닛의 기본 개념을 설명하기 위한 도면.

도 10A 내지 도 10C는 도 7에 도시된 다운믹스 처리 유닛의 제1 실시예의 예시적인 구성도.

도 11은 도 7에 도시된 다운믹스 처리 유닛의 제2 실시예의 예시적인 구성도.

도 12는 도 7에 도시된 다운믹스 처리 유닛의 제3 실시예의 예시적인 구성도.

도 13은 도 7에 도시된 다운믹스 처리 유닛의 제4 실시예의 예시적인 구성도.

도 14는 본 발명의 제2 실시예에 따른 압축된 오디오 신호의 비트스트림 구조의 예시적인 구성도.

도 15는 본 발명의 제2 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 16은 본 발명의 제3 실시예에 따른 압축된 오디오 신호의 비트스트림 구조의 예시적인 구성도.

도 17은 본 발명의 제4 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

도 18은 다양한 타입의 오브젝트의 전송 방식을 설명하기 위한 예시적인 구성도.

도 19는 본 발명의 제5 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도.

본원의 '파라미터'는 값(values), 협의의 파라미터(parameters), 계수(coefficients), 성분(elements)등을 포함하는 정보를 의미한다. 이하 파라미터(parameter)라는 용어는 오브젝트 파라미터, 믹스 파라미터, 다운믹스 프로세싱 파라미터 등과 같이, 정보(information)를 대신하여 사용될 수 있으나, 본 발명은 이에 한정되지 아니한다.

몇 개의 채널 신호 또는 몇 개의 오브젝트 신호를 다운믹스하는 데 있어서, 오브젝트 파라미터 및 공간 파라미터가 추출될 수 있다. 디코더는 다운믹스 신호 및 오브젝트 파라미터(또는 공간 파라미터)를 이용하여 출력 신호를 생성할 수 있다. 출력 신호는 재생 환경(playback configuration) 및 유저 컨트롤을 기반으로 렌더링될 수 있다. 렌더링 프로세스는 도 1을 참조하면서 다음과 같이 상세히 설명될 것이다.

도 1은 재생 환경 및 유저 컨트롤을 기반으로 다운믹스를 렌더링하는 기본 개념을 설명하기 위한 도면이다. 도 1을 참조하면, 디코더(100)는 렌더링 정보 생성 유닛(110) 및 렌더링 유닛(120)을 포함하고, 또는 렌더링 정보 생성 유닛(110) 및 렌더링 유닛(120)을 포함하는 대신에, 렌더러(110a) 및 합성(120a)을 포함할 수 있다.

렌더링 정보 생성 유닛(110)은 인코더로부터 오브젝트 파라미터 또는 공간 파라미터를 포함하는 부가 정보(side information)를 수신하고, 또한 장치 설정 또는 유저 인터페이스로부터 재생 환경 또는 유저 컨트롤을 수신한다. 오브젝트 파라미터(object parameter)는 하나 이상의 오브젝트 신호를 다운믹스하는 과정에서 추출되는 파라미터에 대응할 수 있고, 공간 파라미터(spatial parameter)는 하나 이상의 채널 신호를 다운믹스하는 과정에서 추출되는 파라미터에 대응될 수 있다. 나아가, 각 오브젝트의 타입 정보 및 특성 정보가 상기 부가 정보에 포함될 수 있다. 타입 정보 및 특성 정보는 악기 이름, 연주자 이름 등을 기술할 수 있다. 재생 환경은 스피커 위치 및 앰비언트 정보(ambient information)(스피커의 가상 위치)를 포함할 수 있고, 상기 유저 컨트롤은 오브젝트 위치 및 오브젝트 게인을 제어하기 위해 사용자에 의해 입력되는 정보에 해당할 수 있는데, 재생환경을 위한 제어정보에 해당할 수도 있다. 한편, 재생 환경 및 유저 컨트롤은 믹스 정보로서 표현될 수도 있는데, 본 발명은 이에 한정되지 아니한다.

렌더링 정보 생성 유닛(110)은 믹스 정보(재생 환경 및 유저 컨트롤) 및 수신된 부가 정보를 이용하여 렌더링 정보를 생성할 수 있다. 렌더링 유닛(120)은 오디오 신호의 다운믹스(약칭, 다운믹스 신호)가 전송되지 않는 경우, 렌더링 정보를 이용하여 멀티채널 파라미터를 생성할 수 있고, 오디오 신호의 다운믹스가 전송되는 경우, 렌더링 정보 및 다운믹스를 이용하여 멀티채널 신호를 생성할 수 있다.

렌더러(110a)는 믹스 정보( 재생 환경 및 유저 컨트롤) 및 수신된 부가 정보를 이용하여 멀티채널 신호를 생성할 수 있다. 합성(120a)은 렌더러(110a)에 의해 생성된 멀티채널 신호를 이용하여 멀티채널 신호를 합성할 수 있다.

앞서 설명한 바와 같이, 디코더는 재생 환경 및 유저 컨트롤을 기반으로 다운믹스 신호를 렌더링한다. 한편, 개별적인 오브젝트 신호를 제어하기 위해서, 디코더는 부가정보로서 오브젝트 파라미터를 수신할 수 있고, 전송된 오브젝트 파라미터를 기초로 오브젝트 패닝 및 오브젝트 게인을 제어할 수 있다.

1.

오브젝트

신호의 게인 및

패닝

제어

개별 오브젝트 신호를 제어하기 위한 다양한 방법들이 제공될 수 있다. 우선, 디코더가 오브젝트 파라미터를 수신하고 오브젝트 파라미터를 이용하여 개별 오브젝트 신호를 생성하는 경우, 디코더는 믹스 정보(재생환경, 오브젝트 레벨 등)를 기반으로 개별 오브젝트 신호를 제어할 수 있다.

둘째, 디코더가 멀티채널 디코더에 입력되는 멀티채널 파라미터를 생성하는 경우, 멀티채널 디코더는 멀티채널 파라미터를 이용하여, 인코더로부터 수신되는 다운믹스 신호를 업믹싱할 수 있다. 상기 언급된 두 번째 방법은 다음 세 가지 방식으로 분류될 수 있다. 구체적으로, 1) 종래의 멀티채널 디코더를 이용하는 방식, 2) 멀티채널 디코더를 수정하는 방식, 3) 멀티채널 디코더에 입력되기 전에 오디오 신호의 다운믹스를 프로세싱하는 방식이 제공될 수 있다. 종래의 멀티채널 디코더는 채널 기반의 공간 오디오 코딩(예: MPEG Surround 디코더)에 해당할 수 있지만, 본 발명은 이에 한정되지 아니한다. 세 가지 방식은 다음과 같이 구체적으로 설명될 것이다.

1.1 멀티채널 디코더를 이용하는 방식

첫 번째 방식은 종래의 멀티채널 디코더를 수정하지 않고 있는 그대로 이용할 수 있다. 우선, 오브젝트 게인을 제어하기 위해 ADG(임의적 다운믹스 게인: arbitrary downmix gain)를 이용하는 경우, 오브젝트 패닝을 제어하기 위해 5-2-5 구성(configuration)을 이용하는 경우가 도 2를 참조하면서 설명될 것이다. 이어서, 씬 리믹싱 유닛(scene remixing unit)과 연계되는 경우는 도 3을 참조하면서 설명될 것이다.

도 2는 제1 방식의 본 발명의 제1 실시예에 따른 오디오 신호 처리 장치의 구성도이다. 도 2를 참조하면, 오디오 신호 처리 장치(200)(이하, 디코더(200))는 정보 생성 유닛(210) 및 멀티채널 디코더(230)를 포함할 수 있다. 정보 생성 유닛(210)은 인코더로부터 오브젝트 파라미터를 포함하는 부가정보를, 유저 인터페이스로부터 믹스 정보를 수신할 수 있고, 임의적 다운믹스 게인 또는 게인 변형 게인(이후 간단히, ADG)을 포함하는 멀티채널 파라미터를 생성할 수 있다. ADG는 믹스 정보 및 오브젝트 정보를 기초로 추정된 제1 게인, 및 오브젝트 정보를 기초로 추정된 제2 게인과의 비율(ratio)이다. 구체적으로, 다운믹스 신호가 모노 신호인 경우, 정보 생성 유닛(210)은 ADG만을 생성할 수 있다. 멀티채널 디코더(230)는 인코더로부터 오디오 신호의 다운믹스를, 정보 생성 유닛(210)으로부터 멀티채널 파라미터를 수신하고, 다운믹스 신호 및 멀티채널 신호를 이용하여 멀티채널 출력을 생성한다.

멀티채널 파라미터는 채널 레벨 차이(channel level difference)(이하, 약칭 CLD), 채널 간 상관관계(inter channel correlation)(이하, 약칭 ICC), 채널 예측 계수(channel prediction coefficient)(이하, 약칭 CPC)를 포함할 수 있다.

CLD, ICC, 및 CPC는 세기 차이(intensity difference) 또는 두 채널간 상관 관계(correlation between two channels)을 기술하고, 오브젝트 패닝 및 상관 관계를 제어할 수 있다. CLD, ICC 등을 이용하여 오브젝트 위치나 오브젝트 울려퍼짐정도(diffuseness)(sonority)를 제어하는 것이 가능하다. 한편, CLD는 절대 레벨이 아닌 상대적인 레벨 차이를 기술하고, 분리된 두 채널의 에너지는 유지된다. 따라서 CLD 등을 조절함으로써 오브젝트 게인을 제어하는 것은 불가능하다. 다시 말해서 CLD 등을 이용함으로써 특정 오브젝트를 무음(mute)화 하거나 볼륨을 높일 수 없다.

나아가, ADG는 유저에 의한 상관성 팩터를 조정하기 위한 시간 및 주파수 종속 게인을 나타낸다. 상관성 팩터가 적용되면, 멀티채널을 업믹싱하기 전에 다운믹스 신호의 변형(modification)을 조작할 수 있다. 따라서 ADG 파라미터가 정보 생성 유닛(210)으로부터 수신되는 경우, 멀티채널 디코더(230)는 ADG 파라미터를 이용하여 특정 시간 및 주파수의 오브젝트 게인을 제어할 수 있다.

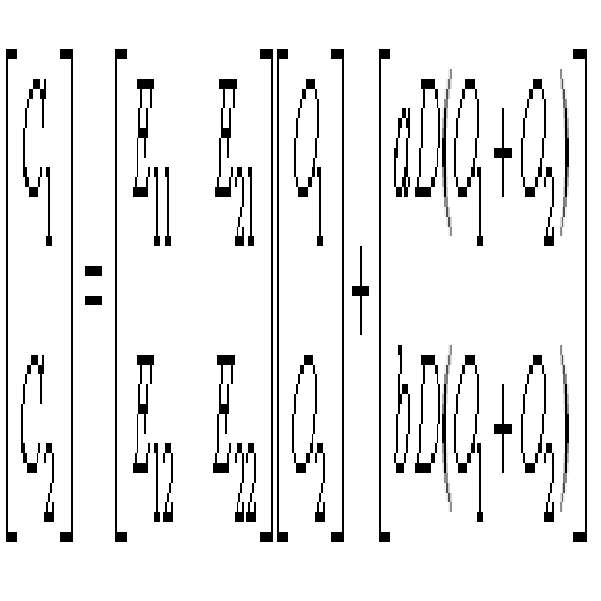

한편, 수신된 스테레오 다운믹스 신호가 스테레오 채널로서 출력되는 경우는 다음 수학식 1로 정의될 수 있다.

[수학식 1]

오브젝트 패닝을 위해서, 좌측 채널 및 우측 채널간의 크로스 토크(cross-talk)를 제어하는 것이 필요하다. 구체적으로 다운믹스 신호의 좌측 채널의 일부가 출력 채널의 우측 채널로서 출력될 수 있고, 다운믹스 신호의 우측 채널의 일부가 출력 채널의 좌측 채널로서 출력될 수 있다. 상기 수학식 1에서 및 는 크로스 토크 성분(다른 말로, 크로스 텀)에 해당할 수 있다.

상기 언급된 경우는 2-2-2 구성에 해당할 수 있는 데, 2-2-2 구성이란, 2 채널 입력, 2채널 전송, 2채널 출력을 의미한다. 2-2-2 구성이 수행되기 위해서는, 종래의 채널 기반의 공간 오디오 코딩(예: MPEG surround)의 5-2-5 구성(5채널 입력, 2채널 전송, 5채널 출력)이 사용될 수 있다. 우선, 2-2-2 구성을 위한 2채널을 출력하기 위해서, 5-2-5 구성의 5 출력 채널 중에서 특정 채널인 불능 채널(페이크 채널)로 설정할 수 있다. 2 전송 채널 및 2 출력 채널간의 크로스 토크를 부여하기 해서, 상기 언급된 CLD 및 CPC가 조절될 수 있다. 요컨대, 수학식 1에서의 게인 팩터가 상기 ADG를 이용하여 획득되고, 상기 수학식 1에서의 가중치는 CLD 및 CPC를 이용하여 획득될 수 있다.

5-2-5 구성을 이용하여 2-2-2 구성을 구현하는데 있어서, 복잡도를 낮추기 위해서, 종래의 공간 오디오 코딩의 디폴드(default) 모드가 적용될 수 있다. 디폴트 CLD의 특성은 2 채널을 출력하도록 되어있고, 디폴트 CLD가 적용되는 경우 연산량을 낮출 수 있다. 구체적으로, 페이크 채널을 합성할 필요가 없기 때문에, 연산량을 크게 감소시키는 것이 가능하다. 따라서 디폴트 모드를 적용하는 것이 적절하다. 구체적으로, 3개의 CLD들(MPEG Surround에서 0,1,2번에 대응)의 디폴트 CLD만이 디코딩에 사용된다. 한편으로, 좌측 채널, 우측 채널 및 센터 채널 중의 4개의 CLD들(MPEG surround 표준에서 3,4,5 및 6번에 대응), 및 2개의 ADG(MPEG surround 표준에서 7,8번에 대응)는 오브젝트 제어를 위해 생성된다. 이 경우, 3번 및 5번에 대응하는 CLD들은 좌측 채널+우측 채널, 및 센터 채널간의 채널 레벨 차이((l+r)/c)를 나타내는데, 센터 채널을 무음화시키기 위해서 150dB(거의 무한대)로 셋팅되는 것이 바람직하다. 또한, 크로스 토크를 구현하기 위해서, 에너지 베이스 업믹스(energy based up-mix) 또는 프리딕션 기반 업믹스(prediction based up-mix)가 수행될 수 있는데, 이는 TTT 모드(MPEG surround 표준에서의 'bsTttModeLow')는 에너지 기반 모드(차감(with subtraction), 매트릭스 호환성 가능)(3번째 모드) 또는 프리딕션 모드(1번째 모드 도는 2번째 모드)에 해당될 수 있는 경우에 호출된다.

도 3은 제1 방식의 본 발명의 다른 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도이다. 도 3을 참고하면, 본 발명의 다른 실시예에 따른 오디오 신호 처리 장치(300)(이하, 약칭 디코더(300))는 정보 생성 유닛(310), 씬 렌더링 유 닛(scene rendering unit)(320), 멀티채널 디코더(330), 및 씬 리믹싱 유닛(scene remixing unit)(350)을 포함할 수 있다.

정보 생성 유닛(310)은 다운믹스 신호가 모노 채널 신호(즉 다운믹스 채널의 수가 1인 경우)에 해당하는 경우, 오브젝트 파라미터를 포함하는 부가 정보를 인코더로부터 수신할 수 있고, 부가정보 및 믹스 정보를 이용하여 멀티채널 파라미터를 생성할 수 있다. 다운믹스 채널의 수는 부가 정보에 포함되어 있는 플래그 정보뿐만 아니라 다운믹스 신호 및 사용자 선택을 기초로 하여 추정될 수 있다. 정보 생성 유닛(310)은 앞서 설명한 정보 생성 유닛(210)과 동일한 구성을 가질 수 있다. 멀티채널 파라미터는 멀티채널 디코더(330)에 입력되고, 멀티채널 디코더(330)는 앞서 설명한 멀티채널 디코더(230)와 동일한 구성을 가질 수 있다.

씬 렌더링 유닛(320)은 다운믹스 신호가 모노 채널 신호가 아닌 경우(즉, 다운믹스 채널의 수가 2 이상인 경우), 인코더로부터 오브젝트 파라미터를 포함하는 부가정보를 수신하고, 유저 인터페이스로부터 믹스 정보를 수신하고, 부가 정보 및 믹스 정보를 이용하여 리믹싱 파라미터를 생성한다. 리믹싱 파라미터는 스테레오 채널을 리믹스하고 2 채널 이상의 출력을 생성하기 위한 파라미터에 해당한다. 씬 리믹싱 유닛(350)은 다운믹스 신호가 2채널 이상 신호인 경우, 다운믹스 신호를 리믹스할 수 있다.

요컨대, 두 가지 경로는 디코더(300) 분리된 응용을 위한 분리된 구현으로서 고려될 수 있다.

1.2 멀티채널 디코더를 수정하는 방식

두 번째 방식은 종래의 멀티채널 디코더를 수정할 수 있다. 우선, 오브젝트 게인을 제어하기 위한 가상 출력을 이용하는 경우, 오브젝트 패닝을 제어하기 위한 장치 설정을 수정하는 경우가 도 4와 함께 설명될 것이다. 이어서, 멀티채널 디코더에서의 TBT(2X2) 기능을 수행하는 경우는 도 5와 함께 설명될 것이다.

도 4는 제2 방식의 본 발명의 일 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도이다. 도 4를 참조하면, 제2 방식의 본 발명의 일 실시예에 따른 오디오 신호 처리 장치(400)(이하, 약칭 디코더(400)는 정보 생성 유닛(410), 내부 멀티채널 합성(420), 출력 맵핑 유닛(430)을 포함할 수 있다. 내부 멀티채널 합성(420) 및 출력 맵핑 유닛(430)은 합성 유닛에 포함될 수 있다.

정보 생성 유닛(410)은 인코더로부터 오브젝트 파라미터를 포함하는 부가 정보를 수신하고, 유저 인터페이스로부터 믹스 파라미터를 수신할 수 있다. 정보 생성 유닛(410)은 부가 정보 및 믹스 정보를 이용하여 멀티채널 파라미터 및 장치 설정 정보를 생성할 수 있다. 멀티채널 파라미터는 앞서 설명된 멀티채널 파라미터와 동일한 구성을 가질 수 있다. 따라서 멀티채널 파라미터의 구체적인 설명은 생략하고자 한다. 장치 설정 정보는 바이노럴(binaural) 프로세싱을 위한 파라미터화된 HRTF에 해당할 수 있는데, 이는 추후 '1.2.2 장치 설정 정보를 이용하는 방법'에서 설정하고자 한다.

내부 멀티채널 합성(420)은 멀티채널 파라미터 및 장치 설정 정보를 파라미터 생성 유닛(410) 으로부터 수신하고, 인코더로부터 다운믹스 신호를 수신한다. 내부 멀티채널 합성(420)은 가장 출력을 포함하는 임시 멀티채널 신호를 생성할 수 있으나, 이는 추후 '1.2.1 가상 출력을 이용하는 방법'에서 설명하고자 한다.

1.2.1 가상 출력을 이용하는 방법

멀티채널 파라미터(예: CLD)는 오브젝트 패닝을 제어할 수 있기 때문에, 종래의 멀티채널 디코더에 의해 오브젝트 패닝뿐만 아니라 오브젝트 게인을 제어하는 것은 어렵다.

한편, 오브젝트 게인을 위해서, 디코더(400)(특히, 내부 멀티채널 합성(420))는 오브젝트의 상대적 에너지를 가상 채널(예: 센터 채널)에 매핑시킬 수 있다. 오브젝트의 상대적 에너지는 감소될 에너지에 해당된다. 예를 들어 특정 오브젝트를 무음화시키기 위해서, 디코더(400)는 오브젝트 에너지의 99.9% 이상을 가상 채널에 매핑시킬 수 있다. 그러면 디코더(400)(특히, 출력 매핑 유닛(430))는 오브젝트의 나머지 에너지가 매핑된 가상 채널을 출력시키지 않는다. 결론적으로, 오브젝트의 99.9%이상이 출력되지 않는 가상 채널에 매핑됨으로써, 원하는 오브젝트가 거의 무음화될 수 있다.

1.2.2 장치 설정 정보를 이용하는 방법

디코더(400)는 오브젝트 패닝 및 오브젝트 게인을 제어하기 위해서 장치 설정 정보를 조절할 수 있다. 예를 들어 디코더는 MPEG surround 표준에서의 바이노럴 프로세싱을 위한 파라미터화된 HRTF를 생성할 수 있다. 파라미터화된 HRTF는 장치 설정에 따라서 다양할 수 있다. 다음 수학식 2에 따라서 오브젝트 신호가 제어되는 것으로 가정할 수 있다.

[수학식 2]

오브젝트 신호 의 오브젝트 정보는 전송된 부가정보에 포함된 오브젝트 파라미터로부터 추정될 수 있다. 오브젝트 게인 및 오브젝트 패닝에 따라서 정의되는 계수 및는 믹스 정보로부터 추정될 수 있다. 원하는 오브젝트 게인 및 오브젝트 패닝은 계수 ,를 이용하여 조절될 수 있다.

MPEG surround 표준(5-1-51 구성)(from ISO/IEC FDIS 23003-1:2006(E), Information Technology MPEG Audio Technologies Part1: MPEG Surround)에서, 바이노럴 프로세싱은 다음과 같다.

[수학식 3]

여기서 yB는 출력, 매트릭스 H는 바이노럴 프로세싱을 위한 변환 매트릭스.

[수학식 4]

매트릭스 H의 성분은 다음과 같이 정의된다.

[수학식 5]

[수학식 6]

[수학식 7]

1.2.3 멀티채널 디코더에서의 TBT(2X2) 기능을 수행하는 방법

도 5는 제2 방식에 따른 본 발명의 다른 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도이다. 도 5는 멀티채널 디코더의 TBT 기능의 예시적인 구성도이다. 도 5를 참조하면, 티비티(TBT) 모듈(510)은 입력 신호 및 티비티(TBT) 제어 정보를 수신하고, 출력 채널을 생성한다. 티비티 모듈(510)은 도 2(또는 구체적으로 멀티채널 디코더(230))의 디코더(200)에 포함될 수 있다. 멀티채널 디코더(230)는 MPEG surround 표준에 따라 구현될 수 있지만, 본 발명은 이에 한정되지 아니한다.

[수학식 9]

여기서 x는 입력 채널, y는 출력 채널, w는 가중치

출력 y1은 제1 게인 w11이 곱해진 다운믹스의 입력 x1과 제2 게인 w12가 곱해진 입력 x2의 조합에 해당할 수 있다.

티비티 모듈(510)로 입력되는 티비티 제어 정보는 가중치 w(w11, w12, w21, w22)를 합성할 수 있는 구성요소를 포함한다.

MPEG surround 표준에서, 오티티(OTT (One-To-Two)) 모듈 및 티티티(TTT)(Two-To-Three) 모듈은 입력 신호를 업믹스할 수 있지만, 입력 신호를 리믹 스하는데는 적합하지 않다.

입력 신호를 리믹스하기 위해서, 티비티(2x2) 모듈(510)(이하, 약칭하여 티비티 모듈(510))이 제공될 수 있다. 티비티 모듈(510)은 스테레오 신호를 수신하고, 리믹스된 스테레오 신호를 출력한다. 가중치 w는 CLD 및 ICC를 이용하여 합성될 수 있다.

티비티 제어 정보로서 가중치 텀 w11~w22가 수신되면, 디코더는 수신된 가중치 텀을 이용하여 오브젝트 패닝뿐 아니라 오브젝트 게인을 제어할 수 있다. 가중치 w가 전송되면, 다양한 방식이 제공된다. 우선, 티비티 제어 정보는 w12 및 w21과 같은 크로스 텀을 포함할 수 있다. 둘째, 티비티 제어 정보는 w12 및 w21과 같은 크로스 텀을 포함하지 않는다. 셋째, 티비티 제어 정보로서 텀의 수가 적응적으로 변화할 수 있다.

우선, 입력 채널의 좌측 신호가 출력 신호의 우측 신호로 가는 오브젝트 패닝을 제어하기 위해서, w12 및 w21과 같은 크로스 텀을 수신할 필요가 있다. N 입력 채널 및 M 출력 채널의 경우, NxM 개의 텀이 티비티 제어정보로서 전송될 수 있다. 이 텀은 MPEG surround 표준에서 제공된 CLD 파라미터 양자화 테이블을 기반으로 양자화될 수 있지만, 본 발명은 이에 한정되지 아니한다.

둘째, 좌측 오브젝트가 오른쪽 위치로 이동하지 않으면(좌측 오브젝트가 좀더 좌측 위치 또는 센터 위치에 가까운 좌측 위치로 이동하거나, 오브젝트의 위치의 레벨만이 조정되는 경우), 크로스 텀이 사용될 필요가 없다. 이 경우, 크로스 텀을 제외한 텀이 전송되는 것이 바람직하다. N 입력 채널 및 M 출력 채널의 경우, N개의 텀만이 전송될 수 있다.

셋째, 티비티 제어 정보의 비트 레이트를 낮추기 위해서, 티비티 제어 정보의 개수가 크로스 텀의 필요에 따라서 적응적으로 변화할 수 있다. 크로스 텀이 현재 존재하는지 여부를 지시하는 플래그 정보 'cross_flag'가 티비티 제어정보로서 전송되도록 설정될 수 있다. 플래그 정보 'cross_flag'의 의미는 다음 테이블에 나타난 바와 같다.

[테이블 1] 'cross_flag'의 의미

| cross_flag | 의미 |

| 0 | 크로스 텀 없음 (넌 크로스 텀만 포함) (w11 및 w22가 존재) |

| 1 | 크로스텀 포함 (w11, w12, w21, 및 w22가 존재) |

'cross_flag'가 0인 경우, 티비티 제어 정보는 크로스 텀을 포함하지 않고, 단지 w11 및 w22와 같은 넌 크로스 텀만 존재한다. 아니면(즉, 'cross_flag'가 1인 경우), 티비티 제어 정보는 크로스 텀을 포함한다.

한편, 크로스 텀 또는 넌 크로스 텀이 존재하는지 여부를 지시하는'reverse_flag'가 티비티 제어 정보로서 전송되도록 설정될 수 있다. 플래그 정보'reverse_flag'의 의미가 다음 테이블 2에 나타나있다.

[테이블 2] 'reverse_flag'

| reverse_flag | 의미 |

| 0 | 크로스 텀 없음(넌 크로스 텀만 포함) (w11 및 w22가 존재) |

| 1 | 크로스텀만 존재 (w12 및 w21가 존재) |

'reverse_flag'가 0인 경우, 티비티 제어 정보는 크로스 텀을 포함하지 않고, w11 및 w22와 같은 넌 크로스 텀만 포함한다. 다른 경우(즉, reverse_flag'가 1인 경우), 티비티 제어 정보는 크로스 텀만 포함한다.

나아가, 크로스 텀을 존재하는지 넌 크로스텀이 존해는지 여부를 지시하는 플래그 정보 'side_flag'이 티비티 제어 정보로서 전송되도록 설정될 수 있다. 플래그 정보 'side_flag'의 의미는 다음 테이블 3에 나타나 있다.

[테이블 3] 'side_flag'의 의미

| side_flag | 의미 |

| 0 | 크로스 텀 없음 (넌 크로스 텀만 포함) (w11 및 w22 존재) |

| 1 | 크로스 텀포함 (w11, w12, w21, and w22이 존재) |

| 2 | 반대 (w12 and w21존재) |

테이블 3은 테이블 1 및 테이블 2의 조합에 해당하기 때문에, 구체적인 설명은 생략하고자 한다.

1.2.4 바이노럴 디코더를 수정함으로써, 멀티채널 디코더에서의 티비티(2x2) 기능을 수행하는 방법

'1.2.2 장치 설정 정보를 이용하는 방법'의 경우, 바이노럴 디코더를 수정하 지 않고, 수행될 수 있다. 이하, 도 6을 참조하면서, MPEG surround 디코더에서 포함된 바이노럴 디코더를 변형(modifying)함으로써 티비티 기능을 수행하는 방법에 대해서 설명하고자 한다.

도 6은 제2 방식의 본 발명의 또 다른 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도이다. 구체적으로, 도 6에 도시된 오디오 신호 처리 장치(630)는 도 2의 멀티채널 디코더(230)에 포함된 바이노럴 디코더, 또는 도 4의 합성 유닛에 해당할 수 있지만, 본 발명은 이에 한정되지 아니한다.

오디오 신호 처리 장치(630)(이하, 바이노럴 디코더(630))는 QMF 분석(632), 파라미터 변환(634), 공간 합성(636), 및 QMF 합성(638)을 포함할 수 있다. 바이노럴 디코더(630)의 구성요소는 MPEG surround 표준에서의 MPEG surround 바이노럴 디코더의 동일한 구성을 가질 수 있다. 예를 들어 공간 합성(636)은 다음 수학식 10에 따라서, 2x2 (필터) 매트릭스를 구성할 수 있다.

[수학식 10]

여기서 y0는 QMF 도메인 입력 채널, yB는 바이노럴 출력 채널, k는 하이브리드 QMF 채널 인덱스, i는 HRTF 필터 탭 인덱스, n는 QMF 슬롯 인덱스

바이노럴 디코더(630)는 '1.2.2 장치 설정 정보를 이용하는 방법'에 절에서 설명된 상기 언급된 기능을 수행할 수 있다. 구성요소 hij는 멀티채널 파라미터 및 HRTF 파라미터 대신에, 멀티채널 파라미터 및 믹스 정보를 이용하여 생성될 수 있다. 이 경우, 바이노럴 디코더(630)는 도 5에서의 티비티 모듈의 기능을 수행할 수 있다. 바이노럴 디코더(630)의 구성요소에 대한 구체적인 설명은 생략하고자 한다.

바이노럴 디코더(630)는 플래그 정보 'binaural_flag'에 따라서 동작될 수 있다. 구체적으로, 바이노럴 디코더(630)는 플래그 정보'binaural_flag'가 0인 경우 스킵될 수 있고, 반대로('binaural_flag'가 1인 경우) 바이노럴 디코더(630)는 아래와 같이 동작할 수 있다.

[테이블 4] binaural_flag의 의미

| binaural_flag | 의미 |

| 0 | 바이노럴 모드 아님(바이노럴 디코더 비활성화) |

| 1 | 바이노럴 모드 (바이노럴 디코더 활성화) |

1.3 멀티채널 디코더에 입력되기 전에 오디오 신호의

다운믹스를

프로세싱하는 방식

종래의 멀티채널 디코더를 이용하는 제1 방식은 앞서' 1.1'절에서 설명되었고, 멀티채널 디코더를 수정하는 제2 방식은 앞서 ' 1.2'절에서 설명되었다. 멀티채널 디코더에 입력되기 전에 오디오 신호의 다운믹스를 프로세싱하는 제3 방식에 대해서 이하 설명하고자 한다.

도 7은 제3 방식의 본 발명의 일 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도이다. 도 8은 제3 방식에 따른 본 발명의 다른 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도이다. 우선 도 7을 참조하면, 오디오 신호 처리 장치(700)(이하 약칭 디코더(700))는 정보 생성 유닛(710), 다운믹스 처리 유닛(720), 멀티채널 디코더(730)를 포함할 수 있다. 도 8을 참조하면, 오디오 신호 처리 장치(800)(이하, 약칭하여 디코더(800))는 정보 생성 유닛(810), 및 멀티채널 디코더(830)를 갖는 멀티채널 합성 유닛(840)을 포함할 수 있다. 디코더(800)는 디코더(700)의 다른 측면이 될 수 있다. 즉, 정보 생성 유닛(810)은 정보 생성 유닛(710)과 동일한 구성을 갖고, 멀티채널 디코더(830)는 멀티채널 디코더(730)와 동일한 구성을 갖고, 멀티채널 합성 유닛(840)은 다운믹스 처리 유닛(720) 및 멀티채널 디코더(730)와 동일한 구성을 가질 수 있다. 따라서, 디코더(700)의 구성요소에 관해서는 상세히 설명될 것이지만, 디코더(800)의 구성요소에 대한 구체적인 설명은 생략하고자 한다.

정보 생성 유닛(710)은 오브젝트 파라미터를 포함하는 부가 정보를 인코더로부터, 믹스 정보를 유저 인터페이스로부터 수신하고, 멀티채널 디코더(730)로 출력될 멀티채널 파라미터를 생성할 수 있다. 이러한 점에서, 정보 생성 유닛(710)은 도 2의 정보 생성 유닛(210)과 동일한 구성을 갖는다. 다운믹스 프로세싱 파라미터는 오브젝트 위치 및 오브젝트 게인을 제어하기 위한 파라미터에 해당할 수 있다. 예를 들어, 오브젝트 신호가 좌측 채널 및 우측 채널에 모두 존재하는 경우, 오브젝트 위치 또는 오브젝트 게인을 변화시키는 것이 가능하다. 오브젝트 신호가 좌측 채널 및 우측 채널 중 하나에 위치하는 경우, 오브젝트 신호를 반대 위치로 위치하도록 렌더링하는 것이 가능하다. 이러한 경우가 수행되기 위해서, 다운믹스 처리 유닛(720)은 티비티(TBT) 모듈(2x2 매트릭스 오퍼레이션)이 될 수 있다. 오브젝트 게인을 제어하기 위해서 정보 생성 유닛(710)은 도 2와 함께 기술된 바와 같이 ADG를 생성하는 경우에는, 다운믹스 프로세싱 파라미터는 오브젝트 게인이 아니라 오브젝트 패닝을 제어하기 위한 파라미터를 포함할 수 있다.

나아가, 정보 생성 유닛(710)은 HRTF 데이터베이스로부터 HRTF 정보를 수신하고, 멀티채널 디코더(730)에 입력되는 HRTF 파라미터를 포함하는 추가 멀티채널 파라미터(extra multi-channel parameter)를 생성할 수 있다. 이 경우, 정보 생성 유닛(710)은 동일한 서브밴드 도메인에서 멀티채널 파라미터 및 추가 멀티채널 파라미터를 생성하고, 서로 싱크를 맞추어 멀티채널 디코더(730)에 전달할 수 있다. HRTF 파라미터를 포함하는 추가 멀티채널 파라미터는 이후 '3. 바이노럴 모드 처리'절에서 상세히 설명될 것이다.

다운믹스 처리 유닛(720)은 인코더로부터 오디오 신호의 다운믹스를, 정보 생성 유닛(710)으로부터 다운믹스 프로세싱 파라미터를 수신하고, 서브밴드 분석 필터뱅크를 이용하여 서브밴드(subband) 도메인 신호로 분석한다. 다운믹스 처리 유닛(720)은 다운믹스 신호 및 다운믹스 프로세싱 파라미터를 이용하여 프로세싱된 다운믹스 신호를 생성할 수 있다. 이러한 프로세싱에서, 오브젝트 패닝 및 오브젝트 게인을 제어하기 위해서 다운믹스 신호를 미리 처리(pre-process)하는 것이 가능하다. 프로세싱된 다운믹스 신호는 업믹스되기 위해 멀티채널 디코더(730)로 입력될 수 있다.

나아가, 프로세싱된 다운믹스 신호는 출력되고 스피커를 통해 또한 재생될 수 있다. 스피커를 통해 프로세싱된 신호를 직접 출력하기 위해서, 다운믹스 처리 유닛(720)은 프로세싱된 서브밴드 도메인 신호를 이용하여 합성 필터뱅크를 수생하고, 시간 도메인의 PCM 신호를 출력할 수 있다. 사용자 선택에 의해 PCM 신호가 직접 출력될지 멀티채널 디코더로 입력될지 여부를 선택하는 것이 가능하다.

멀티채널 디코더(730)는 프로세싱된 다운믹스 및 멀티채널 파라미터를 이용하여 멀티채널 출력신호를 생성할 수 있다. 프로세싱된 다운믹스 신호 및 멀티채널 파라미터가 멀티채널 디코더(730)에 입력될 때, 멀티채널 디코더(730)에서는 딜레이가 도입될 수 있다. 프로세싱된 다운믹스 신호는 주파수 도메인(예: QMF 도메인, 하이브리드 QMF 도메인 등)에서 합성될 수 있고, 멀티채널 파라미터는 시간 도메인에서 합성될 수 있다. MPEG surround 표준에서, HE-AAC과 연결되기 위한 딜레이 및 싱크가 도입된다. 따라서, 멀티채널 디코더(730)는 MPEG surround 표준에 따라서 딜레이를 도입할 수 있다.

다운믹스 처리 유닛(720)의 구성은 도 9 내지 도 13을 참조하면서 상세히 설명될 것이다.

1.3.1 다운믹스 처리 유닛의 일반적 경우 및 특별한 경우

도 9는 렌더링 유닛의 기본 컨셉을 설명하기 위한 도면이다. 도 9를 참조하면 렌더링 모듈(900)은 N 입력 신호, 재생환경, 및 유저 컨트롤을 이용하여 M 출력 신호를 생성할 수 있다. N 입력 신호는 오브젝트 신호 또는 채널 신호에 해당할 수 있다. 나아가, N 입력 신호는 오브젝트 파라미터 또는 멀티채널 파라미터에 해당할 수 있다. 렌더링 모듈(900)의 구성은 도 7의 다운믹스 처리 유닛(720), 도 1의 렌더링 유닛(120), 및 도 1의 렌더러(110a) 중 하나로 구현될 수 있지만, 본 발 명은 이에 한정되지 아니한다.

렌더링 모듈(900)은 특정 채널에 해당하는 개별 오브젝트 신호들을 합하지 않고, N개의 오브젝트 신호들을 이용하여 M개의 채널 신호들을 직접 생성할 수 있는데, 렌더링 모듈(900)의 구성은 다음 수학식 11과 같이 표현될 수 있다.

[수학식 11]

여기서 Ci는 i번째 채널 신호, Oj는 j번째 입력신호, Rij는 j번째 입력신호가 i번째 채널 신호로 매핑되는 매트릭스

여기서 매트릭스 R은 에너지 성분 E와 디코렐레이션 성분으로 분리되는 경우, 다음 수학식 11은 다음과 같이 표현될 수 있다.

[수학식 12]

에너지 성분 E를 이용하여 오브젝트 위치를 제어하는 것이 가능하고, 디코릴레이션 성분 D를 이용하여 오브젝트 퍼짐정도(diffuseness)를 제어하는 것이 가능하다.

i번째 입력 신호만이 j 번째 채널 및 k번째 채널로 출력되기 위해 입력된다고 가정하는 경우, 수학식 12는 다음과 같이 표현될 수 있다.

[수학식 13]

αj_i는 j번째 채널신호로 매핑되는 게인 포션, βjk_i는 k번째 채널로 매핑되는 게인 포션, θ는 퍼짐정도 레벨(diffuseness), 및 D(Oi)는 디코렐레이트된 출력

디코릴레이션이 생략되는 것으로 가정하면, 상기 수학식 13은 다음과 같이 간략화될 수 있다.

[수학식 14]

특정 채널에 매핑되는 모든 입력에 대한 가중치 값이 상기 언급된 방법에 따 라서 추정되면, 다음 방식에 의해 각 채널에 대한 가중치 값이 획득될 수 있다.

1) 특정 채널에 매핑되는 모든 입력에 대한 가중치 값들을 더한다. 예를 들어, 입력 1 (O1) 및 입력 2(O2)가 입력되고 좌측채널(L), 센터채널(C), 우측채널(R)에 대응하는 채널이 출력되는 경우, 총 가중치 값들은 αL(tot), αC(tot) , αR(tot)은 다음과 같이 획득될 수 있다.

[수학식 15]

여기서,αL1은 좌측 채널(L)에 매핑되는 입력 1에 대한 가중치 값이고, αC1은 센터 채널(C)에 매핑되는 입력 1에 대한 가중치 값이고, αC2은 센터 채널(C)에 매핑되는 입력 2에 대한 가중치 값이고, αR2은 우측 채널(R)에 매핑되는 입력 2에 대한 가중치 값.

이 경우, 입력 1만이 좌측 채널로 매핑되고, 입력 2만이 우측 채널로 매핑되고, 입력 1 및 입력 2가 함께 센터 채널로 매핑된다.

2) 특정 채널에 매핑되는 모든 입력에 대한 가중치 값들을 더하고, 그 합을 가장 도미넌트한 채널 쌍(pair)으로 나누고, 디코릴레이팅된 신호를 서라운드 효과 를 위해 다른 채널에 매핑한다. 이 경우, 특정 입력이 좌측 및 센터 사이에 위치하는 경우, 도미넌트 채널 쌍은 좌측 채널 및 센터 채널에 해당할 수 있다.

3) 가장 도미넌트한 채널의 가중치 값을 추정하고, 감쇄된 코릴레이트 신호를 다른 채널을 부여하는데, 여기서 이 값은 추정된 가중치 값의 상대적인 값이다.

4) 각 채널 상의 가중치 값을 이용하여, 디코릴레이팅된 신호를 적절히 조합한 후, 각 채널에 대한 부가정보를 설정한다.

1.3.2. 다운믹스 처리 유닛이 2x4 매트릭스에 대응하는 믹싱 파트를 포함하는 경우

도 10A 내지 도 10C는 도 7에 도시된 다운믹스 처리 유닛의 제1 실시예의 예시적인 구성도들이다. 앞서 언급한 바와 같이, 다운믹스 처리 유닛의 제1 실시예(720a)(이후, 간단히 다운믹스 처리 유닛(720a))는 렌더링 모듈(900)의 구현일 수 있다.

[수학식 15]

상기 수학식 15에 따른 다운믹스 처리 유닛은 도 10A에 도시되어 있다. 도 10A를 참조하면, 다운믹스 처리 유닛(720a)은 모노 입력 신호(m)인 경우에 입력 신호를 바이패스하고, 스테레오 입력 신호(L, R)인 경우에 입력 신호를 프로세싱할 수 있다. 다운믹스 처리 유닛(720a)은 디코릴레이팅 파트(722a) 및 믹싱 파트(724a)를 포함할 수 있다. 디코릴레이팅 파트(722a)는 입력 신호를 디코릴레이팅할 수 있는 디코릴레이터 aD와 디코릴레이터 bD를 포함한다. 디코릴레이팅 파트(722a)는 2x2 매트릭스에 해당할 수 있다. 믹싱 파트(724a)는 입력 신호 및 디코릴레이팅 신호를 각 채널에 매핑시킬 수 있다. 믹싱 파트(724a)는 2x4 매트릭스에 해당할 수 있다.

[수학식 15-2]

수학식 15-2에 따른 다운믹스 처리 유닛은 도 10B에 도시되어 있다. 도 10B를 참조하면, 두 개의 디코릴레이터 D1, D2를 포함하는 디코릴레이팅 파트 722’는 디코릴레이터 신호들 D1(a*O1+b*O2), D2(c*O1+d*O2)를 생성할 수 있다.

[수학식 15-3]

수학식 15-3에 따른 다운믹스 처리 유닛이 도 10C에 도시되어 있다. 도 10C를 참조하면, 두 디코릴레이터 D1, D2를 포함하는 디코릴레이팅 파트(722")는 디코릴레이팅된 신호 D1(O1), D2(O2)를 생성할 수 있다.

1.3.2 다운믹스 처리 유닛이 2x3 매트릭스에 대응하는 믹싱 파트를 포함하는 경우

상기 수학식 15는 다음과 같이 표현될 수 있다.

[수학식 16]

매트릭스 R은 2x3은 매트릭스, 매트릭스 O는 3x1 매트릭스, C는 2x1 매트릭스

도 11은 도 7에 도시된 다운믹스 처리 유닛의 제2 실시예의 예시적인 구성도이다. 앞서 언급한 바와 같이, 다운믹스 처리 유닛의 제2 실시예(720b)(이하, 간단 히 다운믹스 처리 유닛(720b))는 다운믹스 처리 유닛(720a)과 마찬가지로 렌더링 모듈(900)의 구현이 될 수 있다. 도 11을 참조하면, 다운믹스 처리 유닛(720b)은 모노 입력 신호(m)인 경우, 입력신호를 스킵하고 스테레오 입력신호(L, R)의 경우 입력 신호를 프로세싱할 수 있다. 다운믹스 처리 유닛(720b)은 디코릴레이팅 파트(722b) 및 믹싱 파트(724b)를 포함할 수 있다. 디코릴레이팅 파트(722b)는 입력 신호 O1, O2를 디코릴레이팅하고 디코릴레이팅된 신호 D(O1+O2)를 출력할 수 있는 디코릴레이터 D를 갖는다. 디코릴레이팅 파트(722b)는 1x2 매트릭스에 해당할 수 있다. 믹싱 파트(724b)는 입력 신호 및 디코릴레이팅된 신호를 각 채널에 매핑할 수 있다. 믹싱 파트(724b)는 수학식 16에 표현된 매트릭스 R로서 표현된 2x3 매트릭스에 해당할 수 있다.

나아가, 디코릴레이팅 파트(722b)는 두 입력 신호(O1,O2)의 공통 신호로서 차 신호(O1-O2)를 디코릴레이팅할 수 있다. 믹싱 파트(724b)는 입력 신호 및 디코릴레이팅된 공통 신호를 각 채널에 매핑할 수 있다.

1.3.3 다운믹스 처리 유닛이 몇 개의 매트릭스를 갖는 믹싱 파트를 포함하는 경우

특정 오브젝트 신호는 특정 위치에 위치하지 않고 어느 곳에서나 비슷한 영향으로서 들릴 수 있는데, 이를 '공간 음향 신호(spatial sound signal)'라고 불린다. 예를 들어 콘서트 홀의 박수 또는 소음이 공간 음향 신호의 예가 될 수 있다. 공간 음향 신호는 모든 스피커를 통해 재생될 필요가 있다. 만약 공간 음향 신호가 모든 스피커들을 통해서 동일한 신호로서 재생되는 경우, 높은 상호 관련성(inter-correlation)(IC) 때문에 신호의 공간감(spatialness)을 느끼기 어렵다. 따라서, 디코릴레이팅된 신호를 각 채널 신호의 신호에 추가할 필요가 있다.

도 12는 도 7에 도시된 다운믹스 처리 유닛의 제3 실시예의 예시적인 구성도이다. 도 12를 참조하면, 다운믹스 처리 유닛의 제3 실시예(720c)(이하, 간단히 다운믹스 처리 유닛(720c)은 입력 신호 Oi를 이용하여 공간 음향 신호를 생성할 수 있는데, 다운믹스 처리 유닛은 N개의 디코릴레이터를 갖는 디코릴레이팅 파트(722c) 및, 믹싱 파트(724c)를 포함할 수 있다. 디코릴레이팅 파트(722c)는 입력 신호 Oi를 디코릴레이팅할 수 있는 N개의 디코릴레이터 D1, D2, …, DN을 포함할 수 있다. 믹싱 파트(724c)는 입력 신호 Oi 및 디코릴레이팅된 신호 DX(Oi)를 이용하여 출력 신호 Cj, Ck, …, Cl를 생성할 수 있는 N 매트릭스 Rj, Rk, …, Rl를 포함할 수 있다. 매트릭스 Rj은 다음 수학식과 같이 표현될 수 있다.

[수학식 17]

여기서, Oi는 i번째 입력 신호, Rj는 i번째 입력 신호 Oi가 j번째 채널에 매 핑되는 매트릭스, Cj_i는 는 j번째 출력 신호. θj_i 값은 디코릴레이션 비율(rate).

θj_i 값은 멀티채널 파라미터에 포함된 ICC를 기초로 하여 추정될 수 있다. 나아가 믹싱 파트(724c)는 정보 생성 유닛(710)을 통해 유저 인터페이스로부터 수신된 디코릴레이션 비율 θj_i 을 구성하는 공간감 정보(spatialness)를 기반으로 하여 출력 신호를 생성할 수 있으나, 본 발명은 이에 한정되지 아니한다.

디코릴레이터의 수(N)는 출력 채널의 수와 동일할 수 있다. 한편으로는, 디코릴레이팅된 신호는 유저에 의해 선택된 출력 채널에 추가될 수 있다. 예를 들어, 공간 음향 신호를 좌측, 우측, 센터에 위치시키고, 좌측 채널 스피커를 통해 공간 음향 신호로서 출력할 수 있다.

1.3.4 다운믹스 처리 유닛이 추가 다운믹싱 파트(further downmixing part)를 포함하는 경우

도 13은 도 7에 도시된 다운믹스 처리 유닛의 제4 실시예의 예시적인 구성도이다. 다운믹스 처리 유닛의 제4 실시예(720d)(이하, 약칭하여 다운믹스 처리 유닛(720d))는 입력 신호가 모노 신호(m)가 해당하는 경우, 바이패스할 수 있다. 다운믹스 처리 유닛(720d)은 입력 신호가 스테레오 신호에 해당하는 경우 다운믹스 신호를 모노 신호로 다운믹스할 수 있는 추가 다운믹싱 파트(722d)를 포함할 수 있다. 추가로 다운믹스된 모노 채널(m)은 멀티채널 디코더(730)로 입력되어 사용될 수 있다. 멀티채널 디코더(730)는 모노 입력 신호를 이용하여 오브젝트 패닝(특히, 크로스 토크)을 제어할 수 있다. 이 경우, 정보 생성 유닛(710)은 MPEG surround 표준의 5-1-51 구성을 기반으로 멀티채널 파라미터를 생성할 수 있다.

나아가, 상기 언급된 도 2의 임의적 다운믹스 게인(ADG)과 같이 모노 다운믹스에 대한 게인이 적용되면, 오브젝트 패닝 및 오브젝트 게인을 보다 쉽게 제어하는 것이 가능하다. ADG는 믹스 정보를 기반으로 하여 정보 생성 유닛(710)에 의해 생성될 수 있다.

2. 채널 신호의 업믹싱 및 오브젝트 신호의 제어

도 14는 본 발명의 제2 실시예에 따른 압축된 오디도 신호의 비트스트림의 구조의 예시적인 구성도이다. 도 15는 본 발명의 제2 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도이다. 도 14의 (a)를 참조하면, 다운믹스 신호(α), 멀티채널 파라미터(β), 오브젝트 파라미터(γ)가 비트스트림의 구성에 포함되어 있다. 멀티채널 파라미터(β)는 다운믹스 신호를 업믹싱하기 위한 파라미터이다. 한편, 오브젝트 파라미터(γ)는 오브젝트 패닝 및 오브젝트 게인을 제어하기 위한 파라미터이다. 도 14의 (b)를 참조하면, 다운믹스 신호(α), 디폴트 파라미터(β'), 오브젝트 파라미터(γ)가 비트스트림에 포함되어 있다. 디폴트 파라미터(β')는 오브젝트 게인 및 오브젝트 패닝을 제어하기 위한 프리셋 정보를 포함할 수 있다. 프리셋 정보는 인코더 측의 제작자에 의해 제안된 예에 해당할 수 있다. 예를 들어, 기타(guitar) 신호가 좌측 및 우측간의 지점에 위치하고, 기타의 레벨이 특정 볼륨으로 설정되고, 이 시간에 출력 채널의 수가 특정 채널로 셋팅되는 것을 프 리셋 정보가 기술할 수 있다. 각 프레임 또는 특정 프레임에 대한 디폴트 파라미터가 비트스트림에 존재할 수 있다. 이 프레임에 대한 디폴트 파라미터가 이전 프레임의 디폴트 파라미터와 다른지 여부를 지시하는 플래그 정보가 비트스트림에 존재할 수 있다. 비트스트림에 디폴트 파라미터를 포함함으로써, 오브젝트 파라미터를 갖는 부가 정보가 비트스트림에 포함되는 것보다 적은 비트 레이트가 소요될 수 있다. 나아가, 비트스트림의 헤더 정보는 도 14에서 생략되었다. 비트스트림의 순서는 다시 정렬될 수 있다.

도 15를 참조하면, 본 발명의 제2 실시예에 따른 오디오 신호 처리 장치(1000)(이하, 간단히 디코더(1000))는 비트스트림 디멀티플렉서(1005), 정보 생성 유닛(1010), 다운믹스 처리 유닛(1020), 및 멀티채널 디코더(1030)를 포함할 수 있다. 디멀티플렉서(1005)는 멀티플렉싱된 오디오 신호를 다운믹스 신호(α), 제1 멀티채널 파라미터(β), 오브젝트 파라미터(γ)로 분리할 수 있다. 정보 생성 유닛(1010)은 오브젝트 파라미터(γ) 및 믹스 파라미터를 이용하여 제2 멀티채널 파라미터를 생성할 수 있다. 믹스 파라미터는 제1 멀티채널 정보(β)가 프로세싱된 다운믹스에 적용될지 여부를 지시하는 모드 정보를 포함한다. 모드 정보는 사용자가 선택하기 위한 정보에 해당할 수 있다. 모드 정보에 따라서, 정보 생성 정보(1020)는 제1 멀티채널 파라미터(β) 아니면 제2 멀티채널 파라미터를 전송할지 여부를 결정한다.

다운믹스 처리 유닛(1020)은 믹스 정보에 포함된 모드 정보에 따라서 프로세싱 방식을 결정할 수 있다. 나아가 다운믹스 처리 유닛(1020)은 결정된 프로세싱 방식에 따라서 다운믹스(α)를 프로세싱할 수 있다. 그리고 다운믹스 처리 유닛(1020)은 프로세싱된 다운믹스를 멀티채널 디코더(1030)에 전달한다.

멀티채널 디코더(1030)는 제1 멀티채널 파라미터(β) 또는 제2 멀티채널 파라미터를 수신할 수 있다. 디폴트 파라미터(β')가 비트스트림에 포함된 경우에는 멀티채널 디코더(1030)는 멀티채널 파라미터(β) 대신에 디폴트 파라미터(β')를 이용할 수 있다.

멀티채널 디코더(1030)는 프로세싱된 다운믹스 신호 및 수신된 멀티채널 파라미터를 이용하여 멀티채널 출력을 생성한다. 멀티채널 디코더(1030)는 앞서 설명한 멀티채널 디코더(730)와 동일한 구성을 가질 수 있지만, 본 발명은 이에 한정되지 아니한다.

3. 바이노럴 프로세싱

멀티채널 디코더는 바이노럴 모드에서 동작할 수 있다. 이는, 머리 전달 함수(Head Related Transfer Function)(HRTF) 필터링에 의하여 헤드폰에서 멀티채널 효과를 가능하게 한다. 바이노럴 디코딩 측에서, 다운믹스 신호 및 멀티채널 파라미터는 디코더에 제공되는 HRTF 필터와 조합하여 사용된다.

도 16은 본 발명의 제3 실시예에 따른 오디오 신호 처리 장치의 예시적인 구성도이다. 도 16을 참조하면, 오디오 신호 처리 장치의 제3 실시예(이하, 간단히 디코더(1100))는 정보 생성 유닛(1110), 다운믹스 처리 유닛(1120), 및 싱크 매칭 파트(1130a)를 갖는 멀티채널 디코더(1130)를 포함할 수 있다.

정보 생성 유닛(1110)은 동적 HRTF를 생성하고, 도 7의 정보 생성 유닛(710)의 동일한 구성을 가질 수 있다. 다운믹스 처리 유닛(1120)은 도 7의 다운믹스 처리 유닛(720)과 동일한 구성을 가질 수 있다. 상기 구성요소와 마찬가지로, 싱크 매칭 파트(1130a)를 제외한 멀티채널 디코더(1130)는 앞의 구성요소와 동일한 경우이다. 따라서, 정보 생성 유닛(1110), 및 다운믹스 처리 유닛(1120), 및 멀티채널 디코더(1130)의 구체적인 설명은 생략하고자 한다.

동적 HRTF는 HRTF 방위(azimuth) 및 앙각(elevation angles)에 대응하는, 오브젝트 신호 및 가상 스피커 신호간의 관계를 기술하는데, 이는 실시간 유저 컨트롤에 대응하는 시간 종속(time dependent) 정보이다.

멀티채널 디코더가 HRTF 필터 셋 전체를 포함하는 경우, 동적 HRTF는 HRTF 필터 계수 그 자체, 파라미터화된 계수 정보, 및 인덱스 정보 중 하나에 해당할 수 있다.

동적 HRTF의 종류와 상관없이 동적 HRTF 정보는 다운믹스 프레임과 매칭될 할 필요가 있다. HRTF 정보와 다운믹스 신호가 매칭되기 위해서, 다음과 같은 세 가지 방식이 제공될 수 있다.

1) 각 HRTF 정보 및 비트스트림 다운믹스 신호에 태그 정보를 삽입하고, 상기 삽입된 태그 정보를 근거로 HRTF에 비트스트림 다운믹스 신호를 매칭시킨다. 이 방식에서, 태그 정보는 MPEG surround 표준에서의 앤실러리 필드(ancillary filed)에 삽입되는 것이 바람직하다. 태그 정보는 시간 정보, 계수기(counter) 정보, 인덱스 정보 등으로 표현될 수 있다.

2) HRTF 정보를 비트스트림의 프레임에 삽입한다. 이 방식에서, 현재 프레임이 디폴트 모드에 해당하는지 아닌지를 지시하는 모드 정보를 설정하는 것이 가능하다. 현재 프레임의 HRTF 정보가 이전 프레임의 HRTF 정보가 동일한지를 나타내는 디폴트 모드가 적용되면, HRTF 정보의 비트레이트를 줄일 수 있다.

2-1) 나아가, 현재 프레임의 HRTF 정보가 이미 전송되었는지 여부를 나타내는 전송 정보(transmission information)를 정의하는 것이 가능하다. 만약 현재 프레임의 HRTF 정보가 전송된 HRTF 정보와 동일한지 여부를 지시하는 전송정보가 적용되는 경우, HRTF 정보의 비트레이트를 줄일 수 있다.

2-2) 우선 몇 개의 HRTF 정보를 전송한 후, 이미 전송된 HRTF 중에서 어떤 HRTF인지 지시하는 식별 정보를 프레임마다 전송한다.

나아가 HRTF 계수가 갑자기 변하는 경우, 왜곡이 발생될 수 있다. 이 왜곡을 줄이기 위해서, 계수 또는 렌더링된 신호의 스무딩을 수행하는 것이 바람직하다.

4. 렌더링

도 17은 본 발명의 제4 실시예에 따른 오디오 처리 장치의 예시적인 구성도이다. 제4 실시예에 따른 오디오 신호 처리 장치(1200)(이하, 약칭하여 프로세서(1200)는 인코더측(1200A)에서 인코더(1210)를 포함하고, 디코더측(1200B)에서 렌더링 유닛(1220) 및 합성 유닛(1230)을 포함할 수 있다. 인코더(1210)는 멀티채널 오브젝트 신호를 수신하고, 오디오 신호의 다운믹스 신호 및 부가 정보를 생성할 수 있다. 렌더링 유닛(1220)은 인코더(1210)로부터 부가 정보를, 장치 설정 또 는 유저 인터페이스로부터 재생 환경 및 유저 컨트롤을 수신하고, 부가 정보, 재생 환경, 유저 컨트롤을 이용하여 렌더링 정보를 생성한다. 합성 유닛(1230)은 렌더링 정보 및 인코더(1210)로부터 수신된 다운믹스 신호를 이용하여 멀티채널 출력 신호를 합성한다.

4.1 효과 모드(effect mode) 적용

효과 모드(effect mode)는 리믹스된 신호 또는 복원된 신호에 대한 모드이다. 예를 들어, 라이브 모드(live mode), 클럽 밴드(club band mode), 노래방 모드(karaoke mode) 등이 존재할 수 있다. 효과 모드 정보는 제작자 또는 다른 유저에 의해 생성된 믹스 파라미터 셋에 해당할 수 있다. 효과 모드 정보가 적용되면, 유저가 미리 정의된 효과 모드 정보들 중에서 하나를 선택할 수 있기 때문에 최종 사용자는 전체적으로 오브젝트 패닝 및 오브젝트 게인을 제어할 필요가 없다.

효과 모드 정보를 생성하는 두 가지 방법은 구별될 수 있다. 우선, 효과 모드 정보는 인코더(1200A)에서 생성하고 디코더(1200B)에 전송되는 것이 가능하다. 둘째로, 효과 모드 정보는 디코더 측에서 자동적으로 생성될 수 있다. 이 두 가지 방식은 이하에서 상세히 설명될 것이다.

4.1.1 효과 모드 정보를 디코더 측으로 전송

효과 모드 정보는 제작자에 의해 인코더(1200A)에서 생성될 수 있다. 이 방법에 따르면, 디코더(1200B)는 효과 모드 정보를 포함하는 부가 정보를 수신하고, 사용자가 효과 모드 정보들 중 하나를 선택할 수 있는 유저 인터페이스를 출력한다. 디코더(1200B)는 선택된 효과 모드 정보를 기반으로 출력 채널을 생성할 수 있 다.

한편, 인코더(1200A)가 오브젝트 신호의 품질을 높이기 위해서 신호를 다운믹스하는 경우, 청취자가 다운믹스 신호를 있는 그대로 듣는 것은 적절치 않다. 그러나, 효과 모드 정보가 디코더(1200B)에서 적용되면, 최대 품질로서 다운믹스 신호를 재생하는 것이 가능하다.

4.1.2 효과 정보를 디코더 측에서 생성

효과 모드 정보가 디코더(1200B)에서 생성될 수 있다. 디코더(1200B)는 다운믹스 신호에 대해 적절한 효과 모드 정보를 검색할 수 있다. 그리고 디코더(1200B)는 검색된 효과 모드들 중에서 스스로 하나를 선택하거나(자동 조절 모드:automatic adjustment mode), 그 모드들 중에서 하나를 유저에게 선택하도록 할 수 있다(유저 선택 모드:user selection mode). 디코더(1200B)는 부가 정보에 포함된 오브젝트 정보(오브젝트의 수, 악기 이름 등)를 획득하고, 선택된 효과 모드 정보 및 오브젝트 정보를 근거로 오브젝트를 제어할 수 있다.

한편, 유사한 오브젝트를 일괄적으로 제어하는 것이 가능하다. 예를 들어, 리듬에 관련된 악기들은 리듬 강조 모드(rhythm impression mode)의 경우에, 서로 유사한 오브젝트가 될 수 있다. 일괄적으로 제어한다는 것은, 동일한 파라미터를 이용하여 오브젝트를 제어하기 보다는, 각 오브젝트를 동시에 제어하는 것을 의미한다.

한편, 디코더 설정 또는 장치 환경(헤드폰 또는 스피커 포함)을 기반으로 오브젝트를 제어할 수 있다. 예를 들어, 장치의 볼륨 설정이 낮은 경우, 메일 멜로디 에 해당하는 오브젝트가 강조될 수 있고, 장치의 볼륨 설정이 높을 경우, 메인 멜로디에 해당하는 오브젝트는 억압될 수 있다.

4.2 인코더에서의 입력 신호의 오브젝트 타입

인코더(1200A)에 입력되는 입력신호는 다음 3가지로 분류될 수 있다.

1) 모노 오브젝트(모도 채널 오브젝트)

모노 오브젝트는 오브젝트의 일반적인 타입이다. 오브젝트들을 단순히 합함으로써 내부 다운믹스 신호를 합성하는 것이 가능하다. 유저 컨트롤 및 제공된 정보 중 하나가 될 수 있는 오브젝트 게인 및 오브젝트 패닝을 이용하여 내부 다운믹스 신호를 합성하는 것도 가능하다. 내부 다운믹스 신호를 생성하는 데 있어서, 오브젝트 특성, 유저 입력, 오브젝트와 함께 제공된 정보 중 하나 이상을 이용하여 렌더링 정보를 생성하는 것도 가능하다.

외부 다운믹스 신호가 존재하는 경우, 외부 다운믹스 및 오브젝트간의 관계를 지시하는 정보를 추출하여 전송할 수 있다.

2) 스테레오 오브젝트 (스테레오 채널 오브젝트)

상기 모노 오브젝트 경우와 마찬가지로, 오브젝트들을 단순히 합함으로써 내부 다운믹스 신호를 합성하는 것이 가능하다. 유저 컨트롤 및 제공된 정보 중하나가 될 수 있는 오브젝트 게인 및 오브젝트 패닝을 이용하여 내부 다운믹스 신호를 합성하는 것도 가능하다. 다운믹스 신호가 모노 신호에 해당하는 경우, 인코더(1200A)는 다운믹스 신호를 생성하기 위해 모노 신호로 컨버팅된 오브젝트를 이용하는 것이 가능하다. 이 경우, 모노 신호로 변환하는 데 있어서, 오브젝트와 관 련된 정보(예: 각 시간-주파수 도메인에서의 패닝 정보)를 추출하고 전달할 수 있다. 앞의 모노 오브젝트와 마찬가지로, 내부 다운믹스 신호를 생성하는데 있어서, 오브젝트 특성, 유저 입력, 및 오브젝트와 함께 제공된 정보 중 하나 이상을 이용하여 렌더링 정보를 생성하는 것도 가능하다. 상기 모노 오브젝트와 마찬가지로, 외부 다운믹스가 존재하는 경우, 외부 다운믹스 및 오브젝트 간의 관계를 지시하는 정보를 추출하여 전달하는 것도 가능하다.

3) 멀티채널 오브젝트

멀티채널 오브젝트의 경우, 모노 오브젝트 및 스테레오 오브젝트와 함께 앞서 언급된 방법을 수행할 수 있다. 한편, MPEG surround의 형태로서 멀티채널 오브젝트를 입력하는 것이 가능하다. 이 경우, 오브젝트 다운믹스 채널을 이용하여 오브젝트 기반의 다운믹스(ex: SAOC 다운믹스)를 생성하는 것이 가능하고, 멀티채널 정보 및 렌더링 정보를 생성하기 위해 멀티채널 정보(예: MPEG Surround의 공간 정보)를 이용하는 것이 가능하다. 따라서 MPEG surround의 형태로서 존재하는 멀티채널 오브젝트는 오브젝트 기반의 다운믹스(ex: SAOC 다운믹스)를 이용하여 디코딩되거나 인코딩될 필요가 없기 때문에, 연산량을 줄이는 것이 가능하다. 오브젝트 다운믹스가 스테레오에 해당하고, 오브젝트 기반 다운믹스(SAOC 다운믹스)가 모노에 해당하는 경우, 스테레오 오브젝트와 함께 상기 언급된 방법을 적용하는 것이 가능하다.

4) 다양한 타입의 오브젝트에 대한 전송 방식

앞서 기술한 바와 같이, 다양한 타입의 오브젝트(모노 오브젝트, 스테레오 오브젝트, 및 멀티채널 오브젝트)는 인코더(1200A)에서 디코더(1200B)로 전송된다. 다양한 타입의 오브젝트를 전송하는 방식은 다음과 같이 제공될 수 있다.

도 18을 참조하면, 다운믹스가 복수의 오브젝트를 포함할 때, 부가 정보는 각 오브젝트에 대한 정보를 포함한다. 예를 들어, 복수의 오브젝트가 N번째 모노 오브젝트(A), N+1번째 오브젝트의 좌측 채널(B), N+1번째 오브젝트의 우측 채널(C)로 구성되는 경우, 부가 정보는 3개의 오브젝트들(A,B,C)에 대한 오브젝트를 포함한다.

상기 부가 정보는 오브젝트가 스테레오 또는 멀티채널의 오브젝트의 일부분(예를 들어, 모노 오브젝트, 스테레오 오브젝트의 하나의 채널(L 또는 R), 등)인지 여부를 나타내는 상관성 플래그 정보(correlation flag information)을 포함할 수 있다. 예를 들어, 모노 오브젝트가 존재하는 경우 상관성 플래그 정보가 0이고, 스테레오 오브젝트의 하나의 채널이 존재하는 경우, 상관성 플래그 정보가 1일이다. 스테레오 오브젝트의 하나의 부분과 스테레오 오브젝트의 다른 부분이 연이어서 전송되는 경우, 스테레오 오브젝트의 다른 부분에 대한 상관성 정보는 어떤 값(ex: 0, 1, or 기타)이 될 수 있다. 나아가, 스테레오 오브젝트의 다른 파트에 대한 상관성 플래그 정보는 전송되지 않을 수 있다.

나아가, 멀티채널 오브젝트의 경우, 멀티채널 오브젝트의 하나의 파트에 대한 상관성 플래그 정보는 멀티채널 오브젝트의 개수를 기술하는 값일 수 있다. 예를 들어, 5.1 채널 오브젝트의 경우, 5.1 채널의 좌측 채널에 대한 상관성 정보는 '5'가 될 수 있고, 5.1 채널의 다른 채널(R, Lr, Rr, C, LFE)에 대한 상관성 정보 는 '0'이 되거나 전송되지 않을 수 있다.

4.3 오브젝트 속성

오브젝트는 다음과 같은 세 가지 종류의 속성을 가질 수 있다.

a) 싱글 오브젝트(single object)

싱글 오브젝트는 소스로서 구성될 수 있다. 다운믹스 신호를 생성하거나 재생하는데 있어서 오브젝트 패닝 및 오브젝트 게인을 제어하기 위해, 하나의 파라미터가 싱글 오브젝트에 적용될 수 있다. 상기 '하나의 파라미터'란, 모든 시간 및 주파수 도메인에 하나라는 것뿐만 아니라, 각 시간 주파수 슬롯에 하나의 파라미터임을 의미한다.

b) 그룹핑된 오브젝트(grouped object)

싱글 오브젝트는 둘 이상의 소스로 구성될 수 있다. 그룹핑된 오브젝트가 둘 이상의 소스로서 입력될지라도, 오브젝트 패닝 및 오브젝트 게인을 제어하기 위해 그룹핑된 오브젝트에 대해 하나의 파라미터가 적용될 수 있다. 그룹핑된 오브젝트에 대한 구체적인 설명은 도 19와 함께 기술될 것이다. 도 19를 참조하면, 인코더(1300)는 그룹핑 유닛(1310) 및 다운믹스 유닛(1320)을 포함한다. 그룹핑 유닛(1310)은 그룹핑 정보를 근거로 하여, 입력된 멀티 오브젝트 입력들 중에서 둘 이상의 오브젝트를 그룹핑한다. 그룹핑 정보는 인코더 측에서 제작자에 의해 생성될 수 있다. 상기 다운믹스 유닛(1320)은 그룹핑 유닛(1310)에 의해 생성된 그룹핑된 오브젝트를 이용하여 다운믹스 신호를 생성한다. 다운믹스 유닛(132)은 그룹핑된 오브젝트에 대한 부가 정보를 생성할 수 있다.

c) 조합 오브젝트(combination object)

조합 오브젝트는 하나 이상의 소스와 조합된 오브젝트이다. 조합된 오브젝트간의 관계는 변화시키지 않으면서, 오브젝트 패닝 및 오브젝트 게인을 일괄적으로(in a lump)로 제어하는 것이 가능하다. 예를 들어, 드럼의 경우, 베이스 드럼(base drum) 북(탬-탬)(tam-tam), 심볼(symbol)간의 관계를 변화시키지 않고, 드럼을 제어하는 것이 가능하다. 예를 들어, 베이스 드럼이 중앙에 위치하고, 심벌이 좌측 지점에 위치할 때, 드럼이 우측 방향으로 이동되는 경우, 베이스 드럼은 우측 지점에 위치시키고, 심벌은 중앙과 우측의 중간 지점에 위치시키는 것이 가능하다.

조합된 오브젝트간의 관계 정보는 디코더에 전송될 수 있다. 한편으로, 디코더는 조합 오브젝트를 이용하여 상기 관계 정보를 추출할 수 있다.

4.4 계층적으로 오브젝트를 제어

오브젝트를 계층적으로 제어하는 것이 가능하다. 예를 들어 드럼을 제어한 후에, 드럼의 각 서브-엘리먼트(sub-element)를 제어할 수 있다. 계층적으로 오브젝트를 제어하기 위해서, 다음 세 가지 방식이 제공된다.

a) UI(유저 인터페이스)

모든 오브젝트를 디스플레이하지 않고, 대표적인 엘리먼트만 디스플레이될 수 있다. 만약 유저에 의해 대표 엘리먼트가 선택되면, 모든 오브젝트가 디스플레이된다.

b) 오브젝트 그룹핑

대표 엘리먼트를 나타내기 위해 오브젝트들을 그룹핑 한 후에, 대표 엘리먼 트로서 그룹핑된 모든 오브젝트를 제어하기 위해서 대표 엘리먼트를 제어하는 것이 가능하다. 그룹핑하는 과정에서 추출된 정보는 디코더에 전송될 수 있다. 또한, 그룹핑 정보가 디코더에서 생성될 수도 있다. 일괄적으로 제어 정보를 적용하는 것은 각 엘리먼트에 대한 미리 결정된 제어 정보를 근거로 수행될 수 있다.

c) 오브젝트 구성(configuration)

앞서 설명된 조합 오브젝트를 이용하는 것이 가능하다. 조합 오브젝트에의 엘리먼트에 관한 정보는 인코더 또는 디코더에서 생성될 수 있다. 인코더에서의 엘리먼트에 관한 정보는 조합 오브젝트에 관한 정보로와는 다른 방식으로서 전송될 수 있다.

본 발명은 다음과 같은 효과와 이점이 제공된다.

우선, 본 발명은 오브젝트 게인 및 패닝을 제한없이 제어할 수 있는 오디오 신호 처리 방법 및 장치를 제공할 수 있다.

둘째, 본 발명은 유저 선택을 기반으로 오브젝트 게인 및 패닝을 제어할 수 있는 오디오 신호 처리 방법 및 장치를 제공할 수 있다.

본 발명은 오디오 신호를 인코딩 및 디코딩하는데 적용될 수 있다.

Claims (19)

- 하나 이상의 오브젝트를 포함하는 다운믹스 신호를 수신하는 단계;상기 다운믹스 신호가 생성될 때 결정된 오브젝트 정보를 수신하는 단계;오브젝트 신호를 제어하기 위한 믹스 정보를 수신하는 단계;상기 오브젝트 정보 및 상기 믹스 정보를 근거로 하여 다운믹스 프로세싱 정보를 생성하는 단계;상기 다운믹스 프로세싱 정보를 이용하여 상기 다운믹스 신호를 프로세싱하는 단계;상기 프로세싱하는 단계는,디코릴레이팅된 신호를 생성하기 위해서 상기 다운믹스 신호를 디코릴레이팅하는 단계; 및,상기 프로세싱된 다운믹스 신호를 출력하기 위해서 상기 다운믹스 신호 및 상기 디코릴레이팅된 신호를 믹싱하는 단계를 포함하고,상기 오브젝트 정보는 오브젝트 레벨 정보 및 오브젝트 상관 정보 중 하나 이상을 포함하고,상기 다운믹스 신호는 제1 모노 신호 또는 제1 스테레오 신호에 해당하고,상기 프로세싱된 다운믹스 신호는 제2 모노 신호 또는 제2 스테레오 신호에 해당하는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호의 채널 수가 둘 이상에 해당하는 경우, 상기 다운믹스 프로세싱 정보를 이용하여 상기 다운믹스 신호를 프로세싱하는 단계가 수행되는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 프로세싱된 다운믹스 신호의 하나의 채널 신호는, 상기 다운믹스 신호의 다른 채널 신호를 포함하는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 3 항에 있어서,상기 프로세싱된 다운믹스 신호 중 하나의 채널 신호는, 게인 팩터로 곱해진 상기 다운믹스 신호의 다른 채널을 포함하고, 상기 게인 팩터는 상기 믹스 정보로부터 추정된 것임을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호가 상기 제1 스테레오 신호에 해당되는 경우, 상기 다운믹스 신호를 프로세싱하는 단계는, 상기 다운믹스 신호를 위한 2x2 매트릭스 오퍼레이션에 의해 수행되는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 5 항에 있어서,상기 2x2 매트릭스 오퍼레이션은 상기 다운믹스 프로세싱 정보에 포함된 0이 아닌 크로스 텀(non-zero cross term)을 포함하는 것을 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호를 디코릴레이팅하는 단계는, 2개 이상의 디코릴레이터에 의해 수행되는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호의 디코릴레이팅은,2개의 디코릴레이터를 이용하여 상기 다운믹스 신호의 제1 채널 및 상기 다운믹스 신호의 제2 채널을 디코릴레이팅하는 단계를 포함하는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 8 항에 있어서,상기 다운믹스 신호는 상기 제1 스테레오 신호에 해당하고,상기 디코릴레이팅된 신호는, 동일한 디코릴레이터를 이용하여 디코릴레이팅된 상기 제1 채널 및 상기 제2 채널을 포함하는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호를 디코릴레이팅하는 단계는,하나의 디코릴레이터를 이용하여 상기 다운믹스 신호의 제1 채널을 디코릴레이팅하는 단계; 및,다른 디코릴레이터를 이용하여 상기 다운믹스 신호의 제2 채널을 디코릴레이팅하는 단계를 포함하는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호는 스테레오 신호에 해당하고,상기 디코릴레이팅된 신호는, 디코릴레이팅된 제1 채널 및 디코릴레이팅된 제2 채널을 포함하는 것을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호가 상기 제1 스테레오 신호에 해당하는 경우, 상기 프로세싱된 다운믹스 신호는 상기 제2 스테레오 신호에 해당하는 것을 특징으로 하는 오디오 신호 처리 방법.

- 삭제

- 제 1 항에 있어서,상기 믹스 정보는 오브젝트 위치 정보 및 재생 환경 정보 중 하나 이상을 이용하여 생성된 것임을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호는 방송 신호를 통해 수신된 것임을 특징으로 하는 오디오 신호 처리 방법.

- 제 1 항에 있어서,상기 다운믹스 신호는 디지털 매체를 통해 수신된 것임을 특징으로 하는 오디오 신호 처리 방법.

- 하나 이상의 오브젝트를 포함하는 다운믹스 신호를 수신하는 단계;상기 다운믹스 신호가 생성될 때 결정된 오브젝트 정보를 수신하는 단계;오브젝트 신호를 제어하기 위한 믹스 정보를 수신하는 단계;상기 오브젝트 정보 및 상기 믹스 정보를 근거로 하여 다운믹스 프로세싱 정보를 생성하는 단계;상기 다운믹스 프로세싱 정보를 이용하여 상기 다운믹스 신호를 프로세싱하는 단계;상기 프로세싱하는 단계는,디코릴레이팅된 신호를 생성하기 위해서 상기 다운믹스 신호를 디코릴레이팅하는 단계; 및,상기 프로세싱된 다운믹스 신호를 출력하기 위해서 상기 다운믹스 신호 및 상기 디코릴레이팅된 신호를 믹싱하는 단계를 포함하고,상기 오브젝트 정보는 오브젝트 레벨 정보 및 오브젝트 상관 정보 중 하나 이상을 포함하고,상기 다운믹스 신호는 제1 모노 신호 또는 제1 스테레오 신호에 해당하고,상기 프로세싱된 다운믹스 신호는 제2 모노 신호 또는 제2 스테레오 신호에 해당하고,프로세서가 실행될 때, 상기 프로세서에 의해 상기 동작들이 수행되는 명령이 저장되어 있는, 컴퓨터로 읽을 수 있는 매체.

- 하나 이상의 오브젝트를 포함하는 다운믹스 신호 및 다운믹스 프로세싱 정보를 수신하고, 상기 다운믹스 프로세싱 정보를 이용하여 상기 다운믹스 신호를 프로세싱하는 다운믹스 처리 유닛;상기 다운믹스 신호가 생성될 때 결정된 오브젝트 정보를 수신하고, 오브젝트 신호를 제어하기 위한 믹스 정보를 수신하고, 상기 오브젝트 정보 및 상기 믹스 정보를 근거로 하여 상기 다운믹스 프로세싱 정보를 생성하는 정보 생성 유닛을 포함하고,상기 다운믹스 처리 유닛은,디코릴레이팅된 신호를 생성하기 위해서 상기 다운믹스 신호를 디코릴레이팅하는 디코릴레이팅 파트; 및,상기 프로세싱된 다운믹스 신호를 출력하기 위해서 상기 다운믹스 신호 및 상기 디코릴레이팅된 신호를 믹싱하는 믹싱 파트를 포함하고,상기 오브젝트 정보는 오브젝트 레벨 정보 및 오브젝트 상관 정보 중 하나 이상을 포함하고,상기 다운믹스 신호는 제1 모노 신호 또는 제1 스테레오 신호에 해당하고,상기 프로세싱된 다운믹스 신호는 제2 모노 신호 또는 제2 스테레오 신호에 해당하는 것을 특징으로 하는 오디오 신호 처리 장치.

- 삭제

Applications Claiming Priority (21)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US86907706P | 2006-12-07 | 2006-12-07 | |

| US60/869,077 | 2006-12-07 | ||

| US87713406P | 2006-12-27 | 2006-12-27 | |

| US60/877,134 | 2006-12-27 | ||

| US88356907P | 2007-01-05 | 2007-01-05 | |

| US60/883,569 | 2007-01-05 | ||

| US88404307P | 2007-01-09 | 2007-01-09 | |

| US60/884,043 | 2007-01-09 | ||

| US88434707P | 2007-01-10 | 2007-01-10 | |

| US60/884,347 | 2007-01-10 | ||

| US88458507P | 2007-01-11 | 2007-01-11 | |

| US60/884,585 | 2007-01-11 | ||

| US88534707P | 2007-01-17 | 2007-01-17 | |

| US88534307P | 2007-01-17 | 2007-01-17 | |

| US60/885,343 | 2007-01-17 | ||

| US60/885,347 | 2007-01-17 | ||

| US88971507P | 2007-02-13 | 2007-02-13 | |

| US60/889,715 | 2007-02-13 | ||

| US95539507P | 2007-08-13 | 2007-08-13 | |

| US60/955,395 | 2007-08-13 | ||

| PCT/KR2007/006319 WO2008069597A1 (en) | 2006-12-07 | 2007-12-06 | A method and an apparatus for processing an audio signal |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| KR20090098864A KR20090098864A (ko) | 2009-09-17 |

| KR101111521B1 true KR101111521B1 (ko) | 2012-03-13 |

Family

ID=39492395

Family Applications (5)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020097014213A KR101100222B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

| KR1020097014215A KR101100223B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

| KR1020097014212A KR101111520B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

| KR1020097014214A KR101111521B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

| KR1020097014216A KR101128815B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

Family Applications Before (3)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020097014213A KR101100222B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

| KR1020097014215A KR101100223B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

| KR1020097014212A KR101111520B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

Family Applications After (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020097014216A KR101128815B1 (ko) | 2006-12-07 | 2007-12-06 | 오디오 처리 방법 및 장치 |

Country Status (11)

| Country | Link |

|---|---|

| US (11) | US7986788B2 (ko) |

| EP (6) | EP2187386B1 (ko) |

| JP (5) | JP5450085B2 (ko) |

| KR (5) | KR101100222B1 (ko) |

| CN (5) | CN101553866B (ko) |

| AU (1) | AU2007328614B2 (ko) |

| BR (1) | BRPI0719884B1 (ko) |

| CA (1) | CA2670864C (ko) |

| MX (1) | MX2009005969A (ko) |

| TW (1) | TWI371743B (ko) |

| WO (5) | WO2008069596A1 (ko) |

Families Citing this family (103)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP1691348A1 (en) * | 2005-02-14 | 2006-08-16 | Ecole Polytechnique Federale De Lausanne | Parametric joint-coding of audio sources |

| JP4988716B2 (ja) | 2005-05-26 | 2012-08-01 | エルジー エレクトロニクス インコーポレイティド | オーディオ信号のデコーディング方法及び装置 |

| WO2006126844A2 (en) * | 2005-05-26 | 2006-11-30 | Lg Electronics Inc. | Method and apparatus for decoding an audio signal |

| US8082157B2 (en) * | 2005-06-30 | 2011-12-20 | Lg Electronics Inc. | Apparatus for encoding and decoding audio signal and method thereof |

| AU2006266655B2 (en) * | 2005-06-30 | 2009-08-20 | Lg Electronics Inc. | Apparatus for encoding and decoding audio signal and method thereof |

| WO2007007500A1 (ja) * | 2005-07-11 | 2007-01-18 | Matsushita Electric Industrial Co., Ltd. | 超音波探傷方法と超音波探傷装置 |

| TWI329462B (en) * | 2006-01-19 | 2010-08-21 | Lg Electronics Inc | Method and apparatus for processing a media signal |

| JP5054035B2 (ja) * | 2006-02-07 | 2012-10-24 | エルジー エレクトロニクス インコーポレイティド | 符号化/復号化装置及び方法 |

| WO2008004812A1 (en) * | 2006-07-04 | 2008-01-10 | Electronics And Telecommunications Research Institute | Apparatus and method for restoring multi-channel audio signal using he-aac decoder and mpeg surround decoder |

| JP5450085B2 (ja) * | 2006-12-07 | 2014-03-26 | エルジー エレクトロニクス インコーポレイティド | オーディオ処理方法及び装置 |

| EP2109861B1 (en) * | 2007-01-10 | 2019-03-13 | Koninklijke Philips N.V. | Audio decoder |

| US8520873B2 (en) | 2008-10-20 | 2013-08-27 | Jerry Mahabub | Audio spatialization and environment simulation |

| KR20080082916A (ko) * | 2007-03-09 | 2008-09-12 | 엘지전자 주식회사 | 오디오 신호 처리 방법 및 이의 장치 |

| ATE526663T1 (de) | 2007-03-09 | 2011-10-15 | Lg Electronics Inc | Verfahren und vorrichtung zum verarbeiten eines audiosignals |

| EP2278582B1 (en) * | 2007-06-08 | 2016-08-10 | LG Electronics Inc. | A method and an apparatus for processing an audio signal |

| JP2010538571A (ja) | 2007-09-06 | 2010-12-09 | エルジー エレクトロニクス インコーポレイティド | オーディオ信号のデコーディング方法及び装置 |

| KR101461685B1 (ko) * | 2008-03-31 | 2014-11-19 | 한국전자통신연구원 | 다객체 오디오 신호의 부가정보 비트스트림 생성 방법 및 장치 |

| KR101596504B1 (ko) * | 2008-04-23 | 2016-02-23 | 한국전자통신연구원 | 객체기반 오디오 컨텐츠의 생성/재생 방법 및 객체기반 오디오 서비스를 위한 파일 포맷 구조를 가진 데이터를 기록한 컴퓨터 판독 가능 기록 매체 |

| JP5258967B2 (ja) * | 2008-07-15 | 2013-08-07 | エルジー エレクトロニクス インコーポレイティド | オーディオ信号の処理方法及び装置 |

| WO2010008200A2 (en) | 2008-07-15 | 2010-01-21 | Lg Electronics Inc. | A method and an apparatus for processing an audio signal |

| US8315396B2 (en) * | 2008-07-17 | 2012-11-20 | Fraunhofer-Gesellschaft Zur Foerderung Der Angewandten Forschung E.V. | Apparatus and method for generating audio output signals using object based metadata |

| EP2175670A1 (en) * | 2008-10-07 | 2010-04-14 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Binaural rendering of a multi-channel audio signal |

| WO2010041877A2 (en) * | 2008-10-08 | 2010-04-15 | Lg Electronics Inc. | A method and an apparatus for processing a signal |

| US8861739B2 (en) * | 2008-11-10 | 2014-10-14 | Nokia Corporation | Apparatus and method for generating a multichannel signal |

| KR20100065121A (ko) * | 2008-12-05 | 2010-06-15 | 엘지전자 주식회사 | 오디오 신호 처리 방법 및 장치 |

| US8670575B2 (en) * | 2008-12-05 | 2014-03-11 | Lg Electronics Inc. | Method and an apparatus for processing an audio signal |

| JP5309944B2 (ja) * | 2008-12-11 | 2013-10-09 | 富士通株式会社 | オーディオ復号装置、方法、及びプログラム |

| KR101187075B1 (ko) * | 2009-01-20 | 2012-09-27 | 엘지전자 주식회사 | 오디오 신호 처리 방법 및 장치 |

| WO2010085083A2 (en) * | 2009-01-20 | 2010-07-29 | Lg Electronics Inc. | An apparatus for processing an audio signal and method thereof |

| KR101137361B1 (ko) | 2009-01-28 | 2012-04-26 | 엘지전자 주식회사 | 오디오 신호 처리 방법 및 장치 |

| WO2010087627A2 (en) * | 2009-01-28 | 2010-08-05 | Lg Electronics Inc. | A method and an apparatus for decoding an audio signal |

| US8255821B2 (en) * | 2009-01-28 | 2012-08-28 | Lg Electronics Inc. | Method and an apparatus for decoding an audio signal |

| US20100324915A1 (en) * | 2009-06-23 | 2010-12-23 | Electronic And Telecommunications Research Institute | Encoding and decoding apparatuses for high quality multi-channel audio codec |

| RU2607266C2 (ru) * | 2009-10-16 | 2017-01-10 | Фраунхофер-Гезелльшафт цур Фёрдерунг дер ангевандтен Форшунг Е.Ф. | Устройство, способ и компьютерная программа для формирования с использованием среднего значения параметров сигнала, подстроенных для обеспечения представления микшированного с повышением сигнала на базе представления микшированного с понижением сигнала и параметрической сторонней информации, связанной с представлением микшированного с понижением сигнала |

| PL2491551T3 (pl) | 2009-10-20 | 2015-06-30 | Fraunhofer Ges Forschung | Urządzenie do dostarczania reprezentacji sygnału upmixu w oparciu o reprezentację sygnału downmixu, urządzenie do dostarczania strumienia bitów reprezentującego wielokanałowy sygnał audio, sposoby, program komputerowy i strumień bitów wykorzystujący sygnalizację sterowania zniekształceniami |

| KR101106465B1 (ko) * | 2009-11-09 | 2012-01-20 | 네오피델리티 주식회사 | 멀티밴드 drc 시스템의 게인 설정 방법 및 이를 이용한 멀티밴드 drc 시스템 |

| AU2010321013B2 (en) * | 2009-11-20 | 2014-05-29 | Dolby International Ab | Apparatus for providing an upmix signal representation on the basis of the downmix signal representation, apparatus for providing a bitstream representing a multi-channel audio signal, methods, computer programs and bitstream representing a multi-channel audio signal using a linear combination parameter |

| EP2511908A4 (en) * | 2009-12-11 | 2013-07-31 | Korea Electronics Telecomm | AUDIO CREATING APPARATUS AND AUDIO PLAYING APPARATUS FOR AUDIO BASED OBJECT BASED SERVICE, AND AUDIO CREATING METHOD AND AUDIO PLAYING METHOD USING THE SAME |

| CN102696070B (zh) * | 2010-01-06 | 2015-05-20 | Lg电子株式会社 | 处理音频信号的设备及其方法 |

| US20120318412A1 (en) * | 2010-03-29 | 2012-12-20 | Hitachi Metals, Ltd. | Primary ultrafine-crystalline alloy, nano-crystalline, soft magnetic alloy and its production method, and magnetic device formed by nano-crystalline, soft magnetic alloy |

| KR20120004909A (ko) | 2010-07-07 | 2012-01-13 | 삼성전자주식회사 | 입체 음향 재생 방법 및 장치 |

| WO2012009851A1 (en) | 2010-07-20 | 2012-01-26 | Huawei Technologies Co., Ltd. | Audio signal synthesizer |

| US8948403B2 (en) * | 2010-08-06 | 2015-02-03 | Samsung Electronics Co., Ltd. | Method of processing signal, encoding apparatus thereof, decoding apparatus thereof, and signal processing system |

| JP5903758B2 (ja) * | 2010-09-08 | 2016-04-13 | ソニー株式会社 | 信号処理装置および方法、プログラム、並びにデータ記録媒体 |

| EP2727383B1 (en) | 2011-07-01 | 2021-04-28 | Dolby Laboratories Licensing Corporation | System and method for adaptive audio signal generation, coding and rendering |

| EP2560161A1 (en) | 2011-08-17 | 2013-02-20 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Optimal mixing matrices and usage of decorrelators in spatial audio processing |

| CN103050124B (zh) | 2011-10-13 | 2016-03-30 | 华为终端有限公司 | 混音方法、装置及系统 |

| IN2014CN03413A (ko) * | 2011-11-01 | 2015-07-03 | Koninkl Philips Nv | |

| US9584912B2 (en) | 2012-01-19 | 2017-02-28 | Koninklijke Philips N.V. | Spatial audio rendering and encoding |

| US9761229B2 (en) | 2012-07-20 | 2017-09-12 | Qualcomm Incorporated | Systems, methods, apparatus, and computer-readable media for audio object clustering |

| US9479886B2 (en) * | 2012-07-20 | 2016-10-25 | Qualcomm Incorporated | Scalable downmix design with feedback for object-based surround codec |

| KR20140017338A (ko) * | 2012-07-31 | 2014-02-11 | 인텔렉추얼디스커버리 주식회사 | 오디오 신호 처리 장치 및 방법 |

| JP6045696B2 (ja) * | 2012-07-31 | 2016-12-14 | インテレクチュアル ディスカバリー シーオー エルティディIntellectual Discovery Co.,Ltd. | オーディオ信号処理方法および装置 |

| MX351687B (es) | 2012-08-03 | 2017-10-25 | Fraunhofer Ges Forschung | Método y descodificador para codificación de objeto de audio especial de multi-instancias que emplea un concepto paramétrico para casos de mezcla descendente/mezcla ascendente de multicanal. |

| BR122021021503B1 (pt) * | 2012-09-12 | 2023-04-11 | Fraunhofer - Gesellschaft Zur Forderung Der Angewandten Forschung E.V. | Aparelho e método para fornecer capacidades melhoradas de downmix guiado para áudio 3d |

| US9385674B2 (en) * | 2012-10-31 | 2016-07-05 | Maxim Integrated Products, Inc. | Dynamic speaker management for multichannel audio systems |

| CA2893729C (en) | 2012-12-04 | 2019-03-12 | Samsung Electronics Co., Ltd. | Audio providing apparatus and audio providing method |

| TR201808415T4 (tr) | 2013-01-15 | 2018-07-23 | Koninklijke Philips Nv | Binoral ses işleme. |

| JP6433918B2 (ja) | 2013-01-17 | 2018-12-05 | コーニンクレッカ フィリップス エヌ ヴェKoninklijke Philips N.V. | バイノーラルのオーディオ処理 |

| EP2757559A1 (en) * | 2013-01-22 | 2014-07-23 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Apparatus and method for spatial audio object coding employing hidden objects for signal mixture manipulation |

| US9208775B2 (en) | 2013-02-21 | 2015-12-08 | Qualcomm Incorporated | Systems and methods for determining pitch pulse period signal boundaries |

| JP5591423B1 (ja) | 2013-03-13 | 2014-09-17 | パナソニック株式会社 | オーディオ再生装置およびオーディオ再生方法 |

| CN104982042B (zh) | 2013-04-19 | 2018-06-08 | 韩国电子通信研究院 | 多信道音频信号处理装置及方法 |

| WO2014171791A1 (ko) | 2013-04-19 | 2014-10-23 | 한국전자통신연구원 | 다채널 오디오 신호 처리 장치 및 방법 |

| WO2014174344A1 (en) * | 2013-04-26 | 2014-10-30 | Nokia Corporation | Audio signal encoder |

| KR20140128564A (ko) * | 2013-04-27 | 2014-11-06 | 인텔렉추얼디스커버리 주식회사 | 음상 정위를 위한 오디오 시스템 및 방법 |

| CA3211308A1 (en) | 2013-05-24 | 2014-11-27 | Dolby International Ab | Coding of audio scenes |

| EP2973551B1 (en) | 2013-05-24 | 2017-05-03 | Dolby International AB | Reconstruction of audio scenes from a downmix |

| JP6248186B2 (ja) * | 2013-05-24 | 2017-12-13 | ドルビー・インターナショナル・アーベー | オーディオ・エンコードおよびデコード方法、対応するコンピュータ可読媒体ならびに対応するオーディオ・エンコーダおよびデコーダ |

| US20140355769A1 (en) * | 2013-05-29 | 2014-12-04 | Qualcomm Incorporated | Energy preservation for decomposed representations of a sound field |

| KR101454342B1 (ko) * | 2013-05-31 | 2014-10-23 | 한국산업은행 | 서라운드 채널 오디오 신호를 이용한 추가 채널 오디오 신호 생성 장치 및 방법 |

| EP3005344A4 (en) * | 2013-05-31 | 2017-02-22 | Nokia Technologies OY | An audio scene apparatus |

| SG11201600466PA (en) | 2013-07-22 | 2016-02-26 | Fraunhofer Ges Forschung | Multi-channel audio decoder, multi-channel audio encoder, methods, computer program and encoded audio representation using a decorrelation of rendered audio signals |

| EP2830333A1 (en) | 2013-07-22 | 2015-01-28 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Multi-channel decorrelator, multi-channel audio decoder, multi-channel audio encoder, methods and computer program using a premix of decorrelator input signals |

| EP2830049A1 (en) | 2013-07-22 | 2015-01-28 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Apparatus and method for efficient object metadata coding |

| EP2830045A1 (en) | 2013-07-22 | 2015-01-28 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Concept for audio encoding and decoding for audio channels and audio objects |

| EP2830050A1 (en) | 2013-07-22 | 2015-01-28 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Apparatus and method for enhanced spatial audio object coding |

| US9319819B2 (en) * | 2013-07-25 | 2016-04-19 | Etri | Binaural rendering method and apparatus for decoding multi channel audio |

| KR102243395B1 (ko) * | 2013-09-05 | 2021-04-22 | 한국전자통신연구원 | 오디오 부호화 장치 및 방법, 오디오 복호화 장치 및 방법, 오디오 재생 장치 |

| TWI847206B (zh) | 2013-09-12 | 2024-07-01 | 瑞典商杜比國際公司 | 多聲道音訊系統中之解碼方法、解碼裝置、包含用於執行解碼方法的指令之非暫態電腦可讀取的媒體之電腦程式產品、包含解碼裝置的音訊系統 |

| KR101782916B1 (ko) | 2013-09-17 | 2017-09-28 | 주식회사 윌러스표준기술연구소 | 오디오 신호 처리 방법 및 장치 |

| US10049683B2 (en) * | 2013-10-21 | 2018-08-14 | Dolby International Ab | Audio encoder and decoder |

| WO2015060654A1 (ko) | 2013-10-22 | 2015-04-30 | 한국전자통신연구원 | 오디오 신호의 필터 생성 방법 및 이를 위한 파라메터화 장치 |

| EP2866227A1 (en) | 2013-10-22 | 2015-04-29 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Method for decoding and encoding a downmix matrix, method for presenting audio content, encoder and decoder for a downmix matrix, audio encoder and audio decoder |

| ES2755349T3 (es) | 2013-10-31 | 2020-04-22 | Dolby Laboratories Licensing Corp | Renderización binaural para auriculares utilizando procesamiento de metadatos |

| EP2879131A1 (en) | 2013-11-27 | 2015-06-03 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Decoder, encoder and method for informed loudness estimation in object-based audio coding systems |

| WO2015099429A1 (ko) | 2013-12-23 | 2015-07-02 | 주식회사 윌러스표준기술연구소 | 오디오 신호 처리 방법, 이를 위한 파라메터화 장치 및 오디오 신호 처리 장치 |

| WO2015104447A1 (en) | 2014-01-13 | 2015-07-16 | Nokia Technologies Oy | Multi-channel audio signal classifier |

| CN108600935B (zh) | 2014-03-19 | 2020-11-03 | 韦勒斯标准与技术协会公司 | 音频信号处理方法和设备 |

| KR101856127B1 (ko) | 2014-04-02 | 2018-05-09 | 주식회사 윌러스표준기술연구소 | 오디오 신호 처리 방법 및 장치 |

| CN105376691B (zh) * | 2014-08-29 | 2019-10-08 | 杜比实验室特许公司 | 感知方向的环绕声播放 |

| EP3192282A1 (en) * | 2014-09-12 | 2017-07-19 | Dolby Laboratories Licensing Corp. | Rendering audio objects in a reproduction environment that includes surround and/or height speakers |

| TWI587286B (zh) | 2014-10-31 | 2017-06-11 | 杜比國際公司 | 音頻訊號之解碼和編碼的方法及系統、電腦程式產品、與電腦可讀取媒體 |

| US9609383B1 (en) * | 2015-03-23 | 2017-03-28 | Amazon Technologies, Inc. | Directional audio for virtual environments |

| WO2016204580A1 (ko) | 2015-06-17 | 2016-12-22 | 삼성전자 주식회사 | 저연산 포맷 변환을 위한 인터널 채널 처리 방법 및 장치 |

| US10672408B2 (en) | 2015-08-25 | 2020-06-02 | Dolby Laboratories Licensing Corporation | Audio decoder and decoding method |

| CN109427337B (zh) | 2017-08-23 | 2021-03-30 | 华为技术有限公司 | 立体声信号编码时重建信号的方法和装置 |

| US11004457B2 (en) * | 2017-10-18 | 2021-05-11 | Htc Corporation | Sound reproducing method, apparatus and non-transitory computer readable storage medium thereof |

| DE102018206025A1 (de) * | 2018-02-19 | 2019-08-22 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Vorrichtung und Verfahren für objektbasiertes, räumliches Audio-Mastering |

| KR102471718B1 (ko) * | 2019-07-25 | 2022-11-28 | 한국전자통신연구원 | 객체 기반 오디오를 제공하는 방송 송신 장치 및 방법, 그리고 방송 재생 장치 및 방법 |

| EP4018686B1 (en) * | 2019-08-19 | 2024-07-10 | Dolby Laboratories Licensing Corporation | Steering of binauralization of audio |

| CN111654745B (zh) * | 2020-06-08 | 2022-10-14 | 海信视像科技股份有限公司 | 多声道的信号处理方法及显示设备 |

| JP7457215B1 (ja) | 2023-04-25 | 2024-03-27 | マブチモーター株式会社 | 梱包構造 |

Citations (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP0169134A1 (fr) * | 1984-07-20 | 1986-01-22 | Centre Technique Des Industries Mecaniques | Distributeur hydraulique proportionnel |

| WO2005069274A1 (en) | 2004-01-20 | 2005-07-28 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Apparatus and method for constructing a multi-channel output signal or for generating a downmix signal |

| WO2006048203A1 (en) * | 2004-11-02 | 2006-05-11 | Coding Technologies Ab | Methods for improved performance of prediction based multi-channel reconstruction |

Family Cites Families (68)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP0079886B1 (en) | 1981-05-29 | 1986-08-27 | International Business Machines Corporation | Aspirator for an ink jet printer |

| SG49883A1 (en) | 1991-01-08 | 1998-06-15 | Dolby Lab Licensing Corp | Encoder/decoder for multidimensional sound fields |

| US6141446A (en) | 1994-09-21 | 2000-10-31 | Ricoh Company, Ltd. | Compression and decompression system with reversible wavelets and lossy reconstruction |

| US5838664A (en) | 1997-07-17 | 1998-11-17 | Videoserver, Inc. | Video teleconferencing system with digital transcoding |

| US5956674A (en) | 1995-12-01 | 1999-09-21 | Digital Theater Systems, Inc. | Multi-channel predictive subband audio coder using psychoacoustic adaptive bit allocation in frequency, time and over the multiple channels |

| EP0798866A2 (en) | 1996-03-27 | 1997-10-01 | Kabushiki Kaisha Toshiba | Digital data processing system |

| US6128597A (en) | 1996-05-03 | 2000-10-03 | Lsi Logic Corporation | Audio decoder with a reconfigurable downmixing/windowing pipeline and method therefor |

| US5912976A (en) | 1996-11-07 | 1999-06-15 | Srs Labs, Inc. | Multi-channel audio enhancement system for use in recording and playback and methods for providing same |

| US6131084A (en) | 1997-03-14 | 2000-10-10 | Digital Voice Systems, Inc. | Dual subframe quantization of spectral magnitudes |

| DE69817181T2 (de) | 1997-06-18 | 2004-06-17 | Clarity, L.L.C., Ann Arbor | Verfahren und gerät zur blindseparierung von signalen |

| US6026168A (en) | 1997-11-14 | 2000-02-15 | Microtek Lab, Inc. | Methods and apparatus for automatically synchronizing and regulating volume in audio component systems |

| WO1999053479A1 (en) * | 1998-04-15 | 1999-10-21 | Sgs-Thomson Microelectronics Asia Pacific (Pte) Ltd. | Fast frame optimisation in an audio encoder |

| US6122619A (en) | 1998-06-17 | 2000-09-19 | Lsi Logic Corporation | Audio decoder with programmable downmixing of MPEG/AC-3 and method therefor |

| FI114833B (fi) * | 1999-01-08 | 2004-12-31 | Nokia Corp | Menetelmä, puhekooderi ja matkaviestin puheenkoodauskehysten muodostamiseksi |

| US7103187B1 (en) * | 1999-03-30 | 2006-09-05 | Lsi Logic Corporation | Audio calibration system |

| US6539357B1 (en) | 1999-04-29 | 2003-03-25 | Agere Systems Inc. | Technique for parametric coding of a signal containing information |

| CA2402925A1 (en) * | 2000-03-03 | 2001-09-13 | Cardiac M.R.I., Inc. | Magnetic resonance specimen analysis apparatus |

| WO2002007481A2 (en) | 2000-07-19 | 2002-01-24 | Koninklijke Philips Electronics N.V. | Multi-channel stereo converter for deriving a stereo surround and/or audio centre signal |

| US7292901B2 (en) * | 2002-06-24 | 2007-11-06 | Agere Systems Inc. | Hybrid multi-channel/cue coding/decoding of audio signals |

| US7583805B2 (en) | 2004-02-12 | 2009-09-01 | Agere Systems Inc. | Late reverberation-based synthesis of auditory scenes |

| SE0202159D0 (sv) | 2001-07-10 | 2002-07-09 | Coding Technologies Sweden Ab | Efficientand scalable parametric stereo coding for low bitrate applications |

| US7032116B2 (en) | 2001-12-21 | 2006-04-18 | Intel Corporation | Thermal management for computer systems running legacy or thermal management operating systems |

| DE60326782D1 (de) | 2002-04-22 | 2009-04-30 | Koninkl Philips Electronics Nv | Dekodiervorrichtung mit Dekorreliereinheit |

| ES2268340T3 (es) | 2002-04-22 | 2007-03-16 | Koninklijke Philips Electronics N.V. | Representacion de audio parametrico de multiples canales. |

| JP4013822B2 (ja) | 2002-06-17 | 2007-11-28 | ヤマハ株式会社 | ミキサ装置およびミキサプログラム |

| EP1523863A1 (en) | 2002-07-16 | 2005-04-20 | Koninklijke Philips Electronics N.V. | Audio coding |

| KR100542129B1 (ko) | 2002-10-28 | 2006-01-11 | 한국전자통신연구원 | 객체기반 3차원 오디오 시스템 및 그 제어 방법 |

| JP4084990B2 (ja) | 2002-11-19 | 2008-04-30 | 株式会社ケンウッド | エンコード装置、デコード装置、エンコード方法およびデコード方法 |

| JP4496379B2 (ja) | 2003-09-17 | 2010-07-07 | 財団法人北九州産業学術推進機構 | 分割スペクトル系列の振幅頻度分布の形状に基づく目的音声の復元方法 |

| US6937737B2 (en) | 2003-10-27 | 2005-08-30 | Britannia Investment Corporation | Multi-channel audio surround sound from front located loudspeakers |

| TWI233091B (en) | 2003-11-18 | 2005-05-21 | Ali Corp | Audio mixing output device and method for dynamic range control |

| ATE527654T1 (de) * | 2004-03-01 | 2011-10-15 | Dolby Lab Licensing Corp | Mehrkanal-audiodecodierung |

| US7805313B2 (en) | 2004-03-04 | 2010-09-28 | Agere Systems Inc. | Frequency-based coding of channels in parametric multi-channel coding systems |

| SE0400997D0 (sv) * | 2004-04-16 | 2004-04-16 | Cooding Technologies Sweden Ab | Efficient coding of multi-channel audio |

| SE0400998D0 (sv) | 2004-04-16 | 2004-04-16 | Cooding Technologies Sweden Ab | Method for representing multi-channel audio signals |

| US8843378B2 (en) | 2004-06-30 | 2014-09-23 | Fraunhofer-Gesellschaft Zur Foerderung Der Angewandten Forschung E.V. | Multi-channel synthesizer and method for generating a multi-channel output signal |

| EP1768107B1 (en) | 2004-07-02 | 2016-03-09 | Panasonic Intellectual Property Corporation of America | Audio signal decoding device |

| WO2006006809A1 (en) | 2004-07-09 | 2006-01-19 | Electronics And Telecommunications Research Institute | Method and apparatus for encoding and cecoding multi-channel audio signal using virtual source location information |

| US7391870B2 (en) | 2004-07-09 | 2008-06-24 | Fraunhofer-Gesellschaft Zur Foerderung Der Angewandten Forschung E V | Apparatus and method for generating a multi-channel output signal |

| KR100745688B1 (ko) | 2004-07-09 | 2007-08-03 | 한국전자통신연구원 | 다채널 오디오 신호 부호화/복호화 방법 및 장치 |

| KR100663729B1 (ko) | 2004-07-09 | 2007-01-02 | 한국전자통신연구원 | 가상 음원 위치 정보를 이용한 멀티채널 오디오 신호부호화 및 복호화 방법 및 장치 |

| KR101283525B1 (ko) * | 2004-07-14 | 2013-07-15 | 돌비 인터네셔널 에이비 | 오디오 채널 변환 |

| PL2175671T3 (pl) | 2004-07-14 | 2012-10-31 | Koninl Philips Electronics Nv | Sposób, urządzenie, urządzenie kodujące, urządzenie dekodujące i system audio |

| JP4892184B2 (ja) * | 2004-10-14 | 2012-03-07 | パナソニック株式会社 | 音響信号符号化装置及び音響信号復号装置 |

| US7720230B2 (en) * | 2004-10-20 | 2010-05-18 | Agere Systems, Inc. | Individual channel shaping for BCC schemes and the like |

| US8204261B2 (en) | 2004-10-20 | 2012-06-19 | Fraunhofer-Gesellschaft Zur Foerderung Der Angewandten Forschung E.V. | Diffuse sound shaping for BCC schemes and the like |

| SE0402650D0 (sv) * | 2004-11-02 | 2004-11-02 | Coding Tech Ab | Improved parametric stereo compatible coding of spatial audio |

| US7787631B2 (en) * | 2004-11-30 | 2010-08-31 | Agere Systems Inc. | Parametric coding of spatial audio with cues based on transmitted channels |

| KR100682904B1 (ko) * | 2004-12-01 | 2007-02-15 | 삼성전자주식회사 | 공간 정보를 이용한 다채널 오디오 신호 처리 장치 및 방법 |

| US7903824B2 (en) | 2005-01-10 | 2011-03-08 | Agere Systems Inc. | Compact side information for parametric coding of spatial audio |

| EP1691348A1 (en) * | 2005-02-14 | 2006-08-16 | Ecole Polytechnique Federale De Lausanne | Parametric joint-coding of audio sources |

| KR101271069B1 (ko) * | 2005-03-30 | 2013-06-04 | 돌비 인터네셔널 에이비 | 다중채널 오디오 인코더 및 디코더와, 인코딩 및 디코딩 방법 |

| US20060262936A1 (en) | 2005-05-13 | 2006-11-23 | Pioneer Corporation | Virtual surround decoder apparatus |

| KR20060122693A (ko) * | 2005-05-26 | 2006-11-30 | 엘지전자 주식회사 | 다운믹스된 오디오 신호에 공간 정보 비트스트림을삽입하는 프레임 크기 조절방법 |

| EP1905004A2 (en) | 2005-05-26 | 2008-04-02 | LG Electronics Inc. | Method of encoding and decoding an audio signal |

| KR101251426B1 (ko) | 2005-06-03 | 2013-04-05 | 돌비 레버러토리즈 라이쎈싱 코오포레이션 | 디코딩 명령으로 오디오 신호를 인코딩하기 위한 장치 및방법 |

| US20070055510A1 (en) | 2005-07-19 | 2007-03-08 | Johannes Hilpert | Concept for bridging the gap between parametric multi-channel audio coding and matrixed-surround multi-channel coding |

| WO2007013784A1 (en) | 2005-07-29 | 2007-02-01 | Lg Electronics Inc. | Method for generating encoded audio signal amd method for processing audio signal |

| US20070083365A1 (en) | 2005-10-06 | 2007-04-12 | Dts, Inc. | Neural network classifier for separating audio sources from a monophonic audio signal |

| EP1640972A1 (en) | 2005-12-23 | 2006-03-29 | Phonak AG | System and method for separation of a users voice from ambient sound |

| WO2007080212A1 (en) | 2006-01-09 | 2007-07-19 | Nokia Corporation | Controlling the decoding of binaural audio signals |

| JP4399835B2 (ja) * | 2006-07-07 | 2010-01-20 | 日本ビクター株式会社 | 音声符号化方法及び音声復号化方法 |

| AU2007271532B2 (en) | 2006-07-07 | 2011-03-17 | Fraunhofer-Gesellschaft Zur Foerderung Der Angewandten Forschung E.V. | Apparatus and method for combining multiple parametrically coded audio sources |

| CN101517637B (zh) | 2006-09-18 | 2012-08-15 | 皇家飞利浦电子股份有限公司 | 音频编解码器 、编解码方法、 集线器、 发送接收器、 发送接收方法、通信系统、 播放设备 |

| WO2008039041A1 (en) * | 2006-09-29 | 2008-04-03 | Lg Electronics Inc. | Methods and apparatuses for encoding and decoding object-based audio signals |

| DE602007013415D1 (de) * | 2006-10-16 | 2011-05-05 | Dolby Sweden Ab | Erweiterte codierung und parameterrepräsentation einer mehrkanaligen heruntergemischten objektcodierung |

| WO2008046530A2 (en) | 2006-10-16 | 2008-04-24 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Apparatus and method for multi -channel parameter transformation |

| JP5450085B2 (ja) * | 2006-12-07 | 2014-03-26 | エルジー エレクトロニクス インコーポレイティド | オーディオ処理方法及び装置 |

-

2007

- 2007-12-06 JP JP2009540164A patent/JP5450085B2/ja active Active

- 2007-12-06 CN CN2007800453673A patent/CN101553866B/zh active Active

- 2007-12-06 CN CN2007800454197A patent/CN101553868B/zh active Active

- 2007-12-06 MX MX2009005969A patent/MX2009005969A/es active IP Right Grant

- 2007-12-06 WO PCT/KR2007/006318 patent/WO2008069596A1/en active Application Filing

- 2007-12-06 WO PCT/KR2007/006316 patent/WO2008069594A1/en active Application Filing

- 2007-12-06 CN CN2007800453936A patent/CN101553867B/zh active Active

- 2007-12-06 WO PCT/KR2007/006317 patent/WO2008069595A1/en active Application Filing

- 2007-12-06 JP JP2009540163A patent/JP5209637B2/ja active Active

- 2007-12-06 JP JP2009540167A patent/JP5302207B2/ja active Active

- 2007-12-06 JP JP2009540165A patent/JP5270566B2/ja active Active

- 2007-12-06 WO PCT/KR2007/006315 patent/WO2008069593A1/en active Application Filing

- 2007-12-06 EP EP10001843.1A patent/EP2187386B1/en active Active

- 2007-12-06 KR KR1020097014213A patent/KR101100222B1/ko active IP Right Grant

- 2007-12-06 CN CN2007800453353A patent/CN101553865B/zh active Active

- 2007-12-06 WO PCT/KR2007/006319 patent/WO2008069597A1/en active Application Filing

- 2007-12-06 BR BRPI0719884-1A patent/BRPI0719884B1/pt active IP Right Grant

- 2007-12-06 KR KR1020097014215A patent/KR101100223B1/ko active IP Right Grant

- 2007-12-06 EP EP07851288.6A patent/EP2102857B1/en active Active

- 2007-12-06 EP EP07851286.0A patent/EP2122612B1/en not_active Not-in-force

- 2007-12-06 KR KR1020097014212A patent/KR101111520B1/ko active IP Right Grant

- 2007-12-06 KR KR1020097014214A patent/KR101111521B1/ko active IP Right Grant

- 2007-12-06 CA CA2670864A patent/CA2670864C/en active Active

- 2007-12-06 EP EP07851289.4A patent/EP2122613B1/en active Active

- 2007-12-06 JP JP2009540166A patent/JP5290988B2/ja active Active

- 2007-12-06 EP EP07851290A patent/EP2102858A4/en not_active Withdrawn

- 2007-12-06 CN CN2007800452685A patent/CN101568958B/zh active Active

- 2007-12-06 AU AU2007328614A patent/AU2007328614B2/en active Active

- 2007-12-06 EP EP07851287A patent/EP2102856A4/en not_active Ceased

- 2007-12-06 KR KR1020097014216A patent/KR101128815B1/ko active IP Right Grant

- 2007-12-07 US US11/952,918 patent/US7986788B2/en active Active

- 2007-12-07 US US11/952,916 patent/US8488797B2/en active Active

- 2007-12-07 US US11/952,949 patent/US8340325B2/en active Active

- 2007-12-07 US US11/952,919 patent/US8311227B2/en active Active

- 2007-12-07 US US11/952,957 patent/US8428267B2/en active Active

- 2007-12-07 TW TW096146865A patent/TWI371743B/zh not_active IP Right Cessation

-

2009

- 2009-03-16 US US12/405,164 patent/US8005229B2/en active Active

- 2009-10-02 US US12/573,077 patent/US7715569B2/en active Active

- 2009-10-02 US US12/572,998 patent/US7783048B2/en active Active

- 2009-10-02 US US12/573,067 patent/US7783051B2/en active Active

- 2009-10-02 US US12/573,044 patent/US7783049B2/en active Active

- 2009-10-02 US US12/573,061 patent/US7783050B2/en active Active

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP0169134A1 (fr) * | 1984-07-20 | 1986-01-22 | Centre Technique Des Industries Mecaniques | Distributeur hydraulique proportionnel |

| WO2005069274A1 (en) | 2004-01-20 | 2005-07-28 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Apparatus and method for constructing a multi-channel output signal or for generating a downmix signal |

| WO2006048203A1 (en) * | 2004-11-02 | 2006-05-11 | Coding Technologies Ab | Methods for improved performance of prediction based multi-channel reconstruction |

| US20060140412A1 (en) | 2004-11-02 | 2006-06-29 | Lars Villemoes | Multi parametrisation based multi-channel reconstruction |

Also Published As

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| KR101111521B1 (ko) | 오디오 처리 방법 및 장치 | |

| RU2417549C2 (ru) | Способ и устройство для обработки аудиосигнала |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A201 | Request for examination | ||

| E902 | Notification of reason for refusal | ||

| E701 | Decision to grant or registration of patent right | ||

| GRNT | Written decision to grant | ||

| FPAY | Annual fee payment |

Payment date: 20141224 Year of fee payment: 4 |

|

| FPAY | Annual fee payment |

Payment date: 20151224 Year of fee payment: 5 |

|

| FPAY | Annual fee payment |

Payment date: 20161214 Year of fee payment: 6 |

|

| FPAY | Annual fee payment |

Payment date: 20171214 Year of fee payment: 7 |