JP7640552B2 - ニューラルネットワークのパラメータを符号化するための概念 - Google Patents

ニューラルネットワークのパラメータを符号化するための概念 Download PDFInfo

- Publication number

- JP7640552B2 JP7640552B2 JP2022538077A JP2022538077A JP7640552B2 JP 7640552 B2 JP7640552 B2 JP 7640552B2 JP 2022538077 A JP2022538077 A JP 2022538077A JP 2022538077 A JP2022538077 A JP 2022538077A JP 7640552 B2 JP7640552 B2 JP 7640552B2

- Authority

- JP

- Japan

- Prior art keywords

- neural network

- network parameters

- quantization

- current

- reconstruction

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/06—Physical realisation, i.e. hardware implementation of neural networks, neurons or parts of neurons

- G06N3/063—Physical realisation, i.e. hardware implementation of neural networks, neurons or parts of neurons using electronic means

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04L—TRANSMISSION OF DIGITAL INFORMATION, e.g. TELEGRAPHIC COMMUNICATION

- H04L47/00—Traffic control in data switching networks

- H04L47/10—Flow control; Congestion control

- H04L47/24—Traffic characterised by specific attributes, e.g. priority or QoS

- H04L47/2483—Traffic characterised by specific attributes, e.g. priority or QoS involving identification of individual flows

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/04—Architecture, e.g. interconnection topology

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/04—Architecture, e.g. interconnection topology

- G06N3/0495—Quantised networks; Sparse networks; Compressed networks

-

- G—PHYSICS

- G06—COMPUTING OR CALCULATING; COUNTING

- G06N—COMPUTING ARRANGEMENTS BASED ON SPECIFIC COMPUTATIONAL MODELS

- G06N3/00—Computing arrangements based on biological models

- G06N3/02—Neural networks

- G06N3/08—Learning methods

- G06N3/084—Backpropagation, e.g. using gradient descent

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/102—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or selection affected or controlled by the adaptive coding

- H04N19/124—Quantisation

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/10—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding

- H04N19/102—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals using adaptive coding characterised by the element, parameter or selection affected or controlled by the adaptive coding

- H04N19/13—Adaptive entropy coding, e.g. adaptive variable length coding [AVLC] or context adaptive binary arithmetic coding [CABAC]

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N19/00—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals

- H04N19/70—Methods or arrangements for coding, decoding, compressing or decompressing digital video signals characterised by syntax aspects related to video coding, e.g. related to compression standards

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Health & Medical Sciences (AREA)

- Life Sciences & Earth Sciences (AREA)

- Biomedical Technology (AREA)

- Biophysics (AREA)

- Computing Systems (AREA)

- Software Systems (AREA)

- Evolutionary Computation (AREA)

- General Health & Medical Sciences (AREA)

- Molecular Biology (AREA)

- Computational Linguistics (AREA)

- General Engineering & Computer Science (AREA)

- General Physics & Mathematics (AREA)

- Mathematical Physics (AREA)

- Data Mining & Analysis (AREA)

- Artificial Intelligence (AREA)

- Signal Processing (AREA)

- Multimedia (AREA)

- Neurology (AREA)

- Computer Networks & Wireless Communication (AREA)

- Compression Or Coding Systems Of Tv Signals (AREA)

- Compression, Expansion, Code Conversion, And Decoders (AREA)

- Apparatus For Radiation Diagnosis (AREA)

- Measurement Of The Respiration, Hearing Ability, Form, And Blood Characteristics Of Living Organisms (AREA)

- Executing Machine-Instructions (AREA)

Description

現在のニューラルネットワークパラメータについての量子化インデックス56がデータストリーム14中に量子化される1つの再構成レベルを示す現在のニューラルネットワークパラメータ13’についての量子化インデックス56を符号化することによって、ニューラルネットワークパラメータ13を順次符号化するよう構成される。任意選択で、複数50の再構成レベルセット52のうち、本明細書で時々量子化器とも呼ばれる再構成レベルセット52の数は、例えばセット0およびセット1を用いて示されるように、2つであることができる。

2.ロスレス符号化

3.ロスレス復号化

マルチメディアコンテンツの説明及び分析のためのニューラルネットワークの圧縮のためのMPEG-7パート17規格のワーキングドラフト2[2]は、ニューラルネットワークパラメータ符号化に独立スカラー量子化(independent scalar quantization)及びエントロピー符号化を適用している。

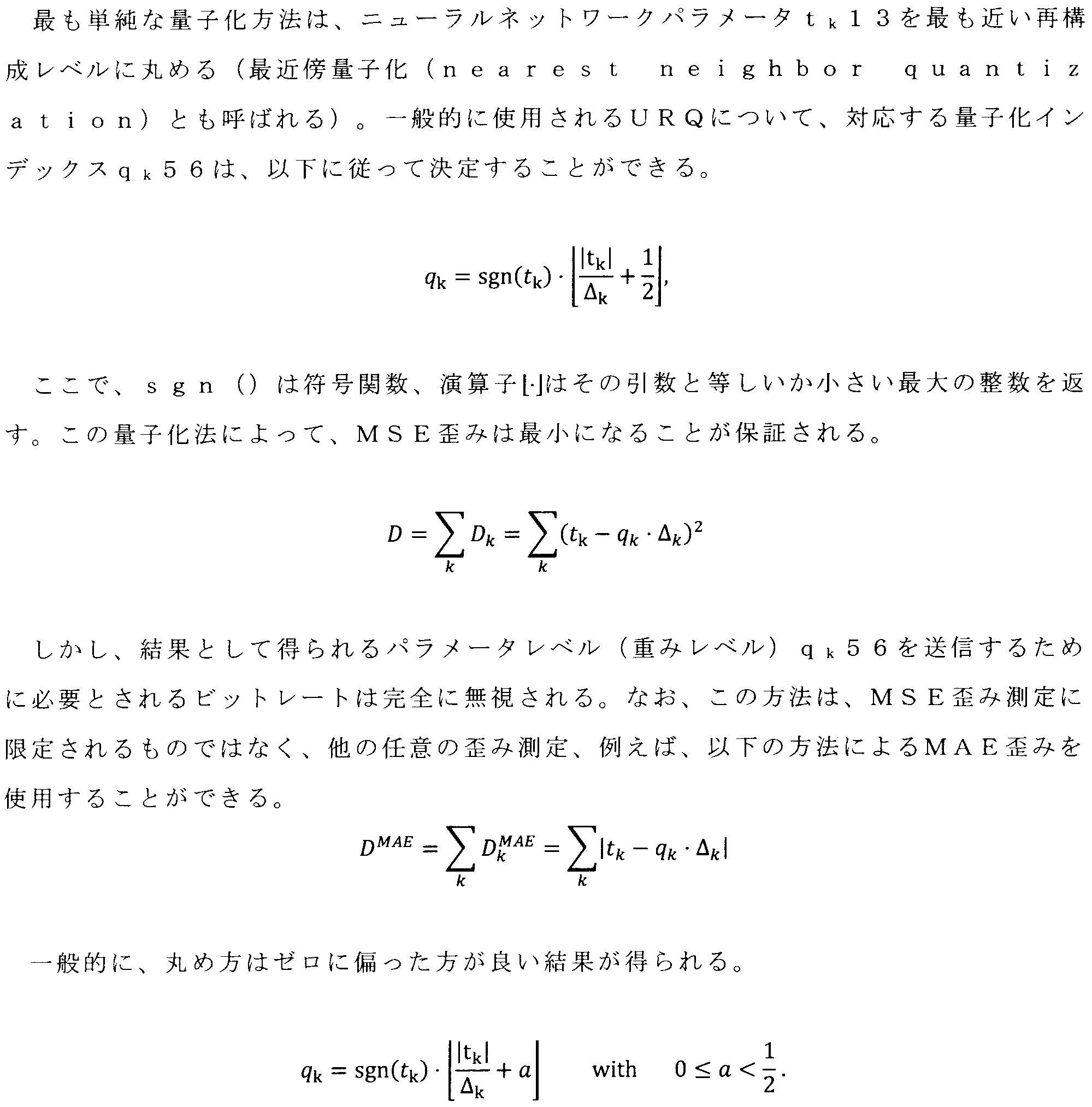

ニューラルネットワークのパラメータは、スカラ量子化器を用いて量子化される。量子化の結果、パラメータ13の許容値のセットは減少する。言い換えれば、ニューラルネットワークのパラメータは、いわゆる再構成レベルの可算集合(実際には有限集合)にマッピングされる。再構成レベルセットは、可能なニューラルネットワークパラメータ値のセット(集合)の適切なサブセット(部分集合)を表す。以下のエントロピー符号化を単純化するために、許容可能な再構成レベルは、量子化インデックス56によって表され、これはビットストリーム14の一部として伝送される。復号化器側では、量子化インデックス56は、再構成されたニューラルネットワークパラメータ13にマッピングされる。再構成されたニューラルネットワークパラメータ13の可能な値は、再構成レベルセット52に対応する。符号化器側では、スカラー量子化の結果は、1セットの(整数)量子化インデックス56である。

ニューラルネットワークの圧縮に関する標準規格は、ビットストリームのシンタックスと再構成プロセスのみを規定している。与えられたオリジナルのニューラルネットワークパラメータ13のセットと与えられた量子化ステップサイズ(QP)に対するパラメータ符号化を考える場合、符号化器は多くの自由度を有する。層10a、10bの量子化インデックスqk56が与えられると、エントロピー符号化は、データをビットストリーム14に書き込む(すなわち、算術符号語(コードワード)を構築する)ための一意に定義されたアルゴリズムに従わなければならない。しかし、重みパラメータのオリジナルセット(例えば層)が与えられた量子化インデックスqk56を得るための符号化アルゴリズムは、ニューラルネットワーク圧縮の規格の範囲外である。以下の説明では、各ニューラルネットワークパラメータ13の量子化ステップサイズ(QP)が既知であると仮定する。それでも、符号化器は、各ニューラルネットワーク(重み)パラメータtk13についての量子化器インデックスqk56を選択する自由を有する。量子化インデックスの選択は、歪み(または再構成/近似品質)とビットレートの両方を決定するので、使用される量子化アルゴリズムは、生成されるビットストリーム14のレート歪み性能に実質的な影響を与える。

前のステップで適用された均一量子化の結果として、重みパラメータはいわゆる再構成レベルの有限集合にマッピングされる。これらは、(整数)量子化器インデックス56(パラメータレベルまたは重みレベルとも呼ばれる)と量子化ステップサイズ(QP)によって表すことができ、例えば、全層に対して固定されている場合がある。層のすべての量子化された重みパラメータを復元するために、層のステップサイズ(QP)および次元は、復号化器によって知られてもよい。これらは、例えば、別々に送信されてもよい。

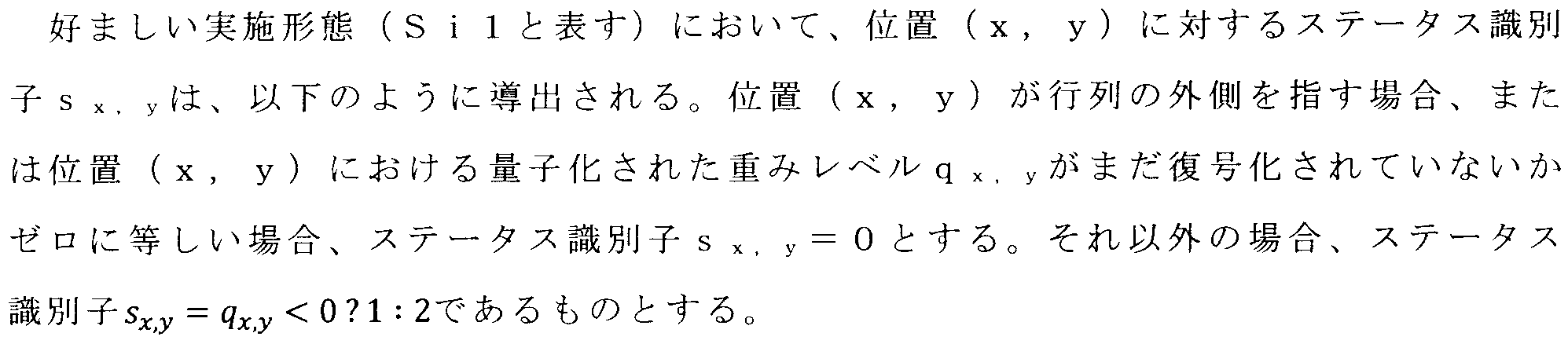

量子化インデックス56(整数表現)は、次にエントロピー符号化技術を使用して送信される。したがって、重みの層は、スキャンを使用して量子化された重みレベルのシーケンスにマッピングされる。例えば、行列の最上部の行から始めて、含まれる値を左から右へ符号化する、行ファーストスキャン順序(row first scan order)を使用することができる。この方法では、すべての行が上から下へ符号化される。スキャンは、ニューロン相互接続11の重みに関連し得るニューラルネットワークパラメータ13を含む行列15aについて、例えば共通の連続的な順番14’に沿って、図3に示すように実行されてもよい。行列は、重み層、例えば、図3及び図1にそれぞれ示すように、ニューロン相互接続11の層p-1 10aと層p 10bとの間の重み、又は隠れ層及び入力層との間の重みを表してもよい。なお、他の任意のスキャンを適用することができる。例えば、行列(例えば、図2又は図3の行列15a)は、行ファーストスキャンを適用する前に、転置され、又は水平及び/又は垂直に反転され、及び/又は左又は右に90/180/270度だけ回転されることができる。

CABACエントロピー符号化では、量子化された重みレベル56のほとんどのシンタックス要素は、2値確率モデリングを用いて符号化される。各2値決定(bin)はコンテキストと関連付けられている。コンテキストは、符号化されたビンのクラスに対する確率モデルを表す。2つの可能なビン値のうちの1つに対する確率は、対応するコンテキストで既に符号化されたビンの値に基づいて、各コンテキストについて推定される。アプリケーションに応じて、異なるコンテキストモデリングアプローチを適用することができる。通常、量子化された重み符号化に関連するいくつかのビンについて、符号化に使用されるコンテキストは、既に送信されたシンタックス要素に基づいて選択される。実際のアプリケーションに応じて、例えばSBMP 0、またはHEVC 0またはVTM-4.0 0のものなど、異なる確率推定器が選択され得る。この選択は、例えば、圧縮効率や複雑さに影響を与える。

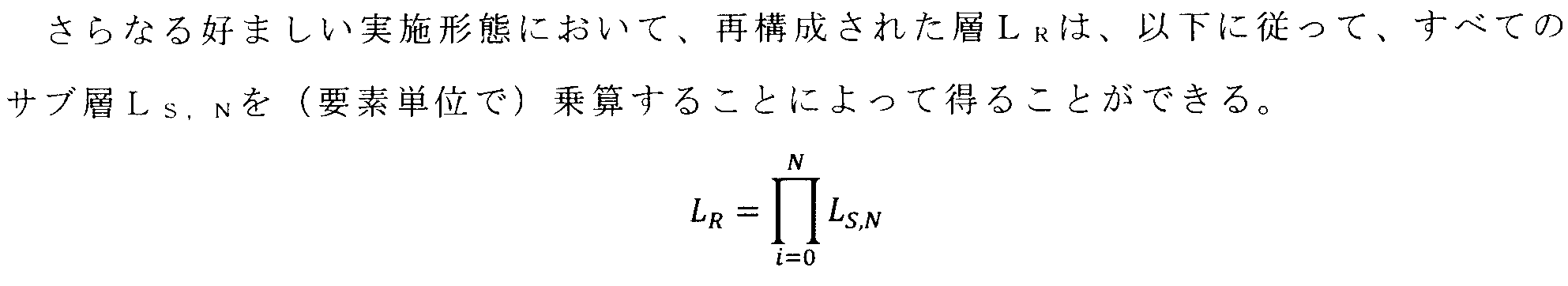

以下では、再構成された層、例えば図6からのニューラルネットワーク層pが、例えば別々に伝送されてもよい図6からの再構成層i-1および再構成層iのような異なるサブ層の構成である、ニューラルネットワーク10の圧縮/送信のための追加の、したがって任意の方法について説明する。

この概念では、ベース層とエンハンスメント層と呼ばれる2種類のサブ層を導入している。そして、再構成プロセス(例えば、すべてのサブ層を追加する)は、サブ層からどのように再構成された層を得ることができるかを定義する。ベース層はベース値を含み、例えば、最初のステップで効率的に表現または圧縮/送信できるように選択することができる。エンハンスメント層は、エンハンスメント情報、(例えばオリジナル層に関する)歪み指標を減少させるために例えば(ベース)層の値に追加される差分値を含む。別の例では、ベース層は(小さなトレーニングセットを用いたトレーニングからの)粗い値を含み、エンハンスメント層は(完全なトレーニングセットまたはより一般的には、別のトレーニングセットに基づく)リファインメント値を含む。サブ層は別々に保存/送信されてもよい。

このセクションでは、図2~図4の文脈で説明したような、本発明による概念および実施形態に対するさらなる任意の側面および特徴が開示される。

ニューラルネットワークパラメータの依存量子化の利点は、許容される再構成ベクトルがN次元信号空間(ここで、Nは、処理されるサンプルのセット、例えば層10a、10bにおけるサンプルまたはニューラルネットワークパラメータ13の数を表す)において密に詰め込まれることである。ニューラルネットワークパラメータセットの再構成ベクトルは、ニューラルネットワークパラメータセットの順序付けられた再構成されたニューラルネットワークパラメータ(または、代替的に、順序付けられた再構成されたサンプル)を指す。依存スカラー量子化の効果を、2つのニューラルネットワークパラメータの最も単純なケースについて図8で説明する。図8は、2つの重みパラメータの単純な場合について、許容される再構成ベクトルの位置の一例を示す図である。図8(a)は独立スカラ量子化の例、図8(b)は依存スカラ量子化の例である。図8aは、独立スカラ量子化の場合の許容再構成ベクトル201(2次元平面上の点を表す)を示している。見て分かるように、第2のニューラルネットワークパラメータt1’13に対する許容値のセットは、第1の再構成されたニューラルネットワークパラメータt0’13に対する選択された値には依存しない。図8(b)は、依存スカラー量子化の例を示す。独立スカラー量子化とは対照的に、第2のニューラルネットワークパラメータt1’13に対して選択可能な再構成値は、第1のニューラルネットワークパラメータt0’13に対して選択された再構成レベルに依存することに注意されたい。図8bの例では、第2のニューラルネットワークパラメータt1’13に対する利用可能な再構成レベルの2つの異なるセット52が存在する(異なる色で図示されている)。第1のニューラルネットワークパラメータt0’13に対する量子化インデックス56が偶数(...,-2,0,2,...)であれば、第1のセット(青い点)の任意の再構成レベル201aを第2のニューラルネットワークパラメータt1’13に対して選択することが可能である。そして、第1のニューラルネットワークパラメータt0’に対する量子化インデックス56が奇数(...,-3,-1,1,3,...)であれば、第2のセット(赤色点)の任意の再構成レベル201bを第2のニューラルネットワークパラメータt1’13に対して選択することが可能である。この例では、第1セットと第2セットの再構成レベルは、量子化ステップサイズの半分だけシフトされる(第2セットの任意の再構成レベルは、第1セットの2つの再構成レベルの間に位置する)。

主な変更点は、前述したように依存量子化である。再構成順序インデックスk>0の再構成されたニューラルネットワークパラメータtk’13は、関連する量子化インデックスqk56だけでなく、再構成順序において先行するニューラルネットワークパラメータの量子化インデックスq0,q1・・・,qk-1にも依存することになる。なお、依存量子化では、ニューラルネットワークパラメータ13の再構成順序を一意に定めなければならない。量子化インデックスqk56に関連する再構成レベルセットに関する知識もエントロピー符号化において利用される場合、ニューラルネットワーク符号化全体の性能は、典型的に改善され得る。つまり、ニューラルネットワークパラメータに適用される再構成レベルセットに基づいて、コンテキスト(確率モデル)またはコードワード表を切り替えることが典型的には好ましい。

ニューラルネットワークパラメータ13の依存量子化とは、ニューラルネットワークパラメータ13のために利用可能な再構成レベルセットが、再構成順序において(例えば層またはサブ層のようなニューラルネットワークパラメータの同じセットの内部において)先行するニューラルネットワークパラメータに対する選ばれた量子化インデックスに依存する概念をいう。

好ましい実施形態では、現在のニューラルネットワークパラメータのための許容される再構成レベルセットは、再構成レベルの予め定義されたセット52の集合(2つ以上のセット、例えば図2および図3からのセット0およびセット1)の中から(符号化順序において先行するニューラルネットワークパラメータの量子化インデックスに基づいて)選択される。

を導出することによって、及び、それぞれのニューラルネットワークパラメータ13について、それぞれのニューラルネットワークパラメータの中間値をそれぞれのニューラルネットワークパラメータ13についての所定の量子化ステップサイズに乗じることによって、ニューラルネットワークパネル13を逆量子化するよう構成されることがある。

符号化器が許容される再構成レベルの中から選択する再構成レベルは、ビットストリーム14の内部で示されなければならない。従来の独立スカラー量子化と同様に、これは、重みレベルとも呼ばれる、いわゆる量子化インデックス56を用いて実現することができる。量子化インデックス56(または重みレベル)は、量子化セット52の内部(すなわち、再構成レベルのセットの内部)で利用可能な再構成レベルを一意に識別する整数値である。量子化インデックス56は、(任意のエントロピー符号化技術を用いる)ビットストリーム14の一部として復号化器に送られる。復号化器側では、再構成されたニューラルネットワークパラメータ13は、再構成レベルの現在のセット48(これは、符号化/再構成順序において先行する量子化インデックスによって決定される)および現在のニューラルネットワークパラメータ13’に対する送信された量子化インデックス56に基づいて一意に計算することが可能である。

それぞれのニューラルネットワークパラメータについての選択された再構成レベルセットが第1のセットである場合、それぞれのニューラルネットワークパラメータに対する量子化インデックスを2倍して、それぞれのニューラルネットワークパラメータに対する中間値を求め;及び、

それぞれのニューラルネットワークパラメータについての選択された再構成レベルセットが2番目のセットであり、それぞれのニューラルネットワークパラメータの量子化インデックスがゼロに等しい場合、それぞれのサンプルの中間値をゼロに設定し;及び、

それぞれのニューラルネットワークパラメータについての選択された再構成レベルセットが第2のセットであり、それぞれのニューラルネットワークパラメータに対する量子化インデックスがゼロより大きい場合、それぞれのニューラルネットワークパラメータに対する量子化インデックスを2倍し、その乗算結果から1を引いてそれぞれのニューラルネットワークパラメータに対する中間値を得て、及び、

現在のニューラルネットワークパラメータについての選択された再構成レベルセットが第2のセットであり、それぞれのニューラルネットワークパラメータに対する量子化インデックスがゼロより小さい場合、それぞれのニューラルネットワークパラメータの量子化インデックスを2倍し、その乗算結果に1を加えて、それぞれのニューラルネットワークパラメータの中間値を得る。

4.3.1節および4.3.2節で説明した再構成レベルのセットの選択に加えて、ニューラルネットワークパラメータ符号化における依存スカラー量子化のもう一つの重要な設計側面は、定義された量子化セット(再構成レベルのセット)間の切り替えに使用するアルゴリズムである。使用されるアルゴリズムによって、ニューラルネットワークパラメータ13のN次元空間(したがって、再構成されたサンプルのN次元空間も同様)で達成できる「パッキング密度」が決まる。パッキング密度が高ければ高いほど、最終的に符号化効率が向上する。

- サブセットAは、量子化セット0のすべての偶数量子化インデックスから構成される。

- サブセットBは、量子化セット0のすべての奇数量子化インデックスから構成される。

- サブセットCは、量子化セット1のすべての偶数量子化インデックスから構成される。

- サブセットDは、量子化セット1のすべての奇数量子化インデックスで構成される。

・層のための第1の状態は、固定された事前定義された値に常に等しく設定される。好ましい実施形態では、第1の状態は0に等しく設定される。

・第1の状態の値は、ビットストリーム14の一部として明示的に送信される。これは、可能な状態値のサブセットのみが対応するシンタックス要素によって示され得るアプローチを含む。

・第1の状態の値は、その層の他のシンタックス要素に基づいて導出される。つまり、対応するシンタックス要素(またはシンタックス要素)が復号化器への他の態様のシグナリングに使用されても、それらは、依存スカラー量子化のための第1の状態を導出するために追加的に使用されることを意味する。

・状態0:前の量子化インデックスlevel[k-1]はセット0の再構成レベルを指定し、現在の量子化インデックスlevel[k]はセット0の再構成レベルを指定する。

・状態1:前の量子化インデックスlevel[k-1]はセット0の再構成レベルを指定し、現在の量子化インデックスlevel[k]はセット1の再構成レベルを指定する。

・状態2:前の量子化インデックスlevel[k-1]はセット1の再構成レベルを指定し、現在の量子化インデックスlevel[k]はセット0の再構成レベルを指定する。

・状態3:前の量子化インデックスlevel[k-1]はセット1の再構成レベルを指定し、現在の量子化インデックスlevel[k]はセット1の再構成レベルを指定する。

依存量子化によって得られた量子化インデックスは、エントロピー符号化方式によって符号化される。これには、任意のエントロピー符号化法が適用可能である。本発明の好ましい実施形態では、コンテキスト適応的2値算術符号化(CABAC)を用いた、第2.2節(符号化方法については第2.2.1節、復号化方法については第2.2.2節参照)によるエントロピー符号化方法が適用される。このために、例えば図5に示すように、量子化インデックスを絶対値として送信するために、まず非2値が一連の2値決定(いわゆるビン)上にマッピングされる(2値化)。

依存スカラー量子化の主な態様は、ニューラルネットワークパラメータ13のための許容される再構成レベルの異なるセット(量子化セットとも呼ばれる)が存在することである。現在のニューラルネットワークパラメータ13’に対する量子化セットは、先行するニューラルネットワークパラメータに対する量子化インデックス56の値に基づいて決定される。図11の好ましい例を考え、2つの量子化セットを比較すると、ゼロに等しい再構成レベルと隣接する再構成レベルとの間の距離は、セット0においてセット1よりも大きいことは明らかである。したがって、量子化インデックス56が0に等しい確率は、セット0が使用される場合により大きく、セット1が使用される場合により小さくなる。好ましい実施形態では、この効果は、現在の量子化インデックスに使用される量子化セット(または状態)に基づいてコードワード表または確率モデルを切り替えることによって、エントロピー符号化で利用される。

・量子化インデックスの絶対値は、適応型確率モデルを用いて符号化される多数のビンと、適応的に符号化されたビンが既に完全に絶対値を指定していない場合、算術符号化エンジンのバイパスモードで符号化されるサフィックス部分(全ビンに対してpmf(例えば確率質量関数)(0.5、0.5)を有する非適応型確率モデル)と、からなる2値方式を用いて送信される。好ましい実施形態では、サフィックス部分に使用される2値化は、既に送信された量子化インデックスの値に依存する。

・量子化インデックスの絶対値に対する2値化は、量子化インデックスが0に等しくないかどうかを指定する適応的に符号化されたビンを含む。このビンの符号化に用いられる確率モデル(コンテキストと呼ばれる)は、候補確率モデルのセットの中から選択される。選択された候補確率モデルは、現在の量子化インデックス56に対する量子化セット(許容再構成レベルのセット)または状態変数によって決定されるだけでなく、加えて、その層に対する既に送信された量子化インデックスによっても決定される。好ましい実施形態では、量子化セット(または状態変数)は、利用可能な確率モデルのサブセット(コンテキストセットとも呼ばれる)を決定し、既に符号化された量子化インデックスの値は、このサブセット(コンテキストセット)内において使用される確率モデルを決定する。

・局所近傍で0に等しくない量子化インデックスの符号。

・局所近傍領域で0に等しくない量子化インデックスの数。この数は最大値にクリップ(短縮化)される可能性がある。

・局所近傍における量子化インデックスの絶対値の合計。この数値は最大値にクリップされる可能性がある。

・局所近傍における量子化インデックスの絶対値の合計と、局所近傍における0に等しくない量子化インデックスの数との差。この数値は最大値にクリップされる可能性がある。

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に符号化されたニューラルネットワークパラメータのゼロでない量子化インデックスの符号。

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に符号化されたニューラルネットワークパラメータの量子化インデックスの数であって、ゼロでない数

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に符号化されたニューラルネットワークパラメータの量子化インデックスの絶対値の合計値

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に符号化されたニューラルネットワークパラメータの量子化インデックスの絶対値の合計と、

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に符号化されたニューラルネットワークパラメータの量子化インデックスの数であって、ゼロでない数と、

の間の差。

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータのゼロでない量子化インデックスの符号。

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの量子化インデックスの数であって、ゼロでない数。

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの量子化インデックスの絶対値の合計値。

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの量子化インデックスの絶対値の合計と、

現在のニューラルネットワークパラメータが関連する部分に隣接するニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの量子化インデックスの数であって、ゼロでない数と、

の差。

1.初期状態でのレート歪みコストを0に設定する。

2.符号化順序におけるすべてのニューラルネットワークのパラメータ13に対して、次のようにする。

a.各サブセットA、B、C、Dについて、与えられたオリジナルのニューラルネットワークパラメータ13に対する歪みを最小化する量子化インデックス56を決定する。

b.現在のニューラルネットワークパラメータ13’に対する全てのトレリスノード(0、1、2、3)に対して、以下を行う。

i 先行するニューラルネットワークパラメータ13の状態と現在の状態とを結ぶ2つのパスのレート歪みコストを計算する。コストは、先行する状態に対するコストと、Dk+λ・Rkの合計として与えられ、ここで、DkとRkは、考慮される接続に関連するサブセット(A、B、C、D)の量子化インデックスを選択するための歪みとレートを表す。

ii 計算されたコストの最小値を現在のノードに割り当て、最小コストのパスを表さない以前のニューラルネットワークパラメータ13の状態への接続を取り除く。

注:このステップの後、現在のニューラルネットワークパラメータ13’に対するすべてのノードは、先行するニューラルネットワークパラメータ13に対する任意のノードへの単一の接続を有する。

3.(符号化順序における最後のパラメータについての)4つの最終ノードのコストを比較し、コストが最小のノードを選択する。このノードは、トレリスを通るユニークなパスに関連していることに注意(他のすべての接続は以前のステップで取り除かれた)。

4.(最終ノードで指定される)選択したパスを逆順にたどり、トレリスノード間の接続に関連する量子化インデックス56を収集する。

・復号化されるテンソルの次元を指定する変数 tensorDims。

・復号化のためのエントリポイントが存在するかどうか、およびエントリポイントが存在する場合エントリポイントオフセットを示す変数 entryPointOffset。

・コードブックの有無と、コードブックが適用されるかどうか、及びコードブックが適用される場合はどのコードブックを使用するかを示す変数 codebookId。

このプロセスの出力は、TENSOR_FLOAT 型の変数recParamであり、次元はtensorDimsと等しい。

変数ctxIncは、以下のように導出される。

・sig_flagが0であれば、ctxIncにはstateId*3が設定される。

・そうでなければ、sign_flagが0に等しい場合、ctxIncはstateId*3+1に設定される。

・そうでなければ、ctxIncはstateId*3+2に設定される。

Claims (46)

- ニューラルネットワーク(10)を定義するニューラルネットワークパラメータ(13)をデータストリーム(14)から復号化するための装置であって、前記装置は、

前記データストリーム(14)から復号化された、以前のニューラルネットワークパラメータのための量子化インデックス(58)に依存して、現在のニューラルネットワークパラメータ(13’)について、複数(50)の再構成レベルセット(52)の中から再構成レベルセット(48)を選択(54)することと、

前記現在のニューラルネットワークパラメータについての選択された前記再構成レベルのセット(48)のうちの1つの再構成レベルを示す、前記現在のニューラルネットワークパラメータ(13’)のための量子化インデックス(56)を前記データストリーム(14)から復号化することと、

前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)によって示される前記選択された再構成レベルセット(48)のうちの前記1つの再構成レベルに前記現在のニューラルネットワークパラメータ(13’)を逆量子化(62)すること

により、前記ニューラルネットワークパラメータ(13’)を順次復号化するように構成され、

前記装置は、

前記現在のニューラルネットワークパラメータ(13’)に関連づけられた状態に応じて、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を決定すること、及び、

前記データストリームから復号化された、直前のニューラルネットワークパラメータのための前記量子化インデックス(58)に応じて、後続のニューラルネットワークパラメータの状態を更新すること

による状態遷移プロセスにより、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択(54)し、

前記現在のニューラルネットワークパラメータ(13’)の状態および以前に復号化されたニューラルネットワークパラメータの前記量子化インデックスに依存する(122)確率モデルを用いる算術符号化を用いて、前記データストリーム(14)から前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を復号化し、

前記現在のニューラルネットワークパラメータ(13’)に関連付けられた前記状態に依存して、複数の確率モデルの中から確率モデルのサブセットを事前選択し、以前に復号化されたニューラルネットワークパラメータのための前記量子化インデックスに依存して(121)、前記確率モデルのサブセットの中から前記現在のニューラルネットワークパラメータのための前記確率モデルを選択し、

前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの前記量子化インデックスの値に依存して、前記現在のニューラルネットワークパラメータのための確率モデルを第1、第2および第3の確率モデルを含むサブセットの中から選択する

ように構成され、

ここで、前記以前に復号化されたニューラルネットワークパラメータがゼロよりも小さければ、第1の確率モデルが選択され、

前記以前に復号化されたニューラルネットワークパラメータがゼロよりも大きければ、第2の確率モデルが選択され、

前記以前に復号化されたニューラルネットワークパラメータがゼロに等しければ、前記第3の確率モデルが選択される、

装置。 - 前記ニューラルネットワークパラメータ(13)が、前記ニューラルネットワーク(10)のニューロン相互接続(11)の重みに関連する、請求項1に記載の装置。

- 前記複数(50)の再構成レベルセット(52)のうちの再構成レベルセット(52)の数は2である、請求項1又は2に記載の装置。

- 前記複数(50)の再構成レベルセット(52)を既定の量子化ステップサイズ(QP)によりパラメータ化(60)し、前記データストリーム(14)から前記既定の量子化ステップサイズに関する情報を導出するように構成される、請求項1乃至3のいずれかに記載の装置。

- 前記ニューラルネットワークは1つ以上のNN層を含み、前記装置は、

それぞれのNN層(p;p-1)について、前記それぞれのNN層のための既定の量子化ステップサイズに関する情報を前記データストリーム(14)から導出し、

それぞれのNN層について、前記それぞれのNN層について導出された前記既定の量子化ステップサイズを使用して前記複数(50)の再構成レベルセット(52)をパラメータ化して、前記それぞれのNN層に属する前記ニューラルネットワークパラメータの逆量子化のために使用されるようにする

ように構成される、請求項1乃至4のいずれかに記載の装置。 - 前記複数(50)の再構成レベルセット(52)のうちの再構成レベルセット(52)の数は2であり、前記複数の再構成レベルセットは、

ゼロと既定の量子化ステップサイズの偶数倍とを含む第1の再構成レベルセット(セット0)と、

ゼロと前記既定の量子化ステップサイズの奇数倍とを含む第2の再構成レベルセット(セット1)と

を含む、請求項1乃至5のいずれかに記載の装置。 - すべての再構成レベルセットのすべての再構成レベルは、既定の量子化ステップサイズの整数倍を表し、前記装置は、

それぞれのニューラルネットワークパラメータについて、前記それぞれのニューラルネットワークパラメータについての前記選択された再構成レベルセットと、前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスをエントロピー復号化したものとに応じて中間整数値を導出すること、及び、

それぞれのニューラルネットワークパラメータについて、前記それぞれのニューラルネットワークパラメータについての前記中間整数値を、前記それぞれのニューラルネットワークパラメータのための前記既定の量子化ステップサイズで乗算すること

により、前記ニューラルネットワークパラメータを逆量子化するように構成される、請求項1乃至6のいずれかに記載の装置。 - 前記複数(50)の再構成レベルセット(52)のうちの再構成レベルセット(52)の数は2であり、前記装置は、

前記それぞれのニューラルネットワークパラメータについての前記選択された再構成レベルセットが第1のセットである場合、前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスを2倍して、前記それぞれのニューラルネットワークパラメータについての前記中間整数値を得ること、及び、

それぞれのニューラルネットワークパラメータについての前記選択された再構成レベルセットが第2のセットであり、かつ前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスがゼロに等しい場合、前記それぞれのニューラルネットワークパラメータについての前記中間整数値をゼロに等しく設定すること、及び、

それぞれのニューラルネットワークパラメータについての前記選択された再構成レベルセットが第2のセットであり、かつ前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスがゼロより大きい場合、前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスを2倍し、該乗算の結果から1を引いて前記それぞれのニューラルネットワークパラメータについての前記中間整数値を得ること、及び、

現在のニューラルネットワークパラメータについての前記選択された再構成レベルセットが第2のセットであり、前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスがゼロより小さい場合、前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスを2倍し、該乗算の結果に1を加えて、前記それぞれのニューラルネットワークパラメータについての前記中間整数値を得る

ことにより、それぞれのニューラルネットワークパラメータについての前記中間整数値を導出するように構成される、請求項7に記載の装置。 - 前記現在のニューラルネットワークパラメータ(13’)について、前記データストリーム(14)から復号化された、以前に復号化されたニューラルネットワークパラメータのための前記量子化インデックス(58)を2値化したもののLSB部分又は以前に復号化されたビンに応じて、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択する(54)ように構成される、請求項1乃至8のいずれかに記載の装置。

- 前記現在のニューラルネットワークパラメータ(13’)について、前記データストリーム(14)から復号化された、以前に復号化されたニューラルネットワークパラメータのための前記量子化インデックス(58)の2値関数の結果に応じて、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択する(54)ように構成される、請求項1乃至8のいずれかに記載の装置。

- 前記装置は、前記現在のニューラルネットワークパラメータ(13’)について、前記データストリーム(14)から復号化された、以前に復号化されたニューラルネットワークパラメータのための前記量子化インデックス(58)のパリティに応じて、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択する(54)ように構成される、請求項1乃至10のいずれかに記載の装置。

- 前記複数(50)の再構成レベルセット(52)のうちの前記再構成レベルセット(52)の数は2であり、前記装置は、

それぞれのニューラルネットワークパラメータのためのサブセットインデックスを、前記それぞれのニューラルネットワークパラメータについての前記選択された再構成レベルセットと、前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスの2値関数とに基づいて導き出し、前記サブセットインデックスについての4つの可能な値を生じさせ、

前記現在のニューラルネットワークパラメータ(13’)について、以前に復号化されたニューラルネットワークパラメータのための前記サブセットインデックスに応じて、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択する(54)

ように構成される、請求項1乃至11のいずれかに記載の装置。 - 前記装置は、前記現在のニューラルネットワークパラメータ(13’)について、複数の直前に復号化されたニューラルネットワークパラメータのための前記サブセットインデックスに依存する選択ルールを用いて、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択し(54)、前記選択ルールを前記ニューラルネットワークパラメータの一部または全部に対して使用するように構成される、請求項12に記載の装置。

- 前記選択ルールが依存する、前記直前に復号化されたニューラルネットワークパラメータの数は2である、請求項13に記載の装置。

- それぞれのニューラルネットワークパラメータのための前記サブセットインデックスは、前記それぞれのニューラルネットワークパラメータについての前記選択された再構成レベルセットと、前記それぞれのニューラルネットワークパラメータのための前記量子化インデックスのパリティとに基づいて導出される、請求項12乃至14のいずれかに記載の装置。

- 前記装置は、

前記現在のニューラルネットワークパラメータ(13’)について、前記現在のニューラルネットワークパラメータ(13’)に関連づけられた状態に応じて、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を決定すること、及び、

前記データストリームから復号化された、前記直前のニューラルネットワークパラメータのための前記量子化インデックス(58)に応じて、後続のニューラルネットワークパラメータの状態を更新すること

による状態遷移プロセスにより、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択する(54)ように構成される、請求項1乃至15のいずれかに記載の装置。 - 前記データストリームから復号化された、前記直前のニューラルネットワークパラメータのための前記量子化インデックス(58)の2値関数を用いて、前記後続の前記ニューラルネットワークパラメータの状態を更新するように構成される、請求項16に記載の装置。

- 前記データストリームから復号化された、前記直前のニューラルネットワークパラメータのための前記量子化インデックス(58)のパリティを使用して、前記後続のニューラルネットワークパラメータの状態を更新するように構成される、請求項16に記載の装置。

- 前記状態遷移プロセスは、4つ又は8つの可能な状態の間で遷移するように構成される、請求項16乃至18のいずれかに記載の装置。

- 前記状態遷移プロセスにおいて偶数の可能な状態の間で遷移し、前記複数(50)の再構成レベルセット(52)のうちの再構成レベルセット(52)の数が2であるように構成され、ここで、前記現在のニューラルネットワークパラメータ(13’)について、前記現在のニューラルネットワークパラメータ(13’)に関連づけられた前記状態に応じて、前記再構成レベルセット(52)のうちの前記再構成レベルセット(48)を決定することにより、前記状態が前記偶数の可能な状態のうちの前半に属する場合は前記複数(50)の再構成レベルセット(52)のうちの第1の再構成レベルセットが決定され、前記状態が前記偶数の可能な状態のうちの後半に属している場合は前記複数(50)の再構成レベルセット(52)のうちの第2の再構成レベルセットが決定される、請求項16乃至19のいずれかに記載の装置。

- 前記データストリームから復号化された、前記直前のニューラルネットワークパラメータの状態及び前記量子化インデックス(58)のパリティの組み合わせを、前記後続のニューラルネットワークパラメータに関連づけられた別の状態にマッピングする遷移テーブルによって、前記状態の更新を実行するように構成される、請求項16乃至20のいずれかに記載の装置。

- 前記現在のニューラルネットワークパラメータ(13’)について選択された前記再構成レベルセット(48)に依存する確率モデル(123)を用いる算術符号化を用いて、前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を前記データストリーム(14)から復号化するよう構成される、請求項1乃至21のいずれかに記載の装置。

- 前記量子化インデックス(56)を2値化したもの(82)の少なくとも1つのビン(84)についての前記現在のニューラルネットワークパラメータ(13’)の状態に依存する(122)前記確率モデルを用いることにより、2値算術符号化を用いて、前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)を前記データストリーム(14)から復号化するように構成される、請求項1乃至22のいずれかに記載の装置。

- 前記少なくとも1つのビンが、前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)がゼロに等しいか否かを示す有意性ビンを含む、請求項23に記載の装置。

- 前記少なくとも1つのビンが、前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)がゼロより大きいか又はゼロより小さいかを示す符号ビン(86)を含む、請求項23または請求項24に記載の装置。

- 前記少なくとも1つのビンが、前記現在のニューラルネットワークパラメータの前記量子化インデックス(56)の絶対値がXより大きいか否かを示す、greater-than-Xビンを含み、ここでXはゼロより大きい整数である、請求項23乃至25のいずれかに記載の装置。

- 前記確率モデルの依存性には、前記依存性を用いた、前記ニューラルネットワークパラメータについてのコンテキストセットのうちのコンテキスト(87)の選択(103)を含み、それぞれのコンテキストには既定の確率モデルが関連づけられているように構成される、請求項1乃至26のいずれかに記載の装置。

- 前記それぞれのコンテキストを用いて算術符号化された前記量子化インデックスに基づいて、前記コンテキストのそれぞれに関連付けられた前記既定の確率モデルを更新するように構成される、請求項27に記載の装置。

- 前記量子化インデックスを2値化したものの少なくとも1つのビンについて、前記現在のニューラルネットワークパラメータ(13’)について選択された前記再構成レベルセット(48)に依存する確率モデルを用いることによって、前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を前記データストリーム(14)から2値算術符号化を用いて復号化するように構成される、請求項1乃至28のいずれかに記載の装置。

- 前記少なくとも1つのビンは、前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)がゼロに等しいか否かを示す有意性ビンを含む、請求項29に記載の装置。

- 前記少なくとも1つのビンは、前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)がゼロより大きいか又はゼロより小さいかを示す符号ビンを含む、請求項29又は30に記載の装置。

- 前記少なくとも1つのビンが、前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)の絶対値がXより大きいか否かを示すgreater-than-Xビンを含み、ここでXはゼロより大きい整数である、請求項29乃至31のいずれかに記載の装置。

- 第1の状態又は再構成レベルセットについて事前選択されたサブセットが、任意の他の状態又は再構成レベルセットについて事前選択されたサブセットと互いに素であるように、前記複数の確率モデルの中から確率モデルの前記サブセットを、前記現在のニューラルネットワークパラメータ(13’)について選択された再構成レベルの前記状態又は前記再構成レベルセット(48)に依存して事前選択するように構成される、請求項1乃至32のいずれかに記載の装置。

- 前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの前記量子化インデックスに応じて、前記確率モデルのサブセットの中から前記現在のニューラルネットワークパラメータについての前記確率モデルを選択するように構成される、請求項1乃至33のいずれかに記載の装置。

- 前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータのための前記量子化インデックスの特性に依存して、前記確率モデルのサブセットの中から前記現在のニューラルネットワークパラメータについての前記確率モデルを選択するように構成され、前記特性は、

前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータのゼロでない量子化インデックスの符号と、

前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの量子化インデックスの数であって、ゼロでない数と、

前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの量子化インデックスの絶対値の合計値と、

前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの量子化インデックスの前記絶対値の合計値と、前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの量子化インデックスの数であって、ゼロでない数と、の差分と、

のうちの1つ以上を含む、請求項1乃至33のいずれかに記載の装置。 - 前記以前に復号化されたニューラルネットワークパラメータが前記現在のニューラルネットワークパラメータと同じニューラルネットワーク層に関連するように、前記以前に復号化されたニューラルネットワークパラメータを位置づけるように構成される、請求項34又は35に記載の装置。

- 1つ以上の前記以前に復号化されたニューラルネットワークパラメータが、前記現在のニューラルネットワークパラメータが参照するニューロン相互接続が関連するニューロンまたは該ニューロンに隣接する別のニューロンから出現するニューロン相互接続又はこれらのニューロンに向かうニューロン相互接続に関連するように、前記以前に復号化されたニューラルネットワークパラメータのうちの1つ以上のパラメータを位置付けるように構成される、請求項34又は35に記載の装置。

- 前記ニューラルネットワークパラメータ(13)のための前記量子化インデックス(56)を復号化し、前記ニューラルネットワークパラメータ(13)間の共通の連続的な順序(14’)に沿って前記ニューラルネットワークパラメータ(13)の前記逆量子化を実行するように構成される、請求項1乃至37のいずれかに記載の装置。

- 前記量子化インデックスを2値化したものの1つ以上のリーディングビン(leading bins)についての以前に復号化されたニューラルネットワークパラメータに依存する確率モデルを用いること、及び、前記1つ以上のリーディングビンに後続する、前記量子化インデックスを2値化したものの等確率バイパスモードサフィックスビンを用いることによって、前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を前記データストリーム(14)から2値算術符号化を用いて復号化するように構成される、請求項1乃至38のいずれかに記載の装置。

- 前記量子化インデックスを2値化したもののサフィックスビンは、絶対値が前記1つ以上の前記リーディングビンによって表現可能な最大絶対値を超える前記量子化インデックスの値を2値化するためのサフィックス2値化の2値化コードのビンを表し、前記装置は、以前に復号化されたニューラルネットワークパラメータの前記量子化インデックスに応じて前記サフィックス2値化を選択するように構成される、請求項39に記載の装置。

- 前記ニューラルネットワークパラメータは、前記ニューラルネットワーク(10)が表現される再構成層のうちの1つの再構成層に関連し、前記装置は、

前記ニューラルネットワークパラメータを、ニューラルネットワークパラメータ単位で、1つ以上の別の再構成層の対応するニューラルネットワークパラメータと組み合わせることによって、前記ニューラルネットワークを再構成するように構成される、

請求項1乃至40のいずれかに記載の装置。 - 前記現在のニューラルネットワークパラメータに対応する、対応ニューラルネットワークパラメータに依存する確率モデルを用いる算術符号化を用いて、前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を前記データストリーム(14)から復号化するように構成される、請求項41に記載の装置。

- ニューラルネットワークを定義するニューラルネットワークパラメータをデータストリームに符号化するための装置であって、

現在のニューラルネットワークパラメータ(13’)について、前記データストリーム(14)に符号化された、以前に符号化されたニューラルネットワークパラメータのための量子化インデックス(58)に依存して、複数(50)の再構成レベルセット(52)の中から再構成レベルセット(48)を選択(54)することと、

選択された前記再構成レベルセット(48)の1つの再構成レベル上に前記現在のニューラルネットワークパラメータ(13’)を量子化(64)することと、

前記現在のニューラルネットワークパラメータのための量子化インデックス(56)が量子化される前記1つの再構成レベルを示す、前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を前記データストリーム(14)に符号化することと

により、前記ニューラルネットワークパラメータ(13’)を順次符号化するように構成され、

前記装置は、

前記現在のニューラルネットワークパラメータ(13’)に関連づけられた状態に応じて、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を決定すること、及び、

前記データストリームに符号化された、直前のニューラルネットワークパラメータのための前記量子化インデックス(58)に応じて、後続のニューラルネットワークパラメータの状態を更新すること

による状態遷移プロセスにより、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択(54)し、

前記現在のニューラルネットワークパラメータ(13’)の状態および以前に符号化されたニューラルネットワークパラメータの前記量子化インデックスに依存する(122)確率モデルを用いる算術符号化を用いて、前記データストリーム(14)から前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を符号化し、

前記現在のニューラルネットワークパラメータ(13’)に関連付けられた前記状態に依存して、複数の確率モデルの中から確率モデルのサブセットを事前選択し、以前に符号化されたニューラルネットワークパラメータのための前記量子化インデックスに依存して(121)、前記確率モデルのサブセットの中から前記現在のニューラルネットワークパラメータのための前記確率モデルを選択し、

前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に符号化されたニューラルネットワークパラメータの前記量子化インデックスの値に依存して、前記現在のニューラルネットワークパラメータのための確率モデルを第1、第2および第3の確率モデルを含むサブセットの中から選択する

ように構成され、

ここで、前記以前に符号化されたニューラルネットワークパラメータがゼロよりも小さければ、前記第1の確率モデルが選択され、

前記以前に符号化されたニューラルネットワークパラメータがゼロよりも大きければ、前記第2の確率モデルが選択され、

前記以前に符号化されたニューラルネットワークパラメータがゼロに等しければ、前記第3の確率モデルが選択される、

装置。 - ニューラルネットワーク(10)を定義するニューラルネットワークパラメータ(13)をデータストリーム(14)から復号化するための方法(400)であって、

現在のニューラルネットワークパラメータ(13’)について、前記データストリーム(14)から復号化された、以前のニューラルネットワークパラメータのための量子化インデックス(58)に依存して、複数(50)の再構成レベルセット(52)の中から再構成レベルセット(48)を選択する(54)ことと、

前記現在のニューラルネットワークパラメータについての前記選択された再構成レベルセット(48)のうちの1つの再構成レベルを示す、前記現在のニューラルネットワークパラメータ(13’)のための量子化インデックス(56)を前記データストリーム(14)から復号化する(420)ことと、

前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)によって示される前記選択された再構成レベルセット(48)のうちの前記1つの再構成レベル上に前記現在のニューラルネットワークパラメータ(13’)を逆量子化する(62)ことと、

によって、前記ニューラルネットワークパラメータ(13)を順次復号化するステップを含み、

前記方法はさらに、

前記現在のニューラルネットワークパラメータ(13’)に関連づけられた状態に応じて、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を決定すること、及び、

前記データストリームから復号化された、直前のニューラルネットワークパラメータのための前記量子化インデックス(58)に応じて、後続のニューラルネットワークパラメータの状態を更新すること

による状態遷移プロセスにより、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択(54)するステップと、

前記現在のニューラルネットワークパラメータ(13’)の状態および以前に復号化されたニューラルネットワークパラメータの前記量子化インデックスに依存する(122)確率モデルを用いる算術符号化を用いて、前記データストリーム(14)から前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を復号化するステップと、

前記現在のニューラルネットワークパラメータ(13’)に関連付けられた前記状態に依存して、複数の確率モデルの中から確率モデルのサブセットを事前選択し、以前に復号化されたニューラルネットワークパラメータのための前記量子化インデックスに依存して(121)、前記確率モデルのサブセットの中から前記現在のニューラルネットワークパラメータのための前記確率モデルを選択するステップと、

前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に復号化されたニューラルネットワークパラメータの前記量子化インデックスの値に依存して、前記現在のニューラルネットワークパラメータのための確率モデルを第1、第2および第3の確率モデルを含むサブセットの中から選択するステップと

を含み、

ここで、前記以前に復号化されたニューラルネットワークパラメータがゼロよりも小さければ、前記第1の確率モデルが選択され、

前記以前に復号化されたニューラルネットワークパラメータがゼロよりも大きければ、前記第2の確率モデルが選択され、

前記以前に復号化されたニューラルネットワークパラメータがゼロに等しければ、前記第3の確率モデルが選択される、

方法。 - ニューラルネットワークを定義するニューラルネットワークパラメータをデータストリームに符号化するための方法(500)であって、

現在のニューラルネットワークパラメータ(13’)について、前記データストリーム(14)に符号化された、以前に符号化されたニューラルネットワークパラメータのための量子化インデックス(58)に依存して、複数(50)の再構成レベルセット(52)の中から再構成レベルセット(48)を選択(54)することと、

前記現在のニューラルネットワークパラメータ(13’)を、前記選択された再構成レベルセット(48)の1つの再構成レベル上に量子化する(64)ことと、

前記現在のニューラルネットワークパラメータのための量子化インデックス(56)が量子化される前記1つの再構成レベルを示す、前記現在のニューラルネットワークパラメータのための前記量子化インデックス(56)を前記データストリーム(14)に符号化する(530)ことと、

によって、前記ニューラルネットワークパラメータ(13)を順次符号化するステップを含み、

前記方法はさらに、

前記現在のニューラルネットワークパラメータ(13’)に関連づけられた状態に応じて、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を決定すること、及び、

前記データストリームに符号化された、直前のニューラルネットワークパラメータのための前記量子化インデックス(58)に応じて、後続のニューラルネットワークパラメータの状態を更新すること

による状態遷移プロセスにより、前記現在のニューラルネットワークパラメータ(13’)について、前記複数(50)の再構成レベルセット(52)の中から前記再構成レベルセット(48)を選択(54)するステップと、

前記現在のニューラルネットワークパラメータ(13’)の状態および以前に符号化されたニューラルネットワークパラメータの前記量子化インデックスに依存する(122)確率モデルを用いる算術符号化を用いて、前記現在のニューラルネットワークパラメータ(13’)のための前記量子化インデックス(56)を前記データストリーム(14)に符号化するステップと、

前記現在のニューラルネットワークパラメータ(13’)に関連付けられた前記状態に依存して、複数の確率モデルの中から確率モデルのサブセットを事前選択し、以前に符号化されたニューラルネットワークパラメータのための前記量子化インデックスに依存して(121)、前記確率モデルのサブセットの中から前記現在のニューラルネットワークパラメータのための前記確率モデルを選択するステップと、

前記現在のニューラルネットワークパラメータが関連する部分に隣接する前記ニューラルネットワークの部分に関連する、以前に符号化されたニューラルネットワークパラメータの前記量子化インデックスの値に依存して、前記現在のニューラルネットワークパラメータのための確率モデルを第1、第2および第3の確率モデルを含むサブセットの中から選択するステップと

を含み、

ここで、前記以前に符号化されたニューラルネットワークパラメータがゼロよりも小さければ、前記第1の確率モデルが選択され、

前記以前に符号化されたニューラルネットワークパラメータがゼロよりも大きければ、前記第2の確率モデルが選択され、

前記以前に符号化されたニューラルネットワークパラメータがゼロに等しければ、前記第3の確率モデルが選択される、

方法。 - プログラムが1つ以上のコンピュータ上で実行されるときに、請求項44又は45に記載の方法を実行するためのコンピュータプログラムを記憶した、非一時的デジタル記憶媒体。

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2024179366A JP7783376B2 (ja) | 2019-12-20 | 2024-10-11 | ニューラルネットワークのパラメータを符号化するための概念 |

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| EP19218862 | 2019-12-20 | ||

| EP19218862.1 | 2019-12-20 | ||

| PCT/EP2020/087489 WO2021123438A1 (en) | 2019-12-20 | 2020-12-21 | Concepts for coding neural networks parameters |

Related Child Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2024179366A Division JP7783376B2 (ja) | 2019-12-20 | 2024-10-11 | ニューラルネットワークのパラメータを符号化するための概念 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2023507502A JP2023507502A (ja) | 2023-02-22 |

| JP7640552B2 true JP7640552B2 (ja) | 2025-03-05 |

Family

ID=69104239

Family Applications (2)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2022538077A Active JP7640552B2 (ja) | 2019-12-20 | 2020-12-21 | ニューラルネットワークのパラメータを符号化するための概念 |

| JP2024179366A Active JP7783376B2 (ja) | 2019-12-20 | 2024-10-11 | ニューラルネットワークのパラメータを符号化するための概念 |

Family Applications After (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2024179366A Active JP7783376B2 (ja) | 2019-12-20 | 2024-10-11 | ニューラルネットワークのパラメータを符号化するための概念 |

Country Status (6)

| Country | Link |

|---|---|

| US (2) | US20220393986A1 (ja) |

| EP (1) | EP4078454A1 (ja) |

| JP (2) | JP7640552B2 (ja) |

| KR (1) | KR20220127261A (ja) |

| CN (1) | CN115087988A (ja) |

| WO (1) | WO2021123438A1 (ja) |

Families Citing this family (10)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US11037330B2 (en) * | 2017-04-08 | 2021-06-15 | Intel Corporation | Low rank matrix compression |

| CN115699020A (zh) * | 2020-06-05 | 2023-02-03 | 华为技术有限公司 | 用于神经网络的量化 |

| WO2021255567A1 (en) * | 2020-06-16 | 2021-12-23 | Nokia Technologies Oy | Guided probability model for compressed representation of neural networks |

| US20240056575A1 (en) * | 2020-12-22 | 2024-02-15 | Intellectual Discovery Co., Ltd. | Deep learning-based image coding method and device |

| JP7325015B2 (ja) * | 2021-03-24 | 2023-08-14 | パナソニックIpマネジメント株式会社 | 量子化方法、量子化装置、及び、プログラム |

| US11909975B2 (en) * | 2021-06-18 | 2024-02-20 | Tencent America LLC | Dependent scalar quantization with substitution in neural image compression |

| US20240419953A1 (en) * | 2021-10-13 | 2024-12-19 | Google Llc | Quantized machine-learning configuration information |

| EP4460967A1 (en) * | 2022-01-09 | 2024-11-13 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Concepts for encoding and decoding neural network parameters |

| EP4555721A1 (en) * | 2022-07-11 | 2025-05-21 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Encoder, decoder and methods for coding a data structure |

| KR20250047001A (ko) * | 2023-09-27 | 2025-04-03 | 삼성전자주식회사 | 심층 신경망 모델을 포함하는 전자 장치 및 그 동작 방법 |

Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2019185769A1 (en) | 2018-03-29 | 2019-10-03 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Dependent quantization |

Family Cites Families (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| AU2006201490B2 (en) * | 2005-04-19 | 2008-05-22 | Samsung Electronics Co., Ltd. | Method and apparatus for adaptively selecting context model for entropy coding |

| US7894523B2 (en) * | 2005-09-05 | 2011-02-22 | Lg Electronics Inc. | Method for modeling coding information of a video signal for compressing/decompressing coding information |

| US9584802B2 (en) * | 2012-04-13 | 2017-02-28 | Texas Instruments Incorporated | Reducing context coded and bypass coded bins to improve context adaptive binary arithmetic coding (CABAC) throughput |

| US20140003488A1 (en) * | 2012-06-30 | 2014-01-02 | Research In Motion Limited | Position-based context selection for greater-than-one flag decoding and encoding |

| US11451840B2 (en) * | 2018-06-18 | 2022-09-20 | Qualcomm Incorporated | Trellis coded quantization coefficient coding |

| KR20220075407A (ko) * | 2019-10-01 | 2022-06-08 | 프라운호퍼 게젤샤프트 쭈르 푀르데룽 데어 안겐반텐 포르슝 에. 베. | 뉴럴 네트워크 표현 형식 |

-

2020

- 2020-12-21 JP JP2022538077A patent/JP7640552B2/ja active Active

- 2020-12-21 WO PCT/EP2020/087489 patent/WO2021123438A1/en not_active Ceased

- 2020-12-21 EP EP20830246.3A patent/EP4078454A1/en active Pending

- 2020-12-21 CN CN202080094840.2A patent/CN115087988A/zh active Pending

- 2020-12-21 KR KR1020227025245A patent/KR20220127261A/ko not_active Ceased

-

2022

- 2022-06-17 US US17/843,772 patent/US20220393986A1/en active Pending

-

2024

- 2024-10-11 JP JP2024179366A patent/JP7783376B2/ja active Active

-

2025

- 2025-07-11 US US19/267,146 patent/US20250343764A1/en active Pending

Patent Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2019185769A1 (en) | 2018-03-29 | 2019-10-03 | Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V. | Dependent quantization |

Non-Patent Citations (2)

| Title |

|---|

| Marta Karczewicz et al.,CE8-related: Sign context modelling and level mapping for TS residual coding,Joint Video Experts Team (JVET),2019年03月21日,[JVET-N0455] (version 3) |

| Simon Wiedemann et al.,DeepCABAC: A universal compression algorithm for deep neural networks,arXiv,2019年07月27日,pp.1-18 |

Also Published As

| Publication number | Publication date |

|---|---|

| US20250343764A1 (en) | 2025-11-06 |

| JP2025016517A (ja) | 2025-02-04 |

| WO2021123438A1 (en) | 2021-06-24 |

| CN115087988A (zh) | 2022-09-20 |

| US20220393986A1 (en) | 2022-12-08 |

| KR20220127261A (ko) | 2022-09-19 |

| JP7783376B2 (ja) | 2025-12-09 |

| EP4078454A1 (en) | 2022-10-26 |

| JP2023507502A (ja) | 2023-02-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP7640552B2 (ja) | ニューラルネットワークのパラメータを符号化するための概念 | |

| Kirchhoffer et al. | Overview of the neural network compression and representation (NNR) standard | |

| US20250278604A1 (en) | Methods and apparatuses for compressing parameters of neural networks | |

| JP2025186542A (ja) | 更新モデルを使用して、ニューラルネットワークパラメーターを復号化する装置、方法及びコンピュータープログラム、並びにニューラルネットワークパラメーターを符号化する装置、方法及びコンピュータープログラム | |

| JP2025513886A (ja) | ニューラルネットワークの復号化パラメータを提供するためのデコーダ、エンコーダ、方法、及び並べ替えを使用するコンピュータプログラム | |

| US20240364362A1 (en) | Concepts for encoding and decoding neural network parameters | |

| Farkash et al. | Transform trellis coding of images at low bit rates | |

| Zhang | Codebook optimization in vector quantization |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20221019 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20221019 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20231130 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20231212 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20240312 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20240611 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20241011 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A821 Effective date: 20241011 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20241031 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20250121 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20250220 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 7640552 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |