JP6044079B2 - 情報処理装置、情報処理方法及びプログラム - Google Patents

情報処理装置、情報処理方法及びプログラム Download PDFInfo

- Publication number

- JP6044079B2 JP6044079B2 JP2012022707A JP2012022707A JP6044079B2 JP 6044079 B2 JP6044079 B2 JP 6044079B2 JP 2012022707 A JP2012022707 A JP 2012022707A JP 2012022707 A JP2012022707 A JP 2012022707A JP 6044079 B2 JP6044079 B2 JP 6044079B2

- Authority

- JP

- Japan

- Prior art keywords

- predetermined

- command

- information processing

- unit

- virtual

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/017—Gesture based interaction, e.g. based on a set of recognized hand gestures

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/0304—Detection arrangements using opto-electronic means

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/16—Sound input; Sound output

- G06F3/165—Management of the audio stream, e.g. setting of volume, audio stream path

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/20—Scenes; Scene-specific elements in augmented reality scenes

Description

1−1:AR仮想デスクトップアプリケーションについて

1−2:物体認識技術について

2:第1実施例(オブジェクト間の位置関係を利用したユーザインターフェース)

2−1:システム構成例

2−2:情報処理装置100の構成

2−3:情報処理装置100の動作

2−4:操作方法について

2−5:応用例

3:第2実施例(ジェスチャーを考慮した操作インターフェース)

3−1:システム構成例

3−2:情報処理装置100の構成

3−3:情報処理装置100の動作

3−4:操作方法について

4:ハードウェア構成例

5:まとめ

はじめに、本実施形態に関連する技術について紹介する。

まず、本実施形態に関連する技術の一例として、AR仮想デスクトップアプリケーションについて紹介する。この技術は、複合現実感(MR:Mixed Reality)技術を利用して表示画面外の空間領域を有効活用することが可能なユーザインターフェースに関する。以下、図1〜図4を参照しながら、当該技術について簡単に説明する。

物体認識は、図5に示すように、ユーザの装着したカメラCAの撮像画像に基づき、撮像画像に含まれる実オブジェクトの位置、姿勢、形状、種類などを物体認識装置により認識することで行われる。また、物体認識装置で用いられる物体認識技術としては、例えば、“Speeded−Up Robust Features(SURF)”などの技術が知られている。

本技術の第1実施例について説明する。同実施例は、オブジェクト間の位置関係を利用したユーザインターフェースの構成に関する。特に、CDケースのような実オブジェクトを利用した直感的なユーザインターフェースを実現するための仕組みに関する。

まず、第1実施例に係る技術を実現可能なシステムの構成例について説明する。当該システムは、例えば、撮像部101、情報処理装置100、表示部104、出力制御装置200、及び出力装置210により構成される。但し、情報処理装置100が撮像部101及び表示部104と一体に形成されていてもよい。また、出力装置210は、音声を出力する音声出力装置であってもよいし、画像を表示する表示装置であってもよい。また、情報処理装置100が有する一部又は全部の機能は、クラウドコンピューティングシステムにより実現されてもよい。以下、情報処理装置100の構成を中心に説明する。

図6を参照しながら、第1実施例に係る情報処理装置100の構成について説明する。図6は、情報処理装置100の機能構成について説明するための説明図である。図6に示すように、情報処理装置100は、撮像部101と、三次元情報解析部102と、仮想オブジェクト管理部103と、表示部104と、位置関係解析部105と、コマンド発行部106と、通信部107とを主に備える。

次に、図7を参照しながら、第1実施例に係る情報処理装置100の動作について説明する。図7は、第1実施例に係る情報処理装置100の動作について説明するための流れ図である。

次に、図8〜図12を参照しながら、第1実施例に係る情報処理装置100の機能を用いて実現可能なユーザインターフェースの例及びその操作方法について説明する。

まず、図8を参照しながら、実オブジェクトを仮想オブジェクト(ウィンドウ)に近づける操作方法について説明する。図8は、実オブジェクトと仮想オブジェクトとの位置関係に応じたコマンド発行処理について説明するための説明図である。図8に示すように、カメラCAが設けられたHMDを装着したユーザは、実オブジェクトR_OBJとしてCDを所望の位置に移動させることが可能である。

次に、図9を参照しながら、実オブジェクトを実オブジェクト(図9の例ではCDプレーヤ)に近づける操作方法について説明する。図9は、実オブジェクトと実オブジェクトとの位置関係に応じたコマンド発行処理について説明するための説明図である。図9に示すように、カメラCAが設けられたHMDを装着したユーザは、実オブジェクトR_OBJ1としてCDを所望の位置に移動させることが可能である。

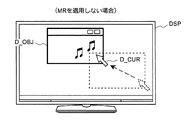

図8の例では、実オブジェクトR_OBJを仮想オブジェクトV_OBJに近づけて楽曲を再生するユーザインターフェースの例を挙げたが、図10に示すように、仮想オブジェクトV_OBJに代えて表示オブジェクトD_OBJを用いる構成も考えられる。この場合も、図8の例を参照しながら説明した処理の流れと実質的に同じ処理によって、オブジェクト間の位置関係に基づく楽曲の再生が実行される。なお、表示オブジェクトD_OBJは、カメラCAにより撮像される表示物であるから、実オブジェクトR_OBJの一例である。

これまでは実オブジェクトR_OBJの一例であるCDを、対象となるオブジェクト(CDプレーヤやウィンドウなど)に近づけ、そのCDに対応する楽曲を再生するユーザインターフェースについて説明してきた。しかし、CDに含まれる個々のトラックを指定して楽曲の再生を実行したい場合もあるだろう。そこで、図11に示すように、複数のトラックの中から所望のトラックを1つ選択して再生できるようにするユーザインターフェースを提案する。

図11の例では、ウィンドウに複数のトラックを示すアイコンを表示する方法を示した。しかし、仮想オブジェクトV_OBJを表示できる環境があることから、図12に示すように、実オブジェクトR_OBJであるCDの側に複数のトラックを示す仮想オブジェクトV_OBJを表示する方法も考えられる。例えば、CDケースの四隅に、トラック#1〜#4をそれぞれ示す仮想オブジェクトV_OBJを表示することが可能である。

上記の説明においては、CDの楽曲を再生するためのユーザインターフェースを例に挙げて説明を進めてきたが、本実施形態に係る技術の適用範囲はこれに限定されない。例えば、以下に例示する操作形態及び当該操作形態から実施時点における技術常識を考慮して想到可能な変形例についても、当然に本実施形態に係る技術の適用範囲に含まれる。

図14は、書籍実施形態に係る技術の応用例について説明するための説明図である。以下では、図14を参照しながら、ブックリーダへの応用例について説明する。この場合、書籍に関連する所定のコマンドを発行させたいユーザは、実オブジェクトである書籍をブックリーダのアプリケーションウインドウに近づけるなど、書籍とアプリケーションウインドウとを所定の位置関係にする。

以上では、主に操作対象となる実オブジェクト(以下、操作対象オブジェクト)がCDである場合について説明した。操作対象オブジェクトがCDである場合、制御対象コンテンツはCDに含まれる楽曲であり、出力先はAR音楽プレーヤであり、コマンド発行部106により発行されるコマンドはCDに含まれる楽曲を再生するためのコマンドである。

次に、本技術の第2実施例について説明する。同実施例は、第1実施例の構成に加え、実オブジェクトを利用したジェスチャーを組み合わせて、より複雑な操作を実現するための仕組みに関する。

まず、第2実施例に係る技術を実現可能なシステムの構成例について説明する。当該システムは、例えば、撮像部101、情報処理装置100、表示部104、出力制御装置200、及び出力装置210により構成される。但し、情報処理装置100が撮像部101及び表示部104と一体に形成されていてもよい。また、出力装置210は、音声を出力する音声出力装置であってもよいし、画像を表示する表示装置であってもよい。また、情報処理装置100が有する一部又は全部の機能は、クラウドコンピューティングシステムにより実現されてもよい。以下、情報処理装置100の構成を中心に説明する。

図18を参照しながら、第2実施例に係る情報処理装置100の構成について説明する。図18は、情報処理装置100の機能構成について説明するための説明図である。図18に示すように、情報処理装置100は、撮像部101と、三次元情報解析部102と、仮想オブジェクト管理部103と、表示部104と、位置関係解析部105と、コマンド発行部106と、通信部107とを主に備える。

次に、図19を参照しながら、第2実施例に係る情報処理装置100の動作について説明する。図19は、第2実施例に係る情報処理装置100の動作について説明するための流れ図である。

次に、図20及び図21を参照しながら、第2実施例に係る情報処理装置100の機能を用いて実現可能なユーザインターフェースの例及びその操作方法について説明する。

ジェスチャーを併用することで、より複雑な操作が可能になる。その一例として、図20に示すように、ウィンドウに表示された複数トラックに対応するアイコンの表示をジェスチャーにより切り替える操作が考えられる。例えば、実オブジェクトR_OBJであるCDケースを左右に振ったり、回転させたりする操作に応じて、トラックの選択画面が切り替わるように構成することができる。より具体的には、実オブジェクトR_OBJを右方向に振ったり、回転させたりすると、アイコンの列が右方向にスクロールするように表示制御する方法などが考えられる。

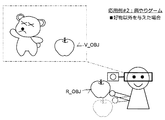

図20を参照しながら、ジェスチャーによりトラックの選択画面を切り替える操作について説明したが、ここでは実オブジェクトR_OBJに付随する仮想オブジェクトV_OBJの動きをジェスチャーで制御する方法を提案する。例えば、図21に示すように、実オブジェクトR_OBJを放る仕草をした場合に、実オブジェクトR_OBJに付随して表示された仮想オブジェクトV_OBJが飛ぶようにする仕組みが考えられる。この仕組みを適用すると、例えば、CDとCDプレーヤとが遠く離れている場合に、CDプレーヤに近づかなくてもCDの楽曲を再生することが可能になる。

上記の情報処理装置100が有する各構成要素の機能は、例えば、図22に示す情報処理装置のハードウェア構成を用いて実現することが可能である。つまり、当該各構成要素の機能は、コンピュータプログラムを用いて図22に示すハードウェアを制御することにより実現される。なお、このハードウェアの形態は任意であり、例えば、パーソナルコンピュータ、携帯電話、PHS、PDA等の携帯情報端末、ゲーム機、又は種々の情報家電がこれに含まれる。但し、上記のPHSは、Personal Handy−phone Systemの略である。また、上記のPDAは、Personal Digital Assistantの略である。

最後に、本実施形態の技術的思想について簡単に纏める。以下に記載する技術的思想は、例えば、PC、携帯電話、携帯ゲーム機、携帯情報端末、情報家電、カーナビゲーションシステム等、種々の情報処理装置に対して適用することができる。例えば、下記(1)のように表現される情報処理装置は、オブジェクト間の位置関係に基づいてコマンドが発行されるため、コマンド発行に際して直感的な操作が可能になる。さらに、発行されるコマンドに関する仮想オブジェクトが第1又は第2のオブジェクトに重畳表示されるため、その後に実行されるであろう処理の内容が事前に認識可能となり、安心感を持って操作することが可能になる。

ユーザが視認している第1のオブジェクトと、当該ユーザが位置を移動可能な第2のオブジェクトと、が所定の位置関係を成す場合に、前記第2のオブジェクトに対応付けられた所定のコマンドを発行するコマンド発行部と、

前記所定のコマンドに関する仮想オブジェクトを前記第1又は第2のオブジェクトに重畳表示させる表示制御部と、

を備える、

情報処理装置。

前記所定のコマンドを実行可能な機器に対して前記コマンド発行部により発行された所定のコマンドを送信するコマンド送信部をさらに備える、

前記(1)に記載の情報処理装置。

前記コマンド発行部は、前記第2のオブジェクトに対応付けられ、かつ、前記第1のオブジェクトにも対応付けられた所定のコマンドを発行する、

前記(1)又は前記(2)に記載の情報処理装置。

複数の前記仮想オブジェクトを前記第2のオブジェクトに重畳表示させる場合に、前記第2のオブジェクトの位置及び形状に基づいて前記各仮想オブジェクトの表示位置を決定する位置決定部を更に備え、

前記表示制御部は、前記位置決定部により決定された表示位置に前記各仮想オブジェクトを表示させる、

前記(1)〜(3)のいずれか1項に記載の情報処理装置。

前記表示制御部は、前記第1のオブジェクトと前記第2のオブジェクトとが前記所定の位置関係を成していない場合には第1の前記仮想オブジェクトを表示させ、前記第1のオブジェクトと前記第2のオブジェクトとが前記所定の位置関係を成している場合には当該第1の仮想オブジェクトとは異なる第2の前記仮想オブジェクトを表示させる、

前記(1)〜(4)のいずれか1項に記載の情報処理装置。

前記コマンド発行部は、前記第1のオブジェクトと前記第2のオブジェクトとの間の距離が所定の閾値以下となった場合に、前記所定の位置関係を成すものと判定して前記所定のコマンドを発行する、

前記(1)〜(5)のいずれか1項に記載の情報処理装置。

前記コマンド発行部は、前記第2のオブジェクトの移動パターンが所定の軌跡を描く場合に前記所定のコマンドを発行する、

前記(1)〜(5)のいずれか1項に記載の情報処理装置。

前記コマンド発行部は、前記所定の軌跡の種類に応じた所定のコマンドを発行する、

前記(7)に記載の情報処理装置。

前記コマンド発行部は、前記第2のオブジェクトが前記第1のオブジェクトを基準とした所定の位置関係を成し、かつ、前記第2のオブジェクトの移動パターンが所定の軌跡を描く場合に前記所定のコマンドを発行する、

前記(7)又は(8)に記載の情報処理装置。

前記コマンド発行部は、複数の前記所定のコマンドが前記第2のオブジェクトに対応付けられ、かつ、複数の前記仮想オブジェクトが前記第1のオブジェクトに重畳表示されている場合に、前記第2のオブジェクトと前記各仮想オブジェクトとの位置関係に応じて、発行する前記所定のコマンドを選択する、

前記(1)〜(5)のいずれか1項に記載の情報処理装置。

前記コマンド発行部は、複数の前記所定のコマンドが前記第2のオブジェクトに対応付けられ、かつ、複数の前記仮想オブジェクトが前記第2のオブジェクトに重畳表示されている場合に、前記第1のオブジェクトと前記各仮想オブジェクトとの位置関係に応じて、発行する前記所定のコマンドを選択する、

前記(1)〜(5)のいずれか1項に記載の情報処理装置。

前記コマンド発行部は、複数の前記所定のコマンドが前記第2のオブジェクトに対応付けられており、かつ、当該第2のオブジェクトが所定の軌跡を描く場合に、当該所定の軌跡に対応した前記所定のコマンドを発行する、

前記(1)〜(5)のいずれか1項に記載の情報処理装置。

前記第1のオブジェクトは、仮想空間内のオブジェクトである、

前記(1)〜(12)のいずれか1項に記載の情報処理装置。

前記第1のオブジェクトは、前記ユーザが位置を移動可能である、

前記(1)〜(13)のいずれか1項に記載の情報処理装置。

前記表示制御部は、前記ユーザが頭部に装着可能であり、かつ、当該ユーザが表示情報を視認可能にする表示部を有する頭部搭載型デバイスを制御して前記仮想オブジェクトを当該表示部に表示させる、

前記(1)〜(14)のいずれか1項に記載の情報処理装置。

前記頭部搭載型デバイスは、撮像部又はセンサをさらに有し、

前記第2のオブジェクトの位置は、前記撮像部により撮像された前記第2のオブジェクトの画像又は前記センサにより検知された前記第2のオブジェクトの検知結果に基づいて検出される、

前記(15)に記載の情報処理装置。

ユーザが視認している第1のオブジェクトと、当該ユーザが位置を移動可能な第2のオブジェクトと、が所定の位置関係を成す場合に、前記第2のオブジェクトに対応付けられた所定のコマンドを発行するステップと、

前記所定のコマンドに関する仮想オブジェクトを前記第1又は第2のオブジェクトに重畳表示させるステップと、

を含む、

情報処理方法。

コンピュータに、

ユーザが視認している第1のオブジェクトと、当該ユーザが位置を移動可能な第2のオブジェクトと、が所定の位置関係を成す場合に、前記第2のオブジェクトに対応付けられた所定のコマンドを発行するコマンド発行機能と、

前記所定のコマンドに関する仮想オブジェクトを前記第1又は第2のオブジェクトに重畳表示させる表示制御機能と、

を実現させるためのプログラム。

上記の位置関係解析部105及びコマンド発行部106は、コマンド発行部の一例である。上記の仮想オブジェクト管理部103は、表示制御部、位置決定部の一例である。上記の通信部107は、コマンド送信部の一例である。上記のHMDは、頭部搭載型デバイスの一例である。

101 撮像部

102 三次元情報解析部

103 仮想オブジェクト管理部

104 表示部

105 位置関係解析部

106 コマンド発行部

107 通信部

121 位置・姿勢検出部

122 オブジェクト識別部

123 動き認識部

131 仮想オブジェクト取得部

132 重畳位置制御部

200 出力制御装置

210 出力装置

Claims (17)

- 実世界の物体であって、ユーザが位置を移動可能な第2のオブジェクトを検出し、前記第2のオブジェクトの種類を認識する認識部と、

前記第2のオブジェクトの種類に基づいて、前記ユーザが視認可能な、仮想空間内のオブジェクトである第1のオブジェクトを取得し、表示させる管理部と、

前記ユーザが、前記第2のオブジェクトを前記第1のオブジェクトに近づけたことにより、前記第1のオブジェクトと前記第2のオブジェクトとが所定の位置関係を成す場合に、前記第2のオブジェクトに対応付けられた所定のコマンドを発行するコマンド発行部と、

前記所定のコマンドに関する仮想オブジェクトを前記第1又は第2のオブジェクトに重畳表示させる表示制御部と、

を備える、

情報処理装置。 - 前記所定のコマンドを実行可能な機器に対して前記コマンド発行部により発行された前記所定のコマンドを送信するコマンド送信部をさらに備える、

請求項1に記載の情報処理装置。 - 前記コマンド発行部は、前記第2のオブジェクトに対応付けられ、かつ、前記第1のオブジェクトにも対応付けられた前記所定のコマンドを発行する、

請求項1又は2に記載の情報処理装置。 - 複数の前記所定のコマンドに関する仮想オブジェクトを前記第2のオブジェクトに重畳表示させる場合に、前記第2のオブジェクトの位置及び形状に基づいて前記各所定のコマンドに関する仮想オブジェクトの表示位置を決定する位置決定部を更に備え、

前記表示制御部は、前記位置決定部により決定された前記表示位置に前記各仮想オブジェクトを表示させる、

請求項1から3のいずれか1項に記載の情報処理装置。 - 前記表示制御部は、前記第1のオブジェクトと前記第2のオブジェクトとが前記所定の位置関係を成していない場合には第1の前記所定のコマンドに関する仮想オブジェクトを表示させ、

前記第1のオブジェクトと前記第2のオブジェクトとが前記所定の位置関係を成している場合には当該第1の所定のコマンドに関する仮想オブジェクトとは異なる第2の前記所定のコマンドに関する仮想オブジェクトを表示させる、

請求項1から4のいずれか1項に記載の情報処理装置。 - 前記コマンド発行部は、前記第1のオブジェクトと前記第2のオブジェクトとの間の距離が所定の閾値以下となった場合に、前記第1のオブジェクトと前記第2のオブジェクトとが前記所定の位置関係を成すものと判定して前記所定のコマンドを発行する、

請求項1から5のいずれか1項に記載の情報処理装置。 - 前記コマンド発行部は、前記第2のオブジェクトの移動パターンが所定の軌跡を描く場合に前記所定のコマンドを発行する、

請求項1から5のいずれか1項に記載の情報処理装置。 - 前記コマンド発行部は、前記所定の軌跡の種類に応じた前記所定のコマンドを発行する、

請求項7に記載の情報処理装置。 - 前記コマンド発行部は、前記第2のオブジェクトが前記第1のオブジェクトを基準とした前記所定の位置関係を成し、かつ、前記第2のオブジェクトの前記移動パターンが前記所定の軌跡を描く場合に前記所定のコマンドを発行する、

請求項7又は8に記載の情報処理装置。 - 前記コマンド発行部は、複数の前記所定のコマンドが前記第2のオブジェクトに対応付けられ、かつ、複数の前記所定のコマンドに関する仮想オブジェクトが前記第1のオブジェクトに重畳表示されている場合に、前記第2のオブジェクトと前記各所定のコマンドに関する仮想オブジェクトとの位置関係に応じて、発行する前記所定のコマンドを選択する、

請求項1から5のいずれか1項に記載の情報処理装置。 - 前記コマンド発行部は、複数の前記所定のコマンドが前記第2のオブジェクトに対応付けられ、かつ、複数の前記所定のコマンドに関する仮想オブジェクトが前記第2のオブジェクトに重畳表示されている場合に、前記第1のオブジェクトと前記各所定のコマンドに関する仮想オブジェクトとの位置関係に応じて、発行する前記所定のコマンドを選択する、

請求項1から5のいずれか1項に記載の情報処理装置。 - 前記コマンド発行部は、複数の前記所定のコマンドが前記第2のオブジェクトに対応付けられており、かつ、当該第2のオブジェクトが所定の軌跡を描く場合に、当該所定の軌跡に対応した前記所定のコマンドを発行する、

請求項1から5のいずれか1項に記載の情報処理装置。 - 前記第1のオブジェクトは、前記ユーザが位置を移動可能である、

請求項1から12のいずれか1項に記載の情報処理装置。 - 前記表示制御部は、前記ユーザの頭部に装着可能であり、かつ、当該ユーザによって表示情報を視認することが可能なように当該表示情報を表示する表示部を有する頭部搭載型デバイスを制御して前記所定のコマンドに関する仮想オブジェクトを当該表示部に表示させる、

請求項1から13のいずれか1項に記載の情報処理装置。 - 前記頭部搭載型デバイスは、撮像部又はセンサをさらに有し、

前記第2のオブジェクトの位置は、前記撮像部により撮像された前記第2のオブジェクトの画像又は前記センサにより検知された前記第2のオブジェクトの検知結果に基づいて検出される、

請求項14に記載の情報処理装置。 - 実世界の物体であって、ユーザが位置を移動可能な第2のオブジェクトを検出し、前記第2のオブジェクトの種類を認識するステップと、

前記第2のオブジェクトの種類に基づいて、前記ユーザが視認可能な、仮想空間内のオブジェクトである第1のオブジェクトを取得し、表示させるステップと、

前記ユーザが、前記第2のオブジェクトを前記第1のオブジェクトに近づけたことにより、前記第1のオブジェクトと前記第2のオブジェクトとが所定の位置関係を成す場合に、前記第2のオブジェクトに対応付けられた所定のコマンドを発行するステップと、

前記所定のコマンドに関する仮想オブジェクトを前記第1又は第2のオブジェクトに重畳表示させるステップと、

を含む、

情報処理方法。 - コンピュータに、

実世界の物体であって、ユーザが位置を移動可能な第2のオブジェクトを検出し、前記第2のオブジェクトの種類を認識する認識機能と、

前記第2のオブジェクトの種類に基づいて、前記ユーザが視認可能な、仮想空間内のオブジェクトである第1のオブジェクトを取得し、表示させる管理機能と、

前記ユーザが、前記第2のオブジェクトを前記第1のオブジェクトに近づけたことにより、前記第1のオブジェクトと前記第2のオブジェクトとが所定の位置関係を成す場合に、前記第2のオブジェクトに対応付けられた所定のコマンドを発行するコマンド発行機能と、

前記所定のコマンドに関する仮想オブジェクトを前記第1又は第2のオブジェクトに重畳表示させる表示制御機能と、

を実現させるためのプログラム。

Priority Applications (5)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012022707A JP6044079B2 (ja) | 2012-02-06 | 2012-02-06 | 情報処理装置、情報処理方法及びプログラム |

| US14/356,306 US10401948B2 (en) | 2012-02-06 | 2013-01-29 | Information processing apparatus, and information processing method to operate on virtual object using real object |

| PCT/JP2013/000459 WO2013118457A1 (en) | 2012-02-06 | 2013-01-29 | Information processing apparatus, and information processing method |

| CN201380007190.3A CN104081319B (zh) | 2012-02-06 | 2013-01-29 | 信息处理设备和信息处理方法 |

| EP13708916.5A EP2812776B1 (en) | 2012-02-06 | 2013-01-29 | Information processing apparatus, and information processing method |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2012022707A JP6044079B2 (ja) | 2012-02-06 | 2012-02-06 | 情報処理装置、情報処理方法及びプログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2013161267A JP2013161267A (ja) | 2013-08-19 |

| JP2013161267A5 JP2013161267A5 (ja) | 2015-02-26 |

| JP6044079B2 true JP6044079B2 (ja) | 2016-12-14 |

Family

ID=47846100

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2012022707A Active JP6044079B2 (ja) | 2012-02-06 | 2012-02-06 | 情報処理装置、情報処理方法及びプログラム |

Country Status (5)

| Country | Link |

|---|---|

| US (1) | US10401948B2 (ja) |

| EP (1) | EP2812776B1 (ja) |

| JP (1) | JP6044079B2 (ja) |

| CN (1) | CN104081319B (ja) |

| WO (1) | WO2013118457A1 (ja) |

Families Citing this family (47)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2014191718A (ja) * | 2013-03-28 | 2014-10-06 | Sony Corp | 表示制御装置、表示制御方法および記録媒体 |

| WO2015075847A1 (ja) * | 2013-11-21 | 2015-05-28 | パナソニック インテレクチュアル プロパティ コーポレーション オブ アメリカ | 情報通信方法 |

| KR102227659B1 (ko) * | 2014-03-12 | 2021-03-15 | 삼성전자주식회사 | Hmd 장치를 통하여 가상 이미지를 디스플레이하는 시스템 및 방법 |

| US9934613B2 (en) * | 2014-04-29 | 2018-04-03 | The Florida International University Board Of Trustees | Systems for controlling a movable object |

| AU2015274283B2 (en) * | 2014-06-14 | 2020-09-10 | Magic Leap, Inc. | Methods and systems for creating virtual and augmented reality |

| US10852838B2 (en) | 2014-06-14 | 2020-12-01 | Magic Leap, Inc. | Methods and systems for creating virtual and augmented reality |

| JP6292181B2 (ja) * | 2014-06-27 | 2018-03-14 | キヤノンマーケティングジャパン株式会社 | 情報処理装置、情報処理システム、その制御方法及びプログラム |

| WO2016006070A1 (ja) * | 2014-07-09 | 2016-01-14 | 日立マクセル株式会社 | 携帯情報端末装置及びそれと連携するヘッドマウントディスプレイ |

| JP6512829B2 (ja) * | 2015-01-09 | 2019-05-15 | キヤノン株式会社 | 情報処理装置、情報処理方法及びプログラム |

| US9659381B2 (en) * | 2015-01-26 | 2017-05-23 | Daqri, Llc | Real time texture mapping for augmented reality system |

| US20170061700A1 (en) * | 2015-02-13 | 2017-03-02 | Julian Michael Urbach | Intercommunication between a head mounted display and a real world object |

| SG11201707278SA (en) * | 2015-03-20 | 2017-10-30 | Ricoh Co Ltd | Display apparatus, display control method, display control program, and display system |

| JP2016206695A (ja) * | 2015-04-15 | 2016-12-08 | 株式会社ウイズ | コンテンツ提供用のアプリケーションプログラムおよびコンテンツ提供方法 |

| CN107852488B (zh) | 2015-05-22 | 2021-03-30 | 三星电子株式会社 | 用于通过hmd设备显示虚拟图像的系统和方法 |

| EP4254145A3 (en) | 2015-09-16 | 2023-11-01 | Magic Leap, Inc. | Head pose mixing of audio files |

| US20170140215A1 (en) * | 2015-11-18 | 2017-05-18 | Le Holdings (Beijing) Co., Ltd. | Gesture recognition method and virtual reality display output device |

| CN105630160A (zh) * | 2015-12-21 | 2016-06-01 | 黄鸣生 | 虚拟现实使用界面系统 |

| US20170185142A1 (en) * | 2015-12-25 | 2017-06-29 | Le Holdings (Beijing) Co., Ltd. | Method, system and smart glove for obtaining immersion in virtual reality system |

| CN105718054B (zh) * | 2016-01-18 | 2019-05-10 | 天词信息科技(上海)有限公司 | 增强现实物的非接触式智能终端控制方法及装置、系统 |

| CN105955470A (zh) * | 2016-04-26 | 2016-09-21 | 乐视控股(北京)有限公司 | 一种头盔显示器的控制方法及装置 |

| CN105915766B (zh) * | 2016-06-07 | 2018-11-09 | 腾讯科技(深圳)有限公司 | 基于虚拟现实的控制方法和装置 |

| CN106200898A (zh) * | 2016-06-24 | 2016-12-07 | 张睿卿 | 虚拟现实软件平台系统 |

| JP6947177B2 (ja) * | 2016-07-05 | 2021-10-13 | ソニーグループ株式会社 | 情報処理装置、情報処理方法およびプログラム |

| CN106201222A (zh) * | 2016-08-09 | 2016-12-07 | 深圳市金立通信设备有限公司 | 一种虚拟现实界面的显示方法及终端 |

| EP3299931A1 (en) * | 2016-09-27 | 2018-03-28 | Alcatel Lucent | Altered-reality control method and altered-reality control system |

| US10732797B1 (en) * | 2017-01-10 | 2020-08-04 | Lucasfilm Entertainment Company Ltd. | Virtual interfaces for manipulating objects in an immersive environment |

| AU2018244316B2 (en) * | 2017-03-28 | 2022-09-29 | Magic Leap, Inc. | Augmented reality system with spatialized audio tied to user manipulated virtual object |

| US11144114B2 (en) * | 2017-05-11 | 2021-10-12 | Sony Corporation | Information processing apparatus and information processing method |

| US10429949B2 (en) * | 2017-06-30 | 2019-10-01 | Htc Corporation | User interaction apparatus and method |

| CN107993292B (zh) * | 2017-12-19 | 2021-08-31 | 北京盈拓文化传媒有限公司 | 增强现实场景复原方法、装置及计算机可读存储介质 |

| AU2019231697B2 (en) | 2018-03-07 | 2020-01-30 | Magic Leap, Inc. | Visual tracking of peripheral devices |

| US10635895B2 (en) * | 2018-06-27 | 2020-04-28 | Facebook Technologies, Llc | Gesture-based casting and manipulation of virtual content in artificial-reality environments |

| US11288733B2 (en) * | 2018-11-14 | 2022-03-29 | Mastercard International Incorporated | Interactive 3D image projection systems and methods |

| JP7223776B2 (ja) * | 2019-01-24 | 2023-02-16 | マクセル株式会社 | 表示端末、アプリケーション制御システムおよびアプリケーション制御方法 |

| KR20200093213A (ko) * | 2019-01-28 | 2020-08-05 | 삼성전자주식회사 | 전자 장치 및 전자 장치의 그래픽 객체 제어 방법 |

| WO2020243056A1 (en) | 2019-05-29 | 2020-12-03 | Raitonsa Dynamics Llc | Generating content for physical elements |

| JP7335221B2 (ja) * | 2019-08-20 | 2023-08-29 | 株式会社Cygames | 画像認識モデルを用いた識別子情報推論のための電子装置、方法、プログラム及びシステム |

| JP6967041B2 (ja) * | 2019-08-20 | 2021-11-17 | 株式会社Cygames | 画像認識モデルを用いた識別子情報推論のための電子装置、方法、プログラム及びシステム |

| CN113711175A (zh) * | 2019-09-26 | 2021-11-26 | 苹果公司 | 呈现计算机生成现实环境的可穿戴电子设备 |

| WO2021084882A1 (ja) * | 2019-10-28 | 2021-05-06 | ソニー株式会社 | 情報処理装置、および情報処理方法、並びにプログラム |

| JP6935531B1 (ja) * | 2020-04-01 | 2021-09-15 | エヌエイチエヌ コーポレーション | 情報処理プログラムおよび情報処理システム |

| US20210358294A1 (en) * | 2020-05-15 | 2021-11-18 | Microsoft Technology Licensing, Llc | Holographic device control |

| US11768535B1 (en) * | 2020-05-18 | 2023-09-26 | Apple Inc. | Presenting computer-generated content based on extremity tracking |

| JP2022110648A (ja) * | 2021-01-19 | 2022-07-29 | 株式会社東芝 | 情報処理システム、情報処理方法およびプログラム |

| JP2022118501A (ja) * | 2021-02-02 | 2022-08-15 | キヤノン株式会社 | 表示システム、表示装置とその制御方法及びプログラム |

| US11954774B2 (en) * | 2021-08-29 | 2024-04-09 | Snap Inc. | Building augmented reality experiences with IoT devices |

| US11941231B2 (en) | 2021-08-29 | 2024-03-26 | Snap Inc. | Camera interfaces to interact with IoT devices |

Family Cites Families (67)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JPH07175587A (ja) * | 1993-10-28 | 1995-07-14 | Hitachi Ltd | 情報処理装置 |

| US5732227A (en) * | 1994-07-05 | 1998-03-24 | Hitachi, Ltd. | Interactive information processing system responsive to user manipulation of physical objects and displayed images |

| US6002808A (en) * | 1996-07-26 | 1999-12-14 | Mitsubishi Electric Information Technology Center America, Inc. | Hand gesture control system |

| US5838326A (en) * | 1996-09-26 | 1998-11-17 | Xerox Corporation | System for moving document objects in a 3-D workspace |

| US6373968B2 (en) * | 1997-06-06 | 2002-04-16 | Oki Electric Industry Co., Ltd. | System for identifying individuals |

| US6118887A (en) * | 1997-10-10 | 2000-09-12 | At&T Corp. | Robust multi-modal method for recognizing objects |

| JP2000350865A (ja) * | 1999-06-11 | 2000-12-19 | Mr System Kenkyusho:Kk | 複合現実空間のゲーム装置、その画像処理方法およびプログラム記憶媒体 |

| JP4332964B2 (ja) * | 1999-12-21 | 2009-09-16 | ソニー株式会社 | 情報入出力システム及び情報入出力方法 |

| US6771294B1 (en) * | 1999-12-29 | 2004-08-03 | Petri Pulli | User interface |

| US7215322B2 (en) * | 2001-05-31 | 2007-05-08 | Siemens Corporate Research, Inc. | Input devices for augmented reality applications |

| GB2377147A (en) * | 2001-06-27 | 2002-12-31 | Nokia Corp | A virtual reality user interface |

| US6757411B2 (en) * | 2001-08-16 | 2004-06-29 | Liska Biometry Inc. | Method and system for fingerprint encoding and authentication |

| US7340077B2 (en) * | 2002-02-15 | 2008-03-04 | Canesta, Inc. | Gesture recognition system using depth perceptive sensors |

| US6738631B1 (en) * | 2002-05-06 | 2004-05-18 | Nokia, Inc. | Vision-guided model-based point-and-click interface for a wireless handheld device |

| US7874917B2 (en) | 2003-09-15 | 2011-01-25 | Sony Computer Entertainment Inc. | Methods and systems for enabling depth and direction detection when interfacing with a computer program |

| WO2005066744A1 (en) * | 2003-12-31 | 2005-07-21 | Abb Research Ltd | A virtual control panel |

| US7519223B2 (en) * | 2004-06-28 | 2009-04-14 | Microsoft Corporation | Recognizing gestures and using gestures for interacting with software applications |

| WO2007132451A2 (en) * | 2006-05-11 | 2007-11-22 | Prime Sense Ltd. | Modeling of humanoid forms from depth maps |

| US7805015B2 (en) * | 2006-10-27 | 2010-09-28 | International Business Machines Corporation | Method of point identification and tracking in a digital video environment |

| US7971156B2 (en) * | 2007-01-12 | 2011-06-28 | International Business Machines Corporation | Controlling resource access based on user gesturing in a 3D captured image stream of the user |

| US8861834B2 (en) * | 2007-03-09 | 2014-10-14 | Omron Corporation | Computer implemented method for recognizing an object based on a correspondence relationship between object feature points and pre-registered model feature points |

| US7909248B1 (en) * | 2007-08-17 | 2011-03-22 | Evolution Robotics Retail, Inc. | Self checkout with visual recognition |

| US8427424B2 (en) * | 2008-09-30 | 2013-04-23 | Microsoft Corporation | Using physical objects in conjunction with an interactive surface |

| JP2010145861A (ja) * | 2008-12-19 | 2010-07-01 | Brother Ind Ltd | ヘッドマウントディスプレイ |

| US20100208033A1 (en) * | 2009-02-13 | 2010-08-19 | Microsoft Corporation | Personal Media Landscapes in Mixed Reality |

| US8428311B2 (en) * | 2009-02-25 | 2013-04-23 | Honda Motor Co., Ltd. | Capturing and recognizing hand postures using inner distance shape contexts |

| EP2410485B1 (en) * | 2009-03-17 | 2019-01-09 | Fujitsu Limited | Data collating device and program |

| US9195898B2 (en) * | 2009-04-14 | 2015-11-24 | Qualcomm Incorporated | Systems and methods for image recognition using mobile devices |

| US8189925B2 (en) * | 2009-06-04 | 2012-05-29 | Microsoft Corporation | Geocoding by image matching |

| JP5263049B2 (ja) | 2009-07-21 | 2013-08-14 | ソニー株式会社 | 情報処理装置、および情報処理方法、並びにプログラム |

| EP2339537B1 (en) * | 2009-12-23 | 2016-02-24 | Metaio GmbH | Method of determining reference features for use in an optical object initialization tracking process and object initialization tracking method |

| US20110181497A1 (en) * | 2010-01-26 | 2011-07-28 | Roni Raviv | Object related augmented reality play system |

| US8947455B2 (en) * | 2010-02-22 | 2015-02-03 | Nike, Inc. | Augmented reality design system |

| JP2011203823A (ja) * | 2010-03-24 | 2011-10-13 | Sony Corp | 画像処理装置、画像処理方法及びプログラム |

| US20110234631A1 (en) * | 2010-03-25 | 2011-09-29 | Bizmodeline Co., Ltd. | Augmented reality systems |

| CN102822770B (zh) | 2010-03-26 | 2016-08-17 | 惠普发展公司,有限责任合伙企业 | 关联文件 |

| JP5743416B2 (ja) * | 2010-03-29 | 2015-07-01 | ソニー株式会社 | 情報処理装置、情報処理方法、およびプログラム |

| US20110254765A1 (en) * | 2010-04-18 | 2011-10-20 | Primesense Ltd. | Remote text input using handwriting |

| US8593402B2 (en) * | 2010-04-30 | 2013-11-26 | Verizon Patent And Licensing Inc. | Spatial-input-based cursor projection systems and methods |

| JP2011244058A (ja) | 2010-05-14 | 2011-12-01 | Sony Corp | 情報処理装置、情報処理システム、及びプログラム |

| US20120011142A1 (en) * | 2010-07-08 | 2012-01-12 | Qualcomm Incorporated | Feedback to improve object recognition |

| US8818025B2 (en) * | 2010-08-23 | 2014-08-26 | Nokia Corporation | Method and apparatus for recognizing objects in media content |

| KR101607419B1 (ko) * | 2010-08-27 | 2016-03-29 | 인텔 코포레이션 | 원격 제어 장치 |

| US8615136B2 (en) * | 2010-10-08 | 2013-12-24 | Industrial Technology Research Institute | Computing device and method for motion detection |

| US8578299B2 (en) * | 2010-10-08 | 2013-11-05 | Industrial Technology Research Institute | Method and computing device in a system for motion detection |

| US20120113223A1 (en) * | 2010-11-05 | 2012-05-10 | Microsoft Corporation | User Interaction in Augmented Reality |

| US9529424B2 (en) * | 2010-11-05 | 2016-12-27 | Microsoft Technology Licensing, Llc | Augmented reality with direct user interaction |

| KR101669119B1 (ko) * | 2010-12-14 | 2016-10-25 | 삼성전자주식회사 | 다층 증강 현실 시스템 및 방법 |

| US20120170800A1 (en) * | 2010-12-30 | 2012-07-05 | Ydreams - Informatica, S.A. | Systems and methods for continuous physics simulation from discrete video acquisition |

| US20120224060A1 (en) * | 2011-02-10 | 2012-09-06 | Integrated Night Vision Systems Inc. | Reducing Driver Distraction Using a Heads-Up Display |

| US8666195B1 (en) * | 2011-03-15 | 2014-03-04 | Google Inc. | Image alignment |

| US8493353B2 (en) * | 2011-04-13 | 2013-07-23 | Longsand Limited | Methods and systems for generating and joining shared experience |

| US8843346B2 (en) * | 2011-05-13 | 2014-09-23 | Amazon Technologies, Inc. | Using spatial information with device interaction |

| WO2012166814A1 (en) * | 2011-05-31 | 2012-12-06 | Honda Motor Co., Ltd. | Online environment mapping |

| US8223088B1 (en) * | 2011-06-09 | 2012-07-17 | Google Inc. | Multimode input field for a head-mounted display |

| US8773513B2 (en) * | 2011-07-01 | 2014-07-08 | Seiko Epson Corporation | Context and epsilon stereo constrained correspondence matching |

| US20130044912A1 (en) * | 2011-08-19 | 2013-02-21 | Qualcomm Incorporated | Use of association of an object detected in an image to obtain information to display to a user |

| US9218063B2 (en) * | 2011-08-24 | 2015-12-22 | Apple Inc. | Sessionless pointing user interface |

| US8453075B2 (en) * | 2011-09-02 | 2013-05-28 | International Business Machines Corporation | Automated lithographic hot spot detection employing unsupervised topological image categorization |

| US9053483B2 (en) * | 2011-09-30 | 2015-06-09 | Microsoft Technology Licensing, Llc | Personal audio/visual system providing allergy awareness |

| US9255813B2 (en) * | 2011-10-14 | 2016-02-09 | Microsoft Technology Licensing, Llc | User controlled real object disappearance in a mixed reality display |

| US8963805B2 (en) * | 2012-01-27 | 2015-02-24 | Microsoft Corporation | Executable virtual objects associated with real objects |

| US20140068526A1 (en) * | 2012-02-04 | 2014-03-06 | Three Bots Ltd | Method and apparatus for user interaction |

| JP6208151B2 (ja) * | 2012-02-06 | 2017-10-04 | ソニー インタラクティブ エンタテインメント ヨーロッパ リミテッド | 拡張現実のためのブックオブジェクト |

| GB2500416B8 (en) * | 2012-03-21 | 2017-06-14 | Sony Computer Entertainment Europe Ltd | Apparatus and method of augmented reality interaction |

| US9696547B2 (en) * | 2012-06-25 | 2017-07-04 | Microsoft Technology Licensing, Llc | Mixed reality system learned input and functions |

| US10025486B2 (en) * | 2013-03-15 | 2018-07-17 | Elwha Llc | Cross-reality select, drag, and drop for augmented reality systems |

-

2012

- 2012-02-06 JP JP2012022707A patent/JP6044079B2/ja active Active

-

2013

- 2013-01-29 WO PCT/JP2013/000459 patent/WO2013118457A1/en active Application Filing

- 2013-01-29 US US14/356,306 patent/US10401948B2/en active Active

- 2013-01-29 CN CN201380007190.3A patent/CN104081319B/zh active Active

- 2013-01-29 EP EP13708916.5A patent/EP2812776B1/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| CN104081319A (zh) | 2014-10-01 |

| JP2013161267A (ja) | 2013-08-19 |

| CN104081319B (zh) | 2017-08-25 |

| US10401948B2 (en) | 2019-09-03 |

| WO2013118457A1 (en) | 2013-08-15 |

| US20150022444A1 (en) | 2015-01-22 |

| EP2812776A1 (en) | 2014-12-17 |

| EP2812776B1 (en) | 2019-12-04 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP6044079B2 (ja) | 情報処理装置、情報処理方法及びプログラム | |

| US9626103B2 (en) | Systems and methods for identifying media portions of interest | |

| JP5962547B2 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| CN102770828B (zh) | 用于人机界面的控制柄交互 | |

| US9229533B2 (en) | Information processing apparatus, method, and program for gesture recognition and control | |

| CN104145233B (zh) | 通过照相机模块跟踪用户的头部来控制屏幕的方法和设备、及其计算机可读记录介质 | |

| US9761277B2 (en) | Playback state control by position change detection | |

| JP2020534592A (ja) | 仮想カメラを制御するシステム及び方法 | |

| US20120102438A1 (en) | Display system and method of displaying based on device interactions | |

| TW201525835A (zh) | 顯示控制裝置、顯示控制方法及程式 | |

| CN101833391A (zh) | 信息处理设备、信息处理方法及程序 | |

| KR20200100046A (ko) | 정보 처리 장치, 정보 처리 방법 및 프로그램 | |

| EP3352051A1 (en) | Information processing device, information processing method, and program | |

| KR20140081636A (ko) | 콘텐트 재생 방법 및 이를 위한 단말 | |

| CN106796810A (zh) | 在用户界面上从视频选择帧 | |

| JP6414079B2 (ja) | 情報処理システム、情報処理方法およびプログラム | |

| WO2017134868A1 (ja) | 情報処理装置、情報処理方法およびプログラム | |

| CN110235093A (zh) | 经由语义抽象的对铰链式设备的导航性辅助 | |

| US20120229375A1 (en) | Display device, display method and recording medium | |

| US10976912B2 (en) | Information processing device, information processing method, and recording medium | |

| WO2014162757A1 (ja) | 情報処理装置、タグ付け方法及びプログラム | |

| KR20170093644A (ko) | 휴대용 단말기 및 그 제어방법 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20150107 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20150107 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20160219 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20160301 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20160415 |

|

| A02 | Decision of refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A02 Effective date: 20160809 |

|

| A521 | Written amendment |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20160920 |

|

| A911 | Transfer to examiner for re-examination before appeal (zenchi) |

Free format text: JAPANESE INTERMEDIATE CODE: A911 Effective date: 20160929 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20161018 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20161031 |

|

| R151 | Written notification of patent or utility model registration |

Ref document number: 6044079 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R151 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |