JP4777182B2 - 複合現実感提示装置及びその制御方法、プログラム - Google Patents

複合現実感提示装置及びその制御方法、プログラム Download PDFInfo

- Publication number

- JP4777182B2 JP4777182B2 JP2006210255A JP2006210255A JP4777182B2 JP 4777182 B2 JP4777182 B2 JP 4777182B2 JP 2006210255 A JP2006210255 A JP 2006210255A JP 2006210255 A JP2006210255 A JP 2006210255A JP 4777182 B2 JP4777182 B2 JP 4777182B2

- Authority

- JP

- Japan

- Prior art keywords

- pointing

- virtual

- image

- pointing device

- measuring

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/011—Arrangements for interaction with the human body, e.g. for user immersion in virtual reality

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/03—Arrangements for converting the position or the displacement of a member into a coded form

- G06F3/033—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor

- G06F3/0354—Pointing devices displaced or positioned by the user, e.g. mice, trackballs, pens or joysticks; Accessories therefor with detection of 2D relative movements between the device, or an operating part thereof, and a plane or surface, e.g. 2D mice, trackballs, pens or pucks

- G06F3/03542—Light pens for emitting or receiving light

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/70—Determining position or orientation of objects or cameras

- G06T7/73—Determining position or orientation of objects or cameras using feature-based methods

Landscapes

- Engineering & Computer Science (AREA)

- Theoretical Computer Science (AREA)

- General Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Human Computer Interaction (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Processing Or Creating Images (AREA)

- Position Input By Displaying (AREA)

Description

撮像装置が撮像した現実画像に仮想画像を合成して提示する複合現実感提示装置であって、

ポインティング装置が指示する方向により現実物体上を指している位置であるポインティング位置を、当該ポインティング装置の位置姿勢情報に基づいて計測する第一計測手段と、

前記現実物体上の前記ポインティング位置を前記撮像装置が撮像して得られる撮像画像中の前記ポインティング位置と、該撮像装置の位置姿勢情報とに基づいて、該ポインティング位置を計測する第二計測手段と、

前記第一計測手段と前記第二計測手段との計測結果に基づいて、前記ポインティング装置の指示する現実ポインティング位置を計測する現実ポインティング位置計測手段と、

前記ポインティング装置の位置姿勢情報に基づいて、当該ポインティング装置と同一の始点から同一の方向に、仮想物体を指示する仮想ポインティング装置を生成する生成手段と、

前記仮想ポインティング装置が指示する方向により前記仮想物体上を指している位置である仮想ポインティング位置を、当該仮想ポインティング装置の指示する始点及び方向と前記仮想物体の情報とに基づいて計測する仮想ポインティング位置計測手段と

を備える。

前記判定手段の判定結果に基づいて、前記ポインティング装置の駆動、及び前記仮想ポインティング位置を示す指標の表示を制御する制御手段と

を更に備える。

撮像装置が撮像した現実画像に仮想画像を合成して提示する複合現実感提示装置の制御方法であって、

第一計測手段が、ポインティング装置が指示する方向により現実物体上を指している位置であるポインティング位置を、当該ポインティング装置の位置姿勢情報に基づいて計測する第一計測工程と、

第二計測手段が、前記現実物体上の前記ポインティング位置を前記撮像装置が撮像して得られる撮像画像中の前記ポインティング位置と、該撮像装置の位置姿勢情報とに基づいて、該ポインティング位置を計測する第二計測工程と、

現実ポインティング位置計測手段が、前記第一計測工程と前記第二計測工程との計測結果に基づいて、前記ポインティング装置の指示する現実ポインティング位置を計測する現実ポインティング位置計測工程と、

生成手段が、前記ポインティング装置の位置姿勢情報に基づいて、当該ポインティング装置と同一の始点から同一の方向に、仮想物体を指示する仮想ポインティング装置を生成する生成工程と、

仮想ポインティング位置計測手段が、前記仮想ポインティング装置が指示する方向により前記仮想物体上を指している位置である仮想ポインティング位置を、当該仮想ポインティング装置の指示する始点及び方向と前記仮想物体の情報とに基づいて計測する仮想ポインティング位置計測工程と

を備える。

撮像装置が撮像した現実画像に仮想画像を合成して提示する複合現実感提示装置の制御をコンピュータに実行させるための、コンピュータ可読媒体に記憶されたプログラムであって、

前記コンピュータを

ポインティング装置が指示する方向により現実物体上を指している位置であるポインティング位置を、当該ポインティング装置の位置姿勢情報に基づいて計測する第一計測手段と、

前記現実物体上の前記ポインティング位置を前記撮像装置が撮像して得られる撮像画像中の前記ポインティング位置と、該撮像装置の位置姿勢情報とに基づいて、該ポインティング位置を計測する第二計測手段と、

前記第一計測手段と前記第二計測手段との計測結果に基づいて、前記ポインティング装置の指示する現実ポインティング位置を計測する現実ポインティング位置計測手段と、

前記ポインティング装置の位置姿勢情報に基づいて、当該ポインティング装置と同一の始点から同一の方向に、仮想物体を指示する仮想ポインティング装置を生成する生成手段と、

前記仮想ポインティング装置が指示する方向により前記仮想物体上を指している位置である仮想ポインティング位置を、当該仮想ポインティング装置の指示する始点及び方向と前記仮想物体の情報とに基づいて計測する仮想ポインティング位置計測手段と

して機能させる。

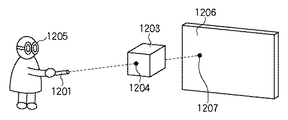

実施形態1では、体験者が複合現実世界の中で仮想物体と現実物体を一つのポインティング装置でシームレスにポインティングと計測を行う構成を実現するものである。

実施形態2を説明するにあたり、図9を用いて、従来の複合現実感提示装置の利用例について説明する。

102 現実画像入力部

103 撮像装置位置姿勢管理部

104 現実ポインティング画像位置計測部

105 現実ポインティング位置計測部

106 ポインティング装置位置姿勢管理部

107 現実ポインティング位置計測部

108 仮想ポインティング装置生成部

109 仮想物体管理部

110 仮想ポインティング位置計測部

120 ポインティング装置

121 撮像装置

Claims (11)

- 撮像装置が撮像した現実画像に仮想画像を合成して提示する複合現実感提示装置であって、

ポインティング装置が指示する方向により現実物体上を指している位置であるポインティング位置を、当該ポインティング装置の位置姿勢情報に基づいて計測する第一計測手段と、

前記現実物体上の前記ポインティング位置を前記撮像装置が撮像して得られる撮像画像中の前記ポインティング位置と、該撮像装置の位置姿勢情報とに基づいて、該ポインティング位置を計測する第二計測手段と、

前記第一計測手段と前記第二計測手段との計測結果に基づいて、前記ポインティング装置の指示する現実ポインティング位置を計測する現実ポインティング位置計測手段と、

前記ポインティング装置の位置姿勢情報に基づいて、当該ポインティング装置と同一の始点から同一の方向に、仮想物体を指示する仮想ポインティング装置を生成する生成手段と、

前記仮想ポインティング装置が指示する方向により前記仮想物体上を指している位置である仮想ポインティング位置を、当該仮想ポインティング装置の指示する始点及び方向と前記仮想物体の情報とに基づいて計測する仮想ポインティング位置計測手段と

を備えることを特徴とする複合現実感提示装置。 - 前記現実ポインティング位置計測手段と前記仮想ポインティング位置計測手段との計測結果に基づいて、前記現実画像と前記仮想画像を合成して表示する表示手段を更に備える

ことを特徴とする請求項1に記載の複合現実感提示装置。 - 前記表示手段は、更に、前記仮想ポインティング位置を示す指標を前記仮想画像上に表示する

ことを特徴とする請求項2に記載の複合現実感提示装置。 - 前記第二計測手段は、前記ポインティング装置が指示する方向により現実物体上を指している位置であるポインティング位置を、複数の前記撮像装置それぞれが撮像して得られる撮像画像中の前記ポインティング位置と、該複数の撮像装置それぞれの位置姿勢情報に基づいて、計測する

ことを特徴とする請求項1に記載の複合現実感提示装置。 - 前記現実ポインティング位置を示す位置情報と、前記仮想ポインティング位置を示す位置情報とを取得して、両者間の距離を算出する算出手段を更に備える

ことを特徴とする請求項1に記載の複合現実感提示装置。 - 前記仮想ポインティング装置が指示する方向に前記仮想画像が存在するか否かを判定する判定手段と、

前記判定手段の判定結果に基づいて、前記ポインティング装置の駆動、及び前記仮想ポインティング位置を示す指標の表示を制御する制御手段と

を更に備えることを特徴とする請求項1に記載の複合現実感提示装置。 - 前記判定手段の判定の結果、前記仮想ポインティング装置が指示する方向に前記仮想画像が存在する場合、前記ポインティング装置の駆動を停止し、及び前記仮想ポインティング位置を示す指標を前記仮想画像上に表示する

ことを特徴とする請求項6に記載の複合現実感提示装置。 - 前記判定手段の判定の結果、前記仮想ポインティング装置が指示する方向に前記仮想画像が存在しない場合、前記ポインティング装置を駆動し、及び前記仮想ポインティング位置を示す指標の表示を禁止する

ことを特徴とする請求項6に記載の複合現実感提示装置。 - 前記判定手段の判定の結果、前記仮想ポインティング装置が指示する方向に前記仮想画像が存在しない場合、前記ポインティング装置を駆動し、及び前記仮想ポインティング位置を示す指標の表示形態を、前記仮想ポインティング装置が指示する方向に前記仮想画像が存在する場合の前記仮想ポインティング位置を示す指標の表示形態と異ならせて表示する

ことを特徴とする請求項6に記載の複合現実感提示装置。 - 撮像装置が撮像した現実画像に仮想画像を合成して提示する複合現実感提示装置の制御方法であって、

第一計測手段が、ポインティング装置が指示する方向により現実物体上を指している位置であるポインティング位置を、当該ポインティング装置の位置姿勢情報に基づいて計測する第一計測工程と、

第二計測手段が、前記現実物体上の前記ポインティング位置を前記撮像装置が撮像して得られる撮像画像中の前記ポインティング位置と、該撮像装置の位置姿勢情報とに基づいて、該ポインティング位置を計測する第二計測工程と、

現実ポインティング位置計測手段が、前記第一計測工程と前記第二計測工程との計測結果に基づいて、前記ポインティング装置の指示する現実ポインティング位置を計測する現実ポインティング位置計測工程と、

生成手段が、前記ポインティング装置の位置姿勢情報に基づいて、当該ポインティング装置と同一の始点から同一の方向に、仮想物体を指示する仮想ポインティング装置を生成する生成工程と、

仮想ポインティング位置計測手段が、前記仮想ポインティング装置が指示する方向により前記仮想物体上を指している位置である仮想ポインティング位置を、当該仮想ポインティング装置の指示する始点及び方向と前記仮想物体の情報とに基づいて計測する仮想ポインティング位置計測工程と

を備えることを特徴とする複合現実感提示装置の制御方法。 - 撮像装置が撮像した現実画像に仮想画像を合成して提示する複合現実感提示装置の制御をコンピュータに機能させるための、コンピュータ可読媒体に記憶されたプログラムであって、

前記コンピュータを、

ポインティング装置が指示する方向により現実物体上を指している位置であるポインティング位置を、当該ポインティング装置の位置姿勢情報に基づいて計測する第一計測手段と、

前記現実物体上の前記ポインティング位置を前記撮像装置が撮像して得られる撮像画像中の前記ポインティング位置と、該撮像装置の位置姿勢情報とに基づいて、該ポインティング位置を計測する第二計測手段と、

前記第一計測手段と前記第二計測手段との計測結果に基づいて、前記ポインティング装置の指示する現実ポインティング位置を計測する現実ポインティング位置計測手段と、

前記ポインティング装置の位置姿勢情報に基づいて、当該ポインティング装置と同一の始点から同一の方向に、仮想物体を指示する仮想ポインティング装置を生成する生成手段と、

前記仮想ポインティング装置が指示する方向により前記仮想物体上を指している位置である仮想ポインティング位置を、当該仮想ポインティング装置の指示する始点及び方向と前記仮想物体の情報とに基づいて計測する仮想ポインティング位置計測手段と

して機能させることを特徴とするプログラム。

Priority Applications (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006210255A JP4777182B2 (ja) | 2006-08-01 | 2006-08-01 | 複合現実感提示装置及びその制御方法、プログラム |

| US11/830,356 US20080030461A1 (en) | 2006-08-01 | 2007-07-30 | Mixed reality presentation apparatus and control method thereof, and program |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2006210255A JP4777182B2 (ja) | 2006-08-01 | 2006-08-01 | 複合現実感提示装置及びその制御方法、プログラム |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2008040556A JP2008040556A (ja) | 2008-02-21 |

| JP2008040556A5 JP2008040556A5 (ja) | 2009-07-16 |

| JP4777182B2 true JP4777182B2 (ja) | 2011-09-21 |

Family

ID=39028649

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2006210255A Expired - Fee Related JP4777182B2 (ja) | 2006-08-01 | 2006-08-01 | 複合現実感提示装置及びその制御方法、プログラム |

Country Status (2)

| Country | Link |

|---|---|

| US (1) | US20080030461A1 (ja) |

| JP (1) | JP4777182B2 (ja) |

Families Citing this family (36)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| NL1035303C2 (nl) * | 2008-04-16 | 2009-10-19 | Virtual Proteins B V | Interactieve virtuele reality eenheid. |

| US8397181B2 (en) * | 2008-11-17 | 2013-03-12 | Honeywell International Inc. | Method and apparatus for marking a position of a real world object in a see-through display |

| KR101171660B1 (ko) * | 2010-03-01 | 2012-08-09 | 이문기 | 증강현실의 포인팅 장치 |

| WO2011156195A2 (en) * | 2010-06-09 | 2011-12-15 | Dynavox Systems Llc | Speech generation device with a head mounted display unit |

| US20120005624A1 (en) | 2010-07-02 | 2012-01-05 | Vesely Michael A | User Interface Elements for Use within a Three Dimensional Scene |

| US8643569B2 (en) * | 2010-07-14 | 2014-02-04 | Zspace, Inc. | Tools for use within a three dimensional scene |

| JP5769392B2 (ja) * | 2010-08-26 | 2015-08-26 | キヤノン株式会社 | 情報処理装置およびその方法 |

| DE102011104524A1 (de) * | 2011-06-15 | 2012-12-20 | Ifakt Gmbh | Verfahren und Vorrichtung zum Ermitteln und Wiedergeben virtueller ortsbezogener Informationen für einen Raumbereich |

| US8638320B2 (en) | 2011-06-22 | 2014-01-28 | Apple Inc. | Stylus orientation detection |

| JP5941146B2 (ja) | 2011-07-29 | 2016-06-29 | ヒューレット−パッカード デベロップメント カンパニー エル.ピー.Hewlett‐Packard Development Company, L.P. | 投影取込システム、プログラムおよび方法 |

| KR101773988B1 (ko) | 2011-07-29 | 2017-09-01 | 휴렛-팩커드 디벨롭먼트 컴퍼니, 엘.피. | 시각적 계층화 시스템 및 시각적 계층화 방법 |

| US9521276B2 (en) | 2011-08-02 | 2016-12-13 | Hewlett-Packard Development Company, L.P. | Portable projection capture device |

| JP5762892B2 (ja) | 2011-09-06 | 2015-08-12 | ビッグローブ株式会社 | 情報表示システム、情報表示方法、及び情報表示用プログラム |

| JP5966510B2 (ja) | 2012-03-29 | 2016-08-10 | ソニー株式会社 | 情報処理システム |

| US8937725B2 (en) * | 2012-06-14 | 2015-01-20 | Nikon Corporation | Measurement assembly including a metrology system and a pointer that directs the metrology system |

| US20140168261A1 (en) * | 2012-12-13 | 2014-06-19 | Jeffrey N. Margolis | Direct interaction system mixed reality environments |

| JP6149403B2 (ja) * | 2013-01-07 | 2017-06-21 | セイコーエプソン株式会社 | 表示装置、および、表示装置の制御方法 |

| US9833697B2 (en) * | 2013-03-11 | 2017-12-05 | Immersion Corporation | Haptic sensations as a function of eye gaze |

| US9607584B2 (en) * | 2013-03-15 | 2017-03-28 | Daqri, Llc | Real world analytics visualization |

| JP6205189B2 (ja) * | 2013-06-28 | 2017-09-27 | オリンパス株式会社 | 情報提示システム及び情報提示システムの制御方法 |

| JP2015037250A (ja) * | 2013-08-14 | 2015-02-23 | 株式会社リコー | 画像投影装置及びプレゼンテーションシステム |

| FR3011952B1 (fr) * | 2013-10-14 | 2017-01-27 | Suricog | Procede d'interaction par le regard et dispositif associe |

| WO2016076874A1 (en) | 2014-11-13 | 2016-05-19 | Hewlett-Packard Development Company, L.P. | Image projection |

| US10338687B2 (en) * | 2015-12-03 | 2019-07-02 | Google Llc | Teleportation in an augmented and/or virtual reality environment |

| EP3223208A1 (en) * | 2016-03-22 | 2017-09-27 | Hexagon Technology Center GmbH | Self control |

| JP6095191B1 (ja) * | 2016-07-15 | 2017-03-15 | ブレイニー株式会社 | 仮想現実システム、及び、情報処理システム |

| KR101853190B1 (ko) * | 2016-07-19 | 2018-04-27 | 동의대학교 산학협력단 | 증강현실을 이용한 침구실습장치 및 방법 |

| KR101806864B1 (ko) * | 2016-10-05 | 2017-12-08 | 연세대학교 산학협력단 | 증강 현실 환경에서 3d 객체를 제어하기 위한 장치 및 그 방법 |

| US20180210561A1 (en) * | 2017-01-24 | 2018-07-26 | Semiconductor Energy Laboratory Co., Ltd. | Input unit, input method, input system, and input support system |

| CN107065195B (zh) * | 2017-06-02 | 2023-05-02 | 那家全息互动(深圳)有限公司 | 一种模块化mr设备成像方法 |

| US10930075B2 (en) * | 2017-10-16 | 2021-02-23 | Microsoft Technology Licensing, Llc | User interface discovery and interaction for three-dimensional virtual environments |

| JP7102173B2 (ja) * | 2018-03-09 | 2022-07-19 | キヤノン株式会社 | 情報処理装置、情報処理方法、及びプログラム |

| US20210181864A1 (en) * | 2018-06-18 | 2021-06-17 | Sony Corporation | Information processing device, information processing method, and program |

| CN110618753A (zh) * | 2019-08-02 | 2019-12-27 | 常州锦瑟医疗信息科技有限公司 | 用于混合现实场景的指示设备、指示方法和混合现实系统 |

| JP7425641B2 (ja) * | 2020-03-25 | 2024-01-31 | 鹿島建設株式会社 | 測距装置およびプログラム |

| US12153764B1 (en) | 2020-09-25 | 2024-11-26 | Apple Inc. | Stylus with receive architecture for position determination |

Family Cites Families (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3287312B2 (ja) * | 1998-08-13 | 2002-06-04 | 日本電気株式会社 | ポインティング装置 |

| JP2000102036A (ja) * | 1998-09-22 | 2000-04-07 | Mr System Kenkyusho:Kk | 複合現実感提示システム、複合現実感提示方法、マン・マシーンインタフェース装置、およびマン・マシーンインタフェース方法 |

| JP2003296757A (ja) * | 2002-03-29 | 2003-10-17 | Canon Inc | 情報処理方法および装置 |

| DE102005061211B4 (de) * | 2004-12-22 | 2023-04-06 | Abb Schweiz Ag | Verfahren zum Erzeugen einer Mensch-Maschine-Benutzer-Oberfläche |

-

2006

- 2006-08-01 JP JP2006210255A patent/JP4777182B2/ja not_active Expired - Fee Related

-

2007

- 2007-07-30 US US11/830,356 patent/US20080030461A1/en not_active Abandoned

Also Published As

| Publication number | Publication date |

|---|---|

| JP2008040556A (ja) | 2008-02-21 |

| US20080030461A1 (en) | 2008-02-07 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP4777182B2 (ja) | 複合現実感提示装置及びその制御方法、プログラム | |

| JP4883774B2 (ja) | 情報処理装置及びその制御方法、プログラム | |

| US8139087B2 (en) | Image presentation system, image presentation method, program for causing computer to execute the method, and storage medium storing the program | |

| US10506218B2 (en) | Computer-readable storage medium having stored therein display control program, display control apparatus, display control system, and display control method | |

| JP4795091B2 (ja) | 情報処理方法および装置 | |

| KR101480994B1 (ko) | 차량의 디스플레이를 이용한 증강 현실 발생 방법 및 시스템 | |

| JP2020024752A (ja) | 情報処理装置及びその制御方法、プログラム | |

| JP5769392B2 (ja) | 情報処理装置およびその方法 | |

| US7911468B2 (en) | Storage medium storing a program for controlling the movement of an object | |

| JP4500632B2 (ja) | 仮想現実感提示装置および情報処理方法 | |

| JP2008040556A5 (ja) | ||

| JP2005038008A (ja) | 画像処理方法、画像処理装置 | |

| JP2008210276A (ja) | 三次元モデル情報の生成方法及び装置 | |

| JP6920057B2 (ja) | 画像処理装置、画像処理方法、コンピュータプログラム | |

| JP6409861B2 (ja) | 情報処理装置、情報処理システム、その制御方法及びプログラム | |

| JP2005174021A (ja) | 情報提示方法及び装置 | |

| JP2017187952A (ja) | 表示制御方法及び当該表示制御方法をコンピュータに実行させるためのプログラム | |

| WO2019065846A1 (ja) | プログラム、情報処理方法、情報処理システム、頭部装着型表示装置、情報処理装置 | |

| JP5831151B2 (ja) | 制御処理プログラム、画像表示装置、および画像表示方法 | |

| KR101811809B1 (ko) | 3d hmd를 활용한 아케이드 게임시스템 | |

| JP2009048237A (ja) | 画像処理装置、画像処理方法 | |

| JP2006085375A (ja) | 画像処理方法、画像処理装置 | |

| JP2005157610A (ja) | 画像処理装置および方法 | |

| JP7279113B2 (ja) | 画像処理装置、画像処理方法、コンピュータプログラム | |

| JP2005251118A (ja) | 画像処理方法、画像処理装置 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20090602 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20090602 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20110404 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20110603 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20110624 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20110629 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 4777182 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20140708 Year of fee payment: 3 |

|

| LAPS | Cancellation because of no payment of annual fees |