JP4641601B2 - Image processing apparatus and image processing system - Google Patents

Image processing apparatus and image processing system Download PDFInfo

- Publication number

- JP4641601B2 JP4641601B2 JP2000273297A JP2000273297A JP4641601B2 JP 4641601 B2 JP4641601 B2 JP 4641601B2 JP 2000273297 A JP2000273297 A JP 2000273297A JP 2000273297 A JP2000273297 A JP 2000273297A JP 4641601 B2 JP4641601 B2 JP 4641601B2

- Authority

- JP

- Japan

- Prior art keywords

- filter

- image

- image processing

- region

- vehicle

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

Images

Landscapes

- Transforming Light Signals Into Electric Signals (AREA)

- Closed-Circuit Television Systems (AREA)

- Color Television Image Signal Generators (AREA)

- Studio Devices (AREA)

- Image Input (AREA)

Description

【0001】

【発明の属する技術分野】

本発明は画像処理装置、特に車両に搭載され車両の周辺の道路状況等をビデオカメラにて監視するのに適した画像処理装置、ならびに画像処理システムに関する。

【0002】

【従来の技術】

上記のような画像処理装置は、前方を走行する車両との間の車両距離が十分でなくなったことを検知して運転者にアラーム音を発したり、あるいはレーンマークから外れて車両が走行し始めたときに同様に運転者にアラーム音を発したりするために用いることができる。

【0003】

また車両が前進する場合のみならず、後退する場合においても後方確認のためにその画像処理装置を利用することができる。

【0004】

【発明が解決しようとする課題】

画像処理装置は上述のように車両の周辺の他の車両、レーンマーク等の道路状況を画像として捉えさらにその道路状況を認識する機能を果す。すなわち画像認識である。

この画像認識の性能は、画像処理装置自身の性能によって定まるものであるが、実際の運用時においては、画像処理装置が置かれる撮影状況によっても大きく左右される。その撮影状況(日照条件、 天候等)によっては、上記の画像認識を行うことが困難な場合に遭遇することがある。

【0005】

例えば夜間の走行中、その前方を走行する車両のブレーキランプが点灯した場合、ブレーキランプ周辺の画像がぼやけてしまい、 当該車両に設けられる画像処理装置の画像認識性能が低下してしまう、という第1の問題がある。

図20は従来技術の第1の問題点を示す画像の一例を表す図である。

本図に示すとおり、 夜間の走行中に前方を走る車両1が有する例えば3個のブレーキランプ2,3および4の周辺の画像に上記の「ぼやけ」が現れる。

【0006】

また画像処理装置に内蔵される画像メモリのメモリ容量と処理時間とに制限が課せられている、という第2の問題がある。

したがって本発明は上記問題点に鑑み、上述した画像認識性能の低下の問題と、上述したメモリ容量および処理時間に課せられる制限の問題とを同時に解消することのできる画像処理装置、ならびに画像処理システムを提供することを目的とするものである。

【0007】

【課題を解決するための手段】

図1は本発明に係る画像処理装置の基本構成を示す図である。

本図において、参照番号10は画像処理装置であり、該装置10は、 撮像素子14を有する光学系11と、光学系11からの撮像信号Sを入力として画像処理を行う演算処理部12とからなる。なお、撮像素子14の部分についてのみ、 拡大した斜視図Aにて示す。この拡大斜視図は、 レンズ13側から見た図である。

【0008】

ここに撮像素子14は行方向の画素と列方向の画素とを全体にマトリクス状に配列してなる。ただしこの構成は周知であるので、詳細に図示しない。

撮像素子14の撮像面14’は、行単位または列単位で複数の領域に区分されると共に、これら複数の領域は、 第1フィルタF1を該撮像面上に備える第1領域I、第2フィルタF2を該撮像面14’上に備える第2領域IIおよび撮像面14’上にフィルタを設けない第3領域III のうちの少なくともいずれか2つの領域によって構成される。

【0009】

かくしてフィルタ処理が加えられた、 光学系11からの撮像信号Sが演算処理部12に入力され、例えば前方の車両の認識等の処理が行われる。

図2は撮像素子14の分光感度特性を示すグラフである。

本図において、横軸には波長〔nm〕を、縦軸には輝度をそれぞれとって、上記の分光感度特性を示す。ただし撮像素子 (センサIC)14としてCMOSセンサを採用した例を示す。

【0010】

本図のグラフ中、 特に注目すべき部分は、波長帯域Bである。この帯域Bが、図20に表した、 車両1のブレーキランプ(2,3,4)周辺に生じる「ぼやけ」の原因となる帯域である。

このようなぼやけは、赤外領域(B)にあることから、人間の眼には見えないが、一方、上記CMOSセンサにとってみると、このような波長帯域も検知範囲となる。したがってこの波長帯域に基づくセンサ信号が撮像信号Sの中に上記のぼやけとして現れることになる。

【0011】

そこで上記の波長帯域Bをフィルタによりカットして、該ぼやけを除去する、というのが本発明の前提となる。ただし、このようなフィルタによる帯域Bのカットということ自体は公知のことである。本発明の特徴は、そのフィルタの形成の仕方にあり、具体的には図1内の拡大斜視図Aに示すように形成される。なお、本図Aは本発明に基づくある一態様を示したものであって、フィルタF1(I)、フィルタF2(II)およびフィルタなし(III )の各領域の全てが撮像面14’上に形成されているが、これに限らず、 フィルタF1(I)、フィルタF2(II)およびフィルタなし(III )のうちのいずれか2つの領域だけが存在するように構成してもよい。

【0012】

以下、上記図2の説明を続けるが、この説明では第1フィルタF1と第2フィルタF2のみを用いた例を用いる。

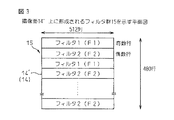

図3は撮像面14’上に形成されるフィルタ群15を示す平面図である。

本図の例では、512列および480行のそれぞれに512画素および480画素をマトリクス状に配列してなる撮像素子14を用いており、その撮像面14’上に、行単位ですなわち奇数行と偶数行とに区分して、第1フィルタ(F1)と第2フィルタ(F2)とを交互配置する。このため各フィルタの幅は数10μmと微小なものとなる。

【0013】

このようなフィルタ群を用いて図1の撮像信号Sを得、図1の演算処理部12にて所定の処理を行う。

図4は演算処理部12による処理の一例を示すフローチャートである。

ステップS11:図3における512画素×120(480/4)画素分の輝度値の平均を算出する。この場合、行単位の画素情報は一例として1/4に間引いている。この行単位の画素情報は、演算処理部12内のメモリ(後述する図5のメモリ24参照)に一旦格納され、さらに、同図中のCPU25にて平均輝度値が算出される。

【0014】

ステップS12:上記ステップS11で算出された平均輝度値により、 当該車両の置かれた環境(昼か夜)を上記CPUにより判断する。

ステップS13:上記の判断により、昼であることが判明すると、インタレース方式により第1フィルタF1が載せられた奇数行のみをスキャンする。このときの第1フィルタF1は、図2の波長帯域Bまでも含めた全波長帯域についての撮像信号Sを得る。この結果、昼間の画像認識性能は従前どおり十分確保することができる。

【0015】

ステップS14:一方上記の判断により、夜であることが判明すると、今度は、上記インタレース方式のもとで、第2フィルタF2が載せられた偶数行のみをスキャンする。このときの第2フィルタF2としては、 図2の波長帯域Bを除いた全波長帯域(青、緑および赤)についての撮像信号Sを得る。この結果、夜間における該帯域Bに起因するぼやけは排除され、夜間の画像認識性能は従前に比して大幅に改善される。

【0016】

上述のとおり、昼と夜とに最適なフィルタ特性をそれぞれ選択でき、既述の第1の問題は解消される。

この場合、第1および第2フィルタF1, F2のいずれか一方に属する撮像面のみしか使用されないので、画像情報量は本来得られる画像情報量に比べてほぼ半減してしまう。しかし実際に実施した結果によれば、画像認識能力の低下は実用上全く問題にならない程度であった。そのような能力の低下は、ぼやけの完全な解消という効果によって十分相殺される。かくして夜間において例えば前方の車両を認識する際、その車両の輪郭をきわめて鮮明に捉えることが可能となる。

【0017】

また上述のとおり、使用する画像情報量がほぼ半減するので、上記メモリ24のメモリ容量は従来のほぼ半分で済むことになり、これに伴い上記CPU25による画像処理(車両の周囲の明るさ判断の処理や、車両の画像の輪郭を抽出する等の処理や、前方の車両との車間距離を計算する処理や、必要に応じて既述のアラーム音を発出する処理等)に要する処理時間も短縮される。この結果、既述の第2の問題も解消される。

【0018】

【発明の実施の形態】

図5は図1の装置構成の具体例を示す図である。なお全図を通じて、同様の構成要素には同一の参照番号または記号を付して示す。

本図において、画像処理装置10は、図1のとおり、光学系11と演算処理部12とからなる。

【0019】

光学系11はいわばビデオカメラであり、レンズ13と撮像素子14とフィルタ群15等を含む。このビデオカメラは例えば、車両内のルームミラーのところに取り付けられ、および/または、車両のリアウィンドウ中央付近に取り付けられる。

このビデオカメラ(11)からのアナログの撮像信号Sは、演算処理部12に入力され、まず、アンプ21にてこれを増幅し、さらに、ADC(Analog/Digital Converter)22によりディジタルの撮像信号Sに変換する。さらに、メモリI/F制御回路23は、CPU25による指令のもとで、メモリ24へのデータ(撮像信号)の書込みおよびCPU25への読出しを制御する。該回路23はさらに他の制御も行う。

【0020】

図6は本発明に基づく第1実施例を示す平面図であり、

図7は第1実施例の説明に用いるグラフである。なお、図6の見方は図3と同じであり、図7の見方は図2と同じである。

この第1実施例においては、既述の複数の領域は、第1領域Iと第3領域III とから構成される。かつ、第1領域Iに備えられる第1フィルタF1は赤外カットフィルタであることを特徴とするものである。

【0021】

これにより、図7におけるにじみ(既述のぼやけと等価)の原因となるセンサ信号の部分Cは、赤外カットフィルタ(F1)により除去される。

さらに詳細には、前方の車両のストップランプがぼやける夜間に対応するため、奇数行と偶数行のフィルタの特性を変えることにする。すなわち奇数行はフィルタなし、偶数行は赤外カットフィルタ(F1)である。このときの処理としては、演算処理部12で昼または夜の判断を行い、その結果をもとに、インタレースのビデオカメラ信号の処理範囲を次のようにする。

【0022】

・昼ならば、フィルタなしの奇数フィールドを選択し、

・夜ならば、赤外カットフィルタ(F1)有りの偶数フィールドを選択する。

図8は本発明に基づく第2実施例を示す平面図であり、

図9は第2実施例の説明い用いるグラフである。なお、図8の見方は図3と同じであり、図9の見方は図2と同じである。

【0023】

この第2実施例においては、既述の複数の領域は、第1領域Iと第2領域IIと第3領域III から構成される。かつ、第1領域Iに備えられる第1フィルタF1は赤外カットフィルタであり、第2領域IIに備えられる第2フィルタF2も赤外カットフィルタであって、第1フィルタF1と第2フィルタF2の各分光感度特性を相互に異ならせることを特徴とするものである。

【0024】

これにより、図9における上記にじみの原因となる部分C(図7のCと同じ)は、赤外カットフィルタ(F1)または赤外カットフィルタ(F2)により除去される。

さらに詳細には、前方の車両のストップランプがぼやける夜間の場合、3行毎にフィルタの特性を変えることにする。すなわちnは整数で、n=0,1,…,159とすると、

3n+1行:フィルタなし

3n+2行:赤外カットフィルタ1(F1)

3n+3行:赤外カットフィルタ2(F2)

とする。このときの処理としては、演算処理部12で昼または夜の判断を行い、その結果をもとに、インタレースのビデオカメラ信号の処理範囲を次のようにする。

【0025】

・昼ならば、フィルタなしの3n+1行を選択し、

・夜で、ぼやけの小さい時は、赤外カットフィルタ1の3n+2行を選択し、

・夜で、ぼやけの大きい時は、赤外カットフィルタ2の3n+3行を選択する。

本発明に係る撮像素子14の撮像面14’は、行単位または列単位で複数の領域に区分される。上述した第1および第2実施例では、行単位で複数の領域に区分した構成を示したので、次に列単位で複数の領域に区分した構成を、第3および第4実施例として示す。

【0026】

図10は本発明に基づく第3実施例を示す平面図である。

第1実施例(図6)が行単位であるのに対し、この第3実施例は、列単位にしたものである。

詳細には、前方の車両のストップランプがぼやける夜間に対応するため、奇数列と偶数列のフィルタの特性を変えることにする。すなわち奇数列はフィルタなし、偶数列は赤外カットフィルタ(F1)である。このときの処理としては、演算処理部12で昼または夜の判断を行い、その結果をもとに、ビデオカメラ信号の処理範囲を次のようにする。

【0027】

・昼ならば、フィルタなしの奇数列を選択し、

・夜ならば、赤外カットフィルタ(F1)有りの偶数列を選択する。

図11は本発明に基づく第4実施例を示す平面図である。

第2実施例(図8)が行単位であるのに対し、この第4実施例は、列単位にしたものである。

【0028】

詳細には、前方の車両のストップランプがぼやける夜間に対応するため、3n+1列と3n+2列と3n+3列のフィルタの特性を変えることにする。すなわちnは整数で、n=0,1,…,159とすると、

3n+1列:フィルタなし

3n+2列:赤外カットフィルタ1(F1)

3n+3列:赤外カットフィルタ2(F2)

とする。このときの処理としては、演算処理部12で昼または夜の判断を行い、その結果をもとに、ビデオカメラ信号の処理範囲を次のようにする。

【0029】

・昼ならば、フィルタなしの3n+1列を選択し、

・夜で、ぼやけの小さい時は、赤外カットフィルタ1の3n+2列を選択し、

・夜で、ぼやけの大きい時は、赤外カットフィルタ2の3n+3列を選択する。

上述した第3および第4実施例は、ビデオカメラからの左右の視野角を適宜設定したいようなときに有効である。例えば、ビデオカメラが車両のリヤウィンドウ側に設けられていて、車両の後方に展開する道路上の白いレーンマークを確認したいような場合に有効である(後述)。

【0030】

このような第3および第4実施例による列単位での撮像信号Sの抽出を行うためには、前述した第1および第2実施例の場合のようなインタレース方式をそのまま利用することができない。

すなわち第1および第2実施例の場合ならば、行単位で区分される既述の複数の領域は、撮像素子14の奇数または偶数番目のいずれか一方の行によって規定され、このインタレース方式の撮像信号Sを、演算処理部12を構成するメモリ24に格納すれば、CPU25およびメモリI/F制御回路23はその後何ら複雑な制御をすることなく、所定の画像処理を行うことができる。

【0031】

しかしながら第3および第4実施例の場合には、演算処理部12内にカウンタ機能(図5のカウンタ31参照)を持たせ、撮像素子14からの行単位の撮像信号Sのうち所定のカウント値に達する毎に選択された撮像信号を、列単位で区分される複数の領域に対応する撮像信号Sとして、演算処理部12を構成するメモリ24から読み出すようにする必要がある。

【0032】

このような読出し操作を行うのは、 例えば図5のメモリI/F(interface)制御回路23である。例えば図11の場合についてみると、上記の所定のカウント値は、赤外カットフィルタ(F1)については、“2→5→8→…→511”であり、赤外カットフィルタ(F2)については、“3→6→9→…→512”である。またフィルタなし(III )については、“1→4→7→…→510”である。

【0033】

どのようなカウント値を選択するかは、最も単純には、車両の置かれた環境が昼であるか夜であるか、に依存する。このような昼/夜の識別は図5の演算処理部12、とりわけCPU25、が行う。

すなわち、演算処理部12は、演算処理部12を構成するメモリ24に格納されている撮像信号Sのデータに基づいて、この撮像素子全体の平均受光輝度を表す輝度値を算出し、この輝度値の大小に応じて、前述した第1、第2および第3領域(I,IIおよびIII )を指定する。つまり、第1フィルタF1を使うか、第2フィルタF2を使うか、またはフィルタなし(III )とするか、を決定する。

【0034】

上記第1および第2実施例は行単位のみでのフィルタ処理をベースにし、上記第3および第4実施例は列単位のみでのフィルタ処理をベースにしている。これをさらに発展させれば行単位と列単位の複合によるフィルタ処理をベースにすることもできる。

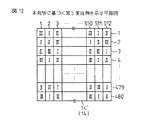

図12は本発明に基づく第5実施例を示す図である。

【0035】

この第5実施例では、行単位と列単位の複合でフィルタ処理を行う。図12においては、既述の複数の領域として、第1領域I(第1フィルタF1付き)、第2領域II(第2フィルタF2付き)および第3領域III (フィルタなし)が全て採用され、これらの領域が格子状に配置されていることを示す。

かくしてこの第5実施例のもとでは撮像素子14を有する光学系11と、光学系11からの撮像信号Sを入力として画像処理を行う演算処理部12とからなる画像処理装置において、撮像素子14は行方向の画素と列方向の画素とを全体にマトリクス状に配列すると共に、

撮像素子14の撮像面14’は、行および列の交点の単位で複数の領域に区分され、これら複数の領域は、第1フィルタF1を撮像面14’上に備える第1領域I、 第2フィルタF2を撮像面14’上に備える第2領域IIおよび撮像面14’上にフィルタを設けない第3領域III のうちの少なくともいずれか2つの領域によって構成されるようにする。

【0036】

図13は本発明に基づく第6実施例の説明に用いるグラフである。

前述した各実施例では第1フィルタF1(第2フィルタF2)として赤外カットフィルタを用いたが、この第6実施例(および後述の第7実施例)では均一な濃度のフィルタ(全波長帯域(減衰を必要とする波長帯域)に亘り略一律に透過光量を抑えるフィルタ)であるND(NEUTRAL DENSITY)フィルタを用いる。

【0037】

すなわち、前述した複数の領域は、第1領域Iと第3領域III とから構成されると共に、この第1領域Iに備えられる第1フィルタF1はNDフィルタであることを特徴とするものである。

前述した各実施例では、ぼやけの原因Cを赤外カットフィルタにより除去したが、第6実施例(第7実施例)では、NDフィルタを用いて、全波長帯域に亘り一律に透過率を下げる(透過光量を抑える)ことにより、その原因Cを排除するようにしたものである。既述のぼやけを防ぐ効果は、赤外カットフィルタにほぼ等しい。

【0038】

図13において、曲線DはNDフィルタにより低下した透過率特性を表す。

図14は本発明に基づく第7実施例の説明に用いるグラフである。

この第7実施例では、前述した複数の領域は、第1領域Iと第2領域IIと第3領域III とから構成され、かつ、この第1領域Iに備えられる第1フィルタF1はNDフィルタであり、その第2領域に備えられる第2フィルタF2もNDフィルタであって、第1フィルタF1と第2フィルタF2の各透過率特性を相互に異ならせることを特徴とするものである。

【0039】

図14を参照すると、曲線D1は第1NDフィルタ(F1)の透過率特性を示し、曲線D2は第2NDフィルタ(F2)の透過率特性を示す。そしてF1の透過率の方がF2の透過率よりも大に設定される。それぞれの役割は、既述した第1赤外カットフィルタ(F1)および第2赤外カットフィルタの役割と同じである。

【0040】

以上の実施例ではビデオカメラを主として車両のフロントウィンドウ側に設けた場合について説明したが、以下、このビデオカメラを車両のリヤウィンドウ側に設ける場合について説明する。また使用するフィルタとして赤外カットフィルタおよびNDフィルタについて述べたが、以下の説明ではRGBカラーフィルタも取り入れた場合について述べる。

【0041】

図15は本発明に基づく第8実施例を示す図である。

この第8実施例においては、前述した複数の領域は列単位のみで区分されると共に、撮像面14’の中間部分に配置される第1領域Iと撮像面14’における該中間部分の左右にある左部分と右部分とにそれぞれ配置される第3領域III とから構成され、ここに、第1領域Iに備えられる第1フィルタF1はRGBカラーフィルタであることを特徴とするものである。

【0042】

図16は第8実施例のもとでの撮影画像の一例を示す図である。

本図において、41はディスプレイであり、車両の後方側の映像を表示する。本図は夜間の映像を表示しており、中央に後方車両が映っている(図15の後方車両部)。

夜間走行では車両後方に展開する道路上のレーンマーク(白線)5だけを鮮明に映し出したいことがある。このために、ディスプレイの中央表示部分の左側および右側の部分に相当する撮像面14’の部分はフィルタなし(第3領域III )とする(図15の白線部)。

【0043】

車両後方に展開する映像としては、上記の他、例えば駐車の際の車両後方の確認用として用いる場合がある。このときは、カラー画像として、視野の中央部分を鮮明に映し出す必要がある。このために図15のRGBカラーフィルタ(F1)を撮像面14’の中央に設ける。なお、このような車両後方の確認のときは、拡大表示するのが都合がよい。これを図16のディスプレイ41’として示す。

【0044】

さらに詳細には、車両の後方に取り付けたビデオカメラ(図18の52参照)から後方の白線を認識する場合、 車両の存在する範囲と白線の存在する範囲とで、フィルタの特性を変えることにする。すなわち

車両部1:RGBカラーフィルタ(I)

白線部5:フィルタなし(III )

とする。このときの処理としては、中央部の映像は画面に表示するために、カラー表示が必要であり、一方、その左右の白線部は画像処理を行うためにRGBカラーフィルタをとり、フィルタなしとする。

【0045】

図17は本発明に基づく第9実施例を示す図である。

第9実施例は上記第8実施例の変形であり、白線部(5)の光量が強過ぎるような場合に採用することができる。

すなわち第9実施例においては、前述の複数の領域は列単位のみで区分されると共に、 撮像面14’の中間部分に配置される第1領域Iと撮像面14’における該中間部分の左右にある左部分と右部分とにそれぞれ配置される第2領域IIとから構成され、ここに、第1領域Iに備えられる第1フィルタF1はRGBカラーフィルタであり、第2領域IIに備えられる第2フィルタF2は赤外カットフィルタであることを特徴とするものである。

【0046】

上記の赤外カットフィルタ(F2)についてみると、これをさらに2段階に区分することもできる。既述の図9において両矢印のF1およびF2として示すとおりである。

すなわち、第2フィルタF2をなす赤外カットフィルタは第1赤外カットフィルタと第2赤外カットフィルタからなり、かつ、該第1および第2赤外カットフィルタの各分光感度特性を相互に異ならせるようにする。

【0047】

またさらなる変形例としては、その赤外カットフィルタに代えて既述のNDフィルタとすることもできる。すなわち、かかる実施態様のもとでは、前述の複数の領域は列単位のみで区分されると共に、撮像面14’の中間部分に配置される第1領域Iと撮像面14’における該中間部分の左右にある左部分と右部分とにそれぞれ配置される第2領域IIとから構成され、かつ、この第1領域Iに備えられる第1フィルタF1はRGBカラーフィルタとし、該第2領域IIに備えられる第2フィルタF2はNDフィルタとする。

【0048】

そしてこのNDフィルタ(F2)についても、これをさらに2段階に区分することもできる。既述の図14において曲線D1およびD2として示すとおりである。

かかる実施態様のもとでは、第2フィルタF2をなすNDフィルタは第1NDフィルタと第2NDフィルタからなり、かつ、これら第1および第2NDフィルタの各透過率特性を相互に異ならせるようにする。

【0049】

次に説明する第10実施例は、車両の後方にビデオカメラだけでなく、その後方の映像を浮かび上がらせる照光手段をもさらに設けるものである。

図18は本発明に基づく第10実施例を説明するための斜視図である。

本図において、車両1はレーンマーク(白線)5に沿って走行中であり、この車両1の後方には、既に述べてきたビデオカメラが52として示されると共に、上述した照光手段が51として示されている。ただし、採用する撮像面14’上のフィルタ構成は、前述の第8実施例(図15)あるいは第9実施例(図17)と全く同じである。

【0050】

照光手段51としては特定波長で発光する発光素子を用いる。本図の例ではその発光素子として赤外LEDを用いており(中心周波数950nm)、図18では、レーンマーク5を照光する様子が示されている。

図19は本発明に基づく第10実施例を示す図であり、分光感度特性を表すグラフGと共に示されている。

【0051】

上記の例では、照光手段51として赤外LED(特定波長は950nm)を用いており、この特定波長域(図19のグラフG内のH参照)を透過させる特定波長フィルタを第2フィルタF2として用いる。

すなわちこの第10実施例においては、前述の複数の領域は列単位のみで区分されると共に、 撮像面14’の中間部分に配置される第1領域Iと該撮像面14’における該中間部分の左右にある左部分と右部分とにそれぞれ配置される第2領域IIとから構成され、ここに、その第1領域Iに備えられる第1フィルタF1はRGBカラーフィルタであり、その第2領域に備えられる第2フィルタF2は特定の波長域を透過させる特定波長フィルタであることを特徴とするものである。

【0052】

さらに上記の特定波長フィルタ(F2)は、第1特定波長フィルタと第2特定波長フィルタからなり、かつ、これら第1および第2特定波長フィルタの各透過率特性を相互に異ならせるようにすることもできる。

【0053】

【発明の効果】

以上説明したように本発明によれば、撮像素子14の撮像面14’上に選択的に所望のフィルタを配列したビデオカメラが提供される。

これにより、所望の映像をより一層鮮明に得ることができる。

また、所望のフィルタを選択的に使用することにより、メモリ24のメモリ容量を減らし、これに伴いCPU25の処理時間を短縮することもできる。

【図面の簡単な説明】

【図1】本発明に係る画像処理装置の基本構成を示す図である。

【図2】撮像素子14の分光感度特性を示すグラフである。

【図3】撮像面14’上に形成されるフィルタ群15を示す平面図である。

【図4】演算処理部12による処理の一例を示すフローチャートである。

【図5】図1の装置構成の具体例を示す図である。

【図6】本発明に基づく第1実施例を示す平面図である。

【図7】第1実施例の説明に用いるグラフである。

【図8】本発明に基づく第2実施例を示す平面図である。

【図9】第2実施例の説明に用いるグラフである。

【図10】本発明に基づく第3実施例を示す平面図である。

【図11】本発明に基づく第4実施例を示す平面図である。

【図12】本発明に基づく第5実施例を示す平面図である。

【図13】本発明に基づく第6実施例の説明に用いるグラフである。

【図14】本発明に基づく第7実施例の説明に用いるグラフである。

【図15】本発明に基づく第8実施例を示す図である。

【図16】第8実施例のもとでの撮像画像の一例を示す図である。

【図17】本発明に基づく第9実施例を示す図である。

【図18】本発明に基づく第10実施例を説明するための斜視図である。

【図19】本発明に基づく第10実施例を示す図である。

【図20】従来技術の第1の問題点を示す画像の一例を表す図である。

【符号の説明】

1…車両

2,3,4…ブレーキランプ

5…レーンマーク

10…画像処理装置

11…光学系(ビデオカメラ)

12…演算処理部

13…レンズ

14…撮像素子

14’…撮像面

15…フィルタ群

21…アンプ

22…ADC

23…メモリI/F制御回路

24…メモリ

25…CPU

31…カウンタ

41…ディスプレイ

51…照光手段

52…ビデオカメラ

S…撮像信号

I…第1領域

II…第2領域

III …第3領域

F1…第1フィルタ

F2…第2フィルタ[0001]

BACKGROUND OF THE INVENTION

The present invention relates to an image processing apparatus, particularly an image processing apparatus mounted on a vehicle and suitable for monitoring a road condition around the vehicle with a video camera. And image processing system About.

[0002]

[Prior art]

The image processing apparatus as described above detects that the vehicle distance from the vehicle traveling ahead is not sufficient and emits an alarm sound to the driver, or comes off the lane mark and the vehicle starts to travel. Similarly, it can be used to make an alarm sound to the driver.

[0003]

The image processing apparatus can be used not only when the vehicle moves forward but also when the vehicle moves backward to confirm the rear.

[0004]

[Problems to be solved by the invention]

As described above, the image processing apparatus performs a function of capturing road conditions such as other vehicles around the vehicle and lane marks as images and recognizing the road conditions. That is, image recognition.

The performance of this image recognition is determined by the performance of the image processing apparatus itself. However, in actual operation, it greatly depends on the shooting situation in which the image processing apparatus is placed. Depending on the shooting conditions (sunshine conditions, weather, etc.), you may encounter when it is difficult to perform the above image recognition.

[0005]

For example, when a vehicle running in front of the vehicle is illuminated at night, the image around the brake light is blurred and the image recognition performance of the image processing device provided in the vehicle is reduced. There is one problem.

FIG. 20 is a diagram illustrating an example of an image showing a first problem of the conventional technique.

As shown in the figure, the above-mentioned “blurring” appears in an image around, for example, the three

[0006]

In addition, there is a second problem that there is a restriction on the memory capacity and processing time of the image memory built in the image processing apparatus.

Therefore, in view of the above problems, the present invention can solve the above-described problem of degradation of image recognition performance and the above-described problem of limitations imposed on the memory capacity and processing time at the same time. And image processing system Is intended to provide.

[0007]

[Means for Solving the Problems]

FIG. 1 is a diagram showing a basic configuration of an image processing apparatus according to the present invention.

In this figure,

[0008]

Here, the

The

[0009]

Thus, the imaging signal S from the

FIG. 2 is a graph showing the spectral sensitivity characteristics of the

In this figure, the wavelength [nm] is plotted on the horizontal axis and the luminance is plotted on the vertical axis, and the above spectral sensitivity characteristics are shown. However, the example which employ | adopted the CMOS sensor as the image pick-up element (sensor IC) 14 is shown.

[0010]

In the graph of this figure, the part to be particularly noted is the wavelength band B. This band B is a band that causes “blurring” generated around the brake lamp (2, 3, 4) of the

Since such blur is in the infrared region (B), it cannot be seen by human eyes. On the other hand, for the CMOS sensor, such a wavelength band is also a detection range. Therefore, a sensor signal based on this wavelength band appears as the blur in the imaging signal S.

[0011]

Therefore, the premise of the present invention is to remove the blur by cutting the wavelength band B with a filter. However, the band B cut by such a filter is known per se. The feature of the present invention lies in the way of forming the filter, specifically, as shown in an enlarged perspective view A in FIG. Note that FIG. A shows one aspect based on the present invention, and all of the regions of the filter F1 (I), the filter F2 (II), and the no filter (III) are on the

[0012]

Hereinafter, the description of FIG. 2 is continued. In this description, an example using only the first filter F1 and the second filter F2 is used.

FIG. 3 is a plan view showing the

In the example of this figure, an

[0013]

The image pickup signal S of FIG. 1 is obtained using such a filter group, and predetermined processing is performed by the

FIG. 4 is a flowchart showing an example of processing by the

Step S11: The average of the luminance values for 512 pixels × 120 (480/4) pixels in FIG. 3 is calculated. In this case, pixel information for each row is thinned out to ¼ as an example. This row-by-row pixel information is temporarily stored in a memory in the arithmetic processing unit 12 (see a

[0014]

Step S12: Based on the average luminance value calculated in step S11, the CPU is used to determine the environment (day or night) in which the vehicle is placed.

Step S13: If it is determined by the above judgment that it is daytime, only the odd-numbered rows on which the first filter F1 is placed are scanned by the interlace method. At this time, the first filter F1 obtains the imaging signal S for the entire wavelength band including the wavelength band B of FIG. As a result, daytime image recognition performance can be sufficiently ensured as before.

[0015]

Step S14: On the other hand, if it is determined by the above judgment that it is night, this time, only the even-numbered rows on which the second filter F2 is placed are scanned under the interlace method. As the second filter F2 at this time, an imaging signal S for all the wavelength bands (blue, green, and red) excluding the wavelength band B of FIG. 2 is obtained. As a result, the blur caused by the band B at night is eliminated, and the image recognition performance at night is greatly improved as compared with the past.

[0016]

As described above, it is possible to select optimum filter characteristics for day and night, and the first problem described above is solved.

In this case, since only the imaging surfaces belonging to one of the first and second filters F1 and F2 are used, the amount of image information is almost halved compared to the amount of image information originally obtained. However, according to the actual results, the decrease in the image recognition capability was not a problem in practical use. Such a decrease in capacity is well offset by the effect of complete elimination of blur. Thus, when the vehicle ahead is recognized at night, for example, the outline of the vehicle can be captured very clearly.

[0017]

Further, as described above, since the amount of image information to be used is almost halved, the memory capacity of the

[0018]

DETAILED DESCRIPTION OF THE INVENTION

FIG. 5 is a diagram showing a specific example of the apparatus configuration of FIG. Throughout the drawings, similar components are denoted by the same reference numerals or symbols.

As shown in FIG. 1, the

[0019]

The

The analog image pickup signal S from the video camera (11) is input to the

[0020]

FIG. 6 is a plan view showing a first embodiment according to the present invention,

FIG. 7 is a graph used for explaining the first embodiment. 6 is the same as FIG. 3, and the view of FIG. 7 is the same as FIG.

In the first embodiment, the plurality of regions described above are composed of a first region I and a third region III. In addition, the first filter F1 provided in the first region I is an infrared cut filter.

[0021]

As a result, the portion C of the sensor signal that causes blurring (equivalent to the blurring described above) in FIG. 7 is removed by the infrared cut filter (F1).

More specifically, in order to cope with nighttime when the stop lamp of the vehicle ahead is blurred, the characteristics of the odd-numbered and even-numbered filters are changed. That is, the odd-numbered rows are without a filter, and the even-numbered rows are infrared cut filters (F1). As the processing at this time, the

[0022]

・ In the daytime, select the odd field without filter,

-At night, select an even field with an infrared cut filter (F1).

FIG. 8 is a plan view showing a second embodiment according to the present invention.

FIG. 9 is a graph used for explaining the second embodiment. 8 is the same as FIG. 3 and FIG. 9 is the same as FIG.

[0023]

In the second embodiment, the plurality of regions described above are composed of a first region I, a second region II, and a third region III. The first filter F1 provided in the first region I is an infrared cut filter, and the second filter F2 provided in the second region II is also an infrared cut filter, and the first filter F1 and the second filter F2 are provided. The spectral sensitivity characteristics are different from each other.

[0024]

As a result, the portion C (same as C in FIG. 7) that causes the blur in FIG. 9 is removed by the infrared cut filter (F1) or the infrared cut filter (F2).

More specifically, in the nighttime when the stop lamp of the vehicle ahead is blurred, the characteristics of the filter are changed every three rows. That is, if n is an integer and n = 0, 1,.

3n + 1 line: No filter

3n + 2 line: Infrared cut filter 1 (F1)

3n + 3 line: Infrared cut filter 2 (F2)

And As the processing at this time, the

[0025]

・ If noon, select 3n + 1 line without filter,

・ At night, when blurring is small, select 3n + 2 lines of

・ At night, when blurring is large, select 3n + 3 rows of

The

[0026]

FIG. 10 is a plan view showing a third embodiment according to the present invention.

While the first embodiment (FIG. 6) is in units of rows, the third embodiment is in units of columns.

More specifically, the characteristics of the odd-numbered and even-numbered filters are changed in order to cope with nighttime when the stop lamp of the vehicle ahead is blurred. That is, the odd-numbered columns are without a filter, and the even-numbered columns are infrared cut filters (F1). As processing at this time, the

[0027]

・ In the daytime, select an odd-numbered column without a filter,

-At night, select an even column with an infrared cut filter (F1).

FIG. 11 is a plan view showing a fourth embodiment according to the present invention.

The second embodiment (FIG. 8) is in units of rows, whereas the fourth embodiment is in units of columns.

[0028]

More specifically, the characteristics of the filters of the 3n + 1 column, the 3n + 2 column, and the 3n + 3 column are changed in order to cope with the night when the stop lamp of the vehicle ahead is blurred. That is, if n is an integer and n = 0, 1,.

3n + 1 column: no filter

3n + 2 rows: infrared cut filter 1 (F1)

3n + 3 rows: Infrared cut filter 2 (F2)

And As processing at this time, the

[0029]

・ If noon, select 3n + 1 column without filter,

・ At night, when blurring is small, select 3n + 2 rows of

・ At night, when blurring is large, select the 3n + 3 column of the

The third and fourth embodiments described above are effective when it is desired to appropriately set the left and right viewing angles from the video camera. For example, this is effective when a video camera is provided on the rear window side of the vehicle and it is desired to check a white lane mark on the road that is developed behind the vehicle (described later).

[0030]

In order to extract the image pickup signal S in units of columns according to the third and fourth embodiments, the interlace method as in the first and second embodiments cannot be used as it is. .

That is, in the case of the first and second embodiments, the plurality of regions described above that are divided in units of rows are defined by one of the odd-numbered or even-numbered rows of the

[0031]

However, in the case of the third and fourth embodiments, the

[0032]

For example, the memory I / F (interface)

[0033]

The count value to be selected depends most simply on whether the environment in which the vehicle is placed is daytime or nighttime. Such day / night identification is performed by the

That is, the

[0034]

The first and second embodiments are based on filter processing only in units of rows, and the third and fourth embodiments are based on filter processing only in columns. If this is further developed, it can be based on a filter processing based on a combination of row units and column units.

FIG. 12 is a diagram showing a fifth embodiment according to the present invention.

[0035]

In the fifth embodiment, filter processing is performed in a composite of row units and column units. In FIG. 12, the first region I (with the first filter F1), the second region II (with the second filter F2), and the third region III (without the filter) are all adopted as the plurality of regions described above. It shows that these regions are arranged in a grid pattern.

Thus, in this fifth embodiment, in the image processing apparatus comprising the

The

[0036]

FIG. 13 is a graph used for explaining the sixth embodiment according to the present invention.

In each of the embodiments described above, an infrared cut filter is used as the first filter F1 (second filter F2). However, in the sixth embodiment (and the seventh embodiment described later), a filter having a uniform density (all wavelength bands) An ND (Neutral Density) filter, which is a filter that suppresses the amount of transmitted light substantially uniformly over (a wavelength band that requires attenuation), is used.

[0037]

That is, the plurality of regions described above are configured by the first region I and the third region III, and the first filter F1 provided in the first region I is an ND filter. .

In each of the above-described embodiments, the cause C of blurring is removed by the infrared cut filter. In the sixth embodiment (seventh embodiment), the ND filter is used to uniformly reduce the transmittance over the entire wavelength band. (suppressing amount of transmitted light) by, in which so as to eliminate the cause C. The effect of preventing the above-described blur is almost the same as that of the infrared cut filter.

[0038]

In FIG. 13, a curve D represents the transmittance characteristic lowered by the ND filter.

FIG. 14 is a graph used for explaining the seventh embodiment according to the present invention.

In the seventh embodiment, the plurality of regions described above are composed of a first region I, a second region II, and a third region III, and the first filter F1 provided in the first region I is an ND filter. The second filter F2 provided in the second region is also an ND filter, and is characterized in that the transmittance characteristics of the first filter F1 and the second filter F2 are different from each other.

[0039]

Referring to FIG. 14, a curve D1 represents the transmittance characteristic of the first ND filter (F1), and a curve D2 represents the transmittance characteristic of the second ND filter (F2). The transmittance of F1 is set larger than the transmittance of F2. Each role is the same as the roles of the first infrared cut filter (F1) and the second infrared cut filter described above.

[0040]

Although the case where the video camera is provided mainly on the front window side of the vehicle has been described in the above embodiment, the case where this video camera is provided on the rear window side of the vehicle will be described below. Moreover, although the infrared cut filter and the ND filter have been described as the filters to be used, in the following description, a case where an RGB color filter is also incorporated will be described.

[0041]

FIG. 15 is a view showing an eighth embodiment according to the present invention.

In the eighth embodiment, the plurality of regions described above are divided only in column units, and the first region I arranged in the middle portion of the

[0042]

FIG. 16 is a diagram showing an example of a captured image under the eighth embodiment.

In this figure, 41 is a display and displays the image | video of the back side of a vehicle. This figure displays a night image, and a rear vehicle is shown in the center (rear vehicle portion in FIG. 15).

When driving at night, there are times when it is desirable to clearly display only the lane mark (white line) 5 on the road developed behind the vehicle. Therefore, the portions of the

[0043]

The image to be developed in the vehicle rear, in addition to the above, there is a case of using, for example, as a confirmation of the vehicle rear during parking. In this case, a color image, it is necessary to project a central portion of the field of view clearly. Providing a RGB color filter (F1) in FIG. 15 for the center of the

[0044]

More specifically, when recognizing a white line behind a video camera (see 52 in FIG. 18) attached to the rear of the vehicle, the filter characteristics are changed depending on the range where the vehicle exists and the range where the white line exists. To do. Ie

Vehicle part 1: RGB color filter (I)

White line part 5: No filter (III)

And As the processing at this time, in order to display the video in the central portion on the screen, color display is necessary. .

[0045]

FIG. 17 is a diagram showing a ninth embodiment according to the present invention.

The ninth embodiment is a modification of the eighth embodiment and can be employed when the amount of light in the white line portion (5) is too strong.

That is, in the ninth embodiment, the plurality of regions described above are divided only in column units, and the first region I arranged in the middle portion of the

[0046]

As for the above infrared cut filter (F2), it can be further divided into two stages this. This is as shown by F1 and F2 of the double arrows in FIG.

In other words, the infrared cut filter forming the second filter F2 includes a first infrared cut filter and a second infrared cut filter, and the spectral sensitivity characteristics of the first and second infrared cut filters are different from each other. I will let you.

[0047]

And as a further modification, it is also possible to ND filter described above in place of the infrared cut filter. That is, according to such an embodiment, the plurality of regions described above are divided only in column units, and the first region I arranged in the middle portion of the

[0048]

And for this ND filter (F2), or it may be further divided into two stages this. This is as shown as curves D1 and D2 in FIG. 14 described above.

Under such an embodiment, the ND filter forming the second filter F2 includes the first ND filter and the second ND filter, and the transmittance characteristics of the first and second ND filters are made different from each other.

[0049]

In a tenth embodiment described below, not only a video camera but also illumination means for raising an image behind the vehicle are provided behind the vehicle.

FIG. 18 is a perspective view for explaining a tenth embodiment according to the present invention.

In this figure, the

[0050]

As the illumination means 51, a light emitting element that emits light at a specific wavelength is used. In the example of this figure, an infrared LED is used as the light emitting element (

Figure 19 is a diagram showing a tenth embodiment according to the present invention, shown with a graph G representing the spectral sensitivity characteristics.

[0051]

In the above example, an infrared LED (specific wavelength is 950 nm) is used as the illuminating means 51, and the specific wavelength filter that transmits this specific wavelength region (see H in the graph G of FIG. 19) is used as the second filter F2. Use.

That is, in the tenth embodiment, the plurality of regions described above are divided only in column units, and the first region I arranged in the middle portion of the

[0052]

Further, the specific wavelength filter (F2) includes a first specific wavelength filter and a second specific wavelength filter, and the transmittance characteristics of the first and second specific wavelength filters are different from each other. You can also.

[0053]

【The invention's effect】

As described above, according to the present invention, a video camera in which a desired filter is selectively arranged on the

Thereby, a desired image can be obtained more clearly.

Further, by selectively using a desired filter, the memory capacity of the

[Brief description of the drawings]

FIG. 1 is a diagram showing a basic configuration of an image processing apparatus according to the present invention.

FIG. 2 is a graph showing spectral sensitivity characteristics of the

FIG. 3 is a plan view showing a

FIG. 4 is a flowchart illustrating an example of processing by the

FIG. 5 is a diagram showing a specific example of the device configuration of FIG. 1;

FIG. 6 is a plan view showing a first embodiment according to the present invention.

FIG. 7 is a graph used for explaining the first embodiment.

FIG. 8 is a plan view showing a second embodiment according to the present invention.

FIG. 9 is a graph used for explaining the second embodiment.

FIG. 10 is a plan view showing a third embodiment according to the present invention.

FIG. 11 is a plan view showing a fourth embodiment according to the present invention.

FIG. 12 is a plan view showing a fifth embodiment according to the present invention.

FIG. 13 is a graph used for explaining a sixth embodiment according to the present invention.

FIG. 14 is a graph used for explaining a seventh embodiment according to the present invention.

FIG. 15 is a diagram showing an eighth embodiment according to the present invention.

16 is a diagram showing an example of a captured image under the eighth embodiment.

FIG. 17 is a diagram showing a ninth embodiment according to the present invention.

18 is a perspective view for explaining a tenth embodiment according to the present invention.

FIG. 19 shows a tenth embodiment according to the present invention.

20 is a diagram illustrating an example of an image showing a first problem of the prior art.

[Explanation of symbols]

1 ... Vehicle

2, 3, 4 ... Brake lamp

5 ... Lane mark

10. Image processing apparatus

11 ... Optical system (video camera)

12 ... arithmetic processing unit

13 ... Lens

14: Image sensor

14 '... Imaging surface

15 ... Filter group

21 ... Amplifier

22 ... ADC

23. Memory I / F control circuit

24 ... Memory

25 ... CPU

31 ... Counter

41 ... Display

51. Illumination means

52 ... Video camera

S: Imaging signal

I ... 1st area

II ... 2nd area

III ... 3rd area

F1 ... 1st filter

F2 ... Second filter

Claims (3)

前記カメラの撮像信号を入力として画像処理を行う画像処理装置と、を備え、

前記カメラは、

前記撮像素子が複数の領域に区分されると共に、前記複数の領域のうち、所定の領域の撮像面上に配置されるフィルタを備え、

前記画像処理装置は、

周囲環境に基づいて、前記撮像信号の画像処理を行う処理範囲を設定する演算処理部を備え、

前記フィルタとして少なくともRGBカラーフィルタを含み、かつ該RGBカラーフィルタが配置される前記所定の領域は、前記撮像面の左右部分を除いた中央に位置する領域であることを特徴とする画像処理システム。A camera having an image sensor;

An image processing device that performs image processing using an imaging signal of the camera as an input,

The camera

The image pickup device is divided into a plurality of regions, and includes a filter disposed on an image pickup surface of a predetermined region among the plurality of regions,

The image processing apparatus includes:

Based on the ambient environment, an arithmetic processing unit for setting the processing range for performing image processing of the image signal,

An image processing system comprising: at least an RGB color filter as the filter, and the predetermined region in which the RGB color filter is disposed is a region located in the center excluding the left and right portions of the imaging surface .

前記演算処理部は、周囲環境に基づいて、前記撮像信号の画像処理を行う処理範囲を設定し、

前記フィルタとして少なくともRGBカラーフィルタを含み、かつ該RGBカラーフィルタが配置される前記所定の領域は、前記撮像面の左右部分を除いた中央に位置する領域であることを特徴とする画像処理装置。An image pickup device having an image pickup device, wherein the image pickup device is divided into a plurality of regions, and an image pickup signal from a camera including a filter disposed on an image pickup surface of a predetermined region of the plurality of regions is input; An arithmetic processing unit that performs image processing on the input imaging signal;

The arithmetic processing unit sets a processing range based on the surrounding environment, performs image processing of the image signal,

An image processing apparatus comprising: at least an RGB color filter as the filter, and the predetermined region where the RGB color filter is disposed is a region located in the center excluding the left and right portions of the imaging surface .

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2000273297A JP4641601B2 (en) | 2000-09-08 | 2000-09-08 | Image processing apparatus and image processing system |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2000273297A JP4641601B2 (en) | 2000-09-08 | 2000-09-08 | Image processing apparatus and image processing system |

Publications (3)

| Publication Number | Publication Date |

|---|---|

| JP2002084534A JP2002084534A (en) | 2002-03-22 |

| JP2002084534A5 JP2002084534A5 (en) | 2007-10-04 |

| JP4641601B2 true JP4641601B2 (en) | 2011-03-02 |

Family

ID=18759266

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2000273297A Expired - Fee Related JP4641601B2 (en) | 2000-09-08 | 2000-09-08 | Image processing apparatus and image processing system |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP4641601B2 (en) |

Families Citing this family (3)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US7746396B2 (en) | 2003-12-17 | 2010-06-29 | Nokia Corporation | Imaging device and method of creating image file |

| JP2005292784A (en) * | 2004-03-09 | 2005-10-20 | Nikon Corp | Photometric device equipped with color measuring function and camera equipped with photometric device |

| JP6197291B2 (en) * | 2012-03-21 | 2017-09-20 | 株式会社リコー | Compound eye camera device and vehicle equipped with the same |

Family Cites Families (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3187820B2 (en) * | 1990-05-29 | 2001-07-16 | 三洋電機株式会社 | Imaging device |

| JPH05296766A (en) * | 1992-04-16 | 1993-11-09 | Canon Inc | Obstacle detector |

| JPH07322142A (en) * | 1994-05-26 | 1995-12-08 | Hitachi Denshi Ltd | Solid-state image sensor and television camera using the same |

| JP2850890B2 (en) * | 1996-12-02 | 1999-01-27 | 日本電気株式会社 | Composite sensor type vehicle detector |

| JPH11103407A (en) * | 1997-09-29 | 1999-04-13 | Nec Corp | Ccd data pixel interpolating circuit and digital still camera provided with the same |

-

2000

- 2000-09-08 JP JP2000273297A patent/JP4641601B2/en not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| JP2002084534A (en) | 2002-03-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN104512411B (en) | Vehicle control system and imaging sensor | |

| US9912876B1 (en) | Vehicle vision system with enhanced low light capabilities | |

| JP3909691B2 (en) | In-vehicle image processing device | |

| KR101367637B1 (en) | Monitoring device | |

| US20120218410A1 (en) | System and method of assisting visibility of driver | |

| EP2351351A1 (en) | A method and a system for detecting the presence of an impediment on a lens of an image capture device to light passing through the lens of an image capture device | |

| JP4399174B2 (en) | Vehicle equipped with automobile display unit, automobile night vision device and automobile infrared night vision device | |

| JPH0951484A (en) | Light quantity controller for electronic camera | |

| JP2005051791A (en) | Sensor array with various optical sensors | |

| JP4798945B2 (en) | Imaging device | |

| WO2016162983A1 (en) | Vehicle-mounted camera | |

| JP2008053901A (en) | Imaging apparatus and imaging method | |

| JP2018007038A (en) | Electronic device, automobile, imaging device, and image recording device | |

| US20080012942A1 (en) | Imaging System | |

| JP4641601B2 (en) | Image processing apparatus and image processing system | |

| KR101070050B1 (en) | Multifunctional camera module | |

| JP6933955B2 (en) | Side mirror device, side mirror system, and vehicle | |

| JP2001111989A (en) | In-vehicle imaging device | |

| CN113126252A (en) | Low-light-level imaging system | |

| WO2019177036A1 (en) | Vehicle imaging system | |

| JP2006024120A (en) | Image processing system for vehicle and image processing apparatus | |

| KR101548987B1 (en) | Video Event Data Recorder having improved visibility and image processing method of the same | |

| JP7051667B2 (en) | In-vehicle device | |

| JPH06233309A (en) | Improving method for contrast of displayed image | |

| JP2005196423A (en) | Image display method, image display system, and image processing apparatus |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20070822 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20070822 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20100415 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20100420 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20100621 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20101102 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20101130 |

|

| R150 | Certificate of patent or registration of utility model |

Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20131210 Year of fee payment: 3 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20131210 Year of fee payment: 3 |

|

| LAPS | Cancellation because of no payment of annual fees |