JP2020515931A - シーンのセグメンテーションと3d再構築を組み合わせるための方法及び装置 - Google Patents

シーンのセグメンテーションと3d再構築を組み合わせるための方法及び装置 Download PDFInfo

- Publication number

- JP2020515931A JP2020515931A JP2019533614A JP2019533614A JP2020515931A JP 2020515931 A JP2020515931 A JP 2020515931A JP 2019533614 A JP2019533614 A JP 2019533614A JP 2019533614 A JP2019533614 A JP 2019533614A JP 2020515931 A JP2020515931 A JP 2020515931A

- Authority

- JP

- Japan

- Prior art keywords

- initial

- reconstruction

- segmentation

- features

- enhanced

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Withdrawn

Links

- 230000011218 segmentation Effects 0.000 title claims abstract description 188

- 238000000034 method Methods 0.000 title claims abstract description 58

- 238000012804 iterative process Methods 0.000 claims description 15

- 238000004590 computer program Methods 0.000 claims description 6

- 238000012545 processing Methods 0.000 claims description 6

- 230000002708 enhancing effect Effects 0.000 claims description 4

- 238000004891 communication Methods 0.000 claims description 2

- 230000003190 augmentative effect Effects 0.000 abstract description 5

- 230000006870 function Effects 0.000 description 23

- 238000005457 optimization Methods 0.000 description 9

- 238000011144 upstream manufacturing Methods 0.000 description 6

- 238000012549 training Methods 0.000 description 5

- 230000008901 benefit Effects 0.000 description 3

- 238000007781 pre-processing Methods 0.000 description 3

- 102000008115 Signaling Lymphocytic Activation Molecule Family Member 1 Human genes 0.000 description 2

- 108010074687 Signaling Lymphocytic Activation Molecule Family Member 1 Proteins 0.000 description 2

- 230000018109 developmental process Effects 0.000 description 2

- 238000001914 filtration Methods 0.000 description 2

- 230000004927 fusion Effects 0.000 description 2

- 230000003993 interaction Effects 0.000 description 2

- 238000002372 labelling Methods 0.000 description 2

- 238000013507 mapping Methods 0.000 description 2

- 238000005259 measurement Methods 0.000 description 2

- 230000002085 persistent effect Effects 0.000 description 2

- 230000008569 process Effects 0.000 description 2

- 238000010420 art technique Methods 0.000 description 1

- 230000008859 change Effects 0.000 description 1

- 230000000295 complement effect Effects 0.000 description 1

- 238000001514 detection method Methods 0.000 description 1

- 238000011161 development Methods 0.000 description 1

- 238000010586 diagram Methods 0.000 description 1

- 238000005516 engineering process Methods 0.000 description 1

- 238000009499 grossing Methods 0.000 description 1

- 230000009467 reduction Effects 0.000 description 1

- 230000008439 repair process Effects 0.000 description 1

- 238000005070 sampling Methods 0.000 description 1

- 230000000007 visual effect Effects 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/60—Analysis of geometric attributes

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/10—Segmentation; Edge detection

- G06T7/11—Region-based segmentation

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/10—Segmentation; Edge detection

- G06T7/12—Edge-based segmentation

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T17/00—Three dimensional [3D] modelling, e.g. data description of 3D objects

- G06T17/10—Constructive solid geometry [CSG] using solid primitives, e.g. cylinders, cubes

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/30—Determination of transform parameters for the alignment of images, i.e. image registration

- G06T7/33—Determination of transform parameters for the alignment of images, i.e. image registration using feature-based methods

- G06T7/344—Determination of transform parameters for the alignment of images, i.e. image registration using feature-based methods involving models

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/50—Depth or shape recovery

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/50—Depth or shape recovery

- G06T7/507—Depth or shape recovery from shading

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/50—Depth or shape recovery

- G06T7/55—Depth or shape recovery from multiple images

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10004—Still image; Photographic image

- G06T2207/10012—Stereo images

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10016—Video; Image sequence

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/10—Image acquisition modality

- G06T2207/10028—Range image; Depth image; 3D point clouds

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Geometry (AREA)

- Computer Graphics (AREA)

- Software Systems (AREA)

- Image Analysis (AREA)

- Processing Or Creating Images (AREA)

- Image Generation (AREA)

Abstract

シーンの少なくとも1つの画像のセットから、このシーンのセグメンテーションと3D再構築を組み合わせる方法は、−シーンの初期3D再構築を取得すること(11)と、−初期3D再構築に関連付けられた初期3D特徴を取得すること(12)と、−初期3D再構築の初期セグメンテーションを取得すること(13)と、−シーンの初期3D再構築に関連付けられた初期3D特徴に対応するように、初期3D特徴から、かつセットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定すること(14)であって、強化された3D特徴が初期セグメンテーションに少なくとも部分的に対応することと、−初期セグメンテーションと強化された3D特徴から、強化されたセグメンテーションと改良された3D再構築を決定すること(15)とを含む。拡張現実感への適用。

Description

1.技術分野

本開示は、信号処理の分野に関し、より詳細には、画像又は動画の処理に関する。

本開示は、信号処理の分野に関し、より詳細には、画像又は動画の処理に関する。

より詳細には、本開示は、従来技術の技法のいくつかと比較して、シーンのセグメンテーションと再構築を改善することを目的として、このシーンのセグメンテーションと3D再構築を組み合わせるための方法に関する。

本開示は、3D再構築が対象となるあらゆる用途に特に適している。たとえば、ナビゲーション、自律ロボット工学、バーチャル・リアリティ、拡張現実感及び/又は複合現実感、スマート・ホーム機器などのような分野では、そうした場合となり得る。

2.背景技術

このセクションは、技術の様々な態様を読者に紹介するものであり、これらの態様は、以下で説明され、及び/又は特許請求の範囲に記載されている本開示の様々な態様に関連していてもよい。本開示の様々な態様の理解がさらに進むよう、読者に背景情報を提示する際に、この考察が有益であると考えられる。したがって、こうした説明は、この観点から読むべきであり、従来技術を認めるものとして読むべきではないことを理解されたい。

このセクションは、技術の様々な態様を読者に紹介するものであり、これらの態様は、以下で説明され、及び/又は特許請求の範囲に記載されている本開示の様々な態様に関連していてもよい。本開示の様々な態様の理解がさらに進むよう、読者に背景情報を提示する際に、この考察が有益であると考えられる。したがって、こうした説明は、この観点から読むべきであり、従来技術を認めるものとして読むべきではないことを理解されたい。

奥行きセンサの開発に伴って、3Dデータを処理しなければならない装置がますます増えてきている。したがって、取り込んだデータを処理し、シーンをさらに良好に理解できるようにするには、困難な課題が持ち上がっている。具体的には、シーンの正確な3D表現を実現するには、セグメンテーションと3D再構築の両方が重要である。

3Dシーンのセグメンテーションは、この3Dシーンを複数のセグメント又は構成要素に分割することとして定義され、このセグメントのそれぞれは、1組の隣接画素を含み、ラベルによって好都合に識別される。

セグメンテーション及び3D再構築は、まずは別々に考えられてきた。その結果は、満足するものではなかった。

3Dメッシュの形で点群の3D再構築を強化することは、たとえば、Autodesk, Inc.の米国特許出願第2015/0146971A1号に記載されている。この文書によれば、点群は、写真画像データとスキャン・データの組合せから生成され、初期の粗いメッシュが、この点群データから推定され、3Dメッシュ全体にわたる画像ペア間のフォトコンシステンシーを最大化し、3Dメッシュと点群の間の3D距離を最小限に抑えることによって、その粗いメッシュが繰り返し改善される。

通常、セグメンテーションの性能は、3D再構築によって影響され、その逆の場合も同様なので、セグメンテーションと3D再構築は一緒に考えられてきた。そうするために、従来技術での各技法のうちいくつかは、ラベル付けされたトレーニング・データセットに基づく、セマンティック・セグメンテーションと再構築の組合せを利用している。

たとえば、C.Haneらにより、「Joint 3D Scene Reconstruction and Class Segmentation」(IEEE Conference on Computer Vision and Patter Recognition(CVPR)、2013年)において、セグメンテーションと密な再構築を組み合わせる問題への解決策が開示されている。データ画像とそれに対応する奥行きマップが入力として取り出され、正確なクラス・ラベルを用いた3D再構築が出力として生成される。著者らは、従来の立体再構築法を、マルチラベル立体セグメンテーション・フレームワークにまで拡張している。この技法によれば、外観ベースの手がかり、及び3D表面配向プライア(prior)は、トレーニング・データから学習され、続いて、クラス固有の正則化に使用される。こうしたプライアは、奥行きマップから得られる測定済みの証拠を互いに補完し合って、再構築とラベリングを一緒に改善する。

A. Kunduらによる「Joint Semantic Segmentation and 3D Reconstruction from Monocular Video」(European Conference on Computer Vision、2014年)において、単眼画像ストリームから始まり、視覚的SLAM(「同時位置決め地図作成」)及び初期の2Dシーン解析が実行される。この技法は、3D構造とセマンティック・ラベルの両方を示す3Dマップを生成する。この技法によると、カテゴリ固有のセンサ・モデルを使用して、SLAMからの奥行き推定を強化し、連続したカメラ位置からの空きスペースを知ることで、構造のあいまいさを低減するのに役立つ。

前述の技法は両方とも、セマンティック・セグメンテーションを考慮に入れ、オブジェクト・カテゴリ固有の手がかりを使用して3D再構築を実現する。したがって、これらの技法の性能は、トレーニング・データ、特にオブジェクト・カテゴリの数のような、データセットのスケーラビリティに依存する。さらに、再構築は、立体データとして示され、したがって空間分解能の観点から制限される。さらに、最終の3D再構築は、幾何学的な観点からは比較的粗い。たとえば、オブジェクトの鋭いエッジは滑らかであることが多く、直線はノイズの多いデータの影響を受けることが多い。したがって、3D再構築は、用途によっては、さらに細かい相互作用をおこなうのに十分なほど正確ではない。

したがって、特にオブジェクトの幾何学的形状の、良好な再構築の質を可能にする、シーンのセグメンテーションと3D再構築の組合せのための方法が必要となっている。

3.概要

本開示は、シーンの少なくとも1つの画像のセットから、このシーンのセグメンテーションと3D再構築を組み合わせる方法に関し、シーンのセグメンテーションが、このシーンの3D再構築の各セグメントへの分割に対応し、この方法は、

−シーンの初期3D再構築を取得することと、

−この初期3D再構築に関連付けられた初期3D特徴を取得することと、

−この初期3D再構築の初期セグメンテーションを取得することと、

−シーンの前記初期3D再構築に関連付けられた初期3D特徴に対応するように、初期3D特徴から、かつセットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定することであって、この強化された3D特徴が初期セグメンテーションに少なくとも部分的に対応することと、

−初期セグメンテーションと強化された3D特徴の両方から、強化されたセグメンテーションと改良された3D再構築の両方を決定することと

を含む。

本開示は、シーンの少なくとも1つの画像のセットから、このシーンのセグメンテーションと3D再構築を組み合わせる方法に関し、シーンのセグメンテーションが、このシーンの3D再構築の各セグメントへの分割に対応し、この方法は、

−シーンの初期3D再構築を取得することと、

−この初期3D再構築に関連付けられた初期3D特徴を取得することと、

−この初期3D再構築の初期セグメンテーションを取得することと、

−シーンの前記初期3D再構築に関連付けられた初期3D特徴に対応するように、初期3D特徴から、かつセットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定することであって、この強化された3D特徴が初期セグメンテーションに少なくとも部分的に対応することと、

−初期セグメンテーションと強化された3D特徴の両方から、強化されたセグメンテーションと改良された3D再構築の両方を決定することと

を含む。

したがって、本開示には、シーンのセグメンテーションと3D再構築の組合せのための新規で発明性のある解決策が提案されており、このシーンを、特にオブジェクトとすることができ、前述の欠点のうち少なくとも1つを克服する。特に、本開示は、トレーニング・データセットを利用しない。

セグメンテーションの性能は、シーンの3D再構築によって改善することができ、またその逆の場合も同様なので、セグメンテーションと再構築の両方は互いに寄与することができ、一緒に考えることができる。

セグメンテーションが3D再構築の影響を受け、3D再構築がセグメンテーションの影響を受けるという点で、このセグメンテーションと3D再構築は「ジョイント(joint)」と呼ばれる。初期セグメンテーションからだけでなく、強化された3D特徴からも、強化されたセグメンテーションを決定することによって、また、強化された3D特徴からだけでなく、初期セグメンテーションからも、改良された3D再構築を決定することによって、これが表現される。

より具体的には、本開示は、初期3Dモデルとも呼ばれる、シーンの初期3D再構築を改良し、画像データ内で決定された初期2D特徴によってセグメンテーションを強化するための解決策を提供する。したがって、本開示の少なくとも1つの実施形態によれば、改良された3D再構築及び強化されたセグメンテーションが一緒に決定される。

2D特徴を考慮に入れることによって、特に幾何学的形状の観点から、したがってシーンの正確な3D再構築を実現することができる。強化されたセグメンテーションをも取得することができる。

このような、改良された、又は正確な3D再構築及び強化されたセグメンテーションは、次いで、拡張現実感におけるテクスチャ・マッピング、変形、衝突検出など、さらなる用途で使用することができる。

たとえば、シーンの3D再構築は、

−点群、

−メッシュ・モデル、

−立体モデル

を含むグループに属する。

−点群、

−メッシュ・モデル、

−立体モデル

を含むグループに属する。

したがって、改良された3D再構築(すなわち、強化された3D特徴から改良される初期3D再構築)において、3D要素の構成要素のラベルを更新することによって、セグメンテーションを強化することができる。「3D要素」は、たとえば、点群の点、多角形メッシュ・モデルの多角形、立体モデルのボクセルなどであり、「構成要素」は、同じラベル、たとえば平面領域を有する3D要素のグループである。

各実装形態に応じて、強化された3D特徴は、初期3D特徴を介して、並びに/又は初期3D特徴及び初期2D特徴から、強化された3D特徴を決定することを介して、少なくとも部分的に初期セグメンテーションに対応する。

したがって、特定の実装形態では、初期セグメンテーションの構成要素間の境界が、初期3D特徴のうちの少なくともいくつかとして、初期3Dの特徴点又は特徴線を提示している。次いでこの初期3D特徴は、強化された3D特徴を構築するのに使用され、それ自体、強化されたセグメンテーション及び改良された3D再構築を決定する際に使用される。

他の実施形態では、これを以前のものと組み合わせることができ、強化された3D特徴は、初期3D特徴及び初期2D特徴からだけでなく、初期セグメンテーションからも決定され、それにより、強化された3D特徴に直接寄与し、したがって、改良された3D再構築に直接寄与する。関連する実施形態によっては、初期3D特徴、初期2D特徴、及び初期セグメンテーションから、強化された3D特徴とともに、改良された3D再構築が決定される。

強化されたセグメンテーションについては、これは、強化された3D特徴を利用することによって、初期セグメンテーションから得られる。

一貫して、強化されたセグメンテーションは、初期セグメンテーションと強化された3D特徴の両方から決定され、改良された3D再構築も、初期セグメンテーションと強化された3D特徴の両方から決定される(前述の特定の実装形態のように、強化された3D特徴を介して初期セグメンテーションを考慮することができるときでも)。

一実施形態によれば、3D特徴は3D特徴線であり、2D特徴は2D特徴線である。別の実施形態では、3D特徴は3D点であり、2D特徴は2D点である。

したがって、セグメンテーションは、セマンティック特徴ではなく、幾何学的形状の特徴に基づいている。

したがって、この実施形態によるセグメンテーション及び3D再構築は、セマンティック/ラベル付きトレーニング・データの質及び/又はスケーラビリティには依存しない。

したがって、本開示の少なくとも1つの実施形態には、たとえば、RGB−Dデータ(赤緑青及び奥行きデータ)から、改良された形状を有するセグメント化された1組の領域を決定することを目的として、シーンのセグメンテーションと3D再構築の組合せ最適化向けのアルゴリズムが開示されている。改良された幾何学的形状によって、セグメンテーションがより正確になり、より正確なこのセグメンテーションが、幾何学的形状を改良するための追加の幾何学的な手がかりを提示する。

一実施形態によれば、シーンの初期3D再構築を取得することが、奥行きデータから初期3D再構築を構築することを含む。したがって、シーンの初期3D再構築は、上流で決定し、動作機器で直接受け取ることができるか、又は動作機器で構築することができる。

一実施形態によれば、初期3D特徴を取得することは、幾何学的特性及び/又は局所的特徴記述子を使用して、シーンの初期3D再構築において3D特徴を識別することを含む。或いは、初期3D特徴は、上流で決定されていてもよく、また動作機器で直接受け取ってもよい。

一実施形態によれば、シーンの画像のセットが、少なくとも2つの画像を含む場合、この方法は、

−可視画像として知られている、初期3D特徴を含むセットの画像を選択することと、

−この可視画像において、初期3D特徴にマッチする初期2D特徴を識別することと

から、初期2D特徴を決定することを含み、

強化された3D特徴を決定することは、

−少なくとも2つの可視画像にわたって初期2D特徴をマッチさせることによって、幾何学的な手がかりを生成することと、

−この幾何学的な手がかりを用いて初期3D特徴を強化して、強化された3D特徴を決定することと

を含む。

−可視画像として知られている、初期3D特徴を含むセットの画像を選択することと、

−この可視画像において、初期3D特徴にマッチする初期2D特徴を識別することと

から、初期2D特徴を決定することを含み、

強化された3D特徴を決定することは、

−少なくとも2つの可視画像にわたって初期2D特徴をマッチさせることによって、幾何学的な手がかりを生成することと、

−この幾何学的な手がかりを用いて初期3D特徴を強化して、強化された3D特徴を決定することと

を含む。

したがって、初期2D特徴は、画像データから決定する(すなわち、このセットの画像から得る)ことができるか、又は上流での前処理の後に動作機器で受け取ることができる。具体的には、1組の画像から可視画像を選択することで、さらなる処理を計算効率のよいものにすることができる。これはまた、(たとえば、位置及び/又は向きに関する)不正確なカメラ姿勢推定によって生成されることのある誤りの低減につながる。

可視画像にわたって初期2D特徴をマッチさせることによって、強化された3D特徴を決定することができる。2D特徴のこのようなマッチングを実際に使用して、たとえばマルチビュー・ステレオ法を利用することによって、3D幾何学的な手がかりを構築する。

一実施形態によれば、この方法は、

−強化された3D特徴から、またセットの前記少なくとも1つの画像において決定される強化された2D特徴から、シーンの改良された前記3D再構築に関連付けられた、強化された3D特徴に対応するように、さらに強化された3D特徴を決定することと、

−強化されたセグメンテーション、及びさらに強化された3D特徴から、さらに強化されたセグメンテーション及びさらに改良された3D再構築を決定することと

を、少なくとも1度は繰返し処理することを含む。

−強化された3D特徴から、またセットの前記少なくとも1つの画像において決定される強化された2D特徴から、シーンの改良された前記3D再構築に関連付けられた、強化された3D特徴に対応するように、さらに強化された3D特徴を決定することと、

−強化されたセグメンテーション、及びさらに強化された3D特徴から、さらに強化されたセグメンテーション及びさらに改良された3D再構築を決定することと

を、少なくとも1度は繰返し処理することを含む。

具体的には、このセットの前記画像は、選択された可視画像であることが好ましい。

このようにして、1つ又は複数の繰返し処理を実施して、セグメンテーションをさらに強化し、3D再構築をさらに改良することができる。

一実施形態によれば、所定の精度閾値に達したときに、この繰返し処理が停止する。このような所定の精度閾値は、少なくとも、さらに強化された3D特徴と強化された2D特徴との間のマッチングでの閾値とすることができる。

たとえば、前記所定の精度閾値は、シーンの3D再構築を各セグメントに分割する程度によって与えられるセグメンテーション・レベル、前記さらに改良された3D再構築で測定された、隣接する同様の各3D要素間のラベルの一貫性、及びセットの前記少なくとも1つの画像(たとえば、可視画像)と、前記さらに改良された3D再構築との間の位置合せ、のうち少なくとも1つに一緒に適用される。

さらに強化された3D特徴と強化された2D特徴との間のマッチングは、次いで、セットの画像とさらに改良された3D再構築との間のグローバル対応から特に留意することができ、このグローバル対応は、具体的には、対応するエネルギー関数(以下でさらに詳細に説明する)の値から確立することができる。

一実施形態によれば、改良された3D再構築又はさらに改良された3D再構築、及び、強化されたセグメンテーション又はさらに強化されたセグメンテーションは、同じ繰返し処理での少なくとも1つのエネルギー関数において考慮される。しかし、最適化問題の解決は、2つのステップで実施することができ、第1のステップでは、3D再構築を調整してセグメンテーションを強化し、第2のステップでは、強化されたこのセグメンテーションを調整して3D再構築を改良する。

より具体的には、初期化において、初期3D再構築及び強化された3D特徴から、改良された3D再構築が決定される。この改良された3D再構築を調整して、強化されたセグメンテーションを決定する。一実施形態によれば、強化されたこのセグメンテーションを調整して、さらに改良された3D再構築を決定することもできる。

後続の繰返し処理では、先行する繰返し処理において取得される3D再構築を調整して、さらに強化されたセグメンテーションを決定する。次いで、さらに強化されたセグメンテーションを調整して、さらに改良された3D再構築を決定する。

したがって、それぞれの繰返し処理では、強化されたセグメンテーションと改良された3D再構築との組合せ決定が存在する。

好ましくは、所定の精度閾値と組み合わせて、又は代替的に、所定の数の繰返し処理に達したときにこの繰返し処理を停止する。

一実施形態によれば、強化されたセグメンテーションを決定することは、セグメンテーション制約条件に依存する。こうしたセグメンテーション制約条件も「プライア」と呼ばれる。

具体的には、セグメンテーション制約条件は、平面形状、凸形状、直方体形状、円柱形状などのような、少なくとも1つのセグメント形状に関連している。

一実施形態によれば、この方法は、前記初期3D再構築及び少なくとも1つの画像の前記セットを、少なくとも1つの入力として受け取ることと、少なくとも1つのプロセッサを用いて、強化された3D特徴、強化されたセグメンテーション、及び改良された3D再構築を決定することと、少なくとも1つの出力から、前記強化されたセグメンテーション及び前記改良された3D再構築を出力して、前記改良された3D再構築をユーザに表示し、また前記強化されたセグメンテーションによって、前記改良された3D再構築を処理することとを含む。

本開示の別の態様は、通信ネットワークからダウンロード可能で、及び/又はコンピュータによる読取り可能な媒体上に記録され、及び/又はプロセッサによって実行可能なコンピュータ・プログラム製品であって、その実施形態のいずれにおいても、コンピュータ又はプロセッサによって実行されるときには、セグメンテーションと3D再構築を組み合わせる前述の方法を実行するように構成されたソフトウェア・コードを含むコンピュータ・プログラム製品に関連する。

本開示の別の態様は、コンピュータ又はプロセッサによって実行されるとき、このコンピュータ又はプロセッサが、セグメンテーションと3D再構築を組み合わせる前述の方法を、その様々な実施形態のいずれにおいても実行できるようにするコンピュータ・プログラム製品を記憶する、持続的でコンピュータ読取り可能な搬送媒体に関する。

本開示はまた、シーンの少なくとも1つの画像のセットから、このシーンのセグメンテーションと3D再構築を組み合わせるための装置に関し、シーンのセグメンテーションが、このシーンの3D再構築の各セグメントへの分割に対応し、この装置は、

−シーンの初期3D再構築を取得するための手段と、

−この初期3D再構築に関連付けられた初期3D特徴を取得するための手段と、

−この初期3D再構築の初期セグメンテーションを取得するための手段と、

−シーンの前記初期3D再構築に関連付けられた初期3D特徴に対応するように、初期3D特徴から、かつセットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定するための手段であって、この強化された3D特徴が初期セグメンテーションに少なくとも部分的に対応する手段と、

−初期セグメンテーションと強化された3D特徴の両方から、強化されたセグメンテーションと改良された3D再構築の両方を決定するための手段と

を備える。

−シーンの初期3D再構築を取得するための手段と、

−この初期3D再構築に関連付けられた初期3D特徴を取得するための手段と、

−この初期3D再構築の初期セグメンテーションを取得するための手段と、

−シーンの前記初期3D再構築に関連付けられた初期3D特徴に対応するように、初期3D特徴から、かつセットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定するための手段であって、この強化された3D特徴が初期セグメンテーションに少なくとも部分的に対応する手段と、

−初期セグメンテーションと強化された3D特徴の両方から、強化されたセグメンテーションと改良された3D再構築の両方を決定するための手段と

を備える。

この開示はさらに、シーンの少なくとも1つの画像のセットから、このシーンのセグメンテーションと3D再構築を組み合わせるための装置に関し、シーンのセグメンテーションが、このシーンの3D再構築の各セグメントへの分割に対応し、この装置は、

−シーンの初期3D再構築を取得し、

−この初期3D再構築に関連付けられた初期3D特徴を取得し、

−この初期3D再構築の初期セグメンテーションを取得し、

−シーンの前記初期3D再構築に関連付けられた初期3D特徴に対応するように、初期3D特徴から、かつセットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定し、この強化された3D特徴が初期セグメンテーションに少なくとも部分的に対応し、

−初期セグメンテーションと強化された3D特徴の両方から、強化されたセグメンテーションと改良された3D再構築の両方を決定する

ように適合され、構成された少なくとも1つのプロセッサを備える。

−シーンの初期3D再構築を取得し、

−この初期3D再構築に関連付けられた初期3D特徴を取得し、

−この初期3D再構築の初期セグメンテーションを取得し、

−シーンの前記初期3D再構築に関連付けられた初期3D特徴に対応するように、初期3D特徴から、かつセットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定し、この強化された3D特徴が初期セグメンテーションに少なくとも部分的に対応し、

−初期セグメンテーションと強化された3D特徴の両方から、強化されたセグメンテーションと改良された3D再構築の両方を決定する

ように適合され、構成された少なくとも1つのプロセッサを備える。

このような装置は、本開示によるシーンのセグメンテーションと3D再構築を組み合わせる方法を実施するのに特に適している。こうした装置は、この開示の任意の実施形態による方法に関する様々な特性を含むこともでき、そうした特性を組み合わせることができ、又は別々に取り込むこともできる。すなわち、このような装置は、本開示による、セグメンテーションと3D再構築を組み合わせる方法の実行モードのいずれをも実行するように構成されている。

したがって、この装置の特性及び利点は、その様々な実施形態のいずれかにおいて、シーンのセグメンテーションと3D再構築を組み合わせるための開示された方法と同じである。

本開示の別の態様は、前述の装置など、シーンのセグメンテーションと3D再構築を組み合わせるための装置を備える機器に関する。

したがって、このような機器の特性及び利点は、その様々な実施形態のいずれかにおいて、シーンのセグメンテーションと3D再構築を組み合わせるための、開示された方法と同じである。

具体的には、このような機器は、好ましくは携帯電話、タブレット、及びヘッドマウント・ディスプレイから選択される携帯機器とすることができる。

様々な実施形態によれば、このような機器は、好ましくはロボット、自律運転機器、及びスマート・ホーム機器から選択される自律機器とすることができる。

したがって、本開示は、ナビゲーション、自律ロボット工学、バーチャル・リアリティ、拡張現実感及び/又は複合現実感、スマート・ホーム機器などのような分野での用途に特に適している。

したがって、本開示はまた、このような分野への本開示の適用に関する。

開示された各実施形態と範囲が同等の、特定の態様を以下に説明する。こうした態様は、本開示がとり得る特定の形態の概要を、読者に提供するためだけに提示されるものであり、こうした態様が本開示の範囲を限定するものではないことを理解されたい。実際、この開示は、以下に説明されていない場合もある様々な態様を包含してもよい。

4.図面の簡単な説明

添付図を参照して、決して限定的ではない以下の実施形態及び実行例によって、この開示がより良好に理解され、また例示されよう。

添付図を参照して、決して限定的ではない以下の実施形態及び実行例によって、この開示がより良好に理解され、また例示されよう。

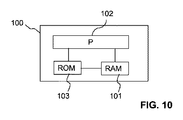

図1、図2、及び図10では、示された各ブロックは、単に機能的な構成要素であり、物理的に別々の構成要素には必ずしも対応していない。すなわち、こうした構成要素は、ソフトウェア、ハードウェアの形態で開発することもでき、又は、1つ若しくは複数のプロセッサを含む、1つ若しくはいくつかの集積回路で実装することもできる。

5.実施形態の説明

本開示の各図及び説明は、本開示の明確な理解に関連する各要素を示すために簡略化してきたが、明確にするために、携帯機器(たとえば、携帯電話、タブレット、ヘッドマウント・ディスプレイなど)、又は自律機器(たとえば、ロボット、自律運転機器、スマート・ホーム機器など)のように、典型的な動作機器に見られる数多くの他の要素を除外してあることを理解されたい。

本開示の各図及び説明は、本開示の明確な理解に関連する各要素を示すために簡略化してきたが、明確にするために、携帯機器(たとえば、携帯電話、タブレット、ヘッドマウント・ディスプレイなど)、又は自律機器(たとえば、ロボット、自律運転機器、スマート・ホーム機器など)のように、典型的な動作機器に見られる数多くの他の要素を除外してあることを理解されたい。

本開示の一般的原理は、シーンの初期3D再構築に関連付けられた初期3D特徴に対応するように、シーンの初期3D再構築から、かつシーンの1組の画像のうち少なくとも1つの画像において決定される初期2D特徴から、このシーンの改良された3D再構築及び強化されたセグメンテーションの決定に依存する。

このシーンは、特にオブジェクトとすることもできる。したがって、このシーンは、1つ又は複数のオブジェクトで構成することができる。

具体的には、シーンの改良された3D再構築は、初期の2D特徴及び3D特徴から取得される、強化された3D特徴によって決定され、強化されたセグメンテーションは、改良された3D再構築から決定される。

本開示の一実施形態による、セグメンテーションと3D再構築を組み合わせる方法の主なステップが、図1に示してある。

たとえば、入力は、シーンの一連の画像及びその奥行きデータのようなRGB−Dデータである。変形形態では、この入力は、シーンの初期3D再構築(初期3Dモデルとも呼ばれる)、及びそのマルチビュー画像である。

ブロック11では、シーンの初期3D再構築が取得される。このような初期3D再構築は、奥行きデータから、若しくはシーンの1組の画像から構築することができるか、又は上流で決定し、動作機器/装置で直接受け取ることができる。初期3D再構築は、既知のどんな技法によっても構築できることに留意されたい。たとえばこれは、KinectFusion(登録商標)のような既製の奥行き融合ツール、又はIntel RealSense(登録商標)のような奥行きセンサによって決定することができる。

ブロック12では、初期3D再構築に関連付けられた初期3D特徴が取得される。このような初期3D特徴は、初期3D再構築を解析することによって取得することができるか、又は上流で決定し、動作機器/装置で直接受け取ることができる。

ブロック13では、初期3D再構築の初期セグメンテーションが取得される。このような初期セグメンテーションは、シーンの粗いセグメンテーションとすることもできる。この初期セグメンテーションは、既知のどんな技法によっても決定できることに留意されたい。たとえばこれは、ランダム・ラベリング又は平面領域の成長によって決定することができる。本明細書で以下に述べるように、初期セグメンテーションはまた、セグメンテーション・プライアによって制約を受ける場合がある。具体的には、たとえば「A Benchmark for 3D Mesh Segmentation」(ACM Transaction on Graphics、2009年)で、X. Chenらによって開示された技法など、先進的な技法によってセグメンテーションが決定される場合、セグメンテーション・プライアの使用を必要とはしない。しかし、対象となる用途によっては、先進的なセグメンテーション技法とともに、セグメンテーション・プライアを使用することもできる。

ブロック14では、シーンの初期3D再構築に関連付けられた初期3D特徴に対応するように、初期3D特徴、及びセットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴が決定される。初期2D特徴は、1組の画像から決定することもできるか、又は上流で決定し、動作機器/装置で直接受け取ることができる。

ブロック15では、初期セグメンテーション及び強化された3D特徴から、シーンの強化されたセグメンテーション及び改良された3D再構築が決定される。強化されたセグメンテーションは、セグメンテーション・プライアによって制約されることが好ましい。初期セグメンテーションは通常、3Dモデルを平面領域へと大まかにセグメント化するように設計されているので、強化されたセグメンテーションは、セグメンテーション・プライアによって制約されない場合には、正確な境界を有する平面領域を実現できる。したがって、シーンの完全なオブジェクトは、一連の平面構成要素にセグメント化される。先進的な用途のために、セグメンテーション・プライア(たとえば、凸面形状)を活用して、完全なオブジェクトをセグメント化する。

シーンのセグメンテーション及び3D再構築をさらに改善するために、停止条件が満たされるまで、ブロック14及び15を繰り返し実施することができる。より具体的には、それぞれの繰返し処理において、シーンの改良された3D再構築に関連付けられた、強化された3D特徴に対応するように、セットの各画像において決定される、強化された3D特徴及び強化された2D特徴から、さらに強化された3D特徴を決定することができ、次いで、強化されたセグメンテーション及びさらに強化された3D特徴から、さらに強化されたセグメンテーション及びさらに改良された3D再構築を決定することができる。

次に図2を参照すると、本開示の一実施形態が示してあり、ここで2D特徴及び3D特徴は、特徴線のような幾何学的特徴である。画像データ(画像のセットとも呼ばれる)、及び対応する奥行きデータを含む、RGB−Dデータを入力とみなす。

この実施形態によれば、メイン・ブロックは、シーンの初期3D再構築に関連付けられた3D特徴と、画像データから得られる幾何学的な手がかりとの間の対応関係を確立し、構成要素ラベルを一緒に最適化し、3Dオブジェクトについての幾何学的形状を改良するように設計されている。セグメンテーションはまた、形状の制約条件、すなわちセグメンテーション・プライアを考慮することによって強化される。

たとえば、画像データ21、奥行きデータ22、及びカメラ姿勢23は、(たとえば、奥行きセンサのソフトウェア開発キットを用いる)Intel RealSense(登録商標)のような奥行きセンサによって取得される。画像データと奥行きデータは良好に調整され、カメラ姿勢は大きな誤りなしに計算されるものと仮定する。前処理を実施して、画像データと奥行きデータを調整し、又は必要ならばカメラ姿勢を処理することができる。

ブロック221では、入力奥行きデータを前処理して、「クリーンな」データ、すなわちシーンの3D再構築に適したデータを生成する。たとえば、この前処理作業は、外れ値の排除、雑音除去、サンプリング、奥行きの修復、オーバ・セグメンテーションなどのうち、少なくとも1つを含む。

ブロック222では、処理された奥行きデータが結合(奥行き融合)されて、シーンの初期3D再構築を生成する。たとえば、KinectFusion(登録商標)のような既製のツールを使用して、シーンの初期3D再構築を生成する。出力3D再構築は、点群、メッシュ・モデル、立体モデルなどとして表すことができる。

ブロック223では、初期3D再構築に関連付けられた初期3D特徴が取得される。たとえば、3D特徴は、曲率、凸面/凹面、又は局所的な特徴記述子などの幾何学的特性を使用して、シーンの初期3D再構築から抽出される3D特徴線である。抽出されたこの初期3D特徴線は、シーン内のオブジェクトの形状を示す。

ブロック224では、シーンの初期3D再構築において初期セグメンテーションが定義されて、それぞれの3D要素が1つの構成要素にセグメント化されるようにラベル付けする。既に述べたように、「3D要素」は、点群の点、多角形メッシュ・モデルの多角形、立体モデルのボクセルなどとすることができ、「構成要素」は、同じラベルを有する3D要素、たとえば平面領域のグループである。初期セグメンテーションは、様々な構成要素間のセグメント境界を示す。これはまた、セグメンテーション・プライアによって制約を受けることがある。

ブロック211では、ブロック223でのシーンの初期3D再構築から抽出される初期3D特徴線に基づいて、画像データ21の中から可視画像が選択される。可視画像を選択するには、1つの解決策として、初期3D再構成の投影を使用して、画像のセットの各画像に3D特徴線を投影し、画像への投影の可視画素数を数えて、その画像が見えるか見えないか判定することがある(3D/2Dマッチング)。したがって、それぞれの3D特徴線について、一連の可視画像を見つけることができる。

ブロック212では、初期3D特徴線とマッチする初期2D特徴線が、選択された可視画像内で抽出される。可視画像内の3D特徴線と2D特徴線をマッチさせるために、ある測定が定義され、この測定は、2D特徴線と、これに対応する3D特徴線の投影線との間の向き及び距離を考慮に入れることもできる。

初期2D特徴線が抽出されると、ブロック213において、様々な画像内の2D特徴線間での2Dマッチングを構築することができる。たとえば、2Dマッチングは、選択された可視画像全体にわたる2D特徴線について定義される。

カメラ姿勢23にはずれが生じる場合があるという事実によって、可視画像にわたる2D特徴線間の2Dマッチングをブロック214でフィルタリングして、ノイズの多いカメラ姿勢に対応する不正確なマッチングを排除することができる。たとえば、1対の画像での1対の2Dマッチング線を考える場合、たとえば「Incremental Line-based 3D Reconstruction using Geometric Constraints」(M. Hoferら、British Machine Vision Conference、2013年)で定義されるような、たとえば、エピポーラ・マッチング法を使用することによって、それぞれの2D線を使用して3D線を再構築することができる。2つの再構築された3D線の類似性を比較することによって、マッチングのこのペアの信頼性を推定することができる。たとえば、3D線の類似性は、その長さ、向き、及び/又は距離を使用することによって評価することもできる。類似性が高い場合、対応する2D線のマッチングは信頼性が高く、このことは、このペアの画像間でのカメラ姿勢の推定の信頼性が高いことを意味する。類似性が低い場合、このことは、カメラ姿勢に大きな誤りがあり、このマッチングを排除しなければならないことを意味する。

カメラ姿勢がフィルタリングされた後、ブロック215において、可視画像全体にわたる残りの2Dマッチングから、信頼性の高い幾何学的な手がかりが生成される。すなわち、フィルタリング214の後に残っている2D特徴線を使用して、たとえばマルチビュー・ステレオ法を使用することによって、幾何学的な手がかりと呼ばれる3D特徴線を構築する。

このような幾何学的な手がかりは、組合せ最適化のブロック25において、3D幾何学的形状を改良するのに使用される強化された3D特徴を定義することを目的として、初期3D特徴への制約条件を提示することができる。

最後に、ブロック25では、初期セグメンテーション224からの各3D要素についての構成要素ラベルと、3D要素の幾何学的形状との両方が一緒に最適化されて、シーンの強化されたセグメンテーション及び改良された3D再構築を取得する。具体的には、このような最適化は、3Dセグメンテーション・プライアとも呼ばれる、セグメンテーション制約条件24に依存する。たとえば、従来のセグメンテーション・プライアは、平面性、接続性、凸面/凹面などを含むが、それだけには限定されない。セグメンテーション・プライアは、組合せを最適化するために、個々に、又は組み合わせて設定することもできる。このようなセグメンテーション・プライアは、明瞭に又は暗に使用されるなど、ユーザ又は用途のタイプによって選択されるデフォルト値に設定することができる。

本開示の一実施形態によれば、セグメンテーション・プライアをインポートするためのインタフェースが提案されており、これをあらかじめ構成することができる。たとえば、ユーザは、様々なレベルのセグメンテーションに対応するスクロール・バーを調整することができる。このセグメンテーションは、3Dシーンを各セグメントに分割する程度(特に、この分割でのセグメント数など)によって与えることができる。大規模なシーンを考えるとき、平面領域のようなセグメンテーション・プライアに対応して、低レベルのセグメンテーションが選択される。テーブルの表面のクローズアップのように小規模なシーンを考えるとき、直方体、円柱形のようなセグメンテーション・プライアに対応する、ハイレベルのセグメンテーションが選択される。

組合せ最適化のために、いくつかのエネルギー関数を定義することができる。強化されたセグメンテーション及び改良された3D表現の決定は、エネルギー関数のうち少なくとも1つを最小限に抑えることによって実施することができる。

たとえば、組合せ最適化、すなわちセグメンテーション、平滑性、及び幾何学的改良について、3つのエネルギー関数を定義することができる。たとえば、シーンの3D再構築の所望の質に応じて、各エネルギー関数の重みを調整することができる。

第1の繰返し処理では、セグメンテーション・エネルギー関数は、初期セグメンテーション224、セグメンテーション・プライア24、及び初期3D特徴223を考慮に入れることができる。このようなセグメンテーション・エネルギー関数は、たとえば、「A Benchmark for 3D Mesh Segmentation」(X. Chenら、ACM Transaction on Graphics、2009年)に開示された技法によって定義することができる。

平滑性エネルギー関数は、シーンの初期再構築で測定された、隣接する同様の3D要素間でのラベルの一貫性を考慮することができる。たとえば、それぞれの3D要素について、そのラベルと、その隣接する3D要素のラベルとの差を測定することによって、平滑性エネルギー関数を定義することができる。

改良エネルギー関数は、選択された可視画像から生成される幾何学的な手がかり215と、初期3D特徴線223との間の位置合せを測定することができる。たとえば、(セグメンテーション境界を含む)初期3D特徴線と、再構築された幾何学的な手がかりとの間の距離、向き、及び/又は長さの差を測定することによって、改良エネルギー関数を定義することができる。

こうしたエネルギー関数をともに最小限に抑えるようにすることによって、セグメンテーションと改良の組合せを実施することもできる。エネルギー関数のそれぞれは、その他のエネルギー関数のうち少なくとも1つの関数の変数の影響を受けるので、それによって、そうしたエネルギー関数間の相互作用が実現する。たとえば、初期セグメンテーション224が、セグメンテーション・エネルギー関数において修正される場合、これは、初期3D特徴223に影響を及ぼし、これにより、シーンの初期再構築においてラベル並びに3D要素が変更され、それによって平滑性エネルギー関数と改良エネルギー関数の両方に影響を及ぼす。

不正確なカメラ姿勢の場合、画像データと奥行きデータの両方から位置合せ誤りをモデル化するように、第4のエネルギー関数を定義することもできる。

組合せ最適化25の第1の繰返し処理の後、各3D要素の構成要素ラベル、及び特徴線の周りの幾何学的形状を更新することもできる。すなわち、組合せ最適化25の第1の繰返し処理の後、強化されたセグメンテーション及び改良された3D再構築を、さらに強化し、改良することができる。

たとえば、第2の繰返し処理において、セグメンテーション・エネルギー関数は、シーンの改良された3D再構築に関連付けられた、強化されたセグメンテーション、セグメンテーション・プライア24、及び強化された3D特徴を考慮に入れることができる。平滑性エネルギー関数は、シーンの改良された3D再構築で測定された、隣接する同様の3D要素間でのラベルの一貫性を考慮することができる。改良エネルギー関数は、選択された可視画像から生成される幾何学的な手がかりと、強化された3D特徴線との間の位置合せを測定することができる。

所定の精度閾値(たとえば、少なくとも前記強化された3D特徴と前記強化された2D特徴との間のマッチングでの閾値)に達すると、又は繰返し処理の所定の数に達すると、この繰返し処理を停止することができる。

個々のセグメンテーション及び3D再構築と比較して、少なくとも1つの実施形態による、セグメンテーションと3D再構築を組み合わせる方法は、したがってセグメンテーションと3D再構築が互いに寄与するようにさせ、さらに良好な結果を実現する。

図3〜図9には、テーブル上の箱を含むシーンの一例について、本開示の一実施形態による、セグメンテーションと3D再構築を組み合わせるためのアルゴリズムの結果が示してある。

図3には、たとえば、ブロック222でKinectFusion(登録商標)のツールによって取得される、シーンの初期3D再構築が示してある。

図4には、たとえばブロック223で取得される、シーンの初期3D再構築に関連付けられた初期3D特徴が示してある。

図5には、たとえばブロック224で取得される、初期セグメンテーションが示してある。たとえば、シーンの初期3D再構築が、メッシュ表面によって表される場合、各3D要素は、このメッシュの三角形の面とすることもでき、各構成要素は、L1、L2、L3、及びL4にラベル付けされた、セグメント化された領域である。

図6A及び図6Bは、ブロック211で1組の入力画像から選択された、テーブル上の箱のマルチビュー画像である。

図7A及び図7Bには、たとえばブロック212で取得される、図6A及び図6Bのマルチビュー画像において決定された初期2D特徴が示してある。

図8には、幾何学的な手がかりによって定義された制約条件を初期3D特徴に適用することによって得られる、強化された3D特徴が示してあり、ここで、この幾何学的な手がかりは、たとえば、フィルタリング214の後に残る2D特徴線からブロック215で生成される。

最後に、図9には、たとえば組合せ最適化ブロック25で取得される、改良された3D再構築及び強化されたセグメンテーションが示してある。

ここで図10を参照すると、本開示の少なくとも1つの実施形態による、シーンのセグメンテーションと3D再構築を組み合わせる方法を実施するのに使用することができる、例示的な装置の構造ブロックが示してある。

一実施形態では、開示された方法を実施するための装置100は、不揮発性メモリ103(たとえば、リードオンリ・メモリ(ROM)又はハード・ディスク)、揮発性メモリ101(たとえば、ランダム・アクセス・メモリ、すなわちRAM)、及びプロセッサ102を備える。不揮発性メモリ103は、持続的でコンピュータ読取り可能な搬送媒体である。これは、実行可能なプログラム・コード命令を記憶し、この命令がプロセッサ102によって実行されて、先に述べた方法の様々な実施形態において、その方法の実装を可能にする。

初期化されると、前述のプログラム・コード命令は、不揮発性メモリ103から揮発性メモリ101に転送されて、プロセッサ102によって実行される。同様に、揮発性メモリ101は、これを実行するのに必要な変数及びパラメータを記憶するためのレジスタを含む。

−PCタイプの機器、DSP(デジタル信号プロセッサ)、又はマイクロコントローラなど、再プログラム可能なコンピューティング・マシンによって実行される1組のプログラム・コード命令を実行することによって、本開示の少なくとも1つの実施形態による、シーンのセグメンテーションと3D再構築を組み合わせる方法の各ステップを、等しく良好に実施することができる。このプログラム・コード命令は、取外し可能(たとえば、フロッピー・ディスク、CD−ROM、若しくはDVD−ROM)、若しくは取外し不可能な、持続的でコンピュータ読取り可能な搬送媒体に記憶することができ、又は−FPGA(フィールド・プログラマブル・ゲート・アレイ)、ASIC(特定用途向け集積回路)、若しくは任意の専用ハードウェア構成要素など、専用のマシン若しくは構成要素によって記憶することができる。

すなわち、この開示は、コンピュータ・プログラム命令の形式で純粋にソフトウェアベースの実装形態に限定されず、ハードウェア形式、又はハードウェア部分とソフトウェア部分とを組み合わせる任意の形式で実装してもよい。

少なくとも1つの実施形態では、この装置は機器内に設けられる。このような機器は、携帯電話、タブレット、ヘッドマウント・ディスプレイなどのような携帯機器、又はロボット、自律運転機器、若しくはスマート・ホーム機器などのような自律機器とすることができる。このような機器は、拡張現実感/複合現実感、及び自律ロボット/自律運転の分野での用途を実装することができる。

説明していない場合でも、このような装置又は機器は、少なくとも1つのカメラ、少なくとも1つのディスプレイ、又は他の従来の装置も含むこともできる。

Claims (15)

- シーンの少なくとも1つの画像のセットから、前記シーンのセグメンテーションと3D再構築を組み合わせる方法であって、前記シーンの前記セグメンテーションが、前記シーンの前記3D再構築の各セグメントへの分割に対応し、前記方法が、

前記シーンの初期3D再構築を取得すること(11)と、

前記初期3D再構築に関連付けられた初期3D特徴を取得すること(12)と、

前記初期3D再構築の初期セグメンテーションを取得すること(13)と、

前記シーンの前記初期3D再構築に関連付けられた前記初期3D特徴に対応するように、前記初期3D特徴から、かつ前記セットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定すること(14)であって、前記強化された3D特徴が前記初期セグメンテーションに少なくとも部分的に対応することと、

前記初期セグメンテーションと前記強化された3D特徴の両方から、強化されたセグメンテーションと改良された3D再構築の両方を決定すること(15)と、

を含む、方法。 - 前記3D特徴が3D特徴線であり、前記2D特徴が2D特徴線である、請求項1に記載の方法。

- 前記シーンの前記初期3D再構築を取得すること(11)が、奥行きデータから前記初期3D再構築を構築することを含む、請求項1又は2に記載の方法。

- 前記初期3D特徴を取得すること(12)が、幾何学的特性及び/又は局所的特徴記述子を使用して、前記シーンの前記初期3D再構築において3D特徴を識別することを含む、請求項1乃至3の何れか1項に記載の方法。

- 前記シーンの前記少なくとも1つの画像の前記セットが、少なくとも2つの画像を含み、前記方法が、

可視画像として知られている、前記初期3D特徴を含む前記セットの画像を選択することと、

前記可視画像において、前記初期3D特徴にマッチする前記初期2D特徴を識別することと、

から、前記初期2D特徴を決定することを含み、

前記強化された3D特徴を決定することが、

少なくとも2つの可視画像にわたって前記初期2D特徴をマッチさせることによって、幾何学的な手がかりを生成することと、

前記幾何学的な手がかりを用いて前記初期3D特徴を強化して、前記強化された3D特徴を決定することと、

を含む、請求項1乃至4の何れか1項に記載の方法。 - 前記強化された3D特徴から、また前記セットの前記少なくとも1つの画像において決定される強化された2D特徴から、前記シーンの前記改良された前記3D再構築に関連付けられた、前記強化された3D特徴に対応するように、さらに強化された3D特徴を決定することと、

前記強化されたセグメンテーション、及び前記さらに強化された3D特徴から、さらに強化されたセグメンテーション及びさらに改良された3D再構築を決定することと

を、少なくとも1度は繰返し処理することを含む、請求項1乃至5の何れか1項に記載の方法。 - 少なくとも前記さらに強化された3D特徴と前記強化された2D特徴との間のマッチングでの所定の精度閾値に達すると、前記繰返し処理が停止される、請求項6に記載の方法。

- 前記所定の精度閾値が、前記シーンの前記3D再構築を前記セグメントに分割する程度によって与えられるセグメンテーション・レベル、前記さらに改良された3D再構築で測定された、隣接する同様の各3D要素間のラベルの一貫性、及び前記セットの前記少なくとも1つの画像と、前記さらに改良された3D再構築との間の位置合せ、のうち少なくとも1つに一緒に適用される、請求項7に記載の方法。

- 所定の数の繰返し処理に達すると前記繰返し処理が停止される、請求項6乃至8の何れか1項に記載の方法。

- 前記強化されたセグメンテーションがセグメンテーション制約条件に依存する、請求項1乃至9の何れか1項に記載の方法。

- 前記セグメンテーション制約条件が、少なくとも1つのセグメント形状に関係する、請求項10に記載の方法。

- 前記初期3D再構築及び少なくとも1つの画像の前記セットを、少なくとも1つの入力として受け取ることと、少なくとも1つのプロセッサを用いて、前記強化された3D特徴、強化されたセグメンテーション、及び改良された3D再構築を決定することと、少なくとも1つの出力から、前記強化されたセグメンテーション及び前記改良された3D再構築を出力して、前記改良された3D再構築をユーザに表示し、また前記強化されたセグメンテーションによって、前記改良された3D再構築を処理することとを含む、請求項1乃至11の何れか1項に記載の方法。

- 通信ネットワークからダウンロード可能であり、及び/又はコンピュータによる読取り可能な媒体上に記録され、及び/又はプロセッサによって実行可能なコンピュータ・プログラム製品であって、プロセッサで実行されるときには、請求項1乃至12の何れか1項に記載の方法を実行するように構成されたソフトウェア・コードを含む、コンピュータ・プログラム製品。

- シーンの少なくとも1つの画像のセットから、前記シーンのセグメンテーションと3D再構築を組み合わせるための装置であって、前記シーンの前記セグメンテーションが、前記シーンの前記3D再構築の各セグメントへの分割に対応し、前記装置が、

前記シーンの初期3D再構築を取得し、

前記初期3D再構築に関連付けられた初期3D特徴を取得し、

前記初期3D再構築の初期セグメンテーションを取得し、

前記シーンの前記初期3D再構築に関連付けられた前記初期3D特徴に対応するように、前記初期3D特徴から、かつ前記セットの少なくとも1つの画像において決定される初期2D特徴から、強化された3D特徴を決定し、前記強化された3D特徴が前記初期セグメンテーションに少なくとも部分的に対応し、

前記初期セグメンテーションと前記強化された3D特徴の両方から、強化されたセグメンテーションと改良された3D再構築の両方を決定する、

ように適合され、構成された少なくとも1つのプロセッサを備える、装置。 - 請求項14に記載の装置を備え、好ましくは携帯電話、タブレット、若しくはヘッドマウント・ディスプレイから選択される携帯機器、又は好ましくはロボット、自律運転機器、若しくはスマート・ホーム機器から選択される自律機器であることを特徴とする、機器。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| EP16306836.4A EP3343506A1 (en) | 2016-12-28 | 2016-12-28 | Method and device for joint segmentation and 3d reconstruction of a scene |

| EP16306836.4 | 2016-12-28 | ||

| PCT/EP2017/084008 WO2018122087A1 (en) | 2016-12-28 | 2017-12-21 | Method and device for joint segmentation and 3d reconstruction of a scene |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2020515931A true JP2020515931A (ja) | 2020-05-28 |

| JP2020515931A5 JP2020515931A5 (ja) | 2021-02-04 |

Family

ID=57755156

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2019533614A Withdrawn JP2020515931A (ja) | 2016-12-28 | 2017-12-21 | シーンのセグメンテーションと3d再構築を組み合わせるための方法及び装置 |

Country Status (6)

| Country | Link |

|---|---|

| US (1) | US20200380711A1 (ja) |

| EP (2) | EP3343506A1 (ja) |

| JP (1) | JP2020515931A (ja) |

| KR (1) | KR20190101382A (ja) |

| CN (1) | CN110121733A (ja) |

| WO (1) | WO2018122087A1 (ja) |

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2023242983A1 (ja) * | 2022-06-15 | 2023-12-21 | 株式会社ニコン | 加工制御情報生成方法、加工方法及びモデル生成方法 |

Families Citing this family (13)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US10495476B1 (en) * | 2018-09-27 | 2019-12-03 | Phiar Technologies, Inc. | Augmented reality navigation systems and methods |

| US11448518B2 (en) | 2018-09-27 | 2022-09-20 | Phiar Technologies, Inc. | Augmented reality navigational overlay |

| US10846817B2 (en) | 2018-11-15 | 2020-11-24 | Toyota Research Institute, Inc. | Systems and methods for registering 3D data with 2D image data |

| US10704918B2 (en) | 2018-11-26 | 2020-07-07 | Ford Global Technologies, Llc | Method and apparatus for improved location decisions based on surroundings |

| US11127162B2 (en) | 2018-11-26 | 2021-09-21 | Ford Global Technologies, Llc | Method and apparatus for improved location decisions based on surroundings |

| US11175156B2 (en) * | 2018-12-12 | 2021-11-16 | Ford Global Technologies, Llc | Method and apparatus for improved location decisions based on surroundings |

| US11176374B2 (en) * | 2019-05-01 | 2021-11-16 | Microsoft Technology Licensing, Llc | Deriving information from images |

| JP7331524B2 (ja) | 2019-07-24 | 2023-08-23 | 富士フイルムビジネスイノベーション株式会社 | 情報処理装置及びプログラム |

| CN111179394A (zh) * | 2019-11-25 | 2020-05-19 | 苏州智加科技有限公司 | 点云场景渲染方法、装置和设备 |

| US11417063B2 (en) * | 2020-09-01 | 2022-08-16 | Nvidia Corporation | Determining a three-dimensional representation of a scene |

| CN113159151B (zh) * | 2021-04-12 | 2022-09-06 | 中国科学技术大学 | 面向自动驾驶的多传感器深度融合3d目标检测方法 |

| CN113256698B (zh) * | 2021-06-09 | 2021-11-05 | 中国人民解放军国防科技大学 | 一种具有深度预测的单目3d重建方法 |

| CN114494668B (zh) * | 2022-04-13 | 2022-07-15 | 腾讯科技(深圳)有限公司 | 三维模型的展开方法、装置、设备及存储介质 |

Family Cites Families (10)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| AU2001250802A1 (en) * | 2000-03-07 | 2001-09-17 | Sarnoff Corporation | Camera pose estimation |

| US6847728B2 (en) * | 2002-12-09 | 2005-01-25 | Sarnoff Corporation | Dynamic depth recovery from multiple synchronized video streams |

| US7324687B2 (en) * | 2004-06-28 | 2008-01-29 | Microsoft Corporation | Color segmentation-based stereo 3D reconstruction system and process |

| KR101055411B1 (ko) * | 2010-03-12 | 2011-08-09 | 이상원 | 입체 영상 생성 방법 및 그 장치 |

| US10734116B2 (en) * | 2011-10-04 | 2020-08-04 | Quantant Technology, Inc. | Remote cloud based medical image sharing and rendering semi-automated or fully automated network and/or web-based, 3D and/or 4D imaging of anatomy for training, rehearsing and/or conducting medical procedures, using multiple standard X-ray and/or other imaging projections, without a need for special hardware and/or systems and/or pre-processing/analysis of a captured image data |

| US9333649B1 (en) * | 2013-03-15 | 2016-05-10 | Industrial Perception, Inc. | Object pickup strategies for a robotic device |

| US9659408B2 (en) * | 2013-11-27 | 2017-05-23 | Autodesk, Inc. | Mesh reconstruction from heterogeneous sources of data |

| GB2526838B (en) * | 2014-06-04 | 2016-06-01 | Imagination Tech Ltd | Relightable texture for use in rendering an image |

| US10354418B2 (en) * | 2014-08-16 | 2019-07-16 | Fei Company | Tomographic reconstruction for material characterization |

| CN106228507B (zh) * | 2016-07-11 | 2019-06-25 | 天津中科智能识别产业技术研究院有限公司 | 一种基于光场的深度图像处理方法 |

-

2016

- 2016-12-28 EP EP16306836.4A patent/EP3343506A1/en not_active Withdrawn

-

2017

- 2017-12-21 US US16/474,860 patent/US20200380711A1/en not_active Abandoned

- 2017-12-21 WO PCT/EP2017/084008 patent/WO2018122087A1/en unknown

- 2017-12-21 JP JP2019533614A patent/JP2020515931A/ja not_active Withdrawn

- 2017-12-21 CN CN201780081492.3A patent/CN110121733A/zh active Pending

- 2017-12-21 EP EP17818151.7A patent/EP3563346A1/en not_active Withdrawn

- 2017-12-21 KR KR1020197018567A patent/KR20190101382A/ko not_active Application Discontinuation

Cited By (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2023242983A1 (ja) * | 2022-06-15 | 2023-12-21 | 株式会社ニコン | 加工制御情報生成方法、加工方法及びモデル生成方法 |

Also Published As

| Publication number | Publication date |

|---|---|

| US20200380711A1 (en) | 2020-12-03 |

| WO2018122087A1 (en) | 2018-07-05 |

| CN110121733A (zh) | 2019-08-13 |

| EP3563346A1 (en) | 2019-11-06 |

| KR20190101382A (ko) | 2019-08-30 |

| EP3343506A1 (en) | 2018-07-04 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP2020515931A (ja) | シーンのセグメンテーションと3d再構築を組み合わせるための方法及び装置 | |

| Tjaden et al. | A region-based gauss-newton approach to real-time monocular multiple object tracking | |

| Pomerleau et al. | Tracking a depth camera: Parameter exploration for fast ICP | |

| Kolev et al. | Turning mobile phones into 3D scanners | |

| Delaunoy et al. | Photometric bundle adjustment for dense multi-view 3d modeling | |

| US9426444B2 (en) | Depth measurement quality enhancement | |

| EP2751777B1 (en) | Method for estimating a camera motion and for determining a three-dimensional model of a real environment | |

| KR101532864B1 (ko) | 모바일 디바이스들에 대한 평면 맵핑 및 트래킹 | |

| RU2642167C2 (ru) | Устройство, способ и система для реконструкции 3d-модели объекта | |

| JP5249221B2 (ja) | 画像から奥行きマップを決定する方法、奥行きマップを決定する装置 | |

| JP2019075082A (ja) | 深度値推定を用いた映像処理方法及び装置 | |

| Takimoto et al. | 3D reconstruction and multiple point cloud registration using a low precision RGB-D sensor | |

| Wang et al. | Plane-based optimization of geometry and texture for RGB-D reconstruction of indoor scenes | |

| Wang et al. | Vid2Curve: simultaneous camera motion estimation and thin structure reconstruction from an RGB video | |

| Rajput et al. | A regularized volumetric fusion framework for large-scale 3D reconstruction | |

| Jaramillo et al. | 6-DoF pose localization in 3D point-cloud dense maps using a monocular camera | |

| KR20090070500A (ko) | 단일 축 회전 영상들로부터의 효율적인 전 방향 3차원모델의 재구성 방법 | |

| Li et al. | Multi-view stereo via depth map fusion: A coordinate decent optimization method | |

| Niemirepo et al. | Open3DGen: open-source software for reconstructing textured 3D models from RGB-D images | |

| Figueroa et al. | A combined approach toward consistent reconstructions of indoor spaces based on 6D RGB-D odometry and KinectFusion | |

| Purohit et al. | Multi-planar geometry and latent image recovery from a single motion-blurred image | |

| Yoshimoto et al. | Cubistic representation for real-time 3D shape and pose estimation of unknown rigid object | |

| Nakayama et al. | Marker-less augmented reality framework using on-site 3D line-segment-based model generation | |

| Liu et al. | Albedo assisted high-quality shape recovery from 4D light fields | |

| Ruchay et al. | Accuracy analysis of 3d object reconstruction using mesh filtering |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20201215 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20201215 |

|

| A761 | Written withdrawal of application |

Free format text: JAPANESE INTERMEDIATE CODE: A761 Effective date: 20210706 |