次に例示的実施形態の詳細な説明が、様々な図に関連して述べられる。この説明は可能な実装形態の詳細な例をもたらすが、詳細は例示的なものであり、本出願の範囲を限定するものでは全くないことが留意されるべきである。

例えばビデオ符号化システムは、デジタルビデオ信号を圧縮して、デジタルビデオ信号のための記憶容量および/または送信帯域幅を低減する。多様なタイプのビデオ符号化システム、例えばブロックベース、ウェーブレットベース、オブジェクトベース、およびブロックベースのハイブリッドビデオ符号化システムが存在する場合がある。さらに多様なブロックベースのビデオ符号化システムが存在し、そのいくつかは国際的ビデオ符号化標準に基づくことができる。MPEG1/2/4パート2、H.264/MPEG−4パート10AVC、VC−1、およびH.265/HEVC(高効率ビデオ符号化)は、国際的ビデオ符号化標準に基づくブロックベースのビデオ符号化システムの例とすることができる。MPEG−2、H.264/AVCおよびHEVC標準は、例えばITU−T/SG16/Q.6/ビデオ符号化専門家グループ(VCEG)およびISO/TEC JTC1 SC29 WG11動画専門家グループ(MPEG)によって開発された。本明細書で述べられるように符号化はアーティストの、彼または彼女がコンテンツを描写したかった可能性がある意図に、影響を与える場合がある。例えばビデオ符号化システムは、アーティストが目立つように鮮やかにしたかった可能性があるオブジェクトの色を薄くする場合があり、従ってオブジェクトは、符号化の後にはもはやコンテンツ内で目立たなくなる場合がある。

図1は、ブロックベースのハイブリッドビデオエンコーダの例の図である。入力ビデオ信号2は、例えばブロックごとに処理されることができる。ビデオブロック単位は、例えばMPEG1/2/4およびH.264/AVCにおいて、16×16輝度サンプルおよび対応する彩度サンプルを含むことができる。彩度サンプルの数は、入力ビデオ信号の彩度フォーマットに依存することができる。例えば4:2:0のサブサンプリングが用いられたとき、2つの8×8彩度ブロックは、輝度サンプルの1つの16×16ブロックに対応することができる。符号化ブロック単位、例えば標準の符号化ブロック単位は、マクロブロック(MB)と呼ばれることができる。拡張されたブロックサイズは、「符号化ツリー単位」(CTU)と呼ばれることができる。CTUは、例えば高解像度ビデオ信号、例えば1080以上の解像度を圧縮するために用いられることができる。CTUは様々なサイズ、例えば64×64、32×32、および16×16輝度サンプルを有することができる。CTUサイズは、例えばシーケンスレベルで選択され、シーケンスパラメータセット(SPS)においてシグナリングされることができる。CTUは、例えば4分木分割によって符号化単位(CU)に分割されることができる。イントラまたはインター予測モードは、例えばCUレベルで選択されることができる。CUは、予測単位(PU)に分割されることができる。PUに対して、個別の予測が適用されることができる。

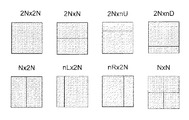

図3は、HEVCにおける予測単位(PU)モード、またはCUの分割の図である。空間的予測(160)および/または時間的予測(162)は、任意の1つまたは複数の入力ビデオブロック(MBまたはCU)に対して行われることができる。

空間的予測(「イントラ予測」と呼ばれる)は、例えばビデオ画像/スライス内のすでに符号化された隣接したブロックからの画素を利用することによって、現在のビデオブロックを予測することができる。空間的予測は、ビデオ信号における空間的冗長性を低減させることができる。

時間的予測(「インター予測」または「動き補償された予測」と呼ばれる)は、例えばすでに符号化されたビデオ画像からの画素を利用することによって、現在のビデオブロックを予測することができる。時間的予測は、ビデオ信号における時間的冗長性を低減させることができる。所与のビデオブロックに対する時間的予測は、例えば1つまたは複数の動きベクトルおよび1つまたは複数の基準インデックスによって、シグナリングされることができる。動きベクトルは、現在のブロックと基準ブロックとの間の動きの大きさ(例えば絶対値またはレート)および方向を示すことができる。基準インデックスは、1つまたは複数の時間的予測ブロックがそこから来る、復号された画像バッファ内の1つまたは複数の基準画像を識別することができる。復号された画像バッファの例は、図1で「基準画像記憶部64」とラベル付けされている。

図1に示されるエンコーダ内のモード決定ブロック80は、(例えば最良の)予測モード(例えばイントラモードまたはインターモード)、および関連付けられた予測情報(例えばイントラ符号化または動き分割に対する輝度および彩度予測モード、およびインター符号化に対する動きベクトルおよび基準インデックス)を選択することができる。選択は、空間的および/または時間的予測の後に生じることができる。

エンコーダモード決定ロジックは、例えばレート−歪み最適化技法に依存して、歪みとレートとの間の最適トレードオフをもたらすように、モード(例えば最良のモード)を選択することができる。歪みは、例えば復元されたビデオブロックと、もとのビデオブロックとの間の2乗平均誤差とすることができる。レートは、例えばブロックの符号化に費やされるビットの数とすることができる。

加算ブロック16は、現在のビデオブロックから予測ブロックを減算することによって、予測残差を生成することができる。変換4は、予測残差を変換することができる。量子化6は、変換された予測残差を量子化することができる。逆量子化10は、量子化された残差係数を逆量子化することができる。逆変換12は、逆量子化された残差係数を逆変換することができる。逆量子化10および逆変換12に対する代替は、変換スキップモードである。変換単位(TU)レベルでの変換スキップモードは、変換段階をバイパスし、空間ドメインにおいてTUブロックの予測残差を直接量子化することができる。逆量子化10および逆変換12に対する他の例または代替は、変換および量子化バイパスモードでできる。変換単位(TU)レベルでの変換および量子化バイパスモードは、変換段階および量子化段階をバイパスすることができる。

逆量子化10および逆変換12は、復元された残差を生成する。加算26は、予測ブロックに復元された残差を加算することによって、復元されたビデオブロックを生成する。

ループフィルタ66は、復元されたビデオブロックにインループフィルタリングを適用することができる。基準画像記憶部64は、フィルタリングされた復元されたビデオブロックを記憶することができる。フィルタリングされた復元されたビデオブロックは、将来のビデオブロックを符号化するために用いられることができる。非ブロック化フィルタは、例えばH.264/AVCおよびHEVCによってサポートされることができる。非ブロック化フィルタは、2つの隣接したブロックを符号化するために用いられた異なるモードおよび/またはパラメータによる、ブロック化アーチファクトを低減するために、ブロック境界に適用される適応平滑化フィルタである。非線形インループフィルタ、例えばサンプル適応オフセット(SAO)フィルタは、例えばHEVCによってサポートされることができる。2つのタイプのSAOフィルタリングがあり、1)バンディングアーチファクトを低減することができるバンドオフセット(BO)、および2)例えば量子化時に歪まされたエッジを復活させることができるエッジオフセット(EO)である。適応ループフィルタ(ALF)などの他のインループフィルタリング方法が、サポートされることができる。

エントロピー符号化ユニット8は、出力ビデオビットストリーム20を生成する。エントロピー符号化ユニット8には、さらなる圧縮およびパッキングのために、符号化モード(例えばインターまたはイントラ)、予測モード情報、動き情報(例えば動きベクトルおよび基準インデックス)、量子化された残差係数、インループフィルタリングパラメータ(例えばEOおよび/またはBOパラメータ)がもたらされて、ビットストリームを生成することができる。

図4は、不感帯を有するスカラー量子化の例を示す。量子化6は、例えば不感帯を有する量子化によって、圧縮時に歪みを導入することができる。量子化時に導入される歪みの大きさは、不感帯のサイズおよび量子化ステップサイズに依存する場合がある。量子化プロセスは歪みを導入することができるが、またビデオを符号化するために用いられるビット数を著しく低減することができる。量子化プロセスによって量子化される信号は、一定の範囲内では、量子化出力の同じ値を有するように量子化されることができる。例えば不感帯内の入力値は、ゼロに等しい量子化された出力値を有することができる。いくつかのコーデック、例えばH.264/AVCおよびHEVCは、不感帯を有するスカラー量子化を用いることができる。不感帯は、小さな絶対値を有する空間ドメインにおける変換係数および/または予測残差を抑圧するために用いられることができる。例えば符号化モードに応じて、異なるサイズの不感帯が用いられることができる。

図2は、ブロックベースのビデオデコーダの例の図である。図2は、図1のエンコーダに対応することができるブロックベースのハイブリッドビデオデコーダを示す。エントロピー復号ユニット208は、ビデオビットストリーム202をアンパックし、エントロピー復号することができる。符号化モードおよび関連付けられた予測情報は、空間的予測ユニット260(例えばイントラ符号化されているとき)、または時間的予測ユニット(動き補償された予測ユニット)262(例えばインター符号化されているとき)にもたらされることができる。空間的予測ユニット260または動き補償された予測ユニット262は、予測ブロックを生成することができる。

逆量子化ユニット210および逆変換ユニット212は、エントロピー復号ユニット208によって生成された残差変換係数から、残差ブロックを復元する。加算226は、予測ブロックと復元された残差ブロックとを加算して、復元されたブロックを形成する。復元されたブロックは、インループフィルタリングユニット266にもたらされ、基準画像記憶部264に記憶されることができる。図2に示されないが、インループフィルタリングパラメータ(例えばEOおよび/またはBOパラメータ)は、ビットストリームから構文解析され、インループフィルタリングユニット266に送られて、例えばループフィルタリング動作を制御することができる。基準画像記憶部264内の復元されたビデオは、ディスプレイを駆動するため、および/または将来のビデオブロックを予測するためにもたらされることができる。

図1および2に示される例示のシステムアーキテクチャにおける機能ブロックは、様々なレベルの高度化および様々なレベルの符号化効率を有する、多様な技法を用いて実施されることができる。例えば時間的予測の形式である双予測、複数の基準画像および非ブロック化フィルタ、フレキシブルブロック構造およびSAOが実施されることができる。より高度化された技法は、エンコーダおよびデコーダにおいて、より多くの計算が関わる場合がある。しかしより高度化された技法は、著しく改善された符号化効率をもたらすことができる。ビデオ符号化標準の進化において、より最近の世代のコーデックは、例えば前の世代のコーデックの2倍効率的とすることができる。例としてHEVCは、平均でH.264/AVCで利用されるビットレートの半分未満を用いて、同じ主観的ビデオ品質を供給することができる。

世界は、有線および無線ネットワーク容量における著しい技術的進歩により、ますます接続されている。スマートフォン、タブレット、および他のポータブルデバイスは、増加するコンピューティング能力およびより高速のネットワーク接続を有する。これらの傾向は、ビデオ圧縮技術での進歩と共に、異なる市場区分にわたる高精細(HD)ビデオの普遍的な存在に繋がってきている。HDビデオは、リニアTVプログラム、TV放送、加入ベースまたは広告でサポートされるオンデマンドビデオストリーミングサービス(例えばNetflix、Hulu、Amazon、GoogleのYouTube)、ライブストリーミング、およびモバイルビデオアプリケーション(例えばユーザ生成コンテンツ、ビデオ録画、再生、ビデオチャット)において提供される。

ビデオ品質改善は、HDを超えて続いている。超高精細(UHD)ビデオ技術は、消費者のために改善された画像品質を有する次世代ビデオサービスをもたらすことができる。UHDディスプレイ(例えば4K解像度TV)の製造および販売、ならびにいつでもどこでもUHD品質ビデオを受信および/または送信するためのより高速な有線および無線通信接続などの関連付けられたサービスにおいて著しい関心がある。

UHDビデオフォーマットは、勧告ITU−R BT.2020およびSMPTE ST 2036−1において正式に定義されている。UHDフォーマットは、ビデオ信号のいくつかの側面における強化されたパラメータを定義する。表1は、HDおよびUHDに対するビデオパラメータの比較をもたらす。HDと比べてUHDは、より高い空間解像度(例えば3840×2160および7680×4320)、より高いフレームレート(例えば120Hzまで)、より高いサンプルビット深度(例えば高ダイナミックレンジサポートのために12ビットまで)、およびより鮮やかな色のレンダリングを可能にするより広い色域をサポートする。

図5は、BT.709およびBT.2020色域の比較を示す。図5は、CIE1931色空間色度図(馬蹄形)が上に重ねられた、HD色域(内側の三角形)およびUHD色域(外側の三角形)を示す。馬蹄形は、人間の目に見える色の範囲を表す。BT.709色域およびBT.2020色域は、それぞれCIE1931色空間の約36%および76%を包含する。言い換えれば、何年もの間、民生用ディスプレイ市場を支配してきたBT.709(HD)ディスプレイ上に再現されることができるカラーボリュームと比べて、BT.2020ディスプレイは、再現可能な色のボリュームを著しく増加させる。BT.2020は、ずっと鮮やかで豊かな色をビデオ消費者にもたらすことができる。

図6は、Y軸に沿った輝度、およびx、y軸に沿った色を有する3Dカラーボリュームを示す。(x,y)平面は、図5のCIE1931色空間に対応する。垂直Y軸は、輝度(例えば明るさ)信号に対応する。輝度信号は、cd/m2(平方メートル当たりカンデラ)で測定され、ニト(1ニト=1cd/m2)とも呼ばれる。ダイナミックレンジは、ディスプレイによってサポートされる輝度信号の範囲である。多くの民生用ディスプレイは、おおよそ100ニトピーク輝度をサポートする。高ダイナミックレンジ(HDR)ディスプレイ(例えばおおよそ1000から4000ニトのピーク輝度を有する)は、顕著な知覚品質の利点をもたらすことができる。

HDRサポートは、著しい変更、例えばエコシステム全体の変化が関わる場合がある。HDR変更は、捕捉、コンテンツ作成ワークフロー、配信、およびディスプレイにおいて生じる場合がある。HDRは、Dolby Visionなど、HDRビデオの魅力的な品質上の利点に鑑みて、民生用の展開に進歩しつつある。HDRディスプレイのサポートにおいてディスプレイ製造業者は、HDRディスプレイを実証している。HDRコンテンツ作成のサポートでは、知覚量子化器(PQ)がSMPTE ST 2084において標準化される。HDR配信のサポートでは、BT.2020コンテナを用い、10ビットY’CbCrフォーマットにおいて運ばれるHDR信号を圧縮するために、HEVCのMain10プロファイルが使用される場合がある。HEVCのMain10プロファイルが用いられることができる。標準ダイナミックレンジ(SDR)ビデオとの下位互換性を提供する、HEVC Main10プロファイルに対する符号化効率改善が存在する場合がある。

UHDおよびHDRビデオによってもたらされるビデオ品質改善に加えて、3Dビデオは強化されたビデオ品質を提供する。3Dビデオ制作、配信、レンダリング研究は、3Dコンテンツの発展、および3D眼鏡などの特別なアイウェアの削除と共に続いている。自動立体視(眼鏡不要)ディスプレイ技術は、低減された空間解像度などによる眼精疲労、頭痛、コンテンツエイリアシングを避けるために進歩しつつある。例えばこのような問題を緩和するために、ビューの数は著しく増加されることができる。しかし多くのビューにおけるビデオサンプルを直接符号化することは、著しいオーバーヘッドコストを生じる場合がある。深度マップ、および効率的なビュー間予測の使用は、例えば3Dビデオ制作の負担、および配信コストを低減するための3Dビデオ改善の一部となることができる。

図7は、深度マップの例の図である。深度マップは、グレースケール値化されたサンプルを有するイメージであり、グレースケール値は、観察者からのオブジェクトの深度または距離を示すことができる。高品質深度マップが付随したいくつかのカメラ捕捉されたビューは、例えば受信器/ディスプレイが任意の観察位置にオブジェクトをレンダリングして、所望の3D効果を作成することを可能にすることができる。

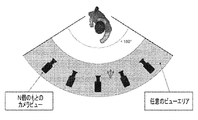

図8は、カメラビューを用いて任意ビューを生成する例である。図8は、固定の数のカメラ捕捉されたビューおよび対応する深度マップを用いて、任意ビューを生成する例を示す。深度マップは、任意ビューレンダリングをサポートすることができ、またカメラ捕捉されたビューの効率的な圧縮をサポートすることができる。例として、図8において第1のカメラビューから直接、第2のカメラビューを予測することに対する代替方法は、第1のカメラビューを第2のカメラビューの位置に投影するために用いられる深度マップである。深度マップは、第2のカメラビューのより正確な予測をもたらすために用いられることができる。HEVC標準の拡張、すなわち3D−HEVCは、深度マップおよび先進型ビュー合成アルゴリズムを利用して、圧縮効率を向上し、3Dビデオを配信するために用いられる帯域幅を低減することができる。

本明細書で述べられるように、ビデオ制作、配信およびレンダリング技術、例えばHDR、WCG、および深度ベースの3Dビデオにおける進歩は、コンテンツ制作者(例えば監督、カラーアーティスト、およびユーザにより生成されるコンテンツを作成するユーザ)に、彼等の芸術的意図をより自由におよび正確に表現するための、より大きな「パレット」(例えばビデオパラメータおよびツールの、より広いセット)をもたらすことができる。例としてカラリストは、咲いている花を有するシーンに特に鮮やかな純粋の赤色を適用することを選ぶことができる。純粋の赤色は、BT.2020色空間を用いて使用可能であるが、BT.709色空間ではできない(例えばこれは使用可能な色空間またはエンコーディングの結果の場合がある)。従って例においてアーティストは、画像における日の出と星明かりの対比を例えばHDRを用いて、より忠実にレンダリングすることができる。自然界では星明かりの輝度レベルは約10-3ニトであるのに対し、太陽光の輝度は何桁も高い約105ニトである。3Dビデオに対して作業する監督またはカラリストは、視聴者または観察者から特定の距離(例えば深度)にある3Dオブジェクトを強調したい場合がある。空間ドメインで作業する監督は、主要なオブジェクトをシーンの一定の領域に配置することによって、芸術的意図を伝えるように選ぶことができる。例として監督は、主演女優の顔を画像の右側に配置するように選ぶことができる。例において、符号化のための現在の技法は、同じ強調をもたらすことができず、および/または、3Dオブジェクトの強調および/または符号化の前に監督によって意図されコンテンツにおいて描写された女優の位置の、喪失を引き起こす場合がある。

図9は、コンテンツ生成およびコンテンツ配信ワークフローの例300である。示されるように302で、コンテンツが記録される。コンテンツは、本明細書の例において述べられるようなオーディオ、ビデオ、静止イメージ、および/または同様のものを含むことができる。304で、例えば302での捕捉または記録の後に、イメージセンサから出力された不完全な色サンプルからフルカラーイメージを復元するために、デモザイキングが適用されることができる。カラリストは、例えば306および308で基準ディスプレイを用いて、それらの芸術的意図を表現するイメージを作成することができる。基準ディスプレイは、Rec.709色空間を有するSDRディスプレイ(例えば306でアーティストはこれと対話することができる)、またはRec.2020色空間を有する先進型HDRディスプレイ(例えば308でアーティストはこれと対話することができる)とすることができる。ディスプレイに関わらずカラリストは、レンダリングされたイメージが彼等の芸術的意図を表すことを望むことができる(例えば306および308でこのようなディスプレイを用いて、このような意図を反映するまたは表現するようにイメージを調整することができる)。310でイメージは、SMPTE標準ST 268M−2003によって標準化されたデジタル中間および視覚的効果作業のためのファイルフォーマットであるデジタル画像交換(DPX)フォーマットなどの、適切なフォーマットにエクスポートおよび/またはレンダリングされることができる。図9における最後の機能は、消費者への配信のために、職業的スタジオコンテンツを準備することができる。例において準備は、例えば312で消費者フォーマットへのフォーマット変換、例えばDPXからYUV 4:2:0への変換、および314で帯域幅要件を満たすための、消費者フォーマットビデオ(例えばYUV 4:2:0)の圧縮(例えば符号化)を含むことができる。

本明細書の例においてアーティストの意図は、図9に示される中央の機能ブロックにおいて、コンテンツ作成時に表現されることができる(例えば304〜310において)。306および/または308でカラリストは、例えばレンダリングデバイス(例えばディスプレイ)に応じて異なる色を用いてシーンを作成することができ、表現強調を有するこのようなシーンは、310でレンダリングされることができる。本明細書で述べられるように芸術的意図は、イメージのシーン内のオブジェクト、色、オーディオ、および/または同様のものの強調を含むことができる。芸術的意図を有するイメージに含まれたシーン(例えば強調が付加された)は、レンダリングまたはエクスポートされることができ、異なるフォーマット(例えばストリーミング、物理メディア、および/または同様のもの)への変換のときに、本明細書で述べられるように最終的に符号化されることができる。残念ながらこのような芸術的意図は、現在の技法および/または方法を用いたこのような符号化時に失われる場合がある。従って本明細書で述べられるようなシステム、方法、および/または手段が、例えば312および314での変換および符号化時に、このような強調(例えば304〜310で入力および/または付加された)を維持するためにもたらされることができる。

図10は、異なる基準ディスプレイ上の異なる色グレーディングを有するコンテンツの例である。例として、ソニーF65カメラを用いて捕捉されたコンテンツは、2つの異なる基準ディスプレイ上でグレーディングされた。左側のコンテンツは、rec.709基準ディスプレイ上でグレーディングされ、右側のコンテンツは、DCI−P3ディスプレイ上でグレーディングされる。DCI−P3は、Rec.709より広いがRec.2020より狭い色空間である。図10は、グレーディングされたコンテンツのxy色度図上への投影を示し、Rec.709空間(例えば軸の各セット内のより小さな三角形)、およびRec.2020空間(例えば軸の各セット内のより大きな三角形)が上に重ねられている。カラリストは、例えばより多くの色を表現(例えばレンダリング)できるので、右側の基準ディスプレイを用いてより多くの自由を有し得る。

図10の右側のグレーディングされたコンテンツの圧縮時に、例えば追加の色(例えばより小さなRec.709三角形の外側の色)が歪まされないことを確実にすることによって、芸術的意図の表現を維持することが望ましい場合がある。これらの色は、圧縮時の量子化の影響を受けやすく、これは目標ディスプレイ上の最終のレンダリングされた色(復号の後)を、芸術的意図とはより明白に異なって見えるようにすることができる。

もとのビデオコンテンツの側面、例えば表現された芸術的意図の維持をサポートするために、ビデオ符号化標準、例えばH.264およびHEVCが用いられることができる。もとのビデオコンテンツのフィルム粒状性の維持を改善するために、H.264およびHEVCにおけるフィルム粒状性特性付加拡張情報(SEI)メッセージが用いられることができる。フィルム粒状性は、もともとフィルムを用いて捕捉されたコンテンツ内にしばしば存在する、ノイズ状の信号である。これは「快適性ノイズ」と呼ばれることができ、一部のコンテンツ作成者がビデオ(例えばムービー)における望ましい「外観」を維持するために用いる。

芸術監督は、ビデオコンテンツがデジタル化された後であっても、フィルム粒状性を維持することを好む場合がある。デジタルビデオ信号におけるフィルム粒状性は、例えば変換ドメインにおいて大きな量の高周波係数を生成することによって、エンコーダに対する著しい挑戦をもたらす場合がある。もとのフィルム粒状性は、例えばエンコーダがこれらの高周波係数を量子化するときに、歪まされおよび/または失われる場合がある。エンコードされたビットレートは、例えばエンコーダがこれらの係数を忠実に維持するときは、著しく増加する場合がある。フィルム粒状性SEIは、フィルム粒状性合成のためのパラメータ化されたモデルを指定することができる。エンコーダは、エンコーディングの前にもとの信号からフィルム粒状性を除去し、フィルム粒状性SEIを用いてデコーダに、どのようにフィルム粒状性を再生させ、表示する前にそれをビデオ信号に付加して戻すかを伝えることができる。

ビデオコンテンツ内の芸術的意図を維持するために、量子化行列などの符号化ツールが用いられることができる。H.264およびHEVCにおけるデフォルトの量子化/非量子化は、変換された残差係数の1つまたは複数の周波数成分に、固定のスカラー量子化器を適用することができる。量子化行列は、例えば主観的品質を改善するために、ビデオシーケンスまたはビデオ画像に対して指定されることができる(例えばシーケンスパラメータセットまたは画像パラメータセットを用いて)。変換ドメインにおける異なる周波数成分に対して、スカラー量子化器の異なる値が適用されることができる。量子化行列の仕様は制限されることができ、図1および図2のビデオ符号化システムにおける量子化および非量子化などの、1つの特定の機能ブロックに対処することができる。フィルム粒状性SEIメッセージは任意選択とすることができ、デコーダが捨てることができる追加の情報とすることができる。言い換えれば例において、芸術的意図を維持するための能力は、制限されることができる。

符号化ツールは、信号忠実度を維持する、主観的品質を改善する、および/または符号化アーチファクトを除去するために用いられることができる。符号化ツール、例えばブロックレベル量子化パラメータ(QP)調整、非ブロック化フィルタ、サンプル適応オフセット(SAO)は、ブロックレベルで適用されることができる。ブロックレベルQP調整は、例えば隣接したブロックの間で、QP値(例えば適用される量子化の大きさ)が変更されることを可能にすることができる。ブロックレベルQP調整は、別のブロックとは独立に、ブロックの品質を制御するために用いられることができる。輝度および彩度色成分に対して、異なるQP調整が適用されることができる。構文要素は、例えばHEVCにおける変換単位(TU)構文構造の一部としてシグナリングされて、例えば現在の符号化単位(CU)に適用されることになるデルタQPを示すことができる。例えばエンコーダのモード決定ロジック(図1のブロック180)に応じて、芸術的意図が表現されたエリアを符号化するために、異なるブロックサイズが選択されることができる。

芸術的意図が表現された領域、例えば芸術的表現を有する領域は、不規則な形状を有する場合がある。不規則な形状に対する芸術的表現を表し維持するために、代替の形状が用いられることができる。コンテンツ内に暗黙的または明示的に表現されることができる芸術的意図の維持を容易にするために、ビデオ符号化技法が用いられることができる。芸術的意図は微細な細分性において識別されることができ、例えばサンプルは芸術的意図に対応することができる。芸術的意図は、著しいシグナリングオーバーヘッドを被らず、サンプルレベル(例えば画素レベル)において識別され維持されることができる。符号化ツールは、符号化されたコンテンツ内の芸術的意図を維持するように、もともと設計または変更されることができる。

コンテンツ内の芸術的意図の表現を維持する、芸術的意図をベースとするコンテンツ符号化のためのシステム、方法、および手段が開示される。芸術的意図の表現は識別され(例えばシグナリングまたはコンテンツ分析によって)、芸術的意図位置PARTおよび芸術的意図特性CARTのセットとして表現される。芸術的意図特性CARTは、芸術的意図位置PARTを識別するためにシグナリングされ用いられることができる。芸術的意図維持符号化および処理は、特性CARTを維持するために、サンプル位置PARTに適用される。符号化ユーザインターフェース(例えばこれはグラフィカルユーザインターフェースを含むことができる)は、ユーザが芸術性セット(例えばPARTおよび/またはCART)を指定し、忠実度強化、QP調整値および/または後処理などの芸術性セットに関連付けられた、画素および/またはブロックの処置を選択および/または構成することを可能にすることができる。コンテンツ優先度または重要度レベルは、コンテンツ符号化、配信、処理、および/またはエラー回復性/ロバスト性における異なる(例えば強化されたまたは低減された)処置のレベルに対して、コンテンツの微細(例えば画素、サンプル)または粗大(例えばブロック)レベルにおいて、暗示的または明示的に示されることができる。

例えば本明細書で述べられるように、アーティストおよび映画産業は、映画館品質の映画を、DVD、ブルーレイ、デジタルコンテンツ、および/または同様のものなど、他のフォーマットに圧縮するために用いられることができる圧縮技術に対するコントロールをもつことができない。さらにアーティストが、映画を解釈するためにこのような圧縮(例えばエンコーディングおよび復号)時に用いられることができる情報(例えばアーティストがオブジェクト、色、および/または映画内の他の項目に対して行うことができる、表現および/または強化を解釈するために用いられることができる)をもたらすために使用可能な適切な技法が存在しない。例によればこのようなシステム、方法、および/または手段は、アーティストの意図を示すことができる情報またはメタデータ(例えばCARTなど、各画素に対する特性)が、オブジェクト、色、および/または他の項目(例えば画素レベルにおいて)が追加されることを可能にすることができる。さらにこのようなシステム、方法、および/または手段において、アーティストの意図を示すことができる情報またはメタデータは、圧縮プロセスに結び付けられることができ、すなわち本明細書で述べられるように、それは圧縮時にエンコーディングされ、再生時に復号されることができる。

本明細書での例において、このようなメタデータまたは情報をもたらすことを含み、芸術的意図を維持するために、損失のないコンテンツなどの高品質コンテンツがアーティストまたは他のユーザにもたらされることができる。アーティストまたはユーザは、グラフィカルユーザインターフェースなどのインターフェースと対話して、ブルーレイなどの圧縮されたフォーマットにおいてコンテンツがどのように見ることができるかを調整することができる。アーティストまたはユーザは、インターフェースによってもたらされる、アクション、機能、方法、および/または同様のものに関連付けられることができるツールを用いて、コンテンツのどの一部または部分をコンテンツにおいて異なって取り扱うか、または調整するかを指定することができる。アーティストまたはユーザは、ユーザインターフェースにおいて、画素に対するこのような調整の結果を視覚的に見ることができる。

異なって取り扱うコンテンツの画素または部分を選択した後、アーティストまたはユーザはツールを用いて、どのように変換時に画素または部分を異なって取り扱うまたは調整するか、すなわち不明瞭化する、色を増加する、および/または本明細書で述べられるような同様なものを行うかどうかを示すことができる。例においてこの段階で(例えばどのように画素を異なって取り扱うかを調整するまたは示すためにツールを用いて)アーティストまたはユーザは、ユーザインターフェースおよびそのツールを用いて、結果としてより高い忠実度となることができる、コンテンツの選択された画素または部分に多くのビットが流入するように量子化ステップサイズを低下させることができ、コンテンツの選択された画素または部分にどのようにループフィルタが適用されるかを調整することができ、および/または任意の他の適切な調整、強化、または変更を行ってコンテンツの選択された画素または部分を異なって取り扱うことができる。

例において(例えば画素を選択し、それらに調整を行った後、符号化パラメータは圧縮プロセスに結び付けられることができる。例えば画素の調整を有するコンテンツは、エンコーダに供給されることができ、それによりエンコーダは、選択された画素(例えば画素セット)に対する特性セット(例えば選択された画素に対する強化、調整など)を考慮に入れ、このような特性セットおよび画素(例えばメタデータの一部とすることができる)を、ビットストリームにエンコードすることができる。これはデコーダが、調整および/または強化する画素(例えば特性セットおよび/または画素セット)、およびどのようにそれらを異なって取り扱うか(例えばそれらを異なって取り扱うためのルール、またはエンコーディングツールの変更)を知ることを可能にし、それによりデコーダはこのような情報を解釈しそれに従って動作することができる。

本明細書で述べられるように芸術的意図は、例えば特性によって、画像および/または画像のシーケンスにおいて表現されることができる。特性によって芸術的意図を表現する例は、例えば色(例えば色度)、輝度値、深度値(例えば3Dコンテンツ)、テクスチャ属性、オーディオ値、オーディオ属性、およびシーン内のオブジェクトへの関連付けに基づいて、サンプルをグレーディング(例えば変更または強化)することである。特性によって芸術的意図を表現する例は、オブジェクトを空間的位置に配置すること、音またはオーディオ効果を関心のあるオブジェクトに適用すること、およびビデオおよびオーディオ効果(例えばフェードイン/フェードアウト)を適用することである。

位置(x,y)におけるサンプル値は、S(x,y)として表されることができる。サンプルは、色成分値のトリプレット、および/または位置に関連付けられた他の値(例えば深度またはオーディオ)を備えることができる。S(x,y)の特性は、C(S(x,y))として表されることができる。特性は、例えば色度図の特定の部分(例えば純粋の赤色の花)、3Dカラーボリュームの特定の部分(例えば月光)、深度値の所与の範囲(例えば視聴者に最も近い移動するオブジェクト)、ビデオ画像の空間領域などの1つまたは複数に対応することができる。

芸術的意図は、CARTとして表される特性値のセットによって表されることができる。CARTは、離散的な値、例えばK個の値のセットCART={C0,C1,...CK-1}を有することができる。空間的位置は、例えば特性がデジタルビデオ内のサンプルの空間的位置に対応するとき、離散的な座標のセットによって表現されることができる。CARTは、連続な値の範囲を包含することができる。特性は、例えば特性が色度図の一部に対応するとき、浮動小数点精度によって表現されることができる。サンプル位置(x,y)は、例えば位置(x,y)に位置するサンプルの特性が芸術的意図セットに属する、C(S(x,y))∈CARTであるとき、芸術的意図位置として定義されることができる。

コンテンツ内の芸術的意図位置の集合は、PART={(x,y)|C(S(x,y))∈CART}として表されることができる。芸術的意図位置でない位置は、通常の位置と呼ばれることができる。例えばPARTによって示される、表現された芸術的意図を有するコンテンツの部分は、高忠実度(例えばコンテンツの他の部分より高い忠実度)およびイメージ品質を有して維持されることができる。符号化および処理ツールは、PARTに位置するサンプルを維持および/または処理するように、もともと設計および/または変更されることができる。

図11は、芸術的意図をベースとするビデオ符号化の例示のフローチャートである。図11に示される例において特性値C(S(x,y))は、例えばS(x,y)またはそのサンプル値、またはサンプル位置における画素に基づいて、サンプル位置(x,y)に対して決定(例えば計算)されることができる(例えば402で)。サンプル値S(x,y)は、例えば1つまたは複数の(Y,U,V)成分、および/または位置に関連付けられた1つまたは複数の他の値(例えば深度値、オーディオ値、オーディオ属性、周囲の位置に関連付けられた値(例えば位置(x,y)の周りの局所エリア内の位置)に対応する一般的な値または画素とすることができる。

サンプル位置(x,y)がPARTに属するかどうかの決定がなされることができる(例えば406の一部として)。決定は、(x,y)∈PARTとして表されることができる。決定は、1つまたは複数のサンプル位置に対してなされることができる。決定は、例えば芸術的意図位置PARTを、明示的にシグナリングすることによってなされることができる。シグナリングは、画像のシーケンス内の1つまたは複数の画像に対してもたらされることができる。芸術的意図位置PARTを明示的にシグナリングすることは、高いシグナリングオーバーヘッドを被る場合がある。他の実施形態において、芸術的意図に対応する特性値CARTのセットは、明示的にシグナリングされることができる(例えば404で)。芸術的意図サンプル位置PARTは、例えばCARTのシグナリングされた値、および計算された特性値C(S(x,y))の1つまたは複数に基づいて識別されることができ、これは最小のシグナリングオーバーヘッドによる、PARTの位置の識別を可能にすることができる(例えば406の一部として)。例えば決定は、位置(x,y)に位置するサンプルの特性が、芸術的意図セットの一部となる、または整合することができる(例えば属する)かどうか、例えばC(S(x,y))∈CARTについてなされることができる。すなわち例において、位置(x,y)に位置するサンプルに対する計算された特性値C(S(x,y))が、芸術的意図に対応するシグナリングされた特性値CARTのセットに含まれる特性の一部となる、それに含まれる、またはそれに属することができる(例えば一致することができる)場合またはそのとき、位置(x,y)は、芸術的意図位置PARTの位置を示すことができる(例えばそれは、芸術的意図および/またはその特性値が適用されることができる画素またはサンプルの位置を示すことができる)。

芸術的意図維持符号化ツールおよび後処理は例えば、例えばPARTによって示される、表現された芸術的意図を有するサンプル位置に、適用されることができる(例えば408および412で)。非芸術的意図維持符号化ツールおよび後処理は、例えば表現された芸術的意図を有しないサンプル位置に、適用されることができる(例えば410)。例えばサンプル位置のインジケーション、およびサンプル位置に適用されるように構成された特性値のセットからの特性が出力され(例えばそれぞれの符号化ツールおよび/または後処理ツールに)、および/またはシグナリングされまたは送られて、本明細書で述べられるように芸術的意図を適用することができる。

本明細書で述べられるように芸術的意図位置は、特性セットCARTに基づいて、コンテンツ内で識別されることができる。デコーダは、もとのサンプル値S(x,y)を有し得ず、例えば量子化(変換を有してまたは有さずに)のとき、圧縮時に損失を導入する。芸術的意図サンプルは、例えばエンコーダおよびデコーダの両方において使用可能なサンプル値を用いて、識別されることができる。これはエンコーダおよびデコーダが、芸術的意図サンプルに対して同期されたままとなることを可能にすることができる。

例においてエンコーダおよびデコーダは、例えば予測されたサンプル(例えば図1および2の「予測ブロック」に属するサンプル)を用いて、サンプル特性を計算し、それらがPARTに属するかどうかを決定することができる(例えば、例えば402および406で)。予測されたサンプルは、イントラ予測(空間的予測60、260)、またはインター予測(動き予測62、262)から来ることができる。位置(x,y)での予測されたサンプルは、

として表されることができる。サンプル特性(例えば予測されたサンプルを用いた)は、

として表されることができる。言い換えれば、本明細書で述べられるように

であるとき、(x,y)∈PARTとなる(例えば上記の402および406で)。従って例において、サンプル値が芸術的意図サンプル値に属するまたはそれに含まれることができるかどうかを決定する(例えば406で)ために受信された特性セットと比較されることができる特性を計算する(例えば402で)ために用いられるサンプル値および/または位置は、予測されたサンプルを含むことができるまたは予測されたサンプルとすることができる。

例において、予測されたサンプルは精度を改善するために、フィルタリングされ、ノイズ除去され、および/または他の形で処理されることができる。予測されたサンプル値ともとのサンプル値との間の差は多大となる場合があり、これは結果として不正確な

の特性値の計算を生じる場合がある。例において加算26または加算226の出力など)、ループフィルタリングの前の復元されたサンプル値は、芸術的意図表現の特性を決定するために用いられることができる。ループフィルタ(例えば66または266)プロセスは、復元されたサンプル値を用いて、芸術的意図表現を決定することができる。位置(x,y)におけるループフィルタリングの前の復元されたサンプルは、

として表されることができる。

の特性は、

として表されることができる。言い換えれば、

であるとき、(x,y)∈PARTである。

ループフィルタリングは、芸術的意図の表現の維持に適応されることができる。例えば現在の位置(x,y)がPARTに属するかどうかの決定(例えば406で)は、インループフィルタが適用された後になされることができる。ループフィルタリングの後の復元されたサンプルは、サンプル特性および特性値Cを計算するために用いられることができる(例えば402で)。位置(x,y)における従来型のループフィルタリングの後の復元されたサンプルは、

として表されることができる。

の特性は、

として表されることができる。言い換えれば、本明細書で述べられるように、

であるとき、(x,y)∈PARTである(例えば上記402および406で)。従って例において、サンプル値が芸術的意図サンプル値に属するまたはそれに含まれることができるかどうかを決定するために(例えば406で)、受信された特性セットと比較されることができる特性を計算するために(例えば402で)用いられる、サンプル値および/または位置は、復元されたサンプルを含むことができるまたは復元されたサンプルとすることができる。

PARTに属するサンプルに、後処理が適用されることができる。位置(x,y)における変更されたループフィルタリングの後の復元されたサンプルは、

として表されることができる。本明細書で述べられるように(例えば上記)、このような復元されたサンプル(例えば変更されたループフィルタリングの後の)は、402で特性を計算するために用いられるサンプルとすることができ、406で)それが芸術的意図位置または値に含まれることができるかどうかを決定するために用いられることができる。

の特性は、

として表されることができる。精密化された芸術的意図位置

のセットは、例えば

であるとき、計算されることができる。精密化された位置

のセットは、芸術的意図サンプルの後処理時に用いられることができる。このやり方で

を計算することは、PARTの精度を改善することができる。

芸術的意図特性値CARTのセットは、シグナリングされることができる。シグナリングは、例えば本明細書で述べられるように芸術的意図位置PARTを識別するための用いられることができる。CART内の1つまたは複数の特性は、維持されることになる芸術的意図の1つまたは複数のタイプを表す。特性は、例えば色度、輝度、深度、空間的位置、エッジ属性、テクスチャ属性、オーディオサンプルおよびオーディオ効果または属性の1つまたは複数とすることができる。芸術的意図の表現の様々なタイプを表す、様々なタイプの特性に対する値は、様々な技法によって計算されることができる。

色度は、芸術的意図のタイプとすることができる。色度特性値は、例えば図5のxy色度図に対応することができる。色度特性値は、例えばサンプル値S(x,y)をその現在の色空間(例えばYCbCrまたはRGB色空間)から、CIE XYZまたは他の色空間に変換することによって計算されることができる。サンプル値は、例えば前に論じられたように

、

、

、または

の1つとすることができる。例えばRGBからXYZへの色空間変換は、式1に従って行われることができる。

式1において3×3行列は、3つのチャネル(赤、緑、および青)に対する測定されたCIE三刺激値を表す。例えばXr、Yr、Zrは、赤色チャネルに対する測定されたCIE三刺激値を表す。3×3行列は、例えば白色点およびRGB色空間の異なるバージョンに応じて、異なる係数を備えることができる。YCbCrからCIE XYZへの色空間変換も、3×3行列を用いて行われることができる。

XY色度値は、XYZ三刺激値から式2および式3に従って計算されることができる。

値xcおよびycは、サンプルの色度特性を表す。値は、サンプル位置(x,y)に対する表記法と区別するために、xc−ycとして(x−yの代わりに)表されることができる。

色度特性値は、CIE XYZ色ドメインまたは他の色空間において指定されることができる。例えば彩度値の範囲またはセットは、YCbCr色空間、RGB色空間において、またはビデオコンテンツが処理またはエンコードされる任意の色空間において指定されることができる。

輝度は、芸術的意図のタイプとすることができる。輝度特性値は、例えば図6の垂直Y軸に対応することができる。輝度は、例えばサンプル値S(x,y)を、その現在の色空間(例えばYCbCrまたはRGB色空間)から、CIE XYZ色空間に変換することによって計算されることができる。サンプル値は、例えば前に論じられたように

、

、

、または

の1つとすることができる。輝度値は、XYZ三刺激値のY値に設定されることができる。

個々にまたは全体として芸術的意図を表現する輝度特性の多様なタイプまたはサブタイプ、例えば輝度の絶対値、輝度の勾配(例えばコントラスト)が存在する場合がある。輝度特性値の計算は、例えば輝度特性のタイプまたはサブタイプに応じて変わることができ、例えば絶対値の計算は、コントラスト値の計算とは異なることができる。

深度は、芸術的意図のタイプとすることができる。深度特性値は、例えば対応する深度マップにおける位置(x,y)での深度値に設定されることができる。深度特性は、d(x,y)として表されることができる。対応する深度マップは符号化される、例えば圧縮されることができる。もとの深度値d(x,y)は、デコーダにおいて使用可能とすることができない。深度特性の値は、符号化された深度値に設定されることができ、これは

として表されることができる。

空間的位置は、芸術的意図のタイプとすることができる。空間的位置特性値は、サンプル位置(x,y)に設定されることができる。

エッジおよび/またはテクスチャ属性は、芸術的意図の1つまたは複数のタイプとすることができる。局所テクスチャまたはエッジをベースとする特性値は、例えば所与の位置(x,y)の周囲の局所エリアにおける値(例えば輝度および彩度成分値の1つまたは複数)の処理に基づいて設定されることができる。

例において位置(x,y)を備える(例えばそれを中心とする)局所エリアに、エッジ検出アルゴリズムが適用されることができる。特性値は、例えばエッジ検出アルゴリズムの出力に設定されることができる。特性値は、例えばエッジの有無を示す2進値に設定されることができる。特性値は、例えば1つまたは複数のエッジ検出アルゴリズムを用いて計算された、エッジ強度または信頼値に設定することができる。

例において位置(x,y)が特定の方向を有するエッジに関連付けられているかどうかを決定するために、1つまたは複数の有向エッジ検出フィルタが適用されることができる。特性値は、例えば1つまたは複数の有向エッジ方向、または位置(x,y)に対応する検出フィルタを示すように設定されることができる。例えば位置(x,y)が、大部分は水平または垂直エッジフィーチャに沿っているかどうかを決定するために、水平および/または垂直エッジ検出フィルタが使用されることができる。特性値は、例えば水平エッジ(またはエッジ強度)、および/または垂直エッジ(またはエッジ強度)を示すように設定されることができる。位置(x,y)は、エッジ検出結果、または異なる方向におけるエッジ強度測定に対応する、複数の特性値に関連付けられることができる。

例において位置(x,y)を中心とする局所エリアに、1つまたは複数のテクスチャ分類アルゴリズムが適用されることができる。特性値は、テクスチャ分類アルゴリズムの出力に設定されることができる。特性値は、位置(x,y)の周囲の局所エリアの統計的な属性に設定されることができる。例えば特性値は、(x,y)の周囲の局所エリアにおける1つまたは複数の成分値の平均または分散に設定されることができる。特性値は、位置(x,y)の周囲の局所エリアにおける画素の間の相関に基づいて設定されることができる。特性値は、位置(x,y)において適用される1Dまたは2Dフィルタの出力に設定されることができる。1Dまたは2Dフィルタは、1つまたは複数のテクスチャ属性に応答して結果を生じるように設計されることができる。フィルタは、特定のスケールおよび周波数における2Dガボール関数とすることができる。特性値は、例えば位置(x,y)の周囲の局所エリアの周波数ドメイン表示の計算および処理に基づいて設定されることができる。局所エリア画素は、例えばDCTまたは他の適切な周波数変換を用いて変換されることができる。周波数ドメイン係数のサブセットの値は、例えば特定の周波数または周波数の範囲に対するエネルギー測定を生じるように、組み合わされることができる。組み合わせは、例えば単純なまたは重み付きの加算的組み合わせを含むことができる。特性値は、1Dまたは2D周波数空間の何らかの部分に著しいエネルギーがあるかどうかを示すことができる。

局所テクスチャまたはエッジをベースとする特性値は、例えば位置(x,y)の周りの局所エリアに関連付けられた成分または値の1つまたは複数を用いて計算されることができる。例えば輝度値または1つまたは複数のクロミナンス値もしくは成分の、1つまたは複数が用いられて、テクスチャまたはエッジ特性値を計算することができる。

オーディオ効果は、芸術的意図のタイプとすることができる。オーディオ効果特性値は、位置(x,y)に関連付けられた1つまたは複数のオーディオ値に設定される、またはそれを用いて計算されることができる。オーディオ値は、符号化されることができる。

例として、オーディオサンプルを備えたオーディオトラックは、関心のあるオブジェクトまたは領域に関連付けられることができる。関心のある領域は、例えば視聴覚コンテンツにおいて表される話者、接近する列車、爆発などとすることができる。聞こえる芸術的意図に関連付けられた位置(x,y)は、オーディオトラックおよび/またはオーディオサンプルに関連付けられることができる。関心のある領域は、重なり合うことができる。位置(x,y)は、複数のオーディオトラックに関連付けられることができる。複数のオーディオトラックは、組み合わされて(例えば加算的に)、位置(x,y)に対するオーディオ表示を形成することができる。ビデオフレーム内の位置(x,y)は、オーディオサンプルおよび/または関係するオーディオ属性に関連付けられることができる。

関連付けられたオーディオサンプルまたはオーディオ属性は、位置(x,y)が特性セットの一部であるかどうかを決定するために処理されることができる。例として位置(x,y)に関連付けられたオーディオ信号の、1つまたは複数のチャネルの音量が取得されることができる。例えば音量が閾値より大きい(または小さい)、または範囲内であるとき、芸術的意図が表現されたと判断されることができる。例えばオーディオフェードイン/フェードアウトの検出に基づいて、芸術的意図が表現されたと判断されることができる。オーディオフェードイン(例えば正の音量勾配において)またはオーディオフェードアウト(例えば負の音量勾配において)を検出するために、音量の勾配が計算されることができる。例えばオーディオコンテンツがオーディオ周波数の一定の範囲を占めるとき、芸術的意図が表現されることができる。例えばカットオフ周波数より高いまたは低いエネルギーの、または一定の周波数帯域内のエネルギーの計算された値は、芸術的意図の表現を示す閾値を超えると決定されることができる。

ビデオ信号に付随するオーディオ信号の1つまたは複数のチャネルは、符号化(例えば圧縮)されることができる。エンコーダおよびデコーダは、圧縮されたオーディオ信号を用いて、オーディオ特性値を計算することができる。

芸術的意図の表現または特性化は、本明細書に示される例に限定されない。

特性値はスカラー、またはベクトル(例えば2つ以上のスカラー成分)の形で表されることができる。例えば色度特性および空間的位置特性は、2次元とすることができる。例えば2次元特性CARTの対応する範囲は、2次元形状を指定することができる。2次元範囲は、任意形状を有することができる。例えば任意形状に対する範囲を指定するために、多角形近似が適用されることができる。

図12は、多角形を用いて近似された2次元CART形状の例である。図12は、色度図上の長円形のCART領域を指定する例を示す。例えば長円形(破線で示される)を近似するために、多角形(実線で示される)が用いられることができる。1つまたは複数の多角形および/または他の形状表示を用いて任意の形状のCARTを近似することは、利点をもたらすことができる。

多角形は、より多くの数の頂点/辺を用いて、より高い精度で形状を近似することができる。多角形は、例えば頂点/辺の数、および頂点の座標値を指定することによって、シグナリングされることができる。所与の点が多角形の内側にあるかどうかを決定することは、(S(x,y))∈CARTであるかどうかを決定するための時間を低減することができる。点が多角形の内側にあるかどうかは、例えば多角形を有限の数の三角形で表し、点が三角形のいずれかの内側にあるかどうかを決定することによって、決定されることができる。

2次元CARTは、N個の頂点を有する多角形近似、およびN個の頂点の座標を用いて指定されることができる。値Nは、例えばエンコーダによって選択されることができる。選択は、例えば多角形近似の精度と、シグナリングオーバーヘッドとの所望のトレードオフに依存することができる。CARTは、例えば特性が1次元であるとき、2つの端点値により指定されることができる。CARTは、例えば特性が深度であるとき、深度範囲(dmin,dmax)を用いて指定されることができる。CARTは、例えば特性が輝度であるとき、輝度範囲(Lmin,Lmax)を用いて指定されることができる。いくつかのシグナリングされるパラメータは、浮動小数点精度を有することができる。例としてxy色度図上の輝度範囲値または座標は、浮動小数点数とすることができる。浮動小数点値の固定小数点近似は、シグナリングされることができる。固定小数点近似の精度(例えば用いられるビット数)は、CARTシグナリングの一部としてシグナリングされることができる。CARTは、例えば値の範囲、またはエリア表示(例えば多角形)を用いて指定されることができ、これは特性値のセット内の1つまたは複数の特性を指定することができる。

2つ以上のタイプの特性の組み合わせが、サポートされることができる。異なるタイプの特性は、互いに直交することができる。例としてCARTは、M個のメンバ(例えば直交する)特性、CART={C0,C1,..CM-1}を備えることができる。CARTの全体としての範囲は、個々のメンバ特性の範囲を個別に指定することによってシグナリングされることができる。例えば芸術的意図は、色度の範囲および輝度の範囲内で表現されることができる。これは、M=2、CART={C0,C1}によって表されることができ、ただし

(色度特性)、および

(輝度特性)である。CARTパラメータは、

を指定することができ(例えば色度値の領域を指定するために多角形近似を用いて)、および

を指定することができる(例えば輝度値の範囲を指定するために2つの端点を用いて)。

メンバ特性は、例えばメンバ特性が互いに直交しないとき、組み合わされることができる。例えば色度および輝度は、一緒に組み合わされて、図6に示される図などの、3Dカラーボリューム図における3D範囲を定義することができる。3D範囲は、例えば3D形状の表面をシグナリングすることによってシグナリングされることができる。(x,y,z)座標を有する点が、3D形状内にあるかどうかの決定がなされることができる。

2つ以上のタイプの特性の組み合わせの例としてC0は、例えば空間/画素ドメインにおける多角形領域として表されることができる、関心のある空間領域を表すと仮定する。C1は、例えばXY色度空間における多角形領域として表されることができる、XY色度空間の領域を表すと仮定する。CART={C0,C1}は、C1によって定義される色度領域内にある彩度成分を有することができる、C0によって定義される空間領域内の画素(例えばすべての画素)を表すことができる。このタイプの特性セット組み合わせは、例えばより高い忠実度、変更された非ブロック化フィルタリング、または特定の色度特性を保有する、画面の領域内の画素のセットに対する他の特別な処理を指定するために用いられることができる。

ユーザ(例えば人間のアーティスト)が、1つまたは複数の特性セットCxおよび特性値セットを指定するためにユーザ入力をもたらすことを可能にするように、ユーザインターフェースがもたらされることができる。ユーザインターフェースツールは、ユーザが、ビデオフレーム内の関心のある領域を識別することを可能にすることができる。例えばユーザインターフェースは、アーティストが、表示されたコンテンツフレームの領域の周りに形状を描くためのポインティングデバイスを用いることを可能にすることができる。ユーザインターフェースは、ユーザが例えばテキスト入力または値スライダを用いて、輝度および/または彩度値の範囲など、1つまたは複数の特性を識別することを可能にすることができる。ユーザインターフェースは、ユーザが例えば図5に示される色マップなどの色マップを用いて、色の領域を指定することを可能にすることができる。ユーザインターフェースは、ユーザが例えばテキスト入力または「値スライダ」インターフェースを用いて、目標深度または深度値の範囲を指定することを可能にすることができる。ユーザインターフェースは、ユーザがエッジ方向、エッジ強度、またはテクスチャ分類を指定することを可能にすることができる。

ユーザインターフェースは、例えば特性セットを定義するための値の選択を支援するように、ユーザがコンテンツの視覚的表示を指し示すことを可能にするように構成されることができる。例えばユーザは、表示されたコンテンツフレーム内の位置(x,y)を指し示すことができる。ユーザインターフェースは、その位置に関連付けられた1つまたは複数の値(例えば輝度、彩度、深度、エッジ強度、テクスチャ分類)を識別することによって応答することができる。ユーザインターフェースは、ユーザが、選択された位置に関連付けられた値を備える、またはそれを中心とする値の範囲を選択することを可能にすることができる。ユーザインターフェースは、例えばユーザインターフェースにおいて選択された値または値の範囲によって定義された1つまたは複数の特性値セットに対応する、位置PARTのセット(例えば画素のセット)を識別するように、表示されたコンテンツフレーム内にインジケーション(例えば輪郭または強調表示)を表示することができる。例えば任意の特性セットタイプの2つ以上の特性セットの組み合わせから、複合特性セットが形成されることができる。複合特性セットは、2つ以上の特性セットを満足する位置、または少なくとも1つの特性セット(例えばユーザによって選択または定義された複数の特性セットの少なくとも1つ)を満足する位置に対して、芸術的意図を指定することができる。

ユーザインターフェースは、ユーザが、芸術性セット位置PARTを処理するために符号化ツールを選択および/または構成することを可能にすることができる。例としてユーザインターフェースは、ユーザが忠実度強化、および芸術性セットに関連付けられた画素および/またはブロックに適用可能なQP調整のための値の、適用を指定することを可能にすることができる。インターフェースは、ユーザが、芸術性セットに関連付けられた画素および/またはブロックに対する、強化されたループフィルタまたは変更された後処理段階の適用を指定することを可能にすることができる。ユーザインターフェースは、ユーザが、芸術性セット位置を処理するために追加または変更されることになる、1つまたは複数の符号化ツールを指定および/または構成することを可能にすることができる。

図13は、CARTシグナリングの例示のフローチャートである。図13に示される例において、CART内のメンバ特性の総数Mは、送られおよび/または受信されるなどシグナリングされることができる(例えば502で)。メンバ特性Ci、ただしi=0からM−1に対して、特性のタイプは、送られおよび/または受信されるなどシグナリングされることができる(例えば504で)。特性のタイプは、例えば輝度、色度、深度、空間的位置、エッジ方向、エッジ強度、テクスチャ属性または分類、およびオーディオ属性または効果とすることができる。Ciのタイプは、例えば2Dまたは1Dとすることができる。例えばCiのタイプが例えば2D(2次元)であるか1D(1次元)であるかについての決定がなされることができる(例えば506で)。例において(例えば506での決定に基づいて)Ciの範囲は、例えば2つの端点(例えば1Dの場合)(例えば508で)、またはCiの多角形表示(例えば2Dの場合)(例えば510で)を指定することによって、送られおよび/または受信されるなどシグナリングされることができる。多角形表示は、頂点の数および頂点座標をシグナリングすることによって(例えば510で)、送られおよび/または受信されるなどシグナリングされることができる。従って例において、決定に基づいてメンバ特性Ciは1次元であるとすることができるとき、メンバ特性Ciに対する特性のタイプの範囲は、端点を用いて送られおよび/または受信される(例えばシグナリングされる)ことを含めて用いられることができ、または決定に基づいてメンバ特性Ciは2次元であるとすることができるとき、メンバ特性Ciに対する特性のタイプの多角形表示は、送られおよび/または受信される(例えばシグナリングされる)ことを含めて用いられることができる。例においてメンバ特性Ciに対する特性のタイプの範囲、および/またはメンバ特性Ciに対する特性のタイプの多角形表示は、エンコーディング、復号、配信、処理およびエラー回復性の少なくとも1つにおいて用いられることができる。示されるようにこれは、特性の総数を有する特性のセット内の各メンバ特性Ciに対して、またはセット内の特性の総数に達するまで、繰り返されることができる(例えば512に示されるように)。

例えば符号化されたビデオビットストリームにおけるCARTシグナリングは、例えばシーケンスレベル(例えばシーケンスパラメータセット、画像パラメータセット、ビデオパラメータセット)、画像レベル(例えば画像パラメータセット、スライスセグメントヘッダ)、またはスライスレベル(例えばスライスセグメントヘッダ)において送られることができる。CARTのシグナリングは、SEIメッセージとして送られることができる。SEIメッセージは、受信器において受信され、構文解析され、および解釈されることができ、例えば芸術的意図サンプルを有するエリアの品質を改善するように、1つまたは複数の後処理ステップを導くために用いられることができる。後処理技法は、ポストループのやり方で適用される適応ループフィルタ、クロスコンポーネントフィルタリングなどを備えることができる。

符号化ツールは、芸術的意図の維持をサポートするように設計および/または変更されることができる。量子化は、圧縮時に情報損失および信号歪みを導入することができる。大きな量子化ステップサイズは著しい情報損失に繋がる場合があり、これは復元されたビデオが目に見える符号化アーチファクトを含む場合があることを意味することができる。著しい情報損失は、特に芸術的意図表現に対応するサンプルを備えたエリア、例えばPART位置に対して望ましくないものとなる場合がある。PARTに位置するサンプルの信号忠実度は、例えばより微細な量子化ステップサイズを適用して、対応するPARTサンプルの予測残差を符号化することによって、維持されることができる。

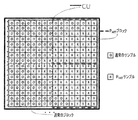

図14は、PARTブロックおよび通常のブロックを有する符号化単位(CU)の例である。図14は、いくつかのPARTサンプル(「x」サンプル)、およびいくつかの通常のサンプル(「o」サンプル)を有するCUを表す。分割および処置は、例えばサンプルベースではなくブロックベースとすることができる。例として図14におけるCUは、4つのブロックに分割されることができる。左側の2つのブロックは、主として通常のサンプルを備える。主として通常のサンプルを有するブロックは、通常のブロックとしてラベル付けされることができる。右側の2つのブロックは、主としてPARTサンプルを備える。主としてPARTサンプルを有するブロックは、PARTブロックとしてラベル付けされることができる。

PARTブロックとしてラベル付けされたブロックには、より微細な量子化が適用されることができる。より微細な量子化を適用するために、HEVCにおけるCUレベルQP調整が用いられることができる。しかしCUレベルQP調整は、十分な細分性をもたらすことができない。図14に示される例におけるCUレベルQP調整の適用は、同じCU内のサンプルに同じQPを適用することができる。より小さなCUレベルQPは、通常のブロックはより少なく量子化されることができることを意味することができ、これはビットレートの増加を引き起こす場合があることを意味することができる。より大きなCUレベルQPは、PARTブロックがより多くの歪みを受ける場合があることを意味することができる。

PARTサンプルは、例えば高位レベルでデルタQP値を指定することによって、高忠実度を有して維持されることができる。高位レベルは、例えばシーケンスレベル、画像レベル、またはスライスレベルとすることができる。これは、芸術的意図をベースとするQP調整と呼ばれることができる。PARTサンプルは、PARTブロック(例えばほとんどPARTサンプルを備えるブロック)を量子化することによって維持されることができる。PARTサンプルは、例えば前に論じられたように、例えばシグナリングされたCARTパラメータを用いて識別されることができる。ブロックは、例えばブロックがPARTサンプルの一部分、百分率、または他の閾値レベルを備えるとき、PARTブロックとして識別されることができる。例として、閾値は10パーセントまたは25パーセントに設定されることができ、それにより10パーセントより多い、または25パーセントより多いPARTサンプルを備えた任意のブロックは、PARTブロックとして識別される。

PARTブロックには、芸術的意図QP調整が適用されることができる。高位レベルでシグナリングされたデルタQP値は、例えばQP調整において用いられて、例えば通常のQP値からデルタQPを減算することによって低減されたQP値を生成することができる。低減されたQP値は、PARTブロックに適用されて、より微細な量子化を達成することができる。ブロック決定閾値のための値、およびデルタQP値は、静的または動的、および固定または可変とすることができる(例えば値は、人間のアーティストなどのユーザによって構成可能とすることができ、およびコンテンツビットストリームにおいてシグナリングされることができる)。

変化するQP調整は、例えばブロック内のPARTサンプルの数または割合に応じて、ブロックに適用されることができる。変化するQP調整は、例えばdeltaQP_maxの値に基づいて、制限されることができる。最大デルタQP値(例えばdeltaQP_max)は、例えば人間のアーティストによって定義されることができる。例えばいくつかのPART画素を有するブロックはQP調整を受けることができ、deltaQPは式4に従って計算される。

deltaQP=round(num(PART)/num(block)×deltaQP_max) 式4

式4においてnum(PART)は現在のブロック内のPART画素の数、num(block)は現在のブロック内の画素の総数、deltaQP_maxは現在の芸術性セットに対する最大QP調整、およびround()は丸め演算である。丸め演算は、deltaQPが整数値を有することを確実にすることができる。

PARTサンプルの決定の代わりまたは追加としてのPARTブロックの決定は、例えば量子化の前に変換の適用を受けないブロックに対しては、削除されることができる。いくつかのブロックに対して、量子化されることができる変換係数を生成するように、予測残差のブロック(そのいくつかはPARTサンプルに、他は通常のサンプルに対応することができる)に変換が適用される。

HEVCにおけるTUレベルで、例えば変換スキップモードが有効にされることができる。量子化は、例えば変換スキップモードで、空間ドメインにおいて予測残差に直接適用されることができる。PARTブロックの識別は、例えば異なる量子化ステップサイズが個々のサンプル位置に適用されることができることを考えれば、削除されることができる。異なるステップサイズは、例えばサンプルがPARTサンプルであるか、通常のサンプルであるかに依存することができる。

芸術的意図をベースとするQP調整は、1つまたは複数のデルタQP値を有することができる。QP値は、1つまたは複数の色成分に対応することができる。量子化ステップサイズは、異なる色成分に対して独立に調整されることができる。deltaQPおよび/またはdeltaQP_maxの値は、ユーザによって構成されることができる。

符号化ツールは、芸術的意図を維持するように、もともと設計および/または変更されことができる。非ブロック化フィルタは、芸術的意図を維持するように変更されることができる。例としてH.264およびHEVCにおける非ブロック化フィルタは、ブロック境界の間のブロック化アーチファクトを低減し、主観的品質を改善するために用いられることができる。

図15は、隣接したブロック(ブロックP)および現在のブロック(ブロックQ)を用いた非ブロック化の例である。図15に示されるように非ブロック化は、水平および垂直ブロック境界に適用されることができる。非ブロック化は、例えば現在のブロック(例えばブロックQ)の隣接したブロック(例えばブロックP)を識別することによって適用されることができる。隣接したブロックの識別は、例えばエッジ方向に依存することができる。

PとQとの間の境界強度(Bs)パラメータが、計算されることができる。Bsの計算は、例えばPおよびQの符号化モード、PおよびQの基準画像、PおよびQの動きベクトル、および/またはブロックPまたはブロックQにゼロでない変換係数が存在するかどうかに、依存することができる。Bsは、PおよびQ内の隣接したサンプルに適用されることができる、非ブロック化フィルタの強度を制御することができる。

適応非ブロック化フィルタは、輝度成分および彩度成分に個別に適用されることができる。ブロック境界のそれぞれの側のサンプルは、例えばBsの値に応じてフィルタリングされることができる。Bsの値は、例えば4つまでの輝度または彩度とすることができる。

境界強度Bsは、例えばPおよび/またはQがPARTブロックであるかどうかを考慮に入れることによって決定されることができる。Bsの値は、例えばPおよびQの1つまたは複数がPARTブロックであるとき、増加されることができ、それにより、より高い主観的品質をもたらすように、より強い非ブロック化フィルタが適用される。非ブロック化の複雑さは、簡素化されることができる。例として例えばBsが1より大きいとき、HEVCにおける彩度成分はフィルタリングされることができる。簡素化は結果として、芸術的意図維持の目的に対して、復元された信号において不十分な品質の色度を生じる場合がある。例えばBsが1に等しいとき、非ブロック化フィルタを適用することによって、より強度の非ブロック化フィルタが彩度成分に適用されることができる。

ブロックPおよびブロックQのQP値は、それぞれQP(P)およびQP(Q)として表されることができる。H.264およびHEVCの非ブロック化フィルタリングプロセスは、例えばQP(P)およびQP(Q)の値などのいくつかの要因に基づいて、適応できるものとすることができる。適応非ブロック化フィルタリング時に用いられるQP(P)およびQP(Q)の値は、芸術的意図をベースとするQP調整が適用される前または後の、ブロックQP値からのものとすることができる。

図16は、芸術的意図維持のためのブロックベースのビデオデコーダの例の図である。図16は、図2に示されるブロックベースのハイブリッドビデオデコーダの図の変更されたバージョンを示す。図16に示されるように、入力ビットストリームはエントロピー復号され、ビットストリームはアンパックされる。

モードおよび動き情報ならびにCARTパラメータは、ビットストリームから取り出されることができる。CARTパラメータは、予測されたサンプルと共に(または復元されたサンプルと共に)用いられて、例えばどのブロック/サンプルがPARTブロック/サンプルであるかを決定することができる(1620)。変更された逆量子化(1610)および変更されたループフィルタ(1640)は、例えばどのブロック/サンプルがPARTブロック/サンプルであるかの決定に応じて適用されることができる。PARTブロック/サンプル決定(1620)は、復元された画像に後処理(1630)を適用するために用いられて、例えばディスプレイ上にレンダリングされた画像内の芸術的意図をさらに復活させるおよび/または強化することができる。後処理は、例えば適応ループフィルタ(例えば後置フィルタとして用いられる)、および/またはクロスコンポーネント彩度強化フィルタを備えることができる。

ブロックベースのハイブリッドビデオ復号が、図16に例として示される。芸術的意図維持技法は、他のタイプのビデオ符号化システムに適用可能である。CARTシグナリングおよびPART識別技法は、多様な符号化システムに適用可能である。例えばCARTパラメータをシグナリングすることは、芸術的意図を維持するために、ウェーブレットベースのビデオ符号化システム、またはオブジェクトベースのビデオ符号化システムと組み合わされることができる。

シグナリングされた芸術的意図特性(例えばCARTパラメータ)は、エラーが生じやすいチャネル(例えば無線チャネル)に依存するものなどのビデオ配信システムの、エラー回復性/ロバスト性を改善または強化するために用いられることができる。例えば送信時に、ビットストリームの一部分が失われる場合がある(例えば破損したまたは失われたパケットにより)。デコーダは、失われたサンプルがPARTブロック/サンプルに対応することを検出することができる。失われたブロック/サンプルを隠蔽するために、強化されたエラー隠蔽アルゴリズムが適用されることができる。

例において深度特性は、CARTにおいてシグナリングされることができる。デコーダは、対応する深度マップを参照して(深度マップが受信されたと仮定して)、失われたサンプルがPARTブロック/サンプルに対応するかどうかを決定することができる。例において空間特性は、CARTにおいてシグナリングされることができる。デコーダは、失われたサンプルの位置を決定して、それらがPARTブロック/サンプルに対応するかどうかを決定することができる。デコーダは、適切なエラー隠蔽方策を選択して、ビデオ品質を改善することができる。例において色度(または輝度)特性は、CARTにおいてシグナリングされることができる。デコーダは、失われたサンプルがPART位置に対応するかどうかを決定することができる。デコーダは、失われたサンプルのサンプル値を知ることができない。デコーダは、例えば使用可能な隣接したサンプル(例えば空間的に隣接したサンプルおよび/または時間的に隣接したサンプル)を用いて、失われたサンプルがPART位置に対応するかどうかの決定を補助し、および適切なエラー隠蔽技法を選択することができる。

エンコーダは、より重要なまたは優先されるサンプル、例えばPARTサンプルを、異なるスライス/タイルにおいて圧縮することができる。重要なスライス/タイルは、コンテンツ配信(例えば送信)段階および/または他の段階で、より高い優先度に関連付けられることができる。例えばCARTシグナリングに基づいてQoSを改善するように、強化されたエラー保護(例えばより強力なFEC符号)および/または強化された送信が用いられることができる。送信器/パケタイザは、例えば基本ストリームにおけるCARTシグナリング情報を用いて、送信/パケット化のためのQoSパラメータ(例えばエラー保護レート、送信優先度)を決定することができる。

より重要度の高いまたは低い、コンテンツ内の位置のセットが、識別されることができる。CARTは、芸術的意図に関して、強化された重要度を有する特性値のセットである。PARTは、芸術的意図に関して、強化された重要度を有するサンプル位置のセットである。芸術的意図特性CARTは、芸術的意図位置PARTのセット(例えば本明細書で述べられるような)を識別するためにシグナリングされおよび用いられることができる。異なる重要度レベルを有する位置のセットが、識別されることができる。

低減された(例えば非常に低い)重要度を有する位置のセットは、例えばコンテンツ作成プロセス時に識別されることができる。アーティストは、特性値のセットおよび/またはサンプル位置のセットを、「低い重要度」を有するものとして明示的にまたは暗示的に識別することができる。例えばアーティストがサンプル位置のセットにさらなる注意を払わなかったとき、芸術的意図が表現されないことが暗示されることができる。重要度の暗示的または明示的な低減を有する位置は、符号化、後処理、および/またはエラー回復性の間に、「非強調化」されることができる。例えば低減された重要度サンプル位置に対しては符号化時に、より厳しい量子化が適用されることができ、ループフィルタリングまたは後置フィルタリングは簡素化または削除されることができ、および/またはロバスト性のより低いエラー保護が用いられることができる。

図17は、位置の任意のセットに対する重要度レベルのシグナリングの例示のフローチャートである。特性の複数のセット、CIMP-k、k=1...Nが、シグナリングされることができる(例えば602で)。関連付けられたサンプル位置のセットPIMP-kが、識別されることができる(図示せず、例えば602の後で)。1つまたは複数のセットCIMP-kに対して重要度インジケータIMPkが割り振られ、シグナリングされることができる(例えば604で)。図13は、図17に示される一般化されたシグナリングフレームワークに対して用いられることができるCARTシグナリングフローチャートの例を示す。例えば特性CIMP-kは、図13で述べられたように、送られおよび/または受信されるなどシグナリングされることができる(例えば606で)。これは各セットに対して繰り返されることができる(例えば608によって示されるように)。

例えば重要度インジケータに基づいて、適切な符号化、後処理、および/またはエラー回復性対策が適用されることができる。一般化された重要度シグナリングは、ビデオ配信チェーンが、異なる重要度レベルを有するサンプル位置のセットの間での、リソース割り当てを強化することを可能にすることができる。リソース割り当ては、圧縮時のビットレート割り当てを含むことができる(例えばより高い重要度を有する信号に、より多くのビットが費やされる)。リソース割り当ては、コンピューティングリソース割り当てを含むことができる(例えばより高い重要度を有する信号の、より良好な処理および維持)。リソース割り当ては、エラー保護リソース割り当てを含むことができる(例えばより高い重要度を有する信号の、よりロバスト性のあるエラー保護)。

符号化ツールのための構成パラメータは、重要度インジケータ値から導き出されることができる。例えば重要度インジケータは、0と100の間の値としてシグナリングされることができる。シグナリングされたQP値に対して、50より大きな重要度インジケータはQPにおける低減を示すことができ、50未満の重要度インジケータはQPにおける増加を示すことができる。例においてdeltaQPの値は、重要度インジケータと50との間の絶対差に基づいて計算されることができる。重要度インジケータに基づいて、他の構成パラメータ(例えば非ブロック化フィルタ選択、境界強度、チャネル符号化強度、再送信の許容回数、エラー隠蔽のための許容計算レベル)が計算されることができる。

関連のある構成パラメータは、例えば異なる重要度インジケータを有する異なる芸術的意図セットからの位置(例えば画素)が、単位(例えば送信されることになるブロック、スライス、パケットにおいて)において一緒に混合されるとき、組み合わされた重要度インジケータを用いて導き出されることができる。例えば単位内の画素の重要度インジケータの重み付けされた組み合わせは、重要度インジケータを共有する画素の数によって重み付けされて計算されることができ、結果としての組み合わされた重要度インジケータは、単位に対する構成パラメータを導き出すために用いられることができる。

位置(x,y)は、2つ以上の芸術的意図セット仕様に属することができる。例えば第1の芸術的意図セット仕様は、現在のフレームの空間領域を備えることができる。第2の(例えば別の)芸術的意図セット仕様は、第1の彩度成分に対する値の範囲を備えることができる。第1の芸術的意図セット仕様は、第1の重要度インジケータIMP1に関連付けられることができる。第2の芸術的意図セット仕様は、第2の重要度インジケータIMP2に関連付けられることができる。位置(x,y)は、第1の芸術的意図セット仕様の空間領域内にあることができ、第2の芸術的意図セット仕様の値の範囲を満足する彩度成分を有することができる。位置(x,y)は、2つ以上の芸術性セット仕様に関連付けられることができる。

位置(x,y)は、2つ以上の重要度インジケータに関連付けられることができる。例において位置(x,y)に対して、組み合わされた重要度インジケータが決定されることができる。組み合わされた重要度インジケータは、位置(x,y)に関連付けられた複数の重要度インジケータの組み合わせとすることができる。例えば位置(x,y)に対する組み合わされた重要度インジケータを決定するために、複数の重要度インジケータは加算されまたは平均されることができる。位置(x,y)に対する組み合わされた重要度インジケータを決定するために、複数の重要度インジケータの最大または最小値が計算されることができる。組み合わされた重要度インジケータは、例えば追加されたおよび/または変更された符号化ツールを用いて、どのように位置(x,y)、および/またはどのように位置(x,y)を備えるブロックが処理されるべきかを決定するための、重要度インジケータ値として用いられることができる。

様々な芸術的意図セットに対して一般的な重要度インジケータを符号化することは、ユーザ(例えば人間のアーティスト)が芸術的意図セットに対する重要度レベルを示すための便利な伝達手段をもたらすことができる。一般的な重要度インジケータは、個々の決定を低減することができる。一般的な重要度インジケータは、芸術的意図セットを処理する様々な符号化ツールのための構成パラメータを設定するために用いられることができる。ユーザは識別された芸術的意図セットの処理にわたって、よりきめの細かい制御を望むことができる。ユーザインターフェースは、ユーザが様々なツール(例えば符号化ツール、配信ツール、エラー隠蔽ツール)のための詳細な構成パラメータを指定することを可能にすることができる。構成パラメータの詳細なセットは、1つまたは複数の芸術性セットに対してシグナリングされることができる。ツール構成パラメータは、例えば図17に示されるように、IMPkをシグナリングすることに加えてまたはその代わりにシグナリングされることができる。

一般化されたシグナリングは、CARTシグナリングがより効率的になることを可能にすることができる。例えば芸術的意図を有しない(例えば低い重要度)位置のセットとして、PNON-ARTが定義されることができる。PNON-ART内の(例えばすべての)位置の数またはある百分率によって共有される「非芸術的意図」特性のセットとして、CNON-ARTが定義されることができる。CNON-ARTをシグナリングすることは、結果としてCARTをシグナリングするより少ないオーバーヘッドを生じることができる。

図18Aは、1つまたは複数の開示される実施形態が実施されることができる、例示の通信システム100の図である。通信システム100は、複数の無線ユーザに音声、データ、ビデオ、メッセージング、ブロードキャストなどのコンテンツをもたらす、多元接続システムとすることができる。通信システム100は、複数の無線ユーザが、無線帯域幅を含むシステムリソースの共有を通じて、このようなコンテンツにアクセスすることを可能にすることができる。例えば通信システム100は、符号分割多元接続(CDMA)、時分割多元接続(TDMA)、周波数分割多元接続(FDMA)、直交FDMA(OFDMA)、単一キャリアFDMA(SC−FDMA)などの1つまたは複数のチャネルアクセス方法を使用することができる。

図18Aに示されるように通信システム100は、無線送信/受信ユニット(WTRU)102a、102b、102c、および/または102d(これらは全体としてまたはまとめてWTRU102と呼ばれることができる)、無線アクセスネットワーク(RAN)103/104/105、コアネットワーク106/107/109、公衆交換電話ネットワーク(PSTN)108、インターネット110、および他のネットワーク112を含むことができるが、開示される実施形態は任意の数のWTRU、基地局、ネットワーク、および/またはネットワーク要素を企図することが理解されるであろう。WTRU102a、102b、102c、102dのそれぞれは、無線環境において動作および/または通信するように構成された任意のタイプのデバイスとすることができる。例としてWTRU102a、102b、102c、102dは、無線信号を送信および/または受信するように構成されることができ、ユーザ機器(UE)、移動局、固定またはモバイル加入者ユニット、ページャ、携帯電話、携帯情報端末(PDA)、スマートフォン、ラップトップ、ネットブック、パーソナルコンピュータ、無線センサ、民生用電子機器などを含むことができる。

通信システム100はまた、基地局114aおよび基地局114bを含むことができる。基地局114a、114bのそれぞれは、コアネットワーク106/107/109、インターネット110、および/またはネットワーク112などの、1つまたは複数の通信ネットワークへのアクセスを容易にするように、WTRU102a、102b、102c、102dの少なくとも1つと無線でインターフェース接続するように構成された任意のタイプのデバイスとすることができる。例として基地局114a、114bは、基地トランシーバ局(BTS)、ノードB、eノードB、ホームノードB、ホームeノードB、サイトコントローラ、アクセスポイント(AP)、無線ルータなどとすることができる。基地局114a、114bはそれぞれ単一の要素として示されるが、基地局114a、114bは、任意の数の相互接続された基地局および/またはネットワーク要素を含むことができることが理解されるであろう。

基地局114aはRAN103/104/105の一部とすることができ、これはまた基地局コントローラ(BSC)、無線ネットワークコントローラ(RNC)、中継ノードなど、他の基地局および/またはネットワーク要素(図示せず)を含むことができる。基地局114aおよび/または基地局114bは、セル(図示せず)と呼ばれることができる特定の地理的領域内で、無線信号を送信および/または受信するように構成されることができる。セルは、セルセクタにさらに分割されることができる。例えば基地局114aに関連付けられたセルは、3つのセクタに分割されることができる。従って一実施形態では基地局114aは、3つのトランシーバ、例えばセルの各セクタに対して1つを含むことができる。他の実施形態では基地局114aは、多入力多出力(MIMO)技術を使用することができ、従ってセルの各セクタに対して複数のトランシーバを利用することができる。

基地局114a、114bは、任意の適切な無線通信リンク(例えば無線周波数(RF)、マイクロ波、赤外線(IR)、紫外線(UV)、可視光など)とすることができるエアインターフェース115/116/117を通して、WTRU102a、102b、102c、102dの1つまたは複数と通信することができる。エアインターフェース115/116/117は、任意の適切な無線アクセス技術(RAT)を用いて確立されることができる。

より具体的には上記のように通信システム100は、多元接続システムとすることができ、CDMA、TDMA、FDMA、OFDMA、SC−FDMAなどの1つまたは複数のチャネルアクセス方式を使用することができる。例えばRAN103/104/105内の基地局114a、およびWTRU102a、102b、102cは、ユニバーサル移動体通信システム(UMTS)地上無線アクセス(UTRA)などの無線技術を実施することができ、これは広帯域CDMA(WCDMA)を用いてエアインターフェース115/116/117を確立することができる。WCDMAは、高速パケットアクセス(HSPA)および/またはEvolved HSPA(HSPA+)などの通信プロトコルを含むことができる。HSPAは、高速ダウンリンクパケットアクセス(HSDPA)および/または高速アップリンクパケットアクセス(HSUPA)を含むことができる。

他の実施形態では基地局114aおよびWTRU102a、102b、102cは、Evolved UMTS地上無線アクセス(E−UTRA)などの無線技術を実施することができ、これはロングタームエボリューション(LTE)および/またはLTE−Advanced(LTE−A)を用いてエアインターフェース115/116/117を確立することができる。

他の実施形態では基地局114aおよびWTRU102a、102b、102cは、IEEE 802.16(例えばマイクロ波アクセス用世界規模相互運用性(WiMAX))、CDMA2000、CDMA2000 1X、CDMA2000 EV−DO、暫定標準2000(IS−2000)、暫定標準95(IS−95)、暫定標準856(IS−856)、移動体通信用グローバルシステム(GSM)、GSM進化型高速データレート(EDGE)、GSM EDGE(GERAN)などの無線技術を実施することができる。

図18Aの基地局114bは、例えば無線ルータ、ホームノードB、ホームeノードB、またはアクセスポイントとすることができ、事業所、ホーム、乗り物、キャンパスなどの局所的エリアにおける無線接続性を容易にするための、任意の適切なRATを利用することができる。一実施形態では基地局114bおよびWTRU102c、102dは、IEEE 802.11などの無線技術を実施して、無線ローカルエリアネットワーク(WLAN)を確立することができる。他の実施形態では基地局114bおよびWTRU102c、102dは、IEEE 802.15などの無線技術を実施して、無線パーソナルエリアネットワーク(WPAN)を確立することができる。他の実施形態では基地局114bおよびWTRU102c、102dは、セルラベースのRAT(例えばWCDMA、CDMA2000、GSM、LTE、LTE−Aなど)を利用して、ピコセルまたはフェムトセルを確立することができる。図18Aに示されるように基地局114bは、インターネット110への直接接続を有することができる。従って基地局114bは、コアネットワーク106/107/109を経由してインターネット110にアクセスするように用いられなくてもよい。

RAN103/104/105はコアネットワーク106/107/109と通信することができ、これは音声、データ、アプリケーション、および/またはボイスオーバインターネットプロトコル(VoIP)サービスをWTRU102a、102b、102c、102dの1つまたは複数にもたらすように構成された、任意のタイプのネットワークとすることができる。例えばコアネットワーク106/107/109は、呼制御、料金請求サービス、モバイル位置ベースのサービス、プリペイドコール、インターネット接続性、ビデオ配信などをもたらすことができ、および/またはユーザ認証などの高レベルセキュリティ機能を行うことができる。図18Aに示されないが、RAN103/104/105および/またはコアネットワーク106/107/109は、RAN103/104/105と同じRATまたは異なるRATを使用する他のRANと、直接または間接に通信できることが理解されるであろう。例えば、E−UTRA無線技術を利用することができるRAN103/104/105に接続されることに加えて、コアネットワーク106/107/109はまた、GSM無線技術を使用する他のRAN(図示せず)とも通信することができる。

コアネットワーク106/107/109はまた、PSTN108、インターネット110、および/または他のネットワーク112にアクセスするように、WTRU102a、102b、102c、102dのためのゲートウェイとして働くことができる。PSTN108は、従来型電話サービス(plain old telephone service)(POTS)をもたらす回線交換電話ネットワークを含むことができる。インターネット110は、TCP/IPインターネットプロトコル群における伝送制御プロトコル(TCP)、ユーザデータグラムプロトコル(UDP)、およびインターネットプロトコル(IP)などの、共通通信プロトコルを用いる、相互接続されたコンピュータネットワークおよびデバイスの地球規模のシステムを含むことができる。ネットワーク112は、他のサービスプロバイダによって所有および/または運用される有線もしくは無線通信ネットワークを含むことができる。例えばネットワーク112は、RAN103/104/105と同じRATまたは異なるRATを使用することができる1つまたは複数のRANに接続された、他のコアネットワークを含むことができる。

通信システム100内のWTRU102a、102b、102c、102dの1つまたは複数は、マルチモード能力を含むことができ、例えばWTRU102a、102b、102c、102dは、異なる無線リンクを通して異なる無線ネットワークと通信するための複数のトランシーバを含むことができる。例えば図18Aに示されるWTRU102cは、セルラベースの無線技術を使用することができる基地局114aと、およびIEEE 802無線技術を使用することができる基地局114bと、通信するように構成されることができる。

図18Bは、例示のWTRU102のシステム図である。図18Bに示されるようにWTRU102は、プロセッサ118、トランシーバ120、送信/受信要素122、スピーカ/マイクロフォン124、キーパッド126、ディスプレイ/タッチパッド128、非リムーバブルメモリ130、リムーバブルメモリ132、電源134、全地球測位システム(GPS)チップセット136、および他の周辺装置138を含むことができる。WTRU102は、実施形態と一貫性を保ちながら、上記の要素の任意のサブコンビネーションを含むことができることが理解されるであろう。また実施形態は、基地局114aおよび114b、および/または非限定的に中でもトランシーバ局(BTS)、ノードB、サイトコントローラ、アクセスポイント(AP)、ホームノードB、進化型ホームノードB(eノードB)、ホーム進化型ノードB(HeNB)、ホーム進化型ノードBゲートウェイ、およびプロキシノードなど基地局114aおよび114bが表すことができるノードは、図18Bに示され本明細書で述べられる要素の1つまたは複数を含むことができることを企図する。

プロセッサ118は、汎用プロセッサ、専用プロセッサ、従来型プロセッサ、デジタル信号プロセッサ(DSP)、複数のマイクロプロセッサ、DSPコアに関連した1つまたは複数のマイクロプロセッサ、コントローラ、マイクロコントローラ、特定用途向け集積回路(ASIC)、フィールドプログラマブルゲートアレイ(FPGA)回路、任意の他のタイプの集積回路(IC)、状態機械などとすることができる。プロセッサ118は、信号符号化、データ処理、電力制御、入力/出力処理、および/またはWTRU102が無線環境において動作することを可能にする任意の他の機能を行うことができる。プロセッサ118はトランシーバ120に結合されることができ、これは送信/受信要素122に結合されることができる。図18Bはプロセッサ118およびトランシーバ120を別個の構成要素として示すが、プロセッサ118およびトランシーバ120は、電子回路パッケージまたはチップ内に一緒に一体化されることができることが理解されるであろう。

送信/受信要素122は、エアインターフェース115/116/117を通して、基地局(例えば基地局114a)に信号を送信し、またはそれから信号を受信するように構成されることができる。例えば一実施形態では送信/受信要素122は、RF信号を送信および/または受信するように構成されたアンテナとすることができる。他の実施形態では送信/受信要素122は、例えばIR、UV、または可視光信号を送信および/または受信するように構成された放射器/検出器とすることができる。他の実施形態では送信/受信要素122は、RFおよび光信号の両方を送信および受信するように構成されることができる。送信/受信要素122は、無線信号の任意の組み合わせを送信および/または受信するように構成されることができることが理解されるであろう。

さらに図18Bでは送信/受信要素122は単一の要素として示されるが、WTRU102は任意の数の送信/受信要素122を含むことができる。より具体的にはWTRU102は、MIMO技術を使用することができる。従って一実施形態ではWTRU102は、エアインターフェース115/116/117を通して無線信号を送信および受信するための、2つ以上の送信/受信要素122(例えば複数のアンテナ)を含むことができる。

トランシーバ120は、送信/受信要素122によって送信されることになる信号を変調するように、および送信/受信要素122によって受信された信号を復調するように構成されることができる。上記のようにWTRU102は、マルチモード能力を有することができる。従ってトランシーバ120は、WTRU102が例えばUTRAおよびIEEE 802.11などの複数のRATによって通信することを可能にするための、複数のトランシーバを含むことができる。

WTRU102のプロセッサ118は、スピーカ/マイクロフォン124、キーパッド126、および/またはディスプレイ/タッチパッド128(例えば液晶表示(LCD)ディスプレイユニット、または有機発光ダイオード(OLED)ディスプレイユニット)に結合されることができ、それらからユーザ入力データを受け取ることができる。プロセッサ118はまたユーザデータを、スピーカ/マイクロフォン124、キーパッド126、および/またはディスプレイ/タッチパッド128に出力することができる。さらにプロセッサ118は、非リムーバブルメモリ130および/またはリムーバブルメモリ132などの任意のタイプの適切なメモリからの情報にアクセスし、それにデータを記憶することができる。非リムーバブルメモリ130は、ランダムアクセスメモリ(RAM)、読み出し専用メモリ(ROM)、ハードディスク、または任意の他のタイプのメモリ記憶デバイスを含むことができる。リムーバブルメモリ132は、加入者識別モジュール(SIM)カード、メモリスティック、セキュアデジタル(SD)メモリカードなどを含むことができる。他の実施形態ではプロセッサ118は、サーバまたはホームコンピュータ(図示せず)上など、物理的にWTRU102上に位置しないメモリからの情報にアクセスし、それにデータを記憶することができる。

プロセッサ118は、電源134から電力を受け取ることができ、WTRU102内の他の構成要素に対して電力を分配および/または制御するように構成されることができる。電源134は、WTRU102に電力供給するための任意の適切なデバイスとすることができる。例えば電源134は、1つまたは複数の乾電池(例えばニッケルカドミウム(NiCd)、ニッケル亜鉛(NiZn)、ニッケル水素(NiMH)、リチウムイオン(Liイオン)など)、太陽電池、燃料電池などを含むことができる。

プロセッサ118はまたGPSチップセット136に結合されることができ、これはWTRU102の現在の位置に関する位置情報(例えば経度および緯度)をもたらすように構成されることができる。GPSチップセット136からの情報に加えてまたはその代わりにWTRU102は、エアインターフェース115/116/117を通して基地局(例えば基地局114a、114b)から位置情報を受信することができ、および/または2つ以上の近くの基地局から受信される信号のタイミングに基づいてその位置を決定することができる。WTRU102は、実施形態と一貫性を保ちながら、任意の適切な位置決定方法によって位置情報を取得できることが理解されるであろう。

プロセッサ118はさらに他の周辺装置138に結合されることができ、これはさらなる特徴、機能、および/または有線もしくは無線接続性をもたらす、1つまたは複数のソフトウェアおよび/またはハードウェアモジュールを含むことができる。例えば周辺装置138は、加速度計、電子コンパス、衛星トランシーバ、デジタルカメラ(写真またはビデオ用)、ユニバーサルシリアルバス(USB)ポート、振動デバイス、テレビ送受信機、ハンズフリーヘッドセット、ブルートゥース(登録商標)モジュール、周波数変調(FM)ラジオユニット、デジタル音楽プレーヤ、メディアプレーヤ、ビデオゲームプレーヤモジュール、インターネットブラウザなどを含むことができる。

図18Cは、実施形態によるRAN103およびコアネットワーク106のシステム図である。上記のようにRAN103は、UTRA無線技術を使用して、エアインターフェース115を通してWTRU102a、102b、102cと通信することができる。RAN103はまた、コアネットワーク106と通信することができる。図18Cに示されるようにRAN103は、ノードB140a、140b、140cを含むことができ、これらはそれぞれ、エアインターフェース115を通してWTRU102a、102b、102cと通信するための1つまたは複数のトランシーバを含むことができる。ノードB140a、140b、140cはそれぞれ、RAN103内の特定のセル(図示せず)に関連付けられることができる。RAN103はまた、RNC142a、142bを含むことができる。RAN103は、実施形態と一貫性を保ちながら、任意の数のノードBおよびRNCを含むことができることが理解されるであろう。

図18Cに示されるようにノードB140a、140bは、RNC142aと通信することができる。さらにノードB140cは、RNC142bと通信することができる。ノードB140a、140b、140cは、Iubインターフェースを経由して、それぞれRNC142a、142bと通信することができる。RNC142a、142bは、Iurインターフェースを経由して互いに通信することができる。RNC142a、142bのそれぞれは、それが接続されるそれぞれのノードB140a、140b、140cを制御するように構成されることができる。さらにRNC142a、142bのそれぞれは、外側ループ電力制御、負荷制御、アドミッション制御、パケットスケジューリング、ハンドオーバ制御、マクロダイバーシティ、セキュリティ機能、データ暗号化などの他の機能を、実行またはサポートするように構成されることができる。

図18Cに示されるコアネットワーク106は、メディアゲートウェイ(MGW)144、モバイル交換局(MSC)146、サービングGPRSサポートノード(SGSN)148、および/またはゲートウェイGPRSサポートノード(GGSN)150を含むことができる。上記の要素のそれぞれはコアネットワーク106の一部として示されるが、これらの要素のいずれの1つも、コアネットワークオペレータ以外のエンティティによって所有および/または運用されることができることが理解されるであろう。

RAN103内のRNC142aは、IuCSインターフェースを経由してコアネットワーク106内のMSC146に接続されることができる。MSC146は、MGW144に接続されることができる。MSC146およびMGW144は、WTRU102a、102b、102cと陸線通信デバイスとの間の通信を容易にするために、PSTN108などの回線交換ネットワークへのアクセスをWTRU102a、102b、102cにもたらすことができる。

RAN103内のRNC142aはまた、IuPSインターフェースを経由してコアネットワーク106内のSGSN148に接続されることができる。SGSN148は、GGSN150に接続されることができる。SGSN148およびGGSN150は、WTRU102a、102b、102cとIP対応デバイスとの間の通信を容易にするために、インターネット110などのパケット交換ネットワークへのアクセスをWTRU102a、102b、102cにもたらすことができる。

上記のようにコアネットワーク106はまた、ネットワーク112に接続されることができ、これは他のサービスプロバイダによって所有および/または運用される他の有線もしくは無線ネットワークを含むことができる。

図18Dは、実施形態によるRAN104およびコアネットワーク107のシステム図である。上記のようにRAN104は、E−UTRA無線技術を使用して、エアインターフェース116を通してWTRU102a、102b、102cと通信することができる。RAN104はまた、コアネットワーク107と通信することができる。

RAN104はeノードB160a、160b、160cを含むことができるが、RAN104は、実施形態と一貫性を保ちながら、任意の数のeノードBを含むことができることが理解されるであろう。eノードB160a、160b、160cはそれぞれ、エアインターフェース116を通してWTRU102a、102b、102cと通信するための1つまたは複数のトランシーバを含むことができる。一実施形態ではeノードB160a、160b、160cは、MIMO技術を実施することができる。従ってeノードB160aは、例えば複数のアンテナを用いてWTRU102aに無線信号を送信し、それから無線信号を受信することができる。

eノードB160a、160b、160cのそれぞれは、特定のセル(図示せず)に関連付けられることができ、無線リソース管理決定、ハンドオーバ決定、アップリンクおよび/またはダウンリンクにおけるユーザのスケジューリングなどに対処するように構成されることができる。図18Dに示されるようにeノードB160a、160b、160cは、X2インターフェースを通して互いに通信することができる。

図18Dに示されるコアネットワーク107は、モビリティ管理ゲートウェイ(MME)162、サービングゲートウェイ164、およびパケットデータネットワーク(PDN)ゲートウェイ166を含むことができる。上記の要素のそれぞれはコアネットワーク107の一部として示されるが、これらの要素のいずれの1つも、コアネットワークオペレータ以外のエンティティによって所有および/または運用されることができることが理解されるであろう。

MME162は、S1インターフェースを経由してRAN104内のeノードB160a、160b、160cのそれぞれに接続されることができ、制御ノードとして働くことができる。例えばMME162は、WTRU102a、102b、102cの初期アタッチ時に、WTRU102a、102b、102cのユーザを認証すること、ベアラ活動化/非活動化、特定のサービングゲートウェイを選択することなどに対して責任をもつことができる。MME162はまた、RAN104と、GSMまたはWCDMAなどの他の無線技術を使用する他のRAN(図示せず)との間で切り換えるための、制御プレーン機能をもたらすことができる。

サービングゲートウェイ164は、S1インターフェースを経由してRAN104内のeノードB160a、160b、160cのそれぞれに接続されることができる。サービングゲートウェイ164は一般に、WTRU102a、102b、102cへのまたはそれらからのユーザデータパケットを、経路指定および転送することができる。サービングゲートウェイ164はまた、eノードB間ハンドオーバ時にユーザプレーンをアンカリングすること、WTRU102a、102b、102cのためのダウンリンクデータが使用可能であるときにページングをトリガすること、WTRU102a、102b、102cのコンテキストを管理および記憶することなどの他の機能を行うことができる。

サービングゲートウェイ164はまたPDNゲートウェイ166に接続されることができ、これはWTRU102a、102b、102cとIP対応デバイスとの間の通信を容易にするために、インターネット110などのパケット交換ネットワークへのアクセスをWTRU102a、102b、102cにもたらすことができる。

コアネットワーク107は、他のネットワークとの通信を容易にすることができる。例えばコアネットワーク107は、WTRU102a、102b、102cと陸線通信デバイスとの間の通信を容易にするために、PSTN108などの回線交換ネットワークへのアクセスをWTRU102a、102b、102cにもたらすことができる。例えばコアネットワーク107は、コアネットワーク107とPSTN108との間のインターフェースとして働くIPゲートウェイ(例えばIPマルチメディアサブシステム(IMS)サーバ)を含むことができ、またはそれと通信することができる。さらにコアネットワーク107は、WTRU102a、102b、102cにネットワーク112へのアクセスをもたらすことができ、これは他のサービスプロバイダによって所有および/または運用される他の有線もしくは無線ネットワークを含むことができる。

図18Eは、実施形態によるRAN105およびコアネットワーク109のシステム図である。RAN105は、IEEE 802.16無線技術を使用して、エアインターフェース117を通してWTRU102a、102b、102cと通信する、アクセスサービスネットワーク(ASN)とすることができる。以下でさらに論じられるように、WTRU102a、102b、102c、RAN105、およびコアネットワーク109の異なる機能エンティティの間の通信リンクは、基準点として定義されることができる。

図18Eに示されるようにRAN105は、基地局180a、180b、180c、およびASNゲートウェイ182を含むことができるが、RAN105は実施形態と一貫性を保ちながら、任意の数の基地局およびASNゲートウェイを含むことができることが理解されるであろう。基地局180a、180b、180cはそれぞれRAN105内の特定のセル(図示せず)に関連付けられることができ、それぞれエアインターフェース117を通してWTRU102a、102b、102cと通信するための1つまたは複数のトランシーバを含むことができる。一実施形態では基地局180a、180b、180cは、MIMO技術を実施することができる。従って基地局180aは、例えば複数のアンテナを用いてWTRU102aに無線信号を送信し、それから無線信号を受信することができる。基地局180a、180b、180cはまた、ハンドオフトリガリング、トンネル確立、無線リソース管理、トラフィック分類、サービス品質(QoS)ポリシー実施などの、モビリティ管理機能をもたらすことができる。ASNゲートウェイ182は、トラフィック集約ポイントとして働くことができ、ページング、加入者プロファイルのキャッシング、コアネットワーク109への経路指定などに対して責任をもつことができる。

WTRU102a、102b、102cとRAN105との間のエアインターフェース117は、IEEE 802.16仕様を実施するR1基準点として定義されることができる。さらにWTRU102a、102b、102cのそれぞれは、コアネットワーク109との論理インターフェース(図示せず)を確立することができる。WTRU102a、102b、102cとコアネットワーク109との間の論理インターフェースは、R2基準点として定義されることができ、これは認証、認可、IPホスト構成管理、および/またはモビリティ管理のために用いられることができる。

基地局180a、180b、180cのそれぞれの間の通信リンクは、基地局間のWTRUハンドオーバおよびデータの転送を容易にするためのプロトコルを含むR8基準点として定義されることができる。基地局180a、180b、180cとASNゲートウェイ182との間の通信リンクは、R6基準点として定義されることができる。R6基準点は、WTRU102a、102b、102cのそれぞれに関連付けられたモビリティイベントに基づくモビリティ管理を容易にするためのプロトコルを含むことができる。

図18Eに示されるようにRAN105は、コアネットワーク109に接続されることができる。RAN105とコアネットワーク109との間の通信リンクは、例えばデータ転送およびモビリティ管理能力を容易にするためのプロトコルを含む、R3基準点として定義されることができる。コアネットワーク109は、モバイルIPホームエージェント(MIP−HA)184、認証、認可、アカウンティング(AAA)サーバ186、およびゲートウェイ188を含むことができる。上記の要素のそれぞれはコアネットワーク109の一部として示されるが、これらの要素のいずれの1つも、コアネットワークオペレータ以外のエンティティによって所有および/または運用されることができることが理解されるであろう。

MIP−HAは、IPアドレス管理に対して責任をもつことができ、WTRU102a、102b、102cが、異なるASNおよび/または異なるコアネットワークの間でローミングすることを可能にすることができる。MIP−HA184は、WTRU102a、102b、102cとIP対応デバイスとの間の通信を容易にするために、インターネット110などのパケット交換ネットワークへのアクセスをWTRU102a、102b、102cにもたらすことができる。AAAサーバ186は、ユーザ認証に対して、およびユーザサービスをサポートすることに対して責任をもつことができる。ゲートウェイ188は、他のネットワークとの相互動作を容易にすることができる。例えばゲートウェイ188は、WTRU102a、102b、102cと陸線通信デバイスとの間の通信を容易にするために、PSTN108などの回線交換ネットワークへのアクセスをWTRU102a、102b、102cにもたらすことができる。さらにゲートウェイ188はWTRU102a、102b、102cにネットワーク112へのアクセスをもたらすことができ、これは他のサービスプロバイダによって所有および/または運用される他の有線もしくは無線ネットワークを含むことができる。

図18Eに示されないが、RAN105は他のASNに接続されることができ、コアネットワーク109は他のコアネットワークに接続されることができることが理解されるであろう。RAN105他のASNとの間の通信リンクは、R4基準点として定義されることができ、これはRAN105と他のASNとの間のWTRU102a、102b、102cのモビリティを協調させるためのプロトコルを含むことができる。コアネットワーク109と他のコアネットワークとの間の通信リンクは、R5基準として定義されることができ、これはホームコアネットワークと訪問先のコアネットワークとの間の相互動作を容易にするためのプロトコルを含むことができる。

コンテンツ内の芸術的意図の表現を維持する、芸術的意図をベースとするコンテンツ符号化のためのシステム、方法、および手段が開示された。芸術的意図の表現は識別され(例えばシグナリングまたはコンテンツ分析によって)、芸術的意図位置PARTおよび芸術的意図特性CARTのセットとして表現される。芸術的意図特性CARTは、芸術的意図位置PARTを識別するためにシグナリングされ用いられることができる。芸術的意図維持符号化および処理は、特性CARTを維持するために、サンプル位置PARTに適用されることができる。符号化ユーザインターフェースは、ユーザが芸術性セット(例えばPARTおよび/またはCART)を指定し、忠実度強化、QP調整値および/または後処理などの芸術性セットに関連付けられた、画素および/またはブロックの処置を選択および/または構成することを可能にすることができる。コンテンツ優先度または重要度レベルは、コンテンツ符号化、配信、処理、および/またはエラー回復性/ロバスト性における異なる(例えば強化されたまたは低減された)処置のレベルに対して、コンテンツの微細(例えば画素、サンプル)および/または粗大(例えばブロック)レベルにおいて、暗示的および/または明示的に示されることができる。

本明細書では用語、画素、サンプル、サンプル値および/または同様のものが用いられる場合があるが、このような用語の使用は同義的に用いられることができ、従って区別できないことが理解されることができ、理解されるべきである。

同様に本明細書では用語、特性、特性セット、芸術的意図の特性、および/または同様のものが用いられる場合があるが、このような用語の使用は同義的に用いられることができ、従って区別できないことが理解されることができ、理解されるべきである。

特徴および要素は上記では特定の組み合わせにおいて述べられたが、当業者は、各特徴または要素は単独で、または他の特徴および要素との任意の組み合わせにおいて用いられることができることを理解するであろう。さらに本明細書で述べられる方法は、コンピュータまたはプロセッサによる実行のためにコンピュータ可読媒体に組み込まれた、コンピュータプログラム、ソフトウェア、またはファームウェアにおいて実施されることができる。コンピュータ可読媒体の例は、電子信号(有線または無線接続を通して送信される)、およびコンピュータ可読記憶媒体を含む。コンピュータ可読記憶媒体の例は、読み出し専用メモリ(ROM)、ランダムアクセスメモリ(RAM)、レジスタ、キャッシュメモリ、半導体メモリデバイス、内蔵ハードディスクおよびリムーバブルディスクなどの磁気媒体、光磁気媒体、ならびにCD−ROMディスクおよびデジタル多用途ディスク(DVD)などの光媒体を含むが、それらに限定されない。WTRU、UE、端末装置、基地局、RNC、または任意のホストコンピュータにおける使用のための無線周波数トランシーバを実施するように、ソフトウェアに関連してプロセッサが用いられることができる。