-

TECHNISCHES GEBIET

-

Die Technologie bezieht sich auf das Gebiet der Navigation auf Bildbasis.

-

HINTERGRUND

-

In Gebieten ohne klare Sicht des Himmels, z. B. in Tunnels oder Wäldern, stehen GPS-Vorrichtungen aufgrund des fehlenden Empfangs von den GPS-Satelliten der anspruchsvollen Aufgabe gegenüber, eine genaue Lokalisierung aufrechtzuerhalten. Wir stellen eine Anwendung vor, die wir ”Bodenverfolgung” nennen und die den 3D-Ort einer Bildaufnahmevorrichtung wiedergewinnen kann. Diese Bildaufnahmevorrichtung, die in einer beliebigen Orientierung liegen kann, nimmt Bilder auf und verwendet eine Kombination von Statistik und Bildverarbeitungsalgorithmen, um ihre 3D-Bahn abzuschätzen.

-

ZUSAMMENFASSUNG

-

Diese Zusammenfassung wird bereitgestellt, um eine Auswahl von Konzepten einzuführen, die nachstehend in der ausführlichen Beschreibung weiter beschrieben werden. Diese Zusammenfassung soll keine Schlüssel- oder wesentlichen Merkmale des beanspruchten Gegenstandes identifizieren und soll auch nicht als Hilfe beim Bestimmen des Schutzbereichs des beanspruchten Gegenstandes verwendet werden.

-

Ein Verfahren zur Bildverfolgung wird bereitgestellt. Das Verfahren umfasst: (A) Durchführen einer Bildaufnahme einer Szene unter Verwendung einer Bildaufnahmevorrichtung; und (B) Verfolgen der Bewegung der Bildaufnahmevorrichtung durch Analysieren eines Satzes von Bildern.

-

BESCHREIBUNG DER ZEICHNUNGEN

-

Die zugehörigen Zeichnungen, die in diese Patentbeschreibung integriert sind und einen Teil von dieser bilden, veranschaulichen Ausführungsbeispiele der Technologie und dienen zusammen mit der Beschreibung zum Erläutern der nachstehenden Prinzipien:

-

1 stellt eine Vorrichtung zur Bildverfolgung gemäß einem Ausführungsbeispiel der vorliegenden Technologie dar.

-

2 ist ein Ablaufplan eines Verfahrens zur Bildverfolgung gemäß einem Ausführungsbeispiel der vorliegenden Technologie, wobei die Tiefendaten der Szene durch Vorvermessen der Szene erhalten werden.

-

3 stellt einen Ablaufplan eines Verfahrens zur Bildverfolgung gemäß einem Ausführungsbeispiel der vorliegenden Technologie dar, wobei die Tiefendaten der Szene unter Verwendung einer Entfernungsmessvorrichtung erhalten werden.

-

4 ist ein Diagramm, das die Aufnahme eines Bildes einer Szene durch die Bildaufnahmevorrichtung darstellt.

-

5 stellt ein Diagramm dar, das die 2D-Bewegung der Bildaufnahmevorrichtung darstellt, die unter Verwendung des Bildverarbeitungsalgorithmus gemäß einem Ausführungsbeispiel der vorliegenden Technologie berechnet wird.

-

6 ist ein Diagramm, das die Bildaufnahmevorrichtungs-Höhenbewegung darstellt, die unter Verwendung des Bildverarbeitungsalgorithmus gemäß einem Ausführungsbeispiel der vorliegenden Technologie berechnet wird.

-

7 stellt ein Diagramm dar, das die Bildaufnahmevorrichtungs-Gesamtdrehwinkel (Gieren, Nicken und Rollen) darstellt, die unter Verwendung des Bildverarbeitungsalgorithmus gemäß einem Ausführungsbeispiel der vorliegenden Technologie berechnet werden.

-

AUSFÜHRLICHE BESCHREIBUNG

-

Nun wird im Einzelnen auf die Ausführungsbeispiele der Technologie Bezug genommen, von der Beispiele in den zugehörigen Zeichnungen dargestellt sind. Obwohl die vorliegende Technologie in Verbindung mit den verschiedenen Ausführungsbeispielen beschrieben wird, sollen sie selbstverständlich die vorliegende Technologie nicht auf diese Ausführungsbeispiele begrenzen. Im Gegenteil soll die vorliegende Technologie Alternativen, Modifikationen und Äquivalente abdecken, die innerhalb des Gedankens und Schutzbereichs der verschiedenen Ausführungsbeispiele enthalten sein können, wie durch die beigefügten Ansprüche definiert.

-

Ferner werden in der folgenden ausführlichen Beschreibung zahlreiche spezifische Details dargelegt, um für ein gründliches Verständnis der vorliegenden Ausführungsbeispiele zu sorgen. Für einen Fachmann auf dem Gebiet ist es jedoch offensichtlich, dass die dargestellten Ausführungsbeispiele ohne diese spezifischen Details ausgeführt werden können. In anderen Fällen wurden gut bekannte Verfahren, Prozeduren, Komponenten und Schaltungen nicht im Einzelnen beschrieben, um die Aspekte der dargestellten Ausführungsbeispiele nicht unnötig unklar zu machen.

-

1 ist ein Blockdiagramm 10, das eine Vorrichtung zur Bildverfolgung 22 gemäß einem Ausführungsbeispiel der vorliegenden Technologie darstellt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Bildverfolgungsvorrichtung 22 ferner: eine Bildaufnahmevorrichtung 12, die dazu konfiguriert ist, eine Bildaufnahme einer Szene 20 in einem Softwaremodus (SW) durchzuführen, die ferner einen Speicher 24, in den ein Bildverarbeitungsalgorithmus 25 geladen ist, und einen Universalprozessor (oder einen Digitalsignalprozessor oder eine Graphikverarbeitungseinheit usw.) 26, der dazu konfiguriert ist, den Satz von Bildern zu analysieren, indem der Bildverarbeitungsalgorithmus 25 aktiviert wird, umfasst.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Bildverfolgungsvorrichtung 22 ferner: eine Bildaufnahmevorrichtung 12, die dazu konfiguriert ist, eine Bildaufnahme einer Szene 20 in einem Hardwaremodus (HW) durchzuführen, die ferner einen ASIC-Chip (oder FPGA-Chip) 27 (in analogen oder digitalen Modi) umfasst, der dazu konfiguriert ist, den Satz von Bildern durch Implementieren des Bildverarbeitungsalgorithmus 25 in der Hardware zu analysieren.

-

Die Bildaufnahmevorrichtung 12 ist aus der Gruppe ausgewählt, die aus Folgendem besteht: {einer Digitalkamera; einer digitalen Videokamera; einem digitalen Camcorder; einer Stereodigitalkamera; einer Stereovideokamera; einer Filmkamera; einer Fernsehkamera; und einer Tiefenkamera}.

-

In einem Ausführungsbeispiel der vorliegenden Technologie ist die Bildaufnahmevorrichtung 12 ein lichtdichter Kasten, in dem ein Bild einer Szene 20 durch eine Lochblende oder Linsen 16 auf einer Sensorplatte 32 erzeugt wird. Standbildvideo- und Digitalkameras speichern die Bilder in einem Halbleiterspeicher 28 oder auf magnetischen Medien oder optischen Platten 28.

-

Bewegtbild- oder Filmkameras zeichnen die Bewegung in regelmäßigen Intervallen in einer Reihe von Einzelbildern auf. Fernseh- und Videokameras zeichnen eine Bewegung elektronisch für die Sendung und Speicherung auf magnetischen Medien oder optischen Platten auf. Camcorder sind Videokameras, die sowohl den Bildsensor als auch Aufzeichnungsmedien in einer einzelnen Einheit enthalten.

-

Abgesehen von Lochkameras, die das Bild auf den Film durch ein winziges Loch fokussieren, verwenden alle anderen Kameras Linsen 16 für die Fokussierung. Die Brennweite von Linsen, d. h. der Abstand zwischen den Rückseiten der Linsen (wenn sie auf unendlich fokussiert sind) und der Abbildungsvorrichtung bestimmt den Blickwinkel oder das Sichtfeld (FOV) 18 und die Größe von Objekten, wie sie auf der Abbildungsoberflächensensorplatte 32 erscheinen. Das Bild wird durch Einstellen des Abstandes zwischen den Linsen und der Oberfläche auf diese Oberfläche fokussiert.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Linse 16 ferner eine reguläre geradlinige Linse. Eine geradlinige Linse ist eine Linse, in der gerade Linien im Wesentlichen nicht gekrümmt oder verzerrt werden.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Linse 16 ferner eine Fischaugenlinse. Eine Fischaugenlinse ist eine Weitwinkellinse, die ein äußerst breites, halbkugelförmiges Bild aufnimmt. Fischaugenlinsen werden häufig verwendet, um weite Landschaften aufzunehmen. Fischaugenlinsen erreichen äußerst weite Blickwinkel durch Verzichten auf ein geradliniges Bild, wobei sie sich stattdessen für eine spezielle Abbildung (beispielsweise: raumwinkelgleich) entscheiden, die den Bildern ein charakteristisches konvexes Aussehen verleiht.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Linse 16 ferner maßgefertigt kalibrierte Linsen.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Bildaufnahmevorrichtung 12 ferner eine Anzeige 34, die ferner eine optische Anzeige, eine Flüssigkristallanzeige (LCD) oder einen Bildschirm umfasst.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Bildaufnahmevorrichtung 12 ferner eine Stereodigitalkamera. Eine Stereokamera ist ein Typ von Kamera mit zwei oder mehr Linsen. Dies ermöglicht, dass die Kamera zweiäugiges Sehen simuliert, und verleiht ihr daher die Fähigkeit, dreidimensionale Bilder aufzunehmen, ein Prozess, der als Stereophotographie bekannt ist. Stereokameras können zur Herstellung von Stereoansichten und 3D-Bildern für Filme, oder für die Entfernungsabbildung verwendet werden. 3-D Images Ltd. mit Sitz in GB stellt eine 3-D-Digitalstereokamera – eine vollautomatische, zeitsynchronisierte, digitale Stereokamera her. Point Grey Research Inc. mit Sitz in Kanada stellt Doppelfernrohre oder Mehrfachmatrixkameras her, die Vollblickfeld-3D-Messungen in einer unstrukturierten Umgebung bereitstellen können.

-

Das Grundelement eines Bildes eines Objekts ist das Pixel, das einen einzelnen Punkt mit einer Farbe oder einer Graustufe beschreibt.

-

Jedes Pixel enthält eine Reihe von Zahlen, die seine Farbe oder Intensität beschreiben. Die Genauigkeit, mit der ein Pixel eine Farbe angeben kann, wird seine Bit- oder Farbtiefe genannt. Je mehr Pixel ein Bild enthält, desto mehr Detail kann es beschreiben.

-

Da ein Pixel nur eine logische Informationseinheit ist, ist es nutzlos zum Beschreiben von Abmessungen der realen Welt, wenn man nicht auch ihre Größe angibt. Der Begriff Pixel pro Inch (PPI) wurde eingeführt, um diese theoretische Pixeleinheit mit der visuellen Auflösung der realen Welt in Beziehung zu bringen.

-

”Pixel pro Inch” (PPI) ist ein sehr einfacher Begriff. Er beschreibt nur: wie viele Pixel ein Bild pro Inch Abstand in der horizontalen und der vertikalen Richtung enthält.

-

Ein ”Megapixel” ist einfach eine Einheit einer Million Pixel. Eine Digitalkamera kann eine Sensormatrix von Megapixeln (Millionen von winzigen Pixeln) verwenden, um ein Bild zu erzeugen. Wenn die Blendentaste der Kamera gedrückt wird und die Belichtung beginnt, weist jedes dieser Pixel eine ”Photostelle” auf, die Photonen speichert. Sobald die Belichtung endet, versucht die Kamera abzuschätzen, wie viele Photonen in jede gefallen sind. Die relative Menge der Photonen in jedem Hohlraum wird dann in verschiedene Intensitätspegel sortiert, deren Genauigkeit durch die Bittiefe (0–255 für ein 8-Bit-Bild) bestimmt ist.

-

Jeder Hohlraum ist außerstande zu unterscheiden, wie viel jeder Farbe in diesen gefallen ist, so dass die obige Beschreibung nur Graustufenbilder erzeugen könnte. Ein Verfahren, das verwendet wird, um digitale Sensoren auf die Erfassung von Farbinformationen zu erweitern, besteht darin, Licht, das in jeden Hohlraum eintritt, zu filtern, was ermöglicht, dass der Sensor zwischen rotem (R), grünem (G) und blauem (B) Licht unterscheidet.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird der Abstand von einem Objektpunkt 30 in der Tiefe der Szene 20 zur Verfolgungsvorrichtung 22 auf Bildbasis unter Verwendung einer Entfernungsmessvorrichtung 14 bestimmt, die aus der Gruppe ausgewählt ist, die aus Folgendem besteht: {einem Punktlaserstrahl; einem Sonar; einem Radar; einem Laserabtaster; und einer Tiefenkamera}.

-

Eine Punktlaserstrahl-Entfernungsmessvorrichtung 14 kann unter Verwendung von blauen Festkörperlasern, roten Diodenlasern, IR-Lasern, die kontinuierlich beleuchtete Laser sein können, oder gepulsten Lasern oder sequenzierten Lasern implementiert werden.

-

Eine Laserabtaster-Entfernungsmessvorrichtung 14 kann unter Verwendung von Positionsbestimmungssensoren implementiert werden, die von der Sensor Intelligence Website www.sick.com angeboten werden. Der Laserabtaster Modellname S10B-9011DA mit einem kompakten Gehäuse und einer robusten IP 65 Konstruktion kann beispielsweise verwendet werden. Dieser Laserabtaster hat das folgende Datenblatt:

Abmessungen: (B × H × T) = 102 × 152 × 105 mm, Abtastwinkel von 270° und Schaltfeldbereich von 10 Metern. Er weist die folgende Funktionalität auf: einen Bereitschaftsmodus, eine 7-Segment-Eingangsanzeige, einen integrierten Parameterspeicher im System, eine CANopen-Steckerschnittstelle und einen niedrigen Energieverbrauch.

-

Eine Sonar-Entfernungsmessvorrichtung 14 kann unter Verwendung eines aktiven Sonars mit einem Schallsender- und -empfänger implementiert werden.

-

Aktives Sonar erzeugt einen Schallimpuls, der häufig ”Ping” genannt wird, und horcht dann auf Reflexionen (Echo) des Impulses. Dieser Schallimpuls wird im Allgemeinen elektronisch unter Verwendung eines Sonarprojektors erzeugt, der aus einem Signalgenerator, einem Leistungsverstärker und einem elektroakustischen Wandler/einer elektroakustischen Matrix möglicherweise mit einem Strahlformer besteht. Um den Abstand zur Szene 20 zu messen, wird die Zeit von der Sendung eines Impulses bis zum Empfang gemessen und durch die bekannte Schallgeschwindigkeit in eine Entfernung umgewandelt. Der Impuls kann auf konstanter Frequenz liegen oder ein Chirp mit sich ändernder Frequenz (um eine Impulskompression beim Empfang zu ermöglichen) sein. Die Impulskompression kann unter Verwendung von digitalen Korrelationsverfahren erreicht werden.

-

Eine Radar-Entfernungsmessvorrichtung 14 kann unter Verwendung eines Senders, der entweder Mikrowellen oder Funkwellen emittiert, die durch die Szene 20 reflektiert werden und durch einen Empfänger, typischerweise am gleichen Ort wie der Sender, detektiert werden, implementiert werden.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Bildaufnahmevorrichtung 12 ferner eine Tiefenkamera, die die Aufnahme von Bildern eines Objekts mit der Messung eines Abstandes zum Objekt kombiniert.

-

Eine Tiefenkamera kann unter Verwendung einer ZCam-Videokamera implementiert werden, die Video mit Tiefeninformationen aufnehmen kann. Diese Kamera weist Sensoren auf, die die Tiefe für jedes der erfassten Pixel unter Verwendung eines Prinzips messen kann, das Laufzeit genannt wird. Sie erhält 3D-Informationen durch Emittieren von Impulsen von Infrarotlicht zu allen Objekten in der Szene und Abtasten des reflektierten Lichts von der Oberfläche jedes Objekts. Die Tiefe wird durch Berechnen der Laufzeit eines Lichtstrahls, wenn er die Quelle verlässt und durch die Objekte in der Szene 20 reflektiert wird, gemessen. Die Umlaufzeit wird unabhängig für jedes Pixel unter Verwendung eines CMOS-Zeit-Digital-Umsetzers in einen digitalen Code umgewandelt. Gemäß 3DV-Systemen des Herstellers ist die Tiefenauflösung ziemlich gut: sie kann eine 3D-Bewegung und ein Volumen bis zu 0,4 Inch erfassen, wobei gleichzeitig Vollfarbenvideo mit 1,3 Megapixel mit 60 Einzelbildern pro Sekunde aufgenommen wird.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst die Bildaufnahmevorrichtung 12 immer noch mit Bezug auf 1 ferner ein Vermessungsinstrument 36, das aus der Gruppe ausgewählt ist, die aus Folgendem besteht: {einem Vermessungssystem eines globalen Navigationssatellitensystems (GNSS); einem Laserebenensystem; und einem Theodoliten}. In diesem Ausführungsbeispiel wird die Szene 20 vorvermessen und die Szenenabstandsdaten werden von der Verfolgungsvorrichtung 22 auf Bildbasis in Kombination mit dem Satz von Bildern verwendet, um die Positionskoordinaten der Verfolgungsvorrichtung 22 auf Bildbasis zu bestimmen.

-

Ein Vermessungssystem 36 eines globalen Navigationssatellitensystems (GNSS) kann unter Verwendung eines TRIMBLE R8 GNSS-Systems implementiert werden, das alle GPS- und GLONASS L1/L2-Signale unterstützt, einschließlich der neuen L2C- und kommenden L5-Signale von GPS, und die Kapazität hat, bis zu 44 Satelliten zu verfolgen.

-

Ein Vermessungssystem 36 eines globalen Navigationssatellitensystems (GNSS) kann auch unter Verwendung des Trimble® R7 GNSS-Systems mit einem GPS-Empfänger mit hoher Genauigkeit und UHF-Funk, die in einer Einheit kombiniert sind, implementiert werden. Trimble R7 GNSS kann für RTK- oder statische Vermessung verwendet werden. Das modulare Trimble R7 GNSS-System verwendet eine separate Antenne: die Trimble ZephyrTM 2, wenn es als Rover verwendet wird, und die Zephyr GeodeticTM 2, wenn es als Basisstation verwendet wird. Die Trimble GeoExplorer-Software kann für verschiedene Führerszenarios verwendet werden. Der Trimble GeoExplorer hat das folgende Datenblatt: 1 bis 3 Meter GPS mit integriertem SBAS; eine VGA-Anzeige mit hoher Auflösung für klare und deutliche Kartenbetrachtung; Bluetooth- und drahtlose LAN-Konnektivitätsoptionen; einen Bordspeicher mit 1 GB plus SD-Schlitz für entnehmbare Karten. Er umfasst das Betriebssystem Windows Mobile Version 6. Er wird auch als robustes Handgerät mit ganztägiger Batterie implementiert.

-

Ein Laserebenen-Vermessungssystem 36 kann auch unter Verwendung eines Trimble-Produkts Spectra Precision Laser GL 412 und GL 422 implementiert werden. Die Spectra Precision® Laser GL 412 und GL 422 Neigungslaser sind kosteneffiziente, automatische selbstnivellierende Laser, die drei Aufgaben durchführen – Nivellierung, Neigung und vertikale Ausrichtung auf Lot. Beide Laser zeichnen sich durch eine 2-Weg-Fernbedienung mit voller Funktion aus, so dass man Neigungsänderungen von irgendwo am Einsatzort für eine verringerte Einrichtungszeit und einen schnelleren Betrieb durchführen kann. Der GL 412 (Einzelneigung) und GL 422 (Doppelneigung) Laser senden eine kontinuierliche, selbstnivellierte Laserreferenz mit 360 Grad über einen ganzen Arbeitsbereich und weisen einen weiten Neigungsbereich auf, so dass sie in einer Vielfalt von Neigungsanwendungen verwendet werden können.

-

Ein Laserebenen-Vermessungssystem 36 kann auch unter Verwendung des Apache Horizon Lasers implementiert werden, der einen kontinuierlichen selbstnivellierten Laserstrahl emittiert, der gedreht wird, um eine Laserlichtebene zu erzeugen. Diese Ebene erstreckt sich über einen Arbeitsbereich mit einem Durchmesser von bis zu 1600 Fuß (500 Meter). Die Referenzebene wird durch einen oder mehrere Laserdetektoren abgetastet, die die Richtung zu bodengleich angeben.

-

Ein Theodolit-Vermessungssystem 36 kann auch unter Verwendung einer Trimble® S6 DR (Direktreflexion) Total Station implementiert werden, die ein kabelfreies Robotertachymeter und ein Rover ist. Man kann aus aktiver oder passiver Verfolgung mit dem Trimble MultiTrack Target auswählen. Die aktive Verfolgung ermöglicht einem, das korrekte Ziel zu orten und auf dieses zu verriegeln.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird das Verfahren zur Bildverfolgung unter Verwendung der Verfolgungsvorrichtung 22 auf Bildbasis von 1 implementiert. Insbesondere wird der Schritt (A) unter Verwendung der Bildaufnahmevorrichtung 12 durchgeführt, um eine Bildaufnahme einer Szene 20 durchzuführen, wohingegen der Schritt (B) der Verfolgung der Bewegung der Bildaufnahmevorrichtung 12 durch Analysieren eines Satzes von Bildern unter Verwendung eines Bildverarbeitungsalgorithmus 25 durchgeführt wird.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird der Schritt (A) der Durchführung der Bildaufnahme der Szene 20 in Echtzeit unter Verwendung der Bildaufnahmevorrichtung 12 durchgeführt.

-

In einem anderen Ausführungsbeispiel der vorliegenden Technologie wird der Schritt (A) der Durchführung der Bildaufnahme der Szene 20 unter Verwendung der Bildaufnahmevorrichtung 12 voraufgezeichnet.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst der Schritt (A) der Durchführung der Bildaufnahme der Szene 20 ferner den Schritt (A3) zum Erhalten eines Satzes von Tiefendaten der Szene 20 durch Vorvermessung der Szene 20 unter Verwendung des Vermessungsinstruments 36, wie es vorstehend vollständig offenbart wurde.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird der Schritt (B) der Verfolgung der Bewegung der Bildaufnahmevorrichtung 12 unter Verwendung des Bildverarbeitungsalgorithmus 25 durchgeführt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie ermöglicht der Bildverarbeitungsalgorithmus 25 die Implementierung der Videoverfolgung der Bildaufnahmevorrichtung 12 durch Analysieren des Satzes von Bildern, die sie aufnimmt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie nimmt der Bildverarbeitungsalgorithmus 25 eine globale starre Bewegung an. Durch Parametrisierung des globalen optischen Ablaufs mit den sechs Freiheitsgraden der Bildaufnahmevorrichtung 12 kann eine optimale globale Transformation zwischen zwei aufeinander folgenden Einzelbildern durch Lösen eines nicht-linearen Problems kleinster Quadrate gefunden werden.

-

Um eine starre globale Transformation mit sechs Freiheitsgraden durchzuführen, muss man die Tiefe der Szene 20 kennen. Wie vorstehend vollständig offenbart wurde, wird entweder die Szene 20 vorvermessen oder die Tiefenmessungen werden in Echtzeit zusammen mit der Bildaufnahme von externen Vorrichtungen wie z. B. Punktlaserstrahlen, Tiefenbildaufnahmevorrichtungen, einer Stereokameraausrüstung usw. erhalten.

-

In einem Ausführungsbeispiel der vorliegenden Technologie vergleicht der Bildverarbeitungsalgorithmus 25 die optischen Eigenschaften der Pixel unter Verwendung einer Einzelbildfunktion.

-

In einem Ausführungsbeispiel der vorliegenden Technologie, in dem die Tiefeninformationen zur Verfügung stehen, vergleicht der Bildverarbeitungsalgorithmus 25 die Tiefe der zwei Einzelbilder (anstelle der optischen Eigenschaften der Pixel) durch Neudefinition der Einzelbildfunktion.

-

In einem Ausführungsbeispiel der vorliegenden Technologie kann der Bildverarbeitungsalgorithmus 25 durch Vergleichen einer Kombination von optischen Eigenschaften von Pixeln und Tiefeninformationen verbessert werden. Dies kann entweder unter Verwendung einer kombinierten Kostenfunktion oder Unterstützen eines Prozesses mit dem anderen durchgeführt werden, wie nachstehend vollständig offenbart.

-

In einem Ausführungsbeispiel der vorliegenden Technologie verwendet ein Bildverarbeitungsalgorithmus 25 mehrere Koordinatensysteme: ein stationäres Referenzsystem; ein Referenzsystem, das an die Bildaufnahmevorrichtung 12 gebunden ist; und ein 2D-Referenzsystem in der Sensorebene 32 der Bildaufnahmevorrichtung.

-

Im stationären Referenzsystem weist ein Punkt 30 in der Szene 20 die Koordinaten x = (x, y, z) auf, die Bildaufnahmevorrichtung 12 wird durch den 6-Vektor 38 mit den Positionskoordinaten xci = (xci, yci, zci) der Vorrichtung und den Orientierungskoordinaten (ψi, θi, φi) der Vorrichtung (Gieren, Nicken und Rollen) für jedes i-te Einzelbild beschrieben.

-

In dem an die Bildaufnahmevorrichtung 12 gebundenen Referenzsystem weist derselbe Punkt 30 in der Szene 20 die Koordinaten xi = (xi, yi, zi) in Bezug auf die Bildaufnahmevorrichtung 12 auf.

-

Im 2D-Referenzsystem, das an die Sensorebene 32 der Bildaufnahmevorrichtung gebunden ist, sind die 2D-Pixelkoordinaten eines Punkts im i-ten Einzelbild: ui = (ui, vi)

-

Die Beziehung zwischen dem stationären 3D-System und dem an die Bildaufnahmevorrichtung gebundenen 3D-System ist wie folgt:

xi = (x – xci)Ri, (Gl.1) wobei

die Rotationsmatrix zwischen zwei Systemen ist.

-

Die Beziehung zwischen den an die Bildaufnahmevorrichtung gebundenen 3D-Koordinaten und den 2D-Pixelkoordinaten hängt von der Abbildungsfunktion m der Bildaufnahmevorrichtung 12 ab. Die Abbildungsfunktion nimmt 3D-Koordinaten xi in dem an die Bildaufnahmevorrichtung gebundenen System des i-ten Einzelbildes und bildet sie in 2D-Pixelkoordinaten im i-ten Einzelbild ab: ui = m(xi). (Gl.3)

-

Die Form der Abbildungsfunktion hängt vom Typ der Linsen ab. In einem Ausführungsbeispiel der vorliegenden Technologie, in dem die Linsen

16 reguläre geradlinige Linsen (in einem umgekehrten Lochblendenmodell) umfassen, kann die Abbildungsfunktion m von den folgenden Gleichungen abgeleitet werden:

wobei f die Brennweite der Bildaufnahmevorrichtung

12 ist, S

u, S

v die Pixelbreite und -höhe sind, u

0, v

0 die Versätze zwischen dem optischen Zentrum und dem Sensorzentrum sind.

-

In einem weiteren Ausführungsbeispiel der vorliegenden Technologie, in dem die Linsen

16 orthographische Fischaugenlinsen umfassen, kann die Abbildungsfunktion m von den folgenden Gleichungen abgeleitet werden:

wobei r der Abstand zwischen dem Punkt und dem optischen Zentrum ist.

-

-

In einem Ausführungsbeispiel der vorliegenden Technologie kann die Abbildungsfunktion m in einer numerischen Form kalibriert und gespeichert werden.

-

Um die Umkehrfunktion der Abbildungsfunktion herauszufinden: xi = m–1(Ui), (Gl. 6) muss man die Tiefe des Objektpunkts 30 kennen.

-

In einem Ausführungsbeispiel der vorliegenden Technologie, wie vorstehend offenbart wurde, wird die Szene 20 vorvermessen. In diesem Ausführungsbeispiel der vorliegenden Technologie werden die Tiefenmessungen im stationären 3D-Referenzsystem z = z(x, y) durchgeführt und ändern sich nicht von Einzelbild zu Einzelbild.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird, wenn eine Entfernungsmessvorrichtung 14 an der Bildaufnahmevorrichtung 12 angebracht ist, die Tiefe eines Szenenobjektpunkts 30 als Funktion des Pixelorts in jedem Einzelbild erhalten zi = zi(ui). Diese Messungen werden in dem an die Bildaufnahmevorrichtung gebundenen 3D-Referenzsystem durchgeführt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird die Entfernungsmessvorrichtung 14 unter Verwendung einer Anzahl von Punktlasern implementiert. In diesem Ausführungsbeispiel der vorliegenden Technologie ist, da die Anzahl von Punktlasern gewöhnlich weitaus geringer als die Anzahl von Pixeln ist, die Dichte der Tiefenmessungen für jedes i-te Einzelbild wahrscheinlich viel geringer als die Pixeldichte. Die Tiefe für jedes Pixel kann durch Interpolation zwischen diesen Messungen erhalten werden.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird die Entfernungsmessvorrichtung 14 unter Verwendung einer Tiefenkamera wie z. B. der Zcam von 3DVsystems implementiert. In diesem Ausführungsbeispiel der vorliegenden Technologie steht ein Raster von Tiefenmessungen mit zu jener des Videoeinzelbildes vergleichbarer Auflösung zur Verfügung, so dass dieses Raster von Tiefenmessungen direkt ohne weitere Behandlung verwendet werden kann.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird die Entfernungsmessvorrichtung 14 unter Verwendung einer Stereokamera implementiert. Eine Stereokamera ermöglicht die Gewinnung von Tiefeninformationen aus einer Anzahl von identifizierten Merkmalspunkten und der Rest der Pixel kann durch Interpolation erledigt werden.

-

Die Beziehung zwischen zwei aufeinander folgenden Einzelbildern fi und fj wird auf der Annahme aufgebaut, dass derselbe Punkt 30 in der Szene 20 zwei Pixel mit derselben Intensität in zwei Einzelbildern erzeugt. Das heißt, wenn ui und uj Pixelorte in fi und fj desselben Objektpunkts sind, dann gilt fi(ui) = fj(uj). Hier bezieht sich fi(ui) auf die Pixelintensität bei ui im Einzelbild fi. Unter dieser Annahme ist die Beziehung zwischen zwei Einzelbildern eine rein geometrische Transformation, die sich aus der Bewegung der Bildaufnahmevorrichtung ergibt.

-

Die Bewegung der Bildaufnahmevorrichtung von fi zu fj kann durch δxci–>j und δRi–>j dargestellt werden, was die relative Verschiebung und Drehung zwischen Einzelbildern ist, oder ξi–>j = (δxci–>j, δyci–>j, δzci–>j, δΨi–>j, δθi–>j, δφi–>j), was ein 6-Vektor mit den sechs Freiheitsgraden ist. Wenn die Position und Lage der Bildaufnahmevorrichtung im Einzelbild fi bekannt sind, dann gibt uns die Lösung dieser relativen Bewegung von fi zu fj. die Position und Lage im Einzelbild fj. Im Folgenden lassen wir den tiefgestellten Index i –> j weg, wann immer es möglich ist.

-

Derselbe Objektpunkt 30, der im Referenzsystem des Einzelbildes fi die Koordinate xi aufweist, hat im Referenzsystem des Einzelbildes fj die Koordinate xj und: xj = (xi – δxc)δR. (Gl. 7)

-

Daher ist in den 2D-Pixelkoordinatensystemen die Beziehung zwischen u

i und u

j wie folgt:

wobei m die Abbildungsfunktion ist. Oder einfach

uj = δP(ui), (Gl. 9) wobei

die Kombination von drei Operationen darstellt.

-

Die Aufgabe besteht nun darin, das optimale ξ zu ermitteln, so dass die Kostenfunktion ∫|fi(u) – fj(δP(u))|du Gl. 10 minimiert wird. Dies ist ein gut erforschtes nicht-lineares Problem kleinster Quadrate. Dessen Lösung beinhaltet gewöhnlich eine lineare Näherung und Iteration. Verschiedene lineare Näherungen führen zu verschiedenen Konvergenzverfahren, wie z. B. Gauss-Newton, steilster Abfall, Levenberg-Marquardt-Abfall usw.

-

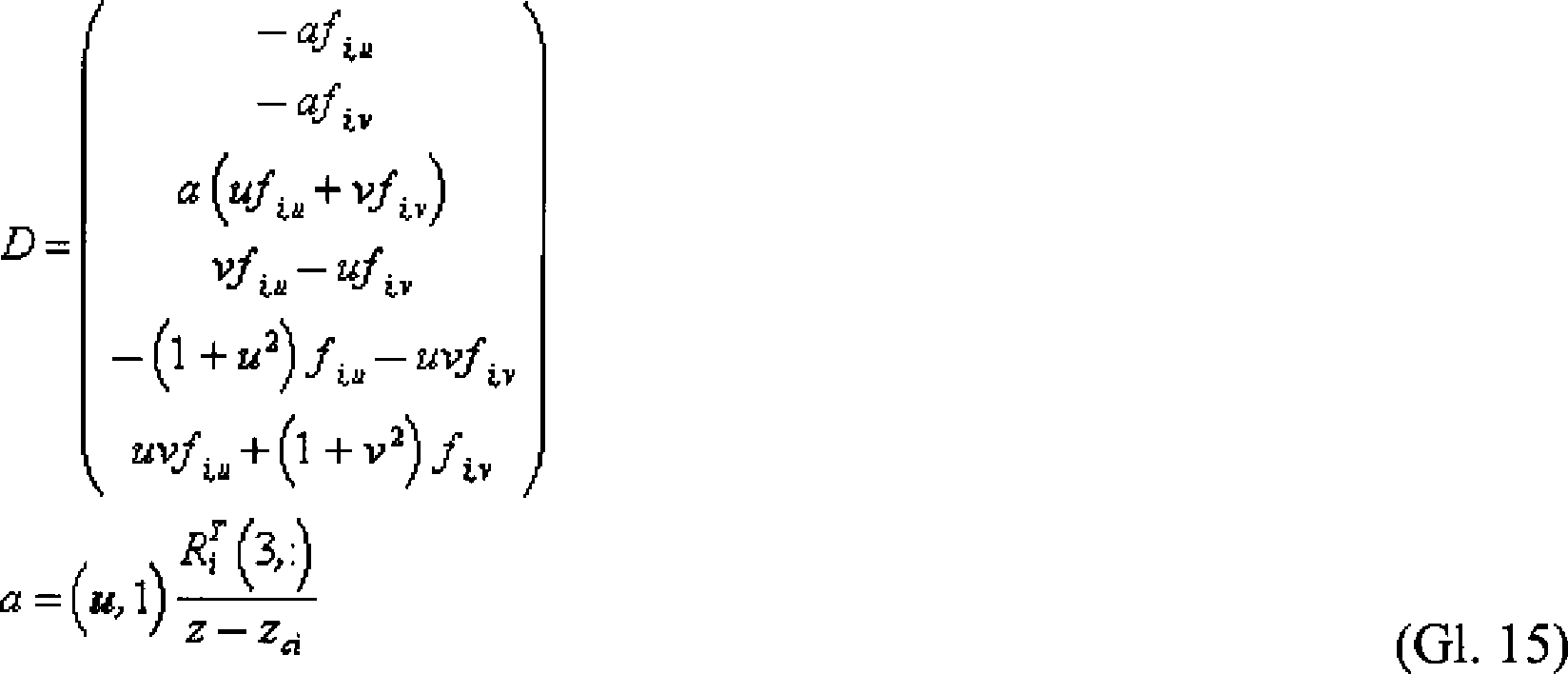

In einem Ausführungsbeispiel der vorliegenden Technologie wird der Bildverarbeitungsalgorithmus 25 unter Verwendung des Gauss-Newton-Ansatzes implementiert. Um den Gauss-Newton-Ansatz zu erhalten, kann man erweitern fj(δP(u))≈ fj(u) + dξ∇fj ∂δP(u) / ∂ξ (Gl. 11)

-

∇fj ist das Gradientenbild des Einzelbildes fj, ∂δP(u) / ∂ξ ist die Jacobi-Determinante der geometrischen Transformation.

-

Man schreibt D = ∇fj ∂δP(u) / ∂ξ (Gl. 12) als 6×1-Spaltenvektor, dann hat man dξ ≈ ∫(fi(u) – fj(u))DTdu/∫DDTdu (Gl. 13)

-

Da fj keine lineare Funktion von ξ ist, wird (Gl. 13) unter Verwendung der folgenden Iterationsschleifenroutine gelöst:

- 1. Initialisieren von ξ;

- 2. Berechnen von δP aus ξ, Durchführen der Transformation an fj: fj(u) ⇒ f .j(u) = fj(δP(u));

- 3. Berechnen von dξ aus fi, f .j, dξ = ∫(fi(u) – f .j(u))DTdu/∫DDTdu

- 4. Aktualisieren von ξ, dξ ⇒ ξ;

- 5. Wenn dξ klein genug ist oder eine maximale Iteration erreicht ist, dann Ausstieg, ansonsten Schleifenrücklauf zu Schritt 2.

-

In der obigen Routine gelangt mit jeder aufeinander folgenden Iteration fj näher an fi, bis sie nahe genug sind. In jeder Iteration muss jedoch das Gradientenbild von f .j erneut berechnet werden, da f .j in Schritt 2 aktualisiert wurde. Das andere Problem besteht darin, dass δP (und daher die Jacobi-Determinante) von den Tiefenmessungen zj abhängt oder im Fall der Vorvermessung der Tiefe im stationären Referenzsystem von den Tiefenmessungen z und der gesamten Bewegung der Bildaufnahmevorrichtung abhängt, die zum Einzelbild fj:xcj, Rj führt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie, in dem die Tiefenmessungen in dem an die Bildaufnahmevorrichtung gebundenen Referenzsystem (wie z. B. Laserpunkte, Tiefenkamera, Stereoausrüstung usw.) erhalten werden, stehen mehr Tiefenmessungen für das Einzelbild fi zur Verfügung, da alle vorherigen Einzelbildmessungen auf das Referenzsystem des Einzelbildes fi transformiert werden können, da nun xci, Ri bekannt ist.

-

In einem Ausführungsbeispiel der vorliegenden Technologie ist, während die Tiefe der Szene im stationären System vorvermessen wird, die Gesamtbewegung xcj, Rj noch zu lösen und kann folglich nur als Funktionen von xci, Ri und ξ ausgedrückt werden, wenn die Form der Jacobi-Determinante berechnet wird. Dies macht nicht nur die Form der Jacobi-Determinante kompliziert, sondern macht auch die Jacobi-Determinante von der Iteration abhängig.

-

In einem Ausführungsbeispiel der vorliegenden Technologie werden das Gradientenbild von f

i und die Jacobi-Determinante im Einzelbild f

i berechnet, während f

j in den Iterationen transformiert wird. Daher 1) wird dξ unter Verwendung von ∫|f

i(δP

–1(u)) – f

j(u)|

2du anstatt in jeder Iteration berechnet, was einem ermöglicht, das Gradientenbild von f

i zu verwenden, und die Jacobi-Determinante der Umkehrtransformation

wird im Einzelbild f

i ausgewertet, die beide nur einmal berechnet werden müssen. 2) Das akkumulierte ξ, und δP werden auf f

j angewendet, um es nahe an f

i zu bringen, um irgendeine Transformation an f

i zu vermeiden.

-

Nach dem Neudefinieren von D = ∇fi ∂δP(u) / ∂ξ, das im Einzelbild fi ausgewertet wird, wird somit der Bildverarbeitungsalgorithmus 25 wie folgt überarbeitet:

- 1. Initialisieren von ξ;

- 2. Initialisieren von D = ∇fi ∂δP(u) / ∂ξ im Einzelbild fi;

- 3. Berechnen von δP aus ξ, Durchführen der Transformation an fi: fj(u) ⇒ f .j(u) = fj(δP(u))

- 4. Berechnen von dξ aus fi, f .j, dξ = ∫(fi(u) – f .j(u))DTdu/∫DDTdu;

- 5. Aktualisieren von ξ, dξ ⇒ ξ;

- 6. Wenn dξ klein genug ist oder die maximale Iteration erreicht ist, dann Ausstieg, ansonsten Schleifenrücklauf zu Schritt 3.

-

Die Tiefe für jedes Pixel in f .j ist erforderlich, um in Schritt 3) δP(u) zu berechnen. Da f .j die beste Abschätzung von fi in dem Moment ist, besteht die einfachste Wahl darin, stattdessen die Tiefe für Pixel in fi zu verwenden.

-

In einem Ausführungsbeispiel der vorliegenden Technologie hängt die Konvergenz der Iterationen davon ab, wie ”glatt” das Gradientenbild ist. Wenn das Gradientenbild in einem viel kleineren Maßstab als die Bildverschiebung, die sich aus der Bewegung der Bildaufnahmevorrichtung zwischen zwei Einzelbildern ergeben hat, variiert, kann die Schleife nicht konvergieren. Daher werden die zwei Einzelbilder zuerst geglättet, bevor sie in die obige Schleife eingespeist werden. Nachdem eine Näherung ξ aus den geglätteten Einzelbildern gefunden ist, kann die Glättung entfernt oder verringert werden und ein genaueres ξkann mit dem vorherigen ξ als Ausgangspunkt erhalten werden.

-

Folglich wird in einer Bilditerationspyramide die höhere Ebene stärker geglättet, während die untere Ebene das Rohbild ohne Glättung ist. Von oben nach unten in der Bildpyramide wird ξ wie folgt verfeinert:

- 1. Initialisieren von ξ

- 2. Konstruieren von Bildpyramiden von fi und fj, wenn sie nicht bereits zur Verfügung stehen,

- 3. Von oben nach unten für jede Ebene der Pyramide

- 3.1 Initialisieren von D = ∇fi ∂δP(u) / ∂ξ im Einzelbild fi;

- 3.2 Berechnen von dξ aus fi, f .j, dξ = ∫(fi(u) – f .j(u))DTdu/∫DDTdu;

- 3.3 Aktualisieren von ξ, dξ ⇒ ξ;

- 3.4 Durchführen einer Transformation an fj: (u) ⇒ f .j(u) = fj(δP(u));

- 3.5 wenn dξ klein genug ist oder eine maximale Iteration erreicht ist, dann Ausstieg, ansonsten Schleifenrücklauf zu Schritt 3.2.

-

Die explizite Form von δP(u

i) hängt von der Abbildungsfunktion m ab. Selbst mit einem gegebenen m ist die Form von δP(u

i) nicht eindeutig. In einem Ausführungsbeispiel der vorliegenden Technologie kann man, wenn die Linsen

16 die geradlinigen Linsen umfassen und wenn die vorvermessene Tiefe z zur Verfügung steht, wählen:

wobei

R T / i(3,:) die Transponierte der dritten Zeile der Gesamtrotationsmatrix R

i im Einzelbild f

i ist. Es ist der Einheitsvektor in der z-Richtung, ausgedrückt im an die Bildaufnahmevorrichtung gebundenen Referenzsystem des Einzelbildes f

i.

-

-

In einem Ausführungsbeispiel der vorliegenden Technologie kann man, wenn die Tiefenmessungen in dem an die Bildaufnahmevorrichtung gebundenen System durchgeführt werden (z

i ist bekannt), wählen

-

In einem Ausführungsbeispiel der vorliegenden Technologie kann man, wenn die Tiefe bekannt ist, die Tiefe der zwei Einzelbilder anstelle der Pixelintensität vergleichen, da, wenn die Tiefe bekannt ist, die 3D-Koordinaten des Pixelpunkts auch bekannt sind.

-

Durch Behandeln der 3D-Koordinaten in dem an die Bildaufnahmevorrichtung gebundenen System als Vektorfunktion der 2D-Pixelkoordinaten: (xi(ui) – δxc)δR = xj(uj), (Gl. 18) kann man eine Kostenfunktion verwenden, die das Quadrat des 3D-Abstandes zwischen dem Einzelbild fi und dem Einzelbild fj ist: ∫||(xi(u) – δxc)δR – xj(δP(u))||2du. (Gl.19)

-

Eine weitere Möglichkeit bestünde darin, das Quadrat der Differenz der Komponente z zwischen diesen beiden zu verwenden.

-

Dieser Algorithmus kann leicht erweitert werden, um Farbbilder zu handhaben. Für RGB-Bilder ist beispielsweise das Einzelbild f = (fy, fg, fb) ein Zeilenvektor und D = (Dy, Dg, Db) ist eine 6×3-Matrix mit Dy, Dg, Db jeweils als 6×1-Spaltenvektor.

-

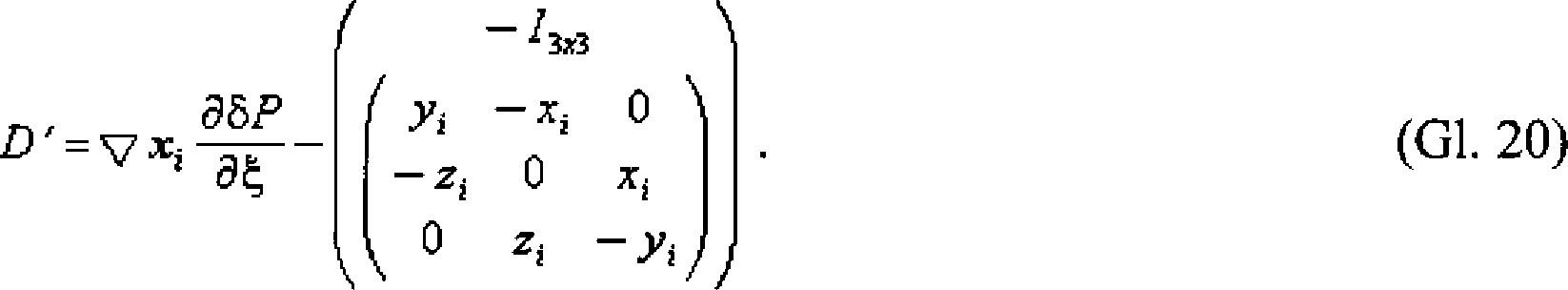

Ähnlich zur Algorithmusoptimierung für die Pixelintensität wird die Jacobi-Determinanten-Berechnung auf der x

i-Seite durchgeführt und die Transformation wird auf der x

j-Seite durchgeführt. Der Spaltenvektor D wird nun durch eine 6×3-Matrix D' ersetzt, da drei Komponenten in einem Satz von 3D-Koordinaten vorliegen:

-

In diesem Ausführungsbeispiel der vorliegenden Technologie kann der Bildverarbeitungsalgorithmus 25 unter Verwendung der folgenden Schleifenroutine implementiert werden:

- 1. Initialisieren von ξ

- 2. Konstruieren von Bildpyramiden von zi und zj, wenn sie nicht bereits zur Verfügung stehen

- 3. Von oben nach unten für jede Ebene der Pyramide

- 3.1 Initialisieren von D' im Einzelbild fi

- 3.2 Berechnen von δP aus ξ, Durchführen der Transformation an xj: xj(u) ⇒ x .j(u) = xj(δP(u))δRT + δxc

- 3.3 Berechnen von dξ aus xi, x .j, dξ = ∫(xi(u) – x .j(u))D'Tdu/∫D'D'Tdu

- 3.4 Aktualisieren von ξ, dξ ⇒ ξ

- 3.5 wenn dξ klein genug ist oder eine maximale Iteration erreicht ist, dann Ausstieg, ansonsten Schleifenrücklauf zu Schritt 3.2.

-

In einem Ausführungsbeispiel der vorliegenden Technologie kann man eine Kombination der Pixelintensitätsvergleichs-Kostenfunktion und der Tiefenvergleichskostenfunktion verwenden ∫(λ|fi(u) – fj(δP(u))|2 + (1 – λ)||(xi(u) – δxc)δR – xj(δP(u))||)2du. (Gl. 21)

-

λ ∊ [0, 1] ist ein Gewichtungsfaktor, der demgemäß, wie gut die Annahme des optischen Ablaufs gehalten wird, gemäß der Qualität des optischen Bildes und der Qualität des Tiefenbildes eingestellt werden soll. Die schrittweise Änderung in jeder Iteration ist dξ = ∫λ(fi(u) – f .j(u))DT + (1 – λ)(xi(u) – x .j(u))D'Tdu/∫λDDT + (1 – λ)D'D'Tdu (Gl. 22)

-

In einem Ausführungsbeispiel der vorliegenden Technologie ist die Beziehung zwischen der Deltabewegung und der Gesamtbewegung von fi und fi+1 wie folgt: Ri+1 = RiδRi –> i+1

xci+1 = xci + δxci –> i+1R T / i (Gln. 23)

-

Wenn die Schleife bei der maximalen Iteration ohne Konvergieren auf ξ zwischen fi und fi+1 aussteigt, kann man sich entscheiden, fi durch fi-1 zu ersetzen, statt dessen die Bewegung zwischen fi-1 und fi+1 herauszufinden, oder man kann sich entscheiden, zwischen fi und fi+2 vorzugehen und das Ergebnis zwischen fi und fi+1 als unzuverlässig zu markieren.

-

Die Tiefeninformationen für jedes Pixel in fi sind erforderlich, um 1) fj(u) ⇒ f .j(u) = fj(δP(u)) zu transformieren und 2) um die Jacobi-Determinante bei fi zu berechnen. Tiefeninformationen können sich in verschiedenen Formen einstellen.

-

In einem Ausführungsbeispiel der vorliegenden Technologie ist die Szene relativ flach und kann durch einige (viel weniger als die Pixelzahlen im Einzelbild) vorvermessene Punkte im stationären Referenzsystem beschrieben werden. Wenn dies der Fall ist, müssen die vorvermessenen Punkte, die im stationären Referenzsystem ausgedrückt werden, in das Referenzsystem des Einzelbildes fi transformiert werden z(x, y) ⇒ zi(ui). Diese Punkte werden dann als Referenzpunkte verwendet, um die Tiefe für jeden Pixelpunkt in fi durch Dreiecksinterpolation herauszufinden. Bei einer Dreiecksinterpolation wird ein Punkt im Dreieck als Kombination von drei Scheitelpunkten des Dreiecks ausgedrückt. Die drei Kombinationskoeffizienten müssen beim Umschalten zwischen dem 3D-Referenzsystem und dem projizierten 2D-Referenzsystem gemäß den Tiefen der drei Scheitelpunkte eingestellt werden.

-

In einem Ausführungsbeispiel der vorliegenden Technologie werden einige (viel weniger als die Pixelzahlen im Einzelbild) Tiefenpunkte zusammen mit jedem Einzelbild in dem an die Bildaufnahmevorrichtung gebundenen System, wie z. B. von Punktlasern, die an der Bildaufnahmevorrichtung angebracht sind, oder entsprechende Merkmalspunkte von einer Stereokameraausrüstung erhalten. Wenn dies der Fall ist, kommen die Laserpunkttiefenmessungen mit jedem Einzelbild. Sie und Punkte von vorherigen Einzelbildern werden in drei Kategorien gesetzt:

- 1) Einstellpunkte: Laserpunkttiefenmessungen kommen mit dem Einzelbild fi+1. Sie werden nur verwendet, wenn der Tiefenvergleich verwendet wird.

- 2) Aktive Punkte: Laserpunkttiefenmessungen kommen mit dem Einzelbild fi und Laserpunkttiefenmessungen kommen mit früheren Einzelbildern, die sich aus keinem der Einzelbilder heraus bewegt haben und in das Referenzsystem des Einzelbildes fi transformiert wurden. Diese Punkte werden in die Delaunay-Triangulation eingesetzt. Die Delaunay-Scheitelpunkte werden als Referenzpunkte verwendet, um die Pixeltiefe durch Dreiecksinterpolation zu berechnen.

- 3) Ausgeschiedene Punkte: Diese Punkte stammen vom vorherigen Einzelbild, die sich aus fi und fi+1 bewegt haben. Diese Punkte werden gespeichert, um eine Tiefenabbildung der Szene zu bilden, falls erwünscht.

-

In einem Ausführungsbeispiel der vorliegenden Technologie steht ein Raster von Tiefenpunkten mit jedem Einzelbild im an die Bildaufnahmevorrichtung gebundenen Referenzsystem mit derselben Auflösung wie oder einer vergleichbaren Auflösung zum Videoeinzelbild zur Verfügung. In diesem Fall können mit dem Einzelbild fi erhaltene Tiefenmessungen direkt verwendet werden, wenn die Auflösung gleich ist, oder können interpoliert werden, wenn die Auflösung niedriger ist. Tiefenmessungen, die mit fi und fi+1 erhalten werden, können im Tiefenvergleich direkt oder nach Interpolation verwendet werden.

-

In einem Ausführungsbeispiel der vorliegenden Technologie ist 2 ein Ablaufplan 50 eines Verfahrens zur Bildverfolgung unter Verwendung der Vorrichtung 22 von 1, wobei die Tiefendaten der Szene 20 durch Vorvermessung der Szene erhalten werden.

-

In diesem Ausführungsbeispiel der vorliegenden Technologie umfasst das Verfahren der Bildverfolgung zwei Schritte: (Schritt 54) Durchführen einer Bildaufnahme der Szene 20 (von 1) unter Verwendung einer Bildaufnahmevorrichtung; und (Schritt 62) Verfolgen der Bewegung der Bildaufnahmevorrichtung durch Analysieren eines Satzes von in Schritt 54 erhaltenen Bildern.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird Schritt 54 zum Durchführen einer Bildaufnahme der Szene 20 in Echtzeit unter Verwendung der Bildaufnahmevorrichtung 22 (von 1) durchgeführt – Schritt 56.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird Schritt 54 durch Voraufzeichnen der Szene 20 unter Verwendung der Bildaufnahmevorrichtung 22 durchgeführt – Schritt 58.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst Schritt 54 ferner das Erhalten eines Satzes von Tiefendaten der Szene 20 durch Vorvermessung der Szene – Schritt 60.

-

Wie vorstehend offenbart wurde, ist die Bildaufnahmevorrichtung aus der Gruppe ausgewählt, die aus Folgendem besteht: {einer Digitalkamera; einer digitalen Videokamera; einem digitalen Camcorder; einer Stereodigitalkamera; einer Stereovideokamera; einer Filmkamera; und einer Fernsehkamera}.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst der Schritt 62 zum Verfolgen der Bewegung der Bildaufnahmevorrichtung durch Analysieren des Satzes von Bildern, die in Schritt 54 erhalten werden, ferner den Schritt 64 zum Durchführen einer starren globalen Transformation des Satzes von erfassten Bilddaten und des Satzes von Szenentiefendaten in einen Satz von 6-Koordinaten-Daten; wobei der Satz von 6-Koordinaten-Daten die Bewegung der Bildaufnahmevorrichtung 22 (von 1) darstellt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie stellt 3 einen Ablaufplan 100 eines Verfahrens zur Bildverfolgung dar, wobei die Tiefendaten der Szene unter Verwendung einer Entfernungsmessvorrichtung 14 erhalten werden.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst der Ablaufplan 100 eines Verfahrens zur Bildverfolgung ferner den Schritt 104 zum Durchführen einer Bildaufnahme einer Szene unter Verwendung einer Bildaufnahmevorrichtung.

-

In einem Ausführungsbeispiel der vorliegenden Technologie kann Schritt 104 durch Durchführen der Bildaufnahme der Szene in Echtzeit unter Verwendung der Bildaufnahmevorrichtung implementiert werden – Schritt 106.

-

In einem Ausführungsbeispiel der vorliegenden Technologie kann Schritt 104 durch Durchführen des Schritts 108 zum Durchführen einer Bildaufzeichnung der Szene unter Verwendung der Bildaufnahmevorrichtung implementiert werden.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst der Ablaufplan 100 eines Verfahrens zur Bildverfolgung ferner den Schritt 110 zum Erhalten eines Satzes von Szenentiefendaten unter Verwendung einer Entfernungsmessvorrichtung, die aus der Gruppe ausgewählt ist, die aus Folgendem besteht: {einem Punktlaserstrahl; einem Sonar; einem Radar; einem Laserabtaster; und einer Tiefenkamera}.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird der Schritt 110 durch Bestimmen des Satzes von Szenentiefendaten in einem an die Bildaufnahmevorrichtung gebundenen 3D-Referenzsystem unter Verwendung eines K-Punkt-Entfernungsmesssystems, das an der Bildaufnahmevorrichtung angebracht ist, implementiert – Schritt 112.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird Schritt 110 durch Bestimmen der Tiefe des Objektpunkts direkt für mindestens einen Bildpunkt des Objektpunkts unter Verwendung eines M-Punkt-Entfernungsmesssystems, das an der Bildaufnahmevorrichtung angebracht ist, implementiert, wobei die ganze Zahl M von Tiefenmessungen der Szene im Wesentlichen gleich der Anzahl von Pixeln im Einzelbild ist – Schritt 114.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird Schritt 110 durch Bestimmen des Satzes von Szenentiefendaten in einem an die Bildaufnahmevorrichtung gebundenen 3D-Referenzsystem unter Verwendung eines Merkmalspunkt-Entfernungsmesssystems, das an der Bildaufnahmevorrichtung angebracht ist, implementiert – Schritt 116.

-

Schließlich umfasst in einem Ausführungsbeispiel der vorliegenden Technologie der Ablaufplan 100 eines Verfahrens zur Bildverfolgung ferner den Schritt 118 zur Verfolgung der Bewegung der Bildaufnahmevorrichtung durch Analysieren des Satzes von Bildern.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird Schritt 118 durch Durchführen einer starren globalen Transformation des Satzes von erfassten Bilddaten und des Satzes von Szenentiefendaten in einen Satz von 6-Koordinaten-Daten durchgeführt; wobei der Satz von 6-Koordinaten-Daten die Bewegung der Bildaufnahmevorrichtung darstellt – Schritt 120.

-

4, 5, 6 und 7 stellen die Beispielergebnisse der Verfolgung auf Bildbasis unter Verwendung der Vorrichtung 22 von 1 dar. Insbesondere stellt 2 ein Diagramm 140 dar, das das Bildaufnahmevorrichtungsbild der Szene 20 in der Sensorebene 16 darstellt.

-

5 zeigt ein Diagramm 150, das die 2D-Bewegung der Bildaufnahmevorrichtung, die unter Verwendung des Algorithmus 25 von 1 berechnet wird, wie vorstehend vollständig offenbart wurde, darstellt.

-

6 stellt ein Diagramm 160 dar, das die Höhenbewegung der Bildaufnahmevorrichtung, die unter Verwendung des Algorithmus 25 von 1 berechnet wird, wie vorstehend vollständig offenbart wurde, darstellt.

-

7 zeigt ein Diagramm 170, das die Gesamtdrehwinkel der Bildaufnahmevorrichtung (Gieren 172, Nicken 174 und Rollen 176), die unter Verwendung des Algorithmus 25 von 1 berechnet werden, wie vorstehend vollständig offenbart wurde, darstellt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie werden Merkmale als nicht einfach Punkte, sondern auch als Darstellung von Bereichen und/oder Konturen definiert. In diesem Ausführungsbeispiel der vorliegenden Technologie können grob definierte Merkmale verwendet werden, um die Oberflächenverfolgungsfähigkeiten wesentlich zu erweitern.

-

In einem Ausführungsbeispiel der vorliegenden Technologie können grob definierte Merkmale verwendet werden, um Szenenverständnistechniken zu verwenden, um problematische Objekte (d. h. Autos) zu verwerfen.

-

In einem Ausführungsbeispiel der vorliegenden Technologie sind Szenenverständnistechniken Verfahren, die höhere Beurteilungsstufen aus einem Bild folgern. Es kann beispielsweise das Erfassen der Grenzen von Autos, Fußgängern in einer Szene und das Verwerfen von verglichenen Merkmalen, die in diesen Bereichen liegen, umfassen. Sobald solche ungewollten Objekte identifiziert sind, wird ein brauchbarer Bereich des Bildes gewonnen. Der Merkmalsvergleich wird anschließend auf diesen Bereich eingeschränkt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie beinhaltet die Erfassung von ungewollten Objekten eine Objekterkennung mit: (A) Gewinnung von spärlichen Merkmalen aus einem Bild; (B) Zusammengruppieren von benachbarten Merkmalen; (C) und Ableiten einer Objektkategorie für mindestens eine gegebene Gruppierung.

-

In einem Ausführungsbeispiel der vorliegenden Technologie können grob definierte Merkmale in der anfänglichen Bildanalyse verwendet werden (z. B. Kontrastbewertung), um die Eignung eines Bildes oder Bildbereichs für die Verfolgung zu bestimmen.

-

In einem Ausführungsbeispiel der vorliegenden Technologie wird, wenn die Qualität der gesammelten Bilder zu schlecht ist, damit sie in die Oberflächenverfolgung übergeben werden, z. B. das Bild zu dunkel ist, und sehr wenige Merkmale gewonnen und verglichen werden würden, eine anfängliche Bildbewertungsanalyse durchgeführt, um die Bedienperson am Einsatzort zu informieren, ob die Bilder brauchbar sind oder ob die Bilder erneut gesammelt werden müssen.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst eine anfängliche Bildbewertungsanalyse das Gewinnen von mindestens drei Attributen aus dem Bild: (A) Sättigungsqualität, um zu prüfen, ob ein Bild hauptsächlich aus einem Rot-Grün-Blau-Wert besteht; (B) Prüfen der Texturqualität eines Bildes, wenn das Bild größtenteils hauptsächlich verschwommen ist und ihm scharfe Bereiche für die Merkmalsgewinnung fehlen; (C) und Prüfen eines Bildkontrasts, wenn das Bild größtenteils dunkel oder größtenteils hell ist, was die Straßenoberflächen im Wesentlichen verwaschen wiedergibt.

-

In einem Ausführungsbeispiel der vorliegenden Technologie können grob definierte Merkmale verwendet werden, um die Oberflächenverfolgungslösung zu initialisieren.

-

In einem Ausführungsbeispiel der vorliegenden Technologie kann insbesondere die anfängliche Lösung unter Verwendung von grob definierten Merkmalen und RANdom SAmple Consensus (RANSAC, Stichprobenkonsens) gefunden werden.

-

RANSAC ist ein iteratives Verfahren zum Abschätzen von Parametern eines mathematischen Modells aus einem Satz von beobachteten Daten, der Ausreißer enthält.

-

In der Statistik ist ein Ausreißer eine Beobachtung, die vom Rest der Daten numerisch entfernt ist. Insbesondere ist ein Ausreißer als abgelegene Beobachtung definiert, die merklich von anderen Mitgliedern der Stichprobe, in der er auftritt, abzuweichen scheint.

-

Ausreißer können zufällig in irgendeiner Verteilung auftreten, sie deuten jedoch häufig entweder auf einen Messfehler oder darauf hin, dass die Population eine endlastige Verteilung aufweist. Im ersteren Fall möchte man sie verwerfen oder eine Statistik verwenden, die gegenüber Ausreißern robust ist, während sie im letzteren Fall darauf hinweisen, dass die Verteilung eine hohe Wölbung aufweist und dass man bei der Verwendung eines Werkzeugs oder von Erkenntnissen, die eine Normalverteilung annehmen, sehr vorsichtig sein sollte. Eine häufige Ursache für Ausreißer ist eine Mischung von zwei Verteilungen, die zwei verschiedene Subpopulationen sein können oder auf einen ”korrekten Versuch” gegenüber einem ”Messfehler” hinweisen können; dies wird durch ein Mischmodell modelliert.

-

In einem Ausführungsbeispiel der vorliegenden Technologie verwendet die anfängliche Lösung auf der Basis von grob definierten Merkmalen und RANSAC einen nicht deterministischen Algorithmus in der Hinsicht, dass er nur mit einer gewissen Wahrscheinlichkeit ein vernünftiges Ergebnis erzeugt, wobei diese Wahrscheinlichkeit zunimmt, wenn mehr Iterationen ermöglicht werden. Der Algorithmus wurde zum ersten Mal 1981 von Fischler und Bolles veröffentlicht.

-

In einem Ausführungsbeispiel der vorliegenden Technologie basiert die anfängliche Lösung unter Verwendung von grob definierten Merkmalen und RANSIC auf der Annahme, dass die Daten aus ”Normalfällen”, d. h. Daten, deren Verteilung durch einen gewissen Satz von Modellparametern erklärt werden können, und ”Ausreißern”, die Daten sind, die nicht zum Modell passen, bestehen. Zusätzlich dazu können die Daten Rauschen unterliegen. Die Ausreißer können z. B. von Extremwerten des Rauschens oder von fehlerhaften Messungen oder falschen Hypothesen über die Interpretation der Daten stammen. RANSAC nimmt auch an, dass in Anbetracht eines (gewöhnlich kleinen) Satzes von Normalfällen eine Prozedur existiert, die die Parameter eines Modells abschätzen kann und die diese Daten optimal erklärt oder anpasst.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst das Verfahren zur Verwendung eines Satzes von grob definierten Merkmalen, um eine anfängliche Lösung der Kameraposition zu finden, als Eingabe in die Oberflächenverfolgung die folgenden Schritte:

Erfassen eines Satzes von grob definierten Merkmalen; Feststellen von Entsprechungen zwischen dem Satz von grob definierten Merkmalen und mindestens zwei ausgewählten Einzelbildern; Abschätzen der Homographie zwischen mindestens zwei ausgewählten Einzelbildern unter Verwendung von Parametern des mathematischen RANSAC-Modells; Ableiten einer anfänglichen Stellung der Bildaufnahmevorrichtung aus der abgeschätzten Homographie zwischen mindestens zwei ausgewählten Einzelbildern; wobei die Stellung der Bildaufnahmevorrichtung Positionskoordinaten der Bildaufnahmevorrichtung und einen Satz von Winkelkoordinaten der Bildaufnahmevorrichtung umfasst; und Verwenden der abgeleiteten anfänglichen Stellung der Bildaufnahmevorrichtung als anfängliche Lösung für die Oberflächenverfolgungslösung.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst das Verfahren zur Verwendung von grob definierten Merkmalen zum Finden einer strengen zweidimensionalen (strict_2D) Oberflächenverfolgungslösung: Erfassen eines Satzes von grob definierten Merkmalen auf einer einzelnen Verfolgungsoberfläche; Auswählen eines Satzes von koplanaren grob definierten Merkmalen unter Verwendung von Parametern des mathematischen RANSAC-Modells; Feststellen von Entsprechungen zwischen dem Satz von ausgewählten koplanaren grob definierten Merkmalen und mindestens zwei ausgewählten Einzelbildern; Ableiten einer anfänglichen Stellung der Bildaufnahmevorrichtung aus der Homographie zwischen mindestens zwei ausgewählten Einzelbildern; Verwenden der abgeleiteten anfänglichen Stellung der Bildaufnahmevorrichtung als anfängliche Lösung für die strenge zweidimensionale (strict_2D) Oberflächenverfolgungslösung; und Gruppieren des Satzes von koplanaren Merkmalen und Verwenden eines Bereichs um die Gruppe von koplanaren Merkmalen als Eingabe in die strict_2D-Oberflächenverfolgungslösung.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst das Verfahren zur Verwendung eines Satzes von koplanaren grob definierten Merkmalen auf einer Vielzahl von zweidimensionalen (2D) Verfolgungsoberflächen zum Finden einer im Wesentlichen zweidimensionalen (sub_2D) Oberflächenverfolgungslösung ferner: Erfassen eines Satzes von grob definierten Merkmalen auf einer Vielzahl von Verfolgungsoberflächen; Auswählen eines Satzes von koplanaren grob definierten Merkmalen unter Verwendung von Parametern des mathematischen RANSAC-Modells; Feststellen von Entsprechungen zwischen dem Satz von koplanaren grob definierten Merkmalen und mindestens zwei ausgewählten Einzelbildern; Ableiten einer anfänglichen Stellung der Bildaufnahmevorrichtung aus der Homographie zwischen mindestens zwei ausgewählten Einzelbildern; Verwenden der abgeleiteten anfänglichen Stellung der Bildaufnahmevorrichtung als anfängliche Lösung für eine im Wesentlichen zweidimensionale (sub_2D) Oberflächenverfolgungslösung; und Auswählen eines lokalen Bereichs um jedes ausgewählte koplanare grob definierte Merkmal, Gruppieren einer Vielzahl der ausgewählten lokalen Bereiche in einen zweidimensionalen (2D) globalen Bereich und Verwenden des globalen 2D-Bereichs als Eingabe in die sub_2D-Oberflächenverfolgungslösung.

-

In einem Ausführungsbeispiel der vorliegenden Technologie umfasst das Verfahren zur Verwendung eines Satzes von grob definierten Merkmalen, die aus einem dreidimensionalen (3D) Bereich gewonnen werden, zum Finden einer Lösung für eine im Wesentlichen dreidimensionale (sub_3D) Oberflächenverfolgung ferner: Erfassen eines Satzes von grob definierten Merkmalen auf der 3D-Oberfläche; Feststellen von Entsprechungen zwischen dem Satz von grob definierten Merkmalen und mindestens zwei ausgewählten Einzelbildern; Abschätzen der Homographie zwischen mindestens zwei ausgewählten Einzelbildern; Ableiten einer anfänglichen Stellung der Bildaufnahmevorrichtung aus der Homographie zwischen mindestens zwei ausgewählten Einzelbildern; Verwenden der abgeleiteten anfänglichen Stellung der Bildaufnahmevorrichtung als anfängliche Lösung für die im Wesentlichen dreidimensionale (sub_3D) Oberflächenverfolgungslösung; und Auswählen eines lokalen Bereichs um jedes ausgewählte grob definierte Merkmal, Gruppieren einer Vielzahl der ausgewählten lokalen Bereiche in einen dreidimensionalen (3D) globalen Bereich und Verwenden des globalen 3D-Bereichs als Eingabe in die sub_3D-Oberflächenverfalgungslösung.

-

Die obige Erörterung hat den Betrieb von verschiedenen beispielhaften Systemen und Vorrichtungen sowie verschiedene Ausführungsbeispiele, die beispielhafte Verfahren zum Betreiben solcher Systeme und Vorrichtungen betreffen, dargelegt. In verschiedenen Ausführungsbeispielen werden ein oder mehrere Schritte eines Verfahrens zur Implementierung durch einen Prozessor unter der Steuerung von computerlesbaren und computerausführbaren Befehlen ausgeführt. In einigen Ausführungsbeispielen werden diese Verfahren folglich über einen Computer implementiert.

-

In einem Ausführungsbeispiel können sich die computerlesbaren und computerausführbaren Befehle auf für einen Computer verwendbaren/lesbaren Medien befinden.

-

Daher können ein oder mehrere Operationen von verschiedenen Ausführungsbeispielen unter Verwendung von computerausführbaren Befehlen wie z. B. Programmmodulen, die von einem Computer ausgeführt werden, gesteuert oder implementiert werden. Im Allgemeinen umfassen Programmmodule Routinen, Programme, Objekte, Komponenten, Datenstrukturen usw., die spezielle Aufgaben durchführen oder spezielle abstrakte Datentypen implementieren. Außerdem kann die vorliegende Technologie auch in verteilten Rechenumgebungen ausgeführt werden, in denen Aufgaben durch entfernte Verarbeitungsvorrichtungen durchgeführt werden, die über ein Kommunikationsnetz verbunden sind. In einer verteilten Rechenumgebung können sich die Programmodule sowohl in lokalen als auch entfernten Computerspeichermedien, einschließlich Speichervorrichtungen, befinden.

-

Obwohl hierin spezielle Schritte von beispielhaften Verfahren zur Implementierung offenbart sind, sind diese Schritte Beispiele von Schritten, die gemäß verschiedenen beispielhaften Ausführungsbeispielen durchgeführt werden können. Das heißt, hierin offenbarte Ausführungsbeispiele sind zur Durchführung von verschiedenen anderen Schritten oder Veränderungen der angeführten Schritte gut geeignet. Die hierin offenbarten Schritte können überdies in einer anderen als dargestellten Reihenfolge durchgeführt werden und nicht alle der Schritte werden notwendigerweise in einem speziellen Ausführungsbeispiel durchgeführt.

-

Obwohl hierin verschiedene elektronische Systeme und Systeme auf Softwarebasis erörtert sind, sind diese Systeme nur Beispiele von Umgebungen, die verwendet werden könnten, und sollen keine Begrenzung hinsichtlich des Verwendungsumfangs oder der Funktionalität der vorliegenden Technologie andeuten. Solche Systeme sollten auch nicht als irgendeine Abhängigkeit von oder Beziehung zu irgendeiner oder einer Kombination von Komponenten oder Funktionen, die in den offenbarten Beispielen dargestellt sind, aufweisend interpretiert werden.

-

Obwohl der Gegenstand in einer für Strukturmerkmale und/oder methodologische Handlungen spezifischen Sprache beschrieben wurde, ist der in den beigefügten Ansprüchen definierte Gegenstand nicht notwendigerweise auf die vorstehend beschriebenen spezifischen Merkmale oder Handlungen begrenzt. Vielmehr sind die vorstehend beschriebenen spezifischen Merkmale und Handlungen als beispielhafte Formen zum Implementieren der Ansprüche offenbart.

-

ZITATE ENTHALTEN IN DER BESCHREIBUNG

-

Diese Liste der vom Anmelder aufgeführten Dokumente wurde automatisiert erzeugt und ist ausschließlich zur besseren Information des Lesers aufgenommen. Die Liste ist nicht Bestandteil der deutschen Patent- bzw. Gebrauchsmusteranmeldung. Das DPMA übernimmt keinerlei Haftung für etwaige Fehler oder Auslassungen.

-

Zitierte Nicht-Patentliteratur

-